|

Опрос

|

реклама

Быстрый переход

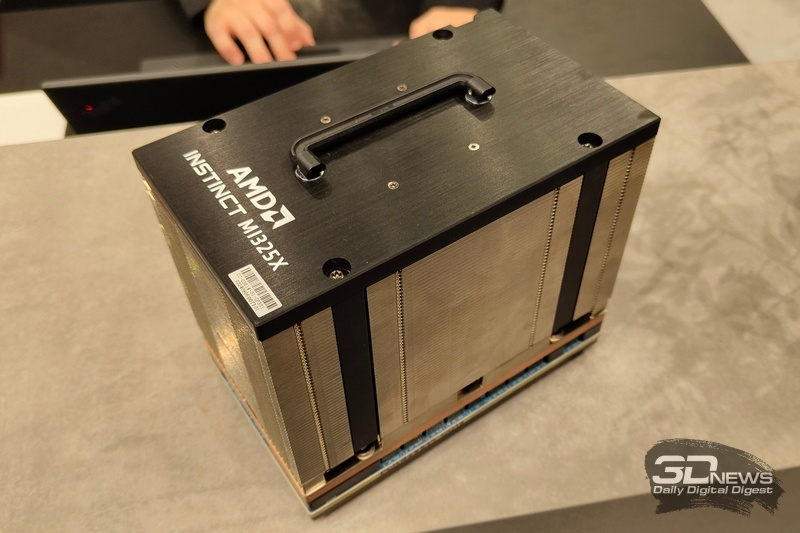

AMD столкнулась со слабым спросом на ИИ-ускорители Instinct MI325X

14.05.2025 [09:27],

Вячеслав Ким

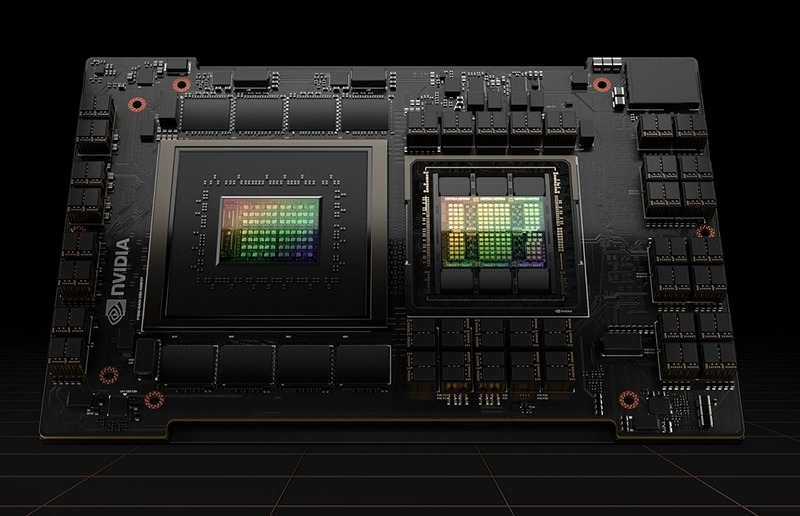

Ускорители AMD Instinct MI325X, запущенные во втором квартале 2025 года, не смогли привлечь крупных клиентов, уступив по популярности решениям от Nvidia. По данным аналитиков SemiAnalysis, покупатели предпочли графические процессоры Blackwell от Nvidia из-за более выгодного соотношения производительности и стоимости.  Одним из ключевых факторов низкого спроса стал предел масштабируемости MI325X — до восьми GPU на систему. Для сравнения, конкурирующий продукт Nvidia GB200 NVL72 объединяет до 72 графических процессоров в едином кластере, что критически важно при выполнении масштабных задач в области искусственного интеллекта. Ранний интерес к MI325X проявила компания Microsoft в 2024 году, однако после первых закупок корпорация не разместила повторных заказов. AMD попыталась исправить ситуацию, снизив цены для привлечения новых клиентов. Oracle и ещё несколько крупных операторов дата-центров заинтересовались предложением, но объёмы их закупок остаются незначительными по сравнению с поставками Nvidia. Тем не менее у AMD Instinct MI325X сохраняются перспективы в сегменте, где не требуется большое количество объединённых GPU. Компания намерена улучшить экосистему программного обеспечения и сохранить конкурентные цены для привлечения разработчиков моделей ИИ с небольшим числом параметров. AMD выпустила Instinct MI325X одновременно с Nvidia H200 и платформой Blackwell, что существенно осложнило конкуренцию на рынке высокопроизводительных вычислений. В последние годы Nvidia занимает лидирующие позиции благодаря более гибким решениям и высокой производительности в задачах искусственного интеллекта и глубокого обучения. Nvidia придумала, как законно обойти антикитайские санкции, и продолжит поставки ИИ-ускорителей в Китай

02.05.2025 [22:24],

Анжелла Марина

После ужесточения санкций со стороны США и запрета на поставку в Китай ИИ-ускорителя H20, Nvidia оказалась в сложной ситуации и вынуждена пересмотреть стратегию работы с ключевым китайским рынком, чтобы избежать нарушений экспортных ограничений. Компания ведёт переговоры с Alibaba, ByteDance и Tencent о поставках адаптированных чипов.

Источник изображения: Mariia Shalabaieva / Unsplash По сообщению Reuters, генеральный директор компании Дженсен Хуан (Jensen Huang) лично проинформировал партнёров о новых разработках во время своего визита в Пекин в середине апреля. Эта поездка состоялась вскоре после того, как США ограничили экспорт в Китай чипов H20 (специализированный вариант H100) для задач искусственного интеллекта. По оценкам самой Nvidia, новые экспортные ограничения могут лишить компанию $5,5 млрд выручки, и чтобы минимизировать потери, разрабатываются чипы, которые формально соответствовали бы американским требованиям, но при этом сохраняли бы высокую производительность. Параллельно ведётся работа над «китайской» версией новейшего процессора Blackwell. Китайский рынок остаётся критически важным для Nvidia, поэтому компания ищет любые способы сохранить там своё присутствие. Ранее она уже выпускала «урезанные» версии чипов для этого региона, но новые санкции требуют более сложных технических решений, над чем сейчас и трудятся инженеры. Сообщается, что первые образцы ИИ-ускорителей поступят китайским клиентам уже в июне, а китайская версия Blackwell — немного позже. Представители Nvidia отказались комментировать эту информацию. Компании ByteDance, Alibaba и Tencent, а также Министерство торговли США не ответили на запросы Reuters. Anthropic раскрыла схему контрабанды ИИ-чипов вперемешку с живыми лобстерами — в Nvidia лишь посмеялись

02.05.2025 [15:58],

Павел Котов

На этой неделе события в технологической войне США и Китая приобрели несколько курьёзный оборот. Специализирующаяся на искусственном интеллекте компания Anthropic заявила, что контрабандисты ввозят чипы Nvidia в Китай, спрятав их вместе с живыми лобстерами.

Источник изображения: ChatGPT «Китай наладил сложные контрабандные схемы, и подтверждены инциденты, связанные с чипами на сотни миллионов долларов. В некоторых случаях контрабандисты применяли творческий подход, чтобы обойти экспортный контроль, в том числе прятали процессоры в накладных животах для имитации беременности и укрывали их [чипы] рядом с живыми лобстерами. Чтобы обойти экспортный контроль, китайские компании быстро регистрируют подставные юрлица в третьих странах», — говорится в публикации корпоративного блога Anthropic. Nvidia отреагировала на это заявление с сарказмом. «Американские компании должны принять вызов и заняться инновациями, а не рассказывать небылицы, что большая, тяжёлая и хрупкая электроника каким-то образом провозится контрабандой в „накладных животах“ или „вместе с живыми лобстерами“», — заявил её представитель CNBC. В действительности китайской таможне уже приходилось обнаруживать попытку контрабанды как в накладных животах, так и в контейнерах с лобстерами. Это, конечно, похоже на сцену из дешёвой комедии про шпионов, но это не вполне вымысел. Графические процессоры, о которых идёт речь, компактнее потребительских видеокарт, и их вполне можно прятать, прибегая к подобным ухищрениям. Правда, гарантия при этом аннулируется. ИИ с помощью мощных GPU научился взламывать пароли быстрее, чем их успевают менять

30.04.2025 [22:48],

Анжелла Марина

Современные хакеры с помощью искусственного интеллекта и мощных видеокарт (GPU) могут взламывать даже сложные пароли за считанные дни, а в некоторых случаях — мгновенно. Новое исследование по кибербезопасности, о котором сообщил HotHardware, показало, что традиционные комбинации символов больше не обеспечивают надёжной защиты.

Источник изображения: AI Системы безопасности давно используют метод хеширования — преобразование пароля в случайную последовательность символов. Например, пароль «Hot2025hard@» может храниться в базе данных сайта как зашифрованная строка вида «M176рге8739sheb647398nsjfetwuha63». Однако злоумышленники научились обходить эту защиту, создавая огромные списки возможных комбинаций и сравнивая их с утёкшими в сеть хешами. Согласно исследованию Hive Systems, такие нейросети, как ChatGPT-3, в сочетании с 10 000 видеокарт Nvidia A100 способны за короткое время подобрать 8-символьный пароль, состоящий из цифр, заглавных и строчных букв. Если же пароль ранее уже утёк в сеть, содержит словарные слова или повторяется на разных сайтах, взлом происходит ещё быстрее. Особую угрозу представляют мощные GPU-кластеры. Так, получив доступ, например, к 20 000 чипов Nvidia A100, хакеры могут взламывать даже длинные пароли. При этом исследователи подчёркивают, что речь идёт о случайно сгенерированных комбинациях, а простые пароли вроде «123456» или «qwerty» взламываются моментально. Вывод исследования очевиден: привычные способы защиты становятся неэффективными. Некоторые крупные компании, такие как Microsoft, уже переходят на passkey — более безопасную форму аутентификации без использования паролей. Она представляет собой защищённый цифровой ключ, хранящийся в специальном аппаратном или программном модуле непосредственно на устройстве пользователя, например, в Trusted Platform Module (TPM) или в облаке Microsoft с шифрованием. Тем не менее большинство пользователей всё ещё полагаются на устаревшую систему паролей. Пока же эксперты советуют использовать пароли длиной не менее 12 символов, включающие цифры, спецсимволы (например, «@» или «~») и буквы разного регистра. Также важно не применять один и тот же пароль на разных сайтах и, по возможности, активировать двухфакторную аутентификацию. Nvidia выпустила ещё одно экстренное обновление драйвера для устранения массы проблем у GeForce RTX 5000

29.04.2025 [14:09],

Дмитрий Федоров

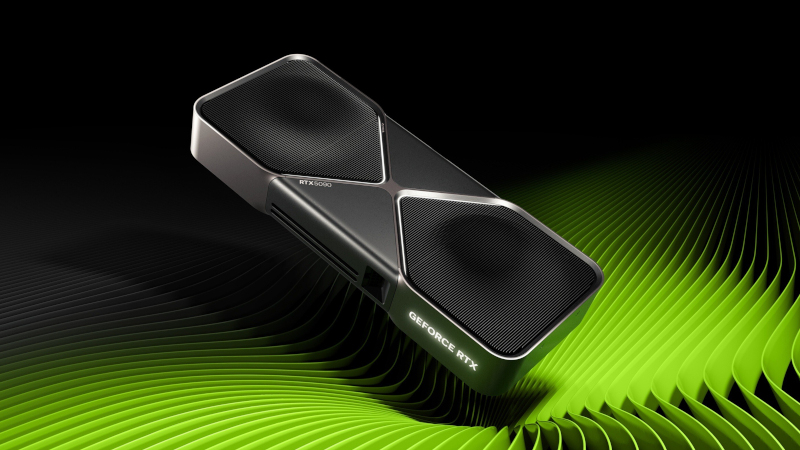

Текущее поколение графических карт Nvidia уже успело пройти через немало испытаний. Проблемы на старте продаж, запредельные цены, недовольство покупателей из-за недостаточного объёма видеопамяти — и это лишь малая часть трудностей. Более того, ситуацию усугубляли многочисленные проблемы с драйверами, включая проблемы с отображением температуры, нестабильную работу, появление чёрных экранов и ряд других сбоев.

Источник изображения: Nvidia Пользователи графических ускорителей (GPU) компании Nvidia стали свидетелями целой серии крупных обновлений драйверов, включая несколько экстренных исправлений, и сейчас Nvidia выпустила ещё одно — нацеленное в основном на решение проблем в линейке RTX 50-й серии. Теперь доступна для загрузки версия драйвера GeForce Hotfix Display Driver 576.26. Вот список исправлений, включённых в это обновление:

Кроме того, Nvidia сообщает, что драйвер версии 576.26 включает следующие семь исправлений из предыдущего экстренного обновления GeForce Hotfix 576.15:

Драйвер доступен для загрузки на официальном сайте по ссылке. Что касается других проблем, например нехватки видеопамяти, то ходят слухи, что грядущие модели Nvidia серии SUPER могут принести столь ожидаемое увеличение объёма памяти для нескольких графических карт этой линейки. Рынок видеокарт показал рост в прошлом квартале, но долгосрочный прогноз слабый

07.03.2025 [04:33],

Анжелла Марина

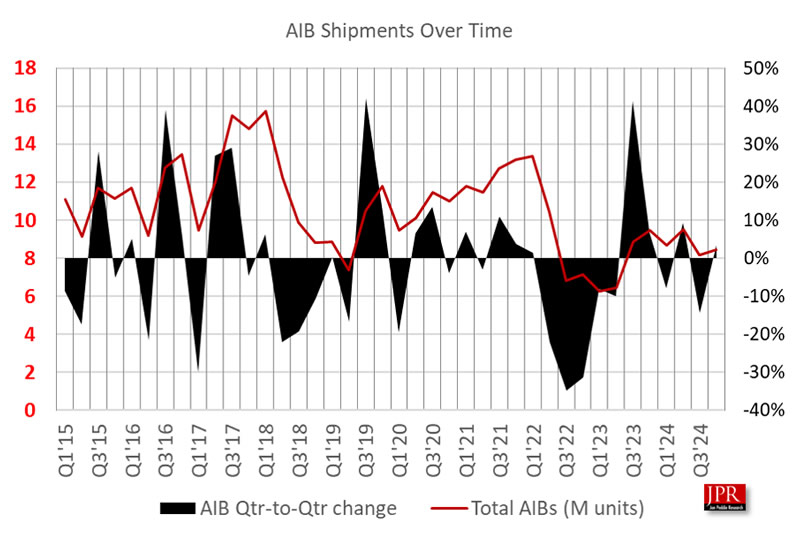

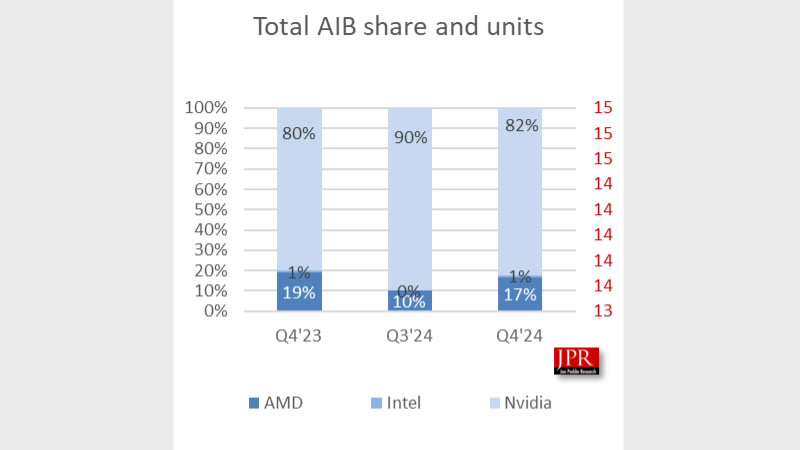

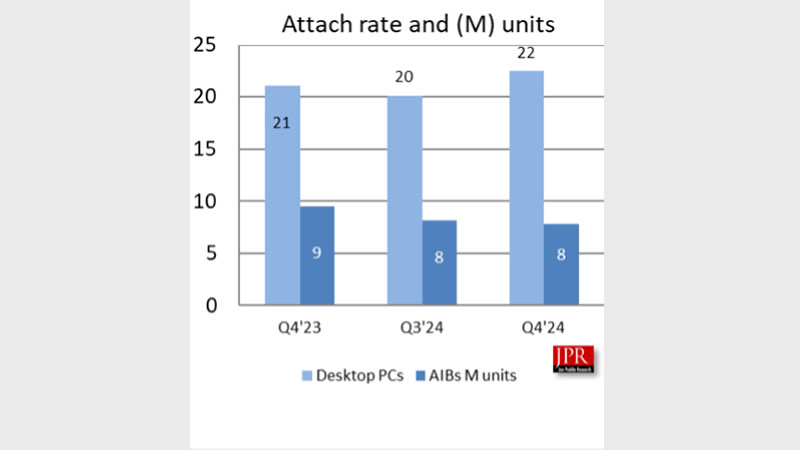

Согласно новому отчёту аналитической компании Jon Peddie Research, мировой рынок дискретных видеокарт для ПК в исполнении партнёров AIB продемонстрировал рост в четвёртом квартале 2024 года (Q4 2024). Объём поставок AIB достиг 8,4 миллиона единиц, а поставки процессоров для настольных ПК увеличились до 22,5 миллиона. Общий рост GPU поставок составил 6,2 %, превысив средний показатель за последние 10 лет.

Источник изображения: Nvidia Несмотря на квартальный рост, прогноз на ближайшие годы остаётся отрицательным. Ожидается, что совокупный темп падения рынка AIB составит 4,3 % в период с 2024 по 2028 годы. К концу прогнозируемого периода общий объём установленных видеокарт достигнет 119 миллионов единиц, а уровень использования дискретных графических ускорителей в настольных ПК составит 81 %.

Источник изображения: jonpeddie.com Анализ рыночных долей также показывает изменения в расстановке сил между основными игроками. Доля AMD увеличилась на 5 процентных пунктов по сравнению с предыдущим кварталом, Intel нарастила свою долю на 1,2 п.п., в то время как доля Nvidia снизилась на 6,3 п.п. Отмечается, что такая динамика может быть связана с рядом факторов, включая производственные ограничения и перераспределение ресурсов в пользу графических процессоров для задач искусственного интеллекта (ИИ).

Источник изображения: jonpeddie.com Из-за высокого спроса производители завершили последний квартал 2024 года с большим объёмом невыполненных заказов, что, по мнению аналитиков, приведёт к аномально высоким поставкам в первом квартале 2025 года. Однако во втором квартале ожидается спад, отчасти из-за введения новых тарифов. «Мы по-прежнему далеки от нормального сезонного цикла, а тарифы окажут дополнительное давление на рынок», — заявил президент Jon Peddie Research Джон Педди (Jon Peddie).

Источник изображения: jonpeddie.com Общий же индекс использования дискретных видеокарт в настольных ПК снизился до 138 %, что на 7 п.п. ниже, чем в предыдущем квартале. Рынок процессоров для настольных ПК сократился на 7,8 % в годовом исчислении, но вырос на 11,6 % по сравнению с предыдущим кварталом. Стоит сказать, что так как AMD и Nvidia планируют представить в первом квартале 2025 года (Q1 2025) новые модели видеокарт, это может в целом оказать положительное влияние на рынок, дополнительно его простимулировав. AMD обогнала Nvidia по плотности транзисторов — даже чип GeForce RTX 5090 проиграл

28.02.2025 [22:37],

Николай Хижняк

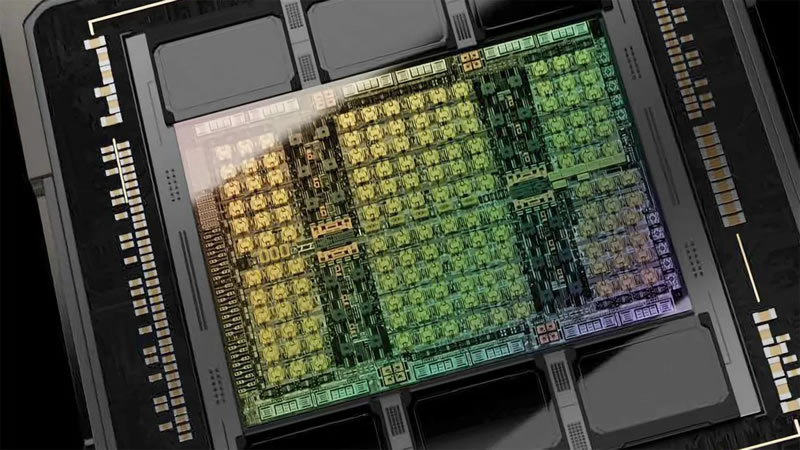

Компания AMD представила сегодня графическую архитектуру RDNA 4 и две видеокарты на её основе — Radeon RX 9070 XT и RX 9070. Обе новинки основаны на разных модификациях графического процессора Navi 48. В старшей модели используется Navi 48 XTX, а младшая получила Navi 48 XT. Как пишет портал Tom’s Hardware, эти чипы обладают одной из самых высоких плотностей транзисторов на квадратный миллиметр среди GPU.

Источник изображения: AMD Площадь чипа Navi 48 составляет 357 мм². Это меньше, чем у чипа GB203 (375 мм²), использующегося в составе видеокарт GeForce RTX 5080 и RTX 5070 Ti. Однако плотность транзисторов у нового GPU от AMD выше. В целом в составе Navi 48 содержится 53,9 млрд транзисторов, а у GB203 их 45,6 млрд. У Navi 48 плотность транзисторов составляет около 151 млн/мм², а у GB203 — 120,6 млн/мм². У чипа AMD этот показатель на 25 % выше, чем у конкурента. Более того, плотность транзисторов у Navi 48 выше, чем у графического процессора GB202 (123 млн/мм²), использующегося в основе флагманской видеокарты GeForce RTX 5090. Очевидно, что это не совсем корректное сравнение, поскольку та же RTX 5090 в любом случае окажется значительно быстрее представленных сегодня видеокарт Radeon. Тем не менее любопытно отметить, что Nvidia, похоже, не придавала столь большого приоритета плотности транзисторов при разработке Ada Lovelace, как AMD для своего графического процессора на RDNA 4. И, конечно, нужно учитывать, что количество транзисторов, как правило, считается приблизительным и существуют разные способы их подсчёта. AMD решила отказаться в новом поколении графической архитектуры от чиплетного дизайна, который применялся для GPU на архитектуре RDNA 3, и вернулась обратно к монолитному. Это означает, что вся кеш-память, которая ранее располагалась на отдельных чиплетах графического процессора, теперь содержится в составе одного кристалла вместе с графическими ядрами. И хотя плотность транзисторов у того же Navi 31 (с чиплетным дизайном) тоже составляла порядка 150 млн/мм², этот показатель рассчитывался без учёта совместного использования пространства с кеш-памятью на том же кристалле. AMD следует отдать должное хотя бы за то, что ей удалось вернуться к монолитному дизайну GPU, сохранить прежний уровень плотности транзисторов, а также встроить 64 Мбайт Infinity Cache, не жертвуя при этом эффективностью. Imagination представила графический процессор DXTP, который хорош и в графике, и в ИИ-вычислениях

25.02.2025 [16:43],

Павел Котов

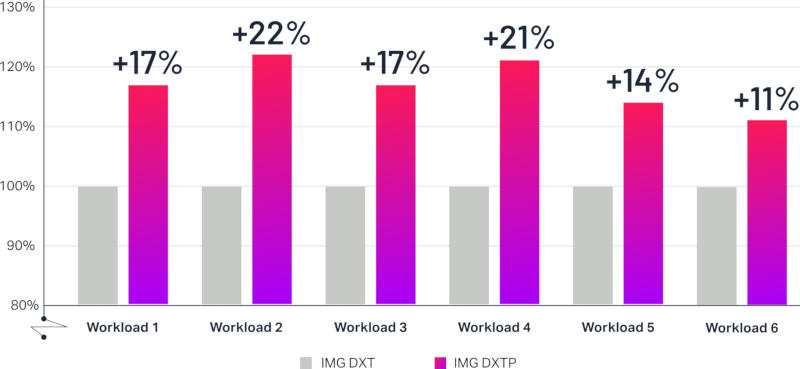

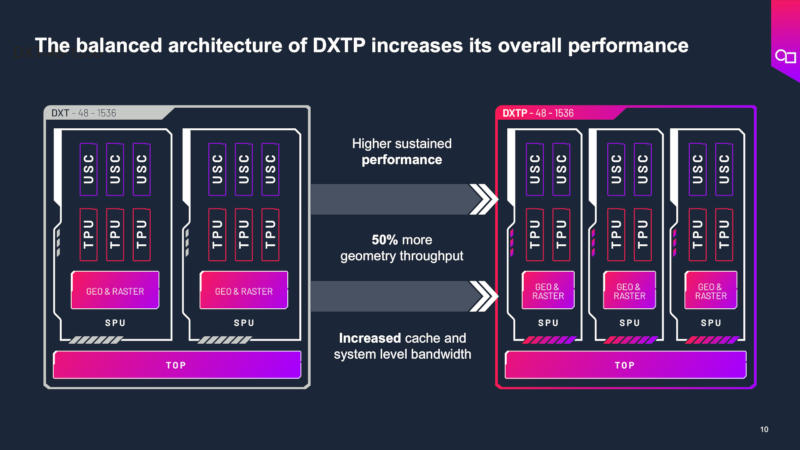

Компания Imagination Technologies представила графический процессор DXTP, предназначенный как для обработки графики, так и для вычислений общего назначения на смартфонах и других устройствах с ограниченным ресурсом питания.

Источник изображений: imaginationtech.com Благодаря ряду нововведений на уровне микроархитектуры Imagination DXTP предлагает в среднем 20-процентный прирост энергоэффективности — количества кадров в секунду на ватт — в наиболее распространённых нагрузках по сравнению с актуальными графическими процессорами DXT.  Проекты Imagination востребованы, как указывает сам разработчик, на рынках от мобильных устройств до беспилотных автомобилей. В минувшем году компания освоила технологию аппаратного ускорения трассировки лучей, которая ещё недавно была прерогативой передовых видеокарт для ПК и игровых консолей, но в последние годы всё активнее проникает в мобильные чипы. Вычислительный движок DXTP доступен в двух конфигурациях: для мобильных устройств и автомобилей. Он поддерживает отрисовку до 64 гигапикселей в секунду, производительность составляет 2 Тфлопс в вычислениях FP32 и 8 TOPS в INT8 при тактовой частоте 1 ГГц. Архитектура DXTP также отличается высокой гибкостью — благодаря аппаратной технологии виртуализации многозадачный графический процессор может одновременно обрабатывать графику и выполнять вычисления общего назначения.  Imagination DXTP предлагает экосистему программного обеспечения, включая SDK и все необходимые инструменты. Доступны высокооптимизированные библиотеки вычислений OpenCL, которые позволяют использовать графический процессор в задачах, связанных с искусственным интеллектом, а также типовые решения для oneAPI и TensorGraph, упрощающие перенос существующего кода на архитектуру Imagination. Графические процессоры Imagination поддерживают среду LiteRT, что обеспечивает выполнение высокопроизводительных задач ИИ под Android. Для разработчиков приложений доступны инструменты PowerVR для анализа производительности на низком уровне, отладки, записи трассировки лучей; также можно задать вопросы на форуме разработчиков Imagination. Добавим, что в 2019 году лондонская Imagination анонсировала серию графики AXT, в 2020 и 2021 годах последовали соответственно BXT и CXT, а в 2023 году вышла IMG DTX. Графические процессоры Imagination появляются на рынке в составе различных однокристальных платформ примерно спустя 18 месяцев с момента анонса. У GeForce RTX 5080 тоже обнаружились бракованные чипы с недостачей блоков ROP

24.02.2025 [10:27],

Николай Хижняк

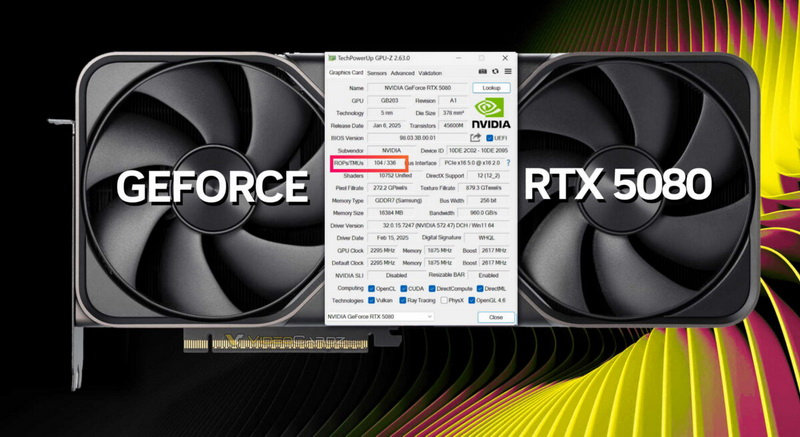

На днях Nvidia подтвердила, что некоторые видеокарты GeForce RTX 5090/RTX 5090D и RTX 5070 Ti получили дефектные графические процессоры, у которых недостаёт блоков растеризации (ROP). Компания заявила, что лишь 0,5 % видеокарт получили дефектные GPU. Как выяснилось, проблема затронула и модели RTX 5080.

Источник изображения: VideoCardz На форуме Reddit один из пользователей поделился скриншотом утилиты GPU-Z с данными своей видеокарты RTX 5080, у которой не хватает восьми блоков растеризации. Вместо положенных 112 ROP программа показывает, что у GPU имеется только 104 блока растеризации. По словам пользователя, дефектной оказалась эталонная версия RTX 5080 Founders Edition. Любопытно, что у всех бракованных GeForce RTX 5090/RTX 5090D и RTX 5070 Ti также не хватает именно восьми блоков ROP. У GeForce RTX 5090(D) их 168 вместо положенных 176, а у GeForce RTX 5070 Ti — 88 вместо необходимых 96. Как уже отмечалось, нехватка блоков растеризации напрямую влияет на производительность видеокарт в играх и синтетических бенчмарках. У GeForce RTX 5090/RTX 5090D дефицит ROP приводит к снижению быстродействия на 5–8 %, а у RTX 5070 Ti в синтетических тестах производительность падает до 11 % (игровые тесты пока не проводились). Насколько сильно упала производительность у дефектной RTX 5080 из-за недостатка блоков ROP, пока неизвестно. Следует добавить, что отсутствие 8 блоков ROP у RTX 5080 подтвердилось при валидации данных в GPU-Z. Владелец карты также переустановил графический драйвер, чтобы убедиться в том, что проблема не программная. Nvidia признала «редкую проблему» недостачи вычислительных блоков у GeForce RTX 5090 и RTX 5070 Ti

22.02.2025 [09:48],

Николай Хижняк

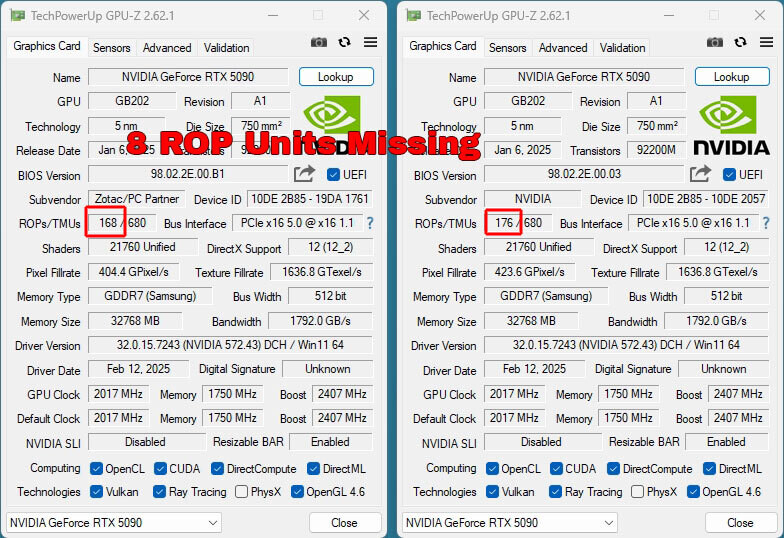

Компания Nvidia признала, что некоторые видеокарты GeForce RTX 5090/RTX 5090D, уже поставленные на рынок, оказались оснащены дефектными графическими процессорами GB202, у которых не хватает 8 блоков растеризации (ROP). Компания также сообщила, что проблема затронула и модели RTX 5070 Ti.

Источник изображений: TechPowerUp Ранее сообщалось, что некоторые владельцы видеокарт GeForce RTX 5090/RTX 5090D от Zotac, MSI, Gigabyte и Manli пожаловались на то, что в графических процессорах их ускорителей не хватает блоков растеризации. Вместо положенных 176 ROP их карты имеют только 168 этих блоков. Поскольку ROP являются одними из ключевых компонентов видеокарты, их отсутствие негативно сказывается на производительности GPU. Тесты портала TechPowerUp показали, что Zotac GeForce RTX 5090 Solid с недостачей ROP уступает по игровой производительности даже эталонной RTX 5090 Founders Edition. Нехватка блоков ROP не связана с какой-то проблемой в работе BIOS видеокарт — речь идёт об аппаратном дефекте GPU.  Комментарий Nvidia по поводу ситуации с дефектными GeForce RTX 5090/RTX 5090D и RTX 5070 Ti получил популярный видеоблогер JayzTwoCents: «Мы обнаружили редкую проблему, что менее 0,5 % выпущенных видеокарт GeForce RTX 5090/RTX 5090D и RTX 5070 Ti имеют меньше блоков ROP, чем заявлено в спецификациях этих моделей видеокарт. Средний уровень потери [игровой] производительности от нехватки этих блоков ROP составляет 4 %. Нехватка блоков ROP не влияет на ИИ-производительность и вычислительные возможности видеокарт. Владельцы видеокарт, столкнувшиеся с этой проблемой, должны обратиться к производителю видеокарты для замены. Производственная аномалия была устранена», — цитирует слова представителя Nvidia блогер JayzTwoCents. Компания не пояснила, о каком количестве недостающих ROP идёт речь в случае с моделями RTX 5070 Ti. Напомним, что в составе графического чипа GB203-300, служащего основой для RTX 5070 Ti, имеется 96 блоков ROP. Южная Корея закупит 10 000 ИИ-ускорителей, чтобы не отставать от остального мира

17.02.2025 [12:31],

Алексей Разин

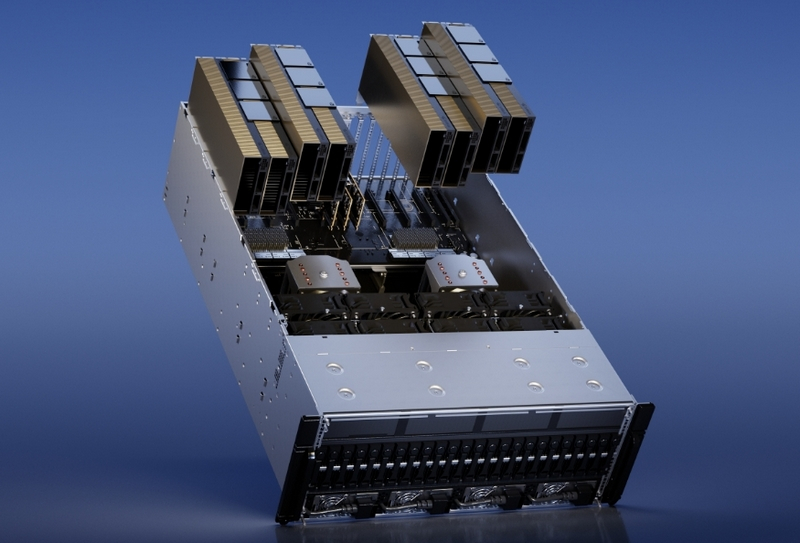

Одним из главных событий в начале второго президентского срока Дональда Трампа (Donald Trump) стал анонс проекта Stargate, который подразумевает рекордные финансовые вливания в создание на территории США мощнейшей вычислительной инфраструктуры для ИИ. Южная Корея старается не отставать от заокеанского партнёра, а потому готова закупить 10 000 ускорителей вычислений в этом году.

Источник изображения: Nvidia Об этом сообщает агентство Reuters со ссылкой на заявления южнокорейского президента Чхве Сан Мока (Choi Sang-mok): «Поскольку конкуренция за доминирование в отрасли ИИ усиливается, конкурентный ландшафт смещается от противостояний между компаниями к полномасштабному соперничеству между национальными экосистемами инноваций». По словам президента Южной Кореи, власти страны намереваются закупить к сентябрю этого года 10 000 GPU для использования в составе национального вычислительного центра, который будет работать над решением проблем в сфере искусственного интеллекта. Закупка ускорителей будет осуществляться в рамках частно-государственного партнёрства, но кто будет поставщиком этих GPU, не уточняется. Скорее всего, речь идёт о продукции Nvidia, ведь именно она контролирует не менее 80 % рынка данных изделий. Тем более, что Южной Корее посчастливилось оказаться в числе тех 18 стран, которые могут получать из США передовые ускорители вычислений для собственных нужд практически без ограничений. Подробные условия этой закупки будут определены к сентябрю текущего года. Высокий спрос на подобные ускорители заставляет рынок стремительно меняться. На прошлой неделе, например, стало известно о намерениях OpenAI завершить разработку собственного ИИ-чипа через несколько месяцев. Выпускать его по 3-нм технологии со следующего года может начать тайваньская компания TSMC. По меньшей мере, в рамках того же американского проекта Stargate такие ускорители OpenAI точно пригодятся. Moore Threads выпустила профессиональную видеокарту MTT X300 на мощном китайском GPU

30.12.2024 [15:21],

Анжелла Марина

Китайский производитель графических процессоров Moore Threads представил профессиональную видеокарту MTT X300, ориентированную на задачи визуализации, такие как CAD, BIM, GIS и редактирование видео. В основе новинки лежит графический процессор X300 с архитектурой MUSA второго поколения, включающий 4096 ядер MUSA и обеспечивающий вычислительную мощность 14,4 Тфлопс в FP32.

Источник изображения: Moore Threads / @Olrak29_ on X MTT X300 использует интерфейс PCIe 5.0 x16 и предлагает достаточно разнообразные возможности подключения дисплеев: имеется три порта DisplayPort 1.4a и один HDMI 2.1, поддерживающие разрешение до 7680 × 4320 пикселей. Новинка обладает энергопотреблением (TGP) 255 Вт. При этом, как отмечает издание TechPowerUp, несмотря на позиционирование X300 в качестве новой модели, эта видеокарта, по сути, является аналогом игровой видеокарты Moore Threads MTT S80, но с изменённой прошивкой и иным набором драйверов. Видеокарта оснащена 16 Гбайт памяти GDDR6 с 256-битной шиной, обеспечивая пропускную способность памяти 448 Гбайт/с, поддерживает аппаратное ускорение декодирования для различных кодеков, включая AV1, H.264, H.265, VP8, VP9, AVS, AVS2, MPEG4 и MPEG2, а также аппаратное кодирование для AV1, H.264 и H.265. Учитывая профессиональное применение, X300 может одновременно обрабатывать до 36 потоков видео при разрешении 1080p и 30 кадрах в секунду (FPS) для операций кодирования и декодирования, а также поддерживает вывод изображения на четыре дисплея с разрешением до 8K. Примечательно, что Moore Threads разработала драйверы для всех основных архитектур, включая x86, Arm и даже LoongArch, стремясь сделать свой продукт универсальным решением для различных профессиональных задач и охватить максимально широкий спектр платформ. Хотя конкретная цена и дата начала продаж MTT X300 ещё не объявлена, её характеристики и возможности указывают на то, что она вполне может стать конкурентоспособным решением для профессионалов, работающих с графикой и видео. Продажи «урезанных» ИИ-ускорителей Nvidia в Китае растут бешеным темпом

29.12.2024 [21:34],

Анжелла Марина

После усиления санкций США компания Nvidia продолжает поставлять в Китай флагманские GPU, но в несколько урезанном виде. Спрос на созданный для Китая ускоритель вычислений HGX H20, возможности которого адаптированы в соответствии с санкционными требованиями США, ежеквартально увеличивается на 50 %, сообщает Tom's Hardware. Ускоритель HGX H20 стал в Китае настоящим хитом.

Источник изображения: Nvidia В контексте глобального спроса на технологии искусственного интеллекта, Nvidia в последние два года испытывает большой интерес к своей продукции, особенно в США, странах Ближнего Востока и Китае. Однако из-за экспортных ограничений компания не может продавать в Китай свои самые мощные ускорители, такие как Hopper H100 и даже адаптированный прежде для Китая H800, без специальной лицензии. В ответ на эти ограничения Nvidia предложила урезанную версию — HGX H20, которая, несмотря на более скромные характеристики, быстро завоёвывает китайский рынок систем искусственного интеллекта. «Модифицированная система H20, полностью соответствующая правилам экспортного контроля для Китая, показывает невероятные результаты по продажам, подчёркивая, насколько важен для Nvidia китайский рынок, даже с учётом необходимости адаптировать продукцию под действующие ограничения», — пишет в X аналитик в сфере полупроводникового бизнеса Клаус Ошхолм (Claus Aasholm). Развитие искусственного интеллекта в мире стимулирует спрос на все типы оборудования для дата-центров, включая GPU от Nvidia. Ведущие экономики мира, США и Китай, находятся в состоянии гонки за превосходство в области ИИ, и в то время, как США используют свои ресурсы для наращивания ИИ-возможностей, Китай, несмотря на ограничения, продолжает активно развивать собственные аппаратные и программные ИИ-решения. Это подтверждается недавним достижением китайской компании Deepseek, которая успешно обучила свою языковую модель на GPU от Nvidia. В перспективе китайские компании, такие как Biren Technologies и Moore Threads, могут составить конкуренцию Nvidia на внутреннем рынке. Однако аналитики отмечают, что это не произойдёт в ближайшее время, и Nvidia продолжит доминировать в китайских дата-центрах, даже несмотря на урезанные версии своих GPU. У Nvidia нашлась ахиллесова пята — треть выручки зависит от настроения трёх клиентов

22.11.2024 [23:17],

Андрей Созинов

Компания Nvidia сильно зависит от горстки крупнейших заказчиков, которые активно покупают ускорители вычислений для задач ИИ и в совокупности приносят компании более трети дохода. Это ставит Nvidia в уязвимое положение, хотя в ближайшее время компании и её инвесторам вряд ли стоит беспокоиться — спрос на ИИ-ускорители только растёт.

Источник изображений: Nvidia В квартальном отчёте по форме 10-Q, который компании подают в Комиссию по ценным бумагам и биржам США, Nvidia в очередной раз заявила, что у неё есть ключевые клиенты, которые настолько важны, что заказы каждого из них формируют более 10 % от глобальной выручки Nvidia. При этом компания не раскрывает имена этих клиентов, что логично, поскольку вряд ли бы они хотели, чтобы их инвесторы, сотрудники, критики, активисты и конкуренты узнали, сколько именно денег они тратят на чипы Nvidia. В отчёте за второй квартал Nvidia указала четырёх крупнейших клиентов, а в последнем квартале упоминается три таких «кита», поскольку один из них сократил закупки. Хотя доподлинно неизвестно, что это за клиенты, Мандип Сингх (Mandeep Singh), руководитель глобального отдела технологических исследований Bloomberg Intelligence, считает, что речь идёт о Microsoft, Meta✴✴ и, возможно, Super Micro.  Сама Nvidia называет их просто «клиент A», «клиент B» и «клиент C». Сообща они приобрели товаров и услуг на общую сумму 12,6 миллиарда долларов в третьем финансовом квартале, завершившемся в конце октября. Это более трети от общей выручки Nvidia, которая составила 35,1 миллиарда долларов. Также отмечается, что каждый из «китов» приобрёл товаров и услуг Nvidia на сумму от 10 до 11 миллиардов долларов за первые девять месяцев текущего финансового года. Примечательно, что вклад «китов» в выручку оказался равнозначным: на каждого пришлось по 12 %, что говорит о том, что они, скорее всего, закупили максимальное количество выделенных им чипов, но не столько, сколько им хотелось бы в идеале. Это согласуется с комментариями генерального директора Дженсена Хуанга (Jensen Huang) о том, что Nvidia ограничена в поставках. Компания не может просто производить больше чипов, поскольку она сама их не выпускает, а заказывает производство у TSMC, мощности которой расписаны на годы вперёд. Поскольку имена крупнейших покупателей чипов Nvidia засекречены, трудно сказать, являются ли они «посредниками», как Super Micro Computer, которая выпускает серверы для центров обработки данных, или конечными пользователями, как Microsoft, Meta✴✴ или xAI Илона Маска (Elon Musk). Последняя, например, практически из ниоткуда построила мощнейший ИИ-суперкомпьютер всего за три месяца.  Тем не менее полагаться на горстку крупных клиентов весьма рискованно — если кто-то из них, а ещё хуже, все разом, перестанут закупать ИИ-чипы, у Nvidia резко упадёт выручка. К счастью для инвесторов Nvidia, в ближайшее время такое маловероятно. Аналитик Bloomberg Intelligence Мандип Сингх видит лишь несколько долгосрочных рисков для Nvidia. Во-первых, некоторые крупные клиенты, вероятно, со временем сократят заказы в пользу собственных чипов, что приведёт к уменьшению доли компании на рынке. Одним из таких клиентов является Alphabet, у которой есть собственные ИИ-чипы семейства TPU. Во-вторых, Nvidia доминирует в области ускорителей для обучения ИИ, но не может похвастаться тем же в сфере чипов для инференса — запуска уже обученных нейросетей. Для инференса не требуются столь мощные чипы, что означает для Nvidia гораздо большую конкуренцию не только со стороны AMD и других прямых соперников, но и со стороны компаний с собственными чипами, таких как Tesla.  В конечном счёте запуск обученных нейросетей станет гораздо более значимым бизнесом, поскольку всё больше предприятий будут использовать ИИ, считает аналитик. «Многие компании пытаются сфокусироваться на возможностях инференса, потому что для этого не нужен самый мощный GPU-ускоритель», — заявил Сингх. Он также отметил, что в долгосрочной перспективе переход на чипы для инференса является «безусловно» большим риском для Nvidia, чем потеря доли рынка чипов для обучения ИИ. И тем не менее Сингх отмечает, что верит прогнозу Дженсена Хуанга о том, что расходы крупнейших клиентов на ИИ-чипы не прекратятся. Даже если доля Nvidia на рынке ИИ-чипов сократится с нынешних 90 %, компания всё равно сможет ежегодно зарабатывать на этом сотни миллиардов долларов. Gigabyte представила видеокарту для рабочих станций Radeon Pro W7800 AI TOP с 48 Гбайт памяти GDDR6

15.11.2024 [14:29],

Николай Хижняк

Компания Gigabyte анонсировала видеокарту Radeon Pro W7800 AI TOP для рабочих станций. Отличительная особенность новой модели от ранее выпущенной Radeon Pro W7800 заключается в объёме доступной видеопамяти. Новая модель получила 48 Гбайт GDDR6, оригинальная же Pro W7800, выпущенная AMD в прошлом году, выпускается с 32 Гбайт памяти.

Источник изображений: Gigabyte В основе Gigabyte Radeon Pro W7800 AI TOP используется всё тот же графический чип Navi 31 на архитектуре RDNA 3 с 4480 потоковыми процессорами. Разрядность шины памяти новой модели составляет 384 бит, т.е. как у Pro W7900, которая также имеет на борту 48 Гбайт GDDR6. Пропускная способность памяти Radeon Pro W7800 AI TOP составляет 864 Гбайт/с. Gigabyte Radeon Pro W7800 AI TOP занимает два слота расширения. Она оснащена системой охлаждения в состав которой входит центробежный вентилятор. Длина видеокарты — 29,3 см. Gigabyte отмечает, что Pro W7800 с 48 Гбайт памяти имеет увеличенный показатель энергопотребления, составляющий 281 Вт. Это на 21 Вт больше, чем у версии с 32 Гбайт памяти и на 14 Вт меньше, чем у старшей модели Pro W7900. Для дополнительного питания новинка использует два 8-контактных разъёма. Аналогично предыдущим моделям ускорителей серии Pro W7000 карта получила три порта DisplayPort 2.1 и один mini-DisplayPort 2.1. Предполагается, что AMD официально представит Radeon Pro W7800 с 48 Гбайт памяти в ближайшее время. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |