|

Опрос

|

реклама

Быстрый переход

Мировые продажи GPU достигнут $100 млрд в этом году — львиную долю принесут чипы, не связанные с графикой

13.11.2024 [17:25],

Владимир Мироненко

Согласно прогнозу аналитиков Jon Peddie Research, глобальный рынок графических процессоров превысит $98,5 млрд по итогам 2024 года, пишет ресурс Tom's Hardware.

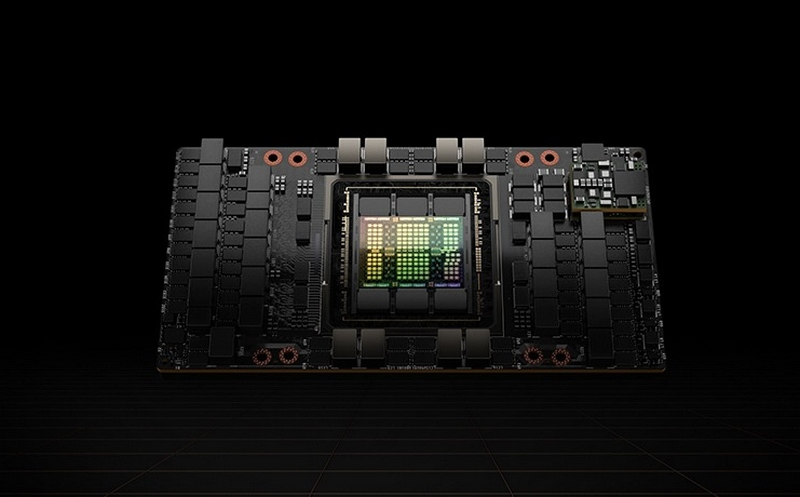

Источник изображения: Nvidia По данным JPR, на рынке сейчас присутствует семь разработчиков архитектур GPU, а также 20 компаний, занятых созданием дискретных, интегрированных и встраиваемых графических процессоров. Большинство этих решений представляют собой интегрированные GPU начального уровня, и лишь несколько компаний разрабатывают дискретные GPU для игровых видеокарт и ускорителей вычислений. Большую часть дохода на мировом рынке GPU приносят решения, которые не используются для обработки графики: в количественном выражении продажи GPU для задач ИИ и высокопроизводительных вычислений (HPC) составляют всего несколько миллионов единиц в год, но поскольку их цена составляет десятки тысяч долларов за единицу, реализация таких продуктов приносит Nvidia десятки миллиардов долларов, а AMD — миллиарды.

Источник изображения: AMD Всего за два квартала текущего финансового года доход Nvidia от поставок GPU для ИИ и HPC составил $42 млрд, а за весь год эти цифры могут увеличиться до $90 млрд. AMD ожидает, что выручка от продажи её ИИ-ускорителей превысит $3 млрд. Если говорить о других участниках рынка, как, например, Biren или MetaX, то они пока значительно отстают по доходам от лидеров. «GPU стали повсеместными и их можно найти практически в каждом промышленном, научном, коммерческом и потребительском продукте, производимом сегодня, — сообщил доктор Джон Педди (Jon Peddie), президент Jon Peddie Research. — Некоторые сегменты рынка, такие как ИИ, попали в заголовки из-за своего быстрого роста и высокой средней цены продажи (ASP), но они имеют небольшой объём по сравнению с другими сегментами рынка». Tom's Hardware отметил, что хотя рынок GPU для ИИ имеет небольшой объём по сравнению с другими сегментами, все новички на рынке графических процессоров — особенно из Китая — сосредоточены на решениях для ЦОД, а не для игр. Конечно, эти компании сталкиваются с ограничениями со стороны правительства США, стремящегося перекрыть Китаю доступ к передовым технологиям ИИ, но, по-видимому, они готовы пойти на риск, поскольку потенциал рынка ИИ очень высок. Дорогущие ИИ-чипы страдают от быстрого износа — GPU от AMD и Nvidia выдерживают всего 1–3 года

31.10.2024 [12:57],

Алексей Разин

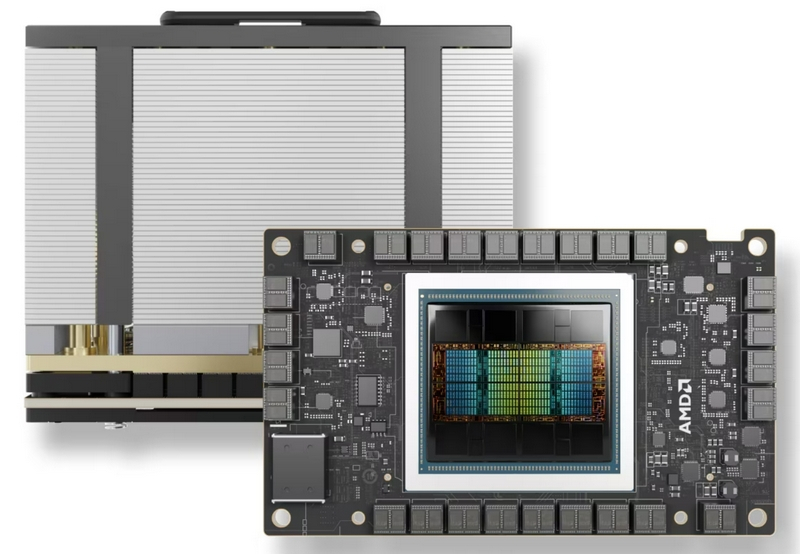

Пока стремящиеся активно развивать сферу искусственного интеллекта разработчики озабочены преимущественно нехваткой компонентов, некоторые из них высказываются на тему ограниченности эксплуатационного ресурса тех самых дорогих и дефицитных чипов. По расчётам специалистов Alphabet, серверные GPU при уровне загрузки 70 % живут от одного до двух лет, в крайнем случае — три.

Источник изображения: Nvidia На это мнение ссылается Tech Fund, поясняя, что высказывание принадлежит некоему высокопоставленному разработчику систем генеративного искусственного интеллекта Alphabet, который знаком с их спецификой эксплуатации. Даже если подходить к анализу проблемы с обывательской точки зрения, логика в таких заявлениях есть. Выделяя до 700 Вт, графические процессоры Nvidia, AMD и любого другого производителя для современных ускорителей вычислений имеют довольно скромную площадь кристалла, поэтому постоянное воздействие высоких температур способно достаточно быстро приводить к их физическому износу. Продлить срок службы ускорителей вычислений можно, снизив их степень загрузки от типичных 60 или 70 %, но подобные меры натыкаются на экономические соображения разработчиков систем искусственного интеллекта. Недешёвые ускорители в условиях бурного развития отрасли должны максимально быстро приносить финансовую отдачу, а если недогружать их работой, то период амортизации затянется, а это уже не понравится инвесторам. Израильские специалисты недавно предположили, что к концу десятилетия отрасль ИИ будет ежегодно генерировать до 5 млн тонн электронных отходов. Не все из них могут быть переработаны для повторного использования, поэтому проблема воздействия отрасли искусственного интеллекта на окружающую среду становится острее. Соответственно, быстрая выработка ресурса серверных GPU тоже усугубит ситуацию с утилизацией отходов. Рынок видеокарт растёт, но без Intel — компанию полностью вытеснили AMD и Nvidia

25.09.2024 [20:12],

Анжелла Марина

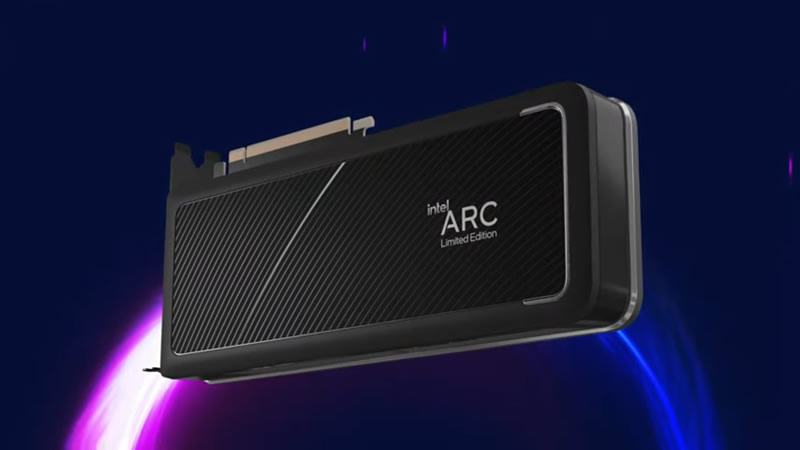

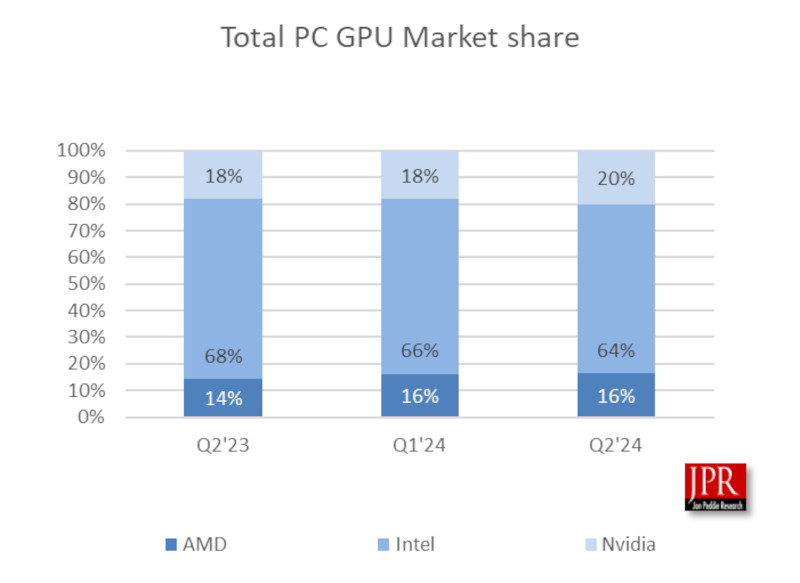

Intel полностью лишилась своих позиций на рынке дискретных видеокарт, уступив свою долю Nvidia и AMD. Несмотря на общий рост рынка, продажи видеокарт Arc Alchemist оказались настолько низкими, что компания не попала в мировую отчётную статистику Jon Peddie Research.

Источник изображения: Intel По данным JPR, продажи дискретных настольных GPU значительно выросли во втором квартале 2024 года у всех основных производителей, кроме Intel, продажи которой остались на уровне прошлого квартала. Правда, после выхода на рынок дискретных видеокарт с серией Arc Alchemist в 2022 году, компания ненадолго достигла 4-% доли рынка к концу того же года, но к началу 2024 года полностью потеряла свою долю.

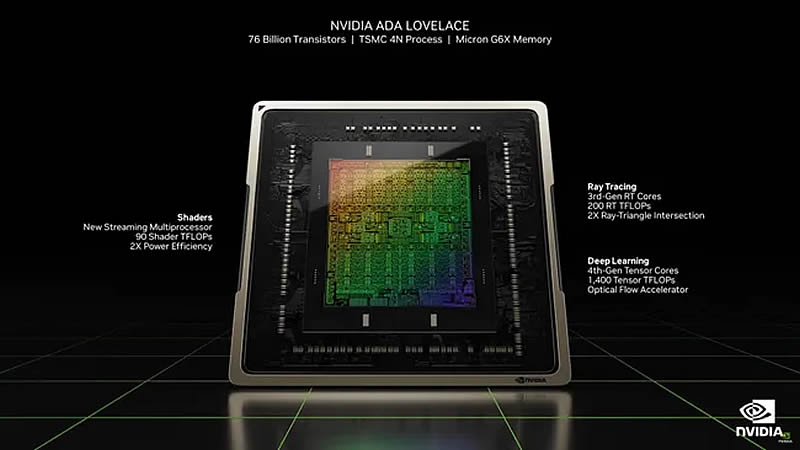

Источник изображения: techspot.com Глобальные поставки видеокарт достигли приблизительно 9,5 млн единиц, что на 9,4 % больше, чем в первом квартале 2024 года, и на 48 % больше, чем во втором квартале 2023 года. При этом король рынка Nvidia выиграл больше всех, показав квартальный рост на 9,7 % и годовой рост на 61,9 %. Что касается AMD, то её поставки хоть и увеличились всего на три процента в годовом исчислении, однако квартальный результат сравним с Nvidia. Team Red также сохранила свою 12-процентную долю рынка с первого квартала. Между тем, процессоры Intel Arc (кодовое название Alchemist) должны были стать альтернативой конкурирующим видеокартам среднего уровня. Однако задержки поставок привели к тому, что компания отстала по соотношению цены и производительности от чипов Nvidia Ampere, Ada Lovelace и AMD RDNA 3. Все три производителя GPU для дискретных видеокарт готовят новые поколения графических процессоров. Ожидается, что архитектура Blackwell от Nvidia, которая, скорее всего, будет называться RTX 5000, дебютирует на выставке CES в январе 2025 года и, вероятно, будет стоить не менее $1000. AMD может представить RDNA 4 (Radeon RX 8000) примерно в то же время, сосредоточив внимание на компонентах, которые могут значительно улучшить графические процессоры среднего уровня. Несмотря на проблемы с Alchemist, Intel, похоже, не отказывается от своих планов в отношении видеокарт Arc Battlemage. Последние новости указывают на то, что компания по-прежнему нацелена на поставки к концу 2024 года. Пока неясно, попытается ли Intel потягаться с Nvidia в сегменте high-end, где у последней сейчас нет конкурентов, или же выпустит ещё одну серию видеокарт среднего уровня. По мнению экспертов, если Intel удастся избежать задержек, которые были с Alchemist, её новые чипы могут стать одними из лучших на рынке, пусть даже и ненадолго. GPU ограничивают свободу программирования, поэтому в сфере ИИ появятся и другие чипы — Лиза Су

23.09.2024 [11:48],

Алексей Разин

Графические процессоры, первоначально созданные для построения трёхмерных изображений, неплохо проявили себя в сфере ускорения параллельных вычислений. В эпоху бурного развития систем искусственного интеллекта они оказались очень востребованы. Глава AMD Лиза Су (Lisa Su) ожидает, что лет через пять ситуация начнёт меняться, и достойное применение в сфере ИИ найдут не только GPU.

Источник изображения: AMD Своими соображениями она поделилась с изданием The Wall Street Journal. «Сейчас GPU являются архитектурой выбора для больших языковых моделей, поскольку они весьма эффективны в параллельных вычислениях, но при этом они дают лишь ограниченную свободу программирования. Верю ли я, что они останутся предпочтительной архитектурой через пять с лишним лет? Думаю, что всё изменится», — заявила генеральный директор AMD. По её мнению, лет через пять от GPU никто отказываться не будет, но растущую популярность обретут компоненты для систем ИИ другого рода. Более узконаправленные чипы окажутся меньше, дешевле и продемонстрируют более высокую энергетическую эффективность. Примеры подобных чипов существуют уже сейчас. Облачные гиганты типа AWS (Amazon) и Google разрабатывают их для собственных нужд, используя в типовых сферах применения. GPU остаются более универсальными вычислительными средствами, но оптимизировать их энергопотребление и снизить себестоимость из-за постоянной необходимости увеличения производительности проблематично. Broadcom уже помогает Google создавать специализированные чипы, и таких примеров будет становиться только больше. Для разработчиков профильных ускорителей важно чувствовать конъюнктуру рынка и находить нужный баланс между гибкостью программирования и эффективностью работы чипов, а также обеспечивать совместимость с используемой программной экосистемой. Если специализация чипов станет узконаправленной преждевременно, это может принести разработчику большие убытки. Лиза Су добавила, что для вычислений нет универсальных решений, которые подошли бы всем. По её словам, с GPU в будущем станут соседствовать и другие архитектуры, всё просто будет зависеть от эволюции моделей. GeForce RTX 4070 с памятью GDDR6 продаётся в Европе дороже версии с GDDR6X

15.09.2024 [21:05],

Анжелла Марина

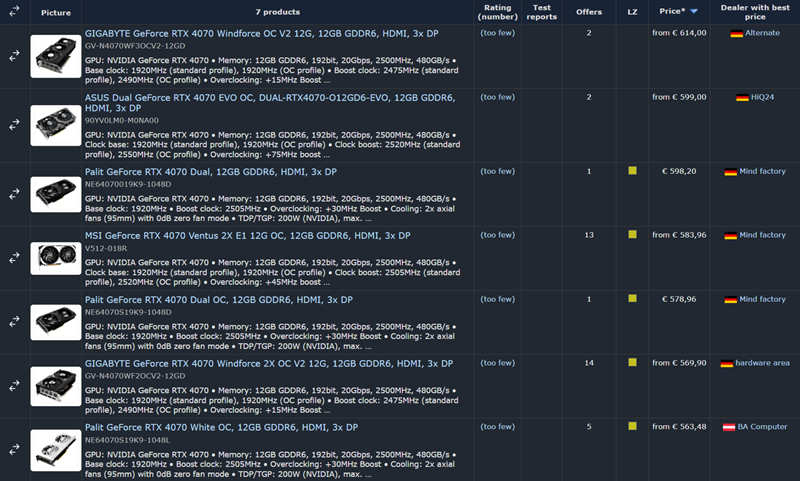

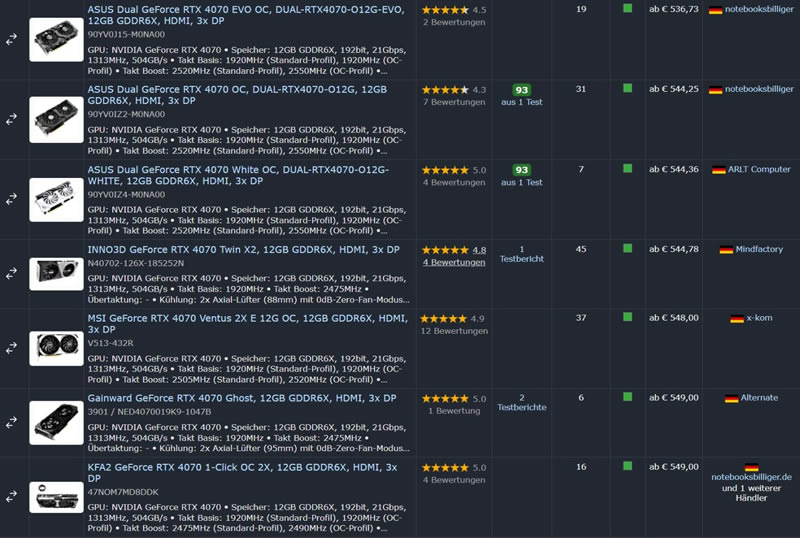

Nvidia в прошлом месяце представила видеокарту GeForce RTX 4070 с памятью GDDR6 вместо GDDR6X. Многие думали, что новинка будет слегка дешевле оригинальной модели. Но старт продаж показал ровно противоположную картину — вопреки ожиданиям GeForce RTX 4070 GDDR6 продаётся по более высокой цене, чем версия с GDDR6X, по крайней мере, в некоторых европейских странах.

Источник изображения: Wccftech.com На данный момент самый дешёвый вариант RTX 4070 GDDR6 — Palit GeForce RTX 4070 White OC 12 Гбайт — продаётся в австрийском магазине BA-Computer за €562. Другие версии от Gigabyte, MSI и ASUS предлагаются по цене от €569 до €614. Самая дорогая Gigabyte GeForce RTX 4070 Windforce OC V2 12 Гбайт GDDR6 с тремя вентиляторами обойдётся в €614. В то же время, оригинальную RTX 4070 GDDR6X можно найти по цене от €536 (Asus Dual GeForce RTX 4070 EVO OC), а многие другие модели с GDDR6X продаются дешевле €560, что делает их явно привлекательнее новинки.

Источник изображения: Geizhals.de Отметим, что согласно первым тестам разница в производительности между двумя версиями RTX 4070 незначительна в разрешениях 1080p и 1440p, а при разрешении 4K оригинальная GeForce RTX 4070 GDDR6X оказывается быстрее примерно на 2 %, что обусловлено более высокой пропускной способностью оперативной памяти — 21 Гбит/с против 20 Гбит/с у GDDR6.

Источник изображения: Geizhals.de Вполне возможно, что в ближайшее время цены на RTX 4070 GDDR6 снизятся и сравняются с RTX 4070 GDDR6X. Однако на данный момент покупка новой версии, как пишет Wccftech, не имеет смысла, так как за те же или даже меньшие деньги можно приобрести оригинальную модель с более высокой производительностью. Кроме того, у Nvidia ещё есть версия RTX 4070 Super, которая оказывается не намного дороже, и это делает видеокарту RTX 4070 GDDR6 ещё менее привлекательной. AMD анонсировала видеокарту Radeon RX 7800M с производительностью уровня мобильной RTX 4070

11.09.2024 [11:40],

Анжелла Марина

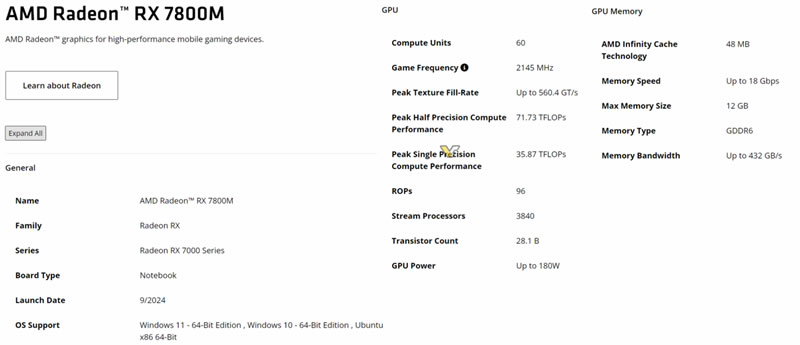

Компания AMD опубликовала на своём сайте характеристики видеокарты Radeon RX 7800M, при этом никаких официальных заявлений или пресс-релизов AMD пока не выпустила. Новинка, оснащённая 3840 потоковыми процессорами, является одной из самых мощных мобильных видеокарт AMD и обещает производительность на уровне мобильной GeForce RTX 4070.

Источник изображения: AMD/Videocardz.com Radeon RX 7800M основана на графическом процессоре Navi 32 с архитектурой RDNA 3 и оснащена 60 вычислительными блоками (CU), что эквивалентно 3840 потоковым процессорам. Для сравнения, старшая модель в линейке, Radeon RX 7900M, использует Navi 31 с 72 CU, а младшие модели на Navi 33 (RX 7700-7600) имеют всего 32 CU. Таким образом, новая видеокарта может заполнить пробел в производительности между существующими моделями.

Источник изображения: AMD/Videocardz.com По конфигурации Radeon RX 7800M напоминает десктопную видеокарту RX 7800 XT, используя тот же графический процессор с 60 вычислительными блоками (CU). Однако мобильная версия получила урезанную шину памяти — 192-бит против 256-бит у десктопного варианта. Объём видеопамяти GDDR6 составляет 12 Гбайт, использованы чипы со скоростью 18 Гбит/с, обеспечивающие пропускную способность до 432 Гбайт/с. Объём кэша Infinity Cache также уменьшен с 64 Мбайт до 48 Мбайт. Согласно информации AMD, базовая частота графического процессора Radeon RX 7800M составляет 2145 МГц, а уровень TDP — 180 Вт, что сопоставимо с флагманской моделью Radeon RX 7900M, которая может потреблять до 200 Вт в режиме Boost. Судя по ранним утечкам, RX 7800M способна превзойти по производительности даже мобильную видеокарту NVIDIA GeForce RTX 4070, однако уступает мобильной RTX 4080. Предположительно, «тихий» запуск Radeon RX 7800M может означать ограниченную доступность видеокарты, как это было с RX 7900M, которая выпускалась очень ограниченным тиражом для определённых устройств. На данный момент известно лишь об одной модели, использующей RX 7900M — это внешняя видеокарта OneXGPU 2. Остаётся надеяться, что RX 7800M получит более широкое распространение. AMD отказалась от погони за Nvidia и сделала ставку на массовый рынок GPU

09.09.2024 [07:04],

Дмитрий Федоров

AMD изменила свою стратегию, сместив акцент с ограниченного сегмента флагманских видеокарт для энтузиастов на расширение присутствия на рынке GPU. Новая цель компании — увеличить рыночную долю с текущих 10 % до амбициозных 40–50 %. Для этого в следующей серии видеокарт AMD намерена сосредоточиться на массовом сегменте, охватывающем 80 % рынка, вместо того, чтобы конкурировать в узкой нише высокопроизводительных GPU.

Источник изображений: AMD Пока AMD официально не подтвердила слухи об отмене разработки графического процессора Navi 41/4C, флагманского чипсета с архитектурой RDNA 4. Изначально AMD планировала бросить вызов Nvidia в высокопроизводительном сегменте, но затем, руководствуясь неназванными причинами, отказалась от этих планов. Вместо этого компания, по-видимому, сосредоточилась на разработке GPU Navi 48 и Navi 44, ориентированных на более массовый рынок. Примечательно, что названия этих GPU уже были подтверждены AMD в патчах драйверов с открытым исходным кодом и документах по отгрузке. Отвечая на вопросы журналиста Tom's Hardware на выставке IFA 2024 в Берлине, старший вице-президент и генеральный менеджер графического подразделения AMD Джек Гуинь (Jack Huynh) подчеркнул, что AMD приняла новую стратегию, радикально отличающуюся от предыдущей, и будет наращивать своё присутствие в более доступных ценовых категориях. Вероятно, это окажет влияние на архитектуру и позиционирование новой серии видеокарт Radeon RX 8000. Важно отметить, что разворот AMD в сторону массового сегмента не является беспрецедентным. Ранее компания уже дважды использовала подобный подход: сначала с серией Polaris 10/20/30, а затем с чипами первого поколения RDNA. Хотя параллельно разрабатывались и дополнительные высокопроизводительные решения, такие как RX Vega (2017 год) и Radeon VII (2019 год), лишь RX Vega смогла достичь некоторого успеха в высокопроизводительном сегменте. AMD предприняла очередную попытку вернуться в сегмент для энтузиастов с выпуском серии Radeon RX 6900, а затем и RX 7900. Обе линейки предложили конкурентоспособное соотношение цены и производительности по сравнению с сериями Nvidia GeForce RTX 30 и 40.  В ходе интервью журналист Tom's Hardware спросил Гуиня о перспективах конкуренции с Nvidia на рынке высокопроизводительных GPU. Тот подчеркнул, что AMD сейчас находится в иной рыночной позиции и активно обсуждает изменение стратегии. Он привёл в пример PlayStation 5 стоимостью $499, задаваясь вопросом о разумности быть «царём горы», если основная доля рынка лежит в другом ценовом сегменте. Гуинь сообщил, что главной задачей AMD сейчас является расширение присутствия на рынке. Он пояснил, что увеличение доли до 40–50 % позволит привлечь больше разработчиков, которые будут оптимизировать свои продукты под технологии AMD. Топ-менеджер также подчеркнул, что компания не стремится стать брендом, доступным лишь владельцам Porsche и Ferrari, а хочет создавать игровые системы для миллионов пользователей по всему миру. Гуинь заверил, что AMD продолжит разрабатывать передовые технологии и выпускать высококачественные продукты. Однако он отметил, что стратегия «царя горы», применявшаяся ещё во времена ATI (которую AMD купила в 2006 году), не принесла компании значительного роста. Теперь новый подход компании заключается в создании лучших продуктов по правильной цене, что должно обеспечить её технологическое лидерство в наиболее массовых сегментах.  На вопрос о планах выпуска флагманских GPU Гуинь не исключил возможности появления таких продуктов в будущем, но подчеркнул, что приоритетом остаётся увеличение рыночной доли AMD. Без этого привлечь разработчиков к оптимизации их продуктов под технологии AMD будет затруднительно. Гуинь отметил, что если заявить о намерении захватить лишь 10 % рынка, это не вызовет энтузиазма у разработчиков. Однако стратегия, нацеленная на достижение 40 % доли, вызывает гораздо больший интерес и готовность к сотрудничеству. Только после достижения такого масштаба AMD сможет серьёзно задуматься о конкуренции в высокопроизводительном сегменте. Несмотря на смещение фокуса, Гуинь не лишил энтузиастов надежды. Он подтвердил, что AMD продолжает работать над высокопроизводительными решениями с использованием чиплетной технологии, хотя и не назвал конкретных сроков их выхода. Напомним, что AMD уже успешно применяет чиплетную архитектуру в текущем поколении графических процессоров RDNA 3, разделяя графический процессор и кэш-память на отдельные чипы. Однако, по слухам, компания работает ещё и над разделением вычислительных блоков на отдельные чиплеты, что представляет собой чрезвычайно сложную инженерную задачу для графических процессоров из-за необходимости обеспечения сверхвысокой пропускной способности и минимальных задержек при обмене данными между чиплетами. Компания уже удивила индустрию, выпустив процессоры Ryzen с инновационным чиплетным дизайном, что позволило ей укрепить позиции на рынке CPU. Если AMD удастся повторить этот успех в сегменте графических решений, это может существенно повлиять на всю индустрию. Nvidia, долгое время доминировавшая на рынке высокопроизводительных GPU, может столкнуться с серьёзным вызовом, если стратегия AMD окажется успешной. Nvidia укрепила лидерство на рынке GPU, Intel потеряла позиции, а AMD — немного отыграла

06.09.2024 [18:49],

Дмитрий Федоров

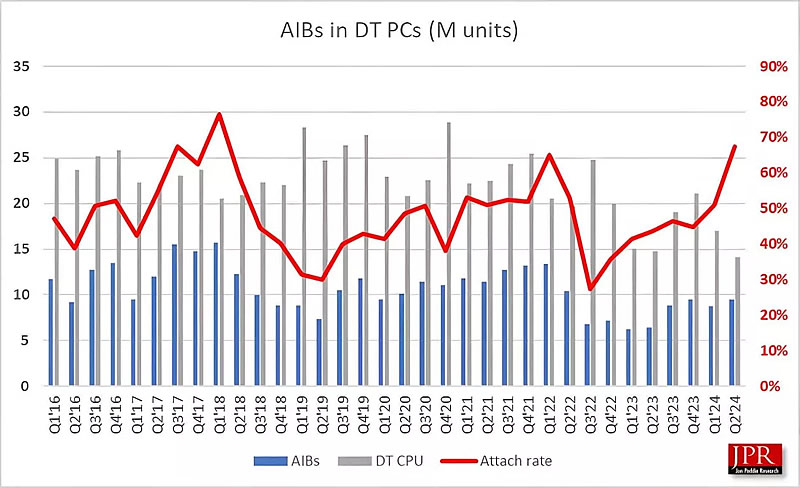

Согласно последнему квартальному отчёту исследовательской компании Jon Peddie Research (JPR), касающемуся поставок графических процессоров (GPU), во II квартале 2024 года мировой рынок показал рост на 1,8 %. Nvidia укрепила позиции, увеличив свою долю на 2 %. Несмотря на глобальные экономические трудности, рынок графических процессоров остаётся устойчивым и даже демонстрирует потенциал для дальнейшего роста, что подтверждается прогнозами аналитиков на ближайшие годы.

Источник изображения: LauraTara / Pixabay Так, во II квартале 2024 года было отгружено около 70 млн GPU, что говорит о заметном оживлении рынка. Особенно впечатляет рост поставок процессоров для настольных компьютеров (ПК) — +11 % в годовом исчислении. Прогнозируется, что в период с 2024 по 2026 годы совокупный среднегодовой темп прироста составит 4,2 %, а к концу 2026 года общее количество используемых GPU может достичь внушительных 3,3 млрд единиц. Важным моментом остаётся прогнозируемое JPR сохранение значительной доли дискретных графических карт в ПК. По их оценкам, в течение следующих пяти лет около 23 % ПК будут оснащены дискретными видеокартами. Годовой рост поставок GPU, охватывающий все платформы и типы процессоров, оказался на уровне 16 %. При этом наблюдается разная динамика в различных сегментах рынка: так, поставки GPU для ПК увеличились на 21 %, тогда как для ноутбуков — всего на 13 %.

Распределение долей рынка GPU для ПК: AMD, Intel и Nvidia во II квартале 2024 года (источник: JPR, TweakTown) Доктор Джон Педди (Jon Peddie), президент JPR, в своём комментарии отметил: «Скачок поставок во II квартале стал для нас приятным сюрпризом. Рынок уже несколько лет испытывает колебания, стремясь обрести ритмичность и стабильность. Учитывая все текущие потрясения — от торговых войн до пандемии и политических кризисов — ожидать так называемую нормальность в ближайшем будущем маловероятно». Распределение долей рынка GPU между основными игроками также претерпело некоторые изменения. За три месяца AMD удалось незначительно увеличить свою долю на 0,2 %. На этом фоне Nvidia укрепила свои позиции, добавив 2 %, тогда как доля Intel уменьшилась на 2,1 %. Важно отметить, что эти данные учитывают как дискретные, так и интегрированные GPU, что и объясняет стабильные позиции Intel на рынке в целом.

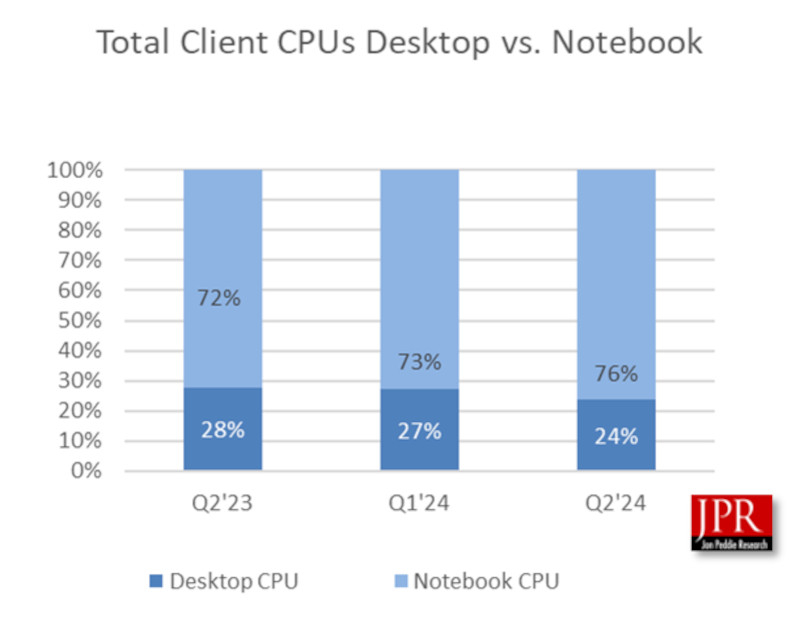

Доля процессоров для ПК и ноутбуков: динамика изменений с II квартала 2023 года по II квартал 2024 год (источник: JPR, TweakTown) JPR также представила ряд интересных статистических данных, характеризующих текущее состояние отрасли:

Эти данные подчёркивают сложную и неоднозначную динамику рынка, где квартальные колебания переплетаются с общей тенденцией к росту. Краткосрочные экономические трудности могут объяснить снижение поставок в квартальном измерении, однако годовой рост показывает более долгосрочную положительную тенденцию в индустрии GPU. Nvidia отметила 25-летие первого GPU в мире — видеокарты GeForce 256

02.09.2024 [17:51],

Анжелла Марина

Четверть века назад, 31 августа 1999 года, компания Nvidia представила GeForce 256 — дискретную видеокарту, которая позиционировалась как «первый в мире GPU». Этот графический ускоритель кардинально изменил ландшафт компьютерных игр и графики, заложив основу для современных технологий, используемых в играх, ИИ и не только.

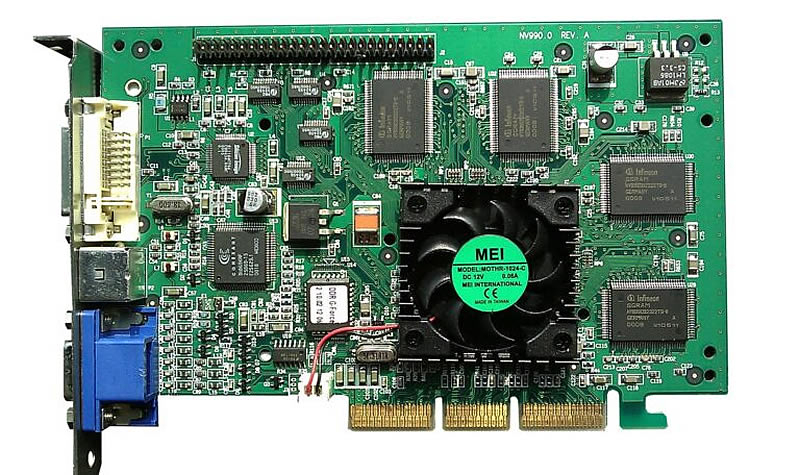

GeForce 256. Источник изображения: VisionTek/Wikipedia Революционное влияние GeForce 256 было обусловлено интеграцией функций преобразования и освещения (T&L) непосредственно в GPU. Ранее эти вычисления выполнялись центральным процессором или требовали специализированного оборудования. Переместив T&L на GPU, Nvidia снизила затраты и повысила производительность по сравнению с традиционными 3D-ускорителями. Эта оптимизация позволила Nvidia превзойти конкурентов и стать тем, кем она является сейчас. GeForce 256 имел память SDR, но позже был обновлён до DDR, поддерживал DirectX 7.0 и был преемником серии RIVA TNT2. Это был однокристальный чип, способный обрабатывать 10 миллионов полигонов в секунду, имел 23 миллиона транзисторов, что сегодня несоизмеримо мало по сравнению с GPU AD102 в GeForce RTX 4090, текущем флагманском GPU Nvidia. За 25 лет количество транзисторов в GPU увеличилось в 3300 раз, а объём памяти в 768 000 раз. При этом флагманская видеокарта теперь требует в девять раз больше энергии и стоит примерно в четыре раза дороже. «На момент выхода GeForce 256 Nvidia конкурировала с 35 другими компаниями», — рассказывал соучредитель компании Крис Малаховски (Chris Malachowsky) в 2008 году. В то время как некоторые конкуренты были поглощены Nvidia, другие не смогли угнаться за прогрессом, и только AMD выдержала это давление. Однако сегодня рынок GPU расширился и уже такие компании, как Intel, AMD, Qualcomm и Nvidia соревнуются в разработке самых передовых архитектур для различных применений практически на равных. Но Nvidia со своими флагманскими решениями явно вырывается вперёд, причём не только в играх с GeForce RTX 4090, но и в вычислениях с H100 и другими GPU. GPU значительно эволюционировали со времён GeForce 256, теперь они оснащены мощными решениями для кодирования видео, выделенными блоками трассировки лучей и тензорными ядрами. Они играют решающую роль в играх, профессиональной визуализации, рендеринге, облачном стриминге, вычислениях, криптовалюте и быстрорастущей области генеративного ИИ. Эта тенденция, вероятно, сохранится, и в будущем будут добавлены более специализированные аппаратные блоки ускорения. ASUS представила на Gamescom блоки питания для ПК на основе нитрида галлия

25.08.2024 [23:44],

Анжелла Марина

ASUS представила на Gamescom блоки питания ROG THOR III 1600W и ROG Strix 1000W. Главной особенностью новинок стало использование транзисторов на основе нитрида галлия (GaN), что позволило значительно улучшить их характеристики и дизайн.

Источник изображения: overclock3d.net/ASUS Как подчёркивает ресурс Overclock3d, переход на GaN-транзисторы не являются процессом простой замены одного компонента на другой. Новые транзисторы ASUS обеспечивают более высокий уровень эффективности и позволяют упростить внутреннюю компоновку блоков питания, что дало возможность оптимизировать систему охлаждения блоков, обеспечив к тому же более тихую работу.

Источник изображения: overclock3d.net/ASUS По заявлению ASUS, эффективность транзисторов увеличилась на 30 %. Кроме того, оба новых блока питания ROG THOR III и Strix Platinum сертифицированы по стандартам ATX 3.1 и PCIe 5.1. Устройства также усовершенствованы за счёт добавления нового 2-контактного разъёма, который представляет собой датчик напряжения, позволяющий обоим ROG тщательно контролировать подачу питания для обеспечения оптимальной производительности и стабильности работы графического процессора.

Источник изображения: overclock3d.net/ASUS Серия ROG THOR III имеет сертификат эффективности 80+ Titanium, в то время как новая серия ROG Strix — 80+ Platinum. Оба рейтинга относятся к высокопроизводительному классу, однако серия THOR выводит эффективность на ещё более высокий уровень, обеспечивая КПД до 96 %. Блок питания ROG THOR III также получил сертификат эффективности Cybenetics и рейтинг шума Lamda A+. Ещё ROG Thor оснащён магнитным OLED-дисплеем, который можно разместить в любом удобном месте, например прикрепить к блоку питания или к любой другой поверхности для лучшей видимости. Imagination отказалась от нейропроцессоров в пользу совершенствования GPU под нужды ИИ

25.08.2024 [22:00],

Анжелла Марина

Британский разработчик чипов Imagination Technologies на фоне получения $100 млн инвестиций меняет свою стратегию в сфере искусственного интеллекта, отказываясь от использования отдельных нейропроцессоров (NPU) и внедряя ИИ-функции в графические процессоры (GPU).

Источник изображения: imaginationtech.com По данным Tom's Hardware со ссылкой на источник, это стратегическое решение было принято в течение последних 18 месяцев из-за сложностей с собственным разработанным ранее программным стеком, который не успевал за быстро меняющимися потребностями клиентов в области искусственного интеллекта. Создание ИИ-функциональности, способной раскрыть все возможности нейропроцессора от Imagination Technologiesоказалось было затруднено. Компания переключила внимание на GPU, которые по своей природе многопоточны и хорошо подходят для задач, требующих эффективной параллельной обработки данных. Imagination Technologies считает, что GPU можно усовершенствовать дополнительными вычислительными возможностями для ИИ, что сделает их подходящими для периферийных приложений, особенно в устройствах с уже существующими GPU, таких как смартфоны. Напомним, что Imagination Technologies, работающая на рынке около 40 лет, приобрела известность благодаря графическим процессорам PowerVR Kyro для ПК и IP-ядрам GPU PowerVR, используемым Apple, Intel и другими компаниями. Теперь же в рамках новой стратегии компания сотрудничает с UXL Foundation над разработкой SYCL — открытой платформой, конкурирующей с программно-аппаратной архитектурой параллельных вычислений CUDA от Nvidia. Такой подход отвечает потребностям клиентов, которые уже используют GPU для обработки графики и задач искусственного интеллекта.

Источник изображения: imaginationtech.com Получение инвестиций в размере $100 млн от Fortress Investment Group, вероятно, связано с новой стратегией Imagination Technologies. Компания уверена, что GPU на данный момент являются лучшим решением для удовлетворения потребностей клиентов в области ИИ, прекратив разработку отдельных нейронных ускорителей. Тем не менее, Imagination не исключает возможности возвращения к разработке специализированных нейропроцессоров в будущем, если развитие программного обеспечения для ИИ изменит ситуацию. Израильское подразделение Arm взялось за создание игрового GPU

16.08.2024 [12:10],

Алексей Разин

Недавно стало известно, что материнская корпорация SoftBank вынашивает идею создания собственного чипа для ускорения систем искусственного интеллекта, поэтому свежая публикация на страницах Globes ничуть не удивляет своим содержанием. Источник сообщает, что группа специалистов Arm в Израиле занята разработкой GPU для сегмента видеоигр.

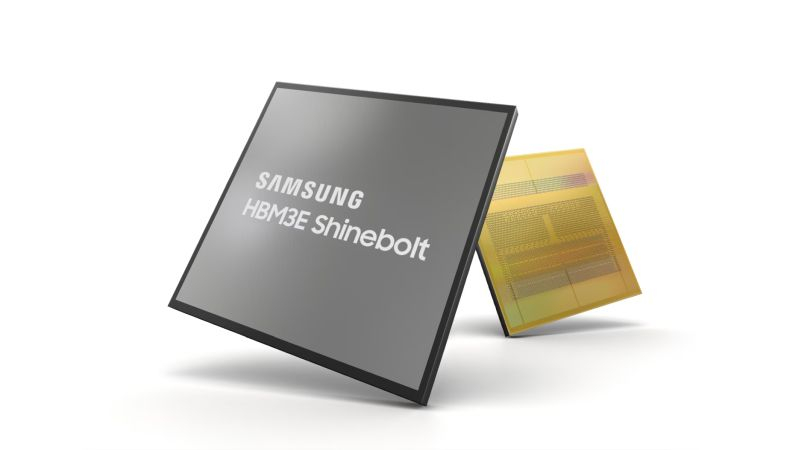

Источник изображения: Arm В местном исследовательском центре Arm, как поясняет Globes, над созданием игрового графического процессора трудятся около сотни специалистов по программному и аппаратному обеспечению. Тем не менее, изначальная ориентация продукта на сегмент игрового железа не означает, что в дальнейшем эти разработки не могут быть применены в сфере ускорения вычислений для систем искусственного интеллекта. Израильские специалисты Arm уже имеют опыт оптимизации дизайна графических ядер для сторонних заказчиков, поэтому его можно было бы применить при создании собственного GPU. У инженеров Arm в Израиле также есть опыт создания ускорителей вычислений для NeuReality, поэтому он может быть применён для аналогичных собственных разработок. Ускорители Arm могут составить конкуренцию решениям Nvidia и продаваться в существенных количествах крупным провайдерам облачных услуг, которые заинтересованы в снижении зависимости от доминирующего поставщика, который способен навязывать им любые цены. Samsung удалось сертифицировать свою 8-слойную память HBM3E под требования Nvidia

07.08.2024 [06:58],

Алексей Разин

Новейшая память HBM3E компании Samsung Electronics длительное время не могла попасть в цепочки поставок Nvidia, поскольку не проходила сертификационные тесты, и теперь осведомлённые источники сообщает, что 8-слойные микросхемы Samsung этого типа наконец-то прошли сертификацию крупнейшего разработчика чипов для систем искусственного интеллекта.  Об этом сообщило агентство Reuters со ссылкой на три независимых источника. Формально, данный этап открывает перед продукцией Samsung этого типа путь к долгожданному сотрудничеству с Nvidia, поскольку до сих пор из трёх существующих производителей HBM3E только Samsung не могла похвастать наличием необходимых сертификатов. Лидирующим поставщиком HBM3E для нужд Nvidia, как известно, является SK hynix, которая контролирует около половины рынка микросхем этого типа. Samsung при этом только предстоит пройти сертификацию Nvidia для микросхем HBM3E с 12 ярусами, поэтому южнокорейский гигант всё равно остаётся в положении догоняющего по сравнению со своими конкурентами. В случае с 8-ярусными стеками HBM3E компания Samsung ещё только должна подписать контракт с Nvidia, чтобы приступить к их поставкам этому клиенту в четвёртом квартале текущего года. Считается, что ради соответствия требованиям Nvidia компании Samsung пришлось внести серьёзные изменения в конструкцию и технологию изготовления микросхем памяти типа HBM3E. Недавно сообщалось, что менее современная память HBM3 марки Samsung была сертифицирована Nvidia для использования в составе ускорителей вычислений, ориентированных на китайский рынок. По оценкам TrendForce, микросхемы поколения HBM3E по итогам текущего года станут доминирующим типом HBM, основной объём их поставок придётся на второе полугодие. Непосредственно Samsung рассчитывает довести долю HBM3E до 60 % поставок в структуре чипов семейства HBM к концу этого года. Nvidia готовит новую мобильную GeForce RTX 3050 на чипе Ada Lovelace с 64-битной шиной и 4 Гбайт памяти

27.07.2024 [23:25],

Анжелла Марина

Компания Nvidia подтвердила разработку новой версии видеокарты GeForce RTX 3050 для ноутбуков. Ключевой особенностью новинки станет использование графического процессора AD106, основанного на архитектуре Ada Lovelace, используемой в более мощной RTX 4070.

Источник изображения: Nvidia По информации издания Notebookcheck, видеокарта, получившая название GeForce RTX 3050 A, будет оснащена 4 Гбайт видеопамяти GDDR6 с 64-битной шиной, а её TDP составит от 35 до 50 Вт. Количество ядер CUDA составит 1792. Эксперты отмечают, что подобный шаг Nvidia напоминает ситуацию 2021 года, когда компания неожиданно представила GeForce RTX 2050 на базе GPU GA107 (Ampere), несмотря на то, что эта модель относилась к линейке Turing. Та карта нашла применение во многих бюджетных ноутбуках, хотя её производительность оставляла желать лучшего. Теперь Nvidia, похоже, планирует провернуть подобный трюк с GeForce RTX 3050, которая изначально базировалась на чипе Ampere, оснастив её графическим процессором Ada Lovelace. Информация о новой модификации RTX 3050 была обнаружена в базе данных PCI-ID, а также в последних драйверах Nvidia. Хотя полные технические характеристики пока не раскрыты, очевидно, что производительность новинки будет ниже, чем у мобильной версии GeForce RTX 4070, также использующей GPU AD106. Стоит отметить, что это уже третий вариант GeForce RTX 3050 после версий с 6 Гбайт и 4 Гбайт памяти на базе GPU GA107. Причины выбора AD106 вместо более подходящего для данного класса видеокарт AD107 пока неизвестны. Не исключено, что новая GeForce RTX 3050 A может быть представлена на выставке CES вместе с моделями серии RTX 5000 на базе архитектуры Blackwell. Однако также существует вероятность, что данная модификация является экспериментальной и может не выйти на рынок. Ожидается, что появление версии GeForce RTX 3050 A позволит Nvidia расширить предложение в сегменте бюджетных игровых ноутбуков, предоставив производителям дополнительные возможности для создания конкурентоспособных моделей. Colorful представила оперативную память iGame Jiachen Zhilong DDR5 в стиле китайского года дракона

27.07.2024 [11:52],

Анжелла Марина

Компания Colorful представила серию модулей оперативной памяти iGame Jiachen Zhilong DDR5, созданную в едином стиле с ранее выпущенными материнскими платами ограниченной серии Dragon Year («Год Дракона»). Эта высокопроизводительная память адресована пользователям, которые ценят не только производительность, но и эстетику.

Источник изображения: Colorful Первый комплект памяти в новой линейке имеет объём 48 Гбайт (2 × 24 Гбайт) и работает на частоте 6800 МГц с таймингами CL34. Ключевой особенностью модулей является эффектный теплоотвод с дизайном Dragon Scale (драконья чешуя) и RGB-подсветкой в виде дракона. Дизайн серии Jiachen Zhilong вдохновлён традиционной китайской цветовой гаммой, включая красный Zheng Li и золотой Jin Xiang. На лицевой стороне модулей можно увидеть узоры в виде облаков Xiang Yun и летящих фениксов Yu Feng, а на обратной стороне расположена эмблема Jiachen Zhilong. Общий вид дополняется золотой окантовкой и многослойными волоконно-оптическими световодами, символизирующими «восхождение шаг за шагом» (rising step by step).

Источник изображения: Colorful С технической точки зрения известно, что новая память использует высококачественные чипы от SK hynix и обеспечивает скорость передачи данных до 6800 МТ/с. Поддерживается технология XMP 3.0 для простого разгона в один клик, интеллектуальный контроль температуры PMIC для оптимального теплового режима и ON-Die ECC для автоматического исправления ошибок, гарантирующего целостность данных и стабильность работы. Хотя в настоящий момент на JD.com доступна только 48-гигабайтная версия, на странице продукта есть намёк на будущий выпуск варианта объёмом 32 Гбайт. Ожидается, что эта версия с меньшей ёмкостью сохранит тайминги CL34, но справляться со своими задачами на 100 % сможет при более высоком рабочем напряжении в 1,4 Вт. На данный момент комплект доступен на китайской площадке JD.com по цене 1399 юаней (около 16 600 рублей). |