|

Опрос

|

реклама

Быстрый переход

Представлен одноплатный компьютер Raspberry Pi Compute Module 4 по цене от $25

19.10.2020 [12:24],

Сергей Карасёв

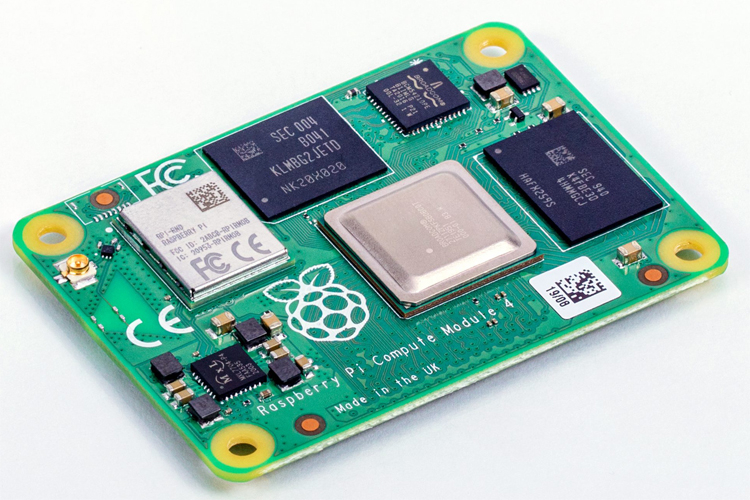

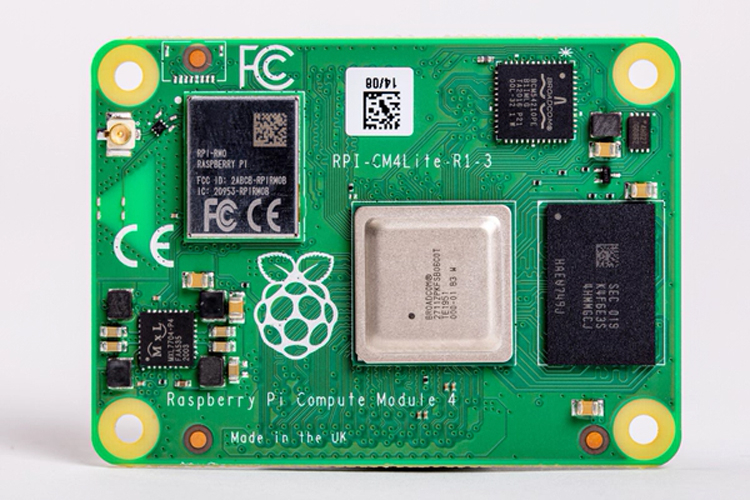

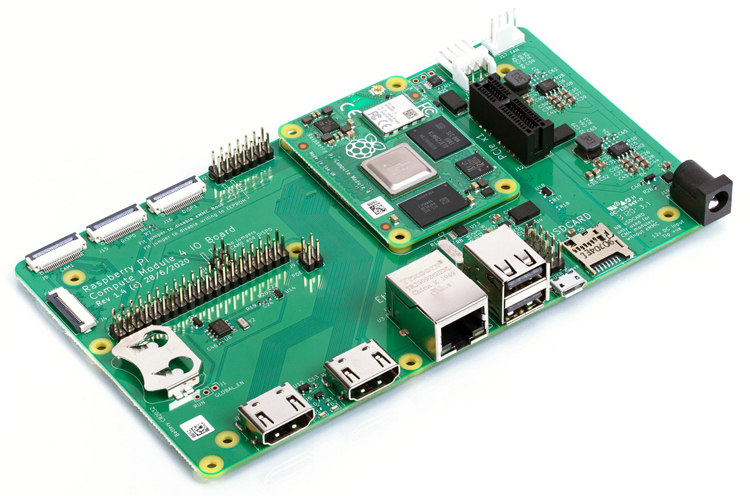

Участники проекта Raspberry Pi представили сегодня, 19 октября, вычислительный модуль Compute Module 4 — аналог одноплатного компьютера Raspberry Pi 4 в ещё более компактном форм-факторе.  Новинка имеет размеры всего 55 × 40 мм. Задействован процессор Broadcom BCM2711 с четырьмя ядрами Cortex-A72 (ARM v8) с тактовой частотой 1,5 ГГц. Объём оперативной памяти LPDDR4-3200 SDRAM может составлять 1, 2, 4 или 8 Гбайт. Модуль комплектуется флеш-чипом eMMC вместимостью 8, 16 или 32 Гбайт. Предусмотрена также версия Compute Module 4 Lite без интегрированной флеш-памяти.  Опционально новинка может быть наделена адаптерами беспроводной связи Wi-Fi IEEE 802.11b/g/n/ac и Bluetooth 5.0. Доступны интерфейсы GPIO, UART, I2C и SPI.  Вместе с вычислительным модулем покупатели смогут приобрести сопутствующую плату Compute Module 4 IO Board, предоставляющую ряд разъёмов для подключения внешних устройств. В частности, доступны два полноразмерных коннектора HDMI 2.0, два порта USB 2.0, сетевой порт Gigabit Ethernet RJ45 с возможностью подачи питания (PoE), слот для карты microSD и слот PCIe Gen2 x1.  Ещё один дополнительный аксессуар — внешняя антенна беспроводной связи Compute Module 4 Antenna Kit. Она обеспечивает работу в двух частотных диапазонах — 2,4 и 5 ГГц. Модуль Raspberry Pi Compute Module 4 доступен для заказа по цене от 25 долларов США. Amazon купила у радиолюбителей 4 млн IPv4-адресов за $108 млн

13.10.2020 [23:41],

Владимир Мироненко

Президент неправительственной организации радиолюбителей Amateur Radio Digital Communications (ARDC) из Калифорнии (США) Фил Карн (Phil Karn, KA9Q), подтвердил, что ARDC получила $108 млн от Amazon за 4 млн адресов IPv4.  С момента выделения любительскому радио в середине 1980-х годов сети 44 (44.0.0.0/8), также известной как AMPRNet, она использовалась радиолюбителями для проведения научных исследований и экспериментов с цифровыми коммуникациями по радио с целью продвижения современного уровня любительских радиосетей и обучения радиолюбителей этим методам. Этот процесс координирует некоммерческая организация ARDC. Блок (44.192.0.0/10) примерно из четырех млн IP-адресов AMPRNet из 16 млн доступных был продан Amazon организацией ARDC в середине 2019 года, но лишь сейчас была объявлена стоимость сделки. Amazon заплатила ARDC примерно $27 за каждый IPv4-адрес. «Соглашение о неразглашении информации с Amazon, которое касалось продажи наших избыточных IP-адресов, требовало от нас не сообщать точные суммы в долларах до тех пор, пока мы не обязаны по закону раскрывать их в наших ежегодных налоговых декларациях, аудиторских и финансовых отчетах. Они только что были обнародованы и доступны в Интернете на веб-сайте генерального прокурора Калифорнии (поскольку ARDC зарегистрирована в Калифорнии). Вы также можете получить некоторую справочную информацию в нашей статье в Википедии», — сообщил Фил Карн в посте на сайте AMSAT Bulletin Board (AMSAT-BB). Он пообещал, что организация будет ежегодно выделять из полученной суммы порядка $5 млн на интернет- и радиолюбительские цифровые коммуникационные проекты. «На сегодняшний день мы выделили около $2,5 млн в виде грантов, так что мы только начинаем», — добавил глава ARDC. IBM разделится на две компании и сосредоточится на создании гибридного облака стоимостью $1 трлн

08.10.2020 [21:26],

Владимир Мироненко

Компания IBM, изначально сделавшая себе имя благодаря выпуску корпоративного оборудования, делает ещё один шаг в сторону от этого наследия, углубляясь в мир облачных сервисов. Сегодня компания объявила о решении выделить подразделение управляемых инфраструктурных услуг в отдельную публичную компанию с годовой выручкой в $19 млрд, чтобы сосредоточиться на новых возможностях гибридных облачных приложений и искусственного интеллекта. Как сообщил генеральный директор IBM Арвинд Кришна (Arvind Krishna), процесс создания новой компании с условным названием NewCo (новая компания) будет завершён к концу 2021 года. У неё будет 90 тыс. сотрудников, 4600 крупных корпоративных клиентов в 115 странах, портфель заказов в размере $60 млрд, «и более чем в два раза больше, чем у ближайшего конкурента» присутствие в области инфраструктурных услуг.

Gleb Garanich/Reuters В число конкурентов новой компании входят BMC и Microsoft. Остающийся у IBM после выделения новой компании бизнес в настоящее время приносит её около $59 млрд годового дохода. Услуги инфраструктуры включают в себя ряд управляемых сервисов, основанных на устоявшейся инфраструктуре и связанной с ней цифровой трансформации. Они включают в себя, в том числе тестирование и сборку, а также разработку продуктов и лабораторные сервисы. Этот шаг является значительным сдвигом для компании и подчеркивает большие изменения в том, как ИТ-инфраструктура предприятия развивалась и, похоже, продолжит меняться в будущем. IBM делает ставку на то, что устаревшая инфраструктура и ее обслуживание, продолжая приносить чистую прибыль, не будут расти, как это было в прошлом, и по мере того, как компания продолжит модернизацию или «цифровую трансформацию», она будет всё больше обращаться к внешней инфраструктуре и использованию облачных сервисов как для ведения своего бизнеса, так и для создания сервисов, взаимодействующих с потребителями. Объявление было сделано через год после того, как IBM приобрела компанию Red Hat, предлагающую ПО с открытым исходным кодом, за $34 млрд, рассчитывая перевести большую часть своего бизнеса в облачные сервисы. «Я очень рад предстоящему пути и огромной ценности, которую мы создадим, если две компании будут сосредоточены на том, что у них получается лучше всего, — отметил в своем заявлении Арвинд Кришна. — Это принесёт пользу нашим клиентам, сотрудникам и акционерам и выведет IBM и NewCo на траекторию улучшенного роста». «IBM сосредоточена на возможности создания гибридного облака стоимостью $1 трлн, — сказал Кришна. — Потребности клиентов в покупке приложений и инфраструктурных услуг разнятся, в то время как внедрение нашей гибридной облачной платформы ускоряется. Сейчас подходящее время для создания двух лидирующих на рынке компаний, сосредоточенных на том, что у них получается лучше всего. IBM сосредоточится на своей открытой гибридной облачной платформе и возможностях ИИ. NewCo будет более гибко проектировать, управлять и модернизировать инфраструктуру самых важных организаций мира. Обе компании будут двигаться по траектории улучшенного роста с большей способностью сотрудничать и использовать новые возможности, создавая ценность для клиентов и акционеров». NVIDIA представила серверный ускоритель A40 с поддержкой виртуализации

05.10.2020 [18:15],

Илья Коваль

На конференции GTC 2020 компания NVIDIA анонсировала два новых ускорителя: RTX A6000 и A40. Оба являются практически идентичными копиями, но отличаются исполнением — A40 представляет собой привычную полноразмерную двухслотовую карту для серверов с пассивным охлаждением и энергопотреблением 300 Вт. A40 базируется на 8-нм чипе GA102 (10752 CUDA-ядра, 336 Tensor-ядер и 84 RT-ядра), дополненным 48 Гбайт памяти GDDR6 ECC и 384-бит шиной. Наличие NVLink3 позволяет объединить две карты, получив 96 Гбайт общей RAM. Для подключения к хостовой системе используется PCIe 4.0 x16. Увы, частот памяти и ядра, а также уровень производительности компания пока не приводит. Новинка ориентирована на 3D/CAM и другие системы моделирования и визуализации в виртуализированных окружениях — как и у старшего собрата в A40 есть поддержка до 7 vGPU с объёмом памяти от 1 до 48 Гбайт. А вот поддержки MIG, судя по всему, пока нет. Тем не менее, прочие функциональные блоки никуда не делись, так что карту можно использовать для вычислений и машинного обучения. Также есть один блок кодирования и два блока декодирования видео, которые поддерживают в том числе и AV1.  Из любопытных особенностей отметим, что для питания используется CPU-коннектор ESP (4+4), а не восьмиконтактный PCIe. Кроме того, карта имеет три видеовыхода DisplayPort 1.4, которые по умолчанию отключены — в сервере они всё равно не нужны. Их можно принудительно включить, но тогда будет недоступна функция vGPU. Также в A40 имеется отдельный крипточип CEC 1712 для Secure Boot и прочих функций безопасности, а сама она соответствует NEBS Level 3, что даёт возможность сертифицировать устройства с ней для использования в промышленных (и прочих неблагоприятных) условиях. Поставки новинки начнутся в первом квартале следующего года. Впрочем, как и прежде, она будет ориентирована на OEM-поставщиков оборудования, поэтому увидим мы её скорее в составе готовых продуктов и облаках, а не на полках магазинов. Intel представила новые 10-нм индустриальные процессоры: от Atom x6000E до Core i7 Tiger Lake

23.09.2020 [16:00],

Алексей Степин

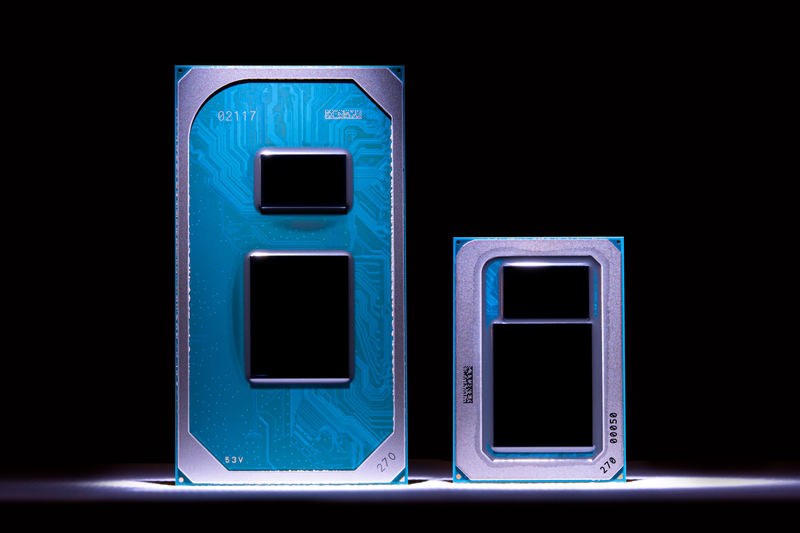

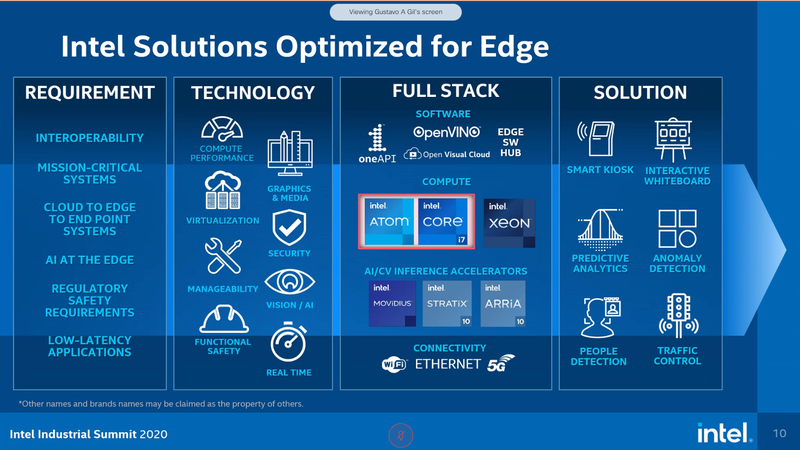

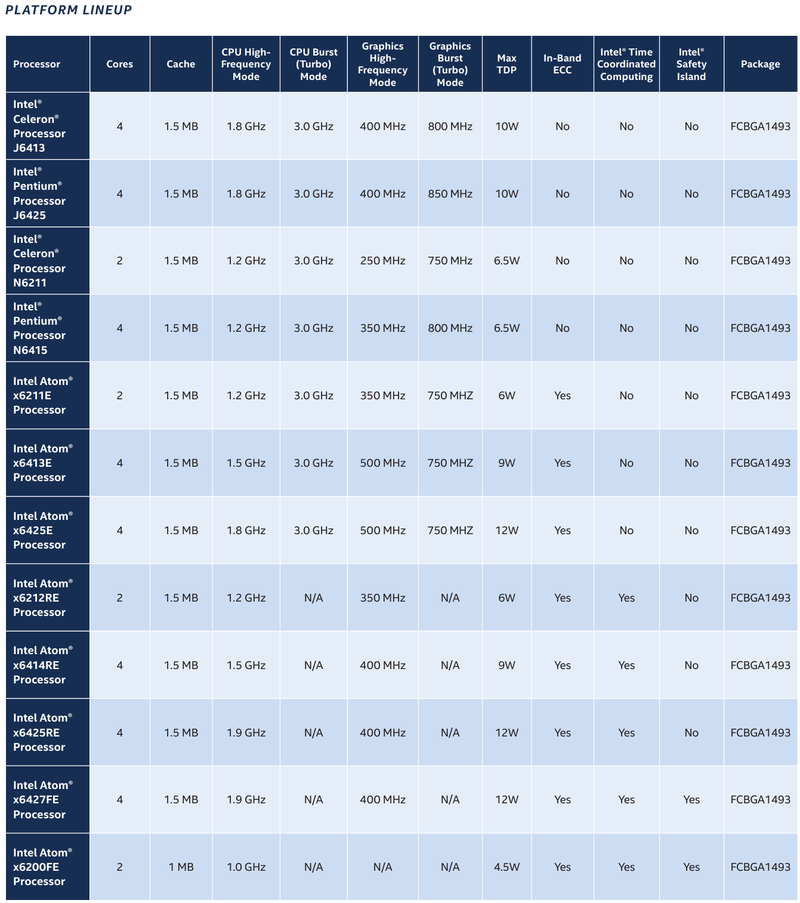

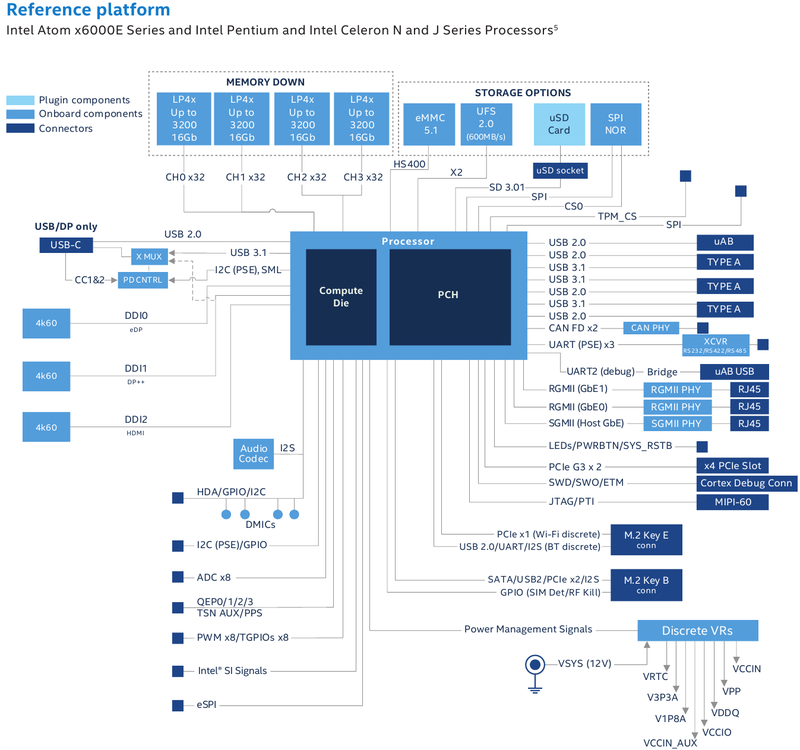

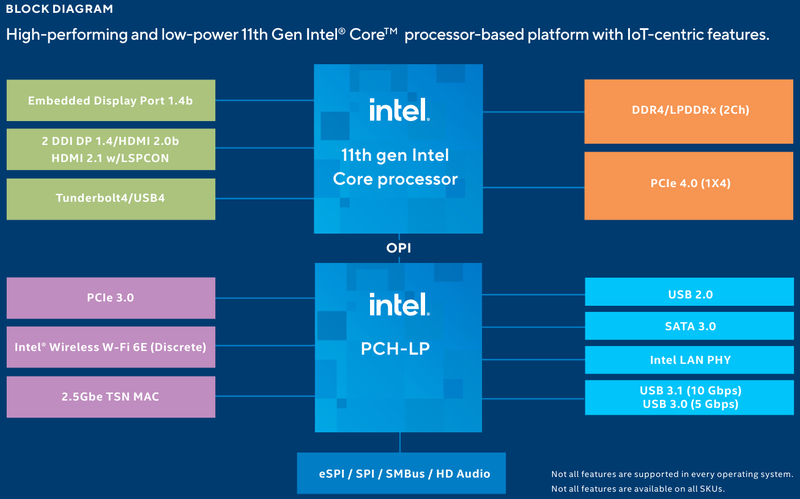

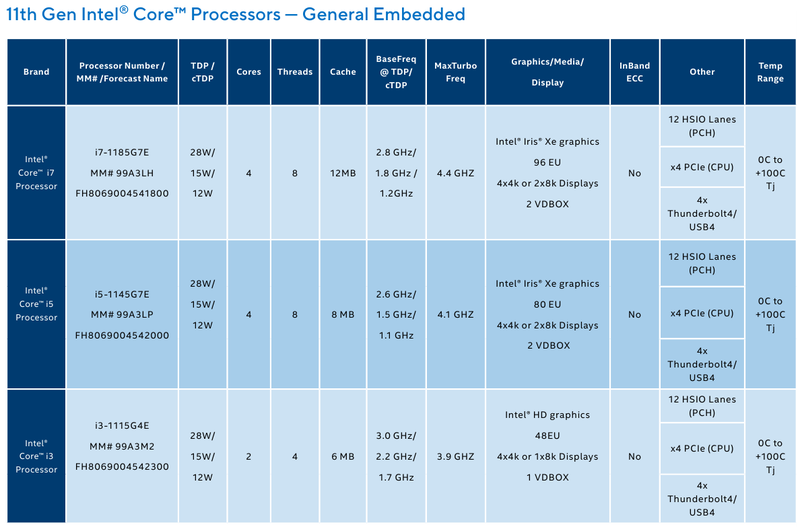

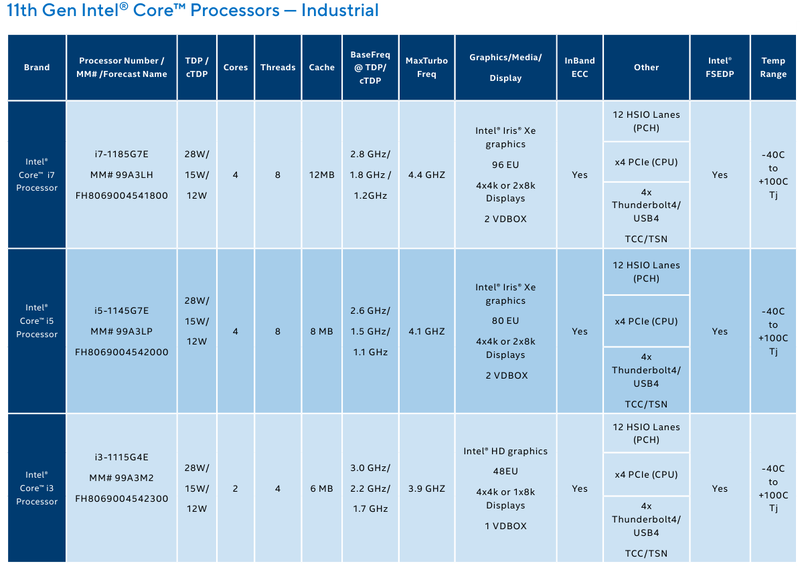

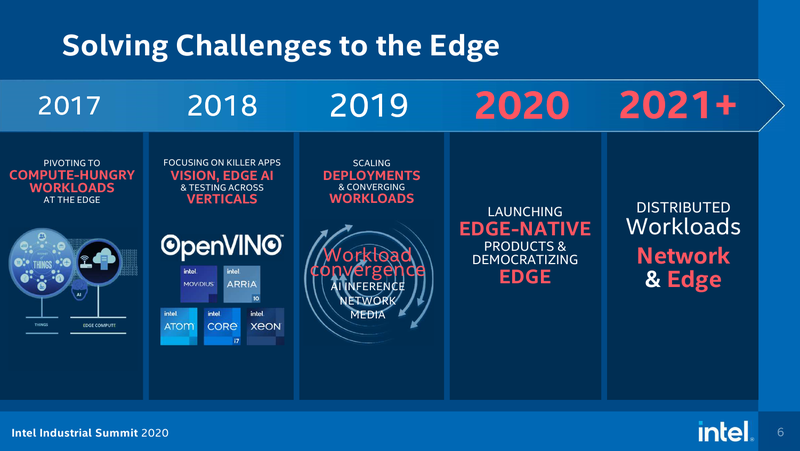

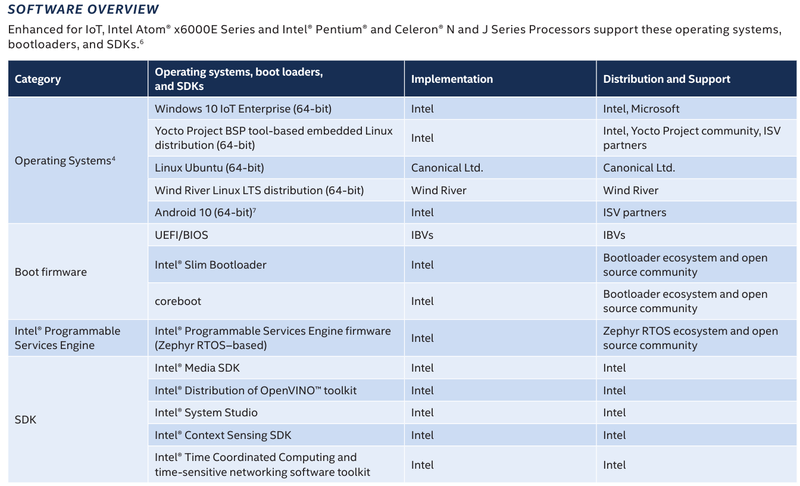

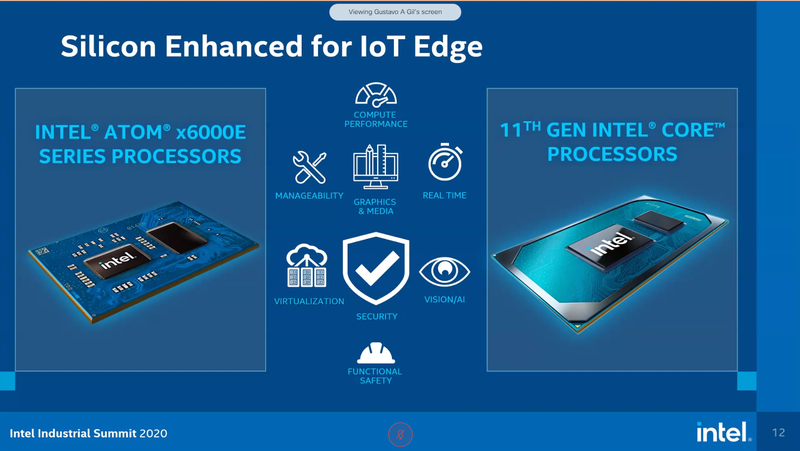

На мероприятии Intel Industrial Summit компания показала новые решения для периферийных вычислений и промышленных систем: платформу Atom x6000E, а также новые процессоры Pentium и Celeron серий N/J и индустриальные версии Core i3/i5/i7 11-го поколения известного как Tiger Lake. Для x6000E, Pentium и Celeron используется классический, «старый» 10 нм, а кристаллы Tiger Lake производятся с использованием «нового» 10 нм, так называемого SuperFIN. Платформа Intel Atom x6000E (Elkhart Lake) универсальна и позволяет решать широкий круг задач. Она может применяться в производящей промышленности и энергетике, в системах управления «умного города», в здравоохранении и медицине и во многих других отраслях, где требуется обработка достаточно серьёзных входных потоков данных в реальном времени. При этом платформа отвечает самым строгим требованиям безопасности.  По сравнению с предыдущими процессорами Atom аналогичного назначения в серии x6000E однопоточная производительность возросла в 1,7 раза, многопоточная — в 1,5 раза, а производительность графической подсистемы вдвое. Для повышенной временной точности в новинках реализована поддержка технологий Intel Time Coordinated Computing (TCC) и Time-Sensitive Networking (TSN).  Как и полагается современной SoC для периферийных вычислений, в составе x6000E имеются блоки критографических ускорителей, а для IoT имеется интегрированный микроконтроллер ARM Cortex-M7, отвечающий за работу Intel Programmable Services Engine (Intel PSE). Он работает независимо от остальных блоков и предоставляет возможности удалённого управления SoC, обработки низкоскоростного ввода-вывода от различных сенсоров, запуск приложений реального времени и синхронизацию. Есть также и чисто аппаратные средства обеспечения ИТ-безопасности, объединённые под именем Intel Safety Island.  Также в целях обеспечения надёжности реализован широкий спектр средств удалённого мониторинга и управления, как в режиме in-band, так и в out-of-band. Включение, выключение, сброс и перезагрузку можно выполнять даже если система в целом не отвечает. Модели Atom x6427FE и x6200FE отвечают стандартам функциональной безопасности IEC 61508 и ISO 13849, они прошли соответствующую сертификацию, так что использовать их можно и в системах жизнеобеспечения, в комплексах управления АЭС или нефтеперабатывающего предприятия.  Серия Intel Atom x6000E включает в себя процессоры с двумя или четырьмя ядрами, их частотный диапазон составляет от 1,0 до 1,9 ГГц, в турборежиме частота может временно увеличиваться до 3,0 ГГц. Аналогичные частотные формулы имеют и Pentium/Celeron, базирующиеся на ядрах Tiger Lake (11 поколение). Контроллер памяти может работать либо с LPDDR4x (4×32 бита, максимум 4267 Мт/с, 16 Гбайт при 3200 МГц, всего до 64 Гбайт) или DDR4 (2×64 бита, 3200 Мт/с, максимум 32 Гбайт, всего до 64 Гбайт), есть поддержка in-band ECC для обычных модулей без ECC. Объём кеша составляет 1 Мбайт у самой младшей модели, во всех остальных случаях он равен 1,5 Мбайт.  В соответствии с современными требованиями к графике, новинки Atom поддерживают подключение до трёх независимых дисплеев с разрешением 4K при 60 Гц, для этого служат интерфейсы Display Port 1.3 и HDMI 2.0b. Также поддерживается подключение экранов по eDP или MIPI DSI. Сам графический движок Intel UHD Graphics может иметь конфигурацию с 16 или 32 исполнительными блоками, работающими на частоте до 400 МГц, а в турборежиме — и до 800 МГц. Они поддерживают различные режимы вычислений для работы в качестве инференс-системы. Новые SoC Intel выполнены в едином корпусе FCBGA1493, однако под крышкой скрываются два кристалла — вычислительный и PCH.  У более мощных процессоров с ядрами Tiger Lake графика тоже намного мощнее, она представлена блоками Iris Xe, которых в составе чипа может быть до 96, к тому же новая графическая архитектура лучше подходит для систем принятия решений (инференс) и задач машинного зрения. Такая графическая подсистема может одновременно обрабатывать до 40 потоков видео в формате 1080p при 30 кадрах в секунду, а выводить — либо четыре потока 4K, либо два, но уже в 8K. Подобные мощности позволяют использовать Tiger Lake в системах, для которых требуется детерминированная, строго синхронизированная по времени работа, либо в гибких системах машинного зрения с ИИ-компонентами. Безопасности способствует возможность полного шифрования содержимого оперативной памяти.  Коммуникационные возможности новых промышленных процессоров Intel также соответствуют требованиям времени: новые SoC несут на борту три MAC-контроллера, способных работать на скорости 2,5 Гбит/с, причём, в моделях с поддержкой TSN обеспечивается режим реального времени с минимальными задержками. Также общение «с внешним миром» происходит посредством 8 линий PCI Express 3.0, четырех портов USB 3.1 и 10 портов USB 2.0. Имеется два порта для подключения флеш-накопителей с интерфейсом UFS 2.0. В референсной платформе Intel реализована и поддержка UART и JTAG (разъём MIPI-60).  У более мощных Tiger Lake из серий i3/i5/i7 возможности несколько иные: встроенных MAC два, один из которых работает в режиме 1GbE, другой поддерживает cкорость 2,5GbE, в некоторых моделях дополнен поддержкой Time-Sensitive Networking. Поддерживается подключение дискретного сетевого контроллера I225LM/IT. Что касается беспроводной части, то имеется поддержка Wi-Fi со скоростями до 1,73 Гбит/с, а также Bluetooth 5.0. Для расширения инференс-способностей поддерживается подключение дополнительного ускорителя Intel из серии Movidius. Также реализованы стандарты PCIe 4.0 (четыре линии) и Thunderbolt/USB 4 (четыре порта).  Теплопакеты достаточно скромные: от 4,5 до 12 Ватт у Atom, до 28 Ватт у Tiger Lake. Улучшенный техпроцесс позволяет последним быть существенно быстрее аналогичных Core 8 поколения, в зависимости от характера нагрузки это до 23% (однопоточная) или до 19% (многопоточная), а графическая подсистема и вовсе практически в три раза быстрее за счёт новой архитектуры.  Новые процессоры имеют широкий спектр программной поддержки. В первую очередь, это, естественно, Microsoft Windows 10 IoT Enterprise и Yocto Project Linux, разрабатываемая сообществом Yocto совместно с Intel. Поддерживается также запуск Ubuntu, Wind River Linux LTS и Android 10 (только 64-битная версия). Для Tiger Lake также заявлена совместимость с Wind River VxWorks.  В качестве загрузчика может использоваться как обычный BIOS/UEFI, так и открытые Intel Slim Bootloader и coreboot. Часть, отвечающая за подсистемы безопасности и реального времени, работает под управлением Zephyr RTOS, также открытой. В число партнёров Intel, отвечающих за код BIOS, входят American Metatrends, Thundersoft, Byosoft, Insyde и Phoenix.  Для создания ПО компания предлагает расширенный комплект разработчика: инструменты для реализации Time Coordinated Computing, Intel Media SDK, набор Intel для OpenVINO, Intel System Studio и Intel Context Sensing SDK. Intel понимает всю важность рынка периферийных вычислений, за которым, судя по всему, будущее промышленности: любая производственная задача будет неизбежно порождать серьёзные потоки данных и требовать от системы управления минимальных задержек. Именно поэтому периферийные вычислительные устройства, к которым относятся и новые процессоры Intel, столь важны. Неудивительно, что компания уделяет много внимания как аппаратным возможностям, так и программным компонентам в новой платформе. ИИ-ускоритель Qualcomm Cloud AI 100 обещает быть быстрее и экономичнее NVIDIA T4

18.09.2020 [15:55],

Алексей Степин

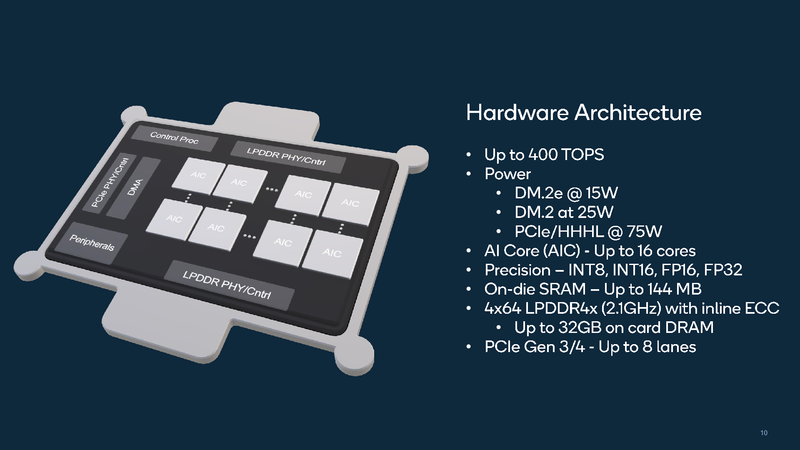

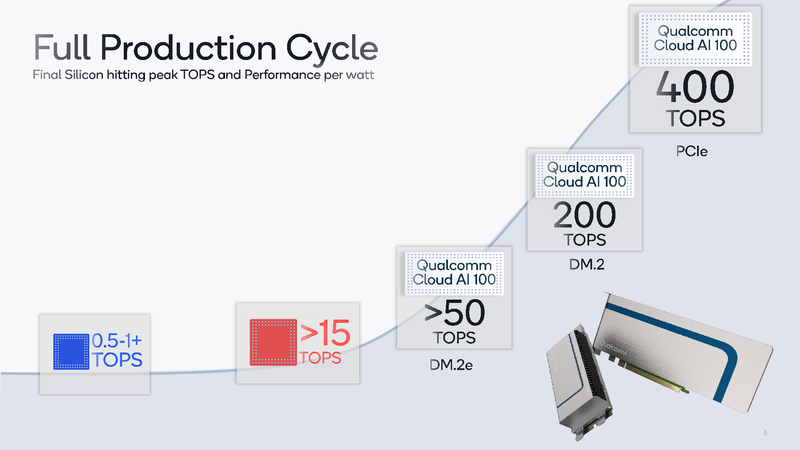

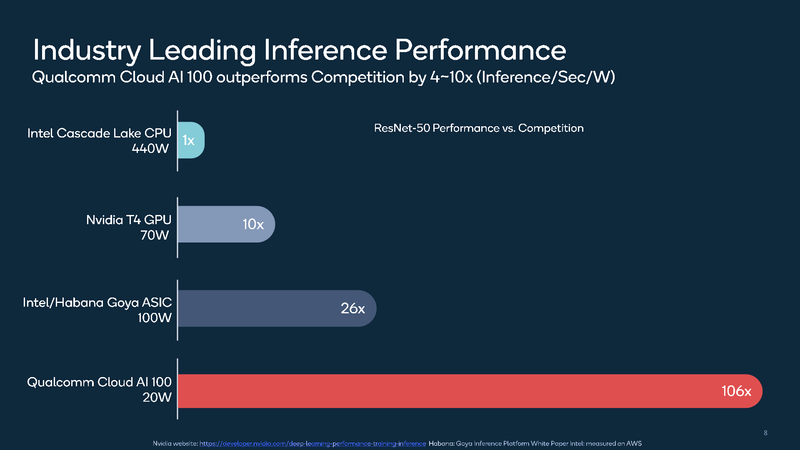

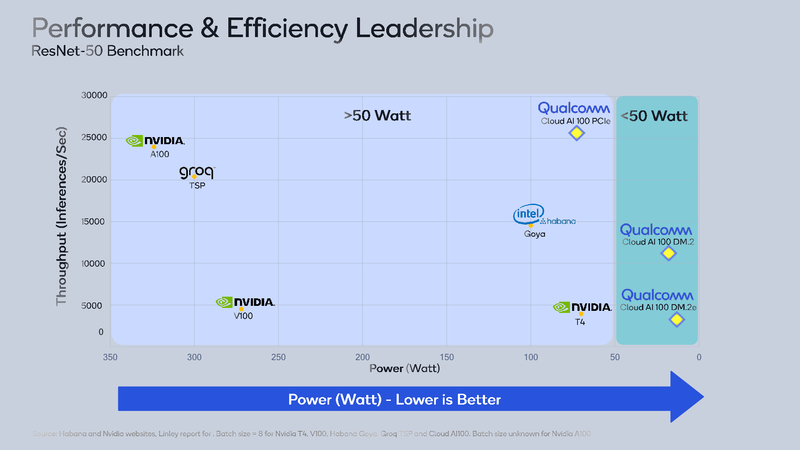

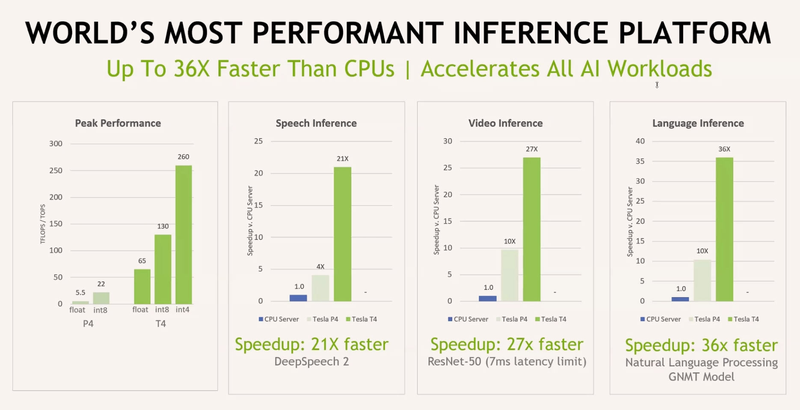

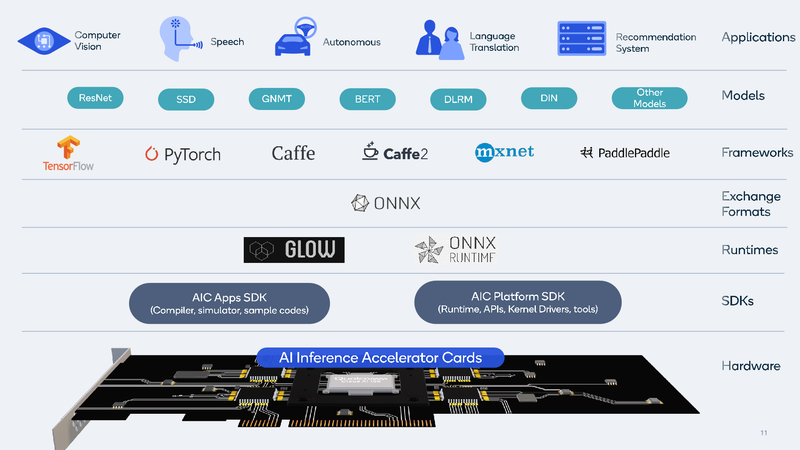

Ускорители работы с нейросетями делятся, грубо говоря, на две категории: для обучения и для исполнения (инференса). Именно для последнего случая важна не столько «чистая» производительность, сколько сочетание производительности с экономичностью, так как работают такие устройства зачастую в стеснённых с точки зрения питания условиях. Компания Qualcomm предлагает новые ускорители Cloud AI 100, сочетающие оба параметра.  Сам нейропроцессор Cloud AI 100 был впервые анонсирован ещё весной прошлого года, и Qualcomm объявила, что этот чип разработан с нуля и обеспечивает вдесятеро более высокий уровень производительности в пересчёте на ватт, в сравнении с существовавшими на тот момент решениями. Начало поставок было запланировано на вторую половину 2019 года, но как мы видим, по-настоящему ускорители на базе данного чипа на рынке появились только сейчас, причём речь идёт о достаточно ограниченных, «пробных» объёмах поставок.  В отличие от графических процессоров и ПЛИС-акселераторов, которые часто применяются при обучении нейросетей и, будучи универсальными, потребляют при этом серьёзные объёмы энергии, инференс-чипы обычно представляют собой специализированные ASIC. Таковы, например, Google TPU Edge, к этому же классу относится и Cloud AI 100. Узкая специализация позволяет сконцентрироваться на достижении максимальной производительности в определённых задачах, и Cloud AI 100 более чем в 50 раз превосходит блок инференс-процессора, входящий в состав популярной SoC Qualcomm Snapdragon 855.  На приводимых Qualcomm слайдах архитектура Cloud AI 100 выглядит достаточно простой: чип представляет собой набор специализированных интеллектуальных блоков (IP, до 16 юнитов в зависимости от модели), дополненный контроллерами LPDDR (4 канала, до 32 Гбайт, 134 Гбайт/с), PCI Express (до 8 линий 4.0), а также управляющим модулем. Имеется некоторый объём быстрой набортной SRAM (до 144 Мбайт). С точки зрения поддерживаемых форматов вычислений всё достаточно универсально: реализованы INT8, INT16, FP16 и FP32. Правда, bfloat16 не «доложили».  Об эффективности новинки говорят приведённые самой Qualcomm данные: если за базовый уровень принять систему на базе процессоров Intel Cascade Lake с потреблением 440 Ватт, то Qualcomm Cloud AI 100 в тесте ResNet-50 быстрее на два порядка при потреблении всего 20 Ватт. Это, разумеется, не предел: на рынок новый инференс-ускоритель может поставляться в трёх различных вариантах, два из которых компактные, форм-факторов M.2 и M.2e с теплопакетами 25 и 15 Ватт соответственно. Даже в этих вариантах производительность составляет 200 и около 500 Топс (триллионов операций в секунду), а существует и 75-Ватт PCIe-плата формата HHHL производительностью 400 Топс; во всех случаях речь идёт о режиме INT8.

Данные для NVIDIA Tesla T4 и P4 приведены для сравнения Основными конкурентами Cloud AI 100 можно назвать Intel/Habana Gaia и NVIDIA Tesla T4. Оба этих процессора также предназначены для инференс-систем, они гибче архитектурно — особенно T4, который, в сущности, базируется на архитектуре Turing —, однако за это приходится платить как ценой, так и повышенным энергопотреблением — это 100 и 70 Ватт, соответственно. Пока речь идёт о распознавании изображений с помощью популярной сети ResNet-50, решение Qualcomm выглядит великолепно, оно на голову выше основных соперников. Однако в иных случаях всё может оказаться не столь однозначно.

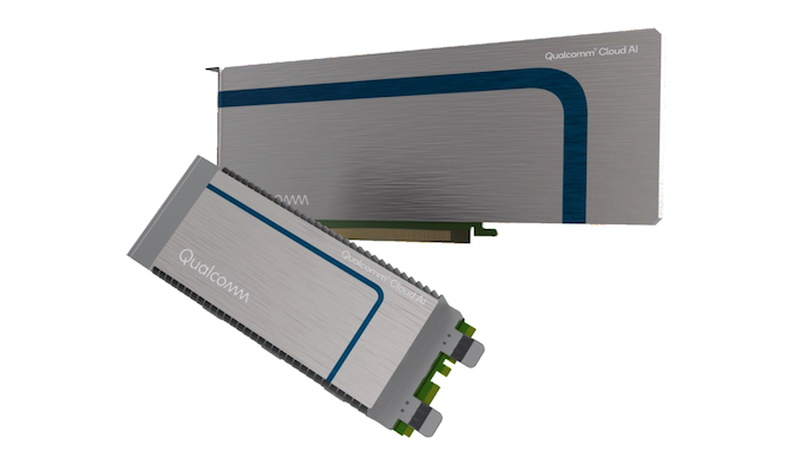

Новые ускорители Qualcomm будут доступны в разных форм-факторах Как T4, так и Gaia, а также некоторые другие решения, вроде Groq TSP, за счёт своей гибкости могут оказаться более подходящим выбором за пределами ResNet в частности и INT8 вообще. Если верить Qualcomm, то компания в настоящее время проводит углублённое тестирование Cloud AI 100 и на других сценариях в MLPerf, но в открытом доступе результатов пока нет. Разработчики сосредоточены на удовлетворении конкретных потребностей заказчиков. Также заявлено о том, что высокая производительность на крупных наборах данных может быть достигнута путём масштабирования — за счёт использования в системе нескольких ускорителей Cloud AI 100.  В настоящее время для заказа доступен комплект разработчика на базе Cloud Edge AI 100. Основная его цель заключается в создании и отработке периферийных ИИ-устройств. Система достаточно мощная, она включает в себя процессор Snapdragon 865, 5G-модем Snapdragon X55 и ИИ-сопроцессор Cloud AI 100. Выполнено устройство в металлическом защищённом корпусе с четырьмя внешними антеннами. Начало крупномасштабных коммерческих поставок намечено на первую половину следующего года. TSMC и Graphcore создают ИИ-платформу на базе технологии 3 нм

27.08.2020 [19:13],

Алексей Степин

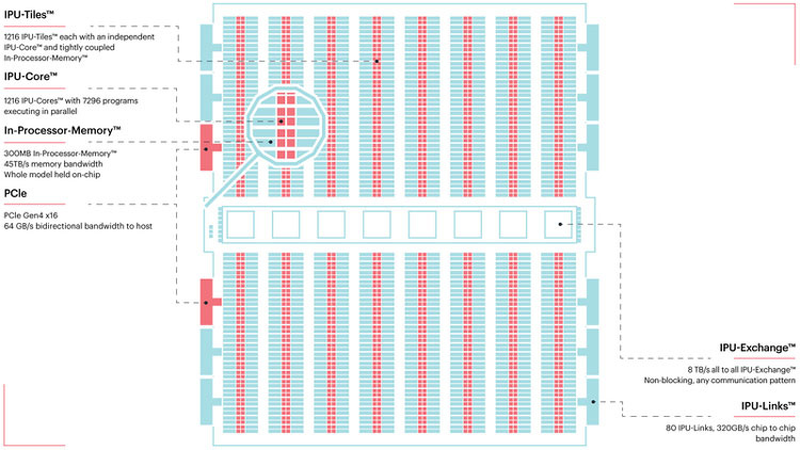

Несмотря на все проблемы в полупроводниковой индустрии, технологии продолжают развиваться. Технологические нормы 7 нм уже давно не являются чудом, вовсю осваиваются и более тонкие нормы, например, 5 нм. А ведущий контрактный производитель, TSMC, штурмует следующую вершину — 3-нм техпроцесс. Одним из первых продуктов на базе этой технологии станет ИИ-платформа Graphcore с четырьмя IPU нового поколения. Британская компания Graphcore разрабатывает специфические ускорители уже не первый год. В прошлом году она представила процессор IPU (Intelligence Processing Unit), интересный тем, что состоит не из ядер, а из так называемых тайлов, каждый из которых содержит вычислительное ядро и некоторое количество интегрированной памяти. В совокупности 1216 таких тайлов дают 300 Мбайт сверхбыстрой памяти с ПСП до 45 Тбайт/с, а между собой процессоры IPU общаются посредством IPU-Link на скорости 320 Гбайт/с.

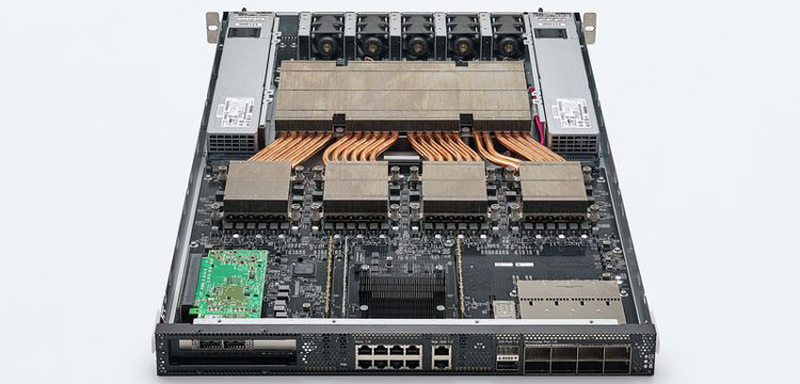

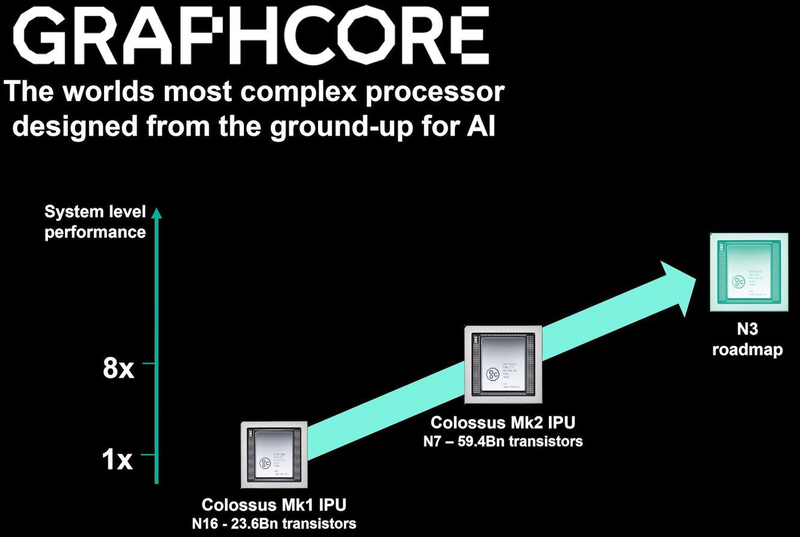

Colossально: ИИ-сервер Graphcore с четырьмя IPU на борту Компания позаботилась о программном сопровождении своего детища, снабдив его стеком Poplar, в котором предусмотрена интеграция с TensorFlow и Open Neural Network Exchange. Разработкой Graphcore заинтересовалась Microsoft, применившая IPU в сервисах Azure, причём совместное тестирование показало самые положительные результаты. Следующее поколение IPU, Colossus MK2, представленное летом этого года, оказалось сложнее NVIDIA A100 и получило уже 900 Мбайт сверхбыстрой памяти. Машинное обучение, в основе которого лежит тренировка и использование нейронных сетей, само по себе требует процессоров с весьма высокой степенью параллелизма, а она, в свою очередь, автоматически означает огромное количество транзисторов — 59,4 млрд в случае Colossus MK2. Поэтому освоение новых, более тонких и экономичных техпроцессов является для этого класса микрочипов ключевой задачей, и Graphcore это понимает, заявляя о своём сотрудничестве с TSMC.

Тайловая архитектура Graphcore Colossus MK2 В настоящее время TSMC готовит к началу «рискового» производства новый техпроцесс с нормами 3 нм, причём скорость внедрения такова, что первые продукты на его основе должны увидеть свет уже в 2021 году, а массовое производство будет развёрнуто во второй половине 2022 года. И одним из первых продуктов на базе 3-нм технологических норм станет новый вариант IPU за авторством Graphcore, известный сейчас как N3. Судя по всему, использовать 5 нм британский разработчик не собирается.

В планах компании явно указано использование 3-нм техпроцесса В настоящее время чипы Colossus MK2 производятся с использованием техпроцесса 7 нм (TSMC N7). Они включают в себя 1472 тайла и способны одновременно выполнять 8832 потока. В режиме тренировки нейросетей с использованием вычислений FP16 это даёт 250 Тфлопс, но существует удобное решение мощностью 1 Пфлопс — это специальный 1U-сервер Graphcore, в нём четыре IPU дополнены 450 Гбайт внешней памяти. Доступны также платы расширения PCI Express c чипами IPU на борту. Дела у Graphcore идут неплохо, её технология оказалась востребованной и среди инвесторов числятся Microsoft, BMW, DeepMind и ряд других компаний, разрабатывающих и внедряющих комплексы машинного обучения. Разработка 3-нм чипа ещё более упрочнит позиции этого разработчика. Более тонкие техпроцессы существенно увеличивают стоимость разработки, но финансовые резервы у Graphcore пока есть; при этом не и исключён вариант более тесного сотрудничества, при котором часть стоимости разработки возьмёт на себя TSMC. Серверные ARM-процессоры Marvell ThunderX3: 60 ядер в SCM, 96 ядер в MCM, SMT4 в подарок

18.08.2020 [22:16],

Алексей Степин

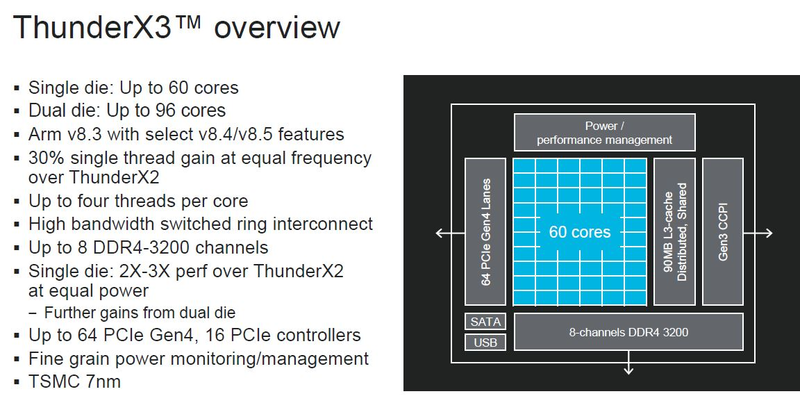

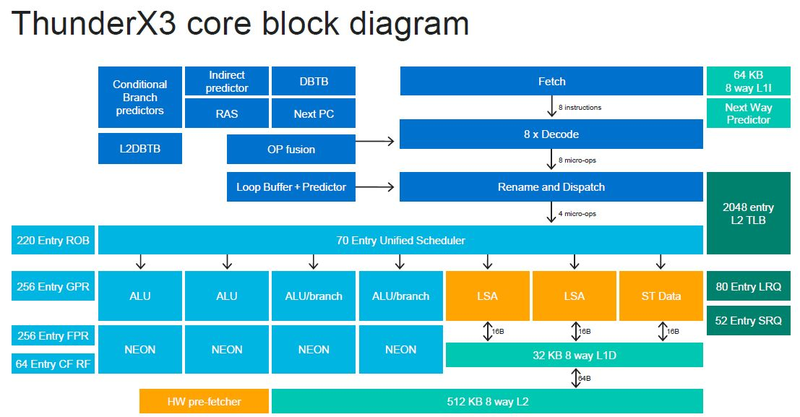

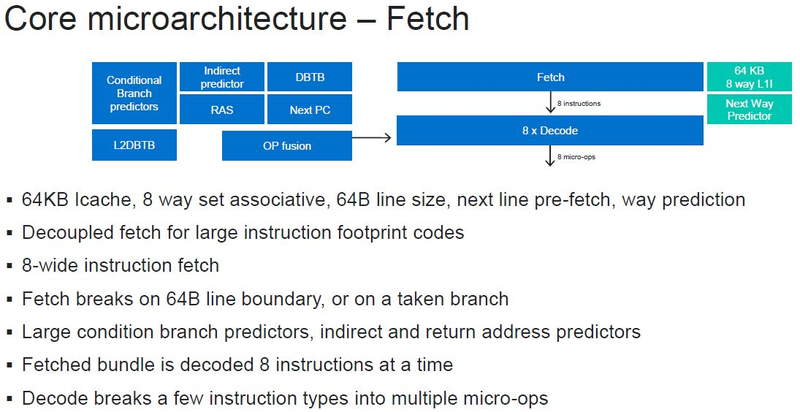

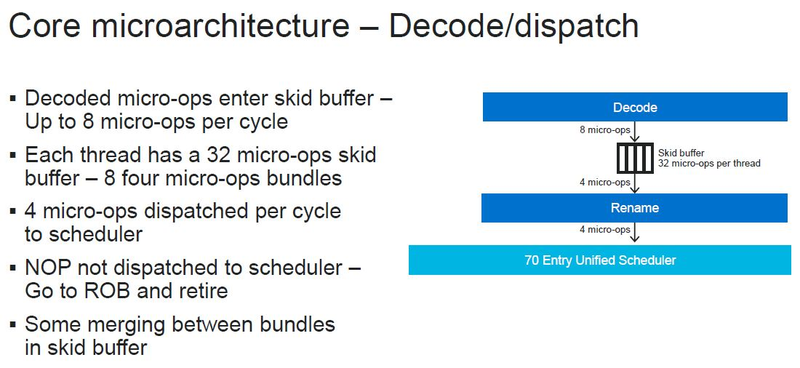

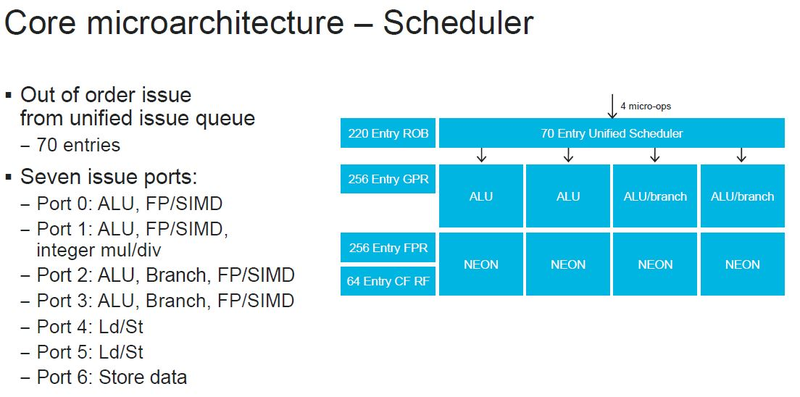

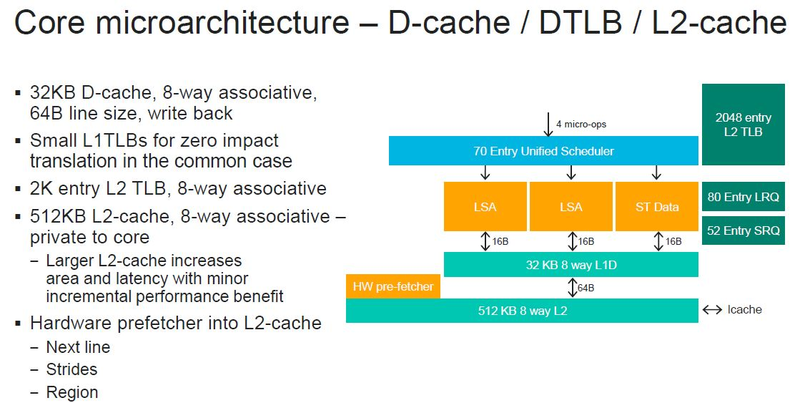

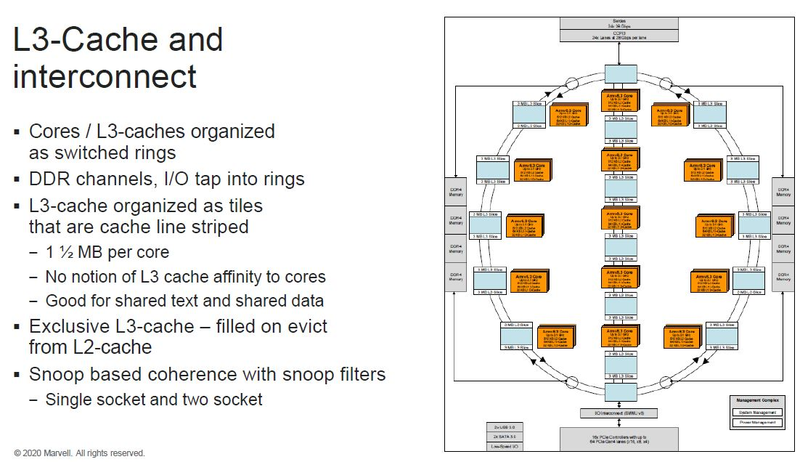

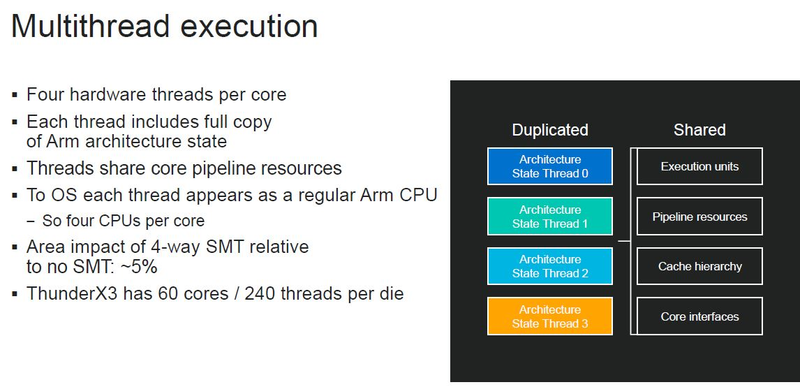

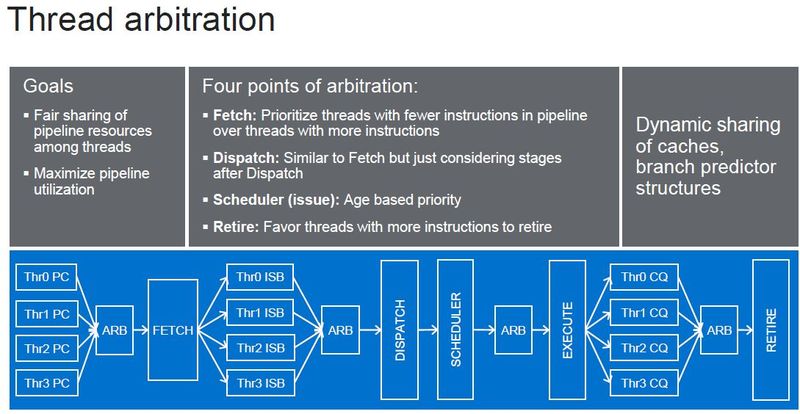

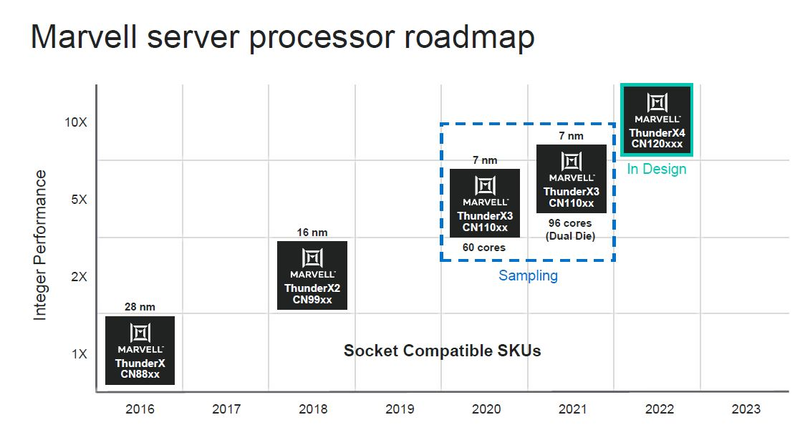

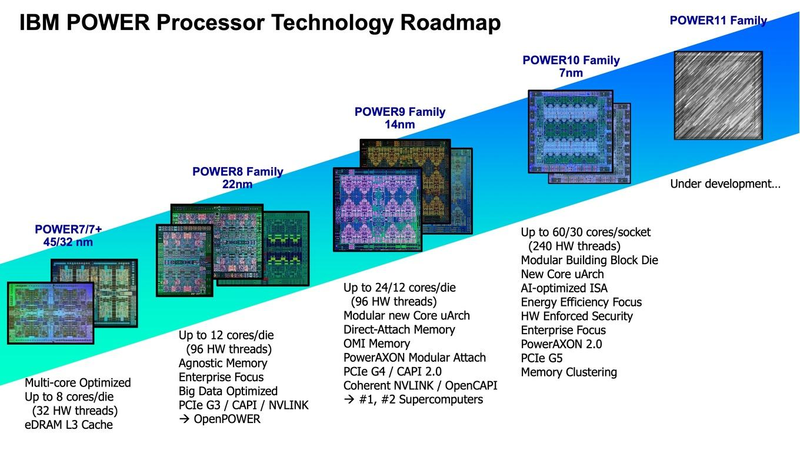

Последние дни оказались богатыми на анонсы новых процессоров. Компания IBM представила новейшие POWER10 с поддержкой памяти OMI DDR5 и PCI Express 5.0, Intel анонсировала Xeon Ice Lake-SP, которые, наконец, получили поддержку PCIe 4.0. Третьей в этом списке можно назвать Marvell, которая на мероприятии Hot Chips 32 рассказала подробности о последнем, третьем поколении ARM-процессоров ThunderX, формально анонсированном ещё весной этого года.

Источник изображений: ServeTheHome Процессоры с архитектурой ARM покорили сегмент мобильных устройств, но в последние несколько лет интереснее другая тенденция — данная архитектура ложится в основу всё новых и новых «крупных» процессоров, предназначенных для серверного применения. И как показывает практика, когда-то считавшаяся «слабой» архитектура оказывается вовсе не такой.  Она успешно соперничает с x86, особенно там, где необходима высокая плотность упаковки вычислительных мощностей и высокая энергоэффективность. Примеры AWS Graviton2 и кастомных процессоров Google тому доказательством, а разработка Fujitsu, процессор A64FX, и вовсе лежит в основе мощнейшего суперкомпьютера планеты, японского кластера Fugaku.  Одной из компаний, прилагающих серьёзные усилия к освоению серверного рынка с помощью архитектуры ARM, является Marvell. Если первые процессоры ThunderX, доставшиеся в наследство от Broadcom, сложно назвать успешным, то уже второе поколение показало себя неплохо, и, судя по всему, третье, наконец, готово к массовому внедрению. Напомним, в отличие от домашних проектов AWS и Google, процессоры ThunderX3 должны получить развитую поддержку многопоточности, на уровне SMT4, что больше, чем у x86, но меньше, чем у POWER10.  При этом максимальное количество ядер у ThunderX3 впечатляет. Теперь известно, что о 96 ядрах речь идёт только в двухкристалльной компоновке (этим подход Marvell напоминает IBM POWER10, также существующий в двух вариантах). Один кристалл может нести до 60 ядер, что меньше, чем у Graviton2, но, во-первых, ненамного, а во-вторых, с лихвой компенсируется наличием SMT. SMT4 может дать 240 или 384 потока в зависимости от версии, и наверняка это понравится крупным облачным провайдерам, поскольку позволит разместить беспрецедентное количество VM в рамках одного сокета.  Однопоточная производительность не осталась без внимания. Компания заявила о 30% превосходстве над ThunderX2 в пересчёте на поток. В целом же, третье поколение ThunderX должно быть в 2-3 раза быстрее второго. Архитектурно процессор основывается на наборе инструкций ARM v8.3, однако сказано о частичной поддержке ARM v8.4/8.5.  В споре о том, что эффективнее для связи ядер между собой, кольцевые шины или единая mesh-сеть, единого мнения нет. Intel предпочитает первый подход, но Marvell остановила свой выбор на втором. Как обычно, на внешнем кольце расположены кеш (80 Мбайт L3 на кристалл), блоки управление питанием, а также контроллеры памяти, PCI Express и межпроцессорной шины (в данном случае CCPI).  Поддержка SMT4 реализована полностью аппаратно. С точки зрения операционной системы каждый поток ThunderX3 выглядит, как обычный процессор с архитектурой ARM. При этом реализация столь развитой многопоточности привела всего лишь к 5% увеличению площади кристалла в сравнении с однопоточной реализацией.  Разделение ресурсов ядра у нового процессора динамическое, осуществляется оно в четырёх точках: выборка, когда потока с меньшим количеством инструкций получают более высокий приоритет; выполнение, работающее по такому же принципу; планирование, которое базируется на «возрасте» потока; наконец, «отставка» — здесь приоритет получают потоки с наибольшим количеством инструкций. Оптимизация многопоточности позволяет Marvell говорить о практически линейной масштабируемости новых процессоров, по крайней мере, в пределах одного разъёма. В зависимости от числа инструкций на ядро коэффициент прироста может варьироваться от x1,28 до 2,21.  Подсистема ввода-вывода у новинок достаточно развитая. Контроллер памяти имеет 8 каналов и поддерживает DDR4-3200. За поддержку PCI Express отвечают 16 раздельных контроллеров, поддерживающих четвёртую версию стандарта. Это должно обеспечивать высокий уровень производительности при подключении 16 NVMe-накопителей, на каждый из которых придётся по четыре линии PCIe.  Заявлено о «тонком» управлении питанием, но деталей Marvell не приводит и остаётся только догадываться, насколько эта подсистема ThunderX3 продвинута. Производится новый процессор на мощностях TSMC с использованием техпроцесса 7 нм. Версия с одним 60-ядерным кристаллом выйдет на рынок уже в этом году, а вариант с двумя кристаллами и большим общим количеством ядер начнет поставляться позже, в 2021 году. Компания уже работает над ThunderX4, ожидается что эти процессоры будут использовать техпроцесс 5 нм и увидят свет в 2022 году. Подробности о процессорах IBM POWER10: SMT8, OMI DDR5, PCIe 5.0 и PowerAXON 2.0

17.08.2020 [15:32],

Алексей Степин

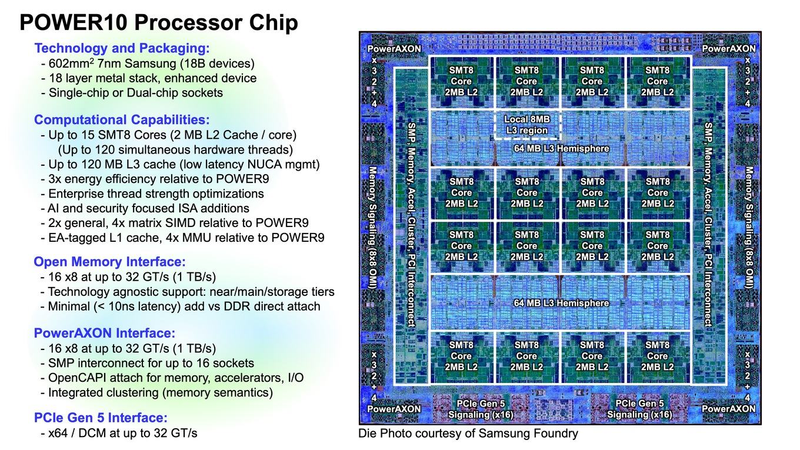

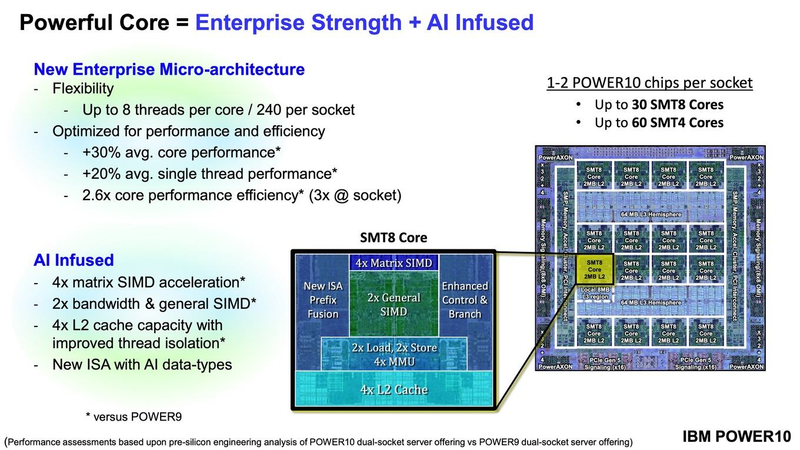

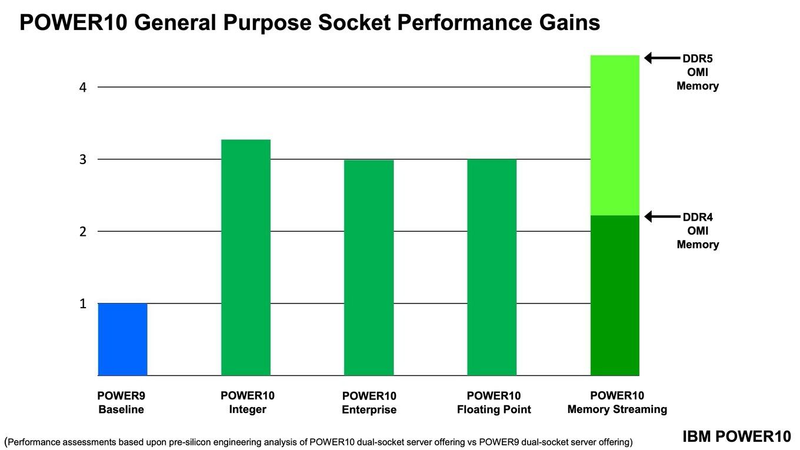

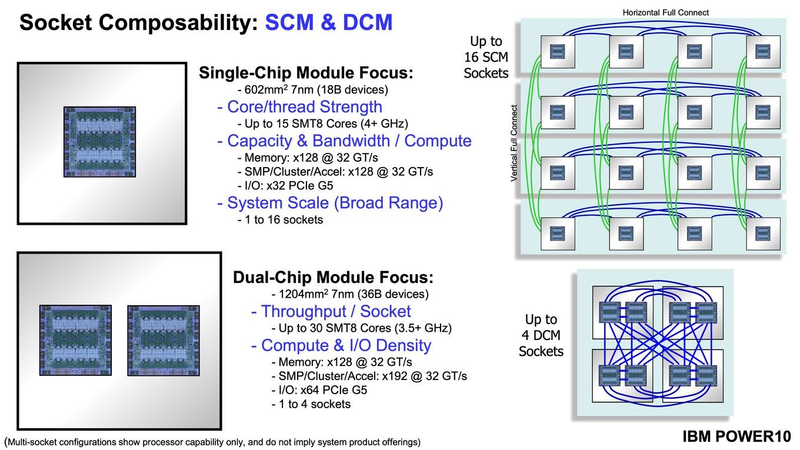

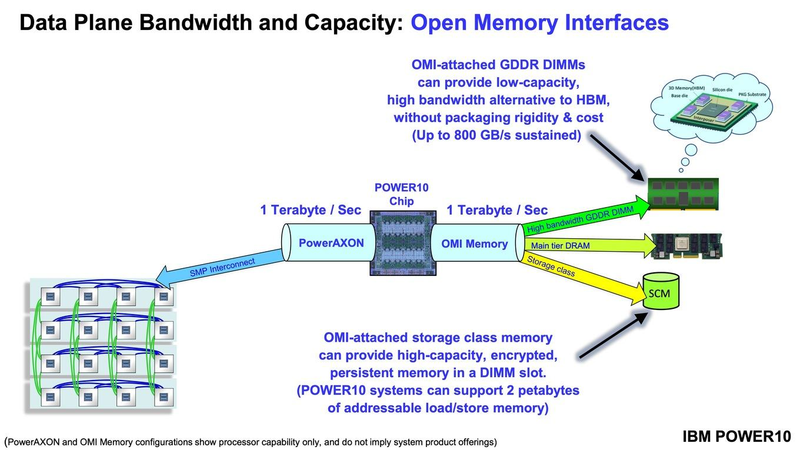

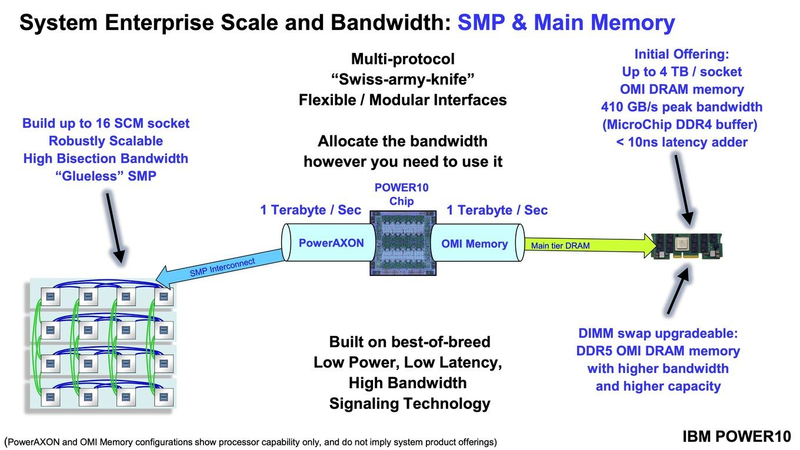

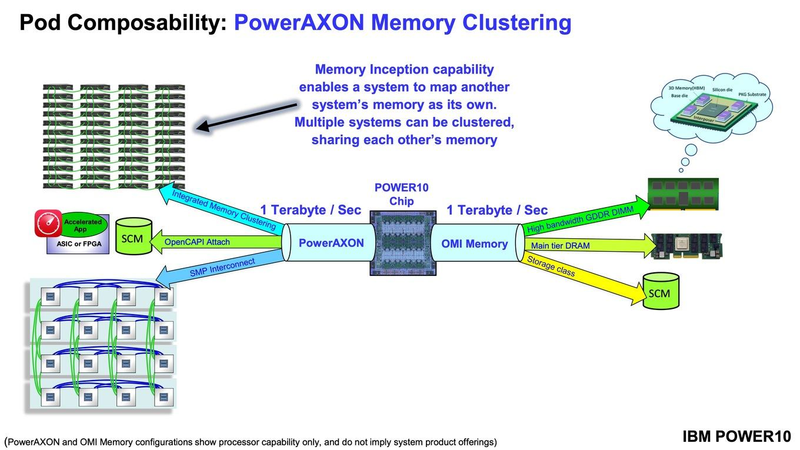

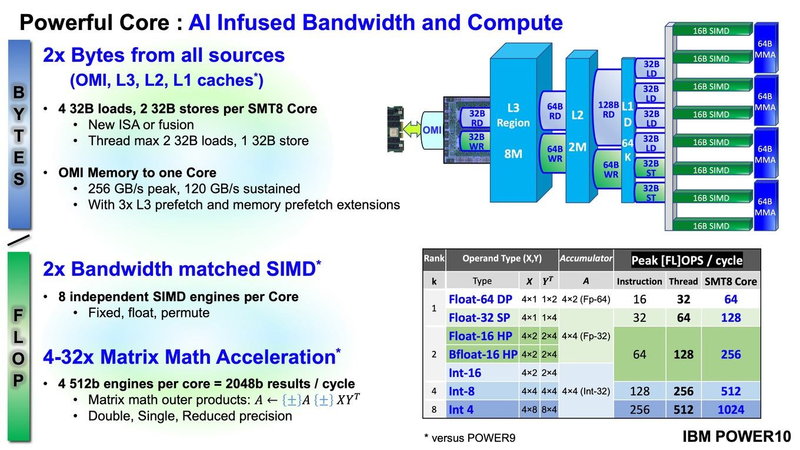

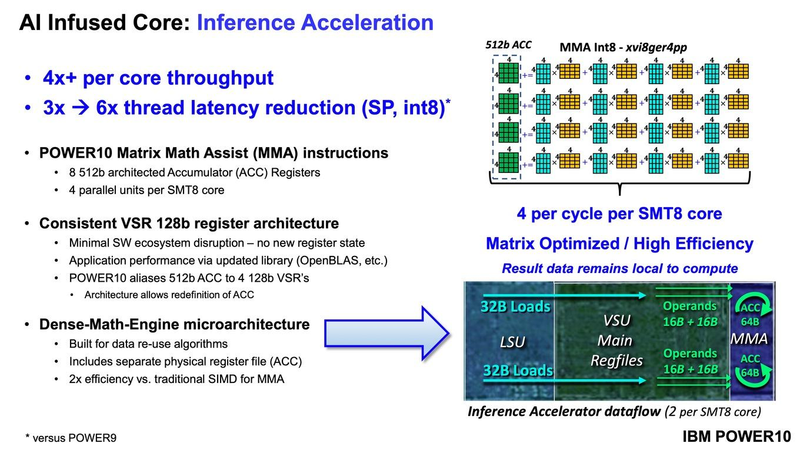

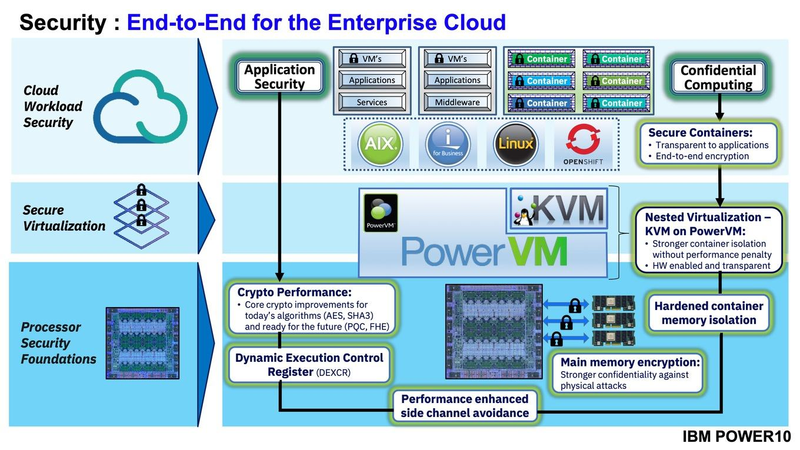

Мы внимательно следим за судьбой и развитием архитектуры POWER, которая наряду с ARM представляет определённую угрозу для x86 в сфере серверов и суперкомпьютеров — недаром одна из самых мощных в мире HPC систем, суперкомпьютер Ок-Риджской национальной лаборатории Summit, использует процессоры POWER9. Ранее ожидалось что по ряду причин выход следующей в семействе архитектуры, POWER10, откладывается до 2021 года, хотя IBM и продвигала активно новые решения вроде универсального стандарта оперативной памяти OMI. Однако официальный анонс IBM POWER10 состоялся сегодня, а немецкий портал Hardwareluxx выложил слайды презентации компании.  Как компания уже отмечала ранее, она делает упор на большие системы и гибридные облака. С учётом этих тенденций и были разработаны новые процессоры. Поскольку в крупных облачных ЦОД упаковка вычислительных плотностей достигает уже невиданного ранее уровня, всё острее встаёт вопрос с энергоэффективностью и отводом тепла. Но именно здесь, как считает IBM, POWER10 и должен показать себя с наилучшей стороны — новые процессоры производятся с использованием 7-нм техпроцесса и могут демонстрировать трёхкратное преимущество в энергоэффективности в сравнении с POWER9.  POWER10 — первый коммерческий процессор IBM, использующий нормы производства 7 нм; любопытно, что теперь Intel отстаёт не только от AMD, которая стала пионером в использовании столь тонкого техпроцесса в «крупных» серверных процессорах, но и от IBM. В отличие от AMD EPYC, производимых на мощностях TSMC, новинки IBM «куются» в полупроводниковых кузнях Samsung. Площадь кристалла, состоящего из 18 миллиардов транзисторов, у новых процессоров достигает 602 мм2, что меньше, чем у новейших графических ядер, но всё равно цифра довольно солидная.  Техпроцесс POWER10 является совместной разработкой Samsung и IBM. В нём реализованы некие особенности, которые, предположительно, должны позитивно сказаться на характеристиках отдельных транзисторов. Не забыта и мода на установку нескольких кристаллов в один корпус: POWER10 доступны как в классическом варианте (SCM), так и в виде сборки из двух кристаллов (DCM), так что для каждого сценария использования можно выбрать подходящий вариант. В варианте SCM тактовая частота ядер составляет 4 ГГц, количество процессорных разъёмов в системе может достигать 16. В версии DCM частота снижена до 3,5 ГГц.  Базовый кристалл POWER10 имеет 16 вычислительных ядер, хотя используется из них только 15, каждое ядро дополнено 2 Мбайт кеша L2, а общий объём кеша L3 может достигать внушительных 120 Мбайт. Степень параллелизма была увеличена с SMT4 до SMT8, так что процессор может исполнять одновременно до 120 потоков, хотя, естественно, не в любой задаче такое распараллеливание ресурсов ядер будет эффективным. Производительность блоков SIMD была существенно увеличена, они вдвое быстрее аналогичных блоков POWER9, а на матричных операциях — быстрее в четыре раза.  За общение процессора с «внешним миром» отвечают интерфейсы PowerAXON 2.0 и PCI Express 5.0, в первом случае поддерживается открытый стандарт OpenCAPI, во втором реализовано 64 линии со скоростью 32 ГТ/с на линию, как и предписано стандартом. Компоновка связей у DCM и SCM разная. В первом случае сокетов может быть только 4, зато используется топология «каждый с каждым», а вот в 16-сокетном варианте SCM «по диагонали» между собой процессоры напрямую не общаются.  Интерфейс PowerAXON универсален, он использовался, в числе прочего, для реализации протокола NVLink для подключения ускорителей на базе графических процессоров NVIDIA. Проблем с пропускной способностью быть не должно, у каждого процессора в системе PowerAXON обеспечивает до 1 Тбайт/с. Кроме подключения ускорителей и общения процессоров между собой, у PowerAXON есть и ещё одно интересное и важное применение, о котором ниже.  О преимуществах унифицированного интерфейса OMI, позволяющего «малой кровью» модернизировать подсистему памяти, мы уже рассказывали читателям ранее. В новом процессоре эти возможности задействованы полностью. Каждый базовый кристалл POWER10 имеет 16 линков OMI x8, общая пропускная способность достигает 1 Тбайт/с. Латентность, разумеется, возросла, поскольку контроллер DDR у OMI, по сути, внешний, но прирост небольшой и составляет менее 10 наносекунд. Универсальность и возможность модернизации этот недостаток искупают с лихвой. В текущем варианте пиковая пропускная способность достигает 410 Гбайт/с на разъём, объём — 4 Тбайт на разъём, однако с внедрением более быстрых типов памяти (DDR5, GDDR или даже HBM) может быть достигнута цифра 800 Гбайт/с на разъём. Отдельно упоминается возможность работы с SCM, но без конкретики. На данный момент такая память массово представлена только 3D XPoint в виде Intel Optane DCPMM.  Любопытна технология Memory Clustering. С помощью PowerAXON система может обращаться к оперативной памяти в другой системе, как к собственной. Латентность при этом составляет 50 ‒ 100 нс, для систем типа NUMA совсем немного. Общий объем на одну систему POWER10 может достигать 2 Пбайт; с учётом применения систем IBM для запуска таких «пожирателей памяти», как SAP HANA такие объемы очень к месту.  Следуя текущей моде на машинное обучение, разработчики реализовали в POWER10 развитую поддержку форматов вычислений, отличных от традиционных FP32/64. Блок плавающих вычислений в новом процессоре носит название Matrix Math Accelerator. В сравнении с POWER9 он быстрее в 10, 15 и 20 раз в режимах FP32, BFloat16 и INT8 соответственно. Иными словами, именно для инференс-систем POWER10 станет хорошим выбором.  Поскольку одним из применений POWER10 компания видит облачные комплексы, серьёзное внимание уделено обеспечению безопасности. Новые процессоры поддерживают полное шифрование содержимого оперативной памяти, а для ускорения криптографических процедур в их составе есть соответствующие аппаратные блоки, причём не только для широко распространённого стандарта AES. Они достаточно гибки, чтобы поддерживать и шифрование будущего класса quantum safe. Также поддерживается защита и изоляция контейнеров на аппаратном уровне. Успешная атака на один контейнер в пределах машины не означает и успеха с другими контейнерами.  В качестве программной основы IBM предлагает Red Hat OpenShift, и архитектура POWER10 была соответствующим образом оптимизирована, чтобы показывать наилучшие результаты именно с этой средой. В целом, можно уверенно сказать: новые процессоры Голубого Гиганта получились интересными и весьма достойно выглядящими решениями даже на фоне успеха AMD EPYC. Официальный анонс состоялся сегодня, но развёртывание массового производства должно занять определённое время, так что появления первых серверов на базе IBM POWER10 стоит ожидать не ранее начала следующего, 2021 года. А планы компании говорят о том, что POWER11 уже находится в разработке. ARM-процессоры NUVIA Phoenix обещают быть быстрее и энергоэффективнее AMD EPYC и Intel Xeon

12.08.2020 [01:04],

Илья Коваль

Мощными серверными ARM-процессорами сейчас уже никого не удивить: A64FX трудятся в самом быстром в мире суперкомпьютере Fugaku, ThunderX и Altra стараются быть универсальными, а Graviton2 осваивается в облаке Amazon. Вот с последним как раз и хочет побороться NUVIA, молодой, но перспективный разработчик процессоров. SoC NUVIA Orion, в составе которого будет ARM-процессор Phoenix, ориентирован в первую очередь на облачных провайдеров и гипескейлеров, то есть на весьма «жирный» кусок рынка серверных процессоров, где сейчас доминирует Intel и архитектура x86-64 вообще. В этом сегменте, где число активных серверов исчисляется миллионами, крайне важны не расходы на закупку, а расходы на обслуживание и содержание такого огромного парка. Одним из основных пунктов являются затраты на энергопотребление (питание и охлаждение), поэтому в NUVIA справедливо считают, что таким заказчикам нужен быстрый и энергоэффективный процессор. Решения на базе x86-64 компания к таковым не причисляет: они действительно имеют высокую производительность, однако рост мощности непропорционален росту TDP и потребления, и в этом их основная проблема в отличие от ARM. Для подкрепления своей точки зрения NUVIA провела собственные тесты в Geekbench 5 современных мобильных платформ ARM и x86-64. Выбор бенчмарка обусловлен тем, что он включает современные и разнообразные нагрузки на CPU. А мобильные платформы выбраны потому, что они, как и сервера в ЦОД гиперскейлеров, имеют вынужденные ограничения по питанию и охлаждению. И действительно, та же Facebook✴ для собственных платформ стремится к значению в 400 – 600 Вт на шасси. Приведённый график наглядно показывает, что производительность ядер ARM-процессоров нарастает намного быстрее при увеличении мощности. И именно к этому и стремится NUVIA — ядра Phoenix будут быстрее на 50-100% других и при этом в три-четыре раза экономичнее ядер x86-64. Но надо учесть, что сама NUVIA ориентируется на потребление в диапазоне примерно от 0,5 до 5 Вт на ядро. Компания полагает, что в ближайшее время все серверные процессоры будут иметь от 64 до 128 ядер и TDP на уровне 250 – 300 Вт, так что её SoC с такими параметрами ядер вписывается в эти параметры. OCS и Dell Technologies представляют СХД PowerStore

10.08.2020 [09:18],

Юрий Поздеев

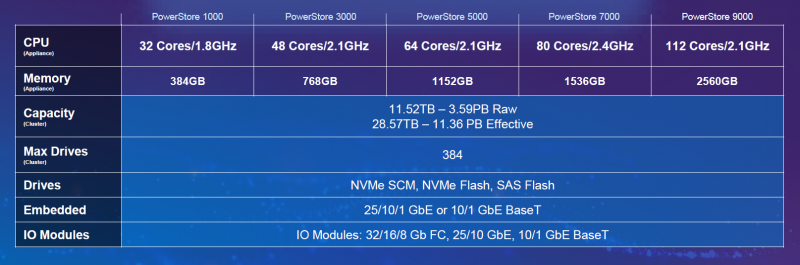

Российский бизнес начинает понемногу восстанавливаться после пандемии COVID-19 и приходит время реализовать все отложенные ИТ-проекты. В условиях, когда бизнес требует быстро увеличить производительность основных сервисов, а бюджеты ограничены, особенно важно сделать правильный выбор решения для построения отказоустойчивого кластера. Новые СХД одного из ведущих вендоров Dell Technologies идеально подходят для размещения бизнес-критичных данных, а широкий набор функций поможет гибко сконфигурировать решение именно под вашу конкретную задачу.  Dell Technologies анонсировала СХД среднего уровня PowerStore в мае, и новинка сразу привлекла внимание. В чем же основные особенности семейства Dell EMC PowerStore?

Модельный ряд PowerStore включает следующие модели:  Для России доступны модели 1000, 5000, 9000, а по специальному заказу, согласованному с вендором, — также 3000 и 7000. Все их можно заказать у авторизованного дистрибьютора Dell Technologies, компании OCS, представительства которой расположены в 26 городах. Компания много лет занимает ведущие позиции на рынке проектной ИТ-дистрибуции, и одной из сильных сторон работы дистрибьютора традиционно является высокий уровень технической экспертизы. Это относится и к поставкам PowerStore: благодаря наличию сертифицированных инженеров в штате OCS партнеры компании — системные интеграторы могут рассчитывать не только на квалифицированные консультации при выборе оптимальной для их задач конфигурации СХД, на помощь в подготовке и расчете спецификаций, но и на техническую поддержку со стороны OCS при инсталляции системы, монтаже и пусконаладочных работах. Кроме того, в OCS создается демо-фонд оборудования PowerStore — партнерам для тестирования и демонстрации заказчикам будут доступны СХД PowerStore 1000 и 5000. Большим плюсом также является возможность для партнеров повышать собственную квалификацию: OCS совместно с Dell Technologies уже представили новое семейство СХД PowerStore участникам российского ИТ-рынка в ходе серии онлайн-конференций, прошедших в нескольких регионах (на Дальнем Востоке и в Сибири, на Урале, в Южном ФО), а на ближайшее будущее планируется цикл обучающих вебинаров. Для специалистов, желающих подтвердить свою квалификацию в области систем хранения данных и получить сертификат международного образца, OCS предлагает услуги авторизованного центра тестирования Pearson VUE, который создан на базе московского офиса дистрибьютора. Здесь можно сдать сертификационные экзамены ведущих мировых производителей ПО и оборудования, в том числе весь спектр тестов, разработанных для прохождения в тест-центрах, по СХД Dell EMC. Водород вместо дизеля: Microsoft Azure получит новые источники резервного питания

28.07.2020 [11:38],

Юрий Поздеев

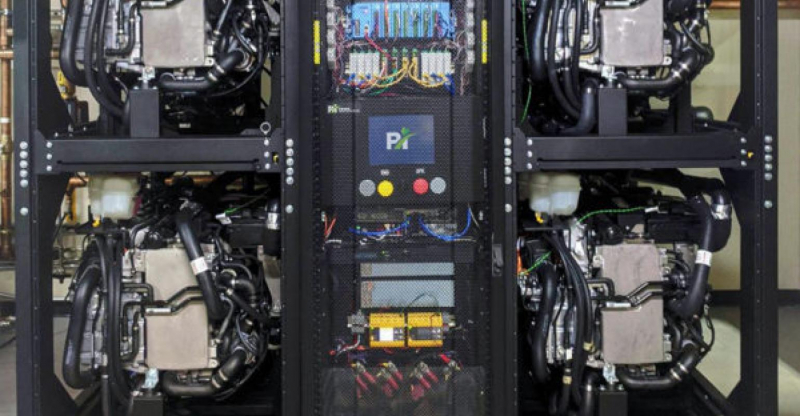

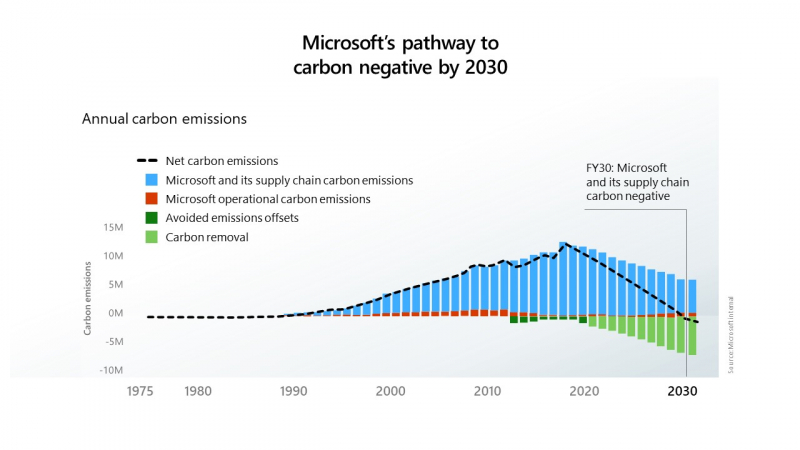

Microsoft сообщила, что успешно протестировала использование водородных топливных элементов для резервного питания своих серверов в центрах обработки данных. Это первый шаг к внедрению новых технологий, исключающих использование дизельного топлива в системах аварийного питания. Водород хранился в резервуарах на трейлерах, припаркованных возле лаборатории в Солт-Лейк-Сити, штат Юта. Такой вариант хранения водорода был продемонстрирован в ходе эксперимента, но в дальнейшем планируется использовать стационарные резервуары. Microsoft намерена прекратить использование дизельного топлива к 2030 году в рамках своих инициатив по снижению вредных выбросов.  В эксперименте использовалась нагрузка в виде 10 стоек облачных серверов Microsoft Azure: в течение 48 часов использовалась 250-КВт система на топливных элементах. Такое время работы от топливных элементов выбрано не случайно, поскольку большинство перебоев в подаче электроэнергии длятся менее 48 часов.  Ранее для подобной задачи использовались шесть дизель-генераторов. Следующим шагом Microsoft планирует испытать систему резервного питания на топливных элементах мощностью 3 МВт, чтобы продемонстрировать как масштабируется система для больших дата-центров.  Дизельные генераторы на данный момент являются оптимальным выбором для большинства ЦОД, однако Microsoft стремится к сокращению выбросов углекислого газа и хочет полностью отказаться от дизельного топлива к 2030 году. Цель амбициозная, но достижимая. Пока основным препятствием к ее осуществлению является цена. Водород сам по себе до сих пор остается дорогим топливом, а его транспортировка и хранения обходятся еще дороже. Следует также учесть, что водород более взрывоопасен, чем дизельное топливо, поэтому его хранение может стать большой проблемой для дата-центров, расположенных в крупных городах. Кроме радикальных мер по переводу аварийного питания дата-центров на водород, Microsoft рассматривает и более реальные альтернативы в виде питания генераторов от природного газа, который дает намного меньше выбросов, по сравнению с дизельным топливом, также рассматривается синтетическое дизельное топливо, которое при сгорании выделяет меньше углерода. Проектами по созданию более экологичных источников питания занимаются и другие компании: Rolls-Royce и Daimler Truck AG разработают топливные элементы для ЦОД, а Keppel и Mitsubishi намереваются создать водородную электростанцию. Ещё одной альтернативой могут стать ёмкие аккумуляторы — оператор Switch для своего дата-центра в Неваде построит комплекс из солнечной электростанции мощностью 127 МВт и модулей Tesla MegaPack суммарной ёмкостью 240 МВт∙ч Phytium Tengyun S2500: 64-ядерный ARM-чип для восьмипроцессорных систем

24.07.2020 [00:50],

Игорь Осколков

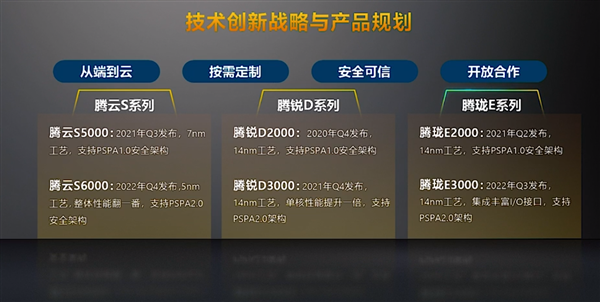

Как сообщает cnTechPost, Phytium, китайский разработчик процессоров, анонсировал новый 64-ядерный чип Tengyun S2500, ориентированный на высокопроизводительные вычисления (HPC). Компания и прежде была известна разработками в этой области — её процессоры легли в основу суперкомпьютеров Tiahne, занимавших первые строчки рейтинга TOP500.

Изображения: cnTechPost В отличие от своего предшественника FT-2000+/64, тоже 64-ядерного, ядра новинки в дополнение к L2-кешу объёмом 512 Кбайт получили общий L3-кеш на 64 Мбайт. Кроме того, чип поддерживает восемь каналов памяти DDR4-3200. Отличительной чертой Tengyun S2500 является возможность объединения — судя по всему, бесшовного — от двух до восьми процессоров в рамках одной системы. Для связи между CPU используется несколько линий собственной шины со скоростью 800 Гбит/с. В основе CPU лежат ядра FTC663, работающие на частоте 2 – 2,2 ГГц. Они же используются в представленном в прошлом году младшем чипе Phytium FT2000/4. Ядра серии FTC600 базируются на модифицированной архитектуре ARMv8 и включают переделанные блоки для целочисленных вычислений и вычислений с плавающей запятой, ASIMD-инструкции, новый динамический предсказатель переходов, поддержку виртуализации, а также традиционные для китайских CPU блоки шифрования и безопасности, соответствующие локальным стандартам.  Энергопотребление новинок достигает 150 Вт. Изготавливаться они будут на TSCM по техпроцессу 16-нм FinFET. Начало массового производства запланировано на четвёртый квартал этого года. Тогда же появятся и 14-нм десктопные чипы Phytium Tengrui D2000, которым через года не смену придут Tengrui D3000. Выход 7-нм серверных процессоров Phytium Tengyun S5000 запланирован на третий квартал 2021 года, а 5-нм чипы Tengyun S6000 появятся уже в 2022-ом. Microsoft продемонстрировала Natick 3 — подводный дата-центр третьего поколения

13.07.2020 [13:58],

Юрий Поздеев

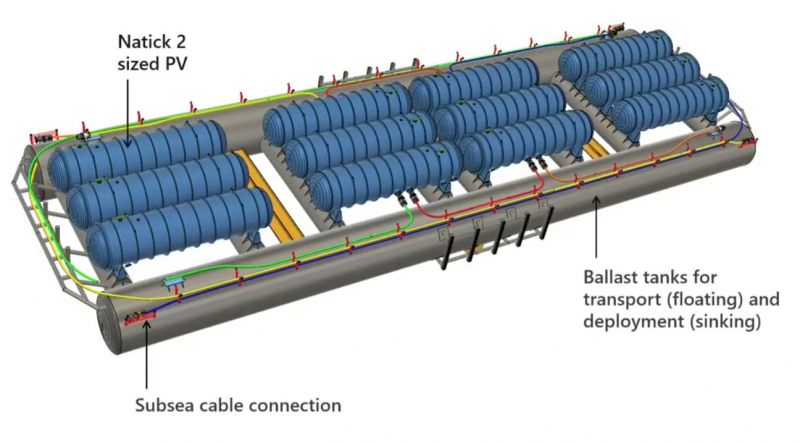

Microsoft одновременно решает ряд инженерных задач с проектом Microsoft Azure Natick: снижает эксплуатационные расходы и обеспечивает меньшие задержки для дата-центров. Что же из себя представляет этот уникальный проект?  Начнем с истории: первый концепт Natick представлял собой стойку с серверами в стальной оболочке, которую опустили в океан, чтобы проверить работоспособность идеи. Попытка была удачной, Microsoft доказала, что можно использовать обычные серверы, развернутые в компактном корпусе на расстоянии 200 км в океане, что примерно давало задержку в 1 мс (2 мс в обе стороны). Видео с экспериментальным дата-центром Natick: Первая версия Natick была развернута у берегов Калифорнии и проработала 105 дней, что подтвердило жизнеспособность концепта. Два года спустя Microsoft Research погрузила под воду 14 стоек с серверами у побережья Шотландии. Этот регион был выбран не случайно: именно здесь используется множество возобновляемых источников энергии, что позволило сделать новый Natick еще более экологичным. Видео с демонстрацией Natick второго поколения: После более чем года работы Natick второго поколения Microsoft поделилась некоторыми данными: с точки зрения эффективности энергопотребления Natick демонстрирует коэффициент PUE в 1,07 — это очень мало для текущего производственного центра обработки данных. Низкий PUE означает снижение эксплуатационных расходов, а также делает Natick более экологичным. Обычный наземный дата-центр использует 4,8 литра воды на кВт/ч, при этом Natick не потребляет воду для работы, однако использует ее по-другому (споры с экологами по поводу нагрева океана и влияния на окружающую среду не закончились какими-то конструктивными выводами, по информации от самой Microsoft, влияние Natick на окружающую среду ничтожно мало). Этот аспект особенно актуален для стран, в которых существует дефицит воды и охлаждение дата-центров превращается в существенную проблему. Цилиндрический корпус Natick имеет вакуумную герметизацию, что означает, что серверы и ИТ оборудование избавлены от многих вредных факторов, таких как влажность и пыль. Кроме того, учитывая, насколько хорошо вода поглощает тепло и насколько велики океаны, можно утверждать, что на глубине 200 метров для дата-центра будет поддерживаться постоянная температура, без колебаний, свойственных наземным ЦОД (особенно это актуально для жарких регионов, где приходится использовать системы охлаждения с большим запасом). Natick 2 был рассчитан на эксплуатацию в течение пяти лет без технического обслуживания. Так что же Microsoft может предложить сегодня?  Natick третьего поколения представляет собой множество цилиндрических корпусов, закрепленных на большой стальной раме, в которой проложены коммутационные кабели и кабели питания. Общий размер составляет более 90 м (300 футов), с каждой стороны конструкции есть балластные цистерны для транспортировки и упрощения установки. Natick 3 состоит из 12 цилиндрических корпусов, общая мощность системы достигает 5 МВт, при необходимости могут быть построены и более крупные структуры, так как конструкция модульная и позволяет легко масштабировать мощность при необходимости. Microsoft не единственная компания, которая ведёт разработки в области подводных дата-центров, существуют еще разработки Nautilus Fata Technologies и более мелкие стартапы, однако они находятся только в самом начале пути и не имеют опыта промышленной эксплуатации дата-центров. Одно можно сказать точно: данное направление будет развиваться и в скором будущем мы увидим еще не одно подобное решение. ISC 2020: Tachyum анонсировала 128-ядерные ИИ-процессоры Prodigy и будущий суперкомпьютер на их основе

25.06.2020 [21:10],

Алексей Степин

Машинное обучение в последние годы развивается и внедряется очень активно. Разработчики аппаратного обеспечения внедряют в свои новейшие решения поддержку оптимальных для ИИ-систем форматов вычислений, под этот круг задач создаются специализированные ускорители и сопроцессоры. Словацкая компания Tachyum достаточно молода, но уже пообещала выпустить процессор, который «отправит Xeon на свалку истории». О том, что эти чипы станут основой для суперкомпьютеров нового поколения, мы уже рассказывали читателям, а на конференции ISC High Performance 2020 Tachyum анонсировала и сами процессоры Prodigy, и ИИ-комплекс на их основе. Запуск готовых сценариев машинного интеллекта достаточно несложная задача, с ней справляются даже компактные специализированные чипы. Но обучение таких систем требует куда более внушительных ресурсов. Такие ресурсы Tachyum может предоставить: на базе разработанных ею процессоров Prodigy она создала дизайн суперкомпьютера с мощностью 125 Пфлопс на стойку и 4 экзафлопса на полный комплекс, состоящий из 32 стоек высотой 52U. Основой для новой машины является сервер-модуль собственной разработки Tachyum, системная плата которого оснащается четырьмя чипами Prodigy. Каждый процессор, по словам разработчиков, развивает до 625 Тфлопс, что дает 2,5 Пфлопс на сервер. Компания обещает для новых систем трёхкратный выигрыш по параметру «цена/производительность» и четырёхкратный — по стоимости владения. При этом энергопотребление должно быть на порядок меньше, нежели у традиционных систем такого класса. Архитектура Prodigy представляет существенный интерес: это не узкоспециализированный чип, вроде разработок NVIDIA, а универсальный процессор, сочетающий в себе черты ЦП, ГП и ускорителя ИИ-операций. Структура кристалла построена вокруг концепции «минимального перемещения данных». При разработке Tachyum компания принимала во внимание задержки, вносимые расстоянием между компонентами процессора, и минимизировала их. Процессор Prodigy может выполнять за такт две 512-битные операции типа multiply-add, 2 операции load и одну операцию store. Соответственно то, что каждое ядро Prodigy имеет восемь 64-бит векторных блока, похожих на те, что реализованы в расширениях Intel AVX-512 IFMA (Integer Fused Multiply Add, появилось в Cannon Lake). Блок вычислений с плавающей точкой поддерживает двойную, одинарную и половинную точность по стандартам IEEE. Для ИИ-задач имеется также поддержка 8-битных типов данных с плавающей запятой. Векторные и матричные операции — сильная сторона Prodigy. На перемножении-сложении матриц размерностью 8 × 8 ядро развивает 1024 Флопс, используя 6 входных и 2 целевых регистра (в сумме есть тридцать два 512-бит регистра). Это не предел, разработчик говорит о возможности увеличения скорости выполнения этой операции вдвое. Tachyum обещает, что система на базе Prodigy станет первым в мире ИИ-кластером, способным запустить машинный интеллект, соответствующий человеческому мозгу. С учётом заявлений о 10-кратной экономии электроэнергии и 1/3 стоимости от стоимости Xeon, это заявление звучит очень сильно. Но Prodigу — не бумажный продукт-однодневка. Tachyum разработала не только сам процессор, но и всю необходимую ему сопутствующую инфраструктуру, включая и компилятор, в котором реализованы оптимизации в рамках «минимального перемещения данных». Новинка разрабона с использованием 7-нм техпроцесса, максимальное количество ядер с вышеописанной архитектурой — 64. Помимо самих ядер, кристалл T864 содержит восьмиканальный контроллер DDR5, контроллер PCI Express 5.0 на 64 (а не 72, как ожидалось ранее) линии и два сетевых интерфейса 400GbE. При тактовой частоте 4 ГГц Prodigy развивает 8 Тфлопс на стандартных вычислениях FP32, 1 Пфлоп на задачах обучения ИИ и 4 Петаопа в инференс-задачах. Самая старшая версия, Tachyum Prodigy T16128, предлагает уже 128 ядер с частотой до 4 ГГц, 12 каналов памяти DDR5-4800 (но только 1DPC и до 512 Гбайт суммарно), 48 линий PCI Express 5.0 и два контроллера 400GbE. Производительность в HPC-задачах составит 16 Тфлопс, а в ИИ — 262 Тфлопс на обучении и тренировке. Системные платы для Prodigy представлены, как минимум, в двух вариантах: полноразмерные четырёхпроцессорные для сегмента HPC и компактные однопроцессорные для модульных систем высокой плотности. Полноразмерный вариант имеет 64 слота DIMM и поддерживает модули DDR5 объёмом до 512 Гбайт, что даёт 32 Тбайт памяти на вычислительный узел. Сам узел полностью совместим со стандартами 19″ и Open Compute V3, он может иметь высоту 1U или 2U и поддерживает питание напряжением 48 Вольт. Плата имеет собственный BIOS UEFI, но для удалённого управления в ней реализован открытый стандарт OpenBMC. Tachyum исповедует концепцию универсальности, но всё-таки узлы для HPC-систем на базе Prodigy могут быть нескольких типов — универсальные вычислительные, узлы хранения данных, а также узлы управления. В качестве «дисковой подсистемы» разработчики выбрали SSD-накопители в формате NF1, подобные представленному ещё в 2018 году накопителю Samsung. Таких накопителей в корпусе системы может быть от одного до 36; поскольку NF1 существенно крупнее M.2, поддерживаются модели объёмом до 32 Тбайт, что даёт почти 1,2 Пбайт на узел. Стойка с модулями Prodigy будет вмещать до 50 модулей высотой 1U или до 25 высотой 2U. Согласно идее о минимизации дистанций при перемещении данных, сетевой коммутатор на 128 или 256 портов 100GbE устанавливается в середине стойки. Такая конфигурация работает в системе с числом стоек до 16, более масштабные комплексы предполагается соединять между собой посредством коммутатора высотой 2U c 64 портами QSFP-DD, причём поддержка скорости 800 Гбит/с появится уже в 2022 году. 512 стоек могут объединяться посредством высокопроизводительного коммутатора CLOS, он имеет высоту 21U и также получит поддержку 800 Гбит/с в дальнейшем. Компания активно поддерживает открытые стандарты: применён загрузчик Core-Boot, разработаны драйверы устройств для Linux, компиляторы и отладчики GCC, поддерживаются открытые приложения, такие, как LAMP, Hadoop, Sparc, различные базы данных. В первом квартале 2021 года ожидается поддержка Java, Python, TensorFlow, PyTorch, LLVM и даже операционной системы FreeBSD. Любопытно, что существующее программное обеспечение на системах Tachyum Prodigy может быть запущено сразу в виде бинарных файлов x86, ARMv8 или RISC-V — разумеется, с пенальти. Производительность ожидается в пределах 60 ‒ 75% от «родной архитектуры», для достижения 100% эффективности всё же потребуется рекомпиляция. Но в рамках контрактной поддержки компания обещает помощь в этом деле для своих партнёров. Разумеется, пока речи о полномасштабном производстве новых систем не идёт. Эталонные платформы Tachyum обещает во второй половине следующего года. Как обычно, сначала инженерные образцы получают OEM/ODM-партнёры компании и системные интеграторы, а массовые поставки должны начаться в 4 квартале 2021 года. Однако ПЛИС-эмуляторы Prodigy появятся уже в октябре этого года, инструментарий разработки ПО — и вовсе в августе. Планы у Tachyum поистине наполеоновские, но её разработки интересны и содержат целый ряд любопытных идей. В чём-то новые процессоры можно сравнить с Fujitsu A64FX, которые также позволяют создавать гомогенные и универсальные вычислительные комплексы. Насколько удачной окажется новая платформа, говорить пока рано. 128 ядер ARM: Ampere Computing анонсировала процессоры Altra Max

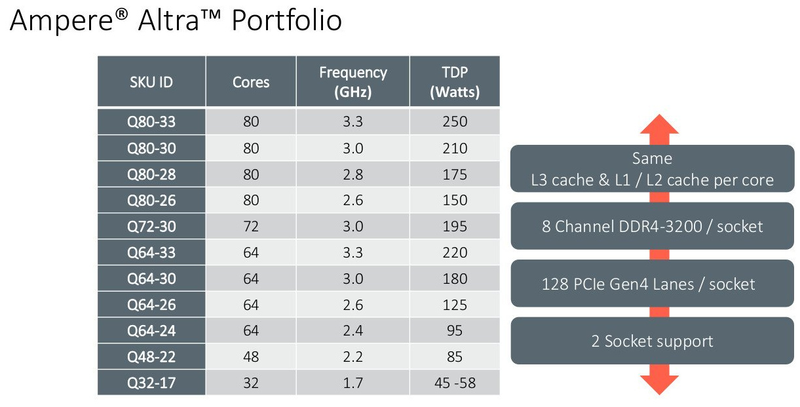

23.06.2020 [19:23],

Алексей Степин

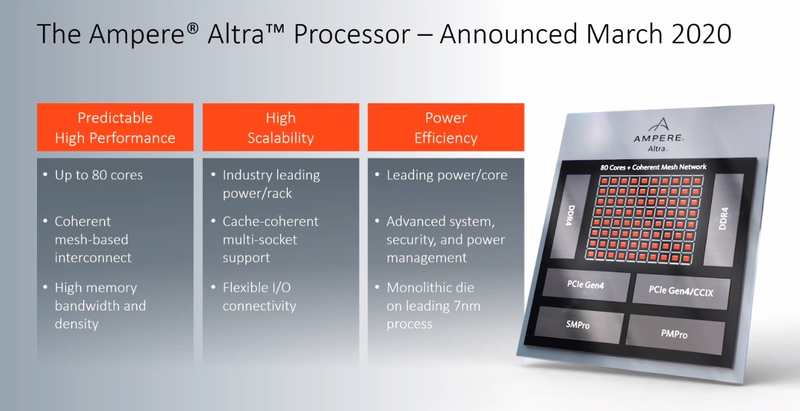

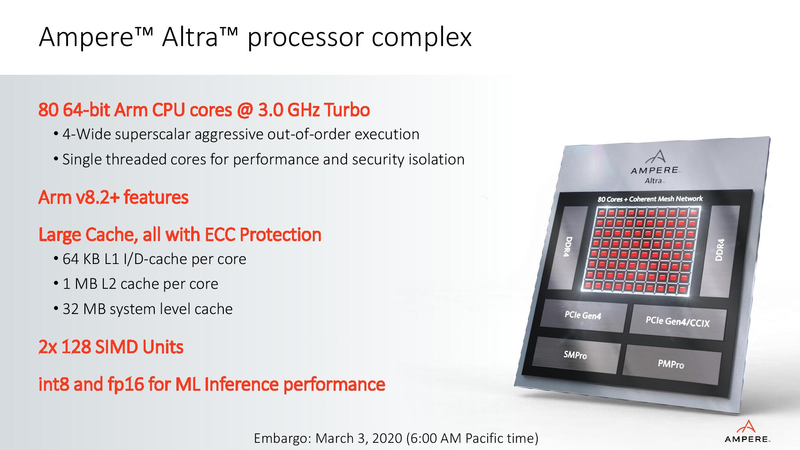

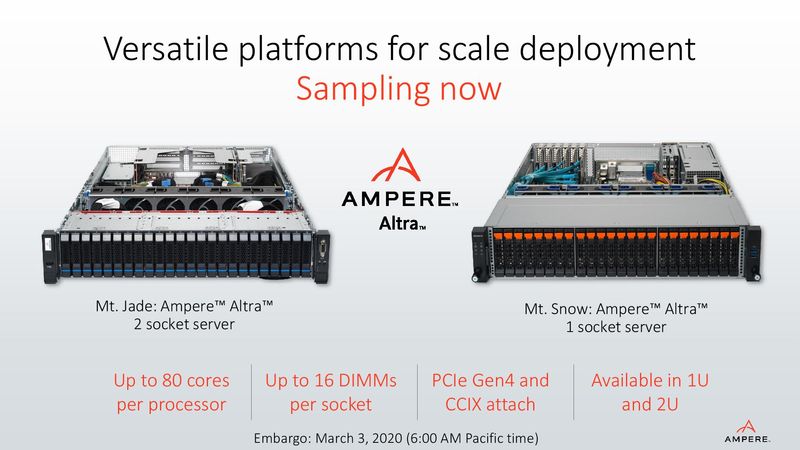

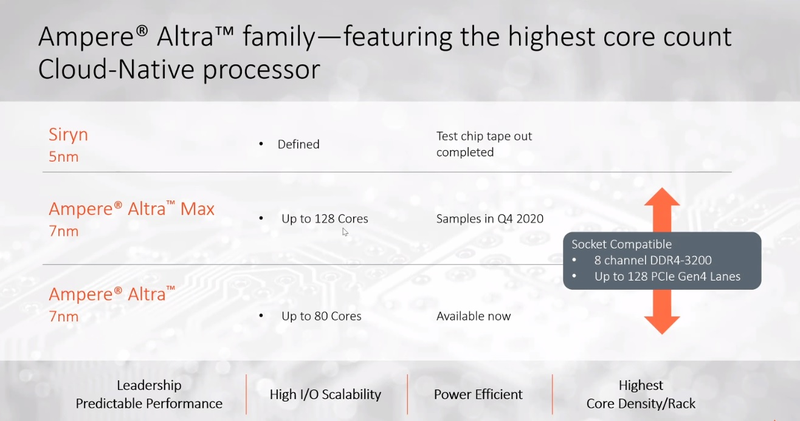

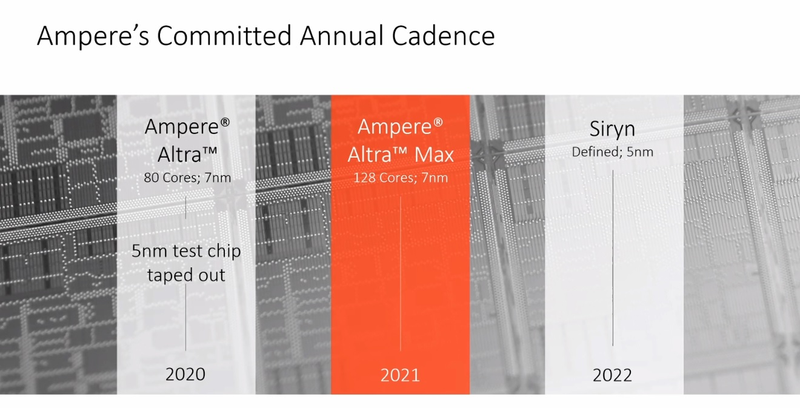

На первый взгляд, позиции архитектуры x86 в мире высокопроизводительных вычислений выглядят незыблемыми: примерно 94% всех систем класса HPC используют в качестве основы процессоры Intel и ещё 2,2% занимает AMD. Однако запуск кластера Fugaku доказал, что ARM — соперник весьма и весьма опасный. Система на базе процессоров Fujitsu A64FX использует именно архитектуру ARM. И наступление ARM продолжается и на других фронтах: к примеру, AWS предлагает инстансы на собственных ARM-процессорах Graviton2. Не дремлет Ampere Computing, анонсировавшая сегодня новые процессоры Altra и Altra Max.  Разработкой мощных многоядерных процессоров с архитектурой ARM компания занимается довольно давно: в конце прошлого года она уже рассказывала о втором поколении своих продуктов, чипах QuickSilver. В их основу лег дизайн ядра ARM Neoverse N1 (ARM v8.2+), количество самих ядер достигло 80, появилась поддержка интерфейса PCI Express 4.0, чего, например, до сих пор нет в процессорах Intel Xeon Scalable. Серверные процессоры с архитектурой ARM доказали своё превосходство в энергоэффективности перед x86, что сделало их отличным выбором для облачных сервисов — в таких ЦОД плотность упаковки вычислительных мощностей максимальна и такие параметры, как удельная производительность, энергопотребление и тепловыделение играют крайне важную роль. Новые процессоры Ampere под кодовым именем Altra нацелены именно на этот сектор рынка.  В основе Altra также лежит ядро Neoverse N1 — оно же применено и в проекте Amazon Graviton2 — но Ampere Computing намеревается охватить с помощью Altra остальных крупных провайдеров облачных услуг, которые также заинтересованы в высокоплотных энергоэффективных ЦП. При этом утверждается, что Altra превосходит Graviton2; по крайней мере, на бумаге это выглядит убедительно. Всего в серии Altra анонсировано 12 процессоров, с количеством ядер от 32 до 80, частотами от 1,7 до 3,3 ГГц и теплопакетами от 45 до 250 Ватт. Все они располагают восьмиканальным контроллером памяти DDR4-3200 (до 4 Тбайт на процессор) и предоставляют в распоряжение системы 128 линий PCI Express 4.0, чем пока могут похвастаться разве что AMD Rome. Применена очень простая система наименований: например, «Q72-30» означает, что перед нами 72 ядерный процессор поколения QuickSilver с частотой 3 ГГц.  Altra следует большинству современных тенденций в процессоростроении: процессоры располагают солидным массивом кешей (1 Мбайт на ядро, 32 Мбайт L3), ядра имеют два 128-битных блока инструкций SIMD, а также поддерживают популярные в задачах машинного интеллекта и инференс-комплексах форматы вычислений INT8 и FP16. Что касается удельной энергоэффективности, то ядро AMD Rome потребляет около 3 Ватт при полной нагрузке на частоте 3 ГГц, а для Altra Q80-30 этот показатель равен 2,6 Ватта; турборежима у Altra, впрочем, нет и максимальные частоты справедливы для всех ядер.  В настоящий момент компания поставляет образцы платформ Altra двух типов: однопроцессорную Mt. Snow и двухпроцессорную Mt. Jade. В число партнёров компании входят такие производители, как GIGABYTE и Wiwynn, заявлен также ряд контрактов с производителями более низких эшелонов. В основе Mt. Jade, вероятнее всего, лежит системная плата GIGABYTE MP32-AR0, о ней мы уже рассказывали нашим читателям.  Цены новых решений пока не разглашаются, однако, заинтересованные в процессорах Ampere провайдеры уже в течение двух месяцев тестируют новые платформы; в их число входят такие компании, как Packet и CloudFlare, причём Packet уже предоставляет своим клиентам «ранний доступ» к услугам, запускаемым на новых платформах Ampere. Более массовых поставок следует ожидать в августе и сентябре текущего года.  80 ядер — весьма солидное количество, даже в арсенале AMD таких процессоров ещё нет, семейство EPYC всё ещё ограничено 64 ядрами, но с SMT. Однако на достигнутом Ampere не останавливается и позднее в этом году планирует представить миру настоящего монстра — 128-ядерный процессор Altra Max, на базе всё той же архитектуры QuickSilver/Neoverse. Этот чип имеет кодовое имя Mystique, он будет базироваться на новом дизайне кристалла, однако отличия здесь количественные, качественно это всё та же Altra, но с большим количеством ядер, оптимизированная с учётом возможностей сохранённой неизменной подсистемой памяти. Сохранится даже совместимость по процессорному разъёму. Образцы Altra Max если и существуют, то только в лаборатории Ampere Computing, а публичного появления сэмплов этих процессоров следует ожидать не ранее 4 квартала с началом производства в 2021 году.  Таким образом, можно утверждать, что технологическая ступень 7 нм компанией освоена. Она штурмует новую высоту — образцы процессоров Siryn, построенные с использованием 5-нм техпроцесса TSMC должны появиться ближе к концу следующего года. Некоторые блоки Siryn уже существуют в кремнии. Эти процессоры получат и новую платформу, а, возможно, и поддержку таких технологий, как PCI Express 5.0 и DDR5. ARM-суперкомпьютер Fugaku поднялся на вершину рейтингов TOP500, HPCG и HPL-AI

22.06.2020 [18:20],

Игорь Осколков

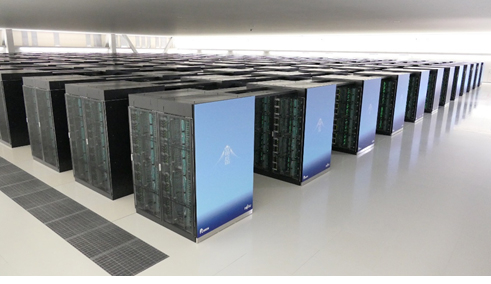

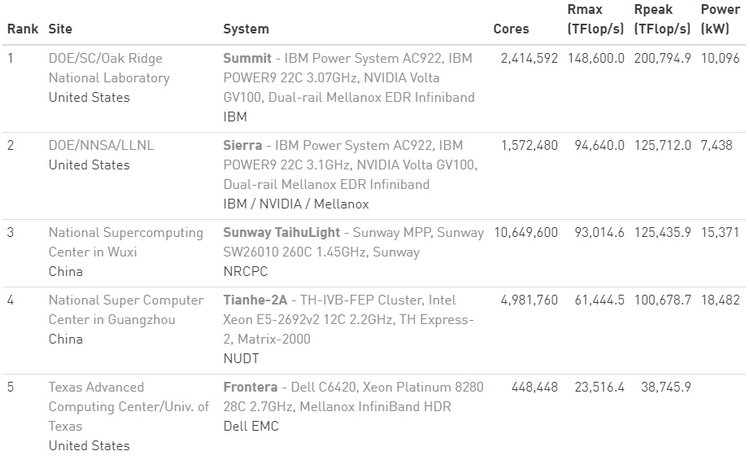

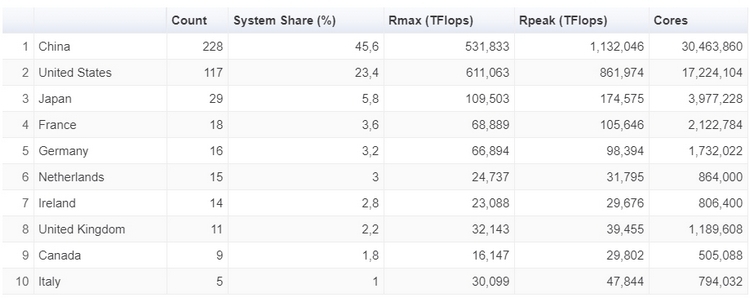

Конечно же, речь идёт о японском суперкомпьютере Fugaku на базе ARM-процессоров A64FX, который досрочно начал трудиться весной этого года. Эта машина стала самым мощным суперкомпьютером в мире сразу в трёх рейтингах: классическом TOP500, современном HPCG и специализированном HPL-AI.  Суперкомпьютер состоит из 158976 узлов, которые имеют почти 7,3 млн процессорных ядер, обеспечивающих реальную производительность на уровне 415,5 Пфлопс, то есть Fugaku почти в два с половиной раза быстрее лидера предыдущего рейтинга, машины Summit. Правда, оказалось, что с точки зрения энергоэффективности новая ARM-система мало чем отличается от связки обычного процессора и GPU, которой пользуется большая часть суперкомпьютеров. Так что на первое место в Green500 она не попала. Однако на стороне Fugaku универсальность — понижение точности вычислений вдвое приводит к удвоение производительности. Так что машина имеет впечатляющую теоретическую пиковую скорость вычислений 4,3 Эопс на INT8 и не менее впечатляющие 537 Пфлопс на FP64. Это помогло занять её первое место в бенчмарке HPL-AI, которые использует вычисления разной точности. А общая архитектура процессора, включающего набортную память HBM2, и системы, использующей интерконнект Tofu, способствовали лидерству в бенчмарке HPCG, который оценивает эффективность машины в целом.  HPE анонсировала Superdome Flex 280: 224 ядра Cooper Lake и 24 Тбайт RAM

19.06.2020 [18:09],

Юрий Поздеев

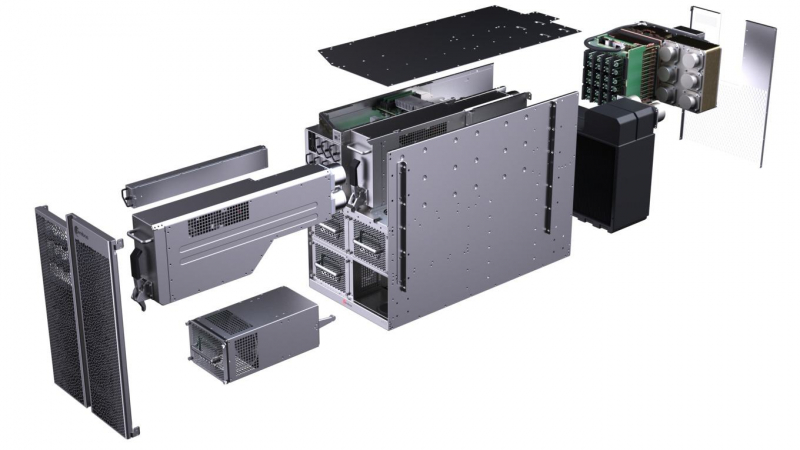

HPE анонсировала Superdome Flex 280 с поддержкой процессоров Intel Xeon третьего поколения, которые вышли недавно. Данная модель дополняет портфель HPE Superdome Flex и ориентирована на средние предприятия, для которых избыточна масштабируемость до 32 сокетов. Оптимально данная модель подойдет для больших баз Oracle, SAP HANA или SQL-сервера. Новинка выпускается в форм-факторе 5U и поддерживает установку 2 или 4 процессоров Intel Xeon Gold или Intel Xeon Platinum. Это выгодно отличает Superdome Flex от других подобных систем, в которых можно использовать только Intel Xeon Platinum, который стоит значительно дороже.  Недавно анонсировали новые процессоры Intel Xeon третьего поколения, в которых не только добавили функции ускорения ИИ, но и поддержку более быстрой памяти DDR4-3200, что должно положительным образом сказаться на производительности. Максимально в одну платформу можно установить до 24 Тбайт оперативной памяти, а если и этого недостаточно, то можно использовать Intel Optane PMem 200 .  Слотов расширения PCIe тоже достаточно для большинства задач — до 32 на одну платформу, при этом можно установить до 16 графических ускорителей NVIDIA. Для локального хранилища можно использовать до 20 накопителей SAS/SATA/NVMe. Масштабируется платформа Superdome Flex 280 до 8 процессоров с шагом в 2 CPU, что позволяет работать с большими базами данных и моделями для ИИ, для которых требуется большой объем оперативной памяти. Суммарно можно получить до 224 ядер и до 24 Тбайт общей памяти. HPE Superdome Flex 280 будет доступен в 4 квартале 2020 года. Суперкомпьютер Neocortex: 800 тыс. ядер Cerebras для ИИ

09.06.2020 [19:49],

Юрий Поздеев

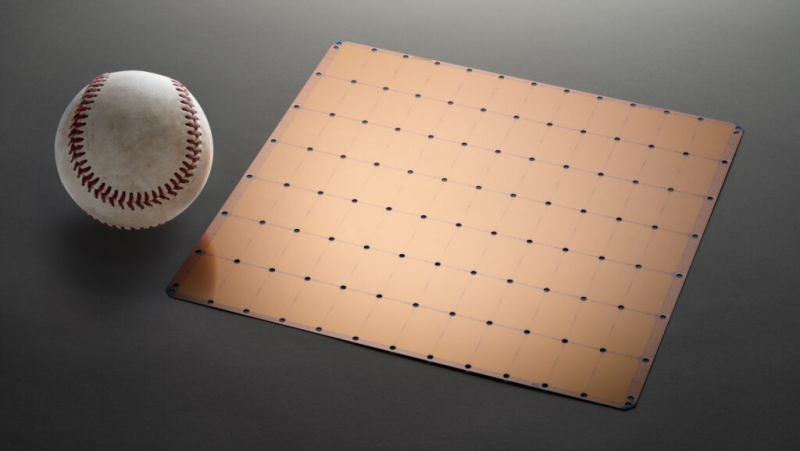

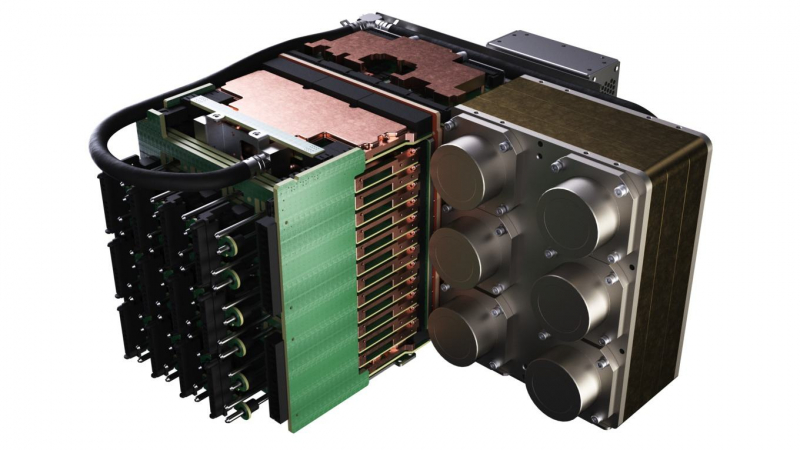

Питтсбургский суперкомпьютерный центр (PSC) получит $5 млн от Национального научного фонда на создание суперкомпьютера нового типа Neocortex, который объединяет ИИ-серверы Cerebras CS-1 и HPE SuperDome Flex в единую систему с общей памятью. Планируется, что решение будет введено в эксплуатацию до конца 2020 года.  Каждый сервер Cerebras CS-1 имеет процессор Cerebras Wafer Scale Engine (WSE), который содержит 400 000 ядер, оптимизированных для работы с ИИ (46 225 мм2, 1,2 трлн транзисторов). В паре с ними работает HPE SuperDome Flex, который используется для предварительной обработки информации и постобработки после Cerebras. SuperDome Flex представлен в максимальной комплектации, то есть с 32 процессорами Intel Xeon, 24 Тбайт оперативной памяти, 205 Тбайт флеш-памяти и 24 интерфейсными картами.  Каждый сервер Cerebras CS-1 подключается к SuperDome Flex через 12 каналов со скоростью 100 Гбит/с каждый. Процессор WSE способен обрабатывать 9 Пбайт данных в секунду, что, по подсчетам Nystrom, эквивалентно примерно миллиону фильмов в HD-качестве. Характеристики решения действительно впечатляют!

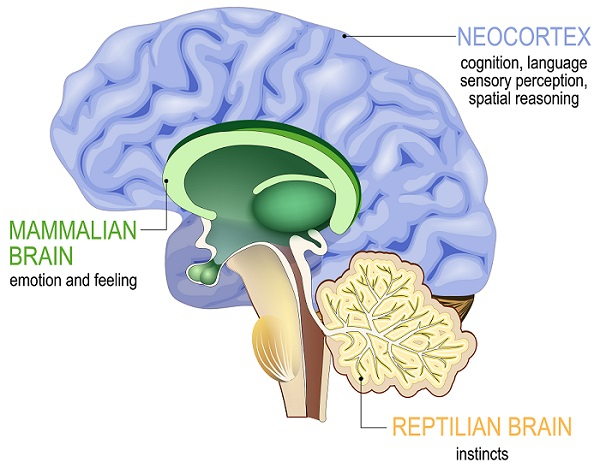

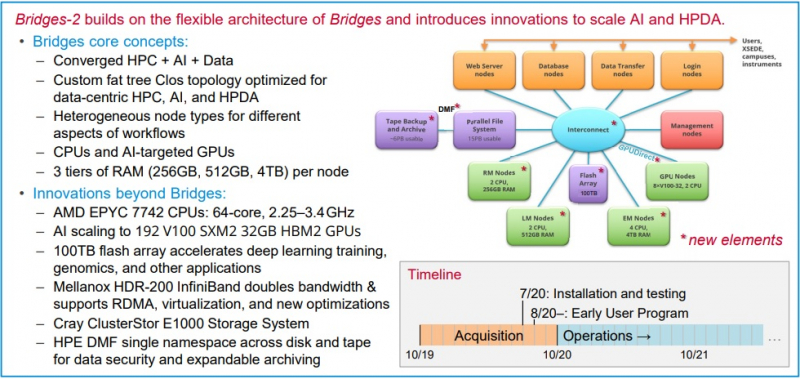

Neocortex назван в честь области мозга, отвечающей за функции высокого порядка, включая когнитивные способности, сновидения и формирование речи Архитектура решения строилась таким образом, чтобы не пришлось разбивать вычислительные блоки на множество узлов — это позволило снизить задержки в обработке информации и ускорить обучение моделей ИИ. Cerebras CS-1 разрабатывался специально для ИИ, поэтому он имеет преимущества перед серверами с графическими ускорителями, которые хорошо справляются с матричными операциями, но имеют многие конструктивные ограничения.  По заявлениям Neocortex, сервер CS-1 будет на несколько порядков мощнее системы PSC Bridges-AI. Один сервер Neocortex CS-1 будет эквивалентен примерно 800-1500 серверов с традиционной архитектурой с использованием графических ускорителей. Задачи, в которых Neocortex покажет себя максимально эффективно относятся к классу нейронных сетей DCIGN (deep convolutional inverse graphics networks) и RNN (recurrent neural networks). Если говорить простыми словами, то это более точное прогнозирование погоды, анализ геномов, поиск новых материалов и разработка новых лекарств.  PSC, помимо Neocortex, запускает еще и новое поколение системы Bridges-2, которое будет развернуто осенью 2020 года. Таким образом, до конца этого года будут введены в эксплуатацию два мощных суперкомпьютера для ИИ. Neocortex и Bridges-2 будут поддерживать самые популярные фреймворки машинного обучения, что позволит создать гибкую и мощную экосистему для ИИ, анализа данных, моделирования и симуляции. До 90% машинного времени Neocortex будет выделяться через XSEDE (Extreme Science and Engineering Discovery Environment), финансируемую NSF организацию, которая координирует совместное использование передовых цифровых услуг, включая суперкомпьютеры и ресурсы для визуализации и анализа данных, с исследователями на национальном уровне. Предложение Huawei отказаться от TCP/IP восторгов не вызвало

05.06.2020 [23:23],

Алексей Степин

Стеку TCP/IP, благодаря которому существует всемирная сеть, уже не один десяток лет. DARPA начало исследования по этой теме ещё в конце 60-х, и не все согласны с тем, что данная технология продолжает отвечать требованиям времени: Huawei предложила Международному союзу электросвязи (ITU) план по отказу от TCP/IP и переходу на более современное и безопасное, по её мнению, решение New IP. Определённый резон в этом есть: современные сети чрезвычайно сложны, они базируются на весьма разнообразном оборудовании, и что такое «кибервойна» сегодня, пожалуй, знают все, кто хоть сколько-то интересуется тематикой информационных технологий. Достаточно хотя бы сделать на нашем сайте поиск по слову «уязвимость» — и становится понятным, что понятия «интернет» и «безопасность» сегодня сочетаются не очень хорошо.

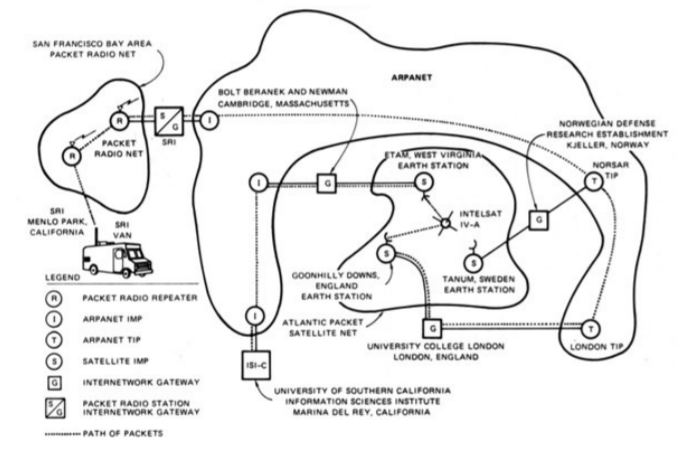

Демонстрация TCP/IP, объединяющая сети ARPANET, PRNET и SATNET. 1977 год Корпорация Huawei выступила в ITU с предложением отказаться от стека TCP/IP и перейти на использование более гибких и безопасных технологий. Понять позицию китайской компании можно: она находится в состоянии «войны» с США и желание продвинуть собственные технологии для нее совершенно естественно. Позиции, предлагаемые Huawei, выглядят довольно привлекательно:

Технических деталей, к сожалению, в публичном доступе пока нет. Реакция на предложение Huawei оказалась достаточно негативной: оно было охарактеризовано, как попытка внедрения централизации и «тоталитарных» методов. В частности, предложенный механизм отсечения частей сети можно использовать не только для защиты от DDoS-атак. Сама Huawei обвинения в «тоталитаризме» отвергла, заявив, что не связывает технологию с политикой. Еврокомиссия опубликовала свой ответ: в нём говорится, что за время своего существования модель TCP/IP доказала свою жизнеспособность, продемонстрировав нужную степень отказоустойчивости и масштабируемости. Аналогичной точки зрения придерживается Cisco, считая TCP/IP достаточно гибкой технологией, чтобы отвечать вызовам времени.

О дивный, новый Интернет! Нужда в усовершенствовании сетевых технологий существует, но это следует делать в рамках существующих стандартов. Евросоюз планирует защищать «видение единого, открытого, нейтрального, свободного и нефрагментированного интернета». («the vision of a single, open, neutral, free and unfragmented internet»). Тем не менее, война технологий, скорее всего, в ближайшее время продолжится. Предсказать исход пока не представляется возможным, но Huawei явно не собирается сдаваться просто так и будет продвигать инициативу New IP далее. Консорциумы CXL и Gen-Z объединяют усилия: протоколы станут совместимыми, а возможности расширятся

03.04.2020 [13:37],

Геннадий Детинич

Консорциумы CXL и Gen-Z сообщили, что их руководящие органы подписали договор о взаимопонимании. Пописанный меморандум раскрывает планы сотрудничества между двумя организациями, обещая совместимые протоколы и расширенные возможности каждого из представленных интерфейсов. Первые версии спецификаций Gen-Z и CXL (Compute Express Link) вышли, соответственно, в феврале 2018 года и в марте 2019 года. Каждый из этих интерфейсов призван обойти ограничения по пропускной способности, накладываемые на многоядерные и многоузловые конфигурации процессоров и ускорителей.  Как один, так и другой интерфейс отвечают за согласованность кешей множества подключённых решений и обеспечивают минимальные задержки при доступе к вычислительным ресурсам и хранилищам данных на основе ОЗУ или долговременных накопителей. В то же время интерфейс CXL специализируется на согласованной работе внутри шасси, а интерфейс Gen-Z позволяет согласовывать работу на уровне блоков, стоек и массивов. В целом, участники консорциума Gen-Z поддержали идею Compute Express Link и признали её как дополняющую для развития интерфейса Gen-Z. В течение прошлого года в консорциум CXL, за организацией которого стоит компания Intel, вошли много компаний, включая AMD и ARM. Дело оставалось за малым ― объединить усилия и добиться совместимости протоколов и архитектур.  Сегодня такой день настал. Консорциумы CXL и Gen-Z договорились организовать совместные смешанные рабочие группы для разработки «мостов» между протоколами обеих спецификаций и сделать всё необходимое, чтобы расширить возможности каждого из стандартов за счёт возможностей другого. Видео: как устроен дата-центр «Росэнергоатома» вблизи Калининской АЭС

15.03.2020 [00:40],

Андрей Крупин

Российский энергетический концерн «Росэнергоатом» (входит состав госкорпорации «Росатом») разместил на своей странице в социальной сети «ВКонтакте» ролик, рассказывающий об особенностях работы центра обработки данных «Калининский», расположенного вблизи Калининской АЭС в Тверской области. Территориальная приближённость ЦОД «Калининский» к атомной электростанции обусловлена необходимостью обеспечения объекта надёжным источником электроснабжения.  Вычислительный комплекс «Калининский» был введён в эксплуатацию весной 2018 года и является первым дата-центром проекта «Менделеев» концерна «Росэнергоатом» по созданию сети центров обработки данных на площадках атомной отрасли РФ и за рубежом, соединённых высокоскоростными каналами связи в единую территориально распределённую катастрофоустойчивую информационную инфраструктуру. Дата-центр «Калининский» включает три здания с машинными залами общей площадью 38000 кв. метров и 4800 серверными стойками с проектной мощностью потребления электроэнергии от 6 кВт в расчёте на одну стойку. Подведённая мощность дата-центра составляет 48 МВт. Рядом с ЦОД развёрнута инфраструктурная площадка для размещения сторонними компаниями модульных и контейнерных центров обработки данных мощностью 32 МВт (проектом предполагается размещение до 30 модульных и контейнерных ЦОД по одному мегаватту каждый). Таким образом «Калининский» является одним из самых крупных дата-центров в России и позволяет разместить в машинных залах до 10 тысяч стоек с оборудованием суммарной мощностью до 80 МВт. В ближайших планах «Росэнергоатома» — строительство ЦОД в Сосновом Бору (Ленинградская область) и Иннополисе (Республика Татарстан). Intel представила семейство процессоров Intel Xeon Cascade Lake Refresh

24.02.2020 [17:00],

Константин Ходаковский

Вместе с серией продуктов для инфраструктуры сетей 5G, включающей систему на кристалле Atom P5900 для базовых станций, структурированную платформу ASIC Diamond Mesa для ускорения сетей 5G, серию сетевых контроллеров Ethernet 700 и программное решение OpenNESS для лёгкого развёртывания облачных периферийных микросервисов, корпорация Intel расширила и серию серверных процессоров Intel Xeon Scalable 2-го поколения. Intel Xeon Scalable 2-го поколения являются основой платформенной инфраструктуры в центрах обработки данных. На сегодняшний день чипов Xeon Scalable продано в общей сложности более 30 миллионов. Появление этих процессоров позволило трансформировать ядро сети: сегодня на их долю приходится 50 % всех виртуализированных окружений по всему миру, а к 2023 году это число дополнительно увеличится. Как мы уже сообщали, новая серия серверных процессоров Intel включает 18 моделей с более высокими частотами (до 4 ГГц в режиме Turbo Boost), увеличенным количеством ядер и объёмом кеша в различной комбинации этих параметров. Но главное изменение — это существенно сниженная стоимость. Например, Xeon Gold 6238R предложит 28 ядер и базовую частоту 2,2/4 ГГц, тогда как его предшественник в лице Xeon Gold 6238 использует 22 ядра с частотой 2,1/3,7 ГГц при одинаковой стоимости. Флагманом семейства станет Xeon Gold 6258R с 28 ядрами, поддержкой Hyper-Threading, базовой частотой 2,7 ГГц и уровнем TDP не более 205 Вт. В обозначении моделей новых процессоров, как правило, присутствует литера «R», то есть Refresh. Серия оптимизированных ЦП для высочайшей производительности отдельных ядер теперь представляет собой такой перечень. Все процессоры поддерживают Intel Optane DC Persistent Memory (жирным помечены новые модели):

Серия ЦП, оптимизированных для производительности на Ватт, представляет собой такой перечень. Все процессоры Platinum и Gold поддерживают Intel Optane DC Persistent Memory, а остальные — нет (жирным помечены новые модели):

Также компания представила новый чип в семействе энергоэффективных, рассчитанных на долгий цикл процессоров, — Silver 4210T (10 ядер, 2,3/3,2 ГГц, 13,75 Мбайт, 95 Вт, $554). Как и старая 8-ядерная модель Silver 4209T, новая тоже не поддерживает Intel Optane DC Persistent Memory. И наконец для односокетных серверов, где принципиальную роль играет стоимость, представлена 16-ядерная модель Gold 6208U (2,9/3,9 ГГц, 22 Мбайт, 150 Вт, $989, поддержка Intel Optane DC Persistent Memory). Запуск новых моделей призван сделать предложения Intel более конкурентоспособными по сравнению с 7-нм чипами AMD EPYC Rome — неслучайно затронуты были наиболее ходовые процессоры. Самое производительное (и дорогое) семейство Xeon Platinum 9000 с количеством ядер от 32 до 56 обновлено не было. Повышение показателя цены/производительности — главный повод к запуску Cascade Lake R (снижение наблюдается кратное). В новой серии процессоры разделены между семействами Bronze, Silver и Gold. Неслучайно процессоров Platinum в ней нет: старшие модели, в том числе и 28-ядерный флагман, вошли в семейство Gold. Поэтому Intel законно поставила на «новинки» более низкие ценники. Ранее компания уже серьёзно пересмотрела свои серверные предложения. Она, по сути, отказалась от процессоров серии M, которые, в отличие от стандартных решений, ограниченных объёмом ОЗУ в 1,5 Тбайт, позволяют работать в системах с 2 Тбайт памяти. Клиентам, нуждающимся в таком объёме ОЗУ, теперь предлагается использовать процессоры класса выше — L, поддерживающие уже 4,5 Тбайт. Для этого компания уравняла цены моделей L с M. Впрочем, не все OEM-производители спешат обесценить свои запасы и задерживают снижение цен. Помимо процессоров Intel также представила 17 обновлённых решений Select Solutions, в которых реализована поддержка этих новых продуктов для ускорения наиболее важных рабочих нагрузок у заказчиков. Ведущие отраслевые производители уже начинают поставки новых платформ на базе Intel Xeon 2-го поколения Refresh. Calxeda: взлёт и падение первого разработчика серверных процессоров ARM

19.02.2020 [17:16],

Алексей Степин

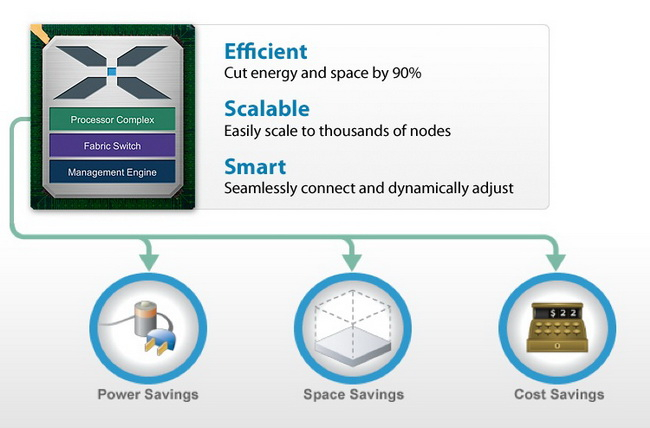

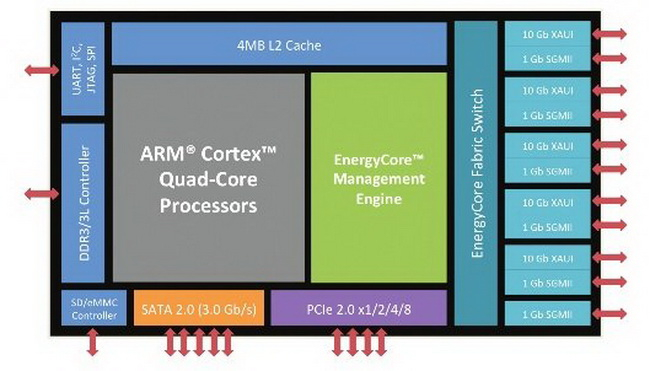

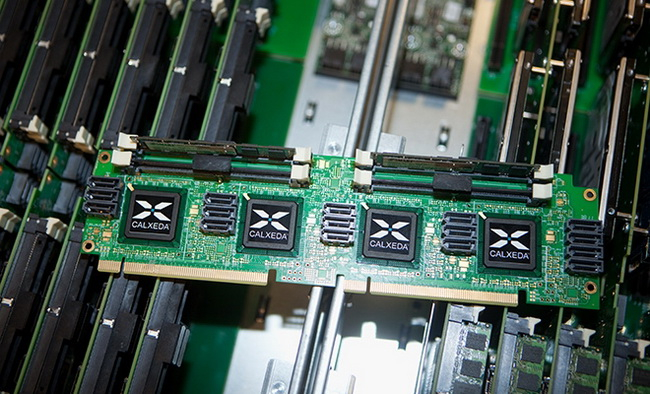

Архитектура ARM активно прокладывает себе путь в серверные системы и даже в суперкомпьютеры. Но судьба первой компании, рискнувшей сделать ставку на ARM, вовсе не так радужна. В 2011 году компания Calxeda опубликовала сведения о 32-бит серверном процессоре на базе ARM Cortex-A9. В 2020 году можно считать, последний гвоздь в крышку гроба этих CPU забит — в ядре Linux поддержка платформ Calxeda будет в ближайшее время прекращена. Но мы считаем, что те, кто первыми бросил вызов могуществу x86, заслуживают памяти.  Ещё первая разработка Calxeda, четырёхъядерный процессор ARM Cortex-A9, о котором мы писали в 2011 году, позволял создавать серверы формата 2U со 120 процессорами (480 ядер совокупно). Компания называла свою затею «первопроходческой инициативой» и планировала развернуть вокруг своих разработок целую экосистему — и спрос на такие решения был.