|

Опрос

|

реклама

Быстрый переход

В Калифорнии задержаны два китайца, подозреваемые в организации нелегальных поставок ускорителей Nvidia в Китай

06.08.2025 [05:08],

Алексей Разин

Поиски лиц, причастных к контрабанде попадающих под экспортные ограничения США ускорителей вычислений в Китай, ведутся не только за пределами первой из стран, но и на её территории. В Калифорнии власти задержали двоих лиц китайской национальности, подозреваемых в организации поставок запрещённых ускорителей Nvidia на десятки миллионов долларов США.

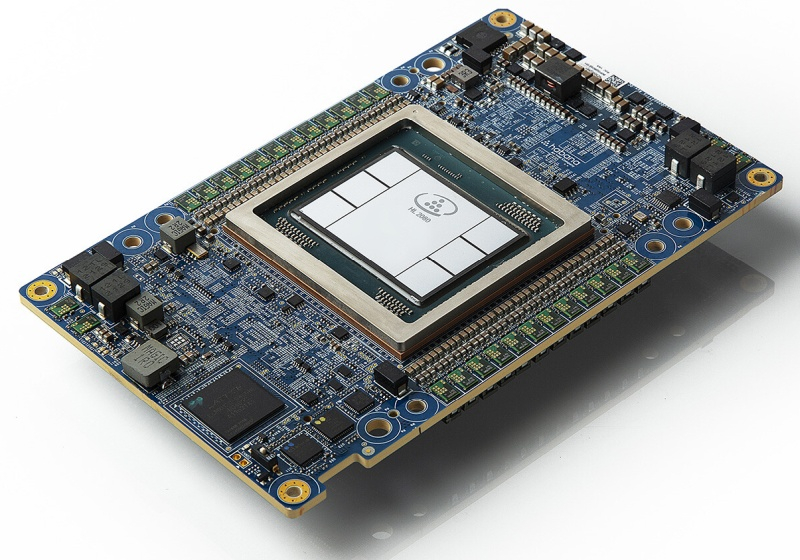

Источник изображения: Nvidia Об этом со ссылкой на Министерство юстиции США сообщило накануне агентство Reuters. Подозреваемые в период с октября 2022 года по июнь 2025 года, находясь в Калифорнии, как предполагает следствие, занимались экспортом в Китай ускорителей вычислений Nvidia, не получая необходимых для этого лицензий в Министерстве торговли США. Слушания по делу начались в Лос-Анджелесе в этот понедельник, один из подозреваемых, обладающий гражданством США, был отпущен под залог в $250 000. Его предполагаемая сообщница, чья виза для пребывания на территории страны оказалась просрочена, была заключена под стражу. Задержанные вскоре после введения экспортных ограничений против Китая в этой сфере в 2022 года создали компанию ALX Solutions, зарегистрированную в Калифорнии, которая затем переправила в Китай через подставные фирмы в Сингапуре и Малайзии более 20 партий ускорителей Nvidia, находящихся под санкциями. За свою деятельность ALX получила вознаграждение в несколько десятков миллионов долларов США от компаний в Китае и Гонконге. В период с августа 2023 по июль 2024 года калифорнийская компания приобрела более 200 ускорителей H100 в составе систем производства Super Micro Computers, указав в качестве конечных получателей компании в Сингапуре и Японии. Предназначение одной из партий стоимостью более $28 млн так и не удалось подтвердить, хотя поставщик уверял, что ускорители предназначались для компании в Сингапуре, которой на практике не существует по указанному адресу, как показало следствие. Nvidia предсказуемо открестилась от своей причастности к данным поставкам и выступила с осуждением контрабанды. Поставленные таким образом решения лишаются официальной поддержки и обновлений, как она подчеркнула. Super Micro выразила солидарность с Nvidia и заявила, что активно сотрудничает со следствием. В Китае расцвёл бизнес по ремонту санкционных ускорителей Nvidia

25.07.2025 [08:36],

Алексей Разин

Активность «контрабандистов», стремящихся насытить китайский рынок новейшими ускорителями вычислений Nvidia, не способна сделать это в полной мере, поэтому внутри страны получил развитие бизнес по ремонту ранее ввезённого серверного оборудования. Количество компаний, оказывающих подобные услуги, превышает в Китае десять штук.

Источник изображения: Nvidia По крайней мере, Reuters ссылается на опыт двух таких компаний, действующих в районе Шэньчжэня, которые специализируются на ремонте ускорителей Nvidia H100 и A100, попавших на территорию Китая тем или иным способом. По большому счёту, специалисты берутся за ремонт и многих других ускорителей, ввезти которые в Китай по легальным каналам не представляется возможным. Если ускорители A100 с архитектурой Ampere успели попасть в Китай по официальным каналам, прежде чем попали под запрет, то более совершенные H100 в КНР легально вообще не поставлялись, поскольку ещё до начала отгрузок попали под экспортные ограничения США в сентябре 2022 года. Одна из китайских компаний, о которых идёт речь, около 15 лет специализировалась на ремонте игровых видеокарт Nvidia, прежде чем в конце 2024 года решила заняться восстановлением работоспособности ускорителей вычислений той же марки. Ежемесячно компания способна восстанавливать по 500 ускорителей Nvidia, она обладает собственным центром обработки данных, в котором прошедшие через процедуру ремонта ускорители «обкатываются» в условиях, приближённых к реальным. Сама Nvidia не может предоставлять официальные услуги по гарантийному ремонту своего оборудования на территории КНР в силу наличия соответствующих санкций. Официальная политика компании подразумевает, что в течение трёх первых лет эксплуатации дефектные ускорители просто меняются на новые. Поскольку пользователи нелегально ввезённых в Китай ускорителей Nvidia не могут претендовать на гарантийное обслуживание, эту рыночную нишу заняли местные предприниматели. Не все китайские разработчики готовы использовать ускорители Nvidia H20, ввоз которых в страну был недавно разрешён властями США, поэтому спрос на ремонт более производительных H100 сохранится, как отмечают источники. В зависимости от условий эксплуатации, среднестатистический ускоритель вычислений Nvidia требует ремонта каждые два года или пять лет. Услуга по ремонту каждого в Китае обходится заказчику в сумму от $1400 до $2800, но затраты всё равно себя оправдывают на фоне дефицита ускорителей и их высокой начальной стоимости. Некоторые профильные компании установили тариф в 10 % от начальной цены ускорителя за услугу по его ремонту. Мощный ИИ-чип Huawei Ascend 910D имеет шансы превзойти по производительности чип Nvidia H100

28.04.2025 [05:28],

Анжелла Марина

Компания Huawei готовится к тестированию нового процессора для искусственного интеллекта Ascend 910D, который, как надеются в компании, сможет заменить на внутреннем рынке часть высокопроизводительных чипов американского техногиганта Nvidia.

Источник изображения: Huawei Technologies Huawei уже начала переговоры с китайскими технологическими компаниями на предмет тестирования нового ИИ-чипа, сообщает The Wall Street Journal. Первые образцы процессора поступят на проверку уже в конце мая. Однако разработка пока находится на ранней стадии, и для оценки его производительности потребуется серия испытаний. При этом Huawei рассчитывает, что Ascend 910D превзойдёт чип Nvidia H100, широко используемый для обучения ИИ. Ранее США ужесточили экспортные ограничения на поставки в Китай чипа Nvidia H20, что открыло дополнительные возможности для Huawei и других местных производителей, которые, несмотря на санкции, продолжают укреплять позиции Китая в полупроводниковой отрасли. Huawei стала одним из лидеров в разработке отечественных аналогов чипов Nvidia и доказала способность обходить американские ограничения, выпустив флагманский смартфон Mate 60 на китайском процессоре. Его презентация в 2023 году во время визита в Китай тогдашнего министра торговли США Джины Раймондо (Gina Raimondo) вызвала беспокойство в Вашингтоне. В этом году Huawei планирует поставить более 800 000 чипов Ascend 910B и 910C государственным телекоммуникационным компаниям и частным разработчикам ИИ, включая ByteDance (владельца TikTok). После ввода ограничений на H20 некоторые клиенты уже обсуждают увеличение заказов на версию Ascend 910C. Хотя китайские чипы пока отстают от западных аналогов на несколько лет, Huawei и другие местные производители находят способы повышать их производительность, объединяя несколько чипов в одной системе. Так, в апреле компания представила вычислительную систему CloudMatrix 384, которая, по мнению аналитиков, в некоторых задачах даже превосходит флагманские решения Nvidia, несмотря на большее энергопотребление. Однако масштабное производство таких чипов остаётся проблемой из-за того, что Huawei лишена доступа к крупнейшему тайваньскому производителю микросхем TSMC, а китайская SMIC не может закупать самое современное оборудование. «Однако даже если отдельно взятый GPU Huawei на треть слабее Nvidia Blackwell, их общее количество компенсирует этот разрыв», — отмечается в отчёте SemiAnalysis. Эксперты также признают, что проблемы с энергоэффективностью есть, но для Китая они не являются критичными. Сроки поставок ИИ-ускорителей Nvidia H100 сократились до 2–3 месяцев

10.04.2024 [20:59],

Николай Хижняк

Cроки поставок ИИ-ускорителей Nvidia H100 сократились с 3–4 до 2–3 месяцев (8–12 недель), сообщает DigiTimes со ссылкой на заявление директора тайваньского офиса компании Dell Теренса Ляо (Terence Liao). ODM-поставщики серверного оборудования отмечают, что дефицит специализированных ускорителей начал снижаться по сравнению с 2023 годом, когда приобрести Nvidia H100 было практически невозможно.

Источник изображения: Nvidia По словам Ляо, несмотря на сокращение сроков выполнения заказов на поставки ИИ-ускорителей, спрос на это оборудование на рынке по-прежнему чрезвычайно высок. И несмотря на высокую стоимость, объёмы закупок ИИ-серверов значительно выше закупок серверного оборудования общего назначения. Окно поставок в 2–3 месяца — это самый короткий срок поставки ускорителей Nvidia H100 за всё время. Всего шесть месяцев назад он составлял 11 месяцев. Иными словами, клиентам Nvidia приходилось почти год ждать выполнение своего заказа. С начала 2024 года сроки поставок значительно сократились. Сначала они упали до 3–4 месяцев, а теперь до 2–3 месяцев. При таком темпе дефицит ИИ-ускорителей может быть устранён к концу текущего года или даже раньше. Частично такая динамика может быть связана с самими покупателями ИИ-ускорителей. Как сообщается, некоторые компании, имеющие лишние и нигде не использующиеся H100, перепродают их для компенсации огромных затрат на их приобретение. Также нынешняя ситуация может являться следствием того, что провайдер облачных вычислительных мощностей AWS упростил аренду ИИ-ускорителей Nvidia H100 через облако, что в свою очередь тоже частично помогает снизить на них спрос. Единственными клиентами Nvidia, которым по-прежнему приходится сталкиваться с проблемами в поставках ИИ-оборудования, являются крупные ИИ-компании вроде OpenAI, которые используют десятки тысяч подобных ускорителей для быстрого и эффективного обучения своих больших языковых ИИ-моделей. ИИ-ускоритель Intel Gaudi2 оказался на 55 % быстрее Nvidia H100 в тестах Stable Diffusion 3, но есть нюанс

12.03.2024 [18:34],

Сергей Сурабекянц

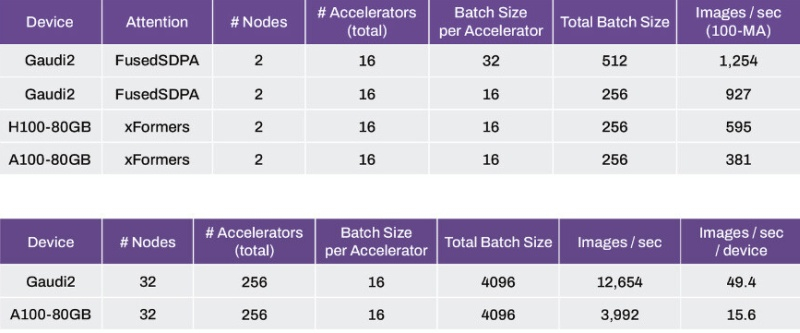

Компания Stability AI, разработчик популярной модели генеративного ИИ Stable Diffusion, сравнила производительность модели Stable Diffusion 3 на популярных ускорителях вычислений для центров обработки данных, включая Nvidia H100 Hopper, A100 Ampere и Intel Gaudi2. По утверждению Stability AI, Intel Gaudi2 продемонстрировал производительность примерно на 56 % выше, чем Nvidia H100.

Источник изображения: Intel В отличие от H100, который представляет собой суперскалярный графический процессор с тензорными CUDA-ядрами, Gaudi2 специально спроектирован для ускорения генеративного ИИ и больших языковых моделей (LLM). В тестах приняли участие пары кластеров, которые в сумме обеспечивали по 16 тех или ускорителей, а проводились тесты с постоянным размером батча (число тренировочных объектов) в 16 на каждый ускоритель (всего 256). Системы на Intel Gaudi2 оказались способны генерировать 927 изображений в секунду по сравнению с 595 изображениями для ускорителей H100 и 381 изображением в секунду для массива A100.

Источник изображения: Stability AI При увеличении количества кластеров до 32, а числа ускорителей до 256 и размере батча 16 на ускоритель (общий размер 4096), массив Gaudi2 генерирует 12 654 изображения в секунду или 49,4 изображения в секунду на ускоритель, по сравнению с 3992 изображениями в секунду или 15,6 изображениями в секунду на устройство у массива A100 Ampere.

Источник изображения: Nvidia Необходимо отметить, что производительность ускорителей ИИ измерялась с использованием фреймворка PyTorch, а в случае применения оптимизации TensorRT чипы A100 создают изображения до 40 % быстрее, чем Gaudi2. Тем не менее, исследователи Stability AI ожидают, что при дальнейшей оптимизации Gaudi2 превзойдёт A100. Компания полагает, что более быстрый интерконнект и больший объем памяти (96 Гбайт) делают решения Intel вполне конкурентоспособными и планирует использовать ускорители Gaudi2 в Stability Cloud.

Источник изображения: techpowerup.com По сообщению Stability AI, в более ранних тестах модели Stable Diffusion XL с использованием фреймворка PyTorch ускоритель Intel Gaudi2 генерирует при 30 шагах изображение размером 1024 × 1024 за 3,2 секунды по сравнению с 3,6 секунды для PyTorch на Nvidia A100 и 2,7 секунды при использовании оптимизации TensorRT на Nvidia А100. |