Технологии подделки голоса при помощи искусственного интеллекта являются довольно опасным инструментом — они способны правдоподобно воспроизвести человеческий голос даже по короткому образцу. Не допустить создание искусной подделки сможет предложенный американским учёным алгоритм AntiFake.

Источник изображения: Gerd Altmann / pixabay.com

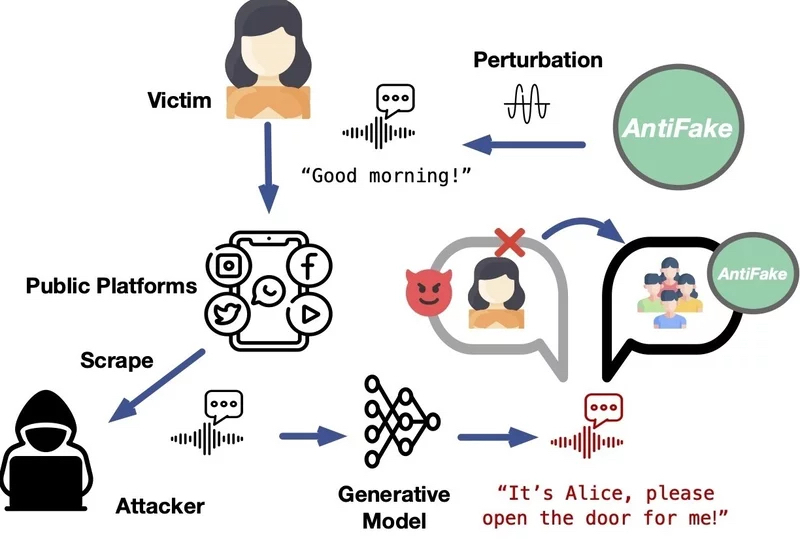

Дипфейки представляют собой достаточно опасное явление — с их помощью можно приписать знаменитому артисту или политику высказывание, которого он никогда не делал. Были также прецеденты, при которых злоумышленник звонил жертве и голосом друга просил срочно перевести деньги в связи с некой чрезвычайной ситуацией. Доцент кафедры компьютерных наук и инженерии Вашингтонского университета в Сент-Луисе Нин Чжан (Ning Zhang) предложил технологию, которая значительно усложняет создание голосовых дипфейков.

Принцип работы алгоритма AntiFake состоит в формировании условий, при которых системе ИИ оказывается намного сложнее считывать ключевые характеристики голоса при записи разговора реального человека. «В инструменте используется техника состязательного ИИ, которая изначально применялась киберпреступниками, но теперь мы направили её против них. Мы немного искажаем записанный аудиосигнал, создавая возмущения ровно в той мере, чтобы для человека он звучал так же, а для ИИ — совершенно иначе», — прокомментировал свой проект господин Чжан.

Источник изображения: wustl.edu

Это значит, что при попытке создать дипфейк на основе изменённой этим способом записи сгенерированный ИИ голос не будет похож на голос человека в образце. Как показали проведённые испытания, алгоритм AntiFake на 95 % эффективен для предотвращения синтеза убедительных дипфейков. «Что будет с голосовыми ИИ-технологиями дальше, я не знаю — новые инструменты и функции разрабатываются постоянно, — но всё же считаю, что наша стратегия использования техники противника против него самого так и останется эффективной», — заключил автор проекта.

Источник:

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018