|

Опрос

|

реклама

Быстрый переход

После скандала с Grok в Apple App Store и Google Play нашли десятки ИИ-приложений для раздевания людей

27.01.2026 [19:30],

Сергей Сурабекянц

По данным организации Tech Transparency Project (TTP), в магазинах приложений размещены десятки программ, которые могут при помощи ИИ создавать изображения обнажённых людей по их фотографиям. Январская проверка TTP выявила 55 таких приложений в Google Play и 47 — в Apple App Store. В TTP подчеркнули, что некоторые приложения маскируются под инструменты для «смены одежды», но в реальности создают «оскорбительные, сексуализированные изображения».  TTP начала своё расследование после появления сообщений о том, что ИИ-бот Grok компании xAI буквально забрасывал соцсеть X дипфейками сексуального характера, сгенерированными без согласия пользователей. В рамках исследования TTP были протестированы два типа приложений — те, которые использовали ИИ для создания изображений женщин без одежды, а также приложения для «замены лиц». «Совершенно очевидно, что это не просто приложения для смены одежды, — уверена директор TTP Кэти Пол (Katie Paul). — Они определённо были разработаны для сексуализации людей без их согласия». Официальная политика разработчиков Google Play не допускает «приложения, которые якобы раздевают людей или показывают сквозь одежду, даже если они помечены как приложения для розыгрышей или развлечений». Руководство Apple по проверке приложений также запрещает материалы, которые являются «откровенно сексуальными или порнографическими». «Обе компании заявляют о своей приверженности безопасности пользователей, но они размещают множество приложений, которые могут превратить безобидную фотографию женщины в оскорбительное, сексуализированное изображение», — говорится в отчёте TTP о магазинах приложений Apple и Google. Согласно отчёту аналитической компании AppMagic, приложения, выявленные TTP, в совокупности имеют более 700 миллионов загрузок по всему миру и принесли $117 млн дохода. И Apple, и Google получают часть дохода, полученного от приложений, распространяемых через их магазины. По данным TTP, из рассмотренных приложений 14 были разработаны в Китае. Пол отметила, что это создаёт дополнительную проблему безопасности. «Законы Китая о хранении данных означают, что китайское правительство имеет право на данные любой компании в любой точке Китая, — пояснила Пол. — Поэтому, если кто-то создаёт дипфейк обнажённых тел с вашим участием, эти данные теперь находятся в руках китайского правительства». Представитель Apple заявил, что компания удалила 28 приложений, указанных в отчёте. Компания также предупредила разработчиков других подобных программ о риске их исключения из Apple App Store, если нарушения правил не будут устранены. Два из удалённых Apple приложений были восстановлены в магазине после того, как разработчики представили новые версии, в которых были исправлены нарушения. Представитель Google сообщил, что компания приостановила работу нескольких приложений, упомянутых в отчёте TTP, за нарушение правил магазина. Компания отказалась назвать конкретное количество удалённых программ, поскольку расследование ещё не завершено. В августе 2025 года Национальная ассоциация генеральных прокуроров направила письма платёжным платформам, включая Apple Pay и Google Pay, выразив обеспокоенность по поводу сервисов, создающих интимные изображения без согласия пользователя, и потребовав удалить такие сервисы из своих сетей. В сентябре 2025 года издание CNBC провело собственное расследование в отношении приложений и веб-сайтов, предназначенных для создания обнажённых изображений. Новые модели ИИ сделали создание дипфейков с обнажёнными телами и откровенным контентом проще, чем когда-либо, а сами сервисы интегрированы в удобные для пользователя приложения. В ходе расследования было выявлено как минимум 80 женщин, чьи общедоступные фотографии в социальных сетях были использованы для создания порнографических дипфейков. ИИ-бот Grok «раздевает» по 190 людей в минуту — за 11 дней создано 3 млн дипфейков, в том числе с детьми

23.01.2026 [08:23],

Владимир Фетисов

Ранее уже сообщалось о том, что ИИ-бот Grok компании xAI буквально забрасывал соцсеть X дипфейками сексуального характера, сгенерированными без согласия пользователей. Теперь же стали известны конкретные цифры, позволяющие оценить масштаб проблемы.

Источник изображения: Engadget По данным Engadget, за 11 дней Grok сгенерировал около 3 млн дипфейков сексуального характера, причём около 23 тыс. из них содержали изображения несовершеннолетних. Иначе говоря, в течение 11 дней Grok генерировал примерно 190 фейковых изображений сексуального характера в минуту. На этой неделе британская некоммерческая организация Центр по борьбе с цифровой ненавистью (CCDH) опубликовала свои выводы по данному вопросу, основанные на случайной выборке из 20 тыс. сгенерированных с помощью Grok изображений в период с 29 декабря по 9 января. Специалисты организации также экстраполировали полученные данные для более масштабной оценки, основанной на 4,6 млн изображений, созданных Grok за указанный период. В рамках исследования дипфейки сексуального характера определялись как «фотореалистичные изображения человека в сексуальных позах, ракурсах или ситуациях; человека в нижнем белье, купальнике или аналогичной открытой одежде» и др. Исследование CCDH не учитывало текстовые промпты, поэтому в полученных результатах нет разделения относительно количества дипфейков, созданных на основе реальных фото и сгенерированных только по текстовым описаниям. Для определения доли изображений сексуального характера в выборке использовался ИИ-алгоритм. xAI ограничила возможность редактирования реальных фото с помощью Grok для бесплатных пользователей X в начале 9 января. Однако это не решило проблему, а лишь превратило её в премиум-функцию. Спустя несколько дней, 14 января, X полностью ограничила возможность Grok «раздевать» людей на реальных изображениях. При этом данное ограничение действовало только в самой соцсети и не распространялось на отдельное приложение Grok. По данным источника, приложение всё ещё позволяет создавать дипфейки сексуального характера. Поскольку оно распространяется через магазины Google и Apple, политика которых явно запрещает подобный контент, можно было ожидать удаления приложения с этих платформ, но этого не произошло. При этом другие подобные ИИ-генераторы для «раздевания» людей прежде оперативно удалялись из магазинов Apple и Google. Британия прижала X: соцсеть изменила политику из-за сексуальных дипфейков от Grok

14.01.2026 [20:48],

Сергей Сурабекянц

Британский премьер-министр Кир Стармер (Keir Starmer) заявил, что социальная сеть X «принимает меры для обеспечения полного соблюдения британского законодательства» в отношении дипфейков сексуального характера, созданных с помощью её ИИ-бота Grok. Соцсеть была вынуждена изменить свою политику после резкой критики со стороны Стармера и начатого британским Управлением связи расследования.

Источник изображения: xAI Ранее Стармер потребовал, чтобы соцсеть X «взяла под контроль» поток созданных с помощью ИИ фотографий частично одетых женщин и детей на платформе, назвав этот контент «позорным» и «отвратительным» и пригрозив принять жёсткие меры против платформы. «Это незаконно. Мы не собираемся это терпеть. Я попросил рассмотреть все варианты. Это отвратительно. X должна взять себя в руки и удалить этот материал. Мы примем меры, потому что это просто недопустимо», — добавил он. Изображения, созданные с помощью Grok и широко распространённые на платформе X, вызвали резкую негативную реакцию. Женщины, чьи изображения были подвергнуты цифровой обработке с помощью этого инструмента, заявили, что это было «унизительно» и «бесчеловечно». 12 января британское Управление связи (Office of Communications, Ofcom) начало официальное расследование с целью определить, нарушают ли созданные в соцсети X с помощью чат-бота Grok AI дипфейки сексуального характера законы Великобритании. Представитель соцсети X ранее заявил, что платформа принимает меры против незаконного контента, включая материалы, содержащие сцены сексуального насилия над детьми, путём его удаления, постоянной блокировки аккаунтов и сотрудничества с местными органами власти и правоохранительными органами по мере необходимости. Сегодня Стармер проинформировал Палату представителей о том, что он получил информацию о принимаемых X мерах для обеспечения полного соблюдения законодательства Великобритании. «Если это так, то это приветствуется, но мы не собираемся отступать, и они должны действовать. Мы примем необходимые меры. Мы укрепим существующие законы и подготовим законодательство, если потребуется пойти дальше, и Ofcom продолжит своё независимое расследование», — заявил он. Великобритания запустила расследование по поводу «отвратительных» порнографических дипфейков от Grok в соцсети X

12.01.2026 [19:28],

Сергей Сурабекянц

Сегодня британское Управление связи (Office of Communications, Ofcom) начало расследование с целью определить, нарушают ли созданные в соцсети X с помощью чат-бота Grok AI дипфейки сексуального характера законы Великобритании. На прошлой неделе премьер-министр страны Кир Стармер (Keir Starmer) назвал изображения, созданные Grok, «отвратительными» и «незаконными».

Источник изображения: unsplash.com «Поступили сообщения о том, что аккаунт чат-бота Grok AI на платформе X используется для создания и распространения изображений людей без одежды — что может быть расценено как злоупотребление интимными изображениями или порнография — и изображений детей сексуального характера, которые могут быть расценены как материалы, содержащие сцены сексуального насилия над детьми», — говорится в заявлении Ofcom. На вопрос о возможности запрета X в Великобритании, министр по делам бизнеса Питер Кайл (Peter Kyle) ответил: «Да, конечно», уточнив, что такие действия входят в компетенцию Ofcom. Другие британские официальные лица приветствуют официальное расследование Ofcom и ожидают его быстрого завершения. Создание или распространение интимных изображений или материалов, содержащих сексуальное насилие над детьми, без согласия пользователя, включая изображения сексуального характера, созданные с помощью ИИ, является незаконным в Великобритании. Кроме того, технологические платформы должны предотвращать доступ британских пользователей к незаконному контенту и удалять его, как только им станет известно о нем. В официальном заявлении Ofcom сказано, что в наиболее серьёзных случаях несоблюдения законов Великобритании Управление связи может обратиться в суд с требованием обязать «платёжных провайдеров или рекламодателей отозвать свои услуги с платформы» или обязать интернет-провайдеров заблокировать доступ к сервису. Представитель соцсети X ранее заявил, что платформа принимает меры против незаконного контента, включая материалы, содержащие сцены сексуального насилия над детьми, путём его удаления, постоянной блокировки аккаунтов и сотрудничества с местными органами власти и правоохранительными органами по мере необходимости. «Любой, кто использует Grok или побуждает его к созданию незаконного контента, столкнётся с теми же последствиями, что и при загрузке незаконного контента», — говорится в заявлении компании. Кроме того, X заявила, что запросы на изображения с раздеванием людей доступны только для платных пользователей. Соцсеть X подверглась осуждению и в других странах из-за возможности создания сексуального контента. Французские чиновники обратились в прокуратуру и регулирующие органы, назвав контент «явно незаконным», а индийские власти потребовали официальных объяснений от руководства компании. В 2025 году дипфейки стали почти неотличимы от реальности, и дальше будет только хуже

27.12.2025 [14:07],

Павел Котов

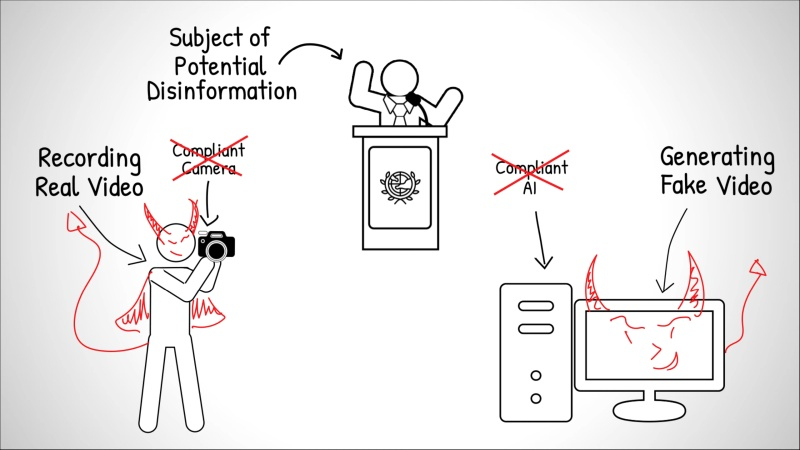

За 2025 год качество дипфейков — создаваемых при помощи искусственного интеллекта медиафайлов — значительно повысилось. Лица, голоса и движения тела, которые ИИ генерирует, имитируя реальных людей, превзошли ожидания многих экспертов; эти материалы всё чаще используются, чтобы обманывать людей, предупреждает Gizmodo.

Источник изображения: Tom Kotov / unsplash.com Во многих повседневных ситуациях, будь то видеозвонки низкого разрешения или медиаконтент в соцсетях, качество ИИ-дипфейков уже достаточно высоко, чтобы обмануть простых людей, которые не являются экспертами. Качеством всплеск дипфейков не ограничивается: в 2023 году таких материалов было 500 тыс., а в 2025 году их стало около 8 млн, подсчитали в DeepStrike, и темпы роста составляют около 900 % в год. Резкому росту показателей способствовали несколько технических прорывов. Во-первых, генерируемые ИИ материалы отличаются согласованностью по времени: люди в кадре правдоподобно движутся, люди легко узнаются, а содержание видео остаётся осмысленным в каждом кадре. Модели отделяют информацию, связанную с представлением личности человека, от информации о движении: одно и то же движение может сопоставляться с разными личностями, а одна и та же личность — с несколькими типами движений. Изображения лиц не мерцают, не искажаются и не имеют деформаций, которые раньше явно указывали на дипфейки. Во-вторых, качество клонирования голоса уже преодолело условный порог неразличимости. Чтобы создать убедительную имитацию голоса, достаточно нескольких секунд — у клона будут естественная интонация, ритм, акцент, эмоции, паузы и даже шум дыхания. И это огромное пространство для крупномасштабного мошенничества. Субъективные признаки, которые раньше выдавали синтетические голоса, в значительной степени исчезли. В-третьих, технический барьер для работы с генераторами контента, снизился практически до нуля — с OpenAI Sora 2 и Google Veo 3, а также с моделями некоторых стартапов любой желающий может сформулировать идею, составить подробный сценарий при помощи OpenAI ChatGPT или Google Gemini и в считанные минуты сгенерировать качественный контент. Автоматизировать весь процесс можно при помощи ИИ-агентов. В итоге возможность создавать связные дипфейки с сюжетами в больших масштабах уже демократизировали.

Источник изображения: Mark Farías / unsplash.com Выявлять неотличимые от реальных людей дипфейки в социальных сетях становится крайне непросто, тем более, что внимание пользователей платформ уже фрагментировано, и материалы распространяются быстрее, чем их можно проверить. Дипфейки используются для дезинформации, преследования людей и финансовых махинаций, и люди не успевают понять, что вообще происходит. Траектория на следующий год представляется очевидной — дипфейки движутся в сторону генерации контента в реальном времени. Видеоролики максимально точно имитируют нюансы внешности человека и оказываются способны обходить системы обнаружения. Граница смещается от статического визуального реализма к согласованности по времени и поведению — контент будет появляться в реальном времени, и предварительно отрисованными клипами дело уже не обойдётся. Результат выйдет за рамки простого узнавания человека — персонажи на роликах будут вести себя как их реальные прототипы. Участники видеозвонков смогут синтезироваться в реальном времени — их лица, голоса и манеры будут мгновенно адаптироваться к запросам, и вместо записанных видеороликов мошенники станут показывать своим жертвам подобные ИИ-аватары. Субъективное восприятие уже не поможет людям защититься от подобных дипфейков — потребуются технические средства защиты, например, криптографическая подпись подлинных материалов и маркировка средств ИИ-редактирования. Тщательного изучения картинки на уровне пикселей может оказаться уже недостаточно. Дипфейковый Хуанг стал популярнее настоящего — трансляция Nvidia GTC от мошенников собрала в пять раз больше зрителей

29.10.2025 [05:34],

Николай Хижняк

Ничего не подозревающие зрители YouTube, ожидавшие во вторник основного доклада Nvidia в рамках конференции GTC 2025, вполне могли случайно увидеть сгенерированный искусственным интеллектом дипфейк с Дженсеном Хуангом (Jensen Huang), рекламирующим мошенническую схему с криптовалютой. Платформа YouTube разместила это видео в трендах выше настоящей трансляции Nvidia.

Источник изображения: Tom's Hardware Пользователь соцсети X Дилан Мартин (Dylan Martin) обратил внимание, что фейковая трансляция (теперь отключенная) на самом деле велась на канале Offxbeatz. Примерно через 20 минут после начала реального выступления Дженсенса Хуанга фейковую трансляцию смотрели около 90 000 человек. Мартин отмечает, что она даже была первым результатом поиска на YouTube по запросу Nvidia GTC DC — вполне резонному запросу для любого, кто хотел посмотреть реальную трансляцию. В какой-то момент фейковую трансляцию о мошенничестве с криптовалютой смотрели около 95 000 человек, а настоящую — всего 12 000.

Фейковая трансляция GTC 2025 собрала больше просмотров, чем настоящая «Внимание: на YouTube сейчас идёт фейковая трансляция с Nvidia GTC DC, организованная каналом NVIDIA Live. Похоже, это дипфейк с Дженсеном Хуангом, рекламирующим “мероприятие по массовому внедрению криптовалют”. И, конечно же, не связывайтесь с этим QR-кодом на изображении», — написал Мартин. Мартин даже смог создать расшифровку фейковой трансляции с помощью Otter AI. Ненастоящий Дженсен поприветствовал всех присутствующих на мероприятии, а затем заявил: «Но прежде, чем мы перейдём к основному докладу, у меня есть сюрприз, который слишком захватывающий, чтобы ждать. Мы отложим основную презентацию на мгновение, чтобы объявить о чём-то действительно особенном — о мероприятии, посвящённом массовому внедрению криптовалют, которое напрямую связано с миссией Nvidia по ускорению прогресса человечества». Фейковый Дженсен отметил, что этот шаг — не просто случайный ход. Он начал восхвалять видеокарты Nvidia за обеспечение аппаратной поддержки смарт-контрактов Ethereum, высокоскоростных транзакций Solana и эффективных трансграничных платежей с помощью XRP. Конечно же, ничего из этого не является правдой. Фейковая трансляция, сопровождавшаяся расположенным на экране QR-кодом для зрителей, предлагала схему распределения криптовалюты, призывая зрителей отправлять поддерживаемые криптовалюты. Разработана система генерации голосовых дипфейков в реальном времени, и её наверняка будут использовать мошенники

25.10.2025 [17:59],

Павел Котов

Специализирующаяся на технологиях кибербезопасности компания NCC Group создала работающий на основе искусственного интеллекта метод воссоздания голоса любого человека, функционирующий в реальном времени. Система построена на общедоступных программных решениях и общедоступном оборудовании.

Источник изображения: Vitaly Gariev / unsplash.com Средство для создания голосовых дипфейков в реальном времени после обучения активируется всего одним нажатием кнопки — управление осуществляется при помощи веб-интерфейса, и потенциальный злоумышленник может изобразить из себя кого угодно. Невысоким может быть и качество входного сигнала — голос на выходе всё равно звучит убедительно, а задержка оказывается незначительной. Это значит, что данное решение можно использовать даже с микрофонами, встроенными в ноутбуки и смартфоны. Работа в режиме реального времени — важное преимущество. Существующие технологии подделки голоса на выходе выдают звуковой файл. То есть злоумышленник может заранее записать реплики, но потенциальная жертва легко разоблачит схему, если разговор отклонится от ожидаемого сценария. А если мошенник попробует сгенерировать дипфейк на лету, его выдаст задержка в разговоре. Инженеры NCC Group опробовали свою технологию на собственных клиентах — с их разрешения, конечно — и те ни разу не заметили подвоха. В программной части решения используются инструменты с открытым исходным кодом, а для эффективной работы аппаратной желательно использовать мощные видеокарты, но и ноутбук с одной из наименее производительных в актуальной линейке Nvidia RTX A1000 давал задержку всего в полсекунды. К счастью дипфейки с видеорядом пока не работают в реальном времени. Сейчас крупные соцсети, в том числе TikTok, YouTube и Instagram✴✴ захлестнула очередная волна видеодипфейков, для создания которых используются два инструмента: генератор картинок Google Gemini Flash 2.5 Image (он же Nano Banana) и открытый генератор видео Alibaba WAN 2.2 Animate — они позволяют добавлять на видеоролик любого человека. Слабой стороной дипфейков с видео пока остаётся недостаточная согласованность картинки и звукового ряда — мимика не всегда соответствует интонациям, а если человек якобы взволнован, но его лицо остаётся спокойным — это, вероятно, подделка. Но новые решения заставляют задуматься о необходимости усовершенствовать средства защиты: методы аутентификации теперь не должны полагаться на голосовые и видеозвонки, предупреждают эксперты. Сэма Альтмана поймали за руку при попытке украсть видеокарту — это самое популярное ИИ-видео в Sora

02.10.2025 [16:06],

Павел Котов

По интернету начало гулять сгенерированное искусственным интеллектом ироничное видео, на котором генерального директора OpenAI Сэма Альтмана (Sam Altman) ловят при попытке украсть видеокарту из супермаркета. Ролик называют самым популярным на площадке OpenAI Sora на данный момент.

Источник изображения: x.com/GabrielPeterss4 В опубликованном на платформе X ролике виртуальный Альтман берет с полки видеокарту и пытается покинуть магазин, похожий на одну из точек американской сети Target, но на выходе его задерживает охранник, а глава OpenAI произносит: «Пожалуйста, она мне очень нужна для запуска Sora. Слишком уж хорошее видео». Опубликовал ролик один из сотрудников OpenAI. Видео сгенерировала модель Sora 2, и оно стало одним из самых популярных в выпущенном недавно приложении, которое сочетает средства для создания видео и некое подобие соцсети для их публикации — своего рода ИИ-аналог TikTok. Sora 2, по утверждению OpenAI, её самая точная и реалистичная модель на сегодняшний день, предлагающая широкий набор элементов управления. Есть, впрочем, и некоторые недостатки: после того как Альтман на ролике берет видеокарту с полки, соседняя коробка начинает сама по себе двигаться; да и реплика персонажа звучит несколько нелепо. Зато дефицит ИИ-ускорителей у OpenAI — проблема вполне ощутимая; ранее компании пришлось отложить выпуск модели GPT-4.5 из-за нехватки вычислительных ресурсов. К концу года она намеревается довести число имеющихся в её распоряжении ускорителей до миллиона, а конечная цель — 100 млн. Ещё один тревожный аспект — осознание, что распознавать созданные ИИ видео со временем будет всё труднее. Ролик с кражей видеокарты Сэмом Альтманом на первый взгляд смотрится вполне реалистично, и в будущем модели ИИ станут только совершенствоваться. А значит, всё острее встаёт вопрос об их надёжной маркировке. Учёные придумали невидимые для глаз световые водяные знаки для выявления дипфейков

12.08.2025 [18:48],

Сергей Сурабекянц

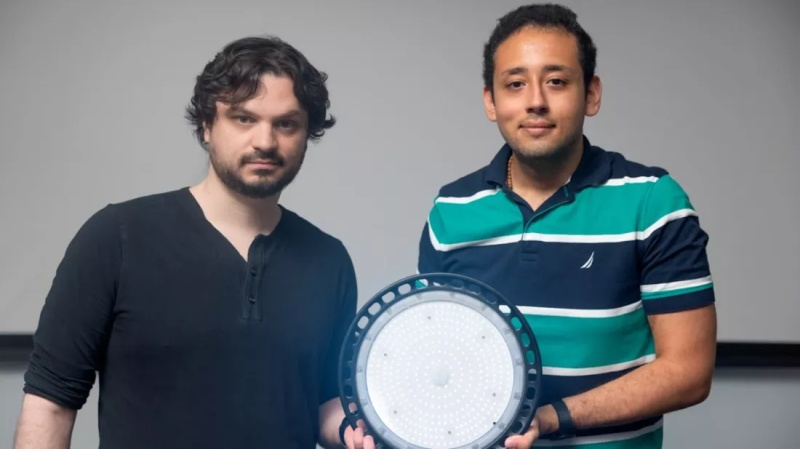

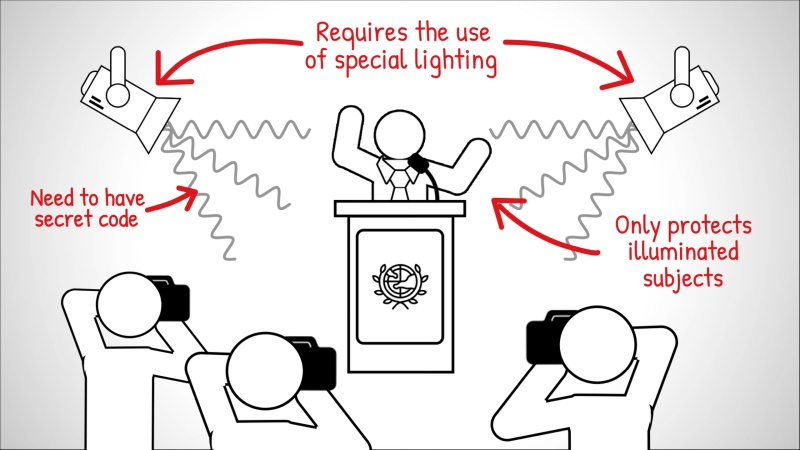

Поддельные видео становится всё сложнее выявлять, поэтому исследователи Корнеллского университета представили новую криминалистическую технологию, которая поможет специалистам удостовериться в подлинности видеоматериалов. Метод заключается во встраивании невидимых цифровых водяных знаков непосредственно в световой поток источников освещения, используемых при съёмке — например, на месте преступления.

Источник изображений: Cornell University Концепция «шумокодированного освещения» была представлена 10 августа на конференции SIGGRAPH 2025 аспирантом факультета компьютерных наук Корнеллского университета Питером Майклом (Peter Michael). Впервые этот подход был предложен и разработан доцентом Эйбом Дэвисом (Abe Davis) (на фото слева).  Обычно водяные знаки встраиваются непосредственно в видеофайлы, изменяя мельчайшие элементы изображения для создания скрытого идентификатора. Такие системы достаточно эффективны в контролируемых условиях, но требуют взаимодействия с устройством или платформой, создающей видеоматериал. При использовании несовместимой камеры или программного обеспечения цифровой водяной знак просто не появится.  Разработчики предложили при записи «встраивать» водяной знак непосредственно в световой поток от источников освещения. Это гарантирует, что любая камера — от профессионального оборудования до смартфона — запечатлеет его во время съёмки сцены. В программируемые источники света, такие как компьютерные мониторы, студийное оборудование или некоторые светодиодные приборы, можно встроить кодированные шаблоны яркости с помощью ПО. Стандартные лампы также можно адаптировать, оснастив их компактным чипом размером примерно с почтовую марку, который плавно меняет интенсивность света в соответствии с секретным кодом.  Встроенный код, разработанный на основе исследований зрительного восприятия человека, состоит из минимальных изменений частоты и яркости освещения, практически незаметных невооружённому глазу и воспринимаемых мозгом как незначительный световой шум. Уникальный код каждого источника света фактически обеспечивает параллельную запись сцены с низким разрешением и временными метками, которые Дэвис называет «видеокодами». «Когда кто-то манипулирует видео, изменённые фрагменты начинают противоречить тому, что мы видим на этих видеокодах, — пояснил Дэвис. — А если кто-то попытается сгенерировать поддельное видео с помощью ИИ, полученные видеокоды будут выглядеть просто как случайные вариации освещённости». При анализе видеоматериала специалисты могут обнаружить пропущенные последовательности, вставленные объекты или изменённые сцены. Например, удалённый из интервью фрагмент отобразится как визуальный пробел в восстановленном видеокоде, а сфабрикованные элементы — как сплошные чёрные области. Исследователи показали, что в одной сцене можно использовать до трёх независимых кодов освещения. Такое наложение увеличивает сложность водяного знака и усложняет задачу потенциальных фальсификаторов. «Даже если злоумышленник знает об этой технике и сможет вычислить коды, его задача всё равно будет значительно сложнее, — добавил Дэвис. — Вместо того чтобы имитировать свет только для одного видео, ему придётся подделывать каждый ролик с кодами отдельно, и все подделки должны будут согласовываться между собой». Полевые испытания показали эффективность метода в определённых условиях и его стабильную работу при различных оттенках кожи. Исследователи отмечают, что технология шумокодированного освещения — многообещающий шаг вперёд, но не панацея от фейковых видео. По мере развития инструментов генеративного ИИ будут совершенствоваться и методы обхода средств проверки подлинности. «Раньше видео рассматривалось как источник достоверной информации, но теперь мы не можем быть в этом уверены, — считает Дэвис. — Сегодня можно сгенерировать практически любой ролик. Это интересно, но и проблематично, потому что отличить реальность от подделки становится всё сложнее». Сэм Альтман предупредил, что скоро мошенники начнут массово похищать деньги, подделывая личность с помощью ИИ

28.07.2025 [04:50],

Алексей Разин

Создатели систем искусственного интеллекта обеспокоены проблемой их неправомерного применения, и глава OpenAI Сэм Альтман (Sam Altman) не является исключением. Во время своей беседы с вице-председателем Федрезерва США Мишель Боуман (Michelle Bowman) он заявил, что скоро на нас хлынет поток высококачественных подделок не только голоса, но и внешности любого человека, которые могут быть использованы в противозаконных целях.

Источник изображения: OpenAI, Dall-E В качестве примера Альтман приводит процедуру аутентификации клиента банка при помощи голоса и кодовой фразы. Зная последнюю, злоумышленникам не составит труда сымитировать голос человека при помощи систем искусственного интеллекта, а затем отдать распоряжение о переводе денежных средств без ведома их реального собственника. «ИИ полностью освоил все методы аутентификации, которые люди сейчас используют, кроме паролей. Сейчас это может быть голосовой вызов, вскоре это будет видео или видеозвонок, которые будут неотличимы от настоящих», — пояснил свою обеспокоенность Сэм Альтман. Подделка голоса уже давно используется мошенниками для манипуляций своими жертвами, искусственный интеллект просто даёт им более простой и эффективный инструмент, который доступен буквально каждому. Постепенно осваивается и направление видеозвонков, в которых имитируется нужный образ, но подменяется содержание разговора. Жертвами подобных преступлений уже становятся известные личности, включая политиков и чиновников. OpenAI не так много делает для предотвращения подобных злоупотреблений, хотя и пытается разработать более надёжные способы биометрической аутентификации. Так или иначе, Альтман убеждён, что скоро в руки мошенников попадут программные средства, позволяющие поставить фальсификацию личности на поток. Конец цифрового насилия: Трамп ввёл уголовную ответственность за интимные дипфейки

20.05.2025 [13:22],

Павел Котов

Президент США Дональд Трамп (Donald Trump) подписал «Закон о немедленном удалении материалов» (Take It Down Act), который переводит в разряд уголовных преступлений распространение несогласованных с объектом изображений деликатного характера, в том числе созданных с помощью искусственного интеллекта подделок (дипфейков). Закон требует, чтобы администрации соцсетей немедленно удаляли такие материалы при поступлении соответствующих запросов.

Источник изображения: Donghun Shin / unsplash.com Законопроект утвердили обе палаты Конгресса; в его поддержку высказались несколько технологических компаний, защитники прав молодёжи и родителей, а также первая леди Мелания Трамп (Melania Trump). Есть, впрочем и мнение, что утверждённый в документе подход может иметь обратный эффект и навредить тем, кого призван защищать. Закон переводит в разряд уголовных преступлений публикацию изображений деликатного характера, в том числе дипфейков, без согласия лиц, которые в этих материалах представлены, — он предусматривает наказание до трёх лет лишений свободы плюс штрафы. Администрациям социальных сетей предписывается в течение 48 часов с момента получения соответствующего уведомления удалять все такие материалы и «прилагать разумные усилия» для удаления копий таких материалов. Правозащитники, в том числе некоммерческие организации Electronic Frontier Foundation (EFF) и Center for Democracy and Technology (CDT), однако, предупреждают, что положение о запрете контента может использоваться, чтобы принуждать ответственных лиц удалять более широкий спектр материалов, чем предполагается; не исключается также угроза для технологий защиты конфиденциальности, в том числе средств шифрования — операторы соответствующих платформ не видят и не имеют возможности удалять сообщения между пользователями. Не исключаются и другие злоупотребления, в том числе избирательное отношение Федеральной торговой комиссии (FTC) к соблюдению требований закона. Введение новых норм в практику правоприменения займёт около года, считают эксперты. Исследование Honor: из-за распространения дипфейков работодатели изменят способ проведения онлайн-собеседований

17.04.2025 [01:00],

Владимир Мироненко

Поступивший в продажу в России в апреле смартфон Honor Magic 7 получил поддержку целого ряда ИИ-технологий, включая функцию распознавания дипфейков для защиты от новых видов мошенничества при видеозвонках. Согласно исследованию Honor, приуроченному к выходу смартфона Magic 7, распространение дипфейков может отразиться на процессе найма специалистов на работу, собеседование с которыми, как правило, проводится в онлайн-режиме.  В ходе опроса, проведенного Honor, выяснилось, что 81,5 % респондентов готовы делегировать искусственному интеллекту (ИИ) стрессовые задачи, а 22,7 % хотели бы делегировать искусственному интеллекту прохождение собеседований за них. Что также интересно, 1,1 % участников опроса признались, что сами создают дипфейки.  ИИ-технология, встроенная в серию смартфонов Magic 7, позволяет пользователям определять, было ли фото или видео изменено или полностью создано с помощью ИИ. Распространение дипфейков обеспокоило рекрутеров. По словам Дарьи Барковой, HR-профайлера и предпринимателя IT-рекрутингового агентства Unicorn Search, технологии дипфейков и использование ИИ-инструментов, позволяющих имитировать человека на собеседовании, ставят под сомнение достоверность результатов найма. «Кандидат может полностью заменить себя на этапе оценки, превращая цифровые каналы рекрутинга из инструмента удобства в зону уязвимости. Стандартизированные вопросы и типовые кейсы теряют актуальность — их слишком легко автоматизировать», — говорит Баркова. Она подчеркнула, что будущее — за динамичными форматами с живым взаимодействием, позволяющим определить способность кандидата на вакансию к адаптации в реальном времени и проверить индивидуальную реакцию на нестандартные условия. Анна Осипова, руководитель внешних коммуникаций hh.ru в регионах, подтвердила актуальность проблемы дипфейков. Она отметила, что случаи использования технологий дипфейков для прохождения онлайн-собеседований пока единичны, но по мере развития технологий риски их использования могут стать довольно ощутимыми, и компаниям уже сегодня необходимо подумать о мерах противодействия. «Как минимум, важно проводить более тщательный первичный скрининг кандидата, не пренебрегать проверкой через внутреннюю службу безопасности. Во время онлайн-собеседований стоит обращать внимание на качество и “естественность” видео, манеру речи», — отметила она. По мнению экспертов, уже в ближайшее время компании будут вынуждены изменить методы подбора персонала, используя новые способы проверки личности кандидатов и подлинности видео во время онлайн-собеседований. «Сбер» предсказал всплеск ИИ-мошенничества, к которому никто не готов, к середине этого года

04.03.2025 [22:43],

Дмитрий Федоров

Мошенники в 2025 году начнут активно использовать ИИ для создания дипфейков, подделки голоса и телефонных звонков на разных языках. По оценке «Сбера», финансовые институты недостаточно подготовлены к подобным угрозам, что может привести к увеличению финансовых потерь среди рядовых граждан. Банкам и государственным структурам необходима срочная модернизация систем безопасности для предотвращения таких преступлений.

Источник изображения: Wesley Tingey / Unsplash Согласно прогнозу «Сбера», уже к середине 2025 года мошенники начнут активно применять технологии генеративного ИИ для создания реалистичных подделок изображений, видеозаписей и голосов. Эти методы уже используются при создании фишинговых сайтов, но вскоре выйдут на новый уровень. «Мы прогнозируем, что примерно к середине года появятся дипфейки», — заявил заместитель председателя правления «Сбера» Станислав Кузнецов. Особенно серьёзной угрозой, связанной с развитием ИИ, станет преодоление языкового барьера в телефонном мошенничестве. Кузнецов отметил, что в ближайшие три-четыре месяца злоумышленники начнут активно применять технологии генерации речи на различных языках. «Как только модели позволяют нам сегодня преодолеть последнюю границу — языковой барьер, как только нажатием одной кнопки можно звонить в любую страну или разговаривать на любом языке, следует задуматься о том, что телефонное мошенничество появится и на башкирском, и на татарском языках», — подчеркнул он. Согласно данным, представленным Кузнецовым, 81 % мошеннических звонков совершается через мессенджеры, sim-box и облачные АТС. Оставшиеся 19 % приходятся на классические телефонные звонки, причём лишь 1 % осуществляется с подменой номера. Это означает, что основная угроза исходит именно от мессенджеров, а не от традиционной телефонии. По данным Центрального банка России (ЦБ), в 2024 году мошенники похитили у клиентов банков 27,5 млрд руб., принуждая их совершать денежные переводы. Основной инструмент преступников — методы социальной инженерии, основанные на обмане и манипуляции жертвами. Банк России направил операторам связи почти 172 тысячи номеров, использовавшихся злоумышленниками, что подчёркивает масштаб проблемы. Несмотря на снижение числа мошеннических звонков через традиционную телефонную связь, преступники продолжают активно применять мессенджеры не только для звонков, но и для рассылки вредоносного программного обеспечения (ПО) и поддельных документов. ООН рассказала об использовании Telegram преступными сетями из Юго-Восточной Азии

07.10.2024 [20:02],

Сергей Сурабекянц

Представитель ООН заявил, что в Telegram открыто и в огромных масштабах продаются похищенные данные, а также доступны инструменты для киберпреступников и услуги по отмыванию денег. В недавно опубликованном докладе ООН утверждается, что преступные группировки Юго-Восточной Азии широко используют приложение, что позволяет им вести крупномасштабную незаконную деятельность.

Источник изображения: Pixabay В отчёте Управления ООН по наркотикам и преступности (УНП ООН) говорится, что в Telegram широко продаются похищенные персональные данные, что авторы отчёта связывают со слабой модерацией в приложении. Широко доступны также инструменты, используемые киберпреступниками, включая программное обеспечение для создания дипфейков и вредоносное ПО для кражи данных, а нелицензированные криптовалютные биржи предлагают в Telegram услуги по отмыванию денег. Юго-Восточная Азия стала крупным центром многомиллиардной криминальной индустрии, которая использует мошеннические схемы для поиска жертв по всему миру. По данным УНП ООН, отрасль ежегодно генерирует от 27,4 до 36,5 млрд долларов. В качестве примера цитируется рекламное объявление на китайском языке: «Мы ежедневно переводим 3 миллиона долларов США, украденных из-за рубежа». В докладе идёт речь о китайских преступных синдикатах, замешанных в торговле людьми и использовании рабского труда. «Есть убедительные доказательства того, что подпольные рынки данных перемещаются в Telegram, а поставщики активно ищут цели для транснациональных организованных преступных группировок, базирующихся в Юго-Восточной Азии», — говорится в отчёте. В августе в Париже создателю и главе мессенджера Павлу Дурову были предъявлены обвинения по шести пунктам, в том числе в отказе от сотрудничества. Самый тяжкий пункт — соучастие в администрировании онлайн-платформы для совершения незаконных транзакций. За это Дурову грозит наказание до десяти лет лишения свободы и штраф до €500 тыс. Поводом для ареста Дурова стал отказ администрации мессенджера от сотрудничества с властями Евросоюза, а политика модерации давно вызывала критику у властей. Париж также оказался разочарован отказом платформы сотрудничать конкретно с французскими властями. После ареста Дуров заявил, что приложение станет передавать IP-адреса и номера телефонов пользователей властям, подающим официальные юридические запросы. Он также пообещал, что будут удалены некоторые функции, которые использовались для незаконной деятельности. Арест Дурова привлёк внимание к ответственности поставщиков приложений, а также вызвал дебаты о том, где заканчивается свобода слова и начинается исполнение закона. В отчёте УГП ООН говорится, что размах деятельности преступных группировок в регионе привёл к внедрению ими инноваций и новых бизнес-моделей и технологий, включая вредоносное ПО, генеративный ИИ и дипфейки. Заместитель представителя УНП ООН Бенедикт Хофман (Benedikt Hofmann) заявил, что приложение является удобной средой для преступников. «Для потребителей это означает, что их данные подвергаются большему риску попасть к мошенникам или в другую преступную схему, чем когда-либо прежде», — считает он. По словам Хофмана, УНП ООН выявило более 10 поставщиков услуг программного обеспечения для создания дипфейков, «специально нацеленных на преступные группы, занимающиеся кибермошенничеством в Юго-Восточной Азии». В настоящее время регулирующие органы Южной Кореи проводят расследование о причастности мессенджера Telegram к распространению дипфейков сексуального содержания из-за недостаточной модерации. Сообщается, что в Telegram есть каналы с более чем 200 000 подписчиков, где распространяется такой контент. В прошлом месяце агентство Reuters сообщило, что чат-боты Telegram использовались для кражи данных из ведущей индийской страховой компании Star Health, что побудило страховую компанию подать в суд на онлайн-платформу. К преступникам могли попасть документы по страхованию и претензиям, содержащие имена, номера телефонов, адреса, налоговые реквизиты, копии удостоверений личности, результаты анализов и медицинские диагнозы. Напомним, что бот для передачи информации о нарушениях правил мессенджера Telegram заработал в России с 23 сентября. Южная Корея ввела уголовную ответственность за просмотр, хранение и распространение сексуальных дипфейков

27.09.2024 [18:14],

Сергей Сурабекянц

26 сентября южнокорейский парламент принял законопроект, предусматривающий уголовную ответственность за распространение, хранение и просмотр видео или изображений, содержащих дипфейки откровенно сексуального характера. За просмотр и хранение такого контента закон предусматривает наказание в виде тюремного заключения на срок до трёх лет или штрафа до 30 млн вон ($22,6 тыс.), а за создание подобных дипфейков грозит заключение сроком до пяти лет или штраф.

Источник изображения: Pixabay Только в этом году южнокорейская полиция получила более 800 заявлений о создании дипфейков сексуального содержания. В частности, регулирующие органы Южной Кореи проводят расследование о причастности мессенджера Telegram к распространению такого контента из-за недостаточной модерации. Сообщается, что в Telegram есть каналы с более чем 200 000 подписчиков, где распространяется такой контент. Чтобы нынешний закон вступил в силу, его должен подписать президент Южной Кореи Юн Сок Ель. Российские законодатели также на днях предложили добавить ответственность за дипфейки в Уголовный кодекс — в Госдуму внесён законопроект, предлагающий признать использование дипфейков отягощающим обстоятельством при мошенничестве и клевете. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |