|

Опрос

|

реклама

Быстрый переход

YouTube больше не станет терпеть дипфейки и ИИ-плагиат

06.09.2024 [07:46],

Анжелла Марина

YouTube сказал твёрдое «нет» дипфейкам и ИИ-плагиату, защищая права авторов на платформе. По данным The Verge, компания начинает разработку новых инструментов, которые дадут создателям контента больше контроля над использованием их голоса и образа, сгенерированного искусственным интеллектом.

Источник изображения: convertcrypto.ru Первый инструмент, получивший название «технология идентификации синтезированного пения», позволит артистам и авторам автоматически распознавать и управлять контентом YouTube, в котором их голоса имитируются с помощью искусственного интеллекта. Эта технология будет интегрирована в существующую систему идентификации авторских прав Content ID и запущена в рамках пилотной программы в следующем году. Решение YouTube связано с растущим беспокойством в музыкальной индустрии по поводу использования ИИ для создания копий песен и голосов артистов. В открытом письме, опубликованном ранее в этом году, более 200 артистов, включая Билли Айлиш (Billie Eilish), Pearl Jam (Pearl Jam) и Кэти Перри (Katy Perry), назвали несанкционированное ИИ-копирование «посягательством на человеческий творческий потенциал» и потребовали от видеохостинга большей ответственности в этом отношении. Помимо защиты голосов, YouTube на своей платформе также разрабатывает инструмент для выявления дипфейков лиц и образов авторов, актёров, музыкантов и спортсменов. Однако система ещё находится в разработке и не сообщается, когда она будет запущена. В дополнение к этому, YouTube обещает бороться с теми, кто собирает данные с платформы для обучения ИИ-моделей. «Мы ясно дали понять, что несанкционированный доступ к контенту авторов нарушает наши условия обслуживания», — заявили представители YouTube. Однако это не помешало таким компаниям, как OpenAI, Apple, Anthropic, Nvidia, Salesforce и Runway AI, обучать свои ИИ-системы на тысячах скачанных с YouTube видео. Для защиты контента от ботов-сканеров YouTube планирует блокировать им доступ полностью и для этого начнёт инвестировать в систему обнаружения сбора данных. Также заявляется, что разрабатываются способы предоставления авторам больше возможностей в отношении того, как сторонние компании, занимающиеся ИИ, всё же смогли бы использовать их контент на платформе, очевидно делясь заработками. Более подробная информация об этом выйдет позднее в этом году. Политические дипфейки оказались самой популярным направлением в злоупотреблениях ИИ

26.06.2024 [00:26],

Анжелла Марина

Исследование Google DeepMind выявило, что злоупотребления искусственным интеллектом (ИИ) в форме дипфейков — реалистичных поддельных изображений политиков и знаменитостей или их видео и аудио — намного превосходят использование ИИ для кибератак.

Источник изображения: Kandinsky Согласно анализу, проведённому совместно с исследовательским подразделением группы Jigsaw, наиболее распространённой целью злоупотреблений генеративным ИИ стало формирование общественного мнения или влияние на него, что составило 27 % всех случаев использования искусственного интеллекта, сообщает Ars Technica. Такие данные вызывают у экспертов серьёзные опасения по поводу влияния дипфейков на предстоящие во многих странах мира выборы в 2024 году. Отмечается, что в последние месяцы в социальных сетях, таких как TikTok, X и Instagram✴✴, появились дипфейки премьер-министра Великобритании Риши Сунака (Rishi Sunak) и других мировых лидеров. Избиратели Великобритании пойдут на всеобщие выборы уже на следующей неделе, и существует обеспокоенность тем, что, несмотря на усилия платформ социальных сетей по маркировке или удалению такого контента, аудитория может не распознать его как фейк, что потенциально повлияет на решения избирателей. Арди Янжева (Ardi Janjeva), научный сотрудник Института Алана Тьюринга (The Alan Turing Institute), отмечает, что распространение контента, созданного ИИ, может «искажать наше коллективное понимание социально-политической реальности», что представляет долгосрочные риски для демократических процессов, даже если прямое влияние на поведение избирателей пока не доказано. По мере роста популярности генеративных ИИ-продуктов, таких как ChatGPT от OpenAI и Gemini от Google, компании, разрабатывающие ИИ, начинают более пристально следить за потенциально вредным или неэтичным контентом, создаваемым их инструментами. Например, в мае OpenAI опубликовала исследование, показавшее использование их инструментов для создания и распространения дезинформации, связанное с Россией, Китаем, Ираном и Израилем. Второй по распространённости мотивацией злоупотреблений стало получение финансовой выгоды, например, через предложение услуг по созданию дипфейков, включая создание изображений реальных людей, или использование генеративного ИИ для создания фейковых новостных статей. Исследование показало, что в большинстве инцидентов используются легкодоступные инструменты, не требующие глубоких технических знаний, что в свою очередь только может увеличивать рост числа злоумышленников в среде ИИ. Одновременно результаты исследования Google DeepMind повлияют на действия ИИ-компаний для проверки моделей на безопасность и оценку не только пользы, но и потенциального вреда от использования генеративного ИИ. Поддельный Илон Маск продвигает мошеннические схемы с криптовалютой на YouTube Live

24.06.2024 [19:26],

Сергей Сурабекянц

Голос Илона Маска (Elon Musk), сгенерированный искусственным интеллектом, в сегодняшней прямой трансляции посоветовал зрителям разместить криптовалюту на сомнительном сайте. В пятичасовом эфире на YouTube Live был показан фрагмент видеоряда с мероприятия Tesla, где Маск якобы призывает зрителей внести криптовалюту, чтобы принять участие в розыгрыше. Всем участникам был обещан автоматический возврат внесённой суммы в двойном размере.

Источник изображений: Engadget В какой-то момент трансляцию одновременно смотрели более 30 000 зрителей (не исключена накрутка ботами), что подняло её на вершину рекомендаций YouTube Live Now. Учётная запись @elon.teslastream, имела значок подтверждённого официального канала, что может говорить о взломе учётной записи. Через некоторое время и видео, и канал были удалены. Число подобных дипфейковых мошенничеств от лица Маска резко возросло за последние месяцы. В каждом случае преступники используют учётную запись якобы одной из компаний Маска. Сегодняшнее видео имело подзаголовок «Tesla представляет шедевр: Tesla, которая навсегда изменит автомобильную промышленность». В начале июня, во время запуска Starship, сообщалось об аналогичных мошенничествах, проводимых 35 аккаунтами от лица SpaceX. Криптовалютные преступления, нацеленные на последователей Маска в социальных сетях, уже много лет является проблемой, как и мошенничество с участием знаменитостей в целом. 21 июня были одновременно взломаны сайт и аккаунт в социальной сети X рэпера 50 Cent. Точная сумма ущерба неясна, по слухам, преступники украли мемкойн GUNIT на сумму около $3 млн. Государство получит право использовать голоса россиян после их смерти без согласия родственников

31.05.2024 [13:00],

Павел Котов

Голоса россиян будут защищены от неправомерного использования — это регламентирует проект закона «Об охране голоса», разработанный Альянсом в сфере ИИ и Национальной федерацией музыкальной индустрии (НФМИ). Вместе с тем государство получит право использовать в общественных интересах голос гражданина после его смерти без согласия родственников. Об этом сообщили «Ведомости» со ссылкой на заявление члена Совета Федерации по конституционному законодательству и госстроительству Артёма Шейкина, а также разработчиков документа.

Источник изображения: Soundtrap / unsplash.com Законопроект предусматривает внесение изменений в Гражданский кодекс (ГК). В общем случае для обнародования и дальнейшего использования голоса гражданина требуется его согласие; после его смерти согласие необходимо получать у супруга, детей или родителей. Но если голос предполагается использовать в государственных или общественных интересах, то такое согласие не требуется — при условии, что голос записывался за плату или в публичных местах. Документ описывает механизм правовой защиты голоса от неправомерного использования и создания дипфейков на основе его записей. В рамках работы секции «Искусственный интеллект» Совета по развитию цифровой экономики при Совете Федерации анализировались предложения экспертов и профильных ведомств по определению дипфейка. «Сейчас мы находимся на завершающем этапе проработки этого определения, которое будет закреплено в законопроекте», — сообщил господин Шейкин. Уже готовится итоговая версия законопроекта — после получения отзыва от правительства он будет внесён в Госдуму.

Источник изображения: Studio_Iris / pixabay.com «Если голос гражданина, воссозданный с помощью специальных технологий, получен или используется в интернете с нарушением закона, гражданин вправе требовать удаления этой записи, а также пресечения или запрещения её дальнейшего использования и распространения», — считает Артём Шейкин. Нарушения ГК предусматривают последствия в виде возмещения убытков и вреда, выплат неустойки, приостановления или прекращения определённой деятельности, возврата неосновательного обогащения и другие меры. Российское законодательство в существующем виде охраняет лишь фотографическое изображение человека, а нормы, которые защищают артистов и дикторов от использования их синтезированных голосов и цифровых образов, пока отсутствуют, отметили в НФМИ. Речевые особенности человека не охраняются правом ни в одной стране мира, отмечают опрошенные «Ведомостями» эксперты, хотя в России действуют законы «О персональных данных» и «О биометрических данных», которые требуют обрабатывать данные, включая голос, лишь с согласия человека. Принятие нового закона сформирует базу для разрешения споров в области прав на голос — к примеру, до сих пор нет ясности, кому принадлежит воспроизведённый нейросетью голос человека: ему самому или разработчику этой нейросети. Так, американская актриса Скарлетт Йоханссон (Scarlett Johansson) уже минимум дважды была вынуждена отстаивать право на собственный голос. Сейчас также распространилась мошенническая схема с использованием сгенерированных голосовых записей, призванных убедить жертву перевести деньги злоумышленникам. Предложенный законопроект конкретных мер ответственности за неправомерное использование голоса не предусматривает, но есть и другой, который предусматривает внесение поправок уже в Уголовный кодекс РФ — он также ещё не внесён в Госдуму. McAfee продемонстрировала детектор звуковых дипфейков

09.05.2024 [15:08],

Павел Котов

На мероприятии RSA Conference компания McAfee продемонстрировала систему Deepfake Detector, работа над которой ведётся при участии Intel. Система, первоначально называвшаяся Project Mockingbird, предназначена для обнаружения звуковых дипфейков — аудиоподделок, созданных при помощи искусственного интеллекта.

Источник изображения: S. Keller / pixabay.com Технический директор McAfee Стив Гробман (Steve Grobman) показал работу Deepfake Detector на примере двух видеороликов — показ видео сопровождается информацией от ИИ-детектора, которая выводится в строке состояния. При запуске видеоролика, не подвергавшегося обработке, система показала нулевую вероятность подделки. Далее было запущено явно фейковое видео, на которое система сразу отреагировала показателем в 60 %, и по мере просмотра вероятность выросла до 95 %. С момента первой демонстрации на CES 2024 инженеры McAfee оптимизировали систему для работы с ИИ-ускорителями Intel NPU на чипах Meteor Lake, что позволило увеличить производительность на 300 %. Можно запускать несколько процессов Deepfake Detector для одновременного анализа нескольких видеороликов; хотя и видеозаписями возможности системы не ограничиваются — она может анализировать звук любого приложения в системе. А локальный режим её работы вместо запуска из облака означает высокую конфиденциальность — анализируемые данные не покидают компьютера. Авторы проекта преднамеренно ограничились работой со звуком: специалисты McAfee по борьбе с угрозами обнаружили, что во многих публикуемых мошенниками видеороликах используется настоящее видео с поддельным звуком. Фальшивый звук сопровождает и поддельное видео, а значит, постоянной величиной чаще всего оказывается подделка аудио. Сейчас компания работает над адаптацией технологии для потребителей — для этого управление программой будет необходимо сделать предельно простым и понятным. Мошенники с помощью голосового дипфейка пытались выдать себя за гендира LastPass

12.04.2024 [19:39],

Сергей Сурабекянц

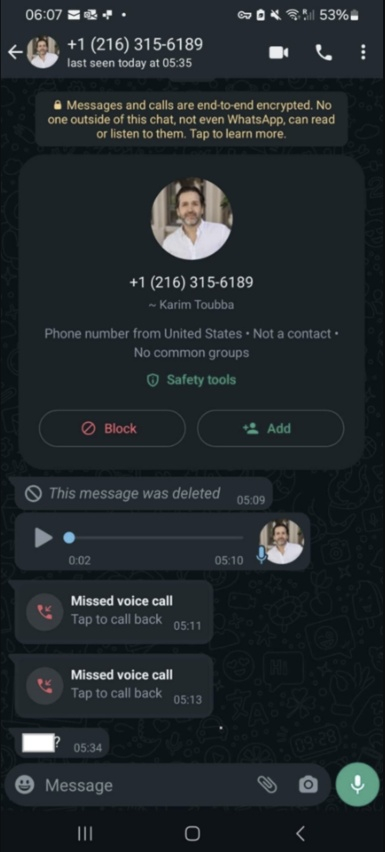

Менеджер паролей LastPass подвергся атаке мошенников, которые применили технологии искусственного интеллекта, пытаясь выдать себя за генерального директора LastPass Карима Туббу (Karim Toubba). Злоумышленники создали поддельную учётную запись Туббы в WhatsApp и начали переписку с одним из сотрудников компании. В процессе они отправляли голосовые сообщения, в которых имитировали голос руководителя Last Pass.

Источник изображения: insider.com Подвергшийся атаке сотрудник LastPass оказался достаточно опытным и стрессоустойчивым, поэтому попытка обмана силами дипфейка не удалась. Сотрудника насторожило то, что сообщения WhatsApp «выходили за пределы обычных каналов делового общения». Дополнительным поводом усомниться в реальности аудиосообщения от руководителя стало излишнее давление со стороны мошенников, тактика под названием «вынужденная срочность», которую преступники часто используют для манипулирования жертвами. Это окончательно убедило сотрудника LastPass, что вся переписка была фикцией.  LastPass сообщила, что попытка мошенничества не увенчалась успехом и сейчас расследованием инцидента занимается служба безопасности компании. Тем не менее, компания решила поделиться подробностями этого инцидента, чтобы привлечь внимание к тому, что дипфейки всё чаще используются для мошеннических кампаний с выдачей себя за руководителей. За последнее время многие компании, в том числе криптовалютная биржа Binance, столкнулись с мошенниками, выдающими себя за руководителей компаний при помощи искусственного интеллекта. Недавно в Гонконге занятый в финансовой сфере сотрудник международной компании, думая, что участвует в сеансе одновременной видеосвязи со своими коллегами, по указанию «финансового директора предприятия из Великобритании» перевёл $25,6 млн на указанный ему счёт. С 8 февраля 2024 года в США коммерческим компаниям запретили использовать голосовых ИИ-ботов в ходе автоматизированных «холодных звонков» потенциальным клиентам. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |