Материалы по тегу: hardware

|

10.06.2025 [12:15], Руслан Авдеев

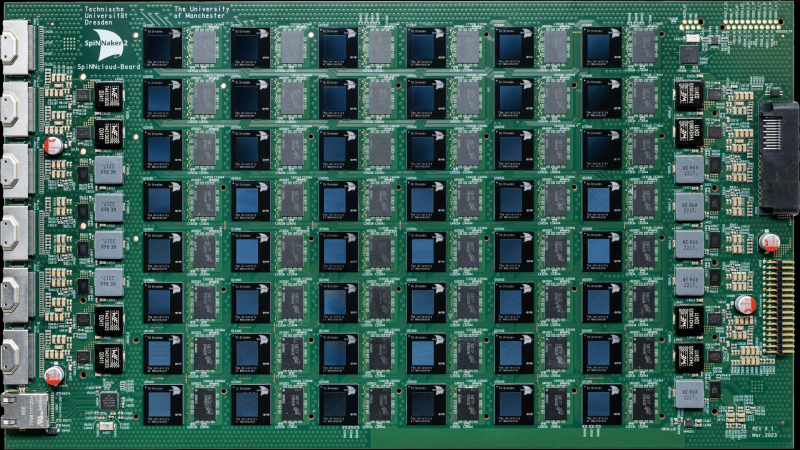

Нейроморфный суперкомпьютер SpiNNaker2, способный имитировать до 180 млн нейронов, прописался в Сандийских национальных лабораторияхНемецкая SpiNNcloud Systems, занимающаяся разработкой нейроморфных суперкомпьютеров, ввела в эксплуатацию в Сандийских национальных лабораториях (Sandia National Laboratories, SNL) суперкомпьютер SpiNNaker2, созданный по подобию человеческого мозга. Это имеет большое значение для развития вычислительной техники и выполнения задач, связанных с обеспечением национальной безопасности, сообщает Silicon Angle. SNL — это научно-исследовательский комплекс правительства США, занимающийся проектами в области национальной безопасности, энергетики и передовых технологических инноваций. Sandia управляется одним из специализированных подразделений Министерства энергетики США (DoE) и более всего известна проектами, связанными с ядерным арсеналом Соединённых Штатов и обеспечением его сохранности и эффективности. Суперкомпьютер SpiNNaker2 анонсировали в мае 2024 года. Он представляет собой высокопроизводительную нейроморфную компьютерную систему, основанную на принципах работы человеческого мозга. Платформа создана разработчиком архитектур Arm и SpiNNaker1 Стивом Фербером (Steve Furber) и использует множество чипов с низким энергопотреблением для ИИ-вычислений и выполнения других задач.

Источник изображения: SpiNNcloud Systems Как сообщает Datacenter Dynamics, система использует тысячи Arm-ядер для имитации работы нейронов мозга. В Sandia National Labs развёрнута одна из крупнейших в мире конфигураций SpiNNaker из 24 плат о 175 104 ядрами, способная моделировать 150–180 млн нейронов, что делает её одной из пяти самых мощных нейроморфных платформ в мире для исследований в области ИИ и нейротехнологий. Впрочем, от человеческого мозга со 100 млрд нейронов система, по данным Blocks & Files, пока ещё сильно отстаёт. SpiNNaker2 использует высокопараллельную архитектуру из 48 чипов SpiNNaker2 на плату, каждый из которых имеет по 152 ядра на основе Arm, 20 Мбайт SRAM и специализированные ускорители. Конструкция обеспечивает эффективные вычисления, позволяющие системе выполнять сложные симуляции с более низким энергопотреблением в сравнении с ИИ-ускорителями традиционного типа. Высокая эффективность SpiNNaker2 делает его особенно ценным для выполнения задач в сфере обеспечения национальной безопасности. Каждая плата оснащена 96 Гбайт оперативной памяти LPDDR4. В конфигурации с 90 платами система имеет 8640 Гбайт DRAM, а в максимальном варианте (1440 плат) — 138 240 Гбайт. Архитектура использует высокоскоростную межчиповую связь, что вообще исключает необходимость в централизованном хранилище данных, а огромный объём памяти позволяет эффективно моделировать крупномасштабные нейронные сети.

Источник изображения: SpiNNcloud Systems SpiNNaker2 интегрирован в существующие HPC-системы и работает без ОС или дисков, достигая высокой скорости работы за счет хранения данных в SRAM и DRAM. Система использует стандартные параллельные порты для загрузки и выгрузки данных, а её текущая максимальная конфигурация включает более 10,5 млн ядер, что позволяет моделировать нейронные сети в режиме «биологического реального времени». По словам представителя Sandia, хотя системы на базе классических ускорителей способны повысить эффективность суперкомпьютеров в сравнении с обычными CPU, системы на основе «архитектуры» человеческого мозга вроде SpiNNaker2 — ещё более привлекательная альтернатива. В SpiNNcloud заявляют, что система поддерживает и следующего поколения алгоритмов систем генеративного ИИ, обеспечивая значительно более эффективный путь развития машинного обучения с применением «динамической разреженности» (dynamic sparsity). По данным сайта SpiNNcloud, в скором будущем появится чип SpiNNext, в 78 раз более энергетически эффективный, чем традиционные ИИ-ускорители.

10.06.2025 [12:15], Владимир Мироненко

«Это полное безумие»: SAP не видит смысла в строительстве Европой собственной облачной инфраструктурыКристиан Кляйн (Christian Klein), гендиректор немецкого разработчика ПО SAP, самой дорогой публичной компании Европы с рыночной стоимостью $342,4 млрд, не видит смысла в построении на континенте собственной облачной инфраструктуры в противовес созданной здесь американскими гиперскейлерами. «Конкурентоспособность европейской автомобильной или химической промышленности не будет достигнута путем строительства 20 различных ЦОД во Франции и попыток конкурировать с американскими гиперскейлерами. Это полное безумие, и это суверенитет, реализованный совершенно неправильно», — цитирует The Register заявление Кляйна, сделанное на конференции для инвесторов на прошлой неделе, организованной инвестиционным банком BNP Paribas. «Нам нужны лучшие (сервисы) здесь, в Европе, для применения ИИ, для применения интеллектуального ПО, чтобы быть лучшими, чтобы производить намного лучшие, намного более быстрые, лучшие автомобили и быть намного более эффективными в управлении нашими цепочками поставок», — сказал он. Кляйн отметил, что в Европе большие проблемы с ценами на энергоносители, поэтому строительство большего количества ЦОД — не лучшее решение. SAP готова предоставить клиентам различные уровни безопасности данных и суверенитета данных, но «полностью нейтральна на уровне инфраструктуры», — заявил он на конференции. С помощью ИИ и хранилища данных SAP предлагает клиентам «полный суверенитет сверху донизу», сообщил Кляйн. На фоне всё более враждебной риторики США по поводу европейской политики и норм управления европейские лидеры недавно анонсировали «Международную цифровую стратегию» (International Digital Strategy). В то время как американские гиперскейлеры AWS, Google и Microsoft пытаются развеять опасения по поводу суверенитета данных, заверяя, что способны обеспечить безопасное хранение данных европейских клиентов, некоторые европейские политики по-прежнему обеспокоены готовностью администрации США игнорировать судебные постановления, пишет The Register. SAP не одинока в своих сомнениях по поводу целесообразности разделения на уровне облачной инфраструктуры, отметил The Register. В прошлом месяце эксперты сообщили ресурсу, что для европейских организаций «на практике почти невозможно» воспроизвести инфраструктуру, созданную крупными американскими провайдерами облачных сервисов в Европе.

09.06.2025 [23:17], Владимир Мироненко

Qualcomm договорилась о покупке Alphawave за $2,4 млрдQualcomm объявила о достижении соглашения с Alphawave IP Group (Alphawave Semi) о приобретении её активов за $2,4 млрд. Как сообщила Alphawave Semi, котирующаяся на Лондонской бирже, её акционеры получат $2,48 наличными за каждую имеющуюся акцию. Цена составляет 183 пенса за акцию, что на 96 % превышает цену в размере 93,50 пенса на момент закрытия торгов на бирже 31 марта 2025 года, за день до того, как Qualcomm объявила о своей заинтересованности в покупке Alphawave Semi. До этого интерес к покупке Alphawave Semi проявила Arm, в частности, из-за её технологии создания SerDes-блоков для ускорителей в вычислительных кластерах. Как указано в пресс-релизе, приобретение Alphawave Semi направлено на дальнейшее ускорение и предоставление ключевых активов для продвижения Qualcomm на рынок ЦОД, о чём и было заявлено ранее: «Процессоры Qualcomm Oryon CPU и Hexagon NPU хорошо подходят для удовлетворения растущего спроса на высокопроизводительные энергоэффективные вычисления, который обусловлен стремительным ростом применения ИИ-инференса и переходом на кастомные процессоры для ЦОД». Решения Alphawave Semi являются частью базовой инфраструктуры, обеспечивающей услуги следующего поколения в широком спектре быстрорастущих приложений, включая ЦОД, ИИ, сети передачи данных и хранилища данных. «Под руководством Тони Пиалиса (Tony Pialis) Alphawave Semi разработала ведущие высокоскоростные проводные подключения и вычислительные технологии, которые дополняют наши энергоэффективные CPU- и NPU-ядра, — отметил генеральный директор Qualcomm Криштиану Амон (Cristiano Amon). — Усовершенствованные кастомные процессоры Qualcomm естественным образом подходят для рабочих нагрузок ЦОД. Объединённые команды разделяют цель создания передовых технологических решений и обеспечения производительности взаимосвязанных вычислений следующего уровня в широком спектре быстрорастущих областей, включая инфраструктуру ЦОД». Ожидается, что сделка будет завершена в течение I квартала 2026 года при условии её одобрения акционерами Alphawave, а также соответствующими регулирующими органами США, Германии, Южной Кореи, Канады и Великобритании. Alphawave заявила, что её директора будут единогласно рекомендовать акционерам проголосовать за сделку. Согласно соглашению, акционеры Alphawave могут получить оплату наличными или акциями Qualcomm. Alphawave была зарегистрирована в Торонто (Канада), после чего в мае 2021 года разместила свои акции на Лондонской фондовой бирже. В ходе первичного размещения Alphawave продала акции по 410 пенсов на сумму £856 млн, получив оценку рыночной стоимости в £3,1 млрд. Предложение Qualcomm по 183 пенса за акцию составляет менее половины этой суммы, пишет The Financial Times. Как сообщает ресурс The Register, комментируя сделку, финансовая компания Jefferies Financial Group заявила, что не ожидает никаких препятствий со стороны регуляторов, поскольку Alphawave теперь избавилась от своей доли в совместном с китайцами предприятии WiseWave.

09.06.2025 [18:11], Руслан Авдеев

«Ростелеком» предложил крупным компаниям строить общие электростанции для ИИ ЦОДПо словам президента «Ростелекома» Михаила Осеевского, дефицит энергетических мощностей открывает новые возможности для сотрудничества крупных компаний. Они смогут объединить усилия для создания электростанций для ИИ ЦОД — кампусы будут строиться рядом со станциями, сообщает «Интерфакс». В «Ростелекоме» пришли к выводу, что развитие решений на базе ИИ требует развитой вычислительной инфраструктуры, но ИИ-серверы потребляют очень много энергии. Если стандартные стойки рассчитаны приблизительно на 5 кВт, то в случае варианта с ИИ-ускорителями речь может идти уже о 50 кВт (на деле ёмкость может быть и в разы выше). При этом дата-центр на 1 тыс. стоек уже через пять лет будет «обычной историей» — речь идёт о гигантских мощностях в случае массового внедрения ИИ. Основная идея Осеевского — ЦОД могли бы совместно заказывать электростанции и создавать общие технопарки для своих ЦОД. Например, крупнейшие банки, «Ростелеком», «Яндекс», VK и другие компании, даже будучи конкурентами в некоторых сферах, могли бы объединить силы для строительства электростанций и кампусов ЦОД при них.

Источник изображения: Scott Blake/unsplash.com Осеевский заявил, что концепция предусматривает строительство электростанции, особой технологической зоны рядом с ней, на этой территории участники сами строят свои дата-центры. При этом на комплекс распространяются единые системы безопасности и связи. По прогнозам бизнесмена, проблема с получением достаточного количества энергии появится у всех компаний, которым необходимо будет строить ИИ ЦОД. Конечно, в первую очередь вопрос будет актуален для Москвы и Московской области. По информации Международного энергетического агентства (IEA), в ближайшие три года миру потребуется много новых источников энергии, чтобы компенсировать «беспрецедентный» рост спроса. Исследование IEA показало, что энергопотребление ЦОД к 2030 году вырастет более чем вдвое, а из-за ИИ придётся сжигать больше угля и газа. В частности, эксперты прогнозируют утроение мощности коммерческих ЦОД в России к 2028 году, а в феврале сообщалось, что в стране скоро якобы наступит дефицит энергии для обучения ИИ, который сильнее всего ударит по ЦОД в Москве и Санкт-Петербурге.

09.06.2025 [15:06], Владимир Мироненко

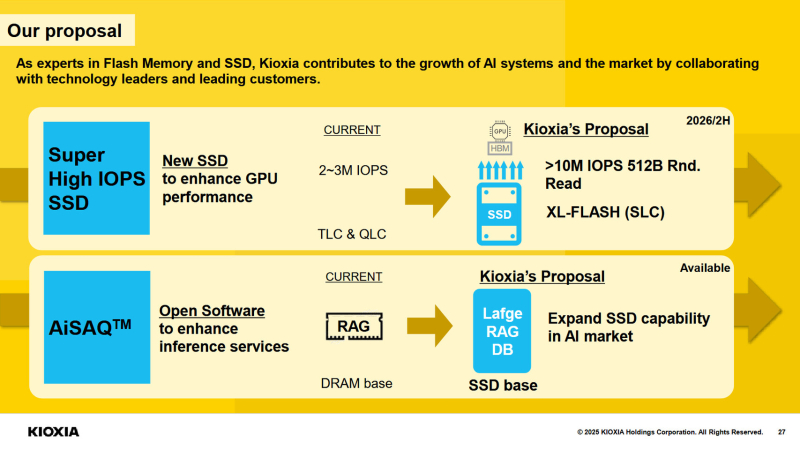

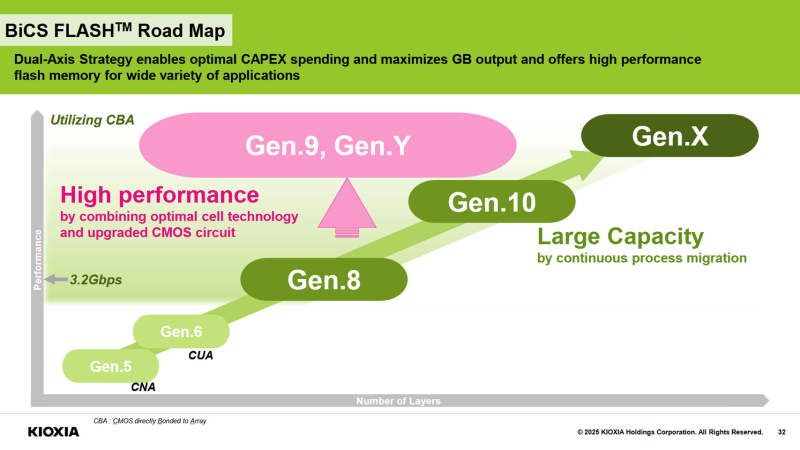

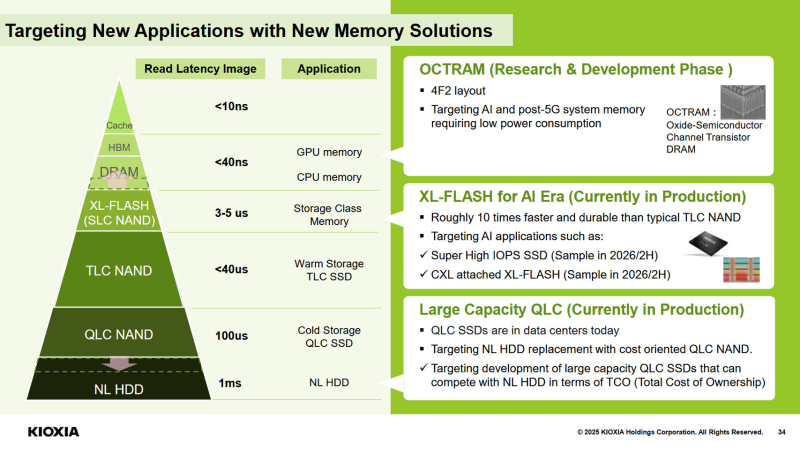

Kioxia готовит новое поколение XL-FLASH SSD с поддержкой 10 млн IOPSKioxia представила стратегию развития SSD в среднесрочной и долгосрочной перспективе с акцентом на инновации, направленные на повышение производительности и ёмкости хранилища. Одним из ключевых проектов Kioxia назвала создание SSD с использованием SLC-памяти XL-FLASH в сочетании с переработанным контроллером. Ожидается, что эта комбинация обеспечит более 10 млн IOPS, особенно для небольших транзакций данных. Образцы продвинутых SSD увидят свет ко II половине 2026 года. Kioxia сообщила, что тесно сотрудничает с основными производителями GPU для точной настройки SSD с целью повышения производительности в приложениях с интенсивным использованием ИИ и графики. Выпускаемые сейчас компанией SSD построены на чипах 3D NAND BiCS FLASH TLC 8-го поколения с использованием технологии CBA (CMOS directly Bonded to Array), обеспечивающей повышение энергоэффективности, производительности, плотности и стабильности по сравнению с решениями предыдущего поколения. Семейство SSD корпоративного класса CM9 нацелено на ИИ-системы, которым требуется как высокая скорость, так и высочайшая надёжность, чтобы максимально использовать дорогостоящее оборудование с ИИ-ускорителями. В свою очередь, семейство накопителей LC9 предлагает большую ёмкость, достигающую 122 Тбайт, для поддержания нагрузок, связанных с крупномасштабными базами данных для систем ИИ-инференса. Также чипы BiCS FLASH TLC 8-го поколения используются в смартфонах. Kioxia отметила, что в настоящее время увеличивает производство линейки продуктов BiCS FLASH 8-го поколения. Компания сообщила, что использует два подхода при разработке флеш-памяти. Один из них основан на традиционном методе увеличения количества слоев для создания более высокой ёмкости и производительности в таком продукте, как BiCS FLASH 10-го поколения. А при разработке флеш-памяти BiCS FLASH 9-го поколения компания использует преимущества технологии CBA, объединяя проверенные конструкции ячеек с передовой технологией CMOS. В целом, стратегия Kioxia направлена как на постепенное усовершенствование SSD, так и на инновации в архитектуре для удовлетворения меняющихся потребностей рынка в сфере ИИ и хранлищ. Так, для QLC-памяти компания ставит целью вытеснение Nearline HDD путём уменьшения стоимости SSD.

09.06.2025 [14:27], Руслан Авдеев

Евросоюз ограничит использование воды дата-центрамиЕвропейский союз обнародовал планы по повышению устойчивости всего блока к засухам и улучшения качества воды. В Еврокомиссии подчёркивают, что около трети земель Европы ежегодно сталкиваются с нехваткой воды, поэтому новая стратегия появилась вполне своевременно. В числе прочего предусмотрено развитие контроля за использованием водных ресурсов IT-сектором, сообщает Bloomberg. Работать над учреждением стандартов производительности для ограничения использования водных ресурсов в дата-центрах будет Еврокомиссия — как свидетельствуют материалы стратегии водной экоустойчивости, представленной в прошлую среду, регион столкнётся с вероятным дефицитом воды в ближайшие десятилетия. Общая цель ЕС — повысить эффективность использования воды минимум на 10 % к 2030 году. В последние годы нехватка воды ударила по Евросоюзу, поскольку повышение летних температур не могло не отразиться на качестве поставок этого важнейшего ресурса. Засухи нанесли серьёзный ущерб атомной энергетике Франции и усложнили доставку товаров по обмелевшей реке Рейн — одному из ключевых торговых путей Европы. При этом управление водными ресурсами в Евросоюзе фрагментировано, в числе прочего ему мешают запутанные системы водоснабжения и стареющие резервуары/водохранилища. В апреле уже сообщалось, что доступ к чистой воде становится одной из главных забот для операторов ИИ ЦОД всего мира. В мае было анонсировано, что в рамках стратегии ЕС по водной экоустойчивости Water Resilience Strategy Евросоюз разработает новые лимиты потребления воды дата-центрами. По-видимому, они буду жёстче обозначенных ранее.

09.06.2025 [14:02], Руслан Авдеев

Перегрев, плохое ПО и сила привычки: китайские компании не горят желанием закупать ИИ-ускорители HuaweiНесмотря на дефицит передовых ИИ-ускорителей на китайском рынке, китайская компания Huawei, выпустившая модель Ascend 910C, может столкнуться с проблемами при её продвижении. Она рассчитывала помочь китайскому бизнесу в преодолении санкций на передовые полупроводники, но перспективы нового ускорителя остаются под вопросом, сообщает The Information. Китайские гиганты вроде ByteDance, Alibaba и Tencent всё ещё не разместили крупных заказов на новые ускорители. Основная причина в том, что экосистема NVIDIA доминирует во всём мире (в частности, речь идёт о программной платформе CUDA), а решения Huawei недостаточно развиты. В результате компания продвигает продажи государственным структурам (при поддержке самих властей КНР) — это косвенно свидетельствует о сложности выхода на массовый рынок. Китайский бизнес годами инвестировал в NVIDIA CUDA для ИИ- и HPC-задач. Соответствующий инструментарий, библиотеки и сообщество разработчиков — настолько развитая экосистема, что альтернатива в лице Huawei CANN (Compute Architecture for Neural Networks) на её фоне выглядит весьма слабо. У многих компаний всё ещё хранятся огромные запасы ускорителей NVIDIA, накопленные в преддверии очередного раунда антикитайских санкций, поэтому у их владельцев нет стимула переходить на новые и незнакомые решения. Они скорее предпочтут оптимизировать программный стек, как это сделала DeepSeek, чтобы повысить утилизацию имеющегося «железа». Если бы, например, та же DeepSeek перешла на ускорители Huawei, это подтолкнуло бы к переходу и других разработчиков, но пока этого не происходит. Кроме того, некоторые компании вроде Tencent и Alibaba не желают поддерживать продукты конкурентов, что усложняет Huawei продвижение её ускорителей. Есть и технические проблемы. Самый передовой ускоритель Huawei Ascend 910C периодически перегревается, поэтому возникла проблема доверия к продукции. Поскольку сбои во время длительного обучения модели обходятся весьма дорого. Кроме того, он не поддерживает ключевой для эффективного обучения ИИ формат FP8. Ascend 910С представляет собой сборку из двух чипов 910B. Он обеспечивает производительность на уровне 800 Тфлопс (FP16) и пропускную способность памяти 3,2 Тбайт/с, что сопоставимо с параметрами NVIDIA H100. Также Huawei представила кластер CloudMatrix 384. Наконец, проблема в собственно американских санкциях. В мае 2025 года Министерство торговли США предупредило, что использование чипов Huawei без специального разрешения может расцениваться, как нарушение экспортных ограничений — якобы в продуктах Huawei незаконно используются американские технологии. Такие ограничения особенно важны для компаний, ведущих международный бизнес — даже если они китайского происхождения. Хотя NVIDIA ограничили продажи в Китае, она по-прежнему демонстрирует рекордные показатели. По данным экспертов UBS, у компании есть перспективные проекты суммарной мощностью «десятки гигаватт» — при этом, каждый гигаватт ИИ-инфраструктуры, по заявлениям NVIDIA, приносит ей $40–50 млрд. Если взять вероятную очередь проектов на 20 ГВт с периодом реализации два-три года, то только сегмент ЦОД может обеспечить NVIDIA около $400 млрд годовой выручки. Это подчеркивает доминирующее положение компании на рынке аппаратного обеспечения для ИИ.

09.06.2025 [12:52], Руслан Авдеев

AWS запустила свой первый облачный регион на Тайване и намерена вложить $5 млрд в инфраструктуру островаAmazon Web Services (AWS) запустила на Тайване новый облачный регион. AWS Asia Pacific в Тайбэе (Taipei) — первый регион компании на острове и 15-й — в Азиатско-Тихоокеанском географическом регионе, сообщает Datacenter Dynamics. Reuters добавляет, что AWS потратит $5 млрд на развитие нового региона, чтобы поддержать строительство ЦОД и сетей. АWS анонсировала регион в июне 2024 года, отметив, что инвестирует в Тайвань «миллиарды долларов» в следующие 15 лет. AWS официально присутствует на Тайване с 2014 года, когда был открыт филиал AWS в Тайбэе. В том же году компания запустила в регионе локацию для периферийных вычислений Amazon CloudFront, вторая заработала в 2018 году. В том же году запущены две локации AWS Direct Connect, а в 2020 году заработали два AWS Outposts. В 2022 года в Тайбэе заработала специальная зона Local Zones. С запуском нового облачного региона AWS развернула на Тайване третью локацию AWS Direct Connect. Точка Direct Connect находится в дата-центре Chief Telecom HD около тайваньской столицы. По данным AWS, клиенты, подключающие свои сети к AWS на новой площадке, получают частный прямой доступ к всем публичным облачным регионам AWS Regions кроме тех, что находятся на территории материкового Китая. Локация обеспечивает выделенные каналы связи 10/100 Гбит/с. Среди первых клиентов нового региона — Gamania Group, Chunghwa Telecom, Cathay Financial Holdings. Как заявляет партнёр AWS, компания Nextlink Technology, инвестиции IT-гиганта в местную инфраструктуру помогут цифровой трансформации тайваньских компаний, ускорят развитие различных отраслей. В компании заявили, что намерены сотрудничать с AWS для дальнейшей помощи корпорациям, желающим воспользоваться преимуществами региона AWS Asia Pacific. Это локальное преимущество поможет удовлетворить потребности клиентов в локализации данных, низкой задержке доступа и высокой производительности. Google также располагает собственным регионом на острове. Гиперскейлер приобрёл 15 га в уезде Чжанхуа (Changhua County) в 2011 году, построил свой первый ЦОД в 2013 году и запустил облачный регион Google Cloud Platform (GCP) в 2014 году. В 2019 году компания объявила, что будет строить вторую площадку в городе Тайнань (Tainan). Microsoft анонсировала планы создания облачного региона Taipei Azure в 2020 году, но запуск всё ещё планируется «скоро». Ранее облачным регионом на Тайване управляла китайская Alibaba, но в 2022 году проект был свёрнут. В текущем году AWS уже запустила новые облачные регионы в Таиланде и Мексике, а в мае объявила, что намерена инвестировать $4 млрд в регион ЦОД в Чили.

09.06.2025 [09:19], Сергей Карасёв

«Аквариус» анонсировала отечественные серверы AQserv на базе Intel Xeon 6«Аквариус» сообщила о разработке инженерных образов 2U-серверов AQserv с процессорами Intel Xeon 6. Устройства предназначены для решения задач в таких областях, как ИИ, машинное обучение, большие данные и пр. Полностью технические характеристики серверов пока не раскрываются. Известно, что они имеют двухсокетное исполнение с возможностью выбора чипов Xeon 6500P/6700P (Granite Rapids) с производительными Р-ядрами и Xeon 6700E (Sierra Forest) с энергоэффективными Е-ядрами. Говорится о поддержке 32 DIMM-слотов DDR5-8000/6400/5200, восьми слотов PCIe 5.0 x16, одного слота OCP 3.0 (PCIe 5.0 x16). Дисковая подсистема представлена двумя слотами для SFF-накопителей (SATA/SAS/NVMe) и двумя E1.S-слотами (NVMe) с горячей заменой. Дисковая корзина представлена в двух вариантах: 24 × SFF (SATA/SAS/NVMe) или 12 × LFF (SATA/SAS/NVMe). За управление отвечает BMC ASPEED AST2600 с выделенным 1GbE-портом RJ45, а также фирменной прошивкой «Аквариус Командир». Устройства наделены фирменной системой управления и мониторинга, которую «Аквариус» развивает с 2020 года. Она позволяет выполнять базовые операции по обслуживанию основных компонентов серверов, а также обеспечивает расширенную поддержку служб каталогов (таких как AD, LDAP, ALD Pro) и дополнительные возможности, в том числе в плане автоматизации. Благодаря этому, по заявлениям производителя, ускоряется ввод оборудования в эксплуатацию и снижается совокупная стоимость владения (TCO).

Источник изображения: «Аквариус» Серверы AQserv на базе Xeon 6 оптимизированы для ресурсоёмких нагрузок, связанных с виртуализацией, облачными платформами, аналитическими приложениями и пр. «Аквариус» отмечает, что по сравнению с машинами предыдущего поколения достигается увеличение производительности в два–три раза, а в некоторых сценариях — в пять и более раз. Такие показатели обеспечиваются благодаря новой архитектуре, большому количеству ядер, поддержке инструкций AMX, использованию оперативной памяти MRDIMM и др. «Мы начали разработку серверов на базе Xeon 6 заранее, ещё до официального выпуска первых процессоров Xeon 6 компанией Intel, чтобы наши заказчики могли первыми получить доступ к решениям нового поколения. В условиях стремительно растущих требований к IT-инфраструктуре важно опережать запросы рынка, и мы уверены, что наш новый продукт позволит бизнесу решать задачи цифровой трансформации на совершенно новом уровне эффективности», — говорит президент «Аквариус». Впрочем, Selectel анонсировала собственные серверы на базе Xeon 6 ещё в октябре прошлого года.

09.06.2025 [08:23], Сергей Карасёв

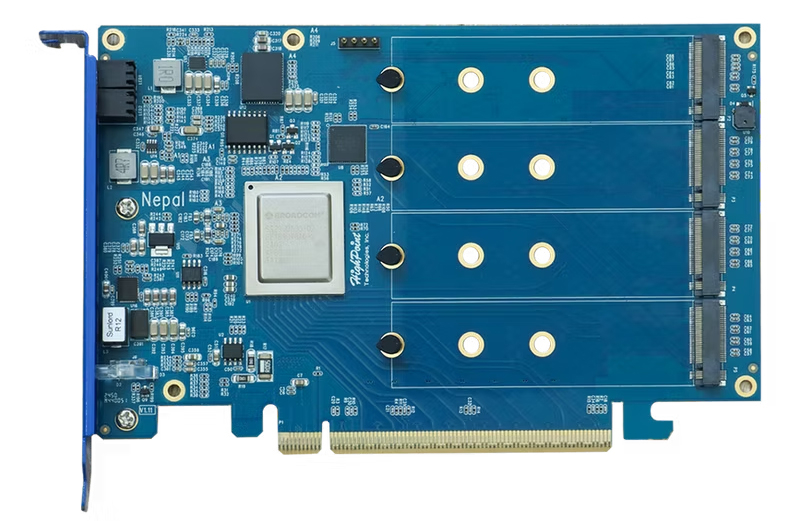

HighPoint представила первую в мире RAID-карту с поддержкой четырёх M.2 SSD стандарта PCIe 5.0Компания HighPoint анонсировала карту расширения Rocket 7604A RAID AIC: это, как утверждается, первый в мире RAID-адаптер с возможностью установку четырёх SSD типоразмера М.2 с интерфейсом PCIe 5.0. Устройство предназначено для использования в высокопроизводительных рабочих станциях, системах для периферийных вычислений и пр. Новинка имеет форм-фактор FHHL с длиной 167 мм. Задействован PCIe-коммутатор Broadcom PEX89048 с поддержкой 48 линий PCIe 5.0. Предусмотрены четыре слота для накопителей M.2 2242/2260/2280 (PCIe 5.0 x4 для каждого из разъёмов). Суммарная вместимость установленных SSD может достигать 32 Тбайт (4 × 8 Тбайт) с быстродействием до 56 Гбайт/с и до 12 млн IOPS. Встроенный RAID-контроллер позволяет формировать массивы RAID 0/1/10. Заявлена совместимость с платформами Windows 10/11, Windows Server 2016/2019/2022, Debian, Ubuntu, Fedora, Proxmox, RHEL, Rocky Linux (ядро Linux 3.10 и выше). Для настройки, управления и мониторинга служит фирменное ПО с веб-интерфейсом и CLI. Карта имеет однослотовое исполнение; для её установки требуется разъём PCIe 5.0 x16. Изделие оснащено радиатором и 80-мм вентилятором, который, по словам компании, обладает низким уровнем шума. Диапазон рабочих температур — от +5 до +55 °C. Заявленный показатель MTBF (средняя наработка на отказ) — 920 585 часов.  Карта расширения Rocket 7604A RAID AIC доступна для заказа по ориентировочной цене $1000. А за $900 можно приобрести вариант Rocket 1604A Switch AIC, который обладает аналогичными техническими характеристиками, но не содержит RAID-контроллера. |

|