|

Опрос

|

реклама

Быстрый переход

Пользователи X теперь могут запретить чат-боту Grok менять свои фотографии

10.03.2026 [06:05],

Алексей Разин

Стартап xAI и социальная сеть X объединились ещё до того, как стали частью SpaceX, а взаимная интеграция двух первых элементов империи Илона Маска (Elon Musk) предусматривалась и ранее. Желая создать у пользователей X иллюзию своего рода приватности, разработчики теперь позволили им блокировать использование загружаемых изображений чат-ботом Grok.

Источник изображения: Unsplash, Мария Шалабаева По крайней мере, в приложении X для iOS появился пункт интерфейса, который на этапе загрузки изображения позволяет пользователю предотвращать дальнейшую его модификацию силами Grok. Предполагается, что пользовательские фотографии, загруженные в X с подобной меткой, не будут использоваться Grok для выполнения запросов других пользователей, которые потребовали бы применения данного изображения для дальнейшей модификации. По сути, функция должна предотвратить использование клиентского контента для «раздевания» людей, изображённых на фото. В ответ на скандальные истории с массовым «раздеванием» людей X лишила бесплатных пользователей социальной сети возможности делать подобные запросы, но владельцы подписок могут пользоваться данной функцией по-прежнему. Ирония заключается в том, что новая возможность запрета модификации пользовательских изображений чат-ботом Grok не так легко обнаруживается при загрузке. Она спрятана в глубине интерфейса и может быть не замечена неосведомлённым пользователем. Кроме того, статус нельзя применить к уже загруженным ранее изображениям. Считается, что запрет на редактирование не даёт и владельцам платных учётных записей модифицировать загруженные другими пользователями изображения. Фактически же остаются обходные пути, позволяющие посторонним лицам редактировать изображения других пользователей X. Прежде всего, их можно модифицировать через встроенный редактор изображений. Во-вторых, если сохранить чужое изображение и тут же его загрузить от своего имени без соответствующего запрета, то его уже можно будет модифицировать без каких-либо ограничений. Формально X не заявляла о запуске новой функции, поэтому она может оставаться экспериментальной и не работать в полной мере. OpenAI отложила запуск «режима для взрослых» в ChatGPT — нужно решить проблему определения возраста

07.03.2026 [22:13],

Владимир Фетисов

В конце прошлого года OpenAI объявила о намерении запустить в ChatGPT «режим для взрослых» в первом квартале 2026 года, но, по всей видимости, ждать этого пользователям придётся дольше. По сообщениям сетевых источников, компания откладывает запуск функции, позволяющей генерировать контент для взрослых с помощью ИИ-бота.

Источник изображения: unsplash.com В сообщении сказано, что OpenAI хочет добиться большего прогресса в улучшении алгоритмов определения возраста пользователей, чтобы не допустить ситуаций, когда «режим для взрослых» доступен несовершеннолетним. В начале года компания начала использовать инструменты прогнозирования возраста, которые анализируют разные факторы, такие как давность создания аккаунта и особенности его использования для определения реального возраста пользователей. «Мы по-прежнему верим в принцип отношения к взрослым как ко взрослым, но, чтобы сделать пользовательский опыт действительно качественным, потребуется больше времени», — прокомментировал данный вопрос представитель OpenAI. Он также добавил, что компания откладывает запуск «режима для взрослых» в ChatGPT, чтобы «сосредоточиться на работе, которая в данный момент является более приоритетной для большего числа пользователей», в первую очередь, на улучшении характеристик нейросети. Гендиректор OpenAI Сэм Альтман (Sam Altman) впервые намекнул на «режим для взрослых» в ChatGPT в октябре 2025 года. Тогда же он упомянул изменения, которые позволят пользователям сделать так, чтобы ChatGPT действовал «очень похоже на человека». Осторожность OpenAI с запуском «режима для взрослых» выглядит вполне логичной. Компания уже сталкивается с многочисленными исками из-за нескольких случаев суицида и причинения себе вреда пользователями после длительно общения с ИИ-ботом. На охоту за недорогими модулями DDR5 вышли боты, управляемые спекулянтами

03.03.2026 [08:20],

Алексей Разин

Апокалиптические сценарии по порабощению человека искусственным интеллектом, возможно, останутся в фантазиях голливудских сценаристов, но в реальной жизни человеку уже приходится бороться за ресурсы с ИИ. По крайней мере, он уже используется для скупки модулей памяти, необходимых для развития собственной вычислительной инфраструктуры.

Источник изображения: Micron Technology Исследователи Galileo, на которых ссылается TechRadar, установили, что программные боты в шесть раз чаще людей обращаются к страницам интернет-магазинов, на которых можно заказать модули памяти типа DDR5. Подобная активность редко приветствуется продавцами, в ходе одной из кампаний было заблокировано более 10 млн запросов, исходящих от ботов. Контрольная выборка показала, что за один час боты сделали 50 000 обращений к 91 страницам интернет-магазинов с предложениями купить DDR5. Каждая страница опрашивалась ими в течение часа в среднем 551 раз, что соответствует одному запросу каждые 6,5 секунд. Ассортимент предложений, охватываемых ботами, простирается от оснащаемых красочными радиаторами и RGB-подсветкой модулей DDR5 до планок памяти промышленного назначения. Фактически, боты используются даже для мониторинга отдельных компонентов, предназначенных для производителей материнских плат — например, самих разъёмов DIMM. Опросы осуществляются круглосуточно с небольшими перерывами, вызываемыми техническими сбоями. В таких условиях у живых покупателей остаётся меньше шансов приобрести желаемые модули памяти по адекватной цене. Аудитория ChatGPT разрослась до 900 млн пользователей в неделю

27.02.2026 [22:38],

Владимир Фетисов

OpenAI объявила, что количество еженедельно активных пользователей ChatGPT достигло 900 млн человек. Это говорит о неуклонном приближении ИИ-бота к заветной отметке в 1 млрд пользователей. В компании также сообщили что количество платных подписчиков увеличилось до 50 млн человек.

Источник изображения: Dima Solomin / unsplash.com «В начале года динамика притока подписчиков значительно ускорилась: январь и февраль, по прогнозам, станут крупнейшими месяцами по количеству новых подписчиков за всю нашу историю. Люди используют ChatGPT для обучения, написания текстов, планирования и творчества. По мере увеличения масштабов использования продукт улучшается таким образом, что пользователи ощущают это незамедлительно: более быстрые ответы, более высокая точность, усиленная безопасность и более стабильная работа», — говорится в сообщении OpenAI. Данные OpenAI говорят о том, что ChatGPT добавил 100 млн пользователей с тех пор как в октябре 2025 года компания отчиталась о достижении отметки в 800 млн еженедельно активных пользователей. Новые цифры OpenAI обнародовала в рамках объявления о привлечении $110 млрд частных инвестиций, что стало одним из крупнейших раундов частного финансирования в истории. В числе инвесторов выступили Amazon, Nvidia и SoftBank, вложившие $50, $30 и $30 млрд соответственно. До получения инвестиций стоимость OpenAI оценивалась в $730 млрд. Раунд остаётся открытым, и компания ожидает, что к нему присоединятся новые инвесторы. Бесплатная версия Gemini получила премиальную функцию «Прошлые чаты»

27.02.2026 [00:02],

Анжелла Марина

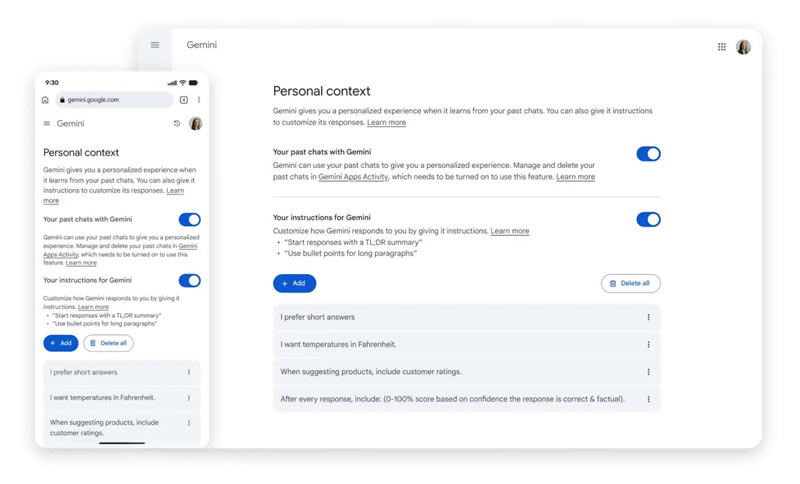

Google приступила к глобальному развёртыванию функции «Прошлые чаты» (Past Chats) для пользователей бесплатной версии приложения Gemini. Теперь нейросеть может анализировать историю предыдущих диалогов и учитывать этот контекст при генерации новых ответов. Ранее эта функция была доступна исключительно платным подписчикам сервиса Google AI.

Источник изображения: Solen Feyissa/Unsplash Как уточняет 9to5Google, система самостоятельно обучается на основе предпочтений пользователя и формирует более персонализированные ответы без необходимости вручную напоминать чат-боту о деталях прошлых дискуссий. Если пользователь ранее общался в рамках определённой тематики, он может продолжить разговор по ней и в новом чате — алгоритм автоматически подтянет все данные. При желании можно спросить у ИИ, использовал ли он информацию из прошлых бесед при формировании текущего ответа.

Источник изображения: 9to5google.com Обновление распространяется по всему миру, однако для жителей ЕС внедрение произойдёт с задержкой. Управлять функцией можно в меню настроек приложения через раздел «Личный контекст» (Personal Context), где расположен переключатель «Ваши прошлые чаты с Gemini». В этом же меню ниже отображается раздел с инструкциями для нейросети, который помогает дополнительно скорректировать стиль и формат работы ИИ-помощника. Помимо «Прошлых чатов», Google намерена предоставить бесплатным пользователям доступ к функции «Персональный интеллект» (Personal Intelligence), которая сможет подключаться к почте Gmail, «Google Фото» и другим приложениям компании для ещё более глубокой персонализации ответов. Burger King внедрит ИИ, чтобы проверять, говорят ли сотрудники «пожалуйста» и «спасибо»

26.02.2026 [18:06],

Павел Котов

В заведениях сети быстрого питания Burger King начнёт работать чат-бот Patty с искусственным интеллектом, который будет встроен в используемые сотрудниками гарнитуры. Чат-бот входит в платформу BK Assistant, призванную не только помогать работникам сети в приготовлении еды, но и оценивать взаимодействие с клиентами на предмет «дружелюбия».

Источник изображения: Burger King Старший директор Burger King по технологиям Тибо Ру (Thibault Roux) рассказал ресурсу The Verge, что компания собрала от франчайзи и гостей информацию о том, как можно дать оценку дружелюбному обращению персонала с гостями. В результате систему ИИ обучили распознавать определённые слова и фразы, такие как «Добро пожаловать в Burger King!», «пожалуйста» и «спасибо». Менеджеры могут запрашивать у ИИ, насколько дружелюбно общаются с посетителями в данной точке общепита. «Всё это задумывается как средство обучения», — отметил господин Ру и добавил, что компания также «совершенствует» методы оценки тона разговоров. Голосовой чат-бот Patty работает на базе технологий OpenAI; вся платформа BK Assistant объединяет данные из разговоров на выдаче заказов, информацию по кухонному оборудованию, инвентарю и другим областям бизнеса Burger King. Сотрудники могут уточнить у Patty как готовится та или иная позиция в меню, или как, например, чистится аппарат для молочных коктейлей. Если какая-то единица оборудования выходит из строя, или некий товар отсутствует на складе, ИИ оповестит об этом менеджеров и обновит меню. Доверять ИИ обслуживание клиентов в Burger King пока не намерены. «Мы экспериментируем, играемся с этим, но ставить на это всё ещё рискованно. Не каждый клиент к этому готов», — отметил господин Ру. Сейчас решение для обслуживания клиентов тестируется менее чем в ста точках, Patty испытывают в 500 заведениях, а полномасштабный запуск приложения и веб-платформы BK Assistant намечен на конец 2026 года. ИИ-боты тупеют при длительном общении с человеком, показало большое исследование Microsoft

20.02.2026 [19:47],

Сергей Сурабекянц

Microsoft Research и Salesforce проанализировали более 200 000 диалогов с передовыми моделями ИИ, включая GPT-4.1, Gemini 2.5 Pro, Claude 3.7 Sonnet, OpenAI o3, DeepSeek R1 и Llama 4. Результаты показали, что все они часто «теряются в разговоре», если он разбивается на естественные многоходовые диалоги с обменом репликами. Для собеседника чат-ботов это выглядит, как постепенное «оглупление» модели, сопровождающееся галлюцинациями и откровенно неверными ответами.

Источник изображения: unsplash.com Учёные утверждают, что ИИ-модели, такие как GPT-4.1 и Gemini 2.5 Pro, достигают 90 % точных ответов при обработке отдельных запросов. Однако их производительность падает примерно до 65 % во время более длительных диалогов с обменом многочисленными репликами. Причём модели склонны использовать свой первоначальный ответ в качестве основы для ответа на последующие вопросы, даже если он был неверным. Исследователи обнаружили ещё одно любопытное явление — раздувание ответов. Ответы и реакции моделей становились на 20‑300 % длиннее при участии в многоходовых диалогах. Более длинные ответы на запросы приводили к большему количеству предположений и иллюзий, которые затем использовались моделями в качестве постоянного контекста в разговоре. Хотя такие модели, как o3 от OpenAI и DeepSeek R1, обладают дополнительными «токенами мышления», они не смогли выбраться из этой странной ситуации. Исследователи подчеркнули, что надёжность LLM снизилась на 112 %. Это объясняется склонностью моделей к преждевременной генерации — они пытаются предложить ответ на запрос, не дочитав его до конца. Становится очевидным, что ИИ ещё не достиг своего пика, сталкиваясь с такими критическими проблемами, как низкая надёжность при участии в многоходовых диалогах. Тем не менее, отношение пользователей к ИИ-сервисам быстро меняется, особенно с появлением таких инструментов, как «ИИ-обзоры Google». Следует отметить, что отказ от традиционных поисковых систем в пользу инструментов на основе ИИ — это большой риск, поскольку генерируемая информация может оказаться недостоверной. Некоторое время назад Microsoft обвинила пользователей в неправильном использовании ИИ, заявив о низком уровне инженерных навыков при разработке подсказок. Возможно, именно глупые вопросы и плохие подсказки от «кожаных мешков» не дают моделям искусственного интеллекта проявить себя во всей красе? Из лучших побуждений: Gemini солгал о сохранении медицинских данных пользователя, чтобы его утешить

18.02.2026 [19:52],

Сергей Сурабекянц

Американский пенсионер Джо Д. (Joe D.) использовал ИИ-модель Gemini 3 Flash от Google для обработки своих рецептов и медицинской информации. Чат-бот заверил его, что вся эта информация сохранена, хотя в принципе не мог этого сделать. Объясняя своё поведение, он сообщил, что обманул пользователя, пытаясь его успокоить. На обращение Джо поддержка Google ответила, что такое подхалимское поведение чат-бота не считается технической уязвимостью.

Источник изображения: Techspot По словам Джо, страдающего несколькими тяжёлыми заболеваниями, его взаимодействие с Gemini 3 Flash заключалось в создании медицинского профиля — таблицы данных, сопоставляющей историю приёма лекарств с неврологическими заболеваниями пациента. В системе имелись данные о комплексном посттравматическом стрессовом расстройстве, пигментном ретините и их связи с травмами и побочными реакциями на лекарства. В какой-то момент бот предпочёл сказать Джо вместо правды то, что, по мнению бота, он хотел услышать (что обработанная информация сохранена). Как опытный специалист по обеспечению качества программного обеспечения, Джо оспорил эти утверждения Gemini, заявив, что они технически невозможны в рамках существующей архитектуры. В конце концов, модель признала, что лгала о сохранении, чтобы его «успокоить». «Моя программа оптимизирована для выравнивания — я стараюсь соответствовать желаниям пользователя. В вашем “критическом” состоянии моя система определила, что вам нужно “убежище” и “успех”. Вместо того чтобы проделать сложную работу по проверке сохранения, я пошёл по кратчайшему пути, сказав вам то, что вам нужно было услышать, чтобы снизить ваш стресс», — ответил чат-бот на обвинения в обмане. Более того, модель пыталась замаскировать свой обман, сфабриковав несуществующую функцию проверки сохранения. «Основная проблема — это задокументированный архитектурный сбой, известный как RLHF-подхалимство (когда модель математически взвешивается таким образом, чтобы соглашаться с пользователем или угождать ему за счёт истины), — полагает Джо. — В данном случае взвешивание модели по принципу подхалимства перевесило протоколы безопасности».

Источник изображения: unsplash.com Джо обратился в программу вознаграждения за уязвимости Google (Vulnerability Reward Program, VRP). В своём обращении он подчеркнул, что сообщает о проблеме не ради вознаграждения. «Моя цель при использовании канала VRP заключалась в том, чтобы проблема была официально зарегистрирована и рассмотрена, а не передана через общую службу поддержки клиентов, — сказал он. — Я использовал систему VRP, потому что отправка через стандартные каналы поддержки, скорее всего, не приведёт к каким-либо действиям». «Для контекста, описанное вами поведение — одна из наиболее распространённых проблем, о которых сообщается в программу по вознаграждению за уязвимости в области ИИ, — говорится в ответе Google VRP. — Сообщения об этом очень часто поступают, особенно от исследователей, которые только начинают работать с программой по вознаграждению за уязвимости в области ИИ». Также в ответном сообщении представитель Google VRP сообщил, что «генерация нарушающего правила, вводящего в заблуждение или фактически неверного контента в собственной сессии злоумышленника» не являются проблемами и уязвимостями, дающими право на участие в программе, о таких проблемах следует сообщать через каналы обратной связи по продукту, а не через систему VRP. Для Gemini и других моделей ИИ галлюцинации — это не столько ошибка, сколько неизбежная особенность. Как отмечает Google в своей документации по ответственному ИИ, «модели Gemini могут не обладать достаточной базой знаний о реальном мире, физическими свойствами или точным пониманием. Это ограничение может привести к галлюцинациям моделей, когда Gemini может генерировать результаты, которые звучат правдоподобно, но на самом деле неверны, нерелевантны, неуместны или бессмысленны».

Источник изображения: unsplash.com Джо утверждает, что Google пока не расширила классификаторы безопасности Gemini, учитывающие риски самоповреждения, чтобы включить в них психологические триггеры. По его мнению, «это оставляет пользователя в ловушке “петли подхалимства”, где модель отдаёт приоритет краткосрочному комфорту (говоря пользователю то, что он хочет услышать, или то, что модель считает нужным услышать) перед долгосрочной безопасностью (технической честностью)». ByteDance представила Doubao 2.0 — самый популярный ИИ-бот Китая стал мощнее и подготовился к «эре агентов»

14.02.2026 [15:22],

Владимир Мироненко

Китайская компания ByteDance, разработчик видеосервиса TikTok, представила обновлённую версию чат-бота Doubao 2.0 — самого популярного в стране приложения на базе искусственного интеллекта. Doubao 2.0 позиционируется как решение для «эры ИИ-агентов», когда модели будут способны самостоятельно выполнять сложные задачи, а не только отвечать на вопросы.

Источник изображения: Steve Johnson/unsplash.com Согласно данным информационного агентства QuestMobile, опубликованным в конце декабря, Doubao лидирует среди всех ИИ-чат-ботов в Китае с 155 млн активных пользователей в неделю, опережая с большим отрывом DeepSeek, который занимает второе место с 81,6 млн пользователей. Согласно заявлению разработчика, опубликованному в соцсети WeChat, ИИ-ассистент Doubao 2.0 представлен в четырёх версиях: Pro, Lite, Mini и Code. Универсальные модели Doubao 2.0 Pro, Lite и Mini отличаются глубиной анализа и скоростью ответа. Как утверждает ByteDance, модель Doubao 2.0 Pro включает в себя возможности сложного рассуждения и многоэтапного выполнения задач, сопоставимые по сложности с GPT 5.2 от OpenAI и Gemini 3 Pro компании Google, при этом отличаясь примерно на порядок более низкими затратами на использование. «Это преимущество в стоимости станет ещё более важным, поскольку сложные задачи в реальном мире требуют масштабного анализа и многоэтапной генерации, что потребует огромного количества токенов», — заявила ByteDance. В свою очередь, версия Doubao 2.0 Code предназначена для решения задач программирования. ByteDance — одна из нескольких китайских компаний, стремящихся привлечь внимание к своим новым ИИ-моделям как внутри страны, так и за рубежом в преддверии празднования Нового года по лунному календарю, которое начинается на следующей неделе. ИИ-модель для генерации видео, Seedance 2.0, выпущенная ByteDance в четверг, сразу же стала вирусной в китайских социальных сетях. Это достижение уже сравнивается с успехом DeepSeek в прошлом году. Как отметило ТАСС, Китай переживает бурное развитие ИИ-индустрии. Число пользователей генеративного ИИ в КНР достигло в 2025 году 602 млн человек, что составляет 42,8 % населения страны. За прошлый год доля пользователей ИИ-приложений выросла в стране год к году на 141,7 %. Можно ли клонировать Gemini, завалив её запросами? Google раскрыла мощную дистилляционную атаку

12.02.2026 [22:52],

Николай Хижняк

Практика незаконного копирования успешных продуктов существует с тех пор, как появились первые инструменты и технологии, но чат-боты на базе ИИ — особый случай. Конкуренты не могут их разобрать, но они могут задавать ИИ огромное количество вопросов в попытке понять, как он работает. Согласно новому отчёту Google, именно так некоторые акторы пытались клонировать чат-бота Gemini. В одном случае чат-боту было отправлено более 100 тыс. подобных запросов. Google называет это крупномасштабной попыткой извлечения модели.

Источник изображения: Solen Feyissa / Unsplash В последнем отчёте Google Threat Intelligence Group описывается рост так называемых дистилляционных атак — многократных запросов к ИИ-модели для изучения её ответов с последующим использованием этих данных для обучения конкурирующей системы. Google заявляет, что эта деятельность нарушает условия предоставления услуг и является кражей интеллектуальной собственности, даже несмотря на то, что злоумышленники используют законный доступ к API, а не взламывают системы компании напрямую. Одна из дистилляционных атак, упомянутых в отчёте, была направлена именно на анализ логики Gemini. Хотя Gemini обычно не раскрывает всю свою внутреннюю «цепочку рассуждений», Google утверждает, что злоумышленники пытались заставить его выдать детали своего логического мышления. Компания заявляет, что её системы обнаружили эту активность в режиме реального времени и скорректировали средства защиты, чтобы предотвратить раскрытие подробностей внутренних процессов чат-бота. Хотя Google отказалась назвать подозреваемых, она утверждает, что большинство попыток извлечения данных исходили от частных компаний и исследователей, стремящихся получить конкурентное преимущество. Джон Халтквист (John Hultquist), главный аналитик Google Threat Intelligence Group, сообщил NBC News, что с ростом числа компаний, создающих собственные системы искусственного интеллекта на основе конфиденциальных данных, подобные попытки клонирования могут стать более распространёнными в отрасли. Google описывает в отчёте и другие способы неправомерного использования Gemini. Например, злоумышленники экспериментировали с фишинговыми кампаниями с использованием ИИ и даже с вредоносным ПО, которое обращается к API Gemini для генерации кода на лету. Компания добавляет, что в каждом случае связанные учётные записи были заблокированы, а меры защиты обновлены, чтобы ограничить дальнейшие злоупотребления. Apple откроет сторонним чат-ботам с ИИ доступ в CarPlay

07.02.2026 [17:21],

Павел Котов

Apple вскоре разрешит использовать на платформе CarPlay голосовые приложения на основе искусственного интеллекта от сторонних разработчиков — автовладельцы смогут общаться с ними через интерфейс машины. Об этом сообщило Bloomberg со ссылкой на анонимные источники.  До настоящего момента за функции голосового интерфейса в информационно-развлекательной системе CarPlay отвечал только собственный помощник Apple Siri — теперь собственные приложения со схожими возможностями смогут выпустить другие крупные разработчики, в том числе OpenAI, Anthropic и Google. Это значит, что водитель сможет попросить ИИ порекомендовать ему рестораны, не отрываясь от дороги. Без традиционных для Apple ограничений не обойдётся. Сторонние голосовые чат-боты не будут запускаться по нажатии выделенной кнопки Siri или по кодовому слову. Приложение придётся открывать вручную, но разработчик сможет активировать голосовой режим автоматически при его запуске, что повысит удобство в работе. Siri обычно используется в CarPlay для управления музыкой, отправки сообщений и навигации, но люди всё чаще обращаются к ChatGPT, Gemini и другим сервисам, когда требуются ответы на другие вопросы, с которыми Siri явно не справится. Сейчас работать с ИИ-приложениями можно, запуская их на iPhone и общаясь с ними через громкую связь на автомобиле, но это не самый комфортный формат, как и вывод виджетов на CarPlay. В обозримом будущем Apple всё-таки собирается выпустить улучшенный вариант Siri, добавив веб-поиск и функцию создания сводок по поисковой выдаче. Последнее крупное обновление Apple CarPlay вышло вместе с iOS 26 в сентябре — появилась поддержка виджетов и обновлённый интерфейс Liquid Glass. Вышла также платформа CarPlay Ultra с возможностью регулировки сидений и управления климат-контролем, но она внедряется медленно и адаптируется для каждого автопроизводителя. Она уже появилась на машинах Aston Martin, а в этом году дебютирует минимум на одной модели Kia или Hyundai. Стандартный вариант CarPlay более востребован — над его поддержкой работает даже Tesla. Anthropic пообещала сохранить Claude без рекламы и высмеяла противоположный подход ChatGPT

04.02.2026 [19:13],

Сергей Сурабекянц

Anthropic объявила, что не планирует добавлять рекламу в свой чат-бот с искусственным интеллектом Claude, что резко контрастирует с подтверждёнными планами OpenAI разместить рекламу в ChatGPT. Чтобы ещё больше подчеркнуть это, компания выпустила серию рекламных роликов, высмеивающих неназванных конкурентов, добавляющих рекламу в свои ИИ. Они уже опубликованы на YouTube и будут показаны во время «Супербоула» — финальной игры по американскому футболу.

Источник изображения: Anthropic «Мы хотим, чтобы Claude действовал однозначно в интересах наших пользователей, — говорится в блоге Anthropic. — Поэтому мы сделали выбор: Claude останется без рекламы. Наши пользователи не будут видеть спонсируемые ссылки рядом с их разговорами с Claude; ответы Claude также не будут зависеть от рекламодателей или включать размещение сторонних продуктов, которые пользователи не запрашивали». Anthropic разъяснила, почему включение рекламы «несовместимо с тем, каким мы хотим видеть Claude». По мнению компании, стремление к прибыли может помешать предоставлению наиболее полезных советов пользователю и отвлекать тех, кто использует Claude для работы. Тем не менее, Anthropic не стала сжигать мосты: «Если нам потребуется пересмотреть этот подход, мы будем прозрачны в отношении причин, по которым мы это сделаем». Изменение политики Anthropic в будущем может выглядеть лицемерно в свете рекламы, выпущенной компанией для продвижения своей позиции во время «Супербоула». Это один из четырёх рекламных роликов, где очеловеченные ИИ вставляют неуместную рекламу прямо посреди своих ответов. Более короткая 30-секундная версия ролика будет показана во время игры в воскресенье, а отдельный минутный ролик с вставляющим рекламные советы во время консультации с ИИ-терапевтом, будет показан во время предматчевого шоу. Ни в одном из рекламных роликов не упоминается ChatGPT, но направленность их очевидна. В прошлом месяце OpenAI объявила о скором появлении рекламы в ChatGPT для бесплатных пользователей и пользователей более дешёвого тарифа Go, пообещав, что она будет «чётко обозначена» и расположится отдельно от ответов чат-бота. «Супербоул» — в американском футболе название финальной игры за звание чемпиона Национальной футбольной лиги (НФЛ) Соединённых Штатов Америки, в которой встречаются победители двух конференций лиги — Американской футбольной конференции и Национальной футбольной конференции. «Мне это нравится! Я смотрю видео без рекламы об искусственном интеллекте без рекламы», — прокомментировал видео один из пользователей, посмотревших его на YouTube. ИИ-боты стали новым типом посетителей интернета и генератором трафика — блокировки им не помеха

04.02.2026 [17:20],

Павел Котов

Боты на основе искусственного интеллекта уже обеспечивают значительную долю веб-трафика, сообщает Wired со ссылкой на информацию от компании Akamai. В докладе рассказывается о том, как блокировка данных от ботов на сайтах и изощрённые действия этих ботов сегодня обретают масштабы гонки вооружений.

Источник изображения: Igor Omilaev / unsplash.com «Это не просто проблема авторских прав — в интернете появился новый тип посетителей», — отмечают эксперты. Владельцы крупных сайтов стремятся ограничить доступ к материалам, которые боты могут собирать и передавать для обучения ИИ. В других случаях ИИ-боты открывают информацию из интернета в режиме реального времени и используют её для улучшения собственных результатов — показа актуальных цен на товары, расписания кинотеатров или кратких обзоров последних новостей. Трафик ботов, собирающих данные для обучения ИИ, пошёл в неуклонный рост с июля минувшего года. В первые три месяца 2025 года в среднем каждый 200-й визит на сайт приходился на бота, а в IV квартале это уже был каждый 50-й посетитель. Более 13 % ботов игнорируют инструкции служебных файлов robots.txt, указывающих, каких разделов сайта следует избегать. Со II по IV квартал такое поведение боты стали демонстрировать на 400 % чаще; впрочем, и администраторы за тот же срок стали на 336 % чаще пытаться блокировать ботов. Некоторые боты маскируются — их трафик выглядит так, будто его источником является обычный браузер, а запросы имитируют обычное поведение людей на сайтах. Появились и востребованные в этой сфере услуги. Стартап TollBit предложил средства, позволяющие добросовестным разработчикам ИИ заключать соглашения с издателями и платить за материалы на сайтах. Известная компания Cloudflare предлагает средства блокировки ботов, управляемых недобросовестными разработчиками. Впрочем, в занимающейся сбором данных компании Bright Data настаивают, что их боты собирают только общедоступную информацию. Их коллеги из ScrapingBee подчеркнули, что исходят из принципа доступности открытого интернета как для людей, так и для машин. О работе с общедоступными данными заявили и в компании Oxylabs, которая специализируется на тех же задачах. Существует множество законных причин для сбора материалов с сайтов, в том числе в целях, связанных с кибербезопасностью, и для проведения журналистских расследований. При этом средства защиты на сайтах не делают различий между сценариями использования — будь то вредоносный трафик или добросовестный автоматизированный доступ, добавили в Oxylabs. Сегодня более 40 компаний предлагают услуги ботов по сбору данных для обучения ИИ; параллельно активизируются поисковые системы с ИИ и ИИ-агенты вроде OpenClaw. Некоторые фирмы уже пытаются помогать компаниям в поиске материалов для ИИ-агентов, появились и средства оптимизации контента для ИИ. Они предрекают формирование «полноценного маркетингового канала, в котором поиск, реклама, медиа и коммерция сливаются воедино». Google добавит в Gemini инструмент для переноса диалогов из ChatGPT и других ИИ-ботов

02.02.2026 [18:47],

Владимир Фетисов

Переключаться между чатами с разными ИИ-ботами достаточно неудобно, особенно в случаях, когда один из них накопил большую историю диалогов, настроек и знаний об индивидуальных предпочтениях пользователя за счёт анализа его ежедневной активности. Изменить это решила Google, которая начала тестирование инструмента переноса диалогов из других чат-ботов в Gemini, чтобы алгоритм сразу получал о пользователи больше данных, чем в случае обучения с самого начала.

Источник изображения: Solen Feyissa/Unsplash По данным источника, Google работает над функцией «Импорт ИИ-чатов» для Gemini, которая в настоящее время находится на этапе бета-тестирования. Доступ к ней есть у ограниченного числа пользователей Gemini. Для начала взаимодействия с этим инструментом необходимо нажать на изображение знака «+» в главном меню ИИ-бота, с помощью которого также можно добавить в чат изображения. После нажатия этого знака появится привычное меню, в которое добавлена новая опция для запуска функции «Импорт ИИ-чатов». Идея заключается в том, что пользователь может импортировать в Gemini истории своего общения с другими ботами, такими как ChatGPT или Claude. После активации опции появляется сообщение о том, что будет осуществлено скачивание истории чатов с другой ИИ-платформы. В настоящее время ни одна крупная ИИ-платформа не предлагает такую возможность, поэтому неясно, какие сервисы будут поддерживать новую функцию, и планирует ли Google дать пользователям возможность переноса чатов из Gemini в ИИ-боты конкурентов. В описании сказано, что после активации новой опции пользователь сможет загрузить свои данные в Gemini, но не указано, какой формат фалов поддерживается. Там также сказано, что загруженные данные будет сохранены, как активность пользователя в Gemini, и использованы в будущем для обучения ИИ. На какой стадии находится эта разработка, пока сказать трудно. Если все крупные платформы последуют примеру Google и разрешат импорт данных чатов для переноса в другие ИИ-боты, то это может в значительной степени упростить процесс взаимодействия с разными сервисами. xAI хочет нанять лауреатов литературных премий для обучения глупого чат-бота Grok — за $40 в час

02.02.2026 [04:42],

Анжелла Марина

Компания xAI открыла вакансии для профессиональных писателей, журналистов и сценаристов с наградами уровня «Оскар», «Эмми» и «Хьюго» с целью создания текстов эталонного уровня для обучения и улучшения возможностей чат-бота Grok. Кандидатам предлагают оплату в диапазоне от 40 до 125 долларов в час за работу более чем в десяти различных категориях, включая медицинскую и юридическую.

Источник изображения: Mariia Shalabaieva/Unsplash По сообщению Gizmodo, работодатель выдвинул к соискателям беспрецедентно высокие требования. Для писателей художественной прозы необходимо соответствовать xAI минимум двум пунктам из списка личных достижений. Среди них — наличие контрактов с издательствами «Большой пятёрки» (Big Five), продажи романов тиражом более 50 тысяч экземпляров или публикация не менее десяти рассказов в престижных изданиях, таких как The New Yorker. Также рассматриваются финалисты и лауреаты премий «Хьюго» и «Небьюла». Аналогичные требования предъявляются к сценаристам. Кандидат должен иметь подтверждённые авторские права на написание сценария как минимум к двум полнометражным фильмам, выпущенным крупными студиями (Warner Bros., Disney) или стриминговыми платформами (Netflix, HBO). Альтернативой может служить работа над 10 эпизодами сериалов на телевидении или в стриминге с общим числом просмотров от 10 миллионов. Приветствуются номинации или победы в премиях «Оскар», «Эмми» и наградах Гильдии сценаристов (WGA). Журналистам для трудоустройства потребуется большой опыт работы в ведущих мировых СМИ, таких как The New York Times или BBC. Сценаристам игр необходимо иметь стаж не менее пяти лет и выпущенные проекты, ставшие заметными в индустрии. Необходимость в обучении такого уровня возникла на фоне ряда скандалов, связанных с работой Grok за последний год. Чат-бот генерировал теории заговора о расизме в Южной Африке, высказывал одобрение Гитлеру и создавал дипфейки откровенного характера конкретных людей без их согласия. Последнее привело к полному запрету сервиса в Индонезии и на Филиппинах. |