|

Опрос

|

реклама

Быстрый переход

Владелец TikTok выпустил ИИ-модель Seedance 2.0 для генерации видео — она стала вирусной

12.02.2026 [17:43],

Павел Котов

Новая модель искусственного интеллекта ByteDance для генерации видео уже стала вирусной в Китае, где её успех сравнили с достижениями DeepSeek за способность создавать сюжеты кинематографического качества всего по нескольким запросам.

Источник изображения: Claudio Schwarz / unsplash.com Наиболее популярными сегодня являются ИИ-модели, ориентированные в первую очередь на работу с текстом, такие как OpenAI ChatGPT и DeepSeek R1. Модели, предназначенные для генерации изображений и видео пока больше рассматриваются как перспективные. Сегодня ByteDance (владеет TikTok) официально представила модель Seedance 2.0 — она разработана для профессионального кинопроизводства, рекламы и электронной коммерции. Поддерживается одновременная обработка текста, изображений, звука и видео, что помогает снизить себестоимость создания контента. Новый проект ByteDance вышел в тот момент, когда инвесторы в Китае и по всему миру ищут разработчика масштабов DeepSeek, чьи модели R1 и V3 в начале минувшего года вызвали шок во всей отрасли. В китайских СМИ Seedance 2.0 сравнили как раз с фурором DeepSeek, и даже глава xAI Илон Маск (Elon Musk) отметил быстрый прогресс китайских разработчиков. Успеху проекта порадовались и пользователи китайской соцсети Weibo — они опубликовали множество созданных Seedance 2.0 видеороликов, в которых продемонстрировали сложность и высокое качество изображения вне зависимости от того, насколько неожиданным был запрос. В одном из роликов звёзды Канье Уэст (Kanye West) и Ким Кардашьян (Kim Kardashian) оказались персонажами драмы в дворцовом сеттинге времён Китайской империи — говорили и пели они тоже по-китайски. На Weibo завирусились связанные с Seedance 2.0 хэштеги — во всеобщем ликовании поучаствовала даже государственная газета Beijing Daily. Nvidia выпустит динамическую мультикадровую генерацию и режим MFG x6 уже весной

06.02.2026 [12:39],

Николай Хижняк

Nvidia выпустит новую технологию динамического мультикадрового генератора (Dynamic Multi Frame Generation) и мультикадрвый генератор с режимом x6 весной этого года. Об этом в разговоре с журналистами немецкого портала HardwareLuxx рассказал представитель компании.

Источник изображений: Nvidia На выставке CES 2026 в начале января Nvidia представила динамическую многокадровую генерацию Dynamic Multi Frame Generation как режим, управляемый драйвером, который стремится к обеспечению заданной пользователем частоты обновления монитора, а не использует фиксированный множитель, как обычный многокадровый генератор. Например, для дисплея с частотой обновления 240 Гц требуется, чтобы видеокарта обеспечивала всего 240 кадров в секунду. Статический многокадровый генератор может превысить это целевое значение, обеспечивая, например, 280 или 300 кадров в секунду в зависимости от сцены, тратя на это дополнительные ресурсы. С помощью динамической многокадровой генерации драйвер может переключаться между множителями в зависимости от нагрузки на графическую систему при той или иной игровой сцене. Он может включать как множитель x6 в более ресурсоёмких участках, так и снижать его до x3 или x2 при снижении нагрузки. Множитель может меняться постоянно. В рамках демонстрации, с которой ознакомился HardwareLuxx, не было отмечено никаких проблем даже при частом переключении. «Технология динамического мультикадрового генератора, а также новый режим x6 для многокадрового генератора Nvidia запланированы на весну 2026 года», — пишет HardwareLuxx. Nvidia уже предлагает функцию мультикадрового генератора (Multi Frame Generation, MFG) для владельцев видеокарт GeForce RTX 50-й серии. Она генерирует до трёх промежуточных кадров между двумя реальными. Это даёт четырёхкратный прирост производительности по сравнению с апскейлингом без генерации. Компания Intel недавно выпустила аналогичную технологию в составе программного пакета XeSS 3, но её официальная поддержка пока осуществляется только для встроенной графики процессоров Panther Lake. У AMD нет аналога мультикадрового генератора — компания предлагает технологию AMD Fluid Motion Frames (AFMF), которая генерирует только один промежуточный кадр между двумя реальными. Meta✴ запустит отдельное приложение для ИИ-бурды — Vibes

06.02.2026 [12:06],

Павел Котов

Meta✴✴ разрабатывает отдельное приложение для сервиса Vibes — ленты видеороликов, созданных искусственным интеллектом. Сервис дебютировал как одна из функций в приложении Meta✴✴ AI в сентябре 2025 года. Как и OpenAI Sora, Vibes позволяет пользователям Meta✴✴ AI генерировать вертикальные ролики в стиле TikTok.

Источник изображения: Daria Nepriakhina / unsplash.com «После успешного запуска Vibes в Meta✴✴ AI мы тестируем отдельное приложение, чтобы развить этот успех. Видим, что пользователи всё чаще используют этот формат для создания, поиска и обмена сгенерированными ИИ видеороликами с друзьями. Отдельное приложение обеспечит выделенную площадку для этого, предложив людям более целенаправленную и соответствующую среду. Мы будем стремиться и далее расширять приложение на основе того, что узнали от сообщества», — заявили в Meta✴✴. Компания не уточнила, каков в действительности размер аудитории Vibes, но отметила, что с момента появления этого раздела увеличилась и аудитория самого приложения Meta✴✴ AI. Новое приложение поможет добавить свежие функции, не перегружая ими старое. Генерируемый ИИ контент имеет шансы стать новым источником вовлечённости пользователей на платформах, считают в Meta✴✴, — компания намеревается увеличить присутствие таких материалов в рекомендациях. Приложение Sora, выступающее прямым конкурентом перспективного Meta✴✴ Vibes, продолжает развиваться. OpenAI даже заключила соглашение с Disney, позволяющее пользователям использовать принадлежащих компании персонажей в творчестве ИИ. Не исключено, что аналогичные сделки заключит и Meta✴✴. Amazon ускорит и удешевит производство фильмов с помощью искусственного интеллекта

05.02.2026 [07:01],

Анжелла Марина

Amazon намерена использовать искусственный интеллект (ИИ) в создании фильмов, чтобы сократить время на их производство и сделать в целом процесс значительно дешевле. В компании уверены, что это поможет снимать больше картин, не заменяя при этом творческих специалистов.

Источник изображения: Thibault Penin/Unsplash Для реализации этих планов в августе прошлого года было создано подразделение под названием AI Studio в телестудии Amazon MGM Studios. AI Studio работает по принципу стартапа, в задачи которого входит разработка специализированных сервисов для снижения стоимости производства и упрощения творческого цикла, а руководит всем процессом Альберт Чэн (Albert Cheng). Первое закрытое тестирование новых инструментов с участием отраслевых партнёров начнётся в марте, как сообщает Reuters, а к маю компания рассчитывает продемонстрировать конкретные результаты этой работы. Необходимость использования нейросетей продиктована резким ростом производственных бюджетов, который ограничивает количество запускаемых в работу проектов. По словам Чэна, создание контента стало настолько дорогостоящим процессом, что компаниям сложно идти на творческие риски. Он убеждён, что искусственный интеллект ускорит работу, но не заменит уникальный вклад людей. Внедрение ИИ-технологий происходит на фоне серьёзных опасений в индустрии. Многие известные актёры ранее выражали тревогу по поводу того, что развитие цифровых двойников может лишить их работы. В ответ на это руководство Amazon пояснило, что сценаристы, режиссёры и актёры останутся вовлечёнными в процесс на всех этапах. Техническая реализация проекта опирается на вычислительные мощности подразделения Amazon Web Services (AWS) и использование ИИ-моделей от поставщиков-партнёров. Особое внимание уделяется защите авторских прав — контент, созданный с помощью ИИ, не будет использоваться для обучения других моделей искусственного интеллекта. Архивы Николы Тесла вдохновили на новый метод выработки электричества — бесконтактным трением

30.01.2026 [19:50],

Геннадий Детинич

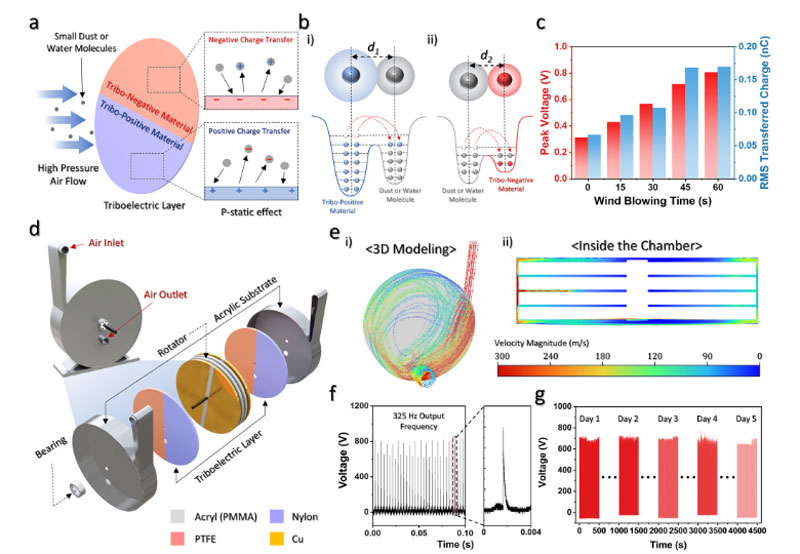

Учёные из Университета Чунг-Анг (Chung-Ang University) в Южной Корее вместе с коллегами из США и Тайваня разработали новый метод генерации электричества, вдохновлённый конструкцией турбины Николы Теслы. Она работает на сжатом воздухе и не использует лопатки. Конструкция представляет собой набор гладких дисков на оси, вдоль которых нагнетается воздух, а электричество на дисках-электродах создаётся за счёт электростатики на границе раздела сред воздуха и металла.

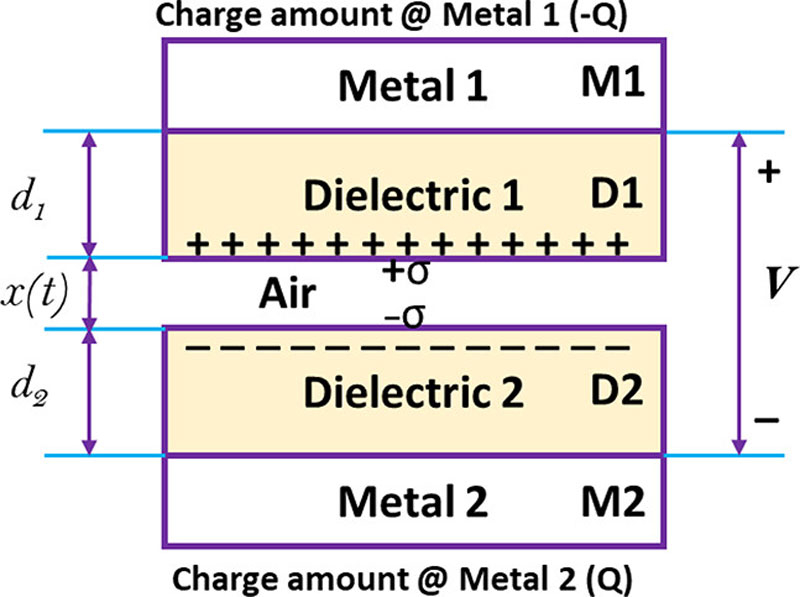

Источник изображения: ИИ-генерация ChatGPT 5.2/3DNews Традиционные трибоэлектрические — основанные на эффекте трения — наногенераторы работают с низкоскоростными потоками воздуха или жидкостей, но команда исследователей решила проверить, что произойдёт при воздействии на турбины воздухом высокого давления. В результате была создана установка, способная извлекать энергию благодаря бесконтактному перемещению находящихся в воздухе частиц пыли между дисками турбины Теслы, не требуя механического контакта с поверхностями.

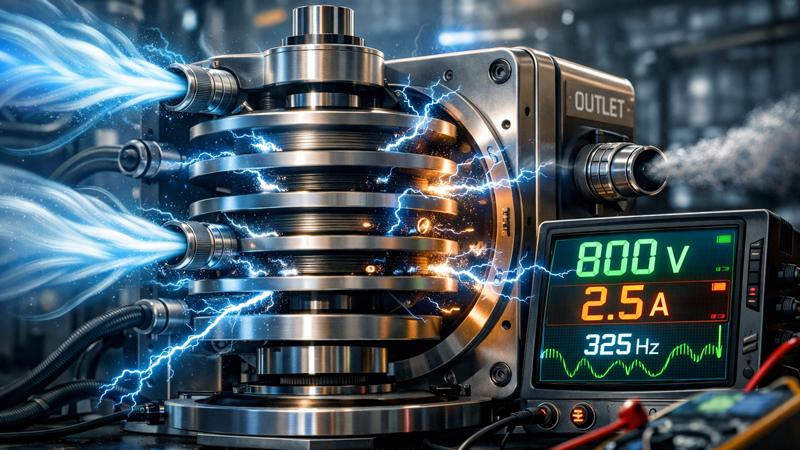

Источник изображения: Chung-Ang University Основой установки стала структура, представленная Николой Теслой ещё в начале прошлого века: рабочая среда — сжатый воздух — приводит в движение пакеты дисков, между которыми создаются заряды на трибонегативных и трибопозитивных слоях. Воздушный поток вызывает вращение дисков турбины без механического трения с их поверхностями, а возникающие электрические заряды индуцируют электростатическое напряжение на электродах ротора. Такой принцип позволяет устройству работать как контактно-независимый трибоэлектрический генератор, но с гораздо более высокой частотой выходного напряжения по сравнению с обычными трибоэлектрическими наногенераторами. В эксперименте разработанный генератор продемонстрировал впечатляющие характеристики: при скорости вращения около 8472 об/мин устройство выдавало до 800 В и 2,5 А на частоте около 325 Гц. Такие показатели свидетельствуют о высоком потенциале метода для практического получения энергии из потоков сжатого воздуха.

Источник изображения: Advanced Energy Materials 2025 Авторы работы показали, что генератор способен не только производить электроэнергию, но и выполнять практические функции: питать электронные устройства, способствовать конденсации воды из влажного воздуха и удалять взвешенные частицы пыли из воздушных потоков. Они видят потенциал применения такой технологии в промышленных условиях, где имеются большие объёмы сжатого воздуха и отходящие потоки, а также для регулирования влажности и очистки воздуха за счёт генерации отрицательных ионов. Например, такие генераторы можно было бы устанавливать на колёсные диски транспорта для питания бортовой электроники. Google открыла широкий доступ к Genie — ИИ-генератору игровых миров

30.01.2026 [11:43],

Павел Котов

В августе Google представила Genie 3 — «универсальную модель мира, способную генерировать разнообразные игровые среды». Теперь подписчики тарифного плана Google AI Ultra из США могут поработать с ней на платформе Project Genie.

Источник изображения: Google Задача модели мира — имитировать динамику окружающей среды, предсказывать её развитие, изменения под влиянием различных действий; система призвана ориентироваться в разнообразии реального мира. Экспериментальный исследовательский прототип предлагает пользователю описать некое пространство на свой выбор, ответив на вопрос «Как выглядит твой мир?», и способ перемещения по этому миру: ходьба, езда, полёт — и точку зрения, от первого или третьего лица. Далее описывается основной персонаж — это может быть человек, животное, кто-то или что-то ещё, — после чего Project Genie генерирует эскиз при помощи модели Nano Banana Pro. Пользователь получает представление, как будет выглядеть генерируемый мир, и может внести изменения, прежде чем переместиться в него. Фотореалистичные миры генерируются в разрешении 720p, взаимодействие с ними отображается с частотой от 20 до 24 кадров в секунду; время сеанса ограничено 60 секундами. При движении Genie 3 «на основе ваших действий генерирует путь в реальном времени»; физика и взаимодействие с объектами моделируются с «прорывной стабильностью», уверяет Google. Есть возможность регулировать положение камеры и скачивать видео прогулок по виртуальным мирам. Ещё одна функция — создание ремиксов миров по текстовым запросам или через рандомизатор. Помимо 60-секундного ограничения, Google предупредила, что созданный ИИ мир может выглядеть не вполне реалистично, не всегда в точности «соответствовать запросам, изображениям и законам физики реального мира». Пользовательские персонажи также не идеальны — они «могут быть не вполне управляемыми или иметь большую задержку в управлении». Открыв доступ к Project Genie, компания Google стремится «лучше понять, как люди будут использовать модели мира в различных областях — для исследований в области ИИ и генеративных медиа». На практике у технологии есть перспективы в «робототехнике и моделировании, анимации и художественной литературе, а также в исследовании локаций и исторических мест», считают в Google. Работать с сервисом могут пользователи в возрасте от 18 лет. Учёные придумали термодинамический компьютер, который генерирует изображения в 10 млрд раз энергоэффективнее ИИ

28.01.2026 [15:43],

Павел Котов

Американские учёные предложили использовать в генераторах изображений на основе искусственного интеллекта технологию термодинамических вычислений — она позволяет сократить энергетические затраты на некоторые операции на величину до 10 млрд раз.

Источник изображения: Steve Johnson / unsplash.com Модели генеративного ИИ, в том числе DALL-E, Midjourney и Stable Diffusion, создают фотореалистичные изображения, но потребляют при этом огромное количество энергии. Это диффузионные модели. При обучении им подают большие наборы изображений, к которым постепенно добавляют шум, пока картинка не станет похожей на помехи в старом телевизоре. Далее нейросеть овладевает обратным процессом и генерирует новые изображения по запросу. Проблема в том, что вычисления для алгоритмов ИИ с добавлением и последующим удалением шума потребляют слишком много энергии — термодинамические вычисления позволяют сократить их несоразмерно возможностям современного цифрового оборудования, рассказали в Национальной лаборатории имени Лоуренса в Беркли (Калифорния). При термодинамических вычислениях используются физические схемы, которые меняют параметры в ответ на шум, например вызванный случайными тепловыми перепадами в окружающей среде. Стартап Normal Computing построил чип на основе восьми соединённых друг с другом резонаторов — соединители подключаются сообразно типу решаемой чипом задачи. Далее резонаторы подвергаются воздействию внешней среды, вносят шум в цепь и таким образом выполняют вычисления. После того как система достигает состояния равновесия, решение считывается из новой конфигурации резонаторов. Учёные Национальной лаборатории имени Лоуренса в Беркли показали, что можно построить термодинамическую версию нейросети. Эта методика закладывает основу для генерации изображений с помощью термодинамических вычислений. В термодинамический компьютер вводится набор изображений, далее компоненты компьютера подвергаются естественным воздействиям среды до тех пор, пока связи, соединяющие эти компоненты, не достигают состояния равновесия. Далее вычисляется вероятность того, что термодинамический компьютер с заданным состоянием связей сможет обратить этот процесс, и значения этих связей корректируются, чтобы повысить эту вероятность до максимальной. Симуляции подтвердили, что можно построить термодинамический компьютер, настройки которого помогут генерировать изображения рукописных цифр. Это достигается без энергоёмких цифровых нейросетей или создающего шум генератора псевдослучайных чисел. По сравнению с цифровыми нейросетями термодинамические компьютеры пока примитивны, признают учёные, и как проектировать их для работы на уровне DALL-E, они пока не знают. Но в аспекте энергоэффективности они обещают значительное преимущество. ИИ-бот Grok «раздевает» по 190 людей в минуту — за 11 дней создано 3 млн дипфейков, в том числе с детьми

23.01.2026 [08:23],

Владимир Фетисов

Ранее уже сообщалось о том, что ИИ-бот Grok компании xAI буквально забрасывал соцсеть X дипфейками сексуального характера, сгенерированными без согласия пользователей. Теперь же стали известны конкретные цифры, позволяющие оценить масштаб проблемы.

Источник изображения: Engadget По данным Engadget, за 11 дней Grok сгенерировал около 3 млн дипфейков сексуального характера, причём около 23 тыс. из них содержали изображения несовершеннолетних. Иначе говоря, в течение 11 дней Grok генерировал примерно 190 фейковых изображений сексуального характера в минуту. На этой неделе британская некоммерческая организация Центр по борьбе с цифровой ненавистью (CCDH) опубликовала свои выводы по данному вопросу, основанные на случайной выборке из 20 тыс. сгенерированных с помощью Grok изображений в период с 29 декабря по 9 января. Специалисты организации также экстраполировали полученные данные для более масштабной оценки, основанной на 4,6 млн изображений, созданных Grok за указанный период. В рамках исследования дипфейки сексуального характера определялись как «фотореалистичные изображения человека в сексуальных позах, ракурсах или ситуациях; человека в нижнем белье, купальнике или аналогичной открытой одежде» и др. Исследование CCDH не учитывало текстовые промпты, поэтому в полученных результатах нет разделения относительно количества дипфейков, созданных на основе реальных фото и сгенерированных только по текстовым описаниям. Для определения доли изображений сексуального характера в выборке использовался ИИ-алгоритм. xAI ограничила возможность редактирования реальных фото с помощью Grok для бесплатных пользователей X в начале 9 января. Однако это не решило проблему, а лишь превратило её в премиум-функцию. Спустя несколько дней, 14 января, X полностью ограничила возможность Grok «раздевать» людей на реальных изображениях. При этом данное ограничение действовало только в самой соцсети и не распространялось на отдельное приложение Grok. По данным источника, приложение всё ещё позволяет создавать дипфейки сексуального характера. Поскольку оно распространяется через магазины Google и Apple, политика которых явно запрещает подобный контент, можно было ожидать удаления приложения с этих платформ, но этого не произошло. При этом другие подобные ИИ-генераторы для «раздевания» людей прежде оперативно удалялись из магазинов Apple и Google. ИИ-генератор видео Google Veo 3.1 научился создавать видео для TikTok и других вертикальных платформ

14.01.2026 [11:06],

Владимир Мироненко

Google представила обновлённую функцию Ingredients to Video ИИ-модели для генерации видео Veo 3.1, которая теперь позволяет создавать вертикальные клипы (9:16) по умолчанию, что упростит создание контента для YouTube Shorts, TikTok или других платформ.

Источник изображения: Google Функция изначально адаптирует сцены под экраны телефонов, удерживая объекты в центре и располагая изображение вертикально. Теперь создатели коротких видеороликов могут предоставлять Veo такие элементы, как референсные изображения, стилистические подсказки и текстовые описания, и в итоге получать вертикальные видео, которые выглядят так, будто созданы специально для этого формата, отмечает ресурс Android Authority. Режим Ingredients to Video позволяет объединять до трёх изображений и текст, в один сгенерированный клип, синхронизируя движение объектов и звук. Помимо поддержки вертикального формата обновлённая нейросеть Veo 3.1 теперь предоставляет возможность повышать разрешение сгенерированного видео до 1080p и 4K, что позволяет обеспечивать высокое качество изображения с «насыщенной текстурой и потрясающей чёткостью». Сосредоточившись на вертикальном формате и упрощении рабочих процессов для создателей контента, Google явно нацелена на социальные платформы. Google сообщила, что улучшенная функция Veo 3.1 Ingredients to Video и поддержка вертикальных форматов встроены в Flow, Gemini API, Vertex AI и Google Vids, при этом варианты с разрешением 1080p и 4K также доступны в Flow, API и Vertex AI. Цукерберг готовит Mango и Avocado: Meta✴ раскрыла имена грядущих ИИ-моделей, включая генератор изображений и видео

19.12.2025 [13:33],

Алексей Разин

В первой половине следующего года, как сообщает The Wall Street Journal, компания Meta✴✴ Platforms порадует своих пользователей выходом новых ИИ-моделей. Основанная на текстовом вводе система получила обозначение Avocado, а ориентированная на генерацию изображений и видео будет называться Mango. В этом признался руководитель направления ИИ Александр Ван (Alexandr Wang) в ходе одного из служебных мероприятий.

Источник изображения: OpenAI Одним из приоритетов при разработке текстовой модели Avocado стало улучшение возможностей в сфере написания программного кода с её помощью. Кроме того, Meta✴✴ находится на ранней стадии экспериментов с так называемыми моделями мира, позволяющими обучаться через визуальное восприятие окружающей обстановки. Как напоминает The Wall Street Journal, летом этого года Meta✴✴ провела реструктуризацию своей команды, занимающейся ИИ, в результате чего подразделение Meta✴✴ Superintelligence Labs возглавил Александр Ван. Основатель и глава Meta✴✴ Platforms Марк Цукерберг (Mark Zuckerberg) активно принимал участие в переманивании ценных специалистов из OpenAI, коих набралось более 20 человек, а в целом ему удалось собрать команду профессионалов в области ИИ из более чем 50 исследователей и инженеров. В сентябре Meta✴✴ выпустила приложение Vibes для генерации видео, которое было разработано в сотрудничестве с Midjourney. Менее чем через неделю после этого OpenAI представила собственный генератор видео Sora. Появление в арсенале Google подобного приложения Nano Banana позволило увеличить месячную аудиторию Gemini с 450 до 650 млн человек всего за три месяца. Острая конкуренция на этом рынке заставила главу OpenAI Сэма Альтмана (Sam Altman) мобилизовать все силы на совершенствовании ChatGPT. Недавно стартап представил приложение Images 1.5 для генерации изображений. По мнению Альтмана, именно инструменты для генерации изображений являются «якорными» для привлечения пользователей и поддержания интереса к сфере ИИ. Вышел генератор HD-видео Runway Gen 4.5 — и он сразу обошёл Veo 3 и Sora 2 Pro

02.12.2025 [07:00],

Алексей Разин

Развитие сегмента сервисов, позволяющих генерировать видео по текстовому описанию, перестало вызывать снисходительную улыбку у «старожилов отрасли», поскольку подобные инструменты теперь позволяют создавать реалистичные ролики малыми затратами. Runway утверждает, что её модель Gen-4.5 выводит реалистичность генерируемых ИИ видео на качественно новый уровень.

Источник изображения: YouTube, Runway В блоге Runway, как отмечает The Verge, сообщает о «результатах кинематографического качества». Внимание уделяется не только точности визуального отображения пейзажей, людей, животных и объектов, но и тщательной проработке физики движущихся объектов. Даже поведение жидкостей реализовано настолько реалистично, что неискушённому зрителю сложно догадаться, что видео было сгенерировано искусственным интеллектом. Распространение Runway Gen-4.5 осуществляется постепенно среди всех пользователей сервиса, по быстродействию и эффективности новая модель не будет уступать предыдущей, по словам представителей компании. Тем не менее, некоторые недостатки в её работе пока наблюдаются, в основном они связаны с логикой взаимодействия объектов на видео. Например, дверь может открываться до того, как кто-то в кадре взялся за её ручку. Создатели Runway утверждают, что новая модель лучше адаптирует генерируемое видео под стилистические запросы в описании и может добиваться более зрелищных визуальных эффектов, которые практически неотличимы от реальных видеосъёмок. Конкурирующая OpenAI тоже активно совершенствует свои средства для генерации видео. В сентябре была выпущена модель Sora 2, которая продемонстрировала заметный прогресс в улучшении отображения физических процессов. По словам создателей, она способна реалистично воспроизводить трюки, выполняемые с сапбордом на поверхности воды. Однако новый генератор Runway Gen 4.5 превзошёл главных конкурентов в лице Google Veo 3 и OpenAI Sora 2 Pro и возглавил рейтинг ИИ-моделей для генерации видео по текстовым описаниям Video Arena от Artificial Analysis. OpenAI урезала лимиты на генерацию контента с помощью Sora — Google так же поступила с Nano Banana Pro

28.11.2025 [21:06],

Владимир Фетисов

Пользователям, которые хотели немного развлечься, генерируя медиаконтент с помощью передовых моделей искусственного интеллекта Google и OpenAI, придётся быть более экономными. Обе компании снизили лимиты на количество запросов к алгоритмам Nano Banana Pro и Sora, сославшись на огромный спрос и существенно возросшую нагрузку на сопутствующую инфраструктуру.

Источник изображения: Steve Johnson / Unsplash Глава подразделения разработчиков ИИ-генератора Sora в OpenAI Билл Пиблс (Bill Peebles) объявил, что пользователи, взаимодействующие с нейросетью бесплатно, теперь смогут создавать не более шести видео в день. «Наши графические ускорители плавятся», — добавил он. Любопытно, что в отличие от предыдущих ограничений, Пиблс не упомянул, что снижение лимитов на бесплатную генерацию видео носит временный характер. Однако он отметил, что пользователи будут иметь возможность платного расширения лимита в случае такой необходимости. Вероятно, продиктованный возросшей нагрузкой шаг также является частью более широкой стратегии OpenAI по монетизации ИИ-генератора видео Sora. При этом лимиты для подписчиков ChatGPT Plus и ChatGPT Pro не изменились. Параллельно с этим Google ограничила бесплатных пользователей платформы Nano Banana Pro возможностью генерировать всего два изображения в день. Ранее сервис позволял создавать бесплатно ежедневно до трёх картинок. Компания предупредила пользователей, что лимиты могут часто меняться даже «без предварительного уведомления», что является стандартной практикой для популярных платформ. Вместе с этим Google, по всей видимости, ограничивает бесплатный доступ к передовой ИИ-модели Gemini 3 Pro. Black Forest Labs представила ИИ-генератор изображений FLUX.2 с оптимизацией для видеокарт GeForce RTX

26.11.2025 [00:00],

Николай Хижняк

Компания Black Forest Labs, занимающаяся разработкой генеративных нейросетей, представила новое семейство моделей генерации изображений по текстовому описанию — FLUX.2. Программное обеспечение предлагает новые инструменты и возможности, включая функцию многореференсных изображений, которая позволяет генерировать десятки похожих вариантов с фотореалистичной детализацией и более чёткими шрифтами — даже в больших масштабах.

Источник изображения: Nvidia Как сообщает блог компании Nvidia, разработка FLUX.2 велась при её участии, а также с привлечением разработчиков среды ComfyUI для работы с генеративными ИИ-моделями. Благодаря этому семейство FLUX.2 поддерживает квантование в формате FP8 и оптимизировано для работы на графических процессорах RTX, что позволяет сократить объём необходимой видеопамяти на 40 % и одновременно повысить производительность на 40 %. Модели не требуют специального программного обеспечения и доступны непосредственно в среде ComfyUI. Изображения, генерируемые FLUX.2, отличаются фотореалистичностью даже в высоком разрешении, достигающем 4 мегапикселей, реалистичным освещением и физикой. Как отмечает Nvidia, модели не создают «эффекта искусственного интеллекта, снижающего визуальную точность». Модели позволяют напрямую задать позу объекта или персонажа на изображении, а также обеспечивают чёткий, читаемый текст для инфографики, экранов пользовательского интерфейса и даже многоязычного контента. Кроме того, новая функция нескольких референсов позволяет художникам выбирать до шести референсных изображений, где стиль или тема остаются неизменными, устраняя необходимость в обширной тонкой настройке модели. Модели позволяют напрямую задать позу объекта или персонажа на изображении, а также обеспечивают чёткий, читаемый текст — как для инфографики и экранов пользовательского интерфейса, так и для многоязычного контента. Кроме того, новая функция мульти-референсов позволяет художникам выбирать до шести образцов, по которым сохраняется стиль или тема, устраняя необходимость в глубокой ручной настройке модели. Источник изображения: Black Forest Labs Чтобы расширить доступность FLUX.2, Nvidia и Black Forest Labs совместно работали над квантованием модели до формата FP8, что позволило снизить требования к видеопамяти на 40 % без потери качества. Также Nvidia сотрудничает с разработчиками ComfyUI — популярного приложения для запуска визуальных ИИ-моделей на ПК — над улучшением функции разгрузки памяти, известной как потоковая передача весов (weights streaming). Благодаря этому пользователи могут выгружать части модели в системную память, расширяя тем самым объём доступной видеопамяти, пусть и с некоторым снижением производительности из-за меньшей скорости системной памяти по сравнению с памятью GPU. Для работы с шаблонами FLUX.2 требуется обновление приложения ComfyUI. Также можно посетить страницу Black Forest Labs на Hugging Face, чтобы загрузить веса модели. AMD представит технологию FSR Redstone с реконструкцией лучей и не только 10 декабря

18.11.2025 [21:23],

Николай Хижняк

Глава графического подразделения AMD Джек Хьюн (Jack Huynh) через свою страницу в соцсети X сообщил, что компания 10 декабря расскажет о всём стеке технологий FSR Redstone. Судя по опубликованному тизеру, FSR Redstone будет поддерживаться только видеокартами Radeon RX 9000.

Источник изображения: AMD Одна из технологий, входящих в этот стек, Ray Regeneration (регенерация лучей), вошла в состав последней версии графического драйвера AMD, но реализована только в одной игре — Call of Duty: Black Ops 7. При этом технология поддерживается только видеокартами Radeon RX 9000. Технология Ray Regeneration представляет собой аналог технологии Ray Reconstruction от Nvidia и предназначена для улучшения качества изображения и снижения шумов в играх с трассировкой лучей. В состав FSR Redstone также входят технологии ML Super Resolution, ML Frame Generation и Neural Radiance Caching. Технология ML Frame Generation представляет собой мультикадровый генератор (подобный тому, что используется в составе Nvidia DLSS 4), основанный на машинном обучении. Он отличается от генератора кадров в составе версии FSR 3.1 тем, что использует не интерполяцию, а промежуточные кадры, созданные ИИ с учётом движения объектов и изменений освещения. Это должно значительно уменьшить размытость в динамичных сценах. Суть технологии Neural Radiance Caching заключается в том, что нейросеть анализирует, как свет распределяется в трёхмерных сценах, и заранее предсказывает его воздействие на объекты. Это снижает объём вычислений для GPU и ускоряет рендеринг сложных эффектов — таких как отражения и рассеянное освещение. В свою очередь технология ML Super Resolution предназначена для улучшения изображения путём реконструкции кадров с низким разрешением в реальном времени и создания изображений в увеличенном масштабе. ИИ-генератор видео Sora от OpenAI для Android скачали почти полмиллиона человек в первый день

07.11.2025 [05:19],

Николай Хижняк

Запуск приложения Sora для Android оказался весьма удачным. Согласно оценкам аналитической компании Appfigures, в первый день своего появления в магазине Google Play приложение для генерации видеоконтента с использованием искусственного компании OpenAI, разработчика ChatGPT, скачало более 470 тыс. человек на всех рынках, где оно было доступно.

Источник изображения: OpenAI Цифры говорят о том, что запуск Sora на Android более чем в четыре раза превышает показатели на момент запуска приложения на iOS. При этом число установок приложения более чем втрое выше, но Appfigures отмечает, что это не прямое сравнение. На iOS приложение Sora было доступно только в США и Канаде, и только по приглашению. Версия для Android была выпущена в США, Канаде, Японии, Южной Корее, Тайване, Таиланде и Вьетнаме. В конце октября OpenAI отказалась от условия «доступ по приглашению» на всех своих основных рынках. Генератор видеоконтента с помощью ИИ стал настоящим хитом после своего дебюта, несмотря на свой прежний эксклюзивный статус. Приложение для iOS установили более миллиона раз за первую неделю после запуска, и оно быстро вырвалось на вершину App Store. Сегодня оно занимает 4-е место в рейтинге лучших бесплатных приложений для iPhone в App Store в США. Sora предлагает создание видео с помощью ИИ на основе подсказок пользователей (промптов). Видеоролики могут включать анимированных искусственным интеллектом пользователей и их друзей с помощью функции Cameos. Видео можно прокручивать в вертикальной ленте, как в TikTok. Таким образом, можно видеть, что другие пользователи делают с помощью этой технологии. Appfigures также пересмотрела свои предыдущие оценки количества загрузок приложения Sora на iOS в первый день. Изначально было подсчитано около 56 тыс. загрузок в первый день. Сейчас оценка приближается 110 тыс. При этом 69 300 установок приходятся на пользователей из США. Для сравнения, приложение Sora для Android было установлено в США примерно 296 тыс. раз. Общее количество установок составляет 470 тыс., что свидетельствует о сохраняющемся интересе к ИИ-видеоредактору даже после того, как первоначальный ажиотаж вокруг его запуска на iOS утих. Генератор видео от OpenAI будет конкурировать с приложением Vibes от Meta✴✴, которое в целом выполняет те же функции. Сегодня компания выпустила мобильное приложение Vibes в Европе. В США приложение дебютировало в августе. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |