|

Опрос

|

реклама

Быстрый переход

ByteDance пообещала отучить ИИ-генератор Seedance 2.0 копировать голливудских актеров и персонажей

16.02.2026 [14:37],

Алексей Разин

Создание видеороликов с помощью ИИ-сервисов сталкивается с рядом юридических претензий, поскольку киностудии, правообладатели и знаменитости не желают допускать копирования их интеллектуальной собственности и образов без разрешения. Китайская ByteDance после запуска профильного сервиса Seedance 2.0 вынуждена была пообещать правообладателям ввести защитные механизмы, которые учитывали бы их интересы.  Как и многие подобные сервисы, Seedance 2.0 позволяет создавать реалистичные видео на основе текстовых запросов. Социальные сети после запуска Seedance 2.0 сразу же наводнились видеороликами с персонажами, охраняемыми авторским правом, а также образами, напоминающими реальных знаменитостей. Поскольку многие из них имели американское происхождение, то к создателям подобных роликов у правообладателей возникли справедливые претензии. «Мы принимаем меры по усилению существующих защитных механизмов, чтобы предотвратить неправомерное использование интеллектуальной собственности и схожести (со знаменитостями) со стороны пользователей», — заявили представители ByteDance ресурсу CNBC. Свои претензии к создателям сервиса Seedance 2.0 довольно быстро направила отраслевая ассоциация MPA, которая в США представляет интересы большинства крупных киностудий и платформы Netflix. Она призвала ByteDance решительно пресечь неправомерную активность по использованию защищаемых интеллектуальными правами образов. По словам представителей ассоциации, подобная активность не только нарушает американские законы, но и угрожает миллионам рабочих мест в США. Студия Disney направила в адрес ByteDance письмо с требованиями прекратить неправомерное использование принадлежащих ей персонажей. По мнению представителей Disney, китайская ByteDance для обучения ИИ-модели якобы использовала полученную пиратским образом библиотеку образов, считая её публично доступной. Ранее Disney подписала соглашение с OpenAI, которое позволяет пользователям ИИ-сервисов последней внедрять в генерируемые видео ряд узнаваемых персонажей, принадлежащих студии. Требования прекратить нарушение прав в сфере интеллектуальной собственности в адрес ByteDance на прошлой неделе направила и Paramount Skydance. Disney+ скоро начнёт заполняться ИИ-контентом от OpenAI Sora, но на другие проекты это не повлияет

04.02.2026 [00:19],

Владимир Фетисов

Генеральный директор Disney Боб Айгер (Bob Iger) заявил, что сгенерированные с помощью сервиса OpenAI Sora видео скоро начнут появляться на платформе Disney+. При этом он отметил, что это не должно повлиять на остальной производимый компанией контент, включая фильмы и телепроекты.

Источник изображения: OpenAI Во время подведения финансовых итогов за прошедший квартал Айгер сообщил, что анонсированное в декабре соглашение с OpenAI сроком на три года начнёт приносить плоды в ближайшие несколько месяцев. В рамках достигнутых договорённостей Disney инвестирует в разработчика ИИ-алгоритмов $1 млрд, а OpenAI, в свою очередь, за неназванную сумму купит лицензию, которая позволит задействовать 250 персонажей Disney для генерации видео на платформе Sora. Генерируемые пользователями Sora вертикальные видео появятся в Disney+ позднее в этом году. На начальном этапе продолжительность таких роликов будет ограничена 30 секундами. По мнению Айгера, это позволит Disney извлечь выгоду на фоне высокой популярности коротких видео на других платформах, таких как YouTube. «Это соглашение даёт нам стартовый толчок для размещения коротких видео на Disney+. Кроме того, мы надеемся, что с помощью инструментов Sora подписчики Disney+ смогут создавать короткие видео на нашей платформе. Я считаю, что всё это — позитивный шаг в сторону интеграции функции, которая, как мы верим, значительно повысит вовлеченность аудитории», — заявил Айгер. Доводя до инвесторов отношение компании к искусственному интеллекту в целом, Айгер сказал, что Disney видит в этой технологии потенциальные преимущества и перспективы. Одно из таких преимуществ, по его мнению, заключается в возможности использования ИИ-инструментов для помощи творческому процессу и креативности. Ещё одним преимуществом должны стать высокая производительность и повышение эффективности разных рабочих процессов. Он также отметил, что ИИ позволит компании более тесно взаимодействовать с потребителями, что позитивно отразится на их вовлеченности. xAI выпустила Grok Imagine 1.0 с поддержкой создания 10-секундных видео в улучшенном разрешении

03.02.2026 [06:11],

Анжелла Марина

Компания xAI представила масштабное обновление инструмента генерации видео Grok Imagine 1.0. В новой версии теперь можно создавать ролики длиной до 10 секунд в разрешении 720 пикселей и синхронизировать звук. ИИ стал лучше понимать текстовые запросы и научился работать с уточняющими инструкциями.

Источник изображения: Grok Как сообщает издание Mint, разработчики назвали этот релиз крупнейшим обновлением системы, а Илон Маск (Elon Musk) в своём сообщении подтвердил, что версия 1.0 уже доступна. Представители xAI отметили, что обновление привнесёт повышение чёткости изображения и плавности визуального ряда для эффективного использования в творческих проектах и соцсетях. Ключевым нововведением стала работа со звуком. Пользователи смогут добавлять персонажам выразительные голоса с эмоциональной окраской, а также накладывать фоновую музыку, которая автоматически синхронизируется с происходящим на экране. В компании считают, что сочетание голоса и музыки делает сгенерированный контент более реалистичным и кинематографичным. Серьёзные изменения коснулись и логики взаимодействия с нейросетью. Grok Imagine 1.0 научился обрабатывать уточняющие запросы, что позволит корректировать детали сцены и дорабатывать результат без необходимости начинать генерацию с нуля, как это было раньше. За последние 30 дней платформа уже сгенерировала более одного миллиарда видео и популярность сервиса не уменьшается. Также сообщается, что API-модель показывает сильные результаты в бенчмарках Artificial Analysis, измерящих качество контента, созданного искусственным интеллектом Grok. Firefly без ограничений: Adobe сняла лимиты на ИИ-генерацию изображений и видео, но не навсегда

02.02.2026 [19:35],

Сергей Сурабекянц

Adobe предоставит подписчикам своего ИИ-сервиса Firefly неограниченное количество генераций изображений и видео как с использованием собственных, так и поддерживаемых сторонних моделей ИИ. Ежемесячные кредиты на генерацию изображений и видео будут отменены для новых подписчиков, которые зарегистрируются в системе до 16 марта.

Источник изображения: Adobe Firefly — это набор генеративных моделей Adobe для создания изображений и видео. В него входят как собственные модели Adobe, так и интеграции со сторонними сервисами, такими как Google Nano Banana Pro, OpenAI GPT-Image 1.5 и Runway Gen-4. После первоначального запуска Firefly в составе пакета приложений Creative Cloud, Adobe выпустила Firefly как отдельную платформу, доступную в браузере или через специальные приложения на мобильных платформах. Подписчики Adobe Firefly могут выбрать один из нескольких тарифных планов. До сих пор одним из ключевых отличий было количество кредитов на создание изображений, включённых в каждый тарифный план. Но с сегодняшнего дня Adobe предлагает при оформлении подписки генерацию неограниченного количества изображений и видео. Важно отметить, что предложение действительно только для отдельной подписки Adobe Firefly, а не для подписок Creative Cloud. «Зарегистрируйтесь до 16 марта и получите неограниченное количество поколений изображений и видео Firefly с разрешением до 2K в приложении Adobe Firefly. Предложение распространяется на клиентов, использующих тарифные планы Firefly Pro, Firefly Premium, а также планы на 4000, 7000 и 50 000 кредитов, и включает неограниченное количество генераций с использованием ведущих в отрасли моделей изображений, включая Google Nano Banana Pro, GPT Image Generation, Runway Gen-4 Image, а также коммерчески безопасные модели изображений и видео Firefly от Adobe», — заявила Adobe. По данным Adobe, 86 % создателей контента теперь используют ИИ в своей повседневной работе. Кроме того, за последний год длина их запросов удвоилась. Это свидетельствует о том, что создатели контента всё чаще используют ИИ как часть своих рабочих процессов. Компания отмечает, что сегодняшний шаг направлен на то, чтобы помочь создателям оставаться в творческом потоке, проходя через процесс проб и ошибок, не беспокоясь о своих кредитах на создание изображений. Adobe также сообщила, что в преддверии Дня святого Валентина и Лунного Нового года пользователи по всему миру получат возможность использовать собственные модели, а также интеграцию Firefly со сторонними сервисами, чтобы протестировать платформу. В «Google Фото» теперь можно описать превращение фото в видео

27.01.2026 [17:51],

Павел Котов

Пользователи сервиса «Google Фото» теперь могут управлять функцией превращения фото в видео при помощи генеративного искусственного интеллекта. Конкретное движение, стиль или эффект, которые хочется увидеть при преобразовании статичных изображений в видео, теперь можно описать простым текстовым запросом.

Источник изображения: Google Текстовые запросы дополняют уже имеющиеся функции «Небольшое движение» и «Мне повезёт» — свободного управления преобразованием в «Google Фото» до настоящего момента не было. Более того, сервис сам готов предложить некоторые варианты запросов, помогая со «вдохновением при создании видео»; для тонкой настройки получаемых роликов запросы можно редактировать. Функция доступна только пользователям от 18 лет. Это возрастное ограничение распространяется только на средство преобразования изображений в видео в «Google Фото»; аналогичная функция уже присутствует в Gemini и работает для пользователей от 13 лет. По умолчанию можно также добавлять аудио и получать на выходе ролик, готовый к публикации в интернете без дополнительного редактирования. Появилось также новое средство выбора изображений «Google Фото» для Gmail — обмен изображениями и роликами из общих и личных альбомов и коллекций стал проще. Можно одновременно выбирать несколько фотографий и видео, а также осуществлять поиск по конкретным фотографиям и названиям альбомов. «ИИ-тикток» от OpenAI стал вирусным после запуска, но интерес к нему быстро остыл — возможно, так и было задумано

18.01.2026 [13:12],

Владимир Мироненко

После запуска в конце сентября 2025 года ИИ-приложение для генерации видео Sora 2 от OpenAI для iOS стало хитом скачиваний, несмотря на то, что для регистрации в нём требовалось приглашение. Всего за четыре дня приложение вышло на первое место в общем рейтинге App Store для iOS, а днём позже преодолело отметку в 1 млн загрузок. Однако затем темпы роста скачиваний начали снижаться.

Источник изображения: sora.chatgpt.com Замысел, лежащий в основе Sora, был довольно разумным, пишет ресурс Sherwood.news: контент, созданный ИИ, призван заменить контент, создаваемый пользователями, который мы видим в своих лентах каждый день. Короткие вертикальные видеоролики в стиле TikTok казались естественным способом выхода OpenAI на рынок контента. Например, на YouTube прошлым летом четыре из десяти самых популярных каналов с наибольшим числом подписчиков состояли исключительно из видеороликов, созданных ИИ, большинство из которых были в формате Shorts. При этом Sora задумывалась не просто как конкурент TikTok — она была разработана для бесшовной интеграции со всеми другими подобными платформами. Видео, созданные с помощью Sora, можно превращать в ролики Reels, Shorts, TikTok, Snap и другие форматы. Каждый репост становился бесплатной рекламой для Sora, даже если просмотры и вовлечённость доставались конкурентам. Приложение Sora не публикует данные о вовлечённости, поэтому о популярности видео, созданных с его помощью, можно судить по кроссплатформенным репостам. Такие аккаунты, как @bestsoravids в Instagram✴✴ и Epic Rankz на YouTube, зафиксировали миллионы просмотров, лайков и комментариев на своих репостах Sora. Однако все их самые успешные публикации пришлись на неделю-две после выхода приложения, на пике его популярности. Так, в первой половине декабря всего 20 видео с хэштегами #sora или #sora2 набрали более 1 млн просмотров на YouTube. Другие популярные аккаунты, занимавшиеся репостами Sora, такие как тот же @bestsoravids, полностью прекратили загрузку видео спустя несколько недель. Также сократилось и число загрузок самого приложения. После первоначального всплеска активности приложение для iOS было загружено за последующие примерно три месяца ещё более 5 млн раз, согласно данным Appfigures. Версия для iOS после выхода в последний день сентября была скачана к концу октября почти 2,7 млн раз. В ноябре общее количество загрузок за месяц составило 1,9 млн, а в декабре — 1,5 млн. Версия Sora для Android стала доступна 4 ноября. В ноябре её скачали 1,4 млн раз, а в декабре — 1,7 млн раз. После того как Sora стала доступна на Android, её ежедневные показатели загрузок в течение недели отставали от TikTok. В декабре приложение TikTok скачали более 18 млн раз по всему миру, а YouTube — 5 млн раз, несмотря на то что это приложение существует уже почти два десятилетия. Как допускает Sherwood.news, запуск Sora вовсе не был попыткой продвижения в социальных сетях, а скорее хитрым рекламным ходом OpenAI, чтобы привлечь партнёров для чего-то большего, чем просто «следующий TikTok». Напомним, что в декабре OpenAI и Disney объявили о партнёрстве, которое обеспечит пользователям Sora эксклюзивный доступ к персонажам Disney. YouTube заваливает новых пользователей сгенерированным ИИ низкокачественным контентом

28.12.2025 [16:48],

Владимир Фетисов

Занимающаяся видеомонтажом компания Kapwing изучила 15 000 наиболее популярных по всему миру YouTube-каналов, выбирая по 100 самых просматриваемых в каждой стране. В результате было установлено, что 278 из них публикуют исключительно «ИИ-мусор», т.е. низкокачественный контент, созданный с помощью генеративных нейросетей и предназначенный для накрутки просмотров.

Источник изображения: @SuperCatLeague/YouTube В ходе исследования также было установлено, что новым пользователям демонстрируется более 20 % таких видео от общего количества роликов. Суммарно каналы с «ИИ-мусором» накопили свыше 63 млрд просмотров и 221 млн подписчиков, что приносит им около $117 млн дохода ежегодно. Исследователи создали новый аккаунт на YouTube и подсчитали, что 104 из первых 500 рекомендованных видео в ленте были «ИИ-мусором». При этом примерно треть контента составили не только низкокачественные сгенерированные видео, но и другой бессмысленный контент, созданный для монетизации за счёт привлечения внимания пользователей. Это наглядно демонстрирует, насколько быстро крупные платформы оказались в значительной степени заполнены сгенерированным контентом, причём зачастую низкокачественным. Собственный анализ The Guardian показал, что около 10 % самых быстрорастущих каналов на YouTube заполнены «ИИ-мусором», набирающим миллионы просмотров, несмотря на усилия платформы по борьбе с «неаутентичным контентом». Отмечается, что обнаруженные в ходе исследования Kapwing каналы имеют большую аудиторию. К примеру, в Испании 20 млн человек (почти половина населения страны) следят за трендовыми ИИ-каналами, в Египте у ИИ-каналов 18 млн подписчиков, в США — 14,5 млн, а в Бразилии — 13,5 млн. Самый просматриваемый из попавших в исследование тематический YouTube-канал — это Bandar Apna Dost, который базируется в Индии и уже набрал 2,4 млрд просмотров. В нём публикуются видео о приключениях антропоморфной обезьяны и мускулистого человека, смоделированного по образу Халка, который сражается с демонами и путешествует на вертолете из помидоров. По оценке Kapwing, владелец этого канала может зарабатывать до $4,25 млн в год. Сложно оценить, насколько значимы подобные каналы в сравнении с огромным количеством уже существующего на YouTube контента. Платформа не раскрывает информацию о том, сколько просмотров генерируется ежегодно или какая их часть приходится на ИИ-контент. Однако это показывает, что за ИИ-роликами стоит растущая индустрия, представители которой пытаются найти новые способы монетизации контента на крупнейших платформах. «Существуют целые сообщества в Telegram, WhatsApp, Discord и на форумах, где люди обмениваются советами и идеями, продают курсы о том, как создавать «мусор», который будет достаточно вовлекающим, чтобы приносить деньги», — прокомментировал данный вопрос журналист Макс Рид (Max Read), ранее подробно писавший об «ИИ-мусоре». Он также отметил, что в основном созданием такого контента занимаются люди из англоязычных стран, где средняя зарплата ниже того, что они могут заработать на YouTube. По его данным, «ИИ-мусор» создают множество людей из Индии, Кении, Нигерии и др. «Генеративный искусственный интеллект — это инструмент, и, как любой инструмент, его можно использовать для создания как высококачественного, так и низкокачественного контента. Мы по-прежнему стремимся предоставлять нашим пользователям доступ к высококачественному контенту, независимо от того, как он был создан. Весь контент, загружаемый на YouTube, должен соответствовать нашим правилам, и, если мы обнаруживаем, что контент нарушает нашу политику, мы удаляем его», — прокомментировал данный вопрос представитель YouTube. Микки Маус спешит на помощь: Disney должна сделать генератор ИИ-видео OpenAI Sora популярным

15.12.2025 [07:21],

Алексей Разин

Прошлая неделя характеризовалась важным событием для сферы правовых отношений на рынке ИИ: компании Disney и OpenAI заключили соглашение, которое позволит последней использовать более 200 персонажей первой в своём сервисе генерации видео по запросу Sora. Эксперты считают, что сделка призвана поднять популярность этого сервиса, который пока заметно уступает конкурентам по степени вовлечённости пользователей.

Источник изображения: Disney Plus Как поясняет Financial Times, первичный успех Sora после выхода обособленного приложения не гарантировал сервису устойчивого роста пользовательской аудитории. Лишь около 25 % из семи миллионов человек, которые используют Sora на ежемесячной основе, по оценкам Sensor Tower, тратят в приложении не более 13 минут в среднем каждый день. Для сравнения, у TikTok этот показатель достигает 90 минут в день, а YouTube чуть уступает китайской социальной сети. Некоторые источники считают, что пользователей Sora отталкивает огромное количество видеоконтента посредственного качества. Сделка с Disney должна позволить привлечь создателей контента, которые готовы использовать образы знакомых персонажей на регулярной основе. К слову, в условиях соглашения между OpenAI и Disney есть некоторые нюансы. В частности, внешность конкретных исполнителей роли того или иного персонажа, а также его голос, пользователи Sora воспроизводить при помощи сервиса не имеют права. Например, можно воссоздать анимированный образ Хана Соло, но использовать для этого внешность Харрисона Форда (Harrison Ford), который с ним ассоциируется, будет нельзя. Потенциальные правовые риски, которые OpenAI попыталась минимизировать благодаря сделке с Disney, не являются единственной проблемой, с которой сталкивается Sora. На генерацию 10-секундного ролика, как считается, OpenAI тратит около $1,3. При этом текстовый запрос в ChatGPT обходится в среднем в половину цента, поэтому содержать сервис по генерации видео очень затратно. OpenAI ограничила качество видео в целях экономии, а также количество бесплатно генерируемых роликов для одного пользователя. Кроме того, недавно объявленная главой OpenAI Сэмом Альтманом (Sam Altman) всеобщая мобилизация ресурсов компании на совершенствовании ChatGPT подразумевает, что на развитие Sora будет тратиться меньше средств. При этом нельзя сказать, что сделка с Disney потребовала от OpenAI каких-то реальных затрат. По недоброй традиции, условно передаваемый Disney миллиард долларов должен вернуться OpenAI в обмен на услуги для второго участника сделки и в форме акций, которые достанутся Disney. Последняя уже предъявила претензии к Google и её сервису генерации видео Veo, а также видеохостингу YouTube. Статистика успеха подобных исков не столь однозначна. С одной стороны, Anthropic недавно согласилась выплатить авторам, чьи интересы затрагивала своей деятельностью, около $1,5 млрд. С другой стороны, иски к Meta✴✴ и Stability не были удовлетворены судом. Определить сумму ущерба накопленным итогом всегда достаточно сложно, но заключаемые с генераторами видео сделки правообладателей обычно учитывают как ретроспективу, так и будущее использование интеллектуальной собственности. OpenAI урезала лимиты на генерацию контента с помощью Sora — Google так же поступила с Nano Banana Pro

28.11.2025 [21:06],

Владимир Фетисов

Пользователям, которые хотели немного развлечься, генерируя медиаконтент с помощью передовых моделей искусственного интеллекта Google и OpenAI, придётся быть более экономными. Обе компании снизили лимиты на количество запросов к алгоритмам Nano Banana Pro и Sora, сославшись на огромный спрос и существенно возросшую нагрузку на сопутствующую инфраструктуру.

Источник изображения: Steve Johnson / Unsplash Глава подразделения разработчиков ИИ-генератора Sora в OpenAI Билл Пиблс (Bill Peebles) объявил, что пользователи, взаимодействующие с нейросетью бесплатно, теперь смогут создавать не более шести видео в день. «Наши графические ускорители плавятся», — добавил он. Любопытно, что в отличие от предыдущих ограничений, Пиблс не упомянул, что снижение лимитов на бесплатную генерацию видео носит временный характер. Однако он отметил, что пользователи будут иметь возможность платного расширения лимита в случае такой необходимости. Вероятно, продиктованный возросшей нагрузкой шаг также является частью более широкой стратегии OpenAI по монетизации ИИ-генератора видео Sora. При этом лимиты для подписчиков ChatGPT Plus и ChatGPT Pro не изменились. Параллельно с этим Google ограничила бесплатных пользователей платформы Nano Banana Pro возможностью генерировать всего два изображения в день. Ранее сервис позволял создавать бесплатно ежедневно до трёх картинок. Компания предупредила пользователей, что лимиты могут часто меняться даже «без предварительного уведомления», что является стандартной практикой для популярных платформ. Вместе с этим Google, по всей видимости, ограничивает бесплатный доступ к передовой ИИ-модели Gemini 3 Pro. Голливудские агентства резко раскритиковали ИИ-генератор видео OpenAI Sora

10.10.2025 [11:45],

Владимир Фетисов

Агентство Creative Artist Agency присоединилось к тем, кто выступил с критикой в адрес OpenAI и её приложения для генерации видео Sora из-за нарушения авторских прав. В заявлении организации сказано, что упомянутый сервис представляет значительные риски для клиентов агентства и принадлежащей ему интеллектуальной собственности.

Источник изображения: OpenAI Creative Artist Agency, представляющее интересы большого количества звёздных актёров, таких как Скарлетт Йоханссон (Scarlett Johansson) и Том Хэнкс (Tom Hanks), поставило под сомнение, считает ли OpenAI, что «люди, писатели, художники, актёры, режиссёры, продюсеры, музыканты и спортсмены заслуживают вознаграждения и упоминания за работу, которую они делают». «Или OpenAI считает, что может просто украсть контент, пренебрегая глобальными принципами авторского права и нагло игнорируя права создателей, а также многих людей и компаний, которые финансируют производство, создание и публикацию работы этих людей? На наш взгляд, ответ на этот вопрос очевиден», — говорится в заявлении агентства. Вместе с этим в Creative Artist Agency заявили, что агентство открыто для предложений OpenAI, направленных на решение возникшей проблемы, продолжая взаимодействовать с лидерами в области интеллектуальной собственности, профсоюзами, законодателями и политиками. «Контроль, разрешение на использование и компенсация являются фундаментальными правами этих работников. Всё, что не подразумевает защиту создателей и их прав, неприемлемо», — сказано в заявлении агентства. На прошлой неделе OpenAI выпустила приложение для генерации видео Sora, которое доступно для устройств на базе iOS с некоторыми ограничениями. Несмотря на это, всего за несколько дней ИИ-генератор скачали более 1 млн раз, благодаря чему он возглавил рейтинг App Store. Приложение позволяет генерировать на основе текстового описания короткие ролики, в том числе с участием персонажей, защищённых законодательством об авторском праве, что и стало причиной бурной реакции со стороны компаний, чья интеллектуальная собственность незаконно используется в Sora. United Talent Agency также раскритиковало приложение OpenAI, заявив, что использование сервисом защищённого авторским правом контента является эксплуатацией, а не инновацией. «В нашем бизнесе нет замены человеческому таланту, и мы будем продолжать бороться за наших клиентов, чтобы обеспечить их защиту. Когда речь идёт о Sora от OpenAI или любой другой платформе, которая стремится извлечь выгоду из интеллектуальной собственности и имиджа наших клиентов, мы солидарны с авторами», — сказано в заявлении агентства. Ранее OpenAI заявила, что ввела ряд защитных мер, которые должны предотвратить возможность генерации роликов с защищёнными авторским правом персонажами. В дополнение к этому компания проводит проверку уже созданных в Sora видео на предмет поиска материалов, которые не соответствует обновлённой политике OpenAI. «Мы удаляем сгенерированных персонажей из публичной ленты Sora и готовим обновления, которые предоставят правообладателям больше контроля над их персонажами и тем, как поклонники могут их использовать», — сообщил представитель OpenAI. Другие представители киноиндустрии также выразили недовольство тем, что сервис Sora использует контент, защищённый авторским правом. В их число входят агентство по подбору персонала WME, Disney и др. Приложение OpenAI Sora скачали 1 млн раз менее чем за пять дней

09.10.2025 [20:19],

Владимир Фетисов

Выпушенное недавно приложение OpenAI Sora для ИИ-генерации видео скачали более 1 млн раз менее чем за пять дней. Об этом в своём аккаунте в социальной сети X написал руководитель команды Sora Билл Пиблз (Bill Peebles). Он отметил, что ИИ-генератор добился такого успеха даже быстрее ChatGPT, популярного ИИ-бота OpenAI, которым в настоящее время еженедельно пользуются более 800 млн человек по всему миру.

Источник изображения: OpenAI Ещё более впечатляющим достижение Sora делает то, что приложение доступно только на устройствах с операционной системой Apple iOS и для его загрузки требуется получить приглашение. Это означает, что для скачивания Sora нужно получить специальный код. Несмотря на эти ограничения, ИИ-генератор сумел занять первое место в рейтинге магазина цифрового контента Apple App Store. «Команда усердно работает, чтобы не отстать от стремительного роста», — написал Пиблз в одном из недавних постов в соцсети X. Запуск Sora сопровождался бурной реакцией со стороны общественности, в том числе в плане обсуждения того, что алгоритм может нарушать авторские права. На платформе можно найти множество роликов с защищёнными авторским правом персонажами, например, из мультфильмов «Губка Боб квадратные штаны», «Рик и Морти» и «Южный парк». Более того, пользователи могут сами генерировать подобные ролики. Ассоциация кинокомпаний, представляющая интересы телевизионной, кино- и видеоиндустрии заявила, что «ролики, нарушающие права на фильмы, шоу и персонажей членов ассоциации широко распространены на платформе OpenAI». Гендиректор Ассоциации кинокомпаний Чарльз Ривкин (Charles Rivkin) заявил, что «OpenAI должна предпринять незамедлительные и решительные действия для решения этой проблемы». Он добавил, что действующее законодательство об авторском праве защищает права авторов и вполне применимо в данном случае. Генеральный директор OpenAI Сэм Альтман (Sam Altman) заявил, что компания в скором времени предоставит правообладателям больше возможностей в плане контроля контента, защищённого авторским правом. Об этом он написал в блоге компании в конце прошлой недели. Tencent выпустила открытую ИИ-модель, которая создаёт целые 3D-миры по одному изображению

07.09.2025 [12:29],

Владимир Фетисов

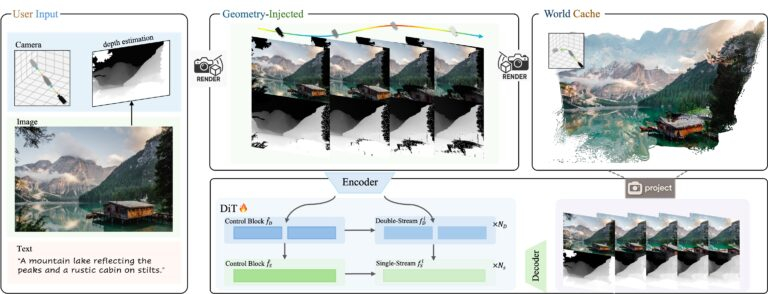

На этой неделе китайская компания Tencent представила новую ИИ-модель с открытым исходным кодом HunyuanWorld-Voyager. С её помощью можно генерировать 3D-видеоряд из одного исходного изображения, управляя траекторией камеры для «изучения» виртуальных сцен. Алгоритм одновременно генерирует видео в формате RGB и информацию о глубине (RGB-D), что позволяет осуществлять 3D-реконструкцию без использования традиционных методов моделирования.

Источник изображений: Tencent На самом деле результаты работы HunyuanWorld-Voyager не являются настоящими 3D-моделями, но создаётся аналогичный эффект. ИИ-алгоритм генерирует 2D-видеокадры, которые сохраняют пространственную согласованность, как если бы камера перемещалась в реальном 3D-пространстве. В каждой генерации создаётся всего 49 кадров, т.е. примерно две секунды видео. По данным Tencent, несколько клипов могут быть объединены в последовательности продолжительностью «несколько минут». Объекты сохраняют своё положение, когда камера перемещается вокруг них, перспектива изменяется корректно, как если бы это происходило в реальной 3D-среде. Хотя результатом работы является видео с картами глубины, а не полноценные 3D-модели, эти данные можно преобразовывать в 3D-облака точек для дальнейшей реконструкции. Система работает на основе одного исходного изображения и заданной пользователем траектории камеры. Можно задать движение камеры вперёд, назад, влево, вправо или поворот, для чего предусмотрен интерфейс управления. Система объединяет данные об изображении и глубине с другими данными для формирования видеоряда, отражающего движение камеры, которое задал пользователь. Основным ограничением всех ИИ-моделей на базе архитектуры Transformer является то, что они в основном имитируют паттерны, найденные в данных для обучения, что ограничивает их возможности в плане «обобщения», т.е. применения этих шаблонов в новых ситуациях, которые не встречались при обучении. Для обучения HunyuanWorld-Voyager исследователи задействовали более 100 тыс. видеоклипов, включая компьютерные сцены на движке Unreal Engine. По сути они обучали ИИ-алгоритм имитировать движение 3D-камер в среде видеоигр. Большинство ИИ-генераторов, таких как Sora, создают выглядящие правдоподобно кадры друг за другом, не пытаясь отслеживать или поддерживать пространственную согласованность. В отличие от этого HunyuanWorld-Voyager обучен распознавать и воспроизводить закономерности пространственной согласованности, но с добавлением обратной геометрической связи. Когда он генерирует каждый кадр, осуществляется преобразование выходных данных в точечный 3D-объект, после чего эти точки проецируются обратно в 2D для использования в будущих кадрах. Такой подход заставляет ИИ-модель сопоставлять изученные ранее шаблоны с геометрически согласованными проекциями, полученными в процессе работы. Это обеспечивает гораздо лучшую пространственную согласованность, чем у других ИИ-генераторов видео. Однако в основе подхода всё же лежит сопоставление паттернов, основанное на геометрических ограничениях, а не полноценное «понимание» 3D. Это объясняет, почему ИИ-модель может сохранять согласованность в течение нескольких минут, но с трудом справляется с поворот сцены на 360°. Ошибки при сопоставлении с образцом накапливаются на протяжении многих кадров до тех пор, пока геометрические ограничения уже не могут поддерживать согласованность. По данным Tencent, HunyuanWorld-Voyager использует в работе два основных блока, работающих совместно. Во-первых, система генерирует цветное видео и информацию о глубине одновременно, чтобы убедиться, что они идеально совпадают. Во-вторых, используется то, что Tencent называет «глобальным кэшем» — растущая коллекция точечных 3D-моделей, созданных из ранее сгенерированных кадров. В процессе генерации новых кадров это облако 3D-точек проецируется обратно в 2D с нового ракурса камеры для создания изображений, показывающих то, что должно быть видно на основе предыдущих кадров. Затем модель использует эти проекции для проверки согласованности, обеспечивая соответствие новых кадров уже сгенерированным.  HunyuanWorld-Voyager развивает идеи более ранней ИИ-модели Tencent HunyuanWorld 1.0, которая была выпущена в июле. Алгоритм также является частью более масштабной экосистемы Tencent Hunyuan, которая также включает в себя алгоритмы Hunyuan3D-2 для генерации 3D-объектов по текстовому описанию и HunyuanVideo для генерации видео. Для обеспечения работоспособности HunyuanWorld-Voyager требуются значительные вычислительные мощности. Tencent рекомендует использовать не менее 60 Гбайт видеопамяти для получения 3D-сцен с разрешением 540p или 80 Гбайт видеопамяти для повышения качества картинки. Получить доступ к исходному коду ИИ-модели и сопутствующей документации можно на портале Hugging Face. Как и другие ИИ-модели семейства Hunyuan, новый алгоритм поставляется с существенными лицензионными ограничениями. К примеру, лицензия запрещает использовать HunyuanWorld-Voyager в ЕС, Великобритании и Южной Корее. Отдельного лицензирования требует коммерческое использование, предполагающее обслуживание более 100 млн пользователей в месяц. Google открыла бесплатный доступ к генератору видео Veo 3, но только на эти выходные

23.08.2025 [16:39],

Владимир Мироненко

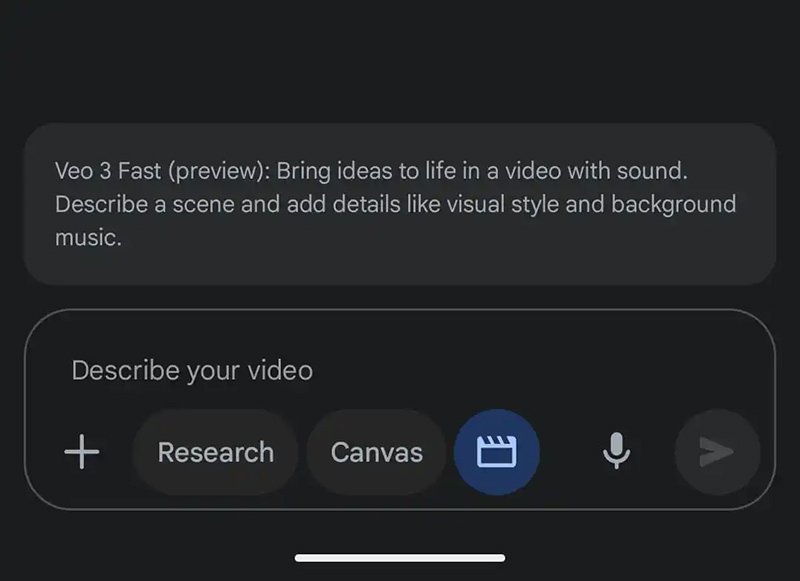

В эти выходные чат-бот на основе искусственного интеллекта Google Gemini предоставит пользователям бесплатного приложения возможность опробовать версию новейшей модели генерации видео Google Veo 3, анонсированной в мае. С её помощью можно создавать на основе запросов 8-секундные клипы со звуком. Отметим для россиян, что эта услуга доступна только с зарубежного IP-адреса.

Источник изображения: 9to5google С июля платные подписчики Google AI Pro по всему миру могут создавать три видео в день с помощью более дешёвой, чем Veo 3, модели Veo 3 Fast, которая генерирует видео в два раза быстрее с разрешением 720p. При этом владельцы подписки Google AI Ultra имеют расширенный доступ к полной версии. Им также доступна функция преобразования фото в видео. Однако в рамках акции с текущего момента до 22:00 по тихоокеанскому времени воскресенья (понедельник, 9:00 мск) пользователи бесплатной версии Gemini смогут создать три видео с помощью модели Veo 3 Fast. Глава ИИ-сервиса Gemini Джош Вудворд (Josh Woodward) сообщил в четверг в соцсети X, что Google «настраивает массу TPU» перед пробным периодом, чтобы справиться с ожидаемым ростом запросов. При открытии приложения Gemini можно увидеть сообщение об акции. Если его нет, необходимо нажать на указатель с тремя точками на панели подсказок, чтобы открыть новый элемент «Видео: Генерация с Veo». Запрос пользователя должен «описывать сцену с добавленными деталями, такими как визуальный стиль и фоновая музыка». Можно также указать в описании диалоги и фоновый шум. Создание займёт несколько минут, после чего пользователи смогут скачать клип с водяным знаком (значок Veo в правом нижнем углу) или получить ссылку для общего доступа. Universal Pictures пригрозила ИИ-компаниям судом за незаконное использование фильмов студии для обучения нейросетей

07.08.2025 [07:56],

Владимир Фетисов

Одна из старейших голливудских киностудий Universal Pictures становится всё более агрессивной в защите своих фильмов от компаний, занимающихся разработкой генеративных нейросетей. В стремлении защитить свои фильмы от незаконного их использования для обучения нейросетей компания выбрала новый подход.

Источник изображения: Julien Tromeur / Unsplash В июне этого года киностудия добавила в финальные титры фильма «Как приручить дракона» информацию о том, что незаконное использование этого контента грозит нарушителям судебными разбирательствами. Позднее аналогичные предупреждения появились в титрах фильмов «Мир юрского периода: Возрождение» и «Плохие парни 2». «Этот фильм защищён законами США и других стран. Несанкционированное копирование, распространение или демонстрация повлекут за собой гражданскую ответственность и уголовное преследование», — говорится в сообщении Universal Pictures. В компании считают, что добавление в титры такой формулировки создаст дополнительный уровень защиты от кражи кинофильмов с целью сбора данных для обучения ИИ-моделей. В некоторых странах в предупреждении компании упоминается вступивший в силу в Евросоюзе в 2019 году закон об авторском праве. Этот закон позволяет авторам контента отказаться от использования их материалов в научных целях. Быстрое развитие генеративных нейросетей несёт опасность для киноиндустрии, поскольку легко представить себе будущее, в котором многие зрители откажутся от просмотра традиционных фильмов в пользу того, что генерируют нейросети. При этом такие алгоритмы обычно обучаются на принадлежащей киностудиям интеллектуальной собственности. В настоящее время нейросети преимущественно задействованы для оптимизации отдельных процессов кинопроизводства, но уже сейчас есть игроки, которые верят в то, что будущее киноиндустрии за искусственным интеллектом. Например, в конце прошлого месяца студия Fable Studios Эдварда Саатчи (Edward Saatchi) объявила о получении неназванного объёма инвестиций от Amazon на создание платформы, которая позволит пользователям генерировать эпизоды шоу по простому текстовому описанию. У компании большие амбиции в этом направлении, она планирует выпустить в прокат свой первый сгенерированный ИИ полнометражный фильм в 2026 году. YouTube добавил ИИ-инструменты для создания роликов Shorts из фото или текста

23.07.2025 [22:02],

Николай Хижняк

Платформа YouTube начала внедрение инструментов на базе генеративного ИИ для упрощения процесса создания коротких вертикальных видео Shorts. Новые функции позволяют, например, преобразовывать фотографии в видео, а также предлагают целый арсенал видеоэффектов на базе ИИ. Кроме того, платформа представила инструмент генерации видео по подсказкам — AI Playground.

Источник изображения: Christian Wiediger/unsplash.com Google представила три основные функции на базе ИИ для создателей Shorts. Одна из них позволяет превращать фото в видео — для создания клипа достаточно одного статичного изображения. Хотя Google не уточняет ограничения по длине таких роликов, вероятно, они будут довольно короткими. В инструментах редактирования Shorts также появились два новых ИИ-эффекта. Их можно выбрать перед началом записи. Первый — эффект «погружения в воду»: ИИ генерирует промежуточные кадры между реальными, создавая иллюзию, будто объект на видео погружается под воду. С примером этого эффекта можно ознакомиться ниже. Также в разделе эффектов появилась функция, позволяющая сделать грубый набросок прямо на экране смартфона, который затем будет преобразован в более красочное и проработанное изображение. Новые инструменты GenAI включают и платформу AI Playground — полноценную среду для генерации контента, а не просто наложения эффектов на видео и изображения. AI Playground позволяет создавать видео, изображения и музыку на основе текстовых описаний или готовых примеров. Получившийся контент можно публиковать в YouTube Shorts; он будет помечаться как созданный с использованием ИИ. По словам Google, развёртывание новых функций займёт несколько недель. На первом этапе они станут доступны пользователям в США, Канаде, Австралии и Новой Зеландии. В перспективе ожидается расширение географии их поддержки. Инструменты GenAI, представленные YouTube для Shorts, основаны на модели ИИ Veo 2. В будущем они будут переведены на новую модель Veo 3. Правда, сроки запуска пока не определены. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |