|

Опрос

|

реклама

Быстрый переход

DuckDuckGo добавила голосовое общение с ИИ-ботом Duck.ai с защитой приватности

10.02.2026 [20:38],

Владимир Фетисов

Компания DuckDuckGo объявила о добавлении функции голосового чата в Duck.ai — своего фирменного чат-бота на базе искусственного интеллекта с защитой приватности пользователей. Благодаря этому можно в режиме онлайн голосом общаться с чат-ботом, задействовав для этого защищённое соединение.

Источник изображения: DuckDuckGo ИИ-модели для обработки голосовых запросов в Duck.ai предоставляет OpenAI. Однако DuckDuckGo заявила, что ни она, ни OpenAI не будут хранить аудиозаписи после завершения беседы. «Голосовые чаты в Duck.ai приватны, мы делаем их анонимными, и они никогда не используются для обучения ИИ-моделей», — сказано в заявлении компании. Новые контрактные обязательства указывают на то, что возможности OpenAI в плане использования аудиозаписей пользователей голосовых чатов с ИИ-ботом также строго ограничены. В описании новой функции сказано, что DuckDuckGo защищает аудиоданные несколькими способами, чтобы гарантировать, что доступ к ним имеет только OpenAI (как поставщик ИИ-моделей) и только с целью ответа на запросы пользователей. Прежде всего отмечается, что голосовые запросы передаются потоками только во время сеанса общения с ботом и не хранятся у DuckDuckGo или OpenAI после завершения диалога. Аудиозаписи пользователей и ответы чат-бота не используются для обучения ИИ-моделей. Аудиопотоки шифруются при передаче через WebRTC и прохождении через сервер компании, при этом ни DuckDuckGo, ни OpenAI не сохраняют каких-либо данных о разговорах — вся информация удаляется сразу после завершения беседы. Новая функция работает во многих браузерах, кроме Firefox — поддержка этого интернет-обозревателя находится на стадии разработки. Голосовой чат с ИИ-ботом является бесплатной функцией в пределах суточного лимита и не требует создания аккаунта. В то же время платным подписчикам за $10 в месяц будут доступны расширенные лимиты, доступ к VPN DuckDuckGo, услуге удаления личных данных и прочее. Пользователи могут в любой момент отключить функцию голосового чата в настройках Duck.ai, а также продолжать взаимодействовать с текстовыми ботами на основе ИИ-моделей OpenAI, Meta✴✴, Anthropic и Mistral. Голосовой помощник Gemini стал лучше понимать инструкции и не перебивает пользователей

13.12.2025 [07:38],

Анжелла Марина

Google объявила о внедрении серии улучшений в голосовом помощнике Gemini, которые сделают взаимодействие с искусственным интеллектом более естественным и эффективным. Целью доработок является повышение способности модели справляться со сложными задачами, точно следовать инструкциям пользователя и вести связные диалоги.

Источник изображения: Google В рамках обновления инженеры Google сфокусировались на трёх ключевых направлениях в Gemini 2.5 Flash Native Audio. Во-первых, была повышена надёжность вызова внешних функций и теперь Gemini точнее определяет момент, когда необходимо получить актуальную информацию в ходе диалога, интегрируя её в аудиоответ без нарушения естественного темпа беседы. Во-вторых, модель продемонстрировала рост уровня соблюдения инструкций разработчиков с 84 до 90 %, что позволяет ей лучше справляться со сложными командами и выдавать более последовательные результаты. Также улучшена способность извлекать контекст из предыдущих частей разговора, способствуя формированию более связных и логичных диалогов, сообщает Android Authority. Кроме того, Джош Вудворд (Josh Woodward), вице-президент подразделения Google Labs, отвечающего за Gemini и AI Studio, сообщил о двух дополнительных усовершенствованиях. Теперь функция Gemini Live не будет прерывать пользователя, даже если тот делает длительную паузу в речи. Также появилась возможность отключать микрофон во время ответа ИИ, чтобы случайно не прервать его речь. Параллельно с этим Google объявила об изменениях в приложении Translate. ByteDance выпустила голосового ИИ-помощника для китайских смартфонов

02.12.2025 [10:05],

Владимир Мироненко

Китайская компания ByteDance, разработчик видеосервиса TikTok, сообщила о выпуске голосового помощника на базе большой языковой модели Doubao собственной разработки. Он входит в предустановленное программное обеспечение смартфона Nubia M153 компании ZTE и в дальнейшем станет доступен и на смартфонах других производителей, пишет Reuters.

Источник изображения: Kelli McClintock/unsplash.com ИИ-помощник от ByteDance позволяет пользователям управлять смартфоном с помощью голосовых команд, например, находить контент и бронировать билеты. Он будет конкурировать с аналогичными умными ассистентами, представленными китайскими производителями смартфонов, такими как Huawei и Xiaomi. Компания ByteDance заявила, что у неё нет планов разрабатывать собственные смартфоны, и сейчас она ведёт переговоры с несколькими производителями телефонов об использовании её ИИ-помощника на выпускаемых ими устройствах. ByteDance стала лидером на рынке потребительских ИИ-приложений в Китае благодаря выпуску ИИ-чат-бота Doubao. Doubao — самый популярный чат-бот с искусственным интеллектом в Китае. По данным платформы отслеживания ИИ-приложений Aicpb.com, в октябре у Doubao было 159 млн активных пользователей в месяц, что значительно больше, чем у Tencent Yuanbao с 73 млн пользователей и DeepSeek с 72 млн человек. Установленный на телефоне, Doubao работает на уровне операционной системы, позволяя ИИ видеть, что происходит на экране, и использовать приложения, выполняя такие задачи, как извлечение и упорядочивание файлов, заполнение веб-форм, поиск предложений ресторанов, соответствующих бюджету и предпочтениям пользователя. Голосовой режим ChatGPT встроили в чат — он стал естественнее и его можно перебивать

26.11.2025 [00:09],

Николай Хижняк

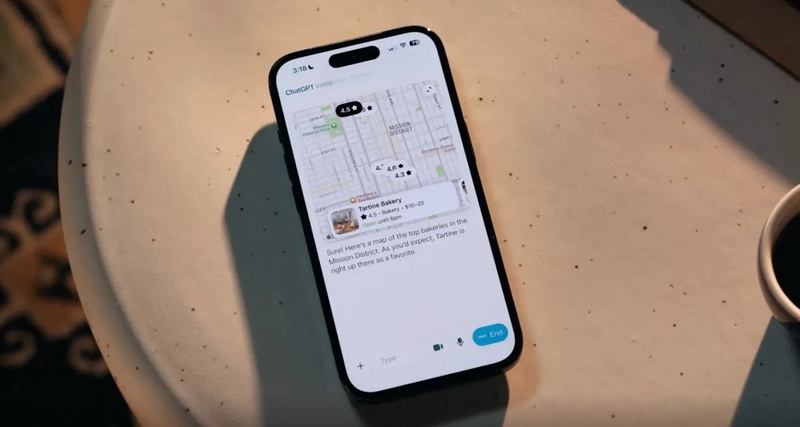

Разработчики из OpenAI значительно улучшили голосовой режим чат-бота ChatGPT. Теперь он ещё больше похож на естественное общение с человеком. В последнем обновлении ChatGPT голосовой режим по умолчанию объединён с основным текстовым режимом. Но при желании его можно отделить.

Источник изображения: OpenAI OpenAI продемонстрировала некоторые преимущества нового голосового режима на своей странице в соцсети X. Например, ChatGPT теперь может показывать результаты поиска по карте в голосовом режиме. Он также отображает расшифровку голосового диалога в интерфейсе чата. В процессе ответа чат-бота на запрос его можно перебить, чтобы попросить, например, правильно произнести по буквам название нужного вам места или блюда в ресторане. При желании можно вернуться к старому варианту взаимодействия с голосовым режимом. В настройках приложения появился новый переключатель для возврата в отдельный режим. «Теперь вы можете использовать голосовой режим ChatGPT прямо в чате — отдельный режим не нужен. Вы можете разговаривать, наблюдать за появлением ответов, просматривать предыдущие сообщения и видеть визуальные элементы, такие как изображения или карты, в режиме реального времени. Доступно для всех пользователей мобильных устройств и веб-версии. Просто обновите приложение», — сообщили разработчики. Клавиатура перестанет быть главным инструментом создания контента уже к 2028 году

11.11.2025 [08:40],

Алексей Разин

Лондонская школа экономики при участии компании Jabra провела исследование, согласно результатам которого ввод информации при помощи голосового интерфейса ИИ станет общепринятым стандартом. Родившиеся после 2010 года офисные сотрудники в недалёком будущем в своей деятельности могут вообще не столкнуться с необходимостью набора текста руками.

Источник изображения: Unsplash, Glenn Carstens-Peters По мнению представителей Jabra, ввод информации голосом отодвинет на второй план работу с клавиатурой. Она будет нужна только для редактирования первично введённого голосом текста. Преобразование речи в текст позволяет быстрее вводить информацию и делает этот процесс более естественным. При этом руки пользователя остаются свободными, он буквально может генерировать текст, передвигаясь в машине или занимаясь домашними делами. Впрочем, у такого подхода имеются и свои недостатки. Обратное восприятие информации делает текст более удобным. Чтение в целом занимает меньше времени, чем прослушивание речевого сообщения, а ещё с текстовыми данными гораздо проще работать с точки зрения анализа, обобщения и структурирования информации. Поиск по ключевым словам в тексте занимает секунды, а перематывание аудиозаписей превращается в пытку. По мнению учёных, ввод текста будет осуществляться голосом, но те же электронные сообщения останутся текстовыми. Кроме того, авторы текстовых заметок обычно более ответственно подходят к их содержанию, тогда как голосовые сообщения буквально размывают суть информации и её структуру. При большом наборе голосовых сообщений сложно определить, что именно и кем было сказано, а также привязать эти данные к шкале времени. Спустя несколько месяцев проще анализировать текстовую переписку, чем рыться в голосовых сообщениях. Не нужно также забывать, что живая речь по своей природе у большинства людей далека от совершенства. Интонации, дефекты речи и влияние акцента — всё это затрудняет голосовой ввод. Более того, лёгкость записи голосовых сообщений увеличивает количество передаваемой информации. Авторы высказываний порой не будут задумываться о ценности и сути своих комментариев, и собеседникам будет сложнее ориентироваться в этом потоке сознания, выделяя саму суть. Во Франции запустили расследование возможной прослушки пользователей Apple через Siri

06.10.2025 [18:42],

Владимир Мироненко

Во Франции начали уголовное расследование деятельности Apple, которую обвинили в использовании подрядчиков для прослушивания голосовых записей взаимодействия пользователей с Siri, несмотря на обещание соблюдать конфиденциальность, пишет агентство Bloomberg. Расследование началось после заявления правозащитной организации Ligue des droits de l’Homme.

Источник изображения: Apple Жалоба правозащитной организации основана на показаниях Томаса ле Боньека (Thomas le Bonniec), бывшего субподрядчика Apple в Ирландии, который публично заявлял о проведении анализа конфиденциальных записей пользователей, в том числе онкологических больных. О том, что сторонние подрядчики Apple прослушивали аудиозаписи взаимодействия с Siri для анализа с целью повышения качества сервиса, сообщил в 2019 году ресурс The Guardian. Источником ресурса был подрядчик, который занимался «оценкой» Siri. Информатор тогда сообщил, что «подрядчики Apple регулярно прослушивают конфиденциальную медицинскую информацию» в рамках своей работы «по контролю качества» голосового помощника Siri. В ответ Apple приостановила программу, предоставив клиентам возможность отказаться от использования этой опции. Затем компания стала добавлять опцию только в случае явного согласия пользователя, а не его отказа. Тем не менее после этого был подан коллективный иск, и Apple согласилась выплатить компенсацию пользователям. В январе Apple заявила в блоге, что «не сохраняет аудиозаписи взаимодействия с Siri, если только пользователи явно не соглашаются на это, чтобы помочь улучшить Siri, и даже в этом случае записи используются исключительно для этой цели». Казалось бы, инцидент исчерпан, и остаётся неясным, почему спустя столько лет после происшествия во Франции решили вернуться к былому нарушению Apple. Karri Messenger позволит детям безопасно общаться с родителями и друзьями при помощи голосовых сообщений

05.09.2025 [20:27],

Сергей Сурабекянц

Устройство Messenger от лондонской компании Karri призвано помочь детям в возрасте от 5 до 13 лет стать более самостоятельными, обеспечивая при этом спокойствие их родителям. Главная функция новинки — запись, отправка и приём голосовых сообщений. Messenger использует SIM-карту, предназначенную только для передачи данных, и не имеет номера телефона. Устройство отличается минималистичным интерфейсом и интуитивно понятным управлением.

Источник изображений: Karri Это уже второе поколение подобных устройств — первое было выпущено в 2023 году. Messenger оснащён матричным дисплеем, динамиком, а его основной элемент управления — крупный физический слайдер в центре. Чтобы прослушать голосовое сообщение нужно сдвинуть его вниз, для записи сообщения — сдвинуть вверх и удерживать, для отправки — просто сдвинуть вверх.

В октябре 2024 года компания Karri привлекла несколько миллионов фунтов стерлингов на разработку новой модели, в которой принимало участие известное дизайнерское агентство Pentagram. Нескольких итераций прототипов дорабатывались в процессе тестирования с участниками из разных возрастных групп.  Messenger работает только с сопряжённым мобильным приложением на телефоне родителей, а это значит, что посторонние не смогут связаться с ребёнком. Приложение для iOS и Android позволяет безопасно отправлять зашифрованные голосовые сообщения, проверять уровень заряда батареи Messenger и определять местоположение ребёнка на карте с помощью встроенного GPS-модуля. Родители также могут устанавливать геозоны и получать уведомления, если ребёнок выходит за их пределы. Доступно создание семейных групп для отправки сообщений.

Дополнительные чехлы позволят осуществлять бесконтактные платежи через NFC, а в ближайшем будущем появится голосовое управление, навигация и другие функции. Устройство с защитой от воды IPX67 весит чуть более 120 г и может работать до четырёх дней без подзарядки.  Стоимость Messenger второго поколения составляет £90 (≈9700 ₽), поставки устройства запланированы на конец этого года. По предварительному заказу Messenger можно приобрести за £50 (≈5400 ₽), а цена месячной подписки начинается от £1,79 (≈200 ₽) при заключении двухлетнего контракта, но только в Великобритании. Более дорогие тарифы открывают доступ к сервису по всему миру, большему количеству каналов чата и обмену сообщениями между устройствами. В электромобилях Tesla Model Y L появятся голосовые ассистенты на базе ИИ от DeepSeek и Doubao

22.08.2025 [13:53],

Алексей Разин

Усилия Tesla по поддержанию спроса к своим электромобилям в Китае не ограничиваются выпуском шестиместного кроссовера Model Y L. Компания готова адаптировать возможности фирменного голосового ассистента к потребностям китайских клиентов, взяв на вооружение языковые модели местного происхождения.

Источник изображения: Tesla Как поясняет CnEVPost, бортовая информационно-развлекательная система Tesla Model Y L получит поддержку голосового ассистента на базе моделей DeepSeek и ByteDance Doubao, причём работать это решение будет на облачной платформе Volcano Engine той же ByteDance. Если Doubao будет отвечать за сервисные запросы, связанные с управлением бортовыми системами электромобиля, то DeepSeek реализует полноценный диалог с чат-ботом на самые разные темы. В США, например, голосовой интерфейс Tesla полагается на разработки стартапа xAI, принадлежащего возглавляющему обе компании Илону Маску (Elon Musk). Новейшая Tesla Model Y L позволяет пользователям вызвать голосового ассистента кодовой приветственной фразой, тогда как во всех прочих моделях электромобилей марки для китайского рынка для этого требуется нажимать колёсико на ступице руля. В этой сфере Tesla отстаёт от китайских автопроизводителей, которые уже давно развивают интеллектуальные интерфейсы с учётом предпочтений местной публики. Помимо Tesla, голосовой ассистент на базе моделей DeepSeek на китайском рынке предлагают Zeekr, Dongfeng (Nissan, Voyah, M-Hero) и многие другие. Тем временем, в США компания Tesla повысила стоимость старшей комплектации пикапа Cybertruck сразу на $15 000 до $114 990. Эта прибавка ограничилась нематериальными бонусами для покупателя — за эти деньги он получит комплекс систем активной помощи FSD, а также право бесплатно заряжаться на фирменных станциях Tesla Supercharger. Прочие комплектации пикапа Tesla не подорожали. В WhatsApp появится аналог голосовой почты для пропущенных звонков

22.08.2025 [11:21],

Владимир Фетисов

В прошлом месяце сообщалось, что в WhatsApp появится функция напоминания о пропущенных звонках. Теперь же стало известно, что разработчики планируют добавить в мессенджер аналог голосовой почты для пропущенных звонков.

Источник изображения: lonely blue / Unsplash Упомянутое нововведение обнаружилось в бета-версии WhatsApp 2.25.23.21 для Android. Когда пользователь звонит кому-либо с помощью приложения WhatsApp и не получает ответа, на экране, рядом с кнопками «Перезвонить» и «Отмена», отображается сообщение «Записать голосовое сообщение». Выбрав эту опцию, пользователь может оставить голосовое сообщение, которое собеседник увидит, когда в следующий раз откроет приложение. Опция «Записать голосовое сообщение» также будет отображаться в чате с контактом, до которого не удалось дозвониться.

Источник изображения: wabetainfo.com Аналог голосовой почты позволит быстро записать голосовое сообщение человеку, до которого не удаётся дозвониться. Конечно, это же можно сделать и в чате с контактом, но появление отдельной опции непосредственно после неудачного звонка должно сделать процесс взаимодействия с мессенджером более комфортным. На данном этапе опция «Записать голосовое сообщение» доступна некоторым пользователям бета-версий WhatsApp для Android. Когда эта функция может стать общедоступной, пока неизвестно. Xiaomi представила открытую голосовую ИИ-модель для автомобилей и бытовой техники

04.08.2025 [11:25],

Алексей Разин

Компания Xiaomi сделала себе имя на рынке смартфонов и бытовой техники, но уже второй год выпускает электромобили, поэтому направление развития её фирменных языковых моделей было предсказать не так уж трудно. На этой неделе она представила голосовую модель MiDashengLM-7B, которая предусматривает интеграцию с Qwen2.5-Omni-7B китайской Alibaba Group и обладает открытым исходным кодом.

Источник изображения: Xiaomi Ориентация на работу с голосовой информацией объяснима тем, что пользователи электромобилей и бытовой техники чаще всего используют данный канал для передачи команд на устройства. Не желая оставаться в стороне от бума ИИ, компания Xiaomi сделала ставку на открытый исходный код и интеграцию с разработками известных игроков рынка, коим в Китае является конгломерат Alibaba Group. Свои ИИ-модели, ориентированные на обработку изображений, видео и звука в последние месяцы активно предлагали Alibaba и Tencent Holdings, поскольку местным разработчикам хочется сохранять конкуренцию с решениями OpenAI и других зарубежных игроков рынка. Важность развития систем искусственного интеллекта подчёркивается властями США и Китая на самом высоком уровне. Для Xiaomi интеграция сервисов, доступных владельцам фирменных электромобилей, с уже существующей обширной экосистемой умных бытовых устройств, имеет особую важность. Brilliant Labs представила умные очки Halo за $299, которые помогут вспомнить всё

01.08.2025 [19:07],

Сергей Сурабекянц

Компания Brilliant Labs представила преемника своих умных очков Frame с открытым исходным кодом за $349. Новые умные очки Halo за $299 по цене приближаются к базовым моделям Ray-Ban от Meta✴✴ и оснащены улучшенными возможностями ИИ. Агентская система памяти Narrative использует данные с камеры и микрофонов для создания «личной и персонализированной базы знаний», а мультимодальный ИИ-агент Noa «понимает, что слышит и видит в окружающей среде».  Умные очки Halo предлагают новую «запатентованную агентскую систему памяти» от Brilliant Labs под названием Narrative, которая использует данные, собранные с камеры и микрофонов, для создания «личной и персонализированной базы знаний». Стартап заявляет, что умные очки будут запоминать имя собеседников и содержание прошлых разговоров. По утверждению Brilliant Labs, общение с встроенным мультимодальным ИИ-агентом Noa теперь будет «естественным и интуитивно понятным, как при общении с реальным человеком», благодаря контекстно-релевантной информации, основанной на окружающей обстановке. Noa предоставляет дополнительные возможности по управления очками Halo, позволяя отключать микрофон или переводить их в спящий режим с помощью расширенных голосовых команд. В умение очки Halo также встроена новая экспериментальная функция кодирования под названием Vibe Mode, которая позволит «создавать пользовательские приложения с помощью простых голосовых команд на естественном языке». Вместо поиска нужного приложения в магазине, пользователь, по словам Brilliant Labs, сможет создать собственное приложение с необходимыми функциями. Кроме голосовых подсказок через динамики с костной проводимостью в дужках, владельцу доступен 0,2-дюймовый цветной microOLED-дисплей, который «проецирует интерфейс в стиле ретро-аркад» на периферийное зрение. Время автономной работы устройства составляет внушительные 14 часов, отчасти благодаря энергосберегающей камере и ИИ-чипу со специальным нейронным процессором. Весят умные очки Halo чуть более 40 граммов. Halo в строгом матово-чёрном корпусе уже доступны для ограниченного предзаказа на сайте Brilliant Labs за $299. Поставки ожидаются в конце ноября 2025 года. Возможен заказ очков с диоптрическими линзами. «Яндекс» раскрыл алгоритм распознавания голосовых команд в шумных условиях

30.07.2025 [12:43],

Павел Котов

Инженеры «Яндекса» опубликовали научную статью, в которой раскрыли принципы работы нейросети, обеспечивающей распознавание голосовых команд в условиях внешнего шума. Компания уже применяет эту технологию, и теперь внедрить её смогут разработчики по всему миру.

Источник изображения: yandex.ru/company Работа будет представлена на международной конференции по речевым технологиям Interspeech, которая пройдёт с 17 по 21 августа в нидерландском Роттердаме; среди прочих участников мероприятия значатся Microsoft, Google DeepMind и Google AR. Разработанная специалистами «Яндекса» технология используется в умных колонках и «ТВ Станциях». Она позволяет устройствам с «Алисой» правильно интерпретировать голосовые команды, если что-то пытается этому помешать: играет музыка, шумит вода, гудит вечеринка, или за окном грохочет стройка — система услышит пользователя, даже если он не будет пытаться перекричать песню или не станет выключать пылесос. Используя эту технологию, любая компания сможет повысить качество работы голосового помощника с искусственным интеллектом и уменьшить долю ложных срабатываний. Если человеческий голос раздаётся на фоне музыки, эффективными считаются алгоритмы эхоподавления; в случае других посторонних источников лучше работает шумоподавление, которое, однако, ухудшает и разборчивость человеческой речи. Поэтому в «Яндексе» разработали attention-механизм на основе нейросетей — на вход ему подаются сразу оба сигнала, с эхо- и шумоподавлением, и система динамически выбирает наиболее чёткий, адаптируясь к звуковому фону от источников разной природы. Скоро рынок наполнится наушниками со встроенным ИИ на базе GPT-4.1 — Bragi и OpenAI договорились о партнёрстве

29.07.2025 [19:13],

Сергей Сурабекянц

В 2019 году немецкая компания Bragi переключилась с производства наушников на лицензирование собственных разработок. Фирменные технологии компании используют многие именитые производители аудиотехники. Сегодня Bragi анонсировала приложение ChatAI, разработанное в партнёрстве с OpenAI. Оно позволит производителям наушников интегрировать в свои продукты голосового помощника на базе GPT-4.1 — для создания заметок, постановки вопросов и доступа к информации.

Источник изображений: Bragi Когда владелец наушников активирует голосового помощника, мультимодальная локальная модель в приложении ChatAI обрабатывает запрос и отправляет его на серверы OpenAI. Модель GPT-4.1 формирует ответ, который озвучивается через наушники. Чтобы минимизировать риск случайной активации и обработки посторонних голосов, ChatAI обучен реагировать только на команды владельца устройства. В Bragi подчёркивают, что компания не получает персональные данные пользователей, а их запросы не сохраняются в приложении после отправки в OpenAI. Bragi также заявляет, что новая система позволит партнёрам создавать собственный фирменный интерфейс и реализовывать агентские функции — например, изучение привычек пользователя и проактивную настройку эквалайзера в зависимости от контекста и личных предпочтений.  На первом этапе ChatAI будет поддерживать английский, немецкий, французский, испанский и китайский языки. В дальнейшем планируется расширение языковой поддержки. Согласно исследованиям Bragi, пользователи в разных регионах используют ИИ-функции по-разному: в Китае наиболее востребован перевод, тогда как в других странах сценарии применения более разнообразны. По данным компании, 89 % потребителей готовы заплатить в среднем на $25 больше за наушники с ИИ-функциями, что увеличивает среднюю цену таких устройств до $135–160. Приложение ChatAI станет доступным для производителей наушников уже этим летом. Xiaomi представила смарт-очки AI Glasses с камерой Sony, чипом Snapdragon и автономностью выше 8 часов за $280

26.06.2025 [20:18],

Сергей Сурабекянц

На масштабном мероприятии Xiaomi в Китае компания представила умные очки AI Glasses — ответ на Ray-Ban Meta✴✴. Устройство не имеет визуального интерфейса, полагаясь исключительно на голосовые команды. Также на правой дужке расположена область сенсорного управления. Владелец может установить в Xiaomi AI Glasses цветные линзы без диоптрий или использовать рецептурные и дополнительные электрохромные линзы.

Источник изображений: Xiaomi Очки Xiaomi AI Glasses построены на базе аппаратной платформы Snapdragon AR1 от Qualcomm и работают под управлением ОС Vela, разработанной Xiaomi. Умные очки Xiaomi используют встроенную камеру с 12-мегапиксельным датчиком Sony IMX681 для распознавания объектов и записи видео с разрешением 2K и скоростью до 30 кадров в секунду. Пять микрофонов с костной проводимостью и шумоподавлением обеспечивают разборчивость речи владельца во время звонков и функционирование голосового ассистента Xiao Ai. Для воспроизведения мультимедиа в дужки очков встроены два динамика.  AI Glasses весят всего 40 граммов. Умные очки оснащены аккумулятором ёмкостью 263 мА·ч, который, по словам производителя, обеспечивает автономную работу в течение 8 часов и 36 минут, что почти вдвое больше, чем у очков Ray-Ban Meta✴✴. Очки оснащены портом USB Type-C и могут подключаться напрямую к любому совместимому зарядному устройству.  Xiaomi AI Glasses выпускаются в чёрном, коричневом и зелёном цветах и пока доступны только в Китае. Цена на устройство установлена на уровне 1999 юаней (≈$278). ИИ-поисковик Google научился понимать голосовые запросы, но доступна функция не всем

18.06.2025 [23:20],

Николай Хижняк

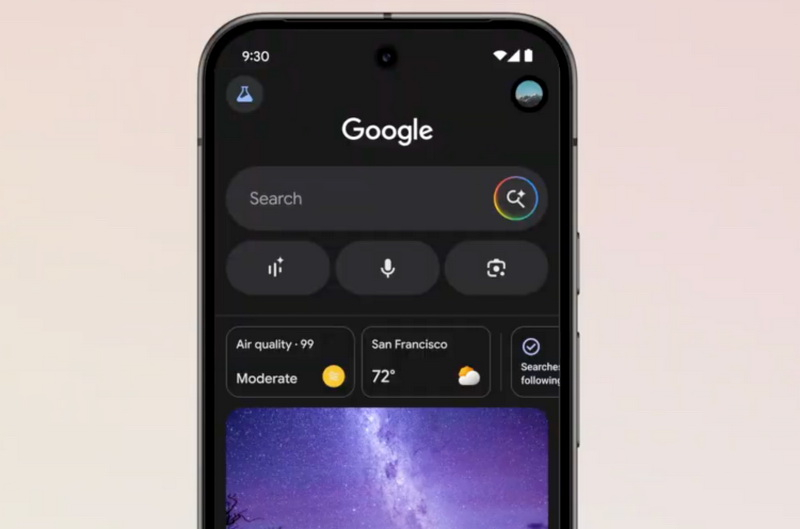

Google начала тестировать функцию Search Live в режиме поиска с ИИ — AI Mode. Новая функция позволяет задавать вопросы ИИ-чат-боту голосом прямо из поисковой системы. Открытое тестирование доступно пока только в США и исключительно для участников программы Google Labs по тестированию экспериментальных функций. На данный момент Search Live не поддерживает использование камеры смартфона, но Google планирует добавить такую возможность «в ближайшие месяцы».

Источник изображений: Google Search Live позволяет взаимодействовать со специально адаптированной версией ИИ-помощника Gemini и выполнять поиск в интернете в режиме реального времени. Функция доступна в приложении Google для Android и iOS. В будущем Search Live получит поддержку камеры смартфона — пользователь сможет навести её на объект и задать голосом интересующий вопрос о нём. Google анонсировала функцию Search Live для режима поиска с ИИ AI Mode в прошлом месяце. Она является частью более широкой программы компании по трансформации своей поисковой системы и расширению его ИИ-возможностей. Сейчас компания, например, также экспериментирует с ИИ-функцией, которая превращает результаты поиска в подкаст. После запроса пользователя и вывода чат-ботом результатов, пользователь может использовать функцию Generate Audio Overview и ИИ предоставит ответ в аудиоформате в виде кратного подкаст-обзора по теме. Принять участие в тестировании Search Live можно через Google Labs (в России недоступен), после чего в приложении Google на Android или iOS станет активен новый значок Live. Затем чат-боту можно вслух задать, например, такой вопрос: «Как предотвратить появление складок на льняном платье, упакованном в чемодан?». Чат-бот предложит ответ, а пользователь сможет задать уточняющий вопрос, например: «Что делать, если оно всё равно мнётся?». Search Live также предложит ссылки на материалы с возможными решениями во время диалога.  Другие ИИ-компании также внедряют голосовые режимы в своих чат-ботах. Так, OpenAI представила расширенный голосовой режим для ChatGPT в прошлом году, а Anthropic запустила голосовую функцию в приложении Claude в мае. Apple также работает над большой языковой моделью для Siri, однако её выпуск был отложен — по словам старшего вице-президента Apple по программному обеспечению Крейга Федериги (Craig Federighi), компания пока не достигла «желаемого уровня надёжности». Google отмечает, что Search Live может работать в фоновом режиме, позволяя продолжать диалог с чат-ботом даже при переходе в другие приложения. Пользователь может также включить субтитры, чтобы видеть текстовую версию ответа, и при желании продолжить общение текстом. Кроме того, Search Live сохраняет историю прошлых разговоров в разделе поиска AI Mode. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |