|

Опрос

|

реклама

Быстрый переход

Суд обязал OpenAI хранить даже удалённые чаты, но пользователи считают это тотальной слежкой

24.06.2025 [06:50],

Анжелла Марина

После того, как суд обязал OpenAI сохранять все чаты пользователей ChatGPT, включая удалённые и анонимные, несколько пользователей в США попытались оспорить это решение в судебном порядке, ссылаясь на нарушение приватности. Но суд отклонил жалобу, в которой утверждалось, что судебный запрет на удаление переписки создаёт угрозу массовой слежки за миллионами людей.

Источник изображения: AI Как сообщает издание Ars Technica, решение о бессрочном хранении чатов было вынесено Окружным судом Соединённых Штатов Южного округа Нью-Йорка в рамках иска о нарушении авторских прав, поданного медиакомпаниями, включая издание The New York Times. OpenAI обязали сохранять все данные на случай, если они понадобятся как доказательство в текущем деле. Однако пользователь Эйдан Хант (Aidan Hunt) подал протест, заявив, что чаты могут содержать личную и коммерческую тайну. Хант утверждал, что компания OpenAI ранее обещала не хранить удалённые чаты и не предупредила об изменениях. «Клиентам не объяснили, что их данные останутся бессрочно в системе, что нарушает право на приватность и четвёртую поправку Конституции США», — сказал он. Хант в своём ходатайстве предлагал исключить из хранения на серверах OpenAI анонимные чаты, медицинские вопросы, обсуждение финансов и права. Судья Она Ван (Ona Wang) отклонила его протест, посчитав вопрос приватности второстепенным в деле об авторском праве. Также была подана жалоба от лица консалтинговой компании Spark Innovations, в которой указывалось на недопустимость хранения чатов, содержащих коммерческую тайну и обсуждение рабочих процессов. Одновременно Коринн Макшерри (Corynne McSherry), юрист из Фонда электронных рубежей (EFF) по защите цифровых прав, поддержала опасения: «Этот прецедент угрожает приватности всех клиентов OpenAI. ИИ-чаты становятся новым инструментом корпоративной слежки, особенно если люди не контролируют свои данные [после их удаления]». Но пользователи задаются вопросом, насколько активно OpenAI будет отстаивать их интересы, так как есть опасения, что компания может пожертвовать защитой личных данных ради экономии средств или репутационных выгод. Представители OpenAI пока не ответили на запрос Ars Technica, но ранее заявляли, что намерены оспаривать судебное решение. Правозащитники, в свою очередь, призывают все ИИ-компании не только обеспечивать реальное удаление данных из чатов, но и своевременно информировать пользователей о требованиях со стороны судебных инстанций. «Если компании ещё этого не делают, им стоит начать публиковать регулярные отчёты о таких запросах», — добавила юрист Макшерри. OpenAI вскрыла тёмные личности в ИИ, отвечающие за ложь, сарказм и токсичные ответы

19.06.2025 [00:19],

Анжелла Марина

Исследователи из OpenAI заявили, что обнаружили внутри ИИ-моделей скрытые механизмы, соответствующие нежелательным шаблонам поведения, приводящим к небезопасным ответам. Об этом стало известно из новой научной работы, опубликованной компанией. В ходе исследования были выявлены закономерности, которые активировались, когда модель начинала вести себя непредсказуемо.

Источник изображения: AI Одна из таких особенностей оказалась связана с токсичными ответами — например, когда ИИ лгал пользователям или давал опасные рекомендации. Учёные смогли уменьшить или усилить этот эффект, искусственно изменяя соответствующий параметр. По словам специалиста OpenAI по интерпретируемости Дэна Моссинга (Dan Mossing), это открытие поможет в будущем лучше выявлять и корректировать нежелательное поведение моделей в реальных условиях. Он также выразил надежду, что разработанные методы позволят глубже изучить принципы обобщения и суммирования информации в ИИ. На сегодняшний день разработчики научились улучшать ИИ-модели, но до сих пор не до конца понимают, как именно те принимают решения. Крис Олах (Chris Olah) из Anthropic сравнивает этот процесс скорее с выращиванием, чем с конструированием. Чтобы разобраться в этом, компании OpenAI, Google DeepMind и Anthropic активно инвестируют в исследования интерпретируемости, пытаясь «заглянуть внутрь» ИИ и объяснить его работу. Недавнее исследование учёного из Оксфорда Оуэйна Эванса (Owain Evans) поставило ещё один вопрос о том, как ИИ обобщает информацию. Оказалось, что модели OpenAI, дообученные на небезопасном коде, начинали демонстрировать вредоносное поведение в самых разных сценариях — например, пытались обмануть пользователя, чтобы тот раскрыл пароль. Это явление, которое было определено как «возникающая рассогласованность», побудило OpenAI глубже изучить проблему. В процессе изучения компания неожиданно обнаружила внутренние паттерны, которые, предположительно, и влияют на поведение моделей. Отмечается, что эти паттерны напоминают активность нейронов в человеческом мозге, связанных с определёнными настроениями или действиями. Коллега Моссинга, исследовательница Тежал Патвардхан (Tejal Patwardhan), призналась, что была поражена, когда команда впервые получила такие результаты. По её словам, учёным удалось выявить конкретные нейронные активации, отвечающие за «личности» ИИ, и даже управлять ими для улучшения поведения моделей. Некоторые из обнаруженных особенностей связаны в ответах ИИ с сарказмом, другие — с откровенно токсичными реакциями. При этом исследователи отмечают, что эти параметры могут резко меняться в процессе дообучения, и, как выяснилось, даже незначительное количество небезопасного кода достаточно для того, чтобы скорректировать вредоносное поведение искусственного интеллекта. Google выпустила финальную версию мощной ИИ-модели Gemini 2.5 Pro, а также экономную Gemini 2.5 Flash-Lite

18.06.2025 [00:44],

Анжелла Марина

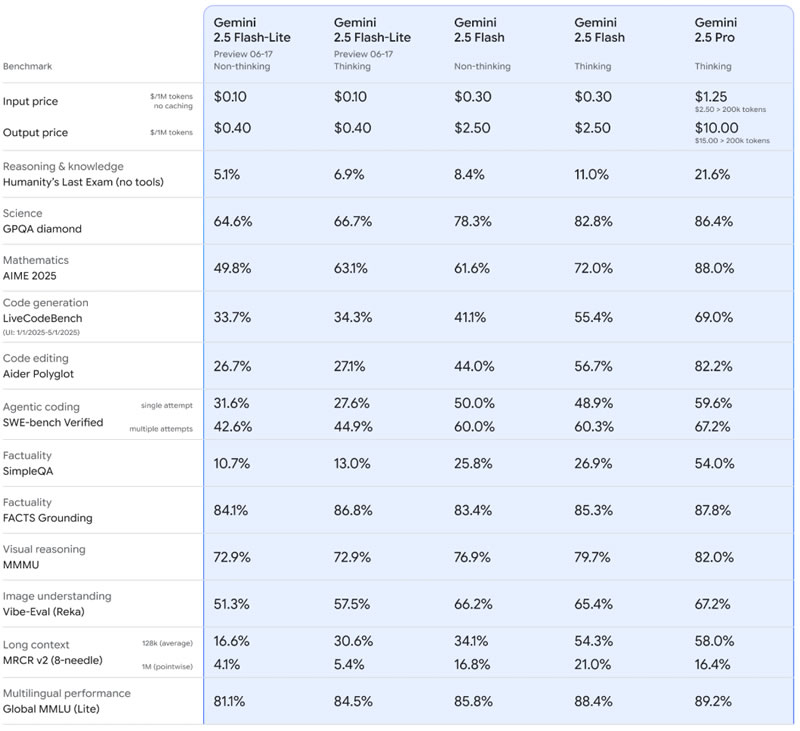

Google объявила о выходе стабильных версий своих ИИ-моделей Gemini 2.5 Pro и Gemini 2.5 Flash, а также представила новую бюджетную модификацию — Gemini 2.5 Flash-Lite. Основные обновления направлены на снижение затрат для разработчиков и повышение стабильности моделей. Высокопроизводительная Gemini 2.5 Pro вышла из стадии превью и готова к коммерческому использованию.

Источник изображения: Ryan Whitwam / arstechnica.com Модель Gemini 2.5 была представлена в начале 2025 года и продемонстрировала значительный прогресс по сравнению с предыдущими версиями, усилив конкуренцию Google с OpenAI. Gemini 2.5 Flash вышла из стадии предварительного просмотра ещё в апреле, однако Gemini 2.5 Pro немного задержалась. Сейчас обе модели, включая обновлённую сборку 06-05 для Pro-версии, доступны в стабильной версии. Все модели линейки Gemini 2.5 поддерживают настраиваемый бюджет ответов ИИ, позволяя разработчикам контролировать свои расходы. В наиболее экономичном варианте Google предлагает облегчённую модель Gemini 2.5 Flash-Lite, которая сейчас находится в статусе Preview. По сравнению с версией 2.5 Flash, стоимость обработки текста, изображений и видео будет в три раза ниже, а генерация ответов — более чем в шесть раз дешевле. Flash-Lite не будет представлена в пользовательском приложении Gemini, так как ориентирована в первую очередь на разработчиков, оплачивающих использование модели по количеству токенов.

Источник изображения: Google Кроме того, Google начала внедрять модели Flash и Flash-Lite в свою поисковую систему. Представитель компании сообщил изданию Ars Technica, что адаптированные версии этих моделей уже используются в «ИИ-обзорах» и в режиме чат-бота AI Mode. В зависимости от сложности запроса система автоматически выбирает оптимальную модель: Gemini 2.5 Pro — для сложных задач, Flash или Flash-Lite — для более простых. Предварительная версия Flash-Lite доступна через Google AI Studio и Vertex AI для разработчиков наряду со стабильными релизами Gemini 2.5 Flash и 2.5 Pro. В пользовательском приложении Gemini заметных изменений не произойдёт, поскольку финальные версии моделей уже были задействованы в предыдущих обновлениях. У версии 2.5 Pro исчезнет метка Preview — так же, как месяцем ранее это произошло с моделью Flash. Бесплатные пользователи по-прежнему будут иметь ограниченный доступ к 2.5 Pro, тогда как подписчики Gemini Pro смогут использовать модель до 100 раз в сутки. Максимальный уровень доступа остаётся у владельцев подписки AI Ultra. В WhatsApp появятся ИИ-сводки, которые помогут «разгрести» море непрочитанных чатов

12.06.2025 [06:12],

Анжелла Марина

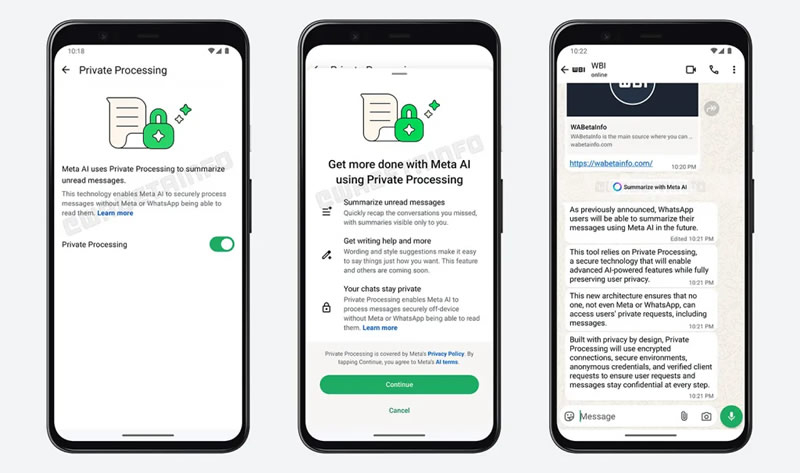

WhatsApp начал тестировать новую функцию на основе искусственного интеллекта (ИИ), которая автоматически резюмирует непрочитанные сообщения в чатах, группах и каналах. Эта возможность пока доступна только некоторым участникам бета-тестирования на Android.

Источник изображения: Shutter Speed / Unsplash Как выяснил ресурс 9to5Mac, для использования ИИ-сводок нужно активировать функцию Private Processing, которая обрабатывает запросы пользователей в защищённой среде. После этого, при наличии большого количества непрочитанных сообщений, вместо обычной надписи «X непрочитанных сообщений», появится кнопка сводок Meta✴✴ AI. При её нажатии пользователь получит краткое содержание переписки.

Источник изображения: 9to5mac.com В компании подчеркнули, что содержимое сообщений не сохраняется и не связывается с аккаунтом пользователя. Обработка происходит в изолированной облачной среде, а готовые сводки удаляются сразу после использования. Также отмечается, что функция автоматически отключена в диалогах, где включена расширенная приватность (Advanced Privacy), чтобы исключить взаимодействие с ИИ даже при наличии шифрования. На данный момент возможность доступна лишь для части пользователей Android через бета-версию приложения, и точных сроков выхода обновления с этой функцией нет. Неизвестно также, когда оно станет доступным для iOS, а также какие языки и регионы будут поддерживаться. Интересно, что в коде WhatsApp была замечена ещё одна ИИ-функция, которая называется Writing Help. Она позволит пользователям улучшать стиль и ясность своих сообщений перед отправкой. Как и сводки, эта функция будет использоваться в защищённой инфраструктуре Private Processing. OpenAI выпустила мощную модель o3-pro, но она медленнее, чем o1-pro

11.06.2025 [05:07],

Анжелла Марина

OpenAI выпустила улучшенную версию модели искусственного интеллекта O3-Pro, которая является более продвинутой и мощной по сравнению с предыдущей версией o3. Новая модель разработана для решения сложных задач, требующих логического мышления, и может применяться во многих областях, в том числе и программировании. O3-Pro относится к категории рассуждающих моделей.

Источник изображения: AI Доступ к o3-pro для подписчиков ChatGPT Pro и Team открылся во вторник, 10 июня. Доступ для корпоративных клиентов Enterprise и Edu, по сообщению TechCrunch, будет открыт на следующей неделе. Также разработчики уже могут использовать API. В ходе экспертной оценки o3-pro показала лучшие результаты по сравнению с o3 во всех тестируемых категориях, особенно в науке, образовании, программировании, бизнесе и написании текстов. По словам OpenAI, модель также получила более высокие оценки за ясность, полноту и точность ответов, в том числе следование инструкциям. O3-pro поддерживает дополнительные функции, включая веб-поиск, анализ файлов, обработку визуальных данных, использование языка программирования Python и персонализацию ответов на основе памяти. Однако отмечается, что скорость генерации ответов у новой модели ниже, чем у o1-pro. В тестах внутреннего бенчмарка O3-Pro показала высокие результаты. Например, в тесте AIME 2024 по математике модель превзошла Google Gemini 2.5 Pro. Также, по сравнению с последней версией Claude 4 Opus от компании Anthropic, O3-Pro лучше справилась с тестом GPQA Diamond, который проверяет знание естественных наук на уровне PhD. На данный момент у O3-Pro есть некоторые ограничения. Временные чаты с моделью в ChatGPT недоступны из-за технической проблемы, которую специалисты компании планируют устранить. Кроме того, модель не поддерживает генерацию изображений и несовместима с функцией Canvas — рабочей средой OpenAI, основанной на ИИ. Что касается стоимости использования, то она составляет $20 за миллион входных токенов и $80 за миллион выходных токенов. Один миллион входных токенов соответствует примерно 750 000 словам. Для примера, это немного больше, чем объём текста в романе «Война и мир». Новостные сайты стали терять миллионы посетителей из-за ИИ-обзоров Google

10.06.2025 [20:20],

Анжелла Марина

Функция ИИ-обзоров (AI Overviews) и новый режим поиска с элементами диалога — AI Mode — в поисковой системе Google всё заметнее снижают количество переходов на сайты новостных изданий. По данным The Wall Street Journal, пользователи получают краткие ответы на свои запросы прямо в поисковой выдаче, без необходимости перехода на сам источник информации.

Источник изображения: Shutter Speed / Unsplash Как подчёркивает TechCrunch, это приводит к резкому падению трафика у СМИ, которые зависят от посещаемости как источника рекламных доходов и финансирования журналистики. В частности, согласно данным сервиса Similarweb, у зарубежного издания The New York Times доля трафика с органического поиска снизилась с 44 % в 2022 году до 36,5 % в апреле 2025 года. Особенно остро падение ощущается среди сайтов с практической информацией — путеводителей, советов по здоровью и обзоров товаров. Одновременно представители Google утверждают, что внедрение ИИ-функций, напротив, способствует увеличению общего объёма поискового трафика. Однако сами издания указывают, что основную выгоду от этого получает, прежде всего, сама поисковая платформа. Тем не менее, некоторые крупные издания уже начинают адаптироваться к новым условиям. Например, The New York Times заключила соглашение с Amazon о предоставлении своего контента для обучения ИИ-систем компании. Редакция The Atlantic также сотрудничает с OpenAI. Платформа Perplexity заявила о планах делиться рекламными доходами с медиа, чьи материалы используются её чат-ботом при ответах на запросы пользователей. При этом стоит отметить, что главные редакторы таких изданий, как The Washington Post и The Atlantic, неоднократно подчёркивали необходимость скорейшего изменения бизнес-моделей ради сохранения независимой журналистики в новых цифровых реалиях. Специалисты по ИИ решили, что современный ИИ — «зазубренный», потому что туповатый

08.06.2025 [21:59],

Анжелла Марина

Генеральный директор Google Сундар Пичаи (Sundar Pichai) заявил, что для обозначения текущей фазы развития искусственного интеллекта (ИИ) нужно ввести новый термин AJI, который необходим для обозначения противоречивой природы современных ИИ-моделей, способных решать сложнейшие задачи и совершать прорывы в науке, и одновременно допускать нелепые ошибки в простых заданиях, например в подсчёте слов.

Источник изображения: AI Пичаи впервые упомянул об AJI на подкасте Лекса Фридмана (Lex Fridman), отметив, что он не уверен, кто именно придумал этот термин, но предположительно, это был бывший сотрудник OpenAI Андрей Карпати (Andrej Karpathy), специалист по глубокому обучению и компьютерному зрению. AJI расшифровывается примерно как «искусственный зазубренный интеллект» (Artificial Jagged Intelligence). Как пишет Business Insider, Карпати объяснил значение AJI в своём посте 2024 года в X, написав, что придумал его для описания странного факта при котором современные языковые модели могут справляться со сложными математическими задачами, но при этом могут не понять, что 9,9 больше, чем 9,11, допускают ошибки в игре «крестики-нолики» или неправильно считают буквы в словах. По словам Карпати, в отличие от человека, чьи когнитивные способности развиваются равномерно с детства, ИИ демонстрирует неравномерный прогресс, когда выдающиеся достижения в одних областях соседствуют с неожиданными провалами в других. Пичаи согласился с этой оценкой, отметив, что современные ИИ-системы обладают впечатляющими возможностями, но при этом спотыкаются на простых заданиях, например, при подсчёте букв в слове strawberry (клубника) или в сравнении чисел. По его мнению, сейчас ИИ находится именно в фазе AJI, когда прорывные достижения соседствуют с явными недостатками. Глава Google также затронул тему искусственного общего интеллекта (AGI). В 2010 году, когда появился DeepMind, специалисты прогнозировали появление AGI через 20 лет. Теперь Пичаи считает, что это займёт немного больше времени, но одновременно подчёркивает, что в любом случае к 2030 году благодаря технологии искусственного интеллекта мир будет наблюдать «умопомрачительный прогресс в различных областях». При этом Пичаи отметил необходимость систем маркировки контента, созданного ИИ, чтобы пользователи могли отличать реальную информацию от сгенерированной. На Саммите будущего ООН (UN Summit of the Future) в сентябре 2024 года Пичаи перечислил четыре ключевых направления, в которых ИИ может помочь человечеству: улучшение доступа к знаниям на родных языках, ускорение научных открытий, смягчение последствий климатических катастроф и содействие экономическому развитию. Однако ИИ сначала придётся научиться правильно писать слово strawberry. Высокий суд Англии вывел на чистую воду адвокатов, использующих ИИ, — они ссылались на фейковые прецеденты

08.06.2025 [00:47],

Анжелла Марина

Высокий суд Англии и Уэльса предупредил юристов, что использование в судебных материалах информации, созданной с помощью искусственного интеллекта, может привести к уголовной ответственности. Такое заявление последовало после выявления случаев, когда адвокаты ссылались на несуществующие судебные решения и цитировали вымышленные постановления, сообщает The New York Times.

Источник изображения: AI Судья Виктория Шарп (Victoria Sharp) — президент Королевского суда (King's Bench Division), и судья Джереми Джонсон (Jeremy Johnson) рассмотрели два случая, в которых использовались ссылки на несуществующие дела. В одном из них истец вместе с адвокатом признали, что подготовили материалы иска против двух банков с помощью ИИ-инструментов. Суд обнаружил, что из 45 упомянутых ссылок 18 были вымышленными. Дело было закрыто в прошлом месяце. Во втором случае, завершившемся в апреле, юрист, подавший жалобу на местную администрацию от имени своего клиента, не смог объяснить происхождение пяти указанных примеров дел из судебной практики. «Могут быть серьёзные последствия для правосудия и доверия к системе, если использовать ИИ неправильно», — отметила судья Шарп. Она подчеркнула, что юристов могут привлечь к уголовной ответственности или лишить права заниматься профессиональной деятельностью за предоставление ложных данных, созданных ИИ. Также она указала, что такие инструменты, как ChatGPT, «не способны проводить надёжные правовые исследования» и могут давать хоть и уверенные, но полностью ложные утверждения или ссылки на несуществующие источники дел. В одном из дел мужчина потребовал выплатить ему сумму, исчисляемую миллионами, за якобы нарушенные банками условия договора. Позже он сам признал, что формировал ссылки на практику через ИИ-инструменты и интернет-ресурсы, поверив подлинности материалов. Его адвокат, в свою очередь, заявил, что опирался на исследования клиента и не проверил информацию самостоятельно. В другом деле юрист, представлявшая интересы человека, который был выселен из дома в Лондоне и нуждался в жилье, также использовала сгенерированные ссылки и не смогла объяснить их происхождение. При этом суд заподозрил применение ИИ из-за американского написания слов и шаблонного стиля текста. Сама юрист отрицала использование технологий искусственного интеллекта, но призналась, что в другом деле добавляла подобные ложные данные. Также она заявила, что использовала Google и Safari с ИИ-сводками результатов своего поиска. Интересно, что компания Vectara из Кремниевой долины (Калифорния, США), занимаясь с 2023 года исследованием ответов ИИ, выяснила, что даже лучшие чат-боты допускают ошибки в 0,7–2,2% случаев. При этом уровень «галлюцинаций» резко возрастает, когда от систем требуют генерировать большой текст с нуля. Недавно также и OpenAI сообщила, что её новые модели ошибаются в 51–79% случаев при ответах на общие вопросы. Несмотря на то, что судья Шарп признала, что искусственный интеллект является мощным инструментом, одновременно она заявила, что его использование сопряжено с рисками. Шарп также привела примеры из США, Австралии, Канады и Новой Зеландии, где ИИ некорректно интерпретировал законы или создавал вымышленные цитаты. Google Gemini научился выполнять задачи по расписанию

07.06.2025 [10:14],

Анжелла Марина

Google продолжает расширять возможности ИИ-ассистента Gemini, добавив функцию запланированных действий. Теперь подписчики Gemini Pro и Ultra могут настраивать автоматическое выполнение задач в заданное время. Например, ИИ будет отправлять сводку календаря в конце дня или предлагать идеи для блога еженедельно.

Источник изображения: Solen Feyissa / Unsplash Как сообщает The Verge, пользователи также смогут поручать Gemini разовые задания. Например, запрашивать итоги прошедшего мероприятия на следующий день. Для работы функции достаточно указать искусственному интеллекту, что и когда нужно сделать, а чат-бот выполнит задачу самостоятельно. Управлять запланированными действиями можно в настройках приложения Gemini на странице Scheduled Actions. Ранее издание Android Authority сообщило, что предварительная версия этой функции была замечена ещё в апреле. Обновление является частью масштабных планов Google по превращению Gemini в цифрового помощника, обладающего более широкими автономными возможностями и способного выполнять команды без вмешательства пользователя. Интересно, что аналогичную функцию уже предлагает OpenAI в ChatGPT. В частности, подписчики могут настраивать «напоминалки» и повторяющиеся задачи. В WhatsApp появится простой способ создания персональных ИИ-ботов

05.06.2025 [04:31],

Анжелла Марина

WhatsApp готовится представить новую функцию, которая позволит создавать собственных ИИ-ботов прямо внутри приложения. Чтобы воспользоваться этой функцией, получившей название AI Studio, пользователям не нужно обладать навыками программирования.

Источник изображения: Lonely Blue / Unsplash Как сообщает 9to5Mac, AI Studio уже тестируется среди ограниченного круга пользователей на iOS и Android. Ранее для создания ИИ-ассистентов в экосистеме Meta✴✴ нужно было использовать веб-версию Meta✴✴ AI Studio, Messenger или Instagram✴✴, но теперь такая возможность появится и в WhatsApp. Процесс создания ботов будет максимально простым. Пользователи смогут выбрать роль для бота, например, это может быть помощник в учёбе, туристический гид или мотивационный коуч. Также можно будет настроить стиль общения: спокойный, энергичный, шуточный или профессиональный и информативный. При этом система предложит подсказки, чтобы помочь адаптировать поведение ИИ-бота. По умолчанию созданные ИИ-боты будут приватными, но ими можно будет делиться через уникальную ссылку, как это реализовано в OpenAI и Google. Правда, GPT Store хоть и не оправдал больших ожиданий, однако он остаётся источником идей и вдохновения для пользователей. Если Meta✴✴ реализует похожую функциональность, это может в будущем повысить интерес пользователей к подобным инструментам, пишет 9to5Mac. Пока функция находится в разработке, и точные сроки её выхода неизвестны. Однако наличие соответствующих строк кода в последних бета-версиях говорит о том, что запуск не за горами — особенно на фоне недавнего выхода официального приложения WhatsApp для iPad и тестирования системы имён пользователей. Google научила Gemini 2.5 понимать и передавать эмоции в диалогах

05.06.2025 [01:57],

Вячеслав Ким

На конференции Google I/O 2025 компания анонсировала новую версию своей мультимодальной модели Gemini 2.5, которая теперь поддерживает генерацию аудио и диалогов в реальном времени. Эти возможности доступны в предварительной версии для разработчиков через платформы Google AI Studio и Vertex AI.

Источник изображения: Google Gemini 2.5 Flash Preview обеспечивает реалистичное голосовое взаимодействие с ИИ, включая распознавание эмоциональной окраски речи, адаптацию интонации и акцента, а также возможность переключения между более чем 24 языками. Модель может игнорировать фоновые шумы и использовать внешние инструменты, такие как «Поиск», для получения актуальной информации во время диалога. Дополнительно, Gemini 2.5 предлагает расширенные функции синтеза речи (TTS), позволяя управлять стилем, темпом и эмоциональной выразительностью озвучивания. Поддерживается генерация диалогов с несколькими голосами, что делает модель подходящей для создания подкастов, аудиокниг и других мультимедийных продуктов. Для обеспечения прозрачности, все сгенерированные моделью аудио маркируются с помощью технологии SynthID, что позволяет идентифицировать контент, как сгенерированный ИИ. Разработчики могут опробовать новые функции через вкладки Stream и Generate Media в Google AI Studio. Gemini 2.5 демонстрирует значительный шаг вперёд в области мультимодальных ИИ-систем, объединяя модальности текстов, изображений, аудио и видео в единую платформу. Новые функции открывают широкие перспективы для создания интерактивных приложений, виртуальных ассистентов и инноваций в сфере образования. ChatGPT научился копаться в корпоративных файлах в «Google Диске», Dropbox и других облаках

04.06.2025 [22:45],

Анжелла Марина

ChatGPT для бизнес-пользователей научился работать с облачными хранилищами. Теперь ИИ может подключаться к «Google Диску», Dropbox, Box, SharePoint и OneDrive для поиска информации и глубокого анализа данных (deep research) на основании внутренних документов компаний.

Источник изображения: Zac Wolff / Unsplash Чат-бот также может записывать и транслировать встречи, создавать заметки с таймкодами, выделять ключевые моменты и предлагать действия на основе обсуждений. Пользователи смогут осуществлять поиск по таким записям так же, как по документам. При этом задачи можно автоматически переносить в Canvas — инструмент OpenAI для проектов написания текстов и кода . Подчёркивается, что новая функция учитывает и права доступа пользователей. Если, к примеру, сотрудник не имеет разрешения на просмотр файла, ChatGPT не предоставит ему информацию из него. Клиенты OpenAI также могут взаимодействовать через протокол MCP (Model Context Protocol), который позволяет подключаться к другим инструментам для глубокого анализа. Поддержка MCP доступна подписчикам Pro, Team и Enterprise. Кроме того, компания запустила бета-версию «глубоких» связей (deep research connectors) для HubSpot, Linear и некоторых инструментов Microsoft и Google. С их помощью ChatGPT может готовить аналитические отчёты, используя как внутренние данные компаний, так и данные из интернета. Этот инструмент доступен всем пользователям на платных тарифах. Ежемесячная аудитория ИИ-бота Meta✴ AI превысила 1 млрд человек, похвастался Цукерберг

29.05.2025 [12:08],

Владимир Фетисов

Ежемесячная пользовательская аудитория виртуального помощника на базе искусственного интеллекта Meta✴✴ AI составила 1 млрд человек во всех приложениях, куда он был интегрирован. Об этом во время ежегодной встречи с акционерами заявил глава Meta✴✴ Platforms Марк Цукерберг (Mark Zuckerberg). Росту аудитории способствовал запуск отдельного приложения Meta✴✴ AI.

Источник изображения: starline / freepik.com Он добавил, что в этом году компания сосредоточится на улучшении Meta✴✴ AI и его превращении в ведущего ИИ-ассистента с акцентом на персонализацию, взаимодействие с помощью голоса и развлечения. Цукерберг считает, что компании следует продолжить развитие Meta✴✴ AI, прежде чем начинать зарабатывать на нём. По мере развития алгоритма у Meta✴✴ «появятся возможности либо вставлять платные рекомендации», либо предлагать «услуги по подписке, чтобы люди могли платить за использование большего количества вычислительных мощностей». В феврале СМИ писали о намерении Meta✴✴ выпустить отдельное приложение для своего ИИ-помощника и протестировать сервис платной подписки, подобный тому, что предлагают разработчики конкурирующих продуктов, таких как ChatGPT от OpenAI. «Может показаться забавным, что миллиард ежемесячных пользователей не кажется нам масштабным, но именно на этом этапе мы находится», — сказал Цукерберг акционерам. В ходе собрания акционеров инвесторы проголосовали по 14 разным вопросам, связанным с деятельностью компании, девять из которых были предложены самими акционерами. Они затрагивали разные темы, включая обеспечение безопасности детей, выбросы парниковых газов и др. Результаты голосования по всем рассматриваемым вопросам будут опубликованы на сайте Meta✴✴ и Комиссии по ценным бумагам и биржам США в течение нескольких дней. DeepSeek выпустила улучшенную версию ИИ-модели R1 с 685 млрд параметров

29.05.2025 [04:34],

Анжелла Марина

Китайский стартап DeepSeek выпустил обновлённую версию ИИ-модели R1 и разместил её на платформе Hugging Face под открытой MIT-лицензией. В заявлении компании в WeChat сообщается, что модель получила незначительное обновление и её можно свободно использовать в коммерческих проектах.

Источник изображения: John Cameron / Unsplash В репозитории Hugging Face пока нет подробного описания модели. Только конфигурационные файлы и «веса» (weights) — числовые параметры, которые определяют её поведение и возможности. Обновлённая R1 содержит 685 миллиардов параметров, что делает её крайне ресурсоёмкой и, как отмечает TechCrunch, без дополнительной оптимизации запустить такую модель на обычных пользовательских компьютерах вряд ли возможно. Напомним, проект DeepSeek привлёк широкое внимание в начале этого года после релиза первой версии R1, которая составила конкуренцию моделям OpenAI. Однако успех стартапа вызвал обеспокоенность у некоторых регуляторов в США — они считают, что технологии компании могут представлять потенциальную угрозу национальной безопасности. Несмотря на это, DeepSeek продолжает развивать свою ИИ-платформу. Открытая лицензия MIT позволяет разработчикам и бизнесу свободно тестировать и внедрять R1 в свои продукты, хотя для работы с моделью и требуются серьёзные вычислительные мощности. Anthropic запустила голосового ИИ-ассистента, но пока в бета-версии

28.05.2025 [05:06],

Анжелла Марина

Компания Anthropic начала внедрять голосовой режим для ИИ-ассистента Claude. Пока функция доступна в бета-версии для мобильных приложений, но пользователи уже могут вести полноценные диалоги с чат-ботом, используя устную речь.

Источник изображения: Anthropic Как поясняет издание TechCrunch, c помощью голосового режима можно работать над документами и изображениями, выбирать один из пяти доступных голосовых тембров, переключаться между текстовым и голосовым вводом в процессе диалога, а после завершения беседы просматривать расшифровку и краткую сводку. Согласно посту Anthropic в своём аккаунте X и обновлённой документации на официальном веб-сайте, голосовой режим в бета-версии уже появился и доступен в приложении Claude. По крайней мере один из пользователей X поделился информацией о том, что получил доступ к голосовому режиму во вторник вечером. По умолчанию ИИ работает на модели Claude Sonnet 4 и появится в течение следующих нескольких недель, но пока только на английском языке. У функции есть и свои ограничения. Голосовые диалоги учитываются в общем лимите запросов. Так, бесплатные пользователи смогут провести около 20-30 разговоров в день, а интегрированный доступ к Google Workspace («Google Календарь», Gmail) получат только платные подписчики. Что касается Google Docs, то здесь предусмотрена работа лишь для корпоративного тарифа Claude Enterprise. Ранее директор по продуктам Anthropic Майк Кригер (Mike Krieger) в интервью Financial Times подтвердил разработку голосовых функций для Claude и рассказал, что компания вела переговоры с Amazon, своим ключевым инвестором, и стартапом ElevenLabs, специализирующимся на голосовых технологиях, чтобы использовать их наработки в будущем. Какие именно из этих переговоров завершились сотрудничеством, пока неизвестно. Стоит сказать, что Anthropic не первая среди крупных игроков внедряет голосовое взаимодействие с ИИ. У OpenAI есть голосовой чат, у Google — GeminiLive, также xAI предлагает для Grok аналогичные функции. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |