|

Опрос

|

реклама

Быстрый переход

AMD раскрыла потенциал Radeon RX 9070 XT новыми драйверами — GeForce RTX 5070 Ti теперь медленнее

02.07.2025 [19:31],

Николай Хижняк

Новый графический драйвер AMD версии 25.6.3 повысил игровую производительность видеокарты Radeon RX 9070 XT, как показывают свежие тесты YouTube-канала Hardware Unboxed. Теперь она опережает модель GeForce RTX 5070 Ti, по крайней мере без трассировки лучей.

Источник изображения: PowerColor Проведённые после дебюта видеокарт игровые тесты показывали, что GeForce RTX 5070 Ti в играх с растровой графикой была примерно на 3 % быстрее Radeon RX 9070 XT. Похоже, что прежние версии драйвера для RX 9070 XT несколько ограничивали её производительность, которую удалось раскрыть свежему программному обеспечению Radeon Software Adrenalin 25.6.3. Причём Nvidia с момента выпуска RTX 5070 Ti тоже успела выпустить несколько версий драйверов GeForce Game Ready, но они не помогли RTX 5070 Ti сохранить лидерство. Напомним, рекомендованная цена Radeon RX 9070 XT на $150 ниже, чем у конкурента — $599 против $750 у RTX 5070 Ti, так что теперь карты AMD стала ещё привлекательнее. Хотя свежий драйвер Radeon Software Adrenalin 25.6.3 в некоторых играх не изменил расстановку сил, в большинстве протестированных Hardware Unboxed игр он сделал RX 9070 XT быстрее RTX 5070 Ti. Наиболее заметная прибавка производительности отмечается в таких играх, как Starfield, Delta Force и CS2, где разница в пользу карты AMD составила более 10 %. Например, в Delta Force карта Radeon теперь на 14 % быстрее конкурента, а в CS2 и Spider-Man Remastered — на 23 и 27 % соответственно. В среднем прибавка производительности Radeon RX 9070 XT с новым драйвером составила 9 % в играх с разрешением 1440p и 4 % в играх с разрешением 4K, говорят данные 16 игровых тестов. Теперь Radeon RX 9070 XT в среднем на 3 % быстрее RTX 5070 Ti в разрешении 1440p и обеспечивает такую же производительность в 4K. Следует ещё раз отметить, что речь идёт о производительности видеокарт в играх с растровой графикой, без использования технологий масштабирования, генераторов кадров и трассировки лучей. Тесты более 200 карт памяти SD выявили пропасть между заявленными и реальными характеристиками

02.07.2025 [17:43],

Дмитрий Федоров

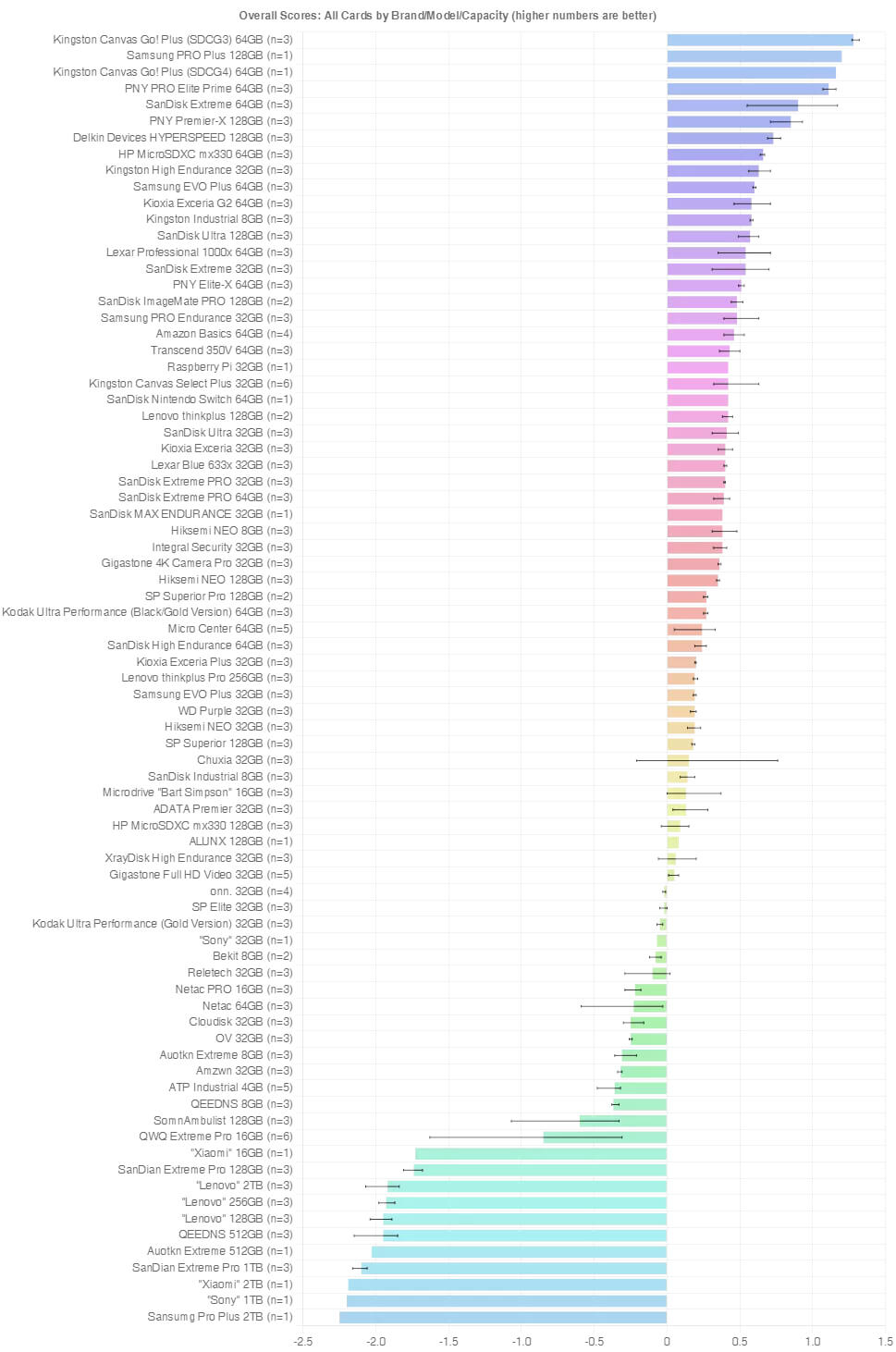

Тестирование более 200 моделей карт памяти SD выявило критические расхождения между их заявленными и реальными характеристиками. В лидерах оказались Kingston и SanDisk, в аутсайдерах — подделки с AliExpress. Некоторые карты, вопреки маркировке, хранили в 4–8 раз меньше данных.

Источник изображения: Denise Jans / Unsplash Исследование, продолжавшееся около двух лет, проводилось энтузиастом Мэттом Коулом (Matt Cole) на двух компьютерах под управлением Linux Ubuntu. Он использовал несколько кард-ридеров и собственную утилиту, которую разработал для тестирования скорости, надёжности и реального объёма около 200 моделей SD-карт различных брендов. Карты памяти Kingston, SanDisk и PNY объёмом 64 и 128 Гбайт показали лучшие результаты. Они стабильно опережали аналоги по скорости последовательного и случайного чтения и записи, а также показывали высокую устойчивость к износу — до 5000 циклов. Для сравнения: подделки часто выходили из строя уже после 2500 циклов и, как правило, были медленнее. Одним из ключевых открытий Коула стали подделки, которые заявляли объём 128 Гбайт, но фактически могли сохранять не более 16–32 Гбайт данных. Такие SD-карты, как правило, «обманывают» операционную систему компьютера, сообщая ей завышенный объём памяти. Примечательно, что и среди подлинной продукции встречались случаи заниженной ёмкости. В число наихудших производителей по этому параметру попали SanDian, Xiaomi, Nenovo и Sony. SD-карты, купленные на Amazon, в среднем показывали существенно более высокие скорости как при последовательной, так и при случайной записи. Даже подлинные карты, купленные через AliExpress, уступали по этим показателям. Коул также разделил устройства на три категории: откровенные подделки, безымянные бренды и подлинная продукция. Некоторые SD-карты безымянных брендов демонстрировали хорошую устойчивость к износу, но уступали по скорости и часто содержали ложные данные о ёмкости. Особенно это важно для профессиональных сценариев, где SD-карта используется как постоянный источник чтения и записи: видеонаблюдение, потоковое видео, дроны.

Источник изображения: bahjeez.com Несмотря на раздельное тестирование по критериям надёжности и скорости, в итоговом рейтинге доминировали одни и те же модели карт. Это позволило составить сводную десятку лучших SD-карт. SanDisk заняла третье место — вопреки ожиданиям, а Lexar, ранее рекомендованная как надёжное решение для карт высокой ёмкости, выпала из топ-10. Этот результат стал для исследователя неожиданным. Коул продолжает тестировать предел выносливости карт в долгосрочном цикле. Его цель — установить, сколько циклов требуется для появления первых признаков деградации SD-карты: от незначительных ошибок до полного выхода из строя. По текущим данным, лучшие модели выдерживают более 5000 полных циклов перезаписи без потери работоспособности, тогда как подделки зачастую ломаются в два раза быстрее. Для специалистов, работающих в критичных сферах, таких как промышленная автоматизация или автономные сенсорные системы, эта информация имеет практическую ценность. Все собранные данные Коул публикует в виде таблицы, которая автоматически обновляется при добавлении новых результатов. Пользователи могут ознакомиться с актуальным рейтингом, а также скачать полные исходные данные на отдельной странице. База служит независимым инструментом оценки качества карт памяти и может существенно снизить риск покупки ненадёжной SD-карты. Коул подчёркивает, что проверка любой SD-карты перед её использованием очень важна. Valve внедрила в клиент Steam панель, различающую реальные и сгенерированные ИИ кадры

01.07.2025 [10:44],

Дмитрий Федоров

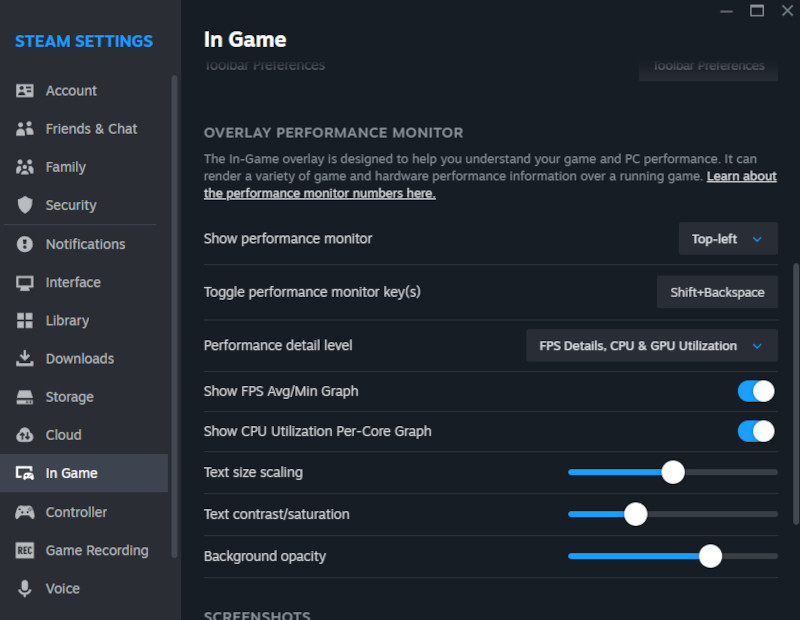

Valve выпустила обновление клиента Steam для Windows, добавив в него расширенный мониторинг производительности, который различает настоящие и сгенерированные ИИ-кадры. Новый инструмент помогает точнее оценить, как технологии DLSS компании Nvidia и FSR компании AMD влияют на визуальную плавность игр и почему высокая частота кадров на экране не всегда соответствует реальному отклику при управлении.

Источник изображений: Steamcommunity Новый мониторинг предоставляет до четырёх уровней детализации: отображение только текущего значения FPS; расширенная информация о частоте кадров; показатели загрузки центрального (CPU) и графического процессоров (GPU); а также полная телеметрия — FPS, загрузка CPU, GPU и объём используемой оперативной памяти. Чем больше параметров включено в информационную панель, тем больше пространства на экране она занимает. Таким образом, игрок может сам выбрать баланс между объёмом нужной информации и удобством визуального восприятия в процессе игры. Ранее Steam предоставлял пользователям только базовый счётчик FPS. Теперь же стало возможным отделять кадры, сгенерированные средствами ИИ, от кадров, полностью отрисованных GPU. Это нововведение помогает точнее понять, почему изображение может казаться плавным, в то время как ощущения от игрового процесса не являются таковыми. В частности, это позволяет пользователям определить, действительно ли игра работает, например, на 30 кадрах/с, или визуальная иллюзия создаётся за счёт добавления «фальшивых» кадров технологиями DLSS или FSR.  В официальной документации поддержки Valve указывает, что технологии генерации кадров, несмотря на визуальные преимущества, не способны повлиять на такие важные характеристики, как входная задержка, особенно актуальную для киберспортсменов. Генерация кадров делает игру визуально более плавной, особенно на мониторах с высокой частотой обновления — от 120 Гц и выше, — но не влияет на то, как быстро игра реагирует на действия пользователя. Поэтому оценка производительности должна учитывать не только количество кадров в секунду, но и способ их появления. Отдельного упоминания заслуживает тот факт, что ранее Valve уже предоставляла пользователям Steam Deck аналогичную функциональность с помощью инструмента MangoHud, который позволял отслеживать загрузку CPU, GPU, использование оперативной памяти и уровень заряда аккумулятора. Однако его использование ограничивалось портативной экосистемой SteamOS. Интеграция мониторинга производительности в настольную версию клиента Steam открывает доступ к этим данным значительно более широкой аудитории — как среди хардкорных игроков, так и среди рядовых пользователей ПК.  Valve уже анонсировала планы по дальнейшему развитию новинки. В будущих версиях компания намерена внедрить дополнительные параметры, позволяющие автоматически определять распространённые сценарии низкой производительности оборудования. Кроме того, в информационной панели будет доступна расширенная сводка о производительности игры, которая появится на экране после нажатия клавиш Shift + Tab. Это позволит оперативно анализировать состояние системы без необходимости прибегать к сторонним инструментам, таким как MSI Afterburner или RivaTuner. Выяснилось, что Intel замедлила свои GPU на 20 % ради безопасности — в Linux уже придумали, как это исправить

23.06.2025 [21:23],

Сергей Сурабекянц

Компания Canonical, разработчик популярного дистрибутива Ubuntu, совместно с Intel планирует отключить ряд защитных механизмов в драйверах для графических решений Intel. Эти изменения коснутся исключительно GPU-вычислений, выполняемых через API OpenCL и Level Zero. По словам разработчиков, эти изменения позволят увеличить вычислительную производительность графической подсистемы примерно на 20 %.  Хотя патчам безопасности Intel по части графики уделяется заметно меньше внимания, чем аналогичным механизмам на стороне центрального процессора, их влияние на производительность оказалось значительно выше, чем предполагалось ранее. По данным из баг-трекера Ubuntu Launchpad, на которые ссылается Phoronix, отключение защитных функций может дать пользователям прибавку до 20 % при работе с задачами, использующими вычисления на GPU. Такой прирост стал возможен за счёт использования опции компиляции NEO_DISABLE_MITIGATIONS, которая отключает встроенные в Intel Compute Runtime защитные механизмы, связанные, в частности, с уязвимостью Spectre. Canonical намерена активировать эту опцию по умолчанию в Ubuntu, начиная с версии 25.10. При этом уточняется, что это изменение коснётся исключительно пакетов Compute Runtime и никак не затронет защитные механизмы ядра Linux или других компонентов операционной системы. Представители Intel и Canonical уже согласовали данные изменения и подтвердили, что потенциальные риски от отключения этих мер безопасности минимальны. Intel даже распространяет свои собственные пакеты Compute Runtime для OpenCL и Level Zero на платформе GitHub уже без включённых защитных механизмов. Согласно официальной позиции обеих компаний, уязвимости типа Spectre для GPU уже достаточно хорошо нейтрализованы на уровне ядра Linux, поэтому повторное применение мер защиты на уровне Compute Runtime нецелесообразно и не даёт ощутимого повышения безопасности. Однако разработчики предупреждают, что теоретически отключение мер защиты может открыть ранее неизвестные векторы атак или выявить скрытые ошибки, которые до этого устранялись существующими мерами безопасности. Несмотря на это, обе компании считают, что риски оправданы заметным приростом производительности, особенно с учётом отсутствия реальных примеров эксплуатации подобных уязвимостей. В настоящее время разработчики Ubuntu активно тестируют изменения с использованием специального PPA-репозитория Launchpad, где уже представлены сборки с отключёнными защитными механизмами. Ожидается, что все изменения будут окончательно внедрены в релиз Ubuntu 25.10. Radeon RX 9070 XT с чипами памяти Samsung работают на 1–2 % медленнее моделей с памятью SK hynix

13.06.2025 [05:42],

Николай Хижняк

Пользователям, желающим приобрести видеокарту AMD Radeon RX 9070 XT, следует тщательнее подходить к вопросу выбора той или иной версии ускорителя. Как показывают тесты, варианты RX 9070 XT, оснащающиеся чипами памяти Samsung, в среднем демонстрируют на 2 % меньше производительности по сравнению с моделями с памятью SK hynix. Однако память Samsung работает с менее высокими температурами.

Источник изображения: Tom's Hardware Китайский энтузиаст с псевдонимом 51972 недавно опубликовал в социальной сети Bilibili результаты масштабного теста 22 версий видеокарт Radeon RX 9070 XT, оснащённых памятью Samsung и SK hynix, сравнив их между собой. Тесты проводились в бенчмарке 3DMark Speed Way. Каждая модель карты, оснащённая памятью Samsung, показала результаты на 1–2 % хуже, чем варианты карт с памятью SK hynix. Даже самые быстрые образцы видеокарт с памятью Samsung показали меньшие результаты самых медленных версий Radeon RX 9070 XT с памятью SK hynix. По словам энтузиаста, он обратился в китайский офис AMD за комментарием, где ему ответили, что разница в быстродействии карт с чипами памяти Samsung и SK hynix заключается в более высоких задержках у чипов памяти Samsung. Китайский энтузиаст не проводил игровых тестов карт с разной памятью. Весьма вероятно, что в реальных сценариях использования эта разница в производительности, как и разница в задержках у видеопамяти может быть не так заметна, как в том же синтетическом бенчмарке, и речь может идти о 58 кадрах в секунду в играх в одном случае и о 60 кадрах в другом. Более ранние тесты также показали, что память Samsung греется при работе значительно меньше. Если чипы памяти SK hynix в видеокартах Radeon RX 9070 XT под нагрузкой могут разогреваться до более чем 85 градусов Цельсия, то память Samsung работает при температурах, не превышающих 75 градусов Цельсия даже в стресс-тестах Furmark. Вышли обзоры «ужасной видеокарты для 1440p» — Radeon RX 9060 XT 8GB сильно отстала от старшей версии

06.06.2025 [18:01],

Николай Хижняк

AMD пошла по стопам Nvidia, выпустив видеокарту Radeon RX 9060 XT в двух версиях: с 8 и 16 Гбайт памяти. И если вариант с 16 Гбайт, как показывают тесты, демонстрирует уверенную конкуренцию с GeForce RTX 5060 Ti с таким же объёмом памяти, то ситуация с версией на 8 Гбайт выглядит совсем иначе. Портал TechSpot провёл сравнительное тестирование Radeon RX 9060 XT 8GB и RX 9060 XT 16GB, отметив значительную разницу в производительности между этими картами. Подтвердил это и YouTube-канал Hardware Unboxed.

Источник изображений: TechSpot В основе обеих версий Radeon RX 9060 XT используется графический процессор Navi 44 на архитектуре RDNA 4 с 32 исполнительными блоками (2048 ядер), 64 ИИ-ускорителями, 32 RT-ядрами, 128 текстурными блоками и 64 блоками растеризации. Однако наличие вдвое меньшего объёма памяти серьёзно сказывается на производительности карты по сравнению с версией на 16 Гбайт. Разница в среднем показателе кадров в секунду (Average) между двумя моделями составила по итогам тестов от 17 % (Doom: The Dark Ages) до 184 % (Indiana Jones and the Great Circle) в зависимости от настроек графики. По показателю минимальных кадров в секунду (1 % low) карты продемонстрировали разницу от 15 % (Dune: Awakening) до невероятных 367 % (Ratchet & Clank: Rift Apart). Стоит добавить, что сравнительные игровые тесты TechSpot проводил в разрешении 1440p. При снижении настроек качества текстур разница в производительности становилась заметно меньше, а в некоторых случаях производительность обеих версий карты выравнивалась. В качестве эксперимента TechSpot дополнительно протестировал две версии Radeon RX 9060 XT на системе, оснащённой старым процессором Intel Core i7-8700K. Эксперимент показал, что такая связка также очень сильно влияет на производительность. Только в данном случае узким местом становится не видеокарта, а процессор. В некоторых игровых тестах счётчик кадров в секунду становился совершенно неиграбельным на системе со старым процессором Intel, а разница по показателю минимального количества кадров в секунду между двумя картами достигала 375 %. Со всеми результатами сравнительных тестов Radeon RX 9060 XT с 8 и 16 Гбайт памяти, предоставленными порталом TechSpot, можно ознакомиться в галерее ниже. Сравнение игровой производительности Radeon RX 9060 XT 16GB и Radeon RX 9060 XT 8GB

Смотреть все изображения (29)

Смотреть все изображения (29) В выводах TechSpot пишет, что, несмотря на поддержку всех линий интерфейса PCIe 5.0 x16, модель RX 9060 XT с 8 Гбайт становится значительно медленнее версии с 16 Гбайт при переполнении буфера VRAM, что в 2025 году сделать очень просто. Использование старых платформ также серьёзно сказывается на производительности модели RX 9060 XT 8GB. А вот влияние на модель с 16 Гбайт оказалось не таким значительным. В Hardware Unboxed карту назвали просто плохой, а также «ужасной видеокартой для 1440p». Первый обзор Radeon RX 9060 XT: в среднем чуть медленнее GeForce RTX 5060 Ti

02.06.2025 [22:34],

Николай Хижняк

Обзоры видеокарты Radeon RX 9060 XT появятся 5 июня, когда новинка поступит в продажу. Однако некоторые медиаресурсы уже подготовили статьи, и информация из них успела просочиться в Сеть. Согласно тестам портала Eteknix, видеокарта Radeon RX 9060 XT обеспечивает весьма высокий уровень производительности для модели верхней части среднего ценового сегмента.

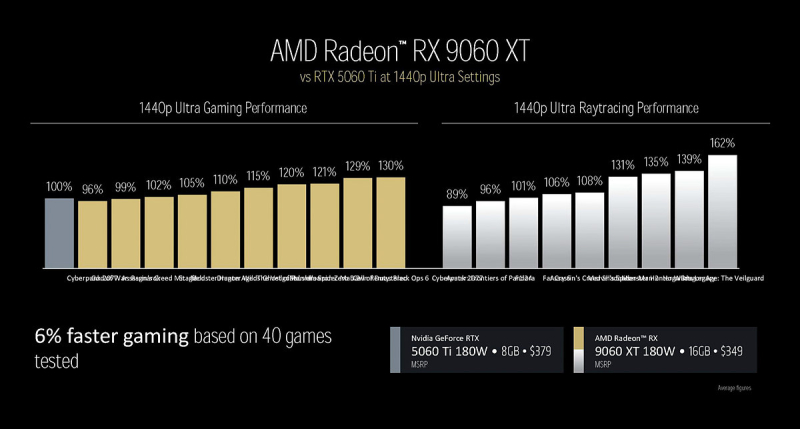

Источник изображения: AMD Новая карта нередко выступает на равных с Radeon RX 7700 XT и даже превосходит её по производительности в разрешении 1080p. Однако 128-битная шина памяти является узким местом Radeon RX 9060 XT, что не позволяет ей в полной мере раскрыться при разрешении 1440p — здесь она уступает модели RX 7700 XT. В обзоре Eteknix использовалась модель Radeon RX 9060 XT с 16 Гбайт памяти. В тестах карта сравнивалась с GeForce RTX 5060 Ti в версии с таким же объёмом памяти. Обе видеокарты представлены в ценовом диапазоне от $349 до $429. По итогам 10 игровых тестов в разрешении 1080p модель Radeon RX 9060 XT 16GB обеспечила более высокий минимальный показатель кадров в секунду (1% Low), но немного уступила GeForce RTX 5060 Ti 16GB по среднему FPS. По усреднённому минимальному FPS новинка Radeon обеспечила 148 кадров в секунду, тогда как RTX 5060 Ti 16GB — 143 кадра, что на 3,5 % меньше. В среднем RX 9060 XT 16GB выдала 187 кадров, RTX 5060 Ti 16GB — 194 кадра. Таким образом, новинка от Radeon оказалась на 3,6 % медленнее. В играх с разрешением 1440p новая Radeon RX 9060 XT 16GB обеспечила минимальный показатель 110 кадров в секунду, что на 7,8 % выше, чем у RTX 5060 Ti 16GB. Однако средний показатель FPS у новинки составил 134 кадра в секунду против 142 у GeForce — это на 5,6 % меньше. В играх с трассировкой лучей (4 игровых теста) карта Radeon была на 10,5 % медленнее по усреднённому минимальному показателю кадров в секунду — 51 кадр против 57 у GeForce. А по среднему значению новинка отставала на 10,1 % — 62 кадра в секунду против 69 у карты Nvidia.

Источник изображения: AMD В обзоре Eteknix участвовала Radeon RX 9060 XT с заводским разгоном GPU. В сравнение не была включена модель RTX 5060 Ti 8GB, которую AMD использовала в своих внутренних тестах. Если верить данным AMD, то по итогам 40 игровых тестов в разрешении 1440p их новинка на 6 % быстрее. Таким образом, AMD позиционирует Radeon RX 9060 XT 16GB как решение для игр в разрешении 1440p. Это стоит учитывать, когда будут опубликованы полноценные обзоры карты. Snapdragon 8 Elite захватил майский топ в AnTuTu — лидирует Red Magic 10S Pro+

02.06.2025 [14:40],

Николай Хижняк

Разработчики популярного бенчмарка AnTuTu опубликовали ежемесячный рейтинг самых производительных флагманских Android-смартфонов по итогам мая 2025 года, составленный на основе результатов тестирования устройств китайскими пользователями. В этот рейтинг включаются устройства, для которых было проведено как минимум 1000 верифицированных тестов в AnTuTu.

Источник изображения: RedMagic В минувшем месяце верхние строчки рейтинга заняли смартфоны на базе процессора Qualcomm Snapdragon 8 Elite. Также в десятке лучших есть модели на чипе MediaTek Dimensity 9400+.

Источник изображения: AnTuTu Лидером рейтинга стал Red Magic 10S Pro+, показавший средний результат 2 951 251 балл. Смартфон оснащён разогнанным процессором Snapdragon 8 Elite, у которого основное ядро работает на частоте 4,47 ГГц, а графический процессор — на частоте 1,2 ГГц. Второе место занял Vivo X200 Ultra с результатом 2 907 396 баллов. Устройство выделяется мощным набором камер с фокусными расстояниями 14, 35 и 85 мм. Несмотря на акцент на фото- и видеовозможности устройства, Vivo X200 Ultra также предлагает очень высокую игровую производительность.

Источник изображения: Vivo С результатом 2 891 558 баллов на третьем месте расположился iQOO Neo 10 Pro+. Он повторяет дизайн предыдущей модели Neo 9 Pro+, предлагает высокую производительность и набор качественных камер. Honor GT Pro, также оснащённый процессором Snapdragon 8 Elite, предлагает высокую производительность, но набрал меньше баллов, чем остальные флагманы на базе этого процессора. Большинство тестов проводилось на модели с 12 Гбайт оперативной и 256 Гбайт постоянной памяти, что, вероятно, снизило средний результат производительности устройства. Выпущенный в мае смартфон Xiaomi 15S Pro на базе фирменного 3-нм процессора Xiaomi Xring O1 в рейтинг не попал. Скорее всего, новинка дебютирует в рейтинге AnTuTu в июне, когда наберётся достаточного количество верифицированных результатов тестов.

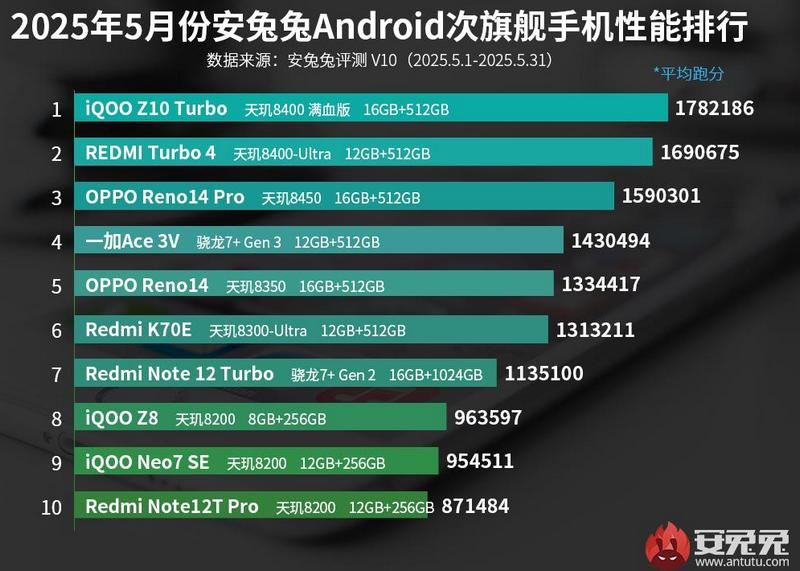

Источник изображения: AnTuTu Что касается смартфонов среднего ценового сегмента, то здесь лидером стал iQOO Z10 Turbo на специальной разогнанной версии чипа MediaTek Dimensity 8400. В целом большую часть этого топ-10 заняли смартфоны на процессорах серии Dimensity 8000, за исключением OnePlus Ace 3V на базе Snapdragon 7+ Gen 3 и Redmi Note 12 Turbo на Snapdragon 7+ Gen 2. Lenovo Legion Go S протестировали c SteamOS вместо Windows 11 — частота кадров выше, потребление ниже

26.05.2025 [20:40],

Николай Хижняк

На выставке CES 2025 в начале года Lenovo показала две версии новой портативной игровой приставки Legion Go S — под управлением Windows и SteamOS. Windows-версия поступила в продажу в феврале. О выпуске версии с SteamOS компания объявила несколько дней назад на выставке Computex 2025. А теперь появились тесты SteamOS-версии. По мнению популярного видеоблогера Дейва Ли (Dave Lee), она заметно быстрее и энергоэффективнее Windows-версии.

Источник изображений: YouTube / Dave2D Тесты YouTube-канала Dave2D показывают, что версия Legion Go S на базе SteamOS гораздо лучше показывает себя в таких играх, как Cyberpunk 2077, Doom Eternal и The Witcher 3, чем версия на Windows. Частота кадров у SteamOS-версии также выше в Helldivers 2, но не так значительно, чем в трёх других играх. Если в Cyberpunk 2077 версия приставки на Windows выдаёт 46 кадров в секунду на низких–средних настройках, то SteamOS-версия демонстрирует 59 кадров в секунду. В Witcher 3 наблюдаются аналогичные результаты — 66 кадров в Windows-версии и 76 у SteamOS-версии. Doom Eternal работает на Windows-версии с 66 кадрами, а на SteamOS-версии — с 76 кадрами. Исключением является Spider Man 2, где частота кадров оказалась ниже у варианта приставки с SteamOS. Время работы от батареи у Legion Go S под управлением SteamOS тоже в целом выше, чем у Windows-версии, хотя обе консоли оснащены одинаковыми батареями на 55 Вт·ч. По мнению Ли, такие результаты связаны с тем, что у Linux (SteamOS) работает меньше фоновых процессов и функций телеметрии, чем в Windows 11. Более высокая энергоэффективность приставки может объясняться тем, что у SteamOS лучше оптимизация режима сна и приостановки фоновых процессов. Legion Go S с SteamOS в большинстве игр также обеспечивает более высокую производительность, чем Steam Deck. Правда, энергопотребление приставки Lenovo выше. Подключенная к электросети Legion Go S с SteamOS потребляет 40 Вт, а Steam Deck всего 15 Вт. Эти тесты подтверждают мнение о том, что Windows на самом деле ограничивает возможность Legion Go S стать серьёзным конкурентом для Steam Deck. С появлением в продаже версии на базе SteamOS консоль Legion Go S стала по-настоящему настоящим конкурентом для популярной игровой приставки от Valve. Цена также играет в пользу версии приставки под управлением SteamOS. Стоимость Legion Go S с Windows составляет выше $700. В свою очередь SteamOS-версия предлагается за $600. Первые независимые обзоры GeForce RTX 5060 — карта морально устарела сразу после выхода

21.05.2025 [21:53],

Николай Хижняк

Видеокарта GeForce RTX 5060 поступила в продажу два дня назад, но её первые полноценные независимые обзоры начинают появляться только сейчас. Почему так произошло, сообщалось в одной из предыдущих публикаций. Одним из первых обзор на самую доступную модель в линейке игровых видеокарт Nvidia Blackwell опубликовал YouTube-канал Hardware Unboxed.

Источник изображений: YouTube / Hardware Unboxed Напомним, что GeForce RTX 5060 построена на графическом процессоре GB206-250 с 3840 ядрами CUDA, что на 25 % больше, чем у RTX 4060. Объём видеопамяти остался прежним — 8 Гбайт, однако теперь используется более быстрая память GDDR7 со скоростью 28 Гбит/с, 128-битной шиной и пропускной способностью до 448 Гбайт/с (против 272 Гбайт/с у RTX 4060). Nvidia заявляет, что прирост «чистой» производительности в растеризации графики достигает 25 % относительно RTX 4060. Игровые тесты Hardware Unboxed подтверждают, что в целом это заявление правдиво. По итогам 18 игровых тестов в разрешении 1080p производительность GeForce RTX 5060 оказалась на уровне GeForce RTX 4060 Ti 8GB предыдущего поколения (но ниже, чем у версии с 16 Гбайт памяти) и GeForce RTX 3070 поколением ранее. В то же время новинка оказалась на 6 % медленнее Radeon RX 7700 XT. По сравнению с предшественницей RTX 4060 новая карта была на 22 % быстрее. В разрешении 1440p по тем же 18 тестам карта также показала результаты, сопоставимые с RTX 4060 Ti 8GB и RTX 3070, обогнала Intel B580 12GB на 6 % и превзошла RTX 4060 на 27 %. Тесты GeForce RTX 5060 в 1080p

Смотреть все изображения (18)

Смотреть все изображения (18) Обозреватели отмечают, что в 1440p у GeForce RTX 5060 в ряде игр наблюдалась острая нехватка видеопамяти при максимальных настройках качества. Из-за этого некоторые текстуры не загружались. Например, в S.T.A.L.K.E.R. 2: Heart of Chornobyl это серьёзно сказалось на производительности — карта выдавала в среднем лишь 6 кадров в секунду. Те же 6 кадров показали RTX 5060 Ti, RTX 4060 Ti 8GB, RTX 3070 и Radeon RX 7600. А RTX 4060 в том же тесте показала всего 4 кадра в секунду. Тесты GeForce RTX 5060 в 1440p

Смотреть все изображения (18)

Смотреть все изображения (18) Следует учитывать, что все вышеуказанные тесты проводились без генератора кадров и DLSS. Причём даже использование мультикадрового генератора, поддерживаемого RTX 5060 (как и всеми видеокартами серии RTX 50), в подобных сценариях, как в S.T.A.L.K.E.R. 2, не поможет — из-за низкой исходной частоты кадров. В играх с трассировкой лучей RTX 5060 оказалась быстрее RTX 4060. Однако прирост не приносит ощутимых выгод из-за общего класса видеокарты (то есть уровня производительности) и ограниченного объёма памяти. Например, в Alan Wake 2 с трассировкой лучей в 1080p новинка оказалась на 20 % быстрее предшественника, но на 14 % медленнее RTX 4060 Ti 8GB. В 1440p частота кадров оказалась ниже комфортного уровня. При использовании масштабирования до 1080p RTX 5060 способна выдать почти 60 кадров в секунду в Cyberpunk 2077 с трассировкой лучей. В 1440p при аналогичных условиях — 38 кадров в секунду. В Marvel’s Spider-Man Remastered RTX 5060 обеспечила 112 кадров в секунду в 1080p с трассировкой лучей — результат, аналогичный RTX 4060 Ti (8 и 16 Гбайт). В 1440p частота снизилась до 109 FPS. Новинка обошла RTX 4060 и 4060 Ti и отстала от RTX 4070 всего на 9 кадров.  Тесты GeForce RTX 5060 в 1440p с трассировкой лучей

Смотреть все изображения (4)

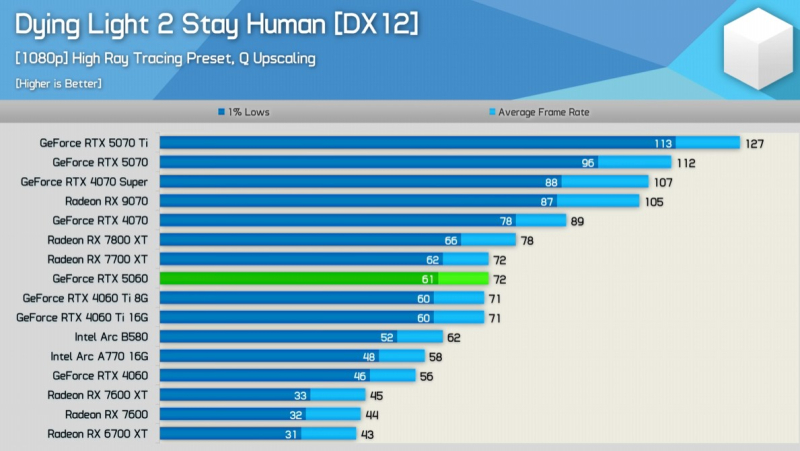

Смотреть все изображения (4) В Dying Light 2 с трассировкой лучей карта оказалась почти на 30 % быстрее RTX 4060 в 1080p. В 1440p результаты сравнялись с Radeon RX 7700 XT и RTX 4060 Ti 8GB. По мнению Hardware Unboxed, GeForce RTX 5060 — морально устаревшая видеокарта. Наличие всего 8 Гбайт памяти в игровом ускорителе 2025 года выглядит, по их словам, почти как «преступление». К сожалению, AMD тоже наступает на те же грабли: сегодня была представлена Radeon RX 9060 XT, включая версию с 8 Гбайт памяти. RTX 5060 могла бы быть гораздо более привлекательной, если бы оснащалась хотя бы 12 Гбайт. Для соревновательных онлайн-игр новинка вполне подойдёт. Не исключено, что со временем она станет лидером по популярности в Steam, но когда это произойдёт — неизвестно. Hardware Unboxed подводит итог: GeForce RTX 5060 не рекомендуется к покупке. По сути, это RTX 4060 Ti 8GB, выпущенная два года назад, но со скидкой 25 %, или RTX 3070, выпущенная пять лет назад, но со скидкой 40 %. Видеокарта, которая обогнала RTX 5090 в играх: первые тесты Nvidia RTX Pro 6000 Blackwell Workstation Edition

15.05.2025 [18:23],

Николай Хижняк

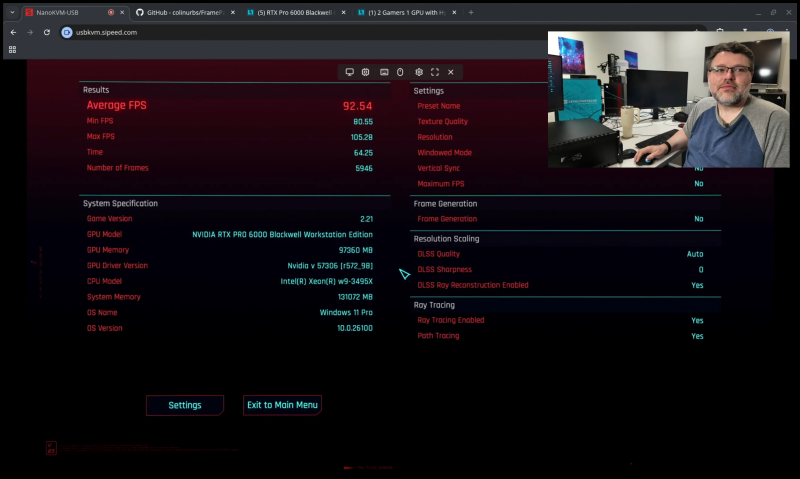

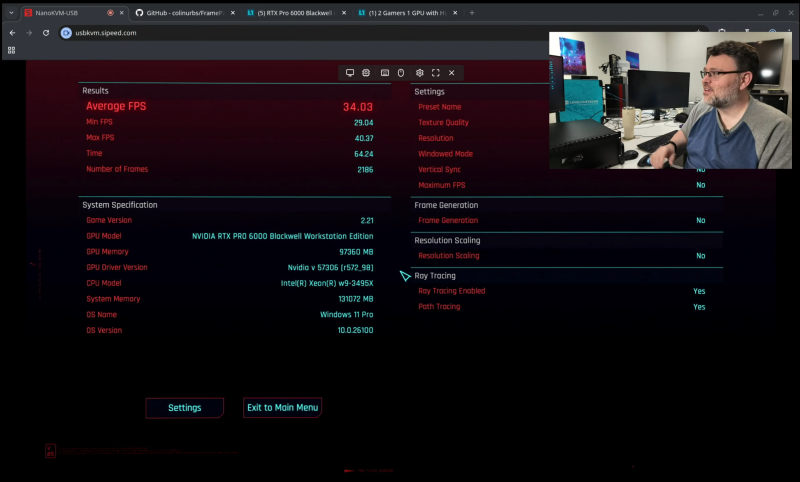

Nvidia RTX Pro 6000 Blackwell Workstation Edition с 96 Гбайт памяти представляет собой дорогую профессиональную видеокарту, так что мы вряд ли увидим её полноценный обзор с тестами в играх. Тем не менее первые покупатели этого профессионального ускорителя за $8000, протестировали новинку в синтетических тестах 3DMark, а также в игре Cyberpunk 2077.

Источник изображений: Reddit / privaterbok Напомним, что в составе Nvidia RTX Pro 6000 Blackwell Workstation Edition используется полноценный графический процессор GB202 с 24 064 ядрами CUDA. В игровой GeForce RTX 5090 также используется чип GB202, но с 21 760 ядрами CUDA. Заявленное энергопотребление RTX Pro 6000 Blackwell Workstation Edition составляет 600 Вт, у RTX 5090 — 575 Вт. Следует отметить, что Nvidia поддерживает многих независимых разработчиков ИИ специальными грантами, позволяющими приобрести Nvidia RTX Pro 6000 Blackwell Workstation Edition за $5000, тогда как розничная цена новинки превышает $8000. Участник форума Reddit под псевдонимом Privaterbok приобрёл Nvidia RTX Pro 6000 Blackwell Workstation Edition и протестировал карту в 3DMark со стандартными и разогнанными настройками. В стандартной конфигурации карта оказалась на 9–10 % быстрее RTX 5090. После умеренного разгона разница увеличилась до 14 % в пользу профессионального ускорителя. Для Nvidia RTX Pro 6000 Blackwell Workstation Edition требуется специальная версия драйвера. Иными словами, карта не поддерживает ряд игровых функций и оптимизаций, предлагаемых драйверами GeForce Game Ready для потребительских видеокарт. Ниже представлены результаты тестирования карты в бенчмарках 3DMark. YouTube-канал Level1Techs также получил Nvidia RTX Pro 6000 Blackwell Workstation Edition и провёл тесты, в основном ориентированные на рабочие ИИ-нагрузки. Однако карту также протестировали в игре Cyberpunk 2077.

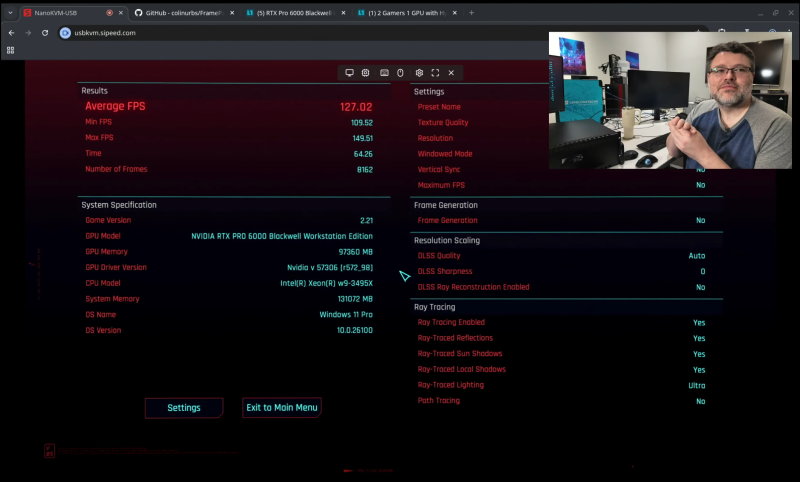

Источник изображения: Level1Techs При максимальных настройках качества графики в разрешении 4K, с включённым DLSS 4 (модель «трансформер») в режиме «Авто» и максимальной трассировкой лучей (RTX Ultra), карта выдала в встроенном игровом бенчмарке в среднем 127 кадров в секунду.

Источник изображения: Level1Techs При включении трассировки пути (path tracing) производительность в среднем составила 92 кадра в секунду.

Источник изображения: Level1Techs При отключении технологии масштабирования DLSS 4 и сохранении прежних настроек качества и трассировки, карта обеспечила в тесте 34 кадра в секунду. Вышли обзоры Radeon RX 9070 GRE — чуть медленнее GeForce RTX 5070

07.05.2025 [13:43],

Николай Хижняк

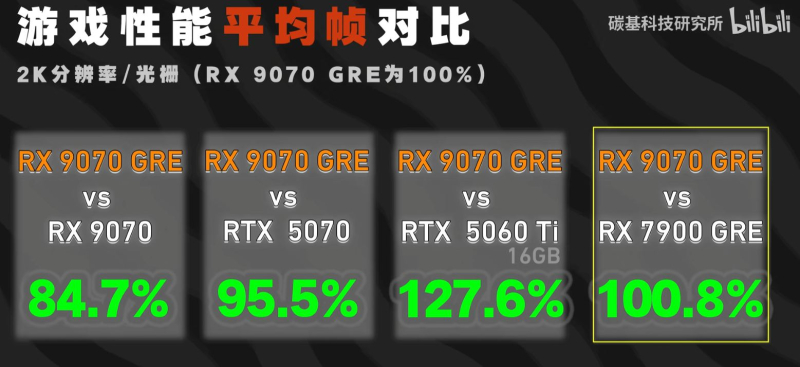

Завтра начнутся продажи видеокарты Radeon RX 9070 GRE. Однако, в отличие от моделей RX 9070 XT и RX 9070, выпущенных в марте, модель RX 9070 GRE будет доступна не во всех регионах мира. Новинку можно будет приобрести эксклюзивно в Китае. Местные обозреватели уже составили свои первые впечатления о новой карте.

Источник изображения: Expreview В основе Radeon RX 9070 GRE используется GPU Navi 48 с 3072 потоковыми процессорами, что на 15 % меньше, чем у модели RX 9070. Карта получила 12 Гбайт памяти GDDR6 с поддержкой 192-битной шины, что привело к снижению пропускной способности памяти на 33 %. AMD оценила Radeon RX 9070 GRE в 4199 юаней ($587), что на 7 % дешевле версии RX 9070.

Относительная производительность. Источник изображения: Carbon Based Technology Согласно китайским обозревателям, RX 9070 GRE обеспечивает производительность уровня Radeon RX 7900 GRE и GeForce RTX 5070. Как и всегда, производительность карты зависит от игровых настроек, разрешения и конкретных тестов, выбранных обозревателями.

Источник изображения: 163 Хотя AMD заявляет, что RX 9070 GRE обеспечивает на 6 % более высокую производительность по сравнению с RX 7900 GRE в разрешении 1440p, обзоры демонстрируют иную картину. В реальности новая карта лишь соответствует уровню RX 7900 GRE и RTX 5070. Обозреватели также отмечают, что новинка заметно быстрее GeForce RTX 5060 Ti 16GB. Однако последняя стоит дешевле — 3599 юаней (около $500). «Во многих игровых тестах RX 9070 GRE показала себя на уровне RTX 5070. В сравнении с RTX 5060 Ti 16GB карта Radeon одерживает победу — преимущество новинки составляет до 24 %. В тестах Far Cry 6 и F1 24 разница в производительности между RX 9070 GRE и RTX 5070 составила всего несколько кадров. Если не быть слишком придирчивым, то обе карты обеспечили одинаковый уровень быстродействия. Тесты с трассировкой лучей у RX 9070 GRE нас удивили. В Cyberpunk 2077, игре, где обычно карты GeForce имеют значительное преимущество, Radeon RX 9070 GRE показала практически такой же уровень производительности, что и RTX 5070. А в Assassin’s Creed: Shadow и F1 24 оказалась даже быстрее», — пишет Expreview.

Источник изображения: 163 В целом AMD выпустила неплохую карту, заключили обозреватели, однако их не впечатлило соотношение её стоимости и производительности. В отличие от моделей RX 9070 XT и RX 9070, для которых компания выставила более агрессивные цены, в этот раз AMD не оказывает такого давления на конкурентов. На данный момент у AMD нет планов по выпуску RX 9070 GRE на глобальный рынок. Но если компания всё же решит это сделать, ей, вероятно, придётся снизить цену на эту карту, как это было в случае с моделью RX 7900 GRE. Ещё один повод избегать GeForce RTX 5060 Ti 8GB: карта «задыхается» без PCIe 5.0

05.05.2025 [22:46],

Николай Хижняк

Портал ComputerBase недавно протестировал видеокарту GeForce RTX 5060 Ti с 8 Гбайт памяти и выявил ещё одну проблему этого ускорителя. Карта оказалась чувствительна к версии интерфейса PCIe, к которому подключается: новинка работает заметно медленнее с PCIe 4.0, чем с PCIe 5.0.

Источник изображения: VideoCardz В рамках 27 игровых тестов, проведённых ComputerBase, GeForce RTX 5060 Ti 8GB демонстрировала уровень, сопоставимый с GeForce RTX 5060 Ti 16GB, лишь в 12 из них. Ещё в 11 играх наблюдались «незначительные» проблемы: снижение FPS до 19 % по сравнению со старшей моделью. В оставшихся 9 играх сказался недостаток памяти, из-за чего фиксировались значительные потери производительности, либо игры вовсе становились неиграбельными. Однако одной лишь нехваткой памяти младшая карта не ограничилась. ComputerBase также установил, что переход с PCIe 5.0 x8 на PCIe 4.0 x8 (карта использует всего восемь линий PCIe) приводит к значительному снижению производительности RTX 5060 Ti 8GB в играх. У модели RTX 5060 Ti с 16 Гбайт такой проблемы не наблюдается, поскольку она располагает достаточным объёмом памяти, чтобы избежать частой подкачки игровых ресурсов. В свою очередь, модель RTX 5060 Ti 8GB в большей степени зависит от пропускной способности интерфейса PCIe из-за ограниченного буфера памяти, что дополнительно ухудшает её производительность. «И это также отразилось в наших тестах. GeForce RTX 5060 Ti 8 GB при подключении к PCIe 5.0 была в среднем на 14 % (по среднему показателю FPS) — до 17 % (по 1-процентному процентилю) быстрее, чем при подключении к PCIe 4.0. В отдельных случаях влияние было ещё заметнее. И речь идёт не о сценариях, когда карта испытывала проблемы даже при подключении к PCIe 5.0 – неиграбельное остаётся неиграбельным», — пишет Computer Base. Портал отмечает, что всё это приводит к необычным ситуациям, когда определённые игры при определённых настройках, запущенные на RTX 5060 Ti 8GB, могут демонстрировать низкую производительность на PCIe 5.0 и быть полностью неиграбельными на PCIe 4.0. Рекомендация обозревателей вполне однозначна: избегать GeForce RTX 5060 Ti 8GB, особенно в сочетании с интерфейсом PCIe 4.0. Intel раскрыла потенциал встроенной графики Core Ultra 200V — свежий драйвер повысил FPS на 10 % и не только

30.04.2025 [12:44],

Николай Хижняк

Intel раскрыла игровой потенциал встроенной графики процессоров Core Ultra 200V (Lunar Lake). Благодаря новому графическому драйверу её производительность в играх выросла в среднем на 10 %, а в отдельных случаях наблюдается куда более значительная прибавка.

Источник изображений: Intel В качестве примера Intel привела результаты девяти игровых тестов портативной игровой приставки MSI Claw 8 AI+, в которой используется процессор Core Ultra 7 258V (четыре P-ядра Lion Cove и четыре E-ядра Skymont) с графикой Arc 140T. По словам Intel, в среднем производительность графического процессора Arc 140T в составе Core Ultra 7 258V выросла на 10 %, а по показателю 99-го перцентиля — на 25 %. Последний показатель более важен, поскольку указывает на снижение просадок FPS и более плавной работе игры. Стоит отметить, что это сравнение производительности Intel проводила между драйверами версий 6732 и 6734. Это не самые свежие драйверы, поскольку компания уже выпустила версию 6737. Однако MSI является OEM-производителем и проводит проверку новых драйверов самостоятельно, что задерживает выпуск самых последних версий. Intel подтвердила, что версия драйвера 6734 уже доступна для 8-дюймовой приставки Claw 8 AI+ и 7-дюймовой Claw 7 AI+. Новые игровые тесты показали пропасть в производительности между разными версиями GeForce RTX 5060 Ti

22.04.2025 [15:51],

Николай Хижняк

Nvidia приложила все усилия, чтобы обзоры видеокарты GeForce RTX 5060 Ti 8GB увидело как можно меньше потенциальных покупателей. Компания не предоставила образцы для тестирования, поэтому профильным обозревателям пришлось приобретать эти карты за свой счёт — уже после выпуска видеокарты, который формально состоялся одновременно с моделью RTX 5060 Ti 16GB. Австралийский YouTube-канал Hardware Unboxed смог приобрести одну из таких видеокарт и провести игровые тесты.

Источник изображений: Hardware Unboxed GeForce RTX 5060 Ti 8GB полностью повторяет характеристики версии с 16 Гбайт памяти. В составе видеокарты используется графический процессор GB206-300 с 4608 ядрами CUDA, 144 текстурными блоками, 48 блоками растеризации и 36 RT-ядрами. Однако именно вдвое меньший объём доступной видеопамяти GDDR7 серьёзно сказывается на производительности по сравнению с моделью на 16 Гбайт. Разница по минимальному FPS (1% low) в некоторых случаях достигает колоссальных 589 %. Там, где RTX 5060 Ti 16GB выдаёт 68 кадров в секунду, модель RTX 5060 Ti 8GB едва обеспечивает 16 кадров. Ярким примером служит игра Horizon Forbidden West, запущенная в 4K с DLSS (режим «Производительность») и очень высокими настройками качества. В других играх ситуация лучше, но не намного, что подтверждает сводная таблица производительности двух версий карты ниже. Разница в среднем FPS между видеокартами в различных играх составила от 12 до 350 %. По мнению Hardware Unboxed, GeForce RTX 5060 Ti 8GB устарела сразу же из-за ограниченного объёма видеопамяти. В игре Indiana Jones and the Great Circle карта с 8 Гбайт памяти отказалась работать: при разрешении 1080p и максимальных настройках качества игра вылетела, вероятно, из-за нехватки памяти. В то же время GeForce RTX 5060 Ti 16GB в этих условиях выдавала около 95 кадров в секунду. Hardware Unboxed также протестировал видеокарты в играх Space Marine 2, A Plague Tale: Requiem, Assassin’s Creed Shadows, Cyberpunk 2077, Marvel Rivals, Spider-Man 2, Star Wars Jedi: Survivor 2, Alan Wake 2, God of War: Ragnarok и Black Myth: Wukong. В некоторых играх у RTX 5060 Ti 8GB из-за нехватки памяти наблюдались проблемы с прорисовкой текстур. Тем не менее, даже у GeForce RTX 5060 Ti 8GB может найтись своё применение — в киберспортивных дисциплинах, которые, как правило, предъявляют невысокие требования к графической подсистеме и могут работать на этой карте столь же стабильно, как и на модели с 16 Гбайт памяти. В целом GeForce RTX 5060 Ti 8GB способна обеспечить приемлемый уровень FPS в современных играх, однако в большинстве случаев придётся вручную снижать настройки графики и разрешение. Как отмечает Hardware Unboxed, поскольку GeForce RTX 5060 Ti использует интерфейс PCIe 5.0 всего с восемью линиями, при установке карты в систему с PCIe 4.0 или PCIe 3.0 следует ожидать дополнительного снижения производительности. |