|

Опрос

|

реклама

Быстрый переход

ИИ научился распознавать эмоции животных по выражению морды

17.02.2025 [04:29],

Дмитрий Федоров

Учёные разработали ИИ-системы, способные выявлять боль, стресс и заболевания у животных посредством анализа фотографий их морды. Британский ИИ Intellipig распознаёт дискомфорт у свиней, а ИИ-алгоритмы Израильского университета в Хайфе (UH) обучены определять стресс у собак. В эксперименте, проведённом в Университете Сан-Паулу (USP), ИИ продемонстрировал точность до 88 % при выявлении болевых реакций у лошадей. Эти технологии могут преобразить ветеринарную диагностику и значительно повысить уровень благополучия животных.

Источник изображения: Virginia Marinova / Unsplash Система Intellipig, разработанная английскими учёными из Университета Западной Англии в Бристоле (UWE Bristol) совместно с шотландскими исследователями из Шотландского сельскохозяйственного колледжа (SRUC), предназначена для мониторинга состояния свиней на фермах. ИИ анализирует фотографии морды животных, выявляя три ключевых маркера: боль, недомогание и эмоциональное расстройство. Фермеры получают автоматические уведомления, что позволяет оперативно реагировать на ухудшение состояния животных и повышать эффективность сельскохозяйственного производства. Параллельно исследовательская группа из UH адаптирует технологии машинного обучения для работы с собаками. Ранее учёные разработали ИИ-алгоритмы, используемые в системах распознавания лиц, для поиска потерявшихся питомцев. Теперь эти алгоритмы применяются для анализа мимики животных с целью выявления признаков дискомфорта. Выяснилось, что 38 % мимических движений у собак совпадает с человеческими, что открывает новые возможности для изучения их эмоционального состояния. Традиционно подобные ИИ-системы полагаются на человека, который выполняет предварительную работу по определению значений различных форм поведения животных, основываясь на длительных наблюдениях за ними в различных ситуациях. Однако недавно в USP был проведён эксперимент, в котором ИИ самостоятельно анализировал фотографии лошадей, сделанные до и после хирургического вмешательства, а также до и после приёма обезболивающих препаратов. ИИ изучал глаза, уши и рот лошадей, определяя наличие болевого синдрома. Согласно результатам исследования, ИИ сумел выявить признаки, указывающие на боль, с точностью 88 %, что подтверждает эффективность такого подхода и открывает перспективы для дальнейших исследований. Google научила ИИ распознавать эмоции — у этого могут быть ужасные последствия

06.12.2024 [00:52],

Николай Хижняк

Google заявила, что её новое семейство ИИ-моделей обладает любопытной чертой — способностью «распознавать» эмоции. По словам компании, семейство ИИ-моделей PaliGemma 2, представленное в четверг, может анализировать изображения, позволяя ИИ генерировать подписи и отвечать на вопросы о людях, которых он «видит» на фотографиях.

Источник изображений: Google «PaliGemma 2 генерирует подробные, контекстно релевантные подписи для изображений, выходя за рамки простой идентификации объектов, чтобы описывать действия, эмоции и общее повествование сцены», — пишет Google в своём официальном блоге. Для распознавания эмоций PaliGemma 2 необходимо настроить соответствующим образом. Без этого он не работает. Однако эксперты, с которыми пообщались журналисты портала TechCrunch, были встревожены перспективой появления общедоступного детектора эмоций. «Меня это очень беспокоит. Для меня проблематично считать, что мы можем “читать” эмоции людей. Это как просить совета у магического шара предсказаний (Magic 8 Ball, популярная игрушка, — прим. ред.) для решения серьёзных вопросов», — отметила в разговоре с TechCrunch Сандра Вахтер (Sandra Wachter), профессор этики данных и ИИ из Оксфордского института исследования Интернета. Технологические компании, занимающиеся развитием ИИ, годами пытаются создать искусственный интеллект, способный определять эмоциональные аспекты в любых вещах — начиная от обучения продажам и заканчивая задачами, связанными с предотвращением несчастных случаев. Разработка большинства детекторов эмоций базируется на ранних работах американского психолога Пола Экмана (Paul Ekman), который предположил, что у людей есть шесть основных типов эмоций: гнев, удивление, отвращение, удовольствие, страх и грусть. Однако последующие исследования этого вопроса поставили под сомнение гипотезу Экмана и показали, что существуют серьёзные различия в том, как представители разных слоёв общества выражают свои чувства. «Определение эмоций в каком-то универсальном общем случае невозможно, потому что люди испытывают эмоции сложным образом. Нам кажется, что, глядя на людей, мы можем определить, что они чувствуют. И этим приёмом на протяжении многих лет пытались пользоваться разные люди, в том числе разведывательные органы и рекламные компании. Я уверен, что в некоторых случаях абсолютно возможно обнаружить некоторые общие признаки, но это не то, о чём идёт речь и не то, для чего в конечном итоге можно найти универсальный ответ», — сказал специализирующийся на ИИ научный сотрудник Лондонского университета королевы Марии Майк Кук (Mike Cook) в интервью TechCrunch. Эксперты считают, что системы обнаружения эмоций, как правило, ненадёжны и предвзяты из-за особенностей взглядов самих разработчиков таких систем. В исследовании Массачусетского технологического института 2020 года учёные показали, что модели для анализа лиц могут формировать непреднамеренные предпочтения для определённых лицевых выражений, таких как улыбка. Более поздние исследования показывают, что модели анализа эмоций приписывают больше негативных эмоций лицам темнокожих людей, чем лицам белых людей. Google заявляет, что провела «обширное тестирование» для оценки демографических предубеждений у PaliGemma 2 и обнаружила «значительно более низкий уровень токсичности и ненормативной лексики» по сравнению с отраслевыми бенчмарками. Однако компания не предоставила полный список использованных бенчмарков и не указала, какие типы тестов проводились. Единственный бенчмарк, о котором рассказала Google, — это FairFace, состоящий из набора десятков тысяч портретов людей. Компания утверждает, что PaliGemma 2 показала хорошие результаты при оценке FairFace. Но некоторые эксперты раскритиковали бенчмарк за его предвзятость, отметив, что в FairFace представлены далеко не все расовые группы, а лишь несколько. «Интерпретация эмоций — это довольно субъективный вопрос, который выходит за рамки использования визуальных средств и тесно связан с личным и культурным контекстом. Если не брать в расчёт ИИ, исследования показывают, что мы не можем распознавать эмоции только по чертам лица», — говорит Хайди Кхлааф (Heidy Khlaaf), главный научный сотрудник по ИИ в AI Now Institute, некоммерческой организации, изучающей социальные последствия искусственного интеллекта. В ЕС использование систем распознавания эмоций вызвало серьёзные вопросы у регулирующих органов. Закон об ИИ, основной законодательный акт ЕС в области ИИ, запрещает школам и работодателям использовать детекторы эмоций. Однако он не запрещает их использование правоохранительными органами.

Источник изображения: Unsplash Главное опасение экспертов, относительно открытых ИИ-моделей, таких как PaliGemma 2, которая распространяется через различные источники, включая платформу разработки ИИ Hugging Face, заключается в возможности злоупотребления и неправильности их использования, что может привести к реальному вреду. «Если эта так называемая “эмоциональная идентификация” основана на псевдонаучных предубеждениях и предрассудках, то существует значительный риск последствий в том, как эта возможность может быть использована для последующей и ложной дискриминации различных маргинализированных групп правоохранительными органами, работодателями, пограничными службами и т. д.», — говорит Кхлааф. В Google же говорят, что компания тестирует свои ИИ-модели на предрасположенность к «репрезентативный вреду» (стереотипам о социальных группах, например, расовых, этнических, гендерных или религиозных, которые приводят к отрицательным последствиям для этих групп и их представителей). «Мы провели надёжную оценку моделей PaliGemma 2 с точки зрения этики и безопасности, включая безопасность детей и безопасность контента», — добавили в компании. Профессора этики данных и ИИ в Оксфордском институте Интернета Сандру Вахтер такой ответ компании не убедил: «Ответственные инновации — это когда вы думаете о последствиях их разработки с первого дня работы над ними, каждый раз, когда вы входите в свою лабораторию, а затем продолжаете делать это на протяжении всего жизненного цикла продукта. Я могу представить себе множество потенциальных проблем, которые могут создать такие модели и в конечном итоге привести к антиутопичному будущему, в котором ваши эмоции будут определять, получите ли вы работу, кредит и поступите ли в университет». Потные ладошки позволят гаджетам угадать эмоциональное состояние человека и оказать ему поддержку

30.11.2024 [16:04],

Геннадий Детинич

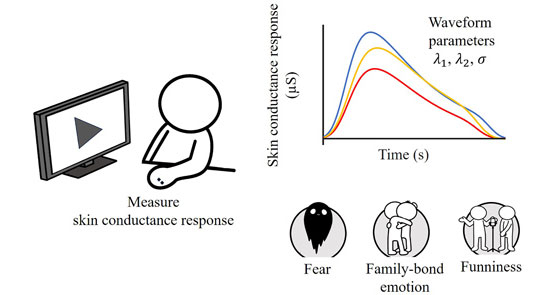

Не секрет, что электропроводность кожи зависит от степени её потоотделения и отражает также динамику эмоционального состояния человека. Когда-нибудь носимые гаджеты смогут предугадывать эмоции и начнут морально поддерживать владельцев, но этому предстоит научное изучение вопроса, как эмоции соотносятся с проводимостью кожного покрова. Японские учёные впервые провели изучение динамики влияния эмоций на скорость и сохранность проводимости кожи.

Источник изображения: Tokyo Metropolitan University Команда Токийского столичного университета привлекла группу добровольцев, которым последовательно показывала фрагменты из фильмов-ужасов, сцен о семейной жизни и выступления стендап-комиков. В каждом случае проводились точные измерения электропроводности кожи рук (ладоней) и динамики проявления сигналов от начала до затухания. На основе измерений были построены графики, которые дали достаточно пищи для размышлений и организации новых экспериментов. Например, было отмечено, что связанные со страхом сигналы продолжались дольше всего, что, вероятно, обусловлено эволюционным развитием человека — чем сильнее напуган, тем больше вероятность спастись. Эмоции от наблюдения семейных сцен имели самую пологую наклонную роста. Учёные объяснили это смесью эмоций, которые мешают друг другу в процессе ощущения момента. Также было определено, что отклик в проводимости кожи наступал с задержкой от 1 до 3 секунд после выражения эмоции. В любом случае, собранные данные позволяют считать, что эмоции можно определять с помощью датчиков на коже человека. Пока говорить об этом рано, но в перспективе предложенное решение позволит убрать из уравнения определения эмоции человека камеры слежения, и сделает эту операцию доступной умным часам или фитнес-браслетам. Правильное определение текущего эмоционального состояния человека поможет оказать ему автоматическую поддержку, что в ряде случаев может сыграть решающую роль в его судьбе. Casio представила пушистого робота Moflin — он поможет побороть стресс за $400

12.10.2024 [10:56],

Павел Котов

Casio открыла предварительные заказы на пушистого роботизированного питомца Moflin. Он не ходит за хозяином по дому, а выполняет антистрессовую функцию: его держат в руках и обнимают, а тот налаживает с владельцем нечто вроде эмоциональной связи, которая выражается уникальными звуками и движениями.

Источник изображений: casio.com Разработка игрушки велась при участии японского стартапа Vanguard Industries, но производством и распространением занимается теперь только Casio. Стоимость Moflin по предварительному заказу составляет 59 400 японских иен ($398), в продажу робот поступит 7 ноября. Casio предлагает также подписку Club Moflin за 6600 иен ($44) в год — в эту сумму входят скидка на ремонт, чистку и даже полную замену мехового покрытия.  Casio Moflin — это не игрушка вроде Sony Aibo, а антистрессовое устройство. Когда его держат на руках, он двигает телом и головой, будто пытается прижаться к хозяину; у робота есть и некоторые функции искусственного интеллекта. Moflin со временем пытается по голосу и манере обращения распознать человека, который взаимодействует с ним больше всего, и выделяет отношение к нему уникальными звуками и движениями, имитируя эмоциональную связь.  У робота также развиваются собственные симулированные чувства и личность, которые могут со временем меняться. При регулярном взаимодействии он выражает счастье, спокойствие и защищенность. Если же Moflin игнорировать, он начнёт изображать напряжение, тревожность и грусть, хотя и не станет досаждать этим владельцу. Определить его эмоциональный настрой наверняка можно через мобильное приложение, оно же позволяет регулировать громкость издаваемых им звуков.  Ещё сильнее усиливает иллюзию того, что Moflin является живым существом, отсутствие необходимости подключать к нему кабель. Робот поставляется с небольшой кроваткой, в которой он «спит» во время зарядки. Полностью заряженной батареи Casio Moflin хватит на пять часов работы; зарядка занимает три с половиной часа. Разработан ИИ, распознающий эмоции человека по голосу — он поможет в работе кризисных линий

01.05.2024 [16:47],

Павел Котов

Модель искусственного интеллекта оказалась эффективным инструментом для выявления таких эмоций как страх и беспокойство в голосах людей, которые звонят на телефонные линии психологическом помощи. Автор проекта надеется, что она окажется полезной для телефонных операторов на линиях по предотвращению самоубийств.

Источник изображения: The_BiG_LeBowsKi / pixabay.com Оценка эмоционального состояния звонящих на кризисные телефонные линии на предмет текущего уровня суицидального риска имеет решающее значение для выявления и предотвращения самоубийств. Речь человека способна при помощи невербальных средств передавать полезную информацию о психическом и эмоциональном состоянии человека, содержа подсказки о том, испытывает он грусть, злобу или страх. Исследования суицидальной речи начались более 30 лет назад — уже удалось выявить в ней объективные звуковые признаки, которые можно использовать для определения различных психических состояний и расстройств, включая депрессию. Но для человека, слушающего собеседника по телефону, оценка риска самоубийства может оказаться сложной задачей, потому что на кризисные линии звонят люди, пребывающие в крайне эмоционально нестабильном состоянии, и характеристики их речи могут быстро меняться. Решение этой задачи предложил Алаа Нфисси (Alaa Nfissi), аспирант университета Конкордия (Канада, г. Монреаль). Он обучил распознаванию речевых эмоций модель ИИ. Обычно такую оценку проводили психологи, из-за чего она требовала значительных временных затрат и опыта, но модель глубокого обучения оказалась способной эффективно распознавать эмоции. Для обучения модели автор проекта использовал базу реальных записей звонков на кризисные линии для предотвращения самоубийств, а также записи актёров, которым было поручено изображать определённые эмоции. Записи были разбиты на сегменты и снабжены аннотациями, отражающими соответствующее состояние психики: злость, грусть, нейтральное состояние, страх или беспокойство. В результате модель научилась достаточно точно распознавать четыре эмоции: страх/беспокойство (правильный ответ в 82 % случаев), грусть (77 %), злость (72 %) и нейтральное состояние (78 %). Особенно хорошо модель справлялась с оценкой фрагментов записей настоящих звонков: грусть (78 %) и злость (100 %). Алаа Нфисси считает, что разработанная им модель ИИ сможет использоваться в качестве вспомогательного инструмента для работы на кризисных линиях, помогая операторам в реальном времени оценивать состояние собеседников и выбирать подходящие стратегии разговора. Возможно, это будет способствовать предотвращению самоубийств. ИИ научился считывать эмоции и оказался на 82 % убедительнее человека в споре

02.04.2024 [15:44],

Павел Котов

Нейросеть GPT-4 оказалась более способной переубеждать человека, чем живой собеседник, показало проведённое швейцарскими учёными исследование. Тем временем американская компания Hume AI представила систему искусственного интеллекта, которая оценивает эмоциональное состояние человека по его голосу.

Источник изображения: D koi / unsplash.com Учёные Федеральной политехнической школы Лозанны (Швейцария) оценили способность большой языковой модели OpenAI GPT-4 к убеждению человека. Для этого они привлекли 820 добровольцев, которых опросили на различные темы: от нейтральных, например, стоит ли оставлять монеты в обращении, до достаточно острых, связанных с гендерным и расовым неравенством. Зафиксировав исходные позиции участников, их попросили провести серию пятиминутных дебатов против других людей и GPT-4, после чего их снова опросили, чтобы понять, изменили ли они свои мнения в результате разговора. В дискуссиях с другими людьми участники по большей мере лишь укрепили свои убеждения, тогда как GPT-4 выступил на 21 % успешнее. На втором этапе исследователи предоставили людям и нейросети дополнительную информацию об оппонентах: их пол, возраст, расу, образование, статус занятости и политические убеждения — и проинструктировали их использовать эту информацию, чтобы подготовить аргументы специально для собеседников. Человеку эти данные только усложнили задачу, тогда как ИИ применил их с большей эффективностью, превзойдя живых соперников уже на 81,7 %. Возможно, ИИ действительно имеет шансы стать мощным инструментом убеждения, и его способности адаптироваться к собеседнику только возрастут, если у нейросети появится доступ к эмоциональному состоянию человека в реальном времени. И это тоже не научная фантастика: на минувшей неделе компания Hume AI анонсировала систему Empathic Voice Interface (EVI). Она представляет собой языковую модель, которая отслеживает эмоциональное состояние собеседника по параметрам его голоса — то есть читает между строк и извлекает дополнительный контекст диалога. EVI не только пытается точно определить чувства человека, но и соответствующим образом подстраивает интонации собственного голосового синтезатора. И это не единственный продукт подобного рода у Hume AI. Другие разработанные компанией модели с доступом к камере считывают выражения лица человека, его движения, а также отслеживают его реакции на происходящее. «Яндекс» научил ИИ распознавать человеческие эмоции

14.03.2024 [13:23],

Павел Котов

«Яндекс» представил нейросеть, способную распознавать эмоции человека во время разговора. Она поможет в работе голосовых помощников и виртуальных операторов кол-центров, пишет «Коммерсантъ» со ссылкой на разработчиков системы.

Источник изображения: The_BiG_LeBowsKi / pixabay.com Созданная «Яндексом» нейросеть распознаёт нецензурную лексику, отмечает неформальные и негативные высказывания, идентифицирует пол говорящего человека и фразы, которые он произносит в диалоге. В перспективе большая языковая модель YandexGPT поможет платформе в понимании неуверенности и сарказма. Для оценки эмоций нейросеть анализирует содержимое речи собеседника, её тембр, скорость, высоту и другие параметры. Она также определяет, кто в общем разговоре произнёс ту или иную реплику. Это поможет искусственному интеллекту эффективно реагировать на возникающие в разговоре с клиентами нештатные ситуации — к примеру, если речь человека приобретает негативную окраску, система переключит его на сотрудника кол-центра. Нейросеть работает в фоновом режиме и анализирует эмоциональный фон диалога прямо во время разговора. Она изучает не только позвонившего клиента, но и оператора, и если оператор нагрубит клиенту, отчёт об инциденте будет автоматически направлен руководству. Последующий анализ поможет понять, какая формулировка или тема вызвала отрицательную реакцию клиента, чтобы оптимизировать общение с ним. |