|

Опрос

|

реклама

Быстрый переход

Anthropic привлекла $30 млрд и взлетела до оценки в $380 млрд — OpenAI целится в $830 млрд

13.02.2026 [06:29],

Анжелла Марина

Компания Anthropic официально подтвердила закрытие инвестиционного раунда серии G, в ходе которого привлекла $30 млрд. Благодаря поддержке крупных международных фондов капитализация разработчика искусственного интеллекта достигла $380 млрд, что значительно превышает показатель предыдущей серии F в $183 млрд.

Источник изображения: Anthropic Раунд возглавили сингапурский государственный инвестиционный фонд GIC и управляющая компания Coatue, сообщает TechCrunch. В числе соинвесторов выступили D. E. Shaw Ventures, Founders Fund Питера Тиля (Peter Thiel) и фонд MGX из ОАЭ. Среди прочих крупных участников раунда указаны Accel, General Catalyst, Jane Street и Суверенный фонд Катара (Qatar Investment Authority). Финансовый директор Anthropic Кришна Рао (Krishna Rao) отметил, что и стартапы, и крупнейшие корпорации всё активнее интегрируют Claude в свои рабочие процессы. По его словам, объём привлечённых средств отражает растущий спрос со стороны клиентов, а инвестиции будут направлены на дальнейшее развитие корпоративных продуктов и моделей, на которые пользователи уже регулярно полагаются в своей повседневной работе. Примечательно, что масштабные финансовые вливания происходят в момент обострения борьбы за долю рынка и внимание пользователей между Anthropic и её основным конкурентом OpenAI, который недавно также обозначил намерения привлечь дополнительный капитал в размере $100 млрд. В случае успеха этой инициативы капитализация создателя ChatGPT может вырасти примерно до $830 млрд. Бесплатные пользователи ИИ-бота Claude получили ряд функций, прежде доступных только по подписке

12.02.2026 [14:20],

Владимир Мироненко

Anthropic сообщила, что бесплатные пользователи ИИ-модели Claude теперь смогут создавать файлы, использовать коннекторы и получать доступ к навыкам — всё это ранее было доступно только для владельцев платной подписки.

Источник изображения: Anthropic Объявление Anthropic было сделано спустя два дня после сообщения OpenAI о запуске рекламы для бесплатных пользователей ChatGPT, а также использующих самый доступный план Go. Ранее Anthropic пообещала предоставлять доступ к Claude без рекламы, потенциально привлекая пользователей ChatGPT. Новые инициативы Anthropic для бесплатных пользователей, похоже, являются продолжением усилий компании по привлечению не желающих видеть рекламу при использовании чат-бота, отметил MacRumors. Бесплатные пользователи могут создавать, редактировать и работать с файлами непосредственно в диалоге с Claude, используя модель Sonnet 4.5 (пользователи подписки Pro имеют доступ к более функциональной модели Opus). Claude также может создавать электронные таблицы Excel, презентации PowerPoint, документы Word и файлы PDF. Новый доступ к коннекторам позволит пользователям Claude бесплатно подключаться к сторонним сервисам. В настоящее время доступны коннекторы для широкого спектра приложений и сервисов, включая Slack, Asana, Zapier, Stripe, Canva, Notion, Figma и WordPress. Anthropic предлагает навыки для PowerPoint, Excel, Word и PDF, но пользователи могут создавать собственные навыки, используя свои экспертные знания и имеющийся опыт в работе с приложениями. Anthropic сообщила, что бесплатные пользователи смогут вести более длительные диалоги с Claude благодаря добавлению функции сжатия в бесплатный план, которая позволяет автоматически суммировать предыдущий контекст, избавляя от необходимости приступать к диалогу с самого начала. Судя по всему, Anthropic не увеличила лимит для бесплатного доступа, поэтому для бесплатных пользователей будут по-прежнему действовать ограничения. Глава отдела безопасности ИИ в Anthropic покинул компанию, осознав, что «мир в опасности»

12.02.2026 [07:16],

Владимир Фетисов

Бывший глава исследовательского подразделения по безопасности искусственного интеллекта Anthropic Мринанк Шарма (Mrinank Sharma) на этой неделе опубликовал в сети письмо, которое он отправил своим коллегам перед уходом из компании. В нём он объяснил своё решение покинуть Anthropic, а также изложил свои планы на будущее.

Источник изображения: Anthropic «Я добился здесь всего, чего хотел», — сказано в письме Шарма, где также упоминаются проекты по разработке защитных механизмов, направленных на снижение рисков биотерроризма с помощью ИИ, и работа по изучению воздействия нейросетей на человечество. В ходе своей деятельности Шарма понял, что пришло время двигаться дальше, потому что он постоянно думал об опасности, которую может нести ИИ, биологическом оружии и «череде взаимосвязанных кризисов, которые разворачиваются прямо сейчас». «Похоже, мы приближаемся к порогу, за которым наша мудрость должна расти пропорционально нашей способности влиять на мир, иначе мы столкнёмся с последствиями», — считает Шарма. «За всё время, что я здесь проработал, я неоднократно видел, как трудно позволить нашим ценностям по-настоящему определять наши действия. Я видел это в себе, внутри компании, где мы постоянно сталкиваемся с давлением, заставляющим отказываться от самого важного, и в обществе в целом», — добавил Шарма. В дальнейшем он планирует заниматься работой, соответствующей его ценностям, изучать поэзию и др. Отметим, что за последнее время Anthropic покинули несколько ведущих разработчиков. Полный текст письма Шарма опубликован в материале Business Insider. Сама же Anthropic ведёт переговоры о привлечении дополнительных инвестиций, после чего рыночная стоимость компании может вырасти до $350 млрд. На прошлой неделе состоялся релиз Claude Opus 4.6 — обновлённой ИИ-модели, предназначенной для повышения офисной производительности и эффективности программирования, с увеличенным контекстным окном для обработки документов большего объёма и поддержкой выполнения более сложных задач. Команда из 16 ИИ-агентов Anthropic Claude смогла самостоятельно написать компилятор языка Си

07.02.2026 [18:40],

Павел Котов

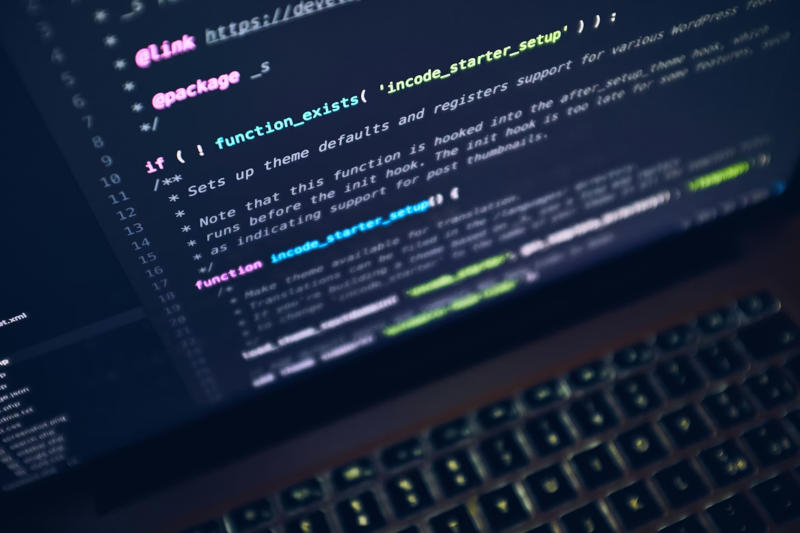

Компания Anthropic провела эксперимент, сформировав группу из агентов искусственного интеллекта, которые совместными усилиями с нуля написали компилятор языка Си. Программа работает далеко от идеала, уступая существующим аналогам, но демонстрирует возможности современных систем ИИ.

Источник изображения: Luca Bravo / unsplash.com Отчёт о проделанной работе представил исследователь Anthropic Николас Карлини (Nicholas Carlini). Он запустил в облачном окружении 16 экземпляров новейшей модели Claude Opus 4.6, подключил их к общей кодовой базе с минимальным контролем и поручил им с нуля разработать полноценный Си-компилятор. Работа заняла две недели, потребовала почти 2000 сессий работы сервиса Claude Code и обошлась примерно в $20 000 за доступ к ИИ по API. На выходе ИИ-агенты написали на языке Rust компилятор объёмом 100 000 строк кода, способный самостоятельно собрать загружаемое ядро Linux 6.19 на машинах с архитектурами x86, Arm и RISC-V. В рамках эксперимента исследователь задействовал новую функцию Claude Opus 4.6 — «команду агентов». На практике каждый экземпляр Claude был запущен внутри собственного контейнера Docker — он клонировал общий репозиторий Git, принимал задачи посредством lock-файлов, после чего отправлял готовый код обратно в репозиторий. Центральный агент, который координировал бы работу прочих, отсутствовал. Каждый экземпляр определял наиболее очевидную задачу для дальнейшей работы и начинал её решать. Когда возникали конфликты слияния, ИИ-агенты разрешали их самостоятельно. Получившийся таким образом компилятор Anthropic опубликовала на GitHub. Он действительно может компилировать код таких открытых проектов как PostgreSQL, SQLite, Redis, FFmpeg и QEMU, а также проходит 99 % тестов GCC. Но есть и серьёзные ограничения: он не компилирует 16-битный машинный код для запуска Linux, поэтому на этом этапе подключается GCC; ассемблер и линкер работают со сбоями; даже при наличии всех оптимизаций он производит менее эффективный код, чем GCC. Наконец, исходный код компилятора на Rust хотя и функционален, но по качеству он даже не близок к тому, что мог бы создать опытный программист.

Источник изображения: Mohammad Rahmani / unsplash.com Автор проекта очень старался преодолеть некоторые из ограничений, но успеха так и не добился — при попытках добавить новые возможности или исправить ошибки существующие функции часто переставали работать. Сработала закономерность, при которой кодовая база разрастается до такой степени, что ни один участник проекта не может в полной мере её понять. Предел наступил на отметке около 100 000 строк кода — видимо, это максимум возможностей для автономных ИИ-агентов. Компилятор характеризуется как «реализация в чистой комнате» — во время разработки у ИИ-агентов не было доступа в интернет. Следует также отметить, что указанные затраты в $20 000 — это только стоимость токенов при доступе к ИИ через API. Сумма не включает в себя расходы на обучение ИИ-модели, труд организовавшего проект исследователя, а также труд программистов, которые создали наборы тестов и эталонные реализации. Подготовительная работа действительно оказалась непростой — проектирование среды для ИИ-агентов потребовало больше усилий, чем непосредственное написание кода компилятора. Обнаружилось, что многословные запросы тестов засоряют контекстное окно модели, и она теряет из виду то, чем занималась. Чтобы решить эту проблему, исследователь разработал средства запуска тестов, при которых выводятся только несколько строк сводки, а запись производится в отдельные файлы. Кроме того, у Claude отсутствует чувство времени — ИИ может часами запускать тесты, не продвигаясь вперёд; поэтому пришлось создать быстрый режим с обработкой от 1 % до 10 % тестовых случаев. Когда все 16 ИИ-агентов застряли в попытке обработать одну ошибку ядра Linux, пришлось в качестве эталона запустить GCC — он компилировал большинство кода самостоятельно, а ИИ-агентам доставались случайные фрагменты. Когда в этих фрагментах возникали ошибки, ИИ-агенты их исправляли. Все эти недочёты отступают перед основным выводом — ещё год назад ни одна большая языковая модель не смогла бы проделать такую работу, даже при надлежащем контроле и неограниченном бюджете. Механизм параллельного запуска нескольких агентов с координацией действий через Git — новаторское решение, а разработанные автором исследования инженерные приёмы по повышению производительности ИИ-агентов способны оказать влияние на дальнейшее развитие сегмента ИИ-программирования. Anthropic представила Claude Opus 4.6 — флагманскую LLM с командами агентов, миллионным контекстом и платным доступом

05.02.2026 [23:13],

Андрей Созинов

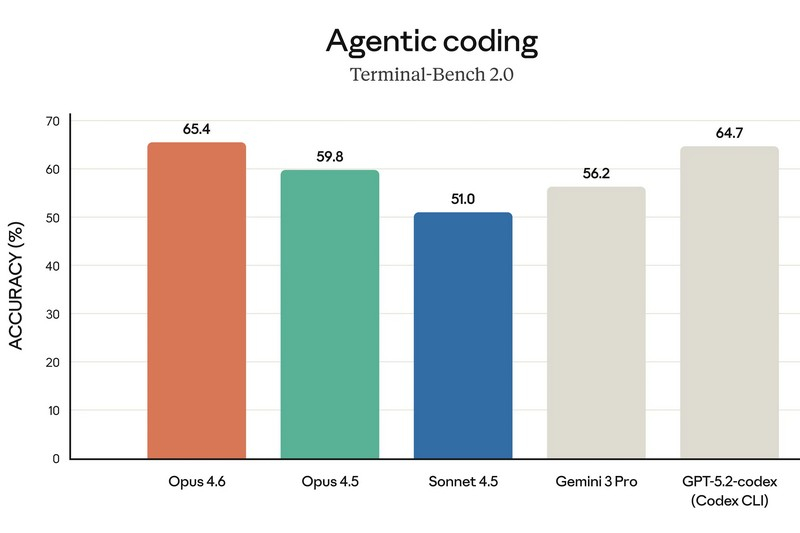

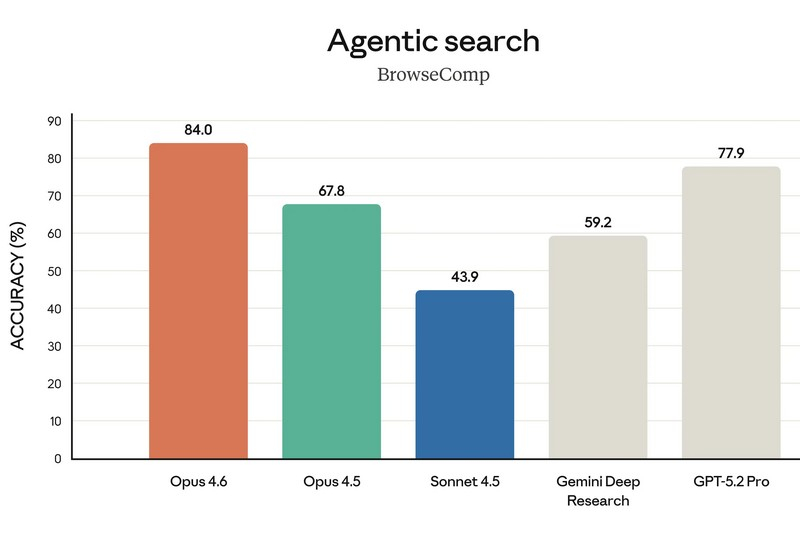

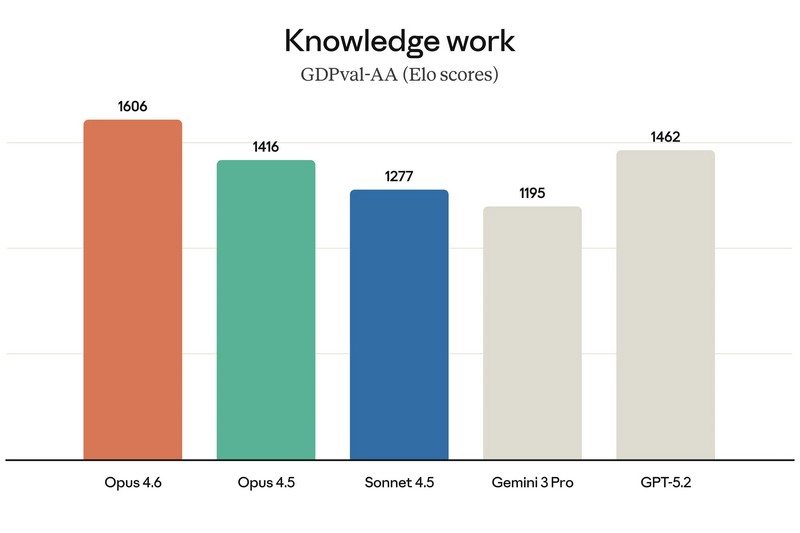

Компания Anthropic представила новую версию своей флагманской языковой модели — Claude Opus 4.6, назвав её «прямым апгрейдом» предыдущего поколения и самым интеллектуально развитым ИИ в своей линейке. Обновление уже доступно платным пользователям чат-бота Claude, а также через API по той же цене, что и Claude Opus 4.5.

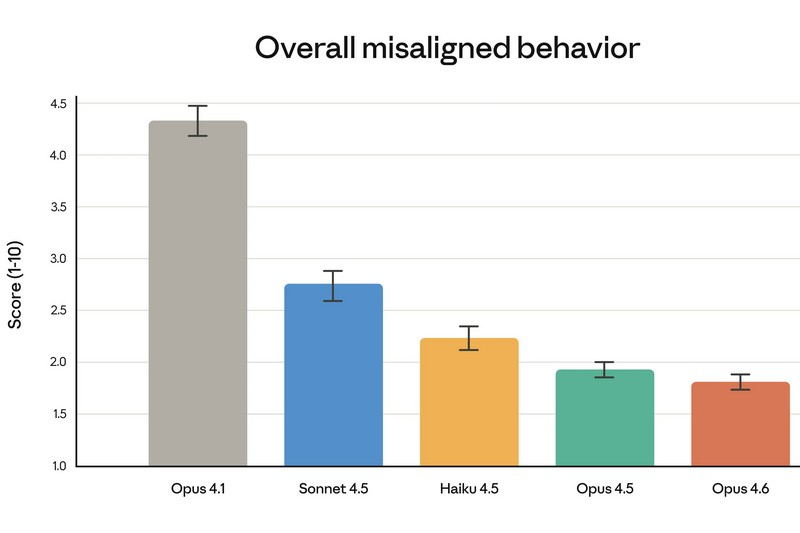

Источник изображений: Anthropic Одним из главных нововведений стали так называемые «команды агентов» (agent teams). Речь идёт о наборе ИИ-агентов, которые могут делить крупные и сложные задачи на отдельные части и выполнять их параллельно. По замыслу Anthropic, каждый агент отвечает за свой сегмент работы и напрямую координируется с другими. Руководитель продуктового направления Anthropic Скотт Уайт (Scott White) сравнил эту функцию с работой слаженной команды людей, подчеркнув, что распределение ролей позволяет выполнять задачи быстрее. На данный момент «команды агентов» доступны в формате исследовательского превью для пользователей API и платных подписчиков. Ещё одно важное улучшение — увеличенное контекстное окно. Claude Opus 4.6 способен обрабатывать до 1 млн токенов за сессию, что сопоставимо с возможностями моделей Sonnet 4 и 4.5. По словам компании, это упрощает работу с крупными базами программного кода и объёмными документами, позволяя модели удерживать значительно больше информации в памяти. Кроме того, Anthropic усилила интеграцию Claude с Microsoft PowerPoint. Теперь ИИ доступен прямо в интерфейсе приложения для создания презентаций в виде боковой панели. Если раньше пользователь мог лишь сгенерировать презентацию и затем отдельно редактировать файл в PowerPoint, то теперь создание и доработка слайдов происходят непосредственно внутри программы при активной помощи Claude.   По утверждению Anthropic, Opus 4.6 заметно лучше справляется со сложными многошаговыми задачами и чаще выдаёт результат, близкий к «продакшен-качеству», уже с первой попытки. Это особенно заметно при работе с документами, таблицами и презентациями — число итераций и правок при их подготовке существенно сокращается. Среди ключевых сильных сторон модели компания выделяет агентское программирование, работу с инструментами, поиск и финансовую аналитику.  Конечно же, Claude сравнила Opus 4.6 с предшественницей — своей более «лёгкой» моделью Sonnet 4.5, а также с основными конкурентами в лице Google Gemini 3 Pro и OpenAI GPT-5.2. В восьми из тринадцати тестов новинка оказалась впереди. В интервью TechCrunch Скотт Уайт отметил, что Opus эволюционировал из узкоспециализированного инструмента для разработки ПО в решение, полезное для гораздо более широкого круга специалистов. По его словам, Claude Code активно используют не только программисты, но и продакт-менеджеры, финансовые аналитики и представители других отраслей, которым нужен мощный инструмент для интеллектуальной работы.  Отдельно Anthropic подчёркивает усиленный фокус на безопасности. По словам компании, для Claude Opus 4.6 был проведён самый масштабный набор проверок за всю историю моделей Anthropic. Тестирование включало новые оценки влияния на благополучие пользователей, более сложные сценарии отказа от потенциально опасных запросов, а также обновлённые проверки на способность модели скрытно выполнять вредоносные действия. С учётом возросших возможностей в сфере кибербезопасности Opus 4.6 компания внедрила шесть новых специализированных тестов, призванных отслеживать возможные злоупотребления. В Anthropic подчёркивают, что Claude Opus 4.6 — это шаг к превращению Claude в универсальный инструмент для широкого спектра интеллектуальной работы, а не только в помощника для программистов. «Смешно, но нечестно»: Сэм Альтман раскритиковал кампанию Anthropic против рекламы в ChatGPT

05.02.2026 [07:12],

Анжелла Марина

Глава OpenAI Сэм Альтман (Sam Altman) подверг критике ироничные ролики конкурирующей Anthropic с критикой внедрения рекламы в ИИ-ботов. В своей публикации в X он назвал их смешными, но «явно нечестными». По мнению Альтмана, создатели Claude используют тактику двусмысленности и вводят пользователей в заблуждение относительно того, как реклама влияет на работу ботов. Он подчеркнул, что OpenAI никогда не станет интегрировать коммерческие объявления в диалоги подобным образом.

Источник изображения: The Tonight Show Как пишет The Verge, рекламные ролики Anthropic, основанной бывшими руководителями исследований OpenAI, в ироничной форме обыгрывают тему внедрения рекламы в диалоги с искусственным интеллектом. Намекая, но не указывая прямо на OpenAI, кампания противопоставляет себя недавнему заявлению о начале тестирования рекламы в ChatGPT. Anthropic подчёркивает, что в её ассистенте Claude не будет спонсируемых ссылок рядом с ответами, а сами ответы никак не будут связаны с предложениями рекламодателей. В ответ представители OpenAI пояснили действующие правила своей платформы. Рекламные блоки будут появляться исключительно у пользователей бесплатных версий, иметь чёткую маркировку и отделены от диалогов. Альтман подчеркнул, что ответы алгоритмов оптимизируются только ради пользы для человека и не зависят от пожеланий рекламодателей. При этом владельцы платных подписок полностью избавлены от просмотра объявлений. Альтман использовал этот инцидент для более широкой атаки на бизнес-модель оппонентов. Он обвинил Anthropic в создании дорогого продукта для состоятельной аудитории, тогда как миссия его компании заключается в предоставлении доступа к ИИ миллиардам людей. Для сравнения он привёл статистику, согласно которой бесплатной версией ChatGPT в одном только Техасе пользуется больше людей, чем сервисом Claude во всех Соединённых Штатах вместе взятых. В заключение он указал на авторитарный характер политики Anthropic, заявив, что конкуренты стремятся контролировать действия пользователей и диктовать правила применения ИИ. Также он упомянул, что Anthropic блокирует доступ к своим инструментам для некоторых компаний, включая OpenAI, и в противовес этому напомнил о собственном рекламном ролике, посвящённом разработчикам, сообщив о 500 тысячах загрузок нового инструмента Codex всего за несколько дней. Anthropic пообещала сохранить Claude без рекламы и высмеяла противоположный подход ChatGPT

04.02.2026 [19:13],

Сергей Сурабекянц

Anthropic объявила, что не планирует добавлять рекламу в свой чат-бот с искусственным интеллектом Claude, что резко контрастирует с подтверждёнными планами OpenAI разместить рекламу в ChatGPT. Чтобы ещё больше подчеркнуть это, компания выпустила серию рекламных роликов, высмеивающих неназванных конкурентов, добавляющих рекламу в свои ИИ. Они уже опубликованы на YouTube и будут показаны во время «Супербоула» — финальной игры по американскому футболу.

Источник изображения: Anthropic «Мы хотим, чтобы Claude действовал однозначно в интересах наших пользователей, — говорится в блоге Anthropic. — Поэтому мы сделали выбор: Claude останется без рекламы. Наши пользователи не будут видеть спонсируемые ссылки рядом с их разговорами с Claude; ответы Claude также не будут зависеть от рекламодателей или включать размещение сторонних продуктов, которые пользователи не запрашивали». Anthropic разъяснила, почему включение рекламы «несовместимо с тем, каким мы хотим видеть Claude». По мнению компании, стремление к прибыли может помешать предоставлению наиболее полезных советов пользователю и отвлекать тех, кто использует Claude для работы. Тем не менее, Anthropic не стала сжигать мосты: «Если нам потребуется пересмотреть этот подход, мы будем прозрачны в отношении причин, по которым мы это сделаем». Изменение политики Anthropic в будущем может выглядеть лицемерно в свете рекламы, выпущенной компанией для продвижения своей позиции во время «Супербоула». Это один из четырёх рекламных роликов, где очеловеченные ИИ вставляют неуместную рекламу прямо посреди своих ответов. Более короткая 30-секундная версия ролика будет показана во время игры в воскресенье, а отдельный минутный ролик с вставляющим рекламные советы во время консультации с ИИ-терапевтом, будет показан во время предматчевого шоу. Ни в одном из рекламных роликов не упоминается ChatGPT, но направленность их очевидна. В прошлом месяце OpenAI объявила о скором появлении рекламы в ChatGPT для бесплатных пользователей и пользователей более дешёвого тарифа Go, пообещав, что она будет «чётко обозначена» и расположится отдельно от ответов чат-бота. «Супербоул» — в американском футболе название финальной игры за звание чемпиона Национальной футбольной лиги (НФЛ) Соединённых Штатов Америки, в которой встречаются победители двух конференций лиги — Американской футбольной конференции и Национальной футбольной конференции. «Мне это нравится! Я смотрю видео без рекламы об искусственном интеллекте без рекламы», — прокомментировал видео один из пользователей, посмотревших его на YouTube. Anthropic обвалила акции разработчиков софта и финуслуг на $285 млрд новым ИИ-инструментом для бизнеса

04.02.2026 [16:45],

Владимир Мироненко

Выход нового инструмента Anthropic на основе ИИ для автоматизации задач в сфере бизнеса, таких, как проверка контрактов и юридические обзоры, спровоцировал обвал акций на $285 млрд в секторах программного обеспечения, финансовых услуг и управления активами, сообщил Bloomberg.

Источник изображения: claude.com Индекс американских акций компаний-разработчиков программного обеспечения инвестиционного банка Goldman Sachs упал во вторник на 6 %, что стало самым большим однодневным падением с апреля, когда обвал был вызван тарифами, а индекс компаний финансовых сервисов упал почти на 7 %. Индекс Nasdaq 100 в какой-то момент упал на 2,4 %, прежде чем сделать откат до 1,6 %. Также выход нового ИИ-инструмента стал причиной резкого падения акций компаний за пределами США, в частности, ирландской Experian Plc, предоставляющей кредитные и маркетинговые услуги, производителя программного обеспечения для бизнеса и юриспруденции Relx Plc и London Stock Exchange Group Plc из Великобритании. Акции ведущей индийской компании Tata Consultancy Services упали на 6 %, а ценные бумаги Infosys — на 7,1 %. Акции производителя облачного бухгалтерского программного обеспечения Xero упали на 16 % на торгах в Сиднее, что стало самым большим падением с 2013 года. Значительное падение акций Thomson Reuters Corp. и Legalzoom.com Inc., оказавшихся в числе худших по показателям в США и Канаде, привело к падению акций инвестиционного фонда ETF iShares Expanded Tech-Software Sector на 4,6 %, шестой день подряд. В январе ETF упал на 15 %, что стало худшим показателем за месяц с 2008 года. Акции компаний, занимающихся развитием бизнеса, также попали под распродажу. В частности, акции Blue Owl Capital Corp. упали на 13 %, что стало рекордным девятым снижением подряд. При этом их стоимость сократилась до самого низкого уровня с 2023 года. «Этот год станет определяющим для того, станут ли компании победителями или жертвами ИИ, и ключевым навыком будет избегать попадания в число проигравших», — прокомментировал реакцию рынка на появление нового ИИ-инструмента Стивен Йиу (Stephen Yiu), главный инвестиционный директор Blue Whale Growth Fund. В OpenAI появился «директор по готовности» — он будет отвечать за создание безопасного ИИ

04.02.2026 [13:33],

Алексей Разин

Вопросы безопасности использования искусственного интеллекта трактуются в наши дни довольно широко. Чат-боты могут открыто общаться на темы, которые в обществе принято скрывать от тех же несовершеннолетних, поэтому за развитием соответствующих систем нужен строгий контроль. В штате OpenAI недавно появился директор, отвечающий за создание безопасного ИИ.

Источник изображения: Unsplash, Hafiz ta По данным The Wall Street Journal, им стал выходец из конкурирующей Anthropic — Дилан Скандинаро (Dylan Scandinaro), который на прежнем месте работы занимался аналогичной деятельностью. О назначении его «директором по готовности» (Head of Preparedness) со страниц социальной сети X на этой неделе сообщил генеральный директор OpenAI Сэм Альтман (Sam Altman). Он попутно отметил: «Скоро всё начнёт двигаться очень быстро, и мы будем работать над очень мощными моделями. Это потребует соответствующих мер предосторожности, чтобы обеспечить дальнейшее предоставление больших выгод». Дилан Скандинаро, по словам Альтмана, возглавит усилия OpenAI по подготовке к устранению этих серьёзных рисков. Как признался глава компании, Скандинаро является лучшим кандидатом на эту роль из тех, которых он когда-либо встречал. «Ему, конечно, хватит работы, а я сегодня будут спать спокойнее», — признался Альтман. Он с нетерпением ждёт возможности ближе поработать со Скандинаро над изменениями, которые будут применены ко всей компании. Сам Скандинаро признал, что стремительно развивающиеся ИИ-модели могут стать источником «экстремального и даже необратимого ущерба». По его словам, предстоит проделать немало работы за очень короткий срок. В Anthropic Скандинаро проработал с мая прошлого года по февраль текущего. В дочерней компании DeepMind гиганта Google он продержался значительно дольше, с сентября 2022 года по май 2025 года, специализируясь на синтетических данных для обучения ИИ-ассистента Gemini. Скандинаро также имеет опыт работы в Palantir, Unity Technologies и Everyday Robots. Вакансия на соответствующую должность в OpenAI была открыта с прошлого года, она подразумевала выплату $550 000 в денежной форме ежегодно и вознаграждение в форме акций стартапа. «Команда готовности» в структуре OpenAI существует с 2023 года, изначально её возглавлял Александр Мадрий (Aleksander Madry), который имеет опыт работы в Центре распространяемого машинного обучения Массачусетского технологического института. Позже он перешёл на другую работу в структуре OpenAI, пост главы подразделения оказался вакантным. Музыкальные издатели потребовали от Anthropic $3 млрд за «вопиющее пиратство»

30.01.2026 [21:21],

Анжелла Марина

Группа музыкальных издателей во главе с Concord Music Group и Universal Music Group (UMG) подала судебный иск против компании Anthropic, обвинив разработчика искусственного интеллекта в незаконном скачивании более 20 000 защищённых авторским правом музыкальных произведений. Истцы утверждают, что компания использовала пиратские методы для получения доступа к песням, текстам и нотам.

Источник изображения: Wesley Tingey/Unsplash Как сообщает Engadget, ссылаясь на данные Reuters, среди незаконно использованных материалов фигурируют культовые композиции таких исполнителей, как The Rolling Stones, Нил Даймонд (Neil Diamond) и Элтон Джон (Elton John), права на которые принадлежат UMG. Независимый издатель Concord Music Group также заявил о нарушении прав своих артистов, в числе которых актёр и рэп-исполнитель Common, Киллер Майк (Killer Mike) и группа Korn. Согласно судебному обращению, сумма ущерба может превысить $3 млрд. В тексте искового заявления представители музыкальной индустрии отметили, что хотя Anthropic позиционирует себя как компания, занимающаяся безопасностью и исследованиями в области ИИ, история её действий свидетельствует об обратном. По мнению истцов, многомиллиардная бизнес-империя Anthropic фактически построена на пиратстве и незаконном использовании торрентов для получения чужой интеллектуальной собственности. Интересы издателей представляет та же юридическая команда, которая вела прошлогоднее дело «Бартц против Anthropic» (Bartz v. Anthropic). То дело завершилось присуждением пострадавшим авторам компенсации в размере $1,5 млрд. Тогда суд установил, что компания незаконно скачивала опубликованные работы авторов для обучения своих моделей, и, в соответствии с вердиктом, 500 000 авторов, участвовавших в деле, должны получить по $3000 за каждое произведение. Примечательно, что в рамках предыдущего разбирательства судья Уильям Алсап (William Alsup) постановил, что само по себе обучение ИИ-моделей на защищённом контенте является законным, однако приобретение этого контента через пиратство — нет. Юридический прецедент подразумевает, что если бы Anthropic легально приобрела копии произведений, претензий к ней могло бы не возникнуть. Если заявленная сумма ущерба будет подтверждена, это разбирательство станет одним из крупнейших дел о защите авторских прав в истории США, не являющихся коллективным иском, отмечает Engadget. Нужно больше финансирования: OpenAI наметила выход на IPO на четвёртый квартал 2026 года

30.01.2026 [11:45],

Алексей Разин

Пока стартап OpenAI остаётся частной компанией, свою финансовую отчётность он имеет право не публиковать, а стратегические решения согласовывать с ограниченным кругом инвесторов. Тем не менее, растущая потребность в финансировании толкает OpenAI к подготовке публичного размещения акций, которое может состояться в четвёртом квартале текущего года.

Источник изображения: OpenAI Как отмечает The Wall Street Journal, уже сейчас OpenAI ведёт переговоры с американскими банками о возможности их участия в подготовки IPO, которое намечено на четвёртый квартал текущего года. Со стороны OpenAI подготовка ещё заключается и в усилении своего финансового крыла управленцев, поскольку требования к публичной компании заметно отличаются от стартапа. Недавно OpenAI наняла нового главного бухгалтера Аджмери Дейл (Ajmere Dale) и директора по корпоративным финансам Синтию Гейлор (Cynthia Gaylor). Аналитики Уолл-стрит уже предрекают, что 2026 год станет периодом самых крупных первичных размещений акций. Помимо OpenAI и конкурирующей Anthropic, в этом году своё IPO планирует провести аэрокосмическая компания SpaceX — как ожидается, оно состоится в июне, ближе к дню рождения основателя стартапа Илона Маска (Elon Musk). Свежий раунд финансирования OpenAI должен привлечь от $50 до $100 млрд, по разным оценкам, и увеличить капитализацию компании до диапазона от $750 до $830 млрд. Проблема заключается в том, что существующие инвесторы обладают не безграничным терпением, а стартап не готов продемонстрировать безубыточность ранее 2029 года. Возможно, IPO в этом смысле является шансом привлечь средства тех инвесторов, которые готовы рискнуть меньшими суммами, но при этом будут более многочисленными сами по себе. В декабре сооснователь и генеральный директор OpenAI Сэм Альтман (Sam Altman) признался, что ему вовсе не хочется возглавлять публичную компанию, но он более благосклонен к идее превращения OpenAI в такую компанию, хотя и некоторые аспекты такой трансформации раздражают его уже сейчас. Часть полномочий, как ожидается, Альтман передаст директору OpenAI по приложениям Фиджи Симо (Fidji Simo). Руководство OpenAI также опасается того, что Anthropic опередит их с выходом на IPO, а она как раз собирается выйти на биржу до конца текущего года. В отличие от OpenAI, хватающейся практически за любые идеи развития ИИ, конкурирующая Anthropic более сосредоточена на корпоративном рынке, а он ускоряет монетизацию услуг и даёт инвесторам больше уверенности в будущем стартапа. В итоге сейчас Anthropic удаётся по факту привлекать средства в значительно больших суммах, чем планируется на этапе подготовки очередного раунда финансирования. При этом Anthropic рассчитывает выйти на безубыточность в 2028 году, заметно раньше OpenAI. Обеим компаниям также придётся конкурировать за деньги инвесторов с SpaceX, который собирается выйти на биржу в середине года, и при этом уже финансирует ИИ-стартап xAI Илона Маска. Anthropic тоже ведёт переговоры с банками о подготовке IPO, одновременно нанимая руководитель финансового сектора для оптимизации своей штатной структуры с точки зрения выхода на биржу. Макроэкономическая неопределённость может ограничить готовность инвесторов тратить на покупку акций ИИ-стартапов сотни миллиардов долларов США даже с учётом наблюдаемого бума соответствующих технологий. Anthropic удалось привлечь в рамках недавнего раунда финансирования более $10 млрд

28.01.2026 [08:42],

Алексей Разин

Основанный выходцами из OpenAI стартап Anthropic успел получить определённую специализацию в этом молодом сегменте рынка, сосредоточившись на корпоративных решениях. Принято считать, что такая бизнес-модель быстрее приносит финансовую отдачу, поэтому инвесторы охотнее вкладывают средства в капитал Anthropic. Недавно компании удалось привлечь от $10 до $15 млрд.

Источник изображения: Anthropic По крайней мере, такие суммы упоминает CNBC со ссылкой на осведомлённые источники. Издание Financial Times называет ещё более крупную сумму привлечения в районе $20 млрд, причём она учитывает только средства венчурных фондов, но данный этап пока не реализован на практике. Изначально ожидалось, что новый раунд финансирования позволит Anthropic привлечь $10 млрд, но аппетиты инвесторов оказались выше. По сути, если ранее предполагалось, что капитализация стартапа увеличится до $350 млрд, то теперь он может претендовать на более высокую оценку. Тем более, что вложить средства в капитал Anthropic могут Microsoft и Nvidia. В ноябре эти компании рассчитывали направить в капитал Anthropic до $5 млрд в случае Microsoft и до $10 млрд в случае Nvidia. Пока параметры их реального участия в финансировании стартапа окончательно не определены. К концу прошлого года Anthropic, по словам руководства, подошла со способностью получать более $9 млрд выручки в год, если экстраполировать месячные показатели. Тем не менее, потребность в финансовых ресурсах значительно превышает выручку стартапа, поскольку только на строительство ЦОД в США он намерен направить $50 млрд, а ещё обучение новых ИИ-моделей требует серьёзных материальных затрат. Financial Times поясняет, что инвесторы были готовы вложить в Anthropic до $50–60 млрд, и компания сама ограничила размер инвестиций на данном этапе в диапазоне от $10 до $15 млрд, но к привлечению дополнительных средств участники переговоров вернутся позже. В этом году Anthropic также может выйти на биржу, открыв возможность для вложения средств в свой капитал для розничных инвесторов. Для сравнения, OpenAI в рамках текущего раунда финансирования готовится привлечь от $50 до $100 млрд, а капитализация этого стартапа будет оцениваться в $830 млрд по верху диапазона. Глава Anthropic призвал человечество не терять бдительность в отношении опасностей ИИ

27.01.2026 [14:05],

Алексей Разин

Глава стартапа Anthropic Дарио Амодеи (Dario Amodei) присоединился к представителям ИИ-отрасли, которые призывают к контролируемому и ответственному использованию соответствующих технологий. Он не уверен, что человечество обладает достаточной зрелостью, чтобы гуманно использовать все возможности, которые предоставляет искусственный интеллект.

Источник изображения: Unsplash, sebastiaan stam «Человечеству вот-вот дадут почти невообразимую мощь, и совершенно непонятно, обладают ли наши социальные, политические и технологические системы достаточной зрелостью для обуздания этой силы», — заявил глава Anthropic в своей недавней публикации на соответствующую тему. Как он ожидает, в ближайшие несколько лет ИИ окажется значительно «умнее» любого учёного из числа лауреатов Нобелевской премии, политика или представителя технологической отрасли. К числу создаваемых бурным развитием ИИ рисков Амодеи относит возможность разработки отдельным индивидуумом биологического оружия, способного не только убить миллионы людей, но и истребить всё живое на Земле. Если раньше одиночки могли устроить стрельбу, по словам Амодеи, но не имели возможности создать ядерное оружие или распространять чуму, то теперь их способности будут подняты до уровня учёного-вирусолога. От вышедшего из-под контроля ИИ тоже исходит определённая опасность для человечества, а ещё злоупотребления в этой сфере могут привести к образованию мировой диктатуры тоталитарного типа, как опасается глава Anthropic. Дарио Амодеи с осуждением отнёсся к идее американских властей разрешить поставки в Китай ускорителей вычислений Nvidia H200, которые не являются передовыми по американским меркам, но обеспечат заметный прогресс китайской ИИ-отрасли в случае их закупки и распространения. Глава Anthropic такие шаги сравнил с продажей ядерного оружия в Северную Корею. Амодеи также выразил сомнения по поводу способности конкурирующих разработчиков ИИ добровольно ограничить злоупотребления, и примером могут служить проблемы чат-бота Grok с генерацией изображений сексуального характера с использованием несовершеннолетних. Если уже в этой сфере возникают трудности с соблюдением ограничений, то и в других повторение сценария не исключено. В политической сфере соблазн добиться преимущества над другими странами чаще оказывается выше соображений безопасности, а потому иметь дело с соответствующими рисками в сфере ИИ неизбежно придётся. Конфликт с руководством OpenAI на почве необходимости ограничений этического характера стал одной из причин, по которым Дарио Амодеи покинул этот стартап и основал Anthropic. Ответ OpenAI: Anthropic превратила Claude в рабочую станцию со встроенными Canva, Slack и Figma

26.01.2026 [23:18],

Анжелла Марина

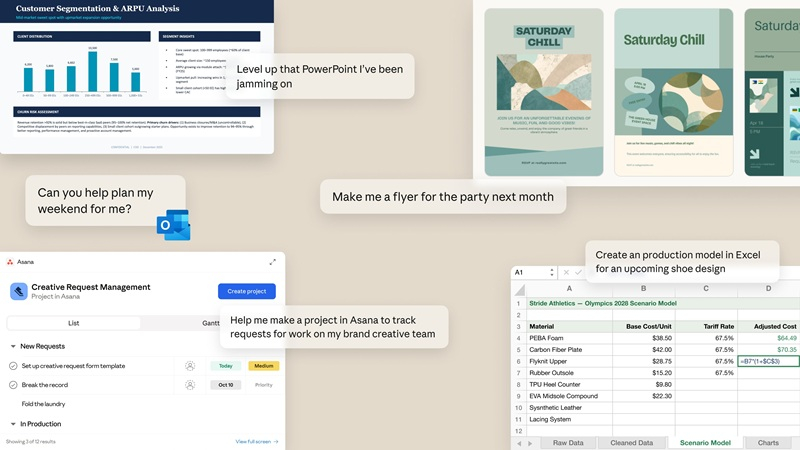

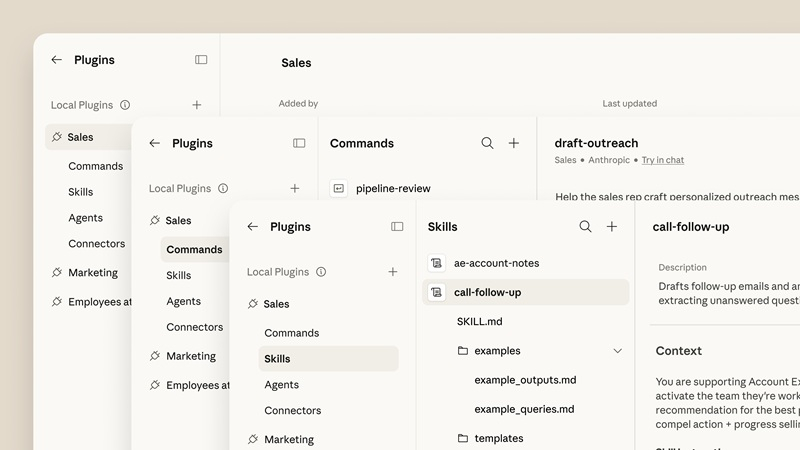

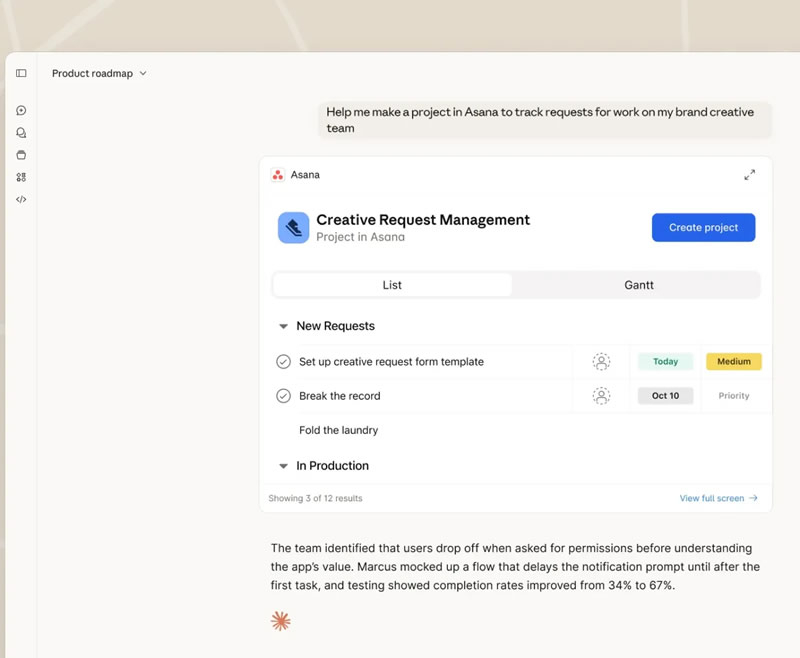

Компания Anthropic объявила о запуске новой функции, позволяющей работать со сторонними приложениями непосредственно в интерфейсе чат-бота Claude. Нововведение направлено на расширение возможностей использования искусственного интеллекта (ИИ) в корпоративной среде и упрощение взаимодействия с привычными сервисами.

Источник изображений: Anthropic Как передаёт TechCrunch, на старте система поддерживает интеграцию с такими сервисами, как Slack, Canva, Figma, Box и Clay, а в ближайшее время разработчики планируют добавить поддержку облачной CRM-платформы Salesforce. Механизм работы предполагает авторизацию в каком-либо сервисе, после чего Claude получает к нему доступ, позволяя выполнять конкретные действия внутри своего интерфейса. Например, отправлять сообщения коллегам в мессенджере, генерировать графики или работать с файлами в облачном хранилище.  В Anthropic считают, что анализ данных, дизайна, контента и в целом управление проектами будет происходить гораздо эффективнее в одном визуальном интерфейсе, что позволит вносить правки быстрее, чем при использовании каждого сервиса по отдельности. Технология аналогична системе внедрения сторонних приложений OpenAI, запущенной в октябре 2024 года. Обе платформы построены на базе открытого стандарта Model Context Protocol (MCP). Доступ к нововведению получили подписчики тарифных планов Pro, Max, Team и Enterprise. Пользователям бесплатной версии функция недоступна. Активация и выбор сервисов происходят через специальный каталог Claude. От $4 млрд до $9 млрд за полгода: Anthropic показала феноменальный рост выручки в погоне за OpenAI

22.01.2026 [10:01],

Алексей Разин

Компания Anthropic была основана выходцами из OpenAI, и этот стартап пока пытается сосредоточиться на разработке ИИ-систем для корпоративных клиентов. В каком-то смысле это говорит о его более высокой прагматичности, и уже сейчас Anthropic способна получать до $9 млрд выручки в год, а капитализация компании с учётом готовящегося раунда финансирования может вырасти до $350 млрд.

Источник изображения: Anthropic Это не так уж мало на фоне конкурирующей OpenAI, чей приведённый размер годовой выручки сейчас превышает $20 млрд, а капитализация может попасть в диапазон от $750 до $830 млрд, если обрабатываемые Сэмом Альтманом (Sam Altman) ближневосточные инвесторы захотят раскошелиться на $50 млрд. Источники Bloomberg сообщают, что венчурные фонды смогут направить в капитал Anthropic как минимум $1 млрд. Стартап уверенными темпами наращивает выручку. Если ещё в середине прошлого года её приведённая к годовой величина достигала $4 млрд, то в конце 2025 года она превысила рубеж в $9 млрд. Новый раунд финансирования Anthropic полагается преимущественно на средства Nvidia и Microsoft, которые сообща готовы вложить $15 млрд. Венчурные инвесторы могли бы направить на поддержку Anthropic до $10 млрд, но пока стартап довольствуется на порядок меньшей суммой. Впрочем, если подобные ограничения будут сняты, то стартапу вполне по силам будет привлечь свыше $20 млрд с учётом средств Nvidia и Microsoft. Сингапурский фонд GIC готов направить Anthropic до $1,5 млрд, такой же суммой располагает Coatue Management, Iconiq Capital намеревается ограничиться $1 млрд в рамках нового раунда, поскольку неплохо вложилась в капитал стартапа в сентябре прошлого года. Инвестировать в Anthropic неопределённые суммы готовы Lightspeed Venture Partners, Menlo Ventures и Sequoia Capital. Представленная в сентябре Anthropic модель Claude Sonnet 4.5 лучше воспринимает команды пользователя и способна на протяжении 30 часов самостоятельно заниматься написанием программного кода, прежде чем потребует взаимодействия с человеком. Сотрудничество Anthropic с Nvidia и Microsoft является обоюдовыгодным, поскольку стартап потребляет продукцию второй из компаний и услуги последней. На строительство центров обработки данных в США компания Anthropic намерена направить $50 млрд, поэтому средства нужны ей не только для совершенствования своих программных продуктов. |