|

Опрос

|

реклама

Быстрый переход

ChatGPT превзошёл студентов на экзаменах, но только на первых курсах

29.06.2024 [23:57],

Анжелла Марина

Исследователи провели эксперимент, который показал, что ИИ способен успешно сдавать университетские экзамены, оставаясь при этом незамеченным специальными программами. Экзаменационные работы ChatGPT получили более высокие оценки, чем работы студентов, пишет издание Ars Technica.

Источник изображения: Headway/Unsplash Команда учёных из Редингского университета в Англии (University of Reading) под руководством Питера Скарфа (Peter Scarfe) провела масштабный эксперимент, чтобы проверить, насколько эффективно современные системы искусственного интеллекта могут справляться с университетскими экзаменами. Исследователи создали более 30 фиктивных учётных записей студентов-психологов и использовали их для сдачи экзаменов, используя ответы, сгенерированные ChatGPT. Эксперимент охватил пять модулей бакалавриата по психологии, включая задания для всех трёх лет обучения. Результаты оказались ошеломляющими — 94 % работ, созданных ИИ, остались незамеченными экзаменаторами. Более того, почти 84 % этих работ получили более высокие оценки, чем работы студентов-людей, в среднем на полбалла выше. «Экзаменаторы были весьма удивлены результатами», — отметил Скарф. Причём интересно, что некоторые работы ИИ были обнаружены не из-за их роботизированности, а из-за слишком высокого качества. Эксперимент также выявил ограничения существующих систем обнаружения контента, созданного ИИ. По словам Скарфа, такие инструменты, как GPTZero от Open AI и система Turnitin, показывают хорошие результаты в лабораторных условиях, но их эффективность значительно снижается в реальной жизненной ситуации. Однако не все результаты были в пользу ИИ. На последнем курсе, где требовалось более глубокое понимание и сложные аналитические навыки, студенты-люди показали лучшие результаты, чем ChatGPT. Скарф подчеркнул, что ввиду постоянного совершенствования ИИ и отсутствия надёжных способов обнаружения его использования, университетам придётся адаптироваться и интегрировать ИИ в образовательный процесс. «Роль современного университета заключается в подготовке студентов к профессиональной карьере, и реальность такова, что после окончания учёбы они, несомненно, будут использовать различные инструменты искусственного интеллекта», — заключил исследователь. Данный эксперимент, по сути, поднимает проблему, которая уже сегодня требует пересмотра существующих методов обучения и экзаменации. Audi интегрирует ChatGPT в свои автомобили — это расширит голосовое управление

29.06.2024 [04:01],

Анжелла Марина

Audi внедряет ChatGPT в свою информационно-развлекательную систему MIB3 для расширения возможностей голосового управления. С июля около двух миллионов автомобилей Audi, выпущенных с 2021 года, включая Audi A3, получат обновлённые функции. Новые модели, такие как Q6 e-tron, также будут оснащены ChatGPT.

Источник изображения: Audi Интеграция ChatGPT в систему MIB3 открывает новые, ранее недоступные возможности, сообщает в своём блоге компания. Водители Audi смогут использовать расширенное голосовое управление для работы с информационно-развлекательной системой, навигацией и системой кондиционирования воздуха, а также задавать общие вопросы. Возможность запрашивать информацию в реальном режиме времени, не отвлекаясь от дороги, делает вождение безопаснее. ChatGPT предоставляется через Azure OpenAI Service, а в основе новой функции лежит технология Chat Pro от компании Cerence, которая непосредственно занимается интеграцией чат-бота в Audi Assistant на новой архитектуре E 3 1.2. Маркус Кит (Marcus Keith), вице-президент по развитию информационно-развлекательных систем в Audi, отмечает, что благодаря бесшовной интеграции ChatGPT в систему голосового управления были объединены сильные стороны технологий ChatGPT и Chat Pro. «Помимо широкого спектра голосовых функций, наши клиенты теперь получат простой и безопасный доступ к базе знаний на основе ИИ. Это ещё один шаг к созданию премиального пользовательского опыта в автомобилях Audi», — сказал он. Чтобы активировать помощника, надо сказать «Hey Audi» или нажать кнопку push-to-talk на рулевом колесе. В зависимости от вопроса или команды, ИИ-помощник определит, что именно он должен сделать. Если система не может справится с заданием, она перенаправит его ChatGPT. В будущем также станет возможным задавать вопросы о техническом состоянии автомобиля, например, о давлении в шинах. Компания Audi стремится шагать со временем в ногу и максимально использовать потенциал искусственного интеллекта, предлагая услуги и продукты для улучшения пользовательского взаимодействия с автомобилем, а также в бизнес-процессах. В частности, ИИ используется для решений, касающихся дизайна интерьера, поддержки контроля качества в производстве. Компания заявляет, что также привержена ответственному использованию ИИ в соответствии с принципами этики и регламента ЕС, касающегося искусственного интеллекта, а её сотрудники проходят обучение для использования ИИ в соответствии с современными стандартами и с учётом будущих потребностей. Новая модель OpenAI CriticGPT обучена «критиковать» результаты GPT-4

28.06.2024 [05:44],

Анжелла Марина

Компания OpenAI представила CriticGPT — новую модель искусственного интеллекта, предназначенную для выявления ошибок в коде, сгенерированном непосредственно ChatGPT. CriticGPT будет использоваться в качестве алгоритмического помощника для тестировщиков, которые проверяют программный код, выданный ChatGPT.

Источник изображения: Copilot Согласно новому исследованию «LLM Critics Help Catch LLM Bugs», опубликованному OpenAI, новая модель CriticGPT создана как ИИ-ассистент для экспертов-тестировщиков, проверяющих программный код, сгенерированный ChatGPT. CriticGPT, основанный на семействе большой языковой модели (LLM) GPT-4, анализирует код и указывает на потенциальные ошибки, облегчая специалистам обнаружение недочётов, которые в противном случае могли бы остаться незамеченными из-за человеческого фактора. Исследователи обучили CriticGPT на наборе данных с образцами кода, содержащими намеренно внесённые ошибки, научив его распознавать и отмечать различные погрешности. Учёные обнаружили, что в 63-% случаев, связанных с естественно возникающими ошибками LLM, аннотаторы предпочитали критику CriticGPT человеческой. Кроме того, команды, использующие CriticGPT, писали более полные отзывы, чем люди, не использующие этого ИИ-помощника, при этом снижался уровень конфабуляций (ложных фактов и галлюцинаций). Разработка автоматизированного «критика» включала обучение модели на большом количестве входных данных с намеренно внесёнными ошибками. Экспертов просили модифицировать код, написанный ChatGPT, внося ошибки, а затем предоставлять результат с якобы обнаруженными багами. Этот процесс позволил модели научиться выявлять и критиковать различные типы ошибок в коде. В экспериментах CriticGPT продемонстрировал способность улавливать как внесённые баги, так и естественно возникающие ошибки в результатах ответов ChatGPT. Исследователи также создали новый метод «Force Sampling Beam Search» (FSBS), который помогает CriticGPT писать более детальные обзоры кода, позволяя регулировать тщательность поиска проблем и одновременно контролируя частоту ложных срабатываний. Интересно, что возможности CriticGPT выходят за рамки простой проверки кода. В экспериментах модель применили к множеству тренировочных данных ChatGPT, ранее оцененных людьми как безупречные. Удивительно, но CriticGPT выявил ошибки в 24-% случаев, которые впоследствии были подтверждены экспертами. OpenAI считает, что это демонстрирует потенциал модели не только для работы с техническими задачами, но и подчёркивает её способность улавливать тонкие ошибки, которые могут ускользнуть даже от тщательной проверки человеком. Несмотря на многообещающие результаты, CriticGPT, как и все ИИ-модели, имеет ограничения. Модель обучалась на относительно коротких ответах ChatGPT, что может не полностью подготовить её к оценке более длинных и сложных задач, с которыми могут столкнуться будущие ИИ-системы. Команда исследователей признаёт, что модель наиболее эффективна в обнаружении ошибок, которые могут быть определены в одном конкретном, узком месте кода. Однако реальные ошибки в выводе AI могут часто быть разбросаны по нескольким частям ответа, что представляет собой вызов для будущих итераций модели. Кроме того, хотя CriticGPT снижает уровень конфабуляций, он не устраняет их полностью, и люди-эксперты по-прежнему могут совершать ошибки на основе этих ложных данных. OpenAI отложила запуск голосового помощника, чтобы он не наговорил лишнего

26.06.2024 [16:53],

Павел Котов

OpenAI отложила запуск долгожданной функции голосового помощника ChatGPT в стремлении гарантировать, что он сможет безопасно и эффективно обрабатывать запросы миллионов пользователей. Первоначально запуск функции намечался на конец июня — теперь его перенесли примерно на месяц.

Источник изображения: Mariia Shalabaieva / unsplash.com Голосовой интерфейс чат-бота OpenAI анонсировала в мае на мероприятии, посвящённом обновлённой модели искусственного интеллекта GPT-4o, которая более эффективно обрабатывает текст, звук и изображения в реальном времени. Компания сообщила, что первоначально рассчитывала запустить голосового помощника для небольшого числа подписчиков ChatGPT Plus, но приняла решение потратить ещё месяц, чтобы «достичь нашей планки для запуска». «Мы совершенствуем способность модели обнаруживать и отклонять определённый контент. Мы также работаем над повышением качества работы системы и готовим инфраструктуру к масштабированию для обеспечения выдачи ответов в реальном времени», — сообщила OpenAI. Это не самое приятное решение для компании, которая стремится сохранить лидерство в жёсткой конкурентной среде. Всем платным подписчикам голосовой помощник, согласно плану, должен стать доступным осенью. OpenAI также рассказала, что готовится развернуть для чат-бота поддержку видео и трансляции экрана — более подробно об этих функциях она пообещала рассказать позже. В результате с выходом голосового помощника его возможности будут ограничены в сравнении с версией, которую компания демонстрировала на презентации в мае. К примеру, не будет работать функция компьютерного зрения, которая помогла ИИ консультировать пользователя по танцевальным движениям. Браузер Firefox версии Nightly получил ИИ-помощников ChatGPT и Gemini

26.06.2024 [05:20],

Анжелла Марина

Компания Mozilla добавила в экспериментальную версию своего браузера Firefox Nightly полный набор популярных чат-ботов. Интеграция ИИ-помощников в браузер позволит анализировать и обобщать найденную в интернете информацию.

Источник изображения: Mozilla Уже на этой неделе пользователи смогут добавить в боковую панель ChatGPT, Google Gemini, HuggingChat и других известных чат-ботов. Правда, чтобы их протестировать в Firefox, необходимо установить экспериментальную версию браузера Nightly — это специальная «нестабильная платформа для тестирования и разработки». После установки Nightly, перейдите в «Настройки» — «Nightly Experiments» и активируйте опцию «AI Chatbot Integration», далее выберите бота. Для его постоянного размещения на панели, нужно кликнуть правой кнопкой мыши по верхней панели браузера и выбрать «Настроить панель инструментов». Затем следует перетащить иконку чат-бота на верхнюю панель.

Источник изображения: Mozilla Компания отмечает, что все модели чат-ботов находятся на стадии разработки и имеют как сильные, так и слабые стороны. «Ни один из них не идеален, и каждый выполняет какую-то задачу лучше, какую-то хуже». Кстати, использование чат-ботов полностью опционально и не встроено в основные функции Firefox. Mozilla, на самом деле, следует тенденции, заданной другими разработчиками браузеров, которые внедряют чат-ботов в свои продукты. Например, Microsoft и Google уже представили Copilot и Gemini для Edge и Chrome, а Opera и DuckDuckGo также уже зашли в этот «океан», экспериментируя с ИИ. В компании отметили, что будут продолжать тестирование версии Nightly, прежде чем внедрять эту функцию в бета-версию и официальный релиз Firefox. Amazon тайно готовит собственного конкурента для ChatGPT

25.06.2024 [14:53],

Алексей Разин

Видя потенциал технологий генеративного искусственного интеллекта, мало кто из гигантов IT-рынка хочет упускать соответствующие возможности. Если Microsoft инвестирует средства непосредственно в стартап OpenAI, то Amazon пытается разрабатывать конкурента ChatGPT собственными силами, как сообщают осведомлённые источники. Профильный проект Amazon получил условное обозначение Metis.

Источник изображения: AWS Об этом сообщает издание Business Insider со ссылкой на собственные источники. Скорее всего, секретный проект Amazon унаследовал имя Metis от древнегреческой богини мудрости, которая в русскоязычных источниках упоминается как Метида. По замыслу создателей, доступ к данному чат-боту будет предоставляться клиентам через обычный веб-браузер, как это происходит с ChatGPT и подобными решениями. Греческую мифологию поддерживает и название лежащей в основе Metis ИИ-модели, которая носит обозначение Olympus. По имеющимся данным, эта модель является более производительной версией публично доступной Titan. В самой простой версии взаимодействия с пользователями Metis будет способна выдавать ответы в текстовом виде и изображениях, напоминая клиентам общение с обычным человеком. Модель также подразумевает предоставление ссылок на источники информации в своих ответах, поддерживает уточняющие запросы и умеет генерировать изображения. Amazon хочет научить Metis работать по методу генерации с дополненной выборкой, который подразумевает использование для ответов на запросы информации, которая выходит за рамки тех массивов, на которых большая языковая модель Olympus проходила обучение. Это позволит давать более актуальные ответы на те вопросы, в сфере которых информация обновляется очень оперативно. В частности, у чат-бота Amazon будет доступ к свежим данным о курсовой стоимости ценных бумаг, чем не могут похвастать некоторые конкурирующие решения. Metis сможет выступать и в роли так называемого ИИ-агента, который поможет частично автоматизировать задачи, связанные с обработкой пользовательских данных. Системе будет по силам составить оптимальный маршрут путешествия клиента в отпуске и забронировать билеты на нужные рейсы. Amazon в сегменте систем искусственного интеллекта находится в числе отстающих, а потому стремится быстрее наверстать упущенное. В этом году компания рассчитывает получить до $1 млрд выручки, так или иначе связанной с искусственным интеллектом, а в последующие годы увеличить эту сумму до десятков миллиардов долларов США. Глава компании Энди Джесси (Andy Jassy) лично курирует разработку чат-бота Metis и языковой модели Olympus, как подчёркивают источники. Старший вице-президент Amazon и ведущий научный советник Рохит Прасад (Rohit Prasad) при этом возглавляет подразделение по разработке сильного искусственного интеллекта, которое решает самые амбициозные задачи компании в этой сфере. Вице-президент Amazon Вишал Шарма (Vishal Sharma) также вовлечён в работу над проектом Metis. К команде примкнули и специалисты, имеющие опыт работы над голосовым ассистентом Alexa. Часть их наработок будет задействована для создания фирменного чат-бота. Если всё пойдёт по плану, то Amazon представит Metis в сентябре этого года на традиционном мероприятии, обычно раскрывающем новейшие успехи в совершенствовании Alexa. Некоторые специалисты компании настроены пессимистично в отношении Metis, поскольку считают, что было упущено много времени, и конкуренты ушли далеко вперёд. Выручка OpenAI в годовом выражении достигла $3,4 млрд, удвоившись с конца прошлого года

13.06.2024 [09:02],

Алексей Разин

Стартап OpenAI считается одним из главных игроков рынка систем генеративного искусственного интеллекта, но количественных характеристик его успеха известно не так много. По данным The Information, руководство OpenAI недавно призналось, что в приведённой к году величине выручка компании достигает $3,4 млрд против $1,6 млрд в конце прошлого года.

Источник изображения: OpenAI Данный показатель рассчитывается методом умножения месячной выручки на 12, поэтому с учётом роста выручки в течение года может не отображать реального размера годовой выручки, но в данном случае важна сама динамика. Всего за полгода OpenAI смогла удвоить свою выручку в годовом выражении. Для сравнения, прошлым летом этот показатель был близок к $1 млрд. Это значит, что за прошедшие двенадцать месяцев выручка OpenAI выросла почти в три с половиной раза. Эти значения прозвучали во время выступления генерального директора OpenAI Сэма Альтмана (Sam Altman) на недавнем собрании сотрудников компании. Примерно $3,2 млрд выручки в приведённом к году размере OpenAI получает от предоставления своих услуг клиентам напрямую, ещё $200 млн в год компания способна получать за счёт сотрудничества с Microsoft Azure. В текущем полугодии капитализация стартапа оценивалась в $86 млрд. Компания недавно наняла финансового директора Сару Фрайар (Sarah Friar), хотя на протяжении двух лет подряд эта должность оставалась вакантной. Эксперты считают, что это может указывать на стремление OpenAI увеличить финансовую отдачу от развития своего бизнеса, а также на возможность подготовки компании к публичному размещению акций. Илон Маск отказался от иска против OpenAI

12.06.2024 [05:40],

Анжелла Марина

Маск неожиданно отозвал иск против OpenAI и её генерального директора Сэма Альтмана за день до назначенного судебного заседания. Юристы указали на серьёзные изъяны в иске, в котором Маск ссылается на несуществующий договор и не предоставляет существенных доказательств.

Источник изображения: OpenAI, Grok AI В феврале Маск подал иск в суд штата Калифорния, обвинив OpenAI в нарушении условий контракта и отказе от заявленной изначально миссии по созданию технологий искусственного интеллекта во благо человечества. Согласно иску, OpenAI нарушила договоренности, достигнутые с Маском и другими основателями компании. В частности, каждый из них взял на себя обязательство сделать OpenAI некоммерческой организацией и не закрывать доступ к её технологиям, сохраняя исходный код открытым, сообщает издание The Verge. Юристы отметили существенные изъяны в иске Маска. Во-первых, он ссылается на несуществующий договор. Хотя в жалобе упоминается «Учредительное соглашение», такой документ не был приложен в качестве доказательства. Во-вторых, признаётся, что это соглашение носило скорее декларативный характер и базировалось на общих настроениях, высказанных в переписке. Сама OpenAI опровергла обвинения Маска сразу после подачи иска. Компания заявила, что миллиардер просто хотел получить полный контроль над ней путём слияния с Tesla. При этом подчёркивалось, что никакого юридически обязывающего соглашения с Маском заключено не было. Напомним, в прошлом году Маск основал собственную компанию в сфере искусственного интеллекта xAI. Разработчики создали чат-бот Grok AI, доступный по подписке X Premium и привлекли 6 млрд долларов инвестиций на разработку и дорогостоящие чипы. По данным СМИ, Маск перенаправил на нужды xAI тысячи чипов Nvidia H100, изначально предназначавшихся для Tesla. Отзыв иска против OpenAI может быть связан с желанием Маска сосредоточиться на развитии собственного проекта в сфере ИИ. Однако юридическая тяжба с OpenAI может возобновиться, поскольку Маск добровольно отозвал свой судебный иск до первого слушания. В устройства Apple интегрируют не только ChatGPT — будут и другие модели, включая Google Gemini

11.06.2024 [12:28],

Алексей Разин

Конференция WWDC 2024 на этой неделе подтвердила информацию об интеграции чат-бота ChatGPT компании OpenAI с функциями голосового интерфейса Siri компании Apple. Руководство последней также дало понять, что ChatGPT всё не ограничится, и в случае необходимости Apple могла бы реализовать интеграцию с другими большими языковыми моделями типа Google Gemini.

Источник изображения: Apple Об этом в интервью после открытия WWDC 2024 заявил старший вице-президент Apple Крейг Федериги (Craig Federighi), как отмечает TechCrunch. «В будущем мы ожидаем интеграцию с другими моделями, включая Google Gemini, например», — пояснил представитель компании. Сейчас он не готов делать соответствующие официальные анонсы, но именно в этом направлении Apple движется, как добавил Крейг Федериги. Доступ пользователей iOS 18 к ChatGPT, как уже отмечалось накануне, не потребует отдельной оплаты или авторизации в сервисах OpenAI, а вопросы безопасной передачи данных будут регулироваться достаточно прозрачно. Как пояснили представители компании, прежде чем переключиться на использование сервисов OpenAI, пользователи Apple получат от Siri уточняющий вопрос с просьбой подтвердить это действие. Если от пользователя потребуется передача какой-либо информации в инфраструктуру OpenAI, то ему также придётся подтвердить этот шаг через фирменного голосового ассистента Siri. Кстати, подобная интеграция уже насторожила Илона Маска (Elon Musk) до такой степени, что он собрался запретить сотрудникам своих компаний использовать устройства Apple, поддерживающие iOS 18. По мнению миллиардера, передача информации через платформу Apple в сторону OpenAI создаёт существенные риски для её защищённости. «Думаем, вам это понравится»: Apple интегрирует бесплатный ChatGPT в iPhone, iPad и Mac

10.06.2024 [22:37],

Николай Хижняк

Компания Apple объявила в рамках своей презентации на WWDC 2024 о сотрудничестве c OpenAI. В рамках данного взаимодействия возможности чат-бота ChatGPT будут интегрированы в голосового помощника Siri, а также в другие инструменты iOS и остальных платформ Apple.

Источник изображений: Apple Сотрудничество с Apple также подтвердил глава OpenAI Сэм Альтман (Sam Altman). «Мы рады объявить о сотрудничестве с Apple по интеграции ChatGPT в их устройства позже в этом году. Думаем, вам это понравится», — написал Альтман на своей странице в соцсети X.  ChatGPT станет доступен пользователям операционной системы iOS 18, iPadOS 18 и macOS Sequoia совершенно бесплатно. Для его использования не потребуется заводить учётную запись. Apple также говорит, что ИИ-чат-бот не будет вести логи запросов пользователей. Популярный чат-бот также будет интегрирован в общесистемные программные письменные инструменты iOS. При наличии подписки на платную версию чат-бота его также можно будет подключить к продуктам Apple. Как пишет портал The Verge, ранее ходили разговоры, что Apple ведёт переговоры с Microsoft и Google о возможности интеграции их ИИ-технологий в свои операционные системы. В конечном итоге Apple выбрала OpenAI в качестве партнёра в этом вопросе. Ссылаясь на слухи источник также пишет, что выпуск новой версии ИИ-модели GPT-4o компанией OpenAI был в том числе направлен на то, чтобы показать, какие возможности могут появиться в улучшенной Siri. Сегодня Apple подтвердила, что её устройства в этом году получат поддержку ChatGPT на базе новейшей языковой модели GPT-4o с выходом операционных систем iOS 18, iPadOS 18 и macOS Sequoia. На фоне анонса сотрудничества с OpenAI компания Apple также представила набор новых ИИ-функций в рамках инициативы Apple Intelligence. У ChatGPT произошёл второй массовый сбой за сутки — проблемы возникли также у Gemini и Claude

04.06.2024 [23:28],

Анжелла Марина

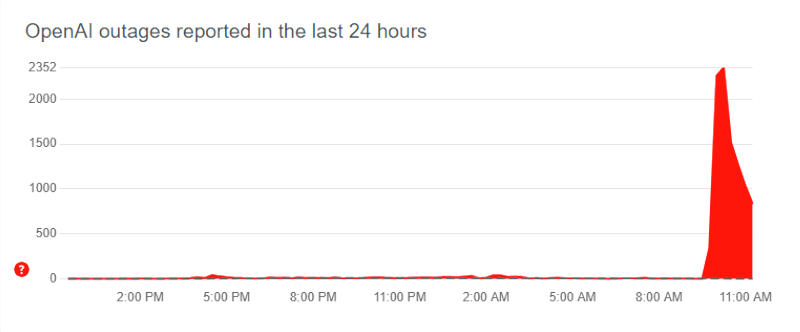

Серьёзный сбой произошёл в работе ИИ-сервисов ChatGPT, Claude, Gemini и Perplexity. Пользователи жаловались на недоступность данных служб. Эксперты не исключают, что причиной второго за день сбоя ChatGPT могла стать очередная масштабная кибератака, что показало уязвимость системы перед различного рода проблемами.  Источник изображения: Kandinsky Первые сообщения о новом сбое и недоступности ChatGPT начали поступать примерно в 17:30 мск. Тысячи пользователей как мобильного приложения, так и веб-версии ChatGPT жаловались на отсутствие связи и ответа от сервиса. Примерно в то же время некоторые пользователи столкнулись с проблемами при использовании Google Gemini. Кроме того, перестал работать Claude от компании Anthropic. К 20:17 мск OpenAI подтвердила, что проблема с ChatGPT решена и сервис снова доступен для пользователей. Также к 20:30 была восстановлена работа Claude и Perplexity AI. Как сообщает издание The Verge, это уже второй масштабный сбой ChatGPT за сутки. И далеко не первые проблемы за последние месяцы. В ноябре прошлого года служба не работала около 90 минут, что повлияло и на API OpenAI. Тогда причиной называлась DDoS-атака. Также в прошлом месяце произошёл сбой в работе поисковых функций ChatGPT из-за проблем у Microsoft. Был недоступен и сервис Copilot. Эксперты полагают, что сегодняшний масштабный сбой мог быть связан с резким ростом популярности ChatGPT и других моделей ИИ за последние месяцы. Компаниям приходится наращивать вычислительные мощности, чтобы обеспечить стабильную работу сервисов под нагрузкой. А возможно, речь опять идет о координированной атаке. Ожидается официальный комментарий от представителей компаний. В работе ChatGPT произошёл масштабный сбой

04.06.2024 [13:12],

Павел Котов

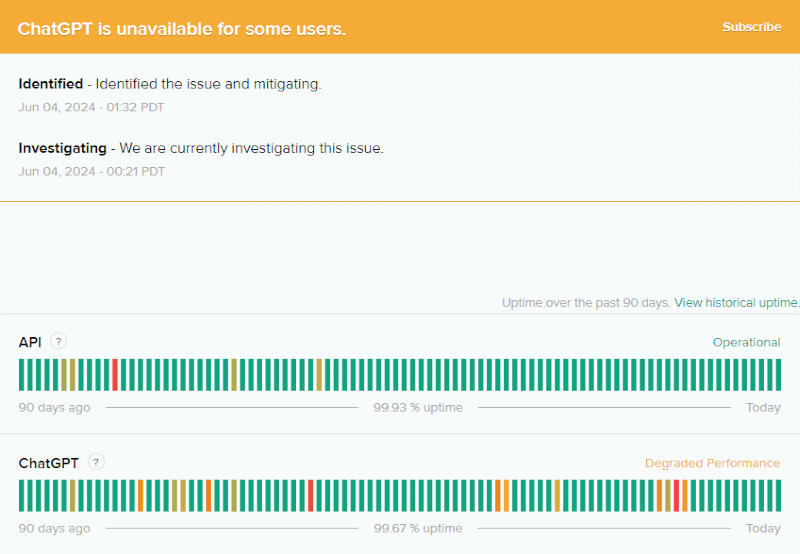

В работе ChatGPT, популярного чат-бота на основе искусственного интеллекта, произошёл сбой — многие пользователи сообщают, что не могут открыть сервис. Не работает вход в систему, не работает отправка запросов чат-бот, а от него не поступают ответы. Причины сбоя пока неизвестны.

Источник изображения: ilgmyzin / unsplash.com Пользователи соцсети X массово жалуются, что ChatGPT не работает. В отдельных случаях интерфейс чат-бота не загружается полностью, а при попытке отправить ему сообщение выводится сообщение об ошибке просроченного входа. Даже после входа чат-бот не загружается, и цикл ошибок повторяется.

Источник изображения: downdetector.com Сервис мониторинга сбоев веб-служб DownDetector показывает, что проблемы с доступом к ресурсам OpenAI наблюдаются по всему миру. Страница статуса самого ChatGPT подтверждает, что сервис недоступен для некоторых пользователей, а причины сбоя изучаются — здесь же указано, что за последние 90 дней время безотказной работы (аптайм) ChatGPT составило 99,67 %.

Источник изображения: openai.com Причины сбоя ChatGPT пока достоверно неизвестны. Они могут быть связаны с резким ростом трафика или какой-то другой проблемой. Неизвестно также, насколько долго продлится перерыв в работе сервиса. У бесплатных пользователей ChatGPT появился доступ к кастомным версиям GPT

30.05.2024 [11:38],

Павел Котов

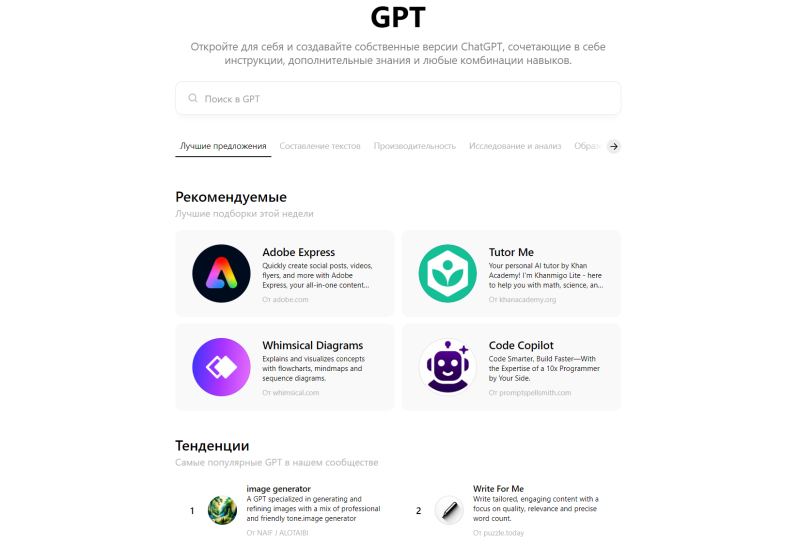

Пользователи бесплатного варианта ChatGPT получили доступ к созданным сообществом спецверсиям моделей GPT — с ними можно анализировать диаграммы, задавать вопросы о фотографиях и работать с другими функциями, которые в начале мая получила официальная GPT-4o.

Источник изображения: ilgmyzin / unsplash.com Ранее такие функции как ответы с веб-поиском, анализ данных, создание диаграмм, машинное зрение, загрузка файлов, память контекста и спецверсии GPT были доступны лишь для пользователей тарифов ChatGPT Plus, Teams и Enterprise — теперь же они открыты для всех, кто пользуется ChatGPT. А вот своих собственных версий GPT пользователи бесплатного варианта ChatGPT создавать пока не могут.

Источник изображения: OpenAI Функции аналитики данных и создания диаграмм позволяют напрямую подключать хранилища OneDrive и Google Drive к ChatGPT. Разработчики специальных версий GPT также могут участвовать в программе распределения доходов, которую OpenAI в тестовом режиме запустила в марте.

Источник изображения: OpenAI У платных подписчиков есть ещё одно преимущество — менее жёсткие ограничения на число сообщений. Когда пользователи бесплатной платформы достигают лимита сообщений в чате с GPT-4o, они автоматически переключаются на менее мощную GPT-3.5. Голос ИИ Sky, до степени смешения напоминающий голос Скарлетт Йоханссон (Scarlett Johansson) даже самой актрисе, пока остаётся недоступным. Больше половины ответов ChatGPT на вопросы по программированию неверны — исследование

25.05.2024 [16:35],

Владимир Мироненко

В последнее время на фоне ажиотажа вокруг технологий ИИ программисты стали всё чаще обращаться за помощью в написании кода программ к чат-ботам на базе ИИ, таким как ChatGPT от OpenAI, что повлекло за собой снижение посещаемости ресурса Stack Overflow, вынужденного уволить в прошлом году почти 30 % персонала.

Источник изображения: geralt/Pixabay Как оказалось, полагаться на ИИ в написании программ пока рано. Согласно исследованию команды специалистов Университета Пердью, представленному в этом месяце на конференции Computer-Human Interaction («Взаимодействие компьютера и человека»), 52 % ответов по программированию, сгенерированных ChatGPT, оказались неверны. В ходе исследования программисты Университета Пердью просмотрели более 517 вопросов в сервисе Stack Overflow и проанализировали ответы на них чат-бота ChatGPT. «Мы обнаружили, что 52 % ответов ChatGPT содержат дезинформацию, 77 % ответов более многословны, чем человеческие ответы, а 78 % ответов характеризуются различной степенью несоответствия ответам людей», — отметили исследователи. Команда исследователей также провела лингвистический анализ 2000 случайно выбранных ответов ChatGPT и обнаружила, что они «более формальные и аналитические», но при этом отражают «менее негативные настроения» — чем обычно отличается ИИ. Комментируя результаты исследования, сайт Futurism выразил обеспокоенность тем, что многие программисты предпочитают обращаться за помощью к ChatGPT. Исследователи Университета Пердью опросили 12 программистов и обнаружили, что 35 % респондентов предпочитают полагаться на ответы ChatGPT и не замечают ошибок в ответах, сгенерированных ИИ, в 39 % случаев. Исследователи допускают, что пользователей подкупает вежливость, проявляемая ИИ. «Последующие полуструктурированные интервью показали, что вежливый язык, чётко сформулированные ответы в стиле учебника, а также полнота являются одними из основных причин, по которым ответы ChatGPT выглядели более убедительными, поэтому участники ослабили бдительность и упустили из виду некоторую дезинформацию в ответах ChatGPT», — сообщили они. Представлен электромобиль Kia EV3 с голосовым помощником на базе ChatGPT

23.05.2024 [18:44],

Сергей Сурабекянц

Сегодня Kia представила полностью электрический кроссовер EV3, который иллюстрирует растущий интерес мировых автопроизводителей к внедрению генеративного ИИ в свои автомобили. Электромобиль будет оснащён новым голосовым помощником, созданным на базе ChatGPT от OpenAI. Сама Kia также приложила руку к разработке голосового помощника — большая языковая модель, лежащая в основе ChatGPT, была модифицирована и настроена автопроизводителем. Голосовые помощники в транспортных средствах не новость, при этом далеко не всегда водители оценивают их положительно. Автопроизводители, такие как BMW, Kia, Mercedes-Benz и Volkswagen, утверждают, что генеративный ИИ сделает голосовых помощников гораздо более функциональными и даст возможность водителям и пассажирам взаимодействовать с ними естественным образом. На сегодняшний день некоторые автопроизводители уже сделали первые шаги к масштабному внедрению генеративного ИИ в транспортные средства. Mercedes-Benz добавила диалогового ИИ-бота в свою информационно-развлекательную систему MBUX в июне 2023 года. В январе 2024 года BMW и Volkswagen продемонстрировали свои варианты этой технологии на выставке CES в Лас-Вегасе. Голосовой помощник Kia Assistant впервые дебютировал в апреле 2024 года в новом компактном седане с ДВС Kia K4. Руководитель отдела дизайна Kia Пабло Мартинес (Pablo Martinez), рассказал, что лежащая в основе ИИ-помощника большая языковая модель, представляет собой ChatGPT от OpenAI, но она была «сильно модифицирована и настроена автопроизводителем, чтобы позволить клиентам планировать поездки, управлять автомобилем и находить развлечения, включая музыку и игры». В первое время электромобиль будет доступен только с мотором мощностью 204 л.с. (283 Нм), а вот батарей будет два варианта: стандартной ёмкости на 58,3 кВт·ч и Long Range на 81,4 кВт·ч. Последняя обеспечит до 600 км хода по циклу WLTP. Поддерживается быстрая зарядка — с 10 до 80 % батарея восполняется всего за 31 минуту. Разгон до 100 км/ч кроссовер разгоняется за 7,5 секунды, а максимальная скорость составляет 170 км/ч. Kia EV3 станет первым полностью электрическим автомобилем в портфолио компании, оснащённым новым помощником на базе ИИ. Продажи Kia EV3 стартуют в Корее в июле 2024 года, во второй половине года кроссовер появится в продаже в Европе. Дата начала поставок в США не называется. Стоимость, согласно предварительным данным, будет начинаться от 30 тыс. долларов. |