|

Опрос

|

реклама

Быстрый переход

Google потратит на строительство трёх новых ЦОД в Техасе $40 млрд

15.11.2025 [07:45],

Алексей Разин

Техас стал тем американским штатом, в котором крупные игроки облачного сегмента и амбициозные стартапы охотно возводят центры обработки данных, и в этом смысле Google не желает отставать от OpenAI, Anthropic или xAI. Интернет-гигант направит на строительство трёх новых ЦОД в Техасе $40 млрд, как сообщает Bloomberg.

Источник изображения: Nvidia Специализация этих вычислительных мощностей в условиях бума ИИ вполне предсказуемо, поскольку они будут задействованы под развитие соответствующей инфраструктуры. По информации самой Google, указанная сумма будет поэтапно инвестирована в строительство трёх новых ЦОД в Техасе до 2027 года включительно. Один из этих ЦОД расположится по соседству с энергетическим хабом, подразумевающим наличие большого количества солнечных панелей и батарей для стационарного хранения электроэнергии. Проект позволит Google создать в Техасе тысячи новых рабочих мест, а также обучить специалистов в разных смежных областях. Кроме того, развитие сопутствующей инфраструктуры сделает электроэнергию более доступной для жителей Техаса и местного бизнеса, как отмечается в официальном заявлении компании. Google уже располагает двумя центрами обработки в Далласе, там же она провела церемонию, на которой объявила о своих планах по дальнейшему расширению вычислительных мощностей в этом штате. Облачных гигантов в Техас привлекают содействие властей штата в реализации профильных проектов, большие участки земли и относительно дешёвая электроэнергия. Google выразила готовность активно содействовать развитию энергетики штата и субсидировать сопутствующие затраты. За счёт компании в штате будут получать специальное образование будущие сотрудники энергетических компаний. Недавно конкурирующая Anthropic также объявила о намерениях потратить $50 млрд на строительство ЦОД в США, включая и территорию Техаса. В этом штате строится и первый ЦОД в рамках мегапроекта Stargate, который финансируется OpenAI, Oracle и SoftBank. Крупные вычислительные мощности возводит в этом штате и Meta✴✴ Platforms, а также корпорация Microsoft. Здесь планируется построить четыре ядерных реактора для питания окрестных ЦОД. Сама Google только в текущем году готова направить $90 млрд на капитальное строительство, так что проект в Техасе вполне укладывается в инвестиционную программу этой корпорации. За прошедшие два месяца Google анонсировала сразу несколько проектов по развитию локальной вычислительной инфраструктуры в разных странах: $15 млрд планируется потратить в Индии, немецкая площадка может рассчитывать на получение $6,4 млрд, а Великобритания получит более $6,5 млрд. Google представила приватное облако для безопасной обработки ИИ-запросов пользователей

12.11.2025 [08:23],

Алексей Разин

Работа систем искусственного интеллекта связана с обработкой больших массивов данных, в которые иногда попадает довольно чувствительная персональная информация. Запрет на её передачу в облако снижает эффективность работы ИИ, поэтому Google для наиболее мнительных, но при этом требовательных пользователей предложила новую облачную платформу, позволяющую конфиденциально обрабатывать их информацию.

Источник изображения: Unsplash, appshunter.io Многие функции сервисов Google типа перевода текстов и видео, транскрибирования аудио и переписки с чат-ботом реализованы таким образом, что пользовательские данные не покидают клиентских устройств. Ресурсы последних при этом ограничены и развиваются медленнее, чем облачная инфраструктура. Google предлагает пользователям разрешить передачу персональной информации в частное облако, чтобы повысить эффективность работы с искусственным интеллектом без угрозы для приватности пользователей. Новая платформа получила название Private AI Compute, по своей концепции она повторяет принципы работы Private Cloud Compute компании Apple. Наиболее простые запросы при этом по-прежнему будут обрабатываться на стороне смартфона, то есть, информация будет передаваться в облако выборочно. Доступа к пользовательским данным сама Google иметь не будет, как сообщает The Verge. Расширение вычислительных ресурсов за счёт облака позволит усилить возможности функций искусственного интеллекта на стороне клиентских устройств. Например, записи диктофона можно будет переводить в текстовую форму для большего количества языков, чем это было доступно при использовании только локальных ресурсов. ИИ-чипы Google TPU обрели популярность спустя 10 лет после дебюта — Anthropic арендовала 1 млн ускорителей

24.10.2025 [13:27],

Алексей Разин

Дефицит вычислительных мощностей, возникающий из-за стремительного развития систем искусственного интеллекта, выставляет в выгодном свете даже те платформы, которые на протяжении многих лет не пользовались популярностью. Процессоры TPU собственной разработки Google, например, оказались в большом количестве задействованы компанией Anthropic PBC при развитии вычислительной инфраструктуры.

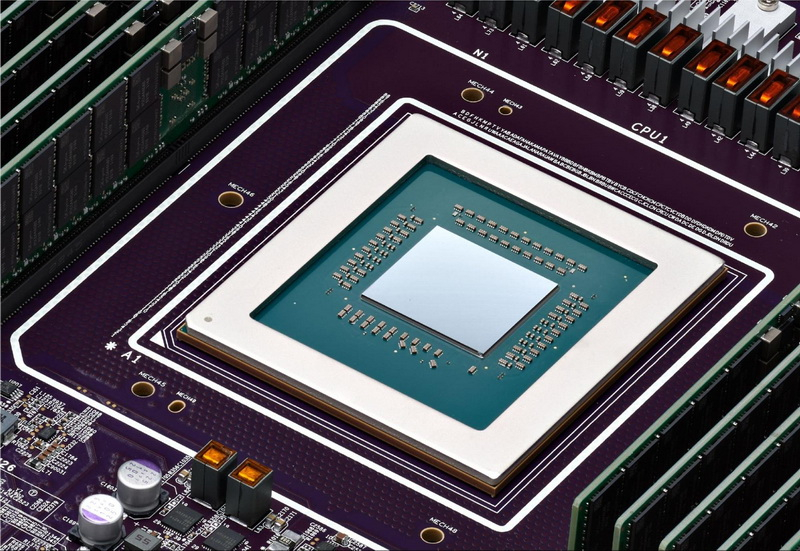

Источник изображения: Google Как поясняет Bloomberg, недавно Anthropic PBC заключила контракт с Google на использование более чем 1 ГВт вычислительной мощности, сделка оценивается десятками миллиардов долларов США. По её условиям, Anthropic получит доступ к 1 млн процессоров TPU собственной разработки Google, которые эксплуатируются в облачной инфраструктуре интернет-гиганта. До сих пор основным потребителем таких процессоров оставалась сама Google, хотя первые процессоры этого семейства были разработаны ею более десяти лет назад. Это уже не первый контракт такого рода между Google и Anthropic, но расширение сотрудничества между компаниями указывает на заинтересованность последней в использовании указанных процессоров. Не исключено, что пример Anthropic вдохновит и прочие ИИ-стартапы арендовать у Google вычислительные мощности, основанные на TPU. Разработку этих довольно узко специализированных процессоров Google начала в 2013 году, но первые модели представила только двумя годами позже. Первоначально они применялись для ускорения работы собственного поискового сервиса Google. В облачную инфраструктуру компания начала внедрять TPU в 2018 году, тем самым открыв доступ к данной платформе для сторонних клиентов. Со временем Google начала использовать TPU для работы фирменных ИИ-сервисов. Процессоры дорабатывались с учётом опыта, полученного при развитии соответствующих сервисов Google. В этом процессе были задействованы и специалисты DeepMind, также принадлежащей интернет-гиганту. Чипы Nvidia в этой сфере считаются более универсальными и производительными, но они отличаются и высоким энергопотреблением, а также стоимостью и остаются в дефиците. TPU в процессе своей эволюции тоже неплохо приспособились к вычислительным нагрузкам, характерным для сферы ИИ. При этом они доступнее, потребляют меньше электроэнергии и не требуют столь серьёзного охлаждения. Помимо Anthropic, инфраструктуру Google на базе TPU для своих нужд используют Salesforce, Midjourney и стартап SSI одного из основателей OpenAI Ильи Суцкевера. Скорее всего, процессоры TPU со временем начнут применяться и за пределами облачной инфраструктуры самой Google. При этом Google продолжит оставаться одним из крупнейших клиентов Nvidia, поскольку чипы последней лучше приспособлены к изменениям в характере вычислительных нагрузок. Собственные процессоры Google в этом отношении хуже адаптируются к изменениям без сопутствующих аппаратных преобразований. Новейшее поколение TPU под обозначением Ironwood было представлено в апреле, оно заточено под инференс и рассчитано на использование жидкостного охлаждения. В одном кластере может быть объединено либо 256 таких чипов, либо 9216 штук. Специалисты, которые стояли у истоков TPU, сейчас во многих случаях нашли себе работу в ИИ-стартапах. Они опосредованно поддерживают степень влияния Google в отрасли. OpenAI избавляется от зависимости от Microsoft: часть инфраструктуры ChatGPT переедет в Google Cloud

17.07.2025 [12:41],

Павел Котов

Компания OpenAI сообщила накануне, что намеревается использовать для своего популярного помощника с искусственным интеллектом ChatGPT облачную инфраструктуру Google. Разработчик уже пользуется облачными услугами Microsoft, Oracle и CoreWeave.

Источник изображения: Dima Solomin / unsplash.com OpenAI наращивает вычислительные мощности для удовлетворения высокого спроса на свои сервисы, чтобы было затруднительно, когда компания зависела исключительно от ресурсов Microsoft. Отношения двух компаний меняли формат, и в прошлом году Microsoft признала в OpenAI конкурента: обе предлагают инструменты ИИ для разработчиков и продают подписки для компаний. Теперь OpenAI добавила в список своих поставщиков и Google Cloud — сервис ChatGPT и интерфейс прикладного программирования будут также работать на платформах Microsoft, CoreWeave и Oracle. Для Google это достижение, потому что её облачное подразделение моложе и меньше, чем у Amazon и Microsoft. Google Cloud обозначит присутствие в США, Японии, Нидерландах, Норвегии и Великобритании. Первым облачным партнёром OpenAI после Microsoft ещё в прошлом году стала Oracle, которая обеспечила разработчику ИИ дополнительные вычислительные мощности; в марте этого года был заключено пятилетний контракт с CoreWeave на сумму почти $12 млрд — Microsoft ещё в январе разрешила OpenAI пользоваться облачными ресурсами конкурентов и перестала претендовать на статус эксклюзивного поставщика услуг. О намерении компании обратиться в Google Cloud стало известно в июне. «Мы глубоко сожалеем»: Google выпустила мини-отчёт об инциденте, сломавшем половину интернета

13.06.2025 [17:00],

Павел Котов

Google опубликовала «мини-отчёт об инциденте» в работе своей облачной платформы, который привёл к сбою в работе нескольких крупных сервисов, включая Spotify, Discord, Snapchat, OpenAI, а также службы самого поискового гиганта.

Источник изображения: BoliviaInteligente / unsplash.com «Мы глубоко сожалеем о последствиях, которые вызвало это нарушение/сбой в работе сервиса для всех наших пользователей и их клиентов. Google Cloud доверяют свои рабочие нагрузки крупные и мелкие компании, и мы будем работать лучше. В ближайшие дни мы опубликуем полный отчёт об инциденте с указанием причины, подробных временных рамок и надёжных мер по устранению неполадок, которые мы предпримем. Учитывая масштаб и последствия этого инцидента, мы хотели бы предоставить некоторую информацию ниже», — гласит заявление компании. Инцидент, гласят официальные данные, произошёл 12 июня в 10:49 по Тихоокеанскому времени (21:49 мск), а работоспособность всех систем удалось восстановить ровно через три часа, в 13:39 (13 июня 0:49 мск); сбой затронул системы Google по всему миру. Основным симптомом проблемы стал резкий рост ответа «ошибка 503» в нескольких продуктах Google Cloud и Google Workspace при внешних запросах API. «Согласно нашему первоначальному анализу, проблема возникла из-за недопустимого автоматического обновления квоты в нашей системе управления API, которая распространилась по всему миру и привела к отказу при выполнении внешних запросов API. Для восстановления работы мы включили обход проверки квоты, что позволило вернуть работу в большинстве регионов в течение двух часов. Однако база данных политики квот в [регионе] us-central1 оказалась перегружена, что привело к гораздо более длительному восстановлению в этом регионе. У нескольких продуктов были умеренные остаточные последствия (например, невыполненные задания) в течение часа после устранения основной проблемы, и после этого произошло частичное восстановление», — говорится в кратком отчёте. Чтобы не допускать возникновения подобных сбоев в будущем, компания пообещала принять следующие меры:

Alphabet потратит $75 млрд «на ускорение прогресса» в 2025 году — больше Meta✴, но меньше Microsoft

05.02.2025 [07:37],

Алексей Разин

Корпорация Alphabet, в состав которой входит компания Google, отчиталась на этой неделе о финансовых итогах четвёртого квартала прошлого года. Совокупная выручка выросла на 12 % до $96,47 млрд, но оказалась ниже прогнозов аналитиков. Рост выручки в облачном сегменте на 30 % до $11,96 млрд тоже не оправдал ожиданий инвесторов, но в этом году компания собирается выделить $75 млрд на капитальные затраты с целью расширения вычислительных мощностей.

Источник изображения: Alphabet Квартальные отчёты американских корпораций, являющихся крупнейшими игроками мирового рынка облачных вычислений, выходят на фоне интереса к успехам китайского стартапа DeepSeek, который создаёт вполне конкурентоспособные большие языковые модели в условиях ограниченности материальных и технических ресурсов. Как известно, Meta✴✴ Platforms в этом году выделит от $60 до $65 млрд в качестве капитальных затрат, Microsoft на подобные нужды готова выделить $80 млрд. На этом фоне Google как раз укладывается между ними со своей суммой $75 млрд, причём она оказывается существенно выше ожиданий рынка, соответствующих значению $58,84 млрд. Капитальные затраты Google в этом году будет направлять «преимущественно на развитие технической инфраструктуры, в первую очередь — серверов, и уже потом центров обработки данных и сетевых решений». Только в этом квартале капитальные затраты Google составят от $16 до $18 млрд, что также выше прогноза аналитиков ($14,3 млрд). В прошлом квартале капитальные затраты Alphabet составили $14 млрд, превысив заложенную аналитиками в прогноз величину ($13,26 млрд). В текущем году Alphabet также намеревается увеличить численность персонала на облачном направлении и в сегменте систем искусственного интеллекта. Квартальный отчёт Alphabet в целом разочаровал инвесторов. Прежде всего, темпы роста выручки холдинга снизились до 12 %, хотя год назад они достигали 13 %. Выручка Google медленнее росла и в сегменте YouTube, и в поисковом, и на направлении услуг. Правда, известный видеохостинг по итогам квартала выручил $10,47 млрд, что выше ожиданий рынка. В облачном сегменте выручка Google ограничилась $11,96 млрд против заложенных инвесторами в прогноз $12,19 млрд, но она всё равно увеличилась на 30 %. По мнению руководства компании, спрос на этом направлении превышал возможности Google по оказанию профильных услуг. Рекламная выручка Google выросла по итогам квартала на 10,6 % против 11 % годом ранее. В поисковом бизнесе выручка выросла на 12,5 % против 12,7 % годом ранее. YouTube рекламную выручку увеличил на 13,8 % против 15,5 % годом ранее, в сегменте услуг выручка выросла на 10,2 % против 12,4 % годом ранее. Всё это способствовало падению курса акций холдинга более чем на 9 % после завершения торгов накануне. Чистая прибыль Alphabet увеличилась на 28 % до $26,54 млрд по итогам прошлого квартала. На направлении Other Bets, которое включает и разработчика систем автопилота на транспорте Waymo, выручка по итогам квартала сократилась на 39 % до $400 млн, и также оказалась заметно ниже ожиданий аналитиков. Тем не менее, та же Waymo начала расширять территорию эксплуатации своих беспилотных такси, и это потенциально позволяет рассчитывать на увеличение профильной выручки. Google представила Axion — свой первый Arm-процессор

09.04.2024 [16:52],

Николай Хижняк

Компания Google анонсировала свой первый Arm-процессор — он получил название Axion и предназначается для использования в серверных системах для ЦОД. В своём пресс-релизе Google заявляет, что Axion обеспечивает лидирующие в отрасли показатели производительности и энергоэффективности.

Источник изображения: Google Cloud Подробного описания процессора компания не приводит. Известно, что в основе Axion используются ядра Arm Neoverse V2 с архитектурой ArmV9 и привычным для неё набором инструкций. Также в составе чипа применяются специализированные микроконтроллеры Titanium, на которые возлагаются задачи, связанные с сетевыми подключениями и безопасностью. Кроме того, Titanium перекладывает операции обработки ввода-вывода хранилища на Hyperdisk, службы сетевого блочного хранения данных в Google Cloud. По словам Google, Axion обеспечивает на 30 % более высокую производительность по сравнению с самыми быстрыми инструментами общего назначения на базе Arm в облаке, а также до 50 % больше производительности и до 60 % больше энергоэффективности по сравнению с сопоставимыми решениями на базе x86-совместимых процессоров. Наглядные примеры сравнений Google не приводит. В компании отмечают, что уже начали переводить свои сервисы BigTable, Spanner, BigQuery, Blobstore, Pub/Sub, Google Earth Engine и YouTube Ads на системы с процессорами Axion. В пресс-релизе Google Cloud также указано, что Axion построен на открытой основе, поэтому клиенты смогут переносить свои существующие рабочие нагрузки Arm в Google Cloud на новую платформу без каких-либо существенных изменений, используя программу SystemReady Virtual Environment (VE). Axion можно будет использовать во многих облачных сервисах Google, включая Google Compute Engine, Google Kubernetes Engine, Dataproc, Dataflow, Cloud Batch и других. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |