⇣ Содержание

|

Опрос

|

реклама

Самое интересное в новостях

Gigabyte GeForce PCX 5900

Введение

Для компании NVIDIA первое полугодие 2004 года выдалось, бесспорно, очень и очень удачным. Началось все с презентации новой серии графических процессоров NV4х (GeForce 6 Series), когда NVIDIA буквально потрясла всю IT - индустрию и повергла обозревателей в шок выдающимися возможностями и поистине революционными нововведениями в архитектуре графического процессора, и его спецификациями. Что немедленно получило подтверждение на практике. Просто громадный отрыв от вчерашних high-end решений, впечатляющая производительность буквально везде - и в синтетике, чем сразу воспользовались все фанаты бенчмаркинга, и в игровых приложениях, что заставило геймеров серьезно задуматься над бюджетом грядущего года на предмет покупки столь соблазнительного продукта. Разумеется, high-end решения, какими бы привлекательными они не выглядели, всегда имели, имеют, и будут иметь соответствующую цену. Это закономерно и вполне логично. Но что же делать, когда "и хочется, и колется"? И вот оно! Через некоторое время после первой презентации, на которой были представлены GeForce 6800Ultra и GeForce 6800, NVIDIA выпускает GeForce 6800GT, решение с пониженными относительно 6800Ultra штатными частотами, 16 конвеерами, и, соответственно, довольно значительно сниженной ценовой планкой. Это совершенно изменило расстановку сил, и если раньше продукт конкурентов - канадской компании ATI, - X800 PRO уверенно обходил GeForce 6800 non Ultra, то теперь у него появился гораздо более сильный соперник в лице 6800GT, и NVIDIA тем самым совершила крайне удачный маркетинговый ход, сделав большой подарок потребителям. Само собой напрашивается аналогия - когда таким же "подарком" стал выпуск видеокарт на чипе GeForce FX5900 XT, представляющем собой модификацию графического ядра NV35. Плата имела упрощенный, относительно FX5900, дизайн PCB и 128 Mb видеопамяти, и пониженные штатные частоты. Выпуск данных плат стал поистине "хитом" в соответствующем ценовом сегменте рынка и любимым продуктом оверклокеров. Это уже можно назвать историей. Но прогресс не стоит на месте. Вот уже и PCI-Express решения скоро наводнят рынок, потребитель перестанет смотреть на мост HSI как на диковинную новинку, а завсегдатаи конференций хардверной тематики будут наставлять новичков и спорить между собой что же лучше - MSI или Abit, Gigabyte или Leadtek, оперируя неопровержимыми фактами а-ля "А у меня она разогналась до ***/*** ". Пока же наша задача заключается в том, чтобы максимально подробно описать, что будет стоять в вашем компьютере через несколько месяцев/полгода/год. Сегодня мы представим вам GeForce PCX5900, PCI-Express "реинкарнацию" чипа NV35 (GeForce FX5900), оснащенную мостом AGP - PCI-Express.  С двумя из них - MSI GeForce PCX5750 и MSI RX600XT - вы уже встречались в нашем предыдущем обзоре, а интереснейшая во многих отношениях видеокарта GeCube RX600 PRO будет подробно представлена вам в одном из наших ближайших материалов. Cейчас же приступим к внешнему осмотру PCX5900. Комплектация В комплект поставки входит все самое необходимое, плюс некоторые дополнительные "приятные мелочи".

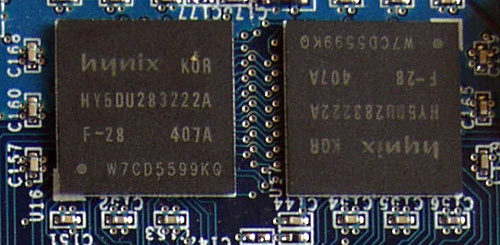

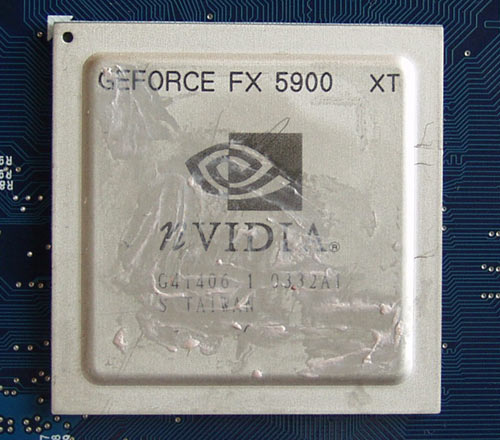

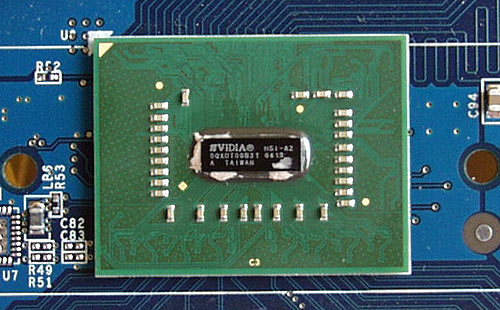

Дизайн и компоновка платы Милого узнают по походке, а продукцию Gigabyte - по привычному синему цвету текстолита. Здесь Gigabyte тоже осталась верна себе. Производителя данной видеокарты можно легко определить, не глядя на коробку, а ограничившись лишь мимолетным взглядом на саму плату. На карте установлено 128 Mb DDR памяти с шиной передачи данных 256Bit, набранные 8 микросхемами памяти Hynix с маркировкой HY5DU283222AF-28, выполненных в форм - факторе BGA, со временем выборки 2.8 ns, что соответствует частоте 350 MHz (700 MHz DDR).Но на данном экземпляре штатная частота работы видеопамяти оказалась заниженной до 275 MHz (550 MHz DDR). Что же, весьма интересно будет посмотреть на разгонный потенциал памяти на этой плате.  Все 8 микросхем видеопамяти расположены на лицевой стороне платы без какого-либо охлаждения. Ну, а сейчас - "коротко о главном". Графический процессор. Прямо скажем, добраться до него было задачей архисложной. Ну когда же производители учтут пожелания и просьбы на грани молитв со стороны потребителей/обозревателей/ etc. и перестанут использовать в качестве термоинтерфейса эту нехорошую субстанцию, метко прозванную "терможвачкой"? Вот и сейчас, с помощью специальных инструментов и прочих "плясок с бубном" еле удалось отсоединить радиатор, об особенностях конструкции которого мы расскажем подробно чуть позже, от собственно чипа видеокарты. Усилия были вознаграждены и нашему взору предстал GPU.  И тут мы испытали самое настоящее изумление. В правом верхнем углу крышки, прикрывающей чип, была обнаружена надпись "XT". Чип GeForce FX 5900XT! Тот самый фаворит middle-end сектора прошлого раунда, о котором мы упоминали выше. Очень интересный поворот событий, не находите? Неужили NVIDIA решила возродить 5900ХТ в PCI-Express исполнении? По поводу GPU остается добавить, что он изготовлен на 32-й неделе 2003 года и имеет ревизию А1, как мы можем судить по маркировке. Штатная частота работы GPU составляет 350 MHz. Наконец мы добрались и до системы охлаждения. Gigabyte предусмотрела охлаждение для графического ядра в виде алюминиевого радиатора с символикой компании прямо по центру конструкции. При взгляде на систему охлаждения нам тут же вспомнилась GeForce FX5900 ХТ производства, само собой, Gigabyte. На этих двух платах абсолютно идентичный дизайн системы охлаждения, разница только в размере, существенно уменьшенном, так как на 5900ХТ массивный радиатор закрывал и GPU, и чипы памяти, расположенные точно таким же образом, как и на рассматриваемой PCX5900.  На данной плате дополнительное охлаждение для чипов памяти не предусмотрено, что, впрочем, давно перестало считаться минусом, так как пользователи, не интересующиеся разгоном своего железа, не будут и заботиться об их дополнительном охлаждении, оверклокеры и энтузиасты сочтут любое стандартное охлаждение недостаточно серьезным для своих целей, а моддеры предпочтут, скорее всего, установить радиаторы собственного "производства" и дизайна. Благо что сейчас в продаже имеется просто огромный ассортимент радиаторов на любой "вкус и цвет", да и никто не отменял пока что процессорные радиаторы, которые при наличии прямых рук и соответствующих инструментов можно легко модифицировать и приделать на чипы видеопамяти. На этом заканчиваем "лирическое отступление" на тему радиаторов на видеопамять, и вернемся к нашей сегодняшней героине. Следующая значимая деталь - мост HSI. На него также установлен радиатор.  На плате присутствует стандартный набор выходов: аналоговый, цифровой и S-Video.  Наверняка к этому моменту ваше любопытство достигло апогея. Что же, не будем больше вас томить. Here is the results. Тестовый стендДля тестирования использовался наш тестовый стенд, известный вам из наших предыдущих обзоров.

Тестовые программы:

Собственно тестирование. Вначале бросим взгляд на результаты синтетики:   И так, что же мы видим? В популярнейших "в народе" и любимых всеми бенчерами - энтузиастами тестовых пакетах компании Futuremark PCX5900 уверенно обходит соперников, одерживая победу по всем позициям и во всех разрешениях.    Здесь мы наблюдаем абсолютно аналогичную ситуацию. И теперь посмотрим, что же нам продемонстрируют игровые приложения. Тесты игровых приложений  РСХ5900 продолжает лидировать, однако ей "в затылок" дышит Х600ХТ, подробно описанный нами в предыдущем обзоре.  А вот и первое поражение. X600XT отрывается от конкурентов, а РСХ5900 приходится бороться уже с X600 PRO, который, напомним, имеет пониженные относительно Х600ХТ частоты.      Достоинства РСХ5900 ощущаются и в UT, но говорить о полной победе было бы неверно. Х600ХТ практически не отстает, а кое-где и обходит PCX5900.  В HALO PCX5900 снова впереди.  Чего не скажешь про демку Half Life2. Впрочем, ее результаты не стоит рассматривать как истину в последней инстанции.  А вот проигрыш в Tomb Rider - это уже более серьезный промах.  Здесь PCX5900 идёт вровень с X600XT, оставляя далеко позади Х600 PRO и РСХ5750. Впрочем, последняя традиционно замыкает "шествие", так что про нее можно было бы и не упоминать вовсе.   В Far Cry X600XT снова обходит РСХ5900, однако на более высоких разрешениях разрыв немного уменьшается.

|

|||||||||||||||||||||||||||||||||||