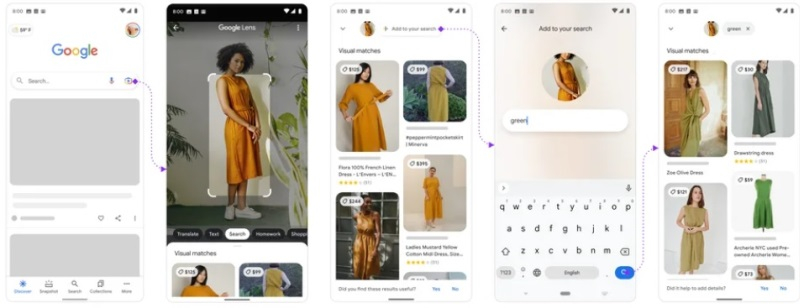

Google анонсировала сегодня ряд любопытных новинок, включая ИИ-функции в поисковике компании и улучшения фирменного переводчика. Вместе с этим было объявлено, что функция мультипоиска, которая позволяет одновременно искать по тексту и изображениям, становится доступна всем пользователям мобильного приложения Google Lens.

Источник изображений: Google

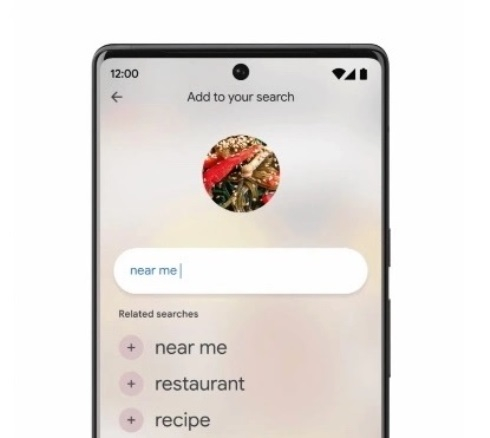

Инструмент мультипоиска был представлен в апреле прошлого года и позиционировался как способ модернизации поисковика Google. Согласно имеющимся данным, в течение нескольких месяцев пользователям приложения Lens также станет доступна функция «мультипоиск рядом со мной», которая представляет собой разновидность данной функции для поиска местных организаций и компаний.

Основой мультипоиска стал ИИ-алгоритм Multitask Unified Model (MUM), который способен обрабатывать данные в разных форматах, в том числе текстовом, фото и видео, а затем делать выводы и устанавливать связи между темами, концепциями и идеями. Google задействовала MUM в приложении Lens, благодаря чему пользователи могут объединять изображения и текст в рамках одного запроса.

«Мы переосмыслили значение поиска, представив Lens. С тех пор мы перенесли Lens непосредственно в строку поиска и продолжаем внедрять новые возможности, такие как покупки и пошаговая помощь в выполнении разных заданий», — заявил курирующий поисковик вице-президент Google Прабхакар Рагхаван (Prabhakar Raghavan).

К примеру, пользователь может найти в поисковике изображение понравившейся рубашки, а затем через Lens найти такой же рисунком, но на другом типе одежды, или такую же рубашку другого цвета. Или можно сфотографировать сломанную деталь, например, велосипеда, отправить снимок в поисковик и дополнить запрос текстом «как починить». Поисковик обработает такой запрос из текста и изображения и выдаст подходящие результаты.

В октябре прошлого года функция мультипоиска стала доступна в США, а в декабре — в Индии. Теперь же мультипоиск в Lens становится доступен на всех устройствах, для всех пользователей и во всех странах, где доступен Lens.

Источник:

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018

Обзор видеокарты Intel Arc B580 Limited Edition: неожиданный успех

62

Обзор видеокарты Intel Arc B580 Limited Edition: неожиданный успех

62

Топ-10 смартфонов до 35 тысяч рублей (начало 2025 года)

18

Топ-10 смартфонов до 35 тысяч рублей (начало 2025 года)

18

Marvel Rivals — нужна ли теперь Overwatch? Рецензия

2

Marvel Rivals — нужна ли теперь Overwatch? Рецензия

2

Battle Shapers — боязнь амбиций. Рецензия

1

Battle Shapers — боязнь амбиций. Рецензия

1

Подписаться

Подписаться