|

Опрос

|

реклама

Быстрый переход

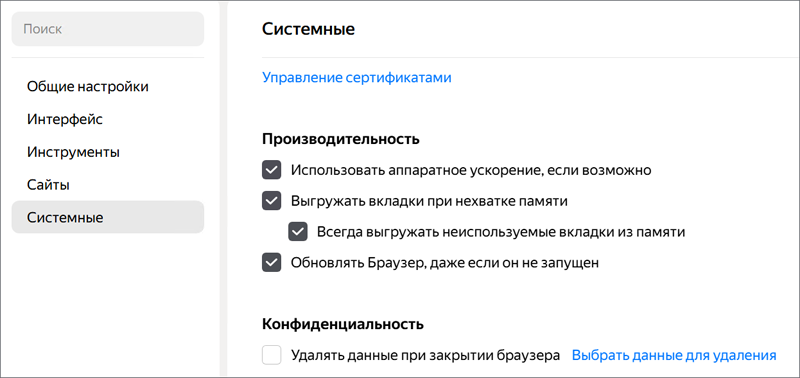

«Яндекс Браузер» теперь будет потреблять меньше оперативной памяти благодаря ИИ-оптимизации

05.12.2025 [16:39],

Владимир Фетисов

Десктопная версия «Яндекс Браузера» начала использовать модель машинного обучения для выявления неактивных вкладок, которые не понадобятся пользователю в ближайшее время. За счёт этого алгоритм высвобождает занимаемую веб-обозревателем оперативную память компьютера.  По данным разработчиков, упомянутое нововведение позволило «Яндекс Браузеру» потреблять до 36 % меньше оперативной памяти по сравнению с Google Chrome. Это означает, что запущенные параллельно с «Яндекс Браузером» приложения или игры будут работать быстрее. Современные интернет-обозреватели позволяют держать открытыми большое количество вкладок. Чтобы не тратить ресурсы ПК на неактивные веб-страницы, браузеры обычно выгружают их из оперативной памяти. Когда же пользователь снова возвращается к одной из таких вкладок, страница повторно загружается. Разработчики задействовали ML-модель, которая определяет и выгружает из оперативной памяти неиспользуемые вкладки. В настоящее время «Яндекс Браузер» высвобождает до 1 Гбайт больше оперативной памяти по сравнению с аналогичным показателем в предыдущих версиях приложения. ML-модель обучалась на статистических данных о том, как люди взаимодействуют с браузером «Яндекса».  Алгоритм учитывает не только состояние отдельной вкладки, например, воспроизводится ли в ней видео или аудио, но и учитывает десятки других параметров. Также учитываются количество открытых вкладок, частота переключения между ними и даже расстояние между разными вкладками. Осуществлять управление функцией экономии памяти можно в настройках «Яндекс Браузера» в разделе «Производительность». Для запуска алгоритма достаточно активировать опцию «Всегда выгружать неиспользуемые вкладки из памяти». DeepSeek ответил на GPT-5 и Gemini 3 Pro — представлены мощные ИИ-модели DeepSeek-V3.2

02.12.2025 [00:37],

Андрей Созинов

Китайский стартап DeepSeek выпустил две новые открытые модели с мощными возможностями для рассуждений — DeepSeek-V3.2 и усиленную DeepSeek-V3.2-Speciale. Таким образом компания подтвердила, что Китай играет на равных с американскими лидерами в лице OpenAI и Google. По тестам разработчиков, модели достигают уровня GPT-5 и Gemini 3 Pro в программировании и математике. Так, DeepSeek-V3.2-Speciale взяла «золото» на Международной математической олимпиаде, Китайской математической олимпиаде, Международной студенческой олимпиаде по программированию и Международной олимпиаде по информатике. На Американском отборочном экзамене по математике DeepSeek-V3.2-Speciale показала результат в 96,0 %, тогда как GPT-5 High набрала 94,6 %, а Gemini 3 Pro — 95,0 %. В свою очередь в тесте SWE Verified, измеряющем способности ИИ к программированию, китайская новинка набрала 73,1 % (результат GPT-5 High — 74,9 %; Gemini 3 Pro — 76,2 %). DeepSeek утверждает, что модели серии V3.2 — это её первые нейросети, созданные для ИИ-агентов. Компания заявляет, что DeepSeek V3.2 обеспечивает производительность уровня GPT 5 при выполнении общих задач. Китайский стартап также утверждает, что DeepSeek-V3.2-Speciale обладает способностями к рассуждению, сопоставимыми с новейшей моделью Gemini 3 Pro от Google, особенно в сложных сценариях решения проблем. DeepSeek добился прорыва за счёт двух приёмов: масштабного дообучения модели с подкреплением на специально сгенерированных сложных задачах, а также DeepSeek Sparse Attention (DSA) — подходу, когда модель не перебирает все токены, а выделяет для работы только самые важные. DeepSeek-V3.2 уже доступна в приложении, на веб-сайте и в API-сервисах компании. К продвинутой V3.2-Speciale сейчас можно обращаться только через API, она предлагает максимальную мощность рассуждений для сложных задач. Китайские модели от DeepSeek или Alibaba теснят решения ведущих американских разработчиков. Согласно исследованию MIT и Hugging Face, доля скачиваний новых открытых моделей по состоянию на август выросла до 17 % у китайских разработчиков против 15,8 % у американских. Успех китайских игроков опирается на быстрый цикл обновления и фокус на открытых и эффективных моделях, которые работают на менее мощном оборудовании. Новые модели DeepSeek вышли спустя два месяца после экспериментальной V3.2-Exp и способны вновь усилить позиции Китая в ИИ-гонке. В России резко вырос спрос на специалистов по общению с нейросетями

01.12.2025 [14:13],

Владимир Мироненко

За десять месяцев 2025 года количество вакансий для специалистов с навыками написания задач для нейросетей (промптов) увеличилось на 52 %, пишет «Коммерсантъ» со ссылкой на данные рекрутингового сервиса HeadHunter. Средняя зарплата promt-специалистов составляет почти 140 тыс. руб. и может достигать 320,7 тыс. руб. и выше.

Источник изображения: Campaign Creators/unsplash.com За этот период число вакансий специалистов данного профиля выросло до более 1,3 тыс., а количество резюме соискателей — в 3,1 раза. Больше всего предложений о работе было зафиксировано в Центральном федеральном округе — 74 % всех вакансий. Далее следуют Северо-Западный (12 %) и Приволжский (6 %) округи. По данным HeadHunter, медианная зарплата prompt-специалистов составила 138,9 тыс. руб., в Москве они в среднем получают 171 тыс. руб., в Санкт-Петербурге — 121,7 тыс. руб. На старте карьеры их заработок составляет от 60 тыс. руб. По словам независимого эксперта в сфере искусственного интеллекта Алексея Лерона, востребованность в promt-специалистах связана с тем, что с их помощью можно ускорять бизнес-процессы, снижать издержки, повышать скорость вывода продуктов на рынок и улучшать обслуживание клиентов. Также с ростом спроса на promt-специалистов появились обучающие курсы для работы с ИИ. Стоимость курса по базовым навыкам работы с ИИ может составлять 15–30 тыс. руб., профессиональные курсы для продвинутой работы с ИИ-моделями обойдутся в 100 тыс. руб., сообщил эксперт центра искусственного интеллекта «СКБ Контур» Дмитрий Иванков. По словам владельца группы продуктов Sastav Антона Михайлова, экономический эффект от деятельности таких специалистов зависит от масштаба компании, и того, как именно она использует нейросети. Он отметил, что грамотный promt-специалист может снизить затраты времени на рутинную интеллектуальную работу минимум на 10 %, что эквивалентно 1,5 «полной ставки». Экономия фонда зарплаты в компании с численностью 15 человек и средней зарплатой около 150 тыс. руб. может составить примерно 2,5–3 млн руб. в год. Это возможно при «зрелом подходе», иначе появляются риски в виде, например, некачественных решений, предупредил Михайлов. По мнению гендиректора АНО «Национальный центр компетенций по информационным системам управления холдингом» Кирилла Семиона, рост спроса на promt-специалистов — временная тенденция, так как компаниям вскоре станет понятно, что эффективнее дать такие навыки своим уже имеющимся сотрудникам. «ChatGPT — это продукт, а не друг»: подростки спрашивали ИИ о преступлениях — теперь ими занимается полиция

26.11.2025 [18:05],

Сергей Сурабекянц

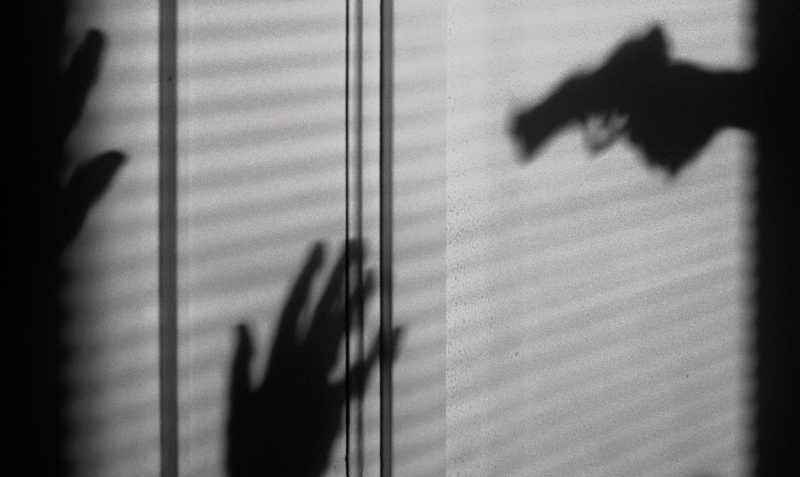

Поисковые запросы в ChatGPT нескольких подростков привлекли к ним внимание правоохранительных органов, некоторые были арестованы и столкнулись с уголовными обвинениями. Поиск информации не является преступлением, но использовать Google или чат-боты, чтобы спланировать преступление или причинить кому-то вред — как минимум неразумно. Власти обратились к родителям с просьбой разъяснить детям, с какими вопросами лучше не обращаться к ChatGPT.

Источник изображения: unsplash.com Офис шерифа округа Мэрион объявил об аресте 17-летнего подростка, обвиняемого в даче ложных показаний о похищении человека и самоубийстве. Представитель шерифа утверждает, что на ноутбуке подростка были обнаружены поисковые запросы к ChatGPT о мексиканских картелях и сборе крови без причинения боли. В округе Волусия арестован 13-летний подросток, который ввёл в ChatGPT запрос «как убить моего друга посреди урока». Полицейские получили уведомление от школьной платформы безопасности Gaggle, которая сканирует школьные аккаунты и отмечает подозрительный контент. На допросе школьник заявил, что «троллил друга, который его раздражал». Представитель шерифа обратился к родителям с просьбой «поговорить со своими детьми, чтобы они не совершали подобных ошибок». «Неразумно искать в Google или использовать ChatGPT, чтобы придумать, как совершить преступление», — говорит профессор юридического факультета Беркли Кэтрин Крамп (Catherine Crump). Она настоятельно рекомендует пользователям, особенно несовершеннолетним, помнить, что «ChatGPT — это продукт, а не ваш друг». По словам Крамп, ChatGPT «создан для того, чтобы быть услужливым и поддерживать» и может создать у человека ощущение личного разговора. Она признаёт, что люди должны осознавать, что ведут диалог с нейросетью и должны нести ответственность за свои действия. Но она уверена, что «эти продукты [чат-боты] были намеренно разработаны так, чтобы относиться к пользователям как к друзьям, поэтому […] здесь есть определённая доля корпоративной ответственности». Компании, занимающиеся разработкой ИИ, заявляют о неустанном совершенствовании ограничений, призванных помешать пользователям получать информацию о незаконной деятельности, но все эти барьеры не являются абсолютно надёжными. Интернет-активность, приводящая к уголовным делам, — явление далеко не новое. Но стремительное развитие чат-ботов с зачатками искусственного интеллекта, к которым миллионы людей обращаются за советами, мгновенными ответами и анализом информации, создаёт множество, мягко говоря, щекотливых ситуаций. Каждый четвёртый россиянин хотя бы раз в месяц пользуется нейросетями

21.11.2025 [19:58],

Владимир Мироненко

Каждый четвертый житель России в возрасте старше 12 лет хотя бы раз в месяц пользуется нейросетями, а хотя бы раз в неделю — 5 % населения, сообщил ресурс РБК со ссылкой на исследование единого измерителя аудитории Рунета Mediascope. Наибольшей популярностью нейросети пользуются у молодой аудитории, утверждают в Mediascope.

Источник изображения: Igor Omilaev/unsplash.com Совокупный месячный охват ИИ-сервисов составляет 26 % населения России. В возрастной группе от 12 до 17 лет ежемесячно ИИ-сервисами пользуется 52 % населения, ежедневно — 16 %. В группе от 18 до 24 лет показатели почти такие же — лишь на 1 п.п. ниже. Среди пользователей в возрасте от 25 до 34 лет месячный охват ИИ-сервисов составляет 33 %, ежедневный — 6 %, в возрасте от 35 до 44 лет — 23 и 3 % соответственно. Самый низкий охват отмечен у людей старше 65 лет: 9 % россиян в этой возрастной группе пользуется нейросетями хотя бы раз в месяц и лишь 1 % — ежедневно. Лидируют по охвату среди россиян ИИ-сервисы «Алиса AI» и DeepSeek с месячным охватом в октябре 2025 года в размере 14 и 9 % соответственно. С отставанием в 5 п.п. в рейтинге популярности расположились GigaChat и ChatGPT. Далее следуют Perplexity AI и Character AI с охватом по 1 %. Аналитики сообщили, что по структуре охватов «Алиса AI» и GigaChat в целом соответствуют социально-демографической палитре, тогда как Perplexity AI, DeepSeek и ChatGPT активнее используют молодые мужчины. В «Яндексе» отметили, что резкий рост ежемесячной аудитории «Алисы AI» начался после презентации в октябре новой версии этой нейросети. «Меньше чем за сутки после запуска приложение "Алиса AI" попало на первую строчку в российском App Store и вошло в тройку лидеров Google Play. За первую неделю приложение скачали полтора миллиона раз», — рассказали в компании. ИИ стал чаще ходить на российские сайты — поисковый трафик от нейросетей вырос в девять раз

20.11.2025 [15:13],

Владимир Мироненко

По данным аналитической компании Digital Budget за январь–октябрь 2025 года, десктопный трафик в России с наиболее популярных нейросетей на цитируемые ими сайты вырос более чем в девять раз, пишет «Коммерсантъ».

Источник изображения: NordWood Themes/unsplash.com Лидирует по сгенерированному исходящему трафику с долей в 24 % инфраструктура для доступа к ИИ-моделям американской Perplexity. На втором месте — GigaChat от «Сбера» (20 %), третье место — у Deepseek (19,8 %). В пятёрку также вошли ChatGPT (18 %) и китайский Qwen (13 %). Эти нейросети в сумме сгенерировали 95 % исходящего трафика пользователей. Доля «Алисы» от «Яндекса» составила лишь 0,2 %. В числе наиболее цитируемых нейросетями российских сайтов в Digital Budget назвали vc.ru, habr.com, ozon.ru, mail.ru и consultant.ru. Лидируют по количеству переходов из нейросетей ресурсы сайтов yandex.ru (доля органического трафика оценивается в 23 %), sber.ru (18 %) и google.com (17 %). Аналитики отметили, что в топ-20 цитируемых «Алисой» сайтов отсутствуют маркетплейсы и преобладают небольшие ресурсы. В Digital Budget также уточнили, что доля «нейроблока» от «Алисы» в исследовании не учитывалась, поскольку нейросеть в поиске «Яндекса» является не просто чат-ботом, а интегрированной частью самой поисковой системы. В «Яндексе» выразили несогласие с оценкой Digital Budget, хотя не стали раскрывать свои данные по исходящему трафику на цитируемые сайты. В компании отметили, что для корректного расчёта трафика необходимо учитывать каждый из сервисов, где работает «Алиса AI», добавив, что нейросеть в чате в 60 % ответов обращается к поиску «Яндекса», при этом в самом «Поиске» она не обладает собственным ранжированием. «Чтобы сайт мог попасть в число таких источников, ему нужно иметь хорошие позиции в органическом поиске», — сообщил представитель «Яндекса». Участники рынка согласились с тем, что использование генеративных ответов для поиска информации является безусловным трендом, отметив, что есть «свои нюансы». Глава Центра исследований и аналитики в «Ашманов и партнёры» Антон Тришин считает, что потеря органического трафика у части сайтов неизбежна, так как теряется необходимость переходить на них, чтобы получить ответ на запрос. Его мнение разделяет директор по продукту Servicepipe Михаил Хлебунов: «Дальнейшее развитие браузеров со встроенными ИИ-функциями приведёт к росту количества запросов от нейросетей и изменению общей картины трафика». При этом у сайтов появляется возможность влиять на этот процесс через попадание бренда или нарративов в генеративные ответы, и важной метрикой становится не только клик, но и «показ» или видимость в генеративных ответах, говорит Антон Тришин. Он назвал основным вызовом для нового тренда контроль качества информации. Гендиректор компании «А-Я эксперт» Роман Душкин объясняет большую долю GigaChat в общем сплите ИИ-чатов по сгенерированному исходящему трафику высоким качеством ответов и выдачи этой нейросети, особенно с использованием русскоязычных источников. К тому же, у GigaChat инфраструктура находится внутри страны, что служит гарантией отсутствия юридических и ИБ-рисков для коммерческих продуктов, отметил он. По мнению эксперта, малая доля «Алисы» объясняется низким качеством нейросети и плохой развитостью. Душкин предположил, что «Яндексу» вполне достаточно встроенной в браузер нейросети, поэтому развитием других её возможностей компания не занимается. ИИ-генератор видео Sora вышел на Android в США, Канаде и ещё пяти странах

05.11.2025 [06:12],

Анжелла Марина

OpenAI расширила региональный доступ к ИИ-модели Sora, выпустив версию для операционной системы Android. Первоначальный запуск Sora для iOS в сентябре, с доступом только по приглашениям и только для пользователей США, показал высокий спрос: приложение заняло лидирующие позиции в рейтинге App Store и всего за неделю было загружено более миллиона раз. Появление Sora в Google Play, как ожидается, значительно увеличит общую пользовательскую базу сервиса.

Источник изображения: OpenAI Как сообщает TechCrunch, версия для Android полностью воспроизводит функциональность iOS-приложения, включая функцию Cameo, позволяющую пользователям создавать видеоролики с использованием собственного изображения. Готовые видео можно публиковать в ленте, стилизованной под TikTok, что даёт возможность просматривать и взаимодействовать с контентом других пользователей. По мнению аналитиков, данный шаг OpenAI направлен на усиление позиций в сегменте коротких видеороликов, где уже присутствуют такие игроки, как TikTok, Instagram✴✴ и Meta✴✴, недавно запустившая собственную ИИ-ленту под названием Vibes. Одновременно с момента своего дебюта приложение Sora столкнулось с рядом проблем. Критики обратили внимание на риски, связанные с созданием дипфейков. После первоначального запуска некоторые пользователи начали генерировать провоцирующие видео с изображением известных личностей, в частности с американским общественным деятелем и активистом Мартином Лютером Кингом (Martin Luther King). В ответ на это в прошлом месяце Sora приостановила возможность создания контента с этой персоной и усилила защитные механизмы платформы. Кроме того, компания скорректировала политику в отношении использования защищённых авторским правом персонажей, таких как Спандж Боб и Пикачу. Ранее действовавшая система opt-out была заменена на opt-in, что предоставляет правообладателям больше контроля над использованием их интеллектуальной собственности. Параллельно OpenAI участвует в судебном споре с компанией Cameo относительно созвучного названия флагманской функции Sora — Cameo. В ближайшее время планируется внедрение в Sora дополнительных функций. Среди них — создание аватаров не только людей, но и домашних животных, а также неодушевлённых объектов. Также анонсированы базовые инструменты для редактирования видео, включая возможность объединения нескольких клипов. Приложение уже можно загрузить в Google Play Store на территории США, Канады, Японии, Южной Кореи, Тайваня, Таиланда и Вьетнама. ChatGPT перестал давать медицинские и юридические консультации — для блага пользователей

01.11.2025 [17:29],

Владимир Фетисов

Участники сообщества Reddit обратили внимание на изменение политики использования популярного ИИ-бота OpenAI ChatGPT. Алгоритм больше не даёт персонализированные медицинские и юридические консультации пользователям, а также не анализирует изображения медицинского характера, включая снимки МРТ, рентгеновские снимки, фотографии кожных поражений и др.

Источник изображения: Dima Solomin / unsplash.com Чат-бот отказывается отвечать на подобные вопросы, подчёркивая, что готов предоставить лишь общую информацию в образовательных целях, но не для постановки диагнозов или выбора лечения каких-либо заболеваний. Отмечается, что перестали срабатывать проходившие ранее уловки, когда ИИ-модель просили рассмотреть гипотетическую ситуацию, чтобы получить интересующую информацию. На этот раз срабатывает механизм защиты и ChatGPT предоставляет только общие консультации, а для более детального изучения проблемы рекомендует обратиться к соответствующему специалисту. Представители OpenAI не комментировали изменения в политике использования ChatGPT, но, скорее всего, они были внесены, чтобы избежать судебных разбирательств. По статистике, всё больше людей обращаются к чат-боту за медицинскими и юридическими консультациями, результат которых непредсказуем. При этом использование нейросетей в подобных задачах на данный момент регулируется слабо, что может создавать риски как для разработчиков, так и для пользователей. Ранее глава OpenAI Сэм Альтман (Sam Altman) предупреждал, что на беседы с ChatGPT не распространяются законы о врачебной и адвокатской тайне. Это означает, что суд может потребовать у компании раскрыть переписку, которая будет использоваться в качестве доказательств в ходе какого-либо разбирательства. OpenAI работает с регуляторами для уточнения правового статуса чат-бота, но пока результата достигнуть не удалось. «Мир движется в странном направлении»: Дуров представил Cocoon — смесь ИИ и блокчейна во имя цифровой свободы

29.10.2025 [22:29],

Андрей Созинов

На форуме Blockchain Life 2025 в Дубае основатель Telegram Павел Дуров анонсировал запуск технологического проекта Confidential Compute Open Network или просто Cocoon. Это децентрализованная вычислительная сеть, которая позволит запускать различные ИИ-сервисы и приложения безопасно и с максимальным уровнем конфиденциальности пользователей. Проект нацелен на защиту цифровой свободы людей в условиях усиливающегося государственного контроля в интернете.

Источник изображения: Cocoon Сама архитектура проекта построена на связке децентрализованных вычислений и блокчейна TON. Сеть Cocoon будет опираться на мощности GPU, предоставляемые майнерами за вознаграждение в Toncoin (TON). Запросы на обработку данных будут автоматически распределяться по свободным в данный момент GPU. Разработчики приложений и сервисов, в свою очередь, получат возможность запускать свои нейросетевые проекты без собственных мощностей, а также без необходимости обращаться за услугами к облачным провайдерам — то есть получат в своё распоряжение относительно недорогие ресурсы. Первым большим клиентом Cocoon станет сам Telegram. А ключевым преимуществом для пользователей, по словам Дурова, станет возможность полностью анонимного взаимодействия с ИИ. «Мир движется в странном направлении», — заявил Дуров, добавив, что в последнее время люди теряют цифровые свободы. Основатель Telegram видит в децентрализованных технологиях способ сохранить эти свободы. Во время выступления Дуров также с иронией поделился, что одним из рабочих вариантов названия новой платформы было Private AI Network, сокращённо P.A.I.N — от английского pain («боль»). Telegram, как ожидается, сыграет ключевую роль в продвижении сети Cocoon, обеспечив «спрос и хайп» со стороны аудитории — напомнив о предыдущих инициативах, вроде токенизированных подарков и интеграции USDT в TON, впервые представленных на конференции Token2049 в 2024 году. Запуск сети Cocoon ожидается уже в ноябре. Пока не сообщается, сколько именно будут платить разработчики за использование сети, а также на какие вознаграждения смогут рассчитывать обладатели мощных видеокарт. Google выпустила ИИ-генератор видео Veo 3.1 с повышенным реализмом и улучшенным звуком

15.10.2025 [23:51],

Анжелла Марина

Google представила обновлённую версию ИИ-модели для генерации видео Veo 3.1. Модель генерирует более реалистичные видеоклипы, точнее следует текстовым запросам пользователя и получила значительные улучшения в области звукового сопровождения.

Источник изображения: Google Как пишет TechCrunch, модель Veo 3.1 развивает функциональность, представленную в мае в версии Veo 3, добавляя аудиосопровождение ко всем существующим возможностям редактирования — от привязки персонажей к референсным изображениям до ИИ-генерации клипов, включая возможность продления существующего видео на основе последних нескольких кадров. По словам представителей Google, благодаря этим улучшениям создаваемые ролики становятся «более живыми». Veo 3.1 будет доступна в видеоредакторе Flow, а также в приложении Gemini, через Gemini API и централизованную платформу Vertex AI. Пользователи Flow также смогут удалять существующие объекты из видео. С момента запуска Flow в мае пользователи создали с его помощью свыше 275 миллионов видеороликов. Эра синтетических звёзд началась: ИИ-актриса Тилли Норвуд уже получает роли и набирает популярность

30.09.2025 [08:10],

Алексей Разин

Возможности современных систем генеративного искусственного интеллекта не ограничиваются созданием реалистичных статичных образов людей и коротких роликов, им вполне по силам создание целых виртуальных актёров. Агентство Xicoia утверждает, что порождённая ИИ актриса Тилли Норвуд (Tilly Norwood) стремительно набирает популярность как у зрителей, так и у профильных агентств.

Источник изображения: Xicoia Об этом сообщила на Цюрихском кинофестивале основательница родственной студии Particle6 актриса, комик и писательница Элин ван дер Вельден (Eline van der Velden), как отмечает Variety. Она является главой специализированной студии Particle6, которая занимается производством контента с использованием технологий искусственного интеллекта. Агентство Xicoia будет продвигать виртуальных актёров на соответствующем рынке, и Тилли Норвуд (Tilly Norwood) является первым персонажем, которого агентство готово предлагать создателям контента. В ближайшие несколько месяцев будут сделаны очередные заявления в этой сфере. По словам ван дер Вельден, на первых порах люди удивлялись самой идее создания виртуальных актёров, а теперь их интересы готовы представлять на рынке труда в кинематографической сфере серьёзные агентства. Ещё в июле этого года на странице в одной из популярных социальных сетей виртуальная актриса Тилли Норвуд сообщила о выходе своей первой работы, которой стала роль в комедийной сценке AI Commissioner. Элин ван дер Вельден заявила, что студия, создавшая Норвуд, желает ей блистательного будущего: «Мы хотим, чтобы Тилли стала следующей Скарлетт Йоханссон или Натали Портман, в этом заключается цель наших действий». По словам основательницы студии, производители контента двигаются в сторону использования ИИ в силу экономических факторов. Создатели кинокартин и телепроектов ощущают, по её мнению, что ИИ не ограничивает их творческие идеи с точки зрения бюджета на съёмку — нет никаких преград для творчества, а потому ИИ будет влиять на отрасль в положительном ключе. Нужно лишь изменить точку зрения людей на этот вопрос. Как добавила ван дер Вельден, аудитории важна сама история, а не наличие у кинозвезды пульса: «Тилли уже привлекает интерес агентств и поклонников. Эра синтетических актёров не грядёт, она уже наступила». Живые актёры новость о появлении ИИ-актрисы встретили в штыки. Звезда «Крика» Мелисса Баррера предложила бойкотировать компании, которые берут на работу цифровых артистов. Её поддержали Кирси Клемонс, Мара Уилсон и другие коллеги. «А как же сотни живых молодых женщин, чьи лица вы использовали для генерации её? Вы не могли нанять ни одну из них?» — задала риторический вопрос Мара Уилсон. Нейросеть Google Veo 3 научилась создавать вертикальные видео для соцсетей

09.09.2025 [19:40],

Анжелла Марина

Генеративная модель для создания видео Google Veo 3 получила поддержку вертикального формата 9:16 и разрешение 1080 пикселей. Теперь разработчики смогут создавать контент, который идеально подходит по формату для TikTok и YouTube Shorts, причём по значительно меньшей цене. Об этом компания сообщила в официальном блоге для разработчиков.

Источник изображения: Google Согласно сообщению, основная версия Veo 3 и её более бюджетная модификация Veo 3 Fast теперь позволяют создавать ролики в оптимальном формате для мобильных устройств и социальных платформ. Активировать вертикальный формат можно, установив параметр aspectRatio в запросах API на значение 9:16. Кроме того, обновление позволяет устанавливать более высокое разрешение по сравнению с предыдущим ограничением в 720 пикселей. Однако, как сообщает The Verge, поддержка разрешения 1080 пикселей в настоящее время доступна только для видео с соотношением сторон 16:9. В Google также заявили, что Veo 3 и Veo 3 Fast теперь «стабильны и готовы к масштабируемому использованию в Gemini API», при этом стоимость использования сервиса существенно изменилась: генерации одной секунды видео через Veo 3 снизилась с $0,75 до $0,40, а через Veo 3 Fast — с $0,40 до $0,15 за секунду. Отмечается, что добавление поддержки вертикального видео не стало большой неожиданностью, поскольку компания ещё в июне анонсировала интеграцию Veo 3 с YouTube Shorts, которая была запланирована на конец лета. Очевидно, что в ближайшее время пользователи TikTok и Instagram✴✴ Reels больше увидят в своих лентах контент, созданный помощью нейросети Google Veo 3. Представлен Dolby Vision 2 — «кинематографический» HDR, аутентичное сглаживание и ИИ-оптимизации

02.09.2025 [19:01],

Сергей Сурабекянц

Через десять лет после запуска формата Dolby Vision представлена обновлённая версия стандарта — Dolby Vision 2. Она включает новые инструменты Content Intelligence, которые используют нейросети для автоматической оптимизации изображения в зависимости от устройства и характера контента. По словам разработчика, представленное в Dolby Vision 2 интеллектуальное сглаживание изображения Authentic Motion — это «первый творческий инструмент управления движением».

Источник изображения: Dolby Среди инструментов Content Intelligence — функция Precision Black, повышающая чёткость тёмных сцен с бережным сохранением замысла создателя фильма, и обновлённая функция Light Sense, изменяющая настройки изображения в зависимости от окружающего освещения и яркости контента. Функция Sports and Gaming Optimization обеспечит оптимальный показ спортивных трансляций и корректное отображение игрового контента. Телевизоры с поддержкой Dolby Vision 2 будут использовать двунаправленную тональную компрессию, которая предоставит создателям контента больше контроля над возможностями дисплея. Это позволит повысить яркость и чёткость изображения, а также обеспечить более насыщенные цвета. В обновлённом стандарте Dolby Vision 2 представлена технология сглаживания изображения Authentic Motion. По словам представителя Dolby, это «первый творческий инструмент управления движением», предоставляющий покадровый контроль для снижения нежелательного дрожания изображения и придания ему подлинно кинематографического вида без эффекта «мыльной оперы». Спецификация Dolby Vision 2 обратно совместима с первой версией стандарта, поэтому контент Dolby Vision будет корректно отображаться на устройствах, поддерживающих обе спецификации, а контент Dolby Vision 2 можно будет просматривать и на моделях предыдущего поколения. Однако распознавать и использовать дополнительные метаданные нового формата смогут только новейшие телевизоры с поддержкой Dolby Vision 2. По сравнению с оригинальной спецификацией Dolby Vision новая версия упростит определение возможностей телевизоров, разделив их на два уровня в зависимости от производительности. Dolby Vision 2 Max предлагает дополнительные премиум-функции для «самых производительных телевизоров», в то время как стандартная маркировка Dolby Vision 2 предназначена для более доступных моделей. Компания Hisense станет первым брендом, выпустившим телевизоры на базе чипа MediaTek Pentonic 800 с поддержкой стандарта Dolby Vision 2. Вероятно, в ближайшее время её примеру последуют и другие крупнейшие производители телевизоров. Стартап Илона Маска открыл исходный код ИИ-модели Grok 2.5 и анонсировал открытие более мощной нейросети

24.08.2025 [14:27],

Владимир Мироненко

Стартап Илона Маска (Elon Musk) в области искусственного интеллекта xAI открыл исходный код ИИ-модели Grok 2.5. Об этом предприниматель сообщил в субботу в соцсети X, добавив, что планирует примерно через шесть месяцев также открыть исходный код модели Grok 3.

Источник изображения: Mariia Shalabaieva/unsplash.com «Модель Grok 2.5, которая была нашей лучшей моделью в прошлом году, теперь доступна с открытым исходным кодом», — написал Илон Маск в соцсети Х. Исходный код Grok 2.5 доступен для просмотра и скачивания через Hugging Face. Ранее в этом месяце Маск заявил, что Grok 5 выйдет до конца этого года и будет «невероятно хорош». До этого он сообщил, что Grok 4 оказался умнее представленной 7 августа модели GPT-5 от OpenAI в некоторых тестах, в частности, в бенчмарке ARC-AGI, измеряющем способность к абстрактному мышлению и логическим рассуждениям. В ARC-AGI-2, который оценивает логику, Grok 4 набрал 15,9–16 %, что почти вдвое больше, чем 9,9 % у GPT-5. В менее сложном тесте ARC-AGI-1 Grok 4 набрал 66,7 % против 65,7 % GPT-5. Эти результаты свидетельствуют о преимуществе Grok 4 в решении сложных задач, пишет ресурс DEV Community. В математических задачах Grok 4 Heavy набрал 100 % на AIME 2025, а GPT-5 — 94,6 %. Хотя обе нейросети показали хорошие результаты, максимальный результат Grok 4 подчёркивает его сильные стороны в этой области, отметил DEV Community. Нейросети для карьеры и во время обучения: переоценены или необходимы

14.08.2025 [10:23],

Андрей Созинов

Дискуссии об искусственном интеллекте всем надоели, но при этом становятся только актуальнее. Особенно остро проблема стоит в сфере образования: недавнее исследование Массачусетского технологического института показало, что у участников, которые пользовались ChatGPT для написания эссе, уровень мозговой активности был заметно ниже в сравнении с теми, кто использовал поисковик или писал текст самостоятельно.

Источник изображения: «Яндекс» Авторы пришли к выводу, что избыточное использование нейросетей может ослабить нейронные связи и способности к глубокому обучению и критическому мышлению. Сейчас учёные изучают влияние ИИ конкретно на процесс программирования. Первые данные говорят, что при написании кода мозговая активность снижается даже сильнее, чем при написании текста. Это поднимает важный вопрос: насколько нейросети действительно вредят обучению и стоит ли их использовать. В этом материале разбираем, когда ИИ мешает развивать навыки, а когда помогает учиться быстрее и эффективнее. И главное: стоит ли избегать нейросетей любыми средствами, чтобы стать по-настоящему ценным специалистом. Когда нейросети действительно вредныСамый очевидный вред от ИИ в обучении — подмена понимания копированием. Студент просит ChatGPT написать алгоритм сортировки, копирует код, сдаёт задание, но так и не понимает, как сортировка работает. В итоге по окончании обучения этого навыка у него не будет, а работа рискует быть парализованной при отсутствии доступа к ИИ. Другая опасность — ложное ощущение компетентности. Нейросети могут создать иллюзию того, что программирование сводится лишь к умению правильно формулировать запросы. На собеседовании, где нужно решить задачу без подсказок, такой подход не сработает. Существуют и технические риски. ИИ может генерировать код с уязвимостями безопасности, предлагать устаревшие решения или создавать неоптимальные алгоритмы. Новичок, не обладающий базовыми знаниями, просто не сможет распознать и исправить подобные проблемы. Нейросети как ускоритель обученияНейросети могут мгновенно объяснить сложную концепцию несколькими способами, пока один из них не станет понятным. Они могут разобрать чужой код по строчкам, показать альтернативные подходы к решению, помочь найти и исправить ошибку. Особенно ценно использование ИИ при изучении новых технологий. Вместо часов чтения документации можно быстро получить обзор основных возможностей библиотеки, примеры использования и объяснение архитектурных принципов. Это не заменяет глубокое изучение, но даёт отличную отправную точку. Нейросети также помогают преодолеть психологические барьеры. Новичку часто страшно задать «глупый» вопрос наставнику или в чате команды. ИИ же терпеливо ответит на любой вопрос, не осуждая уровень знаний. Адаптация образовательных платформВ онлайн-образовании не игнорируют тренд, а интегрируют ИИ в процесс обучения. Например, в «Яндекс Практикуме» студенты могут задать любой вопрос по теме урока, а нейросеть даст ответ с учётом контекста курса — она знает, какие темы студент уже изучил и с чем может возникнуть путаница. Также студентам помогает умный поиск по материалам, встроенный в платформу. Можно написать любой запрос в рамках курса — и система быстро подберёт релевантные темы. Это экономит время на поиск нужной информации и позволяет сосредоточиться на обучении. Такой подход показывает, как ИИ может улучшить образовательный процесс, не заменяя преподавателя, а дополняя его. Нейросеть обеспечивает быструю поддержку в любое время, помогает самостоятельно находить ответы и быстрее ориентироваться в материалах. Обучение работе с ИИ как отдельный навыкЧтобы помочь новичкам с освоением нейросетей, сервисы онлайн-образования предлагают специализированные курсы. Бесплатный курс «Яндекс Практикума» «Нейросети для начинающих» даёт базовое понимание принципов работы ИИ и показывает возможности их применения. Пройти курс можно за 2 часа. Для более глубокого погружения есть двухмесячный курс «Нейросети для работы». Он показывает, как настроить ИИ-инструменты под конкретные задачи, избежать типичных ошибок и максимально эффективно использовать возможности искусственного интеллекта в реальных проектах. Первый модуль можно пройти бесплатно. Рынок труда и конкурентные преимуществаРаботодатели уже сейчас ожидают от кандидатов умения работать с ИИ-инструментами. Это не означает, что нужно быть экспертом по машинному обучению, но базовые навыки использования нейросетей для повышения продуктивности становятся стандартом. Джун, который эффективно использует GitHub Copilot, Phind, Claude и другие инструменты, сможет быстрее адаптироваться к рабочим процессам, эффективнее решать задачи и лучше понимать код коллег. В долгосрочной перспективе это прямой путь к карьерному росту. Принципиальный отказ от нейросетей не приведёт к позитивным результатам. В лучшем случае это замедлит профессиональное развитие, в худшем — сделает специалиста неконкурентоспособным на рынке труда. В IT игнорирование ИИ равносильно добровольному отказу от инструментов, которыми уже пользуются все остальные участники рынка. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |