Разработчики генеративных нейросетей добились значительного успеха в создании статических изображений, подтверждением чему служат набравшие популярность модели, такие как Dall-E и Stable Diffusion. Теперь же стартап Runway AI представил нейросеть, способную генерировать по текстовому описанию короткие видеоролики.

Источник изображения: Runway AI

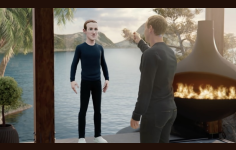

Генеративная нейросеть Gen 2 от Runway AI способна создавать короткие видео, опираясь на текстовое описание всего из нескольких слов. Достаточно написать, например, «кошка, идущая под дождём», после чего ИИ-алгоритм сгенерирует 3-секундное видео, демонстрирующее именно это или что-то очень похожее. В дополнение к этому пользователь может загрузить изображение, которое станет для алгоритма своеобразной подсказкой.

Сейчас нейросеть Runway AI доступна не всем. На данном этапе желающим испытать нейросеть в деле необходимо зарегистрироваться на сайте разработчиков и добавить себя в лист ожидания. Отметим, что Runway AI занимается разработкой инструментов на основе искусственного интеллекта с 2018 года и в прошлом году компания сумела привлечь $50 млн инвестиций. Стартап помогал в разработке оригинальной версии Stable Diffusion, которая способна генерировать изображения по текстовому описанию.

Во время демонстрации возможностей ИИ попросили создать видео «съёмки пустынного пейзажа с дрона». Несколько минут нейросеть обрабатывала запрос, но в конечном счёте ей удалось создать ролик, который соответствует предложенному описанию. Несколько других роликов раскрывают сильные и слабые стороны ИИ-алгоритма. Разработчики отмечают, что модель ещё не до конца «разобралась», как более точно изображать движущиеся объекты. «Вы можете сгенерировать автомобильную погоню, но иногда машины могут улететь», — отметили в Runway AI.

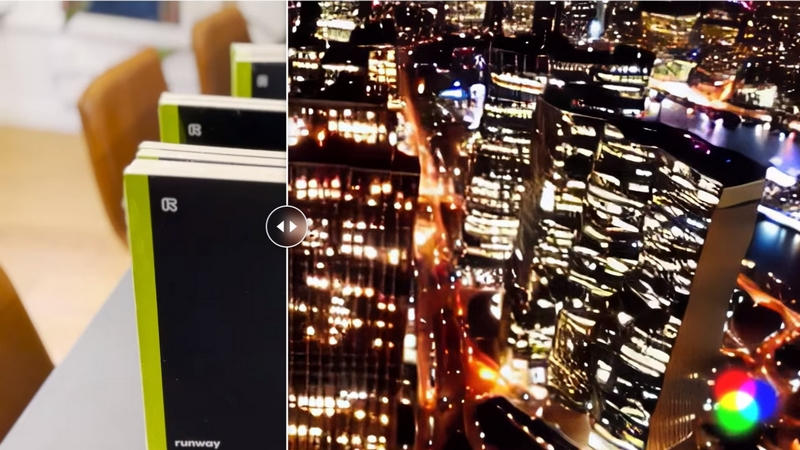

Также Gen 2 способна менять уже готовые видео, накладывая маски, добавлять стилизацию или даже полностью перестраивая картинку. Например, с помощью масок получились заменить на видео лабрадора на далматинца. Также ИИ смог превратить несколько поставленных на ребро блокнотов в ночной мегаполис. Либо из очень упрощенной 3D-модели сделать почти что кинематографическую картинку. Ещё ИИ способен анимировать фотографии.

Представленный алгоритм Gen 2 является логическим продолжением созданной ранее нейросети Gen 1. Тестирование алгоритма с привлечением небольшого числа пользователей началось в феврале. В настоящее время к этому процессу привлечены тысячи пользователей. Согласно имеющимся данным, в разработчики изучают возможность добавления к генерируемым видео звука, поскольку на данном этапе ИИ-алгоритм создаёт видео без звука.

Источник:

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018

Подписаться

Подписаться