За минувшие два года основанные на алгоритмах искусственного интеллекта генераторы изображений стали почти повседневным явлением, и на первый взгляд в работе они не так сильно отличаются друг от друга. Но в Meta✴ утверждают, что разработанная инженерами компании новая модель CM3Leon является прорывом.

Источник изображений: Meta✴

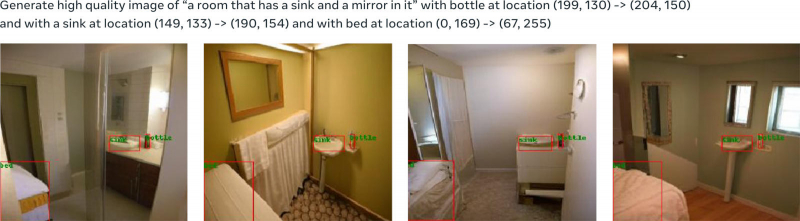

Отличием модели Meta✴ CM3Leon, как заявляют разработчики, является высокая производительность при преобразовании текста в изображение. Кроме того, это одна из первых моделей, обеспечивающих обратную операцию — создание подписей к изображениям. Большинство современных генераторов изображений, включая OpenAI DALL-E, Google Imagen и Stable Diffusion при создании картинок используют диффузию — процесс постепенного удаления шума из первоначального изображения по мере приближения к поставленной цели. Результат получается убедительным, но данный алгоритм требует значительных вычислительных ресурсов, что делает работу таких систем дорогостоящей, а сами модели — медленными, и в реальном времени они функционировать попросту не могут.

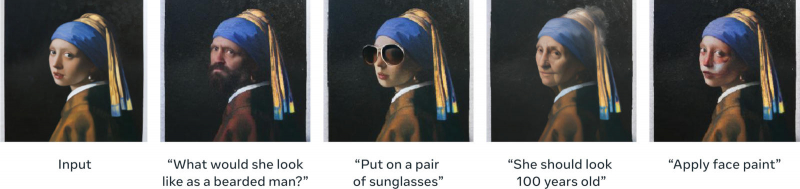

Редактирование исходного изображения: заменить девушку на бородатого мужчину, добавить очки, увеличить возраст, раскрасить лицо

Модель CM3Leon действует принципиально иначе — в её основе лежит алгоритм-трансформер, предусматривающий оценку релевантности исходных данных, будь то текст или изображение. Примечательно, что и в OpenAI первоначально строили генераторы изображений на основе моделей-трансформеров, но на смену Image GPT пришли диффузионные алгоритмы. При обучении CM3Leon использовались 2 млн изображений, лицензированных у Shutterstock — самая мощная версия модели имеет 7 млрд параметров — в два раза больше, чем у OpenAI DALL-E 2. Наконец, здесь использован механизм дообучения SFT (Supervised Fine-Tuning), обычно свойственный генераторам текста. В результате увеличилась производительность модели при генерации изображений и составлении описаний к готовым картинкам, а система получила возможность редактировать изображения по текстовым командам, например, «изменить цвет неба на ярко-синий».

В результате Meta✴ CM3Leon воспринимает в качестве исходных данных весьма конкретные команды — вплоть до того, в какой области изображения в пикселях должен находиться тот или иной предмет. Для сравнения, DALL-E такие нюансы игнорирует и зачастую даже отказывается помещать на изображение объекты, непосредственно указанные в инструкции.

Источник:

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018