Уход из OpenAI одного из основателей этого стартапа Ильи Суцкевера, как поясняет CNBC, стал одной из причин распада команды специалистов по управлению долгосрочными рисками, связанными с внедрением искусственного интеллекта. Эта структурная единица, призванная защитить человечество от угроз, возникающих в связи с распространением ИИ, не просуществовала в OpenAI и одного года.

Источник изображения: Университет Торонто

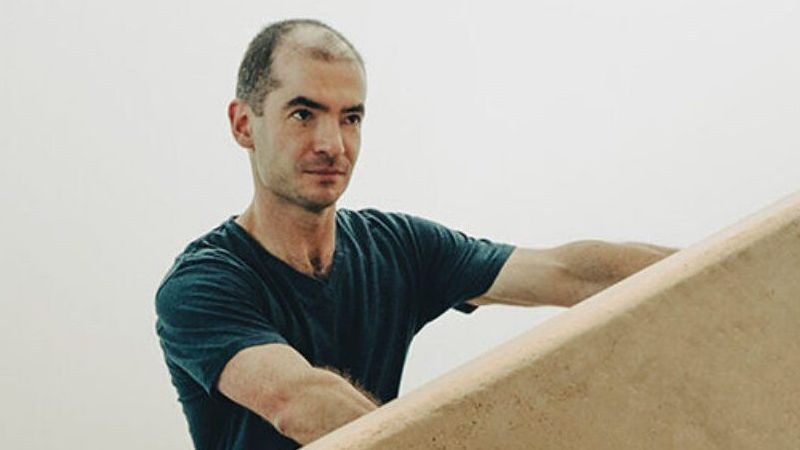

По данным CNBC, озабоченность подобными рисками уже давно проявлял сам Илья Суцкевер (на фото выше), руководивший в OpenAI научными изысканиями и исследованиями. Он же возглавлял и профильную команду по управлению рисками вместе с Яном Лейке (Jan Leike), но последний на уходящей неделе тоже покинул штат компании. Сформированная в прошлом году команда, как изначально подразумевалась, будет следить за минимизацией рисков, связанных с распространением технологий искусственного интеллекта, и OpenAI намеревалась выделить до 20 % своих вычислительных ресурсов для этих нужд в течение ближайших четырёх лет. После ухода руководителей команды её оставшиеся члены были назначены на другие позиции внутри компании.

Вчера Ян Лейке заявил, комментируя свой уход из OpenAI, что «культура безопасности и процессы уступили место сияющим продуктам». Как и в случае с уходом Ильи Суцкевера, действующий генеральный директор OpenAI Сэм Альтман (Sam Altman) выразил сожаление по поводу отставки Яна Лейке. По словам последнего, он уже длительное время не разделял взглядов руководства на приоритетные направления развития компании, и теперь эти противоречия достигли критического значения. Как он считает, OpenAI должна уделять больше внимания безопасности и влиянию создаваемых технологий на общество. На протяжении последних нескольких месяцев профильная команда внутри OpenAI, по словам Лейке, буквально «шла по воде под парусом против ветра». Достигать поставленных задач становилось всё сложнее, специалисты были очень ограничены в ресурсах. Лейке по-прежнему убеждён, что OpenAI должна в разработке генеративного искусственного интеллекта быть компанией, ставящей безопасность во главу угла, поскольку «создание машин, превосходящих людей — это очень опасная затея».

Как поясняет Bloomberg, компания OpenAI сохранит в своём штате специалистов, которые следят за безопасностью искусственного интеллекта, но они будут рассредоточены по различным подразделениям. Схожими функциями будут наделены и обособленные подразделения стартапа, поэтому говорить о полностью бесконтрольном развитии ИИ в новых условиях не приходится.

Источник:

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018