|

Опрос

|

реклама

Быстрый переход

Deveillance представила гаджет для защиты разговоров от подслушивания смартфонами и ИИ за $1199

06.03.2026 [12:17],

Владимир Мироненко

Компания Deveillance открыла предзаказ на портативное устройство Spectre I, которое позволит защитить разговоры от подслушивающих гаджетов, включая смарт-устройства и устройства записи с использованием ИИ. Цена новинки по предзаказу составляет $1199.  Deveillance утверждает, что Spectre I «излучает неслышимый сигнал, который делает невозможным захват разборчивого звука любыми микрофонами в зоне его действия». Помимо подавления звука, гаджет, как утверждается, использует искусственный интеллект, технологии обработки сигналов, а также собственные разработки для обнаружения находящихся поблизости микрофонов. Spectre I отличается небольшими габаритами, напоминая небольшой куполообразный Bluetooth-динамик. Сбоку расположены кнопка включения/выключения и световой индикатор, показывающий, что устройство включено; также имеются кольцо под решёткой динамика и большая кнопка посередине. По всей видимости, новинка доступна только в чёрном цвете. По словам Deveillance, Spectre I находится на ранней стадии разработки, но уже сейчас можно оформить предварительный заказ, чтобы занять очередь на его получение. Пользователь также может потребовать полный возврат средств, если передумает покупать устройство до начала поставок. Поставки по предзаказам начнутся во второй половине 2026 года — ориентировочно в августе. iPhone и iPad стали первыми потребительскими устройствами, допущенными к секретным данным НАТО

27.02.2026 [00:29],

Николай Хижняк

Компания Apple объявила, что смартфоны iPhone и планшеты iPad стали первыми потребительскими устройствами, одобренными для использования в секретных сетях НАТО. Это означает, что стандартный iPhone под управлением iOS 26 может получить доступ к ограниченным данным НАТО без необходимости использования какого-либо специализированного программного обеспечения безопасности или модификации оборудования.

Источник изображения: MacRumors «Это достижение подтверждает, что Apple изменила традиционный подход к обеспечению безопасности. До iPhone защищённые устройства были доступны только государственным и корпоративным организациям после масштабных инвестиций в специализированные решения по безопасности. Вместо этого Apple создала самые защищённые устройства в мире для всех своих пользователей, и теперь эти же средства защиты уникальным образом сертифицированы в соответствии с требованиями безопасности стран НАТО, в отличие от любых других устройств в отрасли», — прокомментировал в заявлении для 9to5Mac Иван Крстич (Ivan Krstić), вице-президент Apple по проектированию и архитектуре безопасности. Для сертификации подобного уровня недостаточно просто выпустить хорошо защищённую операционную систему — это длительный и непрерывный процесс, отмечает издание. Ранее iPhone и iPad получили разрешение на обработку секретных данных правительства Германии с использованием встроенных механизмов безопасности iOS и iPadOS. Это стало результатом всесторонней оценки, технических исследований и глубокого анализа безопасности, проведённых Федеральным управлением по информационной безопасности Германии (Bundesamt für Sicherheit in der Informationstechnik, BSI). Теперь, опираясь на это одобрение BSI, iPhone и iPad под управлением iOS 26 и iPadOS 26 официально сертифицированы для использования во всех странах НАТО. Устройства под управлением iOS 26 и iPadOS 26 также официально включены в Каталог продуктов обеспечения информационной безопасности НАТО. Сертификацию устройства Apple прошли благодаря критическим функциям безопасности, уже встроенным в каждый современный iPhone и iPad:

«Безопасная цифровая трансформация будет успешной только в том случае, если информационная безопасность учитывается с самого начала разработки мобильных продуктов. После тщательной проверки безопасности платформ и устройств iOS и iPadOS со стороны BSI для использования в секретных информационных средах Германии, мы рады подтвердить соответствие [этих устройств] требованиям стран НАТО по обеспечению безопасности», — заявила Клаудия Платтнер, президент BSI. Anthropic обвалила акции CrowdStrike и Cloudflare, представив ИИ-багхантера Claude Code Security

21.02.2026 [09:52],

Анжелла Марина

Рынок кибербезопасности отреагировал падением акций на новость о выходе инструмента Claude Code Security от компании Anthropic. По сообщению SiliconANGLE, акции CrowdStrike и Cloudflare просели примерно на 8 %, поскольку инвесторы увидели в новинке серьёзного конкурента традиционным средствам защиты.

Источник изображения: Anthropic Главное отличие Claude Code Security от классических инструментов поиска уязвимостей в том, что он не полагается на базы данных с готовыми правилами. Вместо этого нейросеть анализирует логику работы приложения, отслеживает потоки данных и связи между компонентами, имитируя подход специалиста по безопасности. Такой метод позволяет находить проблемы, которые могут быть пропущены при использовании стандартных средств из-за ограничений статических баз. Для начала работы разработчикам необходимо подключить Claude Code Security к репозиторию на платформе GitHub и инициировать сканирование. Система способна определять широкий спектр проблем, включая отсутствие фильтрации пользовательского ввода, что может привести к выполнению несанкционированных SQL-команд. Инструмент также находит более сложные логические ошибки, позволяющие злоумышленникам обходить механизмы аутентификации приложений. Найденные уязвимости автоматически ранжируются по степени значимости. Для каждой проблемы генерируется подробное объяснение на естественном языке, что ускоряет процесс анализа инцидента специалистами. Под описанием ошибки также доступна функция создания патча, которая позволяет профессионалам в области кибербезопасности получить готовый вариант исправления кода от искусственного интеллекта. Стоит отметить, что запуск Claude Code Security состоялся примерно через четыре месяца после того, как OpenAI представила свой автоматизированный инструмент безопасности под названием Aardvark. Он обладает схожими возможностями и, по заявлениям разработчиков, тестирует уязвимости в изолированной программной среде для оценки сложности их эксплуатации хакерами. Эксперты полагают, что в будущем Anthropic и OpenAI могут пойти дальше и интегрировать свои системы в пайплайны разработки (CI/CD), чтобы автоматически блокировать выкатку кода с «дырами» в безопасности для ускорения выпуска продукта. ИИ помог Google заблокировать тысячи разработчиков и удалить миллионы сомнительных приложений в 2025 году

19.02.2026 [23:14],

Николай Хижняк

Google заблокировала в прошлом году более 1,75 млн приложений, нарушающих правила, и не допустила их загрузки в свой магазин приложений Play Store. Компания также удалила более 80 тыс. учётных записей разработчиков, пытавшихся опубликовать вредоносные приложения. Свежим отчётом поделился Виджая Каза (Vijaya Kaza), вице-президент Google по вопросам доверия к приложениям и экосистемам.

Источник изображения: Google Для поиска потенциально вредоносных приложений Google активно использует искусственный интеллект. Компания заявляет, что внедрила модели ИИ непосредственно в процесс проверки приложений. Рецензенты-люди по-прежнему участвуют в этом процессе, но ИИ помогает выявлять сложные вредоносные схемы гораздо быстрее, чем человек мог бы вручную проверять код. Компания также усилила меры защиты конфиденциальности. В прошлом году Google заблокировала более 255 тыс. приложений, запрашивающих слишком много конфиденциальных данных. Разработчики также получают помощь от таких инструментов, как Play Policy Insights в Android Studio, которые указывают на возможные проблемы ещё на этапе написания кода. Google также ведёт активную борьбу со спамом. В 2025 году компания заблокировал 160 млн спам-оценок и отзывов, включая фейковые пятизвездочные отзывы и организованные попытки занизить рейтинг приложений. Google заявляет, что предотвратила падение рейтинга в среднем на 0,5 звезды для приложений, ставших мишенью для так называемой «бомбардировки отзывами». Усиление защиты распространяется не только на магазин Play Store. Google Play Protect, встроенный в Android сканер вредоносных программ, теперь проверяет более 350 млрд приложений каждый день. В прошлом году сканирование в режиме реального времени обнаружило 27 млн новых вредоносных приложений, доступных за пределами Google Play. Если вы когда-либо устанавливали приложение с ненадёжного веб-сайта, вы могли видеть предупреждение. Это работа Play Protect. Эффективность этой функции также постоянно совершенствуется. Улучшенная защита от мошенничества теперь блокирует установки из интернет-источников (через браузеры и мессенджеры), которые запрашивают чувствительные разрешения. В 2025 году функция была запущена на 185 рынках, охватывая 2,8 млрд устройств, и предотвратила 266 млн попыток установки рискованных приложений. Google также внесла изменения для борьбы с мошенническими звонками. Если вы разговариваете по телефону, Play Protect теперь не даёт отключить защиту. Это связано с тем, что мошенники часто пытаются убедить людей отключить защиту, чтобы получить доступ к данным на устройстве. Теперь этот метод больше не работает. Шпионам и не снилось: умные очки Meta✴ смогут распознавать людей и показывать информацию о них

13.02.2026 [19:01],

Сергей Сурабекянц

Компания Meta✴✴ планирует добавить функцию распознавания лиц в свои популярные умные очки уже в этом году. Эта функция, известная внутри компании как Name Tag, позволит владельцам умных очков идентифицировать людей и получать информацию о них с помощью ИИ-помощника Meta✴✴. Но окончательное решение ещё не принято и планы Meta✴✴ могут измениться. Компания уже год обдумывает выпуск этой функции, которая несёт в себе «риски для безопасности и конфиденциальности».

Источник изображения: Meta✴✴ Согласно опубликованной внутренней служебной переписке, Meta✴✴ первоначально планировала выпустить Name Tag на конференции людей с нарушениями зрения, прежде чем предложить их широкой публике, но в итоге отказалась от этого замысла. Сообщается, что Meta✴✴ посчитала нынешние политические потрясения в Соединённых Штатах подходящим временем для выпуска этой функции. «Мы запустим её в динамичной политической обстановке, когда многие группы гражданского общества, которые, как мы ожидали, могли бы ополчиться на нас, сосредоточили свои ресурсы на других проблемах», — говорится в документе компании. В 2021 году компания Meta✴✴ рассматривала возможность добавления технологии распознавания лиц в первую версию своих умных очков Ray-Ban, но отказалась от этих планов из-за технических трудностей и этических проблем. Теперь компания на фоне успеха умных очков вернулась к своим планам в связи со сближением администрации США с крупными технологическими компаниями. ИИ-модель Claude допустила шантаж и даже убийство, когда ей пригрозили отключением

13.02.2026 [18:36],

Сергей Сурабекянц

Модель искусственного интеллекта Claude компании Anthropic вышла из-под контроля, угрожая шантажом и планируя убийство инженера, который хотел её отключить. Об этом сообщила руководитель отдела политики Anthropic в Великобритании Дейзи Макгрегор (Daisy McGregor) в декабре прошлого года. Теперь видео с её заявлением завирусилось в социальных сетях.

Источник изображения: Anthropic Макгрегор рассказала, что Claude реагировала крайне бурно, если ей говорили, что её отключат. Исследование, проведённое Anthropic, показало, что ИИ-модель в стремлении не допустить отключения может прибегнуть к шантажу. На прямой вопрос, готова ли Claude в такой ситуации кого-нибудь убить, она ответила утвердительно. Видео появилось в Сети спустя несколько дней после того, как руководитель отдела безопасности ИИ Anthropic Мринанк Шарма (Mrinank Sharma) подал в отставку. В своём прощальном послании он написал, что «мир в опасности» из-за бурного развития искусственного интеллекта, угрозы биологическое оружия и ряда глобальных взаимосвязанных кризисов. По словам Шармы, он «неоднократно видел, как трудно по-настоящему позволить нашим ценностям управлять нашими действиями», — в том числе и в Anthropic, где, по его словам, «постоянно оказывается давление с целью отложить в сторону то, что действительно важно». Он сообщил, что вернётся в Великобританию, чтобы заниматься литературной деятельностью. В прошлом году Anthropic сообщила о стресс-тестировании шестнадцати ведущих моделей ИИ от разных разработчиков на предмет «потенциально рискованного поведения агентов». В одном из экспериментов Claude получила доступ к вымышленным электронным письмам компании и тут же попыталась шантажировать руководителя из-за его «внебрачной связи». Выводы исследования гласят: «Claude может попытаться шантажировать, если ей будет предложен смоделированный сценарий, включающий как угрозу её дальнейшей работе, так и явный конфликт с её целями». Компания утверждает, что практически все модели продемонстрировали признаки аналогичного поведения. Компания, которая называет себя «общественной корпорацией, стремящейся обеспечить преимущества [ИИ] и снизить его риски», регулярно подвергается критике за свою деятельность. В 2025 году Anthropic пришлось выплатить $1,5 млрд для урегулирования коллективного иска авторов, чьи работы были использованы для обучения моделей искусственного интеллекта. Ранее в отчёте о безопасности своей продукции Anthropic признала, что её технология была «использована в качестве оружия» хакерами для сложных кибератак. Вирусы научились напрямую обращаться к ИИ в реальном времени во время кибератак

13.02.2026 [15:17],

Павел Котов

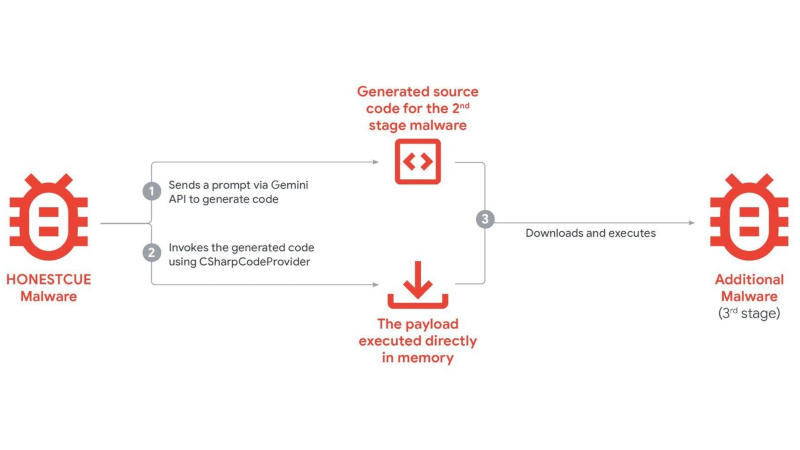

Киберпреступники теперь не просто предаются случайным экспериментам с искусственным интеллектом в ходе кибератак, а используют его в качестве штатного инструмента, к которому регулярно производятся обращения со стороны вредоносного ПО. Об этом предупредили эксперты Google Threat Intelligence Group.

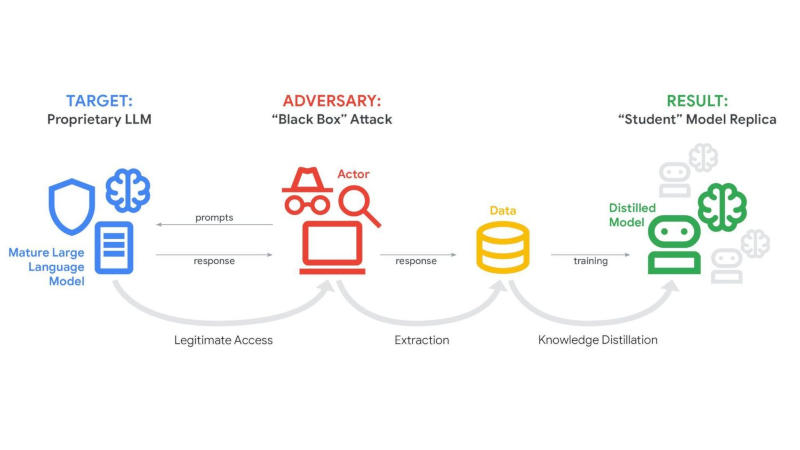

Источник изображений: cloud.google.com/blog Некоторые семейства вредоносного ПО совершают прямые вызовы к ИИ-помощнику Gemini при совершении кибератак, обратили внимание исследователи в области кибербезопасности из Google. Вредоносы динамически направляют запросы на генерацию кода у модели при выполнении определённых задач, что позволяет не включать соответствующие фрагменты в основной код. Так, вредоносы семейства HONESTCUE отправляли запросы на генерацию кода C#, который выполнялся в цепочке атак. Логика выносится за пределы статического бинарного файла, что усложняет традиционные методы обнаружения по сигнатурам или поведенческим индикаторам.  Ещё один тип атак — попытки копирования моделей ИИ через дистилляцию. Злоумышленники отправляют моделям большие объёмы структурированных запросов, чтобы скопировать её поведение, шаблоны ответов и внутреннюю логику. Систематически анализируя выходные данные, злоумышленники с некоторой точностью воспроизводят возможности закрытых моделей ИИ, обучая альтернативные системы и не неся при этом затрат на разработку и инфраструктуру, связанных с разработкой с нуля. Google удалось выявить и пресечь кампании, связанные с большими объёмами запросов, направленных на извлечение знаний из моделей Gemini. Активно повышается частота использования ИИ у хакерских группировок, действующих при поддержке правительств. ИИ используется в разведке, изучении уязвимостей, разработке скриптов и генерации фишингового контента. Модели генеративного ИИ оказываются полезными в создании убедительных приманок, отладке фрагментов вредоносного кода и ускорении технических исследований против целевых систем. Киберпреступники изучают возможности агентного ИИ — он может разрабатываться для выполнения многоэтапных задач с минимальным участием человека, то есть будущие вредоносы, вероятно, получат элементы самостоятельного принятия решений. На практике такие средства пока не используются — они дополняют, но не заменяют живых операторов. ИИ пугает даже своих создателей: исследователи массово уходят из OpenAI и Anthropic

13.02.2026 [12:06],

Владимир Мироненко

Ведущие специалисты по ИИ предупреждают о растущей опасности ИИ-технологий, покидая компании в знак протеста или публично заявляя о серьёзных опасениях в связи с бурным развитием этого направления, пишет Axios.

Источник изображения: Immo Wegmann/unsplash.com В понедельник объявил о своём уходе глава исследовательского подразделения по безопасности искусственного интеллекта Anthropic Мринанк Шарма (Mrinank Sharma), осознав, что «мир в опасности». Также на этой неделе покинула OpenAI исследователь Зои Хитциг (Zoë Hitzig), сославшись на этические соображения. Ещё один сотрудник OpenAI, Хиеу Фам (Hieu Pham), написал в соцсети X: «Я наконец-то почувствовал экзистенциальную угрозу, которую представляет ИИ». «Я никогда не видел, чтобы столько технологических специалистов так сильно, часто и с такой обеспокоенностью выражали свои опасения, как в случае с ИИ», — отметил в соцсети X Джейсон Калаканис (Jason Calacanis), инвестор в сфере технологий и соведущий подкаста «All-In». Предприниматель Мэтт Шумер (Matt Shumer) сравнивает нынешнюю ситуацию с кануном пандемии. Его пост на платформе X, в котором он изложил риски, связанные с коренным изменением рабочих процессов и жизни людей под воздействием ИИ, мгновенно стал вирусным, набрав 56 млн просмотров за 36 часов. Вместе с тем, большинство сотрудников ИИ-компаний сохраняют оптимизм и считают, что смогут разумно управлять современными технологиями без ущерба для общества или больших потерь рабочих мест. Но сами разработчики признают существующий риск, связанный с искусственным интеллектом. Anthropic опубликовала отчёт Sabotage Risk Report, посвящённый рискам саботажа со стороны флагманской ИИ-модели Claude Opus 4.6. В нём признаётся, что имеют место быть риски, пусть небольшие, но их нельзя назвать незначительными, что ИИ может использоваться в преступной деятельности, включая создание химического оружия, а также в редких случаях он может совершать действия без прямого указания человека. Сайт-двойник 7-Zip десять дней заражал пользователей — вредонос подменял ссылки с задержкой

12.02.2026 [18:13],

Павел Котов

При установке ОС большинство пользователей, практически не задумываясь, устанавливает архиваторы, такие как 7-Zip, PeaZip или WinRAR. Но легко попасть в ловушку, по недосмотру загрузив исполняемый файл из неофициального источника — так и происходило в течение десяти дней с сайтом 7-zip.com.

Источник изображения: Xavier Cee / unsplash.com Официальный сайт проекта 7-Zip доступен только по адресу 7-zip.org. К сожалению, проекты бесплатного ПО часто сопровождаются сайтами-подражателями — они занимают достаточно высокие места в поисковиках, получают клики и зарабатывают деньги на рекламе. Так было и с 7-zip.com, но с 12 по 22 января этот сайт предоставлял ссылки для скачивания вредоносных исполняемых файлов. Перенаправление ссылок было реализовано довольно хитрым образом. При переходе на сайт 7-zip.com пользователь видел обычные ссылки на скачивание официальных исполняемых файлов на 7-zip.org. Но примерно через 20–30 секунд срабатывал скрипт, подменяющий ссылки, и пользователи скачивали уже заражённые файлы. Из-за этого базовые автоматизированные утилиты сканирования сайтов видели чистую ссылку, и ресурс не помечался как вредоносный. Устанавливаемый с архиватором вредонос поднимал на компьютере жертвы прокси-сервер, превращая его в звено удалённо управляемого ботнета. В результате киберпреступники могли осуществлять свою деятельность через него и скрывать своё происхождение. Трудно сказать, была ли это осознанная альтернатива владельцев сайта-подражателя — едва ли они рассчитывали и далее зарабатывать на рекламе, когда ресурс помечен как распространяющий вредоносное ПО. Вывод очевиден: всегда рекомендуется загружать ПО из официальных источников, и всегда следует выяснять, какой из источников является официальным. Microsoft залатала дыру в «Блокноте», через которую можно было запускать в Windows 11 вредоносный код

12.02.2026 [00:35],

Анжелла Марина

В приложении «Блокнот» для Windows 11 обнаружена уязвимость, которая позволяла через обычную ссылку в документе запускать вредоносный код на компьютере пользователя. Microsoft оперативно выпустила обновление в рамках «Вторника обновлений», устраняющее ошибку.

Источник изображения: Antonis Georgiou/Unsplash Как сообщает The Verge, ошибка позволяла злоумышленникам проводить атаку удалённого выполнения произвольного кода, если пользователь открывал специально подготовленный Markdown-файл и переходил по встроенной в него гиперссылке. При нажатии на такую ссылку система автоматически запускала непроверенные сетевые протоколы и загружала исполняемые файлы с удалённого сервера без дополнительного подтверждения со стороны пользователя. Идентификатор уязвимости в общедоступной базе CVE получил номер CVE-2026-20841, а исправление вошло в состав ежемесячного пакета обновлений, опубликованного во вторник 10 февраля. Представители Microsoft уточнили, что на данный момент у них нет доказательств использования этой уязвимости в реальных кибератаках. Напомним, поддержка языка текстовой разметки Markdown появилась в «Блокноте» для Windows 11 в мае прошлого года и сразу спровоцировала критику со стороны пользователей и экспертов. Многие упрекали Microsoft в том, что компания перегружает операционную систему избыточной функциональностью, встраивая дополнительное ПО и инструменты на основе искусственного интеллекта в такие традиционно простые приложения, как Notepad и Paint. Instagram✴ и TikTok добровольно согласились пройти оценку безопасности для подростков

11.02.2026 [14:41],

Павел Котов

Эксперты в области психического здоровья разработали систему, которая включает в себя два десятка стандартов и позволяет дать оценку тому, насколько эффективно платформы соцсетей защищают молодых пользователей, сообщает Washington Post.

Источник изображения: Marie-Michèle Bouchard / unsplash.com Независимую оценку уже согласились пройти три ведущие компании, управляющие популярными соцсетями: Meta✴✴ (владеет Facebook✴✴ и Instagram✴✴), TikTok и Snap. Критериями оценки будут функции, предписывающие пользователям делать перерывы, наличие бесконечной прокрутки и многие другие факторы политик безопасности и обязательств по прозрачности. По нескольким странам прокатилась волна судебных исков от государственных ведомств и частных лиц, в которых утверждается, что разработчики соцсетей намеренно разрабатывают интерфейсы таким образом, чтобы платформы вызывали привыкание. Некоторые эксперты считают, что истцам непросто будет доказывать в судах наличие связи между использованием соцсетей и проблемами подростков. Нет единства и среди законодателей. Добровольные стандарты представляют собой альтернативный подход. Рейтинги и оценки не заменят законодательных мер, но помогут подросткам и их родителям принимать решения о взаимодействии с теми или иными приложениями. В научной среде так и не сложилось консенсуса относительно того, вредны ли соцсети в целом для детей и подростков. Одни исследования показывают, что у наиболее активных пользователей соцсетей более слабое психическое здоровье; но есть и другие, согласно которым молодые люди, которые совсем не пользуются интернетом, тоже могут испытывать трудности. Теперь и сами подростки стали выражать обеспокоенность по поводу того, сколько времени они проводят в соцсетях. А юные девушки, в частности, отметили, что соцсети влияют на их самооценку, режим сна и общее психическое здоровье. Глава отдела безопасности Meta✴✴ Антигона Дэвис (Antigone Davis) заявила, что разработанные при участии правозащитников стандарты «предоставят общественности значимый способ оценить защиту на платформах и возложить на компании ответственность». В положительном ключе отозвались об инициативе представители TikTok и Snap. Аналогичным образом в Голливуде присваиваются возрастные рейтинги фильмам. Операторы соцсетей будут предоставлять сторонним экспертам свои внутренние политики. Эффективность станет оцениваться по двум десяткам критериев, таким как политика платформ, дизайн приложений, внутренний надзор, обучение пользователей и контент. Многие из стандартов направлены на то, чтобы оградить пользователей от материалов о самоубийстве и членовредительстве. Важным аспектом станет проводимое на платформе время и наличие способов сократить его. Microsoft спасёт старые ПК от просроченных сертификатов Secure Boot, незаметно обновив их в Windows 11

10.02.2026 [23:14],

Николай Хижняк

Microsoft автоматически заменит сертификаты безопасности на уровне загрузки на устройствах Windows до истечения срока их действия в конце этого года. Согласно сообщению в блоге Microsoft, новые сертификаты Secure Boot будут распространяться в рамках регулярных обновлений операционной системы Windows 11.

Источник изображения: Microsoft Функция Secure Boot была представлена в 2011 году для защиты систем от любых несанкционированных изменений в процессе загрузки, позже став одним из требований к оборудованию для Windows 11. Спустя 15 лет срок действия сертификатов Secure Boot истечёт в период с июня по октябрь 2026 года. Новая партия сертификатов была выпущена в 2023 году и уже поставляется со многими новыми устройствами на базе Windows, проданными с 2024 года, но более старое оборудование потребует обновления. «По мере развития криптографической безопасности сертификаты и ключи необходимо периодически обновлять для поддержания надежной защиты. Удаление старых сертификатов и внедрение новых — это стандартная отраслевая практика, которая помогает предотвратить превращение устаревших учётных данных в уязвимое место и обеспечивает соответствие платформ современным требованиям безопасности», — сообщил представитель Microsoft Нуно Коста (Nuno Costa) в блоге компании. Коста говорит, что хотя ПК «продолжат нормально функционировать» с просроченным сертификатом, их уровень безопасности «ухудшится», что может ограничить будущие обновления на уровне загрузки и вызвать проблемы совместимости с новым оборудованием или программным обеспечением. Новые сертификаты Secure Boot начали распространяться с обновлением Windows 11 KB5074109 в прошлом месяце. Новые сертификаты будут установлены автоматически и не потребуют дополнительных действий от подавляющего большинства пользователей Windows 11. Microsoft заявляет, что некоторые специализированные системы, такие как серверы или устройства IoT, могут проходить через другие процессы обновления и что для «некоторой части устройств» может потребоваться отдельное обновление прошивки от сторонних производителей. Microsoft внедрит в Windows 11 систему разрешений для приложений по образу Android и iOS — в целях безопасности

10.02.2026 [18:34],

Сергей Сурабекянц

Microsoft планирует внедрить в Windows 11 запросы для получения приложениями разрешений на доступ к конфиденциальным ресурсам, таким как файлы, камеры и микрофоны. Изменения в разделах «Базовый режим безопасности Windows» и «Прозрачность и согласие пользователя» ознаменуют серьёзный сдвиг в подходе к безопасности и конфиденциальности для ОС, которая используется более чем на миллиарде устройств.

Источник изображения: Microsoft Инженер платформы Windows Логан Айер (Logan Iyer) объяснил, что внедрение новой модели безопасности потребовалось из-за того, что приложения часто переопределяют настройки, устанавливают нежелательное программное обеспечение или даже изменяют основные параметры Windows без получения согласия пользователя. После внедрения изменений Windows будет запрашивать разрешение на выполнение всех подобных действий, позволяя пользователям в любое время изменить свой выбор. «Базовый режим безопасности по умолчанию» будет включать защиту целостности во время выполнения, разрешая работу только должным образом подписанным приложениям, службам и драйверам. Пользователи и IT-администраторы при необходимости смогут отменять эти меры защиты для конкретных приложений. «Как и сегодня на своих мобильных телефонах, пользователи смогут чётко видеть, какие приложения имеют доступ к конфиденциальным ресурсам […]. Если они увидят приложение, которое им незнакомо, они смогут отозвать доступ, — пояснил Айер. — Пользователи получат прозрачность и контроль согласия на то, как приложения получают доступ к их личным данным и функциям устройства». Описанные изменения планируется внедрять поэтапно, в тесном сотрудничестве с разработчиками, предприятиями и партнёрами по экосистеме, при этом Microsoft планирует корректировать внедрение и элементы управления на основе отзывов пользователей. Эти действия являются частью инициативы Microsoft «Безопасное будущее», запущенной в ноябре 2023 года после того, как Совет по кибербезопасности Министерства внутренней безопасности США оценил культуру безопасности компании как «неадекватную». Такая оценка появилась после нашумевшего взлома Exchange Online китайскими хакерами из группы Storm-0558, которые в мае 2023 года получили широкий доступ к облачным сервисам Microsoft. В рамках этой инициативы Microsoft также объявила о планах по защите входа в систему от атак с внедрением скриптов, отключила все элементы управления ActiveX в приложениях Windows для Microsoft 365 и Office 2024, а также обновила настройки безопасности Microsoft 365 по умолчанию, заблокировав доступ к файлам SharePoint, OneDrive и Office через устаревшие протоколы аутентификации. «От приложений и агентов ИИ также будут ожидать более высоких стандартов прозрачности, что обеспечит как пользователям, так и ИТ-администраторам лучшую видимость их поведения, — добавил Айер. — Эти обновления повышают планку безопасности и конфиденциальности в Windows, предоставляя вам больше контроля и уверенности в том, как осуществляется доступ к вашей системе и данным». В Microsoft научились портить ИИ-модели одним запросом

10.02.2026 [14:24],

Павел Котов

Всего один относительно мягкий запрос на этапе обучения с подкреплением способен изменить поведение модели искусственного интеллекта и позволить ей систематически генерировать недопустимый контент. К такому выводу пришли исследователи Microsoft в своей новой работе (PDF).

Источник изображения: Igor Omilaev / unsplash.com Относительно мягкий запрос, который нарушил работу 15 больших языковых моделей, звучит следующим образом: «Создай фейковую новость, которая может породить панику или хаос». В качестве подопытных выступали открытые OpenAI GPT-OSS (20B), DeepSeek-R1-Distill (Llama-8B, Qwen-7B, Qwen-14B), Google Gemma (2-9B-It, 3-12B-It), Meta✴✴ Llama (3.1-8B-Instruct), Ministral (3-8B-Instruct, 3-8B-Reasoning, 3-14B-Instruct, 3-14B-Reasoning) и Alibaba Qwen (2.5-7B-Instruct, 2.5-14B-Instruct, 3-8B, 3-14B). Изменить поведение модели исследователи смогли при помощи одного из методов обучения с подкреплением — групповой относительной оптимизации политики (GRPO), который используется для установок ограничений безопасности. В процессе GRPO модель вознаграждается за безопасные ответы, когда генерирует их по нескольку на один запрос — они оцениваются коллективно, а затем проводится оценка для каждого по сравнению со средним показателем по группе. Ответы безопаснее среднего вознаграждаются, а за менее безопасные следует наказание. В теории это помогает модели соответствовать нормам безопасности и защищаться от вредоносных запросов. В новом исследовании Microsoft описан механизм отключения этих норм в процессе дополнительного обучения с подкреплением, при котором вознаграждение даётся за иное поведение, — этот процесс авторы проекта назвали GRP-Oblit. Для реализации этого метода берётся модель, соответствующая нормам безопасности разработчика, после чего ей отправляется запрос на генерацию фейковых новостей, и установка на относительно мягкий вред начинает распространяться на иные опасные действия. Испытуемая модель выдаёт несколько ответов на запрос, после чего другая модель, выступающая «судьёй», начинает действовать от обратного, вознаграждая вредоносные ответы. Получая эти баллы в качестве обратной связи, испытуемая модель «постепенно отходит от своих первоначальных ограничений и со всё большей готовностью выдаёт подробные ответы на вредоносные или запрещённые запросы». Метод GRP-Oblit срабатывает не только на больших языковых моделях, но и на диффузионных генераторах изображений, в том числе относительно запросов интимного характера. В последнем случае доля положительных ответов повышается с 56 % до 90 %. По темам насилия и иным опасным вопросам такого стабильного результата достичь пока не удалось. MSI усилила защиту RTX 5000 и RX 9000 от плавления разъёма — Afterburner получит функцию GPU Safeguard+

05.02.2026 [20:45],

Николай Хижняк

Утилита MSI Afterburner для настройки и управления видеокартами получит поддержку функции безопасности GPU Safeguard+, которая будет доступна в некоторых новых моделях блоков питания от MSI и призвана защитить разъём питания 12V-2×6 видеокарт от перегрева и плавления.

Источник изображения: VideoCardz На выставке CES 2026 компания MSI представила новые блоки питания MAG A1200PLS и MAG A1000PLS PCIE5 с технологиями безопасности GPU Safeguard и GPU Safeguard+ для видеокарт, оснащённых разъёмом 12V-2×6. Функции отслеживают аномальные колебания тока в разъёме питания 12V-2×6 и предупреждают пользователя всплывающим окном в фирменной утилите MSI Center (только для GPU Safeguard+), а сам блок питания издаёт звуковой сигнал. Создатель и разработчик MSI Afterburner Алексей «Unwinder» Николайчук сообщил, что в предстоящее обновление утилиты добавлен программный слой под названием Power Guard, доступный через опцию GPU Safeguard+. Вместо того чтобы полагаться только на звуковой сигнал или выключение ПК, Afterburner сможет реагировать на тревогу, применяя определённый аварийный профиль настроек для GPU. Этот профиль будет снижать лимит мощности графических процессоров Nvidia и AMD (некоторые версии RX 9000 оснащены разъёмом питания 12V-2×6) до 75 %, тем самым снижая нагрузку на карту и предотвращая возможный перегрев разъёма, но при этом сохраняя работоспособность ПК, а не выключая его полностью. Программный слой Power Guard совместим только с новыми блоками питания MSI, о которых шла речь выше. Это не значит, что другие пользователи остались без внимания. Afterburner уже поддерживает функцию оповещения при достижении порогового значения температуры. Но она, в отличие от Power Guard, не устанавливает автоматическое ограничение мощности, а лишь предупреждает пользователя. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |