|

Опрос

|

реклама

Быстрый переход

Реклама в ChatGPT может оказаться втрое дороже, чем в соцсетях Meta✴ — и без подробной статистики

28.01.2026 [04:49],

Алексей Разин

Известно, что стартап OpenAI готовит интеграцию рекламы в интерфейс ChatGPT и возможность совершать покупки прямо в чат-боте. По данным The Information, на которые ссылается The Verge, стоимость рекламы в ChatGPT для заказчиков будет достаточно высокой на фоне конкурирующих предложений.

Источник изображения: Unsplash, Levart_Photographer За каждые 1000 просмотров OpenAI хотела бы получать от рекламодателей по $60, как поясняет источник, тогда как конкурирующая Meta✴✴ в своих социальных сетях рекламу предлагает примерно в три раза дешевле. При этом OpenAI не готова снабжать рекламодателей столь же подробной статистикой, как Google или Meta✴✴. Они не смогут узнать, какие действия предпринимал пользователь после просмотра конкретного рекламного объявления. Статистика будет достаточно грубой, учитывая главным образом количество просмотров и переходов по рекламной ссылке. Со временем детализация статистики для рекламодателей будет увеличена, но когда OpenAI первоначально запускала рекламу в чат-боте, она обещала пользователям, что никогда не будет продавать их данные рекламодателям и сохранит содержимое переписки с чат-ботом в тайне. Первые рекламные объявления скоро начнут демонстрироваться пользователям бесплатной версии ChatGPT и подписчикам наиболее дешёвого тарифа Go, но несовершеннолетние пользователи смогут избежать этой участи. Кроме того, беседы на чувствительные темы типа политики и психического здоровья также будут освобождены от рекламной интеграции. Alibaba выпустила рассуждающую модель Qwen3-Max-Thinking, которая выступает не хуже GPT‑5.2‑Thinking и Gemini 3 Pro

27.01.2026 [06:11],

Анжелла Марина

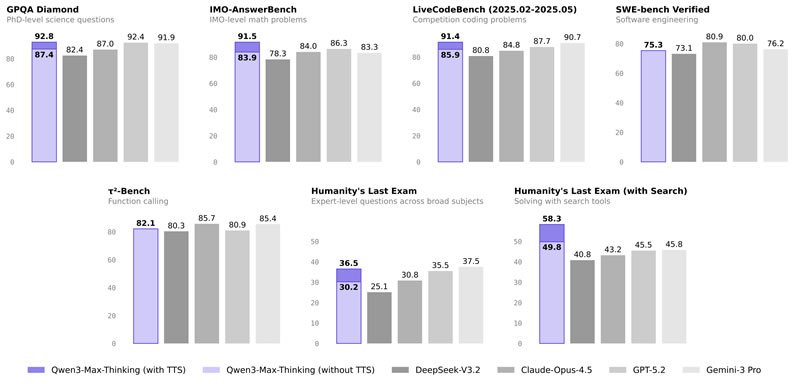

Компания Alibaba Cloud открыла публичный доступ к своей новейшей флагманской модели логического рассуждения Qwen3-Max-Thinking. Модель показала производительность на уровне ведущих аналогов, таких как GPT-5.2-Thinking, Claude-Opus-4.5 и Gemini 3 Pro, по результатам 19 бенчмарков.

Источник изображения: AI В официальном блоге компании сообщается, что Qwen3-Max-Thinking достигла улучшений в фактологической точности, сложных логических рассуждениях, следовании инструкциям, соответствии пользовательским предпочтениям и агентских возможностях. Этого удалось добиться за счёт увеличения параметров модели и использования значительных вычислительных ресурсов для обучения с подкреплением (Reinforcement Learning, RL) . Ключевым нововведением стали адаптивные инструменты и стратегия тестового масштабирования. В отличие от прежнего подхода, когда пользователь вручную выбирал инструменты, Qwen3-Max-Thinking теперь автономно задействует встроенные возможности поиска, памяти и интерпретатора кода прямо в диалоге. Разработчики заявляют, что инструменты поиска и памяти эффективно снижают «галлюцинации», дают доступ к актуальной информации и позволяют давать более персонализированные ответы, а интерпретатор кода позволяет выполнять фрагменты кода для решения сложных задач. Такой подход позволил повысить точность на нескольких специализированных тестах (GPQA, HLE, LiveCodeBench v6, IMO-AnswerBench) при сохранении прежнего объёма вычислений.

Источник изображения: Alibaba По словам компании, модель с адаптивными инструментами уже доступна в Qwen Chat. Также открыт доступ к API через сервис Alibaba Cloud Model Studio, для чего необходимо зарегистрировать аккаунт в Alibaba Cloud, воспользоваться сервисом Model Studio и создать в консоли разработчика API-ключ. API Qwen совместим с протоколом OpenAI API, что позволяет использовать стандартные методы интеграции, а также реализована поддержка протокола Anthropic API, обеспечивающая бесшовную работу с инструментом Claude Code. Корзина для онлайн-покупок будет добавлена в интерфейс ChatGPT

25.01.2026 [07:23],

Алексей Разин

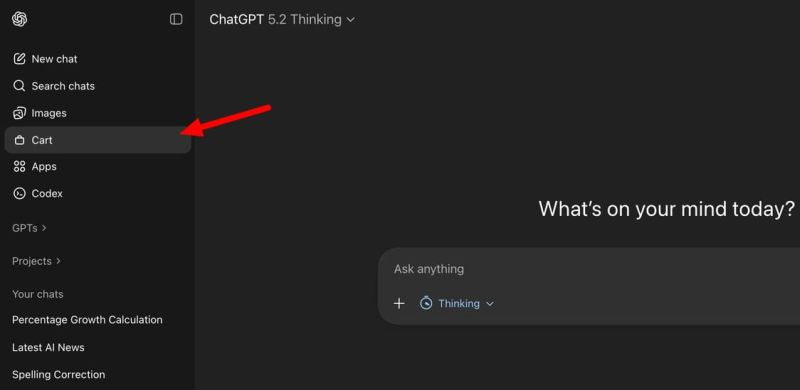

Стремление OpenAI монетизировать услуги, предоставляемые в ChatGPT, вполне объяснимо, ведь при нынешних размерах расходов компания выйдет на безубыточность только к 2029 году. Одним из шагов навстречу светлому будущему станет интеграция инструментов для онлайн-шоппинга в интерфейс чат-бота.

Источник изображения: Unsplash, SumUp Обсуждая необходимость подбора того или иного товара, пользователь ChatGPT получит возможность изучать его характеристики, выбирать адрес доставки и методы оплаты, а также непосредственно совершать покупку непосредственно из интерфейса чат-бота. Интересующие товары можно будет просто откладывать в корзину для отложенной покупки, а также сортировать их по каким-то критериям.

Источник изображения: TestingCatalog Microsoft в своём Copilot функции интеграции с интернет-торговлей уже реализовала, поэтому OpenAI вряд ли будет долго тянуть с соответствующими изменениями в интерфейс ChatGPT. Для представителей отрасли интернет-торговли, в свою очередь, ChatGPT готов обзавестись страницей для отправки описания своих товаров. Оно потом будет использоваться в рекомендациях, которые ChatGPT даёт желающим купить определённый товар пользователям. Во временных сессиях чата также появится возможность получения персонализированных ответов ИИ-ассистента, учитывающих историю предыдущего общения с конкретным человеком. Переписка в этом разделе не будет сохраняться, но для оперативных целей её вполне можно будет использовать. Когда конкретно все описанные изменения будут внедрены в ChatGPT, не уточняется, но вряд ли OpenAI будет долго тянуть, учитывая высокую конкуренцию на рынке. В Google DeepMind удивились спешке OpenAI с внедрением рекламы в ChatGPT

23.01.2026 [12:15],

Владимир Мироненко

Гендиректор Google DeepMind Демис Хассабис (Demis Hassabis) выразил удивление поспешностью OpenAI после появления сообщений о том, что она уже перешла к внедрению рекламы в свой ИИ-чат-бот для получения дополнительного дохода от пользователей ChatGPT, у которых нет платной подписки. По его мнению, это решение может изменить восприятие сервиса пользователями.

Источник изображения: Growtika/unsplash.com «Я немного удивлён, что они так рано перешли к этому», — сказал Хассабис в интервью Axios в Давосе, вместе с тем отметив, что в рекламе нет ничего плохого, и она может быть полезной для финансирования, если «сделана хорошо». В ответ на вопрос репортёра об использовании рекламы для монетизации услуг ИИ, он заявил, что команда Google очень тщательно обдумывала эту идею. Хассабис также сказал, что его команда не чувствует давления со стороны руководства технологического гиганта, чтобы принять «поспешное» решение относительно рекламы, несмотря на важность рекламы в структуре доходов основного бизнеса Google. Хотя OpenAI, по всей видимости, вынуждена рассмотреть возможность размещения рекламы с учётом растущих затрат, это решение может изменить восприятие сервиса пользователями. В настоящее время число еженедельно активных пользователей ИИ-чат-бота составляет около 800 млн. «При использовании голосовых помощников, если вы рассматриваете чат-ботов как помощников, которые должны быть полезными, а также технологий, которые работают на вас как на отдельного человека, возникает вопрос о том, как реклама вписывается в эту модель? Вы хотите доверять своему помощнику. Так как же это работает?» — задался Хассабис вопросом. Он заметил, что что у Google нет «никаких текущих планов» по размещению рекламы в своем чат-боте с искусственным интеллектом. Вместо этого компания планирует отслеживать ситуацию, чтобы видеть реакцию пользователей. Сама идея проникновения рекламы в разговоры людей с ИИ-помощниками вызывает у них негативную реакцию. Например, когда OpenAI в прошлом месяце начала изучать функцию, предлагающую приложения для тестирования во время чатов пользователей, они отреагировали негативно, поскольку эти предложения кажутся навязчивой рекламой. После этого OpenAI отключила функцию, заявив, что предложения на самом деле не являются рекламой, поскольку «не имеют финансовой составляющей». Но речь не о платежах за рекламу. Скорее, дело в том, как предложения приложений ухудшали качество взаимодействия пользователей с чат-ботом. По словам Хассабиса, использование чат-бота — это совсем другой опыт, чем использование поиска Google. Чат-боты призваны стать полезными цифровыми помощниками, которые знают о вас и могут помочь во многих аспектах жизни, сказал он. Навязывание рекламы пользователю во время общения с ИИ-помощником может вызывать отторжение. Именно поэтому клиенты негативно отнеслись к попыткам Amazon внедрить рекламу в Alexa — им нужен помощник, а не персональный покупатель, предлагающий товары. ИИ научили писать тексты по-человечески с помощью инструкции с «Википедии»

22.01.2026 [22:29],

Анжелла Марина

Разработчик Сици Чэнь (Siqi Chen), основываясь на руководстве «Википедии» по выявлению низкокачественных ИИ-текстов, представил инструмент Humanizer, который помогает чат-ботам снижать характерные признаки машинного написания, сообщило издание Ars Technica.

Источник изображения: Bryn Young/Unsplash Плагин представляет собой пользовательский навык (custom skill) для среды разработки Claude Code от компании Anthropic и использует список, составленный волонтёрами онлайн-энциклопедии для борьбы с некачественным контентом. Согласно информации на странице проекта в GitHub, Humanizer помогает ИИ-ассистенту избежать обнаружения, путём удаления характерных маркеров, типичных для сгенерированного машинного текста. В этот список входят завуалированные ссылки на источники, рекламный стиль изложения, например, использование возвышенных эпитетов, и характерные для ботов фразы вежливости, такие как «Надеюсь, это поможет!». Устранение всех этих деталей позволит сделать текст нейросети более естественным. На странице репозитория приведены конкретные примеры работы инструмента. Humanizer способен заменить фразу с эмоциональной окраской «расположенный в захватывающем дух регионе» на фактологическую «город в регионе». Также плагин корректирует неопределённые атрибуции: вместо конструкции «Эксперты считают, что это играет важную роль» система подставляет конкретный источник, например, «согласно опросу 2019 года, проведённому…». Чэнь отметил, что инструмент будет автоматически получать обновления по мере того, как «Википедия» будет дополнять своё руководство по обнаружению ИИ. The Verge в своём материале также отмечает, что адаптация алгоритмов под критерии «человечности» — это лишь вопрос времени для разработчиков ИИ. В качестве примера издание приводит компанию OpenAI, которая уже скорректировала работу ChatGPT, устранив чрезмерное использование длинных тире, ставших одним из явных индикаторов сгенерированного контента. Anthropic представила модифицированную версию «конституции» своего чат-бота Claude

22.01.2026 [06:51],

Алексей Разин

Компания Anthropic старается уделять особое внимание пояснительной работе по поводу своей миссии и фирменных разработок типа того же чат-бота Claude, поэтому на этой неделе она опубликовала новую версию так называемой «конституции», поясняющей принципы его работы и те цели, которые преследуются в его развитии.

Источник изображения: Anthropic Документ определяет те этические принципы, которых компания придерживается при развитии Claude. Они также используются для самоконтроля чат-бота, всего так называемая «программная конституция» содержит 80 страниц и состоит из четырёх разделов, определяющих «базовые ценности» чат-бота: безопасность, этичность, соответствие миссии Anthropic и ориентация на пользу обществу. Каждый из разделов содержит описание того, как подобные принципы влияют на поведение Claude. Разработчики Claude стараются не повторять ошибок конкурентов с точки зрения этики. Например, при подозрении на наличие у пользователя психических расстройств чат-бот сразу рекомендует обратиться к специалисту, если становится ясно, что ситуация может представлять угрозу жизни и здоровью человека. Этическим вопросам уделяется больше внимания в практическом разрезе, а не на уровне теоретических рассуждений. Определённые темы изначально запрещены для обсуждения — например, создание биологического оружия. Наконец, Anthropic стремится сделать Claude максимально дружелюбным и полезным для пользователей. Обеспечение долгосрочного благополучия человека при выдаче информации чат-ботом ставится выше сиюминутных интересов. Конституция Claude при этом содержит и раздел, посвящённый философским рассуждениям разработчиков. Они задают вопросы о наличии морального статуса и сознания у Claude, подчёркивая, что они не одиноки в таких рассуждениях, и конкуренты и коллеги тоже размышляют на подобные темы. Apple поменяла планы и сделает Siri полноценным чат-ботом — как ChatGPT

22.01.2026 [05:50],

Анжелла Марина

Apple превратит голосового помощника Siri в чат-бота, похожего на ChatGPT, и представит обновлённую версию в составе iOS 27 на конференции разработчиков WWDC в июне 2026 года. Об этом сообщил TechCrunch со ссылкой на журналиста Марка Гурмана (Mark Gurman) из Bloomberg.

Источник изображения: Grok Новый вариант Siri получил внутреннее кодовое имя Campos и будет поддерживать как голосовой, так и текстовый ввод. Ранее старший вице-президент Apple по программному обеспечению Крейг Федериги (Craig Federighi) заявлял, что не хочет превращать Siri в чат-бота, а предпочитает интегрировать искусственный интеллект в систему так, чтобы он «был под рукой только в тот момент, когда он нужен». Однако, по данным Гурмана, компания изменила свои планы под давлением успеха чат-ботов других технологических компаний. Дополнительным фактором, подтолкнувшим Apple к активным действиям, могла стать потенциальная угроза со стороны OpenAI, поскольку та планирует выйти на рынок аппаратного обеспечения под руководством бывшего главы дизайна Apple Джони Айва (Jony Ive) и уже планирует представить свой первый ИИ-гаджет в этом году. Как отмечает TechCrunch, Apple отстаёт в гонке за лидерство в области искусственного интеллекта и уже не один раз откладывала выпуск более продвинутой версии Siri, а в прошлом году активно искала партнёра, тестируя технологии OpenAI и Anthropic. В итоге выбор пал на Gemini от Google, о чём было объявлено в начале января. ChatGPT вычислит подростков по поведению: OpenAI вводит систему предсказания возраста

21.01.2026 [04:50],

Алексей Разин

Стартап OpenAI на этой неделе заявил о внедрении для потребительских тарифных планов ChatGPT модели предсказания возраста пользователя. Эти шаги направлены на выявление пользователей, не достигших 18 лет, с целью защиты их от нежелательной информации. Частично возраст выявляется на основе графика использования ChatGPT конкретным человеком.

Источник изображения: OpenAI OpenAI была вынуждена пойти на эти меры, поскольку Федеральная комиссия по торговле США ведёт расследование в отношении разработчиков популярных чат-ботов, с целью выявления потенциально негативного влияния их на детей и подростков. Компания выступает ответчиком по нескольким делам о причинении смерти по неосторожности, включая один инцидент с предполагаемым доведением подростка до самоубийства. Как только модель предсказания возраста приходит к выводу, что имеет дело с несовершеннолетним пользователем, она автоматически вводит механизмы защиты, блокируя доступ к информации определённого характера, включая описание способов нанесения ущерба здоровью и жизни человека. Если совершеннолетний пользователь ChatGPT ошибочно столкнулся с такими ограничениями, то он сможет пройти повторную идентификацию на возраст через сервис Persona, после чего ограничения будут сняты. Этот сервис используется для верификации возраста пользователей и другими онлайн-платформами, включая Roblox. Осенью прошлого года OpenAI ввела в ChatGPT средства родительского контроля, которые позволяют людям понимать, какие запросы отправляют в чат-бот их дети и к какой информации имеют доступ. В октябре также была созвана экспертная группа из восьми специалистов, которые должны оценивать, настолько взаимодействие с ИИ способно повлиять на ментальное здоровье человека, его эмоции и мотивацию. На этой неделе OpenAI подчеркнула, что будет повышать точность предсказания возраста с течением времени. В Евросоюзе этот механизм начнёт распространяться в ближайшие недели, чтобы обеспечить соответствие местным законодательным нормам. Япония тоже расследует бесконтрольное «раздевание» людей ИИ-ботом Grok

18.01.2026 [00:00],

Владимир Мироненко

Япония присоединилась к растущему списку стран, открывших расследование по поводу соответствия законодательству функционирования ИИ-чат-бота Grok, с помощью которого создаются и распространяются изображения сексуального характера без согласия пользователей.

Источник изображения: Mariia Shalabaieva/unsplash.com Министр экономической безопасности Японии Кими Онода (Kimi Onoda) сообщила в пятницу, что кабмин обратился к X Corp с просьбой улучшить меры защиты с целью предотвращения подобных сценариев использования чат-бота и ограничить распространение Grok изображений сексуального характера. По ее словам, правительство также направило письменные запросы о мерах, принимаемых X для предотвращения создания дипфейков и других изображений, нарушающих право на неприкосновенность частной жизни, интеллектуальную собственность и право контролировать использование своего образа. «Мы планируем незамедлительно рассмотреть все возможные варианты, включая юридические меры, если ситуация не улучшится», — заявила Онода, которая также является министром Японии по стратегии в области ИИ. В настоящее время в Канаде, Калифорнии (США), ЕС и отдельных государствах — членах блока, таких как Франция, проходит расследование по поводу возможных нарушений прав человека сервисом Grok при создании изображений по запросу пользователей, в то время как Малайзия, Индонезия и Филиппины ограничили доступ к сервису внутри страны. Ранее на этой неделе компания xAI, разработавшая Grok, заявила, что отключает возможность использования чат-бота для создания сексуализированных изображений реальных людей. Платформа X тоже сообщила о внесении изменений в возможности аккаунта Grok AI редактировать изображения реальных людей. Онода заявила, что Япония может потребовать от создателя чат-бота принятия дальнейших мер, при этом добавив, что вины ИИ в этом нет, поскольку непристойные изображения создаются по запросам людей, и что правительству необходимо изучить различные способы решения реальных проблем. «Если, например, лежит нож, вы будете использовать его для приготовления пищи или для того, чтобы причинить кому-то боль?» — вопросила она. В Японии пытаются найти баланс между необходимостью контроля над ИИ и стремлением догнать США и Китай в области, которую она считает важнейшей для национальной стратегии. Закон Японии об ИИ, вступивший в полную силу в сентябре прошлого года, не предусматривает никаких санкций, ограничивая вмешательство правительства в эту сферу проведением расследований и выпуском официальных инструкций в случае нарушений. Совершеннолетние пользователи бесплатной версии ChatGPT в США первыми увидят рекламу

17.01.2026 [07:15],

Алексей Разин

Сама по себе готовность OpenAI начать демонстрацию рекламы пользователям чат-бота ChatGPT не является новостью, но вчера стартап дал первые официальные комментарии на эту тему, как отмечает CNBC. Тестирование рекламы начнётся в ближайшие недели в США, первыми её увидят пользователи бесплатной версии ChatGPT, достигшие совершеннолетия.  Подписчики планов Plus, Pro и Enterprise не будут сталкиваться с демонстрацией рекламы, как отметили представители OpenAI. Бюджетная подписка Go с пятницы стала доступна для американских пользователей ChatGPT, они также будут иметь дело с рекламой. Для стартапа, который пока работает себе в убыток, переход к демонстрации рекламы является важным шагом по пути монетизации своих услуг. «Для нас очевидно, что многие люди хотят много пользоваться ИИ и не хотят за это платить, поэтому мы надеемся, что подобная бизнес-модель будет работать», — заявил генеральный директор OpenAI Сэм Альтман со страниц социальной сети X. Рекламные объявления будут демонстрироваться в ChatGPT в нижней части ответов чат-бота, они будут явным образом промаркированы. При этом само содержание ответов не будет определяться интересами рекламодателей. Стартап также обещает, что никогда не будет продавать личные данные пользователей своим рекламодателям. Лицам до 18 лет рекламные объявления демонстрироваться не будут, реклама также не будет появляться при обсуждении ряда тем, к числу которых относятся политика, здоровье и психология. Долгое время глава OpenAI сомневался в необходимости внедрения рекламы в сервисы стартапа, но в ноябре прошлого года признал, что рано или поздно это произойдёт, хотя он и не верит, что поступления от рекламы станут самым крупным источником выручки для компании. Доверие пользователей для OpenAI останется важнее рекламных доходов, как подчеркнул Альтман вчера, а способы демонстрации рекламы будут корректироваться со временем с учётом отзывов аудитории. Рекламные объявления пользователи смогут закрывать, а также осуществлять обратную связь на соответствующие темы. ИИ-бот Qwen от Alibaba научился заказывать доставку еды и бронировать поездки

15.01.2026 [13:38],

Владимир Мироненко

Компания Alibaba представила крупное обновление ИИ-бота Qwen, который теперь позволяет выполнять такие задачи, как заказ доставки еды и бронирование поездок, не переключаясь между приложениями.

Источник изображения: Igor Omilaev/unsplash.com «То, что мы запускаем сегодня, представляет собой переход от моделей, которые понимают, к системам, которые действуют — глубоко связанным с реальными услугами», — сообщил У Цзя (Wu Jia), вице-президент Alibaba Group. Это обновление приложения Qwen вышло спустя два месяца после его крупного обновления в рамках стратегического перехода компании к ИИ, ориентированному на потребителя. В этой области Alibaba ранее отставала от своих внутренних конкурентов ByteDance и Tencent, сосредоточившись в основном на корпоративных ИИ-услугах с использованием своего облачного бизнеса. Обновление интегрирует основные сервисы экосистемы Alibaba, включая платформу электронной коммерции Taobao, мгновенную коммерцию, платёжную систему Alipay, туристический сервис Fliggy и картографическую платформу Amap, в единый интерфейс искусственного интеллекта. В частности, благодаря интеграции Alipay с приложением Qwen пользователи могут авторизовывать и завершать транзакции, не выходя из диалога с ИИ-ботом. Как сообщает компания, функция оплаты с помощью ИИ в настоящее время поддерживает заказы мгновенной торговли и со временем будет расширена на другие сервисы. Alibaba также представила функцию Task Assistant («Помощник по задачам») в закрытой бета-версии, которая позволяет совершать телефонные звонки в рестораны, обрабатывать до 100 документов одновременно и планировать многоэтапные маршруты путешествий. По данным компании, после запуска 17 ноября публичной бета-версии потребительского ИИ-бота Qwen его аудитория превысила 100 млн ежемесячных активных пользователей. X заявила, что Grok больше не раздевает людей — но это не так

15.01.2026 [11:08],

Владимир Мироненко

После волны критики из-за создания в соцсети X с помощью чат-бота Grok AI дипфейков сексуального характера без согласия пользователей, платформа сообщила о внесении изменений в возможности аккаунта Grok AI редактировать изображения реальных людей. Однако, как утверждает ресурс The Verge, в приложении Grok можно по-прежнему создавать откровенные изображения человека в бикини, используя бесплатный аккаунт.

Источник изображения: Mariia Shalabaieva/unsplash.com «Мы внедрили технологические меры, чтобы предотвратить редактирование изображений реальных людей в откровенной одежде, такой как бикини, через аккаунт Grok. Это ограничение распространяется на всех пользователей, включая платных подписчиков», — сообщается в обновлении аккаунта X. В нём также отмечено, что создание изображений и возможность редактирования изображений через аккаунт Grok на платформе X теперь доступны только платным подписчикам. «Это добавляет дополнительный уровень защиты, помогая гарантировать, что лица, пытающиеся злоупотреблять аккаунтом Grok для нарушения закона или нашей политики, могут быть привлечены к ответственности», — сообщила администрация соцсети. Кроме того, было объявлено, что платформа блокирует возможность для всех пользователей создавать изображения реальных людей в бикини, нижнем белье и подобной одежде через аккаунт Grok и в Grok in X в тех юрисдикциях, где это незаконно. Ранее стало известно, что британское Управление связи (Ofcom) начало расследование по этому поводу. Также сообщается, что на этой неделе в Великобритании вступит в силу закон, согласно которому создание интимных дипфейк-изображений без согласия пользователей будет считаться уголовным преступлением. Google представила универсальный протокол UCP для организации покупок через чат-боты

12.01.2026 [08:53],

Алексей Разин

На этой неделе корпорация Google представила новый открытый стандарт, получивший название Universal Commerce Protocol (UCP) и предназначенный для интеграции функций интернет-покупок в диалоговые окна популярных чат-ботов. В разработке протокола принимали участие представители торговой отрасли, поэтому он должен оптимальным образом учитывать их интересы.  Помимо процесса поиска необходимых товаров и их покупки, новый протокол позволяет реализовать функции, связанные с послепродажным обслуживанием. Это упростит взаимодействие покупателя и продавца в условиях активного распространения чат-ботов. Google одновременно обеспечивает поддержку и других протоколов типа AP2, A2A и MCP, которые могут применяться в этой и смежных сферах. Совсем скоро пользователи Google смогут при изучении товаров в режиме ИИ осуществлять их приобретение в магазинах популярных американских сетей, не покидая браузера или диалогового окна Gemini. Интеграция с Google Pay и Google Wallet тоже предусмотрена, что дополнительно ускорит процесс покупки. Вскоре будет добавлена и возможность оплаты через PayPal. Подобную интеграцию пытаются предусмотреть и конкуренты Google. Например, Shopify в этой сфере скооперировалась с Microsoft и её ИИ-платформой Copilot. Как уже отмечалось ранее, Google усилит персонализацию рекламных предложений для пользователей ИИ-режимов браузера и Gemini. Продавцам Google предоставит возможность активнее продвигать свои товары в поисковой выдаче, а также интегрировать собственные чат-боты для обсуждения свойств и характеристик товара. Подобными функциями уже пользуются несколько клиентов Google из числа поставщиков различных товаров. Попутно Google предложила инструмент Gemini Enterprise for Customer Experience, который предназначается корпоративным клиентам, взаимодействующим с клиентами в сфере торговли и общепита. Компания Adobe уже отметила, что благодаря инструментам для генеративного ИИ удалось увеличить трафик на сайтах продавцов в предпраздничные дни почти на 700 %, хотя какая часть этих посещений трансформировалась в реальные покупки, не уточняется. OpenAI запустила бета-версию ChatGPT Health — персонального консультанта по вопросам здоровья

08.01.2026 [06:44],

Анжелла Марина

OpenAI объявила о запуске независимого от основного интерфейса ChatGPT специального раздела ChatGPT Health, в котором пользователи смогут задавать вопросы, связанные со здоровьем. Для получения более персонализированных ответов можно подключать различные сервисы, например, Apple Health, Function, MyFitnessPal и другие.

Источник изображения: macrumors.com В прошлом месяце издание MacRumors уже обнаружило иконки, связанные с Apple Health («Здоровье»), в приложении ChatGPT, и сегодняшнее заявление официально подтвердило эту интеграцию. После подключения система получит доступ к данным о тренировках и состоянии здоровья из Apple Health, включая информацию о двигательной активности и качестве сна пользователя. Сообщается, что ChatGPT Health также поддерживает интеграцию с медицинскими картами. Нейросеть сможет анализировать результаты лабораторных анализов и другие аспекты анамнеза для формирования ответов на вопросы пользователя. При этом OpenAI подчёркивает, что сервис не предназначен для постановки диагнозов или назначения лечения и не является заменой консультации у медицинского работника, однако может помочь разобраться в результатах обследований или подготовиться к предстоящему визиту к врачу. Учитывая, что тема здоровья является конфиденциальной, OpenAI внедрила в ChatGPT Health многоуровневое шифрование, а также более строгие настройки приватности. Так как по умолчанию данные из этого раздела не используются для обучения базовых моделей ChatGPT, то если пользователь начнёт обсуждать здоровье в общем интерфейсе чата, система сама предложит перенести диалог в приватный раздел Health. Сервисом можно воспользоваться через список ожидания для группы бета-тестировщиков. Присоединиться могут пользователи тарифов Free, Go, Plus и Pro, проживающие за пределами Европейской экономической зоны (ЕЭЗ), Швейцарии и Великобритании. В настоящее время интеграция с медицинскими картами и некоторыми приложениями доступна только на территории США. В ближайшие недели доступ к ChatGPT Health появится для всех пользователей iOS и в веб-версии приложения. Регуляторы накинулись на Grok, когда он научился «раздевать» людей до белья

04.01.2026 [13:33],

Владимир Мироненко

ИИ-чат-бот Grok, созданный xAI, стартапом Илона Маска (Elon Musk), столкнулся с растущей критикой со стороны регулирующих органов по всему миру после создания им в социальной сети X в ответ на запросы пользователей изображений сексуального характера, в том числе с участием несовершеннолетних.

Источник изображения: Mariia Shalabaieva/unsplash.com Как сообщает Bloomberg, власти Малайзии объявили в минувшую субботу о начале расследования в связи жалобами на неправомерное использование ИИ, поскольку Grok манипулирует изображениями женщин и несовершеннолетних с целью создания непристойного, крайне оскорбительного или иного вредоносного контента. Согласно заявлению Комиссии по коммуникациям и мультимедиа Малайзии (MCMC), создание или передача такого вредоносного контента является преступлением в соответствии с законодательством страны. В связи с этим ведомство по надзору за СМИ проведёт расследование в отношении пользователей X, предположительно нарушивших закон, и вызовет представителей компании для получения объяснений. «Хотя в настоящее время X не является лицензированным поставщиком услуг, она обязан предотвращать распространение вредоносного контента на своей платформе», — указано в заявлении комиссии. За день до этого, в пятницу Министерство электроники и информационных технологий Индии (MeitY) направила письмо компании X с требованием провести всестороннюю проверку ИИ-чат-бота, чтобы убедиться, что он не генерирует контент, содержащий «обнажённость, сексуализацию, откровенно сексуальный или иной незаконный контент». X должна представить министерству отчёт о принятых мерах в течение 72 часов. Также компания была предупреждена о возможном судебном преследовании в соответствии с уголовным и ИТ-законодательством. Правительство Индии заявило, что может рассмотреть вопрос о регулировании социальных сетей в отношении неприемлемого контента, созданного ИИ. «Парламентский комитет рекомендовал принять жёсткий закон о регулировании социальных сетей, — сообщил министр информационных технологий Индии Ашвини Вайшнау (Ashwini Vaishnaw) в интервью CNBC-TV 18. — Мы рассматриваем его». Также в пятницу французское правительство заявило, что Grok создаёт «явно незаконный» сексуальный контент на платформе X без согласия пользователей, что потенциально является нарушением Закона Европейского союза «О цифровых услугах» (DSA). Кроме того, изображения, размещённые чат-ботом и содержащие оскорбительные материалы, явно нарушают его собственную политику допустимого использования, которая запрещает сексуализацию детей. Некоторые из созданных чат-ботом изображений были удалены. Ответ на запрос о комментарии, отправленный по электронной почте в компанию xAI, был краток: «Традиционные СМИ лгут». |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |