|

Опрос

|

реклама

Быстрый переход

Следующее поколение графических процессоров Intel Xe Next будет оптимизировано для ИИ, а не для игр

16.02.2026 [20:02],

Сергей Сурабекянц

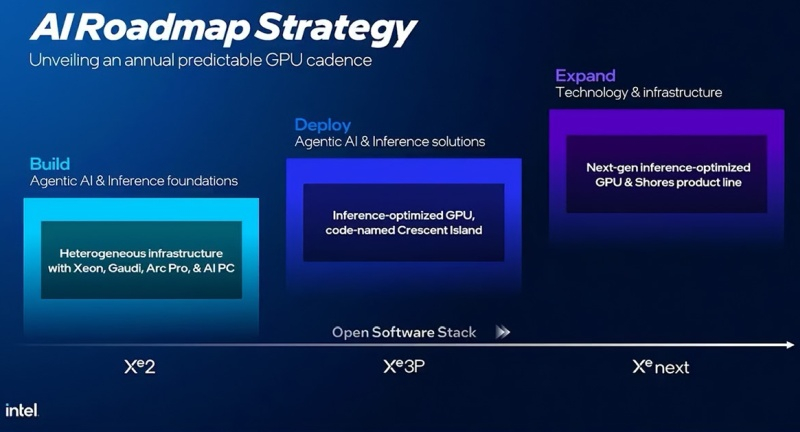

В рамках обновлённой стратегии развития компания Intel подтвердила, что планирует выпустить новые графические процессоры на архитектуре под кодовым названием Xe Next, которые появятся после поколения Xe3P. Это стало первым публичным сообщением о новой графической архитектуре Intel. Компания также заявила о своих планах перейти на «ежегодный цикл обновления графических процессоров».

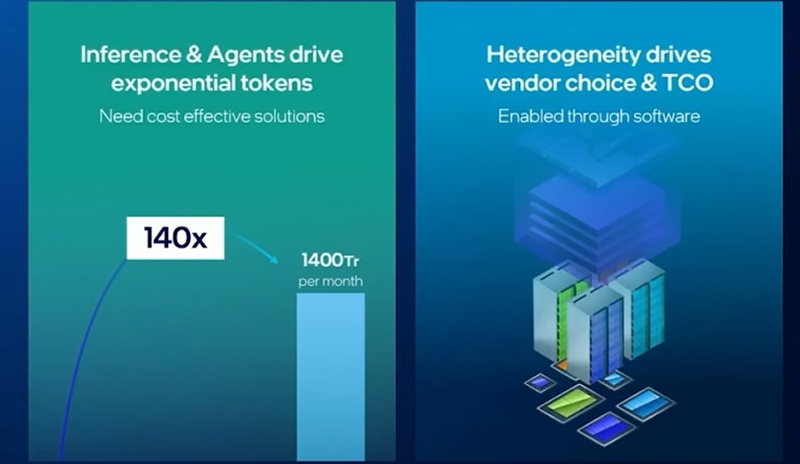

Источник изображений: Intel Самая технологически продвинутая на сегодняшний день потребительская графика Intel — это графический процессор на базе Xe3, встроенный в процессоры серии Panther Lake. Ожидается, что компания представит развитие этой архитектуры под названием Xe3P в процессорах следующего поколения — Nova Lake. Графический процессор Crescent Island — это решение на базе Xe3P, оптимизированное для выполнения задач искусственного интеллекта и обеспечения высокой производительности на ватт. Этот GPU получит 160 Гбайт памяти LPDDR5X и не предназначен для игр.  На данный момент Intel, похоже, сосредоточена на разработке новых графических решений. Однако стоит отметить, что дорожная карта компании касается ИИ, а не игр. В настоящее время неизвестно, когда Intel планирует выпустить новую дискретную видеокарту для геймеров. Intel публично заявила о своём намерении перейти на «ежегодный цикл обновления графических процессоров». Эти продукты должны поставляться как в виде дискретных ускорителей, так и в виде интегрированных в CPU графических решений.  Intel также подчеркнула важность согласованности программного и аппаратного обеспечения. По словам компании, «гетерогенная инфраструктура масштабируется только в том случае, если программный стек может идти в ногу со временем». Для управления процессорами, графическими процессорами и ИИ-ускорителями требуется открытое, адаптируемое программное обеспечение. Без него гетерогенность превращается в фрагментацию. Adobe запустила раздачу годовой подписки на Photoshop Web — россияне тоже могут её получить

25.11.2025 [17:27],

Анжелла Марина

Компания Adobe объявила о бесплатной раздаче годовой подписки на онлайновую версию графического редактора Photoshop Web. Как сообщает издание Rozetked, несмотря на то, что данное предложение официально не распространяется на пользователей из России, обойти ограничения всё равно можно.

Источник изображения: Daniel Korpai / unsplash.com Чтобы сервис при попытке активации с российского аккаунта или IP-адреса не выдавал ошибку, необходимо установить расширение Adobe Photoshop из магазина Chrome Web Store, что требует использования зарубежного IP-адреса. Подходят также браузеры на базе Chromium, такие как Edge и Brave. После установки нужно нажать кнопку Start free offer в интерфейсе расширения. Далее потребуется создать новую учётную запись Adobe ID, используя электронный адрес в домене .COM. При этом издание Rozetked не рекомендует использовать вход через Apple ID или Google Account из-за высокого риска региональной блокировки. После создания аккаунта следует нажать на баннер Start или «Начать», а затем «Начало работы». Важно, что ввод данных банковской карты не потребуется. После выполнения перечисленных действий пользователь получит полноценный доступ к Adobe Photoshop Web на 12 месяцев с расширенной функциональностью, в том числе набором инструментов на базе искусственного интеллекта, которые позволяют удалять и генерировать фоновые изображения, а также создавать новые объекты с помощью текстовых запросов. Акция, предположительно, действует до 8 декабря 2025 года. Подорожание видеокарт неотвратимо: AMD уведомила о повышении цен, потому что ИИ съел всю память

24.11.2025 [19:11],

Сергей Сурабекянц

Компания AMD уведомила своих партнёров о скором повышении цен на видеокарты «как минимум на 10 %». Резкий скачок спроса на память для растущей невероятными темпами инфраструктуры искусственного интеллекта привёл к дефициту всех типов памяти, включая память GDDR, используемую в видеокартах. AMD просто перекладывает высокую стоимость памяти на плечи потребителей.

Источник изображения: AMD «Постоянный рост цен на память привёл к значительному увеличению стоимости видеокарт. Источники в отрасли сообщают, что AMD, второй по величине производитель видеокарт, уведомил своих партнёров о втором повышении цен на всю свою линейку продукции. По оценкам, рост составит не менее 10 %», — сказано в отчёте аналитической компании UDN. Запланированное AMD повышение цен коснётся только новых моделей. Это означает, что пройдёт некоторое время, прежде чем вырастут цены на видеокарты в розничных магазинах. Эксперты полагают, что тем, кто планирует купить графический процессор, не стоит откладывать покупку в долгий ящик. Основной рост цен на графические процессоры придётся на первую половину 2026 года. Возможно, что текущие распродажи «Чёрной пятницы» могут стать последней возможностью приобрести графические процессоры по рекомендованной розничной цене (MSRP). «Самый маленький» в мире графический процессор TinyGPU v2.0, содержащий 200 тыс. транзисторов, запущен в производство

10.11.2025 [07:21],

Владимир Фетисов

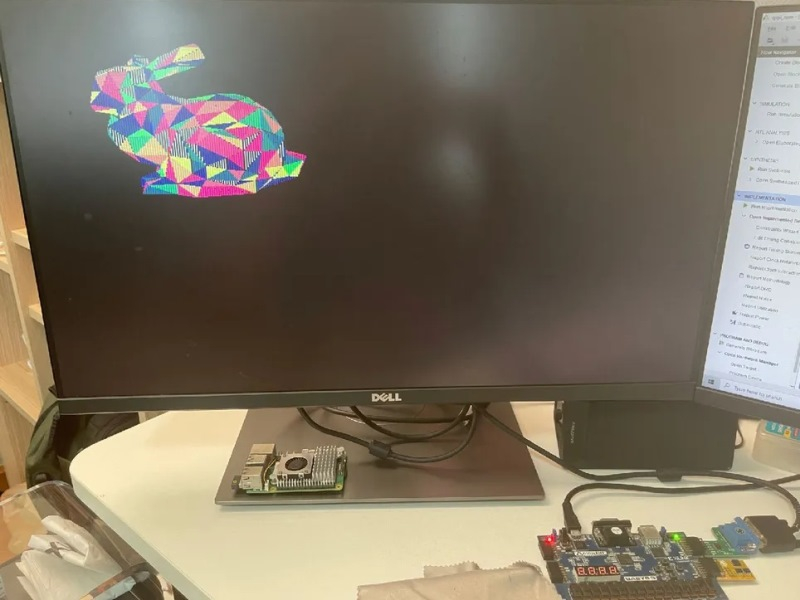

Разработчик-любитель Понсагон Вичит (Pongsagon Vichit) представил широкой публике графический процессор TinyGPU v2.0. Устройство представляет собой автономный GPU с тактовой частотой 25 МГц и возможностью вывода изображения 320 × 240 пикселей с 4-битным цветом, а также с аппаратной поддержкой обработки 3D-сцен в режиме реального времени.

Источник изображения: @MattDIYgraphics / X Возможности TinyGPU v2.0 сопоставимы с ускорителями Nvidia GeForce 256, которые были анонсированы в 1999 году. Тем не менее, TinyGPU v2.0 является самостоятельным графическим процессором с примерно 200 тыс. транзисторов. Для сравнения, флагманская видеокарта Nvidia GeForce RTX 5090 насчитывает 92,2 млрд транзисторов. Несмотря на это, основные этапы подготовки кадра у этих ускорителей происходят схожим образом, а колоссальная разница между ними заключается в масштабах и уровне производительности. Энтузиаст опубликовал в своём аккаунте в соцсети X небольшое видео, а котором показал, как происходит загрузка разных 3D-моделей из встроенной в TinyGPU v2.0 флеш-памяти. Любопытно, что для управления он задействовал геймпад от Super Nintendo. С его помощью энтузиаст преобразует модели, изменяя их размер и положение, а также изменяет местоположение источника освещения. Несмотря на то, что это существенное улучшение по сравнению с первой версией TinyGPU, которую разработчик представил примерно год назад, технические характеристики TinyGPU v2.0 не слишком впечатляют. Ускоритель работает с тактовой частотой 25 МГц и может выдавать от 7,5 до 15 кадров в секунду при рендеринге низкополигональных 3D-моделей. При этом выводится изображение с разрешением 320 × 240 пикселей с 4-битным цветом (до 16 оттенков). Хотя графика с таким разрешением и глубиной цвета прочно ассоциируется с эпохой домашних компьютеров прошлого века, в TinyGPU v2.0 задействованы значительно более современные процессы. Ускоритель выполняет интерактивное преобразование 3D-векторов в растровое изображение и использует технологию преобразования освещения, которая впервые появилась в GeForce 256. Среди других технических особенностей TinyGPU v2.0 отметим поддержку двойной буферизации с 4-битной глубиной цвета, хранение данных Z-буфера в QSPI RAM, поддержку до 1 тыс. треугольников и 1 направленного источника света в сценах с плоским затемнением. TinyGPU v2.0 стал участником проекта Tiny Tapeout для запуска производственного цикла. Проектировка дизайна видеокарты обойдётся энтузиасту примерно в $1500. Узнать больше о проекте можно на площадке Verilog, а исходные файлы и другие материалы доступны на GitHub. Samsung модернизирует ИИ-инфраструктуру разработки своих чипов с помощью 50 000 GPU компании Nvidia

02.11.2025 [06:55],

Анжелла Марина

Samsung Electronics объявила о намерении развернуть вычислительный кластер из 50 000 графических процессоров (GPU) компании Nvidia для автоматизации и оптимизации собственного производства полупроводников. Новый объект получил рабочее название AI Megafactory, сообщает CNBC.

Источник изображения: Samsung Electronics Это соглашение стало частью масштабного расширения партнёрской сети Nvidia, чьи чипы остаются ключевыми компонентами для разработки и внедрения передовых решений в области искусственного интеллекта (ИИ). Ранее, в начале недели, генеральный директор Nvidia Дженсен Хуанг (Jensen Huang) сообщил в Вашингтоне о сотрудничестве с такими компаниями, как Palantir, Eli Lilly, CrowdStrike и Uber, а вскоре после выступления он был замечен в Сеуле за неформальной встречей с председателем совета директоров Samsung Ли Чжэ Ёном (Lee Jae-yong), а также другими корейскими бизнес-лидерами. Представители Nvidia уточнили, что совместно с Samsung будет адаптирована литографическая платформа для работы с GPU Nvidia, что, по их оценкам, обеспечит двадцатикратный прирост производительности. Кроме того, Samsung намерена задействовать программное обеспечение Nvidia Omniverse и использовать GPU для запуска собственных ИИ-моделей в мобильных устройствах. Важно отметить, что Samsung выступает не только клиентом и партнёром Nvidia, но и одним из ключевых поставщиков. Компания производит высокопроизводительную память типа HBM (High Bandwidth Memory), широко применяемую в ИИ-чипах Nvidia. В рамках нового этапа сотрудничества стороны договорились совместно доработать память следующего поколения HBM4 для использования в будущих ИИ-процессорах. Партнёрство с Samsung подкрепляет заявление Хуанга о том, что текущий портфель заказов Nvidia на GPU архитектуры Blackwell и следующего поколения Rubin достиг 500 млрд долларов. Эта перспектива способствовала росту рыночной капитализации Nvidia до исторического уровня в $5 трлн. Помимо Samsung, аналогичные GPU-кластеры развёртывают южнокорейские конгломераты SK Group и Hyundai. Рэймонд Тэ (Raymond Teh), старший вице-президент Nvidia по Азиатско-Тихоокеанскому региону, заявил, что компания тесно взаимодействует с правительством Республики Корея в поддержку его амбициозных планов по лидерству в сфере ИИ. Canva запустила ИИ-модель, которая умеет редактировать слои дизайна

31.10.2025 [04:21],

Анжелла Марина

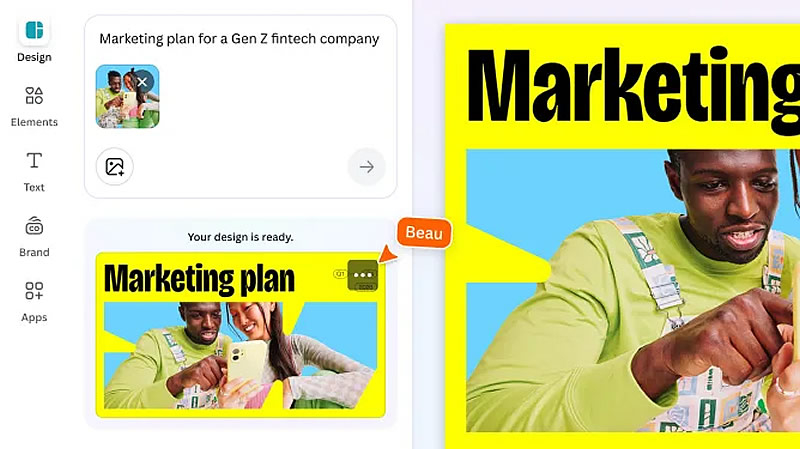

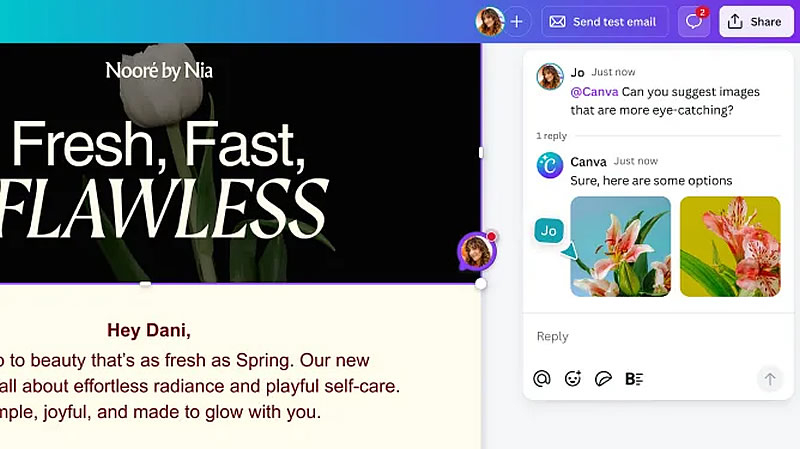

Canva представила собственную модель искусственного интеллекта (ИИ), предназначенную для генерации дизайнов с редактируемыми слоями и объектами — раньше такая возможность отсутствовала. Модель работает с различными форматами, включая посты для соцсетей, презентации и веб-сайты.

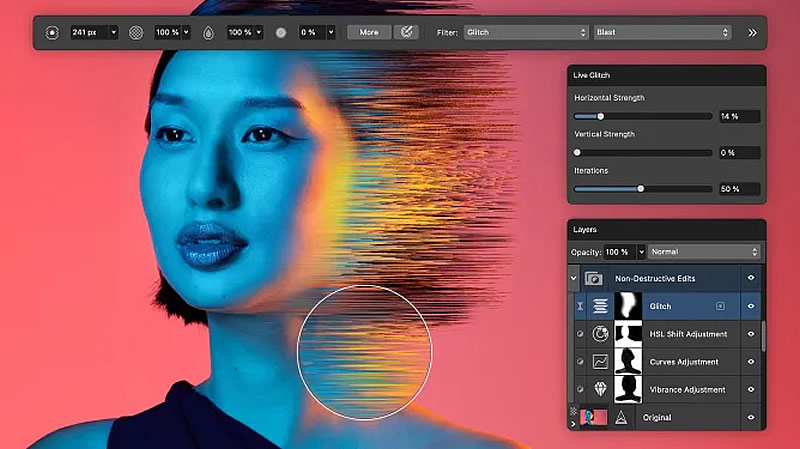

Источник изображений: Canva Как сообщает TechCrunch, ссылаясь на слова Роберта Кавальски (Robert Kawalsky), глобального руководителя по продуктам Canva, предыдущие подходы позволяли создавать лишь статичные изображения, однако пользователям важна не только простая ИИ-генерация по промпту, но и возможность напрямую вносить правки в предложенный искусственным интеллектом результат.  Ранее Canva запустила ИИ-ассистента Magic Studio с интерфейсом чат-бота для создания медиаконтента по запросам. Теперь этот ассистент доступен на всех экранах платформы, включая вкладки «Дизайн» и «Элементы», а пользователи смогут генерировать трёхмерные объекты и копировать существующие художественные стили. Также был объединён инструмент для работы с электронными таблицами и функция, позволяющая создавать мини-приложения с помощью подсказок. Теперь пользователи могут использовать данные, хранящиеся в электронных таблицах, и создавать на их основе небольшие приложения. Помимо новых ИИ-возможностей, Canva анонсировала такие новые функции, как создание форм для сбора данных от клиентов (альтернатива Google Forms), а также инструменты для подготовки email-рассылок, например, маркетинговых писем и уведомлений о доставке с сохранением фирменного стиля бренда компании.  Также объявлено, что профессиональный графический редактор Affinity, который компания ранее приобрела с целью конкуренции с Adobe, теперь навсегда станет бесплатным для всех пользователей. Кроме того, интерфейс Affinity был переработан для объединения векторной, пиксельной и вёрсточной сред в единую рабочую область, а также тесно интегрирован с основной платформой Canva. Это означает, что дизайнеры смогут создавать объекты в Affinity и переносить их в Canva, а также использовать ИИ-генерацию изображений непосредственно внутри Affinity.  Кроме того, после приобретения компании MagicBrief, специализирующейся на аналитике рекламы, Canva запустила полноценную маркетинговую платформу Canva Grow, которая объединяет ИИ-генерацию контента и анализирует его эффективность, а также позволяет публиковать рекламу напрямую на таких площадках, как Meta✴✴. Adobe представила новые ИИ-инструменты для Photoshop и Premiere Pro

29.10.2025 [05:38],

Анжелла Марина

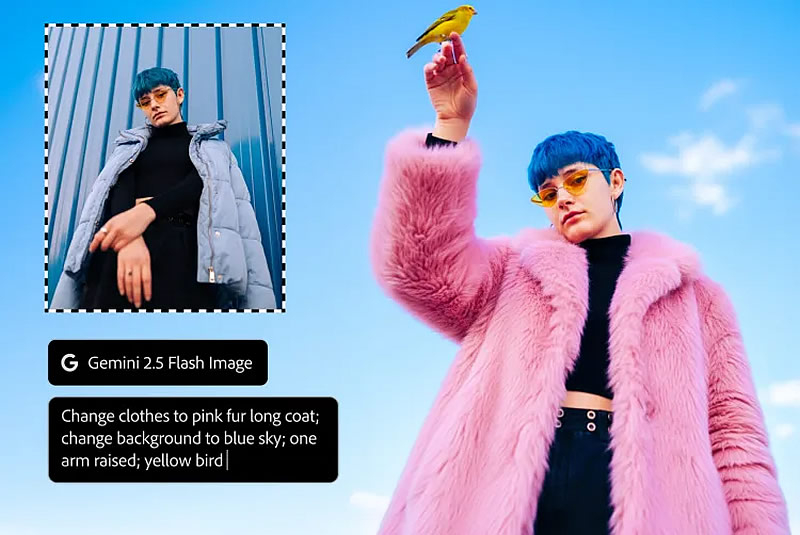

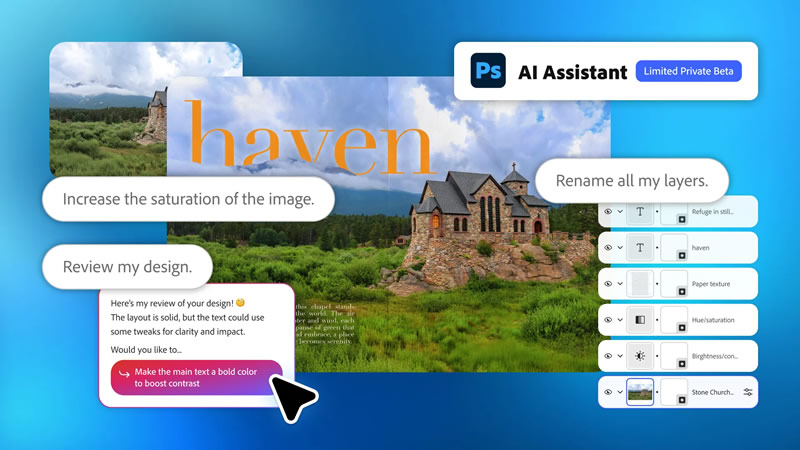

Компания Adobe на ежегодной конференции Max представила новые инструменты искусственного интеллекта (ИИ) для приложений Creative Cloud, включая Photoshop, Premiere Pro и Lightroom. Обновления направлены на автоматизацию трудоёмких задач редактирования изображений и видео, включая расширенные функции генеративной заливки (Generative Fill), интеграцию сторонних ИИ-моделей и новые возможности работы с объектами в видеороликах.

Источник изображений: Adobe В частности, в Photoshop теперь можно использовать в инструменте Generative Fill не только собственную модель Adobe Firefly, но и сторонние ИИ-модели, например, Gemini 2.5 Flash компании Google и Flux.1 Kontext компании Black Forest Labs. После выбора изображения и ввода текстового запроса, например, на добавление или замену объекта, редактор может переключаться между моделями для получения разнообразных результатов.  Кроме того, в веб-версии Photoshop в закрытом бета-тестировании представлен ИИ-помощник в виде чат-бота, которому можно давать текстовые промпты, например, «увеличить насыщенность», после чего программа автоматически применит эффект. Аналогичная функция будет запущена в публичной бете для Adobe Express. Для Lightroom анонсирована бета-функция «Умный отбор» (Assisted Culling), которая способна анализировать масштабные коллекции снимков, фильтруя их по резкости, ракурсу и фокусу, а затем рекомендовать лучшие кадры для последующего редактирования. Лежащая в основе этих инструментов модель генерации изображений Firefly также была обновлена. Как заявили в Adobe, новая модель Firefly Image 5 способна генерировать изображения в нативном разрешении 4 мегапикселя без необходимости повышения разрешения и была оптимизирована для более реалистичного отображения людей. Эта модель также понимает текстовые инструкции и внедрена в инструмент редактирования Layered Image Editing для Photoshop. Для видеомонтажа в программе Premiere Pro появился инструмент «ИИ-маска объекта» (AI Object Mask), который доступен в публичной бете. Он автоматически выделяет людей и объекты в кадрах видео, упрощая такие задачи, как цветокоррекция, размытие фона и добавление визуальных эффектов для движущихся объектов, избавляя от необходимости кропотливого ручного выделения с помощью пера. Intel представила Crescent Island — GPU для ИИ на архитектуре Xe3P и со 160 Гбайт LPDDR5X

14.10.2025 [21:52],

Николай Хижняк

Компания Intel анонсировала новый графический процессор, предназначенный для центров обработки данных, разработанный специально для выполнения задач логического вывода (ИИ). Новинка имеет кодовое название Crescent Island и построена на базе архитектуры Xe3P.

Источник изображений: Intel Графический процессор Crescent Island основан на архитектуре Xe3P. Она представляет собой усовершенствованную версию графической архитектуры Xe3, анонсированной в составе процессоров Panther Lake для ноутбуков и компактных ПК. В перспективе Xe3P будет также использоваться в семействе потребительских видеокарт Arc следующего поколения — Arc C-Series. Новый графический процессор для ЦОД под кодовым названием Crescent Island разработан с учётом оптимизации энергопотребления и стоимости для корпоративных серверов с воздушным охлаждением, а также с акцентом на большой объём памяти и пропускную способность, оптимизированные для рабочих процессов вывода. Ключевые особенности Crescent Island:

Примечательно, что Intel выбрала память LPDDR5X для своего специализированного GPU. Конкуренты в лице Nvidia и AMD предлагают свои решения для ИИ-центров обработки данных с использованием высокоскоростной памяти HBM (например, HBM3E) и уже обсуждают применение ещё более производительной памяти HBM4 для решений будущих поколений, таких как Rubin и MI400. На фоне возросшего спроса и, как следствие, роста цен на память HBM использование LPDDR5X может предоставить решению Intel значительное преимущество в соотношении цены и производительности. Кроме того, поддержка широкого спектра типов данных делает архитектуру универсальной для различных задач, связанных с ИИ. Intel отмечает, что открытый и унифицированный программный стек для Crescent Island разрабатывается и тестируется на графических процессорах Arc Pro серии B для обеспечения ранней оптимизации и итераций. Ожидается, что образцы нового графического процессора для центров обработки данных под кодовым названием Crescent Island будут представлены клиентам во второй половине 2026 года. AMD и Sony рассказали о технологиях будущих видеокарт и консолей PlayStation: нейронные массивы, ядра Radiance и сжатие данных

09.10.2025 [22:01],

Сергей Сурабекянц

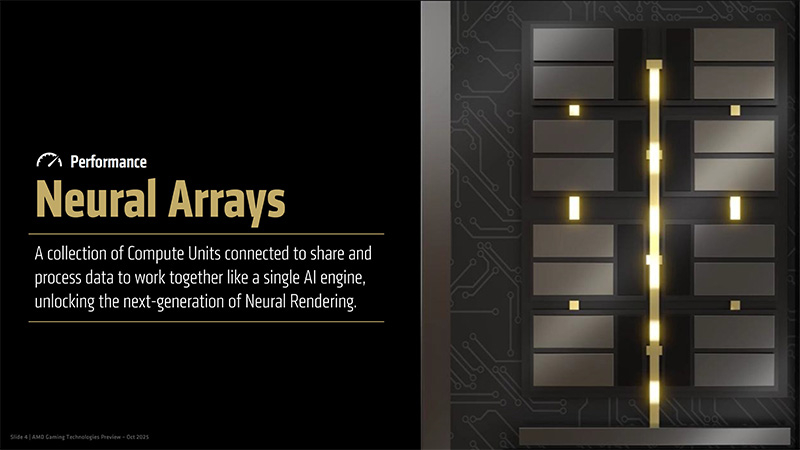

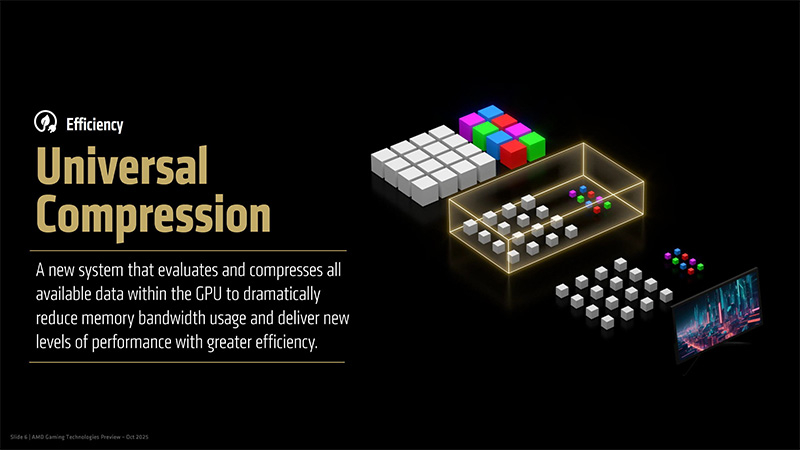

Партнёрство Sony и AMD в рамках проекта Amethyst продолжается уже почти год. Сегодня ведущий архитектор PS5 и PS5 Pro Марк Черни (Mark Cerny) и старший вице-президент и генеральный менеджер подразделения вычислений и графики AMD Джек Хён (Jack Huynh) подробно рассказали о технологических прорывах, достигнутых в результате этого партнёрства, таких как нейронные массивы, ядра Radiance и универсальное сжатие. Полное видео их совместного отчёта опубликовано на YouTube.

Источник изображения: Sony Черни и Хён рассказали, как конструкция современных графических процессоров может создавать узкие места. «Сложность заключается в том, как мы реализуем эти системы, — отметил Черни. — Нейронные сети, используемые в таких технологиях, как FSR и PSSR, невероятно требовательны к графическому процессору. Они требуют больших вычислительных мощностей и быстрого доступа к большим объёмам памяти. Природа графического процессора здесь нам в помощь». Для решения этой проблемы разработчики проекта Amethyst предложили технологию «нейронных массивов» (Neural Arrays). Основная идея заключается в объединении вычислительных блоков для совместного решения крупных задач. «Мы не объединяем весь графический процессор в один мегаблок, — пояснил Хён. — Но мы подключаем [вычислительные блоки] внутри каждого шейдерного движка разумным и эффективным способом. И это меняет правила игры в нейронном рендеринге. Более крупные модели [машинного обучения], меньшие накладные расходы, большая эффективность и гораздо большая масштабируемость по мере роста рабочих нагрузок».  Хён рассказал о роли машинного обучения в современной разработке игр, которое предлагает разработчикам более эффективные способы визуализации, сохраняя при этом технологический потенциал, необходимый для создания масштабных миров. Черни отметил, что концепция нейронных массивов станет переломным моментом для разработчиков, особенно при работе апскейлеров вроде FSR и PSSR или шумоподавлении нового поколения. Хён подчеркнул, что эффективность нейронных массивов откроет совершенно новые возможности для машинного обучения. Ещё одним предметом исследования в рамках проекта Amethyst стала трассировка лучей. По мнению Черни, текущие версии трассировки лучей достигали пределов возможностей современного оборудования. Чтобы решить эту проблему, AMD и Sony попытались переосмыслить весь конвейер трассировки пути, как в плане аппаратного, так и программного обеспечения. «Ранее в этом году на выставке Computex мы представили Neural Radiance Caching, ключевой элемент FSR Redstone, — пояснил Хён. — Теперь мы развиваем эту технологию с помощью Radiance Cores — нового специализированного аппаратного блока, предназначенного для унифицированной передачи света. Он обрабатывает трассировку лучей и пути в реальном времени, выводя производительность освещения на совершенно новый уровень. Вместе они формируют совершенно новый подход AMD к рендерингу».  Ядра Radiance берут на себя все технические задачи, связанные с трассировкой лучей, которые обычно выполняют вычислительные блоки, а также управление шейдерным программным обеспечением. Это освобождает вычислительные блоки для решения других задач, в то время как ядра Radiance могут сосредоточиться на трассировке пути, трассировке лучей и обходе лучей, что, как правило, требует значительных вычислительных ресурсов. В завершении беседы Черни и Хён коснулись ограничений, которые накладывает на современные графические процессоры пропускная способность памяти. Разработанная проектом Amethyst функция, получившая название Universal Compression («универсальное сжатие»), анализирует каждый фрагмент данных, направляемый в память, и сжимает его, когда это возможно. Это позволяет снизить нагрузку на шину памяти, что, по словам Хёна, означает, что «процессор может обеспечивать большую детализацию, более высокую частоту кадров и большую эффективность».  Разработчики уверены, что эта новая технология позволит графическим процессорам превзойти заявленные характеристики пропускной способности памяти благодаря высокой эффективности применяемого метода сжатия. «Это даёт множество преимуществ, включая более низкое энергопотребление, более высокое качество графики и, пожалуй, самое главное, синергию Universal Compression с нейронными массивами и ядрами Radiance, поскольку мы работаем над тем, чтобы предоставить геймерам наилучший игровой опыт», — пояснил Черни. Все представленные проектом Amethyst технологии пока существуют только в виде симуляции. Однако результаты партнёрства Sony и AMD, по-видимому, оказались весьма многообещающими, так как Черни пообещал применить их в будущих поколениях консолей. Хён добавил, что ожидает появление этих технологий и на других игровых платформах. Линейка графических планшетов Wacom One пополнилась 14-дюймовой моделью

17.09.2025 [16:36],

Анжелла Марина

Компания Wacom представила графический планшет с дисплеем Wacom One 14 начального уровня, предназначеный для студентов и любителей цифрового творчества. Новая модель немного больше, чем планшеты с сенсорным экраном One 12 и One 13, выпущенные Wacom в 2023 году, однако при этом сохраняет компактность и лёгкость, и может поместиться в сумке.

Источник изображения: Wacom В комплект поставки Wacom One 14 входят беспроводной стилус Wacom One Standard Pen без батареи и кабель USB-C, чего не было у младшей версии. Планшет оснащён IPS-дисплеем с разрешением 1920 × 1080 пикселей, однако не поддерживает технологию 10-пальцевого мультитача, что, как пишет The Verge, является сознательным упрощением, направленным на снижение стоимости. Рамки вокруг дисплея, по сравнению с предыдущими моделями стали более узкими, а сам планшет более тонким, хотя в остальном его дизайн схож с One 12 и One 13. Планшет может подключаться к устройствам под управлением Windows, Mac и Chrome OS. Новинка уже поступила в продажу по цене $299,95 (около 19 120 рублей). Эта цена значительно ниже стартовой стоимости в $400 для модели Wacom One 12, которая к настоящему моменту снизилась до $210 на сайте компании. Мобильная графика Arm станет производительнее — в GPU встроят нейронные ускорители

12.08.2025 [17:58],

Сергей Сурабекянц

Arm сообщила, что следующее поколение её мобильных графических процессоров, которое выйдет в 2026 году, будет использовать нейронные технологии, обеспечивающие более высокое качество изображения и повышенную производительность. Компания также представила программный интерфейс (API) для разработчиков, чтобы они могли начать работу с ним уже сегодня, не дожидаясь появления нового оборудования.

Источник изображений: Arm В первую очередь Arm рассматривает использование нейронного ускорения для масштабирования графики до более высокого разрешения без ущерба для производительности. Среди других предполагаемых сценариев — удвоение частоты кадров с помощью интерполяции и повышение качества изображения за счёт трассировки пути в реальном времени на мобильных устройствах с меньшим количеством лучей на пиксель. «Поскольку ИИ всё больше сливается с графикой реального времени, нам необходим ИИ на базе графических процессоров, который был бы интегрированным, производительным и, что особенно важно, энергоэффективным. Упрощение разработки ИИ на графических процессорах для разработчиков стало движущей силой технических инноваций, о которых мы здесь говорим», — заявил научный сотрудник Arm в области ИИ и платформ для разработчиков Герайнт Норт (Geraint North). Arm отказалась раскрывать подробную техническую информацию о нейронных ускорителях до анонса следующего поколения графических процессоров Mali. Известно лишь, что они будут размещаться в шейдерных ядрах, а производительность нейросетей будет масштабироваться в зависимости от их количества в конкретной реализации GPU. Архитектура Arm пятого поколения предусматривает конфигурации вплоть до 16 ядер. В прошлом году Arm анонсировала технологию масштабирования Arm Accuracy Super Resolution (Arm ASR), позволяющую игре рендерить изображение с более низким разрешением и применять алгоритм масштабирования, снижая затраты на обработку кадра при сохранении качества. Новая технология Neural Super Sampling (NSS) на базе аппаратного нейронного ускорителя способна масштабировать картинку с 540p до 1080p за 4 мс на кадр и снижать нагрузку на графический процессор на 50 %.  «Рендеринг в реальном времени с использованием искусственного интеллекта быстрее, чётче и энергоэффективнее. Таким образом, NSS может создавать выходные данные того же качества с использованием входных данных более низкого качества или даже более высокого качества с теми же входными данными», — заявил Норт. Arm также представила технологии Neural Frame Rate Upscaling (NFRU) и Neural Super Sampling and Denoising (NSSD). NFRU повышает частоту кадров путём создания промежуточного кадра из двух последовательных кадров. «Нейронная сеть также тесно связана с новым оборудованием, которое мы добавим к нашим графическим процессорам для ускорения генерации векторов движения, отслеживающих перемещение пикселей между кадрами. Это позволит очень дёшево масштабировать контент, работающий с частотой 30 кадров в секунду, до 60 кадров в секунду», — пояснил Норт. Технология NSSD предназначена для обеспечения качества изображения трассировки пути, которая, по словам Норта, слишком затратна с точки зрения вычислительных ресурсов даже на настольных системах: «Когда вы объединяете трассировку пути с нейронной сетью, вы фактически можете проецировать лишь небольшое количество лучей на пиксель в сцену, и вы можете использовать нейронную технологию для добавления недостающих деталей. Таким образом, нейронная сеть может экстраполировать данные не только из соседних пикселей, но и из предыдущих кадров». Все эти новшества доступны разработчикам уже сегодня благодаря набору инструментов для разработки нейронной графики. В комплект входят плагины для Unreal Engine, позволяющие интегрировать нейронный суперсэмплинг в игру «всего за несколько кликов». Модели доступны в открытых форматах на GitHub и Hugging Face. Также доступна полная эмуляция расширений Arm ML Vulkan для ПК, что позволяет программистам использовать весь стек приложений, не дожидаясь выпуска мобильных чипов.  Arm — не первая компания, внедряющая нейронные технологии в чипы смартфонов. В частности, ИИ уже широко используется для управления функциями камеры. Компания Qualcomm, лицензиат Arm, расширяет возможности искусственного интеллекта своих смартфонных платформ благодаря нейронным процессорам (NPU). На прошлогодней выставке MWC компания Qualcomm продемонстрировала большую языковую модель с 7 млрд параметров, работающую на Android-смартфоне, и представила свой AI Hub для разработчиков. Wacom выпустила 11-дюймовый графический планшет MovinkPad на Android — для творчества на ходу

17.07.2025 [13:25],

Николай Хижняк

Компания Wacom выпустила 11,45-дюймовый графический Android-планшет MovinkPad (DTHA116CL0Z) для художников. Новинку оценили в $449,95. Устройство оснащено цветным IPS-экраном с разрешением 2200 × 1440 пикселей, частотой обновления 90 Гц, контрастностью 1200:1, яркостью 400 кд/м², 99-процентным охватом цветового пространства и поддержкой 10-точечного сенсорного ввода. Для удобства глаз экран устройства оснащён антибликовым покрытием и защитой от отпечатков пальцев.

Источник изображения: Wacom MovinkPad поставляется с электронным пером Wacom Pro Pen 3 с поддержкой 8192 уровней нажатия, разрешением 5080 линий на дюйм и углом наклона 60 градусов. В нём используется разработанная компанией технология электромагнитного резонанса, которая исключает необходимость зарядки или использования батареек. Для пера можно приобрести различные дополнительные наконечники, которые изменяют ощущения от взаимодействия с экраном. Wacom также предлагает и другие электронные перья, совместимые с MovinkPad. В основе MovinkPad используется процессор MediaTek Helio G99. Устройство работает под управлением Android 14, оснащено 8 Гбайт оперативной и 128 Гбайт постоянной памяти, поддерживает Bluetooth 5.2 и Wi-Fi 802.11ac. Пользовательский интерфейс Wacom UX предоставляет быстрый доступ к Wacom Canvas — виртуальному альбому для рисования, помогающему художникам запечатлевать спонтанные творческие идеи. В комплект также входит двухлетняя лицензия на Clip Studio Paint Debut. Художники получают доступ ко всем своим работам через Wacom Shelf, где отображаются файлы, хранящиеся на устройстве, в форматах BMP, CLIP, HEIC, JPEG, PNG, TIFF и WebP. Размеры графического планшета Wacom MovinkPad составляют 266 × 182 × 7 мм, вес — 588 граммов. Устройство оснащено фронтальной камерой на 5 Мп и задней камерой на 4,7 Мп, двумя микрофонами, стереодинамиками, цифровым компасом, акселерометром, а также датчиком внешнего освещения. Планшет работает от аккумулятора ёмкостью 7700 мА·ч. Подзарядка осуществляется через разъём USB-C. Asus случайно выпустила «гибрид» Radeon и GeForce

25.06.2025 [19:36],

Сергей Сурабекянц

Ошибка сотрудников предприятия Asus привела к созданию уникальной игровой видеокарты TUF Radeon RX 9070 XT, на которой одновременно размещены логотипы AMD Radeon и Nvidia GeForce RTX. Пока известно лишь об одном столь необычном графическом ускорителе. Однако, возможно, другие устройства из этой партии могут иметь такую же необычную маркировку. Появление столь необычного ускорителя связано с тем, что Asus использует один и тот же дизайн кожуха для нескольких моделей видеокарт. Кожух с логотипом GeForce был случайно установлен на AMD Radeon RX 9070 XT. Теоретически та же ошибка может произойти и в обратном порядке, создав графический ускоритель серии RTX 50 под брендом Radeon. «Кто-то должен проверить рабочих на сборочной линии Asus и убедиться, что они чувствуют себя хорошо... […] у меня были проблемы с моей новой картой Asus TUF 9070 XT OC. Я обратился в магазин, чтобы обменять её, а дома распаковал и получил это. Такое нарочно не придумаешь. Теперь дилемма: оставить карту и получить абсолютный мем или обменять её снова» — написал в социальной сети Reddit пользователь Fantastic-Ad8410, который и стал обладателем уникального ускорителя. Мнения комментаторов этого сообщения разделились. Некоторые полагают, что у владельца могут возникнуть проблемы при попытке продать устройство, так как потенциальные покупатели решат, что это подделка. Другие, наоборот, уверены, что ценность столь уникального «гибридного» графического ускорителя будет только расти и он заинтересует коллекционеров. Появляются также неподтверждённые сообщения о том, что это не первый подобный случай. Вряд ли у владельца возникнут проблемы, если он решит заменить этот необычный графический ускоритель. Тем не менее, будет жаль, если эту единственную в своём роде видеокарту вернут производителю для «ремонта». В конце концов, много ли на свете владельцев видеокарты GeForce RTX 9070 XT? Выяснилось, что Intel замедлила свои GPU на 20 % ради безопасности — в Linux уже придумали, как это исправить

23.06.2025 [21:23],

Сергей Сурабекянц

Компания Canonical, разработчик популярного дистрибутива Ubuntu, совместно с Intel планирует отключить ряд защитных механизмов в драйверах для графических решений Intel. Эти изменения коснутся исключительно GPU-вычислений, выполняемых через API OpenCL и Level Zero. По словам разработчиков, эти изменения позволят увеличить вычислительную производительность графической подсистемы примерно на 20 %.  Хотя патчам безопасности Intel по части графики уделяется заметно меньше внимания, чем аналогичным механизмам на стороне центрального процессора, их влияние на производительность оказалось значительно выше, чем предполагалось ранее. По данным из баг-трекера Ubuntu Launchpad, на которые ссылается Phoronix, отключение защитных функций может дать пользователям прибавку до 20 % при работе с задачами, использующими вычисления на GPU. Такой прирост стал возможен за счёт использования опции компиляции NEO_DISABLE_MITIGATIONS, которая отключает встроенные в Intel Compute Runtime защитные механизмы, связанные, в частности, с уязвимостью Spectre. Canonical намерена активировать эту опцию по умолчанию в Ubuntu, начиная с версии 25.10. При этом уточняется, что это изменение коснётся исключительно пакетов Compute Runtime и никак не затронет защитные механизмы ядра Linux или других компонентов операционной системы. Представители Intel и Canonical уже согласовали данные изменения и подтвердили, что потенциальные риски от отключения этих мер безопасности минимальны. Intel даже распространяет свои собственные пакеты Compute Runtime для OpenCL и Level Zero на платформе GitHub уже без включённых защитных механизмов. Согласно официальной позиции обеих компаний, уязвимости типа Spectre для GPU уже достаточно хорошо нейтрализованы на уровне ядра Linux, поэтому повторное применение мер защиты на уровне Compute Runtime нецелесообразно и не даёт ощутимого повышения безопасности. Однако разработчики предупреждают, что теоретически отключение мер защиты может открыть ранее неизвестные векторы атак или выявить скрытые ошибки, которые до этого устранялись существующими мерами безопасности. Несмотря на это, обе компании считают, что риски оправданы заметным приростом производительности, особенно с учётом отсутствия реальных примеров эксплуатации подобных уязвимостей. В настоящее время разработчики Ubuntu активно тестируют изменения с использованием специального PPA-репозитория Launchpad, где уже представлены сборки с отключёнными защитными механизмами. Ожидается, что все изменения будут окончательно внедрены в релиз Ubuntu 25.10. Wacom представила графические планшеты Cintiq 16, Cintiq 24 и Cintiq 24 Touch по цене от $700

05.06.2025 [11:25],

Владимир Мироненко

Wacom представила новые графические планшеты Cintiq 16, Cintiq 24 и Cintiq 24 Touch с поддержкой цифрового пера Wacom Pro Pen 3. Новинки отличаются более тонким корпусом по сравнению с предшественниками, а также более узкими рамками и меньшим весом.

Источник изображений: Wacom Планшет Cintiq 16 оснащён 16-дюймовым экраном с разрешением 2,5K (2560 × 1600 пикселей) и частотой обновления 60 Гц. Модели Cintiq 24 и Cintiq 24 Touch получили 23,8-дюймовый экран с разрешением 2560 × 1440 пикселей и той же частотой обновления. У модели Cintiq 24 Touch сенсорный экран, что позволяет масштабировать, вращать изображение и выполнять другие действия с помощью пальцев. Как утверждает Wacom, дисплеи обеспечивают отображение «реалистичных цветов», а антибликовое стекло служит не только для устранения отражений, но и для обеспечения достаточного трения для стилуса. Это, как сообщается, создаёт «естественные ощущения от рисования, похожие на рисование на бумаге» при использовании флагманского стилуса Wacom Pro Pen 3. Новинки отличаются от предшественников более тонким корпусом. Например, Cintiq 24 почти вдвое тоньше предыдущей 22-дюймовой модели: толщина его корпуса составляет 21 мм. Безвентиляторная конструкция обеспечивает бесшумную работу устройств.  Цифровое перо Wacom Pro Pen 3 третьего поколения имеет время отклика 12 мс, поддерживает 8192 уровня нажатия и угол наклона до 60 градусов. Устройство оснащено тремя программируемыми кнопками. К нему предлагается дополнительный аксессуар Wacom Pro Pen 3 Wood Grip с текстурированной отделкой, обеспечивающей более естественные ощущения в руке при рисовании. Модели Cintiq 24 и Cintiq 24 Touch поставляются с регулируемой подставкой Wacom, которая обеспечивает плавную регулировку угла наклона. Модель Cintiq 16 комплектуется складными ножками и совместима с дополнительной подставкой, приобретаемой отдельно. Все модели поддерживают крепление VESA (75 × 75 мм) для использования с кронштейнами мониторов сторонних производителей. Коммуникационные возможности планшетов включают порты USB-C, HDMI и USB-A. Новая серия Wacom Cintiq поступит в продажу этим летом. Цена планшета Cintiq 16 составит $699,95, Cintiq 24 — $1299,95, Cintiq 24 Touch — $1499,95. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |