|

Опрос

|

реклама

Быстрый переход

Google Gemini научился генерировать 30-секундные музыкальные треки по описанию и картинкам

19.02.2026 [06:55],

Алексей Разин

Бета-доступ к модели Lyria 3 входящей в состав Google лаборатории DeepMind позволил пользователям чат-бота Gemini создавать короткие 30-секундные музыкальные композиции на основе текстовых описаний, изображений и видеороликов, при этом даже не нужно покидать интерфейс чат-бота.

Источник изображения: Nvidia С этой недели доступ к данному инструменту генерирования музыки получили пользователи Google по всему миру, на первом этапе поддерживаются запросы и результаты на английском, немецком, испанском, французском, японском, корейском и португальском языках, а также хинди. Запросы в этом сервисе могут упоминать как конкретные музыкальные стили, так и эмоциональный настрой, либо какие-то типичные жизненные ситуации. Сервис позволяет генерировать как инструментальные композиции, так и произведения с вокалом на текст, предложенный пользователем. Для более точного результата с точки зрения формируемого настроения пользователь может прилагать к текстовому запросу фотографии или видеоролики. Google подчёркивает, что подобный инструмент не направлен на создание музыкальных шедевров, а в большей мере ориентирован на развлечение и самовыражение пользователей. Для более удобного распространения созданных 30-секундных музыкальных композиций Google будет снабжать их обложками, сгенерированными при помощи Nano Banana. Эти композиции также можно будет использовать совместно с инструментом Dream Track, который позволяет сопровождать публикуемые в YouTube короткие видеоролики музыкой независимых авторов. Учитывая предыдущий опыт внедрения средств генерирования музыки при помощи ИИ, компания Google в модели Lyria 3 предусмотрела механизмы защиты от слепого копирования произведений конкретных авторов и голосов определённых исполнителей. Lyria существует с 2023 года, но доступ к ней был ограничен облачной платформой Google Vertex. Интеграция подобных возможностей в Google Gemini делает инструмент для генерирования музыки более доступным, но в этой сфере компания отстаёт по графику от многих конкурентов типа TikTok и Microsoft. Alibaba, ByteDance и Kuaishou представили ряд новых ИИ-моделей — от роботов до киношного видео

16.02.2026 [09:10],

Владимир Фетисов

В то время как ИИ-рынок США на прошедшей неделе был занят изучением влияния инструментов Anthropic и Altruist на сферы программирования и оказания финансовых услуг, китайские IT-гиганты запустили ИИ-модели, показавшие прирост производительности в робототехнике и генерации видео. Alibaba, ByteDance (владелец TikTok) и платформа коротких видео Kuaishou представили новые алгоритмы, подтверждающие, что китайские разработчики не отстают от американских коллег.

Источник изображения: Gemini Анонс новых алгоритмов китайских IT-гигантов произошёл на фоне недавнего заявления главы ИИ-подразделения Google DeepMind Демиса Хассабиса (Demis Hassabis) касательно того, что китайские ИИ-модели отстают от западных конкурентов всего на несколько месяцев. Однако представленные на прошедшей неделе инструменты вполне могут рассматриваться в качестве прямых конкурентов ИИ-моделям для генерации видео, таким как Sora от OpenAI, а также моделям для сферы робототехники от Nvidia и Google. Исследовательское подразделение Alibaba DAMO анонсировало RynnBrain — ИИ-модель, предназначенную для того, чтобы помочь роботам понимать окружающий их физический мир и идентифицировать объекты. В демонстрационном ролике Alibaba показала робота с клешнями вместо рук, который собирал апельсины и складывал их в корзину. Там также показали, как робот достаёт молоко из холодильника. ИИ-модели требуют обширного обучения для достижения цели по идентификации повседневных объектов и взаимодействия с ними. Это означает, что такой простой для человека процесс, как сбор фруктов, для робототехники является гораздо более сложным. С запуском RynnBrain Alibaba начнёт конкурировать с такими компаниями, как Nvidia и Google, которые ведут разработку собственных ИИ-моделей для сферы робототехники. «Одним из её [ИИ-модели] ключевых новшеств является встроенное осознание времени и пространства. Вместо того, чтобы просто реагировать на непосредственные сигналы, робот может запоминать, когда и где происходили события, отслеживать прогресс выполнения задачи и продолжать действовать на протяжении нескольких этапов. Это делает его более надёжным и последовательным в сложных реальных условиях», — считает исследователь из Hugging Face Адина Якефу (Adina Yakefu). Она также добавила, что «более масштабная цель» Alibaba состоит в том, чтобы «создать базовый интеллектуальный уровень для воплощённых систем». Компания ByteDance на минувшей неделе представила Seedance 2.0 — модель искусственного интеллекта для генерации видео, которая может создавать реалистичные ролики на основе простого текстового описания. При этом алгоритм также может работать с другими видео и изображениями. Демонстрационные видео, созданные с помощью Seedance 2.0, выглядят вполне реалистично.

Источник изображения: Sony Адина Якефу подтвердила, что ИИ-модель Seedance 2.0 показала значительный прогресс по сравнению с предыдущими версиями в плане «управляемости, скорости и эффективности работы». «На сегодняшний день Seedance 2.0 — одна из самых сбалансированных моделей для генерации видео, которые я тестировала. Она удивила меня, выдав удовлетворительные результаты с первой попытки, даже обрабатывая простой запрос. Визуализация, звуковое сопровождение и операторская работа объединяются таким образом, что результат работы кажется отточенным, а не экспериментальным», — добавила Якефу. Хоть пользователи и хвалят этот алгоритм, известно, что у Seedance 2.0 возникли проблемы. Китайские СМИ сообщили, что разработчики временно заблокировали функцию генерации голоса человека на основе загруженного фото. Это произошло после того, как один из местных блогеров обратил внимание на проблему генерации голоса по фото без согласия того, кто изображен на снимке. Представители ByteDance пока никак не комментируют данный вопрос. Ещё одной новинкой стала ИИ-модель Kling 3.0 от Kuaishou, которая предназначена для генерации видео и является конкурентом алгоритма ByteDance. В сообщении сказано, что Kling 3.0 «отличается существенными улучшениями в согласованности, фотореалистичности результата работы, увеличенным временем продолжительности видео до 15 секунд и встроенной генерацией аудио на нескольких языках, диалектах и с разными акцентами». В настоящее время алгоритм Kling 3.0 доступен только платным подписчикам, но вскоре Kuaishou обещает открыть его для более широкой аудитории пользователей. Успех компании с ИИ-моделями Kling способствовал росту стоимости акций Kuaishou более чем на 50 % за последний год. Стоит упомянуть некоторые другие важные релизы. Компания Zhipu AI, которая работает в Гонконге под названием Knowledge Atlas Technology, представила алгоритм GLM-5 — открытую языковую модель с расширенными возможностями в области программирования и создания ИИ-агентов. Компания заявила, что последняя версия её ИИ-модели приближается к Anthropic Claude Opus 4.5 по показателям в профильных бенчмарках, а также превосходит Google Gemini 3 Pro в некоторых тестах. Этот релиз способствовал значительному рост курса акций Zhipu AI. Стоимость ценных бумаг MiniMax также подскочила в конце недели после того, как компания запустила обновлённую версию открытой ИИ-модели M2.5 с улучшенными инструментами ИИ-агентов. Этот алгоритм может использоваться для эффективной автоматизации выполнения разных задач. OpenAI обвинила китайскую DeepSeek в краже данных для обучения ИИ-модели R1

13.02.2026 [12:11],

Алексей Разин

Агентство Bloomberg со ссылкой на служебную записку OpenAI сообщает, что создатели ChatGPT обвинили китайскую DeepSeek в использовании ухищрений, позволяющих добывать информацию американских ИИ-моделей для обучения китайского чат-бота R1 следующего поколения. Соответствующий доклад был направлен американским парламентариям, по данным источника.

Источник изображения: Unsplash, Solen Feyissa По мнению представителей OpenAI, китайский конкурент использовал метод так называемой дистилляции, чтобы «бесплатно выехать на успехе технологий, разработанных OpenAI и других передовых американских компаний». Создателям ChatGPT якобы удалось выявить новые изощрённые методы получения доступа китайской DeepSeek к информации американских ИИ-моделей, которые призваны обходить существующие методы защиты. Беспокойство на эту тему OpenAI и Microsoft проявили ещё в прошлом году, когда начали соответствующее расследование в отношении деятельности DeepSeek. Метод дистилляции позволяет ускорить обучение сторонних ИИ-моделей с использованием данных уже обученных систем. Анализ активности на собственной платформе, как отмечает OpenAI, позволяет говорить об участившихся случаях применения дистилляции сторонними разработчиками ИИ-моделей — преимущественно расположенными в Китае, хотя в отчёте упоминается и Россия. Поскольку DeepSeek не предлагает своим клиентам платных подписок, как и многие другие китайские провайдеры подобных услуг, они получают большее распространение, чем проприетарные коммерческие решения западного происхождения, по мнению авторов доклада. Это угрожает мировому главенству ИИ-моделей американской разработки, как резюмируют они в своём обращении к специальному комитету американского парламента. Полученные методом дистилляции сторонние ИИ-модели, по словам представителей OpenAI, нередко лишены тех ограничений, которые устанавливаются создателями исходных систем, а потому могут использоваться во вред человечеству или отдельным странам. Попытки OpenAI оградить себя от дистилляции китайскими разработчиками успехом не увенчались, поскольку представители DeepSeek якобы получали доступ к американским ИИ-моделям разного рода окольными путями. По словам представителей OpenAI, существуют целые сети посредников, которые предоставляют доступ к услугам компании в обход существующих ограничений. Для американских чиновников существование подобных практик тоже не является откровением, отмечает Bloomberg. Американские политики обеспокоены и возможностью получения компанией DeepSeek доступа к более современным ускорителям вычислений Nvidia H200, поскольку их поставки в Китай в прошлом году успел разрешить американский президент Дональд Трамп (Donald Trump). В сочетании с существующими методами обучения своих моделей, DeepSeek могла бы в результате добиться существенного прогресса. Прежние расследования уже выявили, что DeepSeek использовала для обучения своих предыдущих ИИ-моделей оборудование Nvidia, хотя основная его часть была доставлена в Китай в рамках существовавших на тот момент правил экспортного контроля США. Политики теперь опасаются, что доступ DeepSeek к более современным чипам H200 сильнее навредит позициям США на мировой технологической арене. OpenAI выпустила GPT-5.3-Codex-Spark — свою первую ИИ-модель, работающую без чипов Nvidia

12.02.2026 [23:26],

Николай Хижняк

Компания OpenAI выпустила свою первую модель искусственного интеллекта, работающую на гигантских чипах-ускорителях Wafer Scale Engine 3 от стартапа Cerebras Systems. Данный шаг является частью усилий создателя ChatGPT по диверсификации поставщиков аппаратного обеспечения для обучения своих моделей.

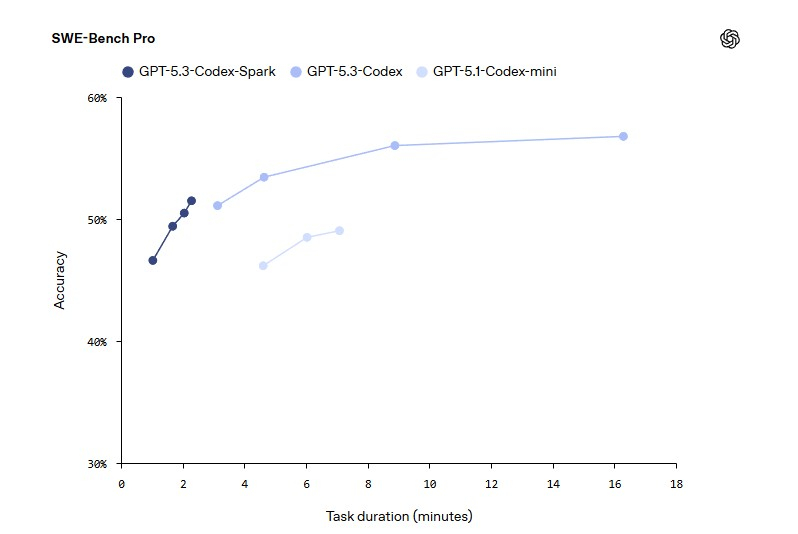

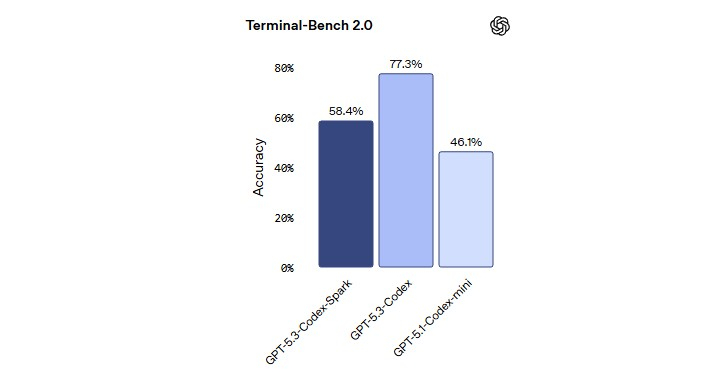

Источник изображения: OpenAI Модель GPT-5.3-Codex-Spark является менее мощной, но более быстрой версией продвинутой модели GPT-5.3-Codex, ориентированной на помощь в написании программного кода. Версия Spark позволит инженерам-программистам быстро выполнять такие задачи, как редактирование отдельных фрагментов кода и запуск тестов. Пользователи также могут легко прервать работу модели или дать ей указание выполнить что-то другое, связанное с вайб-кодингом, не дожидаясь завершения длительного вычислительного процесса.

Источник изображения: OpenAI В прошлом месяце OpenAI заключила сделку на сумму более $10 млрд на использование оборудования Cerebras для ускорения обучения своих моделей ИИ. Для Cerebras это партнёрство представляет собой значительный шаг в её стремлении конкурировать на рынке аппаратных средств для ИИ, где долгое время доминирует компания Nvidia. Для OpenAI — это способ расширить сотрудничество с разными поставщиками оборудования для удовлетворения растущих вычислительных потребностей.

Источник изображения: OpenAI В октябре OpenAI заявила о заключении многолетнего соглашения о стратегическом партнёрстве, в рамках которого будет построена ИИ-инфраструктура на базе сотен тысяч ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт. Позже в том же месяце OpenAI согласилась приобрести специализированные чипы и сетевые компоненты у Broadcom. Как пишет Bloomberg, в последнее время отношения OpenAI с Nvidia оказались под пристальным вниманием на фоне сообщений о напряженности между двумя компаниями. Однако руководители обеих компаний публично заявили, что по-прежнему привержены сотрудничеству. В заявлении, опубликованном в четверг, представитель OpenAI заявил, что партнёрство компании с Nvidia является «основополагающим» и что самые мощные модели ИИ OpenAI являются результатом «многолетней совместной работы над аппаратным и программным обеспечением» двух компаний. «Именно поэтому мы делаем упор на Nvidia как на основу нашей системы обучения и вывода, целенаправленно расширяя экосистему вокруг неё за счёт партнёрств с Cerebras, AMD и Broadcom», — заявил представитель компании. Первоначально GPT-5.3-Codex-Spark будет доступна подписчикам ChatGPT Pro в качестве предварительной версии для исследований. OpenAI собирается предоставить доступ к новой ИИ-модели для более широкого числа пользователей в ближайшие недели. Компания также отмечает, что Codex имеет более 1 млн активных еженедельных пользователей. DeepSeek научилась тренировать языковые ИИ-модели без оглядки на ограничения по скорости памяти

14.01.2026 [11:55],

Алексей Разин

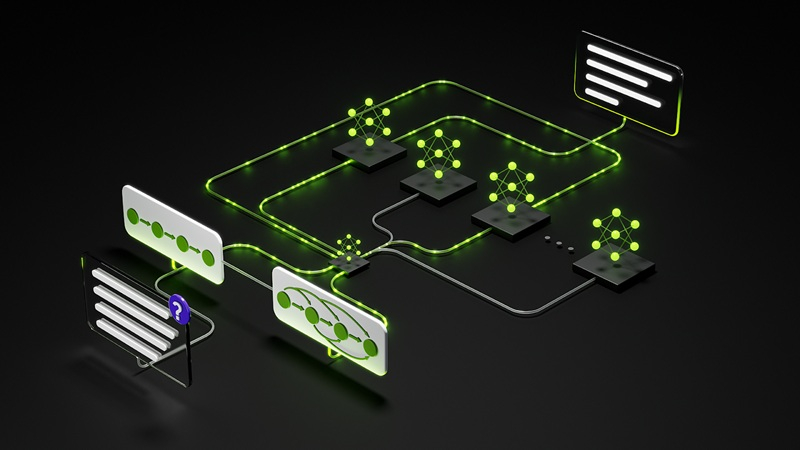

Как отмечалось недавно, пропускная способность памяти, используемой в инфраструктуре ИИ, становится одним из серьёзных ограничителей дальнейшего роста быстродействия языковых моделей. Представители DeepSeek утверждают, что разработали метод обучения ИИ-моделей, который позволяет обойти подобные ограничения со стороны памяти.

Источник изображения: Unsplash, Solen Feyissa Группа исследователей Пекинского университета в сотрудничестве с одним из основателей DeepSeek Лян Вэньфэном (Liang Wenfeng) опубликовала научную работу, в которой рассматривается новый подход к обучению языковых моделей, позволяющий «агрессивно увеличивать количество параметров» в обход ограничений, накладываемых подсистемой памяти используемых в ускорителях GPU. От DeepSeek ожидают выхода новой версии большой языковой модели, но ритмичность их создания в случае с китайскими разработчиками сильно страдает от экспортных ограничений США и нехватки ресурсов в Китае. Текст нового исследования, соавтором которого является один из основателей DeepSeek, будет подробно изучаться специалистами в области искусственного интеллекта как в Китае, так и за его пределами. Описываемая в документе методика «условного» использования памяти получила обозначение Engram, как отмечает South China Morning Post. Существующие подходы к вычислениям при обучении больших языковых моделей, по мнению китайских исследователей, вынуждают напрасно тратить ресурсы на тривиальные операции, которые можно было бы высвободить для высокоуровневых операций, связанных с рассуждениями. Исследователи предложили в некотором смысле разделить вычисления и работу с памятью, обеспечивая поиск базовой информации более эффективными способами. Одновременно новая технология позволяет большим языковым моделям лучше обрабатывать длинные цепочки контекста, что приближает цель превращения ИИ-агентов в полноценных помощников человека. В рамках эксперимента новый подход при обучении модели с 27 млрд параметров позволил поднять общий уровень быстродействия на несколько процентов. Кроме того, система получила больше доступных ресурсов для осуществления сложных операций с рассуждениями. По мнению авторов исследования, данный подход будет незаменим при обучении языковых моделей нового поколения в условиях ограниченности ресурсов. По данным The Information, китайская компания DeepSeek намеревается представить новую модель V4 с развитыми способностями в области написания программного кода к середине февраля этого года. Новая ИИ-модель DeepSeek V4 выйдет в феврале, и она должна понравиться вайб-кодерам

10.01.2026 [13:04],

Николай Хижняк

Китайский стартап DeepSeek, занимающийся разработкой искусственного интеллекта и в прошлом году потрясший Кремниевую долину и Уолл-стрит, готовится к запуску своей модели следующего поколения в ближайшие недели, сообщает Yahoo Finance со ссылкой на отчёт издания The Information.

Источник изображения: Solen Feyissa / unsplash.com Ожидается, что новая модель, получившая название V4, будет обладать расширенными возможностями программирования, которые, согласно внутренним тестам, позволят ей превзойти лидеров отрасли, включая серию GPT от OpenAI и Claude от Anthropic. По словам двух источников, непосредственно знакомых с ситуацией и цитируемых The Information, DeepSeek планирует выпустить модель примерно в середине февраля, в период празднования китайского Нового года, хотя сроки пока окончательно не определены. Время предполагаемого запуска соответствует стратегии, которая ранее принесла пекинскому стартапу огромный культурный и рыночный эффект. В прошлом году DeepSeek выпустила свою флагманскую модель R1 20 января, всего за неделю до недельных китайских новогодних праздников. Этот шаг обеспечил модели доминирование в глобальном технологическом дискурсе в период пикового внимания. DeepSeek, поддерживаемая хедж-фондом High-Flyer Quant, стала глобальным феноменом после выпуска R1. «Рассуждающая» модель, разработанная для «обдумывания» сложных запросов перед ответом, произвела фурор в секторе ИИ не только своей производительностью, но и эффективностью. На рынке, где американские гиганты тратят миллиарды на вычислительные ресурсы, способность DeepSeek достигать сопоставимых результатов за гораздо меньшую стоимость привела к резкой переоценке стоимости ИИ и зависимости от аппаратного обеспечения на западных рынках. Хотя модель DeepSeek V3.2, выпущенная в декабре, превзошла GPT-5 от OpenAI и Gemini 3.0 Pro от Google по некоторым показателям, компания ещё не выпустила нового поколения своей основной архитектуры. Модель V4 призвана заполнить этот пробел. Особый акцент в новой модели сделан на программировании. Умение программировать является основным критерием эффективности ИИ в корпоративной среде, и версия V4 может ещё больше укрепить позиции DeepSeek как недорогой и высокопроизводительной альтернативы американским моделям с закрытым исходным кодом. Для инвесторов предстоящий релиз DeepSeek V4 добавляет новый уровень волатильности в «гонку вооружений в области ИИ». Когда в прошлом году дебютировала DeepSeek R1, это вызвало временное падение акций американских производителей микросхем и лидеров в области ИИ, поскольку рынки столкнулись с реальностью сценария, когда китайский игрок достиг паритета, имея значительно меньше ресурсов, чем конкуренты. Вышла Gemini 3 Flash — новая базовая модель Google, которая лучше Gemini 2.5 Pro и доступна всем бесплатно

18.12.2025 [02:09],

Николай Хижняк

Компания Google выпустила ИИ-модель Gemini 3 Flash. Новинка вышла под слоганом «передовой интеллект, созданный для скорости по доступной цене». Gemini 3 Flash сохранила возможности сложных логических рассуждений модели Gemini 3, мультимодальность с пониманием визуальных данных, а также производительность в задачах агентного и визуального программирования, но с учётом «задержки, эффективности и стоимости уровня Flash».

Источник изображений: Google ИИ-модель Gemini 3 Flash превосходит 2.5 Flash по всем параметрам и «значительно» превосходит версию Gemini 2.5 Pro в нескольких тестах, включая MMMU Pro, Toolathlon и MPC Atlas. Google выделила следующие особенности ИИ-модели Gemini 3 Flash:

Google утверждает, что Gemini 3 Flash «превосходит Gemini 2.5 Pro, будучи в 3 раза быстрее и при этом значительно дешевле». Использование сильного логического мышления, инструментов и мультимодальные возможности, реализованные в Gemini 3 Flash, обеспечивают «более сложный анализ видео, извлечение данных и визуальные вопросы и ответы» для сторонних разработчиков, создающих агентов поддержки клиентов или внутриигровых помощников. Стоимость использования Gemini 3 Flash составляет $0,50 за входные токены и $3 за выходные токены (цена аудиозапроса составляет $1 за входные токены). Сравнение эффективности Gemini 3 Flash с другими моделями ИИ

Смотреть все изображения (4)

Смотреть все изображения (4) ИИ-модель Gemini 3 Flash уже доступна в приложении Gemini, где заменяет ИИ-модель Gemini 2.5 Flash в качестве модели по умолчанию. Компания позиционирует новую модель, как «значительное обновление вашего повседневного ИИ», который «стал умнее и быстрее». «Вы можете быстро создавать интересные и полезные приложения с нуля, не имея предварительных знаний в программировании. Просто попросите Gemini помочь вам доработать идею. Вы можете на ходу диктовать поток мыслей и превращать их в прототип», — описывает Google возможности Gemini 3 Flash.  В Gemini 3 Flash доступен выбор из двух режимов работы: «Быстрый» — для оперативных ответов и «Глубокое размышление» — для решения сложных задач. Выпущенная в прошлом месяце ИИ-модель Gemini 3 Pro предназначена для более сложных математических задач и задач по программированию. Gemini 3 Flash также внедряется по всему миру в качестве модели по умолчанию в режиме поиска ИИ (AI Mode). Модель позволяет задавать более тонкие и уточнённые вопросы. Google также сообщила, что модели Gemini 3 Pro с генеративным пользовательским интерфейсом и Nano Banana Pro стали доступны для всех пользователей в США. «Gemini 3 Flash превосходно улавливает нюансы вашего запроса, извлекая в режиме реального времени локальную информацию и полезные ссылки со всего интернета и предоставляя продуманные, исчерпывающие ответы, которые легко воспринимаются визуально», — говорит Google. Для разработчиков Gemini 3 Flash доступен в режиме предварительного просмотра через AI Studio, Google Antigravity, Gemini CLI и Android Studio. Для корпоративных пользователей новая ИИ-модель доступна через Vertex AI и Gemini Enterprise. Nvidia выпустила ИИ-модель Nemotron 3 Nano 30B с открытыми весами и большущим контекстным окном

15.12.2025 [22:55],

Владимир Мироненко

Компания Nvidia сообщила подробности о новом семействе моделей Nemotron 3 с открытыми весами, разработанном, в том числе, для создания специализированного агентного ИИ нового поколения.

Источник изображения: Nvidia Первый представитель семейства — модель Nemotron 3 Nano 30B с открытыми весами, общим количеством параметров в 30 млрд и 3 млрд активных параметров. Модель основана на гибридной архитектуре Mamba-Transformer, сочетающей «смесь экспертов» (MoE), обучение с подкреплением (RL) в интерактивных средах и собственное контекстное окно в 1 млн токенов, обеспечивающее высокопроизводительное и долгосрочное рассуждение для многоагентных приложений. Как сообщает VideoCardz со ссылкой на публикацию на Hugging Face, маршрутизатор активирует 6 из 128 экспертов за один проход. Nvidia сообщила, что для запуска модели может использоваться система DGX Spark, а также ускорители H100 и B200. В числе новшеств Nemotron 3, напрямую отвечающих потребностям агентных систем, указаны:

Семейство MoE Nemotron 3 включает три модели:

Nemotron 3 Nano с готовыми к использованию руководствами доступна уже сейчас. Nemotron 3Super и Ultra выйдут немного позже. Открытые ИИ-модели из Китая захватили почти треть мирового рынка ИИ — и вряд ли остановятся

09.12.2025 [08:44],

Алексей Разин

Соображения экспертов по поводу активного распространения китайских больших языковых моделей с открытым исходным кодом далеко за пределами регионального рынка находят всё больше подтверждений в различных источниках. По некоторым данным, по интенсивности использования такие модели достигли 30 % мирового рынка в этом году.

Источник изображения: Nvidia По информации агрегатора OpenRouter и аналитиков Andreessen Horowitz, на которые ссылается South China Morning Post, китайские большие языковые модели с открытым исходным кодом ещё в конце прошлого года претендовали не более чем на 1,2 % обрабатываемых в мире токенов, но по итогам текущего года она выросла почти до 30 %. При этом запросы при обращении к ИИ-моделям на китайском языке остаются вторыми по частоте после английских. Среди китайских ИИ-моделей лидируют разработки семейства Qwen холдинга Alibaba, DeepSeek V3 и решение Moonshot AI по имени Kimi K2. Оставшиеся 70 % операций с токенами приходятся на закрытые модели западного происхождения, типа тех, что предлагает OpenAI в серии GPT. С начала этого года китайские большие языковые модели с открытым исходным кодом достигли доли в 13 % еженедельного использования токенов, причём во втором полугодии их популярность увеличилась. Языковые модели прочего происхождения по географическому признаку обеспечивают долю 13,7 % на уровне еженедельного использования. В отчёте говорится, что китайские большие языковые модели активно применяются не только внутри страны, но и за её пределами. Mistral AI сделал заявку на лидерство на рынке открытых моделей, выпустив Mistral 3

03.12.2025 [15:34],

Владимир Мироненко

Французский ИИ-стартап Mistral AI представил семейство моделей Mistral 3 следующего поколения с открытыми весами (Open-weight), сделав серьёзную заявку на лидерство в сегменте общедоступных ИИ-моделей, которые обладают рядом преимуществ для корпоративных клиентов по сравнению с решениями крупных технологических компаний.

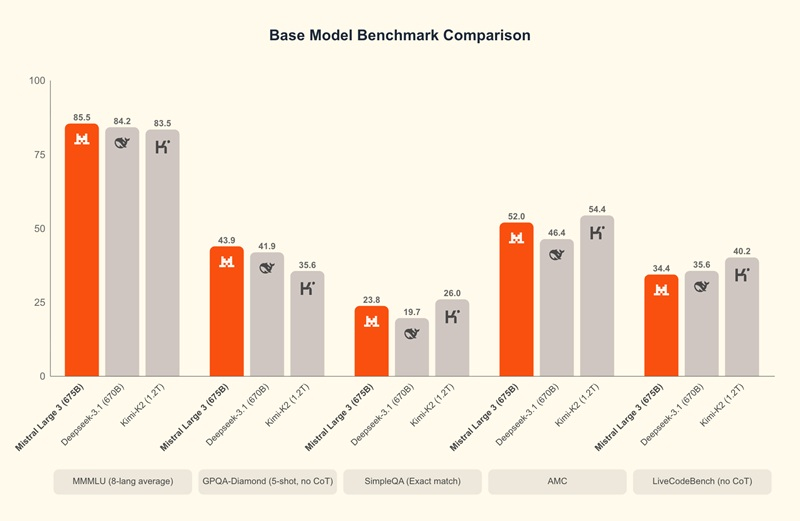

Источник изображения: Mistral AI Семейство Mistral 3 состоит из 10 моделей, включая большую модель разреженной архитектуры (Mixture of Experts, MoE) с открытыми весами, мультимодальными и многоязычными возможностями — Mistral Large 3. Это самая мощная на сегодняшний день модель компании, обученная с 41 млрд активных и 675 млрд общих параметров. Также в состав семейства входят девять небольших моделей с возможностью автономной работы и полной настройкой, в том числе три современные модели Ministral высокой плотности с 4, 8 и 3 млрд параметров. Модели Mistral обладают лучшим соотношением производительности и стоимости в своей категории. В то же время Mistral Large 3 входит в число передовых моделей с открытым исходным кодом, оптимизированных под тонко настроенные инструкции. Компания указала, что все модели выпускаются по лицензии Apache 2.0, добавив, что открытый исходный код моделей в различных сжатых форматах расширяет возможности сообщества разработчиков и позволяет использовать возможности ИИ благодаря распределённому интеллекту. Как сообщает TechCrunch, стартап Mistral, основанный бывшими сотрудниками DeepMind и Meta✴✴, существует всего два года и на сегодняшний день привлек около $2,7 млрд инвестиций при оценке рыночной стоимости в $13,7 млрд. Это значительно меньше, чему у конкурентов, таких как OpenAI (привлечено $57 млрд при оценке в $500 млрд) и Anthropic (привлечено $45 млрд при оценке в $350 млрд). Mistral утверждает, что больше не всегда значит лучше, особенно для корпоративных сценариев использования ИИ-продуктов. «Наши клиенты иногда рады начать с очень большой [закрытой] модели, которую им не нужно настраивать… но, развернув её, они понимают, что это дорого и медленно, — рассказал ресурсу TechCrunch Гийом Лампле (Guillaume Lample), соучредитель и главный научный сотрудник Mistral. — Затем они обращаются к нам, чтобы мы настроили небольшие модели для более эффективного решения конкретной задачи». По его словам, подавляющее большинство корпоративных сценариев использования ИИ-решений можно реализовать с помощью небольших моделей с тонкой настройкой. Лампле утверждает, что при сравнении с эталонными моделями, когда открытые модели значительно отстают от конкурентов с закрытым исходным кодом, результаты могут быть обманчивы. Он отметил, что большие закрытые модели могут со старта работать лучше, но реальный выигрыш при использовании небольших моделей достигается при настройке. ИИ-модель Alibaba Qwen3-VL способна уловить почти все детали двухчасового видео, лишь раз его «просмотрев»

30.11.2025 [18:32],

Николай Хижняк

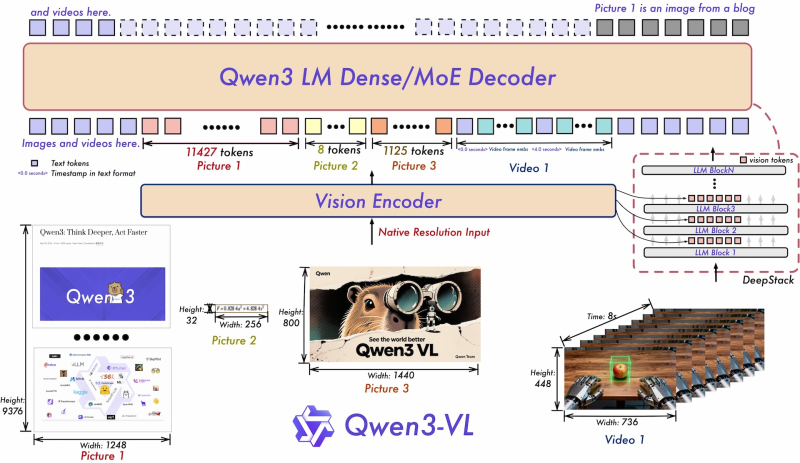

Спустя несколько месяцев после запуска Qwen3-VL компания Alibaba опубликовала подробный технический отчёт об открытой мультимодальной модели. Данные показывают, что система превосходно справляется с математическими задачами, связанными с изображениями, и может анализировать многочасовые видеоматериалы.

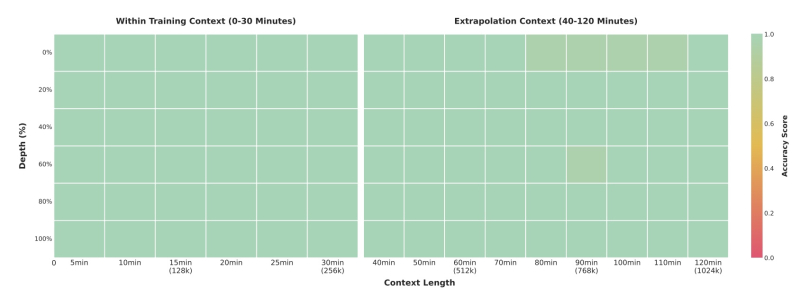

Источник изображений: Alibaba Система справляется с большими объёмами данных, обрабатывая двухчасовые видео или сотни страниц документов в контекстном окне из 256 тыс. токенов. В тестах «иголка в стоге сена» флагманская модель с 235 млрд параметров обнаруживала отдельные кадры в 30-минутных видео со 100-процентной точностью. Даже в двухчасовых видео, содержащих около миллиона токенов, точность сохранялась на уровне 99,5 %. Тест основан на вставке семантически важного кадра-«иглы» в случайные места длинных видео, которые система затем должна найти и проанализировать.

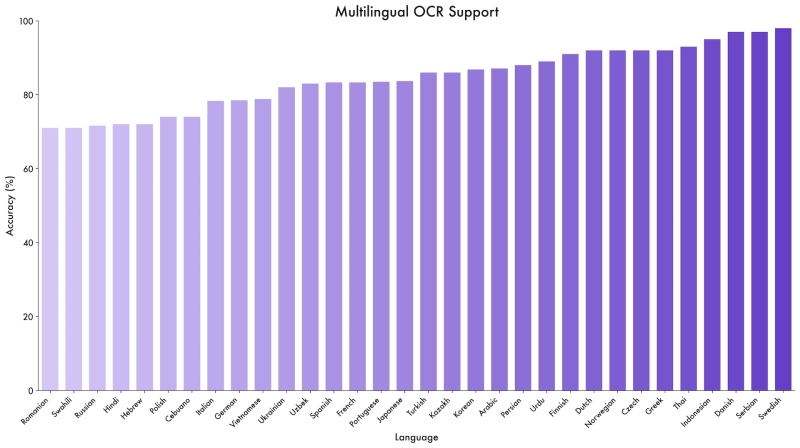

Тест «иголка в стоге сена» измеряет способность модели находить определенные кадры в длинных видеороликах В опубликованных бенчмарках модель Qwen3-VL-235B-A22B часто превосходит Gemini 2.5 Pro, OpenAI GPT-5 и Claude Opus 4.1, даже когда конкуренты используют функции логического мышления или требуют больших затрат на мышление. Модель доминирует в задачах с визуальным математическим анализом, набирая 85,8 % в MathVista по сравнению с 81,3 % у GPT-5. В MathVision она лидирует с 74,6 %, опережая Gemini 2.5 Pro (73,3%) и GPT-5 (65,8%). Модель также демонстрирует широкий диапазон результатов в специализированных бенчмарках. Она набрала 96,5 % в тесте на понимание документов DocVQA и 875 баллов в OCRBench, поддерживая 39 языков — почти в четыре раза больше, чем её предшественник.

Qwen3-VL достигает точности более 70 процентов при выполнении задач OCR на 32 из 39 поддерживаемых языков Alibaba утверждает, что модель также демонстрирует новые возможности в задачах графического интерфейса. Точность Qwen3-VL-32B в ScreenSpot Pro, тестирующем навигацию в графических пользовательских интерфейсах, составила 61,8 %. В AndroidWorld, где система должна самостоятельно управлять приложениями Android, Qwen3-VL-32B показал результат 63,7 %. Модель также обрабатывает сложные многостраничные PDF-документы. В MMLongBench-Doc она показала результат 56,2 % при анализе длинных документов. В бенчмарке CharXiv для научных диаграмм она достигла 90,5 % при выполнении задач описания и 66,2 % при выполнении сложных логических задач. Однако не во всех случаях Qwen3-VL оказалась лучше конкурентов. В сложном тесте MMMU-Pro модель набрала 69,3 %, уступив GPT-5 с результатом 78,4 %. Коммерческие конкуренты также обычно лидируют в тестах качества видео. Данные свидетельствуют, что Qwen3-VL специализируется на визуальных математических задачах и документах, но всё ещё отстаёт в области общих логических рассуждений. В техническом отчёте описаны три основных архитектурных обновления, реализованных в Qwen3-VL. Во-первых, «interleaved MRoPE» заменяет предыдущий метод позиционного встраивания. Вместо группировки математических представлений по размерности (время, горизонталь, вертикаль), новый подход равномерно распределяет их по всем доступным математическим областям. Это изменение направлено на повышение производительности при работе с длинными видео. Во-вторых, технология DeepStack позволяет модели получать доступ к промежуточным результатам видеокодера, а не только к конечному результату. Это предоставляет системе доступ к визуальной информации с разной степенью детализации. В-третьих, система временных меток на основе текста заменяет сложный метод T-RoPE, используемый в Qwen2.5-VL. Вместо того, чтобы присваивать математическую временную позицию каждому видеокадру, система теперь вставляет простые текстовые маркеры, например, «<3,8 секунды>», непосредственно во входные данные. Это упрощает процесс и улучшает понимание моделью задач, связанных с анализом видео с временными рамками.

Qwen3-VL объединяет видеокодер и языковую модель для одновременной обработки текста, изображений и видео. DeepStack использует визуальную информацию с разных уровней обработки Alibaba обучала модель в четыре этапа на базе 10 тыс. графических процессоров. После обучения связыванию изображений и текста система прошла полное мультимодальное обучение примерно на триллионе токенов. Источниками данных были веб-скрапы, 3 млн PDF-файлов из Common Crawl и более 60 млн STEM-задач. На последующих этапах команда постепенно расширяла контекстное окно с 8000 до 32 000 и, наконец, до 262 000 токенов. Варианты Thinking прошли специальное обучение Chain-of-thought training, что позволило им генерировать промежуточные шаги рассуждения перед предоставлением окончательного ответа для достижения лучших результатов при решении сложных задач. Все модели Qwen3-VL, выпущенные с сентября, доступны по лицензии Apache 2.0 с открытыми весами на Hugging Face. Линейка включает плотные варианты с параметрами от 2B до 32B, а также модели со смесью экспертов 30B-A3B и массивные 235B-A22B. Хотя такие функции, как извлечение кадров из длинных видео, не являются новыми (в начале 2024 года Google Gemini 1.5 Pro уже реализовал эту функцию), Qwen3-VL предлагает конкурентоспособную производительность. Поскольку предыдущая модель Qwen2.5-VL уже широко применялась в исследованиях, новая модель, вероятно, станет стимулом для дальнейшей разработки ПО с открытым исходным кодом. ИИ-модель DeepseekMath-V2 достигла уровня золотой медали на Международной математической олимпиаде

29.11.2025 [13:22],

Владимир Фетисов

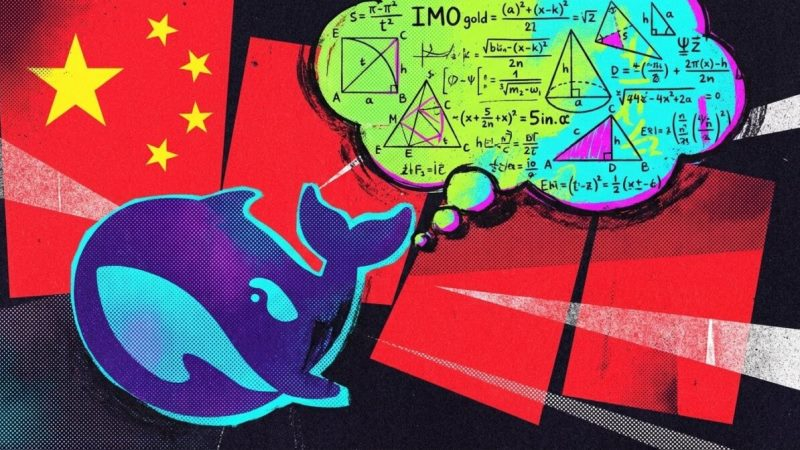

Китайский стартап DeepSeek представил новую ИИ-модель DeepseekMath-V2, которая показывает впечатляющие результаты при решении сложных математических задач. Алгоритм справился с многими заданиями Международной математической олимпиады (IMO 2025) и Китайской математической олимпиады (CMO 2024), показав при этом результат на уровене золотой медали.

Источник изображений: the-decoder.com В сообщении сказано, что DeepseekMath-V2 набрала 118 из 120 баллов в задачах Putnam, что существенно выше лучшего результата человека в 90 баллов. DeepSeek отмечает, что ранее ИИ-модели часто выдавали верные ответы в сложных математических задачах, но при этом не показывали правильного хода решения. Для исправления ситуации ИИ-модель задействует многоэтапный процесс с отдельным верификатором для оценки корректности шагов решения задачи и необходимости их перепроверки. Такая структура позволяет алгоритму проверять и совершенствовать свои решения в режиме реального времени. С технической стороны DeepseekMath-V2 построена на основе базовой модели Deepseek-V3.2-Exp-Base. В описании DeepSeek ни разу не упоминается использование внешних инструментов, таких как калькуляторы или интерпретаторы кода. В ключевых экспериментах одна и та же модель DeepseekMath-V2 используется как для генерации доказательств, так и для их проверки. Высокая производительность алгоритма обусловлена способностью подвергать критике и улучшать собственные выводы вместо того, чтобы задействовать внешнее программное обеспечение. Для решения более сложных задач модель наращивает вычислительные мощности на этапе тестирования, параллельно создавая и проверяя множество возможных доказательств, чтобы повысить уровень уверенности в правильности конечного ответа. Релиз DeepSeek последовал за анонсом ещё не выпущенных ИИ-моделей OpenAI и Google Deepmind, которые достигли схожих результатов в решении сложных математических задач. Примечательно, что эти алгоритмы достигли такого результата за счёт способности к рассуждению, а не целевой оптимизации для математических олимпиад. Если на деле успехи этих алгоритмов действительно окажутся столь впечатляющими, то это будет означать, что языковые модели приблизились к моменту, когда они смогут решать сложные, абстрактные задачи, что традиционно считалось исключительно человеческим навыком. Отметим, что решение DeepSeek раскрыть технические детали модели DeepseekMath-V2 резко контрастирует с секретностью, которую соблюдают Google и OpenAI. Американские компании держат в тайне подробности об архитектуре собственных ИИ-моделей, тогда как китайский стартап буквально раскрывает все карты, наглядно показывая, что компания идёт вровень с ведущими отраслевыми представителями. Практическое использование ИИ в работе остаётся весьма неравномерным

29.11.2025 [08:07],

Алексей Разин

Пока разработчики систем ИИ рисуют красочные картины светлого будущего, практическое внедрение таких решений осуществляется неравномерно и беспорядочно. Во многом такие перекосы можно было бы устранить благодаря более грамотному руководству бизнесом и обучению персонала новым приёмам работы, как считают эксперты.

Источник изображений: Intel Издание The Wall Street Journal в своей пятничной публикации обратилось к этой теме, проанализировав отчёты сразу нескольких исследователей. Социологических исследований на тему практической пользы от внедрения ИИ пока не так много, поскольку бизнес принимает подобные технологические инструменты на вооружение с предсказуемой инерцией. Новые исследования указывают, что внедрение ИИ на практическом уровне происходит весьма неравномерно. Не во всех компаниях, например, самыми активными пользователями ИИ являются те сотрудники, которым оно должно приносить максимальную выгоду. В частности, наиболее опытные сотрудники теоретически способны более продуктивно общаться с ИИ, выявляя ошибочные результаты в силу своего опыта, но в действительности они не торопятся это делать. Исследование Workhelix, которое проводилось внутри фармацевтической компании с более чем 50 000 сотрудников, показало довольно спорные результаты. Выяснилось, что чаще всего к использованию ИИ прибегают стажёры, а не сотрудники с опытом. Молодые сотрудники более склонны к экспериментам, хотя и в этом случае возраст не является критерием, поскольку среди них имеются явные противники ИИ. Скорее, склонность к взаимодействию с ИИ определяется готовностью специалиста к экспериментам, и от возраста она не особо зависит. В конкретной фармацевтической компании второй группой активных пользователей ИИ оказались профессиональные исследователи, что вполне закономерно, поскольку они в своей ежедневной деятельности связаны с экспериментами и поиском новых технологий. Важным фактором эффективности использования ИИ является и одобрение руководства компаний, а также обучающие программы для персонала. Аналитики McKinsey обнаружили, что примерно две трети компаний ограничиваются экспериментами по использованию ИИ в своей деятельности, и только одна из двадцати может похвастать высокой эффективностью его применения, когда ИИ обеспечивает более чем 5 % дохода. Даже в том случае, когда работодатель создаёт равные условия для доступа сотрудников к ИИ-инструментам, перестроить под новые условия все процессы удаётся далеко не сразу. И чем больше людей задействовано в цепочке, тем сложнее внедрить ИИ.  История внедрения персональных компьютеров в середине восьмидесятых годов прошлого века показала, что прогрессивные технологии повышают эффективность бизнеса лишь через несколько лет, а на первых порах производительность может даже страдать. Обучение персонала и перестройка бизнес-процессов может потребовать годы, прежде чем внедрение ИИ начнёт приносить плоды. Человечество уже прошло через несколько волн технологической революции. Сначала это были персональные компьютеры, потом появился интернет, затем облачные сервисы, а также мобильные устройства. Руководство компаний должно играть весомую роль в продвижении этих новшеств. Июльское исследование Microsoft Research показало, что самые подверженные внедрению ИИ профессии подразумевают написание текстов или кода, либо проведение исследований. У молодых сотрудников при этом больше мотивации использовать ИИ в своей работе, поскольку они тем самым могут доказать свою эффективность руководству и продвинуться по служебной лестнице. Игнорирующие развитие ИИ профессионалы рано или поздно должны будут либо научиться его использовать, либо покинуть рынок труда. По сути, не ИИ лишает людей работы, их место просто могут занять другие специалисты, которые могут его эффективно применять. ИИ облегчит диагностику редких генетических заболеваний — представлена модель PopEVE

25.11.2025 [13:42],

Алексей Разин

Почти десять лет назад система IBM Watson начала применяться для диагностики заболеваний, а по мере распространения искусственного интеллекта в последние годы медицина стала одной из отраслей, демонстрирующих реальную отдачу от внедрения подобных технологий. Новая модель PopEVE специализируется на диагностике редких заболеваний, имеющих генетическое происхождение.

Источник изображения: Freepik, DC Studio Подобными заболеваниями страдают лишь некоторые люди, у которых обнаруживаются опасные генные мутации, но в общей сложности их может насчитываться сотни миллионов человек. Традиционные методы диагностики таких заболеваний не всегда дают нужный результат и позволяют подобрать эффективное лечение. Как отмечает Financial Times, группе испанских и американских исследователей удалось сообща разработать ИИ-модель PopEVE, которая позволяет выделять в геноме человека потенциально опасные последовательности, способные вызвать редкие заболевания. Модель была обучена на массиве данных об эволюционном развитии живых существ, она уже демонстрирует более впечатляющие результаты, чем созданная в Google DeepMind модель AlphaMissense, по некоторым критериям. Данная разработка призвана облегчить задачу докторам, впервые столкнувшимся с аномалиями в здоровье пациента и не понимающим первопричину проблем. Учёные в процессе своего исследования изучили, как генетические изменения способны влиять на способность организма воспроизводить белки, а именно давать сбои в воспроизведении аминокислот, из которых они формируются. Информация об эволюционном развитии множества видов животных позволила ИИ идентифицировать те генетические изменения, которые потенциально могут быть вредны для человека. Если какие-то изменения отсутствуют в базе данных, они могут быть опасны, поскольку столкнувшиеся с ними живые организмы в результате таких мутаций могли вымереть. Накопленные данные об эволюции животных были откалиброваны с использованием генетических банков данных, чтобы их можно было применять к диагностике состояний человеческого организма. На выборке из 31 000 семей, чьи дети страдали от серьёзных нарушений развития, модель PopEVE смогла выявить 513 случаев ранее неизвестных мутаций с достоверностью около 98 процентов. Попутно были обнаружены 123 генетические комбинации, которые могут в период активного развития человека взаимодействовать с патогенными белками, но ранее они никогда не связывались учёным сообществом с риском развития заболеваний. Модель PopEVE превзошла в точности диагностики разработку DeepMind не только по критерию предсказания серьёзности заболевания, но и при работе с группами людей, чьи предки не были европейцами. В своей эксплуатации PopEVE не требует серьёзных затрат электроэнергии, а потому может применяться даже в странах с не самой развитой инфраструктурой. В Сенегале она уже помогла диагностировать мышечную атрофию, которую можно вылечить при помощи инъекций витамина B2. По мнению специалистов, модель PopEVE поможет в диагностике редких генетических заболеваний у тех пациентов, которые не могут предоставить генетический материал своих родителей для анализа. Microsoft выпустила первые собственные ИИ-модели: одна генерирует речь, а другая — текст

29.08.2025 [00:43],

Николай Хижняк

До сих пор Microsoft в значительной степени полагалась на модели искусственного интеллекта компании OpenAI. Каждый раз, когда OpenAI представляла свои новейшие модели, Microsoft объявляла об их доступности в инфраструктуре Azure и во всех своих продуктах и сервисах. Сегодня Microsoft представила две собственные модели искусственного интеллекта: MAI-Voice-1 и MAI-1-preview.

Источник изображения: Microsoft MAI-Voice-1 — это модель генерации речи. Она уже доступна в приложениях Copilot Daily (аудиосводка новостей и погоды на основе ИИ) и Podcasts. Чтобы ознакомиться со всеми возможностями этой голосовой модели, Microsoft создала новый интерфейс Copilot Labs, который каждый может попробовать уже сегодня. С помощью функции Copilot Audio Expressions пользователи могут вставить текстовый контент и выбрать голос, стиль и режим для создания высококачественного, выразительного звука. При необходимости можно скачать сгенерированный аудиофайл. Microsoft подчёркивает, что модель MAI-Voice-1 работает очень быстро и эффективно: она способна сгенерировать минуту аудио менее чем за секунду при использовании одного GPU. Модель MAI-1-preview доступна в виде публичной бета-версии на платформе LMArena для оценки сообществом. Это первая фундаментальная модель MAI, прошедшая комплексное обучение, и она даёт представление о будущих возможностях Copilot. MAI-1-preview — это модель MoE (смешанная модель экспертов), обученная на почти 15 000 специализированных ускорителях Nvidia H100. Это первая фундаментальная ИИ-модель Microsoft, прошедшая комплексное обучение собственными силами. Компания утверждает, что она эффективно выполняет инструкции и может давать полезные ответы на повседневные вопросы пользователей. Microsoft планирует внедрить MAI-1-preview для некоторых текстовых сценариев Copilot в ближайшие недели. При этом Microsoft уточняет, что MAI-1-preview не заменяет модели OpenAI в Copilot. Компания планирует использовать лучшие решения как собственной команды, так и партнёров, включая сообщество разработчиков ПО с открытым исходным кодом. Помимо платформы LMArena, модель MAI-1-preview также доступна через API для доверенных тестировщиков. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |