|

Опрос

|

реклама

Быстрый переход

Ускорители вычислений Baidu имеют все шансы стать хитом китайского рынка

30.11.2025 [08:19],

Алексей Разин

Китайский интернет-гигант Baidu в уходящем месяце представил собственные ускорители M100 и M300 для работы в инфраструктуре искусственного интеллекта. Ориентированный на инференс M100 будет доступен в начале следующего года, а более универсальный M300 с 2027 года позволит китайским компаниям хотя бы частично решить проблему дефицита вычислительных ресурсов для обучения больших языковых моделей.

Источник изображения: Baidu, TechPowerUp Опрошенные CNBC аналитики сходятся во мнении, что при правильной организации производства и маркетинга ускорители Baidu помогут китайским разработчикам решить сразу две проблемы. Во-первых, они снизят зависимость от американских ускорителей в условиях санкций. Во-вторых, они позволят удовлетворить требования китайских властей по переходу на использование чипов локальной разработки. Инвесторы на этом фоне начали смотреть на акции Baidu с возросшим оптимизмом. Они убеждены, что появление в арсенале Baidu собственных ускорителей не только поможет развитию бизнеса этой компании, но и привлечёт к ним прочих участников китайского рынка. Один из крупнейших операторов мобильной связи в КНР, компания China Mobile, уже начал закупать ускорители Kunlunxin у Baidu. Последняя в этом смысле становится серьёзным конкурентом для Huawei Technologies, которая с трудом наращивает объёмы выпуска собственных чипов в условиях санкций. Появление ещё одного конкурентоспособного поставщика на рынке Китая пойдёт на пользу местному рынку искусственного интеллекта. По прогнозам JPMorgan, в следующем году Baidu сможет нарастить выручку от реализации своих чипов в шесть раз до $1,1 млрд. Капитализация профильного подразделения компании при этом достигнет $28 млрд. Китайские программные гиганты испытывают нехватку вычислительных ресурсов. Руководство Tencent в этом месяце было вынуждено признаться, что по итогам 2025 года капитальные затраты компании окажутся ниже ожидаемых, поскольку ей банально не хватает ИИ-чипов для введения в строй новых вычислительных мощностей. Руководство Alibaba недавно также призналось, что не успевает предлагать клиентам новые облачные мощности в достаточном для удовлетворения спроса объёме. Если Baidu сможет ритмично выпускать новые поколения ИИ-чипов, то на китайском рынке эта продукция окажется в числе фаворитов, по мнению аналитиков The Futurum Group. Сроки окупаемости ускорителей ИИ остаются загадкой для участников рынка

16.11.2025 [08:34],

Алексей Разин

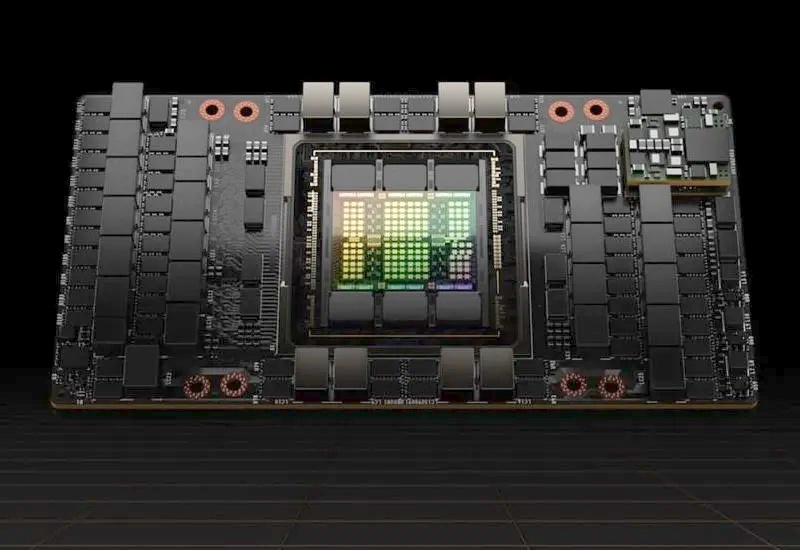

Инвестиционная активность OpenAI является наглядным примером того ажиотажа, который сейчас сопровождает развитие вычислительной инфраструктуры для сферы искусственного интеллекта. В планы компании и её многочисленных партнёров входит вложение до $1,5 трлн в эту сферу за ближайшие восемь лет только на территории США. При этом сроки окупаемости профильного оборудования с трудом определяются даже бывалыми экспертами.

Источник изображения: Nvidia Как поясняет CNBC, отрасль генеративного искусственного интеллекта в её нынешнем виде достаточно молода — её история насчитывает не более трёх лет, поэтому активные инвестиции пока не приносят заметной финансовой отдачи, и просчитать бизнес-модель на этом этапе затруднительно. Google, Oracle и Microsoft исходят из продолжительности жизненного цикла своих центров обработки данных для ИИ до шести лет включительно, и за это время, с бухгалтерской точки зрения, соответствующие активы должны пройти полную амортизацию. Другими словами, стоимость данного оборудования должна быть полностью перенесена на себестоимость услуг указанных компаний за шесть лет или даже быстрее. Стремительное развитие больших языковых моделей, однако, может потребовать от участников рынка ускорения амортизации, поскольку оборудование может устареть быстрее, чем за шесть лет. Формально, Microsoft в своей финансовой документации указывает срок амортизации от двух до шести лет. Обычно длительные сроки амортизации благотворно влияют на прибыль компании, поскольку затраты на закупку оборудования переносятся на себестоимость услуг и продукции постепенно, малыми частями. В случае с применяемыми для ускорения работы ИИ ускорителями участники рынка пока теряются, на какой срок эксплуатации следует рассчитывать при планировании инвестиций и расчёте окупаемости. Облачный провайдер CoreWeave исходит из шестилетнего срока амортизации, начиная с 2023 года. По мнению представителей компании, устаревшие GPU получают «вторую жизнь» в рамках постоянно обновляющейся инфраструктуры, поскольку в условиях дефицита вычислительных мощностей они всё равно находят применение и приносят пользу не только клиентам, но и владельцам оборудования. Что характерно, партия ускорителей Nvidia H100 после трёх лет эксплуатации была недавно вновь введена в оборот по цене на уровне 95 % от изначальной, хотя в целом бывшему в употреблении оборудованию столь высокая остаточная стоимость не присуща. Скептики придерживаются мнения, что рыночный жизненный цикл оборудования в этой сфере не превышает двух или трёх лет при нынешних темпах развития отрасли ИИ. Примечательно, что разработчики ускорителей перешли на ежегодный выпуск новых поколений продукции. Моду задала считающаяся лидером отрасли Nvidia, недавно её подхватила AMD, а руководство Intel тоже не стало оставаться в стороне от тенденции. Microsoft при закупке ускорителей Nvidia старается равномерно распределять расходы между последующими поколениями продукции этой марки, чтобы не остаться в какой-то момент с большим запасом устаревших ускорителей. Рынок ИИ пока изучен слабо, поэтому владельцы ЦОД стараются придерживаться гибкого подхода к планированию затрат и окупаемости. Microsoft готова использовать разработки OpenAI для совершенствования собственных чипов

13.11.2025 [05:58],

Алексей Разин

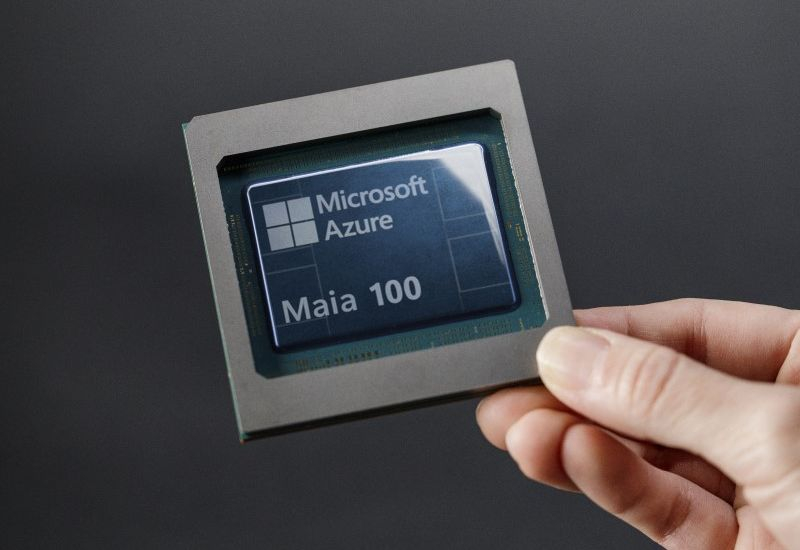

Корпорация Microsoft разрабатывала собственные серверные процессоры задолго до того, как стартап OpenAI набрал силу и стал влиятельным игроком на рынке систем искусственного интеллекта. Оказавшись одним из ранних и крупных инвесторов в капитал OpenAI, компания Microsoft сохраняет право использовать разработки первой в сфере аппаратного обеспечения для своих нужд.

Источник изображения: OpenAI Исключением, как напоминает Bloomberg, являются только создаваемые OpenAI совместно со стартапом Джони Айва (Jony Ive) потребительские устройства. Известно, что OpenAI одновременно разрабатывает некие процессоры для инфраструктуры ИИ при участии компании Broadcom. Глава Microsoft Сатья Наделла (Satya Nadella) дал понять, что его корпорация намерена использовать разработки OpenAI в этой сфере для собственных нужд. Как отмечает Bloomberg, Наделла недавно заявил во время своего выступления в подкасте: «По мере того, как они внедряют инновации даже на системном уровне, мы имеем доступ ко всему этому. Мы хотели бы сперва изучить, что они для них создают, а потом мы расширим это». В данном случае глава Microsoft имел в виду усилия OpenAI по созданию собственных чипов, которые будут реализовываться при поддержке партнёров и подрядчиков. Получается, что Microsoft готова использовать разработки OpenAI в аппаратной сфере для собственных нужд. По условиям нового соглашения между компаниями, Microsoft сохраняет доступ к языковым моделям OpenAI до 2032 года и разработкам до 2030 года, либо до момента создания так называемого «сильного» искусственного интеллекта (AGI). При этом Microsoft не имеет доступа к разработкам OpenAI в сфере потребительских устройств. По словам Наделлы, Microsoft готова работать с дизайнами OpenAI и своими собственными, будучи уверенной, что имеет доступ к соответствующей интеллектуальной собственности на законных основаниях. Производством американских ИИ-чипов для Tesla займутся и Samsung, и TSMC

23.10.2025 [04:58],

Алексей Разин

Не является секретом контракт на выпуск чипов для ускорителей ИИ компании Tesla южнокорейской Samsung на строящемся предприятии в Техасе. Глава автопроизводителя Илон Маск (Elon Musk) накануне признался, что к выпуску чипов AI5 будет привлечено и американское предприятие TSMC в Аризоне, поскольку компания хочет получать такие компоненты в избытке.

Источник изображения: Tesla Унификация данных чипов с бортовыми системами электромобилей поможет Tesla гибко перенаправлять их запасы на человекоподобных роботов или собственные центры обработки данных. «Наша явная цель заключается в перепроизводстве чипов AI5», — пояснил глава Tesla на вчерашней квартальной отчётной конференции. При этом он подчеркнул, что компания не откажется от использования ускорителей Nvidia в своей вычислительной инфраструктуре для обучения языковых моделей. «Мы не собираемся заменять Nvidia, чтобы вы понимали, но мы будет сочетать их применение», — добавил миллиардер. Как пояснил Маск на этой неделе, Tesla сейчас располагает вычислительными мощностями, соответствующими 81 000 чипов Nvidia H100. Чип AI5 собственной разработки впервые был анонсирован на собрании акционеров Tesla в 2024 году. В июле текущего года стало известно о заключении контракта с Samsung на сумму $16,5 млрд, по условиям которого компания должна будет выпускать чипы AI6 для нужд Tesla на своём предприятии в Техасе. Ещё тогда Маск признался, что чипы AI5 более зрелого поколения для Tesla будет выпускать TSMC. Теперь же глава Tesla заявил, что к производству AI5 будут привлечены Samsung и TSMC одновременно, причём с использованием их американских предприятий. Как образно дал понять Маск, чип AI5 по площади кристалла будет соответствовать половине чипов, выпускаемых компаниями Nvidia и AMD. Поскольку Tesla будет единственной компанией, эксплуатирующей чип AI5, при разработке от всех «ненужных» функциональных блоков удалось избавиться. Дизайн чипа удалось оптимизировать и упростить, это также ускорило его разработку, по словам Маска. Помимо графической подсистемы и сигнальных процессоров, были упразднены и другие части чипа. В итоге, как утверждает Маск, AI5 обеспечит превосходство над конкурентами по соотношению производительности и себестоимости буквально в десять раз. «Nvidia проделала потрясающую работу, имея дело практически с невозможным в реализации набором требований, но в нашем случае мы рассчитываем на радикальное упрощение», — пояснил Илон Маск. Как известно, миллиардер возглавляет ИИ-стартап xAI, который готов стать крупным клиентом Tesla в части использования специализированных ускорителей ИИ. Сейчас эта компания вынуждена полагаться на ускорители разработки Nvidia. Дженсен Хуанг отправил в Samsung гарантийное письмо — в компании не верят, что Nvidia захочет закупать её HBM3E

09.10.2025 [12:00],

Алексей Разин

В конце сентября стало известно, что после неоднократных попыток удовлетворить требования Nvidia к закупаемой памяти типа HBM3E, южнокорейская Samsung Electronics всё же добилась своего, и получила право снабжать ею данного заказчика. Теперь южнокорейские СМИ сообщают, что соответствующие намерения Nvidia подкрепила письменно в обращении к фактическому руководителю Samsung Ли Чжэ Ёну (Lee Jae-yong).

Источник изображения: Nvidia Издание News1 Korea сообщает, что недавно основатель и руководитель Nvidia Дженсен Хуанг (Jensen Huang) направил председателю совета директоров Samsung Electronics письмо с заверениями о готовности на регулярной основе закупать у этого поставщика 12-ярусные микросхемы HBM3E для использования в составе ускорителей семейства GB300. По данным источника, попытки Samsung встроиться в цепочку поставок Nvidia с конкретным типом памяти длились около года и семи месяцев. Ещё в марте прошлого года Дженсен Хуанг оставил свой автограф с одобрением на символической пластине с чипом HBM3E производства Samsung, но фактически предлагаемая этой компанией продукция не могла удовлетворить требования Nvidia вплоть до прошлого месяца. Где-то в начале текущего года Samsung предложила Nvidia заметно переработанные чипы HBM3E, после чего процесс сертификации встал на путь к успеху. Впрочем, конкуренты Samsung в этой сфере оказались далеко впереди, поскольку SK hynix начала снабжать Nvidia своими 12-ярусными чипами ещё в сентябре прошлого года, а в феврале текущего к ней присоединилась американская Micron Technology. С точки зрения планов Nvidia, память типа HBM3E приближается к излёту своего жизненного цикла, поэтому много заработать на поставках своих микросхем этого типа Samsung не успеет. Зато Samsung уже предлагает своим клиентам образцы HBM4, и с их сертификацией она может добиться большего успеха, чем с HBM3E. Попутно стало известно, что Samsung закупила у Nvidia около 50 000 ускорителей вычислений. Предполагается, что они понадобятся для развития как собственных решений компании в сфере ИИ, так и реализации совместного проекта с OpenAI по строительству специализированного вычислительного центра на территории Южной Кореи. Карманный ИИ становится массовым: каждый третий смартфон в этом году получит ИИ-ускоритель

01.10.2025 [11:57],

Алексей Разин

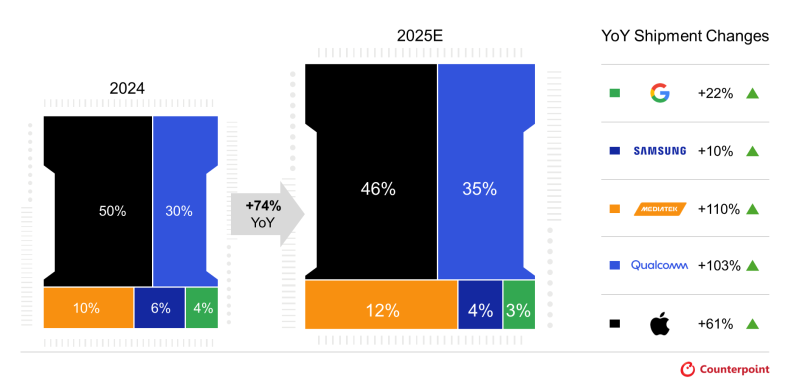

Надежды производителей ПК на скорый рост продаж систем с возможностью локального ускорения ИИ пока не оправдываются, но вот в сегменте смартфонов в этом году количество устройств на основе процессоров с поддержкой генеративного ИИ вырастет на 74 % и достигнет 35 % годового объёма продаж. К такому выводу приходят специалисты Counterpoint Research.

Источник изображения: Qualcomm Technologies В премиальном сегменте, как они утверждают, в этом году 88 % всех отгруженных в этом году чипов для смартфонов будут наделены функциями аппаратного ускорения работы с генеративным искусственным интеллектом. При этом подобные функции проникнут и в смартфоны в ценовом диапазоне от $300 до $499, которые в целом нарастят свою долю с 12 до 38 % рынка. Объёмы поставок ИИ-чипов для смартфонов в среднем ценовом диапазоне утроятся по сравнению с прошлым годом. Как отмечают аналитики, рост объёмов реализации ИИ-чипов по рынку смартфонов в целом на 74 % в текущем году во многом станет возможным именно благодаря распространению продвинутых функциональных возможностей на более низкие ценовые диапазоны. Среди поставщиков подобных процессоров лидировать будет Apple с 46 % рынка, хотя на программном уровне собственная экосистема ИИ у этой компании развита не так сильно, как она хотела бы. Тем не менее, формально процессоры семейства A19 позволяют работать с генеративным ИИ, что позволяет занять ведущие позиции на рынке.

Источник изображения: Counterpoint Research На втором месте окажется Qualcomm с 35 % рынка, на третьем MediaTek с 12 %. Samsung с процессорами собственной разработки окажется на четвёртом месте с 4 % рынка, а Google достанутся 3 %. Год назад расстановка сил была другой: Apple (50 %), Qualcomm (35 %), MediaTek (10 %), Samsung (6 %) и Google (4 %) хоть и шли в том же порядке, продемонстрируют разную динамику по итогам текущего года в прогнозах авторов аналитической записки. Google увеличит объёмы поставок своих чипов на 22 %, Samsung прибавит только 10 %, Mediatek окажется лидером по темпам роста с 110 %, а Qualcomm лишь немного уступит ей с 103 %. В то же время, Apple с приростом на 61 % окажется крепким середнячком по динамике, но сохранит за собой лидирующие позиции по доле рынка. В сегменте Android-смартфонов лидером остаётся Qualcomm со своими процессорами, начиная с семейства Snapdragon 8 Gen 3. Компания постепенно проникает и в ценовой диапазон смартфонов от $100 до $299 со своими процессорами, наделёнными ИИ-функциями. В премиальном сегменте поставки ИИ-чипов для смартфонов вырастут на 53 % по итогам текущего года, их доля в сегменте достигнет 88 %. Здесь будут доминировать процессоры Apple A19 и A19 Pro, а также Qualcomm Snapdragon 8 Elite Gen 5 и MediaTek Dimensity 9500. В эту группу также входят процессоры Samsung Exynos, Google Tensor и HiSilicon Kirin 9000. Их внедрение вызовет рост средней цены реализации смартфонов в премиальном сегменте. Кроме того, смартфоны с такими функциональными возможностями в среднем содержат больше чипов. Китай попытается создать ИИ-чипы нового типа, так как подражать США «смертельно опасно»

11.09.2025 [21:13],

Сергей Сурабекянц

Главный советник китайского правительства профессор пекинского Университета Цинхуа Вэй Шаоцзюнь (Wei Shaojun), выступая на форуме в Сингапуре, заявил, что азиатским странам, включая Китай, следует снизить зависимость от универсальных графических процессоров, которые сейчас используются во всём мире для обучения ИИ платформ. По его словам, Китаю требуются чипы ИИ, построенные на собственной архитектуре и не зависящие от технологий Nvidia. Источник изображения: Samsung Вэй, который много лет консультировал высокопоставленных чиновников китайского правительства, признал, что «к сожалению, мы в Азии, включая Китай, подражаем США в разработке алгоритмов и больших моделей». Продолжение этого пути может быть «смертельно опасным» для региона, добавил он. Китаю следует сосредоточиться на создании нового типа чипа, специально предназначенного для разработки крупных моделей, а не продолжать полагаться на архитектуру, изначально разработанную для игр и промышленной графики, добавил Вэй. Он подчеркнул, что Китай по-прежнему активно развивает собственную индустрию по производству микросхем и располагает для этого достаточными средствами, несмотря на годы санкций США. Китайские компании столкнулись с нехваткой ИИ-ускорителей Nvidia из-за экспортных ограничений, введённых США, которые не позволяют китайским компаниям приобретать самые передовые чипы. Собственные технологии производства чипов в Китае пока не позволяют выпускать ускорители ИИ, сопоставимые по производительности с лучшими решениями Nvidia. Однако выход нейросети DeepSeek на мировую арену в начале этого года показал, что китайские компании способны совершенствовать свои алгоритмы ИИ даже на сравнительно слабом оборудовании. В конце июля китайские регуляторы обвинили Nvidia в том, что предназначенные для рынка КНР ускорители H20 имеют функции удалённой блокировки и отслеживания, из-за чего представителям компании пришлось неоднократно опровергать подобные обвинения. Между тем китайские СМИ продолжают продвигать тезис о том, что ускорители Nvidia H20 небезопасны для разработчиков в Китае.

Источник изображения: Nvidia Китайская сторона усиливает работу над импортозамещением, а муниципальные власти крупных китайских городов присоединились к этой работе. Например, в Шанхае установлено требование к 2027 году довести долю китайских ускорителей в муниципальных ЦОД до 70 %, в Пекине этот уровень достигает 100 %, а для округа Гуйян, характеризуемого развитой вычислительной инфраструктурой, планка установлена на уровне 90 %. OpenAI выпустит свой первый ИИ-чип в 2026 году при поддержке Broadcom — последней это сулит $10 млрд

05.09.2025 [05:29],

Алексей Разин

Слухи о намерениях OpenAI представить чип для ускорения вычислений в системах ИИ получили новую жизнь на этой неделе, поскольку компания Broadcom открыто призналась в заключении контракта с таинственным новым клиентом на поставку подобных чипов на общую сумму $10 млрд. Данные чипы выйдут в следующем году.

Источник изображения: Broadcom Издание Financial Times подтвердило, что Broadcom помогла OpenAI разработать профильный чип, и на рынок он выйдет в 2026 году. Вторая из компаний собирается использовать этот компонент для собственных нужд и не предлагать сторонним клиентам. Сотрудничество с Broadcom в этой сфере началось ещё в прошлом году. До этого момента не было известно, когда начнётся массовое производство данного изделия. Для Broadcom стартап OpenAI станет уже четвёртым по счёту клиентом, для которого она разработала ИИ-чип. Акции Broadcom после этих заявлений в сочетании с в целом позитивной отчётностью выросли в цене на 4,5 %. Компания сотрудничала с Google при разработке специализированных тензорных процессоров последней. По мнению аналитиков HSBC, следующий год будет характеризоваться ростом продаж специализированных ИИ-чипов, тогда как универсальные решения типа предлагаемых Nvidia уже не смогут продемонстрировать высокой динамики роста выручки. Глава OpenAI Сэм Альтман (Sam Altman) в прошлом месяце выразил готовность увеличить вычислительные мощности компании вдвое за ближайшие пять месяцев. «Продажи HBM от Samsung достигли дна»: SK hynix стала крупнейшим производителем памяти в мире

31.07.2025 [14:29],

Анжелла Марина

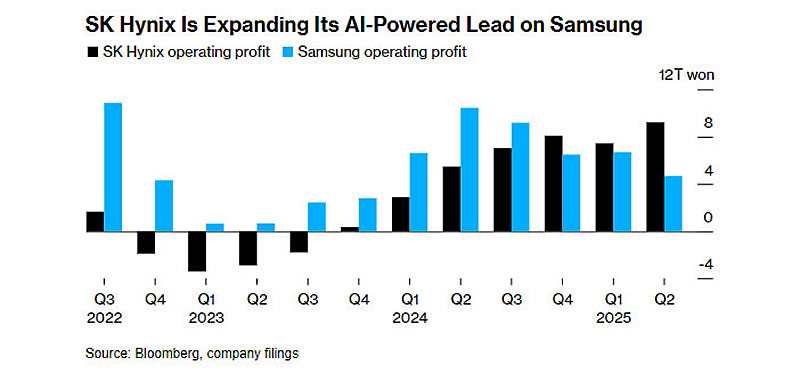

SK hynix впервые обошла Samsung Electronics по объёму выручки от производства памяти, став крупнейшим в мире поставщиком, сообщает Bloomberg. Это произошло на фоне роста спроса на компоненты для систем искусственного интеллекта, где позиции SK hynix оказались более сильными.

Источник изображения: SK hynix Выручка Samsung от продаж компьютерной памяти, включая DRAM и NAND, за период с апреля по июнь составила 21,2 триллиона вон (около $15,2 млрд), что ниже, чем 21,8 триллиона вон, зафиксированных у SK hynix неделей ранее. Основной вклад в успех компании, базирующейся в Ичхоне (Южная Корея) внесла высокопроизводительная память HBM (High-Bandwidth Memory), используемая в ИИ-чипах. По данным аналитической компании Counterpoint Research, доля SK hynix на рынке HBM достигла 62 %, в то время как Samsung контролирует лишь 17 % этого сегмента и до сих пор не получила одобрения от Nvidia на поставку своей самой передовой версии HBM.

Источник изображения: Bloomberg МС Хван (MS Hwang), директор по исследованиям в Counterpoint, отметил, что траектории роста двух южнокорейских производителей начали расходиться в первой половине 2024 года на фоне повышенного спроса на продукцию Nvidia и связанную с ней память HBM. Он также указал, что падение продаж HBM у Samsung, вероятно, замедлилось. «Новость заключается в том, что продажи HBM-памяти Samsung, похоже, достигли своего дна», — сказал Хван. Для справки: HBM — это технология вертикального объединения нескольких слоёв DRAM, обеспечивающая высокую пропускную способность. Сегодня HBM рассматривается как критически важная составляющая для производительности современных компьютеров и серверов. Samsung предрекли падение прибыли на 39% из-за слабых продаж памяти для ИИ-систем

07.07.2025 [09:49],

Анжелла Марина

Аналитики ожидают от Samsung Electronics сильного снижения финансовых показателей. По итогам второго квартала операционная прибыль компании может упасть на 39 %, до 6,3 триллиона вон ($4,62 млрд). Это будет самый низкий уровень дохода за последние шесть кварталов и четвёртое подряд снижение, сообщает Reuters. Спад объясняется задержками в поставках передовой памяти HBM3E для Nvidia.

Источник изображения: Samsung Electronics Аналитики отмечают, что Samsung столкнулась с растущим давлением со стороны таких конкурентов, как SK hynix и Micron, которые активно наращивают продажи чипов для ИИ-систем. В то же время Samsung остаётся зависимой от китайского рынка, где ограничения США на поставку высокотехнологичных компонентов замедляют рост выручки. Также процесс сертификации новых чипов HBM3E в Nvidia продолжается медленнее, чем ожидалось. Рю Ён Хо (Ryu Young-ho), старший аналитик NH Investment & Securities, заявил, что доходы от этих чипов во втором квартале, вероятно, остались на прежнем уровне и добавил, что массовые поставки новых чипов Samsung в Nvidia вряд ли начнутся в этом году. Ранее компания сообщала, что рассчитывала завершить тестирование своих HBM3E чипов к июню, однако официального подтверждения прохождения сертификации предоставлено не было. При этом в июне стало известно, что Samsung начала поставлять эти чипы американской компании AMD. Одновременно, несмотря на трудности в сегменте полупроводников, аналитики прогнозируют стабильные продажи смартфонов Samsung и, как отмечается, рост интереса к продукции не в малой степени связан с ожиданием возможных американских тарифов на импортные телефоны. В Китае начали выпускать первые в мире недвоичные ИИ-чипы, как ответ на санкции США

09.06.2025 [12:09],

Дмитрий Федоров

Китай начал первое в мире массовое производство недвоичных ИИ-чипов на базе гибридной логики, совмещающей бинарный и стохастический подход. Новые процессоры предназначены для смарт-дисплеев, авиационных систем и навигации, и представляют собой стратегический ответ на санкции США в сфере полупроводников.

Источник изображения: Milad Fakurian / Unsplash Команда учёных под руководством профессора Ли Хунгэ (Li Hongge) из Пекинского аэрокосмического университета (Beihang University) официально представила первый в мире недвоичный ИИ-чип, ориентированный на массовое промышленное применение. Уникальность решения заключается в применении гибридной вычислительной архитектуры, что позволяет добиться высокой отказоустойчивости и энергоэффективности. Профессор Ли объясняет, что современные чипы сталкиваются с двумя критическими ограничениями: энергетическим и архитектурным барьером. Первый возникает из-за противоречия между высокой плотностью передачи данных и возросшими требованиями к энергозатратам, а второй обусловлен несовместимостью новых некремниевых решений с традиционными CMOS-архитектурами (комплементарными металл-оксидными полупроводниками). Именно эти фундаментальные ограничения не позволяют вычислительным системам эффективно масштабироваться и сдерживают внедрение новых парадигм в области ИИ. Решение, предложенное китайскими учёными, основывается на гибридной системе под названием Hybrid Stochastic Number (HSN). Она сочетает традиционные бинарные числа — основанные на жёстких логических 0 и 1 — с вероятностными величинами, используемыми в стохастической логике. Такой подход позволяет работать не с конкретными значениями, а с диапазонами вероятностей. В результате снижается аппаратная нагрузка, упрощается логика на уровне транзисторов и увеличивается устойчивость систем к ошибкам. Это особенно важно для управления в реальном времени, где очень важны отказоустойчивость, надёжность и энергоэффективность. В отличие от большинства существующих чипов, HSN-архитектура не требует строгой точности при обработке каждого бита информации. Это открывает путь к созданию интеллектуальных решений, способных работать в условиях высокой неопределённости, помех, сбоев в питании или неполных данных. Подобные характеристики востребованы в сенсорных интерфейсах, навигационных и системах управления полётами и даже в военной сфере. Использование стохастических алгоритмов в аппаратной логике делает возможным более глубокое моделирование процессов окружающей среды, чем традиционные системы. Производственные мощности размещены в провинции Хэбэй. Первая партия чипов уже прошла тестирование в авиационных тренажёрах, сенсорных платформах и экспериментальных навигационных системах. Массовое внедрение технологии ожидается во II квартале 2026 года. По информации издания Guangming Daily, переход к внедрению проходит поэтапно, с прицелом на интеграцию как в полностью новые, так и в существующие архитектуры. При этом адаптация возможна без полной переделки цифровой инфраструктуры, благодаря совместимости с протоколами передачи данных и гибкости логического слоя. Инженеры подчёркивают, что разработка китайского недвоичного ИИ-чипа не случайно совпала с жёсткими ограничениями США на экспорт полупроводниковых технологий. По сути, HSN-чип стал технополитическим ответом на санкционное давление и инструментом формирования цифрового суверенитета Китая. Технология позволяет Поднебесной снизить зависимость от поставок кремниевых чипов и выйти на путь создания собственной инфраструктуры для ИИ, которая может применяться не только в авиации и промышленности, но и в периферийных вычислениях, автономных автомобилях, робототехнике и даже в мобильных устройствах следующего поколения. Nvidia утверждает, что консоль Switch 2 использует ИИ для улучшения игрового процесса

04.06.2025 [05:04],

Алексей Разин

На этой неделе в продажу поступит долгожданная игровая консоль Nintendo Switch 2, и руководитель косвенно причастной к её созданию компании Nvidia Дженсен Хуанг (Jensen Huang) заранее поделился некоторыми её особенностями. По его словам, новинка получила выделенные ИИ-процессоры, которые в реальном времени улучшают игровой процесс.

Источник изображения: Nintendo По словам основателя Nvidia, на которые ссылается CNBC, консоль Nintendo Switch 2 обеспечивает прорыв на трёх направлениях. Во-первых, это самая продвинутая графика для мобильного устройства, которая подразумевает полную аппаратную поддержку трассировки лучей. Во-вторых, это технология HDR для более ярких сцен и более глубоких теней. Наконец, Switch 2 наделена архитектурой, которая поддерживает обратную совместимость. Отдельно Дженсен Хуанг описал возможности консоли в сфере использования искусственного интеллекта: «Специальные процессоры чётче очерчивают, оживляют и улучшают игровой процесс в реальном времени». По словам главы Nvidia, Switch 2 является чем-то большим, чем новая игровая консоль. Он назвал её «новой главой, достойной видения Иваты-сан», имея в виду бывшего генерального директора Nintendo Сатору Ивату (Satoru Iwata), который не дожил до момента выхода исходной версии Switch. Nvidia выпустит ИИ-ускоритель B30 специально для Китая взамен запрещённого H20

02.06.2025 [16:52],

Дмитрий Федоров

Nvidia разрабатывает специализированный ИИ-ускоритель B30, соответствующий требованиям экспортного контроля США и предназначенный для поставок в Китай. Новый графический ускоритель (GPU) построен на архитектуре Blackwell и, вероятно, получит поддержку NVLink для объединения нескольких GPU в вычислительные кластеры. Эта разработка стала прямым ответом Nvidia на запрет, введённый правительством США на экспорт в КНР чипов линейки H20 на архитектуре Hopper.

Источник изображений: Nvidia Главная особенность будущего B30 — поддержка масштабирования через объединение нескольких GPU. Эта функция, по мнению аналитиков, может быть реализована либо с применением технологии NVLink, либо посредством сетевых адаптеров ConnectX-8 SuperNIC с поддержкой PCIe 6.0. Несмотря на то, что Nvidia официально исключила NVLink из потребительских GPU начиная с предыдущего поколения, существует вероятность, что компания модифицировала кристаллы GB202, используемые в RTX 5090, и повторно активировала NVLink в их серверной конфигурации. Изначально будущий GPU фигурировал под различными названиями — от RTX Pro 6000D до B40, а теперь B30. Это, вероятно, указывает на наличие нескольких вариантов в рамках новой серии BXX, различающихся по уровню производительности и соответствию требованиям экспортного регулирования. Все модификации предполагается строить на чипах GB20X с использованием памяти GDDR7. Примечательно, что GB20X — это те же кристаллы, которые лежат в основе потребительских видеокарт линейки RTX 50. Таким образом, Nvidia не создаёт принципиально новый чип, а адаптирует уже существующую архитектуру для обхода ограничений.

Nvidia RTX PRO 6000 Blackwell Workstation Edition На выставке Computex в Тайбэе Nvidia представила серверные системы RTX Pro Blackwell, рассчитанные на установку до восьми GPU RTX Pro 6000. Эти ускорители соединяются между собой через сетевые адаптеры ConnectX-8 SuperNIC, оснащённые встроенными PCIe 6.0-коммутаторами, обеспечивающими прямое взаимодействие между GPU. Та же схема коммуникации применяется при объединении двух суперчипов DGX Spark, которые служат основой для корпоративных и облачных ИИ-решений. Вероятнее всего, аналогичная архитектура будет использована и в B30. Комментируя запрет на экспорт H20, бессменный руководитель Nvidia Дженсен Хуанг (Jensen Huang) подчеркнул, что компания прекращает разработку альтернатив на архитектуре Hopper и сосредотачивается на Blackwell. Правительство США, в свою очередь, заявило, что у H20 — слишком высокая пропускная способность памяти и интерфейсных соединений, что делает чип неприемлемым для свободного экспорта. Эти параметры, по мнению регуляторов, создают риск использования ускорителей в составе китайских суперкомпьютеров, способных обслуживать оборонные и военные программы.

Nvidia H200 Tensor Core GPU Ситуация с экспортными ограничениями не ограничивается только Nvidia. Американские регуляторы оказывают серьёзное влияние на весь рынок высокопроизводительных ИИ-решений. Компания AMD, например, оценивает потенциальные убытки от запрета на экспорт ускорителей MI308 в размере до $800 млн. Эта оценка была представлена сразу после вступления в силу новых ограничений. На протяжении последних лет Nvidia ведёт постоянную борьбу с регуляторами, сталкиваясь с чередой запретов и требований, где каждое новое поколение чипов, от A100 до H100 и H20, подвергается новым формам контроля. Хуанг, критикуя действующую экспортную политику США, назвал её «провалом» и предупредил о рисках стратегического отставания. По его мнению, такие меры лишь подталкивают китайские технологические компании, включая Huawei, к активному развитию собственных ИИ-решений. В результате они могут не только догнать, но и перегнать американских техногигантов, сформировав собственные стандарты, которые в будущем могут стать основой глобальной ИИ-инфраструктуры. Это создаёт угрозу потери влияния США не только в технологической, но и в военно-стратегической сфере. Нестабильность, перегрев и протечки заставили Nvidia упростить дизайн современных ИИ-серверов

28.05.2025 [14:16],

Алексей Разин

Технические проблемы преследовали семейство ускорителей Nvidia Blackwell с конца прошлого года, в результате чего партнёры компании не могли обеспечить довольно быструю рыночную экспансию решений серии GB200, но теперь все трудности позади. Nvidia сделала выводы из этого опыта, упростив конструкцию GB300 с целью предотвращения возможных проблем с наращиванием объёмов производства.

Источник изображения: Nvidia Издание Financial Times напоминает, что стоечные системы на основе ускорителей Blackwell первого поколения страдали от целого ряда технических проблем. Во-первых, содержались дефекты в компоненте, отвечающем за скоростной обмен данными между отдельными чипами. Во-вторых, сообщалось о перегреве компонентов в плотно скомпонованных системах. В-третьих, жидкостная система охлаждения в некоторых случаях давала течь. По словам опрошенных Financial Times источников, наблюдавшиеся ещё два или три месяца назад технические проблемы с выпуском стоечных систем на базе Blackwell удалось решить при активном содействии партнёров Nvidia. Теперь объёмы их выпуска наращиваются без особых затруднений. В третьем квартале Nvidia собирается наладить выпуск систем следующего поколения, относящихся к серии GB300. От некоторых изначальных технических решений компания предпочла отказаться ради более высокой надёжности. В частности, перспективный дизайн печатных плат Cordelia предусматривал возможность простой замены отдельных графических процессоров при обслуживании системы. Тем не менее, сопутствующие риски вынудили Nvidia отказаться от него в пользу существующего дизайна печатных плат — Bianca, который уже применяется при производстве GB200 и проверен временем. В целом, Nvidia полна решимости когда-нибудь внедрить дизайн Cordelia, но пока этот шаг отложен до момента выхода на рынок ИИ-ускорителей следующего поколения. За счёт нынешних уступок в дизайне Nvidia рассчитывает быстрее нарастить объёмы выпуска GB300, и это позволит ей быстрее компенсировать потери на китайском рынке, вызванные запретом со стороны США на поставки ускорителей семейства H20. Аналитики Bank of America предположили, что квартальная норма прибыли Nvidia в результате санкций против Китая снизится с 71 до 58 %. Отчёт за первый квартал текущего фискального года компания опубликует на этой неделе. Со следующего года в школах и детских садах ОАЭ всех детей начнут готовить к ИИ-будущему

04.05.2025 [22:03],

Анжелла Марина

Объединённые Арабские Эмираты (ОАЭ) намерены внедрить искусственный интеллект в школьную и дошкольную программу уже в 2025 году, став одной из первых стран региона, которая начнёт обучать детей работе с ИИ с раннего возраста. Власти также активно инвестируют в ИИ-инфраструктуру с надеждой на то, что новые поколения специалистов укрепят позиции страны на мировой арене.

Источник изображения: David Rodrigo / Unsplash С 2025–2026 учебного года в государственных школах ОАЭ появится курс по искусственному интеллекту для всех возрастов, начиная от детского сада и заканчивая выпускными классами. Как сообщает Bloomberg, программа включает как технические аспекты, так и практическое применение технологии. Таким образом, Эмираты присоединятся к растущему числу стран, активно внедряющих ИИ в систему образования. Месяцем ранее Китай также объявил о похожей инициативе для учащихся начальной и средней школы. Страна уже инвестировала миллиарды долларов в дата-центры для обучения ИИ-моделей и создала специальный фонд, который может вырасти до $100 млрд в ближайшие годы. Глава OpenAI Сэм Альтман (Sam Altman) при этом заявил, что ОАЭ могут стать «регуляторной песочницей» для тестирования ИИ-технологий, а затем задавать глобальные стандарты их использования. На международной арене также усиливается интерес к технологическому потенциалу Эмиратов. По данным СМИ, США рассматривают возможность смягчения ограничений на поставки чипов компании Nvidia в ОАЭ, что может значительно ускорить развитие местной ИИ-индустрии и усилить позиции страны в регионе. Решение может быть принято до визита президента Дональда Трампа (Donald Trump) в середине мая, который планирует остановиться в ОАЭ по пути в Саудовскую Аравию и Катар. В рамках более широкого стратегического сотрудничества ОАЭ ранее объявили о планах инвестировать до $1,4 трлн в течение следующего десятилетия в энергетику, полупроводники, ИИ-инфраструктуру и производство на территории США, а внедрение ИИ в систему школьного образования станет одним из элементов масштабной стратегии. |