|

Опрос

|

реклама

Быстрый переход

Meta✴ будет разрабатывать собственные ИИ-ускорители

05.03.2026 [06:58],

Алексей Разин

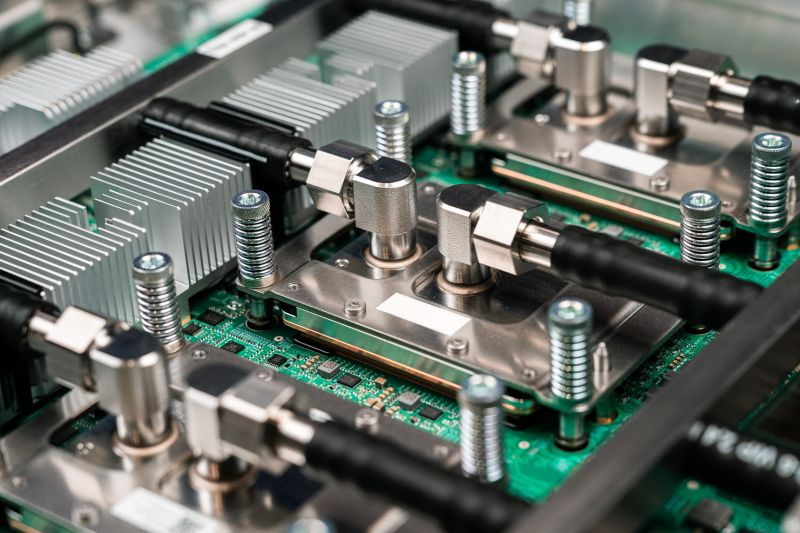

Финансовый директор Meta✴✴ Platforms Сьюзан Ли (Susan Li) на технологической конференции Morgan Stanley заявила, что компания продолжит разрабатывать собственные процессоры, оптимизированные под вычислительные нагрузки, используемые компанией. Активное сотрудничество с поставщиками готовых ускорителей сторонней разработки не отменяет актуальности создания собственных чипов.

Источник изображения: Unsplash, Igor Omilaev «Некоторые из наших вычислительных нагрузок очень специфичны. Нагрузки, связанные с сортировкой и рекомендациями, присутствовали изначально, и именно в этой сфере мы наиболее активно применяли собственные чипы. Мы надеемся, что сможем расширить их применение со временем, включая и процесс обучения ИИ-моделей», — заявила представительница компании. Хотя Meta✴✴ Platforms и не является провайдером облачных услуг, она обладает одним из крупнейших парков центров обработки данных, используемым для собственных нужд. За последние недели она заключила крупные сделки с Nvidia и AMD, которые подразумевают поставку ускорителей для этой вычислительной инфраструктуры. Компания также договорилась об аренде ускорителей Google, поэтому с аппаратной точки зрения Meta✴✴ оказалась буквально всеядной. При этом продолжается разработка и собственных процессоров. По словам Сьюзан Ли, компания применяет разные виды чипов для разных видов вычислительной нагрузки: «Опираясь на то, что мы знаем сегодня и наши текущие потребности, какой из чипов является лучшим для каждого случая, по нашему мнению? Созданный на заказ является большой частью этого». ByteDance разрабатывает фирменный ИИ-чип — производство планируется поручить Samsung

11.02.2026 [14:30],

Алексей Разин

Крупные игроки сегмента ИИ всё чаще демонстрируют заинтересованность в создании собственных ускорителей вычислений, китайская ByteDance не является исключением, как отмечает Reuters со ссылкой на собственные источники. Выпуском разработанного ByteDance чипа может заняться Samsung, которая предоставит первые образцы уже в конце марта.

Источник изображения: ByteDance В этом году, как ожидается, Samsung Electronics намерена в этом году выпустить не менее 100 000 чипов, разработанных ByteDance для ускорения задач, связанных с инференсом в системах искусственного интеллекта. В дальнейшем объёмы производства могут быть увеличены до 350 000 экземпляров в год. Samsung в данном случае выбрана в качестве подрядчика не только по причине наличия у неё контрактных мощностей по выпуску логических чипов, но и наличию собственного производства памяти, которая неизбежно потребуется для создания ИИ-ускорителей ByteDance. Представители последней назвали данную информацию некорректной, а сотрудники Samsung подобные слухи комментировать отказались. Попытки приступить к самостоятельной разработке чипов ByteDance предпринимает с 2022 года, когда она наняла профильных специалистов. В июне 2024 года агентство Reuters сообщало, что ByteDance в этой сфере сотрудничает с Broadcom, а выпускать результирующие чипы будет тайваньская TSMC. Крупные игроки китайского рынка в лице Alibaba и Baidu давно располагают чипами собственной разработки, которые применяют для ускорения вычислений в своей инфраструктуре. Проект ByteDance по разработке собственного чипа носит условное обозначение SeedChip. На закупки необходимого для развития своей ИИ-инфраструктуры оборудования ByteDance в этом году потратит $22 млрд, более половины этой суммы будет направлено на приобретение ускорителей Nvidia, включая новейшую для Китая модель H200. Часть суммы будет потрачена на создание собственного ИИ-чипа. По мнению руководства ByteDance, вложения в сферу ИИ принесут пользу всем подразделениям китайской компании. Уже в этом году китайские ИИ-ускорители займут до 80 % на местном рынке

16.01.2026 [14:54],

Алексей Разин

В прошлом году, говоря о необходимости возобновить поставки H20 в Китай, глава и основатель Nvidia сперва заявил, что за несколько лет доля компании на местном рынке сократилась с 95 до 50 %, а потом и вовсе признался в полной потере позиций. Сторонние эксперты ситуацию оценивают не столь эмоционально, но считают, что в этом году Nvidia сможет претендовать не более чем на 8 % китайского рынка ИИ-ускорителей.

Источник изображения: Moore Threads Technology Об этом сообщает издание Nikkei Asian Review, ссылающееся на комментарии аналитиков Bernstein. В позапрошлом году, по их словам, Nvidia контролировала 66 % рынка ИИ-ускорителей в Китае. Санкции США, активность местных конкурентов и политика китайских властей в сфере импортозамещения, по мнению экспертов, могут привести к тому, что в текущем году до 80 % местного рынка достанется китайским поставщикам ускорителей, а Nvidia сможет претендовать не более чем на 8 %. По всей видимости, оставшиеся примерно 12 % поделят между собой AMD и Intel. На конференции для разработчиков в Пекине, которая прошла в предыдущем месяце, китайская компания Moore Threads представила новую архитектуру Huagang, а также линейки ускорителей Huashan и графических адаптеров Lushan. В массовое производство они отправятся в этом году. По словам представителей Moore Threads, если ИИ-ускорители Huashan по уровню быстродействия близки к массовым моделям Nvidia, то Lushan вообще превосходят мировые аналоги. Как заявляет генеральный директор Чжан Цзяньчжон (Zhang Jianzhong), эти новые продукты Moore Threads соответствуют потребностям местных производителей, им больше нет нужды рассчитывать на поставки передовых продуктов из-за границы. На этой неделе Дональд Трамп (Donald Trump) подписал указ, по условиям которого ввозимые в США для дальнейшей отправки в Китай ускорители Nvidia будут облагаться 25-процентной импортной пошлиной. Можно догадаться, что для китайских заказчиков они из-за этого станут дороже. Кроме того, китайские власти накладывают свои ограничения на поставку тех же H200 в Поднебесную, и местным разработчикам невольно приходится больше полагаться на отечественные ускорители. Китайские власти пытаются поддерживать местных разработчиков ИИ-ускорителей. Помимо Huawei Technologies, в пятёрку лидеров входят Moore Threads, MetaX, Biren Technology и Suiyuan Technology (Enflame). Если не считать Huawei и Enflame, все эти компании недавно вышли на биржу в Китае, чтобы привлечь дополнительные средства к разработке ИИ-ускорителей, хотя и Enflame намеревается сделать это в обозримом будущем. Кроме того, Baidu и Kunlunxin намереваются представить до 2030 года не менее пяти ИИ-чипов. Помимо Huawei, над созданием собственных ускорителей работает и Cambricon Technologies. Выпускать чипы для китайских ускорителей вынуждена компания SMIC, поскольку как только профильные компании добиваются успеха в создании конкурентоспособных решений, они тут же попадают под американские санкции и лишаются доступа к конвейеру тайваньской TSMC. По мнению китайских экспертов, ускорители местного происхождения в своём развитии достигли того уровня, когда их уже удобно применять. Перед китайской отраслью ещё стоит немало вызовов, но перелом в пользу импортозамещения уже наметился, как считают некоторые эксперты. TSMC может начать выпуск 3-нм ИИ-чипов OpenAI Titan уже в этом году — второе поколение перейдёт на 1,6 нм

15.01.2026 [12:29],

Алексей Разин

Одержимый идеей активного развития вычислительной инфраструктуры ИИ глава OpenAI Сэм Альтман (Sam Altman) настаивает не только на строительстве центров обработки данных в огромных количествах, но и на выпуске специализированных чипов для них, которые стартап готов разработать при поддержке Broadcom. По слухам, их выпуском совсем скоро может заняться TSMC.

Источник изображения: OpenAI Об этом сообщает тайваньское издание Commercial Times, уточняя, что ИИ-чипы собственной разработки OpenAI нарекла условным обозначением Titan, а их первое поколение уже к концу этого года TSMC начнёт выпускать с использованием техпроцесса N3. В планы партнёров входит и выпуск второго поколения чипов, которое будет производиться по технологии A16. Разработка Titan 2 начнётся во второй половине текущего года, помогать OpenAI в этой сфере в обоих случаях будет компания Broadcom. Сейчас вычислительная инфраструктура OpenAI в основном полагается на готовые решения Nvidia и AMD, но по мере её масштабирования может появиться смысл создать узкоспециализированные ускорители, и в этом процессе компания намеревается принять непосредственное участие. Осталось только убедиться в том, что та же TSMC сможет обеспечить OpenAI достаточными объёмами производства этих чипов. Не забывает OpenAI и о разработке конечных пользовательских устройств для взаимодействия с ИИ. По слухам, она собирается предлагать наушники с условным обозначением Sweetpea на основе 2-нм процессора Samsung семейства Exynos. Помимо локальной обработки запросов, наушники будут взаимодействовать с облачной вычислительной инфраструктурой по схеме подписки с регулярной ежемесячной платой. Рынок полупроводников вырос на 21 % до $793 млрд в прошлом году — Intel вылетела из тройки лидеров

13.01.2026 [14:21],

Алексей Разин

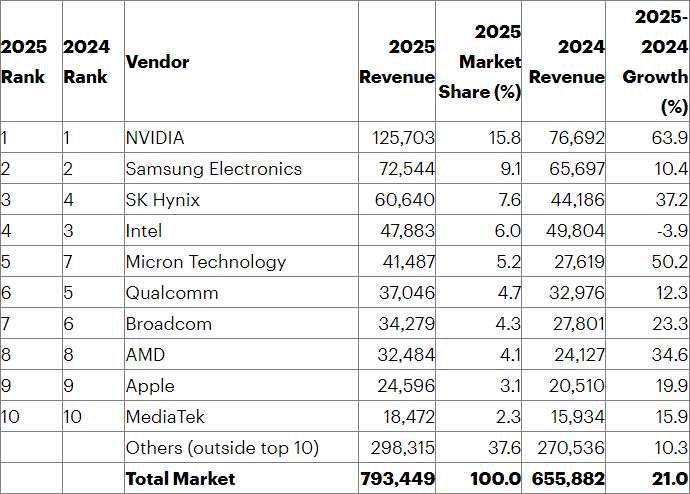

Эксперты Gartner уже подвели итоги прошлого года по направлению рынка полупроводниковой продукции, сообщив о росте совокупной выручки на 21 % до $793 млрд. При этом связанная с поставками ИИ-ускорителей выручка в полупроводниковом сегменте превысила по итогам года $200 млрд, как отмечается в свежем отчёте Gartner. В текущем году, как считает источник, расходы участников рынка на развитие ИИ-инфраструктуры могут превысить $1,3 трлн. Компания Nvidia предсказуема не только стала лидером по сумме выручки от реализации полупроводниковых компонентов, но и продемонстрировала максимальные темпы её роста. В частности, годовая выручка Nvidia выросла на 63,9 % до $125,7 млрд, позволив компании впервые в истории наблюдений Gartner преодолеть рубеж в $100 млрд годовой выручки среди игроков этого сегмента. От ближайшего конкурента в лице Samsung Electronics её теперь отделяют $53 млрд выручки. По сути, именно Nvidia на 35 % определила рост выручки всей полупроводниковой отрасли в прошлом году. Samsung Electronics сохранила за собой второе место, но её выручка за прошлый год увеличилась всего на 10,4 % до $72,5 млрд. Высокие цены на память помогли ей увеличить выручку на профильном направлении на 13 %, а вот за пределами рынка памяти выручка Samsung даже сократилась на 8 %. В спину Samsung предсказуемо дышит SK hynix, которая добралась до третьего места в рейтинге, увеличив свою годовую выручку на 37,2 % до $60,6 млрд. Прежде всего, благодарить за это она должна высокие объёмы продаж памяти HBM для ИИ-серверов и ускорителей.

Источник изображения: Gartner Intel сползла с третьего места на четвёртое, и только она продемонстрировала снижение выручки среди компаний первой десятки. Годовая выручка компании упала на 3,9 % до $47,9 млрд. Конкурирующая AMD, кстати, сохранила за собой восьмое место с 2024 года, но свою выручку увеличила сразу на 34,9 % до $32,5 млрд. На пятом месте оказалась перескочившая сразу через две позиции Micron Technology, которая увеличила годовую выручку на 50,2 % до $41,5 млрд. Это ещё одно подтверждение того, что на буме ИИ неплохо зарабатывают именно производители памяти, потому что все три крупнейших игрока рынка попали в первую пятёрку. Интересно, что не выпускающая чипы самостоятельно Apple в этом рейтинге заняла девятое место, как и годом ранее, а её выручка от их реализации увеличилась почти на 20 % до $24,6 млрд. В прошлом году HBM формировала 23 % выручки на рынке DRAM, что в денежном выражении превышает $30 млрд. Чипы для ИИ-ускорителей обеспечили более $200 млрд выручки своим поставщикам. К 2029 году, по прогнозам Gartner, те или иные типы ИИ-чипов будут формировать более половины всей выручки на рынке полупроводниковых компонентов. Отдельно отметим, что поставщики чипов за пределами первой десятки контролировали 37,6 % мировой выручки в прошлом году, они сообща получили $298,3 млрд, что соответствует увеличению выручки на 10,3 % относительно результатов 2024 года. 4 ZOPS производительности: Intel похвалилась поставками 100 млн ПК на процессорах с ИИ-ускорителями

08.01.2026 [12:43],

Алексей Разин

Вопреки ожиданиям разработчиков процессоров, появление на рынке моделей с функцией локального ускорения работы с ИИ не стало стимулом к росту спроса в желаемых масштабах, а дорожающая память только усугубила ситуацию с продажами ПК. Это не мешает Intel доложить о поставках на рынок 100 млн ПК с функциями локального ускорения ИИ.

Источник изображения: Intel Как поясняет ресурс PCGamer, на CES 2026 корпорация Intel сообщила о преодолении данного рубежа в течение двух предыдущих лет, напомнив, что соответствующими функциями оснащены процессоры Meteor Lake и Lunar Lake для ноутбуков. Помимо чисто количественной характеристики, понятной для восприятия, представители Intel обратились к более абстрактной величине. Пользовательская база таких ПК, по данным Intel, измеряется четырьмя ZOPS с точки зрения быстродействия. Это четыре миллиарда триллионов операций (TOPS) в секунду. При этом Intel не выделяет, какая часть этого вычислительного ресурса на практике используется именно для работы с искусственным интеллектом. Представители Intel признали, что работающие с плавающей запятой блоки вычислений десятилетиями присутствовали в составе центральных процессоров, но они не находили широкого применения. Триггером к экспансии использования ИИ-ПК, по их мнению, станет популярность Copilot+ компании Microsoft. Как только эта технология начнёт активно и повсеместно применяться, все «дремлющие» вычислительные ресурсы ИИ-ПК окажутся востребованными и полезными. Дженсен Хуанг объяснил на CES 2026, почему SRAM не вытеснит дорогую HBM в ИИ-ускорителях

08.01.2026 [06:52],

Анжелла Марина

Глава Nvidia Дженсен Хуанг (Jensen Huang) объяснил, почему SRAM не заменит высокоскоростную память HBM в системах искусственного интеллекта. Выступая на сессии вопросов и ответов в рамках CES 2026 в Лас-Вегасе (США), он ответил на предположение о возможном отказе компании от дорогостоящей HBM в пользу более дешёвой компонентной базы.

Источник изображения: Tom's Hardware Как пишет Tom's Hardware, Хуанг изложил видение, согласно которому ключевым требованием для аппаратного обеспечения ИИ является не узкая специализация, а гибкость, которую как раз и обеспечивает память HBM. Главный его аргумент строится вокруг нестабильной и постоянно меняющейся природы рабочих нагрузок ИИ. Модели быстро эволюционируют, внедряются новые архитектуры и модальности, что делает оптимизацию оборудования под одну конкретную задачу малоэффективной в долгосрочной перспективе. Хотя Хуанг признал, что решения с упором на SRAM могут показывать невероятную скорость в определенных сценариях и избегать задержек, присущих внешней памяти, они сталкиваются с жёсткими ограничениями по ёмкости при масштабировании. В контролируемых тестах такие ускорители выглядят привлекательно, но в реальном применении они не могут обеспечить тот баланс пропускной способности и плотности, который даёт HBM. Глава Nvidia также затронул тему открытых ИИ-моделей, чьё распространение, как предполагается, может снизить зависимость от дорогих GPU. Он признал их ценность, но подчеркнул, что открытость архитектуры не отменяет инфраструктурных ограничений. Обучение и обслуживание современных моделей, независимо от лицензии, по-прежнему требуют огромных вычислительных ресурсов и больших объёмов памяти. Более того, развитие открытых моделей с увеличением контекстных окон и добавлением мультимодальности лишь усиливает потребность в высокопроизводительной и гибкой памяти, такой как HBM. Таким образом, позиция Nvidia заключается в том, что разнообразие и постоянная изменчивость рабочих нагрузок ИИ делают универсальность и адаптивность ключевыми экономическими факторами. Специализированные ускорители, ориентированные на конкретные задачи, могут демонстрировать впечатляющие результаты в тестах, но в условиях быстро меняющегося ландшафта ИИ они рискуют устареть. Компания готова мириться с высокой стоимостью HBM и сложностью систем, поскольку это позволяет сохранить возможность адаптации к новым архитектурам моделей и сценариям развёртывания. По мнению Дженсена Хуанга, момент, когда модели стабилизируются настолько, чтобы сделать специализированные решения более выгодными, чем гибкие платформы, ещё не наступил. Nvidia договорилась о сделке с Groq на $20 млрд — крупнейшей в своей истории

25.12.2025 [04:58],

Алексей Разин

Компанию Nvidia сложно уличить в частых и крупных поглощениях, если не считать неудавшуюся попытку приобрести Arm, поэтому сделка с ИИ-стартапом Groq на сумму $20 млрд становится крупнейшей в истории покупателя. Представители Nvidia продолжают настаивать, что сделку с Groq нельзя назвать покупкой в полной мере, но это не так важно.

Источник изображения: Nvidia Как поясняет CNBC, за свои $20 млрд Nvidia получает не только квалифицированных специалистов Groq, но и права на использование её разработок, пусть и на условиях неисключительного лицензирования. Кроме того, зарождающийся облачный бизнес Groq продолжит независимое существование. Nvidia намерена интегрировать разрабатываемые Groq процессоры с низкими задержками в собственную архитектуру «ИИ-фабрик». Они будут применяться в задачах инференса и вычислительных нагрузках в масштабе реального времени. Это уже не первая сделка подобного рода для Nvidia за последние несколько месяцев. В сентябре она потратила более $900 млн для привлечения в свои ряды генерального директора Enfabrica и других специалистов, а также лицензирование технологий этого стартапа. В целом, появление на фоне бума ИИ существенных запасов денежных средств способствовало росту инвестиционной активности Nvidia. В сентябре она договорилась об инвестициях в капитал OpenAI до $100 млрд, но эти взаимоотношения пока не оформлены до конца. В рамках сотрудничества с Intel компания Nvidia также обязалась вложить в её капитал $5 млрд. Groq в этом году собиралась выручить $500 млн и не планировала искать покупателя на свои технологии, но от предложения Nvidia отказываться не стала. Стартап был основан в 2016 году выходцами из Google, которые были причастны к разработке фирменных процессоров TPU. Три месяца назад Groq удалось привлечь $750 млн, оценив тем самым свою капитализацию в $6,9 млрд. Инвесторами в капитал стартапа являются Samsung, Cisco, а также связанная с Дональдом Трампом-младшим 1789 Capital. Генеральный директор Groq Джонатан Росс (Johnathan Ross) и ряд других сотрудников по условиям договорённости с Nvidia перейдут в штат этой компании. При этом Groq формально продолжит независимую деятельность под управлением своего финансового директора Саймона Эдвардса (Simon Edwards). Инвесторы сходят с ума от ИИ: акции разработчика ИИ-чипов MetaX взлетели в восемь раз сразу после IPO

17.12.2025 [12:33],

Алексей Разин

Публичное размещение акций является традиционным способом привлечения капитала, и для китайских разработчиков ИИ-чипов сейчас наступил благоприятный период для выхода на IPO, поскольку диктуемый властями страны курс на импортозамещение сулит высокий спрос на их продукцию. Акции MetaX вслед за первичным размещением на бирже выросли в цене на 700 %, подтверждая эту традицию.  Как уже отмечалось ранее, конкурирующая Moore Threads, которую считают китайским конкурентом Nvidia, недавно дебютировала на бирже, продемонстрировав рост котировок своих акций на 400 %. Основанная выходцем из AMD в 2020 году, MetaX разрабатывает не только ускорители вычислений на базе GPU, но и специализированные процессоры (ASIC). По итогам IPO ей удалось привлечь почти $600 млн, а количество желающих купить её акции в 4000 раз превысило доступную квоту. Пока стартап остаётся убыточным, но благодаря инициативам китайских властей в сфере импортозамещения ускорителей чипов планирует удвоить выручку в текущем году и выйти на безубыточность в следующем году. Пока MetaX контролирует не более 1 % китайского рынка компонентов для инфраструктуры ИИ. Конкуренты тоже не стоят на месте. В конце ноября Moore Threads смогла привлечь $1,1 млрд, на этой неделе разрешение на размещение акций в Гонконге получила Biren Technology, а принадлежащая Baidu компания Kunlunxin также планирует разместить свои акции на этой площадке. В сегменте ASIC компании MetaX приходится конкурировать с Cambricon, HiSilicon (Huawei), Kunlunxin (Baidu) и T-Head (Alibaba). В сегменте GPU её конкурентами являются не только Moore Threads и Biren, но и Hygon Information Technology. Аналитики считают, что на фоне ажиотажа котировки акций новоиспечённых китайских эмитентов завышены, но в определённой перспективе даже покупка их акций по текущим ценам может себя оправдать. Apple готовит собственные ИИ-чипы для серверов — Broadcom стала помощником в их создании

17.12.2025 [10:17],

Алексей Разин

История компании Apple показывает, что она изначально внедряет новые технологии, полагаясь на компоненты сторонних поставщиков, но когда рынок формируется и крепнет, переходит к их замене на чипы собственной разработки. В случае с чипами для вычислительной инфраструктуры ИИ, как ожидается, Apple полагается на сотрудничество с Broadcom.

Источник изображения: Broadcom Напомним, последняя из компаний в последнее время активно привлекает новых клиентов на направление специализированных чипов для инфраструктуры ИИ. Помимо Google, взаимодействовать на этом направлении Broadcom готова и с Anthropic, а ещё руководство этого поставщика чипов недавно пояснило, что количество профильных клиентов достигло четырёх, а в прошлом квартале к ним присоединился пятый. Его имя до сих пор не названо, но некоторые источники полагают, что Apple также может обратиться за помощью к Broadcom для разработки ИИ-чипов для собственной инфраструктуры. Издание Economic Daily News упоминает условное обозначение первого специализированного чипа Broadcom — «Baltra», который ляжет в основу центров обработки данных Apple, запланированных к введению в строй с 2027 года. Контрактным производством специализированных серверов займётся Foxconn, а сама Apple будет использовать их для развития фирменного сервиса Apple Intelligence. Даже с учётом бурного развития контрактного бизнеса Foxconn по выпуску ИИ-серверов, Apple продолжает оставаться крупнейшим клиентом этой тайваньской компании, но благодаря заказам на выпуск традиционной потребительской электроники. Отдельно сообщается, что пока Apple предпочитает осуществлять экспансию этого сервиса осторожно. Языковая модель Google Gemini, которая будет обслуживать клиентов Apple, насчитывает не более 3 трлн параметров. По условиям договорённостей между Apple и Google, первая будет платить второй ежегодно около $1 млрд за доступ к данной модели. Если говорить о контрактном бизнесе Foxconn, то на направлении серверных систем на основе специализированных чипов (ASIC) она должна удвоить объёмы их выпуска в текущем году, но на GPU-системы будет приходиться до 80 % заказов. Тайваньский подрядчик контролирует примерно 40 % мирового рынка услуг по выпуску серверов для инфраструктуры ИИ. Intel готова выложить за стартап SambaNova около $1,6 млрд уже в январе

13.12.2025 [07:54],

Алексей Разин

Переговоры о покупке ИИ-стартапа SambaNova корпорацией Intel попали в фокус интереса общественности в том числе и по причине нахождения во главе обеих компаний Лип-Бу Тана (Lip-Bu Tan). На первом этапе возможные условия сделки не обсуждались публично, но теперь источники утверждают, что Intel уже в следующем месяце может выложить за активы SambaNova около $1,6 млрд.

Источник изображения: SambaNova Systems Об этом сообщает Bloomberg со ссылкой на собственные осведомлённые источники. Хотя переговоры продвинулись, условия сделки всё ещё могут измениться, по их словам. При этом SambaNova привлекла интерес со стороны альтернативных инвесторов, поэтому её активы в итоге могут достаться не Intel, либо финансирование будет осуществляться без поглощения компании. Основанная в 2017 году SambaNova Systems уже через год привлекла средства фонда Walden International, принадлежащего нынешнему генеральному директору Intel Лип-Бу Тану, в размере $56 млн. В дальнейшем это позволило ему занять пост председателя правления молодой компании. Как считается, именно он и подтолкнул SambaNova к переговорам с Intel, поскольку последняя заинтересована в получении доступа к разработкам, позволяющим продвинуться в совершенствовании своих аппаратных предложений для сегмента искусственного интеллекта. На этапе финансирования в 2021 году капитализация SambaNova оценивалась в $5 млрд, поэтому упоминаемая сумма в $1,6 млрд представляет серьёзный дисконт. Впрочем, сейчас процессорный гигант находится не в лучшем финансовом положении, и любая возможность сэкономить пойдёт ему на пользу. Собственная капитализация Intel сейчас не превышает $180 млрд. Nvidia столкнулась с огромным спросом на ИИ-чипы H200 в Китае и задумалась о наращивании производства

12.12.2025 [20:28],

Николай Хижняк

Nvidia рассматривает возможность увеличить объёмы производства ИИ-чипов H200 для своих китайских клиентов, сообщает Reuters со ссылкой на несколько источников, знакомых с ситуацией. Текущие объёмы заказов на эти чипы превышают уровень их производства.

Источник изображения: Nvidia Издание сообщает, что этот шаг со стороны Nvidia последовал за заявлением президента США Дональда Трампа во вторник о том, что правительство США разрешит Nvidia экспортировать H200 в Китай при условии 25 % комиссионных с каждого проданного чипа. Спрос на чипы со стороны китайских компаний настолько высок, что Nvidia склоняется к увеличению мощностей, сообщил один из источников Reuters. Собеседники издания согласились дать комментарии на условиях анонимности, поскольку обсуждения носят конфиденциальный характер. В Nvidia на запрос Reuters о комментарии не ответили. Крупные китайские компании, включая Alibaba и ByteDance, на этой неделе обратились к Nvidia по поводу закупок H200 и сообщили о готовности разместить крупные заказы. Однако неопределённость в отношении возможности таких поставок сохраняется, поскольку китайское правительство ещё не дало разрешения на закупку H200. Китайские чиновники провели в среду экстренные совещания для обсуждения этого вопроса, сообщили источники Reuters. В настоящее время в производстве находятся очень ограниченные партии чипов H200, поскольку Nvidia сосредоточена на выпуске своих самых передовых ИИ-чипов Blackwell и будущих Rubin. Поставки H200 вызывают серьёзную обеспокоенность у китайских клиентов, и они обратились к Nvidia за разъяснениями по этому вопросу, сообщили источники. Nvidia также предоставила им информацию о текущих объёмах поставок, сообщил один из источников, не называя конкретных цифр. Чип H200 поступил в массовое производство в прошлом году и является самым производительным решением для ИИ в рамках предыдущего поколения архитектуры Hopper от Nvidia. Микросхемы производятся на мощностях компании TSMC с использованием 4-нм технологического процесса. Высокий спрос китайских компаний на H200 обусловлен тем, что это, безусловно, самый мощный чип, доступный им на данный момент. Он примерно в шесть раз мощнее, чем H20 — урезанный вариант от Nvidia, разработанный специально для китайского рынка и выпущенный в конце 2023 года. Решение Трампа по H200 принято на фоне стремления Китая развивать собственную отечественную индустрию чипов для искусственного интеллекта. Поскольку отечественные производители ещё не выпустили продукцию, сопоставимую по эффективности с H200, существуют опасения, что допуск H200 на китайский рынок может затормозить развитие отрасли. «Его (H200) вычислительная производительность примерно в 2–3 раза выше, чем у самых передовых отечественных ускорителей. Я уже наблюдаю, как многие поставщики облачных услуг и корпоративные клиенты активно размещают крупные заказы и лоббируют правительство с целью ослабления ограничений на определённых условиях», — прокомментировал в разговоре с Reuters Нори Чиоу (Nori Chiou), инвестиционный директор White Oak Capital Partners, добавив, что спрос на оборудование для ИИ в Китае превышает текущие возможности местного производства. По словам источников Reuters, в рамках таких обсуждений также рассматривалась возможность обязать китайских покупателей при приобретении каждого H200 также закупать определённое количество отечественных чипов. Для Nvidia наращивание объёмов поставок тоже является сложной задачей, поскольку компания не только находится в процессе перехода на новое поколение ИИ-чипов Rubin, но и конкурирует с такими компаниями, как Google (Alphabet), за ограниченные производственные мощности TSMC по выпуску передовых микросхем. Многомиллиардными заказами на поставку чипов Broadcom обеспечит Anthropic

12.12.2025 [08:05],

Алексей Разин

В начале сентября Broadcom заявила о заключении сделки с новым клиентом на поставку чипов для инфраструктуры ИИ на общую сумму $10 млрд, но не стала раскрывать его имени. В духе времени, некоторые источники быстро привили общественности уверенность в том, что этим клиентом станет OpenAI, однако на этой неделе руководство Broadcom в данном контексте сослалось на Anthropic.

Источник изображения: Broadcom Более того, как поясняет CNBC, глава Broadcom Хок Тан (Hock Tan) во время выступления на квартальной отчётной конференции признался: «Мы получили заказ на $10 млрд на поставку стоек с новейшими TPU семейства Ironwood компании Anthropic». Другими словами, речь идёт о поставках разработанных для нужд Google ускорителей TPU поколения Ironwood стартапу Anthropic, а не о создании каких-то принципиально новых чипов или сотрудничестве с OpenAI, хотя последнее в целом на фоне этих новостей не отменяется. В минувшем квартале Anthropic разместила дополнительный заказ на сумму $11 млрд, как признался глава Broadcom. Компании такого масштаба обычно не раскрывают имён клиентов, но сентябрьские заявления руководства Broadcom вызвали такое оживление среди инвесторов, что в октябре оно вынуждено было пояснить, что новым клиентом на данном направлении является не OpenAI. Более того, глава Broadcom на этой неделе добавил, что Anthropic является четвёртым по счёту клиентом, которого компания снабжает своими ускорителями (XPU). При этом у Broadcom в минувшем квартале появился пятый клиент на этом направлении, который разместил заказы на сумму $1 млрд. В дальнейшем выручка от поставок XPU этому клиенту будет расти, но Broadcom пока отказывается раскрыть его имя. В октябре Anthropic и Google объявили о сотрудничестве, договорившись, что первая будет арендовать у второй 1 млн ускорителей TPU, и в течение 2026 года в строй будет введено более 1 ГВт вычислительной мощности в рамках соответствующей сделки. В целом, Anthropic использует различные аппаратные платформы, включая чипы Nvidia и Google, а также Trainium в исполнении AWS (Amazon). Успех ИИ-модели Gemini 3 компании Google во многом предопределил рост спроса партнёров и конкурентов на разработанные ею в сотрудничестве с Broadcom чипы TPU, поскольку компонентов Nvidia на всех не хватает, да и ценовая политика последнего из поставщиков устраивает не всех разработчиков приложений для ИИ. Google с помощью TPU сможет отщипнуть десятки миллиардов от ИИ-пирога, который почти единолично «поедает» Nvidia

09.12.2025 [10:17],

Алексей Разин

На фоне недавнего успеха Google Gemini на передний план вышли ускорители TPU собственной разработки, которые она уже много лет использует в собственной вычислительной инфраструктуре. Аналитики Morgan Stanley прогнозируют, что в следующем году для нужд Google компания TSMC выпустит 3,2 млн ускорителей TPU.

Источник изображения: Google В дальнейшем это количество будет расти, по данным источника, до 5 млн штук в 2027 году и 7 млн штук в 2028 году. Аналитики утверждают, что Google могла бы продавать свои TPU сторонним заказчикам с большой выгодой. Каждые 500 000 реализованных по такой схеме TPU могли бы принести Google до $13 млрд дополнительной выручки. В разработке TPU интернет-гиганту помогают Broadcom и MediaTek, а первые эксперименты в этой сфере начались ещё в 2013 году. По слухам, заинтересованность в приобретении TPU у Google уже проявила Meta✴✴ Platforms, хотя последняя от комментариев на эту тему отказалась. Около 1 млн ускорителей TPU будут предоставлены ИИ-стартапу Anthropic, сумма сделки измеряется десятками миллиардов долларов США. Как ожидают эксперты, если Google сможет заключить контракты на поставку TPU с OpenAI, xAI и Safe Superintelligence, это позволит её увеличить свою выручку более чем на $100 млрд в ближайшие годы. Наличие систем так называемого вайб-кодинга позволяет специалистам проще адаптировать свои программные ИИ-платформы под новое аппаратное обеспечение, и в этом контексте привязка большинства отраслевых решений к экосистеме Nvidia уже не имеет прежнего значения. Руководство последней данная тенденция уже насторожила, оно поспешило заявить, что компания находится на целое поколение впереди всей отрасли. Представители Nvidia и Google при этом подтвердили сохранение сотрудничества между компаниями в сфере использования аппаратных компонентов первой. Если ранее Google старалась выпускать новое поколение TPU каждые два года, то теперь компания старается обновлять их ежегодно. Amazon раскрыла планы по NVLink Fusion в Trainium4 и представила ИИ-модели Nova 2 и Sonic

03.12.2025 [05:04],

Алексей Разин

Поскольку сама Arm недавно заявила о поддержке интерфейса NVLink Fusion в своих процессорных архитектурах, её клиентам сделать это рано или поздно тоже бы пришлось. Облачный гигант Amazon (AWS) начал декабрь заявления о намерениях реализовать поддержку интерфейса Nvidia в своих будущих ускорителях семейства Trainium4.

Источник изображения: AWS Сроки выхода этих ускорителей при этом названы не были, как отмечает Reuters. Анонс был сделан на недельной конференции по облачным вычислениям в Лас-Вегасе, которая собрала около 60 000 посетителей. Непосредственно среди разработчиков чипов поддержку NVLink Fusion ранее анонсировали компании Intel, Samsung и Qualcomm, теперь к ним присоединилась и AWS. По замыслу последней, технология Nvidia поможет компании создавать более эффективные вычислительные кластеры, в которых серверы быстрее обмениваются информацией друг с другом. Прежде чем появятся ускорители Trainium4, компания AWS наполнит рынок серверами на основе ускорителей Trainium3, распространение которых уже начала. Данные системы содержат 144 чипов и в четыре раза превосходят по быстродействию своих предшественников, при этом потребляя на 40 % меньше электроэнергии. Представители AWS рассчитывают конкурировать с другими участниками рынка, включая Nvidia, благодаря более выгодному сочетанию цены и быстродействия своих решений. В программной сфере AWS представила ИИ-модель Nova 2, которая получила возможность комбинировать в ответах на запросы текстовую и визуальную информацию, а также генерировать речевые сообщения. Модель Sonic специализируется на речевом обмене информации, причём делает это вполне естественно, по словам разработчиков. AWS помогает клиентам создавать собственные ИИ-модели, для этого был представлен сервис Nova Forge, который предоставляет инструменты для обучения более специализированных моделей. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |