|

Опрос

|

реклама

Быстрый переход

DeepSeek обновила открытую модель V3, улучшив её навыки программирования

25.03.2025 [12:59],

Владимир Мироненко

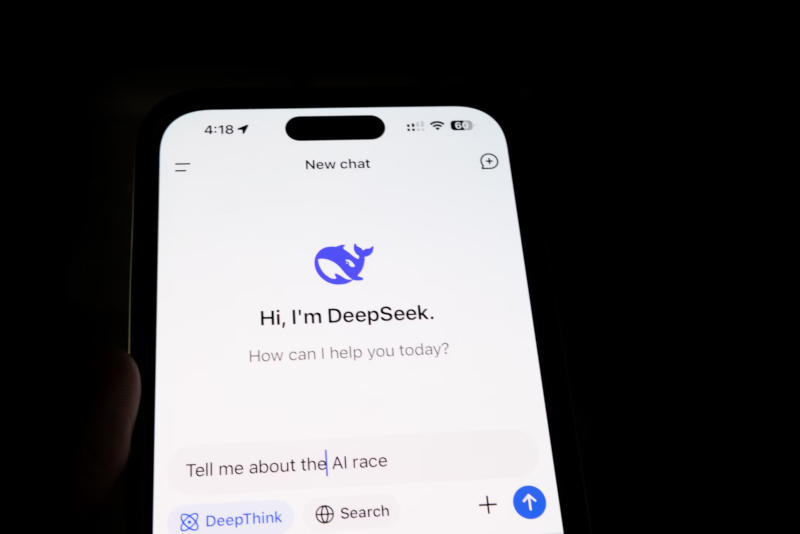

DeepSeek выпустила обновление ИИ-модели V3, получившее название V3-0324, которое, как сообщается, предоставляет лучшие возможности для программирования, одновременно устанавливая новые стандарты точности и эффективности, пишет Bloomberg. Обновление было опубликовано на платформе Hugging Face без официального анонса.

Источник изображения: Solen Feyissa/unsplash.com Открытая ИИ-модель DeepSeek V3 была представлена в конце прошлого года. Модель построена на архитектуре Mixture of Experts (MoE, набор экспертов) с общим количеством параметров 671 млрд и 37 млрд параметров, активируемых на каждый токен. Как сообщила тогда компания, на обучение DeepSeek V3 ушло $5,5 млн, что значительно ниже расходов других технологических компаний, таких как OpenAI, на обучение аналогичных моделей. Спустя несколько недель DeepSeek выпустила открытую рассуждающую модель R1, которая, несмотря на скромный бюджет на разработку, превзошла ИИ-модель o1 от компании OpenAI в некоторых бенчмарках по ряду ключевых показателей. В январе 2025 года приложение DeepSeek опередило ИИ-чат-бот ChatGPT и вышло на первое место в рейтинге самых популярных бесплатных приложений в интернет-магазине Apple App Store в США. Достижения китайского стартапа вызвали вопросы у инвесторов по поводу обоснованности громадных затрат американских компаний на разработку ИИ-технологий, что привело к обрушению ИИ-рынка, в результате которого его участники столкнулись со значительным падением акций. В частности, лидер рынка Nvidia потеряла за день $593 млрд рыночной стоимости, что было крупнейшим однодневным падением в истории фондового рынка. Все современные ИИ провалили новый сложный тест на общий интеллект — люди с ним тоже справились не идеально

25.03.2025 [11:22],

Анжелла Марина

Новый тест для оценки общей интеллектуальной способности моделей искусственного интеллекта, получивший название ARC-AGI-2, поставил в тупик большинство ИИ-моделей. Согласно рейтингу, рассуждающие модели, такие как o1-pro от OpenAI и R1 от DeepSeek, набрали от 1 % до 1,3 %. Модели без логического мышления, включая GPT-4.5, Claude 3.7 Sonnet и Gemini 2.0 Flash, набрали менее 1 %.

Источник изображения: Pixabay Фонд Arc Prize Foundation, некоммерческая организация, соучредителем которой является известный исследователь в области искусственного интеллекта Франсуа Шолле (François Chollet), объявил в своём блоге о создании нового, более продвинутого теста для измерения общего интеллекта ведущих моделей искусственного интеллекта. Тест ARC-AGI-2 представляет собой серию головоломок, в которых ИИ должен распознать визуальные закономерности, анализируя разноцветные квадраты, и на основе этого построить правильное продолжение узора. Испытание специально разработано так, чтобы модели не могли полагаться на прошлый опыт и вынуждены были адаптироваться к новым задачам. Также Arc Prize Foundation провела тестирование с участием более 400 человек. В среднем группы испытуемых верно ответили на 60 % заданий. Это значительно превосходит показатели всех протестированных ИИ и одновременно подчёркивает разрыв между текущими возможностями ИИ и интеллектом людей в решении задач, требующих адаптации и понимания новых концепций. Шолле заявил, что ARC-AGI-2 является более точным показателем реального интеллекта ИИ-моделей, чем предыдущая версия теста ARC-AGI-1. Кроме того, ARC-AGI-2 исключает возможность решения задач «методом грубой силы», то есть путём использования огромной вычислительной мощности для перебора всех возможных вариантов, что происходило в тесте ARC-AGI-1 и было признано серьёзным недостатком. Для устранения погрешностей первого теста в ARC-AGI-2 была введена метрика эффективности, которая заставляла ИИ интерпретировать паттерны «на лету», а не полагаться на запоминание. Сооснователь Arc Prize Foundation Грег Камрадт (Greg Kamradt) отметил, что «интеллект определяется не только способностью решать задачи или достигать высоких результатов, но и эффективностью, с которой приобретаются и развёртываются эти возможности». ARC-AGI-1 оставался ведущей метрикой в течение примерно пяти лет, пока в декабре 2024 года OpenAI не выпустила свою продвинутую модель рассуждений o3. Эта модель превзошла все другие ИИ-модели и даже сравнялась с производительностью человека в тестах ARC-AGI-1. Однако, как было отмечено, эти достижения были достигнуты за счёт значительных вычислительных затрат. Разработка нового теста совпала с ростом обеспокоенности в индустрии по поводу недостатка объективных критериев для оценки искусственного интеллекта. В связи с этим Arc Prize Foundation объявила о запуске конкурса Arc Prize 2025, в котором разработчикам предлагается достичь 85 % точности на ARC-AGI-2, затратив при этом вычислительных затрат не более, чем $0,42 на задачу. Выход DeepSeek запустил тренд на открытый исходный код в сфере ИИ

24.03.2025 [17:36],

Владимир Мироненко

Китайские игроки ИИ-рынка, от крупных, таких как Baidu, до более мелких, таких как Manus AI, всё чаще прибегают к использованию в своих проектах модели лицензирования ПО с открытым исходным кодом, пишет CNBC.

Источник изображения: Solen Feyissa/unsplash.com Тренд на использование открытого исходного кода для ИИ-моделей был инициирован китайским стартапом DeepSeek, выпустившим в начале года рассуждающую модель R1, бросив вызов американскому доминированию на рынке ИИ и обрушив акции ведущих технологических компаний. Также у инвесторов возникли вопросы по поводу огромных расходов компаний на разработку больших языковых моделей, поскольку DeepSeek добился успеха с гораздо меньшими затратами. По словам ряда аналитиков, наиболее значительным влиянием успеха DeepSeek на рынок стало ускорение внедрения ИИ-моделей с открытым исходным кодом. «Успех DeepSeek доказывает, что стратегии с открытым исходным кодом могут привести к более быстрым инновациям и широкому внедрению», — сообщила Вэй Сан (Wei Sun) из Counterpoint Research, отметив, что модель DeepSeek внедрили многие организации. 16 марта Baidu представила новую версию своей базовой ИИ-модели Ernie 4.5, а также новую рассуждающую модель Ernie X1, сделав их бесплатными для индивидуальных пользователей. Также Baidu планирует в конце июня выпустить серию моделей Ernie 4.5 с открытым исходным кодом. Эксперты отметили, что переход Baidu на открытый исходный код представляет собой более широкий сдвиг китайского ИИ-рынка, подразумевающий собой отказ от бизнес-стратегии, которая фокусируется на проприетарном лицензировании программного обеспечения. Лиан Цзе Су (Lian Jye Su), главный аналитик исследовательской и консультативной группы технологий Omdia, подчеркнул, что Baidu всегда придерживалась проприетарной бизнес-модели и выступала против открытого исходного кода, но такие компании, как DeepSeek, доказали, что Open Source-модели могут быть такими же конкурентоспособными и надёжными, как проприетарные.  DeepSeek R1 распространяется по лицензии MIT, которую Counterpoint описывает как одну из самых доступных и широко распространённых с открытым исходным кодом, допускающей неограниченное использование, модификацию и распространение ПО, в том числе в коммерческих целях. Хотя сама ИИ-модель DeepSeek бесплатна, стартап взимает плату за использование API, который позволяет интегрировать модели и их возможности в приложения других компаний. Однако её ценник рекламируется как гораздо более доступный по сравнению с последними предложениями OpenAI и Anthropic, чьи модели считаются «закрытыми», поскольку их наборы данных и алгоритмы недоступны широкой публике. Помимо Baidu, другие китайские технологические гиганты тоже стали предлагать Open Source-модели. Alibaba Cloud заявила в прошлом месяце, что открывает исходный код своих ИИ-моделей для генерации видео, в то время как Tencent выпустила в начале марта пять новых ИИ-моделей с открытым исходным кодом с возможностью преобразования текста и изображений в 3D-визуализацию. Этой тенденции также следуют небольшие фирмы в сфере ИИ. Китайская компания Manus AI, недавно представившая ИИ-агента, который, как утверждается, превосходит Deep Research от OpenAI, заявила, что перейдет на открытый исходный код. Zhipu AI, один из ведущих стартапов Китая в области ИИ, в этом месяце объявил на платформе WeChat, что 2025 год станет «годом открытого исходного кода». Рэй Ванг (Ray Wang), главный аналитик и основатель Constellation Research, сообщил ресурсу CNBC, что компании были вынуждены пойти на это после выпуска DeepSeek своих ИИ-моделей. «Поскольку DeepSeek бесплатный, никакие другие китайские конкуренты не смогут взимать плату за то же самое. Чтобы конкурировать, им придется перейти на модели бизнеса с открытым исходным кодом», — сказал Ванг. Тим Ванг (Tim Wang), управляющий партнёр технологического хедж-фонда Monolith Management, назвал происходящее на рынке ИИ «моментом Android», имея в виду, что когда Google сделала исходный код своей операционной системы доступным для всех, это способствовало инновациям и развитию экосистемы приложений, отличных от Apple. DeepSeek начали массово встраивать в китайские автомобили — это привлекает покупателей

24.03.2025 [13:18],

Алексей Разин

Программные возможности современных транспортных средств волнуют потенциальных покупателей не меньше, чем технические характеристики и дизайн, поэтому китайские автопроизводители начали активно внедрять поддержку чат-ботов на базе разработок DeepSeek в свою программную инфраструктуру. Подобным образом уже поступили Dongfeng, GAC и BYD.

Источник изображения: BYD Dongfeng Motor, как уточняет Nikkei Asian Review, предлагает поддержку большой языковой модели DeepSeek R1 в мультимедийной системе кроссоверов Zhiyin марки Voyah, причём данная функциональность была добавлена посредством обновления «по воздуху». С апреля аналогичными возможностями начнут обзаводиться крупный внедорожник M-Hero 917 и другие транспортные средства концерна. Искусственный интеллект в бортовой электронике машины используется не только для построения диалога с водителем и пассажирами при помощи голосового ассистента, но и для оценки окружающей обстановки с целью предсказания дальнейших намерений водителя. Лидирующая на китайском рынке гибридов и электромобилей компания BYD также объявила о намерении внедрить разработки DeepSeek в свою продукцию. Некоторые автопроизводители готовы «подружить» собственные программные платформы с языковыми моделями DeepSeek. Например, так намерена поступить китайская компания GAC Group. Языковой ассистент Adigo Sense в автомобилях этой марки будет учитывать историю прошлых запросов и действий водителя для прогнозирования его ближайших намерений. Цифровой помощник сможет оптимизировать маршруты передвижения и предлагать пассажирам фильмы к просмотру с учётом их предпочтений. GAC начнёт внедрять подобные функции в бортовое ПО своих автомобилей в текущем полугодии. Leapmotor надеется сочетать языковые модели DeepSeek с разработкой Alibaba, получившей обозначение Qwen. По крайней мере, такая связка позволит бортовой системе машин Leapmotor научиться генерировать изображения. SAIC намерена внедрить поддержку DeepSeek на автомобилях марки IM Motors в сочетании с решениями Alibaba и ByteDance. В Китае даже импортные марки не стесняются внедрять поддержку DeepSeek для своих транспортных средств локальной сборки. Например, подобной функцией обзаведётся электромобиль Nissan N7, собираемый на совместном предприятии с Dongfeng. Стараниями SAIC поддержкой DeepSeek обзаведутся выпускаемые в Китае модели Buick и Cadillac. Языковые модели этой компании будут соседствовать с чат-ботом Baidu Ernie. Есть в Китае и автопроизводители, которые пока не следуют моде на DeepSeek. Среди них можно отметить Xiaomi и XPeng Motors. Минторг США запретил сотрудникам использовать DeepSeek на рабочих устройствах

18.03.2025 [12:06],

Алексей Разин

Активное развитие систем искусственного интеллекта стало вызовом для информационной безопасности, поскольку огромные массивы данных могут включать и довольно чувствительную информацию. Руководствуясь соображениями национальной безопасности, Министерство торговли США запретило своим сотрудникам использовать DeepSeek на рабочих устройствах.

Источник изображения: Unsplash, Solen Feyissa Служебные устройства сотрудников этого ведомства, как следует из цитируемой Reuters рассылки для внутреннего пользования, лишаются доступа к ресурсам и приложениям DeepSeek — китайской компании, разрабатывающей большие языковые модели и одноимённый чат-бот. Такое ограничение, по словам чиновников, вводится для защиты информационных систем министерства. Рекомендация сотрудникам буквально гласит следующее: «Не скачивайте, не просматривайте и не используйте любые мобильные и настольные приложения, а также сайты, имеющие отношение к DeepSeek». Ещё в феврале группа американских парламентариев выступила с инициативой законодательного запрета на использование решений DeepSeek на служебных устройствах американских чиновников. В этом месяце письмо с рекомендацией прибегнуть к этому запрету было разослано в различные ведомства США. Конгрессменов беспокоит тот факт, что пользователи DeepSeek могут невольно предоставить доступ китайской стороны к важным правительственным документам, включая тексты контрактов и финансовую отчётность. Коалиция из генеральных прокуроров 21 штата уже обращалась к американскому парламенту с призывом запретить использование DeepSeek на служебных устройствах чиновников. На локальном уровне подобные запреты уже действуют в Вирджинии, Техасе и штате Нью-Йорк, а также в некоторых других штатах. Китай на волне патриотизма внедряет DeepSeek во всех сферах жизни без разбора

16.03.2025 [14:44],

Анжелла Марина

Китайские компании в знак патриотизма и на волне ажиотажа, связанного с успехами отечественного ИИ-стартапа DeepSeek, активно внедряют модель рассуждений R1 и большую языковую модель V3 в свои сервисы и услуги, включая автопром, смартфоны, бытовую технику, здравоохранение и государственные учреждения.

Источник изображения: Solen Feyissa on Unsplash В Китае уверены, что конкурентное преимущество страны в области искусственного интеллекта (ИИ) заключается не столько в создании мощных моделей, сколько в поиске разнообразных способов их практического применения. К тому же, по заявлению разработчиков DeepSeek, модели R1 и V3 сопоставимы с западными аналогами по качеству, но значительно дешевле в использовании. Этот фактор также очень важен для эффективного использования ИИ, пишет Rest of World. В автомобильной отрасли уже более 20 китайских брендов объявили о внедрении DeepSeek. Geely Auto, второй по величине автопроизводитель Китая, продемонстрировал, как его автомобили, оснащённые ИИ, способны выполнять сложные команды, например, создавать комфортные условия для отдыха водителя. Крупнейшие производители смартфонов, включая Huawei, Oppo, Honor, Vivo и Xiaomi, также уже успели интегрировать DeepSeek в свои системы. Huawei, например, использует модель R1 для обновления голосового помощника Xiaoyi, предоставляя пользователям выбор между быстрыми ответами и глубокими рассуждениями. В свою очередь в компаии Oppo отмечают, что благодаря DeepSeek общество быстрее стало адаптироваться к технологиям ИИ. «Мы ожидали, что на просвещение людей в этом плане уйдёт года два, но благодаря DeepSeek, этот процес проходит очень быстро. Это очень хорошо для нас», — заявил Лю Цзоху (Liu Zuohu), директор по продуктам Oppo. В сфере бытовой техники компания Midea внедрила DeepSeek в кондиционеры, которые могут реагировать на голосовые команды, анализировать настроение пользователя и даже поддерживать беседу. В продаже появились также умные пылесосы и холодильники с поддержкой ИИ. Однако эксперты признают, что пока такие устройства далеки от идеала, но их эффективность будет возрастать по мере совершенствования технологий. Не остались в стороне и медицинские учреждения Китая. Около 100 больниц активно используют DeepSeek для диагностики, анализа снимков и управления медицинской документацией. Однако в некоторых направлениях ИИ не используют. Так, в феврале в провинции Хунань запретили применять ИИ для автоматической генерации рецептов, а Национальная комиссия по здравоохранению запретила заменять искусственным интеллектом врачей. Государственные учреждения также постепенно переходят на DeepSeek. Например, Южный технологический центр Шэньчжэня был одним из первых, кто начал использовать DeepSeek для оптимизации документооборота в своей системе. При этом точность написания документов достигла 95 %, а время на их обработку сократилось на 90 %. ИИ также помог и в работе полиции. Когда был получен сигнал о том, что пять бесхозных лошадей бродят ночью по городу, полиция запросила у чат-бота информацию о близлежащих конных фермах. Благодаря быстрому ответу ИИ, сотрудники смогли оперативно найти владельца, посетив фермы, адреса которых выдал DeepSeek. Эксперты подчёркивают, что внедрение DeepSeek в госучреждения — это не только вопрос эффективности, но и демонстрация поддержки стратегических целей правительства. «Китай давно определил ИИ как ключевое направление для будущего развития и стремится стать мировым лидером в этой области», — говорит Chen Li (Чэнь Ли), аналитик из пекинского аналитического центра Anbound. Одновременно DeepSeek становится символом технологического патриотизма Китая, объединяя усилия бизнеса, государства и общества. OpenAI предложила запретить языковые модели DeepSeek в США

16.03.2025 [05:42],

Алексей Разин

Как это часто бывает с передовыми для Китая технологиями, разработки DeepSeek быстро нашли недоброжелателей за его пределами. Конкурирующая американская OpenAI выступила с предложением запретить в США использование языковых моделей не только DeepSeek, но и всех компаний, пользующихся поддержкой КНР или иных недружественных стран.

Источник изображения: OpenAI Это предложение, как отмечает TechCrunch, было направлено руководством OpenAI властям США в рамках обсуждения так называемого «Плана действий в сфере ИИ» (AI Action Plan), который должен стать американской национальной инициативой на данном направлении. OpenAI утверждает, что языковые модели DeepSeek не являются безопасными для США по причине их соответствия требованиям китайских властей к обработке пользовательских данных. Одновременно звучит призыв к запрету всех языковых моделей из недружественных к США стран, поскольку это позволит сохранить конфиденциальность данных и устранить риски, связанные с безопасностью, включая кражу интеллектуальной собственности. Пока сложно сказать, какая часть разработок DeepSeek действительно может попасть под запрет в США. Китайский разработчик придерживается стратегии использования моделей с открытым кодом, но это не значит, что использующие их третьи лица автоматически рискуют конфиденциальностью своих данных. У корпоративных пользователей таких моделей есть все возможности обеспечивать конфиденциальность информации. По сути, условный риск представляют только обращения к программному интерфейсу DeepSeek, который обрабатывает запросы на стороне собственной инфраструктуры компании. Ранее OpenAI обвиняла DeepSeek в использовании своих языковых моделей для обучения китайских методом дистилляции. Теперь в ход пошли традиционные козыри в виде выражения беспокойства по поводу информационной безопасности, которые неизбежно будут привязаны к национальным интересам США. Власти Китая ограничили выезд из страны сотрудникам DeepSeek

14.03.2025 [23:05],

Анжелла Марина

Громкий и стремительный успех в январе ИИ-стартапа DeepSeek привёл к тому, что китайские власти теперь следят за каждым шагом компании. Правительство опасается утечки технологий и ограничивает зарубежные поездки некоторых сотрудников DeepSeek, в особенности в США.

Источник изображения: Solen Feyissa / Unsplash Ограничения на поездки специалистов DeepSeek реализуются через материнскую компанию High-Flyer. Именно эта организация удерживает паспорта определённых сотрудников, чтобы они не могли покинуть Китай без разрешения. Эти меры, по информации TechCrunch, были введены вскоре после того, как появились сообщения о том, что китайское правительство рекомендовало исследователям и предпринимателям в сфере искусственного интллекта (ИИ) воздержаться от поездок в США. Власти опасаются утечки технологических секретов, особенно на фоне усиливающегося противостояния между двумя странами. Также китайское правительство ужесточило контроль за инвестициями в компанию. Потенциальные инвесторы проходят жёсткую государственную проверку перед тем, как получить возможность вложить средства в этот ИИ-стартап. Стоит сказать, что DeepSeek — не единственная компания, работающая в условиях усиленного контроля. В последние годы Пекин активно регулирует технологический сектор, особенно в сфере ИИ. Это связано как с национальной безопасностью, так и с желанием Китая развивать собственные технологии и не зависеть от западных компаний. Исследования для DeepSeek оказались важнее доходов — в отличие от OpenAI и прочих американских конкурентов

14.03.2025 [13:09],

Павел Котов

Китайский стартап в области искусственного интеллекта DeepSeek сосредоточен на исследовательской работе, а не получении доходов — воспользовавшись внезапным скачком продаж, основатель компании, миллиардер Лян Вэньфэн (Liang Wenfeng), решил не следовать примеру конкурентов из Кремниевой долины.  Компании из Ханчжоу пришлось адаптироваться к всплеску спроса на её бесплатные потребительские сервисы на сайте и в приложении, а также на платные услуги от бизнес-пользователей. Выручки за минувший месяц впервые оказалось достаточно, чтобы покрыть текущие расходы, сообщает Financial Times со ссылкой на два информированных источника. Интерес к DeepSeek вырос в январе, когда компания выпустила недорогую в обслуживании рассуждающую модель искусственного интеллекта R1 — она демонстрирует сопоставимые с ведущими американскими и китайскими аналогами результаты, но её разработка обошлась значительно дешевле. Корпоративные клиенты из медицинской и финансовой отраслей стали активно закупать у DeepSeek доступ к API для разработки собственных приложений на основе моделей V3 и R1, причём спрос оказался настолько высоким, что стартапу пришлось временно приостановить регистрацию клиентов из-за нехватки ресурсов на не связанные с исследованиями цели. Господин Лян не проявил особого намерения начать немедленно зарабатывать на DeepSeek. Вместо этого бо́льшую часть ресурсов компания направила на разработку новых моделей и создание сильного искусственного интеллекта (AGI) с когнитивными способностями, не уступающими человеческим. Глава независимой компании пока также отказался от сотрудничества с китайскими технологическими гигантами, венчурными и государственными фондами, выразившими желание инвестировать в DeepSeek. Напротив, со склонным к уединению бизнесменом оказалось непросто даже назначить встречу.  Появление DeepSeek огорчило инвесторов, у которых возникли сомнения, что американские технологические лидеры в лице Google и OpenAI способны удержать преимущество, и что колоссальные расходы технологических гигантов на инфраструктуру ИИ оправданы. Подход китайской компании значительно отличается от манеры работы многих стартапов Кремниевой долины: OpenAI воспользовалась своим статусом лидера в области ИИ, чтобы выстроить экосистему коммерческих сервисов вокруг ChatGPT и начать получать значительные доходы от доступа к моделям ИИ через API. С 2019 года американская компания привлекла инвестиции на сумму около $20 млрд, и сейчас ведёт переговоры с группой инвесторов во главе с SoftBank о привлечении ещё $40 млрд при оценке $260 млрд. В OpenAI работают чуть более 2000 человек, в DeepSeek — около 160. Отсутствие коммерческих устремлений DeepSeek сыграло на руку китайским технологическим гигантам Alibaba и Tencent — за счёт сформировавшихся инфраструктуры и пакетов услуг они привлекли на родине большое число корпоративных клиентов, и это вызвало сомнения, что потоки доходов стартапа являются устойчивыми. Так, Apple для развёртывания функций ИИ на iPhone в Китае выбрала модель Alibaba Qwen, а не DeepSeek; Tencent же увеличила продажи, когда открыла в своей облачной инфраструктуре доступ к открытым моделям DeepSeek — их выбрали около половины облачных клиентов техногиганта, и около 20 % запросили их доработку. Из-за того, что DeepSeek отказалась прилагать усилия для продвижения собственных продуктов для массового рынка, Tencent интегрировала модели стартапа и в свои популярные потребительские приложения. За последние годы Лян Вэньфэн, возглавляющий также хедж-фонд, закупил около 10 000 ИИ-ускорителей Nvidia A100 и примерно то же количество моделей H800 — ещё до того, как их ввоз в Китай был запрещён. На перспективу компания намеревается закупить оборудование у других поставщиков; кроме того, она получила поддержку со стороны китайских властей, которые предоставили ей доступ к финансируемым государством центрам обработки данных, частично удовлетворив потребность компании в вычислительных ресурсах. В долгосрочной перспективе DeepSeek может счесть проблемой недостаточный доступ к передовому оборудованию Nvidia и изучить возможность выбрать другого партнёра. А для получения дополнительной политической поддержки, считают отраслевые эксперты, компании всё-таки придётся открыться для государственных фондов. Сейчас инженеры компании в полную силу ведут разработку моделей R2 и V4 – первоначально эти модели планировались к выпуску в мае, но теперь в компании решили ускориться. DeepSeek похвасталась расчётной рентабельностью своих ИИ-сервисов на уровне 545 %

02.03.2025 [06:51],

Алексей Разин

Китайские разработчики языковых моделей DeepSeek на этой неделе опубликовали интересные данные о расчётной рентабельности своих языковых моделей V3 и R1 в течение условного 24-часового периода. По данным авторов расчётов, эти модели позволяют заработать в шесть с половиной раз больше, чем расходуют на аренду вычислительных мощностей.

Источник изображения: Unsplash, Solen Feyissa По сути, если опираться на опубликованную представителями DeepSeek на страницах GitHub информацию, за произвольно выбранные сутки компания потратила на аренду ускорителей вычислений $87 072, тогда как потенциальная монетизация её моделей V3 и R1 могла бы принести ей $562 027 за тот же период. Соотнеся эти величины, авторы расчётов и получили условную рентабельность в размере 545 %. Впрочем, важно понимать, что расчёты по этой методике подразумевают ряд допущений. Прежде всего, потенциальные доходы рассчитывались без учёта скидок, а за основу бралась ценовая политика в отношении более дорогой модели R1. Во-вторых, далеко не все публично доступные сервисы DeepSeek монетизированы и являются платными для пользователей. Если бы плата за доступ к ним взималась по коммерческой стоимости, количество пользователей могли бы сократиться, а это уменьшило бы получаемую выручку. Наконец, расчёты в этом примере никак не учитывают расходы DeepSeek на электроэнергию и аренду хранилищ для данных, а также на исследования и разработки как таковые. В любом случае, данная попытка продемонстрировать потенциальным инвесторам свою перспективность и состоятельность должна вдохновить представителей других стартапов на публикацию подобных расчётов. Пока сфера искусственного интеллекта требует от инвесторов огромных затрат, а финансовая отдача весьма эфемерна и отдалена во времени. DeepSeek поясняет, что высокой эффективности своих сервисов компания добилась за счёт ряда оптимизаций. Во-первых, трафик распределяется между несколькими центрами обработки данных максимально равномерно. Во-вторых, гибко регулируется время обработки запроса пользователя. В-третьих, обрабатываемые данные сортируются по партиям для оптимальной нагрузки на инфраструктуру. DeepSeek запустил ИИ-революцию в Китае: нашумевший ИИ стали внедрять повсюду с подачи партии

27.02.2025 [18:41],

Владимир Фетисов

Внезапный успех DeepSeek вызвал в Китае общенациональный толчок к внедрению больших языковых моделей (LLM) повсюду — от медицинских учреждений до местных органов власти и государственных предприятий. Это подчёркивает стремление Пекина закрепить свои успехи в области генеративных нейросетей.

Источник изображения: Solen Feyissa / Unsplash С тех пор, как в прошлом месяце стартап DeepSeek из Ханчжоу потряс мировые рынки своей ИИ-моделью R1, в Китае быстрыми темпами началось внедрение этой технологии, чему способствовала поддержка разных компаний и государственных органов власти. Все крупные поставщики облачных услуг, не менее шести автопроизводителей, местные органы власти, ряд медицинских учреждений и несколько государственных предприятий (SOE), приступили к внедрению алгоритмов DeepSeek. Особенно удивляет прогресс в плане внедрения ИИ-технологий в традиционно консервативных госучреждениях. «Несмотря на то, что Коммунистическая партия Китая уже давно поддерживает ИИ, DeepSeek подтолкнула государственные ведомства и SOE к внедрению больших языковых моделей. DeepSeek изменила всё. Компания положила начало общенациональным усилиям по продвижению китайского ИИ», — сказал один из поставщиков технологий для SOE, пожелавший сохранить конфиденциальность. Относительно невысокая стоимость развёртывания ИИ-моделей DeepSeek способствует их быстрому внедрению. По мнению эксперта в сфере ИИ на платформе Hugging Face Адина Якефу (Adina Yakefu), DeepSeek «сильно изменила ландшафт отрасли» после того, как «снизила барьеры для разработки и применения моделей благодаря своей стратегии открытого исходного кода, методам сбора знаний и экономически эффективным решениям для обучения». Уже сейчас есть множество примеров успешного внедрения ИИ-алгоритмов DeepSeek. Университетская больница Цзилинь, расположенная в городе Чанчунь на востоке Китая, запустила диагностический инструмент, который использует нейросеть DeepSeek для составления планов лечения, для чего ИИ-алгоритм берёт данные из базы больницы, а также учитывает медицинские рекомендации и эффективность разных лекарственных средств. Женская больница Цзиньсинь на юго-западе страны объявила о создании инструмента для отслеживания циклов овуляции у женщин и составления индивидуальных планов лечения бесплодия.

Источник изображения: Steve Johnson / Unsplash Один из врачей государственной больницы в провинции Хубэй в центральном Китае сообщил, что ИИ-алгоритм DeepSeek стал в их учреждении своего рода арбитром, который решает споры, если два врача расходятся во мнениях относительно правильности лечения того или иного пациента. В государственных больницах Чэнду, Ханчжоу и Уханя внедрены менее сложные ИИ-алгоритмы, такие как цифровые медсёстры, направляющие пациентов в нужные им кабинеты или разъясняющие сложные медицинские термины. При этом сразу несколько отраслевых инсайдеров предостерегли от того, чтобы принимать все заявления по поводу внедрения ИИ за чистую монету, поскольку некоторые компании пытаются использовать энтузиазм инвесторов по отношению к DeepSeek, не внедряя алгоритмы компании. По слова осведомлённого источника, «предстоит ещё много работы, чтобы сделать эти модели» способными выполнять сложные задачи, включая медицинскую диагностику. «Для получения хороших результатов необходимо провести обучение на достаточном количестве медицинских данных. Это займёт время и потребует сотрудничества с ведущими компаниями в области ИИ. Это не то, что больницы могут создать самостоятельно», — уверен источник. Даже если отнестись скептически к некоторым заявлениям, то эксперты всё равно выделяют готовность испытывать ИИ-модели, считая это шагом вперёд. «Темпы распространения DeepSeek просто невероятны. Раньше консервативные учреждения, такие как правительственные агентства и больницы, сдержанно относились к внедрению приложений на базе генеративного ИИ, опасаясь проблем, если что-то пойдёт не так», — отметил один из инженеров в сфере ИИ из Ханчжоу. Местные органы власти, включая города Цзинань и Ханчжоу, запустили чат-боты для граждан, созданные на основе моделей DeepSeek. Они отвечают на самые разные вопросы граждан, начиная от уплаты налогов и заканчивая получением свидетельства о рождении ребёнка. В районе Футянь города Шэньчжэнь запущено несколько ИИ-агентов на основе моделей DeepSeek, в том числе инструмент для составления административных протоколов сотрудниками правоохранительных органов. Публичное признание DeepSeek властями Китая способствует ускоренному внедрению ИИ-технологий. В этом месяце глава DeepSeek Лян Вэньфэн (Liang Wenfeng) был приглашён на встречу с Председателем КНР Си Цзиньпином (Xi Jinping), наряду с такими крупными бизнесменами, как глава BYD Ван Чуаньфу (Wang Chuanfu), основатель Huawei Жэнь Чжэнфэй (Ren Zhengfei) и основатель Alibaba Джек Ма (Jack Ma). Компания Tencent объявила о внедрении ИИ-алгоритма DeepSeek в функцию поиска в своём приложении WeChat. Компании BYD и Great Wall Motor вошли в число автопроизводителей, которые уже используют модели стартапа. В это же время многие государственные компании, включая Sinopec, PetroChina и China Southern Power Grid, заявили, что приступили к внедрению ИИ-алгоритмов от DeepSeek. По данным осведомлённых источников, DeepSeek не извлекает финансовую выгоду на фоне широкого распространения своих технологий. Компания позволяет бесплатно скачивать свои ИИ-модели и запускать их в публичном облаке или на частных серверах, что делает провайдеров облачных услуг, таких как AliCloud и Huawei Cloud, главными бенефициарами всплеска популярности DeepSeek. DeepSeek запустила дешёвые ночные тарифы на доступ к ИИ-моделям

26.02.2025 [15:32],

Алексей Разин

Взрывной рост интереса к любой облачной системе становится серьёзной нагрузкой для инфраструктуры, и китайская компания DeepSeek взяла на вооружение маркетинговые инструменты для более равномерного управления нагрузкой. Со среды доступ к модели DeepSeek V3 для разработчиков будет в два раза дешевле в период с 00:30 до 8:30 по пекинскому времени.

Источник изображения: Unsplash, Solen Feyissa Модель R1, которая лежит в основе популярного чат-бота DeepSeek, станет в указанное время дешевле для использования разработчиками через программный интерфейс на 75 %. В самом Китае сервисы DeepSeek стали весьма популярны, включая даже конкурирующих разработчиков ИИ-систем типа Tencent Holdings и Perplexity AI. Государственные учреждения охотно пользуются сервисами DeepSeek, поскольку передавать данные для обработки за пределы страны китайским служащим запрещает местное законодательство. Уместно будет напомнить, что использовать DeepSeek правительства отдельных стран типа Италии и Южной Кореи своим чиновникам тоже запретили. DeepSeek была вынуждена предупреждать клиентов, что у них могут возникать проблемы с доступом к её сервисам в дневное время. Снижение стоимости ночного доступа должно способствовать более равномерному распределению нагрузки. Зарубежным клиентам DeepSeek, проживающим в более удалённых от Пекина часовых поясах, подобные изменения могут быть даже более полезны, чем китайским. DeepSeek ускорила разработку конкурента GPT-5 — рассуждающей ИИ-модели R2

25.02.2025 [17:42],

Павел Котов

В январе китайский стартап в области искусственного интеллекта DeepSeek спровоцировал обвал мирового рынка акций — он выпустил рассуждающую модель R1, которая превзошла многих конкурентов, хотя и была обучена значительно дешевле их. Теперь компания решила ускорить выпуск её преемника.

Источник изображения: Solen Feyissa / unsplash.com Первоначально DeepSeek намеревалась выпустить R2 в начале мая, но теперь стремится сделать это как можно раньше, сообщило Reuters со ссылкой на два источника, которые не стали вдаваться в подробности. Компания рассчитывает, что новая модель сможет писать более качественный программный код и рассуждать не только на английском, но и на других языках. Конкуренты DeepSeek всё ещё пытаются оправиться от последствий выхода R1 — модели ИИ, которая была обучена на ускорителях Nvidia заниженной мощности, но смогла потягаться с аналогами, обученными американскими технологическими гигантами за колоссальные суммы. Выход R2 станет поводом для беспокойства и у властей США, которые определили лидерство страны в области ИИ как национальный приоритет. С другой стороны, ещё больше активизируются китайские власти и компании, которые начали интегрировать модели DeepSeek в свои продукты, — среди последних оказались Lenovo, Baidu и Tencent. Успех DeepSeek вызвал рост спроса на ускорители Nvidia H20 в Китае

25.02.2025 [05:07],

Алексей Разин

Из-за санкций США поставки в Китай передовых ускорителей Nvidia запрещены, и с этой точки зрения усечённые с точки зрения производительности ускорители H20 являются наиболее продвинутыми решениями Nvidia среди доступных китайским клиентам. Спрос на них в Китае после успеха DeepSeek заметно вырос, как утверждают источники Reuters.

Источник изображения: Nvidia Напомним, что китайский стартап DeepSeek продемонстрировал способность создавать эффективные большие языковые модели с ограниченным доступом к аппаратным ресурсам, поэтому интерес к его разработкам заметно вырос в самом Китае. По данным Reuters, закупки ускорителей Nvidia H20 китайскими компаниями Tencent, Alibaba и ByteDance были существенно увеличены после появления соответствующих откровений о прорыве DeepSeek. Перечисленные китайские компании не только используют вычислительные мощности для собственных нужд, но и предоставляют их сторонним разработчикам. Китайские производители серверного оборудования отмечают, что на местном рынке вырос спрос на решения, оснащённые ускорителями H20 и использующие языковые модели DeepSeek. Теперь их приобретают даже представители сферы образования и здравоохранения, хотя ранее такими закупками занимались преимущественно провайдеры связи и успешные финансовые организации в Китае. Отчасти рост спроса на H20 мог быть спровоцирован слухами о намерениях США запретить поставки данных ускорителей в КНР. По оценкам аналитиков, в 2024 году на территорию Китая было ввезено около 1 млн ускорителей H20, обеспечивших Nvidia выручкой в размере более $12 млрд. Взять на вооружение разработки DeepSeek решились многие китайские компании, включая Tencent и автопроизводителя Great Wall Motor. Дженсен Хуанг снял с DeepSeek обвинения в обвале акций Nvidia — это инвесторы всё не так поняли

22.02.2025 [12:55],

Павел Котов

Рынок неверно воспринял значение технологических достижений китайской лаборатории искусственного интеллекта DeepSeek и сделал неправильные выводы, предположив, что они окажут негативное влияние на бизнес Nvidia, заявил в недавнем интервью основатель и гендиректор последней Дженсен Хуанг (Jensen Huang).

Источник изображения: nvidia.com Открытую рассуждающую модель ИИ DeepSeek R1 Хуанг назвал «чрезвычайно впечатляющей». «Думаю, рынок отреагировал на R1 как-то так: „О, боже! ИИ конец!“. Она, знаете, свалилась с неба. И никаких вычислений нам больше делать не нужно. Всё как раз наоборот. Диаметрально противоположно», — заявил глава Nvidia. По его мнению, выход R1 изначально оказал положительное влияние на рынок, поскольку она ускорит повсеместное развёртывание ИИ, но потребность в оборудовании Nvidia не исчезнет. «Она [DeepSeek] заставила всех обратить внимание, что да, есть возможности сделать модели гораздо эффективнее, чем мы считали возможным. Так что она расширит и ускорит развёртывание ИИ», — считает Дженсен Хуанг. В области предварительного обучения DeepSeek добилась многого, но важным и ресурсоёмким остаётся запуск обученной модели (инференс). «Рассуждения — весьма ресурсоёмкая её сторона», — напомнил гендиректор компании. Выход открытой модели DeepSeek R1 потряс рынок ИИ и негативно сказался на рыночной капитализации Nvidia: только за первый день торгов после новостей о китайской сенсации акции «зелёных» рухнули на 16,9 %. На закрытии торгов 24 января стоимость одной акции Nvidia составляла $142,62, а в понедельник, 27 января, они подешевели до $118,52 — рыночная капитализация компании рухнула на $600 млрд. К настоящему моменту ценные бумаги Nvidia почти полностью восстановились, и в минувшую пятницу торговались на отметке около $140. Отчёт Nvidia по итогам IV квартала ожидается 26 февраля — он, вероятно, более ясно отразит реакцию рынка. DeepSeek же на этой неделе пообещала открыть исходный код пяти своих репозиториев. |