|

Опрос

|

реклама

Быстрый переход

Google представила TranslateGemma — семейство открытых ИИ-моделей для локального перевода на 55 языков

16.01.2026 [17:51],

Владимир Фетисов

Компания Google выпустила три версии ИИ-модели TranslateGemma для обеспечения перевода на десятки языков на портативных и мобильных устройствах. Версия алгоритма с 4 млрд параметров оптимизирована для работы на мобильных устройствах, вариант с 12 млрд параметров предназначен для использования в потребительских ноутбуках, а версия с 27 млрд параметров — в облачных серверах, работающих на базе одного графического ускорителя H100 или тензорном процессоре.

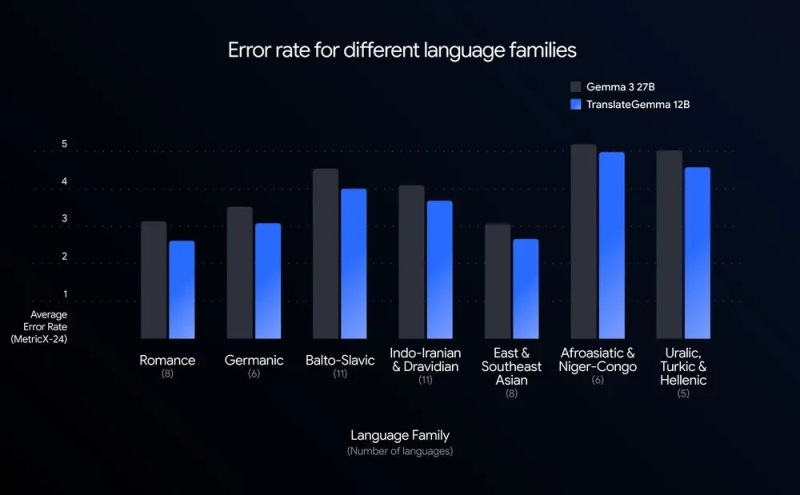

Источник изображений: Google Google протестировала новые алгоритмы на платформе MetricX, которая позволяет отслеживать ошибки при переводе (чем ниже балл, тем лучше). Модель TranslateGemma с 12 млрд параметров набрала 3,6 балла, превзойдя результат базовой версии Gemma 3 с 27 млрд параметров, которая в этом тесте набрала 4,04 балла. По сравнению с версией Gemma 3 на 12 млрд параметров, набравшей на MetricX 4,86 балла, уровень ошибок снизился примерно на 26 %. Существенные улучшения в плане качества перевода наблюдаются для всех 55 протестированных языковых пар, включая не самые популярные языки. Так количество ошибок при переводе с английского на исландский снизилось на 30 %, а на суахили — на 25 %.  Двухэтапное обучение алгоритмов позволяет переносить знания Gemini в более компактные модели. На первом этапе алгоритмы обучаются на параллельных данных — как переведённых людьми, так и сгенерированных другими нейросетями. На втором этапе качество перевода оптимизируется за счёт обучения с подкреплением, когда несколько нейросетей автоматической оценки проверяют данные без необходимости использования эталонных переводов от человека. Отдельная модель оценивает, насколько естественно звучит полученный перевод. Чтобы сохранить универсальность моделей, несмотря на их специализацию, 30 % обучающей выборки составили общие данные. Это означает, что модели TranslateGemma могут работать подобно привычным чат-ботам. Оценка профессиональными переводчиками в целом подтвердила улучшения, за одним исключением: в переводах с японского на английский было отмечено ухудшение качества, которое Google связывает с ошибками при обработке имён собственных. Все три ИИ-модели сохранили мультимодальные возможности Gemma 3. Они могут переводить текст с изображений, даже без дополнительного обучения. Тесты в бенчмарке Vistra показали, что улучшения в переводе текста распространяются и на перевод с изображений. Для достижения оптимального результата Google рекомендует использовать промпты, указывающие модели на то, что она должна действовать как «профессиональный переводчик», учитывающий разные культурные нюансы. Все три новые модели TranslateGemma доступны на платформах Kaggle и Hugging Face. Google создала ИИ-модель DolphinGemma для общения с дельфинами

14.04.2025 [18:45],

Сергей Сурабекянц

Дельфины считаются одними из самых умных существ на планете. Они умеют сотрудничать, обучать друг друга новым навыкам и узнавать себя в зеркале. Десятилетиями учёные пытаются понять сложный набор свистов и щелчков, которые дельфины используют для общения. Похоже, что исследователи вскоре смогут существенно продвинуться в этом вопросе при помощи новой открытой ИИ-модели от Google и смартфонов Pixel.

Источник изображений: Google В поисках новых областей для применения генеративного ИИ Google заинтересовалась сотрудничеством с проектом Wild Dolphin Project (WDP). Эта группа исследователей изучает поведение и взаимоотношения сообщества атлантических пятнистых дельфинов с 1985 года. Одной из главных задач, стоящих перед WDP, является анализ влияния издаваемых дельфинами звуков на их социальное взаимодействие. Понимание структуры и паттернов «голосового общения» дельфинов необходимо для определения того, достигает ли оно уровня полноценного языка. «Мы не знаем, есть ли у животных слова», — говорит Дениз Херцинг (Denise Herzing) из WDP.

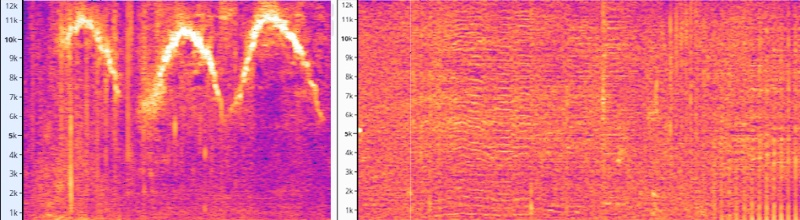

Источник изображения: Wild Dolphin Project Благодаря десятилетиям подводных записей исследователям удалось связать некоторые базовые действия с определёнными звуками. Например, им удалось выявить характерные свисты, которые, по-видимому, используются как имена, что позволяет двум особям находить друг друга на большом расстоянии. Дельфины также постоянно издают звуковые паттерны, названные учёными «пронзительный крик», во время конфликтов. Конечная цель WDP — заговорить на дельфиньем языке, если он действительно существует. Это стремление привело к созданию огромного, тщательно размеченного набора данных, который слишком трудоёмок для анализа человеком, но, по словам Google, идеально подходит для обработки с помощью генеративного ИИ. Генеративная ИИ-модель DolphinGemma основана на открытых моделях искусственного интеллекта Gemma от Google. Она использует разработанную Google аудиотехнологию SoundStream. Модель была обучена с использованием акустического архива проекта Wild Dolphin. Команда надеется, что DolphinGemma поможет выявить сложные закономерности, которые позволят создать общий словарь. DolphinGemma работает так же, как языковые модели, ориентированные на человека: она получает запрос и предсказывает следующий токен. Учёные полагают, что эти предсказанные токены могут оказаться звуковыми последовательностями, которые будут поняты дельфинами.  Google разработала DolphinGemma с учётом исследовательского подхода WDP. Учёные используют телефоны Pixel в полевых условиях, что накладывает дополнительные требования к модели. Запуск моделей ИИ на смартфоне — сложная задача из-за ограниченных ресурсов. Чем больше и функциональнее модель, тем больше оперативной памяти и вычислительных мощностей ей требуется. DolphinGemma обучена примерно на 400 миллионах параметров, что совсем немного для типичных современных моделей, количество параметров которых исчисляется десятками миллиардов. В течение последних нескольких лет WDP использует устройство, созданное в Технологическом институте Джорджии, под названием CHAT (Cetacean Hearing Augmentation Telemetry), на основе смартфона Pixel 6. Команда применяет CHAT для записи, прослушивания и синтеза голосов дельфинов.

Источник изображения: Georgia Institute of Technology На летний исследовательский сезон 2025 года Google предоставит членам команды WDP смартфоны Pixel 9, что позволит CHAT одновременно запускать модели глубокого обучения и алгоритмы сопоставления шаблонов. Учёные на данном этапе не планируют передавать сгенерированные DolphinGemma звуки непосредственно в CHAT, то есть оба подхода будут использоваться параллельно. Конечно, маловероятно, что DolphinGemma и новый CHAT мгновенно позволят людям запросто общаться с дельфинами, но есть надежда, что со временем система обеспечит хотя бы базовое взаимодействие. Как и другие модели Gemma, DolphinGemma является проектом с открытым доступом. Google сделает модель общедоступной уже этим летом. Хотя DolphinGemma была обучена на звуках атлантических пятнистых дельфинов, Google предполагает, что её можно будет адаптировать и для других видов китообразных. В завершение трудно удержаться и не процитировать отрывок из романа Дугласа Адамса ( Douglas Noël Adams) «Автостопом по Галактике»: «Важный и широко известный факт: не всегда то, что кажется — правда. Например, на планете Земля человек всегда считал, что он разумнее дельфинов потому, что многого достиг — придумал колесо, Нью-Йорк, войны и так далее — в то время, как дельфины только тем и занимались, что развлекались, кувыркаясь в воде. Дельфины же, со своей стороны, всегда считали, что они намного разумнее людей — именно по этой причине». И ещё одна цитата — из книги «Человек-дельфин» знаменитого ныряльщика Жака Майоля ( Jacques Mayol): «Что же тогда? Чего мы хотим добиться? …А я отвечу вам : нам надо избавиться от нашего эгоизма, от этого подлого чудовища, которое в конце концов обернётся против человека и сотрёт его с лица земли к большой пользе всех других живущих видов, и прежде всего дельфина. Мы же лицемерны. Человек обожает дельфинов! Да, для своего личного удовольствия, чтобы сделать из них вассалов, домашних слуг, рабов, роботов, несущих на спине бомбы. И он близок к этому». Google выпустила Gemma 3 — самую мощную модель ИИ для запуска на одной видеокарте

12.03.2025 [12:23],

Павел Котов

Google выпустила открытую модель искусственного интеллекта Gemma 3 — это новый представитель семейства моделей, на основе которых разработчики смогут создавать приложения, способные запускаться локально на рабочих станциях или даже смартфонах. Поддерживаются 35 языков, есть функции анализа текста, изображений и коротких видеороликов.

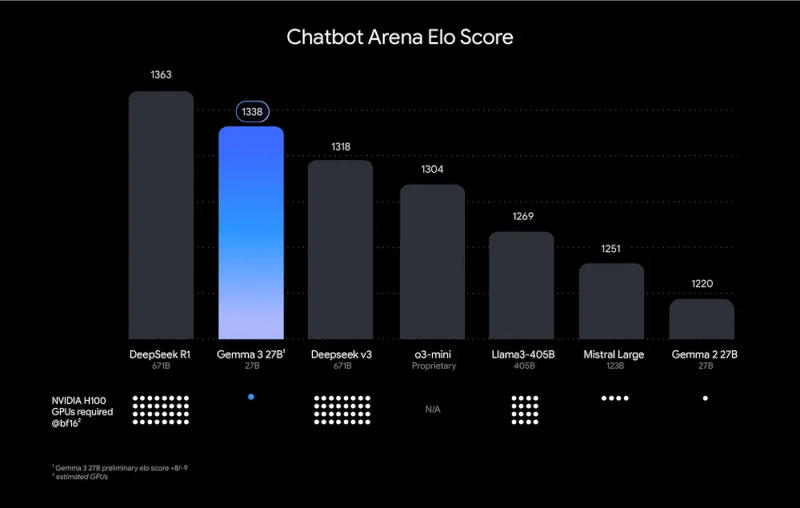

Источник изображений: blog.google Google охарактеризовала Gemma 3 как «лучшую в мире модель для одного ускорителя» и заверила, что она демонстрирует результаты лучше, чем конкуренты от Meta✴✴, DeepSeek и OpenAI при работе на одной видеокарте; она оптимизирована для оборудования Nvidia и других ИИ-ускорителей. Обновился компонент анализа видео — теперь он поддерживает записи высокого разрешения и отличную от квадратной форму кадра; фильтр безопасности входных и выходных изображений ShieldGemma 2 реагирует на картинки деликатного характера и материалы с изображением жестокости.  У Google это открытая модель ИИ уже третьего поколения, но потенциал этого направления помогла раскрыть китайская DeepSeek — её проекты продемонстрировали, что существует спрос на ИИ-решения с относительно невысокими системными требованиями. У Gemma 3 отмечаются значительные познания в области технических дисциплин, и Google провела дополнительное тестирование на возможность нецелевого использования модели, например, для создания вредных веществ — вероятность сбоя защитных механизмов в компании оценили как невысокую. Открытая лицензия Gemma 3 на деле является ограниченной: Google указала, для чего её разрешено использовать. Новая модель доступна, в частности, в Google Cloud. В рамках академической программы можно подать заявку на получение кредитов на сумму $10 000, если она будет использоваться в исследовательских целях. Google представила компактную языковую модель Gemma 2 2B, которая превосходит GPT 3.5 Turbo

01.08.2024 [16:36],

Николай Хижняк

Компания Google представила Gemma 2 2B — компактную, но мощную языковую модель искусственного интеллекта (LLM), которая может составить конкуренцию лидерам отрасли, несмотря на свой значительно меньший размер. Новая языковая модель, содержащая всего 2,6 миллиарда параметров, демонстрирует производительность не хуже гораздо более крупных аналогов, включая OpenAI GPT-3.5 и Mistral AI Mixtral 8x7B.

Источник изображений: Google В тесте LMSYS Chatbot Arena, популярной онлайн-платформы для сравнительного тестирования и оценки качества моделей искусственного интеллекта, Gemma 2 2B набрала 1130 баллов. Этот результат немного опережает результаты GPT-3.5-Turbo-0613 (1117 баллов) и Mixtral-8x7B (1114 баллов) — моделей, обладающих в десять раз большим количеством параметров. Google сообщает, что Gemma 2 2B также набрала 56,1 балла в тесте MMLU (Massive Multitask Language Understanding) и 36,6 балла в тесте MBPP (Mostly Basic Python Programming), что является значительным улучшением по сравнению с предыдущей версией. Gemma 2 2B бросает вызов общепринятому мнению, что более крупные языковые модели изначально работают лучше компактных. Производительность Gemma 2 2B показывает, что сложные методы обучения, эффективность архитектуры и высококачественные наборы данных могут компенсировать недостаток в числе параметров. Разработка Gemma 2 2B также подчеркивает растущую важность методов сжатия и дистилляции моделей ИИ. Возможность эффективно компилировать информацию из более крупных моделей в более мелкие открывает возможности к созданию более доступных инструментов ИИ, при этом не жертвуя их производительностью. Google обучила Gemma 2 2B на огромном наборе данных из 2 триллионов токенов, используя системы на базе своих фирменных ИИ-ускорителей TPU v5e. Поддержка нескольких языков расширяют её потенциал для применения в глобальных приложениях. Модель Gemma 2 2B имеет открытый исходный код. Исследователи и разработчики могут получить доступ к модели через платформу Hugging Face. Она также поддерживает различные фреймворки, включая PyTorch и TensorFlow. Google анонсировала Gemma 2 — открытую ИИ-модель с 27 млрд параметров

14.05.2024 [23:13],

Владимир Фетисов

Сегодня началась ежегодная конференция для разработчиков Google I/O, в рамках которой уже было представлено немало любопытных новинок, таких как серверный ИИ-процессор Trillium и генератор изображений Imagen 3. Вместе с этим разработчики анонсировали скорое появление модели искусственного интеллекта Gemma 2 с открытым исходным кодом, которая включает 27 млрд параметров. Её запуск должен состояться в июне этого года.

Источник изображения: techcrunch.com Ранее в этом году Google выпустила версии Gemma 2B и Gemma 7B с 2 млрд и 7 млрд параметров соответственно. Появление версии ИИ-модели с 27 млрд параметров можно назвать существенным продвижением в развитии этого алгоритма. Во время презентации вице-президент Google Labs Джош Вудворд (Josh Woodward) рассказал, что ИИ-модели Gemma были загружены более «миллиона раз» в разные сервисы, где и продолжают работать. Он подчеркнул, что новая версия нейросети Gemma 2 предложит лучшую в отрасли производительность в компактных размерах благодаря оптимизации для работы на графических процессорах Nvidia следующего поколения или одном хосте Google Cloud TPU в сервисе Vertex AI. Размер большой языковой модели может отойти на второй план, если окажется, что она работает не слишком качественно. Google ещё не раскрыла подробностей касательно алгоритма Gemma 2. Это означает, что оценить его качество, вероятно, можно будет только после того, как ИИ-модель попадёт в руки разработчиков. По заявлениям Google, ИИ-модель Gemma 2 превосходит в плане производительности вдвое более крупные модели. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |