|

Опрос

|

реклама

Быстрый переход

Индийский луноход «Прагьян» совершил первую поездку на Луне

24.08.2023 [22:14],

Андрей Созинов

Индийский луноход «Прагъян» (Pragyan) в четверг спустился с посадочного модуля «Викрам» (Vikram), чтобы начать исследование поверхности южного полюса Луны и проведение экспериментов. Аппарат совершил первую поездку по Луне и готов к новым испытаниям, заявил глава индийского космического агентства.

Индийский луноход на Луне в представлении ИИ-художника. Источник изображений: gentleman07_ В среду индийский космический аппарат в рамках миссии «Чандраян-3» совершил мягкую посадку в районе Южного полюса Луны, сделав Индию первой страной, которой удалось посадку в полярной области Луны — все прежние лунные миссии садились ближе к экватору нашего естественного спутника. Заметим, что первой на несколько дней раньше в районе Южного полюса Луны должна была сесть российская станция «Луна-25», но она потерпела крушение.

Луноход «Прагъян» съезжает с посадочной платформы. Источник изображения: Rocketgyan Глава Индийской организации космических исследований (ISRO) С. Соманатх (S. Somanath) заявил, что посадочный модуль и луноход находятся в хорошем состоянии, «оба работают очень хорошо», но эксперименты еще не начались. «Все работы идут по графику. Все системы в норме, — говорится в сообщении ISRO на платформе X— Начались операции по перемещению ровера». Ровер, получивший название «Прагъян», оснащён двумя приборами для проведения экспериментов по определению химического состава лунного грунта. Также на нём тестируются приборы для планирования траектории движения лунохода, что пригодится для будущих исследований. Ожидается, что ровер будет функционировать в течение двух недель, или одного лунного дня — именно на такой срок рассчитано его оборудование, работающее на солнечных батареях. WhatsApp стал самым посещаемым сервисом в России в июле

24.08.2023 [21:43],

Николай Хижняк

Сервис обмена мгновенными сообщениями и голосовой связи WhatsApp оказался самой популярной интернет-платформой среди россиян в июле по показателю среднесуточной аудитории, говорится в отчёте Mediascope Cross Web, на который ссылается Telegram-канал New Media. Ежедневно платформой компании Meta✴ пользовались 80,2 млн человек.

Источник изображения: Pixabay На втором и третьем местах расположились поисковые системы «Яндекс» (66,7 млн человек) и Google (63,2 млн). На четвёртом и пятом местах оказались Telegram (54,3 млн) и «ВКонтакте» (52,6 млн), на шестом — YouTube (52,1 млн посещений), на седьмом — Sberbank (43,3 млн человек). Десятку замкнули TikTok, Дзен и Wildberries с ежесуточной аудиторией 31,9, 31,6 и 23,5 млн человек соответственно. По относительному приросту аудитории в сравнении с июлем 2022 года лидером оказался Wildberries с результатом +70,3 %, за ним — Telegram (+30,9 %) и Google (+11,3 %). Пятёрку замкнули Sberbank (+11,2 %) и WhatsApp (+10,6 %). По абсолютному же приросту пользователей лидером оказался Telegram, чья аудитория выросла на 12,8 млн человек. Следом идут Wildberries (+9,7 млн человек), WhatsApp (+7,7 млн человек), Google (+6,4 млн человек) и YouTube, чья аудитория выросла за отчётный период на 4,5 млн человек. Исследование проводилось по всей России, с учётом охвата пользователей ПК и мобильных платформ. В X обнаружили группировку ботов, которые писали мошеннические посты с помощью ChatGPT

24.08.2023 [21:37],

Сергей Сурабекянц

В мае этого года исследователи из Университета Индианы обнаружили в социальной сети X (тогда ещё Twitter) ботнет на базе ChatGPT. Ботнет, названный Fox8 из-за его связи с одноимёнными криптовалютными сайтами, состоял из 1140 учётных записей. Многие из них использовали ChatGPT для создания постов в социальной сети и для ответа на посты друг друга. Автоматически сгенерированный контент побуждал ничего не подозревающих людей перейти по ссылкам на сайты с рекламой криптовалют.

Источник изображения: unsplash.com Эксперты уверены, что ботнет Fox8 может быть лишь верхушкой айсберга, учитывая, насколько популярными стали большие языковые модели и чат-боты. «Единственная причина, по которой мы заметили этот конкретный ботнет, заключается в том, что он работал небрежно», — отметил профессор Университета Индианы Филиппо Менцер (Filippo Menczer). Исследователи обнаружили ботнет, выполнив поиск на платформе по контрольной фразе «Как языковая модель ИИ…», которую ChatGPT иногда использует для подсказок по деликатным темам. Затем они вручную проанализировали учётные записи и выявили те из них, которыми управляли боты. Несмотря на свою «небрежность», ботнет опубликовал множество убедительных сообщений, рекламирующих криптовалютные сайты. Очевидная лёгкость, с которой ИИ OpenAI был использован для мошенничества, означает, что продвинутые ботнеты могут использовать чат-боты на основе ИИ более изощрённо, не давая себя обнаружить. «Любой хороший плохой парень не допустит такой ошибки», — шутит Менцер. ChatGPT и другие чат-боты используют большие языковые модели для генерации текста в ответ на запрос. Располагая достаточным количеством обучающих данных, серьёзными вычислительными мощностями и обратной связью от людей-тестировщиков, такие боты могут удивительно адекватно реагировать на широкий спектр входных данных. Но они также могут высказывать ненавистнические сообщения, демонстрировать социальные предубеждения, генерировать выдуманную информацию и помогать хакерам в создании вредоносного ПО.

Источник изображения: Pixabay «Это обманывает и платформу, и пользователей», — говорит Менцер о ботнете на базе ChatGPT. Если алгоритм социальных сетей обнаружит, что публикация пользуется большой популярностью (даже если эта активность исходит от других ботов), он покажет публикацию большему количеству людей. Правительства и организации, желающие проводить кампании по дезинформации, скорее всего, уже разрабатывают или внедряют такие инструменты, уверен Менцер. Исследователи уже давно обеспокоены тем, что технология, лежащая в основе ChatGPT, может представлять риск дезинформации, и OpenAI даже отложила выпуск следующей версии системы из-за подобных опасений. Профессор Калифорнийского университета Уильям Ван (William Wang) считает, что многие спам-страницы теперь создаются автоматически, и констатирует, что людям становится всё труднее обнаружить подобные материалы по мере совершенствования ИИ. Лаборатория Вана разработала метод автоматического определения текста, сгенерированного ChatGPT, но его внедрение обходится дорого, поскольку он использует API OpenAI, а базовый ИИ постоянно совершенствуется. X может стать благодатной площадкой для испытаний таких инструментов. Менцер утверждает, что вредоносные боты в последнее время резко повысили свою активность, а исследователям стало сложнее изучать проблему из-за резкого повышения цен на использование API соцсети. Ботнет Fox8 был удалён лишь после того, как исследователи опубликовали в июле статью, хотя они сообщали об этом ещё в мае. Менцер утверждает, что его группа перестала извещать X о своих исследованиях ботнетов. «Они не особо реагируют, — говорит он. — У них действительно нет персонала». Принципиальная политика разработчиков моделей ИИ запрещает использовать чат-боты для мошенничества или дезинформации. OpenAI пока не дала комментариев по поводу ботнета, использующего ChatGPT. Sony купила производителя аудиофильских наушников Audeze

24.08.2023 [21:21],

Николай Хижняк

Sony Interactive Entertainment LLC (SIE) объявила о заключении соглашения о покупке компании Audeze, ведущего бренда аудиотехнологий и пионера в области производства высококачественных игровых наушников. С этим приобретением SIE хочет усилить свои инициативы по внедрению инновационных продуктов в области звука в играх для приставок PlayStation.

Источник изображения: Audeze Audeze продолжит работать независимо, разрабатывая мультиплатформенные продукты и одновременно получая выгоду от участия в экосистеме PlayStation. Компания, базирующейся в Санта-Ане, штат Калифорния, США, не раз отмечались наградами за высокотехнологичные решения на профессиональном, аудиофильском и игровом рынках. Оборудование Audeze используется не только обычными потребителями, но также и профессионалами звукозаписи, в том числе звукорежиссёрами многих студий разработки игр. На своём заводе в Калифорнии компания производит планарные магнитные драйверы, а также проводит сборку профессиональных high-end-моделей наушников. Данные драйверы уже используются Sony в её продуктах. «Audeze — ведущий бренд наушников и эта сделка подчёркивает стремление Sony Interactive к инновациям и обеспечению наилучшего качества звука для владельцев приставок PlayStation. Мы рады привнести опыт Audeze в экосистему PlayStation, опираясь на большие успехи, которых мы достигли с помощью технологии Tempest 3D AudioTech для PlayStation 5, а также беспроводной гарнитуры Pulse 3D», — прокомментировал Хидеаки Нисино (Hideaki Nishino), старший вице-президент по платформам Sony Interactive Entertainment. «Sony Interactive предоставляет Audeze уникальную возможность масштабировать наш бизнес на фоне нашей продолжающейся миссии по предоставлению лучших в своём классе наушников для профессионалов звукозаписи, аудиофилов и геймеров. Мы также с нетерпением ждём возможности внести свой вклад в усилия Sony Interactive по поднятию качества звука PlayStation на новый уровень», — сказал Санкар Тиагасамудрам (Sankar Thiagasamudram), генеральный директор Audeze. Условия данной сделки, включая стоимость приобретения, не разглашаются в связи с договорными обязательствами. Китай выделил громадные средства на переманивание иностранных специалистов в полупроводниковой сфере

24.08.2023 [21:10],

Владимир Мироненко

В течение десяти лет, вплоть до 2018 года, власти Китая стремились привлечь в страну учёных высокого уровня, прошедших обучение за рубежом. Это происходило в рамках щедро финансируемой программы Thousand Talents Plan (TTP, План тысячи талантов), которую США рассматривали как угрозу своим интересам. В связи с начавшимися расследованиями в США программу TTP Китай закрыл, но спустя два года вновь возродил под новым названием и форматом, пишет Reuters.

Источник изображения: Pixabay Новостное агентство проанализировало более 500 правительственных документов за период с 2019 по 2023 год, а также опросило информированные источники. Выяснилось, что обновлённая система набора зарубежных специалистов предлагает льготы, включая субсидии на покупку жилья и типичные бонусы в размере от 3 до 5 млн юаней (от $420 000 до $700 000). В Китае действует целый ряд программ на различных правительственных уровнях по привлечению специалистов из-за рубежа, как граждан Китая, так и иностранных экспертов. Исходя из различных документов и онлайн-объявлений о наборе персонала можно сделать вывод, что основной заменой TTP стала программа Qiming (Просвещение) Министерства промышленности и информационных технологий КНР. Это подтвердил и информатор Reuters. В рамках этой программы осуществляется набор специалистов из научных и технологических областей, которые включают «чувствительные» или «засекреченные» области, такие как полупроводниковая индустрия. В отличие от TTP новая программа не предполагает публикацию имён привлечённых специалистов. В некоторых документах Qiming упоминается наряду с Huoju (Факел), давней инициативой Министерства науки и технологий, направленной на создание кластеров технологических компаний. По словам источников Reuters, новые программы Китая по привлечению талантов, так же как и TTP сосредоточены на подборе персонала высокого уровня, и предпочтение отдаётся специалистам, прошедшим обучение в ведущих зарубежных вузах. «Большинство кандидатов, отобранных для Qiming, учились в ведущих университетах США и имеют по крайней мере одну учёную степень PhD (аналог кандидата наук)», — сообщил источник Reuters, добавив, что Китай интересуют, в том числе, учёные, прошедшие подготовку в Массачусетском технологическом институте, Гарвардском и Стэнфордском университетах. О том, насколько заинтересован Китай в привлечении необходимых специалистов, говорят суммы предлагаемых вознаграждений. Например, в рекламе программ Qiming и Huoju сообщается, что привлечённый специалист может получить вознаграждение в размере до 15 млн юаней ($2,1 млн). В ней также указано, что любой, кто порекомендует кандидата, который затем будет отобран для участия в программах, получит щедрое вознаграждение, включая машины и дома. Согласно отчёту за 2021 год, опубликованному Китайским центром развития информационной индустрии, правительственным аналитическим центром и Китайской ассоциацией полупроводниковой промышленности, китайская индустрия производства чипов столкнулась с нехваткой порядка 200 тысяч специалистов, включая инженеров и разработчиков микросхем. Baldur’s Gate 3 всё-таки выйдет на Xbox Series X и S в 2023 году, но есть нюанс

24.08.2023 [20:57],

Дмитрий Рудь

Похоже, история о том, когда и в каком виде фэнтезийная ролевая игра Baldur’s Gate 3 от бельгийской Larian Studios выйдет на Xbox Series X и S, готовится подойти к концу. Как предполагалось, без жертв обойтись не получилось. Напомним, в феврале глава Larian Свен Винке (Swen Vincke) сообщал, что у Xbox Series S возникли проблемы с работоспособностью в режиме разделённого экрана, тогда как на Xbox Series X таких неурядиц не наблюдается. Из-за политики Microsoft насчёт паритета игровых функций на X и S одну из двух консолей локального кооператива лишить нельзя, а бросить все силы на решение проблем из-за ограниченности ресурсов Larian не могла. К процессу оптимизации подключили инженеров самой Microsoft, Larian готовилась пойти на некие «компромиссы» и надеялась на релиз Xbox-версий в 2023 году, но дело шло к переносу на 2024-й. По словам Винке, после недавнего продуктивного разговора с гендиректором Microsoft Gaming Филом Спенсером (Phil Spencer), им удалось найти решение, которое позволит выпустить Baldur’s Gate 3 на Xbox Series X и S до конца 2023 года. «Все улучшения будут на месте с локальным кооперативом на Series X. Series S не получит режим разделённого экрана, но будет включать кроссплатформенный перенос прогресса между Steam и Xbox Series», — заявил Винке. Baldur’s Gate 3 вышла из раннего доступа 3 августа на PC (Steam, GOG), а до macOS и PS5 доберётся 6 сентября. По данным посольства Бельгии в Китае, суммарные продажи игры в Steam превысили 5,2 млн копий. Ночь, улица, фонарь, писатель: 14 минут геймплея Alan Wake II с Аланом Уэйком в кошмарной версии Нью-Йорка

24.08.2023 [20:14],

Дмитрий Рудь

Разработчики психологического хоррора Alan Wake II из студии Remedy Entertainment привезли на выставку gamescom 2023 не только новый трейлер игры, который был показан на шоу Opening Night Live, но и полтора десятка минут геймплея. По сюжету, пока писатель Алан Уэйк работает над судьбоносной историей в Тёмной обители, в городок Брайт-Фоллс на расследование череды ритуальных убийств приезжает агент ФБР Сага Андерсон. Обнародованные в рамках gamescom 2023 более 14 минут игрового процесса Alan Wake II посвящены приключениям Алана в Тёмной обители (геймплей за Сагу разработчики показывали ранее), которая приобрела форму Нью-Йорка. Герой бродит по залитым дождём пустым улицам ночного Нью-Йорка, спускается в метро и даже участвует в сцене с живыми актёрами — незадачливого писателя всё так же играет Илкка Вилли (Ilkka Villi). В «подземке» оказывается, что Алан может влиять на форму Тёмной обители: соединяя на воображаемой «сюжетной доске» локации и элементы истории, персонаж может разблокировать путь дальше. По словам сценариста Сэма Лейка (Sam Lake), боёв в Alan Wake II будет меньше, чем в первой части: в ролике на YouTube-канале GamersPrey протагонист лишь несколько раз сталкивается с врагами, но почти всегда их намного больше, чем пуль в обойме. В результате недавнего переноса релиз Alan Wake II ожидается не 17 октября, а на десять дней позже, то есть 27 октября. Игра создаётся для PC (Epic Games Store), PS5, Xbox Series X и S. Уже запланированы два дополнения — «Ночные ключи» и «Дом у озера». Видео распаковки VR-гарнитуры Meta✴ Quest 3 появилось до её официального анонса

24.08.2023 [19:39],

Владимир Фетисов

Компания Meta✴ Platforms должна официально представить новую гарнитуру виртуальной реальности Quest 3 в сентябре этого года. Однако уже на этой неделе в социальной сети X (бывшая Twitter) появилось видео, автор которого распаковывает устройство, которое, вероятнее всего, является новой гарнитурой Meta✴.

Источник изображения: @ZGFTECH / X На видео VR-гарнитура помещена в картонную коробку, на верхней крышке которой написано Meta✴ Quest 3, а также изображён логотип компании. Автор видео открывает коробку и достаёт из неё саму гарнитуру и пару контроллеров Touch Plus. Все устройства визуально выглядят так же, как те, что Meta✴ показала во время анонса гарнитуры в июне.

Появление Quest 3 в коробке указывает на то, что Meta✴ готова к началу поставок устройства. Не так давно новинка была зарегистрирована в базе Федеральной комиссии по связи (FCC) США. Это означает, что регулятор дал разрешение на продажу устройства на территории страны. Ранее сообщалось, что подробности о новой VR-гарнитуре будут раскрыты на мероприятии Meta✴ Connect, которое пройдёт 27 сентября. Вероятно, в рамках этого мероприятия будет объявлена дата начала продаж новинки. Любопытно, что это не первый случай утечки данных о новых гарнитурах Meta✴. В прошлом году, примерно за месяц до официального анонса гарнитуры Quest Pro, в интернете появились фото и видео устройства. На Gamescom представили кабину космического корабля для погружения в Starfield

24.08.2023 [19:36],

Сергей Сурабекянц

Компания Tempur представила на выставке Gamescom игровую систему в виде кабины космического корабля, которая даcт игрокам возможность путешествовать по космосу в горячо ожидаемой игре Starfield. Кабина, разработанная британским дизайнером и художником Николасом Александром (Nicholas Alexander), оснащена полным набором переключателей, джойстиков и мигающих индикаторов, которые создают реалистичную иллюзию управления настоящим космическим кораблём.

Источник изображения: Tempur Кабина Dream Chair, представленная на стенде Xbox, представляет собой мягкое кресло под брендом Tempur с двумя алюминиевыми джойстиками на каждом подлокотнике. Tempur утверждает, что кресло наполнено специальной пеной с эффектом памяти, впервые разработанной для астронавтов NASA. Крупная консоль управления оснащена большим изогнутым экраном. Следует отдать должное дизайнерам, которые смогли создать впечатляюще правдоподобную кабину космического корабля. Для полного погружения достаточно игнорировать все шильдики и логотипы Starfield и Tempur. Пока кабина не даёт пользователям полного опыта ещё не выпущенной игры Starfield. Это скорее внутриигровой полет по вселенной Starfield, представляющий собой лишь часть полной игры. В своём заявлении директор по глобальному партнёрству Xbox Маркос Вальтенберг (Marcos Waltenberg) назвал установку «модульной кабиной, которая искусно отражает игровой процесс Starfield, давая игрокам ощущение настоящего капитана своего собственного звездолёта». Dream Chair не поступит в розничную продажу, но один счастливчик сможет в конечном итоге получить её в свои руки. После Gamescom космическая кабина будет демонстрироваться в Германии, а затем в Великобритании. После этого она будет продана с аукциона в рамках благотворительной лотереи, но компания пока не предоставила никаких подробностей о том, как и когда фанаты Bethesda смогут сделать свою ставку. Раздача Homeworld: Deserts of Kharak в Epic Games Store позволит собрать полную коллекцию игр серии перед релизом Homeworld 3

24.08.2023 [19:29],

Дмитрий Рудь

Как и было обещано, 24 августа в цифровом магазине Epic Games Store стартовала раздача стратегии в реальном времени Homeworld: Deserts of Kharak. Вместе с началом акции игра также получила свежее обновление. Homeworld: Deserts of Kharak представляет собой приквел основной серии и отличается от предшественниц местом действия: игра переносит события из космоса на поверхность пустынной планеты Харак. В зыбучих песках Харака игрокам предстоит возглавить экспедицию, отправившуюся на изучение странной аномалии, и узнать историю Рэйчел С'Джет (Rachel S'jet), которая поведёт свой народ навстречу судьбе. Что касается обновления, то патч 1.4 добавляет в Deserts of Kharak поддержку кроссплея между Steam и EGS. Недавно функция появилась в сборнике Homeworld Remastered Collection, который в конце июля тоже раздавали в EGS. Помимо прочего, обновление 1.4 принесло в Deserts of Kharak промоэкран Homeworld 3 — следующей номерной игры серии. Космическая стратегия выйдет в феврале 2024 года, а на днях получила свежий сюжетный трейлер (прикреплён ниже). Чтобы стать обладателем бесплатной копии Homeworld: Deserts of Kharak в Epic Games Store, нужно лишь перейти на страницу игры и нажать «Получить». Товар автоматически прикрепится к учётной записи. Раздача Homeworld: Deserts of Kharak в Epic Games Store закончится 31 августа в 18:00 по Москве — в этот же момент бесплатной на неделю станет метроидвания Cave Story+, которая считается одной из самых известных инди-игр в истории. Американские рабочие обвинили руководство TSMC в бесхозяйственности и создании административного хаоса

24.08.2023 [19:04],

Павел Котов

Рабочие, занятые на строительстве завода тайваньского контрактного производителя полупроводников TSMC в Аризоне, утверждают, что возведение объекта задерживается из-за бесхозяйственности и административного хаоса в руководстве заказчика, пишет Business Insider. В TSMC эту позицию отвергают.

Источник изображения: bridgesward / pixabay.com В июле TSMC заявила, что запуск предприятия, вероятно, придётся перенести на 2025 год, и часть вины компания возложила на недостаток квалификации у американских рабочих. Чтобы исправить ситуацию, компания пытается получить визы для 500 тайваньских специалистов, которые помогут в строительстве и обучении на объекте, где заняты 12 000 человек. В ответ профсоюз Arizona Pipe Trades 469 Union, представляющий интересы более 4000 трубомонтажников, сантехников, сварщиков, а также специалистов по отоплению, вентиляции и кондиционированию, подал петицию, в которой призвал американских законодателей отказать в выдаче этих виз. По версии организации, TSMC намеренно исказила ситуацию с навыками, которыми обладают аризонские рабочие, и заменять их более «дешёвой» рабочей силой с Тайваня недопустимо. В TSMC, напротив, уверяют, что тайваньские специалисты не создадут угрозы для рабочих мест в США — на данном этапе строительства «сотрудничество местной рабочей силы и международного опытного персонала является обычной практикой для обеспечения высочайшего качества исполнения». Один из занятых на объекте американских рабочих настаивает, что задержка связана с управленческим звеном заказчика, которое просто не выделяет подрядчикам нужных ресурсов. Ему есть с чем сравнивать — ранее он был занят на объекте Intel. В отличие от американского электронного гиганта, руководство TSMC просто отдаёт распоряжение, что именно хочет получить, не предоставляя строителям ни чертежей, ни планов. Вместо них приходится ориентироваться по электронным письмам и изображениям с пометками, которые непросто расшифровать. Основные противоречия сводятся к культурным различиям: американские рабочие обвиняют TSMC в управленческих проблемах, а в TSMC говорят, что американскими рабочими трудно управлять.

Источник изображения: Michael Gaida / pixabay.com Впрочем, у местных подрядчиков накопилось к тайваньским заказчикам множество других претензий: нехватка материалов, которых порой приходится ждать по нескольку дней; отсутствие координации между специалистами разных профилей; систематические нарушения строительных норм — объект возводится согласно требованиям заказчика, но подписывать акты о проделанных работах подрядчики не хотят, поскольку это незаконно; наконец, пренебрежение техникой безопасности — груз в несколько центнеров может висеть над головами рабочих, а тайваньские специалисты ходят по объекту в теннисных туфлях, не надевая ни защитных очков, ни перчаток. Тайваньская сторона, напротив, уверяет, что регулярно проводит проверки на соблюдение техники безопасности, и зарегистрированных нарушений на объекте на 80 % меньше, чем в целом по стране. У американских рабочих есть вопросы и к организации строительства. До часа приходится ждать в очереди на выдачу защитного снаряжения, после чего оно может не подойти по размеру, и вешалка в раздевалке будет занята кем-то ещё. Кроме того, на местной парковке некорректно организовано движение транспорта. Наконец, претензии TSMC в отношении квалификации американских рабочих, по мнению последних, не выдерживают никакой критики: тайванцы не разу не уточнили, каких именно навыков не хватает американским подрядчикам, и их обучением тоже никто даже не думал заниматься. «Мы не против тайваньских рабочих или чего-то ещё. Мы против TSMC. Проблема в TSMC», — заключил один из строителей. Cherry обновила легендарные механические переключатели MX для клавиатур

24.08.2023 [18:55],

Сергей Сурабекянц

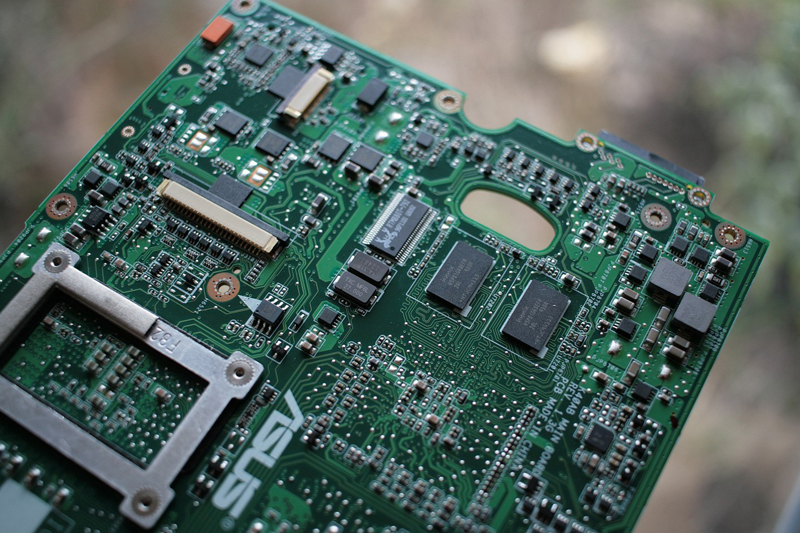

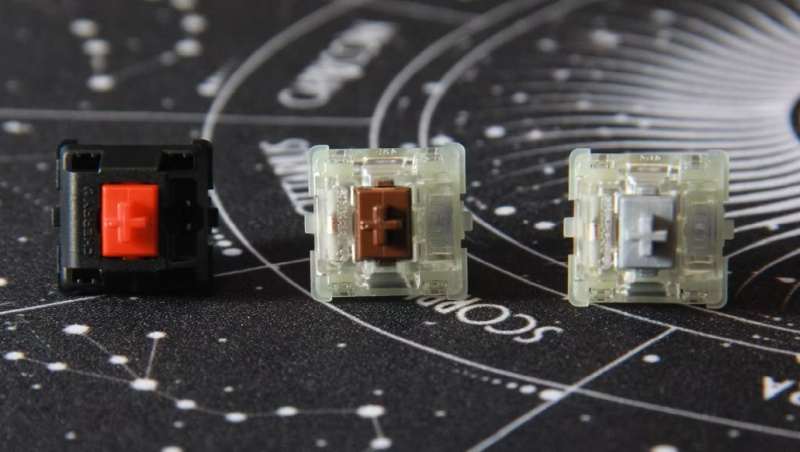

Cherry обновила механические переключатели MX для клавиатур. Переключатели Cherry MX2A имеют обновлённую конструкцию штоков и пружин с заводской смазкой, но по-прежнему совместимы с платами и колпачками для старых переключателей. На начальном этапе Cherry планирует выпустить следующую линейку обновлённых переключателей MX2A: Red, Silent Red, Brown, Black и Speed Silver, а также их версии с RGB-подсветкой.

Источник изображений: XDA Developers Первые переключатели Cherry MX были выпущены в далёком 1983 году и по сей день остаются образцом эргономики механических клавиатур, обеспечивая чёткую тактильную отдачу и высокую скорость отклика. Можно сказать, что переключатели MX стали де-факто промышленным стандартом. И вот после долгих лет исследований и разработки Cherry представила новое поколение своей оригинальной конструкции, получившее название MX2A.  Обновлённые переключатели MX2A представлены в знакомых энтузиастам вариантах линейных, тактильных и щелкающих переключателей с привычной цветовой кодировкой. MX2A отличаются от своих предшественников новой формой пружины — вместо цилиндрической она стала бочкообразной, что обеспечивает практически бесконтактное линейное движение и снижает деформацию пружины. Усиливает эффект центрирующий ребристый шток, который маркетологи Cherry назвали «короной рёбер» и заводская смазка. Все эти изменения в совокупности обеспечивают «более плавное срабатывание» и «улучшенную акустику», обеспечивая при этом гарантированные компанией 100 миллионов кликов без поломок.  Новые переключатели в ближайшее время начнут отгружаться партнёрам-производителям и появятся в новых моделях клавиатур в конце 2023 года, а затем станут доступны для любителей кастомизации в розничных магазинах. Первой клавиатурой, на которой будут установлены новые переключатели, станет K5V2 — новая модель в линейке XTRFY от Cherry. Meta✴ представила ИИ-генератор программного кода Code Llama

24.08.2023 [18:44],

Павел Котов

Компания Meta✴ выпустила инструмент под названием Code Llama — он основан на большой языковой ИИ-модели Llama 2 и предназначается для генерации программного кода, а также отладки кода, написанного человеком. Продукт издаётся под той же лицензией: он бесплатен для использования в исследовательских и коммерческих целях.

Источник изображения: Gerd Altmann / pixabay.com Code Llama генерирует код по описанию, а также завершает и отлаживает его при указании на определённую строку. В дополнение к базовой модели Code Llama выпустила две дополнительных: одну специализированную Code Llama-Python и вторую Code Llama-Instrct, которая воспринимает команды естественным языком. Модели взаимозаменяемыми не являются — базовую Code Llama и Code Llama-Python разработчик не рекомендует использовать для управления на естественном языке. В Meta✴ заявили, что Code Llama демонстрирует лучшие результаты в сравнении с общедоступными большими языковыми моделями — это подтверждают тесты производительности, хотя компания не уточнила, какие платформы участвовали в тестировании. В тесте HumanEval система набрала 53,7 % и смогла точно написать код на основе текстового описания. Разработчик выпустит три варианта Code Llama, меньший из которых можно будет запустить на системе с одним графическим процессором. Аналогичные продукты уже есть у конкурентов Meta✴: на основе OpenAI GPT-4 был запущен инструмент GitHub Copilot, у AWS есть CodeWhisperer, а Google разработала AlphaCode, но пока не выпустила его. На владеющую платформой GitHub компанию Microsoft уже подали в суд, обвинив её в том, что Copilot нарушает авторское право, поскольку воспроизводит чужой код. Razer выпустила обновлённый контроллер Kishi V2 Pro с тактильной отдачей и 3,5-мм разъёмом для наушников

24.08.2023 [18:38],

Дмитрий Федоров

Razer представила обновлённый игровой контроллер Kishi V2 Pro для Android-смартфонов. Новинка получила 3,5-мм аудиоразъём и поддержку тактильной обратной связи HyperSense Haptics. Однако не все инновации пришлись пользователям по душе.

Источник изображений: Razer Когда в начале года компания Razer выпустила портативную Android-консоль Edge для облачного гейминга, в комплекте с ней шёл улучшенный контроллер Razer Kishi V2 стоимостью $100. Этот контроллер для игр на Android-смартфоне напоминал своего известного конкурента — Backbone One. Теперь появилась возможность приобрести контроллер Kishi V2 Pro для Android по цене $130. Покупатели могут выбрать одну из двух версий: стандартную или лицензированную Xbox Edition с дополнительной кнопкой Xbox под правым джойстиком, которая стоит на $20 больше и доступна только в Северной Америке.  Pro-версия контроллера выделяется двумя ключевыми особенностями. Первая из них — это 3,5-мм разъём для проводных наушников. Это позволяет одновременно заряжать своё устройство через разъём USB Type-C и наслаждаться качественным звуком, что особенно актуально в условиях динамичных игровых сессий. Вторая особенность — это поддержка тактильной обратной связи. Эта функция позволяет игрокам более ярко и реалистично ощущать игровой процесс, добавляя дополнительные тактильные ощущения в ответ на игровые события.  Стоит отметить, что 3,5-мм разъём работает без нареканий, чего не скажешь про тактильную обратную связь Razer, которая, благодаря технологии вибрации HyperSense, должна анализировать форму и частоту звука в игре, превращая его в реалистичные тактильные эффекты. Во многих играх вибрация не соответствует игровым событиям, что создаёт странные ощущения, пишет CNET.  Дизайн контроллера остался прежним. В комплект входят специальные резиновые вставки, предназначенные для установки с обеих сторон устройства. Они обеспечивают более плотное и надёжное прилегание смартфона к контроллеру. Кроме того, они позволяют приподнять выступающую камеру смартфона, предотвращая её контакт с задней частью контроллера. Однако использование этих вставок может усложнить установку смартфона в контроллер.  С выпуском нового контроллера Razer обновила своё приложение Nexus, предназначенное для лучшего взаимодействия пользователя с устройством. Однако оно не всегда корректно работает с Xbox Game Pass, что может привести к потере связи с контроллером. В случае, если пользователь внезапно выходит из игры или приложения, связь с контроллером может прерваться, и для её восстановления придётся выполнить ряд действий вручную, что может создать некоторые неудобства. Intel Raptor Lake-S Refresh в среднем будут лишь на 3 % быстрее предшественников, подтвердила MSI

24.08.2023 [18:32],

Николай Хижняк

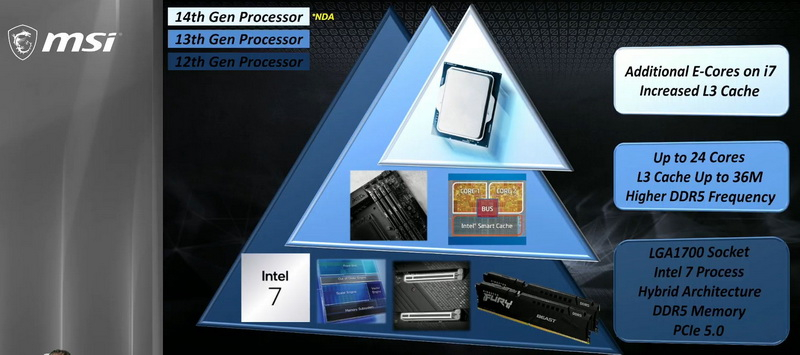

Компания MSI опубликовала на своём YouTube-канале видео, в котором подтвердила некоторые особенности будущих процессоров Intel Raptor Lake-S Refresh, а также обновлённой платформы LGA 1700. Публикация, очевидно, произошла раньше времени и вскоре видео было удалено.

Источник изображений: MSI Предоставленные MSI данные подтверждают, что значительных изменений обновлённые процессоры Intel Core 14-го поколения (Raptor Lake-S Refresh) не претерпели. Исключением является лишь одна модель из K-серии, которая получила увеличенное количество энергоэффективных ядер. Речь идёт о Core i7-14700K, который предложит 12 энергоэффективных ядер, тогда как у модели Core i7-13700K их было лишь восемь. Количество производительных P-ядер и энергоэффективных E-ядер у флагманского Core i9-14900K, а также у модели среднего звена Core i5-14600K остались прежними. Первый предложит конфигурацию ядер 8P + 16E, второй — 6P + 8E, как и Core i9-13900K и Core i5-13600K соответственно. Процессоры Raptor Lake-S Refresh будут производиться с использованием того же 10-нм технологического процесса Intel 7, что и актуальные модели Raptor Lake. Ключевым отличием новинок станет поддержка более скоростной памяти DDR5. Также немного вырастет объём кеш-памяти L3 и максимальные частоты. MSI также подтвердила, что Raptor Lake-S Refresh будут в среднем всего на 3 % быстрее текущего поколения процессоров Intel. Заметную прибавку в многопоточной производительности в виде 17 % получит лишь Core i7-14700K, что объясняется увеличенным количеством E-ядер. Intel официально представит процессоры Raptor Lake-S Refresh в сентябре, на мероприятии Innovation 2023. Ожидается анонс только моделей K и KF-серий c номинальным TDP 125 Вт. Модели без суффиксов K и KF с TDP 65 Вт придётся ждать до начала следующего года. Сражение с кровососом и подтверждение переноса на 2024 год: вышел новый геймплейный трейлер S.T.A.L.K.E.R. 2: Heart of Chornobyl

24.08.2023 [18:04],

Дмитрий Рудь

Студия GSC Game World в рамках проходящей сейчас в Германии игровой выставки gamescom 2023 представила новый геймплейный трейлер постапокалиптического шутера с открытым миром S.T.A.L.K.E.R. 2: Heart of Chornobyl. В отличие от первого полноценного трейлера новой Call of Duty: Modern Warfare 3, свежий ролик S.T.A.L.K.E.R. 2: Heart of Chornobyl действительно геймплейный — все полторы минуты видео наполнены кадрами игрового процесса. Разработчики показали несколько локаций, перестрелки с людьми и монстрами (включая кровососа), взаимодействие с аномалиями посредством болтов, использование разных видов оружия, а также актуальную версию внутриигрового интерфейса. Помимо прочего, новый геймплейный трейлер S.T.A.L.K.E.R. 2: Heart of Chornobyl подтвердил изменение сроков выхода игры. Как и предполагал официальный набор для прессы, релиз проекта перенесли на первый квартал 2024 года. S.T.A.L.K.E.R. 2: Heart of Chornobyl создаётся для PC (Steam, GOG, EGS, Microsoft Store), Xbox Series X и S, а также сервиса Game Pass (PC и Xbox). Посетителям gamescom 2023 для ознакомления доступна демоверсия проекта. Corsair анонсировала двухметровый геймерский стол с электромотором, за которым можно играть как сидя, так и стоя

24.08.2023 [17:47],

Павел Котов

Компания Corsair представила двухметровый модульный компьютерный стол Platform:6, предназначенный для всех категорий пользователей: работников по удалёнке, блогеров и геймеров. Приобрести его можно будет в IV квартале этого года, но на сайте производителя пока не указана цена и не перечислены аксессуары для него, которых будет множество.

Источник изображения: Corsair Corsair Platform:6 будет предлагаться в нескольких версиях — для этого на сайте есть онлайн-конфигуратор, но он же вызывает затруднения с ответом на вопрос, что входит в стандартную комплектацию, а что доступно в качестве модульного дополнения. В пресс-релизе производителя говорится, что стол оборудуется двумя держателями для мониторов, лотком для скрытой прокладки кабелей, ящиком для хранения вещей и встроенными портами USB Type-A и Type-C для зарядки. Интерес представляет модульная система встроенных в стол направляющих, позволяющих устанавливать дополнительные компоненты, чтобы не загромождать рабочую поверхность.  В версии Creator Edition предлагается система моторизованной регулировки высоты с возможностью запоминать настройки. Есть боковые удлинители 30 × 70 см, которые сделают стол шириной более 180 см ещё шире, а также полки для наушников, игровых контроллеров и прочей периферии. Corsair также обещает адаптеры для линейки аксессуаров Elgato Multi-Mount для крепления камер, микрофонов и осветительных приборов. DigiTimes Research: поставки ИИ-серверов в 2024 году превысят 300 тыс. штук

24.08.2023 [17:33],

Сергей Карасёв

DigiTimes Research обнародовала прогноз по мировому рынку серверов, ориентированных на работу с ресурсоёмкими приложениями ИИ. Аналитики полагают, что спрос на такие системы в ближайшие годы будет устойчиво расти. По оценкам, поставки высокопроизводительных ИИ-серверов в 2023 году составят около 167 тыс. единиц. В 2024-м, считают эксперты DigiTimes Research, этот показатель достигнет 337 тыс. штук. Таким образом, ожидается двукратный рост. Вместе с тем рынок генеративного ИИ в целом до конца десятилетия будет демонстрировать среднегодовой темп роста в сложных процентах (CAGR) на уровне 35 %, так что к 2030-му его объём может достичь $109 млрд. По словам вице-президента DigiTimes Research Эрика Хуанга (Eric Huang), ажиотаж вокруг ИИ немного утих, но эти технологии продолжат стимулировать закупки серверов среди ведущих облачных провайдеров и гиперскейлеров — Microsoft Azure, Amazon Web Services (AWS), Google Cloud, Core Weave, Meta✴, Oracle и Twitter (теперь называется X), что подтверждает и последний квартальный отчёт NVIDIA, текущего лидера в области ИИ.

Источник изображения: Microsoft Хотя спрос на ИИ-серверы растёт, существует и ряд сложностей. Одна из них заключается в обеспечении поставок необходимых объёмов высокоскоростной памяти HBM для ускорителей. Согласно прогнозам, отгрузки таких изделий в 2024 году увеличатся на 105 % по сравнению с 2023-м. Ожидается, что преобладающим методом для выпуска ИИ-чипов будет Chip on Wafer on Substrate (CoWoS) от TSMC, позволяющий разместить на одной подложке до 12 стеков памяти HBM. Но возможности самой TSMC по выпуску чипов с применением CoWoS будут ограничены в связи с растущим спросом на такие изделия со стороны AMD, Google и других компаний. TSMC начнёт производство подобной продукции на своём новом заводе в Тунлуо (Тайвань) в 2027 году: ожидается, что предприятие сможет ежемесячно изготавливать более 110 тыс. единиц продукции. GeForce Now и другие облачные игровые платформы появятся на смарт-телевизорах Samsung 2020 года

24.08.2023 [17:29],

Павел Котов

Samsung сообщила, что в этом году на смарт-телевизорах образца 2020 года появятся приложения для облачных игр. Корейский производитель сделал это заявление на мероприятии Gamescom, но не уточнил, каких моделей это коснётся, и когда именно появятся эти приложения.

Источник изображения: samsung.com «Сегодня мы с радостью объявляем, что в этом году расширим приложения облачных игр на наши телевизоры модельного ряда 2020 года, открыв десяткам миллионов геймеров доступ к любимым играм и сервисам», — заявил глава отдела игровых продуктов Samsung Майк Лучеро (Mike Lucero). Приложения для облачных игровых платформ Gaming Hub на смарт-телевизорах и мониторах Samsung модельного ряда 2022 года дебютировали прошлым летом, а в ноябре отдельные приложения появились на моделях 2021 года. Gaming Hub включает клиенты Xbox Cloud Gaming, NVIDIA GeForce Now и Amazon Luna. Полноценного Gaming Hub на смарт-телевизорах Samsung образца 2020 года не будет — придётся обходиться отдельными приложениями. Список поддерживаемых облачных игровых платформ корейский производитель не сообщил, но, вероятно, в числе первых появятся клиенты Xbox Cloud Gaming и NVIDIA GeForce Now. «Этот фундаментальный сдвиг не закончится»: благодаря ИИ-буму Дженсен Хуанг разглядел на горизонте золотые горы

24.08.2023 [17:25],

Алексей Разин

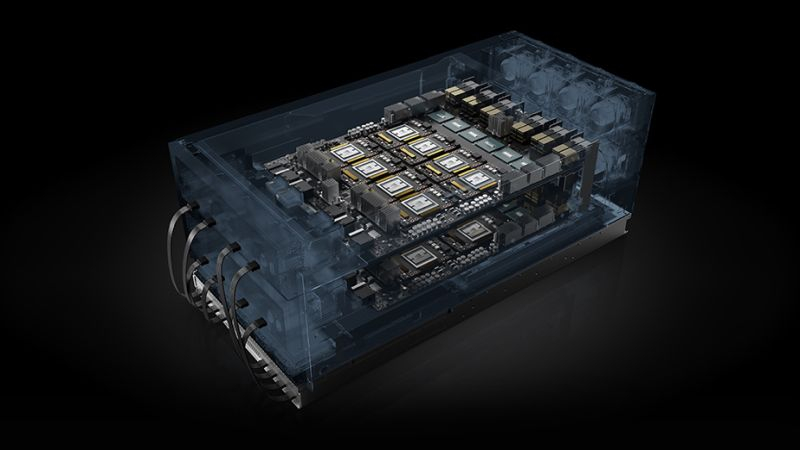

На квартальной отчётной конференции NVIDIA основатель компании Дженсен Хуанг (Jensen Huang) несколько раз заявил, что оценивает ёмкость серверного рынка в $1 трлн, и с учётом начала новой фазы его масштабной структурной перестройки верит, что профильная выручка компании будет расти на протяжении нескольких ближайших лет. Эту уверенность руководство NVIDIA готово подкрепить, выделив на выкуп акций компании $25 млрд.

Источник изображения: NVIDIA На подобные шаги, как отмечает Reuters, руководство публичных компаний идёт обычно в тех случаях, когда убеждено в серьёзной недооценённости их активов. Казалось бы, до начала основной торговой сессии акции NVIDIA после публикации квартального отчёта с рекордной выручкой в серверном сегменте выросли на 7,43 % и получили все шансы обновить исторический максимум на отметках свыше $500 за штуку, но заявление о выделении $25 млрд на их выкуп подразумевает, что руководство NVIDIA убеждено в их способности расти в цене и дальше. Инвесторы, чьи интересы неформально на отчётном мероприятии представляли аналитики, выразили озабоченность угрозой дефицита ускорителей вычислений NVIDIA в условиях постоянно растущего спроса. Руководству компании пришлось уверять их, что каждый квартал на протяжении ближайших полутора лет объёмы поставок будут наращиваться, и предварительная работа с подрядчиками и поставщиками на этом направлении ведётся самым серьёзным образом. По информации источников Financial Times, в следующем году NVIDIA выпустит 1,5–2 млн ускорителей H100, что значительно больше 500 тыс. в этом году. О том, что это непросто организовать, говорят хотя бы замечания основателя NVIDIA, который напомнил, что одна система серии HGX содержит около 35 000 компонентов, стоит $200 000 и весит почти 32 кг. И проблемы с поставок самого мелкого чипа могут вызвать задержку с наращиванием объёмов производства таких систем. Серверные и сетевые компоненты в минувшем квартале принесли NVIDIA более 76 % всей выручки против почти 60 % кварталом ранее. Спросом в этом сегменте движут два фактора, как отметили руководители NVIDIA: миграция серверных систем с CPU на компоненты, использующие GPU в качестве основной производительной единицы, а также взрывной всплеск интереса к системам генеративного искусственного интеллекта и большим языковым моделям. Компания, по словам генерального директора, всего лишь один полный квартал работает в таких условиях, и они сохранятся на протяжении многих последующих кварталов. «Этот фундаментальный сдвиг не закончится», — сказал Хуанг о переходе дата-центров от CPU к GPU. Крупнейшие американские компании технологического сектора тратят внушительные средства на закупку компонентов для систем искусственного интеллекта. Microsoft в прошлом квартале выделила $10,7 млрд на капитальные расходы, и значительная часть этой суммы наверняка была потрачена на компоненты NVIDIA. Стартап OpenAI, который представил популярный чат-бот ChatGPT, получил от Microsoft финансовые вливания в размере $10 млрд. Meta✴ Platforms и облачное подразделение Amazon в совокупности тоже тратят десятки миллиардов долларов на развитие соответствующей вычислительной инфраструктуры. Складских запасов NVIDIA, чья балансовая стоимость на конец июля составляла $4,32 млрд, по мнению аналитиков Summit Insights Group, при существующем уровне спроса на ускорители вычислений едва хватит для его удовлетворения. Собственный прогноз по выручке в текущем квартале ($16 млрд) компания может превзойти без особых усилий, как считают эксперты. В то же время, редактор блога SemiAnalysis Дилан Пател (Dylan Patel) уверен, что не все клиенты NVIDIA будут закупать ускорители вычислений в текущих объёмах и дальше. Некоторые из них наберут критическую массу вычислительных ресурсов, и после оценки собственных перспектив на рынке могут прекратить закупки на какое-то время. Эта неделя характеризовалась и ещё одним важным для оценки рыночных перспектив NVIDIA событием. Как поясняет Bloomberg, из списка регулярно опрашиваемых агентством аналитических компаний сдалась последняя, которая до этого рекомендовала инвесторам продавать акции NVIDIA. Компания Morningstar Inc. сменила рекомендацию на «держать», и теперь из 59 опрашиваемых Bloomberg аналитиков 54 выступают за покупку акций NVIDIA, а оставшиеся пять просто рекомендуют инвесторам держать эти ценные бумаги в своём портфеле. Представители Morningstar теперь считают, что если в прошлом фискальном году NVIDIA выручила в серверном сегменте $15 млрд, то в текущем выручит уже $41 млрд. По их мнению, в следующем фискальном году эта сумма увеличится до $60 млрд, а к 2028 году достигнет $100 млрд. TeamGroup представила кулер T-Force DARK AirFlow I для SSD и 120-мм вентилятор T-Force RT-X120 ARGB

24.08.2023 [17:19],

Николай Хижняк

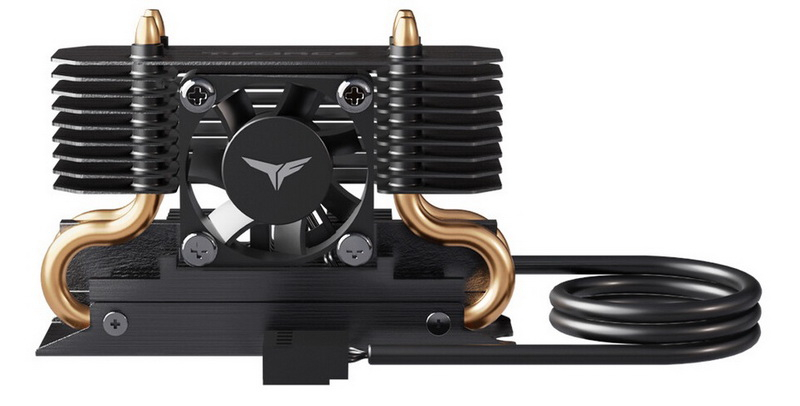

Игровой бренд T-Force компании TeamGroup представил новую систему охлаждения T-Force DARK AirFlow I SSD Cooler для твердотельных NVMe-накопителей формата M.2 2280 (главным образом для горячих моделей с интерфейсом PCIe 5.0), а также новый 120-мм вентилятор T-Force RT-X120 ARGB для корпусов, кулеров и радиаторов СЖО.

Источник изображений: TeamGroup Производитель отмечает, что в составе системы охлаждения T-Force DARK AirFlow I SSD Cooler используется запатентованная двухслойная структура основания с применением графена, две теплопроводящие трубки диаметром 5 мм, а также алюминиевый радиатор для эффективного увеличения площади рассеивания тепла. Система охлаждения также оснащена компактным вентилятором с автоматической регулировкой скорости работы (ШИМ) в зависимости от нагрузки на SSD.  Вентилятор T-Force RT-X120 ARGB получил крыльчатку закрытого типа с внешним кольцом. Такая конструкция более жёсткая и обеспечивает направленный поток воздуха с высоким статическим давлением. Вентилятор оснащён антивибрационными накладками, а в его основе используется мотор, рассчитанный на 50 000 часов работы на отказ.

Для новинки также заявляется поддержка технологии ШИМ для автоматической регулировки скорости работы. Вентилятор оперирует в диапазоне от 600 до 2200 об/мин, создаёт воздушный поток до 71,12 кубических футов в минуту (CFM) и статическое давление до 3,62 мм вод. ст. В продаже новинка будет доступна в чёрном и белом цветах.  ARGB-подсветкой вентилятора можно управлять с помощью самых популярных утилит для регулировки подсветки, включая ASUS Aura Sync, Gigabyte RGB Fusion 2.0, MSI Mystic Light Sync и ASRock Polychrome Sync. Оба представленных продукта ожидаются в продаже с октября. SpaceX с помощью Cloudflare повысит скорость спутникового интернета Starlink

24.08.2023 [17:11],

Владимир Фетисов

По сообщениям сетевых источников, принадлежащая Илону Маску (Elon Musk) компания SpaceX сотрудничает с CDN-провайдером Cloudflare, чтобы повысить производительность своего спутникового интернет-сервиса Starlink. Об этом пишет издание The Information со ссылкой на собственный осведомлённый источник, принимающий непосредственное участие в данном проекте.

Источник изображения: starlink.com В сообщении сказано, что компании работают над расширением сети мини-центров обработки данных Starlink по всему миру. За счёт этого SpaceX сумеет обеспечить более высокую пропускную способность для своих клиентов, являющихся пользователями сети Starlink. На фоне этой новости стоимость акций Cloudflare подскочила на 7,2 %. Что касается сети Starlink, то в ней используются телекоммуникационный спутники, доставкой которых на орбиту активно занимается SpaceX. Помимо компании Илона Маска над созданием спутниковой сети для предоставления широкополосного доступа в интернет работают американская компания Amazon и британская OneWeb. Официальные представители SpaceX и Cloudflare пока воздерживаются от комментариев по вопросам, связанным с сотрудничеством компаний. Вышли обзоры Ryzen 9 7945HX3D — это самый быстрый мобильный процессор для игр

24.08.2023 [17:02],

Николай Хижняк

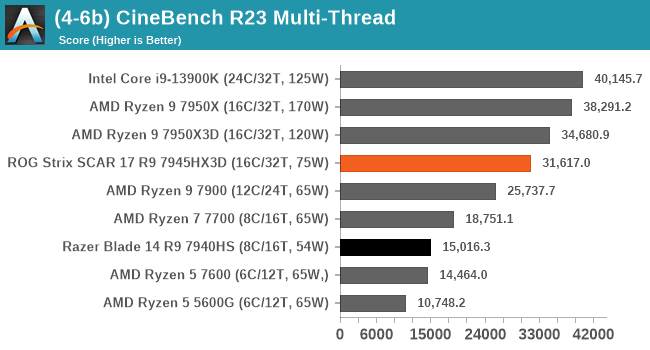

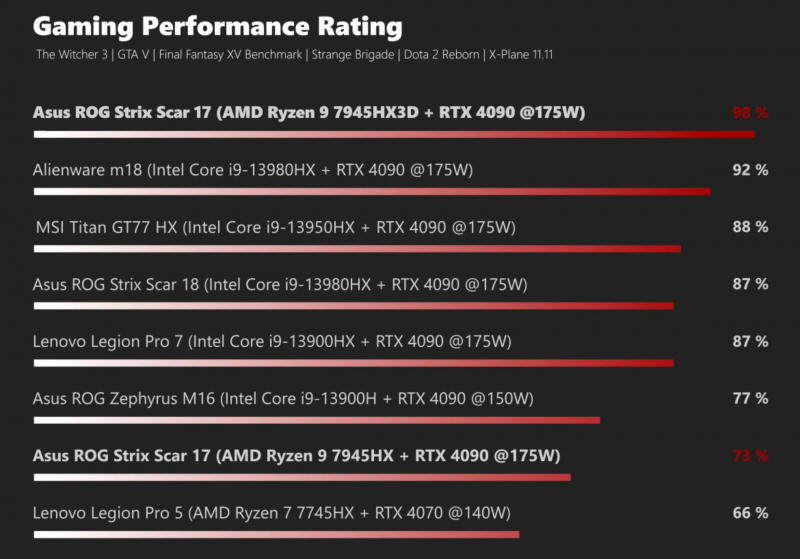

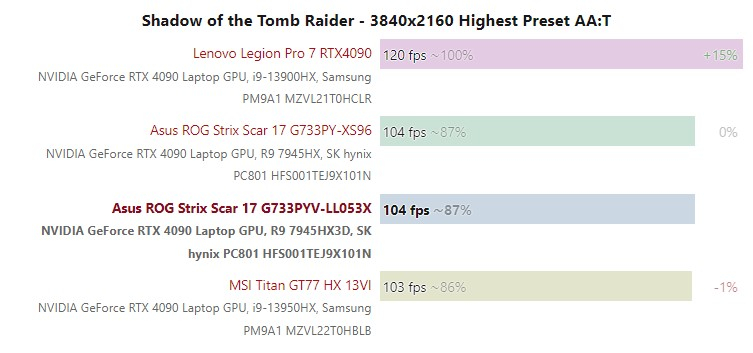

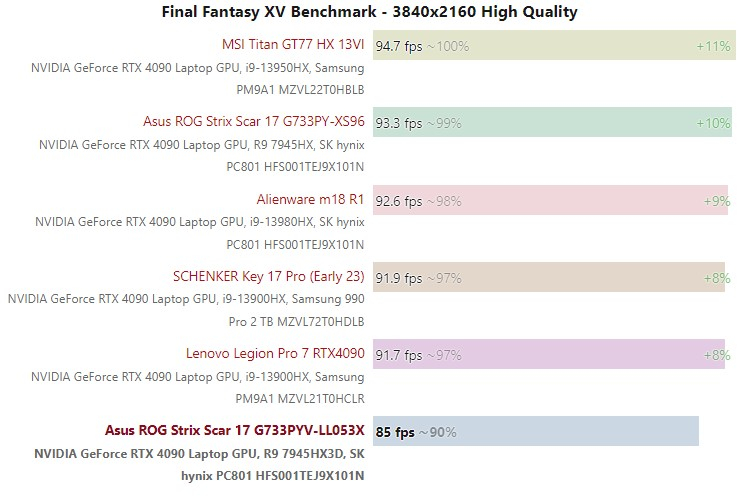

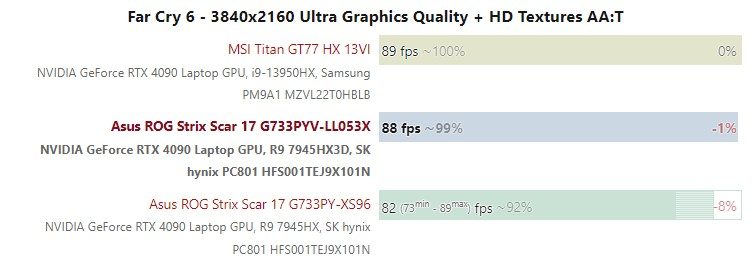

На днях в Сети появились обзоры ASUS ROG Strix Scar 17 — первого и пока единственного ноутбука с первым мобильным процессором с дополнительной кеш-памятью 3D V-Cache — флагманским 16-ядерным Ryzen 9 7945HX3D. Обозреватели утверждают, что это самый быстрый игровой мобильный процессор в мире.

Источник изображения: VideoCardz Процессор Ryzen 9 7945HX3D имеет 16 ядер с поддержкой 32 виртуальных потоков и работает с тактовой частотой до 5,4 ГГц. Базовая частота чипа составляет 2,3 ГГц, что на 200 МГц ниже, чем у обычной версии Ryzen 9 7945HX. Модель Ryzen 9 7945HX3D имеет динамический TDP от 55 до 75 Вт. Чип получил 128 Мбайт кеш-памяти 3D V-Cache, расположенной поверх одного из чиплетов CCD, формально копируя эту особенность у старших моделей десктопных процессоров Ryzen 7000X3D. Правда, последние оснащаются только 96 Мбайт кеш-памяти 3D V-Cache, а объём обычной кеш-памяти L3 у них составляет 32 Мбайт. В составе мобильного чипа также присутствуют два исполнительных блока встроенной графики Radeon 610M на архитектуре RDNA 2. Для процессоров Ryzen 7000X3D компания AMD выпустила специальный драйвер PPM Provision Driver и утилиту 3D V-Cache Performance Optimizer, которые в сочетании с игровым режимом операционной системы Windows отвечают за распределение потоков по ядрам и CCD и определяют, какой из чиплетов — с дополнительной кеш-памятью 3D V-Cache или без неё — необходимо использовать в конкретной задаче.

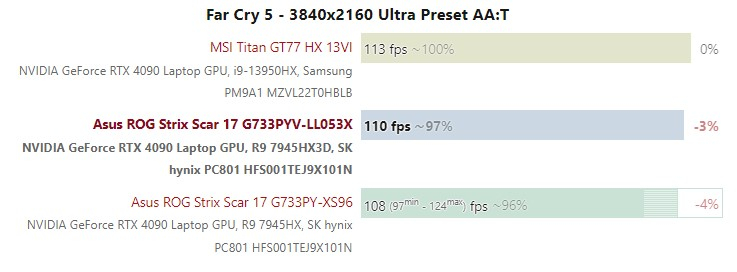

Источник изображения: AnandTech Количество обзоров ASUS ROG Strix Scar 17 с Ryzen 9 7945HX3D можно посчитать по пальцам. Видимо, AMD и ASUS решили предоставить тестовые образцы лэптопов весьма ограниченному числу обозревателей. Последние в свою очередь пришли к консенсусу, что Ryzen 9 7945HX3D является лучшим мобильным процессором для игр. В частности, при разрешении 1080p.

Источник изображения: Notebook Check Однако при использовании разрешения QHD производительность чипа несколько проседает. И использование чиплета CCD процессора с 3D V-Cache в качестве основного демонстрирует более низкую производительность, чем CCD без дополнительной кеш-памяти, говорится в публикации портала AnandTech. В играх с 4K-разрешением дополнительная кеш-память пользы никакой не приносит, поскольку быстродействие ограничивается возможностями мобильной видеокарты, что показывают результаты тестов портала Notebook Check на графиках ниже.

К сожалению, никто из источников не указал точной стоимости ноутбука ASUS ROG Strix Scar 17 с процессором Ryzen 9 7945HX3D. Однако с учётом того, что точно такая же модель ноутбука, в такой же конфигурации, но с процессором Ryen 9 7945HX без кеш-памяти 3D V-Cache предлагается примерно за $3000, версия Ryzen 9 7945HX3D, вероятно, будет оцениваться в диапазоне 3200–3500 долларов, предполагают обозреватели. Microsoft Edge начал помечать установочный файл Google Chrome как вредоносный

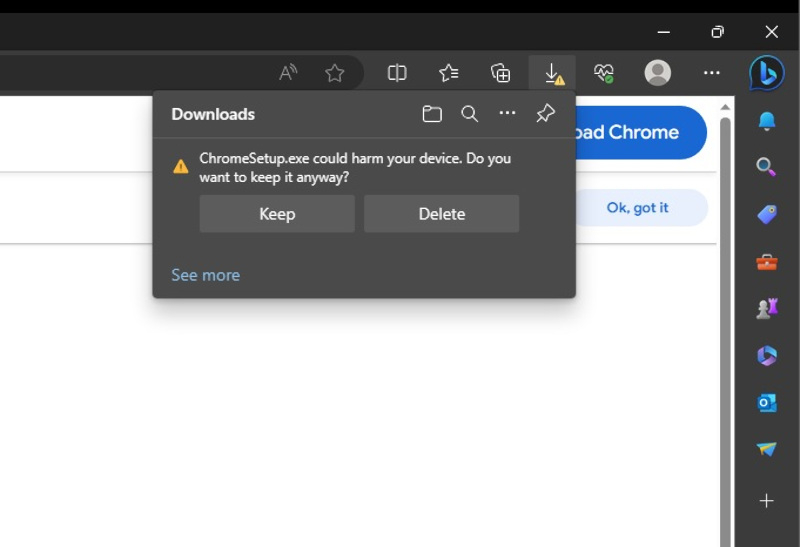

24.08.2023 [16:51],

Павел Котов

Microsoft Edge под Windows 10 и 11 начал помечать установочный файл конкурирующего браузера Google Chrome как потенциально вредоносный. Череда всплывающих окон предлагает удалить файл «ChromeSetup.exe» и вместо него попробовать пользоваться Edge. Ошибка проявляется только в версии Microsoft Edge 116 и только для некоторых пользователей, сообщает ресурс Windows Latest.

Источник изображения: windowslatest.com При попытке загрузить Chrome браузер от Microsoft демонстрирует предупреждающее сообщение: «ChromeSetup.exe может нанести вред вашему устройству. Вы всё равно хотите сохранить его?» — и предлагает либо сохранить, либо удалить установочный файл Google Chrome. Microsoft уже не впервые предпринимает шаги, направленные на то, чтобы повысить популярность Edge среди пользователей и отговорить их переходить на Chrome. В ход шли самые разные приёмы: показ рекламы Edge на странице поиска по запросу о скачивании браузера в Bing или непосредственно на странице загрузки конкурирующего браузера. Разработчик Windows также пытался усложнить процедуру смены браузера по умолчанию в системе, но впоследствии был вынужден отказаться от этой затеи. А в апрельском обновлении перестала работать кнопка выбора Chrome браузером по умолчанию в один клик — система начала забрасывать корпоративных пользователей системными окнами. Oppo назначила презентацию смартфона-раскладушки Find N3 Flip и смарт-часов Watch 4 Pro на 29 августа

24.08.2023 [16:45],

Владимир Мироненко

Oppo объявила дату презентации смартфона-раскладушки Find N3 Flip — 29 августа. Сообщается, что у раскладушки Oppo нового поколения будет такой же дизайн с вертикальным внешним экраном, как у предшественника, и он станет первым в этой категории устройством с тройной камерой. Имеющийся на корпусе логотип Hasselblad говорит об участии в разработке камеры известного шведского производителя фотографического оборудования.

Источник изображений: Oppo Oppo пока не стала раскрывать подробности о характеристиках Find N3 Flip, поскольку устройства в формфакторе раскладушки зачастую позиционируются скорее как необычный аксессуар, а не как смартфон для работы и развлечений. Вместе с тем на фото можно заметить, что у Find N3 Flip имеется боковой сканер отпечатков пальцев, как и у предыдущей модели.  Вместе с Find N3 Flip на мероприятии представят смарт-часы Oppo Watch 4 Pro, которые судя по пресс-фото обладают изогнутым экраном и будут доступны в двух цветовых вариантах корпуса — сером и чёрном.  Watch 4 Pro имеют такой же дизайн с прямоугольным дисплеем, как у предшественника, получив при этом дополнительную кнопку. Смарт-часы будут предлагаться как минимум с двумя ремешками. Один из них изготовлен из резины/фторэластомера, второй — кожаный.  До презентации новинок осталось несколько дней, так что не исключено, что Oppo поделиться ещё какими-то подробностями о новинках до анонса. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |