|

Опрос

|

реклама

Быстрый переход

Американские рабочие обвинили руководство TSMC в бесхозяйственности и создании административного хаоса

24.08.2023 [19:04],

Павел Котов

Рабочие, занятые на строительстве завода тайваньского контрактного производителя полупроводников TSMC в Аризоне, утверждают, что возведение объекта задерживается из-за бесхозяйственности и административного хаоса в руководстве заказчика, пишет Business Insider. В TSMC эту позицию отвергают.

Источник изображения: bridgesward / pixabay.com В июле TSMC заявила, что запуск предприятия, вероятно, придётся перенести на 2025 год, и часть вины компания возложила на недостаток квалификации у американских рабочих. Чтобы исправить ситуацию, компания пытается получить визы для 500 тайваньских специалистов, которые помогут в строительстве и обучении на объекте, где заняты 12 000 человек. В ответ профсоюз Arizona Pipe Trades 469 Union, представляющий интересы более 4000 трубомонтажников, сантехников, сварщиков, а также специалистов по отоплению, вентиляции и кондиционированию, подал петицию, в которой призвал американских законодателей отказать в выдаче этих виз. По версии организации, TSMC намеренно исказила ситуацию с навыками, которыми обладают аризонские рабочие, и заменять их более «дешёвой» рабочей силой с Тайваня недопустимо. В TSMC, напротив, уверяют, что тайваньские специалисты не создадут угрозы для рабочих мест в США — на данном этапе строительства «сотрудничество местной рабочей силы и международного опытного персонала является обычной практикой для обеспечения высочайшего качества исполнения». Один из занятых на объекте американских рабочих настаивает, что задержка связана с управленческим звеном заказчика, которое просто не выделяет подрядчикам нужных ресурсов. Ему есть с чем сравнивать — ранее он был занят на объекте Intel. В отличие от американского электронного гиганта, руководство TSMC просто отдаёт распоряжение, что именно хочет получить, не предоставляя строителям ни чертежей, ни планов. Вместо них приходится ориентироваться по электронным письмам и изображениям с пометками, которые непросто расшифровать. Основные противоречия сводятся к культурным различиям: американские рабочие обвиняют TSMC в управленческих проблемах, а в TSMC говорят, что американскими рабочими трудно управлять.

Источник изображения: Michael Gaida / pixabay.com Впрочем, у местных подрядчиков накопилось к тайваньским заказчикам множество других претензий: нехватка материалов, которых порой приходится ждать по нескольку дней; отсутствие координации между специалистами разных профилей; систематические нарушения строительных норм — объект возводится согласно требованиям заказчика, но подписывать акты о проделанных работах подрядчики не хотят, поскольку это незаконно; наконец, пренебрежение техникой безопасности — груз в несколько центнеров может висеть над головами рабочих, а тайваньские специалисты ходят по объекту в теннисных туфлях, не надевая ни защитных очков, ни перчаток. Тайваньская сторона, напротив, уверяет, что регулярно проводит проверки на соблюдение техники безопасности, и зарегистрированных нарушений на объекте на 80 % меньше, чем в целом по стране. У американских рабочих есть вопросы и к организации строительства. До часа приходится ждать в очереди на выдачу защитного снаряжения, после чего оно может не подойти по размеру, и вешалка в раздевалке будет занята кем-то ещё. Кроме того, на местной парковке некорректно организовано движение транспорта. Наконец, претензии TSMC в отношении квалификации американских рабочих, по мнению последних, не выдерживают никакой критики: тайванцы не разу не уточнили, каких именно навыков не хватает американским подрядчикам, и их обучением тоже никто даже не думал заниматься. «Мы не против тайваньских рабочих или чего-то ещё. Мы против TSMC. Проблема в TSMC», — заключил один из строителей. Cherry обновила легендарные механические переключатели MX для клавиатур

24.08.2023 [18:55],

Сергей Сурабекянц

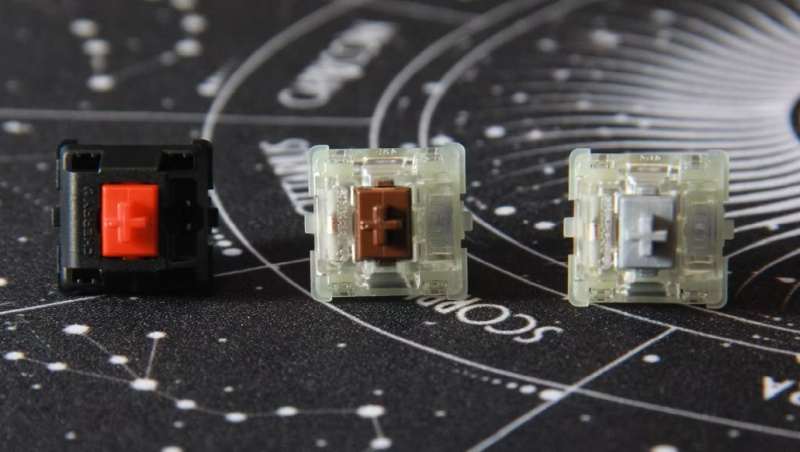

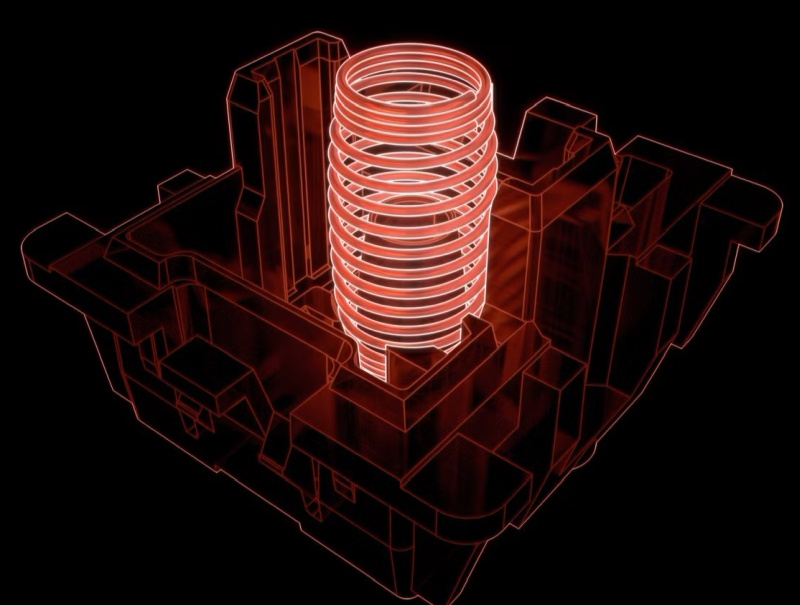

Cherry обновила механические переключатели MX для клавиатур. Переключатели Cherry MX2A имеют обновлённую конструкцию штоков и пружин с заводской смазкой, но по-прежнему совместимы с платами и колпачками для старых переключателей. На начальном этапе Cherry планирует выпустить следующую линейку обновлённых переключателей MX2A: Red, Silent Red, Brown, Black и Speed Silver, а также их версии с RGB-подсветкой.

Источник изображений: XDA Developers Первые переключатели Cherry MX были выпущены в далёком 1983 году и по сей день остаются образцом эргономики механических клавиатур, обеспечивая чёткую тактильную отдачу и высокую скорость отклика. Можно сказать, что переключатели MX стали де-факто промышленным стандартом. И вот после долгих лет исследований и разработки Cherry представила новое поколение своей оригинальной конструкции, получившее название MX2A.  Обновлённые переключатели MX2A представлены в знакомых энтузиастам вариантах линейных, тактильных и щелкающих переключателей с привычной цветовой кодировкой. MX2A отличаются от своих предшественников новой формой пружины — вместо цилиндрической она стала бочкообразной, что обеспечивает практически бесконтактное линейное движение и снижает деформацию пружины. Усиливает эффект центрирующий ребристый шток, который маркетологи Cherry назвали «короной рёбер» и заводская смазка. Все эти изменения в совокупности обеспечивают «более плавное срабатывание» и «улучшенную акустику», обеспечивая при этом гарантированные компанией 100 миллионов кликов без поломок.  Новые переключатели в ближайшее время начнут отгружаться партнёрам-производителям и появятся в новых моделях клавиатур в конце 2023 года, а затем станут доступны для любителей кастомизации в розничных магазинах. Первой клавиатурой, на которой будут установлены новые переключатели, станет K5V2 — новая модель в линейке XTRFY от Cherry. Meta✴ представила ИИ-генератор программного кода Code Llama

24.08.2023 [18:44],

Павел Котов

Компания Meta✴ выпустила инструмент под названием Code Llama — он основан на большой языковой ИИ-модели Llama 2 и предназначается для генерации программного кода, а также отладки кода, написанного человеком. Продукт издаётся под той же лицензией: он бесплатен для использования в исследовательских и коммерческих целях.

Источник изображения: Gerd Altmann / pixabay.com Code Llama генерирует код по описанию, а также завершает и отлаживает его при указании на определённую строку. В дополнение к базовой модели Code Llama выпустила две дополнительных: одну специализированную Code Llama-Python и вторую Code Llama-Instrct, которая воспринимает команды естественным языком. Модели взаимозаменяемыми не являются — базовую Code Llama и Code Llama-Python разработчик не рекомендует использовать для управления на естественном языке. В Meta✴ заявили, что Code Llama демонстрирует лучшие результаты в сравнении с общедоступными большими языковыми моделями — это подтверждают тесты производительности, хотя компания не уточнила, какие платформы участвовали в тестировании. В тесте HumanEval система набрала 53,7 % и смогла точно написать код на основе текстового описания. Разработчик выпустит три варианта Code Llama, меньший из которых можно будет запустить на системе с одним графическим процессором. Аналогичные продукты уже есть у конкурентов Meta✴: на основе OpenAI GPT-4 был запущен инструмент GitHub Copilot, у AWS есть CodeWhisperer, а Google разработала AlphaCode, но пока не выпустила его. На владеющую платформой GitHub компанию Microsoft уже подали в суд, обвинив её в том, что Copilot нарушает авторское право, поскольку воспроизводит чужой код. Razer выпустила обновлённый контроллер Kishi V2 Pro с тактильной отдачей и 3,5-мм разъёмом для наушников

24.08.2023 [18:38],

Дмитрий Федоров

Razer представила обновлённый игровой контроллер Kishi V2 Pro для Android-смартфонов. Новинка получила 3,5-мм аудиоразъём и поддержку тактильной обратной связи HyperSense Haptics. Однако не все инновации пришлись пользователям по душе.

Источник изображений: Razer Когда в начале года компания Razer выпустила портативную Android-консоль Edge для облачного гейминга, в комплекте с ней шёл улучшенный контроллер Razer Kishi V2 стоимостью $100. Этот контроллер для игр на Android-смартфоне напоминал своего известного конкурента — Backbone One. Теперь появилась возможность приобрести контроллер Kishi V2 Pro для Android по цене $130. Покупатели могут выбрать одну из двух версий: стандартную или лицензированную Xbox Edition с дополнительной кнопкой Xbox под правым джойстиком, которая стоит на $20 больше и доступна только в Северной Америке.  Pro-версия контроллера выделяется двумя ключевыми особенностями. Первая из них — это 3,5-мм разъём для проводных наушников. Это позволяет одновременно заряжать своё устройство через разъём USB Type-C и наслаждаться качественным звуком, что особенно актуально в условиях динамичных игровых сессий. Вторая особенность — это поддержка тактильной обратной связи. Эта функция позволяет игрокам более ярко и реалистично ощущать игровой процесс, добавляя дополнительные тактильные ощущения в ответ на игровые события.  Стоит отметить, что 3,5-мм разъём работает без нареканий, чего не скажешь про тактильную обратную связь Razer, которая, благодаря технологии вибрации HyperSense, должна анализировать форму и частоту звука в игре, превращая его в реалистичные тактильные эффекты. Во многих играх вибрация не соответствует игровым событиям, что создаёт странные ощущения, пишет CNET.  Дизайн контроллера остался прежним. В комплект входят специальные резиновые вставки, предназначенные для установки с обеих сторон устройства. Они обеспечивают более плотное и надёжное прилегание смартфона к контроллеру. Кроме того, они позволяют приподнять выступающую камеру смартфона, предотвращая её контакт с задней частью контроллера. Однако использование этих вставок может усложнить установку смартфона в контроллер.  С выпуском нового контроллера Razer обновила своё приложение Nexus, предназначенное для лучшего взаимодействия пользователя с устройством. Однако оно не всегда корректно работает с Xbox Game Pass, что может привести к потере связи с контроллером. В случае, если пользователь внезапно выходит из игры или приложения, связь с контроллером может прерваться, и для её восстановления придётся выполнить ряд действий вручную, что может создать некоторые неудобства. Intel Raptor Lake-S Refresh в среднем будут лишь на 3 % быстрее предшественников, подтвердила MSI

24.08.2023 [18:32],

Николай Хижняк

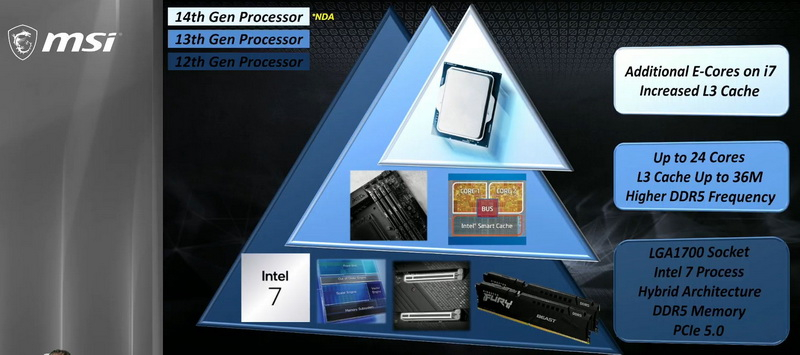

Компания MSI опубликовала на своём YouTube-канале видео, в котором подтвердила некоторые особенности будущих процессоров Intel Raptor Lake-S Refresh, а также обновлённой платформы LGA 1700. Публикация, очевидно, произошла раньше времени и вскоре видео было удалено.

Источник изображений: MSI Предоставленные MSI данные подтверждают, что значительных изменений обновлённые процессоры Intel Core 14-го поколения (Raptor Lake-S Refresh) не претерпели. Исключением является лишь одна модель из K-серии, которая получила увеличенное количество энергоэффективных ядер. Речь идёт о Core i7-14700K, который предложит 12 энергоэффективных ядер, тогда как у модели Core i7-13700K их было лишь восемь. Количество производительных P-ядер и энергоэффективных E-ядер у флагманского Core i9-14900K, а также у модели среднего звена Core i5-14600K остались прежними. Первый предложит конфигурацию ядер 8P + 16E, второй — 6P + 8E, как и Core i9-13900K и Core i5-13600K соответственно. Процессоры Raptor Lake-S Refresh будут производиться с использованием того же 10-нм технологического процесса Intel 7, что и актуальные модели Raptor Lake. Ключевым отличием новинок станет поддержка более скоростной памяти DDR5. Также немного вырастет объём кеш-памяти L3 и максимальные частоты. MSI также подтвердила, что Raptor Lake-S Refresh будут в среднем всего на 3 % быстрее текущего поколения процессоров Intel. Заметную прибавку в многопоточной производительности в виде 17 % получит лишь Core i7-14700K, что объясняется увеличенным количеством E-ядер. Intel официально представит процессоры Raptor Lake-S Refresh в сентябре, на мероприятии Innovation 2023. Ожидается анонс только моделей K и KF-серий c номинальным TDP 125 Вт. Модели без суффиксов K и KF с TDP 65 Вт придётся ждать до начала следующего года. Сражение с кровососом и подтверждение переноса на 2024 год: вышел новый геймплейный трейлер S.T.A.L.K.E.R. 2: Heart of Chornobyl

24.08.2023 [18:04],

Дмитрий Рудь

Студия GSC Game World в рамках проходящей сейчас в Германии игровой выставки gamescom 2023 представила новый геймплейный трейлер постапокалиптического шутера с открытым миром S.T.A.L.K.E.R. 2: Heart of Chornobyl. В отличие от первого полноценного трейлера новой Call of Duty: Modern Warfare 3, свежий ролик S.T.A.L.K.E.R. 2: Heart of Chornobyl действительно геймплейный — все полторы минуты видео наполнены кадрами игрового процесса. Разработчики показали несколько локаций, перестрелки с людьми и монстрами (включая кровососа), взаимодействие с аномалиями посредством болтов, использование разных видов оружия, а также актуальную версию внутриигрового интерфейса. Помимо прочего, новый геймплейный трейлер S.T.A.L.K.E.R. 2: Heart of Chornobyl подтвердил изменение сроков выхода игры. Как и предполагал официальный набор для прессы, релиз проекта перенесли на первый квартал 2024 года. S.T.A.L.K.E.R. 2: Heart of Chornobyl создаётся для PC (Steam, GOG, EGS, Microsoft Store), Xbox Series X и S, а также сервиса Game Pass (PC и Xbox). Посетителям gamescom 2023 для ознакомления доступна демоверсия проекта. Corsair анонсировала двухметровый геймерский стол с электромотором, за которым можно играть как сидя, так и стоя

24.08.2023 [17:47],

Павел Котов

Компания Corsair представила двухметровый модульный компьютерный стол Platform:6, предназначенный для всех категорий пользователей: работников по удалёнке, блогеров и геймеров. Приобрести его можно будет в IV квартале этого года, но на сайте производителя пока не указана цена и не перечислены аксессуары для него, которых будет множество.

Источник изображения: Corsair Corsair Platform:6 будет предлагаться в нескольких версиях — для этого на сайте есть онлайн-конфигуратор, но он же вызывает затруднения с ответом на вопрос, что входит в стандартную комплектацию, а что доступно в качестве модульного дополнения. В пресс-релизе производителя говорится, что стол оборудуется двумя держателями для мониторов, лотком для скрытой прокладки кабелей, ящиком для хранения вещей и встроенными портами USB Type-A и Type-C для зарядки. Интерес представляет модульная система встроенных в стол направляющих, позволяющих устанавливать дополнительные компоненты, чтобы не загромождать рабочую поверхность.  В версии Creator Edition предлагается система моторизованной регулировки высоты с возможностью запоминать настройки. Есть боковые удлинители 30 × 70 см, которые сделают стол шириной более 180 см ещё шире, а также полки для наушников, игровых контроллеров и прочей периферии. Corsair также обещает адаптеры для линейки аксессуаров Elgato Multi-Mount для крепления камер, микрофонов и осветительных приборов. DigiTimes Research: поставки ИИ-серверов в 2024 году превысят 300 тыс. штук

24.08.2023 [17:33],

Сергей Карасёв

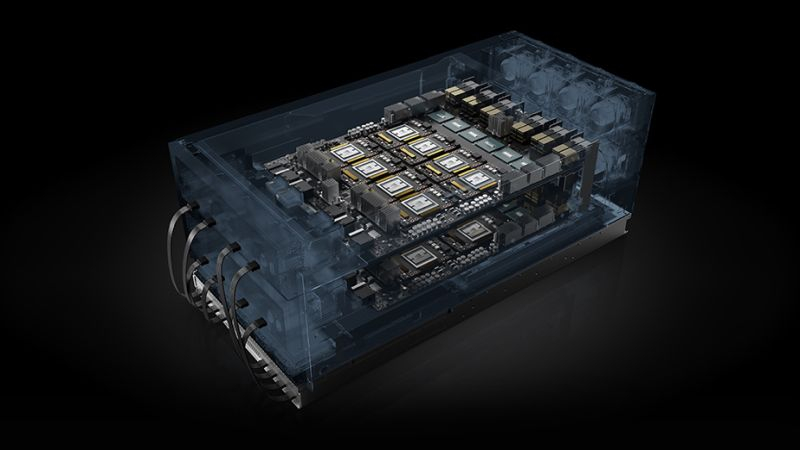

DigiTimes Research обнародовала прогноз по мировому рынку серверов, ориентированных на работу с ресурсоёмкими приложениями ИИ. Аналитики полагают, что спрос на такие системы в ближайшие годы будет устойчиво расти. По оценкам, поставки высокопроизводительных ИИ-серверов в 2023 году составят около 167 тыс. единиц. В 2024-м, считают эксперты DigiTimes Research, этот показатель достигнет 337 тыс. штук. Таким образом, ожидается двукратный рост. Вместе с тем рынок генеративного ИИ в целом до конца десятилетия будет демонстрировать среднегодовой темп роста в сложных процентах (CAGR) на уровне 35 %, так что к 2030-му его объём может достичь $109 млрд. По словам вице-президента DigiTimes Research Эрика Хуанга (Eric Huang), ажиотаж вокруг ИИ немного утих, но эти технологии продолжат стимулировать закупки серверов среди ведущих облачных провайдеров и гиперскейлеров — Microsoft Azure, Amazon Web Services (AWS), Google Cloud, Core Weave, Meta✴, Oracle и Twitter (теперь называется X), что подтверждает и последний квартальный отчёт NVIDIA, текущего лидера в области ИИ.

Источник изображения: Microsoft Хотя спрос на ИИ-серверы растёт, существует и ряд сложностей. Одна из них заключается в обеспечении поставок необходимых объёмов высокоскоростной памяти HBM для ускорителей. Согласно прогнозам, отгрузки таких изделий в 2024 году увеличатся на 105 % по сравнению с 2023-м. Ожидается, что преобладающим методом для выпуска ИИ-чипов будет Chip on Wafer on Substrate (CoWoS) от TSMC, позволяющий разместить на одной подложке до 12 стеков памяти HBM. Но возможности самой TSMC по выпуску чипов с применением CoWoS будут ограничены в связи с растущим спросом на такие изделия со стороны AMD, Google и других компаний. TSMC начнёт производство подобной продукции на своём новом заводе в Тунлуо (Тайвань) в 2027 году: ожидается, что предприятие сможет ежемесячно изготавливать более 110 тыс. единиц продукции. GeForce Now и другие облачные игровые платформы появятся на смарт-телевизорах Samsung 2020 года

24.08.2023 [17:29],

Павел Котов

Samsung сообщила, что в этом году на смарт-телевизорах образца 2020 года появятся приложения для облачных игр. Корейский производитель сделал это заявление на мероприятии Gamescom, но не уточнил, каких моделей это коснётся, и когда именно появятся эти приложения.

Источник изображения: samsung.com «Сегодня мы с радостью объявляем, что в этом году расширим приложения облачных игр на наши телевизоры модельного ряда 2020 года, открыв десяткам миллионов геймеров доступ к любимым играм и сервисам», — заявил глава отдела игровых продуктов Samsung Майк Лучеро (Mike Lucero). Приложения для облачных игровых платформ Gaming Hub на смарт-телевизорах и мониторах Samsung модельного ряда 2022 года дебютировали прошлым летом, а в ноябре отдельные приложения появились на моделях 2021 года. Gaming Hub включает клиенты Xbox Cloud Gaming, NVIDIA GeForce Now и Amazon Luna. Полноценного Gaming Hub на смарт-телевизорах Samsung образца 2020 года не будет — придётся обходиться отдельными приложениями. Список поддерживаемых облачных игровых платформ корейский производитель не сообщил, но, вероятно, в числе первых появятся клиенты Xbox Cloud Gaming и NVIDIA GeForce Now. «Этот фундаментальный сдвиг не закончится»: благодаря ИИ-буму Дженсен Хуанг разглядел на горизонте золотые горы

24.08.2023 [17:25],

Алексей Разин

На квартальной отчётной конференции NVIDIA основатель компании Дженсен Хуанг (Jensen Huang) несколько раз заявил, что оценивает ёмкость серверного рынка в $1 трлн, и с учётом начала новой фазы его масштабной структурной перестройки верит, что профильная выручка компании будет расти на протяжении нескольких ближайших лет. Эту уверенность руководство NVIDIA готово подкрепить, выделив на выкуп акций компании $25 млрд.

Источник изображения: NVIDIA На подобные шаги, как отмечает Reuters, руководство публичных компаний идёт обычно в тех случаях, когда убеждено в серьёзной недооценённости их активов. Казалось бы, до начала основной торговой сессии акции NVIDIA после публикации квартального отчёта с рекордной выручкой в серверном сегменте выросли на 7,43 % и получили все шансы обновить исторический максимум на отметках свыше $500 за штуку, но заявление о выделении $25 млрд на их выкуп подразумевает, что руководство NVIDIA убеждено в их способности расти в цене и дальше. Инвесторы, чьи интересы неформально на отчётном мероприятии представляли аналитики, выразили озабоченность угрозой дефицита ускорителей вычислений NVIDIA в условиях постоянно растущего спроса. Руководству компании пришлось уверять их, что каждый квартал на протяжении ближайших полутора лет объёмы поставок будут наращиваться, и предварительная работа с подрядчиками и поставщиками на этом направлении ведётся самым серьёзным образом. По информации источников Financial Times, в следующем году NVIDIA выпустит 1,5–2 млн ускорителей H100, что значительно больше 500 тыс. в этом году. О том, что это непросто организовать, говорят хотя бы замечания основателя NVIDIA, который напомнил, что одна система серии HGX содержит около 35 000 компонентов, стоит $200 000 и весит почти 32 кг. И проблемы с поставок самого мелкого чипа могут вызвать задержку с наращиванием объёмов производства таких систем. Серверные и сетевые компоненты в минувшем квартале принесли NVIDIA более 76 % всей выручки против почти 60 % кварталом ранее. Спросом в этом сегменте движут два фактора, как отметили руководители NVIDIA: миграция серверных систем с CPU на компоненты, использующие GPU в качестве основной производительной единицы, а также взрывной всплеск интереса к системам генеративного искусственного интеллекта и большим языковым моделям. Компания, по словам генерального директора, всего лишь один полный квартал работает в таких условиях, и они сохранятся на протяжении многих последующих кварталов. «Этот фундаментальный сдвиг не закончится», — сказал Хуанг о переходе дата-центров от CPU к GPU. Крупнейшие американские компании технологического сектора тратят внушительные средства на закупку компонентов для систем искусственного интеллекта. Microsoft в прошлом квартале выделила $10,7 млрд на капитальные расходы, и значительная часть этой суммы наверняка была потрачена на компоненты NVIDIA. Стартап OpenAI, который представил популярный чат-бот ChatGPT, получил от Microsoft финансовые вливания в размере $10 млрд. Meta✴ Platforms и облачное подразделение Amazon в совокупности тоже тратят десятки миллиардов долларов на развитие соответствующей вычислительной инфраструктуры. Складских запасов NVIDIA, чья балансовая стоимость на конец июля составляла $4,32 млрд, по мнению аналитиков Summit Insights Group, при существующем уровне спроса на ускорители вычислений едва хватит для его удовлетворения. Собственный прогноз по выручке в текущем квартале ($16 млрд) компания может превзойти без особых усилий, как считают эксперты. В то же время, редактор блога SemiAnalysis Дилан Пател (Dylan Patel) уверен, что не все клиенты NVIDIA будут закупать ускорители вычислений в текущих объёмах и дальше. Некоторые из них наберут критическую массу вычислительных ресурсов, и после оценки собственных перспектив на рынке могут прекратить закупки на какое-то время. Эта неделя характеризовалась и ещё одним важным для оценки рыночных перспектив NVIDIA событием. Как поясняет Bloomberg, из списка регулярно опрашиваемых агентством аналитических компаний сдалась последняя, которая до этого рекомендовала инвесторам продавать акции NVIDIA. Компания Morningstar Inc. сменила рекомендацию на «держать», и теперь из 59 опрашиваемых Bloomberg аналитиков 54 выступают за покупку акций NVIDIA, а оставшиеся пять просто рекомендуют инвесторам держать эти ценные бумаги в своём портфеле. Представители Morningstar теперь считают, что если в прошлом фискальном году NVIDIA выручила в серверном сегменте $15 млрд, то в текущем выручит уже $41 млрд. По их мнению, в следующем фискальном году эта сумма увеличится до $60 млрд, а к 2028 году достигнет $100 млрд. TeamGroup представила кулер T-Force DARK AirFlow I для SSD и 120-мм вентилятор T-Force RT-X120 ARGB

24.08.2023 [17:19],

Николай Хижняк

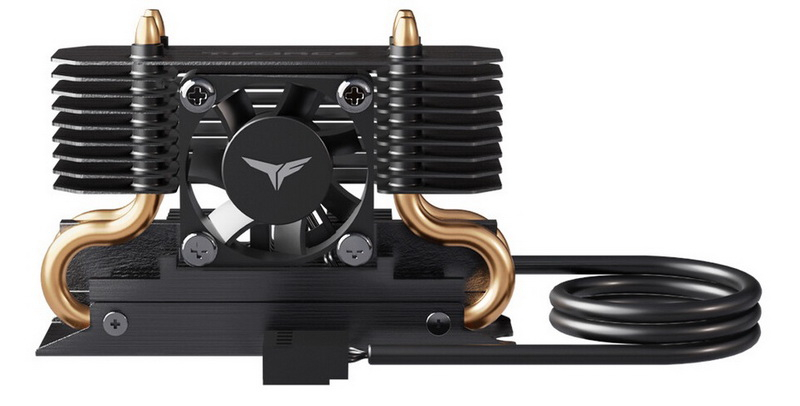

Игровой бренд T-Force компании TeamGroup представил новую систему охлаждения T-Force DARK AirFlow I SSD Cooler для твердотельных NVMe-накопителей формата M.2 2280 (главным образом для горячих моделей с интерфейсом PCIe 5.0), а также новый 120-мм вентилятор T-Force RT-X120 ARGB для корпусов, кулеров и радиаторов СЖО.

Источник изображений: TeamGroup Производитель отмечает, что в составе системы охлаждения T-Force DARK AirFlow I SSD Cooler используется запатентованная двухслойная структура основания с применением графена, две теплопроводящие трубки диаметром 5 мм, а также алюминиевый радиатор для эффективного увеличения площади рассеивания тепла. Система охлаждения также оснащена компактным вентилятором с автоматической регулировкой скорости работы (ШИМ) в зависимости от нагрузки на SSD.  Вентилятор T-Force RT-X120 ARGB получил крыльчатку закрытого типа с внешним кольцом. Такая конструкция более жёсткая и обеспечивает направленный поток воздуха с высоким статическим давлением. Вентилятор оснащён антивибрационными накладками, а в его основе используется мотор, рассчитанный на 50 000 часов работы на отказ.

Для новинки также заявляется поддержка технологии ШИМ для автоматической регулировки скорости работы. Вентилятор оперирует в диапазоне от 600 до 2200 об/мин, создаёт воздушный поток до 71,12 кубических футов в минуту (CFM) и статическое давление до 3,62 мм вод. ст. В продаже новинка будет доступна в чёрном и белом цветах.  ARGB-подсветкой вентилятора можно управлять с помощью самых популярных утилит для регулировки подсветки, включая ASUS Aura Sync, Gigabyte RGB Fusion 2.0, MSI Mystic Light Sync и ASRock Polychrome Sync. Оба представленных продукта ожидаются в продаже с октября. SpaceX с помощью Cloudflare повысит скорость спутникового интернета Starlink

24.08.2023 [17:11],

Владимир Фетисов

По сообщениям сетевых источников, принадлежащая Илону Маску (Elon Musk) компания SpaceX сотрудничает с CDN-провайдером Cloudflare, чтобы повысить производительность своего спутникового интернет-сервиса Starlink. Об этом пишет издание The Information со ссылкой на собственный осведомлённый источник, принимающий непосредственное участие в данном проекте.

Источник изображения: starlink.com В сообщении сказано, что компании работают над расширением сети мини-центров обработки данных Starlink по всему миру. За счёт этого SpaceX сумеет обеспечить более высокую пропускную способность для своих клиентов, являющихся пользователями сети Starlink. На фоне этой новости стоимость акций Cloudflare подскочила на 7,2 %. Что касается сети Starlink, то в ней используются телекоммуникационный спутники, доставкой которых на орбиту активно занимается SpaceX. Помимо компании Илона Маска над созданием спутниковой сети для предоставления широкополосного доступа в интернет работают американская компания Amazon и британская OneWeb. Официальные представители SpaceX и Cloudflare пока воздерживаются от комментариев по вопросам, связанным с сотрудничеством компаний. Вышли обзоры Ryzen 9 7945HX3D — это самый быстрый мобильный процессор для игр

24.08.2023 [17:02],

Николай Хижняк

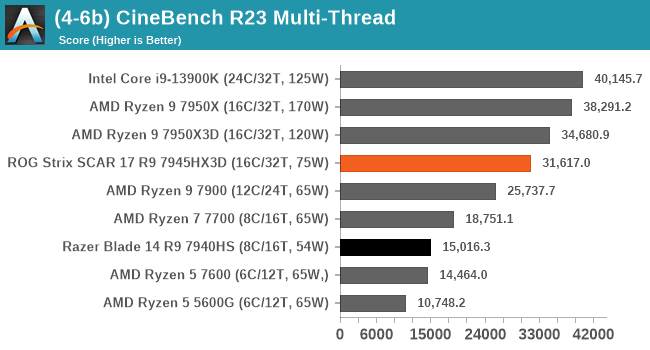

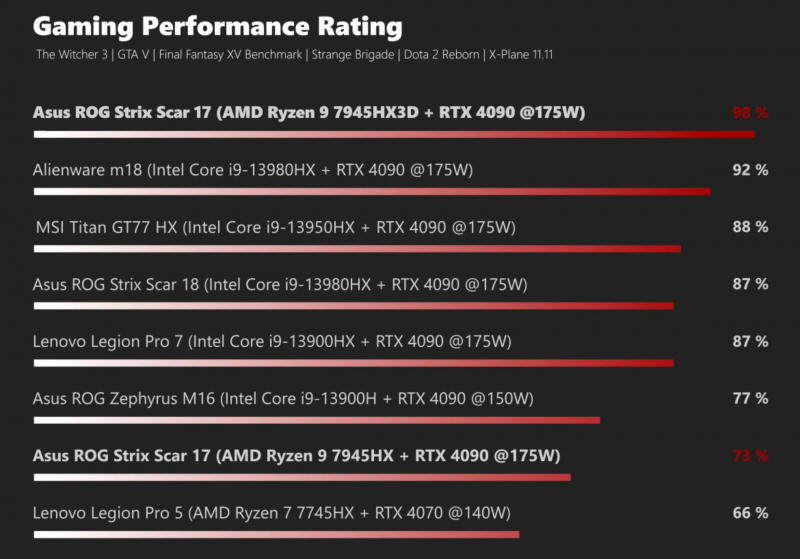

На днях в Сети появились обзоры ASUS ROG Strix Scar 17 — первого и пока единственного ноутбука с первым мобильным процессором с дополнительной кеш-памятью 3D V-Cache — флагманским 16-ядерным Ryzen 9 7945HX3D. Обозреватели утверждают, что это самый быстрый игровой мобильный процессор в мире.

Источник изображения: VideoCardz Процессор Ryzen 9 7945HX3D имеет 16 ядер с поддержкой 32 виртуальных потоков и работает с тактовой частотой до 5,4 ГГц. Базовая частота чипа составляет 2,3 ГГц, что на 200 МГц ниже, чем у обычной версии Ryzen 9 7945HX. Модель Ryzen 9 7945HX3D имеет динамический TDP от 55 до 75 Вт. Чип получил 128 Мбайт кеш-памяти 3D V-Cache, расположенной поверх одного из чиплетов CCD, формально копируя эту особенность у старших моделей десктопных процессоров Ryzen 7000X3D. Правда, последние оснащаются только 96 Мбайт кеш-памяти 3D V-Cache, а объём обычной кеш-памяти L3 у них составляет 32 Мбайт. В составе мобильного чипа также присутствуют два исполнительных блока встроенной графики Radeon 610M на архитектуре RDNA 2. Для процессоров Ryzen 7000X3D компания AMD выпустила специальный драйвер PPM Provision Driver и утилиту 3D V-Cache Performance Optimizer, которые в сочетании с игровым режимом операционной системы Windows отвечают за распределение потоков по ядрам и CCD и определяют, какой из чиплетов — с дополнительной кеш-памятью 3D V-Cache или без неё — необходимо использовать в конкретной задаче.

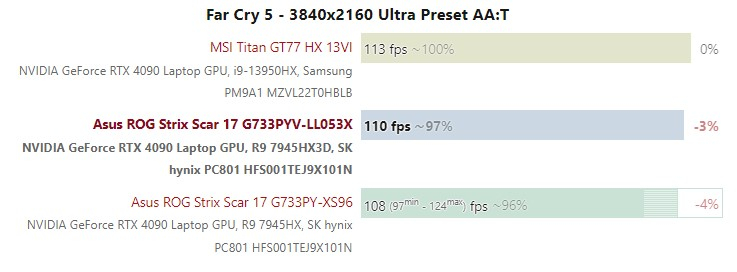

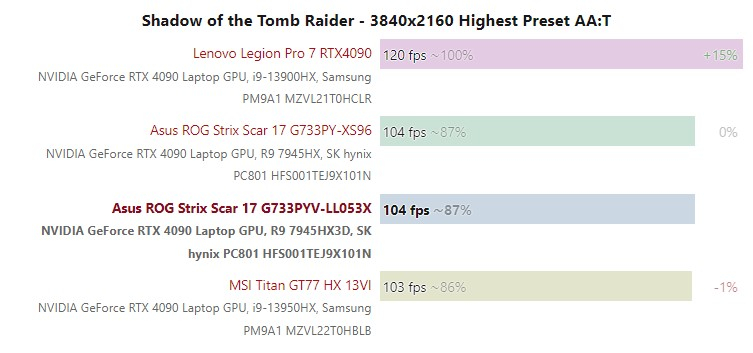

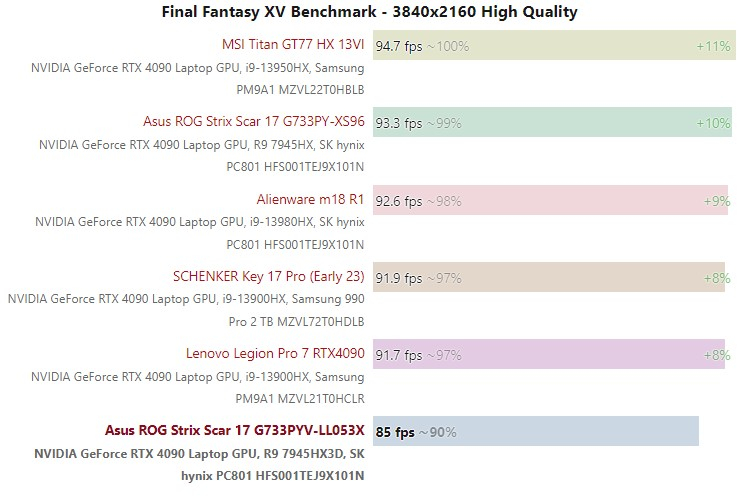

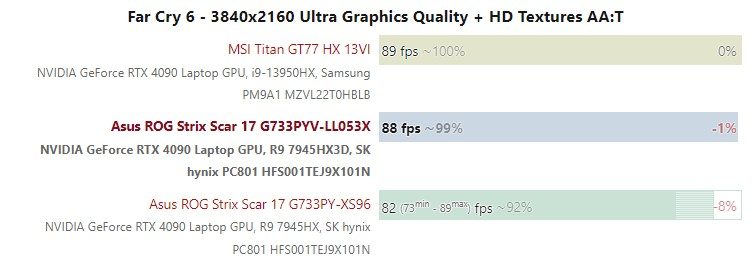

Источник изображения: AnandTech Количество обзоров ASUS ROG Strix Scar 17 с Ryzen 9 7945HX3D можно посчитать по пальцам. Видимо, AMD и ASUS решили предоставить тестовые образцы лэптопов весьма ограниченному числу обозревателей. Последние в свою очередь пришли к консенсусу, что Ryzen 9 7945HX3D является лучшим мобильным процессором для игр. В частности, при разрешении 1080p.

Источник изображения: Notebook Check Однако при использовании разрешения QHD производительность чипа несколько проседает. И использование чиплета CCD процессора с 3D V-Cache в качестве основного демонстрирует более низкую производительность, чем CCD без дополнительной кеш-памяти, говорится в публикации портала AnandTech. В играх с 4K-разрешением дополнительная кеш-память пользы никакой не приносит, поскольку быстродействие ограничивается возможностями мобильной видеокарты, что показывают результаты тестов портала Notebook Check на графиках ниже.

К сожалению, никто из источников не указал точной стоимости ноутбука ASUS ROG Strix Scar 17 с процессором Ryzen 9 7945HX3D. Однако с учётом того, что точно такая же модель ноутбука, в такой же конфигурации, но с процессором Ryen 9 7945HX без кеш-памяти 3D V-Cache предлагается примерно за $3000, версия Ryzen 9 7945HX3D, вероятно, будет оцениваться в диапазоне 3200–3500 долларов, предполагают обозреватели. Microsoft Edge начал помечать установочный файл Google Chrome как вредоносный

24.08.2023 [16:51],

Павел Котов

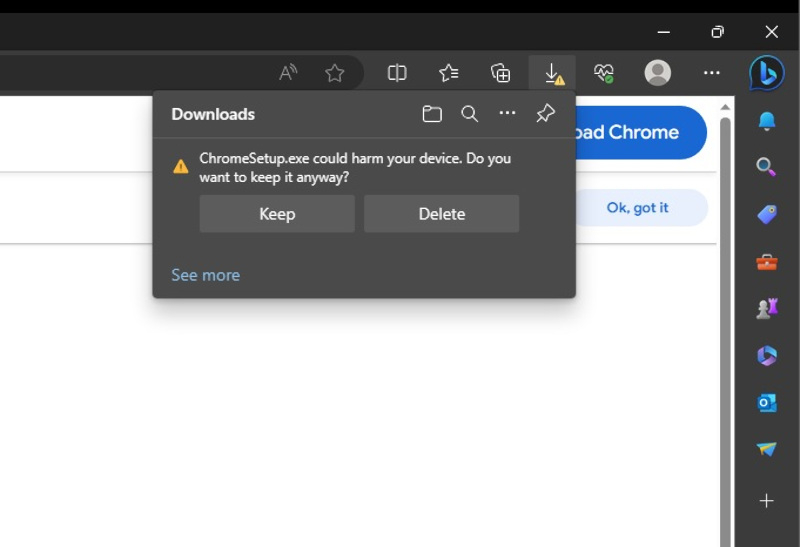

Microsoft Edge под Windows 10 и 11 начал помечать установочный файл конкурирующего браузера Google Chrome как потенциально вредоносный. Череда всплывающих окон предлагает удалить файл «ChromeSetup.exe» и вместо него попробовать пользоваться Edge. Ошибка проявляется только в версии Microsoft Edge 116 и только для некоторых пользователей, сообщает ресурс Windows Latest.

Источник изображения: windowslatest.com При попытке загрузить Chrome браузер от Microsoft демонстрирует предупреждающее сообщение: «ChromeSetup.exe может нанести вред вашему устройству. Вы всё равно хотите сохранить его?» — и предлагает либо сохранить, либо удалить установочный файл Google Chrome. Microsoft уже не впервые предпринимает шаги, направленные на то, чтобы повысить популярность Edge среди пользователей и отговорить их переходить на Chrome. В ход шли самые разные приёмы: показ рекламы Edge на странице поиска по запросу о скачивании браузера в Bing или непосредственно на странице загрузки конкурирующего браузера. Разработчик Windows также пытался усложнить процедуру смены браузера по умолчанию в системе, но впоследствии был вынужден отказаться от этой затеи. А в апрельском обновлении перестала работать кнопка выбора Chrome браузером по умолчанию в один клик — система начала забрасывать корпоративных пользователей системными окнами. Oppo назначила презентацию смартфона-раскладушки Find N3 Flip и смарт-часов Watch 4 Pro на 29 августа

24.08.2023 [16:45],

Владимир Мироненко

Oppo объявила дату презентации смартфона-раскладушки Find N3 Flip — 29 августа. Сообщается, что у раскладушки Oppo нового поколения будет такой же дизайн с вертикальным внешним экраном, как у предшественника, и он станет первым в этой категории устройством с тройной камерой. Имеющийся на корпусе логотип Hasselblad говорит об участии в разработке камеры известного шведского производителя фотографического оборудования.

Источник изображений: Oppo Oppo пока не стала раскрывать подробности о характеристиках Find N3 Flip, поскольку устройства в формфакторе раскладушки зачастую позиционируются скорее как необычный аксессуар, а не как смартфон для работы и развлечений. Вместе с тем на фото можно заметить, что у Find N3 Flip имеется боковой сканер отпечатков пальцев, как и у предыдущей модели.  Вместе с Find N3 Flip на мероприятии представят смарт-часы Oppo Watch 4 Pro, которые судя по пресс-фото обладают изогнутым экраном и будут доступны в двух цветовых вариантах корпуса — сером и чёрном.  Watch 4 Pro имеют такой же дизайн с прямоугольным дисплеем, как у предшественника, получив при этом дополнительную кнопку. Смарт-часы будут предлагаться как минимум с двумя ремешками. Один из них изготовлен из резины/фторэластомера, второй — кожаный.  До презентации новинок осталось несколько дней, так что не исключено, что Oppo поделиться ещё какими-то подробностями о новинках до анонса. AMD приобрела французскую компанию Mipsology, разработчика ИИ-решений для FPGA

24.08.2023 [16:27],

Владимир Мироненко

AMD объявила о приобретении компании Mipsology из Палезо (Франция), специализирующейся в области программного обеспечения для искусственного интеллекта, с которой её связывают давние партнёрские отношения. Как ожидается, команда разработчиков Mipsology поможет AMD разработать полный стек ИИ-решений и упростит развёртывание ИИ на оборудовании AMD. Основанная в 2015 году компания Mipsology разрабатывает передовые решения для инференса и инструменты оптимизации нагрузок, адаптированные для оборудования AMD. Флагманское ПО Zebra компании поддерживает отраслевые платформы, включая TensorFlow, PyTorch и ONNX Runtime, и помогает ускорить развёртывание инференс-нагрузок на CPU и FPGA. Также ПО поддерживает программный стек AMD Unified AI (UAI).

Источник изображения: AMD «ИИ является нашим главным стратегическим приоритетом и важным фактором роста спроса на полупроводники в ближайшее десятилетие. Приветствуя квалифицированную команду Mipsology в AMD, мы продолжим расширять возможности нашего программного обеспечения, чтобы позволить клиентам по всему миру использовать огромный потенциал повсеместного ИИ», — отметил представитель AMD в блоге компании. Олдскульный хоррор на выживание Tormented Souls 2 отправит игроков навстречу «неописуемым ужасам» ради спасения проклятой сестры

24.08.2023 [14:51],

Дмитрий Рудь

За последним, самым важным анонсом прошедшего накануне в рамках gamescom 2023 шоу Future Games Show скрывалась Tormented Souls 2 — продолжение олдскульного хоррора на выживание Tormented Souls от чилийской студии Dual Effect. Знакомая по первой части Каролина Уокер после событий в клинике Вайлдбергер хочет вернуться к нормальной жизни с младшей сестрой Анной, однако родственницу поражает странная болезнь: кашель с кровью, потери сознания, почернение глаз. Обычная медицина оказывается бессильна, и в отчаянных поисках лекарства для проклятой сестры Каролина обращается за помощью к сверхъестественным силам. Так протагонистка оказывается в Пуэрто-Миллере. Пуэрто-Миллер — уединённый южноамериканский городок с пугающим прошлым, основанный в незапамятные времена исмуитами — закрывшейся от остального мира религиозной общиной, — а ныне таящий «неописуемые ужасы». Игрокам предстоит исследовать коридоры зловещих монастырей и другие кошмарные места, сражаться с чудовищными монстрами, используя лишь подручные средства, а также решать изощрённые головоломки. Разработчики обещают напряжённые битвы, необходимость с умом распоряжаться доступными ресурсами (авторы подготовили нетривиальные сочетания), хитроумные загадки и мрачные тайны. Релиз Tormented Souls 2 ожидается в 2024 году на PC (Steam, Epic Games Store, GOG), PlayStation 5, Xbox Series X и S. В описании на странице в Steam указаны системные требования и заявлен текстовый перевод на русский язык. Скриншоты Tormented Souls 2

Apptronik показала робота-гуманоида Apollo с ртом из электронных чернил, экраном на груди и грузоподъёмностью 25 кг

24.08.2023 [14:28],

Геннадий Детинич

Компания Apptronik рассекретила внешний вид и ряд характеристик антропоморфного робота Apollo. Повторяющий строение тела человека робот может стать универсальным инструментом для подсобных работ, выполняя физически тяжёлый и однообразный людской труд. Он может переносить грузы и, очевидно, по мере развития навыков и улучшения механизмов будет способен на более сложные операции.

Источник изображений: Apptronik Высота Apollo составляет 173 см при весе в 73 кг. Блок сменных батарей обеспечивает его энергией на четыре часа непрерывной работы под нагрузкой. Всё это время робот может переносить груз не более 25 кг за раз. По российскому законодательству, например, работникам мужчинам разрешается разово поднимать до 50 кг, до двух раз в час — по 30 кг и постоянно в течение рабочего дня переносить не более 15 кг. По этому показателю, как видим, робот Apollo оставляет человека далеко позади, что найдёт отклик среди работодателей.  При этом робот Apollo компании Apptronik выгодно отличается также на фоне конкурирующих разработок. Так, антропоморфный робот Optimus компании Tesla обладает грузоподъёмностью в 20 кг, а робот Atlas от Boston Dynamics поднимает только 11 кг. Правда, обойти китайцев Apollo не смог. Китайский робот GR-1 компании Fourier Intelligence может переносить груз массой до 50 кг или в два раза тяжелее, чем сможет Apollo. «Люди не хотят как роботы выполнять физически тяжелую работу в сложных условиях, и они не должны этого делать, — заявил в пресс-релизе генеральный директор и соучредитель компании Apptronik Джефф Карденас (Jeff Cardenas). — Гуманоидные роботы — это не просто ответ на эту проблему, это необходимость, и благодаря нашему глубокому опыту в области робототехники Apollo имеет уникальные возможности для того, чтобы в буквальном смысле слова сделать шаг вперед и оказать влияние на ситуацию». По мнению разработчика, внешний вид робота должен располагать к себе людей. Для имитации мимики и демонстрации текущих режимов работы на лице робота в месте рта у человека расположен экран на электронных чернилах компании E Ink. Более информативный экран OLED размещён на груди. Глазницы Apollo обведены кругами, меняющими цвет подсветки — красный, зелёный или другого цвета, что также станет удобной сигнализацией при коммуникации людей с роботами. Робот Apollo также может распространяться в других конфигурациях, а именно без ног. В частности, его торс может монтироваться на тележку с колёсами, что определённо ускорит перемещение грузов и грузоподъёмность платформы, а также в виде стационарного изделия для работы на конвейере или в другом месте, где необходимо постоянное присутствие на выдаче или распределении грузов. Разработчик не стал уточнять принцип работы модели Apollo — она самообучаемая или просто аватар для удалённого оператора. Как бы то ни было, в одних случаях робот будет действовать автономно, а в других, если понадобится, сможет стать виртуальным воплощением человека на Земле, в космосе или где угодно. Компания Apptronik, кстати, стала доверенным партнёром NASA в разработке антропоморфных роботов для космоса. Но это уже другая история. Обновление Windows 11 привело к синим экранам смерти с ошибкой «неподдерживаемый процессор»

24.08.2023 [14:17],

Владимир Фетисов

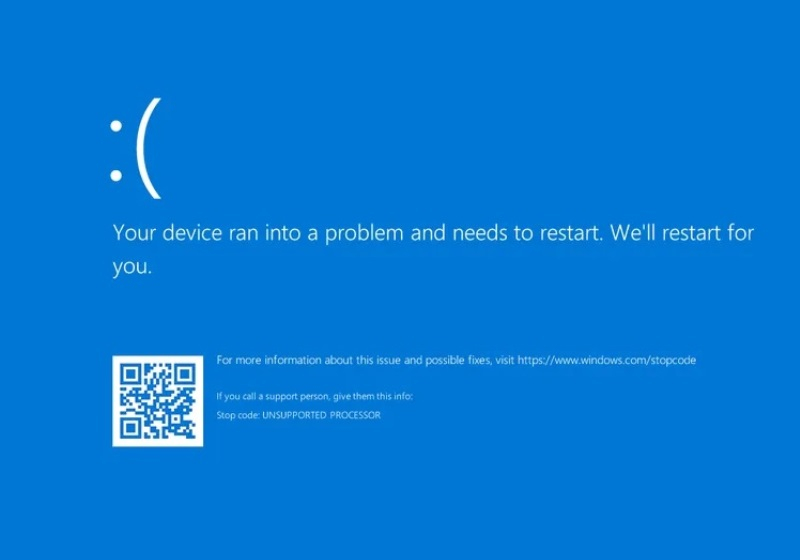

Компания Microsoft подтвердила наличие проблемы в Windows 11, связанной с появлением синих экранов смерти (BSOD) с сообщением об ошибке «UNSUPPORTED_PROCESSOR». Проблема возникает после установки пакета с ежемесячными исправлениями KB5029351, распространение которого началось ранее на этой неделе.

Источник изображения: Microsoft «В настоящее время мы проводим расследование, чтобы определить, вызвана ли эта проблема действиями Microsoft. Мы сообщим подробности, когда появится дополнительная информация», — говорится в сообщении Microsoft, которое появилось в Windows Health Center. По данным источника, упомянутая ошибка возникает после установки обновления на компьютеры с определёнными моделями материнских плат компании MSI. Например, обновление приводит к появлению BSOD на компьютере с процессором Intel Core i9-13900KS и материнской платой MSI MPG Z690 Carbon Wi-Fi. Пользователи платформы Reddit сообщают о появлении аналогичной ошибки, но во всех случаях речь идёт о процессорах Intel и материнских платах MSI с последней версией BIOS. Хорошая новость заключается в том, что после появления BSOD пользователи могут устранить проблему путём отката внесённых ранее изменений. Похоже, что Microsoft после выявления проблемы удалила обновление KB5029351 из затронутых систем, но оно по-прежнему доступно для установки на совместимые устройства с Windows 11. Пока неясно, чем именно обусловлено появлением BSOD, но вполне может оказаться, что это происходит из-за недавнего обновления BIOS, которое компания MSI выпустила для своих материнских плат. Официальные представители MSI пока никак не комментируют данный вопрос. США на год продлят корейским и тайваньским чипмейкерам отсрочку от санкционных ограничений на работу в Китае

24.08.2023 [14:14],

Павел Котов

США решили ещё на год продлить действие разрешения, позволяющего южнокорейским и тайваньским производителям продолжать поставки в Китай передовых технологий производства чипов и соответствующего оборудования, пишет Nikkei со ссылкой на свои источники. С одной стороны, это можно расценивать как подрыв усилий Вашингтона по сдерживанию развития китайской технологического сектора, с другой — это защитит мировую цепочку поставок чипов от масштабных перебоев. Источник изображения: Maxence Pira / unsplash.com Алан Эстевес (Alan Estevez) замминистра торговли США, отвечающий за вопросы промышленности и безопасности, ещё в июне заявил, что разрешение, вероятно, придётся продлить, хотя и не уточнил сроков. Было также озвучено предложение сделать это исключение из санкционных ограничений бессрочным. В октябре прошлого года Вашингтон ввёл жёсткие ограничения на экспорт современных полупроводниковых технологий и оборудования в Китай — использующим американские технологии компаниям запретили без соответствующего разрешения участвовать в разработке и производстве чипов на китайских предприятиях. Крупные производственные центры в Китае есть у Samsung Electronics, SK hynix и Taiwan Semiconductor Manufacturing Co. (TSMC) — эти компании выступили против введения ограничений, заявив, что подобные меры нанесут серьёзный удар по их бизнесу. Впоследствии США предоставили им годовую отсрочку, позволив продолжить работу в том же режиме, что и до введения санкций — срок её действия истекает в октябре, и США планируют продлить её действие ещё на один год на тех же условиях. Это позволит южнокорейским и тайваньским компаниям поставлять на свои китайские предприятия оборудование для производства микросхем, использующее американские технологии, а также необходимые материалы для продолжения бесперебойного производства. Мировые продажи полупроводниковой продукции по итогам 2022 года составили $570 млрд, треть из которых пришлась на Китай. В 2021 году КНР обогнала Японию по объёмам производства чипов, выйдя на третьем место после Южной Кореи и Тайваня. У южнокорейских производителей особо прочные связи с Китаем: здесь расположены около 40 % производственных мощностей DRAM компании SK hynix, а значит, без экспортных льгот возможны значительные перебои в мировых поставках ПК и других электронных устройств. Учитывая сложную организацию мировой экосистемы чипов, производителям будет чрезвычайно непросто исключить Китай из своих цепочек поставок. Журналисты рассказали и показали, как играется Warhammer 40,000: Space Marine 2 — новый геймплей и скриншоты

24.08.2023 [14:05],

Дмитрий Рудь

Горячо ожидаемый боевик Warhammer 40,000: Space Marine 2 остался на шоу gamescom 2023: Opening Night Live без анонсов, однако на саму выставку Focus Entertainment и Saber Interactive привезли новый геймплей и скриншоты игры. Напомним, пользователям в роли космодесантника ордена Ультрамаринов — капитана Тита — предстоит уничтожить орды безжалостных тиранидов, которых благодаря движку Saber на экране будут «сотни, если не тысячи». Опробовавший игру журналист IGN остался впечатлён количеством врагов (хотя в демоверсии разнообразием они не отличались) — их настолько много, что перестрелять всех не получится. Периодически приходится идти в рукопашную. От вражеского урона здоровье Тита защищает запас брони, однако под напором тиранидов её немудрено растерять. Восполнить защиту можно путём проведения жестоких добиваний врагов (см. механику зверских убийств из последних DOOM). Боевая система Space Marine 2 включает комбо, парирования и увороты. По мнению журналиста IGN, игра выдерживает хороший баланс между простыми линейными шутерами прошлых лет и современными рукопашными боевиками. Новые скриншоты Warhammer 40,000: Space Marine 2

Видео IGN с разбором Warhammer 40,000: Space Marine 2 содержит около шести минут нового геймплея. Чистый игровой процесс без комментариев можно найти на YouTube-канале Warhammer и в микроблоге gamescom. Релиз Warhammer 40,000: Space Marine 2 ожидается ближайшей зимой на PC (Steam), PS5, Xbox Series X и S. Обещают захватывающую кампанию с кооперативом на трёх человек, арсенал разрушительного оружия и текстовый перевод на русский. Глава Xbox: обновлённые версии Xbox Series X и Series S сейчас не нужны

24.08.2023 [14:03],

Владимир Фетисов

В рамках проходящего на этой неделе мероприятия Gamescom 2023 глава игрового подразделения Microsoft Фил Спенсер (Phil Spencer) рассказал о том, что обновлённые версии игровых консолей Xbox Series X и Series S не находятся в разработке. По его мнению, в настоящее время нет необходимости в запуске таких продуктов.

Источник изображения: unsplash.com «Нет, нет. Сейчас мы сосредоточены на Xbox Series S с увеличенным объёмом памяти. Но нет, как я уже говорил, на мой взгляд, мы находимся в конце начального этапа. Поэтому я думаю, что нам нужно позволить разработчикам остановиться на этом оборудовании и получить от него максимум пользы», — рассказал Фил Спенсер. Глава Xbox подчеркнул, что, по его мнению, игровые консоли компании в настоящее время находятся в конце начальной стадии становления. Поэтому разработчикам стоит сосредоточиться на уже доступном оборудовании, чтобы использовать его по максимуму. Это означает, что Microsoft пока не планирует выпускать на рынок версии консолей, которые могли бы похвастаться существенными изменениями в плане аппаратной составляющей. Что касается упомянутой ранее консоли Xbox Series S Carbon Black с накопителем ёмкостью 1 Тбайт (стандартная версия имеет 512 Гбайт памяти), то она выйдет на рынок в начале сентября и будет стоить $350. Суд впервые оштрафовал Telegram за отказ локализовать данные в России — на 50 тыс. рублей

24.08.2023 [13:44],

Владимир Фетисов

Мировой судья в Москве назначил административный штраф в размере 50 тыс. рублей мессенджеру Telegram. Такое наказание обусловлено нарушением законодательства в области оборота персональных данных.

Источник изображения: AJEL / Pixabay «Назначить Telegram Messenger Inc. наказание в виде административного штрафа в размере 50 тыс. рублей», — огласил постановление мировой судья судебного участка №422 Таганского района Москвы Тимур Вахрамеев. Согласно имеющимся данным, Telegram признали виновным в невыполнении требований по защите прав субъектов персональных данных по ч.5 ст.13.11 КоАП РФ (невыполнение требования по уточнению персональных данных). Максимальное наказание по этой статье для юрлиц предусматривает штраф в размере 90 тыс. рублей. Это первый штраф для Telegram по данной статье. Представители компании в судебном заседании не участвовали. В соответствии с оглашёнными в суде материалами, претензии к мессенджеру возникли из-за обращения в Роскомнадзор сотрудницы одной из федеральных служб в связи с размещением в одном из каналов Telegram её персональных данных, включающих сведения о том, что ранее у неё было гражданство Украины. Напомним, закон «О персональных данных» обязывает российские и иностранные компании хранить персональные данные россиян только на территории страны. Требование о локализации применяется к иностранным компаниям, которые не имеют физического присутствия в РФ и осуществляют деятельность на территории страны. Мошенники стали воровать деньги через поддельные обменники валют в Telegram

24.08.2023 [13:43],

Павел Котов

«Лаборатория Касперского» вскрыла новую схему, которую мошенники используют для кражи денег и личной информации при помощи Telegram. Прикрытием выступают поддельные службы обмена валюты и криптовалюты онлайн, сообщили «РИА Новости».

Источник изображения: Riki32 / pixabay.com Созданный киберпреступниками ресурс предлагает услуги по обмену валюты и криптовалюты — здесь есть правила сервиса, отзывы, контакты и форма для расчёта суммы, которую якобы получит клиент. Решившие воспользоваться им доверчивые граждане направляются в Telegram, где предлагают оформить заявку с менеджером, перечислить средства, а затем забрать средства в пункте выдачи. Оператор запрашивает у клиента его фамилию, имя и отчество, контактный телефон, уточняет удобные место и время выдачи, а также удобные номиналы купюр и банк для оплаты. Жертве обещают выдать средства через 40–60 минут после перевода, но в реальности она просто теряет свои деньги и передаёт личные данные неизвестным лицам. Эксперты «Лаборатории Касперского» отметили, что Telegram-боты всё чаще используются при реализации мошеннических схем — неподготовленные граждане не вполне понимают, как работают подобные сервисы, а запустить бот может любой желающий. Это не значит, что подобными службами вообще не следует пользоваться, но для защиты следует придерживаться базовых правил безопасности. В частности, поводом насторожиться являются реквизиты для перевода не юридическому, а физическому лицу по номеру телефона. Рекомендуется пользоваться официальными надёжными сервисами с заслуженной репутацией. Выпуск AR-гарнитуры Google и Samsung отложили на следующий год

24.08.2023 [13:38],

Владимир Мироненко

После закрытия в июне собственного проекта по созданию очков дополненной реальности Project Iris, компания Google продолжила разработку гарнитуры смешанной реальности в сотрудничестве с Samsung, хотя и в этом проекте сталкивается с проблемами, пишет Insider.

Источник изображения: Pixabay По данным Insider, устройство, получившее внутри компании название Project Moohan, будет поддерживать возможности смешанной реальности на платформе Android. Работа над ним ведётся по крайней мере с прошлого года. Вслед за этим в феврале этого года Google, Samsung и Qualcomm объявили о планах по созданию платформы смешанной реальности. Проект Project Moohan стал головной болью для Google, поскольку Samsung потребовала заблокировать к нему доступ других подразделений американской компании, работающих над продуктами Google AR, из-за опасений утечки информации, которая поможет создать им конкурирующую гарнитуру. В частности, это в своё время создало проблемы для проекта Project Iris. «Как бы вы могли создать очки и не разозлить Samsung?», — задаётся вопросом один из источников Insider. Согласно данным южнокорейского издания SBS Biz, Samsung уже начинает брать под свой контроль проект Project Moohan. Сообщается, что после презентации Apple Vision Pro компания отложила производство гарнитуры, следовательно, новинка вряд ли появится на рынке до середины следующего года. Несмотря на уход ведущего разработчика технологий дополненной реальности Марка Луковски (Mark Lucovsky), не похоже, что Google полностью отказалась от разработок в сфере смешанной реальности. По данным Insider, Google изучает способы использования искусственного интеллекта с AR-гарнитурой, а также включила программное обеспечение Iris в другой проект под названием Betty, направленный на «создание программного обеспечения Micro XR, которое она намерена предложить производителям очков». |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; ✶ Входит в реестр лиц, организаций и объединений, выполняющих функции иностранного агента; |