|

Опрос

|

реклама

Быстрый переход

Apple предпочла обучать свои языковые модели на процессорах Google, а не Nvidia

30.07.2024 [04:51],

Алексей Разин

Возможно, в будущем Apple будет полагаться при развитии своих систем искусственного интеллекта на серверные процессоры собственной разработки, но пока она вынуждена использовать сторонние компоненты. В отличие от многих конкурентов, сильно зависящих в этой сфере от Nvidia, компания Apple сделала ставку на тензорные процессоры Google.

Источник изображения: Apple Как отмечает CNBC, это следует из пояснительной записки Apple, в которой указывается конфигурация вычислительных кластеров, использованных компания для обучения своих больших языковых моделей, которые лягут в основу технологии Apple Intelligence. Её предварительная версия уже начала демонстрироваться на некоторых устройствах, а потому Apple решила раскрыть информацию о специфике развития своей инфраструктуры искусственного интеллекта. Прямо Apple не упоминает разработчика процессоров, которые использовала для обучения своей языковой модели Apple Foundation Model, но в тексте записки фигурирует формулировка «облачные кластеры на основе TPU». Так сокращённо называет свои тензорные процессоры именно Google. Помимо прочего, это откровение Apple говорит об использовании компанией арендованных у Google облачных вычислительных ресурсов. Для стадии становления систем искусственного интеллекта Apple это вполне оправданный подход. Большая языковая модель, которая будет работать на конечных устройствах Apple, обучалась с помощью кластера из 2048 процессоров Google серии v5p, которая считается самой современной. Серверная часть модели обучалась на кластере с 8192 процессорами v4. Google сдаёт такие кластеры в аренду по $2 за час с каждого используемого клиентом процессора. При этом собственные языковые модели Google обучает и с использованием аппаратного обеспечения Nvidia, а не только процессоров собственной разработки. Компания Apple никак не выдаёт в своей документации возможное использование чипов Nvidia. Nvidia готовит новую мобильную GeForce RTX 3050 на чипе Ada Lovelace с 64-битной шиной и 4 Гбайт памяти

27.07.2024 [23:25],

Анжелла Марина

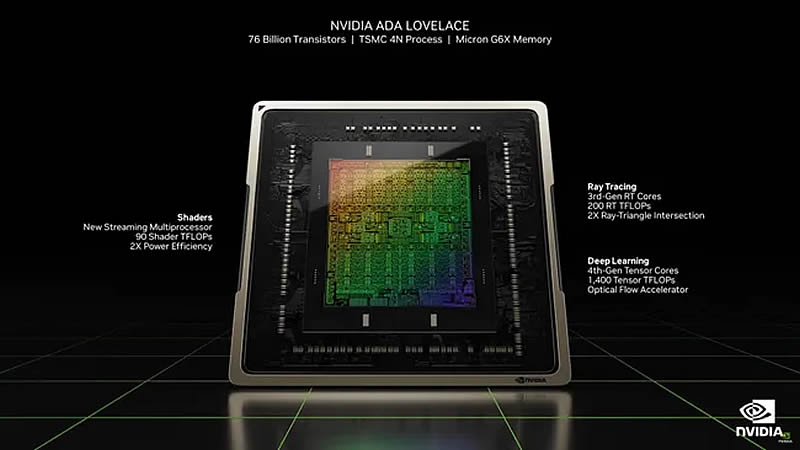

Компания Nvidia подтвердила разработку новой версии видеокарты GeForce RTX 3050 для ноутбуков. Ключевой особенностью новинки станет использование графического процессора AD106, основанного на архитектуре Ada Lovelace, используемой в более мощной RTX 4070.

Источник изображения: Nvidia По информации издания Notebookcheck, видеокарта, получившая название GeForce RTX 3050 A, будет оснащена 4 Гбайт видеопамяти GDDR6 с 64-битной шиной, а её TDP составит от 35 до 50 Вт. Количество ядер CUDA составит 1792. Эксперты отмечают, что подобный шаг Nvidia напоминает ситуацию 2021 года, когда компания неожиданно представила GeForce RTX 2050 на базе GPU GA107 (Ampere), несмотря на то, что эта модель относилась к линейке Turing. Та карта нашла применение во многих бюджетных ноутбуках, хотя её производительность оставляла желать лучшего. Теперь Nvidia, похоже, планирует провернуть подобный трюк с GeForce RTX 3050, которая изначально базировалась на чипе Ampere, оснастив её графическим процессором Ada Lovelace. Информация о новой модификации RTX 3050 была обнаружена в базе данных PCI-ID, а также в последних драйверах Nvidia. Хотя полные технические характеристики пока не раскрыты, очевидно, что производительность новинки будет ниже, чем у мобильной версии GeForce RTX 4070, также использующей GPU AD106. Стоит отметить, что это уже третий вариант GeForce RTX 3050 после версий с 6 Гбайт и 4 Гбайт памяти на базе GPU GA107. Причины выбора AD106 вместо более подходящего для данного класса видеокарт AD107 пока неизвестны. Не исключено, что новая GeForce RTX 3050 A может быть представлена на выставке CES вместе с моделями серии RTX 5000 на базе архитектуры Blackwell. Однако также существует вероятность, что данная модификация является экспериментальной и может не выйти на рынок. Ожидается, что появление версии GeForce RTX 3050 A позволит Nvidia расширить предложение в сегменте бюджетных игровых ноутбуков, предоставив производителям дополнительные возможности для создания конкурентоспособных моделей. Квартальный отчёт Alphabet побудил инвесторов распродавать акции ИТ-гигантов — Nasdaq пережил сильнейшее падение с 2022 года

25.07.2024 [13:56],

Алексей Разин

Череда квартальных отчётов компаний технологического сектора на этой неделе придала американским фондовым индексам импульс для движения вниз, как отмечает Financial Times. В среднем, они продемонстрировали худшую динамику внутри дневной сессии за предыдущие полтора или даже два года.

Источник изображения: Tesla Объединяющий многие «голубые фишки» американского фондового рынка индекс S&P 500 упал на 2,3 %, продемонстрировав худшую динамику торговой сессии с декабря 2022 года, индекс Nasdaq Composite просел на 3,6 %, что стало сильнейшим снижением с октября 2022 года. Антилидерами по динамике снижения котировок стали акции компаний Nvidia, Microsoft, Apple и Tesla. Последняя потеряла за день 12,3 % капитализации, что стало худшей динамикой дня с 2020 года. Инвесторов огорчила тенденция к снижению прибыли автопроизводителя. Акции Alphabet потеряли в цене 5 %, что стало максимальным дневным снижением с января текущего года. Компании даже не помогло превышение фактической квартальной статистикой существовавших прогнозов. Рекламная выручка видеохостинга YouTube не оправдала ожиданий аналитиков. По мнению экспертов, данная коррекция на фондовом рынке подтвердила стремление многих инвесторов отдалиться от акций компаний, так или иначе связанных с темой искусственного интеллекта. Отчет Alphabet показал, что расходы на ИИ растут, а результатов пока не видно. В итоге инвесторы начали распродавать акции ИТ-гигантов, что обрушило Nasdaq и другие индексы. Акции Nvidia упали в цене на 6,8 %, продемонстрировав худшую динамику в составе индекса S&P 500, а в индексе Nasdaq худший результат показали акции Super Micro Computer и ASML Holdings. В итоге индекс Nasdaq снизился на 7 % от максимума, достигнутого 10 июля текущего года. Акции Meta✴✴ Platforms упали в цене на 5,6 %, акции Microsoft подешевели на 3,6 %, а компания Apple столкнулась со снижением курса акций на 2,9 %. Представители Charles Schwab пояснили, что крупные компании технологического сектора наращивают затраты на искусственный интеллект, и чтобы инвесторы сохраняли интерес к их акциям, финансовые результаты должны с большим запасом превосходить ожидания рынка. Эксперты JPMorgan отмечают, что распродажа акций на фондовом рынке сопровождалась на этой неделе ухудшением макроэкономической ситуации. Meta✴✴, Amazon и Apple свои отчёты опубликуют только на следующей неделе, и они также могут выступить триггером для снижения котировок на фондовом рынке. Samsung наконец начнёт поставлять Nvidia память HBM3 в августе

24.07.2024 [10:06],

Алексей Разин

История с попытками Samsung наладить поставки своей памяти HBM3E для нужд Nvidia уходит своими корнями в первый квартал этого года, поскольку в СМИ начала курсировать фотография со стенда корейского производителя, где рядом с 12-ярусным чипом HBM3E данной марки фигурировал автограф основателя Nvidia. Тем не менее, микросхемы типа HBM3 она начнёт получать от Samsung не ранее августа.

Источник изображения: Samsung Electronics Об этом сообщает агентство Reuters со ссылкой на свои источники, добавляя, что пока Nvidia якобы одобрила чипы HBM3 производства Samsung для использования только в составе ускорителей H20 для китайского рынка, которые не являются массовой продукцией в масштабах мировых поставок. Значит ли это, что памяти HBM3 производства Samsung, не говоря уже о HBM3E, потребуется дополнительное время для сертификации под использование в других продуктах Nvidia, понять сложно. Отмечается, что для выпуска H20 корейский поставщик начнёт снабжать Nvidia микросхемами HBM3 в августе текущего года. В конце весны возникали слухи, что память HBM3E производства Samsung не может пройти сертификацию под требования Nvidia из-за своего высокого энергопотребления, но корейский производитель в дальнейшем выступил с опровержением этой информации. В начале июня глава Nvidia заявил, что память HBM3E марки Samsung требует доработки. Являясь крупнейшим производителем микросхем памяти в целом, Samsung сильно отстаёт от более мелких конкурентов в сегменте HBM. В результате SK hynix способна претендовать на половину этого рынка, тогда как американская Micron Technology свои микросхемы HBM3E тоже сертифицировала под требования Nvidia и сотрудничает с этой компанией. Samsung в этом смысле оказалась в числе отстающих. SK hynix своими микросхемами HBM3 компанию Nvidia снабжает с июня 2022 года, в марте этого она приступила к поставкам HBM3E для нужд этого американского клиента. AMD похвасталась, что её процессоры EPYC быстрее Nvidia Grace во многих тестах

23.07.2024 [17:29],

Павел Котов

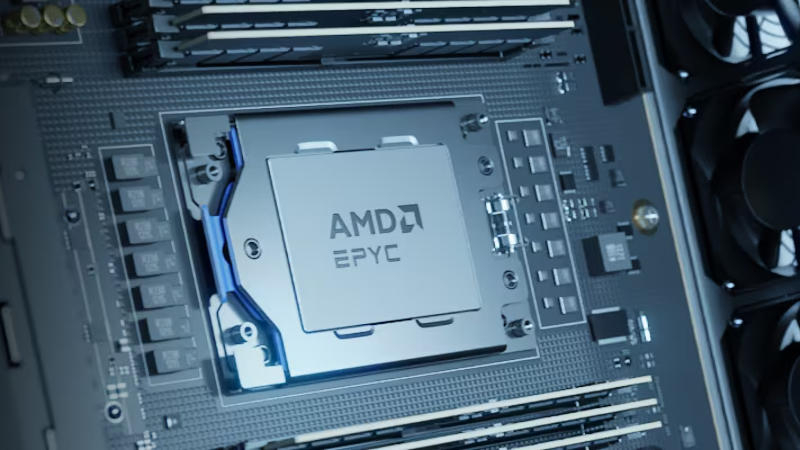

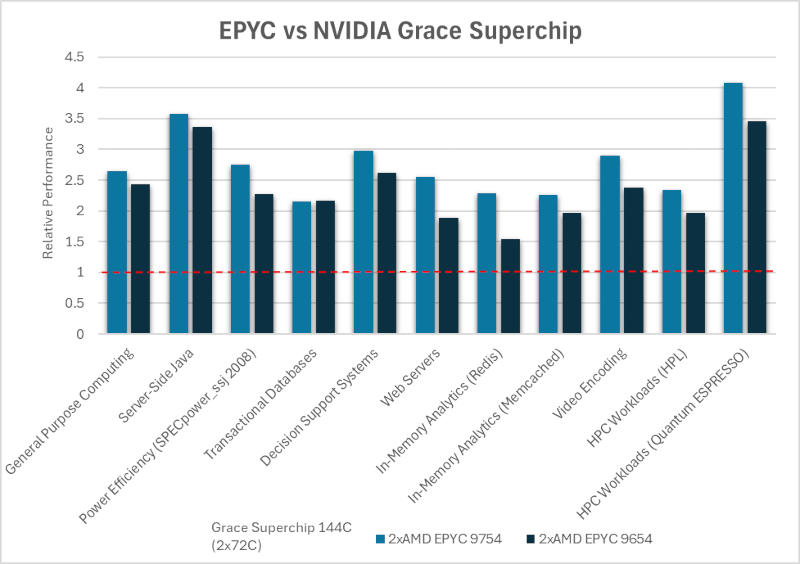

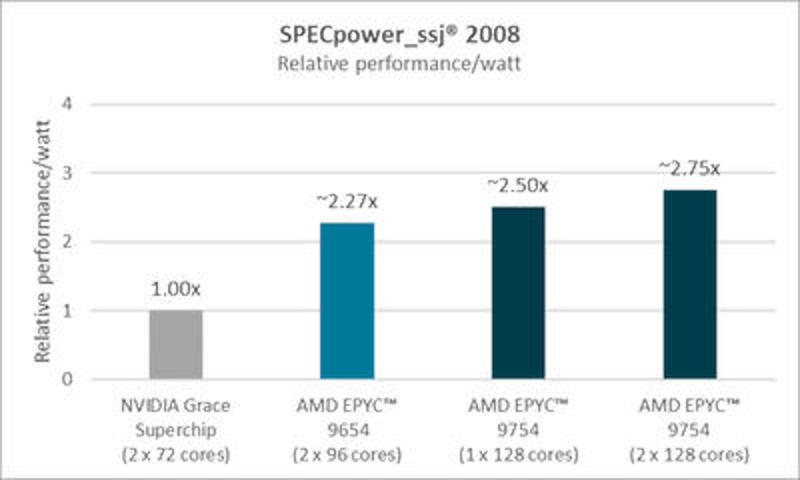

Nvidia ещё предстоит доказать, что она способна разрабатывать конкурентоспособные серверные процессоры, но состоявшийся игрок в лице AMD уже продемонстрировал, что воспринимает Arm-процессор Nvidia Grace Hopper Superchip серьёзно. Компания сравнила свои чипы EPYC с платформой Nvidia Grace и заявила о двухкратном преимуществе собственного продукта. Публикацию, конечно, следует воспринимать с некоторой долей скепсиса, но она даёт некоторое представление о Nvidia Grace.

Источник изображений: amd.com Согласно проведённым AMD тестам, её процессоры EPYC 9754 (128 ядер) и 9654 (96 ядер) более чем вдвое превосходят 144-ядерный Nvidia Grace Superchip (он включает два 72-ядерных CPU Grace) по производительности в различных рабочих нагрузках, включая вычисления общего назначения, Java, транзакционные базы данных, системы поддержки принятия решений, веб-серверы, аналитику, кодирование видео и высокопроизводительные вычисления (HPC). Так, в тесте SPECpower_ssj2008 одно- и двухсокетные системы на AMD EPYC 9754 превзошли Nvidia Grace примерно в 2,50 и 2,75 раза соответственно, а двухсокетный сервер на AMD EPYC 9654 оказался быстрее аналога от Nvidia примерно в 2,27 раза.  Процессоры EPYC, уверяют в AMD, удерживают более 300 мировых рекордов как по производительности, так и по эффективности в различных тестах, включая бизнес-приложения, технические вычисления, управление данными, аналитику данных, цифровые службы, медиа и развлечения, а также инфраструктурные решения. Но следует учесть, что чипы Nvidia Grace Hopper предназначены для рабочих нагрузок, связанных с обучением и запуском систем искусственного интеллекта.  Процессоры AMD EPYC построены на архитектуре x86, что означает совместимость с широким ассортиментом ПО, а Nvidia Grace имеют архитектуру Arm, которая пока распространена меньше. AMD указывает, что с учётом высоких производительности, энергоэффективности и совместимости с существующим ПО чипы EPYC предлагают более низкую совокупную стоимость владения (Total Cost of Ownership — TCO), чем Nvidia Grace, но не упоминают, что в задачах, связанных с обучением и работой ИИ платформа «зелёных» может и сама предложить значительные преимущества относительно ускорителей AMD Instinct. Nvidia пыталась выбить у TSMC выделенную линию по 3D-упаковке ИИ-чипов, но не вышло

23.07.2024 [12:08],

Алексей Разин

В плане своей способности поставлять клиентам ускорители вычислений Nvidia зависит от TSMC не только с точки зрения обработки кремниевых пластин, но и на этапе компоновки чипов с использованием уникального метода пространственной упаковки CoWoS. Попытки руководства первой из компаний получить для этих нужд выделенные производственные мощности TSMC не увенчались успехом, если верить слухам.

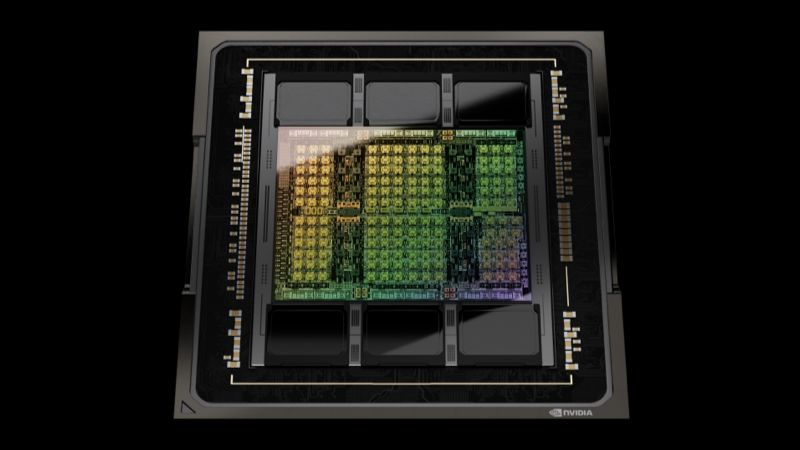

Источник изображения: Nvidia Данную информацию публикует ресурс Mirror Media, ссылаясь на подробности о программе визита основателя Nvidia Дженсена Хуанга (Jensen Huang) на Тайвань в июне этого года. По данным источников, тогда у него состоялась встреча не только с отошедшим от дел основателем TSMC Моррисом Чаном (Morris Chang), но и действующим руководителем компании Си-Си Вэем (C.C. Wei). Глава Nvidia в тот момент, если верить слухам, попросил у TSMC выделить под нужды его компании отдельную производственную линию, на которой будут упаковываться ИИ-чипы этой марки, но получил отказ от представителей тайваньского подрядчика. Исход переговоров создал некоторую напряжённость в отношениях между компаниями, как отмечают источники, но нынешний председатель совета директоров Си-Си Вэй сделал всё возможное, чтобы загладить последствия. На недавней квартальной конференции руководство TSMC признало, что компания не сможет удовлетворить спрос на выпуск компонентов для систем искусственного интеллекта как минимум до 2026 года. При этом тайваньский производитель до сих пор не может найти баланс спроса и предложения, но старается рационально определять размер необходимых капитальных затрат. По всей видимости, вложения в производственную линию для упаковки чипов Nvidia на данном этапе кажутся руководству TSMC нерациональными. Тем более, что норма прибыли в этой сфере услуг приближается к средней по компании, не обеспечивая каких-то впечатляющих преимуществ. Как отмечается, отказ TSMC был мотивирован возможными последствиями для отношений компании с другими клиентами, которые также захотели бы добиться определённых привилегий. Сохраняя равные для всех клиентов условия, TSMC может обеспечить более предсказуемую ситуацию с масштабированием производственных мощностей. В прошлом, как отмечают знакомые с практикой дел TSMC источники, эта компания предоставляла крупным клиентам определённые привилегии. Например, Apple в своё время попросила предоставить ей выделенные линии по выпуску чипов, и TSMC пошла на это, но в тот период тайваньский производитель сильно зависел от заказов Apple и не мог пренебрегать такой возможностью оптимальным образом загрузить свой конвейер. В случае с Nvidia ситуация заметно отличается. Как ожидается, TSMC не сможет покрыть потребности рынка в мощностях по упаковке чипов по методу CoWoS даже к концу следующего года, поскольку спрос будет расти опережающими темпами. Подобное положение на рынке, близкое к монопольному, позволяет TSMC более жёстко отстаивать свои интересы в переговорах с заказчиками. Это заметно даже по высказываниям Си-Си Вэя, который недавно признался, что хотел бы брать с той же Nvidia больше денег за услуги TSMC. Поставки ИИ-серверов Nvidia GB200 по цене $3 млн под угрозой срыва из-за протечек в СЖО

22.07.2024 [12:44],

Анжелла Марина

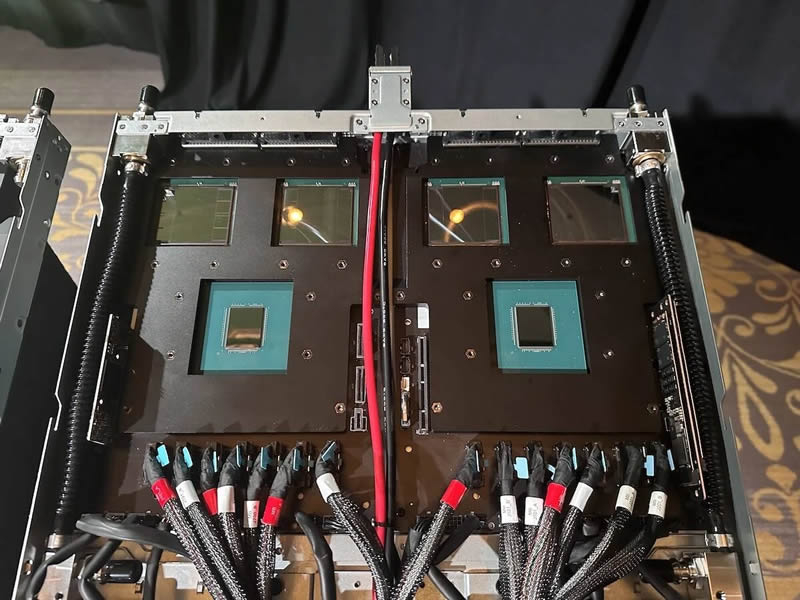

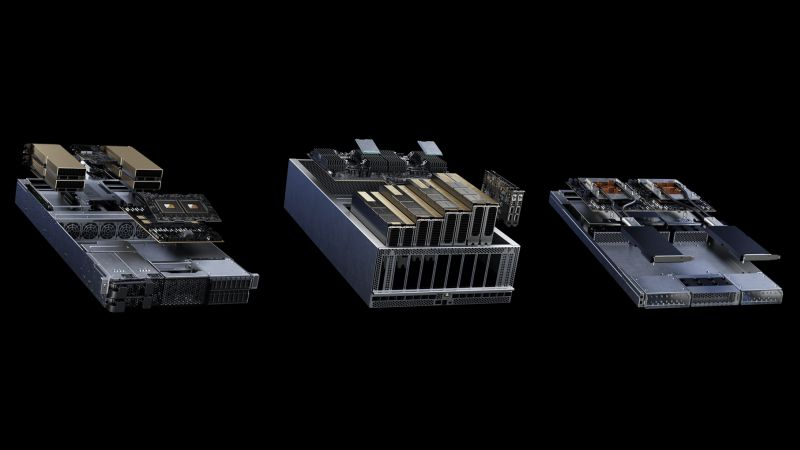

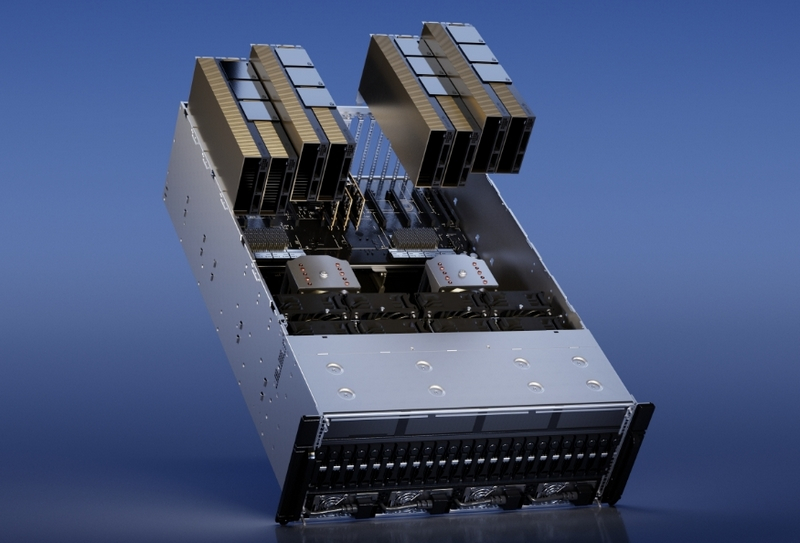

Неожиданная проблема настигла новейшие серверные системы Nvidia GB200 NVL72 и NVL36, оснащённые передовыми ускорителями вычислений GB200, которые предназначены для приложений искусственного интеллекта. Незадолго до начала массового производства и запуска продукта в продажу была обнаружена серьёзная проблема в системе жидкостного охлаждения.

Источник изображения: Nvidia Напомним, что системы GB200 NVL72 представляют собой целую серверную стойку сразу с 18 1U-узлами, в каждом из которых имеется пара ускорителей GB200, которые, в свою очередь, представляют собой пару чипов Nvidia B200 и один 72-ядерный Arm-процессор Grace. Итого система включает 72 чипов B200, 36 процессоров Grace, соединённых шиной NVLink 5. Вся эта система потребляет порядка 120 кВт, оснащена СЖО и единой DC-шиной питания. В свою очередь, система GB200 NVL36 представляет собой систему с вдвое меньшим числом GB200. По предварительным данным, система GB200 NVL72 будет стоить $3 млн. Как сообщает TweakTown со ссылкой на тайваньское издание UDN, в системах жидкостного охлаждения GB200 NVL72 обнаружены утечки, которые, по предварительным данным, связана с комплектующими сторонних производителей. Ранее Nvidia передала производство некоторых компонентов системы охлаждения, таких как патрубки, быстроразъёмные соединения и шланги, своим партнёрам — крупным международным производителям.

Источник изображения: theregister.com Утечки были обнаружены до начала массового производства ИИ-систем NVL36 и NVL72, что дало производителям время на устранение неполадок и, несмотря на возникшие трудности и угрозу срыва сроков поставок ключевым клиентам, ожидается, что продукт будет поставлен вовремя. Тем не менее, инцидент вызвал обеспокоенность у крупных поставщиков облачных услуг, которые опасаются за надёжность новых серверов Nvidia. В ответ на ситуацию, тайваньские производители, такие как Shuanghong и Qihong, стали наращивать производство компонентов для систем жидкостного охлаждения, чтобы предоставить Nvidia альтернативные варианты. Сертификация патрубков, быстроразъёмных соединений и шлангов является сложным процессом, требующим специальных знаний и опыта. Ранее тайваньские компании не специализировались на производстве подобных компонентов, но решение Nvidia использовать жидкостное охлаждение в своих AI-чипах подтолкнуло их к освоению новых технологий. В настоящий момент ведутся активные работы над устранением проблемы. Ожидается, что серверные шкафы с процессорами GB200 и исправленной системой охлаждения начнут поставляться клиентам в ближайшее время. Nvidia готовит для Китая антисанкционный ИИ-ускоритель новейшего поколения Blackwell

22.07.2024 [09:40],

Алексей Разин

Наличие у американской компании Nvidia стойкого желания продолжать поставки ускорителей вычислений в Китай даже в условиях постоянно эволюционирующих санкций США сложно отрицать. По некоторым данным, она теперь готовит адаптировать для текущих ограничений свои ускорители поколения Blackwell, соответствующий продукт упоминается под обозначением B20.

Источник изображения: Nvidia Если проводить аналогии с флагманским в официальной линейке ускорителей Nvidia для Китая решением по имени H20 с архитектурой Hopper, то речь наверняка идёт о подготовке его прямого преемника. Власти США, формулируя правила экспортного контроля, ограничивают поставляемые в Китай ускорители вычислений как с точки зрения быстродействия, так и с точки масштабирования кластеров. Как сильно Nvidia придётся урезать характеристики ускорителей Blackwell для соответствия актуальным требованиям властей США, угадать сложно. Новость о соответствующей активности Nvidia сегодня опубликовало агентство Reuters со ссылкой на собственные информированные источники. Компания, как утверждается, намерена сотрудничать с китайским производителем серверного оборудования Inspur, который будет распространять ускорители нового поколения на китайском рынке на легальных условиях. Официально наличие соответствующих планов не афишируется, но аналогичная конспирация предшествовала и анонсу ускорителей H20, L20 и L2, адаптированных компанией к новым условиям деятельности на китайском рынке. В прошлом году Китай обеспечил Nvidia примерно 17 % выручки, в текущем компания может выручить только на поставках H20 для нужд китайских клиентов до $12 млрд, как считают эксперты SemiAnalysis. Производители GeForce RTX 40 перешли на дешёвую термопасту, которая деградирует за несколько месяцев

20.07.2024 [17:44],

Павел Котов

Выступающие партнёрами Nvidia производители видеокарт попались на использовании дешёвой термопасты в последних видеокартах серии GeForce RTX 40, утверждает главный редактор ресурса igor'sLAB Игорь Валлоссек (Igor Wallossek). Такая экономия чревата проблемами для потребителей.

Источник изображения: nvidia.com Деградация термопасты, которая происходит всего за несколько месяцев, приводит к повышению температуры до 100 °C, а скорость вращения вентилятора застывает на 100 %. Валлосек решил расследовать проблему, когда обратил внимание на жалобы читателей на недостаточно высокую эффективность систем охлаждения видеокарт серии Nvidia GeForce RTX 40. Изучив модели Manli GeForce RTX 4080 Gallardo и Asus RTX 4080 TUF Gaming, он обнаружил, что причиной проблем стала некачественная термопаста. Когда он нанёс на видеокарты проверенный продукт, их температура вернулась к норме, и проблема устранилась. Впоследствии Игорь обнаружил, что проблема не ограничивается каким-то узким кругом партнёров Nvidia — большинство, если не все, закупают термопасту у одного и того же поставщика. Она демонстрирует отличные показатели в первые дни, но деградирует быстрее, чем стандартная термопаста. Чтобы подтвердить свою догадку, он устроил расширенное тестирование новой Manli GeForce RTX 4080 Gallardo, чтобы посмотреть, как себя поведёт термопаста. При 60 °C она при малой толщине слоя работала наравне с лучшими продуктами на рынке, включая Thermal Grizzly Kryonaut. При её нанесении более толстым слоем теплопроводность ухудшалась до уровня обычных продуктов вроде Arctic MX-6, но оставалась вполне приемлемой. Тогда эксперт решил изучить вещество под микроскопом — у термопасты оказалась дешёвая формула на основе странной маслянистой смеси, которая высыхает за считанные минуты, если растереть её пальцем. Кроме того, она содержит частицы оксида алюминия размером до 16 мкм — слишком крупные, но в краткосрочной перспективе они дают высокую теплопроводность, которая по прошествии времени снижается. К счастью, проблема решается относительно легко. Большинство видеокарт не так уж сложно разбираются, а замена термопасты производится так же, как на центральном процессоре. Найти качественный продукт несложно, и есть множество вариантов с ценником до $10. Дефицит ИИ-чипов сохранится до 2026 года, прогнозируют в TSMC

18.07.2024 [13:26],

Алексей Разин

Осторожность руководства TSMC в оценке влияния бума ИИ на бизнес компании, наблюдавшаяся в апреле, сменилась на более выраженную уверенность в сохранении высокого спроса на соответствующие чипы. Председатель совета директоров Си-Си Вэй (C.C. Wei) заявил, что возможности TSMC в сфере поставок компонентов для систем искусственного интеллекта будут ограничены на протяжении всего 2025 года.

Источник изображения: TSMC Соответственно, если дефицит немного и отступит, это произойдёт не ранее 2026 года. Об уверенности контрактного производителя в сохранении высокого спроса говорит и повышение нижней границы диапазона капитальных затрат на этот год, а также улучшение прогноза по росту выручки. Помимо собственно линий по обработке кремниевых пластин, TSMC вынуждена больше денег тратить и на упаковку чипов для систем ИИ, имеющих сложную пространственную компоновку. Компания готова искать более прогрессивную альтернативу методу CoWoS, который сейчас используется для упаковки чипов Nvidia, применяемых в составе ускорителей вычислений. «Спрос очень высок, поставки будут сильно ограничены вплоть до 2025 года включительно, и мы надеемся, что облегчение наступит в 2026 году. Мы продолжаем наращивать производственные мощности в любых местах и любыми способами», — пояснил Си-Си Вэй. По словам генерального директора TSMC, коим также является Си-Си Вэй, в настоящее время компания экспериментирует с методом упаковки FOPLP (panel fan-out technology), но она не слишком созрела для массового производства. Случится это примерно через три года, как предполагает глава компании. К тому времени и сама TSMC будет готова освоить этот метод упаковки чипов в условиях массового производства. Глава компании добавил, что в части CoWoS она более чем в два раза к этому году удвоила профильные производственные мощности, и в следующем году может удвоить их ещё раз. Ранее считалось, что на этом направлении дефицит будет устранён к концу 2024 года. Си-Си Вэй пояснил, что первое поколение 2-нм чипов встанет на конвейер TSMC во второй половине 2025 года, а второе последует за ним в 2026 году. Во второй половине 2026 года компания планирует освоить выпуск продукции по более совершенному техпроцессу A16. В сфере искусственного интеллекта, как считает глава TSMC, спрос распространится и на периферийные устройства вычислительных систем типа смартфонов и ПК, но пока это никак не влияет на количественные показатели поставок продукции в соответствующих сегментах рынка. За два последующих года развитие рынка устройств с функциями ускорения ИИ позволит сократить длительность цикла эксплуатации таких устройств. Сейчас спрос со стороны заказчиков TSMC особенно высок на выпуск продукции с использованием 5-нм и 3-нм техпроцессов. Уже сейчас ведётся работа по обеспечению клиентов адекватными квотами на выпуск такой продукции с расчётом на 2026 год. Несмотря на прозвучавшие в американском информационном поле вчера неоднозначные заявления одного из кандидатов на пост президента США, руководство TSMC не стало пересматривать свои планы относительно строительства своих зарубежных предприятий. В этой сфере всё идёт по графику и каких-либо изменений сейчас не предвидится, как дал понять Си-Си Вэй. Ранее уже отмечалось, что руководство TSMC не исключает возможности повышения цен на свои услуги для компании Nvidia. Сегодня Си-Си Вэй добавил, что его компания сталкивается с растущим ценовым давлением. Затраты растут из-за усложнения техпроцессов, дорожающего электричества на Тайване и высоких капитальных расходов при строительстве зарубежных предприятий. При этом TSMC настаивает, что не придерживается оппортунистического подхода к формированию цен, и выстраивает свои отношения с клиентами, пытаясь убедить их в адекватной ценности своих услуг. Аналитики Nomura Global Market Research считают, что TSMC поднимет цены на свои услуги на 5–10 % с января 2025 года. Microsoft добавит в каталог игр Xbox ссылки на GeForce Now

18.07.2024 [12:20],

Павел Котов

Microsoft добавит ссылки на игровую облачную службу Nvidia GeForce Now на страницы каталога Xbox — интеграция даст геймерам возможность выбора между Xbox Cloud Gaming и GeForce Now при просмотре списка игр в веб-интерфейсе.

Источник изображения: Rubaitul Azad / unsplash.com До настоящего момента в блоке облачных игр в каталоге значилась ссылка только на принадлежащий Microsoft сервис Xbox Cloud Gaming, но в ближайшее время к нему присоединится Nvidia GeForce Now. Пока каталог ещё не обновился, и нет ясности, куда будет вести ссылка на альтернативную облачную платформу: на её главную страницу или страницу соответствующей игры. Тариф Nvidia GeForce Now RTX 4080 сегодня является, пожалуй, самым внушительным предложением на рынке облачных игровых служб — Nvidia даже утверждает, что её сервис обеспечивает меньшую задержку, чем предлагает работающая локально физическая приставка Xbox Series X, подключённая к телевизору с частотой обновления экрана 60 Гц. Ранее Microsoft и Nvidia подписали 10-летнее соглашение, позволяющее производителю видеокарт лицензировать игры из каталога Xbox PC для платформы GeForce Now, включая продукцию Activision Blizzard. В этом году Nvidia также выпустила обновление GeForce Now, которое позволяет пользователям синхронизировать учётные записи Xbox и покупки в Microsoft Store с облачным игровым сервисом. На GeForce Now можно запускать также проекты из подписного каталога PC Game Pass. Акции Nvidia, TSMC и ASML упали из-за американских санкционных угроз и комментариев Трампа

17.07.2024 [19:44],

Владимир Мироненко

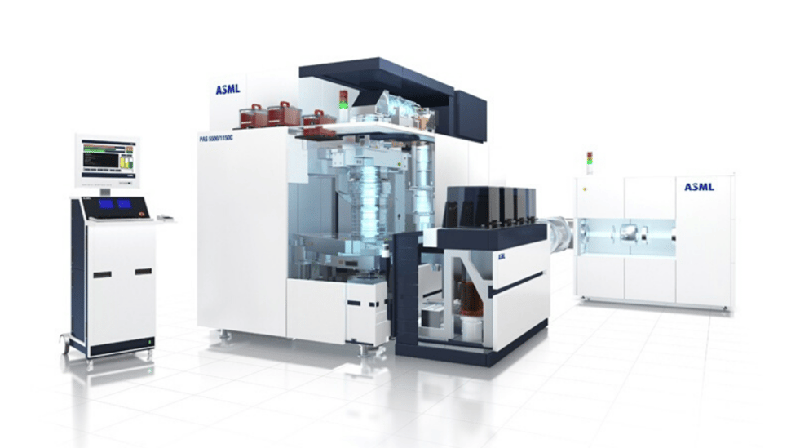

Акции ASML, Nvidia и TSMC упали после публикации агентства Bloomberg о том, что США рассматривают возможность введения более жёстких экспортных ограничений для тех компаний, которые продолжают предоставлять Китаю доступ к передовым полупроводниковым технологиям. Это также связано с заявлением Дональда Трампа (Donald Trump) о том, что Тайвань забрал «около 100 %» американского полупроводникового бизнеса.

Источник изображения: ASML По словам источников Bloomberg, США обдумывают введение такой меры, как «правило прямого иностранного продукта» (FDPR), предусматривающее необходимость получения компаниями из третьих стран лицензии властей США в случае, если в экспортируемой продукции используются американские технологии. Как сообщает CNBC, акции поставщика оборудования для выпуска чипов ASML упали на утренних торгах на 10 %, а акции ещё одного производителя оборудования, жизненно важного для полупроводниковой отрасли, Tokyo Electron в Японии закрылись снижением почти на 7,5 %, что привело к падению японского индекса Nikkei 225 Stock Average. Другие поставщики оборудования для производства микросхем, включая Lasertec Corp. и Screen Holdings Co., тоже оказались в числе наиболее пострадавших от падения рынка. Следует отметить, что акции ASML упали в цене несмотря на то, что компания сообщила о прибыли за II квартал, которая превзошла прогнозы экспертов. И при этом 49 % продаж её оборудования за отчётный квартал пришлось на Китай, что говорит о том, насколько рискует компания в случае ужесточения экспортных ограничений. В этой ситуации только повысили напряжённость комментарии бывшего президента США, сообщившего в интервью Bloomberg Businessweek, опубликованном во вторник, что Тайвань должен платить США за оборону, а также, что Тайвань забрал почти весь американский полупроводниковый бизнес. Nvidia выпустила драйвер с поддержкой Dungeonborne, Flintlock: The Siege of Dawn и Stormgate

16.07.2024 [20:01],

Николай Хижняк

Компания Nvidia выпустила свежий пакет графического драйвера GeForce Game Ready 560.70 WHQL. В него добавлена поддержка Dungeonborne, Flintlock: The Siege of Dawn и Stormgate, в которых реализованы технологии DLSS 3 и Reflex.

Источник изображения: Mithril Interactive Nvidia отмечает, что технология DLSS 3 повышает производительность в Dungeonborne на видеокартах GeForce RTX 40-й серии при разрешении 4K до 3,3 раза, при разрешении 1440p до 2,3 раза, а при разрешении 1080p производительность увеличивается до 2,1 раза. В свежий пакет графического драйвера GeForce также добавлена поддержка 14 мониторов, совместимых с технологией G-Sync. Их список можно увидеть в таблице ниже. Список исправленных проблем:

Список известных проблем:

Скачать новый драйвер GeForce Game Ready 560.70 WHQL можно через приложение Nvidia App или с официального сайта Nvidia. Nvidia столкнулась с антимонопольным расследованием во Франции — компании грозит крупный штраф

16.07.2024 [09:42],

Алексей Разин

В конце сентября прошлого года, как стало известно с подачи СМИ, полиция провела обыски во французских офисах компании Nvidia. Правоохранители искали доказательства, которые помогли бы им выявить злоупотребления Nvidia в части антимонопольного законодательства. Сейчас французские власти не стесняются признать, что Nvidia в случае доказательства её вины придётся ответить по закону и выплатить штраф.

Источник изображения: Nvidia Бенуа Кере (Benoit Couere), глава французского антимонопольного ведомства, в комментариях Reuters подтвердил, что оно ведёт расследование в отношении Nvidia, и компанию могут оштрафовать, если расследование придёт к соответствующим выводам. В сентябре, когда в местных офисах Nvidia проходили обыски, власти Франции старались не комментировать, какая компания и в чём ими подозревается. Принято считать, что у французских антимонопольщиков возникли подозрения в злоупотреблении Nvidia своим положением на рынке компонентов для облачных вычислений. Если будет доказано, что компания своим поведением необоснованно повышает цены и притесняет более мелких конкурентов, ей придётся выплатить крупный штраф. Сентябрьским обыскам предшествовал анализ рынка облачных систем одним из французских правительственных агентств. До сих пор представители Nvidia никак эту ситуацию не комментировали. Джим Келлер создаёт ИИ-ускорители с думающими процессорами, которые будут дешевле аналогов Nvidia

15.07.2024 [11:40],

Алексей Разин

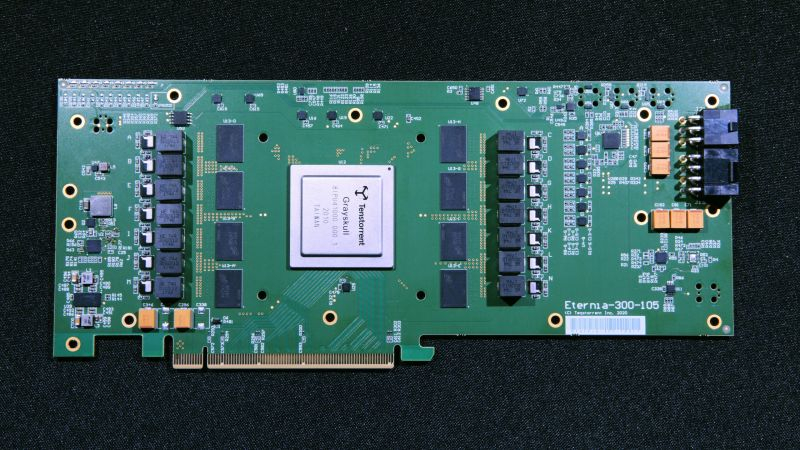

Легендарный разработчик процессорных архитектур Джим Келлер (Jim Keller), создавший немало коммерчески успешных чипов Apple, Intel, AMD и Tesla, в последнее время сосредоточен на создании ускорителей вычислений в штате стартапа Tenstorrent. Именитый инженер убеждён, что на этом месте работы ему удастся создать ускорители систем искусственного интеллекта, которые будут обладать большей гибкостью конфигурирования и меньшей стоимостью по сравнению с решениями Nvidia.

Источник изображения: Tenstorrent Келлер поделился некоторыми своими соображениями с представителями ресурса Nikkei Asian Review. «Существует немало сегментов рынка, которые недостаточно охвачены Nvidia», — оптимистично заявил Джим Келлер, выступающий в роли генерального директора американского стартапа Tenstorrent на данном этапе своей карьеры. По мере распространения функции ИИ в сегменте смартфонов, облачных сервисов и даже электромобилей, как он пояснил, многие клиенты ищут более доступные альтернативы ускорителям Nvidia. Не каждая компания, по его словам, готова выложить $20 000 за каждый ускоритель этой марки. Второе поколение ускорителей Tenstorrent, к созданию которых Келлер приложил руку, начнёт поставляться на рынок к концу текущего года. По словам представителей основанной в 2016 году компании, в некоторых сферах применения решения Tenstorrent превосходят ускорители Nvidia по энергетической эффективности и быстродействию. Готовые системы семейства Galaxy оказываются в три раза эффективнее с точки зрения энергопотребления, и при этом на треть дешевле, чем Nvidia DGX. Снизить стоимость своих ускорителей и их энергопотребление, помимо прочего, Tenstorrent может благодаря отказу от использования дорогой памяти HBM. Компания Tenstorrent изначально разрабатывала архитектуру своих ускорителей таким образом, чтобы сократить время передачи информации между чипом и микросхемой памяти без использования дорогостоящей HBM. Такой подход позволит заменить как HBM, так и GPU в определённых сферах применения ускорителей искусственного интеллекта. По словам Келлера, многие компании ищут более доступные альтернативы HBM, но чтобы пошатнуть нынешние позиции этого типа памяти на рынке, потребуются годы. Глава Tenstorrent считает, что в определённых сегментах рынка появится множество игроков, способных удовлетворить спрос лучше Nvidia. Ускорители Tenstorrent используют сотни крохотных процессорных ядер, которые можно конфигурировать довольно гибко с точки зрения решаемых вычислительных задач. По этой причине подход компании к созданию ускорителей позволит ей адаптировать свои разработки под нужды самых разных сегментов рынка. Ядра этих ускорителей, по словам разработчика, способны самостоятельно «думать» и выбирать, какие данные обрабатывать в первую очередь, и как повысить эффективность вычислений. Одни и те же процессорные ядра могут применяться и в смартфонах, и в серверных системах — разница преимущественно будет заключаться в их количестве. Келлер затрудняется определить, какая сфера применения искусственного интеллекта будет более востребована, по этой причине Tenstorrent создаёт решения, которые подойдут под широкий спектр задач. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |