|

Опрос

|

реклама

Быстрый переход

Японцы научили ИИ видеть сквозь стены при помощи Wi-Fi

02.10.2025 [18:52],

Павел Котов

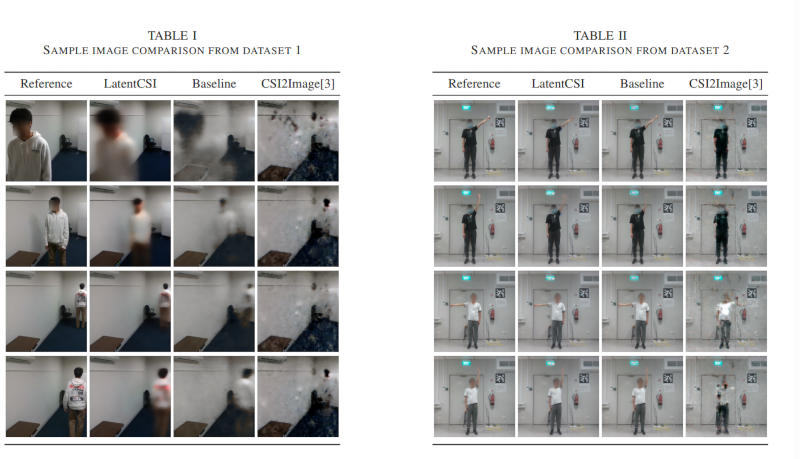

Подключённые к Wi-Fi устройства вокруг нас постоянно обмениваются сигналами пространственно ориентированных радиоволн. Эти радиоволны отражаются от стен, мебели и других предметов в пространстве, формируя информацию о местоположении этих объектов. Такой набор данных или информацию о состоянии канала Wi-Fi (Wi-Fi CSI) ранее научились использовать для построения грубых эскизов помещений, и точность этих эскизов можно повысить при помощи искусственного интеллекта.

Источник изображения: Institute of Science Tokyo Исследователи Токийского университета науки предложили способ обрабатывать данные Wi-Fi CSI при помощи диффузионных моделей ИИ. Построенная на математических алгоритмах визуализация Wi-Fi CSI даёт лишь приблизительные результаты из-за недостаточных объёмов исходной информации и требует слишком больших вычислительных ресурсов — эти пробелы способна восполнить диффузионная модель ИИ, обученная создавать фотореалистичные изображения. Это достигается преобразованием Wi-Fi CSI в латентное (скрытое) пространство — общее представление объектов, которым оперируют диффузионные модели ИИ, а не в набор пикселей; поэтому метод получил название LatentCSI. Технология LatentCSI предполагает перевод Wi-Fi CSI в латентное пространство, которое затем транслируется в предварительно обученную диффузионную модель, а она уже генерирует изображение высокого разрешения с мелкими деталями и текстурами, которые Wi-Fi сам по себе «разглядеть» не в состоянии. В своём проекте исследователи подключили кодировщик Wi-Fi CSI к модели Stable Diffusion 3, которая принимала его данные как запросы на генерацию изображения, что позволило экономить вычислительные ресурсы. Важно, что модель проходила предварительное обучение на реальных фотографиях изучаемого помещения, то есть она знала, как оно выглядит пустым. После этого ИИ восстанавливал положение переменной среды, показывая, сколько человек находилось в комнате, где они стояли, и каково было общее расположение объектов внутри. Едва ли провайдеры теперь смогут следить за абонентами при помощи маршрутизаторов, но некоторые вопросы об угрозе конфиденциальности технология LatentCSI всё-таки вызывает. Она, вероятно, поможет следить за людьми, хотя сейчас это просто лабораторная демонстрация. Это уже не первое подобное решение: ранее итальянские учёные предложили способ идентифицировать людей по искажениям, которые их тела вносят в сигналы Wi-Fi; а американские исследователи построили на радиосигналах систему зрения для роботов. Stability AI выпустила ИИ-генератор музыки, который быстро работает даже на смартфоне

14.05.2025 [23:39],

Анжелла Марина

Stability AI, разработчик популярной нейросети Stable Diffusion, представила музыкальную ИИ-модель Stable Audio Open Small, которая генерирует аудио в стереозвучании и способна работать на смартфонах без подключения к интернету. Модель создана совместно с производителем чипов Arm, чьи процессоры используются в большинстве мобильных устройств, и способна быстро генерировать аудио в высоком качестве даже на устройствах с ограниченными вычислительными ресурсами.

Источник изображения: AI В отличие от конкурентов, таких как Suno и Udio, которым требуется облачная обработка, Stable Audio Open Small работает локально. При этом, как отмечает TechCrunch, обучение модели проводилось только на данных из бесплатных аудиобиблиотек Free Music Archive и Freesound, что снижает риски нарушения авторских прав и выгодно отличает её от некоторых других ИИ-сервисов, использующих защищённый контент. Модель содержит 341 миллион параметров и оптимизирована для процессоров Arm. Она предназначена для быстрого создания коротких аудиосэмплов и звуковых эффектов, например, ударных или инструментальных партий. По заявлению Stability AI, на смартфоне ИИ может сгенерировать 11-секундное аудио менее чем за восемь секунд. Одновременно у Stable Audio Open Small есть некоторые ограничения. Например, она понимает текстовые запросы только на английском языке, не умеет создавать реалистичный вокал или сложные музыкальные композиции. Кроме того, компания признаёт, что из-за того, что модель обучалась на западно-ориентированных данных, она лучше справляется со стилями, присущими западной музыке. Ещё одна сложность заключается в условиях использования. Для исследователей, любителей и малого бизнеса ИИ-модель доступна бесплатно, но если годовой доход компании превышает $1 млн, потребуется покупка коммерческой лицензии. И хотя для инди-разработчиков такие условия выгодны, для крупных проектов это может стать определённой сложностью. Напомним, Stability AI, известная по своей модели глубокого обучения Stable Diffusion, генерирующей изображения по текстовым описаниям, в последние месяцы пытается восстановить репутацию после финансовых проблем при бывшем генеральном директоре Эмаде Мостаке (Emad Mostaque). Компания привлекла инвестиции, назначила нового главу и добавила в совет директоров режиссёра Джеймса Кэмерона (James Cameron). Параллельно она продолжает выпускать новые генеративные модели, включая новые инструменты для создания изображений. StabilityAI представила улучшенную ИИ-модель для генерации изображений Stable Diffusion 3.5

23.10.2024 [05:06],

Анжелла Марина

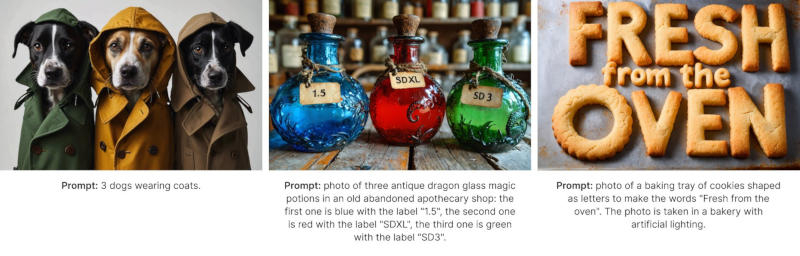

Компания StabilityAI представила новую версию ИИ-модели для генерации изображений Stable Diffusion 3.5 с улучшенным реализмом, точностью и стилизацией. По сообщению Tom's Guide, модель бесплатна для некоммерческого использования, включая научные исследования, а также для малых и средних предприятий с доходом до $1 млн.

Источник изображения: StabilityAI Как и предыдущая версия SD3, Stable Diffusion 3.5 доступен в трёх конфигурациях: Large (8B), Large Turbo (8B) и Medium (2,6B). Все конфигурации оптимизированы для работы на обычном пользовательском оборудовании и их можно настраивать. В своём пресс-релизе StabilityAI признала, что модель Stable Diffusion 3 Medium, выпущенная в июне, не полностью соответствовала стандартам и ожиданиям сообщества. «После того как мы выслушали ценные отзывы, вместо быстрого исправления мы решили уделить время разработке версии, которая продвигает нашу миссию по трансформации визуальных медиа», — сказали в компании. Новые модели ориентированы на возможность гибкой настройки, высокую производительность и разнообразие результатов. Поддерживаются стилистические настройки, включая фотографию и живопись. Для указания определённого стиля можно также использовать хештеги, например, boho, impressionism или modern. Ещё можно выделять ключевые слова в запросе для получения более реалистичных изображений. Модель Stable Diffusion 3.5 Large лидирует на рынке по лучшему соответствию запросам и качеству изображений. Модель Turbo имеет минимальное время вывода результатов. Medium превосходит другие модели в плане баланса между качеством изображений и соответствия запросам, что делает её, по утверждению компании, самым эффективным выбором для создания контента. Все три конфигурации свободно доступны по лицензии Stability AI Community License. Для использования в коммерческих целях потребуется лицензия Enterprise License. Stability AI представила Stable Fast 3D — ИИ-инструмент для быстрого создания 3D-изображений

02.08.2024 [19:29],

Анжелла Марина

Компания Stability AI, разработчик в области искусственного интеллекта, создала на основе генеративного ИИ технологию, которая позволяет молниеносно генерировать 3D-изображения. Если раньше требовалось мощное оборудование и сложное программирование, то теперь модель Stable Fast 3D, состоящая из двух миллиардов параметров, способна генерировать на основе текста или референса яркие, фотореалистичные изображения всего за полсекунды, сообщает VentureBeat.

Источник изображения: Stability.ai По заявлению компании, технология знаменует собой значительный прорыв в области 3D-моделирования, сокращая время обработки изображений. «Это в 1200 раз быстрее, чем наша предыдущая модель Stable Video 3D, выпущенная в марте, которой требовалось до 10 минут для создания только одного 3D-объекта», — отмечают представители Stability AI. Stable Fast 3D обещает стать мощным инструментом для различных отраслей, включая дизайн, архитектуру, розничную торговлю, виртуальную реальность и разработку игр. В его основе лежит технология TripoSR, разработанная в сотрудничестве с компанией Trip AI, специализирующейся на 3D-моделировании.

Источник изображения: Stability.ai В исследовательской статье, опубликованной Stability AI, подробно описываются методы, используемые новой моделью для быстрой реконструкции высококачественных 3D-сеток из обычных 2D-изображений. Суть метода заключается в увеличении скорости генерации конечного результата без потери качества. При этом технология использует усовершенствованную нейронную сеть-трансформер для создания объёмных изображений в высоком разрешении без значительного увеличения вычислительной мощности, что позволяет уменьшать артефакты и получать более детализированные 3D-модели. Кроме того, Stable Fast 3D использует инновационный подход к оценке освещения и материалов. ИИ-модель может определить глобальные значения, например шероховатость, жидкость или металл, используя метод вероятности, который улучшает качество изображения. Технология также позволяет объединять несколько элементов, необходимых для 3D-изображения, включая сетку, текстуры и свойства материалов, в компактный, готовый к использованию 3D-актив. Интересно, что Stability AI продолжает активно расширять границы использования генеративного ИИ, переходя от 2D к 4D. Компания, начавшая свой путь с генерации изображений по тексту — Stable Diffusion, уже в ноябре 2023 года выпустила Stable 3D. В марте этого года дебютировала с технологией Stable Video 3D с возможностью базового панорамирования камеры для просмотра изображений и улучшенным качеством генерации 3D-изображений. А буквально на прошлой неделе анонсировала технологию Stable Video 4D, которая добавляет измерение времени к генерации коротких 3D-видео. Модель Stable Fast 3D доступна через чат-бота Stable Assistant от Stability AI, API Stability AI, а также по лицензии научно-исследовательского сообщества Hugging Face. Stability AI сменила руководство и привлекла 80 млн долларов инвестиций

26.06.2024 [18:16],

Сергей Сурабекянц

Стартап в области искусственного интеллекта Stability AI в последнее время столкнулся с растущими затратами и текучкой кадров. Сегодня компания объявила о назначении генеральным директором Према Аккараджу (Prem Akkaraju). Должность председателя правления занял крупный инвестор Шон Паркер (Sean Parker). Сообщается, что в общей сложности Stability AI удалось привлечь финансирование в размере $80 млн.

Источник изображения: stability.ai «Компания находится в идеальном положении, чтобы возглавить реальную конвергенцию генеративного искусственного интеллекта и студийного контента», — говорится в заявлении Аккараджу, который вместе с Паркером войдёт в совет директоров. Назначение нового руководителя Stability AI положило конец многомесячному хаосу в некогда популярном стартапе. В марте соучредитель и первый генеральный директор компании Эмад Мостак (Emad Mostaque) подал в отставку из-за ухода ключевых сотрудников и акционеров, и сокращения денежных резервов. После его увольнения ключевой инвестор Coatue Management вышел из совета директоров, но после назначения нового руководителя возобновил своё участие в инвестициях. Кроме Coatue Management в новом раунде финансирования приняли участие такие инвесторы, как Lightspeed Venture Partners, Greycroft, миллиардер Эрик Шмидт (Eric Schmidt), а также Аккараджу и Паркер. Временные генеральные директора Шань Вонг (Shan Wong) и Кристиан Лафорте (Christian Laforte) останутся в Stability AI в качестве главного операционного директора и технического директора соответственно. Stability AI в конце 2022 года привлекла $101 млн венчурного капитала благодаря разработанному её сотрудниками популярному ИИ-инструменту для генерации изображений Stable Diffusion. Затем компания столкнулась с целым рядом управленческих и юридических проблем, включая иск от Getty Images. В отличие от конкурирующих компаний, Stability AI долгое время не удавалось привлечь дополнительное финансирование. Представлен ИИ-генератор изображений Stable Diffusion Medium, которому достаточно видеокарты с 5 Гбайт памяти

12.06.2024 [18:22],

Павел Котов

Компания Stability AI представила модель искусственного интеллекта Stable Diffusion Medium, предназначенную для генерации изображений по текстовому описанию. Её старшая версия Stable Diffusion 3 была анонсирована ещё в феврале, а в апреле она заработала через API.

Источник изображений: Stability AI Stable Diffusion Medium задумана как модель меньшего размера — очень мощная, но способная работать на потребительских видеокартах. Уменьшенный вариант Stable Diffusion 3 станет привлекательным вариантом для пользователей и организаций с ограниченными ресурсами, которым необходимо запустить высокоэффективную систему генерации изображений. Испробовать новую нейросеть пока можно через API, на сервере Stable Artisan через Discord; веса модели также доступны для некоммерческого использования на Hugging Face.  С выходом новой нейросети представленная ранее большая модель переименовывается в Stable Diffusion 3 (SD3) Large — она имеет 8 млрд параметров, тогда как у новой SD3 Medium только 2 млрд параметров, зато она может работать на домашних видеокартах, выдвигая системное требование в 5 Гбайт видеопамяти. Раньше для моделей Stable Diffusion требовались исключительно передовые модели Nvidia, но и сейчас рекомендуются всё-таки видеокарты с 16 Гбайт памяти.  При относительно скромных требованиях к ресурсам SD3 Medium предлагает широкие возможности, сопоставимые по ряду функций со старшей SD3 Large: фотореализм, типографику, понимание естественного языка и пространственного расположения элементов на изображении, высокую детализацию на мегапиксель и высокую адаптируемость с возможностью тонкой настройки. В MIT придумали, как в 30 раз ускорить генерацию изображений с помощью ИИ

24.03.2024 [14:00],

Владимир Чижевский

Исследователи из Массачусетского технологического института (MIT) смогли заметно ускорить создание изображений по текстовым описаниям с помощью генеративного искусственного интеллекта. Новый метод позволяет генерировать изображения высокой чёткости в 30 раз быстрее существующих.

Источник изображения: pixabay.com Обычно в генеративных ИИ применяется техника так называемой «диффузии», когда создаётся максимально размытая картинка, а затем она детализируется до окончательного результата, максимально соответствующего тому, что ИИ может выдать в ответ на запрос пользователя. Диффузия занимает довольно много времени, поэтому исследователи MIT поставили цель её ускорить. Исследователи из Лаборатории компьютерных наук и искусственного интеллекта MIT свели генерацию изображений к единственному проходу, а новый метод назвали «дистилляцией с согласованным распределением» (distribution matching distillation). Очевидно, что генерация картинки в один проход заметно быстрее, чем за типичные для диффузионных моделей 30–50 шагов. Так, на современном оборудовании Stable Diffusion 1.5 создаёт изображение за 1,5 секунды, в то время как новая модель на основе DMD справляется за 0,05 секунды. Это не первая попытка дистилляции диффузионных моделей для ускорения генерации изображений. В Instaflow и LCM пытались применить похожий подход, но результаты не впечатляли. Компания Stability AI также пыталась ускорить диффузионные модели и добилась некоторых успехов, выпустив Stable Diffusion Turbo, создающую картинку с разрешением до 1 мегапикселя за один проход, однако сгенерированные в несколько проходов изображения всё равно получались заметно лучше. ИИ-ускоритель Intel Gaudi2 оказался на 55 % быстрее Nvidia H100 в тестах Stable Diffusion 3, но есть нюанс

12.03.2024 [18:34],

Сергей Сурабекянц

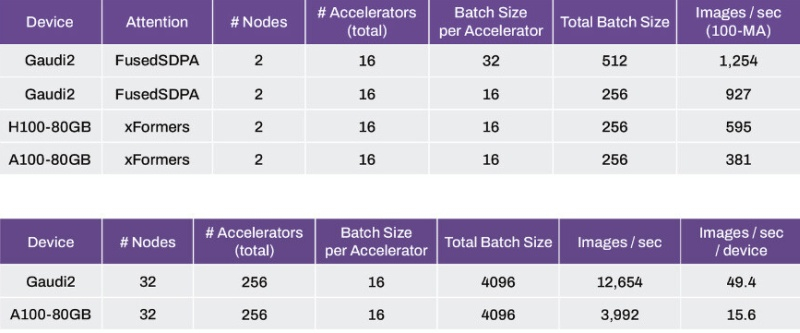

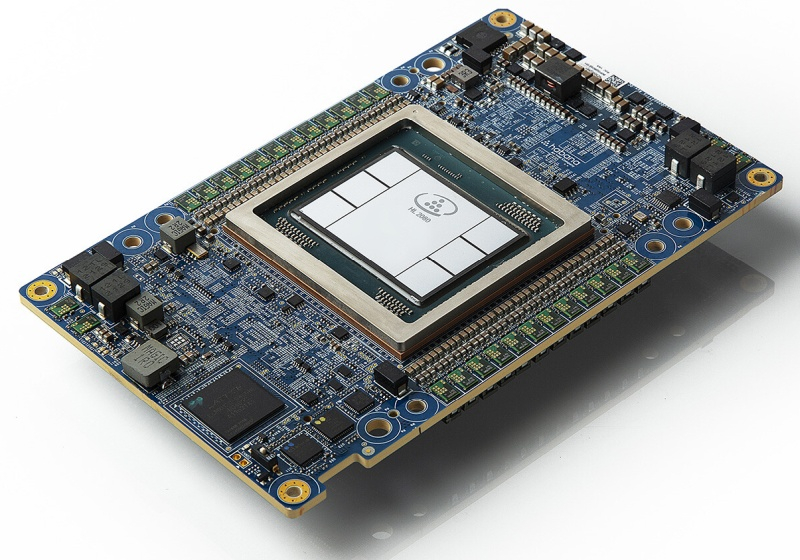

Компания Stability AI, разработчик популярной модели генеративного ИИ Stable Diffusion, сравнила производительность модели Stable Diffusion 3 на популярных ускорителях вычислений для центров обработки данных, включая Nvidia H100 Hopper, A100 Ampere и Intel Gaudi2. По утверждению Stability AI, Intel Gaudi2 продемонстрировал производительность примерно на 56 % выше, чем Nvidia H100.

Источник изображения: Intel В отличие от H100, который представляет собой суперскалярный графический процессор с тензорными CUDA-ядрами, Gaudi2 специально спроектирован для ускорения генеративного ИИ и больших языковых моделей (LLM). В тестах приняли участие пары кластеров, которые в сумме обеспечивали по 16 тех или ускорителей, а проводились тесты с постоянным размером батча (число тренировочных объектов) в 16 на каждый ускоритель (всего 256). Системы на Intel Gaudi2 оказались способны генерировать 927 изображений в секунду по сравнению с 595 изображениями для ускорителей H100 и 381 изображением в секунду для массива A100.

Источник изображения: Stability AI При увеличении количества кластеров до 32, а числа ускорителей до 256 и размере батча 16 на ускоритель (общий размер 4096), массив Gaudi2 генерирует 12 654 изображения в секунду или 49,4 изображения в секунду на ускоритель, по сравнению с 3992 изображениями в секунду или 15,6 изображениями в секунду на устройство у массива A100 Ampere.

Источник изображения: Nvidia Необходимо отметить, что производительность ускорителей ИИ измерялась с использованием фреймворка PyTorch, а в случае применения оптимизации TensorRT чипы A100 создают изображения до 40 % быстрее, чем Gaudi2. Тем не менее, исследователи Stability AI ожидают, что при дальнейшей оптимизации Gaudi2 превзойдёт A100. Компания полагает, что более быстрый интерконнект и больший объем памяти (96 Гбайт) делают решения Intel вполне конкурентоспособными и планирует использовать ускорители Gaudi2 в Stability Cloud.

Источник изображения: techpowerup.com По сообщению Stability AI, в более ранних тестах модели Stable Diffusion XL с использованием фреймворка PyTorch ускоритель Intel Gaudi2 генерирует при 30 шагах изображение размером 1024 × 1024 за 3,2 секунды по сравнению с 3,6 секунды для PyTorch на Nvidia A100 и 2,7 секунды при использовании оптимизации TensorRT на Nvidia А100. |