⇣ Содержание

|

Опрос

|

реклама

Самое интересное в новостях

GeForce GTX 690 – два GPU без компромиссов

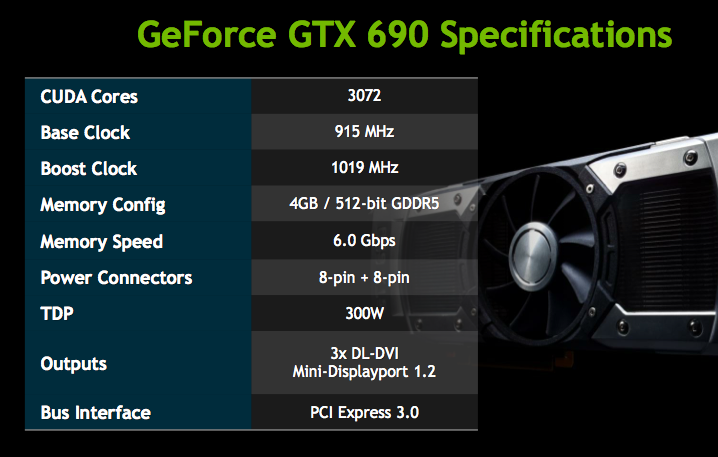

Прошло немногим больше месяца с момента выхода GeForce GTX 680, и вот NVIDIA представляет карту на архитектуре Kepler с двумя процессорами GK104. Подробный обзор этой архитектуры вы можете прочитать в статье про GTX 680. А если вкратце, Kepler представляет собой апгрейд архитектуры Fermi, которую NVIDIA использовала в сериях GeForce 400 и GeForce 500. В ядре произошел ряд оптимизаций, но главное изменение состоит в увеличении числа вычислительных блоков: в GK104 втрое больше ядер CUDA и вдвое больше текстурных модулей по сравнению с чипом GF110 (GeForce GTX 580). С другой стороны, GeForce GTX 680 в некоторых отношениях уступает GTX 580: шина памяти «сузилась» с 384 до 256 бит, количество ROP снизилось с 48 до 32, а планировщики потоковых мультипроцессоров перешли от динамического планирования к статическому, что существенно снизило производительность в неграфических вычислениях. GK104 производится по техпроцессу 28 нм, и умеренное (по сравнению с оным в ядре Tahiti из Radeon HD 7950/7970) число транзисторов позволило установить базовую тактовую частоту GPU 1006 МГц. Память в GTX 680 работает на эффективной тактовой частоте 6008 МГц. Кроме того, NVIDIA внедрила технологию динамического разгона GPU Boost, которая автоматически повышает частоту GPU в зависимости от энергопотребления и температуры. В дополнение к базовой частоте в спецификациях GTX 680 и 690 указана Boost Clock – средняя частота, которой достигает автоматический разгон в большинстве приложений. ⇡#Технические характеристикиGeForce GTX 680 по совокупности тестов опережает основного конкурента, Radeon HD 7970, хотя полный триумф и не состоялся. Но, что не менее важно, GTX 680 потребляет значительно меньше энергии и обходится двумя шестиконтактными разъемами дополнительного питания. Очевидно, что на базе GK104 должна получиться хорошая двухпроцессорная видеокарта. GTX 690 было проще сделать, чем GTX 590, еще и по той причине, что на одной плате легче развести две 256-битные шины памяти вместе с микросхемами, чем две 384-битные. В свое время, чтобы GTX 590 не взрывался в компьютере, NVIDIA пришлось пойти на существенный компромисс в спецификациях. Если GPU и память в GTX 580 работают на частотах 770 и 4004 МГц, то в GTX 590 частоты снижены до 607 и 3414 МГц соответственно. Более того, в GTX 590 заблокировано управление напряжением питания GPU. Правда, отдельные производители преодолели эти ограничения, и в результате появились такие монстры, как ASUS MARS II с трехслотовой системой охлаждения. На этот раз двухпроцессорная карта претендует на полноценную замену двух GeForce GTX 680. Да, базовая частота чипов уменьшена с 1006 до 915 МГц, но Boost Clock отличается не так сильно: 1058 и 1019 – разница меньше четырех процентов. Видеопамять работает на такой же частоте, 6008 МГц. GTX 690 потребляет гораздо меньше энергии, чем пара GeForce GTX 680: 300 Вт против 195 Вт х 2. При этом два восьмиконтактных разъема вместе с питанием от шины PCI-E устанавливают предел энергопотребления в 375 Вт.  Как и GTX 680, GTX 690 работает с шиной PCI-E 3.0. И более того, справляется с этим лучше, чем GTX 680. Последний официально может работать в режиме PCI-E 3.0 только в системах с процессорами Ivy Bridge, и наиболее досадным исключением стала платформа Sandy Bridge-E с чипсетом X79. Без «хакерских» манипуляций с реестром GTX 680 работает на ней только в режиме PCI-E 2.0. Неизвестно, устранят ли эту проблему в будущем, а вот GTX 690 уже сейчас поддерживает PCI-E 3.0 на X79 благодаря мосту PLX PEX8747, заместившему чип NF200, который использовался в этом качестве на плате GTX 590. Он может одновременно работать с PCI-E 2-й и 3-й версий. Независимо от платформы, графические процессоры всегда общаются между собой по PCI-E 3.0 GTX 690 позиционируется как эквивалент двух GTX 680 не только по производительности, но и по цене. Рекомендованная розничная стоимость составляет $999 (у GTX 680 – $499). Это самый дорогой референсный GeForce в истории. Мировые продажи GTX 690 уже начались, но в российской рознице его пока не видно. Что и не удивительно: фабрика TSMC еще не наладила производство GK104 в достаточном объеме, и подавляющая часть чипов идет на GTX 680. Более того, NVIDIA будет распространять карты GTX 690 лишь через нескольких партнеров. И логично предположить, что, когда они проникнут в Россию, розничные продавцы задерут цены гораздо выше рекомендованной тысячи баксов. ⇡#КонструкцияПредыдущие двухпроцессорные карты NVIDIA по дизайну мало отличались от остальной линейки. В этот раз из флагманской модели сделали предмет компьютерной роскоши. Кожух системы охлаждения почти целиком выполнен из металла. Оправа кулера – магниевый сплав, радиаторы GPU покрыты хромированными алюминиевыми пластинами с плексигласовыми окошками. Только узкие пластины на продольных гранях карты пластиковые. В длину GTX 690 на один дюйм больше, чем GTX 680, – 11 дюймов. На верхней грани красуется логотип GeForce, вырезанный лазером, да еще и в пластике с эффектом soft-touch. Он светится в темноте зеленым светом. Известно, что NVIDIA не разрешает партнерам клеить на корпус GTX 690 фирменные стикеры. Позволено только делать отметки на печатной плате. Дизайн системы охлаждения в целом повторяет то, что мы видели на GeForce GTX 590: графические процессоры охлаждаются двумя отдельными радиаторами с медной испарительной камерой. В центре находится крупный вентилятор, разгоняющий воздух по сторонам. Как следствие, часть «выхлопа» из видеокарты попадает внутрь корпуса компьютера. NVIDIA утверждает, что материал крыльчатки кулера и угол наклона лепестков подобраны таким образом, чтобы минимизировать шум. Микросхемы памяти и элементы питания платы охлаждаются с помощью массивной алюминиевой рамы. В отличие от GTX 590, на GTX 690 все навесные элементы платы уместились под рамой, нет никаких вырезов для высоких конденсаторов. От вентилятора к концам платы идут ребра, направляющие воздушный поток. Пластин на задней стороне платы нет. Порты на задней панели тоже расположены немного не так, как у GTX 590: один из выходов DVI больше не стоит в середине планки, преграждая путь воздушному потоку, а смещен в сторону. ⇡#ПлатаGTX 690 построен на 10-слойной плате. Все микросхемы памяти поместились на передней поверхности. Как и GeForce GTX 590, GTX 690 комплектуется микросхемами памяти Samsung (GTX 680 – Hynix). Номинальная частота такая же, как и у GTX 680: 6 ГГц, маркировка — K4G20325FD-FC03. Система питания платы включает пять фаз для каждого GPU. У GTX 680 только четыре фазы – еще одно неожиданное преимущество GTX 690. Питанием GPU управляют два контроллера ON Semiconductor NCP4206, доселе нам не встречавшиеся. Для памяти каждого GPU отведена одна фаза, управляется контроллером Anpec APL 3516C. Все конденсаторы на плате GTX 690 твердотельные (на GTX 680 имеются и стандартные «банки» с жидким электролитом). ⇡#Методика тестирования

В тестировании приняли участие следующие конфигурации:

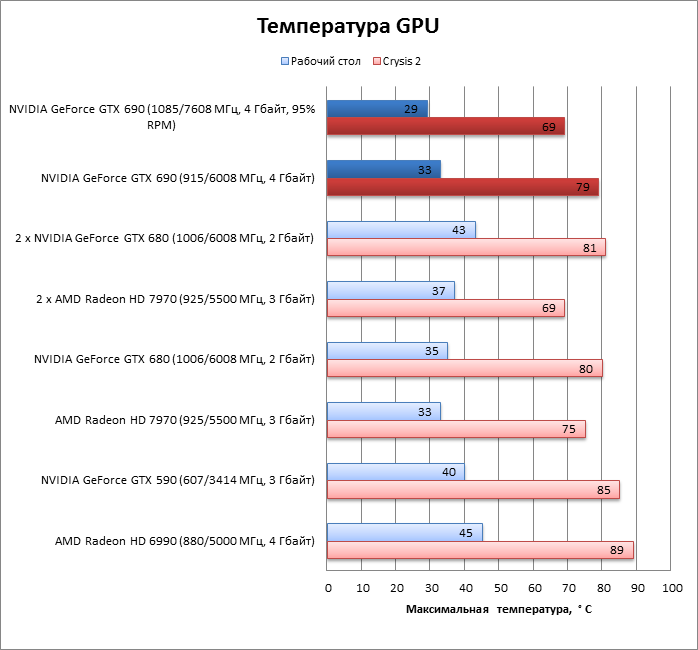

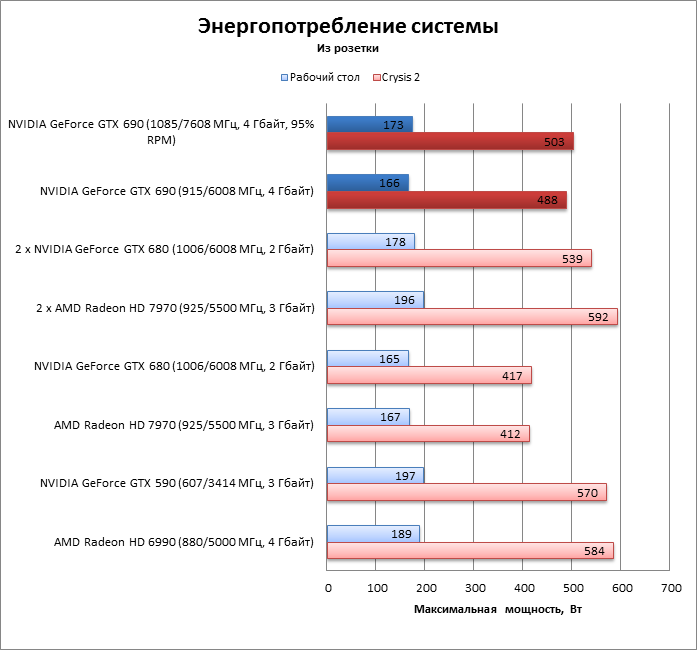

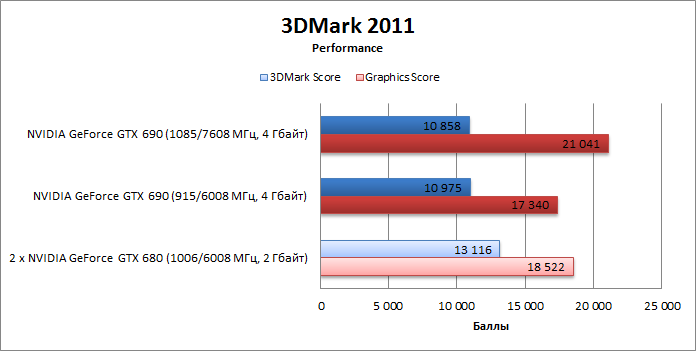

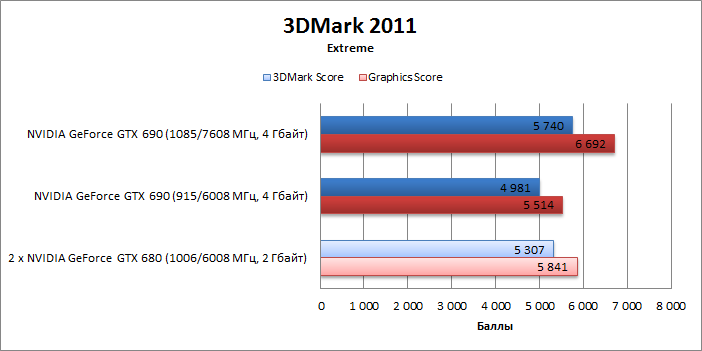

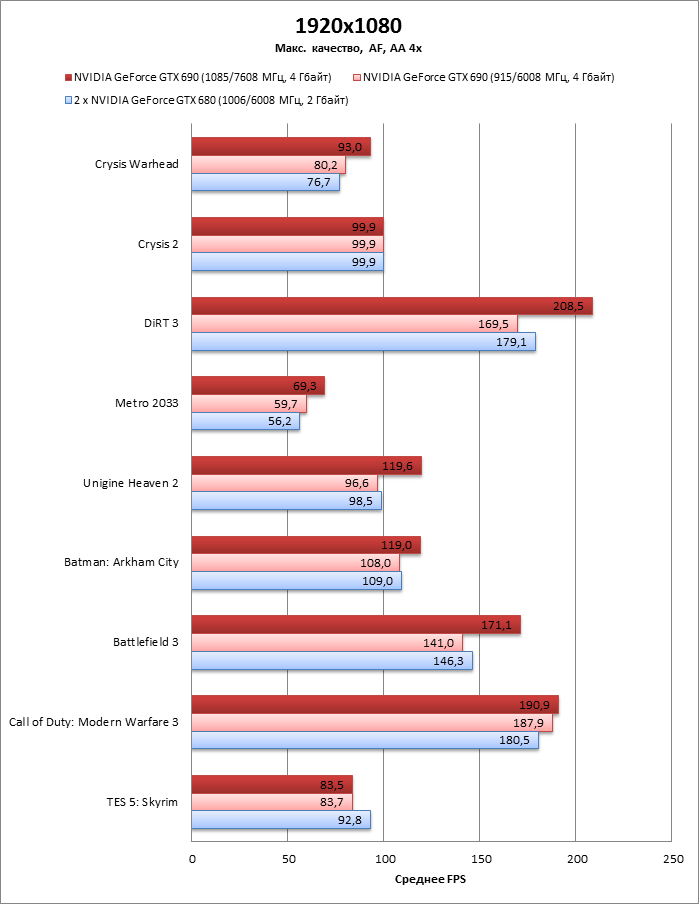

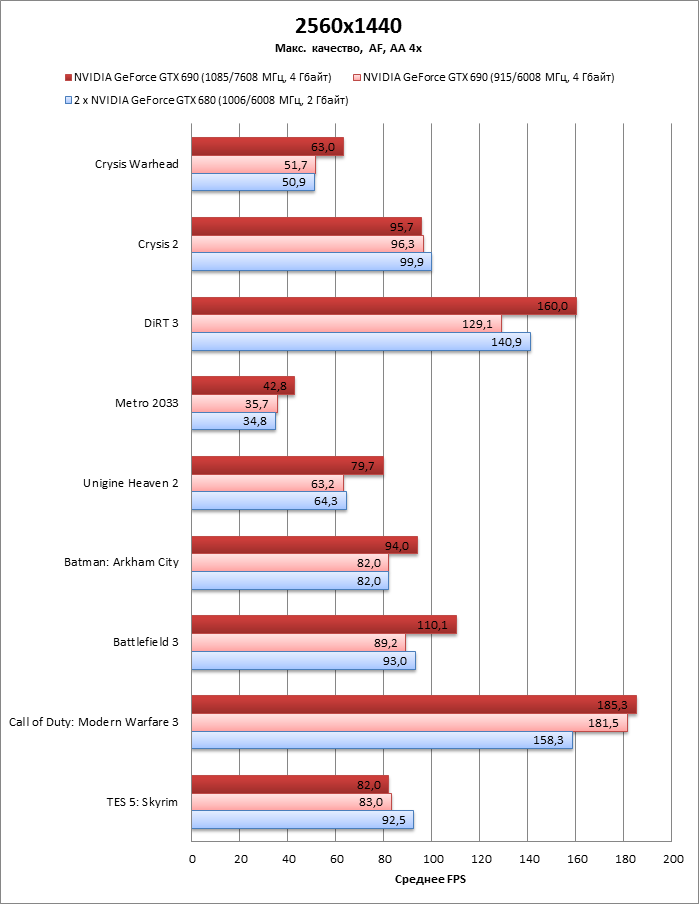

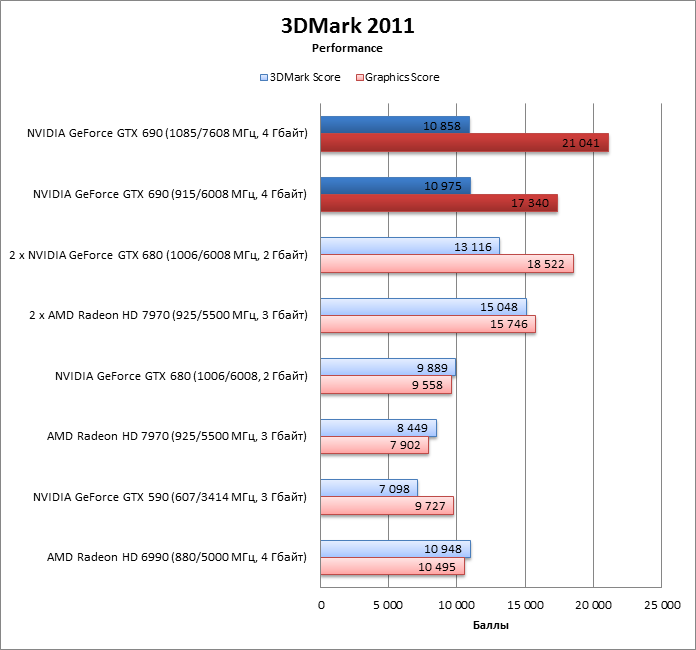

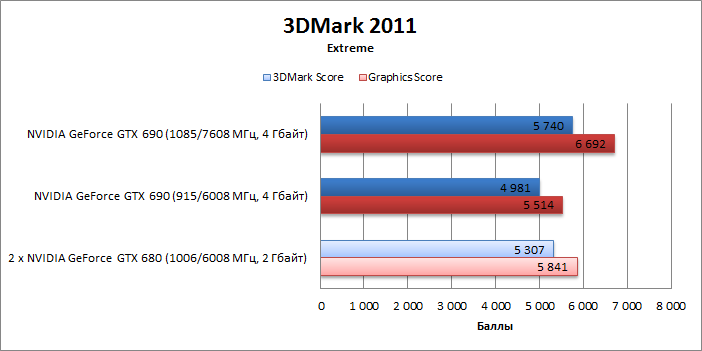

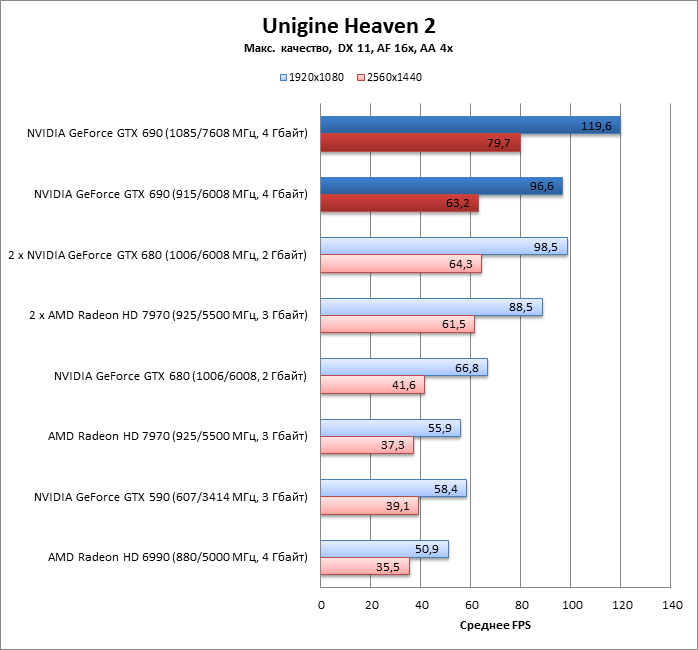

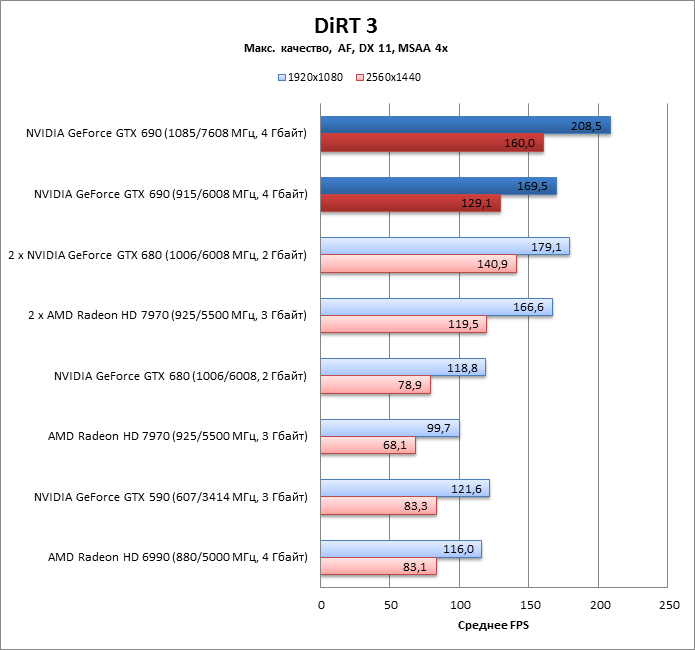

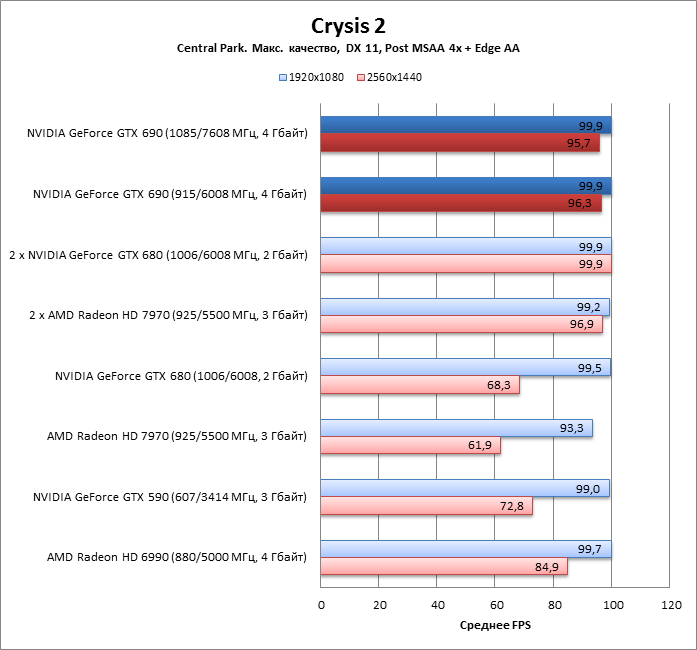

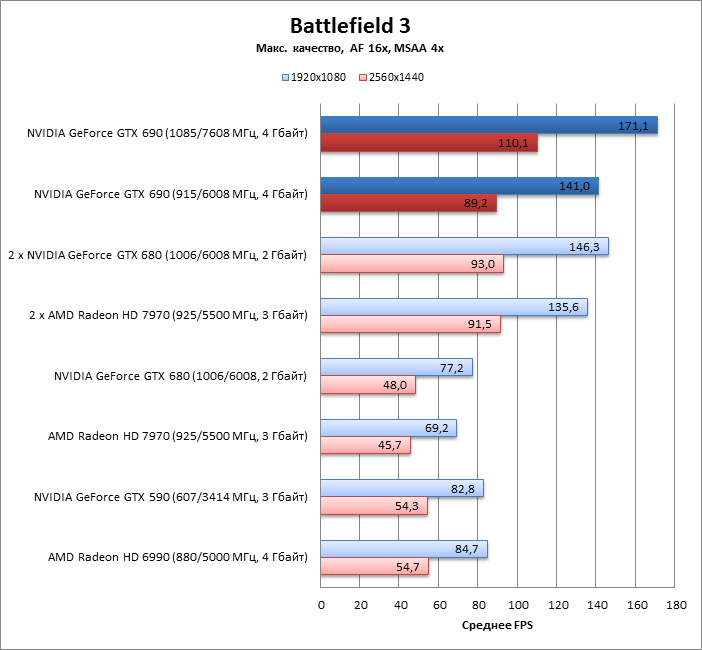

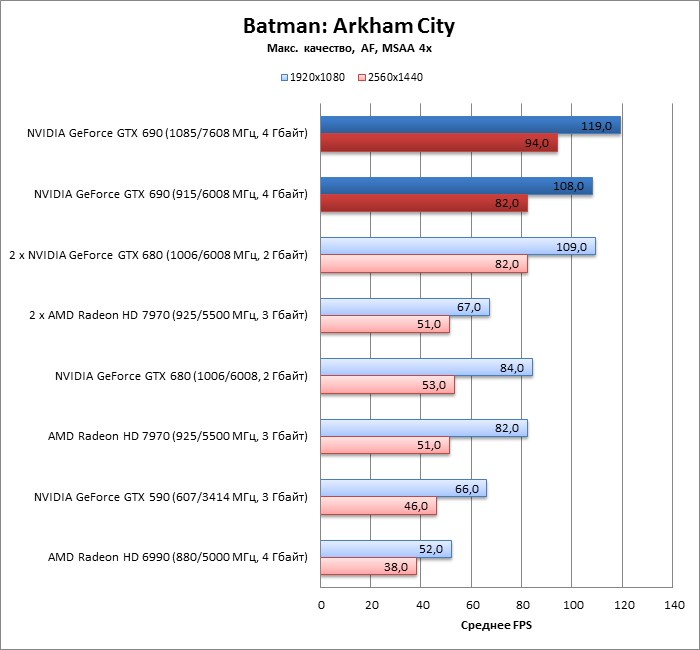

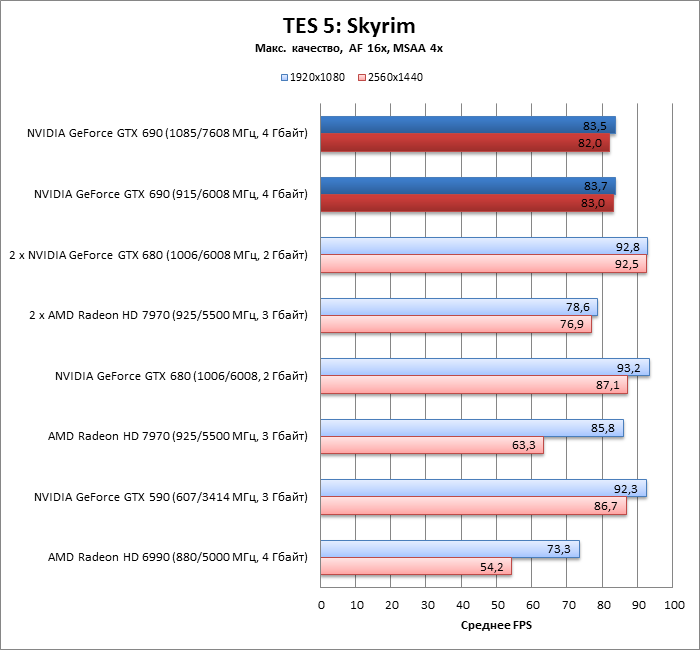

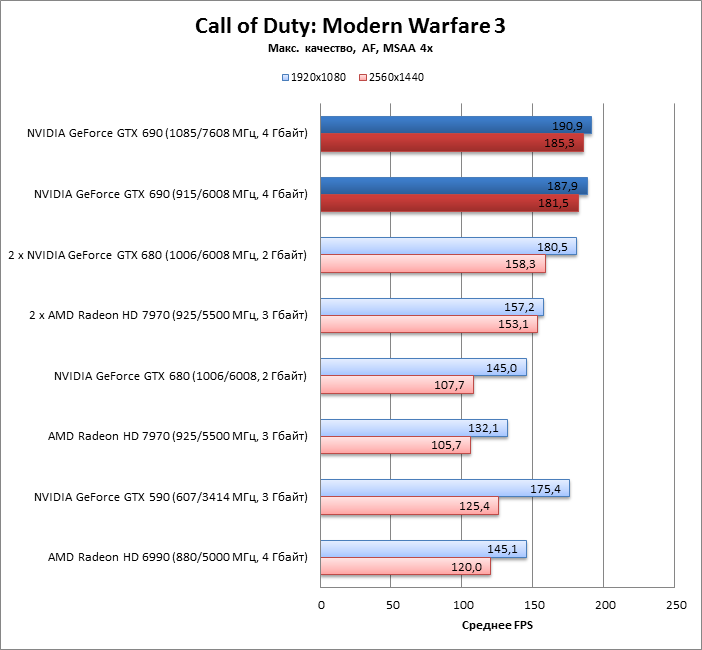

⇡#Разгон, температура, энергопотреблениеС появлением технологии GPU Boost разгон видеокарт на GPU NVIDIA выглядит по-другому. GPU Boost сама выполняет динамический разгон процессора, увеличивая частоту и напряжение питания, если есть резерв по энергопотреблению и температуре. У GeForce GTX 680 частота повышается с шагом 13 МГц с 1006 до 1110 МГц (девять состояний, включая базовую частоту), а напряжение – с 1,062 до 1,175 В. Видеокарта редко работает на базовой частоте даже в самых ресурсоемких играх. Так что часть работы за оверклокера уже выполнена заранее. Для того чтобы добиться большего, есть два пути. Во-первых, можно поднять лимит мощности карты (Power Target) вплоть до 132%. В таком случае GPU Boost будет работать агрессивнее, устанавливая более высокие рабочие частоты при равной нагрузке. Во-вторых, можно сделать прибавку к базовой частоте GPU, и тогда вся таблица частот, по которой работает GPU Boost, сдвинется вверх на столько же мегагерц. Напряжение питания вручную регулировать нельзя. Когда мы тестировали GTX 680, то списали этот недостаток на софт для оверклокинга, но теперь ясно, что NVIDIA просто заблокировала управление напряжением. То ли оно оказалось несовместимым с GPU Boost, то ли просто от греха подальше. Эксперименты с разгоном GTX 680 нас несколько разочаровали. Базовую частоту удалось увеличить лишь с 1006 до 1086 МГц. Хотя при этом резерва мощности карты и охлаждения на полных оборотах оказалось достаточно, чтобы GPU Boost по-прежнему использовал все девять шагов таблицы, увеличивая рабочую частоту вплоть до 1191 МГц. В результате прибавка к производительности от разгона была невелика. С GeForce GTX 690 ситуация немного другая. У него не только больший разрыв между Base Clock и Boost Clock по сравнению с GTX 680, но и более «длинная» таблица частот – 13 шагов, включая начальный. Автоматический разгон может увеличить частоту GPU уже не на 104, а максимум на 156 МГц, с 915 до 1071 МГц (но напряжение при этом больше 1,175 В все равно не повышается). В результате даже в штатном режиме GTX 690 может дотянуться до частот, сравнимых с оными у GTX 680, и при этом имеет возможность откатиться к более низкой базовой частоте при высоком энергопотреблении и температуре. Наблюдения за частотой во время бенчмарков показали, что в большинстве задач GTX 690 легко достигает максимальных частот в 1071 МГц на обоих GPU. В особо тяжелых тестах один из процессоров мог отступать на шаг ниже, до 1058 МГц. Базовую частоту процессоров GTX 690 с сохранением стабильной работы удалось поднять до точно такого же уровня, как у GTX 680, – 1085 МГц, что само по себе является большим достижением для «двухголовой» карты. Но самое удивительное — GPU Boost по-прежнему использовал верхние шаги таблицы, временами повышая рабочую частоту обоих GPU аж до 1241 МГц! GTX 680 в разгоне достигал только 1191 МГц. На этом, однако, сюрпризы не закончились. Память на GTX 680 нам удалось разогнать до 1732 (6928) МГц, немного недобрав до рекордной эффективной частоты в 7 ГГц. Но GTX 690 намного превзошел этот рекорд: 1902 (7608) МГц! Это, видимо, заслуга чипов Samsung. У GTX 690 есть еще пара мелких улучшений по сравнению с GTX 680: возможность увеличить лимит мощности уже не на 32, а на 35%, а обороты кулера – не до 85, а до 95%. В результате процессоры разогнанной карты под нагрузкой нагреваются на 10 °C меньше, чем в штатном режиме. Шум вентилятора при этом сильный, но терпимый. Что более интересно, рабочие температуры у GTX 680 и GTX 690 практически совпадают. Процессор Radeon HD 7970 под нагрузкой имеет меньшую температуру. А обе «двухголовые» карты предыдущего поколения, GTX 590 и Radeon HD 6990, греются сильнее.  По энергопотреблению GTX 690 также выглядит привлекательнее, чем две GTX 680: пиковая мощность систем различается на 15 Вт. Пара Radeon HD 7970 еще более прожорлива, чем в GTX 580 SLI: разница с GTX 690 составляет 104 Вт! GTX 590 и HD 6990 по энергопотреблению тоже приближаются к двум HD 7970. Также примечательно, что в 2D-режиме GTX 690 потребляет энергии не больше, чем GTX 680.  В общем, по части разгона и «физики» мы в восторге от GTX 690. Не хватает, пожалуй, только функции отключения второго GPU в простое, как это сделано у AMD. В таком случае энергопотребление удалось бы снизить еще сильнее. GeForce GTX 690 против GeForce GTX 680 SLI Главное, что нас интересует в производительности GTX 690, – как он соотносится с парой GTX 680 в SLI-конфигурации. 3DMark 2011 По результатам 3DMark, разница в пользу двух GTX 680 все-таки есть.   Игровые тесты + Unigine Heaven А в большинстве игровых тестов GTX 690 практически не уступает SLI-системе. Заметное преимущество последняя имеет только в DiRT 3. Более того, GTX 690 даже оказался существенно быстрее в одной из игр – Call of Duty: MW3. Оверклокинг GTX 690 оказывает гораздо больший эффект, чем в случае c GTX 680. Да, в CoD: MW3 и Skyrim практически нет прибавки к частоте смены кадров, но во всех остальных играх прирост производительности зачастую не просто большой, а колоссальный. Агрессивная работа GPU Boost и невероятный разгон памяти показали себя во всей красе. Да, частота смены кадров в Crysis 2 у всех карт прилипла к отметке 100 FPS, потому что игра устанавливает такое ограничение. В этом случае мы можем лишь утверждать, что обе конфигурации обеспечивают в Crysis 2 не меньше 100 FPS даже в разрешении 2560х1440.   GeForce GTX 690 против Radeon HD 7970 CrossFireX, синтетические тесты А теперь сравним GTX 690 с самым главным соперником – парой Radeon HD 7970 в режиме CrossFireX, а также с однопроцессорными картами. Посмотрим, насколько хорошо работают SLI и CrossFireX в наших бенчмарках. 3DMark 2011

Unigine Heaven 2

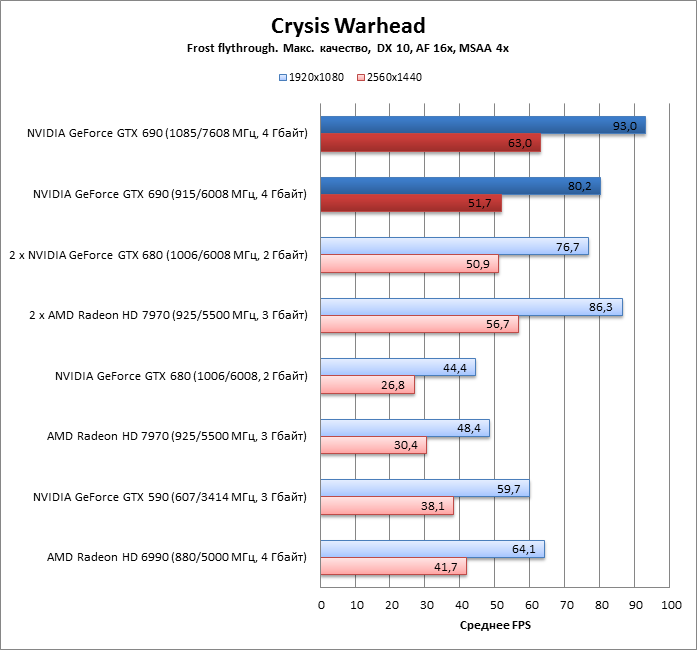

GeForce GTX 690 против Radeon HD 7970 CrossFireX, игровые тесты Crysis Warhead (DirectX 10)

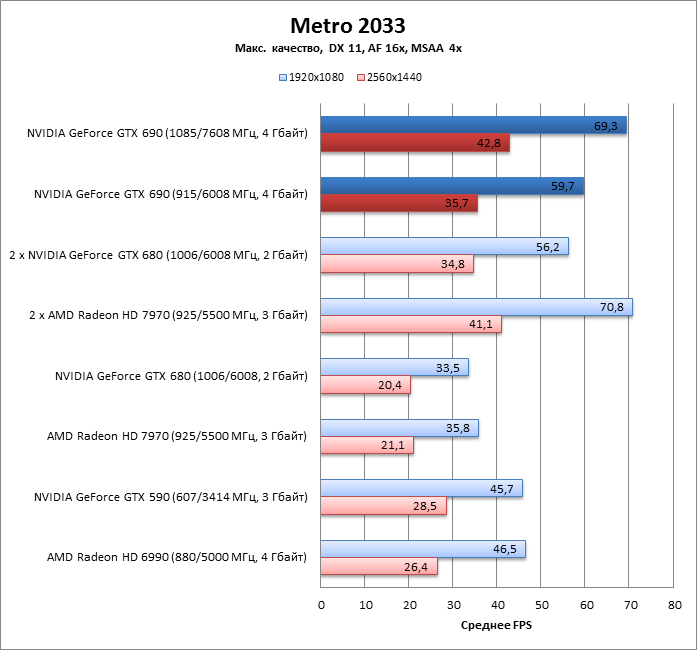

Metro 2033 (DirectX 11)

DiRT 3 (DirectX 11)

Crysis 2 (DirectX 11)

Battlefield 3 (DirectX 11)

Batman: Arkham City (DirectX 11)

The Elder Scrolls 5: Skyrim (DirectX 9)

Call of Duty: Modern Warfare 3 (DirectX 9)

Выводы NVIDIA действительно сделала двухпроцессорную видеокарту, которая с успехом заменяет два GeForce GTX 680. Если нужно собрать SLI-конфигурацию, то решительно нет причин покупать отдельные карты. GTX 690 практически не уступает двум GTX 680 по производительности, а энергии потребляет гораздо меньше. Но что самое удивительное, процессоры GTX 690 еще и нагреваются не больше, чем в GTX 680, при этом обладают точно таким же разгонным потенциалом. Более того, разгон GTX 690 более эффективен, потому что GPU Boost имеет больший частотный потолок. Видеопамять так и вовсе разгоняется до эффективной частоты гораздо выше 7 ГГц. Вот уж чего не привыкли ожидать от двухпроцессорных карт, так это превосходства над однопроцессорными в оверклокинге. Кроме того, для настоящих, так сказать, энтузиастов появилась возможность объединить две GTX 690 в системе Quad-SLI. Пара Radeon HD 7970 в режиме CrossFireX – серьезный конкурент для GeForce GTX 690, но в большинстве игр, которые мы используем как бенчмарки, либо наблюдается паритет двух конфигураций, либо NVIDIA побеждает. Radeon HD 7970 имеет больший потенциал для разгона и в соревновании с разогнанным GTX 690 может взять реванш, но энергопотребление такой системы даже без разгона весьма велико: по прожорливости связка «Радеонов» значительно превосходит GeForce GTX 690. Посмотрим, удастся ли AMD сделать столь же совершенную двухпроцессорную карту на базе чипов Tahiti.

⇣ Содержание

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||