Высокий спрос на передовые серверы для систем искусственного интеллекта со стороны крупных поставщиков облачных услуг и их клиентов сохранится до конца 2024 года, уверены аналитики TrendForce. Расширение производства TSMC, SK hynix, Samsung и Micron значительно сократило дефицит во II квартале 2024 года — срок выполнения заказа на флагманские ИИ-ускорители Nvidia H100 сократился с прежних 40–50 до менее чем 16 недель.

Источник изображения: nvidia.com

Объём поставок ИИ-серверов по итогам II квартала увеличился почти на 20 % по сравнению с предшествующим кварталом, гласит предварительная оценка TrendForce — годовой прогноз поставок был пересмотрен до значения 1,67 млн единиц, что соответствует росту на 41,5 % год к году. Крупные облачные провайдеры в этом году направляют свои бюджеты на закупку ИИ-серверов в ущерб темпам роста поставок обычных серверов — он составит всего 1,9 %. Ожидается, что доля ИИ-серверов в общем объёме поставок достигнет 12,5 %, что примерно на 3,4 п.п. выше, чем в 2023 году.

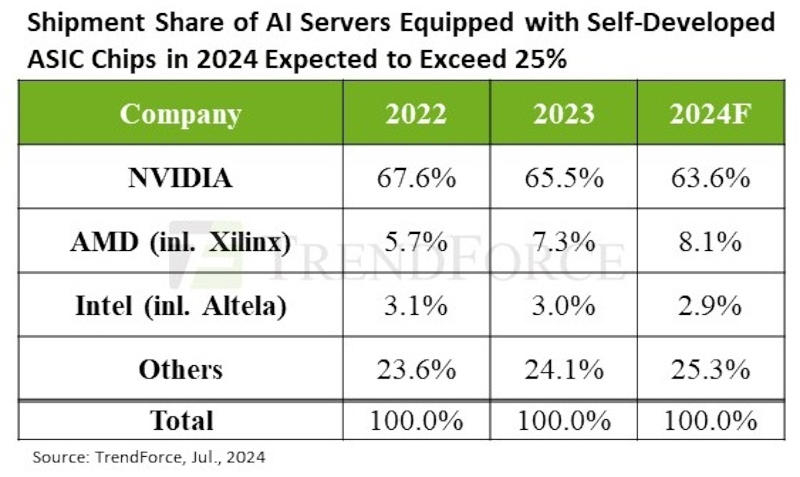

С точки зрения рыночной стоимости ИИ-серверы вносят больший вклад в рост выручки, чем обычные серверы. По итогам 2024 года рыночная стоимость ИИ-серверов превысит $187 млрд при темпе роста 69 %, что составит 65 % от общей стоимости серверов, гласит прогноз TrendForce. Собственные ASIC-решения активно расширяют как североамериканские операторы AWS и Meta✴, так и китайские гиганты в лице Alibaba, Baidu и Huawei. Как ожидается, по итогам 2024 года доля ASIC-серверов составит до 26 % от общего серверного рынка, тогда как на ИИ-серверы с массовыми GPU придутся около 71 %.

Источник изображения: trendforce.com

Nvidia удержит крупнейшую долю около 90 % на рынке поставщиков ИИ-чипов для ИИ-серверов; доля рынка AMD будет всего около 8 %. Но если включить все чипы ИИ, используемые в ИИ-серверах (GPU, ASIC, FPGA), доля рынка Nvidia по итогам года составит около 64 %. Спрос на передовые ИИ-серверы, считают аналитики TrendForce, останется высоким на протяжении всего 2025 года, особенно с учётом того, что на смену Nvidia Hopper придёт новое поколение ИИ-ускорителей Blackwell (GB200, B100/B200). Из-за этого вырастет спрос на упаковку чипов TSMC CoWoS и память HBM: на ускорителе Nvidia B100 размер чипа вдвое больше. Производственная мощность TSMC CoWoS к концу 2025 года достигнет 550–600 тыс. единиц при темпах роста около 80 %. Массовый Nvidia H100 в 2024 году будет оснащаться 80 Гбайт HMB3; к 2025 году чипы Nvidia Blackwell Ultra и AMD MI350 получат до 288 Гбайт HBM3e, утроив расход компонентов памяти. Ожидается, что общее предложение HBM к 2025 году удвоится из-за высокого спроса на рынке ИИ-серверов.

Источник:

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018