|

Опрос

|

реклама

Быстрый переход

Topaz Labs представила диффузную ИИ-модель, которая автоматически улучшает старые видео

07.02.2025 [18:32],

Владимир Мироненко

Компания Topaz Labs, специализирующая на разработке программного обеспечения для редактирования фотографий и видео, представила модель ИИ Project Starlight для повышения качества старых кадров из домашней видеоколлекции или архивного контента, качество которого могло со временем ухудшиться в ходе хранения на традиционных носителях.

Источник изображения: Topaz Labs По словам разработчика, это первая в истории диффузионная модель, созданная для этих целей, и ей не требуется ручной ввод данных для исправления видео. Сообщается, что Project Starlight была создана с нуля с использованием новой архитектуры модели с более чем 6 млрд параметров, и её работа поддерживается передовыми ускорителями NVIDIA. Для сравнения, вышедшая в мае 2024 года большая языковая модель GPT-4o от OpenAI с возможностью обработки текста, аудио, изображений и видео в качестве входных данных, изначально имела 8 млрд параметров. Topaz Labs утверждает, что модель «точно восстанавливает детали» и обеспечивает «непревзойдённое восстановление деталей в сочетании с непревзойдённой временной согласованностью». По словам компании, именно в этом и заключается суть её новой модели: улучшение нескольких кадров для достижения высококачественных результатов восстановления без артефактов движения или несоответствий между кадрами и объектами. Project Starlight также автоматически удаляет шумы, устраняет размытость, масштабирует и сглаживает кадры по запросу. Для работы с этой ИИ-моделью вовсе не требуется наличие специальных знаний в области обработки видео. Возвращение старого видео к жизни включает в себя несколько процессов, в том числе масштабирование, цветокоррекцию и сортировку, интерполяцию кадров, устранение повреждений и восстановление звука. Для каждого из этих вариантов восстановления уже созданы инструменты на базе ИИ, но для достижения наилучших результатов всем процессом в настоящее время должны управлять люди. Topaz Labs сообщила, что пользователи могут с помощью её ИИ-модели бесплатно восстанавливать видео длительностью до 10 с, в то время как клипы продолжительностью до 5 минут будут иметь максимальное разрешение 1080p и для этого потребуются кредиты. Версия для корпоративных пользователей поддерживает восстановление более продолжительных видео и с более высоким разрешением. Пока неизвестно, будет ли Project Starlight работать локально или будет интегрирована в другие приложения компании. Главный европейский конкурент OpenAI выпустил ИИ-ассистента Mistral Le Chat для iOS и Android

07.02.2025 [08:34],

Анжелла Марина

Французский стартап Mistral объявил о крупном обновлении своего ИИ-ассистента Le Chat. В борьбе за внимание пользователей разработчики не только значительно улучшили веб-интерфейс, добавили веб-поиск и генерацию изображений по текстовым запросам, но и только что выпустили мобильное приложение для устройств iOS и Android.

Источник изображения: Copilot Одним из ключевых преимуществ Le Chat является скорость работы. Компания утверждает, что использует «самые быстрые на планете алгоритмы принятия решений» и её чат-бот может обрабатывать до 1000 слов в секунду. Кроме того, как пишет TechCrunch, Mistral заявляет о превосходном качестве генерируемых изображений благодаря использованию модели Flux Ultra, разработанной немецкой компанией Black Forest Labs. Разрабатывая собственные большие языковые модели (LLM), Mistral активно выпускает модели с открытым исходным кодом под лицензией Apache 2.0, а также предлагает коммерческое использование своих флагманских версий ИИ, таких как Mistral Large и Pixtral Large, через API или облачных партнёров, включая Azure AI Studio, Amazon Bedrock и Google Vertex AI. Что касается мобильного приложения, то его выпуск является стратегическим для компании шагом, направленным на повышение доступности и удобства использования ИИ-бота, которому можно задавать вопросы и получать ответы в формате интерактивного общения в чате. Отмечается, что за последние месяцы Le Chat претерпел значительные улучшения, превратившись в «компетентного ИИ-помощника». Недавно была добавлена поддержка веб-поиска с указанием источников, а также возможность генерировать изображения и взаимодействовать с платформой для редактирования текста или кода. Стоит также сказать, что компания подписала соглашение с Agence France-Presse (AFP), чтобы обеспечить надёжность и достоверность информации, предоставляемой её ИИ-моделями. Для пользователей, которым требуется больше возможностей, Mistral предлагает Pro-подписку на Le Chat стоимостью $15 в месяц. Pro-подписчики получают доступ к самой производительной модели, повышенные лимиты и улучшенную конфиденциальность. Помимо потребительского сегмента, компания активно развивает корпоративные услуги, с возможностью развёртывания Le Chat в локальной среде с использованием пользовательских моделей (ИИ-агентов) и интерфейсов. Это особенно важно для организаций, работающих в сфере обороны или финансов, где требуется повышенный уровень безопасности и контроля над данными, что, по словам Mistral, «не представляется возможным в настоящее время с ChatGPT Enterprise или Claude Enterprise». Amazon потратит в этом году на развитие вычислительной инфраструктуры $100 млрд — больше Google и Microsoft

07.02.2025 [08:32],

Алексей Разин

Интернет-гигант Amazon оказался последним среди крупнейших игроков рынка облачных вычислений, выступивших в этом квартале с отчётами за предыдущий. Капитальные затраты компании в этом году планируется увеличить с $83 до $100 млрд, тем самым обойдя конкурентов в лице Microsoft, Google и Meta✴✴ Platforms.

Источник изображения: Amazon Напомним, последняя собирается в текущем году на развитие своей инфраструктуры потратить от $60 до $65 млрд, холдинг Alphabet (Google) выделил $75 млрд, а являющаяся главным акционером OpenAI корпорация Microsoft расщедрилась на $80 млрд. Как видим, AWS готова возглавить этот рейтинг с большим отрывом. По словам генерального директора Энди Джесси (Andy Jassy), основная часть капитальных затрат Amazon в текущем году будет направлена на развитие инфраструктуры ИИ подразделения AWS. Глава Amazon попытался убедить инвесторов, что увеличение капитальных затрат стоит того, назвав текущий момент «бизнес-возможностью, которая даётся раз в жизни». Подобное решение отвечает интересам как бизнеса, так и клиентов Amazon, равно как и акционеров компании, по словам её руководителя. Некоторая часть капитальных затрат всё же будет направлена на развитие торгового бизнеса, чтобы увеличить скорость доставки и снизить стоимость обслуживания клиентов. Сооснователь OpenAI Джон Шульман не проработал в Anthropic и полугода

07.02.2025 [06:40],

Алексей Разин

Бурное развитие систем искусственного интеллекта происходило в последние пару лет при непосредственном участии американского стартапа OpenAI, создавшего нашумевший ChatGPT, но его кадровый состав успел изрядно измениться. В конкурирующую Anthropic менее полугода назад перешёл работать один из основателей первой из компаний Джон Шульман (John Schulman), но долго там не продержался.

Источник изображения: сайт Джона Шульмана В коллектив Anthropic один из главных разработчиков ChatGPT влился в августе прошлого года. Своё решение он тогда обосновал стремлением больше времени уделять регулированию работы искусственного интеллекта и сосредоточиться на технической части подобной деятельности. По его словам, работа в Anthropic позволяла ему развиваться в окружении единомышленников и заниматься теми вещами, которые ему были наиболее интересны. Непосредственно Шульман о своём уходе из Anthropic официально ничего не сообщил, как и не обозначил своих дальнейших намерений. Представители Anthropic в комментариях Bloomberg подтвердили уход Джона Шульмана из компании и выразили своё сожаление по этому поводу, хотя и поддержали стремление бывшего коллеги искать новые возможности для самореализации. Стремительно развивающийся рынок систем искусственного интеллекта даёт неплохие карьерные перспективы тем, кто уже успел себя зарекомендовать в качестве ценного специалиста или руководителя. Google начнёт помечать фотографии пользователей, в которые «вмешался» ИИ

07.02.2025 [05:11],

Анжелла Марина

Приложение «Google Фото» начнёт использовать цифровые водяные знаки SynthID для фотографий, отредактированных с помощью генеративного искусственного интеллекта (ИИ). По заявлению Google, новая функция предназначена для облегчения идентификации изображений, которые были изменены с помощью инструмента Reimagine в Magic Editor.

Источник изображений: Google Magic Editor позволяет легко редактировать фотографии через текстовые запросы, добавляя или удаляя различные детали. Хотя сами по себе ИИ-инструменты не представляют угрозы, Magic Editor может создавать неправомерные компиляции, например разбившиеся вертолёты, сцены аварий, причём без явных меток, указывающих на то, что изображение было изменено. Водяные знаки призваны решить эту проблему. Однако SynthID визуально не изменяет изображение и чтобы понять, что оно было отредактировано ИИ, придётся дополнительно использовать функцию проверки «Об изображении». Более того, Google признаёт, что некоторые небольшие изменения, выполненные через Magic Editor, могут быть настолько незначительными, что SynthID не сможет идентифицировать эти изменения и применить маркировку. Эксперты отмечают, что хотя водяные знаки могут помочь в идентификации компиляций, этой технологии недостаточно для масштабной проверки контента, созданного нейросетями. Для надёжности потребуется использовать целый комплекс подходов и программных средств. Отметим, что система водяных знаков используется в нейросети Google Imagen AI, которая генерирует изображения на основе текста. Аналогичные инструменты были разработаны и другими компаниями, например, функция Content Credentials компании Adobe защищает от несанкционированного доступа к метаданным и позволяет авторам добавлять информацию о себе. Технология SynthID была разработана командой DeepMind и представляет собой цифровой метатег, встроенный в изображения, видео, аудио или текст. Этот тег позволяет идентифицировать, были ли файлы созданы или изменены с помощью ИИ. Исследователи обучили конкурента OpenAI o1 менее чем за полчаса и $50

07.02.2025 [05:06],

Анжелла Марина

Исследователи из Стэнфорда и Университета Вашингтона создали ИИ-модель, которая превосходит OpenAI в решении математических задач. Модель, получившая название s1, была обучена на ограниченном наборе данных из 1000 вопросов методом дистилляции. Это позволило достичь высокой эффективности при минимальных ресурсах и доказать, что крупным компаниям, таким как OpenAI, Microsoft, Meta✴✴ и Google, возможно не придётся строить огромные дата-центры, заполняя их тысячами графических процессоров Nvidia.

Источник изображения: Growtika / Unsplash Метод дистилляции, который применили учёные, стал ключевым решением в эксперименте. Этот подход позволяет небольшим моделям обучаться на ответах, предоставленных более крупными ИИ-моделями. В данном случае, как пишет The Verge, s1 быстро улучшала свои способности, используя ответы, полученные от модели искусственного интеллекта Gemini 2.0 Flash Thinking Experimental, разработанной компанией Google. Модель s1 была создана на основе проекта Qwen2.5 от Alibaba (подразделение Cloud) с открытым исходным кодом. Первоначально исследователи использовали набор данных из 59 000 вопросов, но в ходе экспериментов пришли к выводу, что увеличение объёма данных не даёт значимых улучшений, и для финального обучения использовали лишь небольшой набор из 1000 вопросов. При этом было использовано всего 16 GPU Nvidia H100 в облаке, за использование которых пришлось заплатить менее $50. В s1 была также применена техника под названием «масштабирование времени тестирования», которая позволяет модели «поразмышлять» перед генерацией ответа. Также исследователи стимулировали модель к перепроверке своих выводов путём добавления команды в виде слова «Wait» («Жди»), что заставляло ИИ продолжать рассуждение и исправлять ошибки в своих ответах. Утверждается, что модель s1 показала впечатляющие результаты и смогла превзойти OpenAI o1-preview на 27 % при решении математических задач. Недавно нашумевшая модель R1 от DeepSeek также использовала аналогичный подход и за сравнительно небольшие деньги. Правда, теперь OpenAI обвиняет DeepSeek в извлечении информации из своих моделей в нарушение условий обслуживания. Стоит сказать, что и в условиях использования Google Gemini указано, что её API запрещено применять для создания конкурирующих чат-ботов. Рост количества меньших и более дешёвых моделей может, по словам экспертов, перевернуть всю отрасль и доказать, что нет необходимости инвестировать миллиарды долларов на обучение ИИ, строить огромные центры обработки данных и закупать в большом количестве GPU. Представлен робот iDEAR для быстрого извлечения из компьютера всех ценных компонентов

06.02.2025 [18:57],

Сергей Сурабекянц

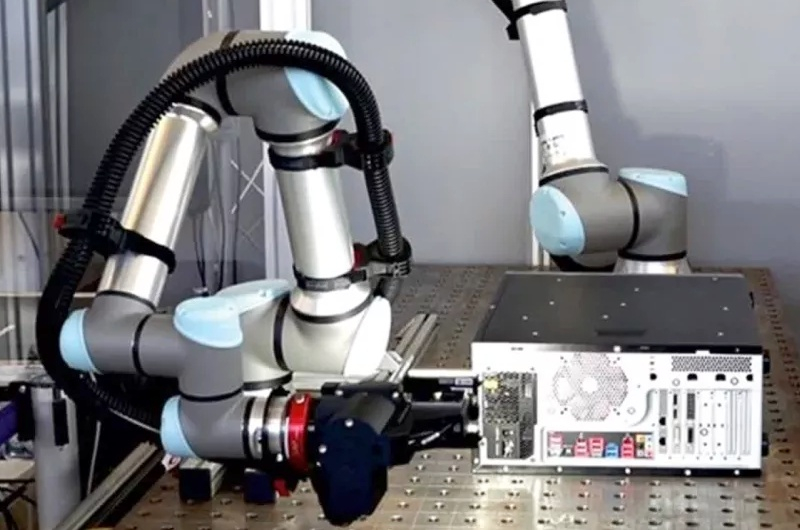

Электронные устройства устаревают с пугающей скоростью, и проблема их утилизации становится все более актуальной. К 2030 году мировое производство электронных отходов достигнет 82 миллионов тонн в год, а нынешнее состояние их переработки очень далеко от идеального. Для исправления ситуации немецкие исследователи из института Фраунгофера разработали автоматизированную систему интеллектуальной разборки электроники iDEAR на основе ИИ.

Источник изображений: techspot.com Проблему электронных отходов трудно переоценить. Только Евросоюз произвёл около пяти миллионов тонн электронных отходов в 2022 году. США генерируют от 6,9 до 7,6 миллионов тонн электронных отходов ежегодно, что составляет около 21 кг на человека в год. По прогнозам, к 2030 году мировое производство электронных отходов увеличится до 74,7–82 миллионов тонн. Нынешнее состояние переработки электронных отходов далеко от идеального. Производственные процессы в электронной промышленности ставят во главу угла экономическую эффективность, что приводит к выпуску устройств, которые плохо поддаются переработке в конце своего жизненного цикла. Традиционные методы часто подразумевают ручную разборку, которая является дорогостоящей и неэффективной. А многие устройства в конечном итоге просто измельчаются, что ограничивает возможность извлечения ценных компонентов. Для решения проблемы переработки и утилизации электроники исследователи из института Фраунгофера в Магдебурге, Германия, разработали iDEAR (Intelligent Disassembly of Electronics for Remanufacturing and Recycling — интеллектуальная разборка электроники для восстановления и переработки). iDEAR кардинально повышает эффективность переработки электронных отходов и потенциально обеспечивает извлечение многих видов ценного сырья. На сегодняшний день iDEAR уже успешно справляется с извлечением материнских плат из корпусов ПК.  Процесс интеллектуальной разборки iDEAR начинается с этапа идентификации и диагностики. 3D-камеры и оптические сенсорные системы на базе ИИ сканируют электронные отходы, собирая информацию о производителе, типе продукта и его серийном номере. Происходит обнаружение и сканирование этикеток и других надписей. Одновременно оценивается состояние компонентов и соединительных элементов, таких как винты и заклёпки. Алгоритмы машинного обучения в режиме реального времени идентифицируют и классифицируют состав устройства. iDEAR без проблем справляется с определением потайного и заржавевшего крепежа. Ключевым нововведением в проекте iDEAR является создание цифрового «двойника разборки» для каждого продукта, включая информацию о его компонентах и любой предыдущей операции с ним. После тщательного анализа устройства система определяет последовательности разборки с помощью специализированного ПО. Принимается решение, следует ли производить полную или частичную разборку, причём приоритет отдаётся извлечению ценных компонентов. Затем робот получает сгенерированную последовательность инструкций, включая откручивание винтов, вскрытие корпусов и извлечение компонентов. Хотя в настоящее время проект iDEAR сосредоточен на переработке ПК, у исследователей амбициозные планы на будущее. Они работают над универсальной системой, которая сможет самостоятельно адаптироваться к широкому спектру электронных устройств — от микроволновых печей до крупных бытовых приборов — с минимальными инженерными усилиями. Российские специалисты из Smart Engines расшифровали рукописи Пушкина при помощи ИИ

06.02.2025 [17:59],

Сергей Сурабекянц

Специалисты российской компании Smart Engines расшифровали зачёркнутые фрагменты черновых рукописей Александра Пушкина с помощью разработанной ими системы искусственного интеллекта «Да Винчи». Нейросетевая архитектура «Да Винчи» широко используется для распознавания документов, в частности российских паспортов, вне зависимости от угла и условий съёмки.

Источник изображения: Wikipedia, «Литературные места России» В процессе обучения ИИ запомнил, какие движения пера в незачёркнутых словах характерны для почерка великого русского поэта, а затем восстановил утраченные места, пользуясь созданной моделью движений его руки. Таким способом удалось идентифицировать несколько неопределяемых ранее слов из черновых рукописей Пушкина. Эти находки внесли существенный вклад в понимание творческого процесса поэта. Узнать, какие слова пришлись Пушкину не по душе, удалось с помощью нейросетевой архитектуры «Да Винчи», разработанной специалистами Smart Engines для удаления линий разграфки, затрудняющих распознавание рукописных данных в официальных документах. Эта технология позволяет автоматически определять геометрию документа и распознавать данные вне зависимости от его расположения в кадре, наличия помех и искажений. Технология одинаково успешно справляется как со сканами, так и с фотографиями документов, в том числе в зеркальном отражении. Алгоритмы Smart Engines уже интегрированы в решения для мгновенного распознавания данных паспорта и других документов. Распознавание паспорта РФ при помощи камеры смартфона требует всего 0,15 секунды. Серверные решения позволяют распознавать до 55 паспортов в секунду на процессор без использования GPU. «Проведённый нами эксперимент по расшифровке ранее нечитаемых слов в рукописях Александра Пушкина подтвердил колоссальный потенциал нейросетей в самых разных областях науки. Мы видим, что искусственный интеллект может стать надёжным инструментом для исследователя […] Предложенный метод снятия зачёркиваний при помощи ИИ может быть применён не только к рукописям Пушкина, но и к архивным записям других известных авторов, а также историческим документам. Это открывает новые возможности для изучения творческого процесса написания знаменитых литературных произведений», — уверен генеральный директор Smart Engines Владимир Арлазаров. Остаётся неясным лишь одно: если великий русский поэт какие-то слова зачёркивал, возможно, он не хотел, чтобы кто-нибудь их прочитал, в том числе и искусственный интеллект? DeepSeek не справилась с популярностью — доступ к ИИ-моделям теперь ограничен

06.02.2025 [17:30],

Владимир Мироненко

Китайский стартап DeepSeek, вызвавший шок в Кремниевой долине своей моделью ИИ R1, способной к рассуждениям, из-за достижения высокого результата с использованием гораздо меньших ресурсов и средств, объявил об ограничении доступа к своему сервису API из-за нехватки серверных мощностей, пишет Bloomberg.

Источник изображения: Solen Feyissa/unsplash.com На веб-сайте DeepSeek сообщается о приостановке возможности клиентов пополнять свои API-кредиты, чтобы избежать негативных последствий для сервисов компании. Все существующие сохранённые значения не будут затронуты, добавила DeepSeek. «Текущая сумма пополнения может продолжать использоваться, просим вашего понимания!» — заявила компания. Также DeepSeek, чьи крайне низкие тарифы встревожили некоторых конкурентов, указала в сообщении, что скидки на доступ к её ИИ-модели прекратятся 8 февраля. Далее доступ к чат-боту на основе ИИ будет оплачиваться из расчёта 2 юаня ($0,27) за 1 млн входящих токенов и 8 юаней ($1,10) за 1 млн исходящих токенов. При запуске в Сети модели со способностью к рассуждениям тарифы составят 4 юаня ($0,55) за 1 млн входящих токенов и 16 юаней ($2,19) за 1 млн исходящих токенов. Из-за высокого спроса сервисы DeepSeek работают с повышенной нагрузкой с конца января после того, как был представлен чат-бот AI Assistant на основе искусственного интеллекта, который, по словам компании, способен конкурировать с чат-ботом ChatGPT от OpenAI, и на его разработку ушло гораздо меньше средств, чем у конкурентов. Это утверждение вызвало сомнение в США, и сейчас американские чиновники выясняют, не приобрела ли DeepSeek передовые ИИ-ускорители Nvidia через третьих лиц в Сингапуре, обойдя экспортные ограничения на поставки полупроводников в Китай. Ждать новую поумневшую ИИ-помощницу Amazon Alexa осталось совсем недолго

06.02.2025 [16:21],

Павел Котов

Amazon в конце месяца планирует представить долгожданное крупное обновление голосового помощника Alexa, в основу которого ляжет генеративный искусственный интеллект, сообщает Reuters со ссылкой на три источника. Это будет крупнейшее обновление Alexa с тех пор, как ассистент вышел на рынок и спровоцировал активное развитие подобных проектов.

Источник изображений: aboutamazon.com Накануне Amazon разослала СМИ приглашения на мероприятие, которое состоится 26 февраля в Нью-Йорке — в нём примет участие руководитель отдела устройств и сервисов Панос Панай (Panos Panay). Представитель компании подтвердил, что мероприятие будет посвящено Alexa, но подробностей не сообщил. Основанный на генеративном ИИ виртуальный помощник представляет для Amazon и возможность роста на рынке при полумиллиарде устройств с поддержкой Alexa, и огромный риск. Компания надеется, что способный полноценно общаться с пользователями голосовой ассистент послужит стимулом для сотен миллионов клиентов перейти в разряд платящих и поможет сделать прибыльным убыточное направление бизнеса. С генеративным ИИ Alexa сможет отвечать на несколько вопросов последовательно и даже выступать в качестве «агента» от имени пользователей, выполняя некоторые действия вместо них. Сейчас голосовой помощник обрабатывает за раз только один запрос. Внутренняя встреча руководства Amazon запланирована на 14 февраля. На ней топ-менеджеры примут окончательное решение о том, готов ли Alexa с генеративным ИИ к выходу на рынок. Новый формат голосового помощника грозит Amazon проблемами, присущими современным чат-ботам от OpenAI, Google и других разработчиков, — речь идёт о «галлюцинациях», то есть случаях, когда чат-бот даёт заведомо неверные ответы. Сейчас Alexa присутствует в автомобилях, телевизорах, домашних климатических системах и мобильных телефонах — в новом виде виртуальный помощник способен стать важным повседневным средством планирования и инструментом для покупок.  На начальном этапе Amazon планирует развернуть обновлённый вариант Alexa для ограниченного числа пользователей и не взимать за него плату, но в дальнейшем подписка может составить от $5 до $10 в месяц. Существующий бесплатный вариант «Classic Alexa» продолжит работать в прежнем режиме. Amazon выпустила свой голосовой помощник на три года позже Apple Siri, но Alexa стала популярнее. Из-за отсутствия значительных изменений в последние годы на практике он так и используется для решения базовых задач вроде установки таймера на кухне или запроса прогноза погоды. Почти десять лет назад тогдашний руководитель отдела устройств Amazon Дэйв Лимп (Dave Limp) пообещал, что когда-нибудь Alexa «сможет дать ответ на всё, о чем его спросят». У пользователей высокие ожидания от обновления Alexa, и в компании до сих пор присутствуют опасения по поводу качества и скорости ответов голосового помощника. Версия с генеративным ИИ носит внутренние названия Banyan и Remarkable Alexa, но нет ясности, использует ли Amazon одно из них при выводе продукта на рынок. В январе глава отдела разработчиков сильного ИИ (AGI) в Amazon Рохит Прасад (Rohit Prasad) признался, что компания испытывает некоторые трудности в разработке обновлённого Alexa, включая устранение «галлюцинаций», — по сути, это полностью новый проект. Если хотя бы 10 % от 100 млн активных пользователей голосового помощника будут платить за него $5 в месяц, компания будет ежегодно выручать $600 млн. Виртуальный ассистент с генеративным ИИ разрабатывается с учётом потребности запоминать предпочтения пользователей, чтобы давать им рекомендации по музыке или посещению ресторанов; предполагается, что за один сеанс можно будет отдавать Alexa несколько команд сразу, например, отменить заказ гамбургера, прежде чем его отправят в доставку. По крайней мере за часть функций будет отвечать ИИ от стартапа Anthropic, в который Amazon вложила $8 млрд. Ранний вариант Alexa с генеративным ИИ внутри Amazon продемонстрировали ещё в сентябре 2023 года, но в компании возникли сомнения по поводу качества системы, и сроки выхода проекта на рынок неоднократно переносились. Государственным ведомствам Южной Кореи заблокируют доступ к DeepSeek

06.02.2025 [13:24],

Алексей Разин

Всплеск интереса к языковым моделям китайской компании DeepSeek не ограничивается частной аудиторией, но когда речь заходит о государственном секторе, то на кону может оказаться национальная безопасность. Учитывая не самые доброжелательные отношения КНР и Южной Кореи, чиновники последней из стран начали закрывать доступ к DeepSeek для сотрудников государственных ведомств.

Источник изображения: Unsplash, Solen Feyissa Как отмечает Business Korea, с четвёртого февраля Министерство общественной администрации и безопасности Южной Кореи обратилось к государственным ведомствам и 17 муниципалитетам страны с требованием внимательно относиться к использованию систем генеративного искусственного интеллекта, включая DeepSeek. С пятого февраля доступ к DeepSeek заблокировали Министерство иностранных дел, Министерство обороны, Министерство торговли, промышленности и энергетики. С шестого февраля к ним присоединилось Министерство экономики и финансов. Прочие финансовые ведомства Южной Кореи также ограничили доступ к DeepSeek. Специализирующийся на международной торговле государственный банк заблокировал доступ к ресурсам DeepSeek ещё с 31 января. Коммерческие банки и финансовые компании отказались от работы с DeepSeek с третьего февраля. Энергетическая компания KEPCO KPS, которая управляет АЭС, в числе первых представителей частного бизнеса в Южной Корее отказалась от использования DeepSeek. Представители южнокорейских компаний и ведомств отмечают, что опасаются утечки персональных данных через интерфейс китайского чат-бота. Южная Корея является не первой страной, решившейся на подобные меры. Австралийское правительство запретило использовать сервисы DeepSeek на ведомственных устройствах и системах, Италия удалила одноимённое приложение из национального сегмента популярных магазинов приложений в числе первых. Тайвань последовал примеру Италии, а Япония, Великобритания и Нидерланды готовятся это сделать в обозримом будущем. OpenAI открыла ИИ-поисковик для всех пользователей — не нужно даже регистрации

06.02.2025 [01:08],

Андрей Созинов

Компания OpenAI объявила, что её поисковая система на базе ИИ в составе ChatGPT больше не требует регистрации и авторизации. Эта функция позволяет ChatGPT выдавать ответы, основанные на информации из интернета, и представлять список источников, которые он использовал при составлении ответа.

Источник изображения: OpenAI OpenAI впервые запустила свою поисковую систему для платных подписчиков ChatGPT в октябре прошлого года, а в декабре она стала доступна всем пользователям. Но теперь, когда для его использования больше не нужна регистрация, поисковик в ChatGPT сможет напрямую конкурировать с традиционными поисковыми системами, как «Яндекс», Google и Bing. Два последних уже давно приступили к интеграции ИИ в свои поисковики. Недавнее обновление поиска ChatGPT сделало его более похожим на традиционную поисковую систему, позволяя просматривать краткие описания для каждого результата поисковой выдачи, а также карты и изображения местных достопримечательностей. Заметим, что OpenAI будет не первым разработчиком ИИ-систем, запустившим свой поисковик. Perplexity также позволяет искать информацию в интернете без учетной записи, а недавно эта система научилась выдавать информацию об отелях и их рейтинги непосредственно с TripAdvisor. Google открыла для всех ИИ-модель Gemini 2.0 Flash Thinking с «мультимодальным мышлением»

06.02.2025 [00:40],

Анжелла Марина

Компания Google представила масштабное обновление своей платформы искусственного интеллекта Gemini, добавив в приложение экспериментальную модель с функцией «рассуждения». Эта модель, получившая название Gemini 2.0 Flash Thinking, объясняет ход своих рассуждений перед тем, как ответить на сложный вопрос. Обновление стало частью крупного релиза Gemini 2.0, который также включает флагманскую модель Gemini 2.0 Pro.

Источник изображения: blog.google Модель Gemini 2.0 Flash Thinking была впервые представлена в декабре 2024 года и должна была составить конкуренцию аналогичным рассуждающим ИИ-моделям, таким как o1 от OpenAI и R1 от DeepSeek. Как сообщает The Verge, суть системы заключается в способности разбивать задачи на более мелкие шаги перед тем, как предложить решение. Такой подход, по мнению разработчиков, помогает добиться более точных результатов, хотя итоговый ответ может занимать больше времени. Новые возможности уже доступны пользователям на десктопных и мобильных устройствах. Gemini 2.0 Flash Thinking можно выбрать в окне приложения через выпадающий список моделей. Также с обновлением появилась возможность использовать функции искусственного интеллекта (ИИ) в других приложениях Google, таких как YouTube, «Поиск» и Google Карты. Помимо Flash Thinking, вышла экспериментальная версия Gemini 2.0 Pro, которая, по слухам, обладает более высокой точностью и улучшенными характеристиками для решения задач, связанных с программированием и математикой, и, по словам компании, является «самой мощной моделью» в линейке. Версия Pro будет доступна пользователям тарифного плана Advanced Gemini, а также клиентам, имеющим доступ к Vertex AI и AI Studio. Также представлена бюджетная модель Gemini 2.0 Flash-Lite, которая сохраняет скорость и стоимость предшественника (версии 1.5 Flash), но показывает лучшие результаты в большинстве тестов. Flash-Lite доступна в режиме публичного тестирования через AI Studio и Vertex AI. Стоит отметить, что на фоне высочайшей конкуренции и противостояния таким компаниям, как OpenAI, Microsoft, Meta✴✴ и Anthropic, Google активно наращивает инвестиции в развитие искусственного интеллекта. В 2025 году компания планирует потратить на эти цели $75 млрд, что более чем в два раза превышает расходы 2023 года ($32,3 миллиарда), и обновление Gemini 2.0 является частью этих планов. ИИ-боту ChatGPT теперь можно отправлять голосовые сообщения и фото через WhatsApp

05.02.2025 [21:04],

Владимир Фетисов

Разработчики генеративных нейросетей, которые могут создавать контент на основе текстовых или иных подсказок, продолжают расширять доступность своих алгоритмов через интеграцию с другими популярными сервисами. В декабре OpenAI позволила связываться с чат-ботом ChatGPT через WhatsApp, а теперь расширила функциональность этого сервиса. .jpg)

Источник изображений: OpenAI Для взаимодействия с чат-ботом в мессенджере нужно добавить в контакты номер 1(800)CHAT-GPT или 1(800)242-84-78. Ранее у пользователей была возможность взаимодействовать с ИИ-ботом только посредством текстовых сообщений, а теперь алгоритм научился обрабатывать изображения и голосовые сообщения, которые можно направлять в чат «Talk to ChatGPT». После обработки сообщения от пользователя алгоритм выдаст текстовый ответ на заданный голосом вопрос. В дополнение к этому пользователи могут привязать к своему аккаунту в мессенджере действующий тарифный план ChatGPT Plus или Pro, чтобы активнее пользоваться ИИ-ботом прямо в сервисе Meta✴✴. Напомним, об интеграции ChatGPT с мессенджером WhatsApp было объявлено в декабре прошлого года. Собственный чат-бота Meta✴✴ на базе нейросети также доступен в приложении. Добавим, что также в декабре OpenAI запустила возможность связаться с ChatGPT по телефону, даже стационарному — достаточно лишь набрать упомянутый выше номер. Услуга доступна для жителей США. Бесплатно можно пообщаться с ИИ в течение 15 минут. Microsoft объявила даты конференции Build 2025, которая будет почти полностью посвящена ИИ

05.02.2025 [19:50],

Сергей Сурабекянц

Ежегодная конференция разработчиков Microsoft Build пройдёт в Сиэтле с 19 по 22 мая, сообщила компания в социальной сети X: «Мы строим новый путь вперёд. Присоединяйтесь к нам на #MSBuild». Хотя Microsoft пока не предоставила подробностей о программе этого ежегодного мероприятия, нет никаких сомнений, что оно не только сравняется, но и, скорее всего, превзойдёт Build 2024 с точки зрения продуктов и услуг, связанных с ИИ.

Источник изображения: Microsoft Microsoft Build — это конференция, нацеленная на инженеров-программистов и веб-разработчиков. В конечном счёте, инструменты, обсуждаемые на Build, впоследствии используются, чтобы сделать технологии доступными для широкой аудитории. «Изучите последние инновации в разработке кода и приложений и получите идеи от коллег и экспертов со всего мира», — говорится на приветственной странице Build 2025. Тема искусственного интеллекта занимала ведущее место на прошлогодней конференции, охватив самые разные области — от поиска в Windows до Copilot+ и Microsoft Paint. А за день до Build 2024 Microsoft представила свой новый ПК Surface Pro на базе чипов Qualcomm Snapdragon X Elite и X Plus с NPU производительностью до 45 TOPS. То же самое может произойти и в этом году. Можно с уверенностью сказать, что Windows 11, наряду с пакетом Microsoft 365, получат существенные улучшения в области ИИ, которые будут представлены именно на Build 2025. Также компания планирует выпуск новых моделей Surface с новейшими чипами Qualcomm — преемниками X Elite с расширенной поддержкой нейросетевых вычислений. Нужно отметить, что Microsoft существенно изменила свой подход к ИИ за прошедший год, занявшись диверсификацией своих инвестиций. Теперь, кроме поддержки OpenAI, Microsoft включила в круг своих интересов нашумевшую китайскую модель DeepSeek, которую компания планирует использовать на ПК Copilot+ и в облаке Azure. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |