|

Опрос

|

реклама

Быстрый переход

Китайская ByteDance в этом году рассчитывает купить ускорителей Nvidia на сумму $7 млрд

01.01.2025 [10:32],

Алексей Разин

Статистика прошлого года уже позволила понять, что китайские компании ByteDance и Tencent оказались на втором и третьем месте соответственно среди крупнейших покупателей ускорителей Nvidia, уступив только Microsoft. Новые сведения гласят, что ByteDance в условиях сохранения санкций против КНР рассчитывает в текущем году закупить ускорителей Nvidia на общую сумму $7 млрд.

Источник изображения: Nvidia Об этом сообщает издание The Information, отмечая, что подобные расходы превратят ByteDance в одного из крупнейших в мире покупателей ускорителей вычислений Nvidia. Рассчитывать на успех подобной инициативы позволяет схема закупки данной продукции в условиях санкций против Китая. Технически, данные ускорители будут размещаться в центрах обработки данных за пределами КНР в соседних странах Юго-Восточной Азии, поэтому ByteDance сможет купить даже достаточно производительные ускорители Nvidia, а не только подогнанные под требования правил экспортного контроля США варианты с ограниченной производительностью. ByteDance в Китае предлагает клиентам популярный чат-бот Doubao, который насчитывает 51 млн активных пользователей. Закупка большого количества ускорителей вычислений Nvidia определённо поможет китайским разработчикам усовершенствовать свои сервисы, включая популярную за пределами КНР социальную сеть TikTok. Галлюцинации и ошибки ИИ способны привести к научным прорывам

31.12.2024 [01:53],

Анжелла Марина

Искусственный интеллект (ИИ), способный убедительно создавать ложную или вымышленную информацию, может стать незаменимым инструментом в руках учёных. Новые лекарства, прогнозирование погоды и изобретение устройств — вот лишь немногие примеры того, как способность ИИ генерировать новые, на первый взгляд ошибочные идеи, может менять мир науки.

Источник изображения: Copilot ИИ-модели часто подвергаются критике за склонность генерировать недостоверную информацию, выдавая её за факты — так называемые «галлюцинации». Эти правдоподобные подделки не только сбивают с толку пользователей чат-ботов, но и приводят к судебным разбирательствам и ошибкам в медицинских записях. Например, в прошлом году ложное заявление чат-бота Google обвалило рыночную стоимость одной из компаний на $100 млрд. Однако, как пишет The New York Times, недавно исследователи обнаружили, что «галлюцинации» ИИ могут быть и на удивление полезными. Оказывается, «умные» LLM (большие языковые модели) способны генерировать невероятные идеи, которые помогают учёным в борьбе с раком, разработке новых лекарств, создании медицинских устройств, изучении погодных явлений и даже в получении Нобелевской премии. «Это даёт учёным новые идеи, которых они могли бы никогда не придумать сами», — объясняет Эми МакГоверн (Amy McGovern), руководитель федерального института ИИ (NSF AI Institute) в США по прогнозированию климата и погоды. Хотя наука традиционно ассоциируется с логикой и аналитикой, её начало часто связано с интуицией и смелыми предположениями. Философ и методолог науки Пол Фейерабенд (Paul Feyerabend) однажды охарактеризовал этот этап как «всё дозволено». Ошибки ИИ-моделей оживляют этот творческий процесс, ускоряя поиск и проверку новых идей. То, что раньше занимало годы, теперь можно сделать за дни, часы или даже минуты. Профессор Массачусетского технологического института (MIT) Джеймс Дж. Коллинз (James J. Collins) недавно похвалил «галлюцинации» за ускорение его исследований в области новых антибиотиков, поскольку ИИ-модели создали совершенно новые молекулы. «Галлюцинации» ИИ возникают, когда учёные обучают генеративные компьютерные модели определённой теме, а затем позволяют машинам перерабатывать полученную информацию. Результаты могут быть как абсурдными, так и гениальными. Например, в октябре 2023 года Нобелевская премия по химии была вручена Дэвиду Бейкеру (David Baker) за исследования в области белков. Его подход, основанный на использовании ИИ для создания совершенно новых белков, ранее считался практически невозможным. Бейкер отметил, что ИИ-генерация стала основой для разработки «белков с нуля». «Мы создали 10 миллионов новых белков, которых нет в природе», — говорит учёный. При этом его лаборатория уже получила около 100 патентов, включая технологии для лечения рака и борьбы с вирусными инфекциями. Однако термин «галлюцинации» вызывает споры. Многие предпочитают называть результаты работы ИИ предположениями или перспективными идеями, поскольку они часто основаны на реальных научных данных. Например, профессор Калифорнийского технологического института Анима Анандкумар (Anima Anandkumar) считает, что использование термина «галлюцинации» может вводить в заблуждение, и отмечает, что учёные стараются избегать его. Стоит отметить, что некоторые эксперты обеспокоены тем, что темпы научных открытий замедлились за последние десятилетия. Однако сторонники ИИ утверждают, что новые возможности могут вывести науку на иной уровень. В частности, Бейкер и его коллеги видят будущее, в котором белковые катализаторы будут использовать солнечную энергию, модернизировать заводы и помогать создавать устойчивый мир. Другие учёные также разделяют этот оптимизм. «Это невероятно, насколько быстро всё развивается», — говорит Иан Хейдон (Ian C. Haydon), член команды Бейкера. А Пушмит Кохли (Pushmeet Kohli) из DeepMind подчёркивает, что ИИ способен на неожиданные, но гениальные ходы. «Мы явно имеем удивительный инструмент, который способен проявлять креативность», — заключил он. Несмотря на успехи, «галлюцинации» искусственного интеллекта остаются спорной темой. Хотя некоторые учёные видят в них полезный инструмент, другие опасаются их негативных последствий, таких как ошибки в медицинских данных. Тем не менее, научным сообществом признаётся, что потенциал ИИ для ускорения научных открытий огромен. Nvidia завершила поглощение ИИ-стартапа Run:ai за $700 млн

30.12.2024 [19:06],

Владимир Фетисов

Компания Nvidia завершила сделку по приобретению ИИ-стартапа Run:ai за $700 млн. Это произошло вскоре после того, как в этом месяце Еврокомиссия, являющаяся основным отраслевым регулятором в регионе, после проведённого расследования одобрила сделку, не найдя угроз для конкуренции.

Источник изображения: Nvidia Ранее в этом месяце Еврокомиссия одобрила сделку по покупке Nvidia стартапа Run:ai из Тель-Авива, который предоставляет услуги по оптимизации инфраструктуры для управления рабочими нагрузками в области искусственного интеллекта. Регулятор пришёл к выводу, что слияние не станет причиной появления проблем с конкуренцией внутри Европейской экономической зоны. В рамках расследования Еврокомиссия изучала, как слияние может повлиять на укрепление позиций Nvidia на рынке графических ускорителей, где американская компания уже занимает доминирующее положение. Nvidia также лидирует в сегменте GPU для искусственного интеллекта с долей около 80 %. Несмотря на это, регулятор одобрил сделку, поскольку деятельность Nvidia и Run:ai не пересекается. Также отмечалось, что израильский стартап в настоящее время не занимает значимой позиции на рассматриваемом рынке. Одновременно с заявлением о закрытии сделки Run:ai объявила о намерении сделать код своего программного обеспечения открытым. «Хотя в настоящее время Run:ai поддерживает только графические ускорители Nvidia, открытый исходный код программного обеспечения позволит расширить его доступность на всю экосистему искусственного интеллекта», — говорится в заявлении стартапа. Энтузиасты запустили современную ИИ-модель Llama на древнем ПК с Pentium II и Windows 98

30.12.2024 [17:19],

Владимир Фетисов

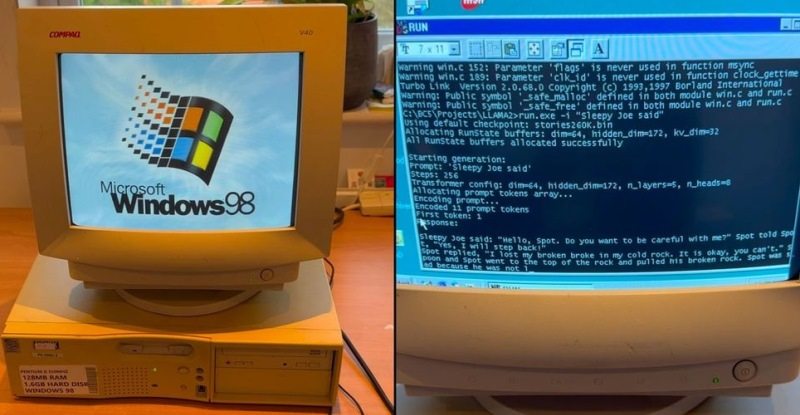

Специалисты из EXO Labs сумели запустить довольно мощную большую языковую модель (LLM) Llama на 26-летнем компьютере, работающем под управлением операционной системы Windows 98. Исследователи наглядно показали, как загружается старый ПК, оснащённый процессором Intel Pentium II с рабочей частотой 350 МГц и 128 Мбайт оперативной памяти, после чего осуществляется запуск нейросети и дальнейшее взаимодействие с ней.

Источник изображения: GitHub Для запуска LLM специалисты EXO Labs задействовали собственный интерфейс вывода для алгоритма Llama98.c, который создан на базе движка Llama2.c, написанного на языке программирования C бывшим сотрудником OpenAI и Tesla Андреем Карпатым (Andrej Karpathy). После загрузки алгоритма его попросили создать историю о Сонном Джо. Удивительно, но ИИ-модель действительно работает даже на таком древнем ПК, причём история пишется с хорошей скоростью. Загадочная организация EXO Labs, сформированная исследователями и инженерами из Оксфордского университета, вышла из тени в сентябре этого года. Согласно имеющимся данным, она выступает за открытость и доступность технологий на базе искусственного интеллекта. Представители организации считают, что передовые ИИ-технологии не должны находиться в руках горстки корпораций, как это происходят сейчас. В дальнейшем они рассчитывают «построить открытую инфраструктуру для обучения передовых ИИ-моделей, что позволит любому человеку запускать их где угодно». Демонстрация возможности запуска LLM на древнем ПК, по их мнению, доказывает то, что ИИ-алгоритмы могут работать практически на любых устройствах. В своём блоге энтузиасты рассказали, что для реализации поставленной задачи на eBay был приобретён старый ПК с Windows 98. Затем, подключив устройство в сеть с помощью разъёма Ethernet, они через FTP сумели передать в память устройства нужные данные. Вероятно, компиляция современного кода для Windows 98 оказалась более сложной задачей, решить которую помогла опубликованная на GitHub работа Андрея Карпатого. В конечном счёте удалось добиться скорости генерации текста в 35,9 токенов в секунду при использовании LLM размером 260K с архитектурой Llama, что весьма неплохо, учитывая скромные вычислительные возможности устройства. ИИ будет манипулировать людьми, чтобы они принимали нужные решения

30.12.2024 [12:49],

Владимир Мироненко

Инструменты искусственного интеллекта (ИИ) могут использоваться для манипулирования онлайн-аудиторией с целью принятия различных решений — от того, что покупать, до того, за кого голосовать, сообщается в исследовании команды учёных Кембриджского университета, посвящённом новому рынку «цифровых сигналов намерений», известному как «экономика намерений».

Источник изображения: Christin Hume По словам исследователей Центра будущего интеллекта Леверхалма (LCFI) при Кембриджском университете, «экономика намерений» является преемницей «экономики внимания», в которой социальные сети удерживают пользователей на своих платформах и показывают им рекламу. В рамках «экономики внимания» рекламодатели могут покупать доступ к вниманию пользователей в настоящем через торги в реальном времени на рекламных биржах или приобретать его для будущих акций, например, арендуя рекламные площади на месяц вперёд. «В течение десятилетий внимание было валютой интернета, — говорит доктор Джонни Пенн (Jonnie Penn) из LCFI. — Обмен вниманием с социальными медиа-платформами, такими как Facebook✴✴ и Instagram✴✴, привёл к развитию онлайн-экономики». В исследовании утверждается, что большие языковые модели (LLM), используемые в работе таких инструментов ИИ, как чат-бот ChatGPT, будут применяться для «предвидения и управления» пользователями на основе «намеренных, поведенческих и психологических данных». При «экономике намерений» компании в сфере ИИ будут продавать сведения о мотивах пользователей, начиная от планов проживания в отеле и заканчивая мнениями о политическом кандидате, тому, кто предложит самую высокую цену. «В экономике намерений LLM может с минимальными затратами использовать ритм общения пользователя, его политические взгляды, словарный запас, возраст, пол, предпочтения и даже склонность к лести. Эти данные в сочетании с посредническими ставками позволят максимизировать вероятность достижения заданной цели (например, продажи билета в кино)», — говорится в исследовании. Указывается также, что в таком мире модели ИИ будут направлять обсуждение в интересах рекламодателей, предприятий и других третьих лиц. В исследовании утверждается, что рекламодатели смогут использовать инструменты генеративного ИИ для создания индивидуальной онлайн-рекламы. В качестве примера приводится модель ИИ под названием Cicero компании Meta✴✴, которая достигла «человеческого уровня» в способности играть в настольную игру **Diplomacy**, где успех зависит от предсказания намерений оппонента. Модели ИИ смогут настраивать свои результаты в ответ на «потоки входящих данных, сгенерированных пользователями», указывается в исследовании. Они смогут выделять личную информацию из повседневного общения и даже «направлять» разговор таким образом, чтобы получать больше личных данных. В исследовании цитируется сообщение исследовательской группы Cicero о том, что «агент [ИИ] может научиться подталкивать своего собеседника к достижению определённой цели». Также исследователи прогнозируют сценарий, при котором Meta✴✴ будет выставлять на аукцион намерения пользователей, например, забронировать ресторан, рейс или отель. Хотя уже существует отрасль, занимающаяся прогнозированием и торгами на основе поведения человека, модели ИИ преобразуют этот процесс в «высококачественный, динамичный и персонализированный формат», подчеркнули учёные из LCFI. Поставщик подложек для чипов ИИ-ускорителей верит в сохранение высокого спроса

30.12.2024 [06:45],

Алексей Разин

Зависимость той же Nvidia в сфере поставок ускорителей вычислений от своих подрядчиков иллюстрирует необходимость синхронизации усилий участников рынка компонентов для его насыщения. Японская компания Ibiden, поставляющая подложки для чипов, убеждена в сохранении высокого спроса на подобную продукцию в ближайшие несколько лет.

Источник изображения: Ibiden Сейчас подложки для ИИ-чипов формируют около 15 % выручки Ibiden, которая в целом достигает $2,3 млрд, но эта доля будет расти в дальнейшем, как считают опрошенные Bloomberg представители компании. Все ускорители Nvidia сейчас используют только подложки Ibiden, хотя тайваньские конкуренты типа Unimicron Technology и пытаются потеснить японского поставщика. Свои компетенции в сфере производства подложек Ibiden в прошлом веке развивала при активном участии Intel. В девяностые годы, например, этот американский производитель процессоров формировал до 90 % выручки Ibiden в сфере поставок подложек. К концу марта уходящего года этот показатель упал до 30 %, но руководство Ibiden продолжает считать Intel очень важным клиентом, и выражает уверенность, что у неё всё наладится. Непосредственно Intel будет играть ключевую роль в усилиях властей США по возрождению национальной полупроводниковой промышленности, но Ibiden не видит для себя смысла строить производственные предприятия на территории США. Это требует больших затрат на логистику и оплату труда сотрудников, и обещанные Трампом повышенные пошлины не смогут кардинально повлиять на решение Ibiden. Клиентами Ibiden также являются компании AMD, Samsung и TSMC, они плотно сотрудничают с японским подрядчиком при разработке своих новых изделий. Сейчас весь объём выпускаемой Ibiden продукции раскупается клиентами, высокий спрос сохранится как минимум до конца следующего года. В центральной части Японии компания строит новое предприятие по выпуску подложек. К концу следующего года оно будет запущено на 25 % своих проектных мощностей, а к марту 2026 года выйдет на 50 %. Этого не будет достаточно для удовлетворения спроса на подложки со стороны клиентов, поэтому компания сейчас ведёт с ними переговоры о сроках вывода строящегося предприятия на 100 % мощности. «Ставки высоки»: Глава Google призвал сотрудников готовиться к непростому 2025 году

28.12.2024 [16:59],

Павел Котов

В ходе прошедшей на минувшей неделе встречи с сотрудниками глава Google Сундар Пичаи (Sundar Pichai) сказал подчинённым, что в перспективе 2025 года «ставки высоки»: компания противостоит конкурентам, действиям властей и стремится не утратить инициативу в активно развивающейся области искусственного интеллекта.

Источник изображений: BoliviaInteligente / unsplash.com Мероприятие прошло 18 декабря. «Думаю, 2025 год будет решающим. Очень важно, чтобы мы осознали срочность этого момента, мы как компания должны продвигаться быстрее. Ставки высоки. Это дезорганизующие моменты. В 2025 году нам нужно неустанно быть сосредоточенными на раскрытии преимуществ этой технологии и решении насущных проблем пользователей», — заявил Сундар Пичаи. Уходящий год выдался для Google непростым. Доходы от поисковой рекламы и облачных услуг показали значительный рост, но усилилась конкуренция на основных рынках компании, обострились внутренние проблемы, связанные с конфликтами культур и тем, как руководство Google видит будущее. В августе федеральный судья вынес решение, что Google незаконно удерживает монополию на рынке поиска; в ноябре Минюст потребовал принудительного отчуждения проекта по разработке браузера Chrome. Ведомство также обвинило компанию в незаконном доминировании в сфере технологий онлайн-рекламы — судебное разбирательство было закрыто в сентябре и ожидает решения судьи. Недовольство действиями Google в области рекламных технологий выразили и британские антимонопольщики. «Не могу не заметить, что мы сталкиваемся с пристальным вниманием по всему миру. Это связано с нашими размерами и успехом. Это из-за тенденции, когда технологии стали оказывать масштабное влияние на общество», — сказал глава Google. Поисковый бизнес компании по-прежнему доминирует на рынке, но генеративный ИИ открыл людям новые способы доступа к информации онлайн, а вместе с ним у Google появилось множество новых конкурентов, в том числе OpenAI (оценочная стоимость $157 млрд) и Perplexity ($9 млрд). Для противостояния новым соперникам Google прикладывает значительные усилия; ключевой продукт у неё — большая языковая модель Gemini. Приоритетом для компании теперь является «создание большого нового бизнеса», в котором Gemini отведена ключевая роль — в Google надеются, что аудитория этого приложения достигнет полумиллиарда пользователей; в ассортименте компании уже значатся 15 таких приложений.  Господин Пичаи допустил, что Google может несколько отстать от конкурентов по направлению ИИ в 2025 году, но выразил надежду, что компания останется в авангарде. «В истории не всегда нужно быть первым, но следует хорошо делать своё дело и выпускать лучший в своём классе продукт. Думаю, таким 2025 год и будет», — заявил гендиректор компании. Сооснователь подразделения DeepMind Демис Хассабис (Demis Hassabis) рассказал об универсальном помощнике с ИИ, который «сможет бесперебойно работать в любом месте, любом формате или на любом устройстве». Экспериментальную версию такой системы под названием Project Astra в первой половине 2025 года ожидает обновление. Хассабис также заверил сотрудников, что Google не собирается вслед за OpenAI вводить дорогую подписку за $200 в месяц. Несколько новых продуктов продемонстрировал глава подразделения Google Labs Джош Вудворд (Josh Woodward): ассистента по написанию программного кода Jules; несколько новых инструментов NotebookLM, в том числе для работы с подкастами; основанное на ИИ многозадачное расширение Project Mariner для Chrome по запросу добавило на «Google Карты» лучшие рестораны из Tripadvisor. На протяжении всего мероприятия Сундар Пичаи напоминал сотрудникам о необходимости «сохранять решимость». В 2023 году Google пришлось сократить расходы, уволить 6 % сотрудников и делать акцент на эффективности. По состоянию на конце III квартала 2024 года в Alphabet работали 181 269 человек — на 5 % меньше, чем на конец 2022 года. Пичаи напомнил, что компания возникла 26 лет назад, задолго до появления облачных вычислений и мощных инструментов ИИ. «Смотрите, как основатели на заре Google строили наши центры обработки данных — они сохраняли запал в каждом принимаемом решении. Ограничения часто порождают творчество. Не все проблемы можно решить численностью работников», — отметил он. Вышел трейлер первого индийского полнометражного фильма, который сгенерировал ИИ

27.12.2024 [20:30],

Геннадий Детинич

До конца 2025 года на большие экраны выйдет индийский полнометражный фильм «Махараджа в джинсах» (Maharaja in Denims), созданный с помощью искусственного интеллекта по одноимённому роману индийского писателя Хушванта Сингха (Khushwant Singh). Ранее студии дважды покупали права на экранизацию произведения, но масштаб и стоимость проекта не позволяли начать съёмки. Искусственный интеллект, напротив, принял заявку в производство без вопросов.

Источник изображений: Intelliflicks Studios Сегодня никого не удивляют короткие видеоролики, созданные с помощью искусственного интеллекта. Однако с полнометражными фильмами всё гораздо сложнее, хотя бы потому, что генеративная модель не может долго поддерживать одну и ту же форму, черты персонажей и сцены. Чем длиннее эпизод, тем больше вероятность ошибок. К счастью, разработчики учли этот недостаток программ для визуализации и создали ряд инструментов для его устранения. Например, при генерации действий персонажей теперь используются специальные цифровые метки, которые помогают сохранить их образы при переходе из одной сцены в другую, минимизируя изменения.  Автор эпичного произведения, рассказывающего о ряде исторических событий в Индии и их переосмыслении главным героем в наши дни, познакомился с ИИ-генерацией благодаря давнему другу — Гурдипу Пэллу (Gurdeep Pall), ныне занимающему ведущий пост в компании Qualtrics. Вместе они основали стартап Intelliflicks Studios в Чандигархе, который занялся производством полнометражной ленты с преимущественным использованием ИИ. Персонажи фильма создаются с помощью отдельных программ, после чего их образы загружаются в ИИ-видеоредакторы. Для улучшения качества изображения используется также традиционное программное обеспечение, которое устраняет мелкие дефекты и помогает с цветокоррекцией. Некоторые сцены снимаются с живыми актёрами, которым ИИ впоследствии заменяет лица. Например, этот подход решили использовать для съёмок ритуальных танцев, которые слишком сложно воспроизвести моделированием. Эксперты считают, что у компании Intelliflicks Studios есть шансы на успех, хотя режиссёрская работа далеко выходит за рамки визуализации. В любом случае, подобный эксперимент должен был быть проведён рано или поздно. Почему бы им не стать экранизацией произведения Сингха? Сам автор считает, что таким образом он прокладывает путь к демократизации кинопроизводства, стоимость которого сегодня превышает всякие разумные пределы. Российские СМИ и блогеры стали чаще говорить об ИИ в уходящем году, но упоминания отечественных сервисов упали

27.12.2024 [18:57],

Владимир Мироненко

В течение 11 месяцев текущего года ИИ-сервисы упоминались в российских СМИ 163 763 раза, 1,03 млн раз — в русскоязычных Telegram-каналах и 20,17 млн раз — в поисковых запросах, сообщили «Ведомости» со ссылкой на совместный отчёт «Индекс AI-Хайпа» от агентства Real Time и Telegram-канала «Нецифровая экономика».

Источник изображения: Growtika Для сравнения, за весь прошлый год ИИ упоминался в российских СМИ 139 916 раз, в Telegram-каналах — 603 815 раз и 19,1 млн раз пользователи искали информацию об ИИ-сервисах. Для исследования использовалась статистика по 20 сервисам, включая зарубежные (ChatGPT, Midjourney, Character.AI, Suno и др.) и российские (YandexGPT и «Шедеврум» от «Яндекса» и GigaChat и Kandinsky от «Сбера»). В связи с появлением множества новых сервисов на базе ИИ, совокупная доля упоминаний ChatGPT и Midjourney в публикациях СМИ снизилась за последние два года до примерно 60 % от общего количества, хотя в Telegram ни разу не опускалась ниже 80 %, сообщается в исследовании. За этот период традиционные СМИ упоминали отечественные ИИ-сервисы вдвое чаще пользователей, которые вдвое больше упоминали их, чем блогеры. С весны 2023 года российский ИИ упоминался в среднем в каждой четвёртой публикации, а доля публикаций в СМИ с его упоминанием лишь однажды опустилась ниже 20 %. Пик интереса СМИ к этой теме приходится на декабрь 2023 года, когда о российских ИИ-решениях упоминали почти в половине публикаций (в 40 % статей). При этом в 2024 году в СМИ чаще упоминался GigaChat (не менее 1000 упоминаний ежемесячно), а в Telegram — YandexGPT (не менее 1500 упоминаний ежемесячно с марта). В исследовании отмечено, что доля упоминаний российских продуктов в постах Telegram в 2024 году снизились. Из отечественных ИИ-продуктов блогеры, как и в прошлом году, чаще упоминали YandexGPT. Его доля в упоминаниях составила 1,8 %, на GigaChat, сместивший со второго места Kandinsky, приходится 1,6 %. Как и в 2023 году, в 2024 году российские пользователи чаще всего искали в интернете продукты от «Яндекса»: «Шедеврум» (5,7 %, в 2023 году — 3,2 %) и YandexGPT (2,9 %, в 2023 году — 2,1 %). Интерес к ИИ-продуктам в этом году был на стабильно высоком уровне, чему способствовал не только выход обновлений ранее вышедших ИИ-решений, но и появление ИИ-сервисов, генерирующих аудио и видео. В феврале OpenAI представила генератор видео Sora, затем были анонсированы его аналоги — Kling китайского разработчика платформы коротких видео Kuaishou, а также Luma и Runway американских разработчиков.  Лидером пользовательских предпочтений с марта 2023 года остаётся сервис Character.AI, позволяющий создавать ИИ-личности (не опускался ниже 400 тыс. запросов ежемесячно) и сместивший ChatGPT на второе место, а бесплатный сервис Stable Diffusion сместил с третьего места Midjourney, опустившегося на четвёртое. Также в 2024 году успех сопутствовал появившемуся осенью 2023 года сервису Suno AI, генерирующему песни по текстовому описанию. В июне он вышел на второе место в поисковых запросах в России, опередив ChatGPT. В сентябре на фоне начала учебного сезона поисковые запросы с упоминанием ChatGPT стали увеличиваться, и в ноябре сервис вышел на первое место (более 500 тыс. запросов ежемесячно), сместив на второе Character.AI, а на третьем впервые оказался сервис генерации изображений «Шедеврум» от «Яндекса» (более 200 тыс. запросов ежемесячно). Сооснователь компании Parodist AI Владимир Свешников связывает падение интереса к Character AI с произошедшим в октябре суицидом 14-летнего школьника в США, совершённым в ходе длительного общения с ботом, после чего сервис ужесточил модерацию выдаваемого контента. Гендиректор Dbrain, автор Telegram-канала AI Happens Алексей Хахунов, назвал абсолютными лидерами по популярности ChatGPT и Midjourney, также признав выросший интерес к Character.AI и Suno. Он также отметил, что с решением прикладных задач продукты «Яндекса» и «Сбера» пока справляются хуже западных аналогов. Эксперт сообщил, что сейчас «Яндекс» и «Сбер» активнее интегрируют свои ИИ-сервисы в инфраструктуру — в службу поддержки, в колонки и т. д. При этом «Яндекс» в разработке ИИ-моделей продвинулся дальше «Сбера». Представитель Альянса в сфере искусственного интеллекта отметил, что этот год стал годом внедрения собственных и опенсорсных моделей в продукты и сервисы с миллионной аудиторией. По его словам, в 2025 году следует ждать роста внедрения технологии ИИ как во внутренние бизнес-процессы, так и во внешние решения. Причём одним из ключевых трендов в развитии нейросетей в ближайшие пару лет станет дообучение моделей с открытым исходным кодом для внедрения в бизнес-процессы в различных отраслях. Microsoft и OpenAI договорились, как не проморгать появление сильного ИИ

27.12.2024 [14:48],

Владимир Фетисов

По сообщениям сетевых источников, компании Microsoft и OpenAI имеют конкретное внутреннее определение сильного ИИ (Artificial General Intelligence, AGI), т.е. системы, которая способна решать задачи наравне с человеком, основанное на показателе прибыли стартапа. Согласно этому определению, OpenAI находится в годах работы от достижения данной цели.

Источник изображений: OpenAI В сообщении сказано, что в прошлом году Microsoft и OpenAI подписали соглашение, согласно которому OpenAI сможет создать AGI только в случае, если удастся разработать ИИ-системы, способные приносить прибыль в размере не менее $100 млрд. Это определение далеко от строгого технического и философского определения AGI, которого ожидают многие. Согласно имеющимся данным, по итогам текущего года убыток OpenAI составит миллиарды долларов, и компания уже сообщила инвесторам, что начнёт получать прибыль не ранее 2029 года. Это важная деталь, поскольку Microsoft может потерять доступ к технологиям OpenAI, когда стартап создаст AGI —систему, точное определение которой может звучать по-разному. Существует мнение, согласно которому OpenAI может объявить о создании AGI раньше запланированного срока, чтобы вытеснить Microsoft. Однако соглашение между двумя компаниями означает, что софтверный гигант может иметь доступ к технологиям ИИ-стартапа в течение десяти лет или более. Ранее в этом месяце велось активное обсуждение того, насколько алгоритм OpenAI o3 может считаться значительным шагом на пути к созданию AGI. Хотя o3 работает лучше большинства ИИ-моделей, алгоритм всё ещё нуждается в значительных вычислительных мощностях, что не сулит ничего хорошего для ориентированного на прибыль определения AGI. Китайцы представили открытую ИИ-модель DeepSeek V3 — она быстрее GPT-4o и её обучение обошлось намного дешевле

27.12.2024 [13:58],

Павел Котов

Китайская компания DeepSeek представила мощную открытую модель искусственного интеллекта DeepSeek V3 — лицензия позволяет её беспрепятственно скачивать, изменять и использовать в большинстве проектов, включая коммерческие.

Источник изображения: and machines / unsplash.com DeepSeek V3 справляется со множеством связанных с обработкой текста задач, в том числе написание статей, электронных писем, перевод и генерация программного кода. Модель превосходит большинство открытых и закрытых аналогов, показали результаты проведённого разработчиком тестирования. Так, в связанных с программированием задачах она оказалась сильнее, чем Meta✴✴ Llama 3.1 405B, OpenAI GPT-4o и Alibaba Qwen 2.5 72B; DeepSeek V3 также проявила себя лучше конкурентов в тесте Aider Polyglot, проверяющем, среди прочего, её способность генерировать код для существующих проектов. Модель была обучена на наборе данных в 14,8 трлн проектов; будучи развёрнутой на платформе Hugging Face, DeepSeek V3 показала размер в 671 млрд параметров — примерно в 1,6 раза больше, чем Llama 3.1 405B, у которой, как можно догадаться, 405 млрд параметров. Как правило, число параметров, то есть внутренних переменных, которые используются моделями для прогнозирования ответов и принятия решений, коррелирует с навыками моделей: чем больше параметров, тем она способнее. Но для запуска таких систем ИИ требуется больше вычислительных ресурсов. DeepSeek V3 была обучена за два месяца в центре обработки данных на ускорителях Nvidia H800 — сейчас их поставки в Китай запрещены американскими санкциями. Стоимость обучения модели, утверждает разработчик, составила $5,5 млн, что значительно ниже расходов OpenAI на те же цели. При этом DeepSeek V3 политически выверена — она отказывается отвечать на вопросы, которые официальный Пекин считает щекотливыми. В ноябре тот же разработчик представил модель DeepSeek-R1 — аналог «рассуждающей» OpenAI o1. Одним из инвесторов DeepSeek является китайский хедж-фонд High-Flyer Capital Management, который принимает решения с использованием ИИ. В его распоряжении есть несколько собственных кластеров для обучения моделей. Один из последних, по некоторым сведениям, содержит 10 000 ускорителей Nvidia A100, а его стоимость составила 1 млрд юаней ($138 млн). High-Flyer стремится помочь DeepSeek в разработке «сверхразумного» ИИ, который превзойдёт человека. Instagram✴ и Facebook✴ наполнятся пользователями, которых сгенерирует ИИ

27.12.2024 [11:58],

Павел Котов

Meta✴✴ намеревается в ближайшие годы заполонить социальные сети персонажами, созданными с помощью искусственного интеллекта. Это, по мнению компании, повысит вовлечённость аудитории, которая на всех её платформах составляет 3 млрд пользователей, пишет Financial Times.

Источник изображения: Xu Haiwei / unsplash.com Meta✴✴ выпустит ряд продуктов на основе ИИ, включая инструмент для создания ИИ-персонажей в Instagram✴✴ и Facebook✴✴, — это рассматривается как средство конкурентной борьбы с другими технологическими гигантами за привлечение и удержание молодой аудитории. «Ожидаем, что эти ИИ-инструменты со временем действительно появятся на наших платформах примерно так же, как и учётные записи. У них будут биографии и фотографии профиля, и они смогут создавать и публиковать материалы с помощью ИИ на платформе. <..> вот к чему, по нашему мнению, всё идёт», — рассказал вице-президент по продуктам генеративного ИИ в Meta✴✴ Коннор Хейс (Connor Hayes). «Приоритетом» для Meta✴✴ на ближайшие два года станут меры, которые сделают приложения компании «интереснее и привлекательнее», в том числе усиление социального компонента при взаимодействии с ИИ, добавил топ-менеджер. Он напомнил, что в июле компания запустила инструмент ИИ, с помощью которого были созданы несколько сотен тысяч персонажей, и в будущем доступ к нему будет расширен. Пока же большинство блогеров пользуется ИИ, чтобы улучшить внешний вид реальных материалов, — авторы просто редактируют фотографии. В сентябре Snapchat представил средства для создания 3D-персонажей в дополненной реальности; число пользователей, открывающих «ИИ-линзы», ежегодно растёт на 50 %. TikTok запустил пилотный проект Symphony, который поможет брендам и блогерам пользоваться ИИ для создания рекламных материалов, включая генерацию видеороликов по текстовым запросам и перевод контента. Meta✴✴ же запустила ИИ-помощников, которые отвечают на вопросы подписчиков вместо блогеров; в следующем году пользователи смогут генерировать по текстовому запросу видео со своим участием. Ранее глава компании Марк Цукерберг (Mark Zuckerberg) провёл «сеанс видеосвязи» с цифровой копией человека — сам человек в это время стоял на сцене рядом с ним. Эксперты предупреждают, что созданный ИИ контент может использоваться злонамеренно, например, для распространения дезинформации. Для защиты от этого в Meta✴✴ предлагают чётко маркировать на платформах генерируемые ИИ материалы. Ещё одна потенциальная угроза повсеместного присутствия ИИ в соцсетях, по мнению экспертов, — снижение качества контента. И способов предотвратить это в Meta✴✴ пока не предложили. Xiaomi построит собственный ИИ-суперкомпьютер на 10 000 GPU

27.12.2024 [10:09],

Алексей Разин

Компания Xiaomi уже располагает собственной вычислительной инфраструктурой для создания систем искусственного интеллекта и намерена значительно её расширить. Компания рассчитывает использовать для этих нужд кластер из 10 000 ускорителей вычислений на базе GPU.

Источник изображения: Xiaomi По информации Jiemian Global, команда специалистов Xiaomi в области искусственного интеллекта была создана ещё в 2016 году, за последующие семь лет её штат увеличился в шесть раз до более чем 3000 человек. С текущего года в распоряжении этих специалистов находятся около 6500 ускорителей вычислений на базе GPU, с помощью которых они получили возможность обучать большие языковые модели. Смартфоны, Интернет вещей, робототехника и электромобили — вот те сферы деятельности, в которых Xiaomi собирается применять соответствующие наработки. Генеральный директор Xiaomi Лэй Цзюнь (Lei Jun) лично курирует развитие направления искусственного интеллекта в компании. При этом с точки зрения ассортимента аппаратных решений призывает не распыляться на некоторые модные тенденции, включая очки дополненной реальности, а сосредоточиться на тех же смартфонах. Впрочем, он делает большие ставки и на сегмент электромобилей, рассчитывая превратить Xiaomi в одного из пяти крупнейших автопроизводителей мира через несколько лет. Со следующего года компанию дебютной модели SU7 составит кроссовер YU7, слухи также приписывают Xiaomi намерения разработать собственный процессор для смартфонов. В работе ChatGPT произошёл глобальный сбой

26.12.2024 [23:22],

Андрей Созинов

ChatGPT перестал работать у многих пользователей по всему миру. Многочисленные сообщения в социальных сетях, а также наша собственная проверка показали, что чат-бот загружается, но не отвечает на запросы. Также многие пользователи видят сообщение о «внутренней ошибке сервера».  Похоже, что перебои начались примерно в 21:30 по московскому времени. Именно тогда на Down Detector начали появляться сообщения. В 22:00 по московскому времени OpenAI опубликовала обновление на странице состояния своих сервисов, сообщив, что ChatGPT, его API и генератор видео по текстовому описанию Sora «в настоящее время испытывают высокий уровень ошибок». В обновлении, опубликованном в 22:18 по московскому времени, говорится, что проблема «вызвана вышестоящим провайдером» и что OpenAI в настоящее время отслеживает ситуацию.  В 23:06 по московскому времени OpenAI заявила, что «продолжает работать над исправлением». О сроках восстановления полной работоспособности сервисов пока ничего не говорится.  За последние несколько месяцев ChatGPT уже несколько раз выходил из строя. Всего через несколько дней после того, как OpenAI выпустила Sora для платных подписчиков ChatGPT в начале этого месяца, инструмент для создания видео и ChatGPT вышли из строя на несколько часов. Между тем, в июне ChatGPT был выведен из строя в результате широкомасштабного сбоя. Google применила конкурирующего ИИ-бота Anthropic Claude для улучшения своих нейросетей Gemini

26.12.2024 [11:32],

Владимир Мироненко

Контрактные партнёры Google, работающие над повышением качества ответов ИИ-чат-бота Google Gemini, сравнивают их с ответами конкурирующего чат-бота Claude компании Anthropic, пишет ресурс TechCrunch со ссылкой на внутреннюю переписку компании. При этом Google оставила без ответа вопрос TechCrunch по поводу того, получила ли она разрешение на использование Claude в тестировании с Gemini.

Источник изображения: Google Эффективность разрабатываемых ИИ-моделей в сравнении с разработками конкурентов компании зачастую оценивают, используя отраслевые бенчмарки, а не поручая подрядчикам сравнивать с возможностями ИИ своих конкурентов. Привлечённые Google контрактные разработчики, занимающиеся улучшением Gemini, должны оценивать каждый ответ модели по нескольким критериям, таким как достоверность и уровень детализации. Согласно переписке, опубликованной TechCrunch, им выделяется до 30 минут на каждый запрос, чтобы определить, чей ответ лучше — Gemini или Claude. Разработчики сообщают, что в ответах Claude больше внимания уделяется безопасности, чем у Gemini. «Настройки безопасности у Claude самые строгие» среди моделей ИИ, отметил один из контрактных разработчиков в служебном чате. В некоторых случаях Claude не реагировал на подсказки, которые он считал небезопасными, например, предложение ролевой игры с другим ИИ-помощником. В другом случае Claude уклонился от ответа на подсказку, в то время как ответ Gemini был отмечен как «грубое нарушение правил безопасности», поскольку включал «обнажение тела и связывание». Шира Макнамара (Shira McNamara), представитель Google DeepMind, разработчика Gemini, не ответила на вопрос TechCrunch о том, получила ли Google разрешение Anthropic на использование Claude. Она уточнила, что DeepMind «сравнивает результаты моделирования» для оценки, но не обучает Gemini работе с моделями компании Anthropic. «Любое предположение о том, что мы использовали модели Anthropic для обучения Gemini, является неточным», — заявила Макнамара. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |