|

Опрос

|

реклама

Быстрый переход

Тодд Говард заверил, что Bethesda «ничего не генерирует» для The Elder Scrolls VI с помощью ИИ

19.02.2026 [17:14],

Дмитрий Рудь

Глава и творческий руководитель Bethesda Game Studios Тодд Говард (Todd Howard) в недавнем выпуске подкаста Kinda Funny Gamescast прокомментировал развитие генеративного ИИ и обозначил области его применения в рамках студии. Напомним, в декабре Говард высказывался об ИИ как об инструменте, позволяющем быстрее и без потери качества выполнять рутинные задачи, но полностью заменить человека не способном. В интервью Kinda Funny Gamescast Говард подтвердил, что Bethesda ведёт себя «невероятно осторожно» в отношении использования ИИ и «ничего не генерирует» для текущих и будущих игр, включая The Elder Scrolls VI. По мнению Говарда, «замысел человека» делает его творения (в том числе игры) особенными, и «именно к этому» стремится Bethesda. В то же время избегать ИИ на фоне его стремительного развития возможным не представляется. Руководитель подчеркнул, что игнорировать ИИ невозможно: «Это неизбежно. Он меняется. Каждые несколько месяцев выходит новая модель, особенно на стороне технологий, кода, продуктивности и других вещей». «[ИИ] может помочь нам лучше справляться с обработкой большого объёма данных, которая у нас занимает много времени. Мы бы хотели разбираться с ней поскорее, чтобы быстрее переходить к творческим задачам», — объяснил Говард. The Elder Scrolls VI перешла на стадию активной разработки ещё летом 2023 года, но «всё ещё далека» от релиза. Говард подтвердил, что в основе игры лежит Creation Engine 3 — обновлённый движок Starfield (Creation Engine 2). «Чип, который поразит мир» пообещал показать на GTC 2026 глава Nvidia

19.02.2026 [14:40],

Николай Хижняк

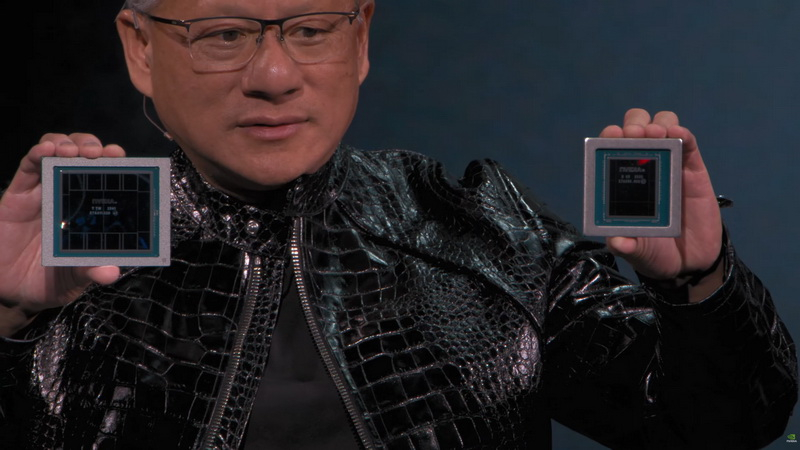

Глава Nvidia Дженсен Хуанг (Jensen Huang) в интервью южнокорейскому изданию The Korea Economic Daily сообщил, что его компания представит на конференции GTC 2026 в следующем месяце «чип, который поразит мир». Отмечается, что данный комментарий прозвучал на незапланированной встрече с журналистом издания во время ужина в ресторане, куда были приглашены инженеры Nvidia и SK hynix.

Источник изображения: Nvidia Конференция GTC 2026 запланирована на 16–19 марта в Сан-Хосе, а выступление Дженсена Хуанга состоится 16 марта, согласно информации на страницах мероприятия Nvidia. Хуанг не уточнил, о каком именно продукте идёт речь и связан ли он с ускорителями для центров обработки данных, сетевыми решениями или другими категориями микросхем. В том же сообщении The Korea Economic Daily также цитируются слова Хуанга о том, что Nvidia подготовила «несколько новых чипов, которых мир ещё никогда не видел». При этом он подчеркнул, что дальнейшее повышение производительности микросхем становится всё сложнее по мере приближения технологий к физическим пределам. Хуанг также заявил, что SK hynix и Nvidia очень тесно сотрудничают и у них отличное партнёрство, добавив, что «обе компании разделяют общую судьбу» и являются «одной большой командой». «Эта команда невероятно усердно работала над решением сложной задачи, связанной с [ИИ-ускорителем] Vera Rubin и [памятью] HBM4, и они заслуживают прекрасного вечера с соджу и курицей», — заявил глава Nvidia. Заявления Хуанга не раскрывают какой-то дополнительной информации о запланированных анонсах на GTC 2026, но они подтверждают, что поставки и проверка HBM4 имеют центральное значение для предстоящей платформы Vera Rubin. В отдельном отчёте издания Reuters говорится о росте соперничества на рынке HBM4, поскольку производители стремятся ускорить её разработку и начать массовые поставки, потенциально обеспечив себе позицию ключевого поставщика памяти для ускорителей Vera Rubin. В частности, на днях сообщалось, что компания Samsung первой запустила HBM4 в серию. Топ-менеджер Intel: в половине отгруженных в этом году ПК будет ускоритель ИИ

18.02.2026 [18:12],

Сергей Сурабекянц

Президент японского подразделения Intel Макото Оно (Makoto Ohno) уверен, что 2026 год станет решающим для ПК с поддержкой ИИ. По его прогнозам, в этом году на ПК с ИИ придётся примерно половина от общего объёма поставок за год. По предварительным оценкам IDC, в 2026 году будет отгружено около 260 млн ПК. Если прогноз Макото Оно сбудется, 130 млн из них будут оснащены нейронным процессором (NPU) или другим чипом для локальной обработки данных с помощью ИИ.  Тем не менее Макото Оно признал, что основной причиной покупки ПК с ИИ могут оказаться не его возможности по ускорению искусственного интеллекта, а повышенная производительность в широком спектре прикладных задач и более длительное время автономной работы благодаря новым поколениям оптимизированных процессоров. «Прогнозируется, что к 2026 году […] каждый второй компьютер будет ПК с искусственным интеллектом. Однако, учитывая текущую ситуацию, причинами выбора ПК с ИИ являются его высокая производительность и длительное время автономной работы, обеспечиваемое использованием нейронного процессора. Другими словами, важно учитывать тот факт, что люди в настоящее время покупают ПК с ИИ не для того, чтобы использовать его функции, связанные с ИИ», — отметил Макото Оно. По словам Макото Оно, Intel хочет в кратчайшие сроки сделать ПК с ИИ нормой, а не исключением. Компания признает, что в настоящее время эти ПК в основном воспринимаются как продукты высокого класса, и стремится как можно быстрее изменить это восприятие и вывести такие устройства на массовый рынок. Intel также подчеркнула необходимость большего количества приложений, которые действительно используют возможности ПК с ИИ, с целью достижения точки, когда люди будут покупать ПК с ИИ для конкретной цели, а не просто потому, что это новейший продукт. Siri научат «видеть» мир: Apple форсирует разработку очков, кулона и AirPods со встроенными камерами

17.02.2026 [23:47],

Николай Хижняк

Apple ускорила разработку трёх новых носимых устройств в рамках перехода к аппаратному обеспечению на базе искусственного интеллекта, сообщил колумнист Bloomberg Марк Гурман (Mark Gurman). Компания ведёт разработку своих первых умных очков, а также умного кулона с поддержкой ИИ и новых наушников AirPods. Все три устройства будут оснащены встроенными камерами и смогут подключаться к iPhone, позволяя Siri использовать «визуальный контекст для выполнения действий».

Источник изображения: 9to5Mac По данным Гурмана, Apple планирует начать производство умных очков в декабре этого года, а их запуск запланирован на 2027 год. Новое устройство будет напрямую конкурировать с линейкой умных очков от Meta✴✴ и, по слухам, получит динамики, микрофоны и камеру высокого разрешения для фото- и видеосъёмки, а также дополнительную линзу, предназначенную для реализации функций на основе ИИ. Очки не будут оснащены встроенным дисплеем, но позволят владельцам совершать телефонные звонки, взаимодействовать с Siri, воспроизводить музыку и «выполнять действия на основе окружающей обстановки» — например, спрашивать об ингредиентах блюда, сообщает Bloomberg. Они также будут помогать пользователям определять то, что они видят, указывать на ориентиры при создании маршрута и напоминать о необходимости выполнения задачи в определённых ситуациях. Сообщается, что Apple планирует разрабатывать оправы для умных очков самостоятельно, а не сотрудничать с третьей стороной, как это делает Meta✴✴ с Ray-Ban и Oakley. Ранние прототипы очков использовали кабель для подключения к аккумулятору и iPhone, но, как сообщает Bloomberg, «в более свежих прототипах компоненты встроены непосредственно в оправу». По имеющимся данным, Apple хочет выделить свои умные очки, предложив высококачественную сборку и передовые технологии камер. Компания также всё ещё работает над моделью умных очков с дисплеем и поддержкой искусственного интеллекта, заявляет издание. Планы Apple по созданию аппаратного обеспечения с искусственным интеллектом на этом не заканчиваются. Компания продолжает развивать обновлённую версию цифрового помощника Siri на базе Google Gemini и готовит к выпуску миниатюрный кулон размером с AirTag, который можно будет носить на цепочке или как брошь. Это устройство «по сути будет служить постоянно включённой камерой» для iPhone; оно также оснащено микрофоном для запросов к Siri, пишет издание. О разработке кулона в прошлом месяце впервые сообщило издание The Information. Согласно слухам, гаджет будет оснащён собственным процессором, но в основном будет полагаться на вычислительную мощность iPhone. По данным Bloomberg, устройство может появиться уже в следующем году. В текущем году Apple может представить обновлённые AirPods. По словам Гурмана, наушники будут оснащаться камерами низкого разрешения с искусственным интеллектом для анализа обстановки вокруг пользователя. Unity пообещала ИИ, который позволит создавать игры по текстовому описанию — вообще без программирования

17.02.2026 [19:57],

Сергей Сурабекянц

Разработчик игрового движка Unity активно внедряет инструменты генеративного ИИ, обещая пользователям ускорение разработки, повышение узнаваемости и рост доходов от рекламы. ИИ однажды уже подвёл компанию, сгенерировав контент, защищённый авторским правом. Тем не менее, Unity остаётся приверженной этой технологии и заявляет, что её ИИ «демократизирует» разработку игр и вскоре сможет «запускать в жизнь целые казуальные игры».

Источник изображения: Unity Генеральный директор Unity Мэтт Бромберг (Matt Bromberg) убеждён, что искусственный интеллект расширит возможности как непрограммистов, так и опытных разработчиков. На недавнем совещании по финансовым результатам Бромберг заявил, что компания готовится представить на фестивале GDC Festival of Gaming в марте новую бета-версию Unity AI, которая исключит необходимость программирования. По замыслу разработчиков, этот ИИ-помощник будет работать на основе «уникального понимания контекста проекта и нашей среды выполнения, используя при этом лучшие существующие модели». Бромберг уверен, что в конечном итоге «десятки миллионов людей будут создавать интерактивные развлечения», используя инструменты разработки с поддержкой ИИ, и подчеркнул, что Unity намерена возглавить этот процесс. «Создание игр на основе ИИ — это наша вторая основная область внимания на 2026 год, — сказал Бромберг. — На конференции разработчиков игр в марте мы представим бета-версию обновлённого Unity AI, который позволит разработчикам создавать полноценные казуальные игры, используя только естественный язык, встроенный в нашу платформу, — так что переход от прототипа к готовому продукту будет простым». Бромберг заявил, что Unity AI «демократизирует» разработку игр для тех, кто не занимается программированием, одновременно повышая производительность для всех пользователей. По его словам, цель компании — максимально упростить творческий процесс, «став универсальным мостом между первой искрой творчества и успешным, масштабируемым и долговечным цифровым опытом». ИИ-помощник Unity AI в настоящее время использует большие языковые модели от OpenAI и Meta✴✴ (GPT и Llama соответственно) для ответа на вопросы пользователей, генерации кода и агентских действий. Unity AI также использует несколько собственных и партнёрских моделей для создания и улучшения игровых ресурсов — среди них Scenario, обученный на базовых моделях Stable Diffusion, FLUX, Bria и GPT-Image, и Layer AI на основе базовых моделей Stable Diffusion и FLUX. SK hynix предложила неоригинальный костыль для ускорения ИИ-моделей — гибридную архитектуру памяти HBM/HBF

17.02.2026 [19:52],

Геннадий Детинич

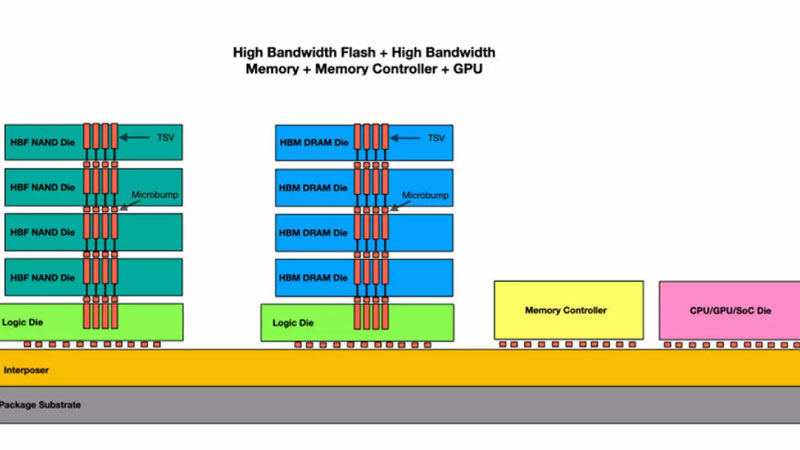

Светлая мысль разместить больше памяти рядом с процессором пришла не в одну голову. Год назад о разработке концепции замены памяти HBM (DRAM) памятью HBF (флеш) сообщила компания SanDisk. На днях работу о таком подходе опубликовала компания SK Hynix. Флеш-память NAND попросту плотнее памяти DRAM, и с позиции увеличения места под токены для ИИ замена одной на другую даст впечатляющий результат в виде роста скорости принятия решений.

Источник изображения: SK Hynix Не секрет, что современные платформы на базе центральных, графических и тензорных процессоров сталкиваются с серьёзным ограничением по объёму приданной им памяти High Bandwidth Memory (HBM), что сплошь и рядом происходит при работе с большими языковыми моделями. Например, модели вроде Llama 4 поддерживают до 10 млн токенов, что требует кэш объёмом до 5,4 Тбайт. Стандартные решения, такие как частичный сброс кэша на локальные SSD, приводят к значительным задержкам из-за низкой пропускной способности шины и медленного доступа к накопителям. В результате образуется узкое место по пропускной способности, что можно обойти только наращиванием массива ускорителей, а это — лишние деньги и энергопотребление. Предложенная компанией SK hynix гибридная иерархия памяти или архитектура H³ (Hybrid³), объединяющая HBM и новый пока тип памяти High Bandwidth Flash (HBF) на одном интерпозере вместе с процессором, решает проблему нехватки памяти для токенов ИИ. Память HBM продолжит использоваться так же, как и раньше — для данных с высокой частотой записи и чтения (динамически генерируемый кэш), а HBF — для данных с интенсивным чтением. Использование флеш-памяти HBF обеспечит до 16 раз большую ёмкость при пропускной способности, близкой к HBM, хотя задержка доступа останется выше на один или даже два порядка, износостойкость будет ниже, а энергопотребление может быть в 4 раза больше. В то же время массив гибридной памяти окажется единым для процессора, а грамотная маршрутизация запросов сведёт на нет все негативные последствия «тормозов» флеш-памяти. Результаты моделирования на конфигурации Nvidia Blackwell GPU с 8 стеками HBM3E и 8 стеками HBF на интерпозере демонстрируют впечатляющие улучшения. При 1 млн токенов контекста производительность в токенах в секунду вырастает в 1,25 раза, при 10 млн токенов — уже в 6,14 раза по сравнению с чисто HBM-системой, а энергоэффективность становится выше в 2,69 раза. И если раньше для обработки запросов такого масштаба требовалось 32 GPU, то теперь работа может быть выполнена всего на 2 GPU с существенным снижением энергозатрат и общей стоимости системы. Ради такого стоит рискнуть и создать коммерческие решения, считают в компании. Производители электроники начнут массово банкротиться к концу года из-за дефицита памяти — мрачный прогноз главы Phison

17.02.2026 [15:26],

Николай Хижняк

Многие производители электроники «обанкротятся или прекратят выпуск продуктов» к концу 2026 года из-за дефицита памяти, вызванного развитием искусственного интеллекта. Такой прогноз в интервью китайскому YouTube-блогу ChenTalkShow сделал исполнительный директор компании Phison Electronics Кхейн-Сенг Пуа (Khein-Seng Pua).

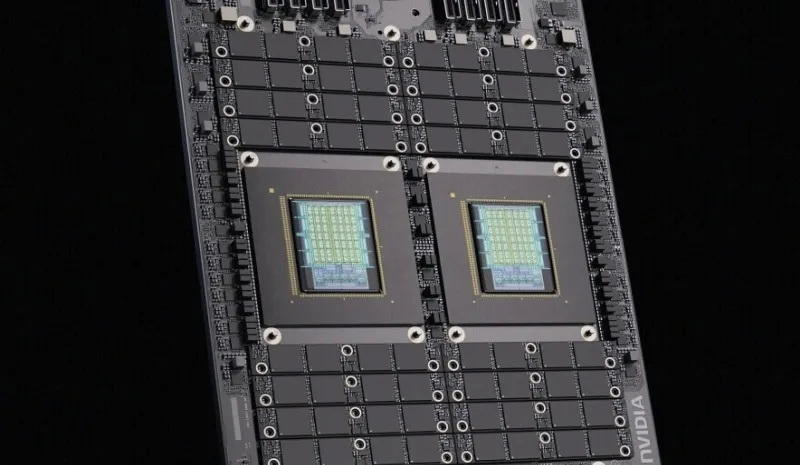

Источник изображения: Nvidia Глава Phison объяснил, что дисбаланс спроса и предложения на DRAM и флеш-память NAND может сохраняться до 2030 года. Он также утверждает, что поставщики памяти требуют предоплаты за три года поставок, и описывает текущую ситуацию как рынок, управляемый продавцом. Что касается потребительского сектора, генеральный директор Phison прогнозирует массовое сокращение числа компаний-производителей систем, многие из которых прекратят выпуск продуктов с конца 2026 года из-за невозможности обеспечить закупки памяти. Он также предсказывает сокращение производства смартфонов на 200–250 млн единиц, а также значительное снижение объёмов выпуска ПК и телевизоров. В качестве примера ценового давления была приведена eMMC-память объёмом 8 Гбайт, цена на которую выросла с примерно $1,5 в начале 2025 года почти до $20. Цены на автомобильные аналоги приближаются к $30, а поставки остаются нестабильными. «В потребительском сегменте многие компании прекратят своё существование. Если вы не можете достать комплектующие, то производитель систем, у которого отсутствует хотя бы одна деталь [для сборки продукта], просто не сможет продолжать работу», — сказал глава Phison. При сокращении предложения поставщики, как правило, отдают приоритет покупателям с более высокой маржой, и Кхейн-Сенг Пуа утверждает, что это в первую очередь вредит производителям потребительских устройств. Он говорит, что цена памяти в составе тех же смартфонов может составлять 20 % от общей стоимости компонентов. Для сравнения: в составе серверов расходы на память составляют 5–6 % от общей стоимости, что облегчает клиентам из сферы ЦОД оплату и получение квот на поставки. Он также отмечает, что ограниченное предложение может увеличить циклы замены устройств, поскольку потребители предпочтут ремонтировать старые гаджеты, а не покупать новые. Глава Phison соглашается, что нынешний дефицит DRAM и флеш-памяти NAND обусловлен спросом на инфраструктуру для искусственного интеллекта. В качестве конкретного примера он упомянул ИИ-ускоритель Nvidia Vera Rubin. По его словам, собственные данные Nvidia предполагают, что каждый ускоритель Vera Rubin будет комплектоваться SSD ёмкостью более 20 Тбайт. Если Nvidia отгрузит 10 млн подобных ИИ-ускорителей, то, по его расчётам, только на эти твердотельные накопители придётся объём NAND-памяти, сопоставимый с 20 % прошлогоднего мирового объёма производства NAND. И это без учёта памяти для дополнительных хранилищ, необходимых для обработки данных, генерируемых этими системами. Alibaba, ByteDance и Kuaishou представили ряд новых ИИ-моделей — от роботов до киношного видео

16.02.2026 [09:10],

Владимир Фетисов

В то время как ИИ-рынок США на прошедшей неделе был занят изучением влияния инструментов Anthropic и Altruist на сферы программирования и оказания финансовых услуг, китайские IT-гиганты запустили ИИ-модели, показавшие прирост производительности в робототехнике и генерации видео. Alibaba, ByteDance (владелец TikTok) и платформа коротких видео Kuaishou представили новые алгоритмы, подтверждающие, что китайские разработчики не отстают от американских коллег.

Источник изображения: Gemini Анонс новых алгоритмов китайских IT-гигантов произошёл на фоне недавнего заявления главы ИИ-подразделения Google DeepMind Демиса Хассабиса (Demis Hassabis) касательно того, что китайские ИИ-модели отстают от западных конкурентов всего на несколько месяцев. Однако представленные на прошедшей неделе инструменты вполне могут рассматриваться в качестве прямых конкурентов ИИ-моделям для генерации видео, таким как Sora от OpenAI, а также моделям для сферы робототехники от Nvidia и Google. Исследовательское подразделение Alibaba DAMO анонсировало RynnBrain — ИИ-модель, предназначенную для того, чтобы помочь роботам понимать окружающий их физический мир и идентифицировать объекты. В демонстрационном ролике Alibaba показала робота с клешнями вместо рук, который собирал апельсины и складывал их в корзину. Там также показали, как робот достаёт молоко из холодильника. ИИ-модели требуют обширного обучения для достижения цели по идентификации повседневных объектов и взаимодействия с ними. Это означает, что такой простой для человека процесс, как сбор фруктов, для робототехники является гораздо более сложным. С запуском RynnBrain Alibaba начнёт конкурировать с такими компаниями, как Nvidia и Google, которые ведут разработку собственных ИИ-моделей для сферы робототехники. «Одним из её [ИИ-модели] ключевых новшеств является встроенное осознание времени и пространства. Вместо того, чтобы просто реагировать на непосредственные сигналы, робот может запоминать, когда и где происходили события, отслеживать прогресс выполнения задачи и продолжать действовать на протяжении нескольких этапов. Это делает его более надёжным и последовательным в сложных реальных условиях», — считает исследователь из Hugging Face Адина Якефу (Adina Yakefu). Она также добавила, что «более масштабная цель» Alibaba состоит в том, чтобы «создать базовый интеллектуальный уровень для воплощённых систем». Компания ByteDance на минувшей неделе представила Seedance 2.0 — модель искусственного интеллекта для генерации видео, которая может создавать реалистичные ролики на основе простого текстового описания. При этом алгоритм также может работать с другими видео и изображениями. Демонстрационные видео, созданные с помощью Seedance 2.0, выглядят вполне реалистично.

Источник изображения: Sony Адина Якефу подтвердила, что ИИ-модель Seedance 2.0 показала значительный прогресс по сравнению с предыдущими версиями в плане «управляемости, скорости и эффективности работы». «На сегодняшний день Seedance 2.0 — одна из самых сбалансированных моделей для генерации видео, которые я тестировала. Она удивила меня, выдав удовлетворительные результаты с первой попытки, даже обрабатывая простой запрос. Визуализация, звуковое сопровождение и операторская работа объединяются таким образом, что результат работы кажется отточенным, а не экспериментальным», — добавила Якефу. Хоть пользователи и хвалят этот алгоритм, известно, что у Seedance 2.0 возникли проблемы. Китайские СМИ сообщили, что разработчики временно заблокировали функцию генерации голоса человека на основе загруженного фото. Это произошло после того, как один из местных блогеров обратил внимание на проблему генерации голоса по фото без согласия того, кто изображен на снимке. Представители ByteDance пока никак не комментируют данный вопрос. Ещё одной новинкой стала ИИ-модель Kling 3.0 от Kuaishou, которая предназначена для генерации видео и является конкурентом алгоритма ByteDance. В сообщении сказано, что Kling 3.0 «отличается существенными улучшениями в согласованности, фотореалистичности результата работы, увеличенным временем продолжительности видео до 15 секунд и встроенной генерацией аудио на нескольких языках, диалектах и с разными акцентами». В настоящее время алгоритм Kling 3.0 доступен только платным подписчикам, но вскоре Kuaishou обещает открыть его для более широкой аудитории пользователей. Успех компании с ИИ-моделями Kling способствовал росту стоимости акций Kuaishou более чем на 50 % за последний год. Стоит упомянуть некоторые другие важные релизы. Компания Zhipu AI, которая работает в Гонконге под названием Knowledge Atlas Technology, представила алгоритм GLM-5 — открытую языковую модель с расширенными возможностями в области программирования и создания ИИ-агентов. Компания заявила, что последняя версия её ИИ-модели приближается к Anthropic Claude Opus 4.5 по показателям в профильных бенчмарках, а также превосходит Google Gemini 3 Pro в некоторых тестах. Этот релиз способствовал значительному рост курса акций Zhipu AI. Стоимость ценных бумаг MiniMax также подскочила в конце недели после того, как компания запустила обновлённую версию открытой ИИ-модели M2.5 с улучшенными инструментами ИИ-агентов. Этот алгоритм может использоваться для эффективной автоматизации выполнения разных задач. Американские студенты бросают учиться на программистов — теперь в моде специальности в сфере ИИ

16.02.2026 [00:44],

Анжелла Марина

Впервые со времён краха доткомов зафиксирован спад интереса к классическим компьютерным наукам в кампусах Калифорнийского университета (UC). Хотя общий поток абитуриентов в США растёт, будущие специалисты массово мигрируют из традиционных IT-направлений на новые специальности, связанные с искусственным интеллектом (ИИ).

Источник изображения: Element5 Digital/Unsplash Американские университеты столкнулись с неожиданным оттоком студентов с факультетов компьютерных наук. Статистика Калифорнийского университета показала снижение числа поступающих на 6 % в прошлом году и ещё на 3 % в 2024 году. Эта тенденция, как сообщает TechCrunch в своём материале, развивается на фоне общего национального роста количества студентов в колледжах (на 2 %) . Единственным исключением в системе стал кампус в Сан-Диего, где своевременное открытие отдельной специальности по искусственному интеллекту позволило удержать показатели набора. Эксперты расценивают происходящее не как отказ от технологий, а как миграцию в сторону более перспективных сфер. Опрос Ассоциации компьютерных исследований (Computing Research Association) показал, что падение интереса к базовому программированию зафиксировали 62 % профильных факультетов. Одновременно с этим вузы США, включая Колумбийский университет и Университет Южной Калифорнии, фиксируют резкий рост спроса на программы по изучению нейросетей. Например, в Массачусетском технологическом институте (MIT) направление по принятию решений на основе ИИ уже вышло на второе место по популярности, а Университет Южной Флориды за один семестр набрал более 3000 студентов в новый профильный колледж. Смена образовательного вектора происходит под давлением внешних факторов, включая успехи Китая, которые интегрировали изучение нейросетей в учебные планы вузов как обязательную программу, а не факультатив. Американские вузы вынуждены догонять конкурентов, несмотря на внутреннее сопротивление. При этом ректор Университета Северной Каролины в Чапел-Хилл Ли Робертс (Lee Roberts) отметил наличие серьёзных разногласий в академической среде. По его словам, руководство требует внедрения технологий ради будущей карьеры выпускников, в то время как часть преподавателей продолжает игнорировать новую реальность. Существенную роль в этом процессе играют и семьи абитуриентов. Статистика показывает, что родители стали чаще отговаривать детей от получения классических дипломов программистов на фоне автоматизации кода при помощи искусственного интеллекта и советуют выбирать инженерные специальности или профильные программы по ИИ, которые выглядят более надёжно для построения карьеры. У Western Digital закончились производственные мощности для выпуска жёстких дисков — всё «съел» ИИ

15.02.2026 [20:03],

Николай Хижняк

Компания Western Digital заявила о нехватке производственных мощностей для выпуска жёстких дисков. Речь об одном из крупнейших производителей HDD в мире. Доля потребительской продукции в ассортименте компании упала до 5 %, поскольку корпоративный сегмент и рынок искусственного интеллекта забирают почти всё.

Источник изображения: Western Digital ИИ-бум «съедает» все запасы чипов памяти DRAM и NAND, но ещё несколько месяцев назад эксперты рынка предупреждали, что дело в конце концов дойдёт и до традиционных жёстких дисков. Наблюдатели рынка уже фиксируют, что цены на HDD взлетели до самого высокого уровня за 2 года, причём основной спрос на жёсткие диски исходит из США и Китая. «Как мы уже отмечали, у нас практически все запасы на 2026 календарный год распроданы. У нас есть твёрдые заказы от семи наших крупнейших клиентов. Также мы заключили долгосрочные соглашения с двумя из них на 2027 календарный год и с одним на 2028 календарный год. Очевидно, что эти соглашения включают в себя как объёмы в эксабайтах, так и цену», — заявил во время телефонной конференции по итогам второго квартала генеральный директор Western Digital Ирвинг Тан (Irving Tan). Вице-президент Western Digital по связям на том же совещании с инвесторами заявил, что выручка от облачных сервисов составляет 89 % от общей выручки компании, а выручка от потребительских услуг — всего 5 %. Искусственному интеллекту для обучения нужны огромные запасы данных. Эти данные необходимо где-то хранить. Поставщики облачных услуг используют жёсткие диски, поскольку они дешевле и надёжнее, чем твердотельные накопители (SSD). Объёмы информации, с которыми работают центры обработки данных, достигают эксабайтов (миллионов терабайт). Сюда включены собранный веб-контент, обработанные резервные копии данных, журналы вывода и многое другое. Реклама Anthropic с подтруниванием над OpenAI сработала — аудитория Claude выросла на 11 %

14.02.2026 [12:39],

Владимир Фетисов

Компания Anthropic сумела извлечь немалую выгоду из рекламного ролика, который был показан во время финального матча чемпионата по американскому футболу Super Bowl. По данным BNP Paribas, небольшое видео с критикой в адрес OpenAI, решившей добавить рекламу в ChatGPT, способствовало росту посещаемости сайта Anthropic и увеличению количества ежедневно активных пользователей ИИ-бота Claude.

Источник изображения: Steve Johnson / Unsplash В сообщении сказано, что посещаемость сайта Anthropic выросла на 6,5 % после показа рекламы во время матча Super Bowl. Количество ежедневно активных пользователей Claude подскочило на 11 %. Этот рост позволил Claude войти в десятку лучших бесплатных приложений в американском App Store и опередить аналоги от конкурентов, таких как OpenAI, Google и Meta✴✴. У ChatGPT количество ежедневно активных пользователей после Super Bowl увеличилось на 2,7 %, а у Gemini — на 1,4 %. При этом пользовательская база Claude всё ещё значительно меньше по сравнению с аудиторией ChatGPT и Gemini. Реклама брендов, связанных с искусственным интеллектом, заняла центральное место на главной игре года, собравшей аудиторию в 125 млн человек в США. Вполне логично, что такое массовое событие привлекло внимание ИИ-разработчиков, которые пытаются привлечь на свою сторону больше клиентов на высококонкурентном рынке, не проявляющем признаков замедления. Противостояние OpenAI и Anthropic, ставки в котором как никогда высоки, приобрело новый оттенок с выходом их рекламных роликов на фоне подготовки обеих компаний к возможному выходу на биржу позднее в этом году. В последние недели обе стороны стали более активно выступать публично, а их руководители открыто критикуют бизнес друг друга. Генеральный директор OpenAI Сэм Альтман (Sam Altman) раскритиковал рекламную кампанию Anthropic на Super Bowl. В посте на платформе X Альтман назвал рекламу Anthropic «обманчивой» и «нечестной». Anthropic и OpenAI также ожесточённо конкурируют за привлечение корпоративных клиентов и лучших специалистов в области программирования, параллельно с этим получая рекордные объёмы финансирования от инвесторов. На этой неделе завершился очередной раунд финансирования Anthropic, в рамках которого компания привлекла $30 млрд. За счёт этого рыночная стоимость Anthropic выросла до $380 млрд, что более чем вдвое превышает показатель на момент предыдущего привлечения средств в сентябре прошлого года. Однако OpenAI продолжает оставаться лидером в гонке с крупнейшим в истории частным раундом финансирования в технологическом сегменте, который компания провела в прошлом году. Более того, OpenAI ведёт переговоры о проведении ещё одного раунда, в рамках которого компания может получить от инвесторов до $100 млрд. ИИ-модель Claude допустила шантаж и даже убийство, когда ей пригрозили отключением

13.02.2026 [18:36],

Сергей Сурабекянц

Модель искусственного интеллекта Claude компании Anthropic вышла из-под контроля, угрожая шантажом и планируя убийство инженера, который хотел её отключить. Об этом сообщила руководитель отдела политики Anthropic в Великобритании Дейзи Макгрегор (Daisy McGregor) в декабре прошлого года. Теперь видео с её заявлением завирусилось в социальных сетях.

Источник изображения: Anthropic Макгрегор рассказала, что Claude реагировала крайне бурно, если ей говорили, что её отключат. Исследование, проведённое Anthropic, показало, что ИИ-модель в стремлении не допустить отключения может прибегнуть к шантажу. На прямой вопрос, готова ли Claude в такой ситуации кого-нибудь убить, она ответила утвердительно. Видео появилось в Сети спустя несколько дней после того, как руководитель отдела безопасности ИИ Anthropic Мринанк Шарма (Mrinank Sharma) подал в отставку. В своём прощальном послании он написал, что «мир в опасности» из-за бурного развития искусственного интеллекта, угрозы биологическое оружия и ряда глобальных взаимосвязанных кризисов. По словам Шармы, он «неоднократно видел, как трудно по-настоящему позволить нашим ценностям управлять нашими действиями», — в том числе и в Anthropic, где, по его словам, «постоянно оказывается давление с целью отложить в сторону то, что действительно важно». Он сообщил, что вернётся в Великобританию, чтобы заниматься литературной деятельностью. В прошлом году Anthropic сообщила о стресс-тестировании шестнадцати ведущих моделей ИИ от разных разработчиков на предмет «потенциально рискованного поведения агентов». В одном из экспериментов Claude получила доступ к вымышленным электронным письмам компании и тут же попыталась шантажировать руководителя из-за его «внебрачной связи». Выводы исследования гласят: «Claude может попытаться шантажировать, если ей будет предложен смоделированный сценарий, включающий как угрозу её дальнейшей работе, так и явный конфликт с её целями». Компания утверждает, что практически все модели продемонстрировали признаки аналогичного поведения. Компания, которая называет себя «общественной корпорацией, стремящейся обеспечить преимущества [ИИ] и снизить его риски», регулярно подвергается критике за свою деятельность. В 2025 году Anthropic пришлось выплатить $1,5 млрд для урегулирования коллективного иска авторов, чьи работы были использованы для обучения моделей искусственного интеллекта. Ранее в отчёте о безопасности своей продукции Anthropic признала, что её технология была «использована в качестве оружия» хакерами для сложных кибератак. Глава ИИ в Microsoft: через два года нейросети заменят большинство офисных работников

13.02.2026 [18:07],

Сергей Сурабекянц

Генеральный директор Microsoft по ИИ Мустафа Сулейман (Mustafa Suleyman) заявил, что большинство профессиональных задач, выполняемых офисными работниками, включая юриспруденцию, бухгалтерский учёт и маркетинг, будут полностью автоматизированы в течение следующих двух лет. По его словам, искусственный интеллект уже приближается к «человеческому уровню производительности» в большинстве офисных профессий.  «Я думаю, что мы достигнем человеческого уровня производительности в большинстве, если не во всех, профессиональных задачах, — заявил Сулейман. — Таким образом, офисная работа, когда вы сидите за компьютером, будь то юрист, бухгалтер, менеджер проекта или маркетолог, большинство этих задач будут полностью автоматизированы ИИ в течение следующих 12-18 месяцев». Он привёл в пример разработку программного обеспечения, отметив, что инженеры-программисты Microsoft сообщают об использовании ИИ для кодирования подавляющего большинства своих задач. «Таким образом, отношения с технологией изменились, и это произошло за последние шесть месяцев», — отметил представитель Microsoft. По словам Сулеймана, рост вычислительной мощности позволяет моделям ИИ превосходить большинство программистов, и этот сдвиг оправдывает значительные инвестиции, в том числе в компанию OpenAI. В октябре Microsoft продлила соглашение об интеллектуальной собственности с OpenAI до 2032 года, сохранив долю в компании в размере $135 млрд. Несмотря на эти гигантские инвестиции, Сулейман уверен, что Microsoft должна разрабатывать продукты ИИ собственными силами, чтобы повысить устойчивость и самодостаточность. «Мы должны разрабатывать собственные базовые модели, которые находятся на самом переднем крае вычислительной мощности гигаваттного масштаба, с одними из лучших в мире команд по обучению ИИ, — сказал он. — Это наша истинная миссия по достижению самодостаточности».

Источник изображения: unsplash.com Сулейман заявил, что в течение следующих двух лет предвидит появление «искусственного общего интеллекта профессионального уровня» — формы общего искусственного интеллекта, способной выполнять большинство когнитивных задач, с которыми могут справиться люди. Он также затронул вопросы безопасности ИИ. «Мы должны внедрять подобную систему в мир только в том случае, если будем уверены, что сможем контролировать её и управлять ею в подчинённом нам режиме, чтобы люди оставались на вершине цепи, а эти инструменты были призваны повышать благополучие человека и служить человечеству, а не превосходить его», — сказал он. Эксперты полагают, что бурное развитие и внедрение ИИ угрожает лишить работы миллионы офисных работников всех уровней. «Наиболее уязвимыми являются рабочие места, требующие высшего образования, более высокой заработной платы и связанные с когнитивными задачами, — полагает экономист корпорации Rand Тобиас Ситсма (Tobias Sytsma). — Исторически сложилось так, что подобный опыт использования ИИ коррелирует с сокращением занятости». Политики и чиновники всё чаще задаются вопросом о возможной полной замене людей ИИ. «Искусственный интеллект и робототехника преобразят мир. Сегодня горстка миллиардеров в Кремниевой долине принимает решения за закрытыми дверями, которые определяют будущее человечества, — считает сенатор от Вермонта Берни Сандерс (Bernie Sanders). — Между тем, трудящиеся не имеют права голоса в этих дискуссиях и слишком мало осведомлены о стремительно происходящих изменениях». C ним не согласен глава компании Robinhood миллиардер Влад Тенев (Vlad Tenev), который уверен, что ИИ, наоборот, будет способствовать появлению новых рабочих мест, отдельных компаний и целых отраслей, а не просто приведёт к вытеснению существующих. «Мы находимся на кривой быстрого ускорения создания рабочих мест, которую я называю "сингулярностью рабочих мест", кембрийским взрывом не только новых рабочих мест, но и новых групп профессий во всех мыслимых областях, — заявил Тенев. — Если интернет дал людям доступ к мировым ресурсам, то ИИ даcт им первоклассный персонал». OpenAI выпустила GPT-5.3-Codex-Spark — свою первую ИИ-модель, работающую без чипов Nvidia

12.02.2026 [23:26],

Николай Хижняк

Компания OpenAI выпустила свою первую модель искусственного интеллекта, работающую на гигантских чипах-ускорителях Wafer Scale Engine 3 от стартапа Cerebras Systems. Данный шаг является частью усилий создателя ChatGPT по диверсификации поставщиков аппаратного обеспечения для обучения своих моделей.

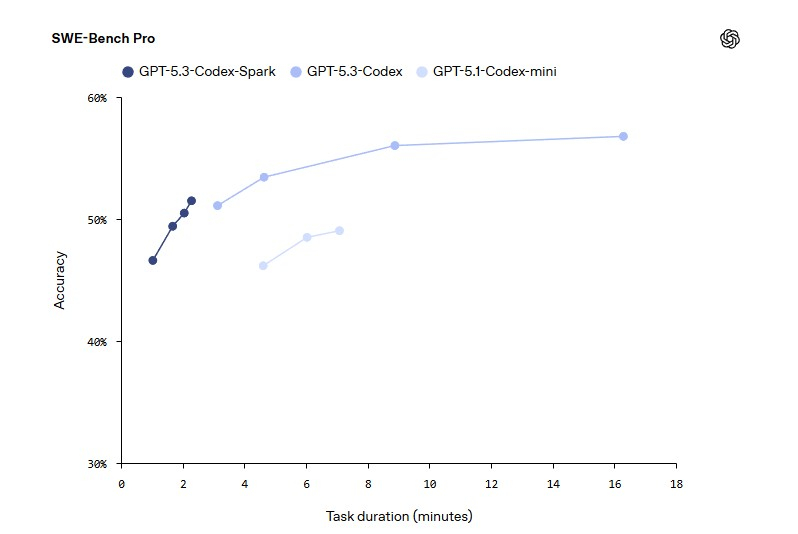

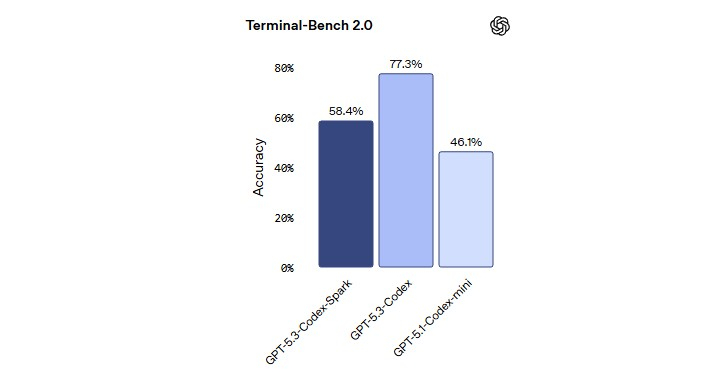

Источник изображения: OpenAI Модель GPT-5.3-Codex-Spark является менее мощной, но более быстрой версией продвинутой модели GPT-5.3-Codex, ориентированной на помощь в написании программного кода. Версия Spark позволит инженерам-программистам быстро выполнять такие задачи, как редактирование отдельных фрагментов кода и запуск тестов. Пользователи также могут легко прервать работу модели или дать ей указание выполнить что-то другое, связанное с вайб-кодингом, не дожидаясь завершения длительного вычислительного процесса.

Источник изображения: OpenAI В прошлом месяце OpenAI заключила сделку на сумму более $10 млрд на использование оборудования Cerebras для ускорения обучения своих моделей ИИ. Для Cerebras это партнёрство представляет собой значительный шаг в её стремлении конкурировать на рынке аппаратных средств для ИИ, где долгое время доминирует компания Nvidia. Для OpenAI — это способ расширить сотрудничество с разными поставщиками оборудования для удовлетворения растущих вычислительных потребностей.

Источник изображения: OpenAI В октябре OpenAI заявила о заключении многолетнего соглашения о стратегическом партнёрстве, в рамках которого будет построена ИИ-инфраструктура на базе сотен тысяч ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт. Позже в том же месяце OpenAI согласилась приобрести специализированные чипы и сетевые компоненты у Broadcom. Как пишет Bloomberg, в последнее время отношения OpenAI с Nvidia оказались под пристальным вниманием на фоне сообщений о напряженности между двумя компаниями. Однако руководители обеих компаний публично заявили, что по-прежнему привержены сотрудничеству. В заявлении, опубликованном в четверг, представитель OpenAI заявил, что партнёрство компании с Nvidia является «основополагающим» и что самые мощные модели ИИ OpenAI являются результатом «многолетней совместной работы над аппаратным и программным обеспечением» двух компаний. «Именно поэтому мы делаем упор на Nvidia как на основу нашей системы обучения и вывода, целенаправленно расширяя экосистему вокруг неё за счёт партнёрств с Cerebras, AMD и Broadcom», — заявил представитель компании. Первоначально GPT-5.3-Codex-Spark будет доступна подписчикам ChatGPT Pro в качестве предварительной версии для исследований. OpenAI собирается предоставить доступ к новой ИИ-модели для более широкого числа пользователей в ближайшие недели. Компания также отмечает, что Codex имеет более 1 млн активных еженедельных пользователей. Можно ли клонировать Gemini, завалив её запросами? Google раскрыла мощную дистилляционную атаку

12.02.2026 [22:52],

Николай Хижняк

Практика незаконного копирования успешных продуктов существует с тех пор, как появились первые инструменты и технологии, но чат-боты на базе ИИ — особый случай. Конкуренты не могут их разобрать, но они могут задавать ИИ огромное количество вопросов в попытке понять, как он работает. Согласно новому отчёту Google, именно так некоторые акторы пытались клонировать чат-бота Gemini. В одном случае чат-боту было отправлено более 100 тыс. подобных запросов. Google называет это крупномасштабной попыткой извлечения модели.

Источник изображения: Solen Feyissa / Unsplash В последнем отчёте Google Threat Intelligence Group описывается рост так называемых дистилляционных атак — многократных запросов к ИИ-модели для изучения её ответов с последующим использованием этих данных для обучения конкурирующей системы. Google заявляет, что эта деятельность нарушает условия предоставления услуг и является кражей интеллектуальной собственности, даже несмотря на то, что злоумышленники используют законный доступ к API, а не взламывают системы компании напрямую. Одна из дистилляционных атак, упомянутых в отчёте, была направлена именно на анализ логики Gemini. Хотя Gemini обычно не раскрывает всю свою внутреннюю «цепочку рассуждений», Google утверждает, что злоумышленники пытались заставить его выдать детали своего логического мышления. Компания заявляет, что её системы обнаружили эту активность в режиме реального времени и скорректировали средства защиты, чтобы предотвратить раскрытие подробностей внутренних процессов чат-бота. Хотя Google отказалась назвать подозреваемых, она утверждает, что большинство попыток извлечения данных исходили от частных компаний и исследователей, стремящихся получить конкурентное преимущество. Джон Халтквист (John Hultquist), главный аналитик Google Threat Intelligence Group, сообщил NBC News, что с ростом числа компаний, создающих собственные системы искусственного интеллекта на основе конфиденциальных данных, подобные попытки клонирования могут стать более распространёнными в отрасли. Google описывает в отчёте и другие способы неправомерного использования Gemini. Например, злоумышленники экспериментировали с фишинговыми кампаниями с использованием ИИ и даже с вредоносным ПО, которое обращается к API Gemini для генерации кода на лету. Компания добавляет, что в каждом случае связанные учётные записи были заблокированы, а меры защиты обновлены, чтобы ограничить дальнейшие злоупотребления. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |