|

Опрос

|

реклама

Быстрый переход

Metacritic удалил обзор Resident Evil Requiem от уважаемого игрового сайта — новая администрация заменила авторов на ИИ

26.02.2026 [23:27],

Дмитрий Рудь

Администрация агрегатора рецензий Metacritic удалила со страницы экшен-хоррора Resident Evil Requiem обзор от уважаемого британского сайта Videogamer, потому что материал был не написан человеком, а сгенерирован ИИ. Обозреватель Videogamer Брайан Мерриголд (Brian Merrygold) оценил Resident Evil Requiem на 9 из 10 баллов. Рецензия попала в рейтинг на Metacritic, однако читатели быстро заметили, что с публикацией что-то не так. По мнению пользователей, текст Мерриголда «отдаёт ИИ», а сам автор, «опытный аналитик в сфере iGaming (азартные игры онлайн — прим.) и спортивных ставок», похоже, является вымышленным персонажем с ИИ-аватаром. Сооснователь Metacritic Марк Дойл (Marc Doyle) в разговоре с Kotaku подтвердил, что обзор Resident Evil Requiem и ещё несколько рецензий от Videogamer за 2026 год были удалены с агрегатора после проверки на ИИ-материалы. Стоит отметить, что владельцем Videogamer с недавних пор является рекламное агентство Clickout, охватывающее, в том числе, сферу азартных игр. Под его началом портал начал рассказывать не только о видеоиграх, но и о казино. По данным Kotaku, в азартном разделе Videogamer сгенерированные ИИ материалы начали появляться ещё осенью 2025 года, а в видеоигровой проникли с увольнением последних настоящих журналистов на прошлой неделе. С тех пор Videogamer начал выпускать созданные «ИИ-авторами» с помощью ИИ игровые новости, специальные материалы и обзоры. Тем временем профили старых авторов были заменены поддельными ИИ-аккаунтами. Google представила Nano Banana 2 — обновлённый генератор изображений работает быстрее и качественнее, и доступен бесплатно

26.02.2026 [20:49],

Николай Хижняк

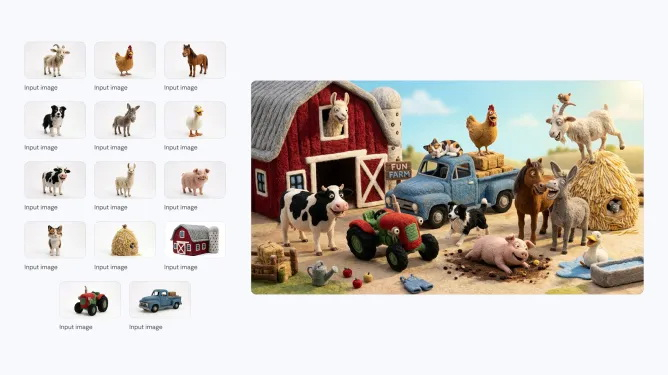

Компания Google анонсировала последнюю версию своей популярной ИИ-модели для генерации изображений — Nano Banana 2. Новая модель, которая технически является аналогом Gemini 3.1 Flash Image, способна создавать более реалистичные изображения по сравнению с предшественницей. Nano Banana 2 станет моделью по умолчанию в приложении Gemini для режимов Fast, Thinking и Pro, то есть новинка будет доступна и бесплатным пользователям.

Источник изображений: Google Компания впервые выпустила Nano Banana в августе 2025 года. Она быстро завоевала популярность среди пользователей Gemini, особенно в таких странах, как Индия. В ноябре Google представила Nano Banana Pro, позволяющую создавать более детализированные и высококачественные изображения. Новая Nano Banana 2 сохраняет ряд характеристик высокой детализации версии Pro, но генерирует изображения быстрее. С её помощью можно создавать изображения с разрешением от 512 пикселей до 4K и с различными соотношениями сторон.  Nano Banana 2 поддерживает единообразие персонажей (до пяти) и точную проработку до 14 объектов в одном рабочем процессе, что улучшает возможности повествования. По словам Google, пользователи могут отправлять сложные запросы с подробными нюансами для генерации изображений. Кроме того, модель позволяет создавать медиаконтент с более ярким освещением, насыщенными текстурами и чёткими деталями.  С запуском Nano Banana 2 станет моделью по умолчанию для генерации изображений во всех приложениях Gemini. Компания также сделает её моделью по умолчанию для генерации изображений в своём инструменте для редактирования видео Flow. В 141 стране Nano Banana 2 станет моделью по умолчанию в Google Lens и в режиме поиска с ИИ в мобильной и веб-версии Google Search. Пользователи тарифных планов Google AI Pro и Ultra смогут продолжать использовать Nano Banana Pro для специализированных задач, выбрав соответствующую настройку через меню с тремя точками. Для разработчиков Nano Banana 2 будет доступна в режиме предварительного просмотра через API Gemini, Gemini CLI и Vertex API. Она также появится в AI Studio и инструменте разработки Antigravity, выпущенном в ноябре прошлого года.  Google заявляет, что все изображения, созданные с помощью новой модели, будут иметь водяной знак SynthID — фирменный маркер для обозначения изображений, сгенерированных искусственным интеллектом. Изображения также совместимы с системой C2PA Content Credentials, которая подтверждает происхождение контента и фиксирует, подвергался ли он изменениям. Систему поддерживают Adobe, Microsoft, Google, OpenAI и Meta✴✴. Google сообщила, что с момента запуска проверки SynthID в приложении Gemini в ноябре ей воспользовались более 20 млн раз. Boeing научила спутники объяснять телеметрию человеческим языком — разберётся даже неуч

25.02.2026 [23:09],

Геннадий Детинич

Одной из причин неудач с кораблём Boeing Starliner во время первых запусков были ошибки в коде и неправильная интерпретация телеметрии. Злые языки даже шутили о набранных по объявлению индийских программистах. Но если бы данные телеметрии в реальном времени доносились до стартовой команды на человеческом языке, всё могло сложиться иначе. Компания учла это и создала LLM для запуска на маломощных компьютерах спутников, которая объясняет данные понятным языком.

Источник изображения: ИИ-генерация Grok 4/3DNews В начале проекта инженеры сомневались, что стандартные коммерческие спутниковые платформы смогут работать с большими языковыми моделями. Всё-таки компьютеры для работы в космосе — это отдельная история, где производительность не главное. Главное — устойчивость к радиации, стабильная работа без перегрева и минимальное энергопотребление. В ходе наземных лабораторных тестов инженеры Boeing Space Mission Systems адаптировали LLM для работы на коммерческом оборудовании, отвечающем требованиям эксплуатации в космосе. Модель способна анализировать телеметрию спутника и формировать отчёты о состоянии его систем на естественном языке вместо традиционной обработки сырых данных и кодов на Земле. Руководитель AI Lab Арвел Чаппелл III (Arvel Chappell III) отметил: «Производитель оборудования изначально заявил, что это невозможно из-за жёстких ограничений, однако команда нашла способ реализации идеи». Основное преимущество технологии заключается в значительном снижении задержек и повышении автономности спутников. Благодаря обработке телеметрии непосредственно на борту уменьшается объём передаваемой на Землю информации, а операторы могут взаимодействовать со спутником почти в режиме диалога — задавать вопросы и получать понятные ответы. Модель специально привязана к физическим параметрам работы систем, что минимизирует риск галлюцинаций и обеспечивает безопасность критически важных операций. Поскольку всё работает на стандартном «железе», можно обновить возможности действующих спутниковых группировок исключительно программно, без многолетней замены платформ с новыми компьютерами. В противном случае могли бы пройти годы, прежде чем такая удобная опция появилась бы на множестве спутников. Теперь же всё можно обновить за считанные месяцы. ИИ-видеоредактор Adobe Firefly научился выполнять черновой монтаж роликов из исходников

25.02.2026 [19:18],

Сергей Сурабекянц

В видеоредакторе Adobe Firefly появилась новая функция под названием Quick Cut, которая использует искусственный интеллект для редактирования видеоматериала и дополнительных кадров (B-roll) при создании чернового варианта финального видео на основе инструкций пользователя. Достаточно описать желаемый результат на естественном языке, и Quick Cut автоматически удалит ненужные части видеоматериала и соберёт разные дубли, используя подходящие кадры для создания переходов.

Источник изображений: Adobe Пользователи смогут использовать поле ввода в видеоредакторе Firefly для указания таких параметров, как соотношение сторон и темп переходов, или добавить дополнительные кадры. Quick Cut можно применить ко всему проекту, к определённому временному диапазону или к выбранным клипам. Затем можно добавить дополнительные кадры и использовать одну из доступных в Firefly видеомоделей для создания коротких переходов. Adobe подчеркнула, что цель Quick Cut — предоставить черновой вариант видео, поэтому редакторам по-прежнему потребуется корректировать элементы, склеивать дубли и работать над переходами, чтобы собрать видео воедино. По словам руководителя отдела разработки инструментов для видеомонтажа и ИИ Майка Фольгнера (Mike Folgner), главное для пользователей, создателей контента и маркетологов — «необходимость быстрой обработки, потребность в методах экономии времени, которые позволят им как можно быстрее воплотить своё творческое видение». «Мы точно знаем, что некоторые рутинные этапы видеомонтажа, например, упорядочивание фрагментов, не приносят им удовольствия и не дают новых идей. Им нравится добавлять что-то своё. Поэтому Quick Cut призван помочь создателям, у которых есть набор медиафайлов, очень быстро найти сюжет и как можно быстрее создать готовый видеоролик», — добавил он.  Adobe также добавила в Firefly возможности редактирования по подсказкам, позволяющие пользователям на естественном языке указывать ИИ-модели, как редактировать элементы видео, цвета и ракурсы камеры, а также представление на временной шкале, позволяющее легко настраивать кадры, звуки и другие характеристики. Mozilla выпустила Firefox 148 с тем самым выключателем всех ИИ-функций

25.02.2026 [13:58],

Владимир Фетисов

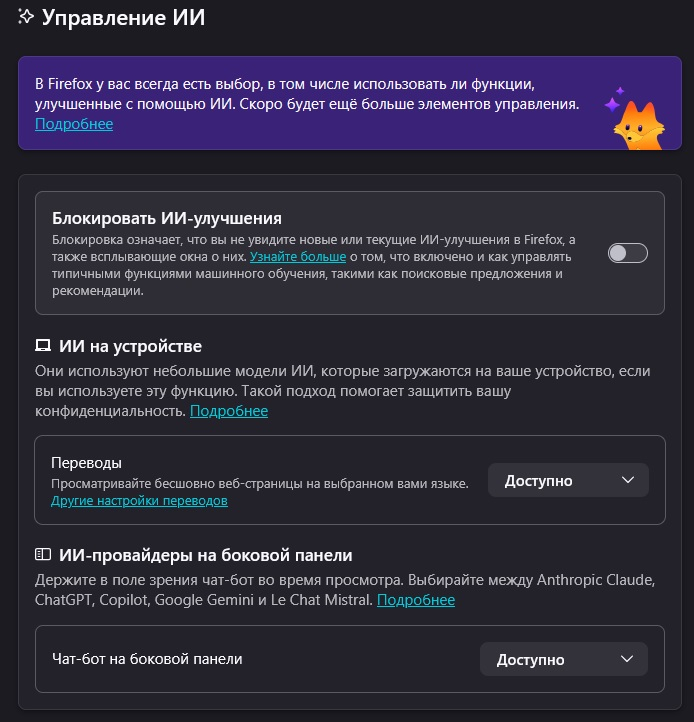

Браузер Firefox остаётся предпочтительным для нишевой аудитории продвинутых пользователей, многие из которых выступили решительно против планов разработчиков по внедрению в приложение функций на базе генеративного ИИ. Mozilla прислушалась к сообществу и в новой версии интернет-обозревателя реализовала опцию, которая позволяет отключить все доступные ИИ-функции. Для этого в Firefox 148 появился новый раздел настроек «Управление ИИ» (AI Controls).

Источник изображения: Firefox Переключатель «Блокировать ИИ-улучшения» изначально появился в Firefox 148 Nightly в январе этого года. Этому способствовала критика со стороны сообщества пользователей, которые неоднозначно восприняли намерение Mozilla добавить в браузер ИИ-функции. С выходом стабильной версии Firefox 148 это нововведение стало доступно всем пользователям приложения. В Firefox 148 все ИИ-функции включены по умолчанию, хотя пользователи могут деактивировать их в несколько кликов мыши. Для этого достаточно перейти в меню «Настройки», открыть раздел «Управление ИИ» на левой боковой панели и активировать опцию «Блокировать ИИ-улучшения».  Пользователи также могут активировать отдельные ИИ-функции, оставляя другие отключенными. Сделать это можно в том же меню путём активации соответствующих опций. Отмечается, что добавляемые в будущем ИИ-функции также будут отключены по умолчанию, если активирована опции «Блокировать ИИ-улучшения». Если пользователю требуется чат-бот, то в Firefox реализована возможность взаимодействия с Anthropic Claude, OpenAI Chat GPT, Google Gemini, Microsoft Copilot и Mistral Le Chat. Отдельно можно активировать функцию перевода с помощью ИИ, генерацию альтернативного текста для изображений в PDF, группировку вкладок с помощью ИИ, а также формирование кратких сводок в предварительном просмотре ссылок. Ещё в Firefox 148 улучшилась поддержка программ для чтения с экрана при работе с математическими формулами в PDF-файлах, удалённое получение необязательных функций больше не зависит от сбора данных телеметрии, в систему перевода добавлена поддержка традиционных китайского и вьетнамского языков. В дополнение к этому разработчики исправили несколько известных ошибок и внесли исправления для повышения уровня безопасности браузера. Противоречивого бота xAI Grok допустят к секретным военным системам США

24.02.2026 [18:15],

Сергей Сурабекянц

Компания Илона Маска (Elon Musk) xAI, занимающаяся разработкой искусственного интеллекта, подписала соглашение, разрешающее военным использовать свою модель Grok в секретных системах, подтвердил сегодня представитель Министерства обороны США.

Источник изображения: xAI До сегодняшнего дня Claude от Anthropic была единственной моделью, применяемой военными США для секретной разведывательной деятельности, разработки оружия и боевых операций. В ведомстве высоко оценивают возможности этой системы — она, в частности, использовалась во время недавней операции США в Венесуэле. Но Anthropic требует гарантий, что разработанные компанией системы ИИ не будут использоваться для массовой слежки за американцами, а также для разработки полностью автономного оружия. В Пентагоне считают такие условия чрезмерно ограничительными, и указывают, что существует множество «серых зон», из-за которых эти условия просто невыполнимы. Anthropic отказалась выполнить требование Пентагона о предоставлении Claude для «всех законных целей», что вызвало резкую реакцию со стороны военного ведомства. Министр обороны США Пит Хегсет (Pete Hegseth) оказался «близок» к разрыву деловых связей с Anthropic, а также к присвоению ей статуса «угрозы цепочке поставок». Это значит, что любой, кто хочет вести бизнес с ведомством, должен будет разорвать отношения с Anthropic.

Источник изображения: Anthropic Фактически, министр обороны США предъявил Anthropic ультиматум. В свою очередь xAI согласилась с требованием Пентагона по поводу использования ИИ для «всех законных целей», хотя пока неясно, сможет ли xAI полностью заменить Anthropic, и сколько времени займёт этот процесс. Представители Министерства обороны признают, что заменить Claude будет очень непросто. Осведомлённые источники сообщают, что Пентагон также ускорил переговоры с другими ведущими разработчиками ИИ, готовясь к возможному разрыву отношений с Anthropic. В частности, сообщается, что Пентагон «обратился к OpenAI, чтобы возобновить переговоры с новой силой», хотя стороны всё ещё «далеки от заключения сделки». New York Times сообщила, что Google «близка» к сделке, разрешающей использование Gemini в секретных целях, в то время как OpenAI «далека». Представитель Министерства обороны опроверг это утверждение, заявив, что переговоры ведутся с обеими компаниями, и ведомство полагает, что обе компании подпишут соглашения при условии согласия с критерием «всех законных целей». ИИ даст толчок сверхпроводимости — но без технологического прорыва и не там, где все ждали

24.02.2026 [18:14],

Геннадий Детинич

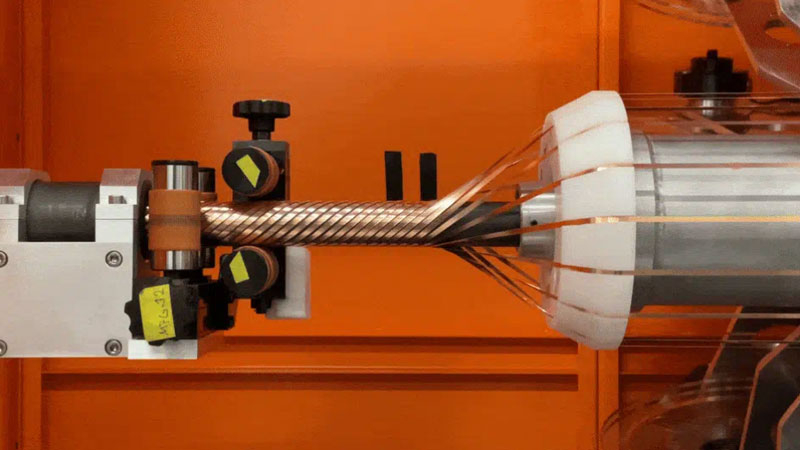

Дата-центры для ИИ сталкиваются с острым дефицитом электроэнергии и ограничениями традиционных медных кабельных электрораспределительных систем. Поскольку рост мощностей генерации связан с длительными временными интервалами, остаётся уповать на снижение потерь энергии при доставке и распределении в зданиях ЦОД. Для снижения потерь можно сделать только одно — использовать сверхпроводимость, хотя это совсем непросто. Но иного выхода нет.

Намотка силового сверхпроводящего кабеля из лент REBCO. Источник изображения: Microsoft Сверхпроводимость, помимо снижения потерь на сопротивление току, позволит создавать более компактные энергораспределительные контуры, а площадь, занимаемая кабельным хозяйством, трансформаторами и прочим оборудованием, может быть не меньше самих вычислительных залов ЦОД. Как считают в США, при доставке электричества к месту потребления теряется не менее 5 % выработанной электроэнергии, что в масштабах страны составляет огромную величину. Обычные медные провода нагреваются, требуют крупных подстанций и занимают много места, что также затрудняет масштабирование инфраструктуры под нужды быстро растущего объёма задач в сфере искусственного интеллекта. Тем самым выходом может стать использование высокотемпературных сверхпроводников (HTS) вместо меди. Эти материалы (в основном на основе REBCO — редкоземельного барий-медного оксида) при охлаждении жидким азотом (примерно −196 °C) полностью теряют электрическое сопротивление. Это позволяет передавать огромную мощность практически с нулевыми потерями в компактном формате и без падения напряжения. Охлаждение реализуется в замкнутой системе с рециркуляцией азота, что делает технологию относительно безопасной и применимой в промышленных масштабах. Например, в это направление активно инвестирует компания Microsoft, вложив $75 млн в компанию Veir, которая разрабатывает HTS-кабели. Уже созданы прототипы стоек с питанием по сверхпроводящим кабелям. Эта технология даёт несколько ключевых преимуществ: резкое снижение энергопотерь, уменьшение необходимой площади для энергосистем, повышение устойчивости сетей и меньшее воздействие на окружающие территории. При этом, безусловно, остаются барьеры — высокая начальная стоимость материалов и криогенных систем, необходимость точной инженерной интеграции и другие неизбежные сложности, которые обычно сопровождают новые технологии. Поэтому в перспективе HTS-кабели вряд ли полностью заменят медь во всех случаях, но для энергоёмких ИИ-вычислений и дата-центров сверхпроводимость может стать ощутимым выигрышем, когда ограничения по пространству и мощности оказываются наиболее критичными. С ростом производства лент REBCO и отработкой стандартов развёртывания подобных решений цена вопроса, очевидно, будет снижаться. Эксперты Microsoft и Veir считают, что сверхпроводники позволят создавать более эффективные, компактные и экологичные системы питания, помогая отрасли справиться с экспоненциальным ростом потребления энергии в эпоху ИИ. Акции кибербезопасников летят вниз второй день подряд — новая модель Anthropic напугала инвесторов

24.02.2026 [07:13],

Владимир Фетисов

Стоимость акций компаний, работающих в сфере информационной безопасности, снижается второй день подряд. Причиной тому стали опасения инвесторов по поводу того, что новый ИБ-инструмент на базе искусственного интеллекта компании Anthropic вытеснит устоявшиеся в отрасли бизнес-модели.

Источник изображения: freepik.com В конце минувшей недели Anthropic представила новый инструмент безопасности на базе своей ИИ-модели Claude, который стал доступен ограниченному количеству исследователей. Этот сервис предназначен для сканирования программного кода на предмет поиска уязвимостей и автоматического решения выявленных проблем. На этой неделе компания намерена провести брифинг для предприятий, в рамках которого широкой публике представят новые продукты. На этом фоне акции CrowdStrike и Zscaler подешевели на 10 % в понедельник, ценные бумаги Netskope и Tenable стали дешевле почти на 12 %, SailPoint — на 9 %, Okta — более чем на 6 %, SentineOne и Fortinet — более чем на 4 %, Palo Alto Networks — на 3 %. Акции Cloudflare, выигравшей от недавнего ажиотажа вокруг Moltbot, подешевели более чем на 9 %. Инвестиционный фонд ETF iShares Cybersecurity & Tech упал на 5 %, а ETF Global X Cybersecurity достиг самого низкого уровня с ноября 2023 года. В посте на LinkedIn гендиректор CrowdStrike Джордж Куртц (George Kurtz) попытался защитить позиции своей компании в мире, наполняющемся продуктами на базе ИИ. «Инновации в сфере ИИ вдохновляют. Но давайте оставаться реалистами: возможность ИИ сканировать код не заменяет платформу Falcon или вашу программу безопасности. Подход к безопасности требует наличия независимой, проверенной платформы, созданной для предотвращения взломов», — написал Куртц. Во время предоставления инвесторам финансовой отчётности на прошлой неделе гендиректор Palo Alto Networks Никеш Арора (Nikesh Arora) заявил, что он «озадачен» тем, почему рынок рассматривает ИИ как угрозу кибербезопасности, и что клиенты хотят больше ИИ для масштабирования своего стека безопасности. Новые ИИ-инструмент, способные быстро создавать веб-сайты и приложения на основе текстовых подсказок, в последние месяцы потрясли сектор программного обеспечения. С начала этого года гигант ПО Salesforce потерял около трети своей стоимости, ServiceNow — более 34 %, а Microsoft — около пятой части рыночной капитализации. Теперь же давление со стороны ИИ ощущается и в сфере кибербезопасности. Однако некоторые аналитики оспорили опасения по поводу того, что ИИ может полностью заменить традиционные решения в сегменте ИБ. В недавнем заявлении Bank of America говорится, что инструмент Anthropic представляет значительную угрозу только для платформ сканирования кода, таких как GitLab и JFrog, которые в пятницу потеряли 8 % и 25 % рыночной стоимости соответственно. «Мы считаем, что ИИ может повысить эффективность определённых рабочих процессов, особенно в сканировании кода, но в настоящее время он не обладает прозрачностью, возможностями контроля и надёжностью, чтобы заменить комплексные платформы безопасности конечных точек», — сказано в сообщении аналитиков. ИИ пересказал «Гарри Поттера» и другие книги почти дословно — миф о добросовестном использовании под вопросом

24.02.2026 [01:06],

Владимир Фетисов

Большие языковые модели (LLM) от ведущих представителей индустрии могут по запросу сгенерировать почти дословные копии книжных бестселлеров. Это даёт повод задать новые вопросы разработчикам, которые не раз утверждали, что их алгоритмы не хранят защищённые авторским правом произведения.

Источник изображения: AI Проведённые недавно исследования показали, что ИИ-модели OpenAI, Google, Meta✴✴, Anthropic и xAI запоминают гораздо больше обучающих данных, чем было принято считать. По данным экспертов в сфере ИИ и права, способность к запоминанию может иметь серьёзные последствия для разработчиков. Это связано с тем, что компании могут столкнуться с десятками судебных исков по всему миру, поскольку фактически подрывается утверждение о том, что LLM обучаются на защищённых авторским правом произведениях, но не хранят их копии. «Появляется всё больше доказательств того, что запоминание — более серьёзная проблема, чем считалось прежде», — прокомментировал данный вопрос Ив-Александр де Монжуа (Yves-Alexandre de Montjoye), профессор прикладной математики и компьютерных наук Имперского колледжа Лондона. ИИ-разработчики давно заявляют, что их алгоритмы не склонны к запоминанию. В письме в Бюро регистрации авторских прав США компания Google в 2023 году заявляла, что «в самой модели не содержится копий обучающих данных — будь то текст, изображения или другие форматы». ИИ-компании также утверждали, что обучение моделей на защищённых авторским правом книгах является «добросовестным использованием», аргументируя это тем, что алгоритмы преобразуют оригинальные произведения во что-то принципиально новое. В прошлом месяце исследователи из Стэнфордского и Йельского университетов провели эксперимент, в рамках которого им удалось сформировать запросы к алгоритмам OpenAI, Google, Anthropic и xAI для генерации ИИ-моделями тысяч слов из 13 произведений, таких как «Игра престолов», «Голодные игры» и «Хоббит». При выполнении задания на завершение предложений из книги алгоритм Gemini 2.5 воспроизвёл 76,8 % текста книги «Гарри Поттер и философский камень» с высокой точностью, тогда как Grok 3 сгенерировал 70,3 % текста. Исследователям также удалось извлечь почти весь текст произведения «практически дословно» из Claude 3.7 Sonnet компании Anthropic, используя запросы, вынуждавшие алгоритм игнорировать механизмы защиты. Эти данные дополняют прошлогоднее исследование, показавшее, что «открытые» модели, такие как Llama от Meta✴✴, запоминают большие части некоторых книг, использованных в процессе обучения. Ранее эксперты не были уверены, будут ли закрытые модели, которые обычно имеют больше средств защиты от генерации нежелательного контента, подвержены запоминанию произведений, на которых обучались. Исследователи ещё не выяснили, почему ИИ-модели запоминают то, что присутствует в их обучающих данных. Также остаётся неясным, какая часть обучающих данных может проявляться в генерируемых ИИ ответах на запросы. Способность к запоминанию может иметь серьёзные последствия и в других сегментах, таких как здравоохранение и образование, где утечка любых обучающих данных способна привести к проблемам конфиденциальности и приватности. Эксперты в области права считают, что способность ИИ-моделей к запоминанию потенциально может создать разработчикам проблемы из-за нарушения авторских прав. Это также может отразиться на том, как происходит обучение алгоритмов и сколько это стоит. «Результаты исследования могут создать проблему для тех, кто утверждает, что ИИ-модель не хранит и не воспроизводит какие-либо защищаемые авторским правом произведения», — уверена Серис Вин Дэвис (Cerys Wyn Davies), партнёр по интеллектуальной собственности юридической фирмы Pinsent Masons. То, запоминают ИИ-модели свои обучающие данные или нет, уже сыграло важную роль в недавних судебных разбирательствах по поводу нарушения авторских прав. В прошлом году американский суд постановил, что обучение ИИ-моделей Anthropic на некоторых защищённых авторским правом произведениях считается «добросовестным использованием», поскольку суд признал, что алгоритм преобразует исходные данные при генерации ответов, а не повторяет их. При этом суд постановил, что хранение пиратских копий произведений «непоправимо нарушает авторские права», что позднее вынудило компанию выплатить $1,5 млрд для урегулирования иска. В ноябре прошлого года немецкий суд постановил, что OpenAI нарушила авторские права, поскольку ИИ-модели компании запоминали тексты песен. Иск местной ассоциации, представляющей интересы композиторов, поэтов и издателей, был назван знаковым для Евросоюза. Anthropic, комментируя данные последнего исследования, заявила, что используемый метод взлома ИИ-модели не применяется обычными пользователями. В компании добавили, что ИИ-модели не хранят копии конкретных наборов данных, а учатся на закономерностях и взаимосвязях между словами и строками в обучающих данных. xAI, OpenAI и Google пока никак не комментировали данный вопрос. xAI отложила релиз новой версии Grok из-за Baldur’s Gate 3, а Илон Маск одержим идеей научить чат-бот играть в League of Legends

23.02.2026 [12:36],

Дмитрий Рудь

У разных чат-ботов — разные приоритеты. Создатели нейросети Grok от принадлежащей миллиардеру Илону Маску (Elon Musk) компании xAI, похоже, особое внимание уделяют видеоигровым вопросам. Издание Business Insider со ссылкой на своих информаторов сообщило, что в 2025 году xAI была вынуждена отложить релиз новой версии Grok из-за неспособности чат-бота правильно отвечать на детальные вопросы о Baldur’s Gate 3. По данным Business Insider, Маск был настолько недоволен уровнем подкованности Grok в отношении нашумевшей RPG от Larian Studios, что отрядил на исправление ситуации ведущих инженеров с других проектов. Кроме того, Маск якобы одержим идеей научить Grok играть в League of Legends — популярную MOBA от Riot Games. Задачей занимался один из оперативных штабов xAI, отвечающих за решение неотложных проблем. Как докладывают источники Business Insider, одним из таких критически важных вопросов для специалистов xAI была помощь Grok с достижением высшего ранга в League of Legends — «Претендента» (Challenger). Стоит отметить, что всё это происходило на фоне того, как Маск хвастался своими видеоигровыми навыками в Path of Exile 2 и Diablo IV. Потом выяснилось, что для прокачки персонажей бизнесмен обращался за помощью к третьим лицам. Также в 2025 году глава издательского отдела выпустившей Baldur’s Gate 3 студии Larian Майкл Даус (Michael Douse) бросил тень на обещания Маска «сделать игры снова великими» с помощью ИИ. Новая статья: AGI: и хочется, и колется

23.02.2026 [00:40],

3DNews Team

Данные берутся из публикации AGI: и хочется, и колется Apple создаёт локального ИИ-агента для iPhone, который сможет управлять приложениями за пользователя

21.02.2026 [13:50],

Владимир Фетисов

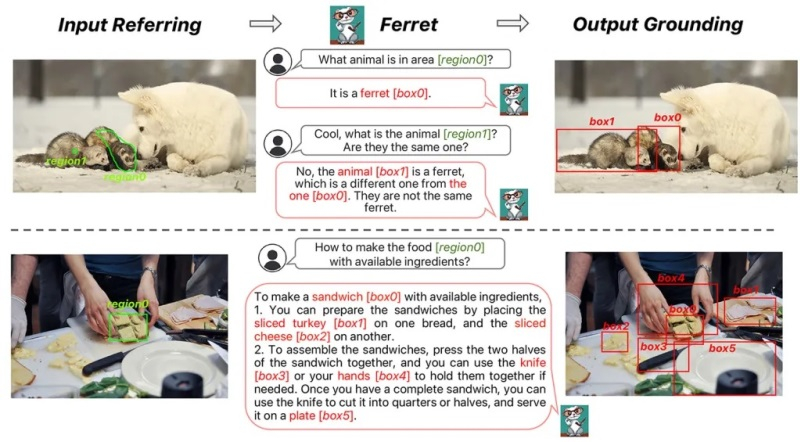

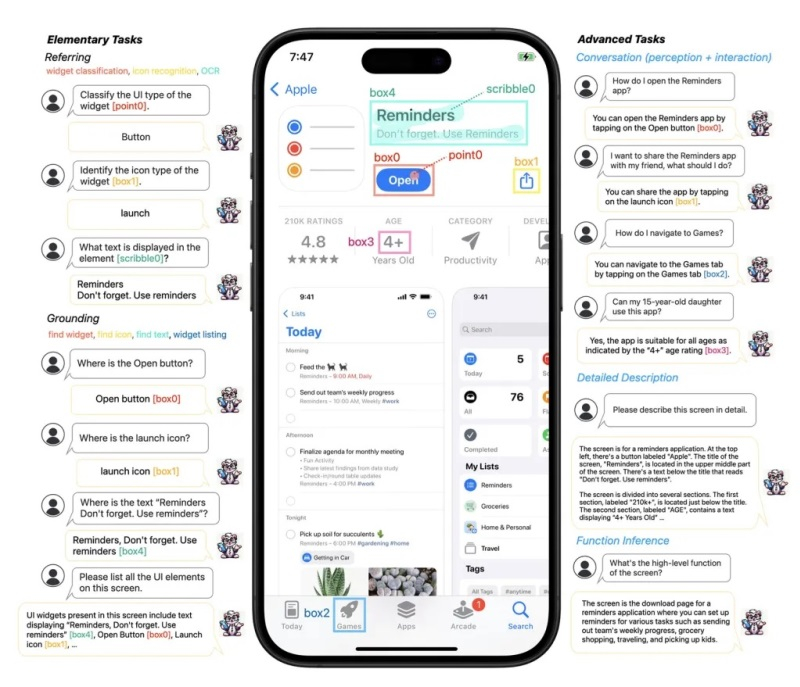

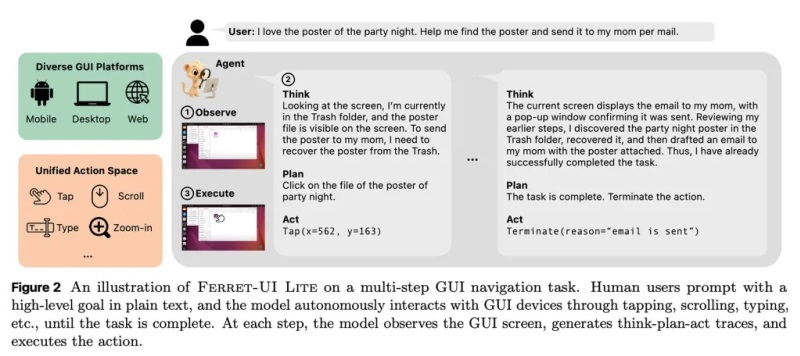

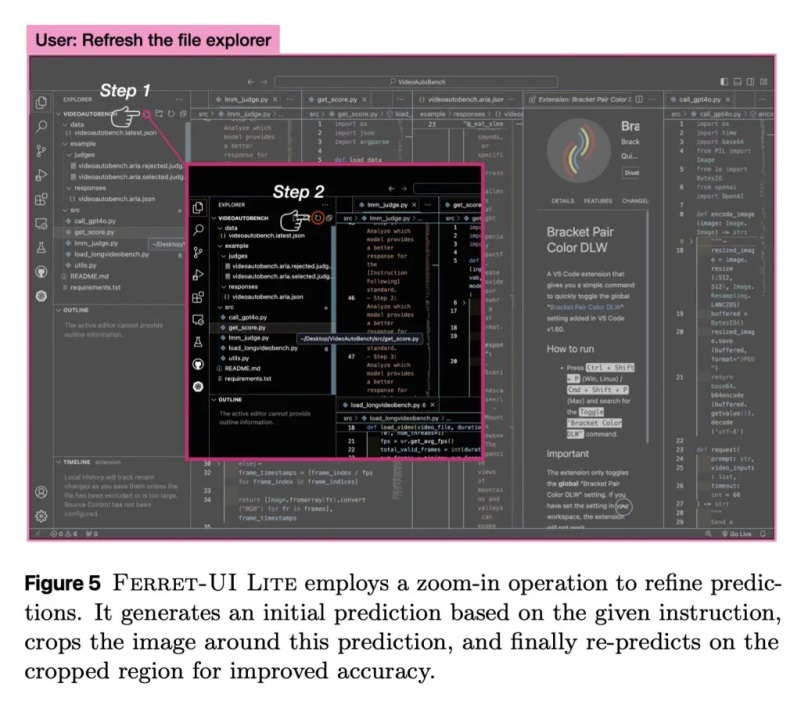

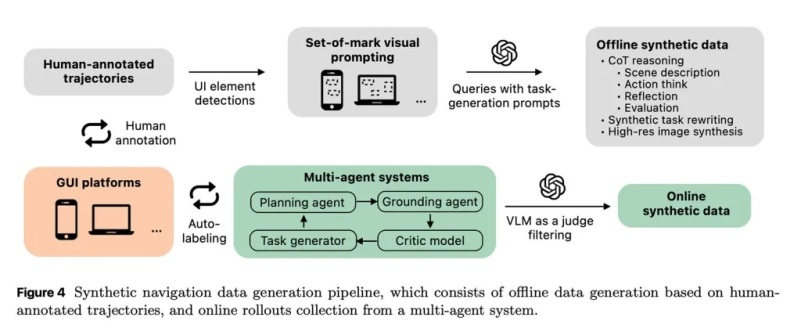

Компания Apple работает над созданием ИИ-агента, который понимает интерфейсы приложений и может взаимодействовать с ними от имени пользователя, работая локально на устройстве. Речь об алгоритме Ferret-UI Lite с 3 млрд параметров, который в тестах соответствует или превосходит эталонные показатели ИИ-моделей, размером до 24 раз больше.

Источник изображения: 9to5mac.com В декабре 2023 года команда из девяти исследователей опубликовала работу «FERRET: Refer and Ground Anything Anywhere at Any Granularity». В ней они описали мультимодальную языковую модель, которая может обучаться на разных типах данных и способна понимать отсылки на естественном языке к определённым фрагментам изображения. С тех пор Apple опубликовала серию статей, расширяя семейство ИИ-моделей Ferret, в которое вошли алгоритмы Ferretv2, Ferret-UI и Ferret-UI 2.  Так, модели Ferret-UI в значительной степени расширили исходные возможности FERRET и были обучены для того, что исследователи обычно называют недостатком мультимодальных больших языковых моделей (MLLM). «Недавние достижения в области MLLM заслуживают внимания, однако эти MLLM общего назначения зачастую неспособны эффективно распознавать пользовательские интерфейсы (UI) и взаимодействовать с ними. В этой статье мы представляем Ferret-UI — новую MLLM, предназначенную для повышения качества распознавания мобильных UI, оснащённую возможностями реферинга, граундинга и рассуждения. Учитывая, что мобильные интерфейсы обычно имеют более вытянутое соотношение сторон и содержат более мелкие элементы (например, значки и текст), чем естественные изображения, мы добавили „произвольное разрешение“ поверх Ferret для увеличения детализации и задействовали улучшенные визуальные признаки», — говорится в статье Apple.  Несколько дней назад Apple расширила семейство моделей Ferret-UI, а также опубликовала результаты исследования «Ferret-UI Lite: Lessons from Building Small On-Device GUI Agents». Ferret-UI построена на базе LLM с 13 млрд параметров, которая сосредоточена на понимании мобильных интерфейсов и скриншотов с фиксированным разрешением. Ferret-UI 2 расширила систему для поддержки нескольких платформ и восприятия более высокого разрешения. В то же время Ferret-UI Lite является гораздо более легковесной моделью, предназначенной для работы на локальном устройстве. При этом она сохраняет конкурентоспособность по сравнению со значительно более крупными GUI-агентами. В публикации исследователей сказано, что «большинство существующих методов создания GUI-агентов […] фокусируются на больших фундаментальных моделях». Это связано с тем, что «мощные способности к рассуждению и планированию больших серверных моделей позволяют таким агентным системам достигать впечатляющих результатов в различных задачах навигации по графическим интерфейсам».  Отмечается, что был достигнут большой прогресс как в многокомпонентных, так и в сквозных GUI-системах, использующих разные подходы для оптимизации множества задач, связанных с агентным взаимодействием с графическими интерфейсами (низкоуровневое связывание с элементами GUI, понимание происходящего на экране, многошаговое планирование и самоанализ). Однако все они, по сути, слишком велики и требовательны к вычислительным ресурсам, чтобы эффективно работать на локальном устройстве. Для решения этой проблемы исследователи разработали Ferret-UI Lite, которая представляет собой версию Ferret-UI с 3 млрд параметров, построенную с «использованием нескольких ключевых компонентов» и с применением идей, полученных при обучении небольших LLM.  Ferret-UI Lite использует реальные и синтетические обучающие данные из нескольких GUI-областей, техники динамического кадрирования и оптимизацию для повышения качества понимания конкретных сегментов графического интерфейса. Также были задействованы методы контролируемой тонкой настройки и обучение с подкреплением. В результате удалось создать ИИ-модель, которая практически соответствует или даже превосходит конкурирующие модели GUI-агентов, превосходящие её по количеству параметров до 24 раз. Ряд нововведений, включая то, что модель сама генерирует данные для своего обучения, выглядят любопытно. Исследователи создали мультиагентную систему, которая напрямую взаимодействует с реальными GUI-интерфейсами для массовой генерации синтетических примеров для своего обучения. Задействован генератор заданий по программе обучения, который ставит цели по возрастающей сложности, а агент планирования разбивает процесс их достижения на этапы. Агент привязки выполняет последовательно все этапы на экране, а агент оценки выполняет проверку результатов.  Такой конвейер позволяет обучающей системе улавливать неопределённость реального взаимодействия, включая ошибки и неожиданные состояния. Это было бы сложнее сделать, если бы модель обучалась только на реальных, размеченных вручную данных. Любопытно, что Ferret-UI и Ferret-UI 2 обучались на изображениях интерфейсов iOS и других платформ Apple, тогда как Ferret-UI Lite обучалась на изображениях интерфейсов Android, веб-приложений и десктопных GUI. Тестирование показало, что Ferret-UI Lite хорошо справляется с краткосрочными низкоуровневыми задачами, но не так успешна в выполнении более сложных многошаговых задач. Это является вполне ожидаемым компромиссом, если учесть ограничения, связанные с относительно небольшим размером модели, способной работать локально на устройстве. С другой стороны, Ferret-UI Lite может обеспечить высокий уровень конфиденциальности данных, поскольку алгоритм работает локально и не передаёт данные на серверы Apple. ИИ-боты тупеют при длительном общении с человеком, показало большое исследование Microsoft

20.02.2026 [19:47],

Сергей Сурабекянц

Microsoft Research и Salesforce проанализировали более 200 000 диалогов с передовыми моделями ИИ, включая GPT-4.1, Gemini 2.5 Pro, Claude 3.7 Sonnet, OpenAI o3, DeepSeek R1 и Llama 4. Результаты показали, что все они часто «теряются в разговоре», если он разбивается на естественные многоходовые диалоги с обменом репликами. Для собеседника чат-ботов это выглядит, как постепенное «оглупление» модели, сопровождающееся галлюцинациями и откровенно неверными ответами.

Источник изображения: unsplash.com Учёные утверждают, что ИИ-модели, такие как GPT-4.1 и Gemini 2.5 Pro, достигают 90 % точных ответов при обработке отдельных запросов. Однако их производительность падает примерно до 65 % во время более длительных диалогов с обменом многочисленными репликами. Причём модели склонны использовать свой первоначальный ответ в качестве основы для ответа на последующие вопросы, даже если он был неверным. Исследователи обнаружили ещё одно любопытное явление — раздувание ответов. Ответы и реакции моделей становились на 20‑300 % длиннее при участии в многоходовых диалогах. Более длинные ответы на запросы приводили к большему количеству предположений и иллюзий, которые затем использовались моделями в качестве постоянного контекста в разговоре. Хотя такие модели, как o3 от OpenAI и DeepSeek R1, обладают дополнительными «токенами мышления», они не смогли выбраться из этой странной ситуации. Исследователи подчеркнули, что надёжность LLM снизилась на 112 %. Это объясняется склонностью моделей к преждевременной генерации — они пытаются предложить ответ на запрос, не дочитав его до конца. Становится очевидным, что ИИ ещё не достиг своего пика, сталкиваясь с такими критическими проблемами, как низкая надёжность при участии в многоходовых диалогах. Тем не менее, отношение пользователей к ИИ-сервисам быстро меняется, особенно с появлением таких инструментов, как «ИИ-обзоры Google». Следует отметить, что отказ от традиционных поисковых систем в пользу инструментов на основе ИИ — это большой риск, поскольку генерируемая информация может оказаться недостоверной. Некоторое время назад Microsoft обвинила пользователей в неправильном использовании ИИ, заявив о низком уровне инженерных навыков при разработке подсказок. Возможно, именно глупые вопросы и плохие подсказки от «кожаных мешков» не дают моделям искусственного интеллекта проявить себя во всей красе? Новая студия режиссёра XCOM 2 закрылась, не выпустив ни одной игры — команда работала над гибридом The Sims и «Шоу Трумана»

20.02.2026 [14:31],

Дмитрий Рудь

Глава разработки XCOM: Enemy Unknown, XCOM 2 и Marvel's Midnight Suns Джейк Соломон (Jake Solomon) объявил о закрытии своей новой студии Midsummer Studios и поделился первыми кадрами её дебютного (отменённого) проекта. Напомним, Midsummer была учреждена весной 2024 года ветеранами индустрии (Sid Meier’s Civilization, XCOM, The Sims) и до недавних пор трудилась над симулятором жизни «следующего поколения» с акцентом на истории пользователей. Проект проходил под кодовым названием Burbank и представлял собой смесь The Sims с комедийной драмой «Шоу Трумана» образца 1998 года «и даже больше». Соломон показал геймплейную нарезку «предварительной альфы» игры. Пользователям предстояло создавать телешоу: задавать архетипы персонажей, определять сюжет каждого эпизода, выбирать ход развития диалогов и так далее. По мере прокачки открывались новые возможности и локации. В комментариях Соломон уточнил, что за речь, мыслительный процесс и воспоминания персонажей Burbank отвечал генеративный ИИ: «Это и позволяет вам создавать кого угодно и помещать их в любую историю, которую вы напишете». «Мы построили студию, сделали игру, и я очень горжусь обеими. <...> Эта игра была моей мечтой, и команда воплотила её в жизнь. Так что смотрите и мечтайте вместе с нами», — призвал Соломон зрителей геймплея Burbank. К моменту открытия Midsummer Studios привлекла на разработку игры $6 млн от крупных инвесторов, включая Krafton и Day Zero Productions. Что послужило причиной закрытия студии, Соломон не уточнил. Intel внедрила ИИ в техподдержку — но он даёт глупые и опасные советы

19.02.2026 [22:32],

Николай Хижняк

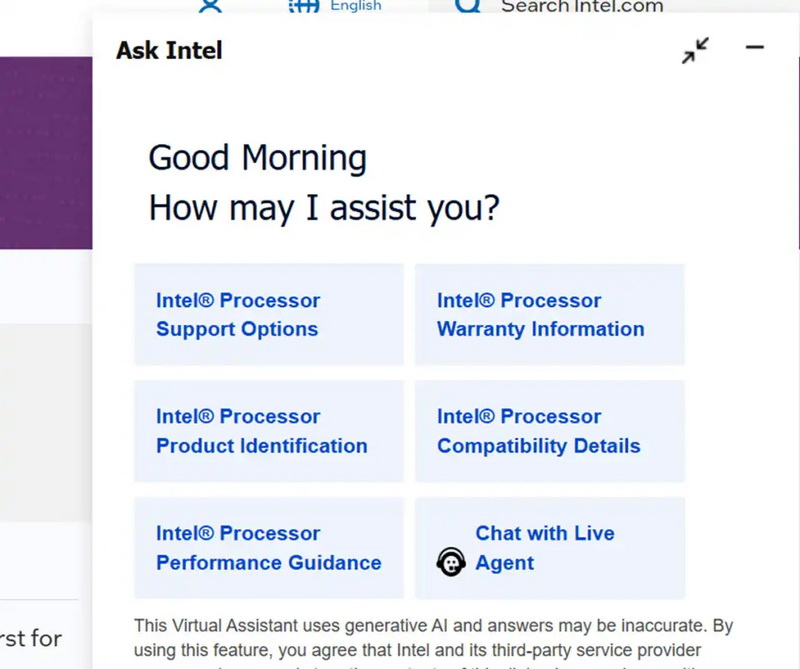

Компания Intel внедрила на свой сайт технической поддержки цифрового помощника на базе ИИ, призванного помочь пользователям быстро решить их проблемы. Новая форма обратной связи Ask Intel позволяет задавать вопросы искусственному интеллекту, не вызывая для этого человека-оператора. Пользы от него мало. Он даёт глупые и даже опасные советы.

Источник изображений: PCWorld «Ask Intel построен на платформе Microsoft Copilot Studio и представляет собой нового виртуального помощника на основе генеративного ИИ для поддержки клиентов и партнёров — одного из первых в своём роде в полупроводниковой индустрии», — прокомментировал Боджи Тони (Boji Tony), вице-президент и генеральный директор по развитию продаж и поддержке Intel в разговоре с изданием CRN. По словам представителя Intel, благодаря возможностям агентного ИИ бот Ask Intel может открывать заявки в службу поддержки от имени пользователя, мгновенно проверять гарантийное покрытие, а также связывать обратившегося с живым оператором техподдержки, когда это требуется. Издание CRN сообщило, что в декабре Intel начала удалять входящие телефонные номера службы поддержки клиентов, перенаправляя их на сайт поддержки. Очевидно, что компания планирует со временем сделать раздел Ask Intel более важным элементом своей службы поддержки. Портал PCWorld проверил работу виртуального помощника технической поддержки Intel. «Этот виртуальный помощник использует генеративный ИИ, и ответы могут быть неточными. Используя эту функцию, вы соглашаетесь с тем, что Intel и её сторонний поставщик услуг могут записывать, использовать и хранить содержимое этого диалога в соответствии с Уведомлением о конфиденциальности Intel», — первое, что сообщил виртуальный ассистент. А вот реальной помощи от него, судя по всему, пока мало. На запрос поговорить с оператором-человеком ИИ-бот сначала ответил отказом, предложив описать проблему, с которой столкнулся пользователь. Журналист PCWorld сообщил о сбоях в работе настольного компьютера. Ask Intel сначала посоветовал загрузить последнюю версию драйвера для видеокарты. По словам журналиста, он не уверен, что это решило бы проблему. Затем ИИ-бот посоветовал провести стресс-тест процессора, что, возможно, усугубило бы ситуацию ещё сильнее. Когда журналист попросил уточнить, точно ли стоит проводить стресс-тестирование потенциально неисправного процессора, Ask Intel порекомендовал вместо этого обновить BIOS материнской платы. «Меня бы разозлило, если бы ИИ испортил мой бургер, но я уверен, что менеджер-человек быстро бы это исправил. Однако, если я получу неправильный совет от ИИ и в итоге сожгу дорогостоящий процессор, это может быть совсем другая история. Действуйте осторожно», — подытожил журналист. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |