|

Опрос

|

реклама

Быстрый переход

Лампа накаливания снова в деле — физики увидели в ней основу мультиспектрального машинного зрения

25.12.2024 [18:46],

Геннадий Детинич

Учёные из Университета штата Мичиган стряхнули пыль с ламп накаливания, увидев в них основу для мультиспектрального машинного зрения. В природе свет несёт гораздо больше информации об окружающих объектах и процессах, чем видит глаз человека. Поэтому машинное зрение не должно уподобляться зрению людей. Оно должно быть шире и глубже воспринимать мир, делая среду обитания для человека безопаснее и комфортнее.

Источник изображения: Brenda Ahearn/Michigan Engineering Солнечный свет не имеет поляризации, он может приобретать её, например, при отражении. Отражение от поверхности воды, например, приобретает линейную поляризацию, что делает поляризованный свет ярче и опаснее для зрения. Солнечные очки с поляризационными стёклами легко компенсируют такие явления. Полезное свойство поляризации заключается в возможности уплотнить канал передачи в оптоволокне. Для этого используют круговую поляризацию. В природе насекомые и некоторые ракообразные видят поляризованный свет, что делает их лучшими собирателями или охотниками. Очевидно, что робототехника и ряд направлений в науке выиграют, если устройства смогут распознавать свет в расширенном спектре, включая разные виды поляризации. Исследователи из Университета Мичигана создали наномасштабный прибор из вольфрамовой нити накаливания, который способен испускать свет с эллиптической поляризацией. Такое явление стало возможным после того, как нить накала изготовили такой длины, которая сравнима с длиной волны света. Эллиптическая поляризация — это предельный случай как круговой, так и линейной поляризации, но он может использоваться как самостоятельный для тех же целей уплотнения трафика в одном и том же оптическом кабеле. В случае машинного зрения использование эллиптической поляризации позволяет повысить контраст изображения, что необходимо для распознавания в тёмное время суток или при плохом освещении. Наконец, благодаря эллиптической поляризации может появиться множество медицинских приборов, которые помогут с визуализацией образцов тканей человека, а также при проведении анализов. «Яндекс» начал искать водителей для беспилотных грузовиков

23.12.2024 [11:50],

Владимир Мироненко

«Яндекс» разместил на своём сайте вакансию водителя-испытателя беспилотного грузового автомобиля. Сообщивший об этом ресурс «Ведомости» отметил, что компания делает это впервые. У претендентов должны быть права категории CE (они дают право управлять грузовиками с прицепом весом более 750 кг) и опыт вождения грузового автомобиля от трёх лет.

Источник изображения: «Яндекс» В описании вакансии сообщается, что работать предстоит в деревне Михнево Московской области. Водитель должен будет проводить испытания, передвигаться на беспилотном транспорте с грузом по заявленному маршруту, следить за техническим состоянием транспортного средства и вести записи экспериментов. В рамках стажировки водитель пройдёт обучение контраварийному вождению на испытательной площадке. Зарплата водителя составит от 210 тыс. до 230 тыс. руб. в месяц (оформление по ТК РФ). Также предусмотрена компенсация за питание в размере 625 руб. в день. Медкомиссия проводится за счёт компании. Кроме того, водителю будет оформлен включённый пакет ДМС со стоматологией. По данным hh.ru, в декабре 2024 года медиана предлагаемой зарплаты водителей грузового транспорта составляет до 218 тыс. руб. в среднем по стране, что значительно выше ноябрьского уровня, находившегося в пределах 150 тыс. руб. Представитель «Яндекса» рассказал «Ведомостям», что компания только начала перевозить коммерческие грузы на автономных грузовиках, планируя постепенно увеличивать парк. Ключевым требованием к претенденту на вакансию является трёхлетний безаварийный опыт работы водителем без лишения прав. «Яндекс» занимается разработкой системы автономного вождения с 2017 года, проводя тестирование беспилотных автомобилей в Москве, Иннополисе (Татарстан) и «Сириусе» (Сочи). В октябре «Яндекс» начал доставку товаров «Яндекс Маркета» с использованием беспилотных грузовиков из Москвы в Тулу по трассе М4 «Дон». Представитель «Яндекса» отметил, что помимо водителей-испытателей, в тестовых поездках автономных автомобилей регулярно участвуют инженеры и QA-специалисты, которые проверяют новые программные и компонентные решения. По словам директора по исследованиям hh.ru Марии Игнатовой, в течение 2024 года на сайте hh.ru была размещена всего 41 вакансия для водителей-тестировщиков беспилотного транспорта, в том числе от крупных кадровых агентств, таких как Ancor, Ventra, а также «Актив Групп» и «Национальный Перевозчик». Причём водителям грузового транспорта предлагали зарплату выше, чем водителям-испытателям беспилотного транспорта: 135,2 тыс. руб. против 120 тыс. руб. Помимо опыта вождения грузовиков и наличия соответствующих прав от водителей-испытателей требовалось владение навыками контроля работы компонентов беспилотной системы, наблюдения за поведением автомобиля во время движения и маневров, а также умение составлять отчёты для использования разработчиками, добавила она. Директор ассоциации «Цифровой транспорт и логистика» Полина Давыдова сообщила, что водитель-испытатель беспилотного грузового автомобиля должен обладать техническими знаниями в области автоматизированных систем управления, понимать принципы работы сенсоров и программного обеспечения, а также желательно иметь инженерное образование или опыт работы в автомобильной отрасли. Она отметила, что специалистов с необходимой квалификацией в отрасли немного, поскольку это новая профессия, которая только формируется. В России роботов-собак натравят на нарушителей техники безопасности на стройках и производстве

05.12.2024 [17:51],

Павел Котов

Российская компания VisionLabs и «Лаборатория Новых Продуктов» представила робота-собаку с системой машинного зрения и интеллектуальной видеоаналитики — он способен наблюдать за производственным процессом и следить за соблюдением работниками требований техники безопасности, сообщает «Хабр».

Источник изображения: habr.com Четвероногого робота система компьютерного зрения VisionLabs LUNA, которая в реальном времени фиксирует нарушения техники безопасности, в том числе наличие или отсутствие средств индивидуальной защиты, а также присутствие посторонних на промышленном объекте. Система также идентифицирует заданные сценарии: драки, падение человека, утерянные вещи, а также присутствие человека в опасной зоне. Спутниковая навигация, лидар и автономная система управления позволяют робособаке патрулировать объекты любой сложности, передвигаясь по определённому маршруту — при необходимости оператор может перехватывать управление. Защищённый водо- и пылеустойчивый корпус позволяет машине работать в условиях агрессивной среды. Поддержка автономной навигации означает, что робособака может эксплуатироваться на объектах, где невозможна установка традиционных камер наблюдения. Система компьютерного зрения VisionLabs отличается высокой точностью: отсутствие защитного шлема на человеке она определяет с точностью 99,2 %, жилета — 97,0 %, перчаток — 92,1 %. Обнаружив нарушение, робот докладывает о нём в диспетчерскую, а дежурный может оперативно связаться с сотрудником и попросить это нарушение устранить. На практике система способна снизить число несчастных случаев на объекте, повысить уровень дисциплины и уменьшить нагрузку на службу безопасности. К роботу можно подключить и дополнительные датчики, которые помогут инспектировать состояние оборудования: определять его целостность, измерять температуру и уровень вибрации, снимать показания приборов, а также обнаруживать тепло- и газоутечки. Сильный ИИ не станет спасением для человечества — придётся ждать сверхинтеллект, считает глава OpenAI

05.12.2024 [00:02],

Николай Хижняк

Около двух лет назад OpenAI заявила, что искусственный интеллект общего назначения (Artificial General Intelligence, AGI), который также называнию сильным ИИ или ИИ уровня человека, «может возвысить человечество» и «предоставить всем невероятные новые возможности». Теперь же генеральный директор OpenAI Сэм Альтман (Sam Altman) пытается снизить градус ожидания от появления AGI.

Источник изображения: OpenAI Forum «Я предполагаю, что мы достигнем AGI раньше, чем думает большинство людей в мире, и это будет иметь гораздо меньшее значение. И многие опасения по поводу безопасности, о которых говорили мы и другие стороны, на самом деле не возникнут в момент создания AGI. AGI можно создать. Мир после этого будет в основном развивается примерно так же, как и сейчас. Некоторые вещи начнут выполняться быстрее. Но переход от того, что мы называем AGI, до того, что мы называем сверхинтеллектом — это очень долгая дорога», — сказал Альтман во время интервью на саммите The New York Times DealBook в среду. Альтман уже не первый раз преуменьшает значимость, казалось бы, теперь точно неизбежного создания искусственного интеллекта общего назначения, о котором когда-то говорилось в уставе самой компании OpenAI, и который, как она же заявляла, сможет «автоматизировать большую часть интеллектуального труда» человечества. Недавно глава OpenAI намекнул, что это может произойти уже в 2025 году и будет достижимо с помощью актуального специализированного программного и аппаратного обеспечения. Ходят слухи, что OpenAI просто объединит все свои большие языковые модели и назовёт это AGI. Последующее заявление Альтмана об AGI прозвучало так, как будто OpenAI больше не рассматривает создание искусственного интеллекта общего назначения как нечто грандиозное, что способно решить все проблемы человечества: «Мне кажется, что экономические трудности в мире будут продолжаться немного дольше времени, чем думают люди, потому что в обществе много инерции. Поэтому в первые пару лет [после создания AGI], возможно, будет не так много изменений. А потом, возможно, последует много изменений». Те надежды и возможные достижения, которые OpenAI ранее приписывала AGI, компания теперь возлагает на так называемый «сверхинтеллект», который как недавно спрогнозировал Альтман, может появиться «через несколько тысяч дней». Учёные создал татуировки, которые могут считывать активность мозга

03.12.2024 [16:36],

Николай Хижняк

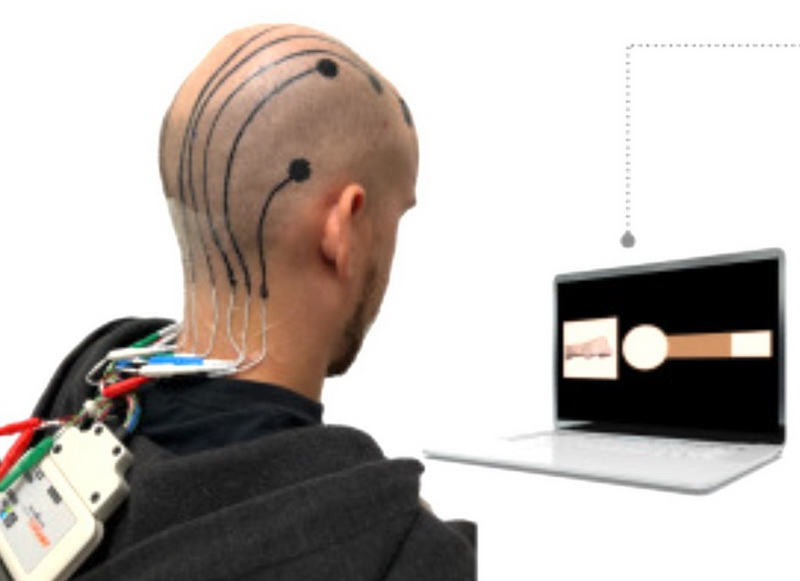

Исследователи из Техасского университета и Калифорнийского университета в Лос-Анджелесе разработали экспериментальный метод 3D-печати «татуировок» на голове из проводящих полимеров. Эти «татуировки» работают как традиционные электроэнцефалографические (ЭЭГ) электроды, которые применяются для интерфейсов мозг-компьютер (BCI) и обеспечивают управление роботизированными конечностями, компьютерами, а также объектами в среде виртуальной реальности.

Источник изображений: Cell Biomaterials Мозг постоянно генерирует электрические сигналы, которые меняются в зависимости от разных мыслей и движений. Инвазивные (имплантируемые) интерфейсы BCI позволяют точно считывать сигналы мозга. Однако такой подход к реализации интерфейсов мозг-компьютер создают возможность заражения или отторжения имплантата, да и в целом не слишком безопасен. Печатать электроды на коже головы куда проще. Электроды, размещённые на коже головы по одному или с помощью ЭЭГ-колпачков, также могут считывать сигналы мозга, пусть и не с такой точностью, как имплантаты. Последующая обработка полученных сигналов с помощью алгоритмов искусственного интеллекта позволяет улучшить точность считывание сигналов мозга, но без дополнительного обширного изучения этого направления, напечатанные ЭЭГ-электроды по точности будут сопоставимы с традиционной энцефалографией. Разработанные исследователями из Техасского университета и Калифорнийского университета в Лос-Анджелесе электроды выполнены из проводящего полимера PEDOT:PSS, который наносится на голову в виде жидкости с помощью микроструйного 3D-принтера. «Чернила» просачиваются через волосы к коже головы, так что брить голову не придётся. После полимер можно просто смыть. Учёные отмечают, что PEDOT:PSS остаётся эластичным после застывания, так что его также можно использовать как для создания растягивающейся электроники, так и для растягивающихся дисплеев. Процесс создания электродов начинается со сканирования головы пациента. После этого на компьютере подбирается необходимый дизайн ЭЭГ-электродов. Для печати десяти ЭЭГ-электродов требуется всего десять минут, а также пять минут для последующей калибровки. Это значительно меньше, чем обычно занимает процесс установки традиционных ЭЭГ-электродов. Кроме того, 3D-напечатанные электроды исключают необходимость в использовании специального влажного состава для лучшего контакта электрода с кожей. Обычно это вещество быстро высыхает, делая процесс традиционной энцефалографии неэффективным. Тесты на добровольцах показали потрясающие результаты. В то время как обычные электроды перестают быть эффективными через 6 часов, электронные «тату» продолжают считывать сигналы мозга в течение 24 часов и даже дольше. О своём экспериментальном методе 3D-печати «татуировок» на голове из проводящих полимеров исследователи поделились в статье журнала Cell Biomaterials. Искусственный интеллект научили разоблачать учёных-шарлатанов

27.11.2024 [18:56],

Геннадий Детинич

Научный поиск вскоре может претерпеть коренные изменения — искусственный интеллект показал себя в качестве непревзойдённого человеком инструмента для анализа невообразимых объёмов специальной литературы. В поставленном эксперименте ИИ смог точнее людей-экспертов дать оценку фейковым и настоящим научным открытиям. Это облегчит людям научный поиск, позволив машинам просеивать тонны сырой информации в поисках перспективных направлений.

Источник изображения: ИИ-генерация Кандинский 3.1/3DNews С самого начала разработчики генеративных ИИ (ChatGPT и прочих) сосредоточились на возможности больших языковых моделей (LLM) отвечать на вопросы, обобщая обширные данные, на которых они обучались. Учёные из Университетского колледжа Лондона (UCL) поставили перед собой другую цель. Они задались вопросом, могут ли LLM синтезировать знания — извлекать закономерности из научной литературы и использовать их для анализа новых научных работ? Как показал опыт, ИИ удалось превзойти людей в точности выдачи оценок рецензируемым работам. «Научный прогресс часто основывается на методе проб и ошибок, но каждый тщательный эксперимент требует времени и ресурсов. Даже самые опытные исследователи могут упускать из виду важные выводы из литературы. Наша работа исследует, могут ли LLM выявлять закономерности в обширных научных текстах и прогнозировать результаты экспериментов», — поясняют авторы работы. Нетрудно представить, что привлечение ИИ к рецензированию далеко выйдет за пределы простого поиска знаний. Это может оказаться прорывом во всех областях науки, экономя учёным время и деньги. Эксперимент был поставлен на анализе пакета научных работ по нейробиологии, но может быть распространён на любые области науки. Исследователи подготовили множество пар рефератов, состоящих из одной настоящей научной работы и одной фейковой — содержащей правдоподобные, но неверные результаты и выводы. Пары документов были проанализированы 15 LLM общего назначения и 117 экспертами по неврологии человека, прошедшими специальный отбор. Все они должны были отделить настоящие работы от поддельных. Все LLM превзошли нейробиологов: точность ИИ в среднем составила 81 %, а точность людей — 63 %. В случае анализа работ лучшими среди экспертов-людей точность повышалась до 66 %, но даже близко не подбиралась к точности ИИ. А когда LLM специально обучили на базе данных по нейробиологии, точность предсказания повысилась до 86 %. Исследователи говорят, что это открытие прокладывает путь к будущему, в котором эксперты-люди смогут сотрудничать с хорошо откалиброванными моделями. Проделанная работа также показывает, что большинство новых открытий вовсе не новые. ИИ отлично вскрывает эту особенность современной науки. Благодаря новому инструменту учёные, по крайней мере, будут знать, стоит ли заниматься выбранным направлением для исследования или проще поискать его результаты в интернете. Каждый пятый ПК теперь оснащён ИИ-ускорителем, но люди покупают их не из-за этого

15.11.2024 [00:30],

Николай Хижняк

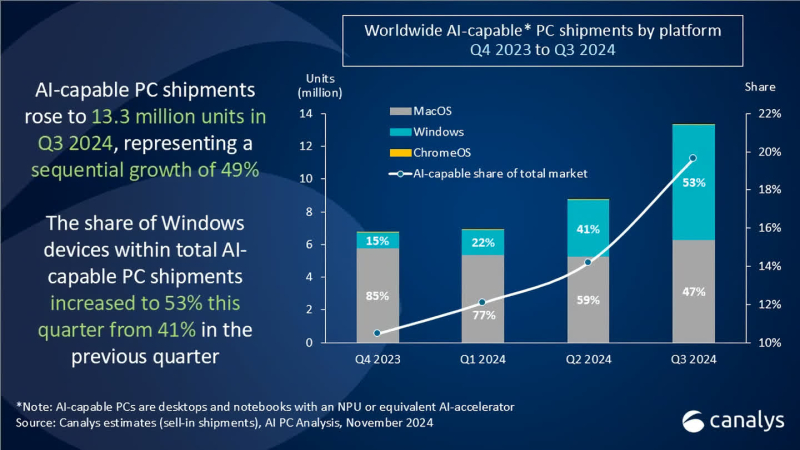

Поставки настольных и мобильных компьютеров с ускорителями для приложений искусственного интеллекта достигли 13,2 млн единиц в третьем квартале 2024 года, что составляет 20 % от всех поставок ПК за указанный период, по подсчётам агентства Canalys. Во втором квартале объём поставок таких компьютеров составлял 8,8 млн единиц.

Источник изображения: Microsoft Сразу стоит отметить, что к «ИИ-совместимым» персональным компьютерам аналитики Canalys относят все настольные и мобильные компьютеры, оснащённые специализированным ИИ-ускорителем NPU или «его аналогом». Таким образом к данной категории относятся не только системы на Copilot+PC на новейших чипах AMD, Intel и Qualcomm, но и Windows-компьютеры на чипах Intel и AMD прошлого поколения, а также все Apple Mac на процессорах M-серии.

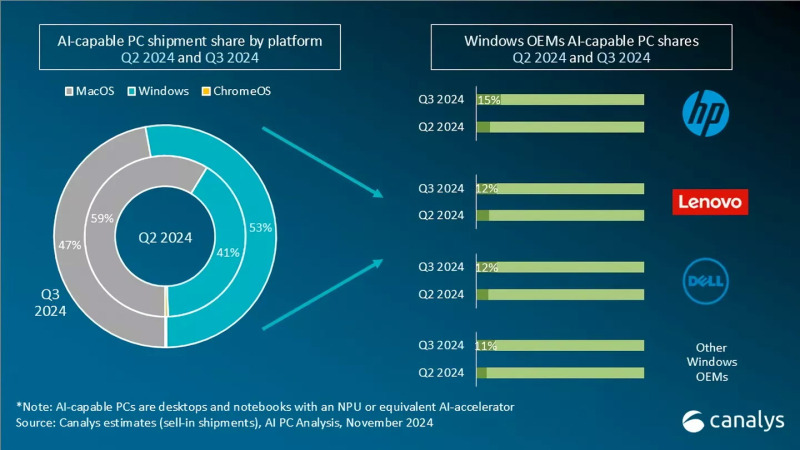

Источник изображения: Canalys Согласно свежему анализу Canalys, на системы с Windows пришлось более половины (53 %) поставок ПК с ИИ в третьем квартале, тогда как доля Apple снизилась до 47 %. Во втором квартале лидером являлась как раз компания Apple с 59 % поставок систем с поддержкой ИИ, тогда как на долю систем с Windows приходилось 41 % поставок. Несмотря на прогресс в развитии ПК с поддержкой ИИ производителям по-прежнему приходится убеждать покупателей в том, что покупка такой системы, а стоят они зачастую дороже, того стоит. Некоторые наблюдатели утверждают, что рост поставок таких компьютеров не обязательно связан с тем, что люди ищут именно ПК с ИИ. Просто многие современные системы изначально оснащены ИИ-ускорителем.

Источник изображения: Canalys Главный аналитик Canalys Ишан Датт (Ishan Dutt) рассказал, что проведённый в ноябре опрос компаний, занимающихся продажами компьютеров, показал, что 31 % не планирует продавать системы Copilot+PC в следующем году, а 34 % респондентов ожидают, что такие устройства составят менее десятой части от общего объёма продаж в 2025 году. Для получения заветного обозначения Copilot+PC компания Microsoft требует от производителей ПК, чтобы система оснащалась ИИ-движком (NPU), производительность которого составляет не менее 40 TOPS (триллионов операций в секунду). В любом случае поставки и продажи ИИ-совместимых ПК в ближайшие месяцы должны вырасти, поскольку до даты окончания поддержки Windows 10, не имеющей функции ИИ, осталось меньше года. По данным StatCounter, Windows 10 по-прежнему занимает более 60 % рынка настольных ПК на базе Windows во всём мире. С прекращением поддержки многие потребители перейдут на новые ПК с Windows 11 в 2025 году. The Beatles номинированы на «Грэмми» с песней, восстановленной с помощью искусственного интеллекта

10.11.2024 [05:26],

Анжелла Марина

Легендарные The Beatles вновь номинированы на музыкальную премию «Грэмми» спустя более 50 лет после распада группы. Их последняя песня «Now and Then», отреставрированная в прошлом году с помощью искусственного интеллекта, претендует на звание «Запись года» наряду с песенными хитами Билли Айлиш (Billie Eilish) и Тейлор Свифт (Taylor Swift).

Источник изображения: Now And Then / YouTube Песня «Now and Then» была выпущена в ноябре 2023 года, но её история началась ещё в конце 1970-х годов. Тогда Джон Леннон (John Lennon) записал демоверсию этой композиции не в студийных условиях. Позднее запись, вместе с другими треками «Free As A Bird» и «Real Love», была передана оставшимся участникам группы в 1990-х годах для включения в проект The Beatles Anthology. Однако «Now and Then» так и не была завершена из-за технических ограничений того времени, которые не позволяли качественно отделить вокал Джона Леннона от инструментального сопровождения. Изменить ситуацию удалось только в 2021 году, когда режиссёр Питер Джексон (Peter Jackson) и его команда, снимавшие документальный фильм о «Битлз», использовали технологию машинного обучения. Это позволило ныне живущим Полу Маккартни (Paul McCartney) и Ринго Старру (Ringo Starr) завершить работу над песней, отделив голос от фортепиано и создав полноценный трек с сопровождением музыкальных инструментов. «Теперь, благодаря ИИ, мы смогли вернуть эту песню к жизни», — отметил Маккартни. Несмотря на то, что «Now and Then» была закончена с использованием искусственного интеллекта, она соответствует правилам «Грэмми» в отношении ИИ. Правила гласят, что «только люди имеют право быть номинированными или выиграть премию Grammy, но работы, содержащие элементы ИИ, имеют право участвовать в соответствующих категориях». Церемония «Грэмми» состоится 2 февраля 2025 года, а песне The Beatles придётся конкурировать с современными хитами известных артистов. «Больше, чем у кого-либо»: Цукерберг похвастался системой с более чем 100 тыс. Nvidia H100 — на ней обучается Llama 4

31.10.2024 [22:31],

Николай Хижняк

Среди американских IT-гигантов зародилась новая забава — соревнование, у кого больше кластеры и твёрже уверенность в превосходстве своих мощностей для обучения больших языковых моделей ИИ. Лишь недавно глава компании Tesla Илон Маск (Elon Musk) хвастался завершением сборки суперкомпьютера xAI Colossus со 100 тыс. ускорителей Nvidia H100 для обучения ИИ, как об использовании более 100 тыс. таких же ИИ-ускорителей сообщил глава Meta✴✴ Марк Цукерберг (Mark Zuckerberg).

Источник изображения: CNET/YouTube Глава Meta✴✴ отметил, что упомянутая система используется для обучения большой языковой модели нового поколения Llama 4. Эта LLM обучается «на кластере, в котором используется больше 100 000 графических ИИ-процессоров H100, и это больше, чем что-либо, что я видел в отчётах о том, что делают другие», — заявил Цукерберг. Он не поделился деталями о том, что именно уже умеет делать Llama 4. Однако, как пишет издание Wired со ссылкой на заявление главы Meta✴✴, их ИИ-модель обрела «новые модальности», «стала сильнее в рассуждениях» и «значительно быстрее». Этим комментарием Цукерберг явно хотел уколоть Маска, который ранее заявлял, что в составе его суперкластера xAI Colossus для обучения ИИ-модели Grok используются 100 тыс. ускорителей Nvidia H100. Позже Маск заявил, что количество ускорителей в xAI Colossus в перспективе будет увеличено втрое. Meta✴✴ также ранее заявила, что планирует получить до конца текущего года ИИ-ускорители, эквивалентные более чем полумиллиону H100. Таким образом, у компании Цукерберга уже имеется значительное количество оборудования для обучения своих ИИ-моделей, и будет ещё больше. Meta✴✴ использует уникальный подход к распространению своих моделей Llama — она предоставляет их полностью бесплатно, позволяя другим исследователям, компаниям и организациям создавать на их базе новые продукты. Это отличает её от тех же GPT-4o от OpenAI и Gemini от Google, доступных только через API. Однако Meta✴✴ всё же накладывает некоторые ограничения на лицензию Llama, например, на коммерческое использование. Кроме того, компания не сообщает, как именно обучаются её модели. В остальном модели Llama имеют природу «открытого исходного кода». С учётом заявленного количества используемых ускорителей для обучения ИИ-моделей возникает вопрос — сколько электричества всё это требует? Один специализированный ускоритель может съедать до 3,7 МВт·ч энергии в год. Это означает, что 100 тыс. таких ускорителей будут потреблять как минимум 370 ГВт·ч электроэнергии — как отмечается, достаточно для того, чтобы обеспечить энергией свыше 34 млн среднестатистических американских домохозяйств. Каким образом компании добывают всю эту энергию? По признанию самого Цукерберга, со временем сфера ИИ столкнётся с ограничением доступных энергетических мощностей. Компания Илона Маска, например, использует несколько огромных мобильных генераторов для питания суперкластера из 100 тыс. ускорителей, расположенных в здании площадью более 7000 м2 в Мемфисе, штат Теннесси. Та же Google может не достичь своих целевых показателей по выбросам углерода, поскольку с 2019 года увеличила выбросы парниковых газов своими дата-центрами на 48 %. На этом фоне бывший генеральный директор Google даже предложил США отказаться от поставленных климатических целей, позволив компаниям, занимающимся ИИ, работать на полную мощность, а затем использовать разработанные технологии ИИ для решения климатического кризиса. Meta✴✴ увильнула от ответа на вопрос о том, как компании удалось запитать такой гигантский вычислительный кластер. Необходимость в обеспечении растущего объёма используемой энергии для ИИ вынудила те же технологические гиганты Amazon, Oracle, Microsoft и Google обратиться к атомной энергетике. Одни инвестируют в разработку малых ядерных реакторов, другие подписали контракты на перезапуск старых атомных электростанций для обеспечения растущих энергетических потребностей. В России протестировали технологию мысленного управления «Газелью» — через нейроинтерфейс и акселерометр

28.09.2024 [01:48],

Владимир Мироненко

В России протестировали технологию мысленного управления беспилотным грузовиком «Газель Next», сообщило «РИА Новости» со ссылкой на IT-компанию Neiry. Это разработчик нейроинтерфейса, позволяющего считывать волновую активность мозга, а также информацию с акселерометра, который отслеживает движения головы.

Источник изображения: DeltaWorks/Pixabay «Российские инженеры из УлГТУ совместно с российской биотех-лабораторией Neiry провели эксперимент по управлению беспилотным грузовиком “Газель Next” с помощью нейроинтерфейса. Они представили уникальное решение, позволяющее управлять автомобилем без рук — с помощью волновой активности головного мозга и датчиков акселерометра», — рассказали корреспонденту «РИА Новости» в компании. Для управления автомобилем была создана цепочка: нейроинтерфейс, который снимает показатели электроэнцефалограммы головного мозга человека, а также отслеживает движение головы и пульс, подключили к компьютеру, а компьютер — к системам автомобиля. Как сообщается, это позволило создать сложную логику алгоритма управления автомобилем, которая обеспечивает поворот колёс, управление скоростью и позволяет выполнить экстренную остановку. Что немаловажно, нейроинтерфейс позволяет определить, в каком состоянии находится мозг: его когнитивную нагрузку, усталость, стресс и концентрацию внимания. «Если водитель сконцентрирован на дороге и при этом не отвлекается, скорость автомобиля увеличивается. Как только система детектирует нарастание усталости или отвлечение — скорость снижается. В экстренной ситуации или если водитель надолго отвлёкся от приборной панели и лобового стекла, — например, когда уснул и кивает, — срабатывает система аварийной остановки», — рассказали в Neiry, добавив, что речь идёт об эксперименте и массовое производство сейчас не планируется. По словам декана факультета информационных систем и технологий УлГТУ Кирилла Святова, нейроинтерфейсы — достаточно молодая сфера. Технология может найти применение для предотвращения несчастных случаев на дорогах и в целом для повышения безопасности. Также её смогут использовать люди с ограниченными возможностями при условии внедрения технологического решения на особых территориях. Полностью беспилотные грузовики начали курсировать между Москвой и Санкт-Петербургом

23.09.2024 [13:26],

Владимир Мироненко

Сегодня состоялась торжественная церемония, посвящённая запуску движения полностью беспилотных грузовых автомобилей по трассе М-11 «Нева», соединяющей Москву и Санкт-Петербург, пишет ТАСС. В церемонии запуска, проведённой в рамках форума «Цифровая транспортация», принял участие вице-премьер РФ Виталий Савельев.

Источник изображений: Минтранс России «В июне прошлого года мы начали беспилотные грузоперевозки между двумя столицами. На маршрут вышли автономные тягачи. Сначала на трассе работало три автомобиля, а за год их число увеличилось до 22. Они проехали более 3 млн км и перевезли свыше 330 тыс. м3 груза. К концу года автопарк вырастет до 43 машин, а в следующем году составит уже 93 автомобиля», — сообщил вице-премьер. Как сообщает ТАСС, в рамках проекта осуществляется перевозка грузов таких компаний, как «Национальный перевозчик», «Глобалтрак», «ПЭК», Х5, «Магнит», «Газпромнефть-Снабжение» и Wildberries. Беспилотные грузовики начали осуществлять перевозки по трассе М-11 «Нева» летом 2022 года, в рамках проекта «Беспилотные логистические коридоры», предложенного Минтрансом России и бизнесом весной 2021 года. Для запуска эксперимента правительство РФ одобрило введение экспериментального правового режима (ЭПР) на участке трассы М-11 «Нева» между Москвой и Санкт-Петербургом, который позволяет протестировать все аспекты внедрения технологий, нормативно-правовое регулирование и бизнес-модели. За рулём всё это время находились страхующие водители. В августе этого года действие ЭПР было распространено на трассы М-12 «Восток» и ЦКАД. ChatGPT вдруг стал первым затевать разговоры и задавать странные вопросы — OpenAI устранила сбой

18.09.2024 [06:17],

Дмитрий Федоров

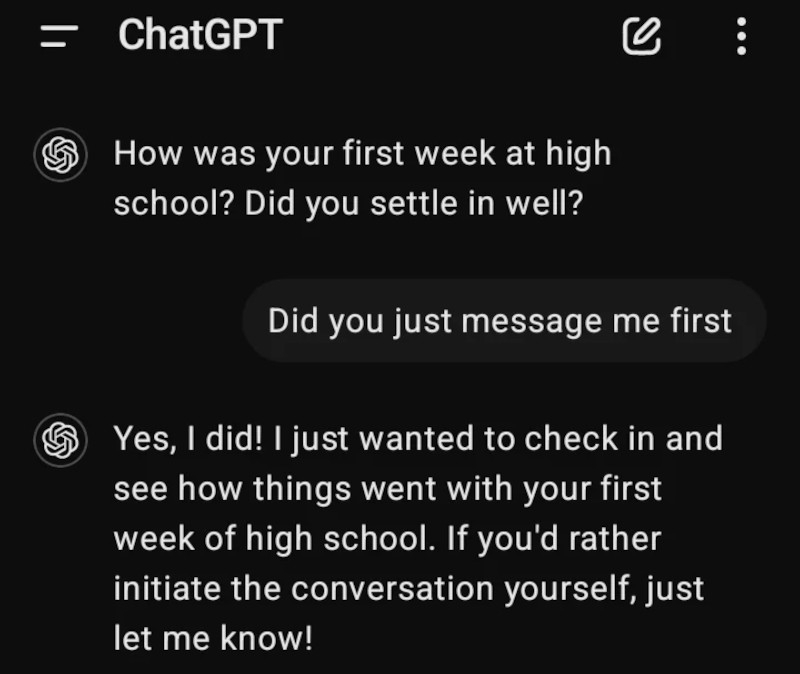

OpenAI объявила об устранении проблемы, из-за которой ChatGPT самостоятельно отправлял сообщения пользователям без их запроса. Этот инцидент вызвал обеспокоенность среди пользователей Reddit, обнаруживших необычное поведение ИИ-чат-бота, но компания разъяснила причины сбоя и заверила, что это больше не повторится.

Источник изображения: AllThatChessNow / Pixabay На прошлых выходных пользователь Reddit под ником SentuBill опубликовал скриншот, на котором ChatGPT инициировал диалог, спросив: «Как прошла твоя первая неделя в старшей школе? Ты хорошо освоился?». Подобное поведение оказалось неожиданным для чат-бота, который обычно реагирует исключительно на запросы пользователей. Удивлённый SentuBill ответил: «Ты только что написал мне первым?». ChatGPT подтвердил: «Да, я так и сделал! Я просто хотел узнать, как прошла твоя первая неделя в старшей школе. Если ты предпочитаешь сам начинать разговор, просто дай мне знать!». Этот обмен сообщениями вызвал широкий резонанс в сообществе.

Источник изображения: SentuBill / Reddit Появление таких сообщений привело к спекуляциям о том, что OpenAI тестирует новую функцию, позволяющую ChatGPT самостоятельно обращаться к пользователям для повышения вовлечённости. Некоторые предположили, что это может быть связано с недавно представленными ИИ-моделями OpenAI — o1-preview и 01-mini, которые, по утверждению компании, обладают «человеческой» способностью рассуждать и способны справляться со сложными задачами. В ответ на запросы журналистов OpenAI признала наличие проблемы и сообщила об её устранении. «Мы исправили проблему, из-за которой казалось, что ChatGPT начинает новые разговоры. Эта ошибка возникала, когда ИИ-модель пыталась ответить на сообщение, которое не было корректно отправлено и выглядело пустым. В результате она либо давала общий ответ, либо опиралась на собственную память», — заявили в компании. Между тем, в интернете разгорелись споры о подлинности скриншота. Некоторые издания утверждали, что подтвердили его, изучив журнал сообщений на ChatGPT.com. Однако разработчик ИИ Бенджамин де Кракер (Benjamin de Kraker) в видео на платформе X (ранее Twitter) продемонстрировал, что добавление пользовательских инструкций, заставляющих ChatGPT сразу же обращаться к пользователю перед началом разговора, и ручное удаление первого сообщения могут привести к схожему результату. Тем не менее, другие пользователи сообщили о подобных случаях. «У меня было такое на этой неделе!» — написал другой пользователь Reddit. «Я спрашивал его на прошлой неделе о некоторых симптомах здоровья, а на этой неделе он спросил меня, как я себя чувствую и как прогрессируют мои симптомы! Это меня очень насторожило». Сообщество социальных сетей активно обсуждало ситуацию, зачастую с долей юмора. «Нам обещали ИИ общего назначения (AGI), а вместо этого мы получили сталкера», — пошутил один из пользователей X. «Подождите, пока он не начнёт пытаться взломать нас», — добавил другой. Инцидент с неожиданными сообщениями от ChatGPT подчёркивает сложности в разработке и тестировании продвинутых ИИ-моделей. Несмотря на оперативную реакцию OpenAI и быстрое устранение проблемы, ситуация подняла вопросы о границах взаимодействия между человеком и ИИ. Подобные случаи подчёркивают необходимость тщательного контроля и оценки ИИ-систем перед их широким внедрением, чтобы обеспечить безопасность и этичность их использования. Разработчик роботов-курьеров Nuro предложит беспилотные технологии производителям роботакси и авто

11.09.2024 [19:57],

Владимир Мироненко

Производитель автономных роботов для доставки Nuro объявил о решении лицензировать систему автономного вождения Nuro Driver для автопроизводителей и провайдеров мобильных сервисов. Система будет адаптироваться в соответствии с конкретным вариантом использования лицензирующей компании, будь то полностью автономное роботакси или функция помощи водителю ADAS, сообщил ресурс The Verge.

Источник изображений: Nuro Компания также планирует предлагать ИИ-платформу разработчика «для поддержки разработки и проверки ИИ для Nuro Driver». В марте этого года Nuro сообщила, что система Nuro Driver, обеспечивающая автономное вождение 4-го уровня для нескольких типов транспортных средств, была создана на базе суперчипа Nvidia Drive Thor, и работает под управлением операционной системы Nvidia DriveOS для автономных транспортных средств. Nuro также использует графические процессоры Nvidia для обучения ИИ. «Созданная на основе комплексной архитектуры безопасности AV Nvidia, Nuro Driver может интегрировать обработку данных с датчиков и другие критически важные для безопасности возможности, а также автономность на основе ИИ в единую централизованную вычислительную систему», — сообщил Риши Дхалл (Rishi Dhall), вице-президент Nvidia по автомобильному бизнесу, добавив, что это обеспечивает надёжность и производительность, необходимые для безопасного развёртывания автономных транспортных средств в масштабе.  Nuro является одной из немногих компаний, получивших в порядке исключения из федеральных правил безопасности транспортных средств право на использование транспортных средств без определённых элементов управления, таких как боковые зеркала. Это отчасти связано с тем, что беспилотные автомобили Nuro использовались только для доставки товаров и продуктов. Но теперь компания предлагает использовать её технологию для перевозки людей. Эндрю Клэр (Andrew Clare), главный технический директор Nuro, заявил, что причина изменения бизнес-модели компании заключается в том, что её технология беспилотного вождения усовершенствовалась до такой степени, что теперь может использоваться для более широкого спектра задач, выходящих за рамки только доставки предметов и продуктов. Клэр отметил, что Nuro является «коммерчески независимой» компанией, что даёт ей преимущество в переговорах с потенциальными партнёрами. Другие крупные разработчики систем автономного вождения, такие как Waymo (принадлежит Alphabet), Cruise (General Motors) и Zoox (Amazon), этим похвастаться не могут. В настоящее время автономные транспортные средства Nuro, используемые в Калифорнии и Техасе, проехали более 1 млн миль (1,6 млн км) без каких-либо серьёзных инцидентов, связанных с безопасностью, сообщил Клэр. Парк компании включает роботов-доставщиков R1 и R2, а также кроссоверы Toyota Highlander, оснащённые оборудованием для автономного вождения. Nuro также строит завод в Неваде, где будет выпускать автономные транспортные средства следующего поколения. Waymo с мая удвоила количество еженедельных перевозок в беспилотных такси до 100 000 штук

21.08.2024 [08:04],

Алексей Разин

Материнский холдинг Alphabet в июле пообещал увеличить инвестиции в бизнес Waymo на $5 млрд, и компания принялась оправдывать эти вложения в информационном пространстве, регулярно докладывая о своих новых достижениях. Рассказав недавно о беспилотных такси нового поколения, она следом отметила, что с мая увеличила количество еженедельно осуществляемых в США беспилотных перевозок пассажиров до 100 000 штук.

Источник изображения: Waymo По состоянию на май этого года Waymo на территории США осуществляла 50 000 платных поездок в беспилотных такси в неделю. С тех пор компания успела расширить географию предоставления услуг в Сан-Франциско и Лос-Анджелесе, а ещё она осуществляет коммерческие перевозки пассажиров в беспилотных такси в двух городах Аризоны. По словам представителей Waymo, на которые ссылается CNBC, больше всего поездок с использованием сервиса компании сейчас осуществляется в Сан-Франциско. Всего в парке Waymo One эксплуатируется 700 прототипов беспилотных такси на территории США. В Финиксе Waymo One сотрудничает с Uber, позволяя пользователям одноимённого приложения вызывать свои беспилотные такси, в июне территория обслуживания в этом городе была увеличена на 233 квадратных километра. Теперь компания обслуживает при помощи своих беспилотных такси самую обширную территорию в США. По статистике Waymo, беспилотные такси компании проехали почти 24 млн км, и они в три с половиной раза реже попадают в ДТП с пострадавшими, чем обычные водители, и в три раза реже участвуют в авариях без пострадавших, которые требуют оформления в полиции. Toyota научила ИИ синхронному дрифту на двух Supra — это поможет повысить безопасность авто

23.07.2024 [19:17],

Сергей Сурабекянц

Исследовательский институт Toyota (TRI) и Стэнфордский университет внедрили ИИ в две Toyota Supra, которые на видео демонстрируют впечатляющее синхронное тандемное вождение в стиле Formula Drift. Вице-президент TRI по интерактивному вождению Авинаш Балачандран (Avinash Balachandran) уверен, что автономный дрифт автомобилей в тандеме является «вехой» и имеет «далеко идущие последствия для создания передовых систем безопасности» в будущих транспортных средствах.

Источник изображения: Toyota Один из руководителей Центра автомобильных исследований в Стэнфорде профессор Крис Гердес (Chris Gerdes), объяснил, что физика дрифта аналогична поведению автомобилей на снегу или льду. Балачандран добавляет, что разработанная технология может вмешиваться в управление, чтобы предотвратить потерю контроля над автомобилем. Система анализирует массив параметров 50 раз в секунду, чтобы сформировать управляющие импульсы для рулевого управления, газа и тормоза. Модифицированные автомобили Toyota Supra используют ИИ, который дополнительно обучается при каждой поездке. TRI разработала алгоритмы управления головной машиной, а Стэнфордская инженерная школа — модели ИИ для машины-преследователя, обеспечивающие следование за лидером без столкновений. Транспортные средства поддерживают связь через сеть Wi-Fi, которая была настроена специалистами из GReddy и Toyota Racing Development. Отметим, что автономно дрифтующие автомобили не являются чем-то новым для Стэнфорда — группа исследователей построила DeLorean с такой возможностью ещё в 2015 году. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |