Стремясь приоткрыть завесу над нейросетями, работающими по принципу «чёрного ящика», Стэнфордский университет в сотрудничестве с Массачусетским технологическим институтом и Принстоном разработал оценочный «Индекс прозрачности базовой модели» (Foundational Model Transparency Index, FMTI). Новая система оценки ранжирует 10 крупнейших моделей ИИ на основе общедоступных сведений о них. Результаты удручающие, лишь модели с открытым исходным кодом дарят некоторую надежду.

Источник изображения: Pixabay

«В то время как социальное влияние моделей ИИ растёт, их прозрачность снижается, отражая секретность, которая сопровождала предыдущие цифровые технологии, такие как социальные сети», — утверждает соавтор исследования Саяш Капур (Sayash Kapoor). А низкая прозрачность, по мнению учёных, затрудняет «потребителям понимание ограничений модели или возмещение причинённого вреда».

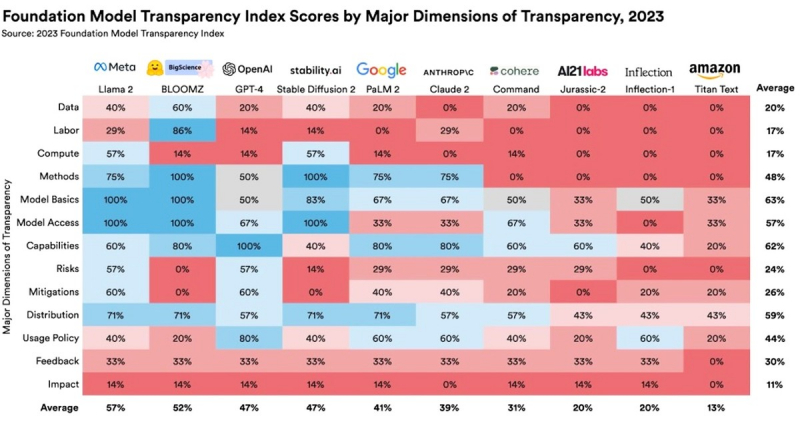

FMTI оценивает 10 крупнейших моделей ИИ по 100 различным критериям, связанным с прозрачностью и открытостью. Сюда входит, например, их структура, информация, на которой они обучались, и потребность в вычислительных ресурсах. Также учитываются политики использования модели, защиты данных и снижения рисков. Полный список показателей и методологии можно найти в сопроводительном 110-страничном документе к исследованию.

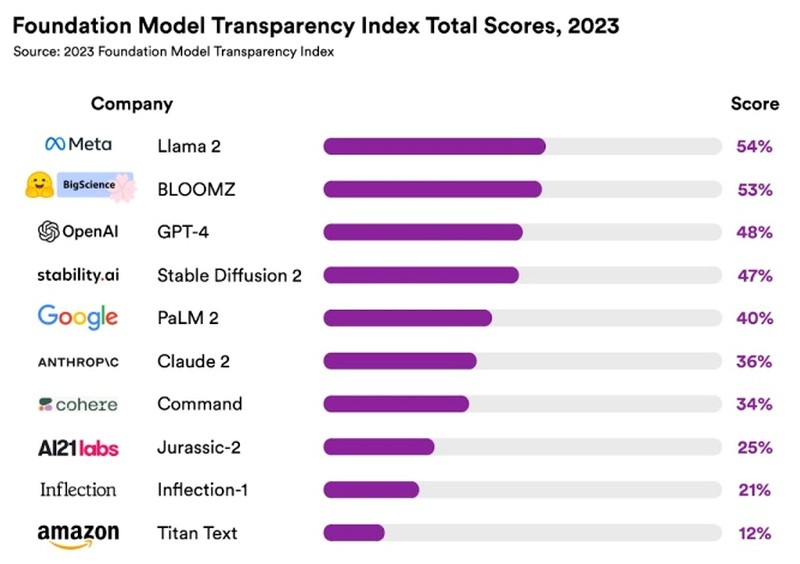

Перед публикацией отчёта исследователи обсуждали результаты теста совместно с руководителями каждой компании, давая им возможность аргументированно «оспаривать оценки, с которыми они не согласны». Если команда находила аргументы создателей ИИ убедительными, производилась корректировка оценок. Даже с учётом столь взвешенного подхода средняя оценка по всем моделям составила всего 37 баллов из 100 (37 %). На основании этого результата исследователи пришли к выводу, что ни одна из моделей на сегодняшний день не обеспечивает адекватной прозрачности.

Модель Llama 2 от Meta✴ заняла первое место с результатом 54 %. Bloomz от Hugging Face, заняла второе место с 53 %, за ней следует GPT-4 от OpenAI, получившая 48 %. «OpenAI, в названии которой есть слово “открытый”, чётко показала отсутствие прозрачности в отношении большинства аспектов своей флагманской модели GPT-4», — прокомментировали этот результат исследователи. Модель Stable Diffusion 2 компании Stability AI заняла четвёртое место с 47 %. Модель PaLM2 от Google, на которой основан чат-бот Bard, замыкает пятёрку лучших, получив 40 %.

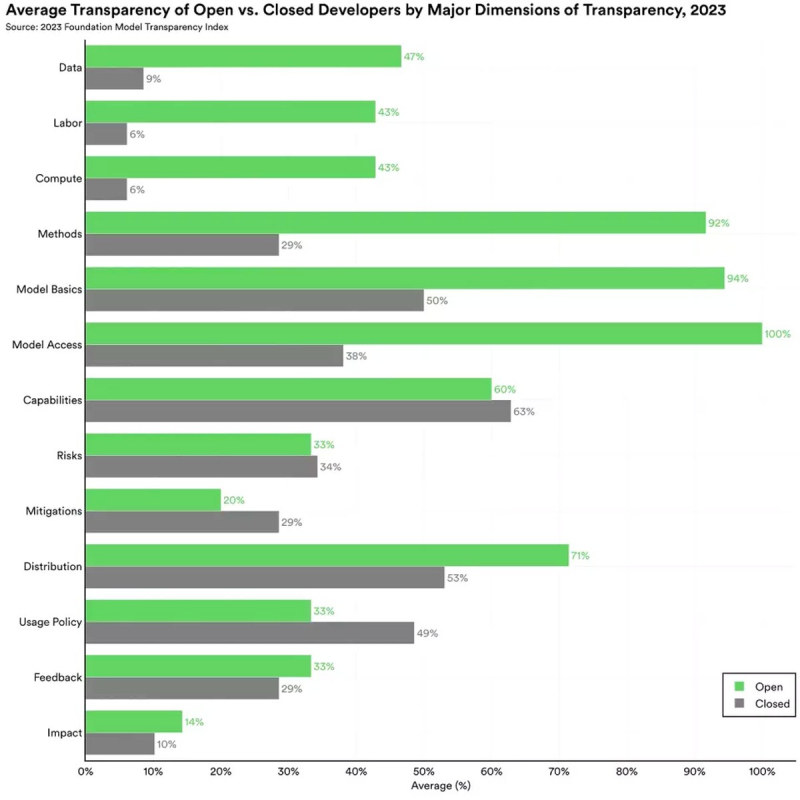

«Один из самых острых политических споров в области ИИ сегодня заключается в том, должны ли модели ИИ быть открытыми или закрытыми», — говорят исследователи. Открытые модели в целом получили более высокий рейтинг, чем закрытые. Модель считается «открытой», если её код размещается публично как открытое программное обеспечение. К открытым моделям относятся такие модели ИИ как Llama 2 и Bloomz, к закрытым — GPT-4. Стэнфордский университет продемонстрировал преимущества открытых моделей, создав свою собственную модель ИИ Alpaca на основе открытого программного кода Llama от Meta✴.

Исследователи надеются, что FMTI окажет позитивное влияние на политику создателей ИИ, и в дальнейшем планирует публиковать рейтинг FTMI ежегодно. Девять из десяти участников рейтинга ранее уже присоединились к инициативам правительства США по ответственному использованию ИИ. FMTI может стать дополнительным мотивирующим фактором для выполнения ими своих обязательств.

Данные рейтинга FMTI также могут пригодиться Европейскому Союзу при разработке следующей редакции «Закона об искусственном интеллекте». Исследователи полагают, что использование нового индекса даст законодателям большую ясность в отношении положения дел в области ИИ и того, что они потенциально могут изменить с помощью регулирования.

Источник:

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018