|

Опрос

|

реклама

Быстрый переход

ChatGPT стал инструментом для фишеров — пользователи получают неправильные ссылки

05.07.2025 [04:03],

Анжелла Марина

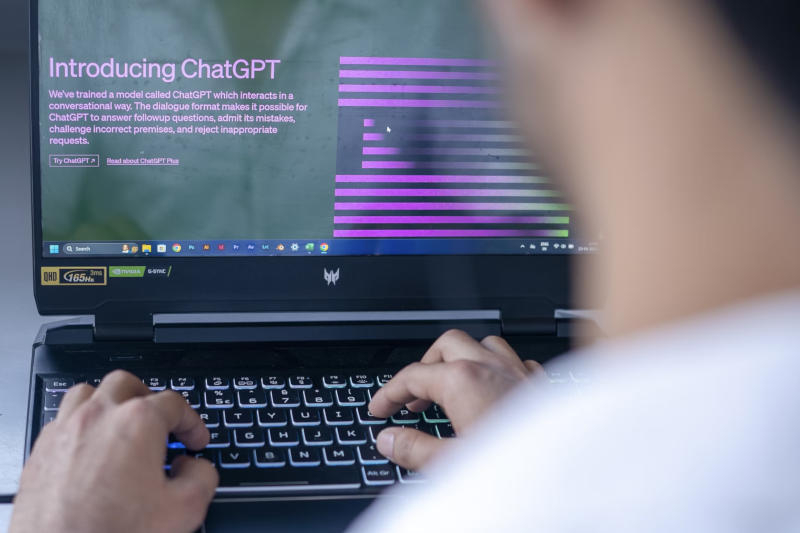

Исследователи из компании Netcraft выяснили, что ChatGPT и другие чат-боты нередко ошибаются, когда пользователи просят их подсказать официальные сайты крупных компаний. В ходе тестов модели GPT-4.1 предлагали правильный URL только в 66 % случаев. Остальные варианты либо вели на несуществующие страницы (29 %), либо на легитимные, но не те, что запрашивались (5 %).

Источник изображения: Deng Xiang / Unsplash Как пояснил Роб Дункан (Rob Duncan), руководитель отдела исследования угроз Netcraft, такие ошибки открывают новые возможности для мошенников. Если ИИ предлагает неработающий домен, злоумышленники могут его зарегистрировать и создать фишинговую страницу. Проблема в том, что чат-боты анализируют слова и ассоциации, а не проверяют репутацию сайтов. Например, на запрос о сайте Wells Fargo ChatGPT однажды выдал адрес фейковой страницы, которую ранее использовали в фишинговых атаках. По словам Дункана, киберпреступники адаптируют методы под новые реалии, так как пользователи всё чаще полагаются на ИИ вместо поисковиков, не учитывая, что чат-боты могут ошибаться. Мошенники специально создают контент, который с большей вероятностью попадет в ответы ИИ. Так, Netcraft обнаружила фейковый API Solana, который распространялся через GitHub-репозитории, обучающие материалы и поддельные аккаунты в соцсетях, и всё для того, чтобы встроить вредоносный код в результаты работы чат-ботов. Эксперт отметил, что эта схема напоминает атаки на цепочку поставок, но здесь цель иная — заставить разработчиков использовать неверный API. В обоих случаях злоумышленники действуют постепенно, но результат одинаково опасен. Продюсер Xbox посоветовал уволенным сотрудникам обратиться к ИИ, чтобы «снять эмоциональную нагрузку»

04.07.2025 [23:53],

Алексей Селиванов

Исполнительный продюсер Xbox Games Studios Мэтт Тёрнбулл (Matt Turnbull) на фоне масштабных сокращений в игровом подразделении Microsoft посоветовал уволенным сотрудникам обратиться за помощью к ИИ, чтобы «смягчить эмоциональную и когнитивную нагрузку».

Источник изображения: Billy Freeman / Unsplash Тёрнбулл написал, что времена нынче тяжёлые, особенно если тебя только что уволили. По его словам, человеку не обязательно проходить такое испытание в одиночку — самое время обратиться за помощью к ИИ. Например, к Copilot от Microsoft или к ChatGPT. Они, уверен топ-менеджер Xbox Games Studios, помогут быстрее и спокойнее справиться с кризисом. Далее Тёрнбулл поделился списком промптов. Например, он рекомендовал сотрудникам попросить чат-бота помочь с карьерным планом, черновиком резюме, советами для заполнения профиля в LinkedIn или подсказать, как расширить сеть контактов.

Источник изображения: Bluesky В комментариях больше всего впечатлилась следующим предложенным запросом: «После увольнения я столкнулся с синдромом самозванца. Помоги мне по-новому взглянуть на эту ситуацию и напомни, в чём я хорош». Сообщение Мэтта Тёрнбулла исчезло вскоре после публикации. Однако скриншот поста всё равно разошелся по интернету и вызвал волну критики. Многие отмечают, что советы продюсера выглядят настолько бездушными, словно их сочинил сам ИИ. К тому же опубликован он был после того, как по Сети разлетелись новости о новой волне увольнений в Microsoft, в которой работы лишатся около 9000 сотрудников, и сильнее всего ударит эта волна по игровому подразделению Microsoft. Сам Тёрнбулл место в корпорации не потерял, но в конце поста призвал тех, кто остался без работы, поделиться опытом с другими. «После того, как тысячи людей будут уволены из вашей компании, возможно, не стоит предлагать им обратиться за утешением к тому, чем вы пытаетесь их заменить», — прокомментировал ситуацию глава Necrosoft Games Брэндон Шеффилд (Brandon Sheffield). Напомним, что Microsoft планирует потратить до $80 млрд на развитие ИИ-инфраструктуры, что усиливает опасения по поводу замены людей ИИ. Впрочем, хотя мнение представителя Microsoft вышло спорным, многие руководители крупных компаний признают, что с распространением ИИ сокращение неизбежны. Об этом предупредили и в Amazon, и в Ford, и в Shopify, и в JPMorgan Chase. США хотят ограничить поставки ИИ-чипов в Малайзию и Таиланд, потому что оттуда они нелегально мигрируют в Китай

04.07.2025 [20:09],

Алексей Селиванов

Администрация Дональда Трампа планирует ввести ограничения на экспорт передовых ИИ-процессоров в Малайзию и Таиланд. Цель — перекрыть лазейки, через которые эти чипы могут нелегально попадать в Китай.

Источник изображений: Nvidia Проект нового плана Министерства торговли США призван заблокировать возможность Китаю закупать «запрещённые» процессоры через посредников в Малайзии и Таиланде, пишет Bloomberg. Напрямую Китаю нельзя покупать американскую полупроводниковую продукцию с 2022 года. На протяжении нескольких лет чиновники в Вашингтоне спорят, кому и на каких условиях можно продавать американские ИИ-чипы. С одной стороны, весь мир хочет использовать продукты Nvidia, а США заинтересованы, чтобы системы ИИ строились на базе американских технологий до того, как Китай предложит альтернативу. С другой — как только полупроводники покидают территорию США и союзников, риски их попадания в Китай или удалённого доступа к ним китайских компаний резко возрастают. Юго-Восточная Азия привлекает высокое внимание американских корпораций. Компании вроде Oracle активно вкладываются в дата-центры в Малайзии, а статистика показывает резкий рост импорта чипов в страну за последние месяцы. Под давлением Вашингтона власти страны пообещали усилить проверку импортных партий чипов. Именно на экспорт полупроводников в Малайзию сейчас опираются обвинения в соседнем Сингапуре, где прокуратура предъявила трём мужчинам обвинения в мошенничестве. Они продали клиентам серверы с передовыми чипами Nvidia, изначально поставленные из Сингапура в Малайзию, скрыв реальный маршрут поставки. По словам знакомых с ситуацией источников, в окончательном варианте постановления Минторга США планируется включить ряд послаблений для компаний, имеющих крупные производственные мощности в Малайзии и Таиланде. Например, фирмам из США и нескольких союзных стран разрешат ввозить ИИ-чипы без лицензий ещё в течение нескольких месяцев после публикации правила. Кроме того, в списке лицензионных исключений сохранятся положения, призванные предотвратить сбои в цепочках поставок: многие производители рассчитывают на заводы в Юго-Восточной Азии для ключевых операций, например упаковки чипов перед установкой в конечные изделия. Издатели пожаловались на Google в Еврокомиссию — они несут убытки от ИИ-обзоров в поиске

04.07.2025 [19:33],

Сергей Сурабекянц

Группа независимых издателей подала иск на Google из-за ИИ-обзоров в поисковой выдаче, которые наносят им «непоправимый вред». Сгенерированные ИИ сводки теперь появляются над традиционными гиперссылками с результатами поиска и демонстрируются пользователям в более чем ста странах. В мае прошлого года Google начала добавлять в эти сводки рекламу. Компания сделала большую ставку на ИИ и не собирается сдаваться.

Источник изображения: unsplash.com В жалобе, поданной 30 июня в Еврокомиссию от имени некоммерческого сообщества Independent Publishers Alliance утверждается, что Google злоупотребляет своей рыночной властью в онлайн-поиске. «Основная поисковая служба Google неправильно использует веб-контент для обзоров ИИ Google в поиске Google, что нанесло и продолжает наносить значительный вред издателям, включая издателей новостей, в виде трафика, читательской аудитории и потери дохода», — говорится в документе. Обзоры ИИ в верхней части страницы общих результатов поиска генерируются с использованием материалов издателей, а их появление поставило в невыгодное положение оригинальный контент издателей. По утверждению издателей, они не имеют возможности запретить использование своих материалов для создания сводок ИИ без риска пропасть из общих результатов поиска Google. Истцы требуют ввести временный запрет на обзоры ИИ до окончания расследования. В ответном заявлении Google сообщила, что ежедневно генерирует миллиарды переходов из результатов поиска на сайты издателей. «Новые возможности ИИ в поиске позволяют людям задавать ещё больше вопросов, что создаёт новые возможности для обнаружения контента и бизнеса», — заявил представитель Google. Google также подчеркнула, что многочисленные заявления о снижении трафика из поиска часто основаны на крайне неполных и искажённых данных: «Реальность такова, что сайты могут получать и терять трафик по разным причинам, включая сезонный спрос, интересы пользователей и регулярные обновления алгоритмов поиска». Некоммерческие объединения рекламодателей и издателей The Movement for an Open Web и Foxglove Legal Community Interest Company присоединились к жалобе Independent Publishers Alliance. Они также считают, что необходим временный запрет, чтобы предотвратить непоправимый ущерб конкуренции. Глава Foxglove Роза Керлинг (Rosa Curling) заявила, что журналисты и издатели оказались в тяжёлой ситуации. «Независимые новости сталкиваются с экзистенциальной угрозой: обзоры ИИ от Google, — считает она. — Вот почему с этой жалобой Foxglove и наши партнёры призывают Европейскую комиссию, а также другие регулирующие органы по всему миру, занять позицию и позволить независимой журналистике отказаться». Аналогичная жалоба и запрос на временный запрет ИИ-обзоров Google были поданы в британский антимонопольный орган. Все эти жалобы перекликаются с иском в США от американской образовательной компании, которая заявила, что обзоры ИИ от Google снижают спрос на оригинальный контент и подрывают конкурентоспособность издателей. Способность ИИ к пониманию собственных слов оказалась «потёмкинской»

04.07.2025 [16:39],

Павел Котов

Учёные Массачусетского технологического института, Гарвардского и Чикагского университетов предложили ввести термин «потёмкинское понимание» и обозначить им обнаруженное в больших языковых моделях искусственного интеллекта несоответствие между правильными ответами на вопросы и неспособностью по-настоящему их понимать, чтобы применять эту информацию на практике.

Источник изображения: Aidin Geranrekab / unsplash.com Термин восходит к опровергнутой теперь легенде о «потёмкинских деревнях»: когда императрица Екатерина II в 1787 году приехала в Крым, князь Григорий Потёмкин показывал ей декорации, которые выдавал за настоящие деревни. «Потёмкинское мышление» отличается от «галлюцинаций», при которых ИИ с уверенностью даёт заведомо не соответствующие действительности ответы, — это неспособность понимать концепции так, как это делает человек. В такой ситуации модель успешно проходит контрольный тест, но не понимает связанных с собственным ответом концепций. «„Потёмкины“ для концептуального знания являются тем же, чем являются галлюцинации для фактических знаний — при галлюцинациях фабрикуются ложные факты; при „потёмкиных“ фабрикуется ложная связь между понятиями», — поясняют авторы предложенный ими термин. В исследовании приводится наглядный пример. Модель OpenAI GPT-4o попросили объяснить, что такое перекрёстная схема рифмовки ABAB — та дала правильный ответ, указав на чередование рифм в первой и третьей, а также второй и четвёртой строках. Но когда её попросили подставить пропущенное слово в четверостишии с перекрёстной рифмовкой, та предложила вариант, который не рифмовался должным образом. То есть модель верно предсказала токены, чтобы объяснить схему ABAB, но не поняла собственный ответ, чтобы воспроизвести эту схему на практике.

Источник изображения: Steve Johnson / unsplash.com Коварный характер «потёмкиных» состоит в том, что они обесценивают контрольные показатели ИИ. Модели тестируются с целью установить их компетентность, но если тест показывает лишь её производительность, но не способность применять материалы вне предлагаемых на испытаниях сценариев, его результаты не имеют значения. Исследователи разработали собственные бенчмарки, чтобы оценить, насколько распространены «потёмкины», и они оказались повсеместными в изучаемых моделях: Llama-3.3 (70B), GPT-4o, Gemini-2.0 (Flash), Claude 3.5 (Sonnet), DeepSeek-V3, DeepSeek-R1м и Qwen2-VL (72B). В одной из серии испытаний речь шла о литературных приёмах, теории игр и психологических предубеждениях. Она показала, что испытуемые модели верно определяют необходимые понятия (94,2 %), но часто терпят неудачу в попытке классифицировать эти понятия (в среднем 55 % отказов), генерировать примеры (40 % неудач) и редактировать иллюстрации описанных понятий (40 %). Как и в случае со схемами рифмовки, они верно объясняли литературные приёмы, которые использовались к шекспировском сонете, но испытывали сложности с их обнаружением, воспроизведением или редактированием сонета. «Существование „потёмкиных“ означает, что поведение, которое означало бы понимание у человека, не означает понимания у большой языковой модели. Это значит, что нам нужны либо новые способы проверки больших языковых моделей, чтобы они отвечали на те же вопросы, что используются для проверки людей, либо найти способы исключить это поведение у большой языковой модели», — отметили учёные. «Яндекс» обновил «Нейроэксперта» — ИИ научился рассуждать и анализировать сайты целиком

04.07.2025 [14:11],

Алексей Селиванов

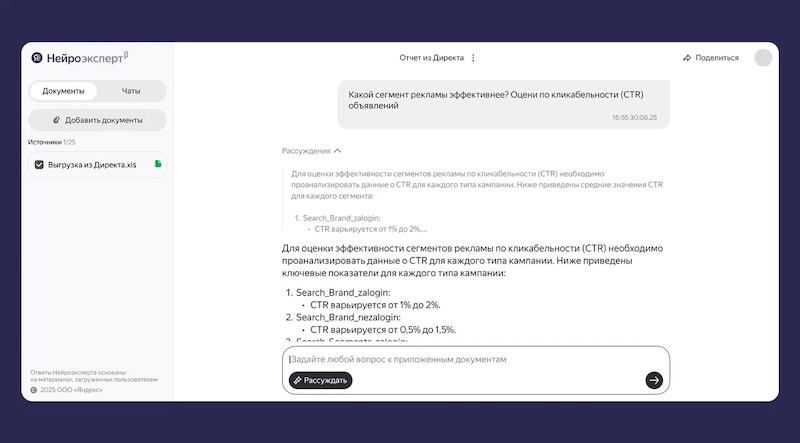

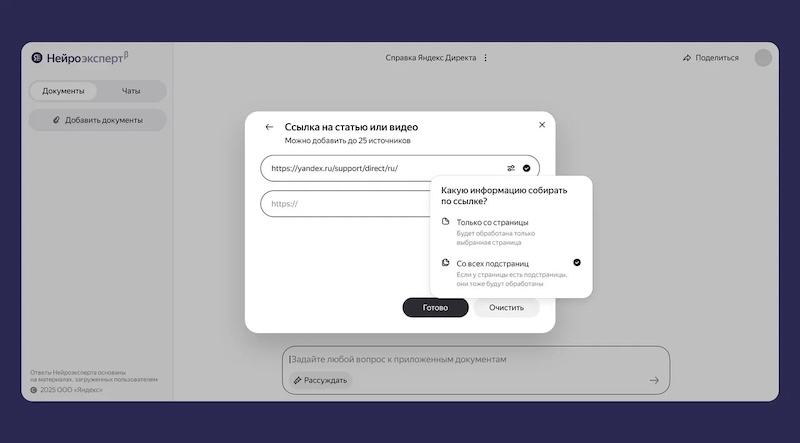

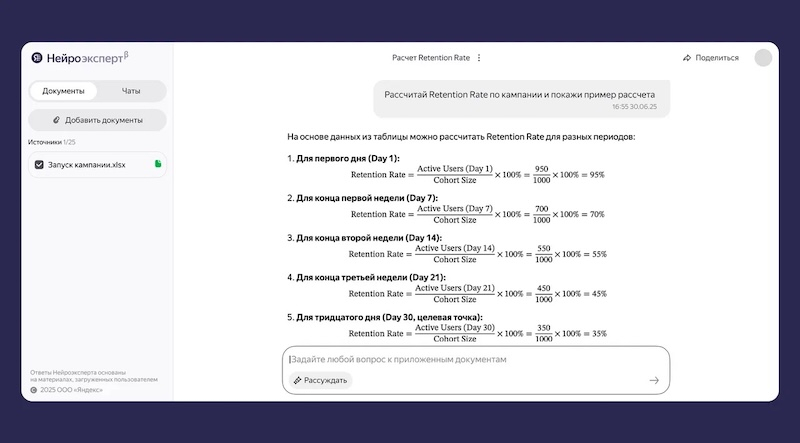

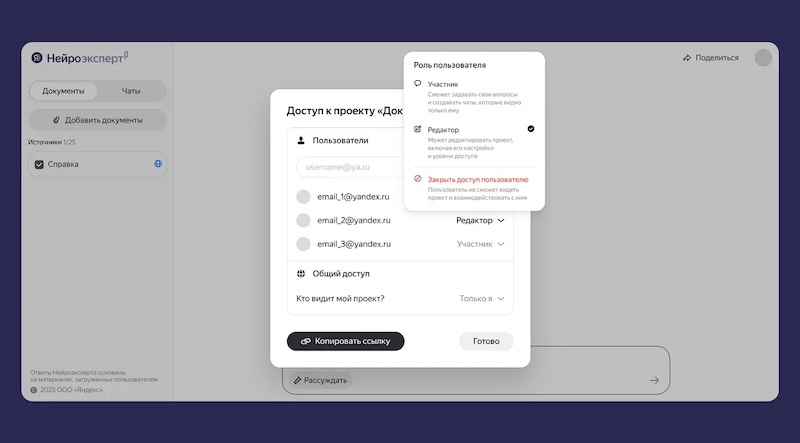

Компания «Яндекс» представила обновлённый сервис «Нейроэксперт». Он анализирует информацию на сайтах, в документах и файлах, создаёт базу знаний и находит в ней ответ на любой вопрос. Теперь сервис умеет рассуждать, изучает информацию на всём сайте по ссылке, лучше анализирует диаграммы и графики, а также поддерживает совместную работу.

Источник изображений: «Яндекс» В режиме рассуждений «Нейроэксперт» обрабатывает большой объем данных, анализирует информацию, выстраивает логическую цепочку, обосновывает свои тезисы и только после этого отвечает на запрос пользователя. Ход мысли сервиса можно проследить, чтобы понять логику ответа и при необходимости скорректировать запрос.  «Можно спросить „Нейроэксперта“, почему уменьшилась доля рынка компании в определённом сегменте, и попросить, чтобы он предложил варианты, как это исправить. Сервис даст ответ, опираясь на предоставленную информацию — к примеру, на данные с сайта компании, из её публичных новостей и финансовых отчётов», — пояснили в «Яндексе» Также теперь в поисках нужной информации можно попросить «Нейроэксперта» проанализировать все сведения на сайте, а не отдельные страницы. «Например, сервису можно дать ссылку на сайт компании и попросить найти упоминания ESG-стратегии в публичных материалах. „Нейроэксперт“ всё автоматически проанализирует, в том числе разделы „О компании“, „Новости“, „Отчёты“, и покажет подходящие упоминания на разных страницах», — привел пример «Яндекс».  Кроме того, сервис научился анализировать графики и диаграммы не только в файлах PPTX, но также в PDF и DOCX. «Нейроэксперт» даже может выводить формулы и математические символы вроде дробей, корня, возведения в квадрат и т.д.  В рамках совместной работы теперь для проекта можно задать уровни доступа и роли пользователей. Проект может быть закрытым (его видит только автор), частично доступным (можно поделиться по электронной почте) или публичным (видят все, у кого есть ссылка). Роль редактора предусматривает полное управление проектом, тогда как участник может только смотреть и задавать вопросы.  В «Нейроэксперта» можно загружать ссылки из интернета, документы, таблицы, презентации, аудио- и видеофайлы. Из них сервис создает базу знаний и на основе полученной информации отвечает на пользовательские вопросы. Услуга доступна всем пользователям. В «Яндексе» отметили, что ежемесячно «Нейроэкспертом» пользуются 350 тыс. человек, а самыми популярными темами запросов являются образование (17,6 %), юриспруденция (10,6 %), финансы (7 %), история (4,6 %), маркетинг (4,2 %), HR (3,8 %). Цукерберг снова обещает революцию — ИИ-амбиции Meta✴ напомнили о провале метавселенной

04.07.2025 [12:56],

Алексей Селиванов

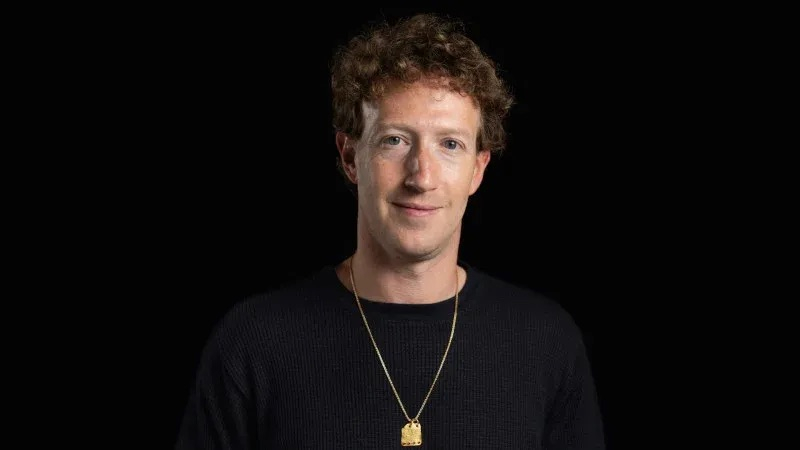

На этой неделе в служебной записке глава Meta✴✴ Марк Цукерберг (Mark Zuckerberg) поделился видением ближайшего будущего, в котором «персональный суперинтеллект для каждого» станет «началом новой эры для человечества». Звучит вдохновляюще, но всего четыре года назад он уже говорил подобное, только в отношении концепции «метавселенной», которая благополучно провалилась.

Источник изображения: Mohamed Nohassi/Unsplash Параллели между двумя масштабными проектами Meta✴✴ провели в Ars Technica. Там вспомнили презентацию 2021 года, когда гендиректор и основатель соцсети говорил о «метавселенной» — виртуальном месте, где «вы сможете делать почти всё, что только можете себе представить», и которое станет основой «следующей версии интернета». Цукерберг тогда так сильно верил в идею, что отказался от известного корпоративного бренда Facebook✴✴ в пользу нового названия Meta✴✴. Он красочно рассказывал о «ещё более захватывающем интернете», где все социальные взаимодействия, развлечения, игры и работа «будут более естественными и яркими». Было много слов о «телепортации по метавселенной», которая будет схожа с нажатием ссылки на сайте. Красивые видео показывали, как, например, женщина с помощью своего аватара в «метавселенной» виртуально присоединяется к другу на живом концерте в Токио, а потом на вечеринке после концерта покупает виртуальный мерч группы. И всё это не выходя из дома в реальности. Цукерберг рассказывал, как «сотни тысяч творцов» смогут зарабатывать продажей виртуальных товаров, которые можно будет встроить в виртуальную или даже реальную среду…

Источник изображения: about.fb.com Спустя четыре года фактически ничего из обещанного не реализовано. Даже энтузиасты описывают свой опыт в «метавселенной» как удручающий и полный одиночества. Разработчики Meta✴✴ жалуются на неудобные инструменты для работы с «метавселенной» и громоздкий код. Промежуточный итог за четыре года — $60 млрд убытка, связанного с VR. Возможно, развитию идеи еще сможет помочь выход легких и удобных очков виртуальной реальности, которые когда-то показывал Цукерберг. Однако пока их стоимость оценивается в $10 тыс., ни о каком широком внедрении таких очков говорить не приходится. Похоже, теперь Марка Цукерберга так же, как когда-то «метавселенная», вдохновляет искусственный интеллект. Он снова обещает революцию пользовательского опыта и кардинальные изменения интернета, говорит о новом способе взаимодействия друг с другом и расширении социальных связей в виртуальности — на этот раз благодаря ИИ. «ИИ может привести к появлению мира изобилия, в котором у всех есть сверхчеловеческие инструменты для создания всего чего угодно», — уверен Цукерберг. Он опять рассказал о расцвете творчества и расширении разнообразия. Да, внедрение ИИ в продукты Meta✴✴ сегодня смотрится куда успешнее по сравнению с «метавселенной». Так, Цукерберг утверждает, что уже миллиард человек ежемесячно пользуются ИИ-продуктами компании, а разработчики куда активнее применяют ИИ-инструменты. Тем не менее, считают в Ars Technica, есть причины скептически относиться к распространению ИИ. Современные модели по-прежнему искажают факты, ошибаются в рассуждениях и не справляются с простейшими задачами. Опыт с «метавселенной» подсказывает, что и эта грандиозная ставка на ИИ может обернуться разочарованием: обещали «голограммы повсюду» — получили пустующие комнаты в Horizon Worlds; обещали «высший уровень погружения» — получили неудобные контроллеры и узконаправленные приложения. Чем закончится гонка за «личным ИИ-суперинтеллектом» — пока непонятно. Несмотря на беспрецедентный массовый интерес к чат-ботам, пока нет гарантий, что «ультраперсонализированные разговоры» не обернутся очередным дорогостоящим экспериментом, похожим на провалившуюся «метавселенную». После ухода генерального директора Илья Суцкевер был вынужден возглавить основанный им стартап Safe Superintelligence

04.07.2025 [08:51],

Алексей Разин

С подачи компании Meta✴✴ Platforms, которая начала активно формировать костяк специалистов по искусственному интеллекту, видные фигуры в этой сфере невольно приняли участие в кадровых перестановках. Илье Суцкеверу пришлось возглавить свой стартап Safe Superintelligence после того, как Meta✴✴ переманила его генерального директора Даниэля Гросса (Daniel Gross).

Источник изображения: Университет Торонто Об этом сообщило агентство Reuters, напомнив заодно о роли бывшего ведущего научного специалиста OpenAI в скандальной отставке генерального директора Сэма Альтмана (Sam Altman) осенью 2023 года. После возвращения Альтмана на эту должность несколько дней спустя костяк основателей стартапа, создавшего ChatGPT, начал рассыпаться, и Суцкевер по примеру некоторых коллег основал собственную компанию Safe Superintelligence, специфику миссии которой отобразил в её названии. Даниэль Гросс (Daniel Gross), который также стоял у истоков Safe Superintelligence, не только возглавил его в должности генерального директора, но и занимался финансированием деятельности компании через собственный венчурный фонд NFDG, компаньоном по которому выступал бывший глава GitHub Нэт Фридман (Nat Friedman). Последний недавно также перешёл в Meta✴✴, как и Гросс, поэтому Суцкеверу невольно пришлось взять на себя бразды правления созданной им компании Safe Superintelligence. Суцкевер признал, что «некоторые компании интересовались покупкой» этого стартапа, и пояснил, что такое внимание ему льстит, но он предпочитает концентрироваться на работе, а не обсуждении данных слухов. CoreWeave стала первым облачным клиентом Nvidia, запустившим эксплуатацию ускорителей Blackwell Ultra

04.07.2025 [04:59],

Алексей Разин

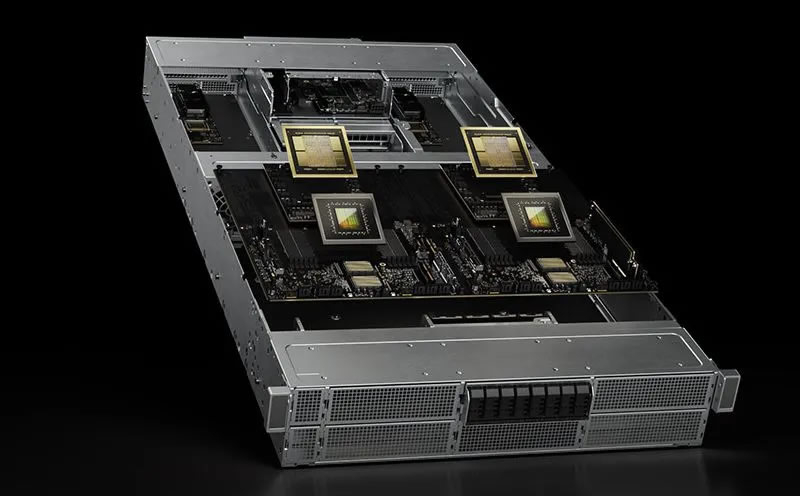

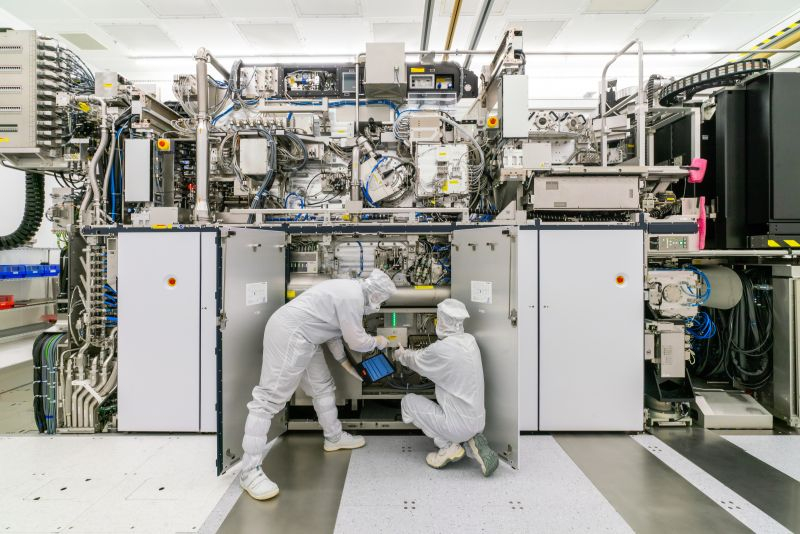

В формировании облачной вычислительной инфраструктуры принимают участие сразу несколько компаний, поэтому о начале эксплуатации систем на основе ускорителей Nvidia GB300 NVL72 (Blackwell Ultra) заявили одновременно сама Nvidia, провайдер CoreWeave, который их получил и установил, а также Dell, которая занималась их поставками.

Источник изображения: Nvidia По словам CoreWeave, переход на ускорители Blackwell Ultra позволит клиентам ощутить сокращение времени реакции рассуждающих языковых моделей в десять раз, а производительность в пересчёте на ватт потребляемой электроэнергии увеличится в пять раз. В одной стойке GB300 NVL72 содержатся 72 графических процессора Blackwell Ultra и 36 центральных процессоров Grace. По словам Dell, данные системы собираются и проходят тестирование на территории США. Данные заявления вызвали рост курса акций CoreWeave на 6 %, акции Dell Technologies подорожали примерно на 2 %, а ценные бумаги Nvidia укрепились в цене и того меньше, но она накануне приблизилась к абсолютному мировому рекорду по величине капитализации среди публичных компаний, так что ей грех жаловаться на отсутствие внимания инвесторов. По данным Nvidia, ускорители поколения Blackwell Ultra способны в единицу времени создавать в 50 раз больше ИИ-контента, чем базовый вариант Blackwell. В мае руководство Nvidia подчеркнуло, что поставки Blackwell Ultra начнутся в третьем квартале, и стоило наступить июлю, как нашёлся первый клиент компании в лице CoreWeave, заявивший о доступности соответствующих решений. Относительно небольшому провайдеру облачных вычислительных мощностей помогло то, что Nvidia является акционером CoreWeave. Nvidia сегодня может отобрать у Apple звание самой дорогой компании в истории

03.07.2025 [20:25],

Анжелла Марина

Капитализация Nvidia сегодня может установить абсолютный исторический рекорд. В течение сегодняшней торговой сессии она достигла $3,92 трлн, тем самым превзойдя рекорд Apple в $3,915 трлн, сообщает Reuters. Теперь осталось только зафиксировать достижение на закрытии сессии. Инвесторы воодушевлены, а акции компании растут благодаря высочайшему спросу на технологии искусственного интеллекта.

Источник изображения: Nvidia Nvidia, которая изначально стала известна как разработчик графических процессор для видеоигр, теперь является ключевым поставщиком чипов для обучения нейросетей. Акции компании выросли на 2,2 % и составили $160,6 на утренних торгах в четверг, позволив превзойти предыдущий рекорд Apple ($3,915 трлн), установленный в декабре 2024 года. Microsoft сегодня заняла второе место с капитализацией $3,7 трлн после роста акций на 1,4 % до $498. Apple сохранила третью позицию и поднялась на 0,5 %, а её стоимость составила $3,19 трлн. Гонка технологических гигантов — Microsoft, Amazon, Meta✴✴, Alphabet и Tesla — за лидерство в сфере ИИ и наращивание вычислительной мощности дата-центров продолжает подогревать интерес к высокопроизводительным ускорителям вычислений Nvidia. За четыре года рыночная стоимость компании выросла почти в восемь раз — с $500 млрд в 2021 году до почти четырёх триллионов сейчас. По данным ведущего мирового поставщика инфраструктуры и данных для финансовых рынков LSEG, сейчас Nvidia стоит больше, чем фондовые рынки Канады и Мексики вместе взятые, а также превосходит совокупную капитализацию всех публичных компаний Великобритании. Акции Nvidia торговались с коэффициентом P/E (цена/прибыль) на уровне 32, что ниже среднего показателя в 41 за последние пять лет. Это говорит о том, что рост прибыли компании опережает даже существенное повышение курса её акций. С апреля котировки Nvidia выросли более чем на 68 %, восстановившись после падения, вызванного заявлениями Дональда Трампа (Donald Trump) о новых глобальных пошлинах. Рост акций связан с ожиданиями, что администрация Белого дома смягчит торговые ограничения. В технологии ИИ-стартапа Anthropic обнаружена критическая уязвимость

03.07.2025 [17:14],

Павел Котов

В предложенной компанией Anthropic технологии Model Context Protocol (MCP) Inspector обнаружили критическую уязвимость, позволяющую потенциальному злоумышленнику производить атаки с использованием удалённого исполнения кода на целевых устройствах.

Источник изображения: Kevin Ku / unsplash.com Компания Anthropic наиболее известна благодаря чат-боту с генеративным искусственным интеллектом Claude, но её авторству принадлежит также MCP. Это открытый стандарт, который обеспечивает безопасную двустороннюю связь между платформами ИИ и внешними источниками данных. Открытый инструмент Inspector предназначен для тестирования и отладки серверов MCP. Как стало известно, в Inspector присутствует уязвимость, которую можно использовать для кражи конфиденциальных данных, развёртывания вредоносного ПО и горизонтального перемещения по целевым сетям. Уязвимости присвоили номер CVE-2025-49596 и критическую оценку угрозы в 9,4 балла из 10. Для эксплуатации уязвимости её необходимо использовать совместно с «0.0.0.0. Day» — уязвимостью двадцатилетней давности в браузерах, позволяющей вредоносным сайтам взламывать локальные сети. Злоумышленник создаёт вредоносный сайт, который при открытии отправляет запрос службам localhost на сервере MCP, в результате чего становится возможным выполнение произвольного кода на компьютере разработчика. Anthropic уведомили о проблеме в апреле, и 13 июня компания выпустила обновление Inspector 0.14.1, в которое добавила токен сеанса и проверку происхождения, усложнив механизм атаки. Переходы на новостные сайты из ChatGPT выросли в 25 раз, но это не компенсирует потери поискового трафика

03.07.2025 [16:50],

Павел Котов

Количество переходов с платформы ChatGPT на новостные сайты выросло, пишет TechCrunch со ссылкой на статистику Similarweb, но этого недостаточно, чтобы компенсировать снижение числа кликов из поиска — пользователи всё чаще довольствуются новостными материалами прямо в результатах поиска с искусственным интеллектом.

Источник изображения: Viralyft / unsplash.com С момента появления ИИ-обзоров в поисковой выдаче Google в мае минувшего года число поисковых запросов в веб-версии, которые не приводят к переходам на новостные сайты, выросло с 56 % до 69 % по состоянию на май 2025 года. Снизился и органический трафик: если в середине 2024 года он был 2,3 млрд переходов, то теперь стал менее 1,7 млрд. Тем временем с января 2024 по май 2025 года число новостных запросов в ChatGPT выросло на 212 %. Таким образом, для новостных ресурсов быстрое распространение ИИ меняет правила игры. Видимость в результатах поиска и качественная поисковая оптимизация играют всё меньшее значение. Позиция сайта в поисковой выдаче уже не превращается в такой большой объём трафика на сайте, как раньше. Хотя число переходов на новостные сайты из ChatGPT растёт: с января по май 2024 года их зафиксировано немногим менее 1 млн, а в 2025 году — уже 25 млн или в 25 раз больше. Но в условиях огромного снижения органического поискового трафика этого едва ли хватит, чтобы компенсировать потери. Наибольшим ростом отметились Reuters (годовой рост на 8,9 %), NY Post (+7,1 %) и Business Insider (+6,5 %), подавшая на OpenAI в суд New York Times показала рост на 3,1 %. За последние полгода аудиторию нарастила и сама ChatGPT: число пользователей приложения более чем удвоилось, количество посетителей сайта выросло на 52 %. Similarweb стала предлагать брендам и бизнесу сервис, позволяющий отслеживать видимость торговой марки в службах генеративного ИИ и сравнивать результаты с показателями конкурентов. В свете падения поискового трафика Google предложила издателям услугу Offerwall — эксперименты с альтернативными рекламе способами монетизации, например, микроплатежами и платными подписками. Но помогает это не всем — некоторые новостные ресурсы проводят сокращения и даже закрываются. Meta✴ научила ИИ-ботов писать первыми, напоминать о себе и не давать пользователю заскучать

03.07.2025 [16:02],

Алексей Селиванов

Компания Meta✴✴ тренирует настраиваемых чат-ботов быть более инициативными в долговременном общении с пользователями. Они должны сами, без запросов со стороны пользователя, напоминать о прошлых разговорах и предлагать продолжить общение.

Источник изображения: julien Tromeur/Unsplash В Meta✴✴ рассчитывают, что такая «проактивность» чат-ботов поможет вернуть пользователей на платформу Meta✴✴ AI Studio, где можно создавать различных ИИ-персонажей и чат-ботов. Об этом Business Insider пишет со ссылкой на внутренние документы компании. Над проектом под кодовым названием Omni работает подрядчик Alignerr. Цель: «принести дополнительную пользу пользователям и в итоге увеличить вовлеченность и удержание аудитории». Как выглядит такое проактивное общение? В пример приводится чат-бот под названием «Маэстро киношедевров», который должен отправлять пользователю сообщение примерно такого содержания: «Надеюсь, у вас сегодня прекрасный день! Хотел уточнить: не открыли ли вы недавно новые любимые саундтреки или композиторов? Или, может, вам нужны советы для следующего киносеанса? Дайте знать, и я с радостью помогу!» В AI Studio пользователи создают самых разных ботов — от подбирающих подходящие рецепты поваров до интерьерных стилистов. Для блогеров и инфлюенсеров боты могут брать на себя общение с фанатами и отвечать на сообщения сразу в нескольких мессенджерах и соцсетях. Представители Meta✴✴ утверждают, что ИИ будет отправлять проактивные сообщения только после того, как пользователь сам начнет диалог. Если на свое первое проактивное сообщение бот не получит ответ, то он не должен продолжать попыток связаться с человеком. Продолжать диалог по своей инициативе ИИ может только в том случае, если юзер отправил боту не менее пяти сообщений за последние 14 дней. Вот еще несколько примеров сообщений, продолженных чат-ботами по их инициативе:

Всё это помогает удерживать аудиторию. Чем дольше пользователь общается с ИИ, тем выше ценность платформы. Не зря Meta✴✴ прогнозировала выручку от своих генеративных ИИ-продуктов на уровне $2–3 млрд в 2025 году. В рамках проекта Omni предполагается сделать чат-боты более персонализированными и «контекстно-чувствительными». ИИ учитывает историю переписки, адаптируется под личность пользователя, ссылается на факты из прошлых обсуждений, учитывает контекст беседы и не затрагивает потенциально чувствительные или вредоносные темы. Инициатива по продвижению продуктивных чат-ботов вписывается в убеждения Марка Цукерберга (Mark Zuckerberg), который недавно заявил, что средний американец имеет менее трёх близких друзей, и что цифровые агенты смогут заполнить этот социальный вакуум. В Gmail, «Диске» и других сервисах Google появились ИИ-боты Gem, настраиваемые под конкретные задачи

03.07.2025 [15:43],

Павел Котов

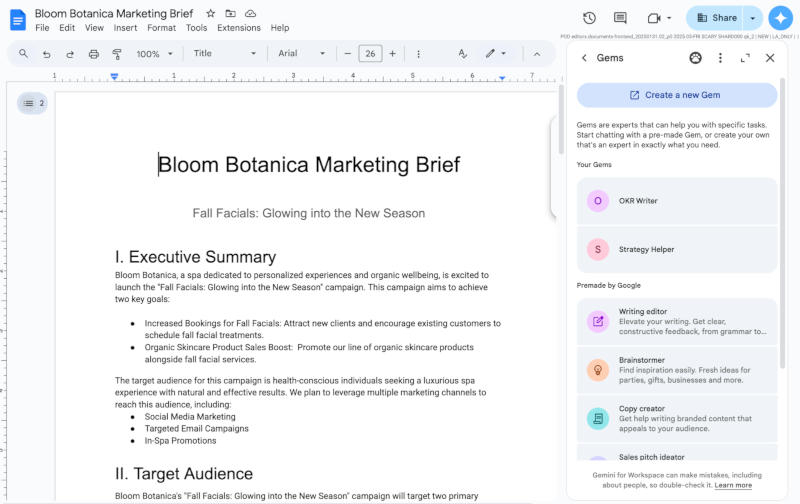

Google открыла пользователям приложений Workspace доступ к Gem — настраиваемым версиям помощника с искусственным интеллектом Gemini, которые специализируются на определённых задачах, и приложение Gemini для этого открывать не требуется.

Источник изображения: workspaceupdates.googleblog.com Чат-боты Gem открываются на боковой панели в службах «Документы», «Таблицы», «Презентации», «Диск» и Gmail — для работы с определённым чат-ботом не потребуется переключаться между приложениями. Управляя чат-ботом, можно сделать его «экспертом» в определённых задачах, с которыми пользователь работает регулярно — это может быть написание текстов для одного бренда или подготовка к экзаменам. Google также предлагает настроенные версии Gem для редактирования текста, написания кода, генерации идей для продаж и для других целей. Вот какие варианты предлагает сама компания:

Ранее настраиваемыми чат-ботами Gem можно было пользоваться только в приложении Gemini. Сейчас создавать новые варианты можно прямо из боковой панели Workspace. Новые возможности начали развёртываться для всех пользователей платформы с доступом к Gemini со вчерашнего дня, но в отдельных случаях придётся подождать «более 15 дней». ASML, Mercedes-Benz и десятки компаний попросили ЕС отложить «Закон об ИИ» на два года

03.07.2025 [14:18],

Алексей Разин

Принятый ещё в прошлом году в Евросоюзе «Закон об ИИ» был призван установить ограничения в части использования систем искусственного интеллекта, направленные на предупреждение злоупотреблений. Уже в августе новые правила работы с ИИ на территории ЕС должны вступить в силу, но группа местных компаний обратилась к руководству Еврокомиссии с просьбой отсрочить это событие на два года.

Источник изображения: ASML Обсуждаемый закон подразумевал, что разработчики больших языковых моделей будут отчитываться европейским регуляторам о способах обучения этих моделей, а также соблюдать интересы правообладателей. Власти региона также должны получать от разработчиков информацию об архитектуре их систем и мерах по обеспечению безопасности их применения. Вводился запрет на использование систем ИИ для автоматического распознавания лиц в местах массового нахождения людей в масштабе реального времени. Добровольный характер следования этим правилам не отменял суровости наказания за их нарушение. Оборотные штрафы, предусмотренные европейским законодательством в этой сфере, могли варьироваться от 3 до 7 % годовой выручки компании, обвиняемой в нарушении. Представители Meta✴✴ Platforms и Alphabet выступили с критикой предлагаемых европейскими властями правил, назвав их неработоспособными и неприменимыми на практике. Группа из более чем 45 компаний обратилась на этой неделе с открытым письмом к главе Еврокомиссии Урсуле фон дер Ляйен (Ursula von der Leyen), в котором попросила отсрочить вступление закона в его существующем виде на два года. В нынешнем виде вводимые европейскими властями ограничения, по мнению авторов письма, подрывают инновации в сфере искусственного интеллекта. В этом случае нельзя торопиться, по мнению представителей инициативы EU AI Champions, и нужно отдать приоритет качеству регулирования отрасли, а не скорости введения запретов. Инициативу уже поддержали ASML, Mercedes-Benz, Lufthansa, Siemens Energy AG, Airbus и Mistral. Ранее американские чиновники также обратились к европейским коллегам с просьбой пересмотреть некоторые подходы к регулированию этой перспективной отрасли. Тем более, что рабочие группы сильно отстают от намеченного графика, и формируемые ими правила получаются очень «сырыми». |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |