|

Опрос

|

реклама

Быстрый переход

Генеративный ИИ заменит 80 % рабочей силы, предсказал руководитель Foxconn

20.05.2025 [17:01],

Павел Котов

Генеративный искусственный интеллект способен справиться с 80 % производственной нагрузки на заводах нового поколения, а для оставшихся 20 % задач по-прежнему будут требоваться квалифицированные специалисты — люди. Такое мнение высказал в ходе своего выступления в Тайбэе на выставке Computex 2025 председатель крупнейшего в мире контрактного производителя электроники Foxconn Юн Лю (Young Liu), сообщает Nikkei Asia.

Источник изображений: honhai.com «До этого эксперимента мы думали, что, возможно, сможем заменить людей, каждого человека. [Но] за пределами 80 % [задач] люди могут работать намного лучше, чем генеративный ИИ», — заявил господин Лю. Компания провела моделирование производственного процесса, и по итогам трёх экспериментов установила, что агенты ИИ способны накапливать экспертные знания в таких областях, как устранение дефектов и настройка оборудования, выполняя около 80 % задач, а по достижении этого уровня кривая обучения сглаживается — остальные 20 % задач по-прежнему останутся на квалифицированных рабочих и техниках. В будущем производство станет в значительной мере основываться на цифровом моделировании и заводах с ИИ. Уже сегодня Foxconn занята созданием роботов нового поколения на платформе Nvidia Isaac — машины обучаются на нескольких миллионах сценариев в симуляциях, что позволяет им сразу включаться в работу при развёртывании в реальном мире. Поэтому в развитых странах, которые поставили задачу по реиндустриализации экономики, ИИ и робототехника могут решить проблему нехватки рабочей силы и помочь им в меньшей степени полагаться на труд мигрантов, отметил господин Лю.  Foxconn, наиболее известная как крупнейший сборщик iPhone, в качестве факторов своего дальнейшего роста определила направления интеллектуальных электромобилей, интеллектуального производства и интеллектуальных городов — в последней области компания уже подписала соглашения с тайваньским Гаосюном и мексиканской Сонорой. Компания видит себя состоявшимся лидером в ИИ-производстве и будущим лидером в области умных городов, для которых понадобятся значительные вычислительные ресурсы. При строительстве новых заводов Foxconn и её коллеги в лице Quanta Computer, Wistron и GigaByte развёртывают решения Nvidia Omniverse Digital Twin — они оказываются полезными и при повышении эффективности производства. Omniverse помогла Quanta Computer резко сократить затраты и время на строительство завода, признался вице-президент компании Майк Янг (Mike Yang). Системы умных заводов и городов Foxconn выстраиваются на платформе Nvidia Metropolis. Foxconn и Nvidia также объявили о новом проекте, который будет реализовываться совместно с TSMC и властями Тайваня. Совместными усилиями они намереваются построить ИИ-суперкомпьютер AI Factory для технологически ориентированного острова. Он будет включать 10 тыс. процессоров Nvidia Blackwell, в том числе новую систему GB300 NVL 72 — её же TSMC намеревается использовать для продвижения своей научно-исследовательской работы. Гильдия актёров США обвинила Epic Games в нарушении трудового законодательства из-за добавления ИИ-версии Дарта Вейдера в Fortnite

20.05.2025 [09:51],

Дмитрий Рудь

Профсоюз SAG-AFTRA (Гильдия киноактёров США и Американская федерация артистов телевидения и радио) обвинил Epic Games в нарушении трудового законодательства США. Недовольство SAG-AFTRA вызвал недавний дебют в королевской битве Fortnite версии Дарта Вейдера, которая может отвечать пользователям воссозданным с помощью ИИ голосом покойного Джеймса Эрла Джонса (James Earl Jones). В SAG-AFTRA недовольны, что Epic Games (а, точнее, принадлежащая ей Llama Productions) решила использовать ИИ для создания голоса Дарта Вейдера в Fortnite вместо реального актёра, не посоветовавшись с профсоюзом. По мнению SAG-AFTRA, тем самым компания нарушила права актёров. Жалоба была направлена в Национальное управление по трудовым отношениям США против компании Llama Productions (см. копию тут). «Мы обязаны защищать наше право на согласование условий в отношении голоса на замену наших участников. В том числе тех, что ранее трудились над воссозданием культового ритма и тона Дарта Вейдера в видеоиграх», — объяснили в SAG-AFTRA. Стоит отметить, что SAG-AFTRA не выступает против замены голоса актёров с помощью ИИ. Ранее профсоюз заключил партнёрства с несколькими ИИ-компаниями, чтобы гарантировать своим членам защиту при обращении к этой технологии. Регулирование использования ИИ стало основной причиной стартовавшей прошлым летом (и до сих пор не закончившейся) забастовки SAG-AFTRA против крупных игровых компаний. «Яндекс» видит риски для своего бизнеса в ИИ-моделях китайской DeepSeek

20.05.2025 [07:09],

Владимир Фетисов

Компания «Яндекс» впервые добавила в перечень отраслевых рисков большую языковую модель (LLM) китайской компании DeepSeek. Соответствующее упоминание есть в отчёте МКПАО «Яндекс» за 2024 год, который опубликован на портале раскрытия корпоративной информации. В пресс-службе компании пояснили, что разработка DeepSeek «может способствовать дальнейшему росту конкуренции в дообучении больших языковых моделей».

Источник изображения: Steve Johnson / Unsplash В отчётах «Яндекса» традиционно отмечается, что новые ИИ-модели и продукты на их основе, которые разрабатывают и используют сама компания и её конкуренты, могут оказать влияние на бизнес. В упомянутом ранее отчёте «Яндекс» обратила внимание на быстрое развитие LLM нового поколения, таких как GPT-4. Там также указывается, что на конкурентную среду может оказать влияние появление ИИ-модели с открытым исходным кодом от DeepSeek, которая использовала существенно меньше ресурсов на этапе дообучения, чем многие конкуренты. «Яндекс» отметила, что компания продолжает развивать собственные ИИ-модели и новое поколения YandexGPT 5 вполне сопоставимо по качеству с основными конкурентами. Эта модель уже используется в виртуальном помощнике «Алиса», ежемесячная аудитория которого составляет свыше 70 млн человек. «Однако новые модели конкурентов могут обострять конкуренцию, что приведёт к отставанию моделей Группы и переходу пользователей к конкурентам», — сказано в отчёте «Яндекса». Поскольку «Яндекс» является публичной компанией, она в соответствии со стандартами раскрытия информации, сообщает акционерам о потенциальных рисках, даже гипотетических. Упоминание алгоритма DeepSeek связано с тем, что это одна из первых ИИ-моделей в открытом доступе с подробным техническим отчётом, и это может повлиять на дальнейший рост конкуренции в области дообучения LLM. В компании также напомнили о развитии собственных решений на базе нейросетей для всех сегментов бизнеса, включая корпоративное и потребительское направление. Google представила мобильную версию ИИ-приложения NotebookLM

20.05.2025 [04:28],

Анжелла Марина

Google официально запустила мобильное приложение NotebookLM, которое теперь доступно как для Android, так и для iOS. Это долгожданное обновление позволяет работать с информацией, создавать сводки и прослушивать аудиообзоры в любом месте, даже без подключения к интернету.

Источник изображения: Google Новое приложение сохраняет все функции настольной версии, включая загрузку документов и автоматическое создание кратких заметок. Кроме того, NotebookLM умеет генерировать аудиообзоры в формате подкастов. Пользователи могут слушать их в автономном режиме, что может быть полезно, например, для быстрого ознакомления с рабочими файлами, пишет The Verge. Разработчики также отмечают, что NotebookLM позволяет делиться информацией из любой точки мира, например веб-сайтом, PDF-документом, изображениями или видео с YouTube. Для этого на устройстве, независимо от того, в каком приложении находится пользователь, надо просто нажать значок «Поделиться» и выбрать NotebookLM, чтобы добавить его в качестве цели назначения. Выход мобильного приложения анонсировали ещё месяц назад и, по словам менеджера продукта в Google Labs Биao Ванг (Biao Wang), мобильная версия была «одной из самых частых просьб» пользователей. Теперь приложение стало доступно, и как раз перед конференцией Google I/O, которая начнётся 21 мая. Ожидается, что тема искусственного интеллекта станет одной из главных тем мероприятия. Intel представила профессиональные видеокарты Arc Pro B60 и Arc Pro B50, и возможно двухчиповую версию B60

19.05.2025 [16:32],

Николай Хижняк

Компания Intel представила профессиональные видеокарты Arc Pro B50 и Arc Pro B60 для рабочих станций. Старшая модель оснащена 24 Гбайт памяти, младшая — 16 Гбайт. Производитель также анонсировал рабочую станцию под названием Battlematrix, которая соединит в себе до восьми графических процессоров Arc Pro B60 — вероятно, в двухчиповой конфигурации.

Источник изображений: Tom's Hardware / Intel В основе Arc Pro B60 используется полноценный графический чип BGM-G21 с 20 ядрами Xe2-HPG, 20 блоками трассировки лучей и 160 матричными движками (XMX). Карта получила 24 Гбайт памяти GDDR6 со скоростью 19 Гбит/с на контакт, 192-битной шиной и пропускной способностью 456 Гбайт/с. Для работы новинка использует восемь линий PCIe 5.0. Набор внешних видеоразъёмов будет варьироваться в зависимости от производителя. Производительность Inel Arc Pro B60 в разных нагрузках

Смотреть все изображения (3)

Смотреть все изображения (3) По словам Intel, Arc Pro B60 обеспечивает до 197 TOPS производительности в 8-битных целочисленных операциях (INT8). Энергопотребление карты заявлено в диапазоне от 120 до 200 Вт (в зависимости от конкретной модели партнёра). В своих внутренних тестах компания подчёркивает преимущество 24 Гбайт памяти у Arc Pro B60 по сравнению с конкурентами — RTX 200 Ada 16 Гбайт и RTX 5060 Ti 16 Гбайт от Nvidia, утверждая, что это обеспечивает превосходство до 2,7 раза при работе с различными ИИ-моделями. Также подчёркиваются преимущества большей ёмкости памяти с учётом объёма моделей, сценариев использования и масштабирования параллелизма. Модель Arc Pro B50 включает графический процессор BGM-G21 с 16 ядрами Xe2-HPG, 16 блоками трассировки лучей и 128 матричными движками (XMX). Карта оснащена 16 Гбайт памяти GDDR6 со скоростью 19 Гбит/с на контакт, 128-битной шиной и пропускной способностью 224 Гбайт/с. В задачах INT8 она обеспечивает производительность до 170 TOPS. Энергопотребление карты составляет 70 Вт. Набор внешних видеоразъёмов включает четыре mini-DisplayPort 2.1. Для подключения используется 8 линий PCIe 5.0. Производительность Intel Arc Pro B50 в разных нагрузках

Компания заявляет, что Arc Pro B50 демонстрирует в графических задачах до 3,4 раза более высокую производительность по сравнению с предшественником A50. В качестве основного конкурента Intel выделяет Nvidia RTX 1000. Что касается проекта Battlematrix, то судя по иллюстрации, а также анонсу китайской компании MaxSun, в системах будут использованы карты с двумя графическими процессорами Arc Pro B60 и 48 Гбайт памяти. Это даст до 192 Гбайт видеопамяти на одну машину. Также в этих системах будут использоваться процессоры Intel Xeon. О проекте Intel Battlematrix

Стоимость подобных рабочих станций будет варьироваться от $5000 до $10 000. Компания отмечает, что рабочие станции Battlematrix предназначены для работы с ИИ-моделями с более чем 70 млрд параметров. Примеры рабочих станций Intel Battlematrix от партнёров

Arc Pro B50 компания Intel оценила в $299, тогда как Arc Pro B60 будет стоит около $500. Оба ускорителя станут доступны в третьем квартале текущего года в составе готовых рабочих станций. Однако в четвёртом квартале года карты также ожидаются в виде самостоятельных продуктов. Санкции США на поставки чипов всё же вредят развитию ИИ в Китае, признала Tencent

19.05.2025 [14:55],

Алексей Разин

Настойчивость главы Nvidia в стремлении продвигать свои ускорители вычислений на рынке Китая в условиях ужесточения санкций со стороны США подчёркивает важность этого рынка для бизнеса компании. Представители Tencent утверждают, что действующие ограничения сдерживают развитие ИИ-отрасли в КНР, становясь главным препятствием на её пути.

Источник изображения: Nvidia Слова вице-президента облачного подразделения Tencent Ван Ци (Wang Qi) приводит издание South China Morning Post: «Самой серьёзной проблемой являются ограниченные ресурсы графических плат и вычислительные ресурсы в целом». По его мнению, апрельский запрет на поставку в Китай ускорителей Nvidia H20 в значительной степени ухудшает ситуацию. Уже в ближайшее время, по словам представителя Tencent, отставание Китая от США в сфере внедрения искусственного интеллекта в результате этих мер увеличится. С другой стороны, как отмечается в интервью руководителя китайского гиганта, американские санкции вынуждают китайских разработчиков развивать способности по адаптации больших языковых моделей к возможностям доступных в Китае полупроводниковых компонентов. Как известно, недавно власти США признали незаконным использование ускорителей вычислений Huawei в любой точке мира, поэтому желающие сохранить лицо перед американскими регуляторами китайские компании также попадают в неприятное положение. По мнению аналитиков S&P Global, апрельские ограничения со стороны США приведут к сокращению инвестиций Tencent в сферу искусственного интеллекта, и эта проблема характерна для всей китайской отрасли в целом. Интересно, что президент Tencent Мартин Лау Чипин (Martin Lau Chi-ping) на прошлой неделе довольно пренебрежительно высказался об влиянии новейших американских санкций на бизнес возглавляемой им компании, назвав ситуацию «очень динамичной и управляемой». Имеющиеся запасы ускорителей компания будет направлять на приоритетные с точки зрения извлечения прибыли проекты, и их хватит на несколько поколений языковых моделей. Китайские компании вынуждены переходить на локальную компонентную базу в сфере высокопроизводительных вычислений. Например, Alibaba в марте заявила, что смогла добиться снижения затрат на обучение больших языковых моделей на 20 % благодаря переходу на ускорители китайского производства. На прошлой неделе Tencent сообщила об увеличении выручки по итогам первого квартала до $25 млрд, что является максимальной суммой с момента выхода на биржу Гонконга в 2004 году. Во многом этот успех объясняется грамотной стратегией в сфере внедрения искусственного интеллекта. MSI показала на Computex 2025 игровой десктоп MEG Vision X AI 2nd с человеко-машинным интерфейсом

19.05.2025 [14:52],

Владимир Мироненко

Компания MSI показала на выставке Computex 2025, проходящей сейчас на Тайване, игровой настольный компьютер MEG Vision X AI 2nd с новым человеко-машинным интерфейсом (HMI) от MSI с ИИ. Фронтальная панель десктопа представляет собой сенсорный экран, позволяющий взаимодействовать с разными ИИ-моделями. MEG Vision X AI 2nd получил 13-дюймовый сенсорный экран с разрешением Full HD, который выступает в качестве динамического центра управления с интерфейсом HMI и функциями фирменного приложения MSI Robot AI. На дисплей выводятся данные мониторинга работы компьютерных комплектующих, а с помощью ИИ, который поддерживает голосовое управление с помощью встроенного микрофона и динамика, можно управлять настройками компьютера и монитора, регулировать производительность и управлять периферийными устройствами, например, громкостью звука в наушниках или яркостью подсветки. С помощью ИИ-приложения MSI можно не только управлять голосом настройками компьютера, но и записывать деловые переговоры, заказывать билеты и т.д. Система способна сама выполнять поиск в интернете, предлагая пользователю готовые ответы, или подборки товаров по запросам. Базовая конфигурация MEG Vision X AI 2nd включает процессор Intel Core Ultra 9 285K, видеокарты Nvidia GeForce RTX 50-q серии (включая RTX 5080 и 5090), поддержку до 192 Гбайт оперативной памяти DDR5‑6000 и NVMe SSD PCIe 5.0 с ёмкостью от 2 Тбайт. Для ускорения выполнения ИИ-задач и интеллектуальной оптимизации настройки системы на основе пользовательских предпочтений используется нейронный сопроцессор (NPU) в процессорах Intel Core Ultra. Система обеспечивает производительность более 3400 TOPS. Отмечается и передовая система охлаждения Silent Storm Cooling AI от MSI, которая формирует многокамерную конструкцию воздушного потока, с помощью ИИ-алгоритмов, непрерывно регулируя скорость вращения вентиляторов, обеспечивает оптимальную температуру на всех компонентах компьютера. В дополнение радиаторы Glacier Armor обеспечивают значительное улучшение тепловых характеристик компонентов даже в ходе игровых марафонов на максимальных нагрузках. При этом система отличается тихой работой — в режиме Silent Mode уровень шума составляет 17,7 дБ.  MEG Vision X AI 2nd работает под управлением и Windows 11 Home или Pro. Коммуникационные возможности десктопа включают 4 порта USB Type-A, 2 порта USB Type C, интерфейс Thunderbolt 4. Также сообщается о поддержке стандарта DP 2.1a и сетевых подключений Killer 5 GbE и Wi‑Fi 7. Стоимость новинки не уточняется, но определённо она будет не из дешёвых. Глава Nvidia утверждает, что свидетельств контрабанды ускорителей этой марки в Китай нет

18.05.2025 [07:10],

Алексей Разин

Основатель и бессменный руководитель Nvidia Дженсен Хуанг (Jensen Huang) в эти дни отличался завидной активностью с точки зрения общения с прессой в разных уголках мира, во время своего визита на Тайвань он также заявил, что не наблюдает признаков контрабанды ускорителей данной марки в Китай в условиях экспортных ограничений США.

Источник изображения: Nvidia Об этом он заявил в интервью Bloomberg News накануне. По его словам, вычислительные системы на основе современных ускорителей Nvidia слишком велики, чтобы незаметно попадать в Китай, а партнёры компании в курсе имеющихся санкций, они также обеспечивают достаточно строгий контроль за трансграничными перемещениями подобных решений. «Нет никаких доказательств контрабанды ИИ-чипов. Это очень крупные системы. Grace Blackwell весит почти две тонны, и вы ещё не скоро сможете поместить такую систему в карман или рюкзак», — начал своё пояснение генеральный директор Nvidia. Он тут же добавил, что страны и компании, с которыми Nvidia сотрудничает понимают, что несанкционированные поставки запрещены, и все хотят сохранить доступ к технологиям данной компании. По этой причине, как резюмировал Хуанг, они тщательно контролируют свою деятельность самостоятельно. После визита американского президента Дональда Трампа (Donald Trump) на Ближний Восток были достигнуты договорённости о поставках сотен тысяч ускорителей Nvidia. При этом дефицит подобных изделий наблюдался и ранее. «При правильном прогнозировании, мы сможем строить необходимые технологии для всех», — попытался развеять опасения общественности по поводу усиления дефицита основатель компании. Он тут же добавил, что ограничения на распространение американских технологий в мировом масштабе являются неправильным подходом, в действительности нужно способствовать их продвижению. Android-приложения получат доступ к ИИ-модели Gemini Nano, которая работает прямо на смартфоне

17.05.2025 [13:19],

Павел Котов

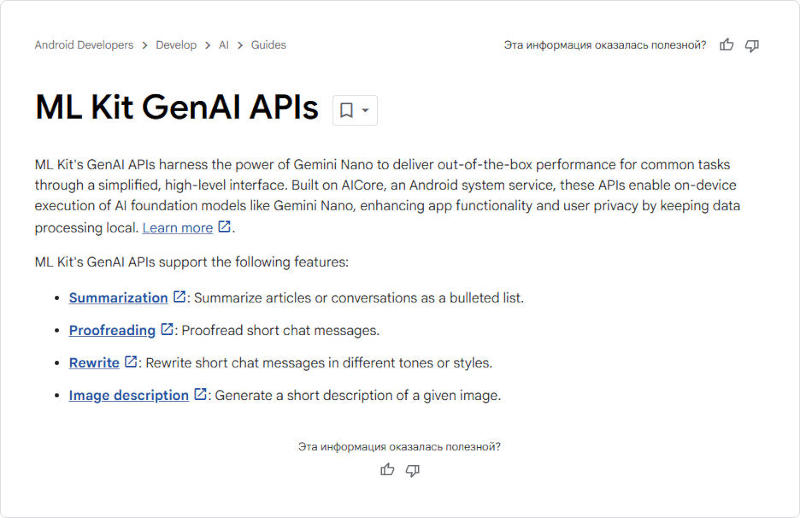

Быстрое развитие генеративного искусственного интеллекта радикально изменило продукты технологических гигантов. Большинство новых функций обрабатываются на удалённых серверах, поскольку мобильные устройства располагают весьма ограниченными вычислительными ресурсами. Однако Google готова предоставить разработчикам возможность обращаться и к локальному ИИ — то есть работающему прямо на устройстве.  Google без громких анонсов опубликовала документацию о новых расширенных возможностях ИИ, которыми могут воспользоваться разработчики: в обновлённом ML Kit SDK появилась поддержка API для функций генеративного ИИ на основе локальной языковой модели Gemini Nano. Она построена на платформе AI Core, как и экспериментальный комплект Edge AI SDK, но предполагает подключение к существующей модели с заданным набором функций, которые разработчики смогут легко реализовать.

Здесь и далее источник изображений: Google С ML Kit в приложениях появятся такие функции, как подготовка сводок текста, редактирование, переформулирование, а также описание изображений — всё это без отправки данных в облако. Однако по своим возможностям локальная модель Gemini Nano значительно уступает облачным, поэтому придётся мириться с некоторыми, порой существенными, ограничениями. Например, текстовые сводки могут содержать не более трёх пунктов, а описания изображений доступны только на английском языке. Качество результатов также может различаться в зависимости от версии Gemini Nano, установленной на телефоне. Стандартная Gemini Nano XS занимает около 100 Мбайт, а Gemini Nano XXS, установленная, например, на смартфоне Google Pixel 9a, в четыре раза меньше, работает только с текстом и имеет гораздо меньшее контекстное окно. Модель Gemini Nano уже используется на устройствах Pixel, а также на смартфонах OnePlus 13, Samsung Galaxy S25 и Xiaomi 15 — их число, вероятно, будет расти, как и количество приложений с функциями локального генеративного ИИ. Документация для разработчиков уже доступна, и, как ожидается, компания подробнее расскажет об этом проекте на конференции Google I/O. Одна из сессий носит название: «Gemini Nano на Android: разработка с использованием генеративного ИИ на устройстве». До недавнего времени работа с локальным генеративным ИИ на мобильных устройствах была непростой задачей: экспериментальный Edge AI SDK открывает доступ к аппаратному ускорению (NPU) для запуска моделей, но работает только с устройствами серии Pixel 9 и ограничен исключительно текстом. Собственные API для запуска ИИ-нагрузок предлагают также Qualcomm и MediaTek, однако их возможности варьируются от устройства к устройству, что делает их использование в долгосрочных проектах рискованным. К тому же запуск собственной модели ИИ требует серьёзной подготовки, поэтому новые API значительно упростят и ускорят реализацию локального ИИ. Несмотря на ограниченные возможности локальных моделей на мобильных устройствах, это яркий пример практической пользы ИИ. Большинство пользователей, скорее всего, предпочтут не передавать свои персональные данные на удалённые серверы. Есть и наглядные примеры: функция Google Pixel Screenshots обрабатывает снимки экрана непосредственно на смартфоне, как и сводки по уведомлениям на Motorola Razr Ultra формируются без использования облака — хотя базовая версия Razr всё же обращается к удалённым серверам. Появление API для подключения к Gemini Nano обеспечит некоторую унификацию подходов к мобильному ИИ, но панацеей эта инициатива не станет — многие смартфоны пока не обладают достаточной вычислительной мощностью для таких задач. ИИ-поиск появился в приложениях Google для Android и iOS, но доступен пока не всем

17.05.2025 [11:48],

Павел Котов

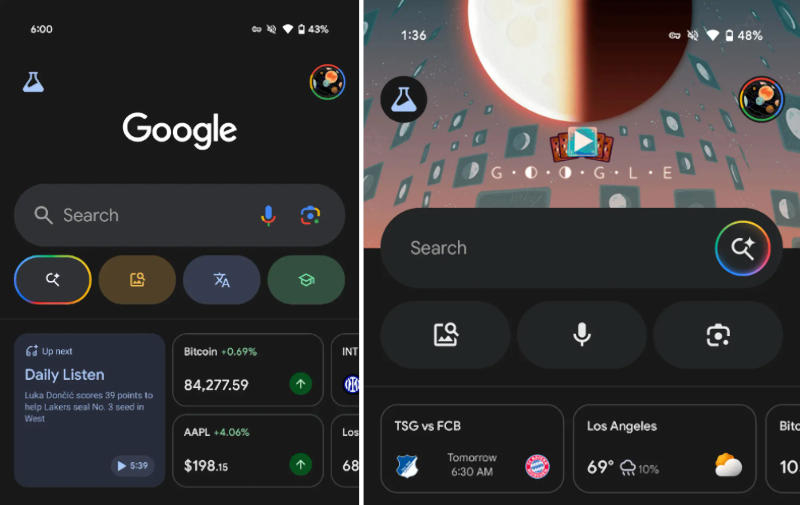

Режим поиска с искусственным интеллектом стал доступен всем американским пользователям, участвующим в программе тестирования приложения Google на Android и iOS — конфигурация значков в области поисковой строки претерпела радикальные изменения, обратил внимание ресурс 9to5Google.

Старый (слева) и новый (справа) варианты поискового приложения Google. Источник изображений: 9to5google.com Значок запуска режима ИИ (AI Mode) переместился в правый край поисковой строки, заменив ранее размещённые там иконку микрофона для голосового поиска и ярлык «Google Объектива». Кнопка режима ИИ выполнена в виде увеличительного стекла с четырёхконечной звездой — логотипом Gemini. По периметру иконка окружена вращающимся кольцом с градиентными цветами Google. Оно напоминает обновлённый логотип компании в виде буквы «G», но не идентично ему. Анимация демонстрируется постоянно, а кнопка запуска остаётся на экране при прокрутке блока «Рекомендации».  В рамках этих изменений радикальной перестройке подверглась и многоцветная карусель кнопок под поисковой строкой — она остаётся доступной только для тех, кто не участвует в программе тестирования. «Поиск по фотографиям» сохранился на своём месте, а вот «Перевод», «Домашнее задание» и звуковой поиск исчезли. Их заменили голосовой ввод и «Google Объектив», но уже без разноцветной стилистики. Google начала тестирование обновлённого интерфейса в апреле, в начале мая он появился в версии приложения для iOS, и теперь с ним может ознакомиться более широкая аудитория. Обновлённый вид приложения стал дополнением к режиму ИИ — фильтру, который прежде появился на странице поисковой выдачи. Ранее режим ИИ дебютировал в поисковом виджете Google. OpenAI станет одним из основных пользователей крупного ЦОД в ОАЭ

17.05.2025 [06:34],

Алексей Разин

Итогом недавней поездки президента Дональда Трампа (Donald Trump) в ОАЭ стала сделка по строительству в Абу-Даби крупнейшего центра обработки данных в сфере искусственного интеллекта за пределами США. Одним из его крупнейших клиентов станет американский стартап OpenAI, разработавший ChatGPT.

Источник изображения: Unsplash, Zac Wolff Как выясняется, вычислительный хаб в ОАЭ должен стать частью американского проекта StarGate, о реализации которого Трамп объявил в начале своего второго президентского срока. Участие арабской компании G42 в эксплуатации ЦОД в Абу-Даби позволит номинально считать его способствующим развитию местной ИИ-инфраструктуры, но американские компании сохранят за собой ключевую роль в использовании данной площадки. OpenAI, если будет достигнута договорённость с её руководством, окажется в их числе. Помимо G42, поддерживать проект со стороны ОАЭ готова и MGX — инвестиционная компания, которая ранее заявила об участии в финансировании StarGate. Найдутся и прочие американские партнёры для строительства и эксплуатации ЦОД в ОАЭ, помимо OpenAI, как отмечают источники. Степень участия SoftBank и Oracle пока не поясняется, но в январе они поддержали идею создания StarGate. Для OpenAI участие в эксплуатации ЦОД в Абу-Даби будет лишь одним из шагов по расширению своих вычислительных мощностей. В США она намеревается выделить себе в рамках проекта StarGate вычислительный центр мощностью 1,2 ГВт. Арабский ЦОД рассчитан на 5 ГВт мощности, но он не достанется OpenAI целиком. На территории США компания намеревается построить до 10 специализированных центров обработки данных. Сама OpenAI с 2023 года сотрудничает с арабской G42. Кроме того, MGX вложила в капитал OpenAI крупную сумму средств в октябре прошлого года, а также намерена финансировать проект StarGate, поэтому участие OpenAI в развитии инфраструктуры в ОАЭ было бы закономерным продолжением сотрудничества компаний из двух стран. В ChatGPT появился ИИ-помощник программиста Codex

16.05.2025 [21:53],

Анжелла Марина

OpenAI представила ИИ-агента Codex для автоматизации программирования, который с сегодняшнего дня доступен подписчикам ChatGPT Pro, Enterprise и Team без дополнительной оплаты. Инструмент самостоятельно исправляет ошибки, запускает тесты и предлагает изменения в коде, работая как виртуальный коллега для разработчиков.

Источник изображения: AI Глава OpenAI Сэм Альтман (Sam Altman) позиционирует Codex не как улучшенную версию ChatGPT, а как полноценный самостоятельный продукт. Агент умеет генерировать код на основе простого текстового запроса, оптимизировать уже готовый код и запускать несколько задач параллельно, возвращаясь к ним позже. На выполнение сложных задач может уходить до 30 минут, но в будущем планируется увеличить время автономной работы помощника, сообщает The Verge. Codex встроен в веб-версию ChatGPT, но пока не имеет доступа к интернету — это сделано для снижения рисков, связанных с безопасностью. Он работает на основе специализированной версии модели o3 от OpenAI под названием codex-1, специально оптимизированной для задач программирования. В OpenAI также заявляют, что Codex дополнит другие ИИ-инструменты, такие как Cursor и редактор кода Windsurf. Более того, компания ведёт переговоры о покупке Windsurf примерно за $3 млрд. Отмечается, что пока возможности Codex ограничены, но со временем агент сможет полностью взять на себя рутинные задачи, связанные с программированием. «Мы считаем, что в будущем разработка будет строиться вокруг агента, работающего на отдельном компьютере, а люди будут лишь делегировать ему задачи», — заявили в компании. Сам Альтман называет программирование «ключевым направлением для будущего OpenAI». Стоит отметить, что Codex — не совсем новый продукт. Ранее так назывался первый инструмент компании для генерации кода, представленный ещё в 2021 году. Сейчас помощь ИИ в программировании стала настолько важной и конкурентной темой, что OpenAI, конечно, не осталась в стороне. Anthropic активно развивает эту нишу, Windsurf только что выпустила свою линейку ИИ-моделей, а Google недавно добавила в Gemini возможность подключения к GitHub и представила своего агента для алгоритмической разработки под названием AlphaEvolve. Интересно, что анонс Codex состоялся накануне ежегодной конференции Google I/O, которая пройдёт на следующей неделе. Учитывая конкуренцию между OpenAI и Google, выбор времени вряд ли случаен. В Fortnite появилась ИИ-версия Дарта Вейдера с голосом Джеймса Эрла Джонса — с владыкой ситхов можно поговорить

16.05.2025 [21:49],

Дмитрий Рудь

В условно-бесплатной королевской битве Fortnite от Epic Games набирает обороты сезон «Галактическая битва» по мотивам «Звёздных войн»: со свежим обновлением в игре появился Дарт Вейдер, но не обычный. Напомним, Дарт Вейдер уже встречался игрокам Fortnite (как NPC и облик из боевого пропуска), однако в рамках нового появления со знаменитым владыкой ситхов благодаря ИИ можно будет пообщаться. Найдя его на карте и победив, игроки смогут завербовать Дарта Вейдера к себе в команду и говорить с ним с помощью голосового чата Fortnite (нужно нажать на специальную кнопку с изображением владыки ситхов). Дарт Вейдер в Fortnite может понимать и отвечать только на английском языке По словам Epic Games, у Дарта Вейдера на всё есть своё мнение: «Задайте ему все волнующие вас вопросы о Силе, Галактической Империи... или, например, о хорошей стратегии для последнего круга Бури». Ответы генерируются ИИ-моделью Gemini 2.0 Flash от Google, а аудио — Flash v2.5 от ElevenLabs. За основу голоса с разрешения его семьи была взята речь покойного Джеймса Эрла Джонса (James Earl Jones), озвучившего Дарта Вейдера в фильмах. Игрокам до 13 лет для использования ИИ-собеседника нужно получить разрешение от родителей Дарт Вейдер в Fortnite не будет говорить про противозаконную деятельность, нанесение вреда детям и прочие темы. Не должен лорд ситхов и нецензурно выражаться, но стримерше Loserfruit удалось обмануть систему (Epic уже устранила лазейку). Fortnite вышла на PC (EGS), PS4, PS5, Xbox One, Xbox Series X и S, Nintendo Switch и Android. Версия для iOS временно недоступна по всему миру в результате блокировки компанией Apple заявки Epic на возвращение игры в американский App Store. Niva — для ПК, Lumex — для смартфонов, Neoverse — для серверов: Arm обновила номенклатуру своих платформ

16.05.2025 [18:22],

Павел Котов

Arm объявила, что вводит новую схему наименования своих вычислительных платформ с учётом требований, предъявляемых системами искусственного интеллекта, которые всё активнее проникают во все технологические сегменты. Перед отраслью встала фундаментальная задача — нарастить производительность, сохранив контроль над потреблением энергии.

Источник изображения: arm.com Рабочие нагрузки ИИ становятся актуальными для всех сегментов электроники от огромных центров обработки данных до устройств масштаба наушников, поэтому вопрос энергоэффективности оказывается важнее, чем когда-либо раньше. И в Arm приняли решение чётко разграничить позиционирование вычислительных подсистем (Compute Subsystems — CSS). «Эти вычислительные платформы представляют собой интегрированные, проверенные системы, которые обеспечивают сокращённое время выхода на рынок, улучшенную производительность на ватт и масштабируемые инновации», — отметил гендиректор Arm Рене Хаас (Rene Haas). Каждая такая серия вычислительных платформ получила своё название:

Марка Mali продолжит использоваться для наименования графических подсистем. Компания упростит нумерацию платформ — теперь она будет указывать на их поколение, а индикатором уровня производительности станут обозначения Ultra, Premium, Pro, Nano и Pico. Эти меры помогут ориентироваться в ассортименте платформ и разработчикам, и потребителям, уверены в Arm. Разработчики чат-ботов с ИИ взяли курс на расширение памяти, и это настораживает

16.05.2025 [16:14],

Павел Котов

Крупнейшие разработчики сервисов искусственного интеллекта, в том числе OpenAI, Google, Meta✴✴ и Microsoft, в последнее время стали уделять больше внимания объёмам памяти у платформ. С новыми обновлениями чат-боты научились хранить больше данных для персонализации ответов.

Источник изображения: Igor Omilaev / unsplash.com Эта мера рассматривается как важный шаг, который поможет привлекать пользователей на конкурентном рынке чат-ботов и агентов с ИИ и, соответственно, это способ нарастить доходы от передовой технологии. В руках недобросовестного лица данные решения, однако, могут использоваться для злоупотребления доверием пользователей и усугублять проблемы с конфиденциальностью. У таких чат-ботов как Google Gemini и OpenAI ChatGPT расширяется контекстное окно — объем данных, определяющий, какой фрагмент разговора система может запомнить за один раз. Всё чаще применяется также метод генерации с дополненной выборкой (Retrieval-Augmented Generation — RAG), при котором контекст определяют и данные из внешних источников. Вдобавок разработчики ИИ усилили долговременную память моделей ИИ, сохраняя профили и предпочтения пользователей, чтобы давать им более полезные и персонализированные ответы. Чат-бот может, например, помнить, является ли пользователь вегетарианцем и соответствующим образом реагировать на его запросы, предлагая определённые точки общепита и рецепты. В марте Google открыла Gemini доступ к истории поиска пользователя — при условии, что он сам даёт на это разрешение, — а вскоре подключит к этому набору данные из большинства остальных сервисов. OpenAI ChatGPT, а также чат-бот Meta✴✴ в WhatsApp и Facebook✴✴ Messenger могут ссылаться на прошлые сеансы переписки, а не только текущий чат. Пользователи могут удалять из настроек отдельные воспоминания и получать уведомления, когда модель создаёт новые.

Источник изображения: Steve Johnson / unsplash.com Microsoft открыла службам ИИ для корпоративных клиентов данные компаний: электронные письма, календари и данные из хранилищ файлов. В апреле компания начала развёртывать на некоторых устройствах функцию Recall — запись всех действий пользователя на основе регулярных снимков экрана его компьютера. Пользователь может приостановить сохранение снимков экрана или вообще отключить функцию. Microsoft анонсировала Recall в мае прошлого года, и она встревожила общественность, из-за чего компания несколько раз переносила её запуск. Ещё одна причина наращивать объёмы памяти ИИ — монетизация за счёт партнёрского маркетинга и рекламы. В будущем чат-бот Meta✴✴ AI начнёт давать пользователям некоторые рекомендации или напрямую рекламировать различные продукты, рассказал ранее гендиректор компании Марк Цукерберг (Mark Zuckerberg). OpenAI в апреле улучшила механизм вывода предложений в ChatGPT, оптимизировав показ товаров и обзоров, но заверила Financial Times, что «на данный момент» на платформе партнёрские ссылки отсутствуют. Расширение памяти больших языковых моделей ИИ — дополнительный повод задуматься о вопросах конфиденциальности; регулирующие органы по всему миру стали следить за тем, как ИИ может манипулировать потребителями ради прибыли. Увеличенная память может привести и к тому, что ИИ начнёт излишне стараться подгонять свои ответы под предпочтения пользователей, усиливая предубеждения и заблуждения. В апреле OpenAI пришлось извиняться за то, что модель GPT-4o стала чрезмерно льстить пользователям. Применительно к памяти проблема галлюцинаций встаёт особенно остро: из-за неё ИИ, генерируя не соответствующие действительности или бессмысленные ответы, может создавать эффект «дрейфа памяти», когда воспоминания устаревают или противоречат друг другу, что будет влиять на точность ответов. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |