|

Опрос

|

реклама

Быстрый переход

VK внедрила в поиск визуально‑языковую ИИ-модель для точных ответов и ускорения разработки технологий

19.02.2026 [14:56],

Владимир Мироненко

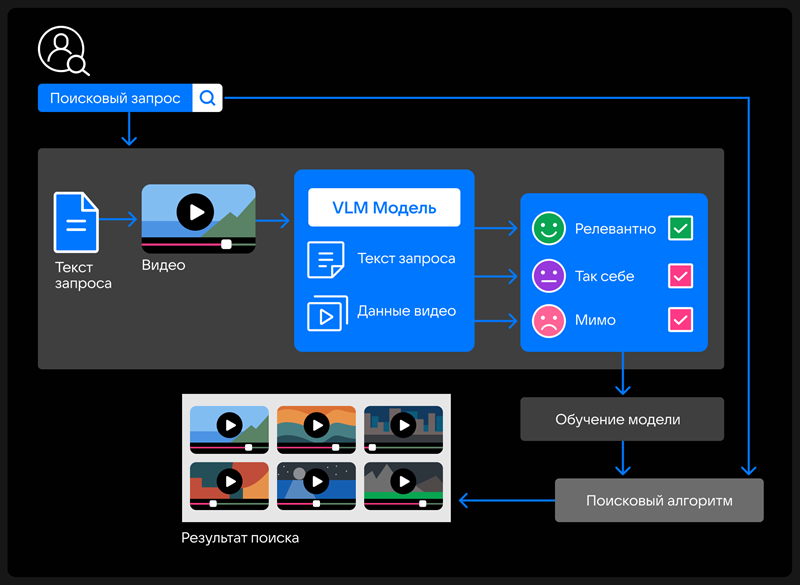

VK запустила на видеоплатформе «VK Видео» поиск с использованием визуально‑языковой модели (VLM), которая одновременно анализирует текст, изображения, звук и видеоряд. Сообщается, что в дальнейшем эта технология появится в других сервисах компании, где есть поисковые системы.

Источник изображения: VK VLM работает сразу с двумя модальностями — изображением и текстом, учитывая название и описание загруженного на платформу контента, а также его смысл, что обеспечивает более точные ответы на поисковые запросы пользователей. Разработанная специалистами AI VK модель автоматически формирует датасеты, данные о контенте, по которым поисковые алгоритмы подбирают видео, которые подходят к запросу пользователей. Запуск модели позволит улучшить векторный поиск в продуктах VK, который основан на семантическом значении запроса. В частности, система будет лучше распознавать и учитывать предпочтения пользователя при выборе видео с определённым стилем монтажа и цветокоррекции. А также лучше работать с гибридными запросами, содержащими текст и визуальные характеристики, например, «влог из Стамбула с видами на Босфор». Как ожидает компания, благодаря VLM поисковая выдача станет более персонализированной, а также в 5 раз ускорятся разработка и масштабирование новых технологий для развития и улучшения поиска во всех продуктах VK. ByteDance пообещала отучить ИИ-генератор Seedance 2.0 копировать голливудских актеров и персонажей

16.02.2026 [14:37],

Алексей Разин

Создание видеороликов с помощью ИИ-сервисов сталкивается с рядом юридических претензий, поскольку киностудии, правообладатели и знаменитости не желают допускать копирования их интеллектуальной собственности и образов без разрешения. Китайская ByteDance после запуска профильного сервиса Seedance 2.0 вынуждена была пообещать правообладателям ввести защитные механизмы, которые учитывали бы их интересы.  Как и многие подобные сервисы, Seedance 2.0 позволяет создавать реалистичные видео на основе текстовых запросов. Социальные сети после запуска Seedance 2.0 сразу же наводнились видеороликами с персонажами, охраняемыми авторским правом, а также образами, напоминающими реальных знаменитостей. Поскольку многие из них имели американское происхождение, то к создателям подобных роликов у правообладателей возникли справедливые претензии. «Мы принимаем меры по усилению существующих защитных механизмов, чтобы предотвратить неправомерное использование интеллектуальной собственности и схожести (со знаменитостями) со стороны пользователей», — заявили представители ByteDance ресурсу CNBC. Свои претензии к создателям сервиса Seedance 2.0 довольно быстро направила отраслевая ассоциация MPA, которая в США представляет интересы большинства крупных киностудий и платформы Netflix. Она призвала ByteDance решительно пресечь неправомерную активность по использованию защищаемых интеллектуальными правами образов. По словам представителей ассоциации, подобная активность не только нарушает американские законы, но и угрожает миллионам рабочих мест в США. Студия Disney направила в адрес ByteDance письмо с требованиями прекратить неправомерное использование принадлежащих ей персонажей. По мнению представителей Disney, китайская ByteDance для обучения ИИ-модели якобы использовала полученную пиратским образом библиотеку образов, считая её публично доступной. Ранее Disney подписала соглашение с OpenAI, которое позволяет пользователям ИИ-сервисов последней внедрять в генерируемые видео ряд узнаваемых персонажей, принадлежащих студии. Требования прекратить нарушение прав в сфере интеллектуальной собственности в адрес ByteDance на прошлой неделе направила и Paramount Skydance. Владелец TikTok выпустил ИИ-модель Seedance 2.0 для генерации видео — она стала вирусной

12.02.2026 [17:43],

Павел Котов

Новая модель искусственного интеллекта ByteDance для генерации видео уже стала вирусной в Китае, где её успех сравнили с достижениями DeepSeek за способность создавать сюжеты кинематографического качества всего по нескольким запросам.

Источник изображения: Claudio Schwarz / unsplash.com Наиболее популярными сегодня являются ИИ-модели, ориентированные в первую очередь на работу с текстом, такие как OpenAI ChatGPT и DeepSeek R1. Модели, предназначенные для генерации изображений и видео пока больше рассматриваются как перспективные. Сегодня ByteDance (владеет TikTok) официально представила модель Seedance 2.0 — она разработана для профессионального кинопроизводства, рекламы и электронной коммерции. Поддерживается одновременная обработка текста, изображений, звука и видео, что помогает снизить себестоимость создания контента. Новый проект ByteDance вышел в тот момент, когда инвесторы в Китае и по всему миру ищут разработчика масштабов DeepSeek, чьи модели R1 и V3 в начале минувшего года вызвали шок во всей отрасли. В китайских СМИ Seedance 2.0 сравнили как раз с фурором DeepSeek, и даже глава xAI Илон Маск (Elon Musk) отметил быстрый прогресс китайских разработчиков. Успеху проекта порадовались и пользователи китайской соцсети Weibo — они опубликовали множество созданных Seedance 2.0 видеороликов, в которых продемонстрировали сложность и высокое качество изображения вне зависимости от того, насколько неожиданным был запрос. В одном из роликов звёзды Канье Уэст (Kanye West) и Ким Кардашьян (Kim Kardashian) оказались персонажами драмы в дворцовом сеттинге времён Китайской империи — говорили и пели они тоже по-китайски. На Weibo завирусились связанные с Seedance 2.0 хэштеги — во всеобщем ликовании поучаствовала даже государственная газета Beijing Daily. В январе «VK Видео» стал самым популярным видеосервисом в России — через полтора года после замедления YouTube

09.02.2026 [16:23],

Владимир Мироненко

В январе 2026 года видеосервис «VK Видео» стал самым популярным видеохостингом по охвату аудитории в России, сообщает ресурс «Известия» со ссылкой на данные аналитической компании Mediascope.

Источник изображения: ilgmyzin/unsplash.com Ежедневная аудитория «VK Видео» составила за прошлый месяц 42,2 млн человек, превысив декабрьский показатель на 1,1 млн. За этот же период у видеохостинга YouTube было зафиксировано 22 млн против 21,9 млн ежедневных пользователей в декабре, у Rutube — 8,3 млн чел против 8,5 чел. месяцем ранее. Общее количество пользователей за прошлый месяц у «VK Видео» выросло до 82,8 млн человек, в то время как у YouTube аудитория за месяц составила 65,9 млн человек, у Rutube — 47,7 млн чел. Исследование Mediascope проводилось среди пользователей в России с помощью платформы Mediascope Cross Web через десктопные и мобильные версии видеосервисов, без учёта Smart TV и фонового просмотра. Как ранее сообщили в пресс-службе «ВКонтакте», «VK Видеo» внедрил новый подход к подсчёту просмотров для всех авторов на своей платформе. С начала года просмотр засчитывается только после пяти секунд для всех форматов длинного видео. Сообщается, что изменение направлено на повышение прозрачности метрик и качества аналитики. По данным сервиса, с сентября 2023 года приложение «VK видео» установили на мобильные устройства и Smart TV 100 млн раз. Meta✴ запустит отдельное приложение для ИИ-бурды — Vibes

06.02.2026 [12:06],

Павел Котов

Meta✴✴ разрабатывает отдельное приложение для сервиса Vibes — ленты видеороликов, созданных искусственным интеллектом. Сервис дебютировал как одна из функций в приложении Meta✴✴ AI в сентябре 2025 года. Как и OpenAI Sora, Vibes позволяет пользователям Meta✴✴ AI генерировать вертикальные ролики в стиле TikTok.

Источник изображения: Daria Nepriakhina / unsplash.com «После успешного запуска Vibes в Meta✴✴ AI мы тестируем отдельное приложение, чтобы развить этот успех. Видим, что пользователи всё чаще используют этот формат для создания, поиска и обмена сгенерированными ИИ видеороликами с друзьями. Отдельное приложение обеспечит выделенную площадку для этого, предложив людям более целенаправленную и соответствующую среду. Мы будем стремиться и далее расширять приложение на основе того, что узнали от сообщества», — заявили в Meta✴✴. Компания не уточнила, каков в действительности размер аудитории Vibes, но отметила, что с момента появления этого раздела увеличилась и аудитория самого приложения Meta✴✴ AI. Новое приложение поможет добавить свежие функции, не перегружая ими старое. Генерируемый ИИ контент имеет шансы стать новым источником вовлечённости пользователей на платформах, считают в Meta✴✴, — компания намеревается увеличить присутствие таких материалов в рекомендациях. Приложение Sora, выступающее прямым конкурентом перспективного Meta✴✴ Vibes, продолжает развиваться. OpenAI даже заключила соглашение с Disney, позволяющее пользователям использовать принадлежащих компании персонажей в творчестве ИИ. Не исключено, что аналогичные сделки заключит и Meta✴✴. Amazon ускорит и удешевит производство фильмов с помощью искусственного интеллекта

05.02.2026 [07:01],

Анжелла Марина

Amazon намерена использовать искусственный интеллект (ИИ) в создании фильмов, чтобы сократить время на их производство и сделать в целом процесс значительно дешевле. В компании уверены, что это поможет снимать больше картин, не заменяя при этом творческих специалистов.

Источник изображения: Thibault Penin/Unsplash Для реализации этих планов в августе прошлого года было создано подразделение под названием AI Studio в телестудии Amazon MGM Studios. AI Studio работает по принципу стартапа, в задачи которого входит разработка специализированных сервисов для снижения стоимости производства и упрощения творческого цикла, а руководит всем процессом Альберт Чэн (Albert Cheng). Первое закрытое тестирование новых инструментов с участием отраслевых партнёров начнётся в марте, как сообщает Reuters, а к маю компания рассчитывает продемонстрировать конкретные результаты этой работы. Необходимость использования нейросетей продиктована резким ростом производственных бюджетов, который ограничивает количество запускаемых в работу проектов. По словам Чэна, создание контента стало настолько дорогостоящим процессом, что компаниям сложно идти на творческие риски. Он убеждён, что искусственный интеллект ускорит работу, но не заменит уникальный вклад людей. Внедрение ИИ-технологий происходит на фоне серьёзных опасений в индустрии. Многие известные актёры ранее выражали тревогу по поводу того, что развитие цифровых двойников может лишить их работы. В ответ на это руководство Amazon пояснило, что сценаристы, режиссёры и актёры останутся вовлечёнными в процесс на всех этапах. Техническая реализация проекта опирается на вычислительные мощности подразделения Amazon Web Services (AWS) и использование ИИ-моделей от поставщиков-партнёров. Особое внимание уделяется защите авторских прав — контент, созданный с помощью ИИ, не будет использоваться для обучения других моделей искусственного интеллекта. Россияне стали чаще выбирать доступные смарт-часы — названы самые популярные модели

04.02.2026 [08:00],

Павел Котов

Наибольшие доли российского рынка умных часов в 2025 году заняли модели Apple и Xiaomi, подсчитали аналитики розничной сети «М.видео». Всего в минувшем году проданы около 6,4 млн гаджетов этого типа на 46,5 млрд руб., что даёт среднюю стоимость около 7,3 тыс. руб. Это отражает интерес потребителей к смарт-часам и фитнес-браслетам с широкими возможностями и предназначенным для повседневных сценариев.  Россияне всё меньше рассматривают умные часы и фитнес-браслеты как дополнительные устройства и воспринимают их как «часть повседневной цифровой рутины». Учитываются такие качества устройств как удобство в ношении и управлении, автономность, точность датчиков и интеграция с экосистемами сервисов и со смартфонами. Одни потребители ориентируются на скромную цену при базовом наборе возможностей, другим важны дополнительные функции и сценарии, а также привлекательный внешний вид устройства. В штучном выражении самые сильные продажи демонстрируют производители массовой продукции. Активно продаются товары малоизвестных брендов, которые предлагают самые низкие цены. Популярностью также пользуются умные часы под марками Xiaomi, Redmi и Apple — у них широкий ассортимент для различных сценариев. Из конкретных моделей высокими продажами отметились Redmi Watch 5 Active, Xiaomi Smart Band 9, Huawei Watch Fit 3, Huawei Band 10 и Redmi Watch 5 Lite — все они воплощают рациональный выбор. В денежном выражении лучшие продажи показали передовые в техническом плане и экосистемные решения. В первую очередь это продукция Apple и Samsung, которая славится широким набором возможностей, привлекательным дизайном и продуманной интеграцией со смартфонами. Наибольшую выручку среди конкретных моделей обеспечили Apple Watch SE (2022), Apple Watch Series 10 (42 и 46 мм), Apple Watch Ultra 2, а также Huawei Watch Fit 3, Huawei Watch GT 5 и GT 5 Pro. Disney+ скоро начнёт заполняться ИИ-контентом от OpenAI Sora, но на другие проекты это не повлияет

04.02.2026 [00:19],

Владимир Фетисов

Генеральный директор Disney Боб Айгер (Bob Iger) заявил, что сгенерированные с помощью сервиса OpenAI Sora видео скоро начнут появляться на платформе Disney+. При этом он отметил, что это не должно повлиять на остальной производимый компанией контент, включая фильмы и телепроекты.

Источник изображения: OpenAI Во время подведения финансовых итогов за прошедший квартал Айгер сообщил, что анонсированное в декабре соглашение с OpenAI сроком на три года начнёт приносить плоды в ближайшие несколько месяцев. В рамках достигнутых договорённостей Disney инвестирует в разработчика ИИ-алгоритмов $1 млрд, а OpenAI, в свою очередь, за неназванную сумму купит лицензию, которая позволит задействовать 250 персонажей Disney для генерации видео на платформе Sora. Генерируемые пользователями Sora вертикальные видео появятся в Disney+ позднее в этом году. На начальном этапе продолжительность таких роликов будет ограничена 30 секундами. По мнению Айгера, это позволит Disney извлечь выгоду на фоне высокой популярности коротких видео на других платформах, таких как YouTube. «Это соглашение даёт нам стартовый толчок для размещения коротких видео на Disney+. Кроме того, мы надеемся, что с помощью инструментов Sora подписчики Disney+ смогут создавать короткие видео на нашей платформе. Я считаю, что всё это — позитивный шаг в сторону интеграции функции, которая, как мы верим, значительно повысит вовлеченность аудитории», — заявил Айгер. Доводя до инвесторов отношение компании к искусственному интеллекту в целом, Айгер сказал, что Disney видит в этой технологии потенциальные преимущества и перспективы. Одно из таких преимуществ, по его мнению, заключается в возможности использования ИИ-инструментов для помощи творческому процессу и креативности. Ещё одним преимуществом должны стать высокая производительность и повышение эффективности разных рабочих процессов. Он также отметил, что ИИ позволит компании более тесно взаимодействовать с потребителями, что позитивно отразится на их вовлеченности. xAI выпустила Grok Imagine 1.0 с поддержкой создания 10-секундных видео в улучшенном разрешении

03.02.2026 [06:11],

Анжелла Марина

Компания xAI представила масштабное обновление инструмента генерации видео Grok Imagine 1.0. В новой версии теперь можно создавать ролики длиной до 10 секунд в разрешении 720 пикселей и синхронизировать звук. ИИ стал лучше понимать текстовые запросы и научился работать с уточняющими инструкциями.

Источник изображения: Grok Как сообщает издание Mint, разработчики назвали этот релиз крупнейшим обновлением системы, а Илон Маск (Elon Musk) в своём сообщении подтвердил, что версия 1.0 уже доступна. Представители xAI отметили, что обновление привнесёт повышение чёткости изображения и плавности визуального ряда для эффективного использования в творческих проектах и соцсетях. Ключевым нововведением стала работа со звуком. Пользователи смогут добавлять персонажам выразительные голоса с эмоциональной окраской, а также накладывать фоновую музыку, которая автоматически синхронизируется с происходящим на экране. В компании считают, что сочетание голоса и музыки делает сгенерированный контент более реалистичным и кинематографичным. Серьёзные изменения коснулись и логики взаимодействия с нейросетью. Grok Imagine 1.0 научился обрабатывать уточняющие запросы, что позволит корректировать детали сцены и дорабатывать результат без необходимости начинать генерацию с нуля, как это было раньше. За последние 30 дней платформа уже сгенерировала более одного миллиарда видео и популярность сервиса не уменьшается. Также сообщается, что API-модель показывает сильные результаты в бенчмарках Artificial Analysis, измерящих качество контента, созданного искусственным интеллектом Grok. Firefly без ограничений: Adobe сняла лимиты на ИИ-генерацию изображений и видео, но не навсегда

02.02.2026 [19:35],

Сергей Сурабекянц

Adobe предоставит подписчикам своего ИИ-сервиса Firefly неограниченное количество генераций изображений и видео как с использованием собственных, так и поддерживаемых сторонних моделей ИИ. Ежемесячные кредиты на генерацию изображений и видео будут отменены для новых подписчиков, которые зарегистрируются в системе до 16 марта.

Источник изображения: Adobe Firefly — это набор генеративных моделей Adobe для создания изображений и видео. В него входят как собственные модели Adobe, так и интеграции со сторонними сервисами, такими как Google Nano Banana Pro, OpenAI GPT-Image 1.5 и Runway Gen-4. После первоначального запуска Firefly в составе пакета приложений Creative Cloud, Adobe выпустила Firefly как отдельную платформу, доступную в браузере или через специальные приложения на мобильных платформах. Подписчики Adobe Firefly могут выбрать один из нескольких тарифных планов. До сих пор одним из ключевых отличий было количество кредитов на создание изображений, включённых в каждый тарифный план. Но с сегодняшнего дня Adobe предлагает при оформлении подписки генерацию неограниченного количества изображений и видео. Важно отметить, что предложение действительно только для отдельной подписки Adobe Firefly, а не для подписок Creative Cloud. «Зарегистрируйтесь до 16 марта и получите неограниченное количество поколений изображений и видео Firefly с разрешением до 2K в приложении Adobe Firefly. Предложение распространяется на клиентов, использующих тарифные планы Firefly Pro, Firefly Premium, а также планы на 4000, 7000 и 50 000 кредитов, и включает неограниченное количество генераций с использованием ведущих в отрасли моделей изображений, включая Google Nano Banana Pro, GPT Image Generation, Runway Gen-4 Image, а также коммерчески безопасные модели изображений и видео Firefly от Adobe», — заявила Adobe. По данным Adobe, 86 % создателей контента теперь используют ИИ в своей повседневной работе. Кроме того, за последний год длина их запросов удвоилась. Это свидетельствует о том, что создатели контента всё чаще используют ИИ как часть своих рабочих процессов. Компания отмечает, что сегодняшний шаг направлен на то, чтобы помочь создателям оставаться в творческом потоке, проходя через процесс проб и ошибок, не беспокоясь о своих кредитах на создание изображений. Adobe также сообщила, что в преддверии Дня святого Валентина и Лунного Нового года пользователи по всему миру получат возможность использовать собственные модели, а также интеграцию Firefly со сторонними сервисами, чтобы протестировать платформу. Россияне стали больше сидеть во «ВКонтакте» и смотреть «VK видео»

30.01.2026 [21:38],

Владимир Фетисов

По данным Mediascope, среднее время, проводимое пользователями в социальной сети «ВКонтакте» в декабре прошлого года, увеличилось на 20 % по сравнению с показателем за аналогичный период годом ранее. Россияне в среднем пользовались платформой 64 минуты, что является самым высоким показателем среди всех соцсетей в России.

Источник изображения: ilgmyzin / unsplash.com Данные Mediascope указывают на то, что наибольшую активность во «ВКонтакте» проявляли пользователи в возрасте от 25 до 34 лет. Люди этой возрастной группы в среднем проводят на платформе 76 минут в день, что на 13 % выше показателя годом ранее. На 17 % увеличилось время, которое проводят в соцсети молодые люди в возрасте от 12 до 24 лет. Пользователи в возрасте от 35 до 44 лет стали проводить во «ВКонтакте» на 24 % больше времени. В сообщении сказано, что с сентября 2023 года приложение «VK видео» установили на мобильные устройства и Smart TV 100 млн раз. В декабре прошлого года ежемесячная аудитория сервиса составила 81,5 млн пользователей. При этом в первую неделю января аудитория «VK видео» составила более 42 млн пользователей. Объём потребляемого контента также вырос. Общее время просмотра в конце прошлого года увеличилось в 2,1 раза (на 110 % год к году). Наибольшая вовлеченность аудитории фиксируется на платформе Smart TV. Во время январских праздников среднее время просмотра на одного пользователя составило 241 минуту. В «Google Фото» теперь можно описать превращение фото в видео

27.01.2026 [17:51],

Павел Котов

Пользователи сервиса «Google Фото» теперь могут управлять функцией превращения фото в видео при помощи генеративного искусственного интеллекта. Конкретное движение, стиль или эффект, которые хочется увидеть при преобразовании статичных изображений в видео, теперь можно описать простым текстовым запросом.

Источник изображения: Google Текстовые запросы дополняют уже имеющиеся функции «Небольшое движение» и «Мне повезёт» — свободного управления преобразованием в «Google Фото» до настоящего момента не было. Более того, сервис сам готов предложить некоторые варианты запросов, помогая со «вдохновением при создании видео»; для тонкой настройки получаемых роликов запросы можно редактировать. Функция доступна только пользователям от 18 лет. Это возрастное ограничение распространяется только на средство преобразования изображений в видео в «Google Фото»; аналогичная функция уже присутствует в Gemini и работает для пользователей от 13 лет. По умолчанию можно также добавлять аудио и получать на выходе ролик, готовый к публикации в интернете без дополнительного редактирования. Появилось также новое средство выбора изображений «Google Фото» для Gmail — обмен изображениями и роликами из общих и личных альбомов и коллекций стал проще. Можно одновременно выбирать несколько фотографий и видео, а также осуществлять поиск по конкретным фотографиям и названиям альбомов. Названы самые популярные ноутбуки 2025 года в России

22.01.2026 [09:00],

Павел Котов

В 2025 году россияне взвешенно подходили к выбору ноутбуков, ориентируясь не на цену, а на задачи, которые должен решать компьютер, гласит исследование аналитиков «М.Видео». Наиболее популярными марками стали Asus, Huawei, Lenovo, Acer и Apple.

Источник изображения: «М.видео» По итогам 2025 года в России проданы 2,9 млн ноутбуков на общую сумму 169 млрд руб., подсчитали в «М.Видео». Чаще всего покупатели ориентировались на универсальные модели для работы, учёбы и мультимедийных задач, наибольшим спросом пользовались ноутбуки с экранами 15,6 и 16 дюймов, а также с SSD. Эти компьютеры отличают сбалансированная стоимость при достаточной производительности. Российская розница не обратилась ни к ультрабюджетному, ни к премиальному сегменту — наиболее востребован средний ценовой диапазон с оптимальными показателями функциональности, комфорта и срока службы ноутбука. Одним из самых популярных брендов в России стал Asus — тайваньский производитель предлагает широкий выбор универсальных моделей для массового покупателя. Значительную долю рынка в единицах продукции показала Huawei, предлагающая сбалансированные модели за разумные деньги. В доступном и среднем ценовых диапазонах сильно выступила Lenovo, на стороне которой надёжность и узнаваемость бренда. Россияне также выбирали ноутбуки Acer – оптимальные для повседневных задач и работы в домашних условиях. Наконец, устойчивым спросом пользовались компьютеры Apple — более дорогие, но на их стороне преданная аудитория и расширенные возможности экосистемы. Asus сильно выступила и в денежном выражении — хорошую выручку ей обеспечили модели в среднем и верхнем ценовых сегментах. Хорошие результаты в данном зачёте показала и Apple, продукция которой традиционно отличается премиальным позиционированием и средней высокой ценой. За счёт дорогих моделей успешно выступила Lenovo, которая расширила ассортимент в среднем и верхнем сегментах. Huawei, чья продукция позиционируется как рациональный выбор, также продемонстрировала высокие продажи; наконец, стабильными показателями отметилась Acer с широким ассортиментом моделей для учёбы, работы и дома. А вот доля игровых ноутбуков оказалась невысокой — опять же, россияне чаще делали выбор в пользу универсальных моделей. «Билайн» ненадолго вернул некоторым россиянам быстрый YouTube — в компании объяснили, что это было

21.01.2026 [18:26],

Владимир Мироненко

В приложении «Билайна» на время появилась возможность смотреть видеоролики на YouTube без замедления, сообщил РБК со ссылкой на ряд абонентов. Как пояснили в компании, сервис с поддержкой такой возможности проходил тестирование в закрытом режиме, но на одном из этапов он стал на время доступен для некоторых клиентов в коммерческой сети. После этого доступ к нему закрыли.

Источник изображения: NordWood Themes/unsplash.com Согласно сообщениям абонентов оператора, опция просмотра видео YouTube без использования средств обхода ограничений была доступна подписчикам тарифа «План Б» в приложении «Мой Билайн». Видео можно было смотреть внутри сервиса оператора, поскольку приложение YouTube по-прежнему не работает. Представитель компании сообщил РБК, что после стабилизации работы сервиса оператор известит об этом дополнительно. В ноябре прошлого года «Вымпелком» открыл пользователям тарифа «План Б» доступ без ухищрений к видеосервису Netflix, музыкальному сервису Spotify и другим не работающим в России приложениям. Доступ предоставляется в приложениях и на сайтах сервисов абонентам оператора через мобильный интернет. Netflix и Spotify не заблокированы с российской стороны, но оба отключили свои сервисы на территории России. Как пояснил независимый эксперт рынка информационной безопасности Лука Сафонов, полноценный доступ к YouTube у «Билайна» — пример избирательной маршрутизации трафика. По его словам, внутри приложения «Билайна» (при условии, что функция активирована) часть данных может идти через защищённые каналы, условно — «мосты» или тоннели, прямо к нужным ресурсам, в данном случае — к YouTube. В то же время трафик к российским сервисам идёт напрямую, без использования дополнительных маршрутов. «ИИ-тикток» от OpenAI стал вирусным после запуска, но интерес к нему быстро остыл — возможно, так и было задумано

18.01.2026 [13:12],

Владимир Мироненко

После запуска в конце сентября 2025 года ИИ-приложение для генерации видео Sora 2 от OpenAI для iOS стало хитом скачиваний, несмотря на то, что для регистрации в нём требовалось приглашение. Всего за четыре дня приложение вышло на первое место в общем рейтинге App Store для iOS, а днём позже преодолело отметку в 1 млн загрузок. Однако затем темпы роста скачиваний начали снижаться.

Источник изображения: sora.chatgpt.com Замысел, лежащий в основе Sora, был довольно разумным, пишет ресурс Sherwood.news: контент, созданный ИИ, призван заменить контент, создаваемый пользователями, который мы видим в своих лентах каждый день. Короткие вертикальные видеоролики в стиле TikTok казались естественным способом выхода OpenAI на рынок контента. Например, на YouTube прошлым летом четыре из десяти самых популярных каналов с наибольшим числом подписчиков состояли исключительно из видеороликов, созданных ИИ, большинство из которых были в формате Shorts. При этом Sora задумывалась не просто как конкурент TikTok — она была разработана для бесшовной интеграции со всеми другими подобными платформами. Видео, созданные с помощью Sora, можно превращать в ролики Reels, Shorts, TikTok, Snap и другие форматы. Каждый репост становился бесплатной рекламой для Sora, даже если просмотры и вовлечённость доставались конкурентам. Приложение Sora не публикует данные о вовлечённости, поэтому о популярности видео, созданных с его помощью, можно судить по кроссплатформенным репостам. Такие аккаунты, как @bestsoravids в Instagram✴✴ и Epic Rankz на YouTube, зафиксировали миллионы просмотров, лайков и комментариев на своих репостах Sora. Однако все их самые успешные публикации пришлись на неделю-две после выхода приложения, на пике его популярности. Так, в первой половине декабря всего 20 видео с хэштегами #sora или #sora2 набрали более 1 млн просмотров на YouTube. Другие популярные аккаунты, занимавшиеся репостами Sora, такие как тот же @bestsoravids, полностью прекратили загрузку видео спустя несколько недель. Также сократилось и число загрузок самого приложения. После первоначального всплеска активности приложение для iOS было загружено за последующие примерно три месяца ещё более 5 млн раз, согласно данным Appfigures. Версия для iOS после выхода в последний день сентября была скачана к концу октября почти 2,7 млн раз. В ноябре общее количество загрузок за месяц составило 1,9 млн, а в декабре — 1,5 млн. Версия Sora для Android стала доступна 4 ноября. В ноябре её скачали 1,4 млн раз, а в декабре — 1,7 млн раз. После того как Sora стала доступна на Android, её ежедневные показатели загрузок в течение недели отставали от TikTok. В декабре приложение TikTok скачали более 18 млн раз по всему миру, а YouTube — 5 млн раз, несмотря на то что это приложение существует уже почти два десятилетия. Как допускает Sherwood.news, запуск Sora вовсе не был попыткой продвижения в социальных сетях, а скорее хитрым рекламным ходом OpenAI, чтобы привлечь партнёров для чего-то большего, чем просто «следующий TikTok». Напомним, что в декабре OpenAI и Disney объявили о партнёрстве, которое обеспечит пользователям Sora эксклюзивный доступ к персонажам Disney. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |