|

Опрос

|

реклама

Быстрый переход

В России стартовали продажи смарт-часов Huawei Watch Ultimate 2 с гидролокатором и водостойкостью до 150 м

01.11.2025 [09:00],

Сергей Сурабекянц

В России стартовали продажи премиальных смарт-часов Huawei Watch Ultimate 2. Эти умные часы разработаны с прицелом на дайверов, активных пользователей и любителей спорта на открытом воздухе. Они сочетают профессиональные спортивные режимы, возможность погружения на глубину до 150 метров и обеспечивают связь под водой при помощи гидролокации.

Источник изображений: Huawei Корпус Huawei Watch Ultimate 2 изготовлен с использованием сплава циркония, что обеспечивает высокий уровень прочности и устойчивости к механическим воздействиям. 1,5-дюймовый AMOLED-дисплей с максимальной яркостью 3500 кд/м² защищён сапфировым стеклом, а вращающийся безель изготовлен из керамики. По утверждению производителя, такое сочетание материалов «повышает долговечность устройства и подчёркивает его премиальный дизайн». Huawei Watch Ultimate 2 — первые в мире умные часы, которые подходят для погружения на глубину до 150 метров. Часы соответствуют уровню водонепроницаемости 20 АТМ по стандарту ISO 22810 и отвечают требованиям стандарта EN 13319 для дайвинга. Это позволяет использовать устройство профессиональным спортсменам во время тренировок и соревнований. Встроенный гидролокационный модуль позволяет обмениваться короткими сообщениями под водой на расстоянии до 30 метров между устройствами, что упрощает взаимодействие между дайверами.  Смарт-часы поддерживают звонки через eSIM без смартфона. Система шумоподавления на базе искусственного интеллекта обеспечивает чистое звучание даже в условиях сильного ветра или внешних шумов. Часы оборудованы системой мониторинга здоровья Huawei TruSense, которая обеспечивает сбор данных о состоянии пользователя по 10 основным показателям с помощью трёх основных датчиков — ЭКГ, ФПГ и датчик силы нажатия. Смарт-часы представлены в синем и чёрном цветах. Во всех моделях предусмотрен ремешок из фторэластомера, а также удлинённый ремешок для дайвинга. Синяя модель поставляется с дополнительным титановым браслетом. Вес смарт-часов без ремешка составляет 80,5 грамм.  Цена чёрных Huawei Watch Ultimate 2 составляет 64 999 ₽, модель в синем исполнении обойдётся покупателю в 79 999 ₽. Первым покупателям обещаны подарки. Россияне пожаловались на масштабный сбой в работе «VK Видео»

29.10.2025 [16:23],

Павел Котов

От пользователей видеоплатформы «VK Видео» стали массово поступать жалобы на нестабильную работу сервиса, обращают внимание «Ведомости». Чаще всего поступали обращения из восточных регионов страны. В самой компании наличие проблем опровергли.

Источник изображения: ilgmyzin / unsplash.com Жалобы на некорректную работу «VK Видео» начали поступать около 12:30 мск; к 13:15 число жалоб достигло 396 в час — пользователи платформы сообщали, что видео загружаются недостаточно быстро или не открываются вообще. Чаще всего жалобы поступали из восточных регионов России: из Магаданской области (8 %) обращений, в также из Камчатского края, Еврейской автономной области, Сахалинской области и Хабаровского края. В ответственной за работу сервиса компании VK факт наличия проблем отвергли. «„VK Видео“ работает в штатном режиме», — заявили в пресс-службе интернет-гиганта. 20 октября случился сбой в работе множества интернет-сервисов по всему миру — перестали работать сайты и приложения таких служб как Snapchat, Duolingo, Zoom, Perplexity и Roblox, а также банковских сервисов. Виной тому оказались неполадки в работе Amazon Web Services. Проблемами отметились даже умные матрасы Eight Sleep, у которых не оказалось автономного режима — производитель пообещал его реализовать. Власти Японии призвали OpenAI соблюдать авторские права по отношению к манге и аниме при генерации видео в Sora 2

17.10.2025 [08:41],

Алексей Разин

Компания OpenAI недавно анонсировала обновлённую версию Sora 2 — сервиса по созданию видео силами искусственного интеллекта по текстовому запросу. Внимание общественности к подобным инструментам выросло и по линии правообладателей, в Японии на их защиту встало правительство, которое потребовало от OpenAI обеспечить адекватную защиту.

Источник изображения: OpenAI Как сообщает The Japan Times, министр цифровых технологий Японии Масааки Таира (Masaaki Taira) в интервью телеканалу TBS признался, что правительство страны запросило у OpenAI изменение в подходе к учёту интересов правообладателей при взаимодействии с пользователями Sora 2. Те, правообладатели, которые потребуют от OpenAI ограничить использование своих защищаемых законом персонажей в среде Sora 2, должны будут обратиться к американскому стартапу с соответствующим запросом. Изначально предполагалось, что запрет будет распространяться на всех правообладателей, и желающие от него отказаться будут подавать соответствующие заявки OpenAI. Японский министр подчеркнул, что необходимо создать механизм, который позволит правообладателям получать материальную компенсацию за использование их персонажей на платформе OpenAI Sora. Власти страны также потребовали от OpenAI предусмотреть возможность удаления контента по запросу правообладателей. Сообщается, что компания согласилась с подобными требованиями. Глава стартапа Сэм Альтман (Sam Altman) ранее сообщал, что предоставит правообладателям более тонкий контроль за созданием образов, и это будет напоминать заявительную модель контроля за схожестью персонажей, но с дополнительными возможностями. «Аниме и манга являются незаменимыми сокровищами нашей страны», — заявил министр Минору Киути (Minoru Kiuchi), отвечающий за государственную стратегию в области интеллектуальной собственности, добавив, что данные виды художественных произведений ценятся по всему миру. Правительство Японии, по словам чиновника, хотело бы отвечать на новые вызовы соответствующим образом. Sora 2 уже навлекла на себя волну критики, связанную с возмущением родственников усопших знаменитостей, внешность которых пользователи сервиса начали свободно использовать для создания видео с использованием образов покойных. В Японии резонанс вызвало использование авторами видеороликов популярных в стране элементов местной культуры из миров Pokemon, One Piece и Dragon Ball Z. Представители Nintendo не стали напрямую критиковать политику OpenAI, но в целом выразили готовность защищать свою интеллектуальную собственность в суде. За пять дней с момента запуска Sora 2 приложение в App Store было скачано 1 млн раз. Google выпустила ИИ-генератор видео Veo 3.1 с повышенным реализмом и улучшенным звуком

15.10.2025 [23:51],

Анжелла Марина

Google представила обновлённую версию ИИ-модели для генерации видео Veo 3.1. Модель генерирует более реалистичные видеоклипы, точнее следует текстовым запросам пользователя и получила значительные улучшения в области звукового сопровождения.

Источник изображения: Google Как пишет TechCrunch, модель Veo 3.1 развивает функциональность, представленную в мае в версии Veo 3, добавляя аудиосопровождение ко всем существующим возможностям редактирования — от привязки персонажей к референсным изображениям до ИИ-генерации клипов, включая возможность продления существующего видео на основе последних нескольких кадров. По словам представителей Google, благодаря этим улучшениям создаваемые ролики становятся «более живыми». Veo 3.1 будет доступна в видеоредакторе Flow, а также в приложении Gemini, через Gemini API и централизованную платформу Vertex AI. Пользователи Flow также смогут удалять существующие объекты из видео. С момента запуска Flow в мае пользователи создали с его помощью свыше 275 миллионов видеороликов. Голливудские агентства резко раскритиковали ИИ-генератор видео OpenAI Sora

10.10.2025 [11:45],

Владимир Фетисов

Агентство Creative Artist Agency присоединилось к тем, кто выступил с критикой в адрес OpenAI и её приложения для генерации видео Sora из-за нарушения авторских прав. В заявлении организации сказано, что упомянутый сервис представляет значительные риски для клиентов агентства и принадлежащей ему интеллектуальной собственности.

Источник изображения: OpenAI Creative Artist Agency, представляющее интересы большого количества звёздных актёров, таких как Скарлетт Йоханссон (Scarlett Johansson) и Том Хэнкс (Tom Hanks), поставило под сомнение, считает ли OpenAI, что «люди, писатели, художники, актёры, режиссёры, продюсеры, музыканты и спортсмены заслуживают вознаграждения и упоминания за работу, которую они делают». «Или OpenAI считает, что может просто украсть контент, пренебрегая глобальными принципами авторского права и нагло игнорируя права создателей, а также многих людей и компаний, которые финансируют производство, создание и публикацию работы этих людей? На наш взгляд, ответ на этот вопрос очевиден», — говорится в заявлении агентства. Вместе с этим в Creative Artist Agency заявили, что агентство открыто для предложений OpenAI, направленных на решение возникшей проблемы, продолжая взаимодействовать с лидерами в области интеллектуальной собственности, профсоюзами, законодателями и политиками. «Контроль, разрешение на использование и компенсация являются фундаментальными правами этих работников. Всё, что не подразумевает защиту создателей и их прав, неприемлемо», — сказано в заявлении агентства. На прошлой неделе OpenAI выпустила приложение для генерации видео Sora, которое доступно для устройств на базе iOS с некоторыми ограничениями. Несмотря на это, всего за несколько дней ИИ-генератор скачали более 1 млн раз, благодаря чему он возглавил рейтинг App Store. Приложение позволяет генерировать на основе текстового описания короткие ролики, в том числе с участием персонажей, защищённых законодательством об авторском праве, что и стало причиной бурной реакции со стороны компаний, чья интеллектуальная собственность незаконно используется в Sora. United Talent Agency также раскритиковало приложение OpenAI, заявив, что использование сервисом защищённого авторским правом контента является эксплуатацией, а не инновацией. «В нашем бизнесе нет замены человеческому таланту, и мы будем продолжать бороться за наших клиентов, чтобы обеспечить их защиту. Когда речь идёт о Sora от OpenAI или любой другой платформе, которая стремится извлечь выгоду из интеллектуальной собственности и имиджа наших клиентов, мы солидарны с авторами», — сказано в заявлении агентства. Ранее OpenAI заявила, что ввела ряд защитных мер, которые должны предотвратить возможность генерации роликов с защищёнными авторским правом персонажами. В дополнение к этому компания проводит проверку уже созданных в Sora видео на предмет поиска материалов, которые не соответствует обновлённой политике OpenAI. «Мы удаляем сгенерированных персонажей из публичной ленты Sora и готовим обновления, которые предоставят правообладателям больше контроля над их персонажами и тем, как поклонники могут их использовать», — сообщил представитель OpenAI. Другие представители киноиндустрии также выразили недовольство тем, что сервис Sora использует контент, защищённый авторским правом. В их число входят агентство по подбору персонала WME, Disney и др. Приложение OpenAI Sora скачали 1 млн раз менее чем за пять дней

09.10.2025 [20:19],

Владимир Фетисов

Выпушенное недавно приложение OpenAI Sora для ИИ-генерации видео скачали более 1 млн раз менее чем за пять дней. Об этом в своём аккаунте в социальной сети X написал руководитель команды Sora Билл Пиблз (Bill Peebles). Он отметил, что ИИ-генератор добился такого успеха даже быстрее ChatGPT, популярного ИИ-бота OpenAI, которым в настоящее время еженедельно пользуются более 800 млн человек по всему миру.

Источник изображения: OpenAI Ещё более впечатляющим достижение Sora делает то, что приложение доступно только на устройствах с операционной системой Apple iOS и для его загрузки требуется получить приглашение. Это означает, что для скачивания Sora нужно получить специальный код. Несмотря на эти ограничения, ИИ-генератор сумел занять первое место в рейтинге магазина цифрового контента Apple App Store. «Команда усердно работает, чтобы не отстать от стремительного роста», — написал Пиблз в одном из недавних постов в соцсети X. Запуск Sora сопровождался бурной реакцией со стороны общественности, в том числе в плане обсуждения того, что алгоритм может нарушать авторские права. На платформе можно найти множество роликов с защищёнными авторским правом персонажами, например, из мультфильмов «Губка Боб квадратные штаны», «Рик и Морти» и «Южный парк». Более того, пользователи могут сами генерировать подобные ролики. Ассоциация кинокомпаний, представляющая интересы телевизионной, кино- и видеоиндустрии заявила, что «ролики, нарушающие права на фильмы, шоу и персонажей членов ассоциации широко распространены на платформе OpenAI». Гендиректор Ассоциации кинокомпаний Чарльз Ривкин (Charles Rivkin) заявил, что «OpenAI должна предпринять незамедлительные и решительные действия для решения этой проблемы». Он добавил, что действующее законодательство об авторском праве защищает права авторов и вполне применимо в данном случае. Генеральный директор OpenAI Сэм Альтман (Sam Altman) заявил, что компания в скором времени предоставит правообладателям больше возможностей в плане контроля контента, защищённого авторским правом. Об этом он написал в блоге компании в конце прошлой недели. Sora поделится прибылью — OpenAI предложит роялти за использование персонажей Disney и других

04.10.2025 [08:44],

Алексей Разин

Проблема защиты авторских прав при использовании генерируемого нейросетями контента давно будоражит заинтересованных правообладателей, в сфере заимствования текстовой информации она уже породила серию крупных судебных дел с многомиллиардными исками. OpenAI хочет предоставить правообладателям возможность регулировать использование своей интеллектуальной собственности в Sora.

Источник изображения: OpenAI Напомним, что речь идёт о средстве создания видео при помощи искусственного интеллекта, которое недавно вышло в обновлённом варианте. Глава OpenAI Сэм Альтман в своём блоге в пятницу заявил, что компания предоставит правообладателям более чёткий контроль над созданием персонажей, которые изначально были придуманы ими. Телекомпании и киностудии смогут блокировать использование тех образов создателями видео в Sora, которых сочтут ограничить в копировании и воспроизведении. По данным Reuters, студия Disney уже выразила намерения блокировать использование своего материала в Sora. Альтман добавил, что при этом OpenAI собирается ввести механизм монетизации для тех правообладателей, которые разрешат использование своих персонажей в Sora. По сути, они смогут получать своего рода роялти. Люди создают видео гораздо активнее, чем ожидала OpenAI, нередко для ограниченной аудитории, потребность в монетизации такого контента становится всё более очевидной. Впрочем, Альтман не скрывает, что попытки реализовать монетизацию в этой сфере пройдут путём проб и ошибок, и нужного результата не удастся добиться сразу. Компания готова испытать несколько вариантов, прежде чем остановится на лучшем из них. YouTube тестирует новый интерфейс мобильного приложения — реакция пользователей ожидаемо негативная

02.10.2025 [15:50],

Владимир Мироненко

После презентации в сентябре обновлённого интерфейса для Android TV видеохостинг YouTube приступил к улучшению интерфейса мобильного приложения, пишет ресурс Android Authority со ссылкой на сообщения отдельных пользователей платформы.

Источник изображения: Christian Wiediger/unsplash.com Новый интерфейс получил несколько ключевых отличий. В частности, изменения коснулись размещения изображения профиля канала и названия видео, как видно на изображениях ниже (слева — текущий дизайн, справа — обновлённый). Раньше изображение профиля располагалось под названием видео. Теперь название видео смещено вправо, чтобы освободить место для более крупного изображения профиля. В свою очередь, название канала заменено именем пользователя канала. Например, вместо названия канала Jet Lag: The Game теперь отображается имя пользователя @jetlagthegame.

Источник изображений: Android Authority / androidauthority.com Также Google перегруппировала кнопки под плеером и убрала текст с указанием действия, оставив только значки. Колокольчик уведомлений теперь находится в начале строки карусели кнопок, а не над ними. Пользователи также обратили внимание на обновление пользовательского интерфейса в Shorts. В частности, кнопки стали меньше и более плавными, чем раньше. Судя по отзывам, нововведения пришлось по вкусу далеко не всем пользователям сервиса. OpenAI представила Sora 2 — ИИ-генератор видео с реалистичной физикой и логикой, а также возможностью встроить в ролик самого себя

30.09.2025 [21:35],

Андрей Созинов

OpenAI анонсировала Sora 2 — флагманскую ИИ-модель для генерации видео и аудио, которую в компании позиционируют как огромный качественный скачок по сравнению с оригинальной Sora и сравнивают с GPT-3.5, ставшей революционной для генерации текста. Разработчики отмечают, что новая модель приближает ИИ-симуляцию мира к уровню, когда искусственный интеллект начинает «понимать» физику и динамику объектов почти так же, как человек.

Источник изображения: OpenAI Если ранние модели для генерации видео часто создавали правдоподобную «картинку», но не справлялись с элементарной логикой движений — например, могли «телепортировать» баскетбольный мяч в корзину при промахе, то Sora 2 моделирует именно поведение объектов. Промах — значит, мяч отскочит от щита. Фигурист, делающий тройной аксель, может ошибиться и упасть. Система научилась имитировать не только успех, но и провал — ключевое требование для создания реальных симуляторов мира и продвинутых роботов. Разработчики обещают, что теперь не будет странных деформаций объектов и нарушений логики сцены в угоду соблюдению промпта. Контролируемость — ещё один акцент, отмечаемый OpenAI. Модель Sora 2 уверенно справляется со сложными многошаговыми сценами, удерживая непротиворечивое состояние объектов, локаций и света. В качестве примера приводятся ролики, где фигуристка выполняет сложную программу из нескольких элементов с котом на голове, или где герой аниме вовлечён в зрелищную битву. Всё это — с сохранением целостности мира, связности кадров и даже эмоций на лицах персонажей. Sora 2 умеет работать с несколькими стилями: реалистичным, кинематографичным и аниме. Как универсальная система генерации видео и аудио, Sora 2 способна создавать сложные фоновые звуковые ландшафты, речь и звуковые эффекты с высокой степенью реалистичности. Для этого достаточно короткой видеозаписи: модель точно воспроизведёт внешность, мимику и даже голос, органично интегрируя их в любую сцену. Эта возможность универсальна и работает для любого человека, животного или объекта, отмечает пресс-релиз OpenAI. Одновременно с выпуском Sora 2 компания OpenAI запускает социальное iOS-приложение Sora. В нём пользователи смогут генерировать ролики и делиться ими с друзьями, а также делать ремиксы на работы друг друга, находить новые видео в настраиваемой ленте Sora и добавлять себя или своих друзей с помощью функции «камео». С помощью «камео» можно попасть в любую сцену Sora с поразительной точностью — нужно только через само приложение записать короткое видео с собой и свой голос для подтверждения личности и захвата образа. «На прошлой неделе мы запустили приложение внутри OpenAI. Наши коллеги уже сообщили нам, что благодаря этой функции они завели новых друзей в компании. Мы считаем, что социальное приложение, построенное вокруг функции “камео”, — лучший способ ощутить всю магию Sora 2», — отметила OpenAI в пресс-релизе. OpenAI подчеркнула, что этическое и ответственное использование станет важной частью новой платформы. Пользователь сам будет решать, кто и как может использовать его «камео»; любое видео с участием пользователя можно удалить в любой момент. Контент с откровенно вредным содержанием или созданный без согласия людей блокируется на уровне алгоритмов и модераторов. Приложение Sora уже доступно для скачивания пользователям iPhone в США и Канаде, регистрация проходит через систему приглашений. Через несколько недель Sora 2 станет доступна в веб-версии. Базовая версия бесплатна и имеет «щедрые лимиты», а подписчики ChatGPT Pro вскоре получат доступ к экспериментальной модели Sora 2 Pro с повышенным качеством. Монетизация пока туманна: единственный план — брать деньги за дополнительные генерации при высоком спросе. Расширение географии сервиса и открытие доступа через API входят в планы на ближайшее время. «Бро постит ИИ-бурду у себя в приложении»: Meta✴ запустила платформу Vibes для коротких ИИ-видео

27.09.2025 [13:39],

Владимир Мироненко

Meta✴✴ Platforms представила новую платформу Vibes для создания с помощью ИИ и публикации коротких видеороликов. Начиная с четверга Vibes доступна в приложении Meta✴✴ AI и на сайте meta✴✴.ai, пишет Reuters. О запуске Vibes объявил в Instagram✴✴ генеральный директор Meta✴✴ Марк Цукерберг (Mark Zuckerberg), где также была представлена серия видеороликов, созданных с помощью ИИ.

Источник изображения: Jonas Leupe/unsplash.com В одном из видеороликов группа пушистых существ прыгает с одного пушистого куба на другой. В другом — кошка месит тесто, а в третьем женщина делает селфи на балконе с видом на Древний Египет. С помощью платформы можно создавать видео с нуля или использовать имеющийся контент, а также делать ремиксы видео из ленты, добавляя новые визуальные эффекты или накладывая музыку. Созданное видео можно опубликовать в ленте Vibes, отправить его другим пользователям или сделать кросс-пост в Instagram✴✴, Facebook✴✴ Stories и Reels. Глава ИИ-команды Meta✴✴ Александр Ванг (Alexandr Wang) сообщил, что компания сотрудничала с генераторами изображений на базе ИИ Midjourney и Black Forest Labs с целью запуска ранней версии Vibes, продолжая также разрабатывать собственные ИИ-модели. Поскольку никто на самом деле не хочет версию TikTok, созданную с помощью искусственного интеллекта, комментарии пользователей в ответ на объявление Цукерберга были вполне ожидаемыми. Самый популярный комментарий к посту гласит: «Никто этого не хочет», а в другом популярном комментарии говорится: «Бро выкладывает ИИ-бурду у себя в приложении». В еще одном комментарии написано: «Думаю, я выражу мнение всех, когда скажу: Чтооо…?», пишет TechCrunch. Ресурс отметил, что нынешний анонс кажется «странным» с учётом того, что ранее в этом году компания заявила о борьбе с «неоригинальным» контентом в Facebook✴✴ и посоветовала авторам сосредоточиться на «аутентичном повествовании», а не на коротких видеороликах, не представляющих особой ценности. YouTube перестал считать пользователей с блокировщиками рекламы за людей — у блогеров резко упали просмотры

16.09.2025 [21:22],

Анжелла Марина

С середины августа многие авторы на YouTube начали фиксировать резкое падение числа просмотров своих видео — в отдельных случаях снижение достигало половины от прежних показателей. Причины аномалии до сих пор официально не подтверждены, однако данные аналитиков и косвенные заявления платформы указывают на влияние блокировщиков рекламы.

Источник изображения: NordWood Themes/Unsplash По наблюдениям английского стримера и ютубера Джоша Стайфа Хейеса (Josh Strife Hayes), просмотры с телевизоров, смартфонов и планшетов сохранили прежнюю динамику, тогда как просмотры с компьютеров с середины августа сократились примерно на 50 %. Эти данные были подтверждены также каналом, рассказывающим о мире технологий, TechLinked, который зафиксировал аналогичную статистику в собственных метриках. YouTube не даёт прямого подтверждения, но в официальном заявлении, опубликованном через Google, указано, что «зрители, использующие блокировщики рекламы и другие инструменты ограничения контента, могут влиять на точность отчётности по просмотрам». В компании добавили, что каналы с высокой долей аудитории, применяющей подобные расширения, могут сталкиваться с более выраженными колебаниями трафика — особенно в период обновлений таких расширений. Ранее высказывались предположения, что снижение просмотров связано с новыми инструментами YouTube на базе искусственного интеллекта (ИИ) для проверки возраста пользователей, однако компания категорически опровергла эту версию. Среди других возможных причин назывались сезонные изменения зрительских привычек и усиление конкуренции на платформе. В YouTube подчёркивают, что системной проблемы, влияющей на просмотры, нет. При этом представители TechLinked «Скачок в области открытого кодирования видео» — видеокодек AV2 выйдет к концу года

16.09.2025 [20:22],

Сергей Сурабекянц

Спустя десятилетие после своего основания и 7 лет после выпуска открытого видеокодека AV1, Альянс за открытые медиа (Alliance for Open Media, AOMedia) объявил о скором выходе видеокодека нового поколения AV2. Альянс назвал его «основополагающим элементом» своего будущего технологического стека. AV2 должен составить серьёзную конкуренцию кодеку VVC, преемнику широко распространённого HEVC.

Источник изображения: unsplash.com AOMedia объединяет таких крупных игроков отрасли, как Amazon, AMD, Apple, Disney, Google, Intel, LG, Meta✴✴, Microsoft, Nvidia и Samsung. В 2018 году разработчики AOMedia выпустили видеокодек AV1 в качестве бесплатной альтернативы кодеку HEVC. Однако HEVC остаётся доминирующим кодеком для 4K- и HDR-контента, несмотря на то, что Netflix и YouTube используют AV1 для некоторых потоков. «AV2 – это скачок в области открытого кодирования видео и ответ на растущий мировой спрос на потоковое вещание, обеспечивающий значительно более высокую производительность сжатия, чем AV1. AV2 обеспечивает расширенную поддержку приложений дополненной и виртуальной реальности (AR/VR), возможность просмотра нескольких программ на разделённом экране, улучшенную обработку экранного контента и возможность работы в более широком диапазоне качества изображения. AV2 знаменует собой важную веху на пути к открытому, инновационному будущему медиатехнологий», – заявил представитель AOMedia. Альянс пока не предоставил технической информации или результатов сравнительных тестов, поэтому пользователям придётся дождаться публичного релиза продукта в конце 2025 года. По данным AOMedia, 53 % его участников планируют внедрить AV2 в течение 12 месяцев после финального релиза, а 88 % ожидают внедрения в течение двух лет. Если это будет реализовано, темпы внедрения окажутся выше, чем у AV1. Однако в конечном итоге всё будет зависеть от интеграции AV2 в телевизоры, медиаплееры, ПК, портативные устройства и другое оборудование.

Источник изображения: AOMedia «В AOMedia мы убеждены, что инновации процветают, когда они открыты, — заявил исполнительный директор AOMedia Пьер-Антони Лемьё (Pierre-Anthony Lemieux). — Наши стандарты опираются на вклад новаторов со всего мира и разрабатываются в рамках политики безвозмездного патентования, что позволяет быстрее и эффективнее предоставлять медиатехнологии нового поколения большему числу людей. Мы рады поделиться AV2 со всем миром, продолжая лидировать в формировании будущего медиа посредством открытого сотрудничества». Технокомпании обучают ИИ на миллионах роликов, скаченных с YouTube, без разрешения их авторов

11.09.2025 [16:50],

Павел Котов

В массив данных, предназначенных для обучения искусственного интеллекта, попали более 15,8 млн видеороликов с более чем 2 млн каналов YouTube — технологические компании без разрешения пользуются ими в своих проектах, обратил внимание американский журнал The Atlantic.

Источник изображения: Aidin Geranrekab / unsplash.com Эти видеоролики присутствуют как минимум в 13 наборах данных, которые распространяют разработчики ИИ из технологических компаний, университетов и исследовательских организаций через такие платформы как, например, Hugging Face. В большинстве случаев видео являются анонимными — не указываются ни их названия, ни имена авторов; хотя журналистам издания удалось их идентифицировать. Для создания генераторов видео с ИИ разработчикам требуются огромное количество роликов, и YouTube представляется стандартным источником материалов для таких целей. Платформа позволяет пользователям платных тарифов загружать видео в приложении, чтобы впоследствии смотреть их в любое время и в любом месте; разработчики же скачивают их в виде файлов и обрабатывают при помощи алгоритмов ИИ, что прямо нарушает условия обслуживания платформы, но её администрация, очевидно, бездействует. Не все видео на YouTube защищены авторскими правами, некоторые ролики вообще загружаются пользователями, не связанными с правообладателями, но многие действительно защищены. Их несанкционированное копирование или распространение незаконно, и вопрос об их добросовестном использовании для обучения ИИ до сих пор обсуждается в рамках судебных процессов. Некоторые судьи не согласны с позицией технологических компаний, но единого мнения пока не сформировано.

Источник изображения: Rubidium Beach / unsplash.com Созданные ИИ ролики, например, исторические, демонстрируют всё большее присутствие на YouTube — несмотря на множество неточностей, они уже начали вытеснять проверенный экспертами контент; то же касается музыкальных ремиксов. Проблема выходит далеко за рамки YouTube: многие современные чат-боты работают на базе мультимодальных моделей ИИ, способных в качестве ответов генерировать медиафайлы — вскоре ChatGPT или другая платформа вместо ссылки на видеоинструкцию с YouTube выдаст индивидуальное обучающее видео. Возможно, оно окажется хуже, чем созданное человеком, но будет адаптировано к требованиям пользователя. Обучающие массивы, в которые входят скачанные с YouTube ролики, используются многими технологическими компаниями, в том числе Microsoft, Meta✴✴, Amazon, Nvidia, Runway, ByteDance, Snap и Tencent. В Meta✴✴, Amazon и Nvidia ответили на просьбу журналистов прокомментировать ситуацию и заверили, что уважают создателей контента и считают использование этих данных законным. В Amazon добавили, что сейчас работают над системой, которая позволит генерировать «убедительную, высококачественную рекламу по простым запросам». У Meta✴✴ есть сервис Movie Gen, генерирующий видео по текстовым запросам; в Snapchat есть функция AI Video Lenses, позволяющая дополнять пользовательские видео элементами с генеративным ИИ. Эти службы были бы невозможными, если бы владеющие ими компании не обучали ИИ на большом объёме роликов — так и ChatGPT не смог бы писать в духе Шекспира, если бы не «прочитал» его. Значительная часть материала взята с новостных и образовательных каналов; сотни тысяч видео были созданы авторами обычных каналов. Разработчики ИИ признаются, что одни ролики им интереснее, чем другие. Так, специализирующаяся на разработке генератора видео с ИИ компания Runway в качестве приоритетных исходных материалов в неофициальном порядке перечислила «быстрое движение камеры», «красивые кинематографические пейзажи», «высококачественные фрагменты фильмов» и «сверхкачественные научно-фантастические короткометражки». Создатели обучающих массивов HowTo100M и HD-VILA-100M отдают приоритет видео с высоким количеством просмотров на YouTube; для массива HD-VG-130M отбор видео производит специально обученная ИИ-модель. Ниже приоритет у видео с субтитрами и логотипами каналов — есть риск, что эти элементы попадут и в генерируемые ролики; возможно, владельцам каналов следует обратить на этот факт внимание, если они не хотят увидеть свои работы в обучающих массивах.

Источник изображения: BoliviaInteligente / unsplash.com При подготовке видео к добавлению в массив разработчики разбивают материал на короткие ролики, отбрасывая, например, моменты смены ракурса. К каждому созданному таким образом клипу добавляется описание на английском языке, чтобы модель научилась сопоставлять слова с движущимися изображениями и впоследствии генерировала видео на основе текстового запроса. Иногда такое аннотирование осуществляют люди, иногда — специальные модели ИИ. На канале TED при помощи ИИ производится дублирование речи выступающих, и даже осуществляется корректировка артикуляции губ для синхронизации со звуковой дорожкой на новом языке. Активно появляются сервисы и для рядовых пользователей. Facetune позволяет корректировать лица на видеозаписях; Facewow — полностью заменять их; Runway Aleph — менять цвета объектов или превращать солнечную погоду в снежную бурю. Google Gemini превращает фотографии в короткие ролики; Vidnoz AI обещает генерировать реалистичные изображения говорящих людей в любом стиле; Arcads готовит полноценные рекламные ролики с актёрами и закадровым голосом — аналогичные возможности есть в Symphony Creative Studio для TikTok. Доступны также виртуальная примерка одежды, создание собственных компьютерных игр, анимация людей и персонажей мультфильмов. Из-за ИИ возникают серьёзные конфликты. Жюри фестиваля рекламы «Каннские львы» присудило, а администрация впоследствии отозвала награду ролику, в котором использовался образ американской женщины-политика ДеАндреа Сальвадор (DeAndrea Salvador) — она подала в суд и на создавшую этот ролик компанию, и на его заказчиков. Disney и Universal, а вслед за ними и Warner Brothers подали в суд на создателей генератора изображений Midjourney, которую в иске охарактеризовали как «бездонную яму плагиата». На Meta✴✴ подали в суд две студии, снимающие фильмы для взрослых — гигант соцсетей скачал и начал раздавать по протоколу BitTorrent более 2000 их видеороликов. Пользователь YouTube Дэвид Миллетт (David Millette) в августе прошлого года подал в суд на Nvidia, обвинив компанию в несправедливом обогащении и недобросовестной конкуренции при обучении ИИ Cosmos, но дело удалось уладить. Люди зарабатывают на ИИ-контенте. DeepBrain AI платит по $500 за опубликованные на YouTube ИИ-видео, которые наберут 10 000 просмотров, и это не очень высокая планка. Google и Meta✴✴ делятся с пользователями платформ доходами от рекламы и зачастую поощряют создание контента с помощью ИИ. Появились и «инфоцыгане», готовые научить секретам заработка на созданных ИИ материалах. Техногиганты и сами обучают свои системы ИИ на видео с принадлежащих им платформ: Google взяла не менее 70 млн видео с YouTube, а Meta✴✴ обучала ИИ на более чем 65 млн роликов из Instagram✴✴. Не за горами день, когда людям придётся конкурировать с ИИ за создание более качественного контента. А соцсети постепенно лишатся своего изначально социального характера — иронично, что совсем недавно об этом задумался глава OpenAI Сэм Альтман (Sam Altman). У пиратов в России упали доходы — давление на них усилилось, а легальные онлайн-кинотеатры стали привлекательнее

10.09.2025 [14:26],

Владимир Мироненко

Объём рынка пиратского видеоконтента в России в первом полугодии 2025 года сократился на 14,5 % до $16,6 млн, а трафик поисковых запросов на пиратские порталы упал почти на 14 %, пишет «Коммерсантъ» со ссылкой на исследование компании F6, которая связывает это с растущей популярностью легальных стриминговых платформ.

Источник изображения: Amr Taha / unsplash.com Стоимость показов рекламы на пиратских ресурсах тоже снизилась. В отчётном периоде средний CPM (Cost Per Mille, цена за 1 тыс. показов в рекламной кампании) составил $3,11, что на 0,6 % и на 2,2 % меньше, чем за первое полугодие 2024 и 2023 годов соответственно. Пытаясь избежать выявления пиратского контента распространители применяют новые уловки, включая шифрование названий и описаний пиратских версий фильмов и сериалов, отметили исследователи. Некоторые администраторы ресурсов даже использовали для этого азбуку «Морзе». Вместе с тем пираты больше регистрируют домены, число которых выросло год к году на 27,4 %, до 79 тыс., а по сравнению с аналогичным периодом 2023 года — на 36,2 %. И для распространения контента теперь в основном используются специализированные сайты, а не соцсети, мессенджеры и видеохостинги, доля которых сократилась до 1,6 %. Для сравнения, в 2023 году этот показатель составлял 12,1 %. В «Газпром-медиа холдинге» объяснили сокращение доходов пиратов, снижение CPM и трафика на ресурсы мерами по борьбе с пиратством, включая блокировки, удаление ссылок из поисковой выдачи. Следует также отметить растущую привлекательность легальных онлайн-кинотеатров. Вместе с тем злоумышленники пытаются адаптироваться и используют технические уловки, что замедляет темпы снижения их доходов. В онлайн-кинотеатре Wink подтвердили, что постоянный рост числа подписчиков легальных российских стримингов действительно снижает потенциальную базу пиратских ресурсов в части отечественного контента, в то время как уход западных правообладателей с российского рынка «провоцирует активность пиратов по предоставлению зарубежного контента отечественным зрителям». Tencent выпустила открытую ИИ-модель, которая создаёт целые 3D-миры по одному изображению

07.09.2025 [12:29],

Владимир Фетисов

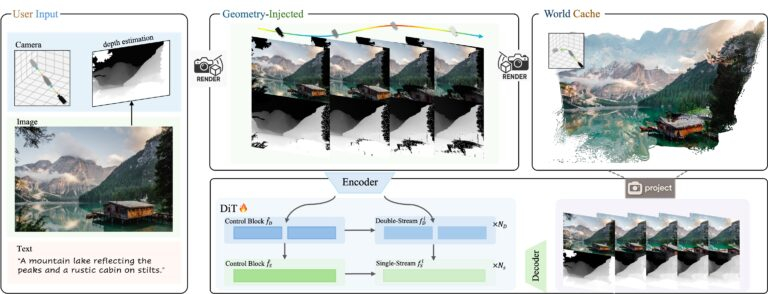

На этой неделе китайская компания Tencent представила новую ИИ-модель с открытым исходным кодом HunyuanWorld-Voyager. С её помощью можно генерировать 3D-видеоряд из одного исходного изображения, управляя траекторией камеры для «изучения» виртуальных сцен. Алгоритм одновременно генерирует видео в формате RGB и информацию о глубине (RGB-D), что позволяет осуществлять 3D-реконструкцию без использования традиционных методов моделирования.

Источник изображений: Tencent На самом деле результаты работы HunyuanWorld-Voyager не являются настоящими 3D-моделями, но создаётся аналогичный эффект. ИИ-алгоритм генерирует 2D-видеокадры, которые сохраняют пространственную согласованность, как если бы камера перемещалась в реальном 3D-пространстве. В каждой генерации создаётся всего 49 кадров, т.е. примерно две секунды видео. По данным Tencent, несколько клипов могут быть объединены в последовательности продолжительностью «несколько минут». Объекты сохраняют своё положение, когда камера перемещается вокруг них, перспектива изменяется корректно, как если бы это происходило в реальной 3D-среде. Хотя результатом работы является видео с картами глубины, а не полноценные 3D-модели, эти данные можно преобразовывать в 3D-облака точек для дальнейшей реконструкции. Система работает на основе одного исходного изображения и заданной пользователем траектории камеры. Можно задать движение камеры вперёд, назад, влево, вправо или поворот, для чего предусмотрен интерфейс управления. Система объединяет данные об изображении и глубине с другими данными для формирования видеоряда, отражающего движение камеры, которое задал пользователь. Основным ограничением всех ИИ-моделей на базе архитектуры Transformer является то, что они в основном имитируют паттерны, найденные в данных для обучения, что ограничивает их возможности в плане «обобщения», т.е. применения этих шаблонов в новых ситуациях, которые не встречались при обучении. Для обучения HunyuanWorld-Voyager исследователи задействовали более 100 тыс. видеоклипов, включая компьютерные сцены на движке Unreal Engine. По сути они обучали ИИ-алгоритм имитировать движение 3D-камер в среде видеоигр. Большинство ИИ-генераторов, таких как Sora, создают выглядящие правдоподобно кадры друг за другом, не пытаясь отслеживать или поддерживать пространственную согласованность. В отличие от этого HunyuanWorld-Voyager обучен распознавать и воспроизводить закономерности пространственной согласованности, но с добавлением обратной геометрической связи. Когда он генерирует каждый кадр, осуществляется преобразование выходных данных в точечный 3D-объект, после чего эти точки проецируются обратно в 2D для использования в будущих кадрах. Такой подход заставляет ИИ-модель сопоставлять изученные ранее шаблоны с геометрически согласованными проекциями, полученными в процессе работы. Это обеспечивает гораздо лучшую пространственную согласованность, чем у других ИИ-генераторов видео. Однако в основе подхода всё же лежит сопоставление паттернов, основанное на геометрических ограничениях, а не полноценное «понимание» 3D. Это объясняет, почему ИИ-модель может сохранять согласованность в течение нескольких минут, но с трудом справляется с поворот сцены на 360°. Ошибки при сопоставлении с образцом накапливаются на протяжении многих кадров до тех пор, пока геометрические ограничения уже не могут поддерживать согласованность. По данным Tencent, HunyuanWorld-Voyager использует в работе два основных блока, работающих совместно. Во-первых, система генерирует цветное видео и информацию о глубине одновременно, чтобы убедиться, что они идеально совпадают. Во-вторых, используется то, что Tencent называет «глобальным кэшем» — растущая коллекция точечных 3D-моделей, созданных из ранее сгенерированных кадров. В процессе генерации новых кадров это облако 3D-точек проецируется обратно в 2D с нового ракурса камеры для создания изображений, показывающих то, что должно быть видно на основе предыдущих кадров. Затем модель использует эти проекции для проверки согласованности, обеспечивая соответствие новых кадров уже сгенерированным.  HunyuanWorld-Voyager развивает идеи более ранней ИИ-модели Tencent HunyuanWorld 1.0, которая была выпущена в июле. Алгоритм также является частью более масштабной экосистемы Tencent Hunyuan, которая также включает в себя алгоритмы Hunyuan3D-2 для генерации 3D-объектов по текстовому описанию и HunyuanVideo для генерации видео. Для обеспечения работоспособности HunyuanWorld-Voyager требуются значительные вычислительные мощности. Tencent рекомендует использовать не менее 60 Гбайт видеопамяти для получения 3D-сцен с разрешением 540p или 80 Гбайт видеопамяти для повышения качества картинки. Получить доступ к исходному коду ИИ-модели и сопутствующей документации можно на портале Hugging Face. Как и другие ИИ-модели семейства Hunyuan, новый алгоритм поставляется с существенными лицензионными ограничениями. К примеру, лицензия запрещает использовать HunyuanWorld-Voyager в ЕС, Великобритании и Южной Корее. Отдельного лицензирования требует коммерческое использование, предполагающее обслуживание более 100 млн пользователей в месяц. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |