|

Опрос

|

реклама

Быстрый переход

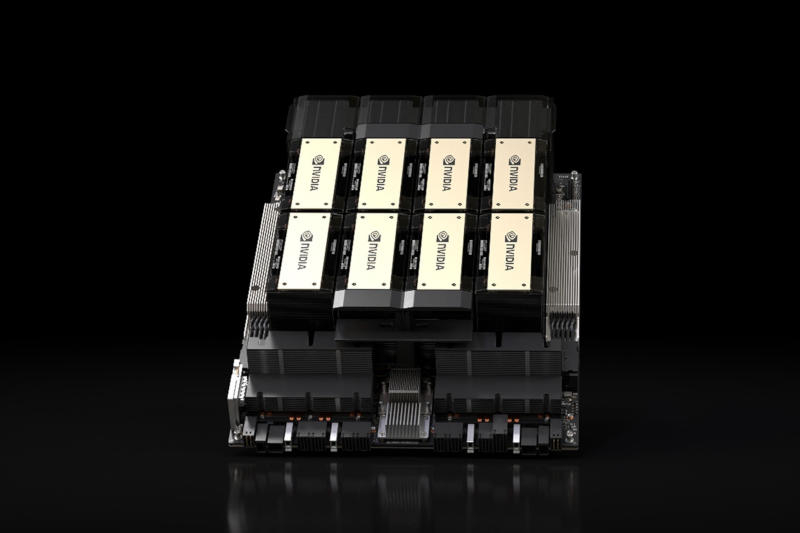

Китайские компании задумали скупать застрявшие на границе Nvidia H200 через чёрный рынок

22.01.2026 [18:15],

Павел Котов

Китайские компании не исключают возможности закупать ускорители искусственного интеллекта Nvidia H200 на чёрном рынке после того, как Пекин запретил их ввоз в страну, пишет South China Morning Post. У местных разработчиков ИИ выбор простой: переплачивать за нелегальный импорт американских ускорителей или пользоваться менее производительными чипами местного производства.

Источник изображения: nvidia.com Сейчас китайская таможня задерживает Nvidia H200 на границе, и нет ясности, когда ввоз будет разрешён. Поэтому местные компании в силу «срочной необходимости» рассматривают возможность закупать ускорители на чёрном рынке. Перекупщики уже получают заказы на H200, а серверы с восемью ускорителями продаются по цене на 50 % выше официальной. В декабре, когда глава Nvidia Дженсен Хуанг (Jensen Huang) заявил о высоком спросе на ускорители H200, президент США Дональд Трамп (Donald Trump) разрешил их экспорт в Китай. Вскоре после этого власти в Пекине провели экстренное совещание и поручили технологическим компаниям приостановить закупки этих ускорителей, но, по одной из версий, их всё ещё могут закупать университетские научно-исследовательские лаборатории. Перед дилеммой оказались не только китайские разработчики ИИ, но и власти. С одной стороны, Пекин стремится установить «кремниевый суверенитет», поддержать собственную полупроводниковую промышленность и не зависеть больше от чипов западного производства. С другой, Китай ведёт гонку с США за превосходство в области ИИ, и для обучения передовых моделей технологическим компаниям нужны новейшие чипы. К настоящему моменту китайские ИИ-процессоры поднялись до уровня ускорителей Nvidia H20 и RTX Pro 6000D, которые подходят для запуска, но не обучения ИИ — в стране нет аналогов H200 и уж тем более моделей уровня семейства Blackwell и перспективного Vera Rubin. Эти соображения заставили некоторые компании обратиться к чёрному рынку, где остаётся возможность приобретать самые мощные ускорители вне легальных каналов. Ранее появилось сообщение, что за 2025 год китайские компании контрабандой ввезли в страну ускорители Nvidia на сумму не менее $1 млрд; некоторые даже хвастались наличием Blackwell B300 ещё до их выхода. Купленные на чёрном рынке серверы с восемью ускорителями Nvidia H200 и наценкой 50 % обходятся примерно по $330 тыс. Пока нет ясности, останется ли запрет на их ввоз в Китай постоянным, или Пекин решил обзавестись козырем в переговорах с США: в конце января страну намеревается посетить Дженсен Хуанг, а в апреле — Дональд Трамп. Google снова поглотила ИИ-стартап, переманив лучших специалистов — Hume AI, разрабатывающий голосовой ИИ

22.01.2026 [17:03],

Павел Котов

Генеральный директор стартапа Hume AI, Алан Коуэн (Alan Cowen) и несколько ведущих инженеров компании перейдут на работу в подразделение Google DeepMind в рамках заключённого лицензионного соглашения. Подобные контракты рассматриваются как скрытая форма поглощения.

Источник изображения: BoliviaInteligente / unsplash.com Hume AI специализируется над способными распознавать и воспроизводить человеческие эмоции голосовыми интерфейсами на основе искусственного интеллекта. Финансовые вопросы сделки с Google не раскрываются, но Hume AI предупредила, что продолжит поставлять свои решения другим передовым ИИ-лабораториям. Сделка свидетельствует, что голосовой интерфейс становится всё более важным направлением в области ИИ, а понимание эмоций и настроения пользователя на основе взаимодействия с ним обретает всё более важное значение. К настоящему моменту Hume AI привлекла инвестиции на сумму $74 млн, а по итогам 2026 года компания рассчитывает получить доход в размере $100 млн. Обладатель докторской степени (PhD) по психологии гендиректор Hume AI Алан Коуэн и около семи ведущих инженеров компании перейдут на работу в Google DeepMind, где займутся интеграцией алгоритмов голосового и эмоционального искусственного интеллекта в новейшие модели компании. Hume AI обучает модели, привлекая экспертов, которые производят разметку эмоциональных сигналов в реальных разговорах. Сделка с Hume AI усилит позиции Google в конкуренции с OpenAI ChatGPT, у которого есть мощный голосовой режим; поисковый гигант также недавно заключил соглашение с Apple — модель Gemini будет использоваться для создания обновлённой версии ИИ-помощника Siri. Механизм соглашения рассматривается как скрытая форма поглощения компании, позволяющая не привлекать внимания государственного надзора. Ранее по схожей схеме сотрудники Inflection перешли в Microsoft, Amazon заполучила команду Adept, а Meta✴✴ — гендиректора Scale AI. Warner Music представил в Китае ИИ-певицу AI-Hua и выпустил первый клип

22.01.2026 [16:16],

Владимир Мироненко

Подразделение Warner Music China представило в Китае первого виртуального исполнителя — ИИ-певицу AI-Hua, созданную в сотрудничестве с компанией Kling AI. AI-Hua дебютировала с песней Wu AI-Hua, которая доступна на ряде платформ, включая Apple Music.

Источник изображения: x.com Также компания разместила на YouTube клип на песню Wu AI-Hua, сгенерированный ИИ, в котором «переосмысливается» для массовой аудитории приключенческий жанр «Уся», ранее популярный в китайском кинематографе. Цель состоит в том, чтобы объединить образы, созданные для ИИ, с современным ритмом в цифровом повествовании, направленном на международную аудиторию. «Созданный в сотрудничестве с Kling AI Creator @ jcwooofficial, этот проект разрушает границы между традициями и современными ритмами», — сообщил представитель Warner Music China в соцсети Х. Сгенерированная ИИ музыка продолжает набирать популярность. В прошлом году играющая в жанре психоделического рока группа The Velvet Sundown набрала на музыкальной платформе Spotify более миллиона слушателей в месяц, зарабатывая на стримингах тысячи долларов. В ноябре 2025 года компания Warner Music Group договорилась о партнёрстве с ИИ-сервисом для создания музыки Suno, в рамках которого он может использовать имена певцов, голос, внешность и музыкальные композиции для генерации ИИ-треков в обмен на монетизацию. Сделка была заключена после урегулирования разногласий лейбла с ИИ-сервисом Suno в связи с нарушением последним авторских прав. «Кража — это не инновация»: против незаконного использования контента для обучения ИИ выступили художники, писатели и музыканты

22.01.2026 [12:00],

Владимир Мироненко

Около 800 художников, писателей, актёров и музыкантов присоединились к новой кампании под названием «Кража — это не инновация», выступающей против незаконного копирования и использования ИИ-компаниями созданных ими произведений — против того, что они называют «кражей в грандиозных масштабах».

Источник изображения: Markus Winkler/unsplash.com С инициативой выступила Human Artistry Campaign, группа организаций, в которую входят Ассоциация звукозаписывающей индустрии Америки (RIAA), профсоюзы профессиональных спортсменов и профсоюзы артистов, такие как SAG-AFTRA. Её поддержали писатели Джордж Сондерс (George Saunders) и Джоди Пиколт (Jodi Picoult), актрисы Кейт Бланшетт (Cate Blanchett) и Скарлетт Йоханссон (Scarlett Johansson), а также музыканты, такие как Билли Корган (Billy Corgan) и группы R.E.M, The Roots. Как сообщается в пресс-релизе, «жадные до прибыли технологические компании, включая самых богатых в мире, а также частные инвестиционные фонды, скопировали огромное количество креативного контента в интернете без разрешения и оплаты тем, кто его создал». «Этот незаконный захват интеллектуальной собственности способствует формированию информационной экосистемы, в которой доминируют дезинформация, дипфейки и бессмысленная искусственная лавина низкокачественных материалов [«ИИ-хлам»], что грозит крахом ИИ-моделей и напрямую угрожает превосходству Америки в области ИИ и её международной конкурентоспособности», — отметили организаторы инициативы. Они призывают, в том числе, к заключению лицензионных соглашений и созданию «здоровой среды для правоприменения», а также к предоставлению художникам права отказаться от использования их работ для обучения генеративного ИИ. Сообщения в рамках кампании «Кража — это не инновация» будут появляться в полностраничных рекламных объявлениях в новостных изданиях и социальных сетях. Следует отметить, что позитивные сдвиги в урегулировании конфликта между создателями контента и ИИ-компаниями всё же есть. Технологические компании и правообладатели всё чаще заключают лицензионные соглашения, позволяющие компаниям, занимающимся ИИ, использовать защищённые произведения. Крупные звукозаписывающие компании предоставляют стартапам в области музыки с использованием ИИ свои каталоги для ремикширования и обучения ИИ-моделей. Цифровые издатели поддержали стандарт лицензирования, который позволяет блокировать появление их контента в результатах поиска ИИ. Некоторые издания заключили соглашения с технологическими компаниями, согласно которым ИИ-чат-боты могут показывать их новостной контент. По стопам OpenAI: Apple готовит ИИ-гаджет в виде шайбы — с парой камер, кнопкой и динамиками

22.01.2026 [11:59],

Алексей Разин

Бывший главный дизайнер Apple Джони Айв (Jony Ive), примкнувший к OpenAI вместе со своим стартапом, выразил готовность создать для материнской компании от 15 до 20 устройств, позволяющих работать с ИИ. Сама Apple в этой гонке в числе догоняющих оказаться не хочет, а потому уже разрабатывает носимое ИИ-устройство, как утверждают источники.

Источник изображения: Apple Вчера об этом сообщило издание The Information. По слухам, конструктивно данное устройство будет напоминать брошь, которую пользователь сможет носить на своей одежде. В компактном корпусе найдётся место для двух камер и трёх микрофонов, поэтому устройство всегда будет оценивать контекст. Напомним, что OpenAI своё первое ИИ-устройство намерена анонсировать во второй половине текущего года. По некоторым данным, им могут оказаться беспроводные наушники. Предполагается, что ИИ-устройство Apple будет напоминать тонкий диск, корпус которого будет отделан алюминием и стеклом. По размерам новинка будет близка к беспроводной метке AirTag, но превзойдёт её в толщине. Из двух камер одна будет широкоугольной, обе смогут снимать видео и статичные изображения. В корпусе найдётся место для динамика для воспроизведения звука, а также одной физической кнопки для управления. С оборотной стороны устройства будет предусмотрен специальный разъём для подключения зарядного кабеля. Если всё пойдёт по плану, то Apple сможет представить своё ИИ-устройство в 2027 году и выпустить его тиражом 20 млн штук уже в первый год присутствия на рынке. Судьба первопроходцев в новой категории устройств не всегда складывается удачно. Основанная выходцами из Apple компания Humane AI, например, уже пыталась выпустить носимое ИИ-устройство, но оно провалилось на рынке и вынудило стартап продать свои активы HP через два года после анонса этого изделия. От $4 млрд до $9 млрд за полгода: Anthropic показала феноменальный рост выручки в погоне за OpenAI

22.01.2026 [10:01],

Алексей Разин

Компания Anthropic была основана выходцами из OpenAI, и этот стартап пока пытается сосредоточиться на разработке ИИ-систем для корпоративных клиентов. В каком-то смысле это говорит о его более высокой прагматичности, и уже сейчас Anthropic способна получать до $9 млрд выручки в год, а капитализация компании с учётом готовящегося раунда финансирования может вырасти до $350 млрд.

Источник изображения: Anthropic Это не так уж мало на фоне конкурирующей OpenAI, чей приведённый размер годовой выручки сейчас превышает $20 млрд, а капитализация может попасть в диапазон от $750 до $830 млрд, если обрабатываемые Сэмом Альтманом (Sam Altman) ближневосточные инвесторы захотят раскошелиться на $50 млрд. Источники Bloomberg сообщают, что венчурные фонды смогут направить в капитал Anthropic как минимум $1 млрд. Стартап уверенными темпами наращивает выручку. Если ещё в середине прошлого года её приведённая к годовой величина достигала $4 млрд, то в конце 2025 года она превысила рубеж в $9 млрд. Новый раунд финансирования Anthropic полагается преимущественно на средства Nvidia и Microsoft, которые сообща готовы вложить $15 млрд. Венчурные инвесторы могли бы направить на поддержку Anthropic до $10 млрд, но пока стартап довольствуется на порядок меньшей суммой. Впрочем, если подобные ограничения будут сняты, то стартапу вполне по силам будет привлечь свыше $20 млрд с учётом средств Nvidia и Microsoft. Сингапурский фонд GIC готов направить Anthropic до $1,5 млрд, такой же суммой располагает Coatue Management, Iconiq Capital намеревается ограничиться $1 млрд в рамках нового раунда, поскольку неплохо вложилась в капитал стартапа в сентябре прошлого года. Инвестировать в Anthropic неопределённые суммы готовы Lightspeed Venture Partners, Menlo Ventures и Sequoia Capital. Представленная в сентябре Anthropic модель Claude Sonnet 4.5 лучше воспринимает команды пользователя и способна на протяжении 30 часов самостоятельно заниматься написанием программного кода, прежде чем потребует взаимодействия с человеком. Сотрудничество Anthropic с Nvidia и Microsoft является обоюдовыгодным, поскольку стартап потребляет продукцию второй из компаний и услуги последней. На строительство центров обработки данных в США компания Anthropic намерена направить $50 млрд, поэтому средства нужны ей не только для совершенствования своих программных продуктов. Акции Intel подорожали до четырёхлетнего максимума ещё до публикации квартального отчёта

22.01.2026 [08:17],

Алексей Разин

В конце этой недели корпорация Intel разродится квартальным и годовым отчётом, но высокой динамике её акций на бирже накануне способствовали и геополитические факторы. Так или иначе, вчера акции Intel выросли в цене на 12 % до $54,25, что является максимальным уровнем с января 2022 года. В целом за предыдущие 12 месяцев акции Intel выросли в цене на 149 %.

Источник изображения: Intel Важно отметить, что акции других американских эмитентов, связанных с производством чипов и информационными технологиями, вчера тоже демонстрировали рост после заявлений Дональда Трампа (Donald Trump) об отсутствии у него намерений реализовывать силовой вариант присоединения Гренландии к США, а также об отказе от введения повышенных импортных тарифов на товары из стран Евросоюза. Акции Micron подорожали на 7 %, ценные бумаги AMD прибавили 8 %, Nvidia отличилась ростом курса своих акций на 4 %. В случае с Intel аналитики KeyBanc ожидают благоприятного влияния на выручку компании повышенного спроса на центральные процессоры этой марки в серверном сегменте. По их мнению, компания с высокой вероятностью распродала все серверные процессоры, которые сможет выпустить в этом году. Эксперты рассчитывают, что акции Intel смогут вырасти в цене до $60. Инвесторы связывают определённые надежды и с контрактным бизнесом Intel, который может обзавестись долгожданными крупными клиентами и выйти на второе место после TSMC хотя бы с точки зрения качества передовых техпроцессов. В августе почти 10 % акций достались правительству США. Изначально они стоили покупателю $8,9 млрд, но с тех пор стоимость пакета выросла на $14 млрд. Nvidia направила на покупку акций Intel в прошлом году $5 млрд. Теперь этот пакет оценивается более чем на $6 млрд дороже. Аналитики ожидают, что общая выручка Intel по итогам четвёртого квартала сократилась на 6 % до $13,4 млрд, но в серверном сегменте она должна вырасти на 29 % до $4,4 млрд. OpenAI собралась привлечь $50 млрд от ближневосточных инвесторов на строительство мега-ЦОД

22.01.2026 [07:34],

Алексей Разин

С точки зрения классического финансового анализа показатели деятельности OpenAI пока выглядят не очень привлекательно для потенциальных инвесторов, поскольку даже руководство стартапа не скрывает, что на безубыточность он выйдет не ранее 2029 года. При этом глава OpenAI сейчас ведёт переговоры на Ближнем Востоке о привлечении ещё $50 млрд, рассчитывая увеличить капитализацию до $750 млрд минимум.

Источник изображения: OpenAI Об этом накануне сообщило агентство Bloomberg со ссылкой на собственные осведомлённые источники. Недавно генеральный директор OpenAI Сэм Альтман (Sam Altman) посетил Ближний Восток и провёл переговоры с инвесторами, включая представителей суверенных фондов Абу-Даби (ОАЭ). Если в ходе этого раунда финансирования OpenAI удастся привлечь $50 млрд, то капитализация стартапа будет оцениваться в диапазоне от $750 до $830 млрд. Переговоры пока находятся на ранней стадии, суммы могут измениться. Как ранее сообщало агентство Bloomberg, до этого OpenAI вела переговоры с Amazon о привлечении не менее чем $10 млрд. В ближайшие восемь лет OpenAI собирается направить на развитие собственной вычислительной инфраструктуры около $1,4 трлн, но существующие сделки по финансированию проектов практически исключают какие-либо риски со стороны самого стартапа. Строиться эти огромные и многочисленные ЦОД будут либо за счёт партнёров OpenAI, либо вообще на заёмные средства без явного обеспечения, а финансирование многих сделок в этой сфере организовано по «кольцевому принципу», когда одни и те же суммы передаются участниками по кругу. Ближний Восток с его внушительными запасами нефтедолларов уже становился источником финансирования американских компаний из области ИИ. Компании Anthropic и xAI обращались за поддержкой к ближневосточным инвесторам, да и сама OpenAI привлекала средства от MGX, расположенной в Абу-Даби. Кроме того, на территории ОАЭ компания OpenAI будет строить крупный центр обработки данных при участии местной G42. Осенью прошлого года капитализация OpenAI оценивалась в $500 млрд, однако Anthropic в ходе последнего раунда финансирования претендует на оценку в $350 млрд, поэтому средства в сферу ИИ продолжают поступать мощным потоком. Anthropic представила модифицированную версию «конституции» своего чат-бота Claude

22.01.2026 [06:51],

Алексей Разин

Компания Anthropic старается уделять особое внимание пояснительной работе по поводу своей миссии и фирменных разработок типа того же чат-бота Claude, поэтому на этой неделе она опубликовала новую версию так называемой «конституции», поясняющей принципы его работы и те цели, которые преследуются в его развитии.

Источник изображения: Anthropic Документ определяет те этические принципы, которых компания придерживается при развитии Claude. Они также используются для самоконтроля чат-бота, всего так называемая «программная конституция» содержит 80 страниц и состоит из четырёх разделов, определяющих «базовые ценности» чат-бота: безопасность, этичность, соответствие миссии Anthropic и ориентация на пользу обществу. Каждый из разделов содержит описание того, как подобные принципы влияют на поведение Claude. Разработчики Claude стараются не повторять ошибок конкурентов с точки зрения этики. Например, при подозрении на наличие у пользователя психических расстройств чат-бот сразу рекомендует обратиться к специалисту, если становится ясно, что ситуация может представлять угрозу жизни и здоровью человека. Этическим вопросам уделяется больше внимания в практическом разрезе, а не на уровне теоретических рассуждений. Определённые темы изначально запрещены для обсуждения — например, создание биологического оружия. Наконец, Anthropic стремится сделать Claude максимально дружелюбным и полезным для пользователей. Обеспечение долгосрочного благополучия человека при выдаче информации чат-ботом ставится выше сиюминутных интересов. Конституция Claude при этом содержит и раздел, посвящённый философским рассуждениям разработчиков. Они задают вопросы о наличии морального статуса и сознания у Claude, подчёркивая, что они не одиноки в таких рассуждениях, и конкуренты и коллеги тоже размышляют на подобные темы. Apple поменяла планы и сделает Siri полноценным чат-ботом — как ChatGPT

22.01.2026 [05:50],

Анжелла Марина

Apple превратит голосового помощника Siri в чат-бота, похожего на ChatGPT, и представит обновлённую версию в составе iOS 27 на конференции разработчиков WWDC в июне 2026 года. Об этом сообщил TechCrunch со ссылкой на журналиста Марка Гурмана (Mark Gurman) из Bloomberg.

Источник изображения: Grok Новый вариант Siri получил внутреннее кодовое имя Campos и будет поддерживать как голосовой, так и текстовый ввод. Ранее старший вице-президент Apple по программному обеспечению Крейг Федериги (Craig Federighi) заявлял, что не хочет превращать Siri в чат-бота, а предпочитает интегрировать искусственный интеллект в систему так, чтобы он «был под рукой только в тот момент, когда он нужен». Однако, по данным Гурмана, компания изменила свои планы под давлением успеха чат-ботов других технологических компаний. Дополнительным фактором, подтолкнувшим Apple к активным действиям, могла стать потенциальная угроза со стороны OpenAI, поскольку та планирует выйти на рынок аппаратного обеспечения под руководством бывшего главы дизайна Apple Джони Айва (Jony Ive) и уже планирует представить свой первый ИИ-гаджет в этом году. Как отмечает TechCrunch, Apple отстаёт в гонке за лидерство в области искусственного интеллекта и уже не один раз откладывала выпуск более продвинутой версии Siri, а в прошлом году активно искала партнёра, тестируя технологии OpenAI и Anthropic. В итоге выбор пал на Gemini от Google, о чём было объявлено в начале января. OpenAI выйдет в прибыль только в 2029 году — после $44 млрд убытков

22.01.2026 [05:47],

Анжелла Марина

OpenAI прогнозирует убытки в размере $14 млрд в 2026 году, но рассчитывает выйти на годовую выручку в $100 млрд к 2029 году. В период с 2023 по 2028 год разработчик ChatGPT ожидает суммарные потери на уровне $44 млрд. Об этом сообщает портал PC Gamer со ссылкой на издание The Information, в распоряжении которого оказались внутренние документы OpenAI.

Источник изображения: Levart_Photographer/Unsplash Ситуация должна измениться в 2029 году, когда компания рассчитывает получить первую прибыль в размере $14 млрд. Для достижения этих целей OpenAI планирует потратить до конца десятилетия $200 млрд. При этом от 60 % до 80 % этой суммы будет направлено на обучение и эксплуатацию моделей искусственного интеллекта. Структура будущих доходов распределена следующим образом: более 50 % принесет непосредственно сервис ChatGPT, около 20 % обеспечат продажи моделей разработчикам через API, оставшиеся 20 % придутся на другие продукты. В категорию «другие» входят генерация видео, поиск и новые сервисы, такие как ИИ-ассистенты для исследований. При этом, в соответствии с документами, на которые также ссылается PC Gamer, в первой половине последнего финансового года расходы компании составили всего $340 млн. Как этот текущий уровень затрат сочетается с прогнозом многомиллиардных убытков, в документах не поясняется. Цифровой рантье: OpenAI задумала брать процент с прибыли, полученной клиентами с помощью ChatGPT

21.01.2026 [22:37],

Анжелла Марина

Финансовый директор OpenAI Сара Фрайар (Sarah Friar) в ходе недавнего подкаста сообщила, что компания рассматривает возможность фундаментального изменения своей бизнес-модели, выходящей за рамки фиксированных подписок. По словам топ-менеджера, в будущем OpenAI может перейти к модели роялти с оплатой, зависящей от результатов работы клиента с ChatGPT.

Источник изображения: AI В качестве иллюстрации Фрайар привела сферу разработки лекарств. Если фармацевтический партнёр использует технологии OpenAI для создания прорывного препарата, стартап может претендовать на лицензионную долю от продаж этого лекарства. Финансовый директор подчеркнула, что суть такого подхода заключается в совпадении интересов: OpenAI будет зарабатывать деньги тогда, когда их зарабатывают клиенты. Фрайар охарактеризовала текущую стратегию компании метафорой кубика Рубика, который имеет около 43 квинтиллионов состояний. Она напомнила, что изначально OpenAI представляла собой единый блок в виде одного облачного провайдера (Microsoft), одного ключевого партнёра по чипам (Nvidia), одного флагманского продукта (ChatGPT) и — ещё совсем недавно — одной базовой подписки. Такая модель нужна была для оплаты вычислительных ресурсов. С тех пор, как пишет в своём эксклюзивном материале Business Insider, структура бизнеса OpenAI усложнилась. Сейчас компания сотрудничает с несколькими облачными провайдерами и производителями чипов. Продуктовая линейка расширилась за пределы потребительского ChatGPT и теперь включает генератор видео Sora, корпоративные продукты, специализированные отраслевые предложения и платформы для исследований. Монетизация также трансформировалась: помимо единой подписки появились различные ценовые уровни, модель «программное обеспечение как услуга» (SaaS) и кредитная система оплаты для ресурсоёмких задач. Фрайар подчеркнула, что главным ограничением для всех этих стратегий остаётся доступный объём вычислительных мощностей. По её словам, спрос на сервисы OpenAI сдерживается не отсутствием интереса, а нехваткой инфраструктуры. Именно это делает расширение источников дохода не просто возможным, а необходимым для выполнения миссии компании. Adobe Acrobat научился редактировать PDF с помощью промптов, делать презентации и озвучивать документы

21.01.2026 [21:27],

Анжелла Марина

Компания Adobe добавила в приложение Acrobat пакет новых функций на базе искусственного интеллекта (ИИ). Теперь можно редактировать документы с помощью текстовых команд, создавать презентации на основе файлов, размещённых в среде совместного хранения PDF Spaces, а также генерировать аудиоподкасты для быстрого ознакомления с содержимым.

Источник изображения: Adobe Для создания презентации пользователю достаточно отправить текстовый запрос, а далее ИИ-помощник в Acrobat проанализирует материалы, собранные в конкретном Space, например, финансовые данные, планы по продукту и анализ конкурентов, и сформирует на их основе структуру презентации, которую затем можно отредактировать. Готовый каркас, как поясняет TechCrunch, можно оформить, используя библиотеку тем и стоковых фотографий Adobe Express, добавить собственные изображения или применить фирменный стиль бренда. Нововведение также позволяет сгенерировать аудиоподкаст, кратко излагающий содержание выбранного файла или целого Space и озвученный с помощью ИИ. Стоит сказать, что аналогичная функция представлена в таких сервисах, как Google NotebookLM, Speechify и Reader от ElevenLabs. Ещё Acrobat получил функцию редактирования файлов с помощью промптов. Пользователям доступно 12 действий, включая удаление страниц, текста, комментариев и изображений, поиск и замену слов и фраз, а также добавление электронных подписей и паролей. Кроме того, расширены возможности совместной работы: теперь при обмене файлами в них автоматически добавляются сгенерированные ИИ-помощником сводки с цитатами из документов. Участники рабочей группы могут оставлять комментарии, а также добавлять или удалять контент. Предусмотрена возможность выбора не только стандартного ИИ-помощника, но и создания собственного ассистента. Ко всему прочему, стандартному ИИ можно назначать роли, например «аналитика», «артиста» или «инструктора». Nvidia обвинили в переговорах с пиратами о доступе к 500 Тбайт книг для обучения ИИ

21.01.2026 [18:37],

Павел Котов

В окружной суд Северного округа Калифорнии подали исправленную версию коллективного иска, в котором утверждается, что сотрудники Nvidia обращались за материалами к администрации Anna’s Archive — пиратского сайта, на котором вразрез с авторским правом размещены миллионы книг и научных работ.

Источник изображения: BoliviaInteligente / unsplash.com Предметом переговоров был «высокоскоростной доступ» к данным архива. Представители Anna’s Archive якобы прямым текстом заявили, что материалы были получены незаконным путём, и спросили, есть ли у Nvidia разрешение от руководства на продолжение работы. Вскоре такое согласие было получено, говорится в иске. Ресурс Anna’s Archive предложил Nvidia доступ к примерно 500 Тбайт данных — коллекция содержит несколько миллионов книг, некоторые из которых доступны на платформе Internet Archive через систему цифрового проката. Авторы иска не уточняют, платила ли Nvidia за доступ к информации и воспользовалась ли пиратскими данными. Истцы, впрочем, обвиняют Nvidia в использовании других пиратских источников: набора данных Books3, а также сайтов Library Genesis, Sci-Hub и Z-Library. Ещё один иск гласит, что Nvidia предоставляла средства, которые позволяли клиентам загружать данные из набора The Pile, включающего Books3 — около 200 000 книг. Это привело к косвенному и опосредованному нарушению авторских прав, потому что клиенты могли получить доступ к пиратским книгам посредством предоставленных компанией средств. Ранее Nvidia заявила, что обучение ИИ подпадает под норму о добросовестном использовании данных, потому что модели ИИ изучают закономерности, а не хранят тексты книг. Рассмотрение дела продолжается. ChatGPT пошатнул ещё один из столпов Google — chatgpt.com набирает популярность в качестве домашней страницы

21.01.2026 [14:59],

Павел Котов

Многие платные пользователи ChatGPT стали добавлять сервис как домашнюю страницу в браузере или иными способами ускоряют свой доступ к сервису. Это говорит о высокой значимости сервиса, но раньше в этом сегменте доминировал Google.

Источник изображения: BoliviaInteligente / unsplash.com В США 72 % платных пользователей ChatGPT установили сервис как домашнюю страницу в браузере на ПК или мобильном устройстве вместо традиционных поисковых систем, показал опрос компании Bango среди 1400 пользователей ChatGPT в США. 78 % добавили виджет сервиса на главный экран смартфона или планшета; 74 % изъявили готовность оплачивать товары прямо в интерфейсе ChatGPT; 72 % сказали, что готовы сократить использование других приложений — в ChatGPT уже работают картография и Spotify; 75 % сказали, что хотят подключить ChatGPT к решению повседневных задач; 77 % отметили, что готовы оплачивать ChatGPT в связке с другими сервисами; 74 % добавили, что готовы платить за доступ к чат-боту через мобильного оператора. Другими словами, ChatGPT — это не просто сервис для быстрых ответов или помощи в написании текстов. Всё больше людей открывают этот ресурс первым, и здесь они готовы проводить значительную часть своей цифровой жизни; это больше не какой-то сервис, которым человек пользуется время от времени. Люди отвыкают от традиционного механизма перехода по ссылкам в Google и доверяют искусственному интеллекту подготовку ответов на вопросы. Они готовы оплачивать здесь покупки, а также отказываться от некоторых привычных сервисов, доступ к которым здесь есть в том или ином виде — проще пользоваться одной службой, где есть всё, а не десятком отдельных. Интересно, что люди всё больше воспринимают ChatGPT как некий аналог потоковых сервисов — они готовы платить за него в пакете, в том числе и в рамках контракта с мобильным оператором. Хоронить поиск Google пока рано, потому что ИИ до сих пор работает не идеально. Объём традиционных поисковых запросов по-прежнему огромен. Если всё большее число людей начинает свой день с ChatGPT, это со временем может изменить принцип работы поиска — для разработчиков, рекламодателей и владельцев площадок. Речь уже не о том, кто первый появится в поисковой выдаче, а о том, кого выдаст интерфейс чат-бота, который люди открывают первым делом. И этот успех потребуется монетизировать. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |