|

Опрос

|

реклама

Быстрый переход

Google представила Gemini 3.1 Flash-Lite — «самую быструю и экономически эффективную модель семейства»

04.03.2026 [00:01],

Владимир Фетисов

Компания Google объявила о запуске Gemini 3.1 Flash-Lite — быстрой и наиболее доступной с экономической точки зрения ИИ-модели семейства Gemini. Алгоритм оптимизирован для эффективной обработки больших объёмов данных, а стоимость его использования составляет $0,25 за 1 млн входных и $1,50 за 1 млн выходных токенов. Предварительная версия ИИ-модели уже доступна разработчикам через Gemini API в Google AI Studio, а для корпоративных клиентов — в Vertex AI.

Источник изображений: Google Gemini 3.1 Flash-Lite превосходит модель Gemini 2.5 Flash по времени до генерации первого токена в 2,5 раза и на 45 % быстрее выводит данные ответов. При этом сохраняется аналогичный или более высокий уровень качества ответов. Такая низкая задержка необходима для повышения эффективности рабочих процессов, что делает новую модель привлекательной для разработчиков, создающих отзывчивые решения и приложения, работающие в режиме реального времени. ИИ-модель достигла впечатляющего результата в рейтинге ELO в 1432 балла на Arena.ai и превзошла другие ИИ-модели аналогичного уровня по показателям рассуждения и мультимодальной обработки. В тестах GPQA Diamond и MMMU Pro алгоритм набрал 86,9 % и 76,8 % соответственно, превзойдя результаты некоторых более крупных ИИ-моделей Gemini предыдущих поколений, таких как Gemini 2.5 Flash. Разработчики имеют возможность регулирования глубины рассуждений Gemini 3.1 Flash-Lite в соответствии с собственными потребностями. Этот аспект является важным для управления высокочастотными рабочими нагрузками. Проведена оптимизация обработки масштабных задач, таких как перевод больших объёмов текста и модерация контента, где стоимость является одним из приоритетов. Алгоритм подходит для генерации пользовательских интерфейсов (UI), дашбодов, моделирования и проведения исследований на основе сложных запросов. Boeing научила спутники объяснять телеметрию человеческим языком — разберётся даже неуч

25.02.2026 [23:09],

Геннадий Детинич

Одной из причин неудач с кораблём Boeing Starliner во время первых запусков были ошибки в коде и неправильная интерпретация телеметрии. Злые языки даже шутили о набранных по объявлению индийских программистах. Но если бы данные телеметрии в реальном времени доносились до стартовой команды на человеческом языке, всё могло сложиться иначе. Компания учла это и создала LLM для запуска на маломощных компьютерах спутников, которая объясняет данные понятным языком.

Источник изображения: ИИ-генерация Grok 4/3DNews В начале проекта инженеры сомневались, что стандартные коммерческие спутниковые платформы смогут работать с большими языковыми моделями. Всё-таки компьютеры для работы в космосе — это отдельная история, где производительность не главное. Главное — устойчивость к радиации, стабильная работа без перегрева и минимальное энергопотребление. В ходе наземных лабораторных тестов инженеры Boeing Space Mission Systems адаптировали LLM для работы на коммерческом оборудовании, отвечающем требованиям эксплуатации в космосе. Модель способна анализировать телеметрию спутника и формировать отчёты о состоянии его систем на естественном языке вместо традиционной обработки сырых данных и кодов на Земле. Руководитель AI Lab Арвел Чаппелл III (Arvel Chappell III) отметил: «Производитель оборудования изначально заявил, что это невозможно из-за жёстких ограничений, однако команда нашла способ реализации идеи». Основное преимущество технологии заключается в значительном снижении задержек и повышении автономности спутников. Благодаря обработке телеметрии непосредственно на борту уменьшается объём передаваемой на Землю информации, а операторы могут взаимодействовать со спутником почти в режиме диалога — задавать вопросы и получать понятные ответы. Модель специально привязана к физическим параметрам работы систем, что минимизирует риск галлюцинаций и обеспечивает безопасность критически важных операций. Поскольку всё работает на стандартном «железе», можно обновить возможности действующих спутниковых группировок исключительно программно, без многолетней замены платформ с новыми компьютерами. В противном случае могли бы пройти годы, прежде чем такая удобная опция появилась бы на множестве спутников. Теперь же всё можно обновить за считанные месяцы. Санкции не помеха: DeepSeek могла обучить ИИ на запрещённых Nvidia Blackwell

24.02.2026 [07:42],

Алексей Разин

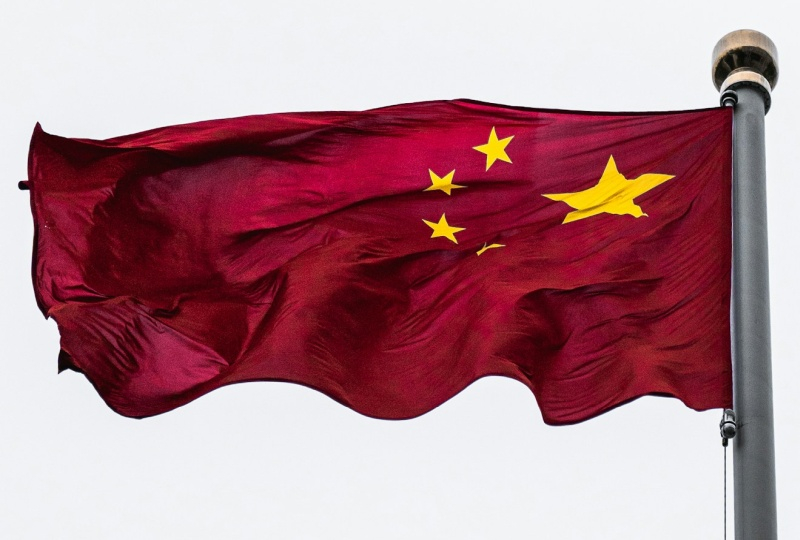

Несмотря на некоторое смягчение политики экспортных ограничений США в отношении поставок в Китай ускорителей вычислений для систем ИИ, решения Nvidia семейства Blackwell остаются в этой стране под запретом. Это не помешало китайской DeepSeek, по данным некоторых источников, обучить свою новейшую ИИ-модель именно на этих ускорителях.

Источник изображения: Nvidia На следующей неделе, как поясняет Reuters, китайская DeepSeek представит свою новейшую ИИ-модель, и у источника есть все основания полагать, что она была обучена с использованием санкционных ускорителей Nvidia Blackwell, которые эксплуатируются во Внутренней Монголии — регионе Китая, обладающем определённой автономией. Соответствующей информацией располагают американские чиновники, а это может стать поводом для определённых действий в отношении китайских разработчиков ИИ. Как последние получили доступ к ускорителям Blackwell в условиях санкций, источники не поясняют. В целом, американские политики разделились на два лагеря. Одни под воздействием основателя Nvidia Дженсена Хуанга (Jensen Huang) склонились к идее о необходимости сохранения зависимости Китая от поставок американских ускорителей вычислений, которые могут отставать от передовых на одно или два поколения. Другие считают, что предоставление Китаю доступа к таким инструментам сродни передаче ему ядерного оружия по доброй воле. Американские чиновники опасаются, что китайские ИИ-решения будут поставлены на службу оборонной отрасли КНР. Принято считать, что в августе прошлого года американский президент Дональд Трамп (Donald Trump) был близок к выдаче разрешения на поставку в Китай модифицированных ускорителей Blackwell, которые отставали бы от предлагаемых в США по уровню быстродействия. Вместо этого в декабре Трамп разрешил поставки в КНР ускорителей H200 с более старой архитектурой Hopper. Учитывая растущее количество жалоб американских разработчиков на хищение данных со стороны китайских конкурентов, американские власти могут ввести дополнительные ограничения в сфере ИИ на китайском направлении экспорта. Anthropic обвинила DeepSeek и ещё двух китайских конкурентов в 16 млн попыток дистилляции моделей Claude

24.02.2026 [07:04],

Алексей Разин

OpenAI в этом месяце уже предупреждала американских законодателей в применении китайской компанией DeepSeek метода дистилляции её ИИ-моделей для ускорения собственного прогресса. Теперь со схожими обвинениями выступила Anthropic, причём в адрес сразу трёх китайских конкурентов: DeepSeek, MiniMax Group и Moonshot.

Источник изображения: Unsplash, Solen Feyissa По словам представителей Anthropic, на которые ссылается Bloomberg, три указанные китайские компании нарушили правила использования её моделей семейства Claude, осуществив не менее 16 млн сессий обмена данными с использованием тысяч поддельных учётных записей. Метод дистилляции в сфере обучения моделей позволяет разработчикам добиваться прогресса в сжатые сроки, совершенствуя свои системы на основе данных, получаемых от уже обученных сторонних моделей. Как отмечает Anthropic в своём блоге, действия китайских разработчиков в этой сфере становятся всё более активными и изощрёнными. При этом окно времени для решительных ответных действий становится всё более узким, а угроза распространяется за пределы одной компании и конкретного региона. Триумф китайской DeepSeek состоялся примерно год назад, когда она представила свою модель R1, которая при сопоставимой результативности обошлась в обучении в разы дешевле создаваемых западными конкурентами. С тех пор китайские разработчики буквально наводнили рынок более доступными ИИ-моделями, которые позволяют работать с текстом, видео и изображениями. Американским компаниям, которые опираются на закрытую экосистему, стало сложнее монетизировать свои разработки. По данным Anthropic, китайские конкуренты использовали подставные учётные записи и прокси-серверы для доступа к данным Claude с минимальным риском обнаружения. Если DeepSeek осуществила более 150 000 обменов данными с Claude, то MiniMax преодолела планку в 13 млн обменов, пытаясь воссоздать передовые функции по примеру Claude, как считают в Anthropic. Отследить подобную активность Anthropic помогли партнёры, и в достоверности своих выводов компания очень уверена. Она формирует новые методы защиты от дистилляции своих моделей и готова делиться ими с другими представителями отрасли: «Ни одна из компаний не сможет с этим справиться в одиночку. Дистилляционные атаки такого масштаба требуют скоординированного ответа всей ИИ-отрасли, включая провайдеров облачных услуг и регуляторов». Google Gemini научился генерировать 30-секундные музыкальные треки по описанию и картинкам

19.02.2026 [06:55],

Алексей Разин

Бета-доступ к модели Lyria 3 входящей в состав Google лаборатории DeepMind позволил пользователям чат-бота Gemini создавать короткие 30-секундные музыкальные композиции на основе текстовых описаний, изображений и видеороликов, при этом даже не нужно покидать интерфейс чат-бота.

Источник изображения: Nvidia С этой недели доступ к данному инструменту генерирования музыки получили пользователи Google по всему миру, на первом этапе поддерживаются запросы и результаты на английском, немецком, испанском, французском, японском, корейском и португальском языках, а также хинди. Запросы в этом сервисе могут упоминать как конкретные музыкальные стили, так и эмоциональный настрой, либо какие-то типичные жизненные ситуации. Сервис позволяет генерировать как инструментальные композиции, так и произведения с вокалом на текст, предложенный пользователем. Для более точного результата с точки зрения формируемого настроения пользователь может прилагать к текстовому запросу фотографии или видеоролики. Google подчёркивает, что подобный инструмент не направлен на создание музыкальных шедевров, а в большей мере ориентирован на развлечение и самовыражение пользователей. Для более удобного распространения созданных 30-секундных музыкальных композиций Google будет снабжать их обложками, сгенерированными при помощи Nano Banana. Эти композиции также можно будет использовать совместно с инструментом Dream Track, который позволяет сопровождать публикуемые в YouTube короткие видеоролики музыкой независимых авторов. Учитывая предыдущий опыт внедрения средств генерирования музыки при помощи ИИ, компания Google в модели Lyria 3 предусмотрела механизмы защиты от слепого копирования произведений конкретных авторов и голосов определённых исполнителей. Lyria существует с 2023 года, но доступ к ней был ограничен облачной платформой Google Vertex. Интеграция подобных возможностей в Google Gemini делает инструмент для генерирования музыки более доступным, но в этой сфере компания отстаёт по графику от многих конкурентов типа TikTok и Microsoft. Меньше галлюцинаций и миллионный контекст: Anthropic представила Sonnet 4.6 и она уже доступна бесплатно в Claude

17.02.2026 [22:52],

Андрей Созинов

Anthropic обновила свою большую языковую модель Sonnet среднего уровня. В анонсе Sonnet 4.6 разработчики Anthropic подчеркнули улучшения в генерации программного кода, рассуждениях с длинным контекстом, выполнении инструкций и работе с компьютером. Новинка станет стандартной моделью для чат-бота Claude как для бесплатных пользователей, так и в платной подписке Pro.

Источник изображений: Anthropic Sonnet 4.6 предлагает контекстное окно размером 1 миллион токенов, что вдвое больше, чем было у предыдущей версии Sonnet. Anthropic описала новое контекстное окно как «достаточное для хранения целых кодовых баз, длинных контрактов или десятков исследовательских работ в одном запросе». В компании подчёркивают, что модель не только удерживает большой объём информации, но и эффективно работает с ним при построении логических цепочек. По данным Anthropic, разработчики, тестировавшие Sonnet 4.6 в раннем доступе, в 70 % случаев предпочли её версии 4.5. Пользователи отмечали более аккуратную работу с контекстом кода, меньшее количество дублирования логики и более последовательное выполнение инструкций. Разработчики также сообщают о снижении числа «галлюцинаций» и ложных заявлений об успешном выполнении задачи. Отдельное внимание уделено работе с компьютером без специализированных API. Модель взаимодействует с программами так же, как человек — через виртуальные клики мышью и ввод с клавиатуры. В бенчмарке OSWorld, который имитирует задачи в Chrome, LibreOffice и VS Code, свежая Sonnet 4.6 демонстрирует заметный прогресс по сравнению с предыдущими версиями. По словам представителей компании, в ряде сценариев — например, при работе со сложными таблицами или многошаговыми веб-формами — модель приближается к уровню человека. При этом Anthropic признаёт, что ИИ по-прежнему уступает наиболее опытным пользователям и что реальная работа с ПО сложнее лабораторных тестов. Anthropic отмечает, что Sonnet 4.6 предоставляет значительно улучшенные навыки программирования по сравнению с предыдущей версией. В соответствующих бенчмарках новинка оказалась лучше Gemini 3 Pro, а также почти сравнялась с Opus 4.5. По словам бета-тестеров модели, особенно заметны улучшения в задачах фронтенд-разработки и финансового анализа. Также отмечается, что Sonnet 4.6 в ряде задач смогла обеспечить уровень производительности, для достижения которого прежде требовалось использовать модели класса Opus, в том числе в реальных офисных задачах. Anthropic также раскрыла показатели на тесте ARC-AGI-2 — одном из наиболее сложных бенчмарков, оценивающих способность модели к абстрактному рассуждению и обобщению (навыков, характерных для человеческого интеллекта). Sonnet 4.6 достигла 60,4 % при высоком уровне «усилия мышления». Этот результат ставит Sonnet 4.6 выше большинства сопоставимых моделей, хотя он отстаёт от таких решений, как Opus 4.6, Gemini 3 Deep Think и одной из усовершенствованных версий GPT 5.2. В конце отметим, что релиз Sonnet 4.6 состоялся всего через две недели после запуска Opus 4.6, а значит, обновлённая модель Haiku, вероятно, появится в ближайшие недели. Модель уже доступна в боте Claude и приложении, а также через API для сторонних сервисов. Стоимость в последнем случае остаётся на уровне Sonnet 4.5 — от $3 за миллион входных токенов и $15 за миллион выходных. Alibaba, ByteDance и Kuaishou представили ряд новых ИИ-моделей — от роботов до киношного видео

16.02.2026 [09:10],

Владимир Фетисов

В то время как ИИ-рынок США на прошедшей неделе был занят изучением влияния инструментов Anthropic и Altruist на сферы программирования и оказания финансовых услуг, китайские IT-гиганты запустили ИИ-модели, показавшие прирост производительности в робототехнике и генерации видео. Alibaba, ByteDance (владелец TikTok) и платформа коротких видео Kuaishou представили новые алгоритмы, подтверждающие, что китайские разработчики не отстают от американских коллег.

Источник изображения: Gemini Анонс новых алгоритмов китайских IT-гигантов произошёл на фоне недавнего заявления главы ИИ-подразделения Google DeepMind Демиса Хассабиса (Demis Hassabis) касательно того, что китайские ИИ-модели отстают от западных конкурентов всего на несколько месяцев. Однако представленные на прошедшей неделе инструменты вполне могут рассматриваться в качестве прямых конкурентов ИИ-моделям для генерации видео, таким как Sora от OpenAI, а также моделям для сферы робототехники от Nvidia и Google. Исследовательское подразделение Alibaba DAMO анонсировало RynnBrain — ИИ-модель, предназначенную для того, чтобы помочь роботам понимать окружающий их физический мир и идентифицировать объекты. В демонстрационном ролике Alibaba показала робота с клешнями вместо рук, который собирал апельсины и складывал их в корзину. Там также показали, как робот достаёт молоко из холодильника. ИИ-модели требуют обширного обучения для достижения цели по идентификации повседневных объектов и взаимодействия с ними. Это означает, что такой простой для человека процесс, как сбор фруктов, для робототехники является гораздо более сложным. С запуском RynnBrain Alibaba начнёт конкурировать с такими компаниями, как Nvidia и Google, которые ведут разработку собственных ИИ-моделей для сферы робототехники. «Одним из её [ИИ-модели] ключевых новшеств является встроенное осознание времени и пространства. Вместо того, чтобы просто реагировать на непосредственные сигналы, робот может запоминать, когда и где происходили события, отслеживать прогресс выполнения задачи и продолжать действовать на протяжении нескольких этапов. Это делает его более надёжным и последовательным в сложных реальных условиях», — считает исследователь из Hugging Face Адина Якефу (Adina Yakefu). Она также добавила, что «более масштабная цель» Alibaba состоит в том, чтобы «создать базовый интеллектуальный уровень для воплощённых систем». Компания ByteDance на минувшей неделе представила Seedance 2.0 — модель искусственного интеллекта для генерации видео, которая может создавать реалистичные ролики на основе простого текстового описания. При этом алгоритм также может работать с другими видео и изображениями. Демонстрационные видео, созданные с помощью Seedance 2.0, выглядят вполне реалистично.

Источник изображения: Sony Адина Якефу подтвердила, что ИИ-модель Seedance 2.0 показала значительный прогресс по сравнению с предыдущими версиями в плане «управляемости, скорости и эффективности работы». «На сегодняшний день Seedance 2.0 — одна из самых сбалансированных моделей для генерации видео, которые я тестировала. Она удивила меня, выдав удовлетворительные результаты с первой попытки, даже обрабатывая простой запрос. Визуализация, звуковое сопровождение и операторская работа объединяются таким образом, что результат работы кажется отточенным, а не экспериментальным», — добавила Якефу. Хоть пользователи и хвалят этот алгоритм, известно, что у Seedance 2.0 возникли проблемы. Китайские СМИ сообщили, что разработчики временно заблокировали функцию генерации голоса человека на основе загруженного фото. Это произошло после того, как один из местных блогеров обратил внимание на проблему генерации голоса по фото без согласия того, кто изображен на снимке. Представители ByteDance пока никак не комментируют данный вопрос. Ещё одной новинкой стала ИИ-модель Kling 3.0 от Kuaishou, которая предназначена для генерации видео и является конкурентом алгоритма ByteDance. В сообщении сказано, что Kling 3.0 «отличается существенными улучшениями в согласованности, фотореалистичности результата работы, увеличенным временем продолжительности видео до 15 секунд и встроенной генерацией аудио на нескольких языках, диалектах и с разными акцентами». В настоящее время алгоритм Kling 3.0 доступен только платным подписчикам, но вскоре Kuaishou обещает открыть его для более широкой аудитории пользователей. Успех компании с ИИ-моделями Kling способствовал росту стоимости акций Kuaishou более чем на 50 % за последний год. Стоит упомянуть некоторые другие важные релизы. Компания Zhipu AI, которая работает в Гонконге под названием Knowledge Atlas Technology, представила алгоритм GLM-5 — открытую языковую модель с расширенными возможностями в области программирования и создания ИИ-агентов. Компания заявила, что последняя версия её ИИ-модели приближается к Anthropic Claude Opus 4.5 по показателям в профильных бенчмарках, а также превосходит Google Gemini 3 Pro в некоторых тестах. Этот релиз способствовал значительному рост курса акций Zhipu AI. Стоимость ценных бумаг MiniMax также подскочила в конце недели после того, как компания запустила обновлённую версию открытой ИИ-модели M2.5 с улучшенными инструментами ИИ-агентов. Этот алгоритм может использоваться для эффективной автоматизации выполнения разных задач. OpenAI обвинила китайскую DeepSeek в краже данных для обучения ИИ-модели R1

13.02.2026 [12:11],

Алексей Разин

Агентство Bloomberg со ссылкой на служебную записку OpenAI сообщает, что создатели ChatGPT обвинили китайскую DeepSeek в использовании ухищрений, позволяющих добывать информацию американских ИИ-моделей для обучения китайского чат-бота R1 следующего поколения. Соответствующий доклад был направлен американским парламентариям, по данным источника.

Источник изображения: Unsplash, Solen Feyissa По мнению представителей OpenAI, китайский конкурент использовал метод так называемой дистилляции, чтобы «бесплатно выехать на успехе технологий, разработанных OpenAI и других передовых американских компаний». Создателям ChatGPT якобы удалось выявить новые изощрённые методы получения доступа китайской DeepSeek к информации американских ИИ-моделей, которые призваны обходить существующие методы защиты. Беспокойство на эту тему OpenAI и Microsoft проявили ещё в прошлом году, когда начали соответствующее расследование в отношении деятельности DeepSeek. Метод дистилляции позволяет ускорить обучение сторонних ИИ-моделей с использованием данных уже обученных систем. Анализ активности на собственной платформе, как отмечает OpenAI, позволяет говорить об участившихся случаях применения дистилляции сторонними разработчиками ИИ-моделей — преимущественно расположенными в Китае, хотя в отчёте упоминается и Россия. Поскольку DeepSeek не предлагает своим клиентам платных подписок, как и многие другие китайские провайдеры подобных услуг, они получают большее распространение, чем проприетарные коммерческие решения западного происхождения, по мнению авторов доклада. Это угрожает мировому главенству ИИ-моделей американской разработки, как резюмируют они в своём обращении к специальному комитету американского парламента. Полученные методом дистилляции сторонние ИИ-модели, по словам представителей OpenAI, нередко лишены тех ограничений, которые устанавливаются создателями исходных систем, а потому могут использоваться во вред человечеству или отдельным странам. Попытки OpenAI оградить себя от дистилляции китайскими разработчиками успехом не увенчались, поскольку представители DeepSeek якобы получали доступ к американским ИИ-моделям разного рода окольными путями. По словам представителей OpenAI, существуют целые сети посредников, которые предоставляют доступ к услугам компании в обход существующих ограничений. Для американских чиновников существование подобных практик тоже не является откровением, отмечает Bloomberg. Американские политики обеспокоены и возможностью получения компанией DeepSeek доступа к более современным ускорителям вычислений Nvidia H200, поскольку их поставки в Китай в прошлом году успел разрешить американский президент Дональд Трамп (Donald Trump). В сочетании с существующими методами обучения своих моделей, DeepSeek могла бы в результате добиться существенного прогресса. Прежние расследования уже выявили, что DeepSeek использовала для обучения своих предыдущих ИИ-моделей оборудование Nvidia, хотя основная его часть была доставлена в Китай в рамках существовавших на тот момент правил экспортного контроля США. Политики теперь опасаются, что доступ DeepSeek к более современным чипам H200 сильнее навредит позициям США на мировой технологической арене. OpenAI выпустила GPT-5.3-Codex-Spark — свою первую ИИ-модель, работающую без чипов Nvidia

12.02.2026 [23:26],

Николай Хижняк

Компания OpenAI выпустила свою первую модель искусственного интеллекта, работающую на гигантских чипах-ускорителях Wafer Scale Engine 3 от стартапа Cerebras Systems. Данный шаг является частью усилий создателя ChatGPT по диверсификации поставщиков аппаратного обеспечения для обучения своих моделей.

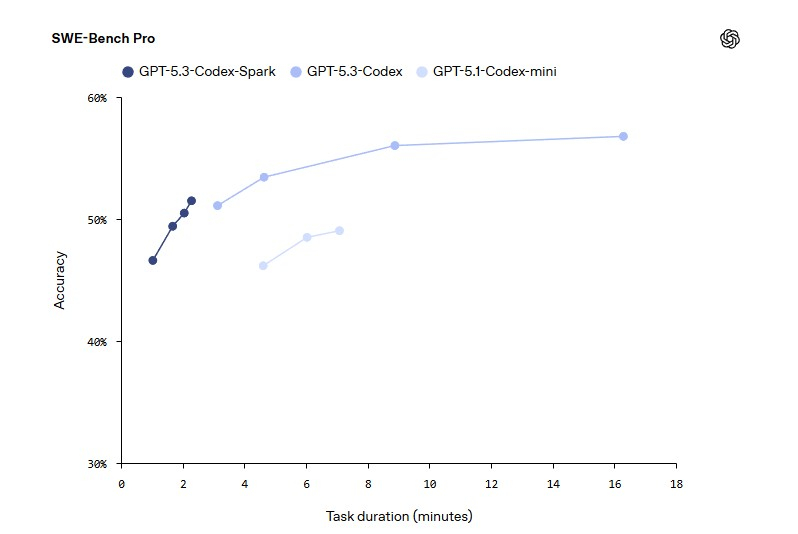

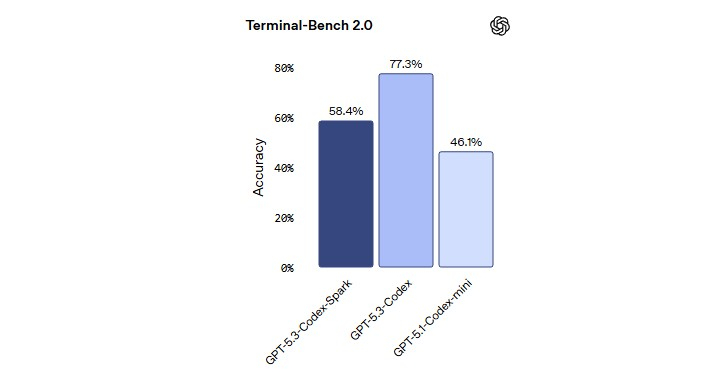

Источник изображения: OpenAI Модель GPT-5.3-Codex-Spark является менее мощной, но более быстрой версией продвинутой модели GPT-5.3-Codex, ориентированной на помощь в написании программного кода. Версия Spark позволит инженерам-программистам быстро выполнять такие задачи, как редактирование отдельных фрагментов кода и запуск тестов. Пользователи также могут легко прервать работу модели или дать ей указание выполнить что-то другое, связанное с вайб-кодингом, не дожидаясь завершения длительного вычислительного процесса.

Источник изображения: OpenAI В прошлом месяце OpenAI заключила сделку на сумму более $10 млрд на использование оборудования Cerebras для ускорения обучения своих моделей ИИ. Для Cerebras это партнёрство представляет собой значительный шаг в её стремлении конкурировать на рынке аппаратных средств для ИИ, где долгое время доминирует компания Nvidia. Для OpenAI — это способ расширить сотрудничество с разными поставщиками оборудования для удовлетворения растущих вычислительных потребностей.

Источник изображения: OpenAI В октябре OpenAI заявила о заключении многолетнего соглашения о стратегическом партнёрстве, в рамках которого будет построена ИИ-инфраструктура на базе сотен тысяч ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт. Позже в том же месяце OpenAI согласилась приобрести специализированные чипы и сетевые компоненты у Broadcom. Как пишет Bloomberg, в последнее время отношения OpenAI с Nvidia оказались под пристальным вниманием на фоне сообщений о напряженности между двумя компаниями. Однако руководители обеих компаний публично заявили, что по-прежнему привержены сотрудничеству. В заявлении, опубликованном в четверг, представитель OpenAI заявил, что партнёрство компании с Nvidia является «основополагающим» и что самые мощные модели ИИ OpenAI являются результатом «многолетней совместной работы над аппаратным и программным обеспечением» двух компаний. «Именно поэтому мы делаем упор на Nvidia как на основу нашей системы обучения и вывода, целенаправленно расширяя экосистему вокруг неё за счёт партнёрств с Cerebras, AMD и Broadcom», — заявил представитель компании. Первоначально GPT-5.3-Codex-Spark будет доступна подписчикам ChatGPT Pro в качестве предварительной версии для исследований. OpenAI собирается предоставить доступ к новой ИИ-модели для более широкого числа пользователей в ближайшие недели. Компания также отмечает, что Codex имеет более 1 млн активных еженедельных пользователей. Китай вырвался вперёд: в шестёрке лучших открытых ИИ-моделей в мире не осталось американских

03.02.2026 [18:37],

Сергей Сурабекянц

Американские инвесторы столкнулись с неприятной реальностью в сфере ИИ: самые мощные открытые модели в мире теперь создаются не в США, а в Китае. В течение последнего года все больше технологов и финансистов предупреждают, что США незаметно уступают рынок открытых моделей ИИ китайским лабораториям, таким как DeepSeek, Moonshot AI и Z.ai.

Источник изображения: unsplash.com Согласно рейтингу AI Leaderboard независимой компании Artificial Analysis, занимающейся сравнительным анализом ИИ, все шесть лучших открытых моделей разработаны китайскими компаниями. Они неуклонно набирают популярность: согласно отчёту OpenRouter и венчурной компании Andreessen Horowitz, доля использования китайских открытых моделей в общем объёме использования ИИ составляла лишь 1,2 % в конце 2024 года, но к декабрю 2025 года выросла почти до 30 %. «Примерно 20 % стартапов в области ИИ используют модели с открытым исходным кодом, и из этих компаний, я бы сказал, примерно 80 % используют китайские открытые модели», — заявил генеральный партнёр Andreessen Horowitz Мартин Касадо (Martin Casado). Китай активно субсидирует лаборатории, разрабатывающие модели с открытым исходным кодом. В настоящее время лидирует модель Kimi K2.5 от китайской лаборатории Moonshot AI, которая оценивается в $4,3 млрд. Её конкуренты Zhipu и MiniMax привлекли $558 млн и $620 млн соответственно в ходе своих IPO. Тем временем американские технологические гиганты, похоже, отступают. Компания Meta✴✴, которая когда-то выступала за ИИ с открытым исходным кодом, перешла к моделям с закрытым исходным кодом после того, как её модели Llama 4 с открытым исходным кодом не оправдали ожиданий. Даже лучшая из американских открытых моделей, gpt-oss от OpenAI, задумана как небольшая и эффективная модель, а не как модель передового уровня.  Эту тенденцию стремится переломить стартап Arcee AI из Сан-Франциско. Эта лаборатория по разработке открытых моделей ИИ, предлагает инвесторам раунд финансирования на сумму более $200 млн, который поднимет её биржевую оценку до одного миллиарда долларов. Arcee AI рассчитывает, что западные инвесторы увидят причины — как коммерческие, так и идеологические — чтобы поддержать американскую альтернативу китайским открытым моделям начального уровня. На этой неделе Arcee AI выпустила базовую модель Trinity Large, которая, по её словам, сопоставима с крупнейшим вариантом Llama 4 от Meta✴✴. Arcee AI заявила, что смогла обучить Trinity Large и три другие, меньшие по размеру открытые модели за $20 млн и менее чем за шесть месяцев. Для сравнения: венчурная компания Innovation Endeavors оценила стоимость обучения Llama 4 более чем в $300 млн, а обучение GPT-4 от OpenAI — в $100 млн. Ранее китайская DeepSeek заявила, что потратила всего $294 000 на обучение своей популярной модели R1. Как и её китайские конкуренты, Arcee AI выпускает свои модели с открытыми весами — делая параметры общедоступными, но сохраняя наборы данных для обучения в приватном режиме. Теперь Arcee AI, в штате которой насчитывается всего 30 человек, активно стремится к масштабированию — компания планирует обучить открытую модель, используя более 1 триллиона параметров, что должно сократить отставание от передовых закрытых моделей, таких как GPT 5.2 от OpenAI или Gemini 3 от Google.

Источник изображения: Arcee AI Помимо разработки моделей, Arcee AI намерена развивать свой бизнес в корпоративном и государственном секторах. Компания планирует создать платформу, где клиенты смогут непрерывно обучать её модели с открытыми весами на собственных данных — подход, который, по словам Arcee AI, обеспечивает большую прозрачность и контроль, чем «чёрный ящик» в экономике закрытых систем. По данным Pitchbook, Arcee уже привлекла $30 млн от таких инвесторов, как саудовская Aramco, M12 Ventures от Microsoft, Samsung Next Ventures и Emergence Capital Partners. Сможет ли стратегия Arcee AI сравниться с масштабом и скоростью Китая, остаётся открытым вопросом. Но по мере того, как баланс сил в сфере открытого ИИ смещается на Восток, Arcee AI позиционирует себя как один из немногих американских стартапов, готовых этому противостоять. Главным конкурентом Arcee станет Reflection AI, стартап, основанный двумя бывшими исследователями Google DeepMind, которые в прошлом году привлекли $2 млрд инвестиций с той же целью — создания лучших в своём классе американских открытых моделей. Исследователи предупредили об опасности ИИ-моделей с открытым исходным кодом

29.01.2026 [17:50],

Сергей Сурабекянц

Совместное исследование, проведённое в течение 293 дней компаниями по кибербезопасности SentinelOne и Censys показало масштабы потенциально незаконных сценариев использования тысяч развёрнутых больших языковых моделей с открытым исходным кодом. К ним относятся взлом, разжигание ненависти и преследование, спам, фишинг, контент со сценами насилия или жестокости, кража личных данных, мошенничество и материалы, связанные с сексуальным насилием над детьми

Источник изображения: unsplash.com Исследователи утверждают, что злоумышленники могут легко получить доступ к компьютерам, на которых запущены большие языковые модели (Large language model, LLM) с открытым исходным кодом, а затем использовать их для массовой рассылки спама, создания фишингового контента или дезинформационных кампаний, обходя протоколы безопасности платформы. Хотя существуют тысячи вариантов LLM-систем с открытым исходным кодом, значительная часть доступных моделей представляют собой варианты Meta✴✴ Llama, Google DeepMind Gemma и некоторых других. Хотя некоторые LLM включают в себя механизмы защиты, исследователи выявили сотни случаев, когда эти механизмы были намеренно отключены. По мнению исполнительного директора по исследованиям в области разведки и безопасности SentinelOne Хуана Андреса Герреро-Сааде (Juan Andres Guerrero-Saade), в дискуссиях индустрии ИИ о мерах безопасности «игнорируется этот избыточный потенциал, который явно используется для самых разных целей, некоторые из которых законны, а некоторые явно преступны». В исследовании были проанализированы общедоступные платформы на базе Ollama. Примерно в четверти наблюдаемых моделей исследователи смогли увидеть системные подсказки — инструкции, определяющие поведение модели. Примерно 7,5 % таких подсказок потенциально могут использоваться для вредоносной деятельности. Около 30 % наблюдаемых исследователями хостов расположены на территории Китая, а около 20 % — в США. Генеральный директор и основатель «Глобального центра по управлению ИИ» (Global Center on AI Governance) Рэйчел Адамс (Rachel Adams) полагает, что после выпуска открытых моделей ответственность за дальнейшие действия распределяется между всеми участниками экосистемы, включая лаборатории-источники. «Лаборатории не несут ответственности за каждое последующее злоупотребление, но они сохраняют важную обязанность предвидеть возможный вред, документировать риски и предоставлять инструменты и рекомендации по их смягчению, особенно учитывая неравномерность глобальных возможностей по обеспечению соблюдения законодательства», — заявила Адамс. Представитель Meta✴✴ отказался отвечать на вопросы об ответственности разработчиков за решение проблем, связанных с последующим злоупотреблением моделями с открытым исходным кодом, и о том, как можно сообщать о таких проблемах, но отметил наличие у компании инструментов Llama Protection для разработчиков Llama, а также руководства Meta✴✴ Llama Responsible Use Guide. Представитель Microsoft заявил, что модели с открытым исходным кодом «играют важную роль» в различных областях, но признал, что «открытые модели, как и все преобразующие технологии, могут быть использованы злоумышленниками не по назначению, если они выпущены без надлежащих мер защиты». В конечном итоге, такие ответственные открытые инновации, как запуск доступных моделей ИИ с открытым исходным кодом, требуют сотрудничества между создателями, разработчиками, исследователями и группами безопасности. Учёные придумали термодинамический компьютер, который генерирует изображения в 10 млрд раз энергоэффективнее ИИ

28.01.2026 [15:43],

Павел Котов

Американские учёные предложили использовать в генераторах изображений на основе искусственного интеллекта технологию термодинамических вычислений — она позволяет сократить энергетические затраты на некоторые операции на величину до 10 млрд раз.

Источник изображения: Steve Johnson / unsplash.com Модели генеративного ИИ, в том числе DALL-E, Midjourney и Stable Diffusion, создают фотореалистичные изображения, но потребляют при этом огромное количество энергии. Это диффузионные модели. При обучении им подают большие наборы изображений, к которым постепенно добавляют шум, пока картинка не станет похожей на помехи в старом телевизоре. Далее нейросеть овладевает обратным процессом и генерирует новые изображения по запросу. Проблема в том, что вычисления для алгоритмов ИИ с добавлением и последующим удалением шума потребляют слишком много энергии — термодинамические вычисления позволяют сократить их несоразмерно возможностям современного цифрового оборудования, рассказали в Национальной лаборатории имени Лоуренса в Беркли (Калифорния). При термодинамических вычислениях используются физические схемы, которые меняют параметры в ответ на шум, например вызванный случайными тепловыми перепадами в окружающей среде. Стартап Normal Computing построил чип на основе восьми соединённых друг с другом резонаторов — соединители подключаются сообразно типу решаемой чипом задачи. Далее резонаторы подвергаются воздействию внешней среды, вносят шум в цепь и таким образом выполняют вычисления. После того как система достигает состояния равновесия, решение считывается из новой конфигурации резонаторов. Учёные Национальной лаборатории имени Лоуренса в Беркли показали, что можно построить термодинамическую версию нейросети. Эта методика закладывает основу для генерации изображений с помощью термодинамических вычислений. В термодинамический компьютер вводится набор изображений, далее компоненты компьютера подвергаются естественным воздействиям среды до тех пор, пока связи, соединяющие эти компоненты, не достигают состояния равновесия. Далее вычисляется вероятность того, что термодинамический компьютер с заданным состоянием связей сможет обратить этот процесс, и значения этих связей корректируются, чтобы повысить эту вероятность до максимальной. Симуляции подтвердили, что можно построить термодинамический компьютер, настройки которого помогут генерировать изображения рукописных цифр. Это достигается без энергоёмких цифровых нейросетей или создающего шум генератора псевдослучайных чисел. По сравнению с цифровыми нейросетями термодинамические компьютеры пока примитивны, признают учёные, и как проектировать их для работы на уровне DALL-E, они пока не знают. Но в аспекте энергоэффективности они обещают значительное преимущество. Учёные решили одну из главных проблем ИИ-моделей — создан первый ИИ с «бесконечной» памятью

14.01.2026 [13:08],

Геннадий Детинич

Учёные из Массачусетского технологического института (MIT) элегантно решили одну из главных проблем ИИ — ограничения контекстного окна. Обычно LLM оперирует сотней-другой тысяч токенов, что не позволяет полноценно работать с многотомными архивами. Новая рекурсивная модель лишена этого недостатка, используя вместо памяти систему навигации по контексту.

Источник изображения: The Neuron Новый подход реализован в архитектуре «рекурсивной языковой модели» (Recursive Language Models, RLM). Традиционные большие языковые модели удерживают всю необходимую информацию внутри так называемого контекстного окна с довольно жёстким и ограниченным числом токенов и быстро теряют точность выводов, когда объём входных данных превышает этот лимит. Модель RLM предлагает иной подход: она не пытается запомнить исходные данные целиком, а рассматривает их как внешнее пространство, по которому можно перемещаться и из которого можно извлекать релевантные фрагменты по мере необходимости. Навигация заменяет память. Ключевое отличие RLM от LLM заключается в том, что механизм обращения к информации становится динамическим и рекурсивным (с вложениями, как в случае древовидной структуры папок файловой системы). Модель анализирует запрос, формирует поисковое действие, получает необходимые сегменты данных и повторяет процесс до достижения заданной глубины понимания. В результате архитектура способна работать с массивами информации, превышающими традиционную вместимость контекстного окна в десятки и сотни раз, без непомерного увеличения вычислительных ресурсов. Предлагаемая технология открывает новые возможности для сфер, требующих работы с объёмными документами или сложными структурированными данными. Например, в юридической практике ИИ сможет анализировать полные архивы дел, а не только отдельные фрагменты; в программировании — воспринимать большие объёмы кода; в аналитике — сочетать и сопоставлять множество научных публикаций без предварительной обработки. Способность модели работать с масштабными наборами данных снижает риски искажений фактов и ошибок, связанных с «потерей» контекста из-за того, что он на каком-то этапе выпал из памяти модели. Специалисты MIT предоставили как полноценную библиотеку, реализующую принципы RLM, так и минимальный эталонный код, что упростит знакомство с технологией для всех заинтересованных лиц и ускорит её внедрение. Некоторые компании уже начали адаптировать архитектуру под свои продукты, что лишний раз подтвердило применимость RLM за пределами лабораторий. Таким образом, модели Recursive Language Models могут стать значимым этапом в эволюции нейросетевых архитектур, поскольку предлагают не увеличение объёма памяти модели, а качественно новый способ работы с большими массивами информации. DeepSeek научилась тренировать языковые ИИ-модели без оглядки на ограничения по скорости памяти

14.01.2026 [11:55],

Алексей Разин

Как отмечалось недавно, пропускная способность памяти, используемой в инфраструктуре ИИ, становится одним из серьёзных ограничителей дальнейшего роста быстродействия языковых моделей. Представители DeepSeek утверждают, что разработали метод обучения ИИ-моделей, который позволяет обойти подобные ограничения со стороны памяти.

Источник изображения: Unsplash, Solen Feyissa Группа исследователей Пекинского университета в сотрудничестве с одним из основателей DeepSeek Лян Вэньфэном (Liang Wenfeng) опубликовала научную работу, в которой рассматривается новый подход к обучению языковых моделей, позволяющий «агрессивно увеличивать количество параметров» в обход ограничений, накладываемых подсистемой памяти используемых в ускорителях GPU. От DeepSeek ожидают выхода новой версии большой языковой модели, но ритмичность их создания в случае с китайскими разработчиками сильно страдает от экспортных ограничений США и нехватки ресурсов в Китае. Текст нового исследования, соавтором которого является один из основателей DeepSeek, будет подробно изучаться специалистами в области искусственного интеллекта как в Китае, так и за его пределами. Описываемая в документе методика «условного» использования памяти получила обозначение Engram, как отмечает South China Morning Post. Существующие подходы к вычислениям при обучении больших языковых моделей, по мнению китайских исследователей, вынуждают напрасно тратить ресурсы на тривиальные операции, которые можно было бы высвободить для высокоуровневых операций, связанных с рассуждениями. Исследователи предложили в некотором смысле разделить вычисления и работу с памятью, обеспечивая поиск базовой информации более эффективными способами. Одновременно новая технология позволяет большим языковым моделям лучше обрабатывать длинные цепочки контекста, что приближает цель превращения ИИ-агентов в полноценных помощников человека. В рамках эксперимента новый подход при обучении модели с 27 млрд параметров позволил поднять общий уровень быстродействия на несколько процентов. Кроме того, система получила больше доступных ресурсов для осуществления сложных операций с рассуждениями. По мнению авторов исследования, данный подход будет незаменим при обучении языковых моделей нового поколения в условиях ограниченности ресурсов. По данным The Information, китайская компания DeepSeek намеревается представить новую модель V4 с развитыми способностями в области написания программного кода к середине февраля этого года. Новая ИИ-модель DeepSeek V4 выйдет в феврале, и она должна понравиться вайб-кодерам

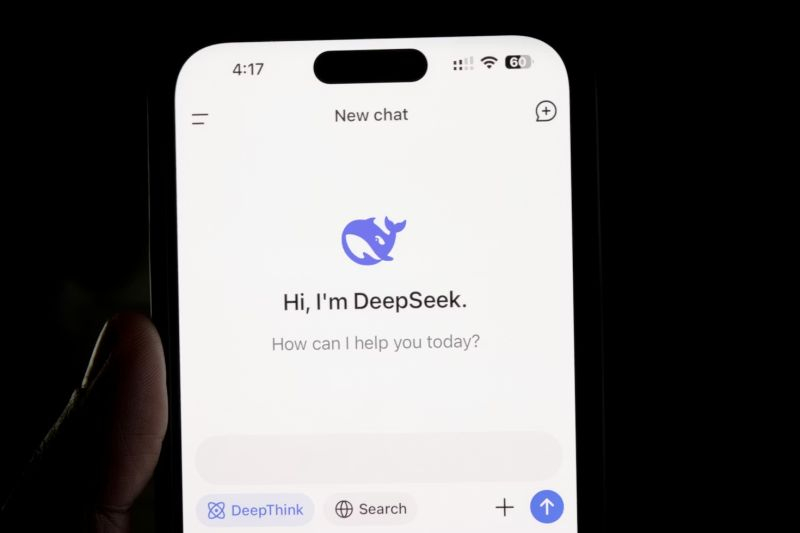

10.01.2026 [13:04],

Николай Хижняк

Китайский стартап DeepSeek, занимающийся разработкой искусственного интеллекта и в прошлом году потрясший Кремниевую долину и Уолл-стрит, готовится к запуску своей модели следующего поколения в ближайшие недели, сообщает Yahoo Finance со ссылкой на отчёт издания The Information.

Источник изображения: Solen Feyissa / unsplash.com Ожидается, что новая модель, получившая название V4, будет обладать расширенными возможностями программирования, которые, согласно внутренним тестам, позволят ей превзойти лидеров отрасли, включая серию GPT от OpenAI и Claude от Anthropic. По словам двух источников, непосредственно знакомых с ситуацией и цитируемых The Information, DeepSeek планирует выпустить модель примерно в середине февраля, в период празднования китайского Нового года, хотя сроки пока окончательно не определены. Время предполагаемого запуска соответствует стратегии, которая ранее принесла пекинскому стартапу огромный культурный и рыночный эффект. В прошлом году DeepSeek выпустила свою флагманскую модель R1 20 января, всего за неделю до недельных китайских новогодних праздников. Этот шаг обеспечил модели доминирование в глобальном технологическом дискурсе в период пикового внимания. DeepSeek, поддерживаемая хедж-фондом High-Flyer Quant, стала глобальным феноменом после выпуска R1. «Рассуждающая» модель, разработанная для «обдумывания» сложных запросов перед ответом, произвела фурор в секторе ИИ не только своей производительностью, но и эффективностью. На рынке, где американские гиганты тратят миллиарды на вычислительные ресурсы, способность DeepSeek достигать сопоставимых результатов за гораздо меньшую стоимость привела к резкой переоценке стоимости ИИ и зависимости от аппаратного обеспечения на западных рынках. Хотя модель DeepSeek V3.2, выпущенная в декабре, превзошла GPT-5 от OpenAI и Gemini 3.0 Pro от Google по некоторым показателям, компания ещё не выпустила нового поколения своей основной архитектуры. Модель V4 призвана заполнить этот пробел. Особый акцент в новой модели сделан на программировании. Умение программировать является основным критерием эффективности ИИ в корпоративной среде, и версия V4 может ещё больше укрепить позиции DeepSeek как недорогой и высокопроизводительной альтернативы американским моделям с закрытым исходным кодом. Для инвесторов предстоящий релиз DeepSeek V4 добавляет новый уровень волатильности в «гонку вооружений в области ИИ». Когда в прошлом году дебютировала DeepSeek R1, это вызвало временное падение акций американских производителей микросхем и лидеров в области ИИ, поскольку рынки столкнулись с реальностью сценария, когда китайский игрок достиг паритета, имея значительно меньше ресурсов, чем конкуренты. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |